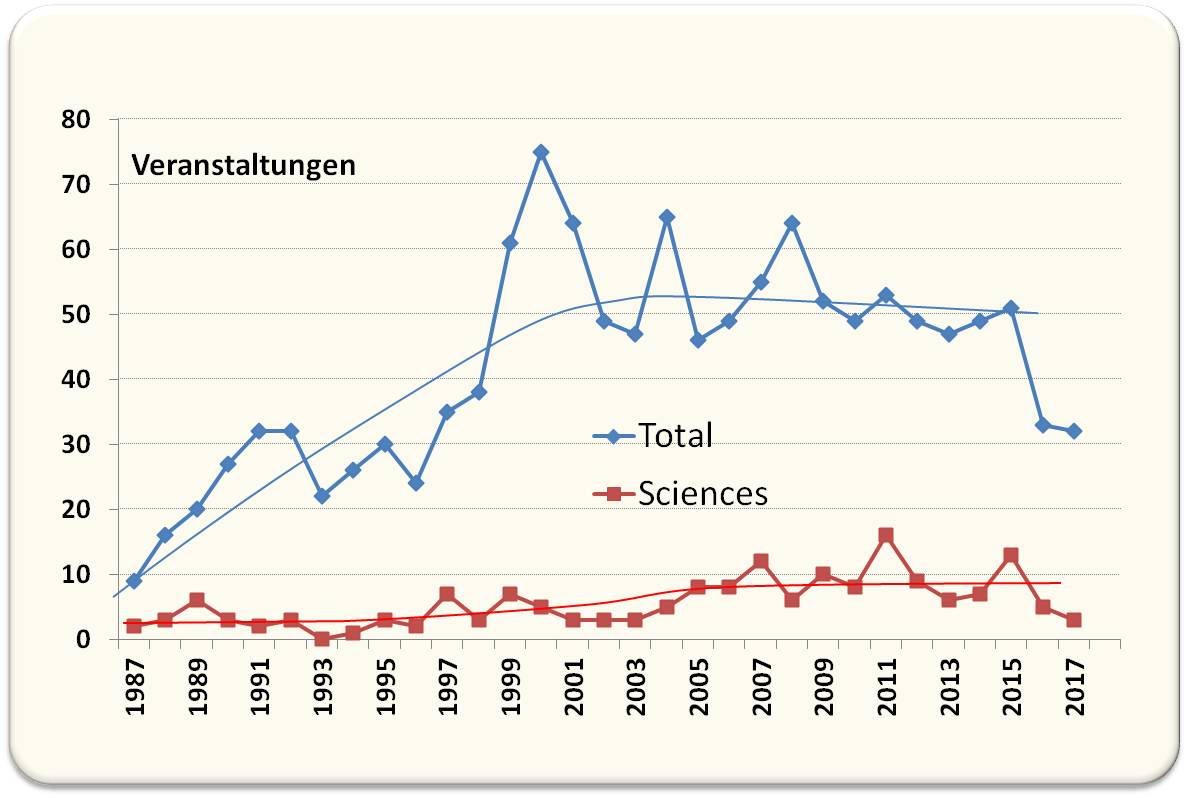

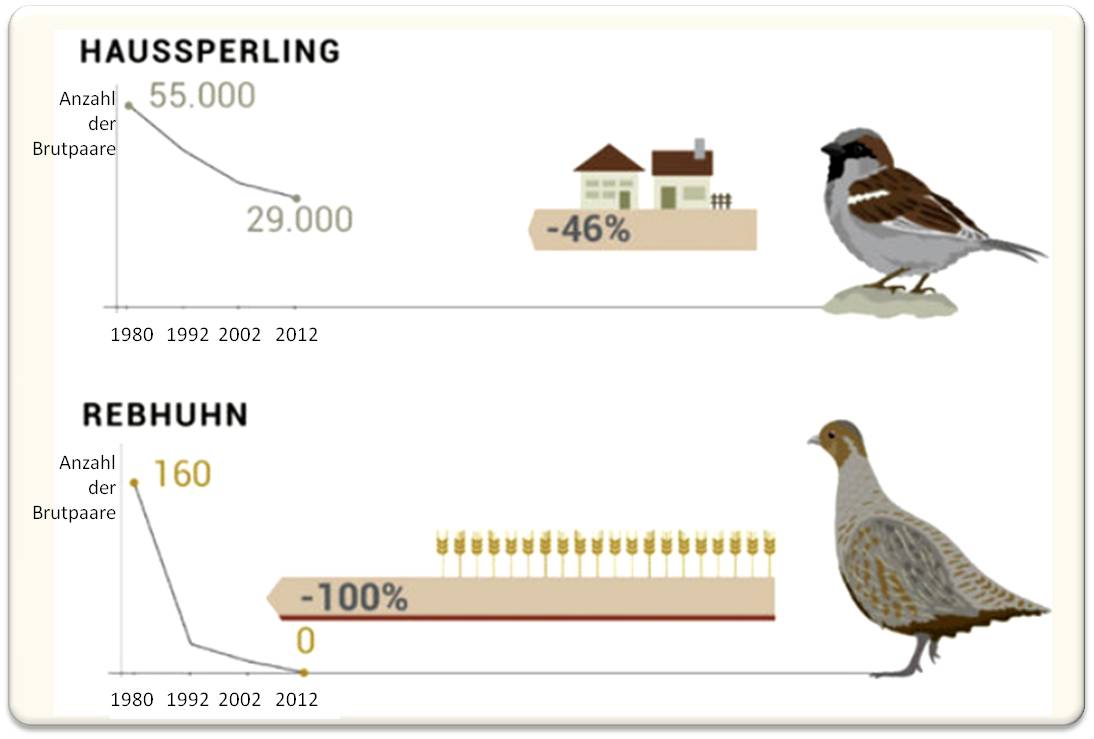

…Erscheinungsdatum

…Erscheinungsdatum Redaktion Tue, 19.03.2019 - 10:102024

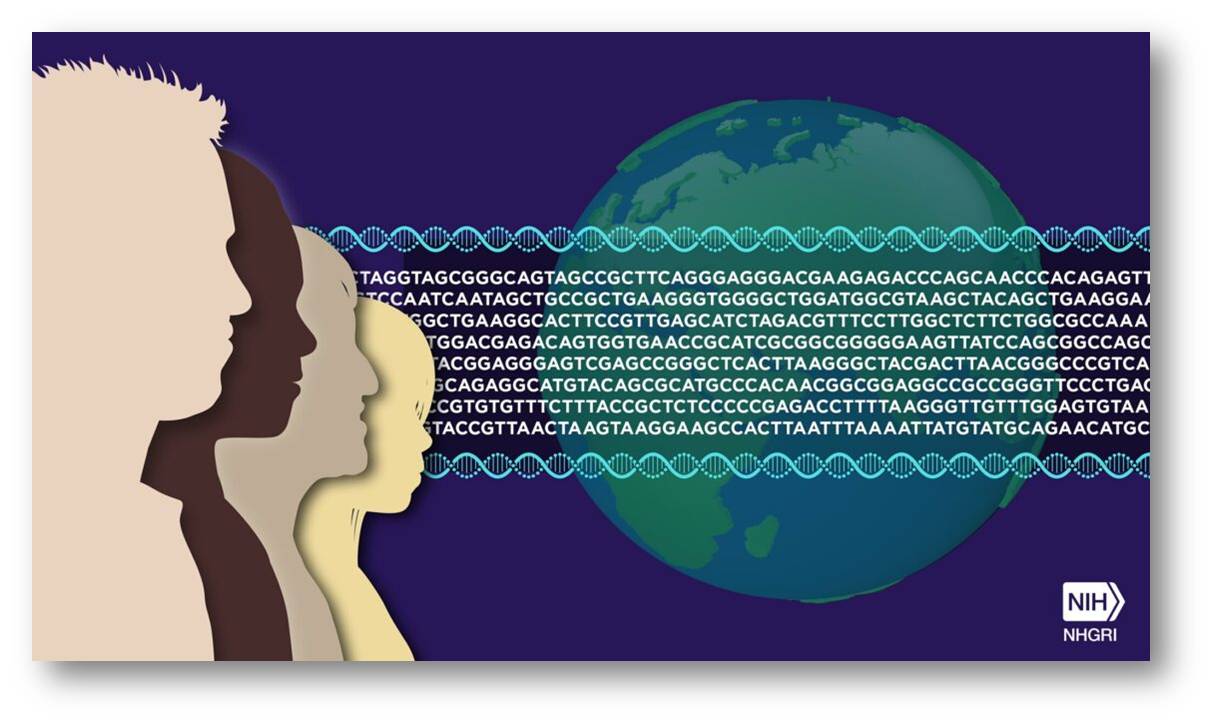

2024 inge Thu, 04.01.2024 - 01:13Schützende Genvarianten bei Alzheimer

Schützende Genvarianten bei AlzheimerFr, 03.05.2024 — Ricki Lewis

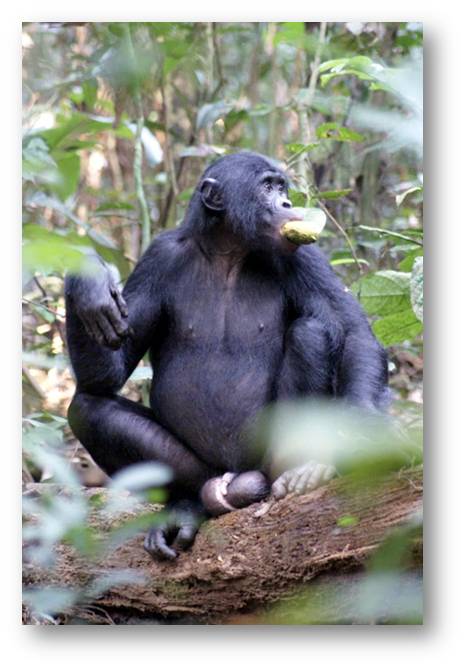

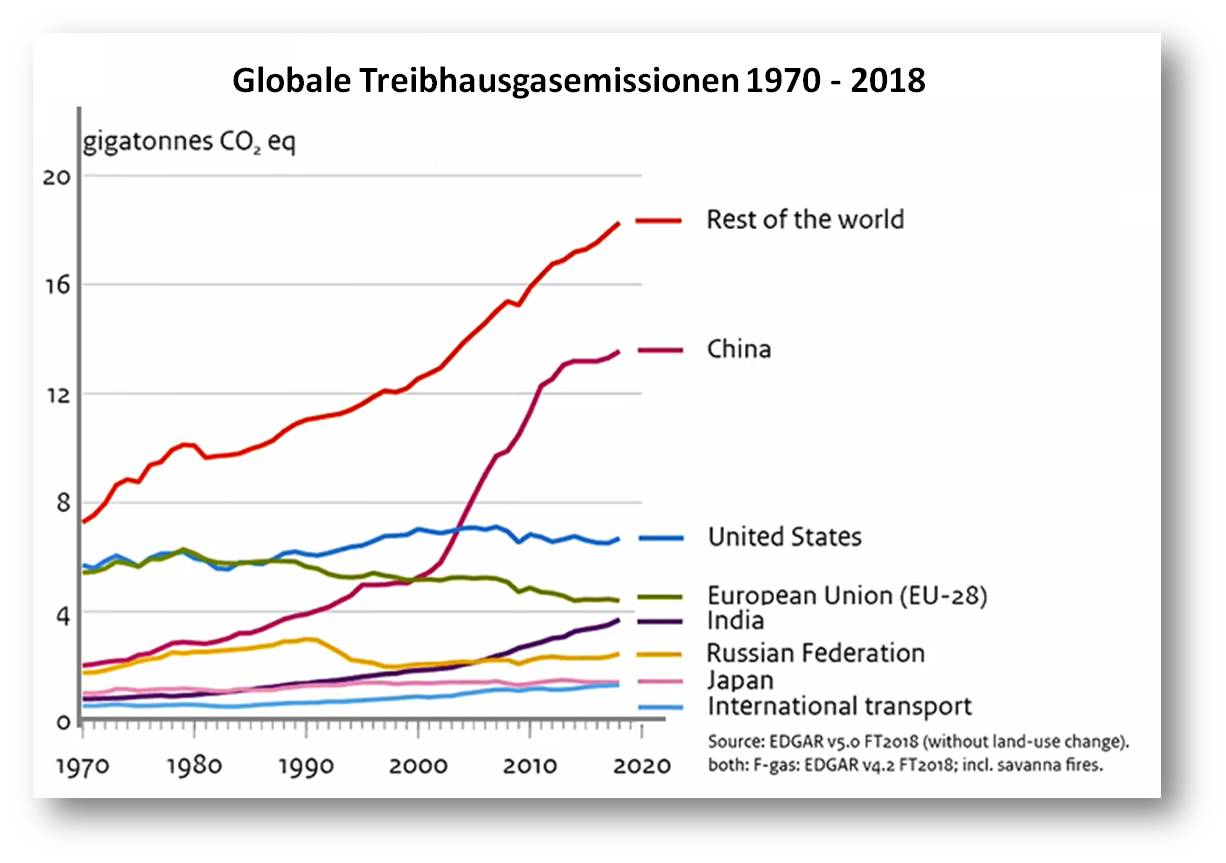

![]() Hinweise auf die Bekämpfung einer verheerenden Krankheit können sich aus der Identifizierung von Menschen ergeben, die Genvarianten - Mutationen - haben, die sie schützen, indem sie die Krankheit verlangsamen oder überhaupt das Risiko ihrer Entstehung verringern. Wenn wir verstehen, wie sie dies tun, können wir Behandlungsstrategien für die gesamte Patientenpopulation entwickeln. Die Genetikerin Ricki Lewis berichtet über seltene Varianten von drei bereits gut untersuchten Genen - APOE-Cristchurch, Reelin und Fibronektin -, die vererbte Formen der Alzheimer-Krankheit zu verzögern scheinen - und zwar um Jahrzehnte. *

Hinweise auf die Bekämpfung einer verheerenden Krankheit können sich aus der Identifizierung von Menschen ergeben, die Genvarianten - Mutationen - haben, die sie schützen, indem sie die Krankheit verlangsamen oder überhaupt das Risiko ihrer Entstehung verringern. Wenn wir verstehen, wie sie dies tun, können wir Behandlungsstrategien für die gesamte Patientenpopulation entwickeln. Die Genetikerin Ricki Lewis berichtet über seltene Varianten von drei bereits gut untersuchten Genen - APOE-Cristchurch, Reelin und Fibronektin -, die vererbte Formen der Alzheimer-Krankheit zu verzögern scheinen - und zwar um Jahrzehnte. *

Gen Nr. 1: Der berühmte Fall der aus einer kolumbianischen Familie stammenden Aliria

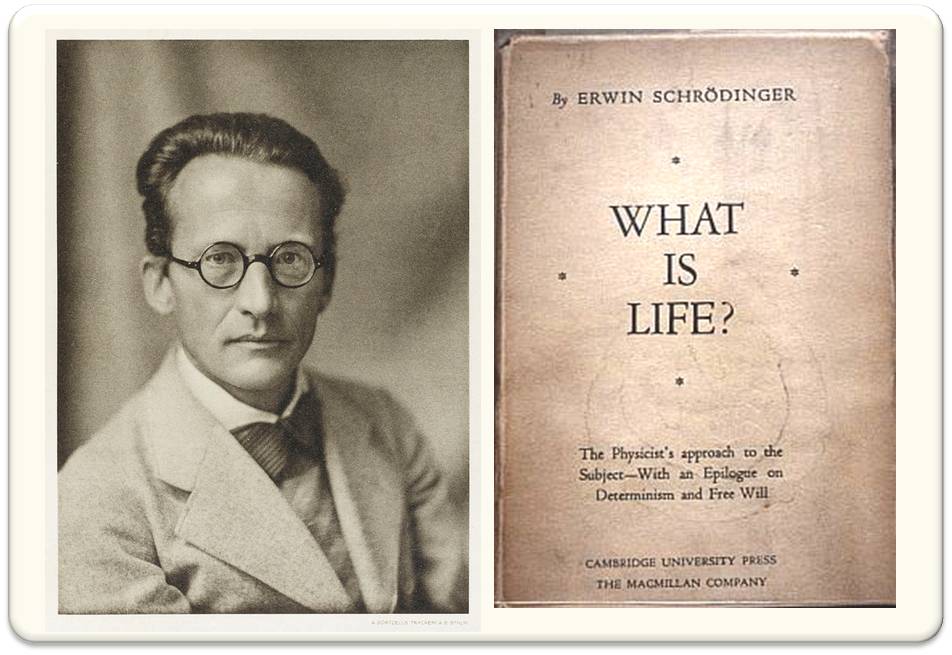

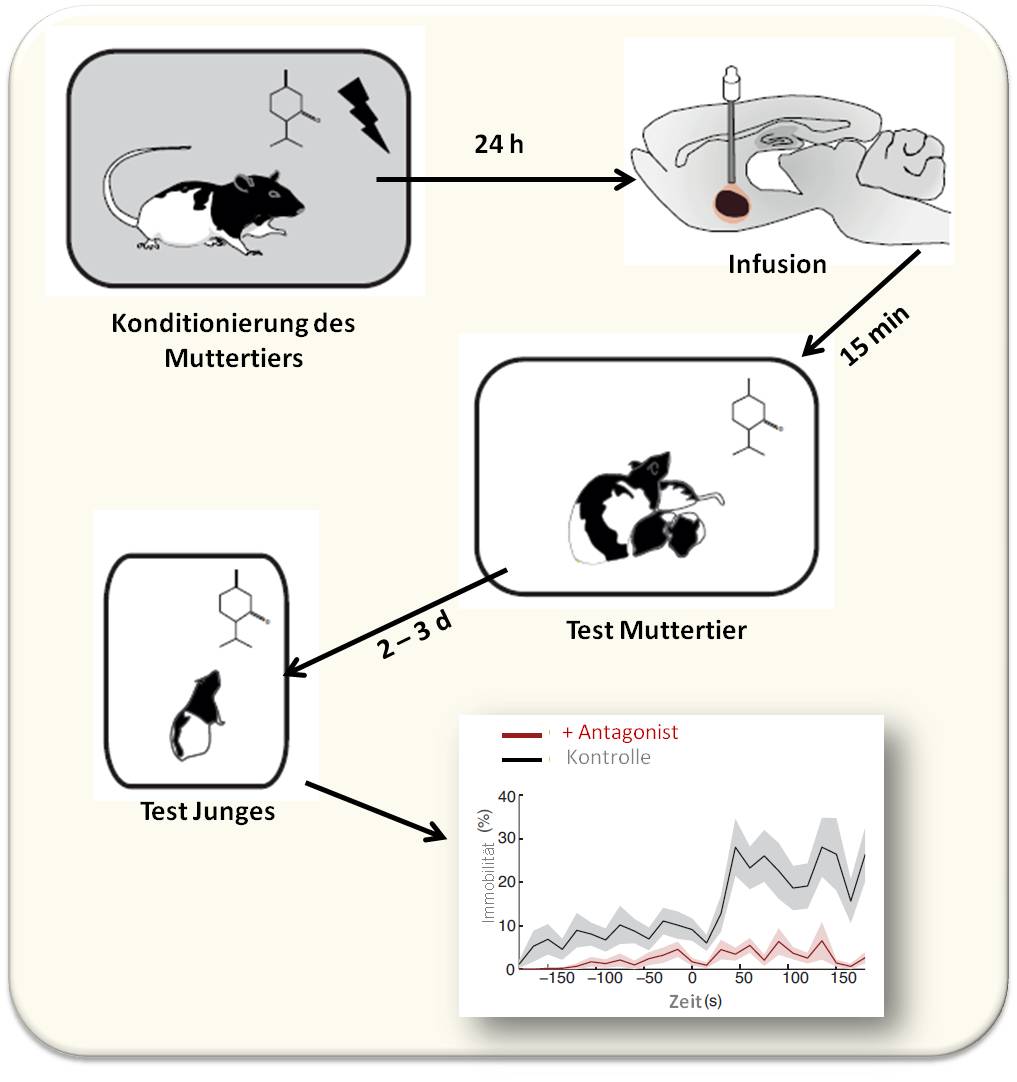

Im Jahr 2019 berichteten Forscher über die Patientin Aliria Rosa Piedrahita de Villegas, die dank einer Variante eines zweiten, offenbar schützenden Gens die früh einsetzende familiäre Alzheimer-Krankheit abgewehrt zu haben schien. Der Bericht erschien in Nature Medicine [1].

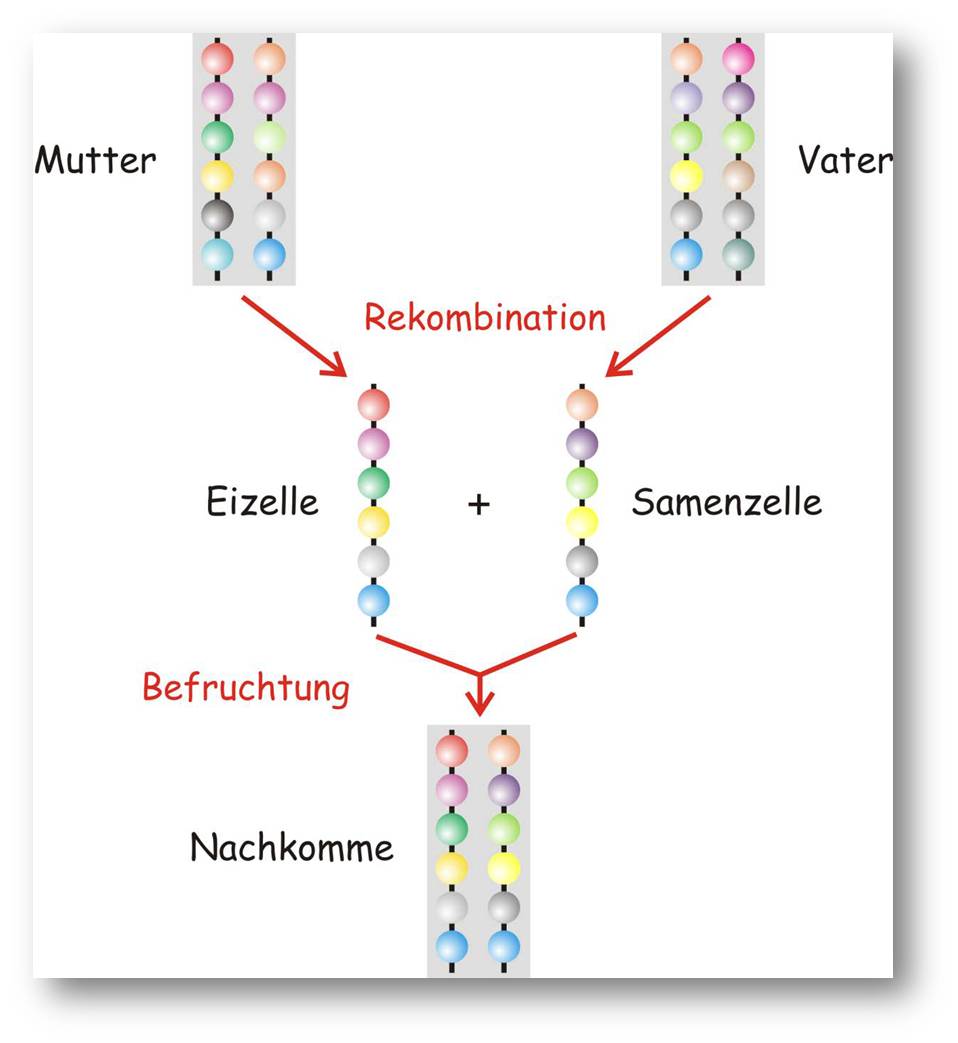

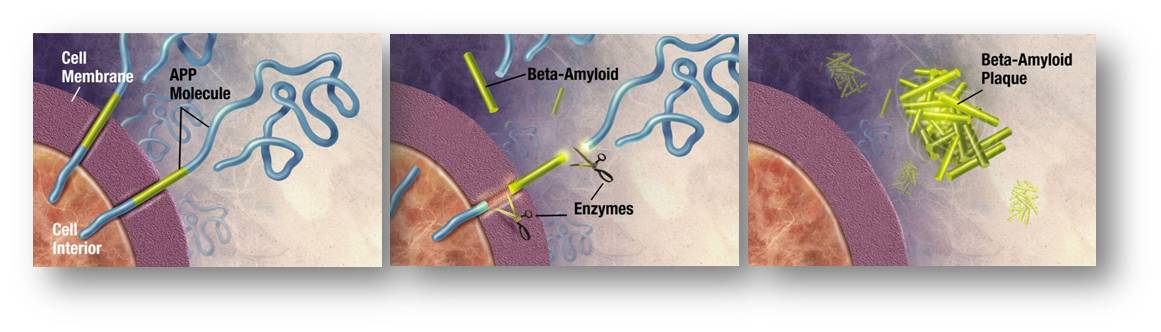

Aliria gehört zu einer 6 000 Mitglieder zählenden Familie in Kolumbien, die dafür bekannt ist, dass viele Menschen im Alter von etwa 44 Jahren Symptome von Alzheimer zeigen, die verdächtige Anhäufung von Amyloid-Beta-Protein aber bereits in ihren Zwanzigern auftrat. Etwa die Hälfte der Familie ist davon betroffen. Sie haben eine Variante des Presenilin-1-Gens (PSEN1 E280A), die für etwa 70 Prozent der Fälle von früh einsetzender Alzheimer-Krankheit verantwortlich ist. Aliria hat die Variante geerbt, doch bei ihr setzte der kognitive Abbau erst im Alter von 72 Jahren ein.

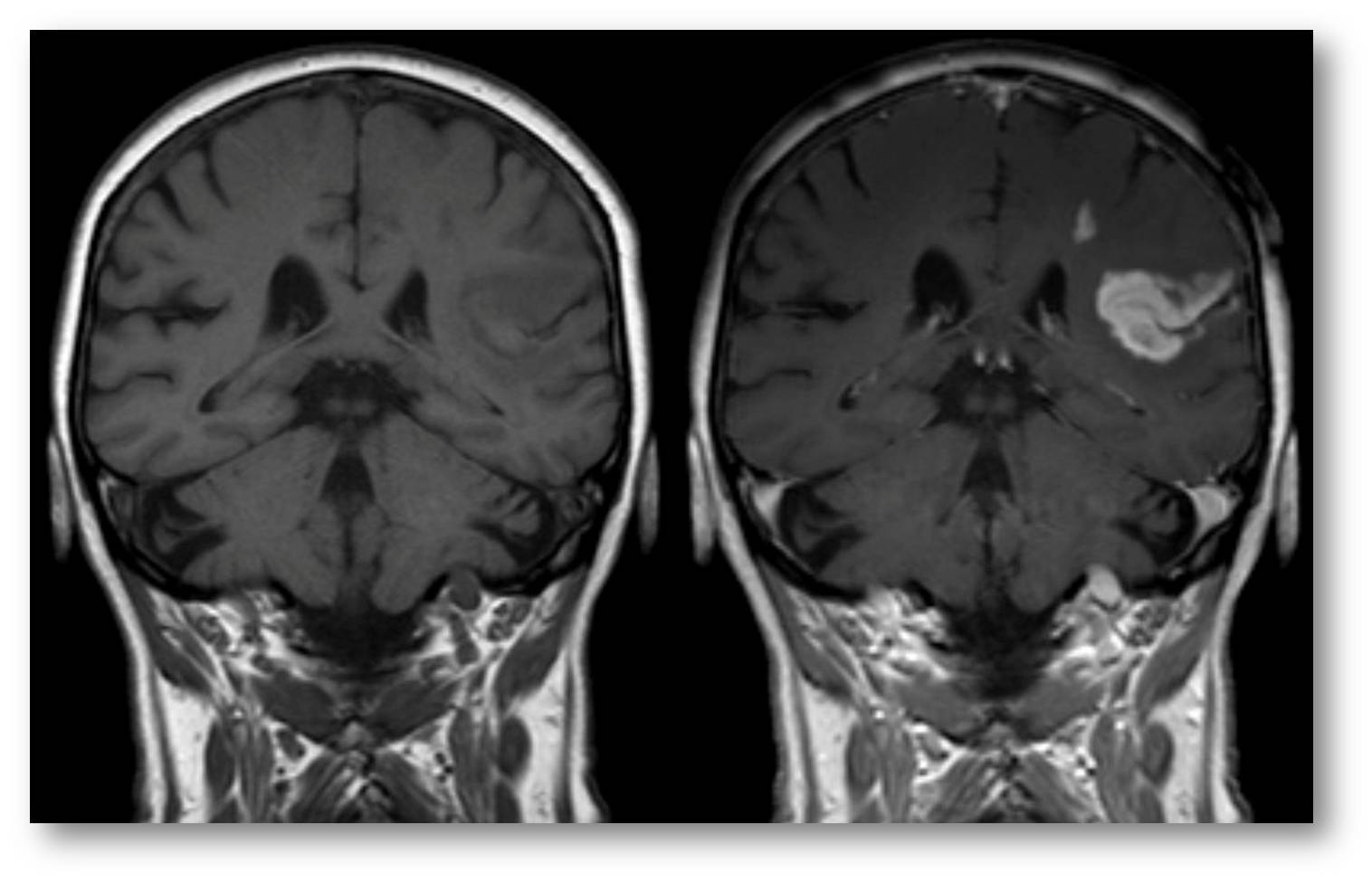

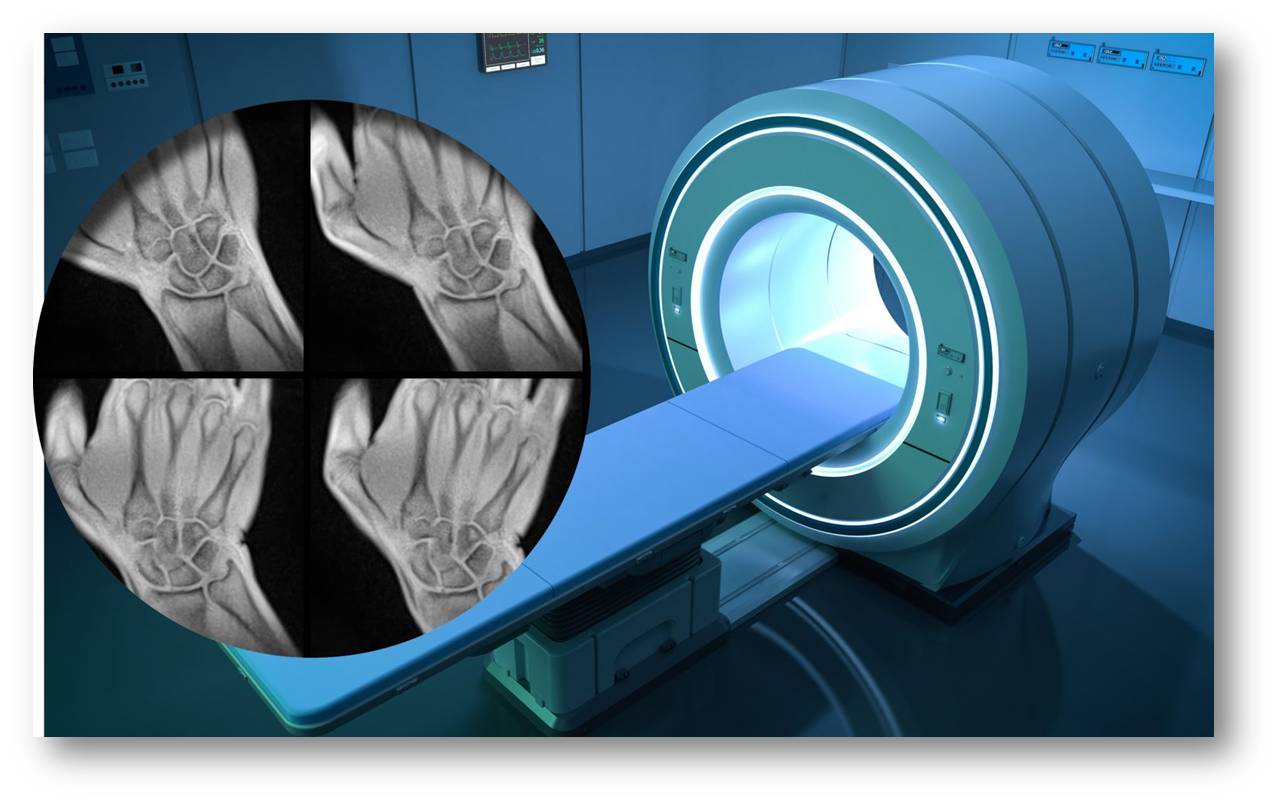

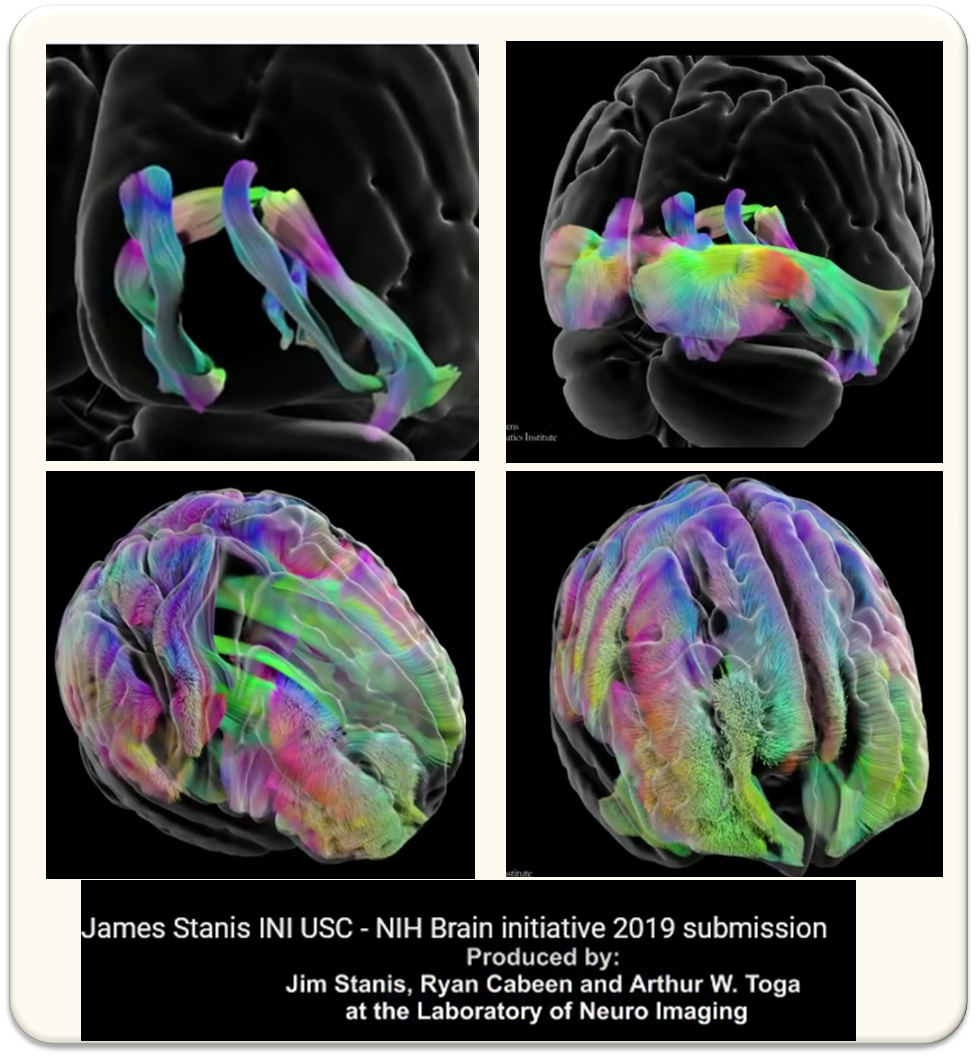

"Unsere Arbeit mit dieser Familie ermöglicht es uns, die frühesten Veränderungen, die mit der Alzheimer-Krankheit in Verbindung gebracht werden, zu verfolgen und festzustellen, wie diese Veränderungen im Laufe der Zeit ablaufen. Dies wird uns helfen, über die Menschen in Kolumbien hinaus festzustellen, wer gefährdet und wer resistenter gegen Alzheimer ist, und zu lernen, welche Biomarker das Fortschreiten der Krankheit besser vorhersagen können", erklärte Dr. Yakeel T. Quiroz vom Massachusetts General Hospital gegenüber der Alzheimer's Association. Dort wurden bei dieser speziellen Patientin Hirnscans durchgeführt, die die für die Krankheit charakteristischen sehr hohen Konzentrationen von Amyloid-Beta-Protein-Plaques aufzeigten.

Aber was genau hat Aliria geschützt?

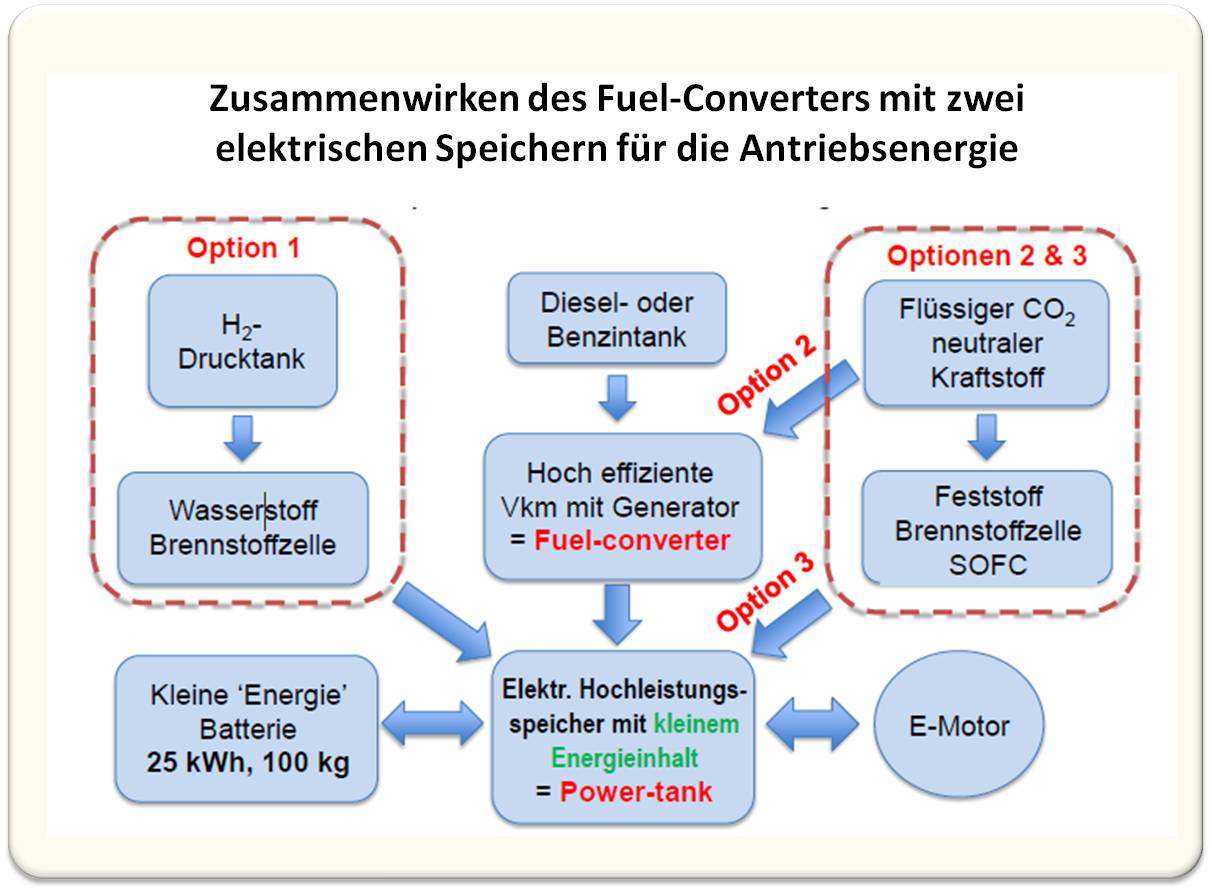

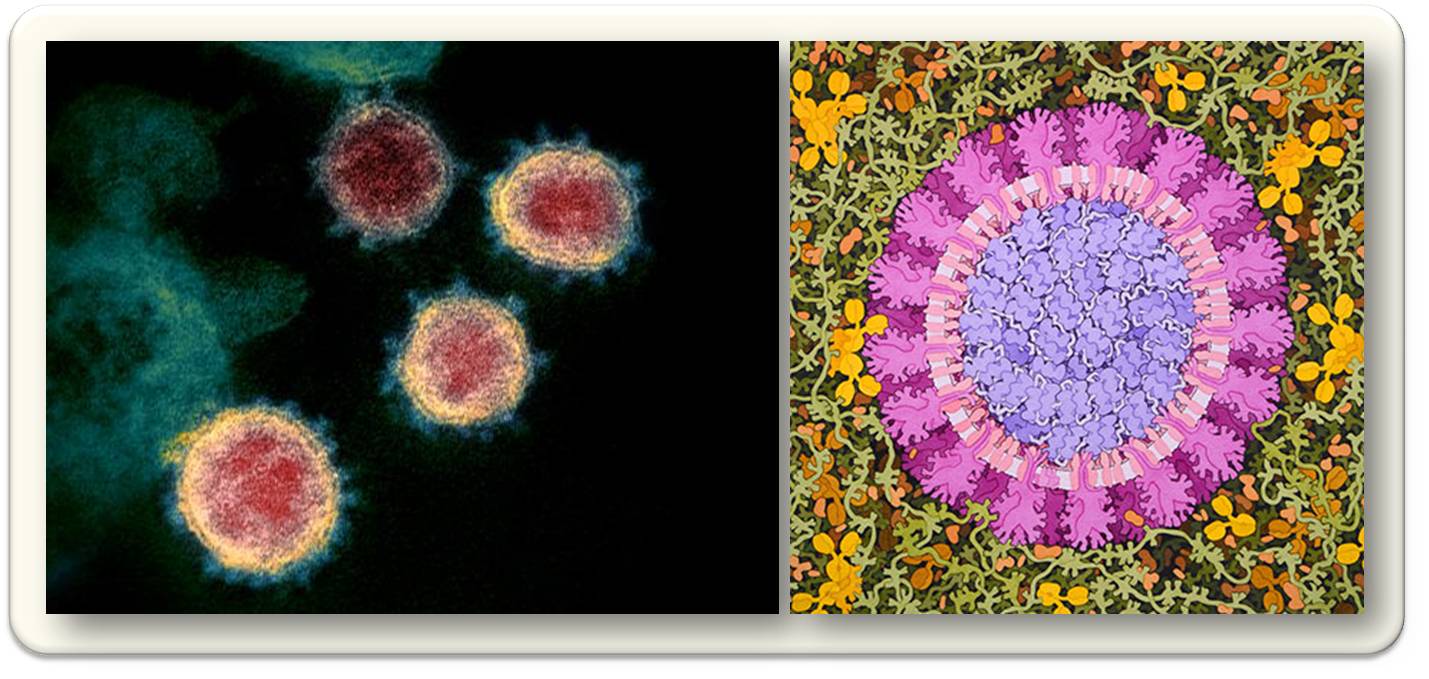

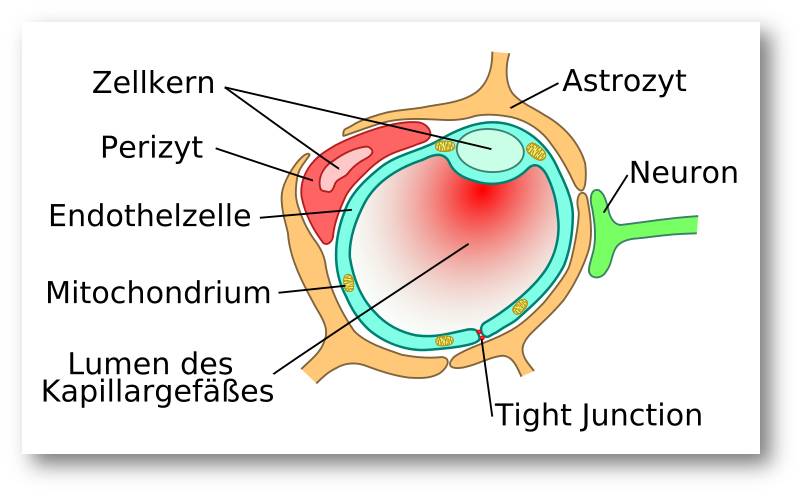

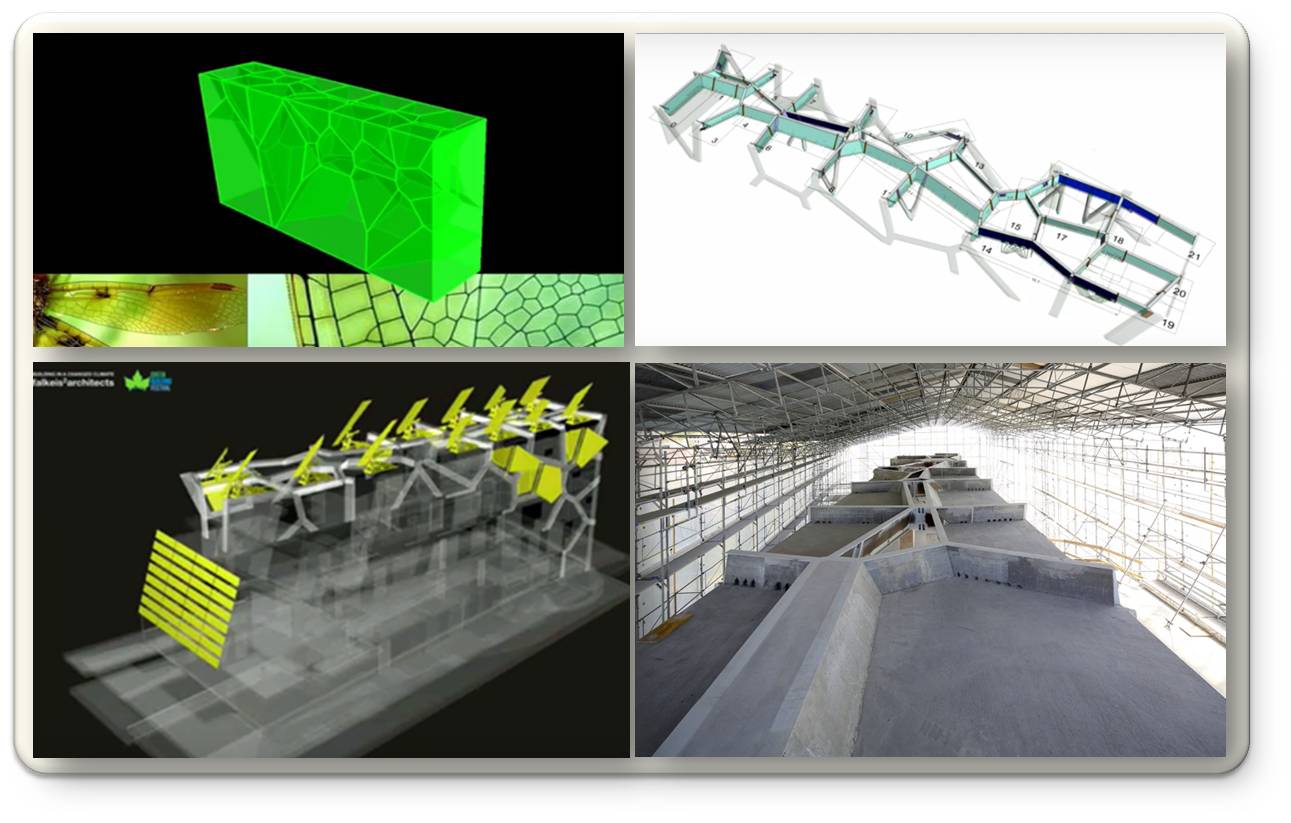

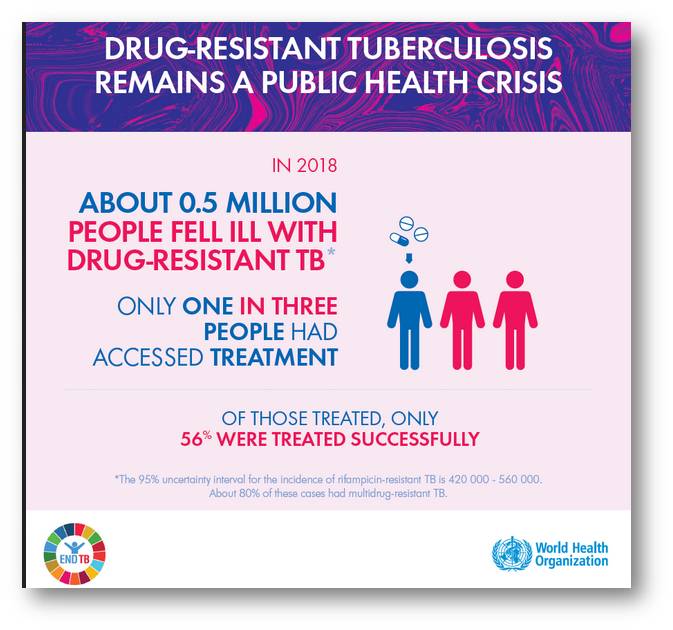

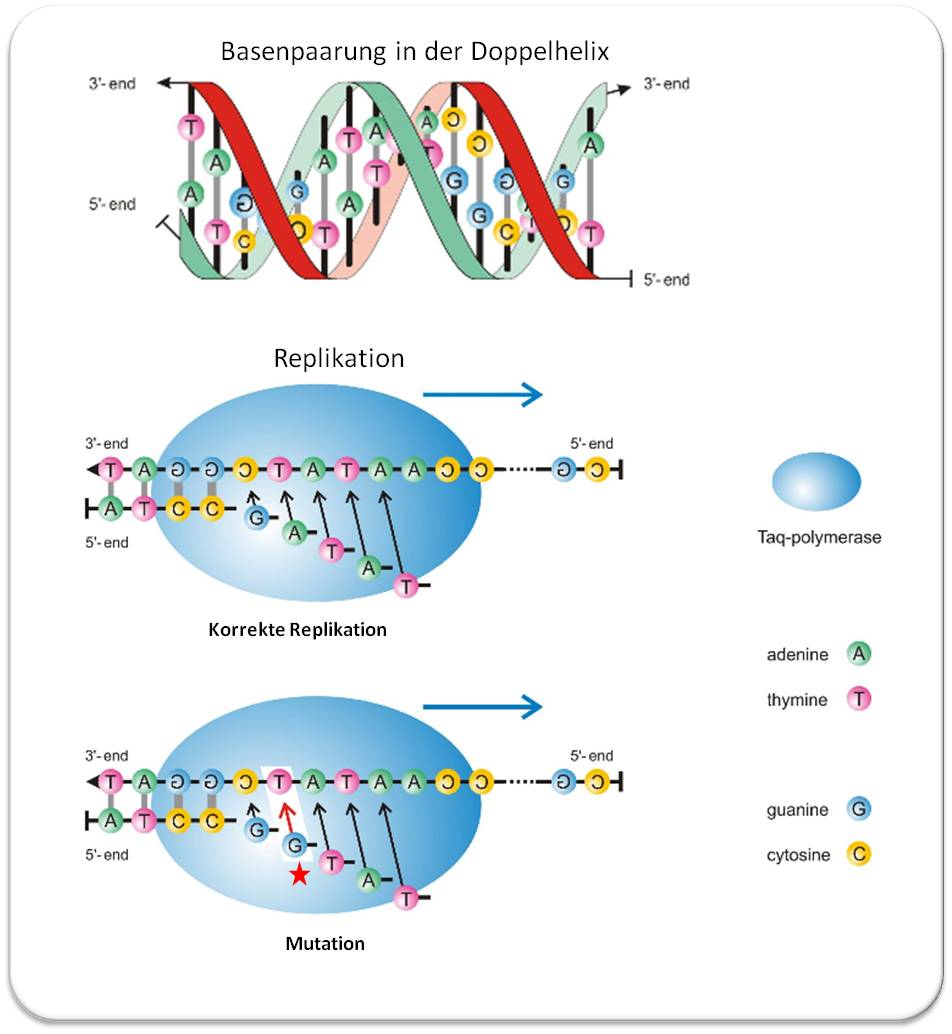

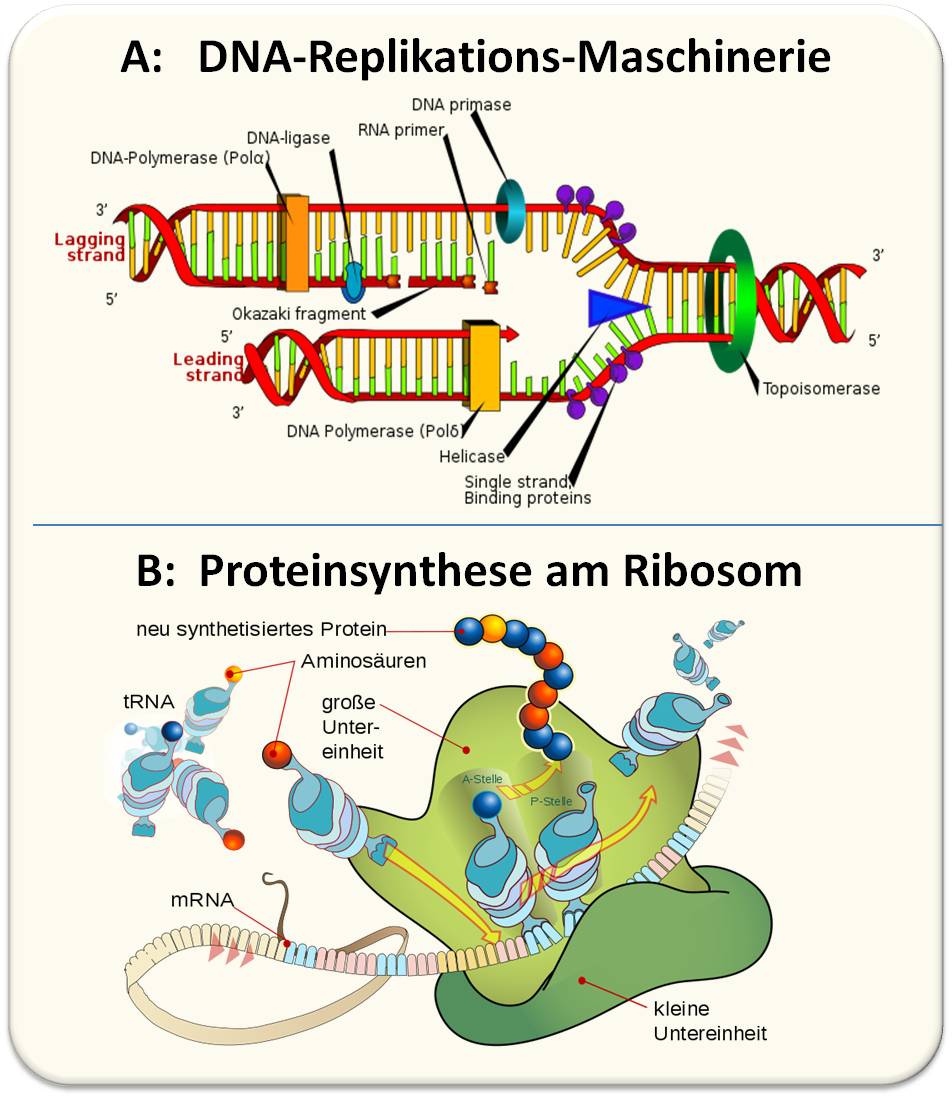

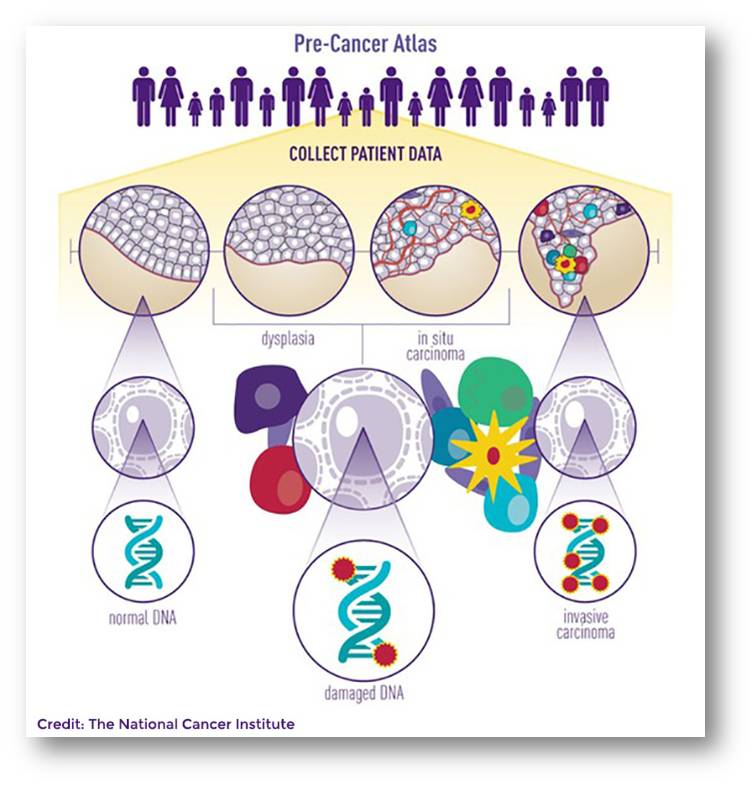

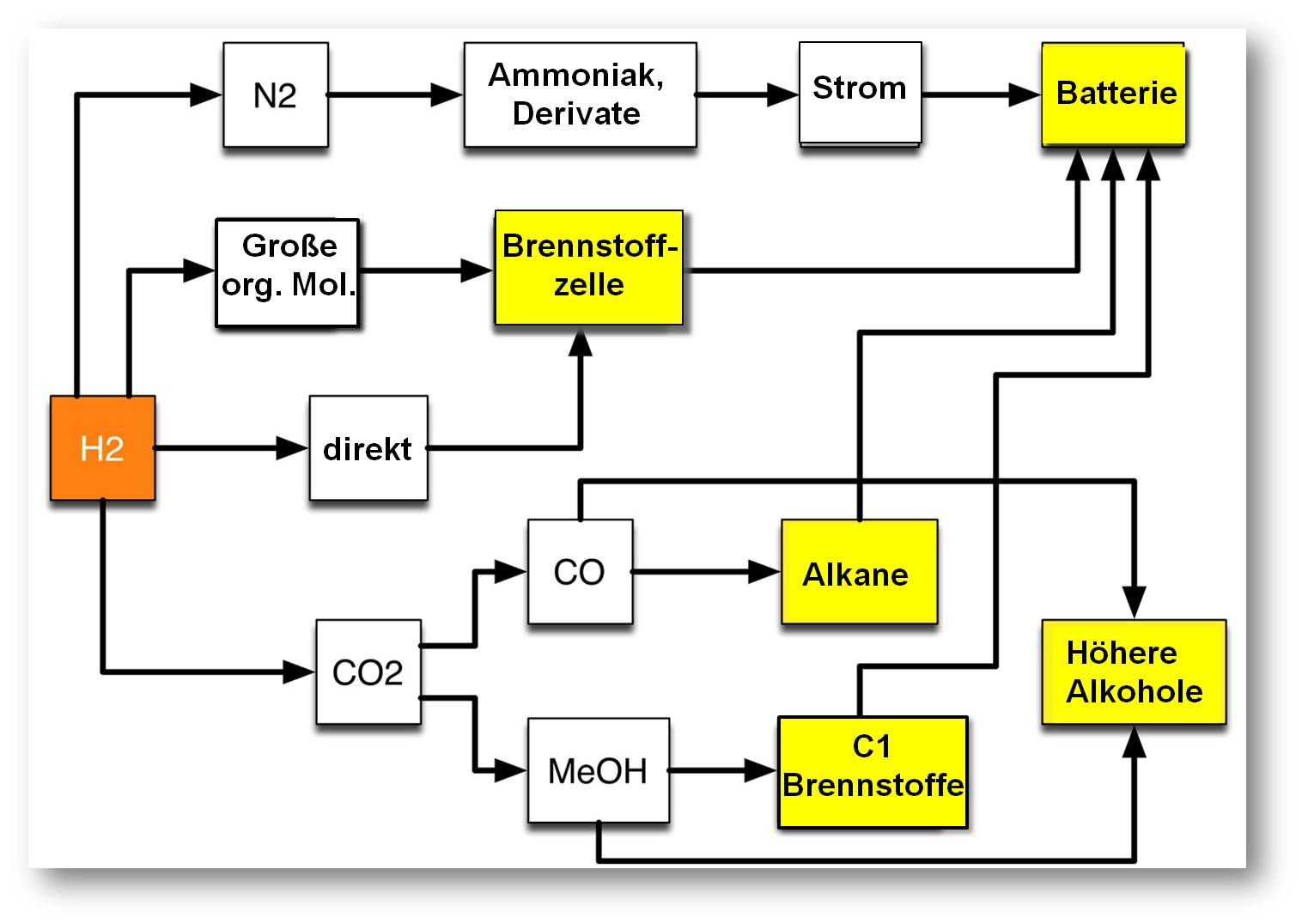

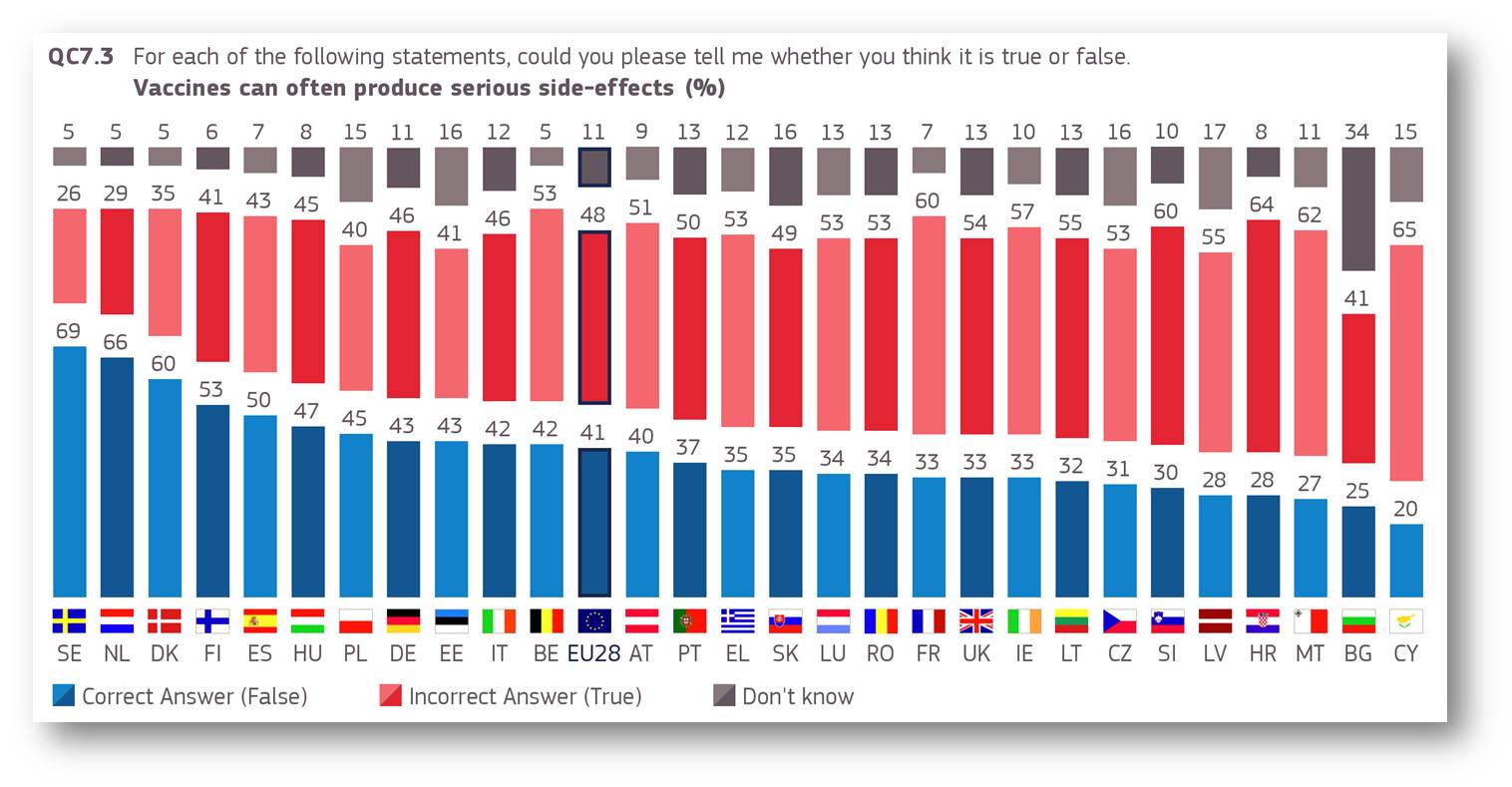

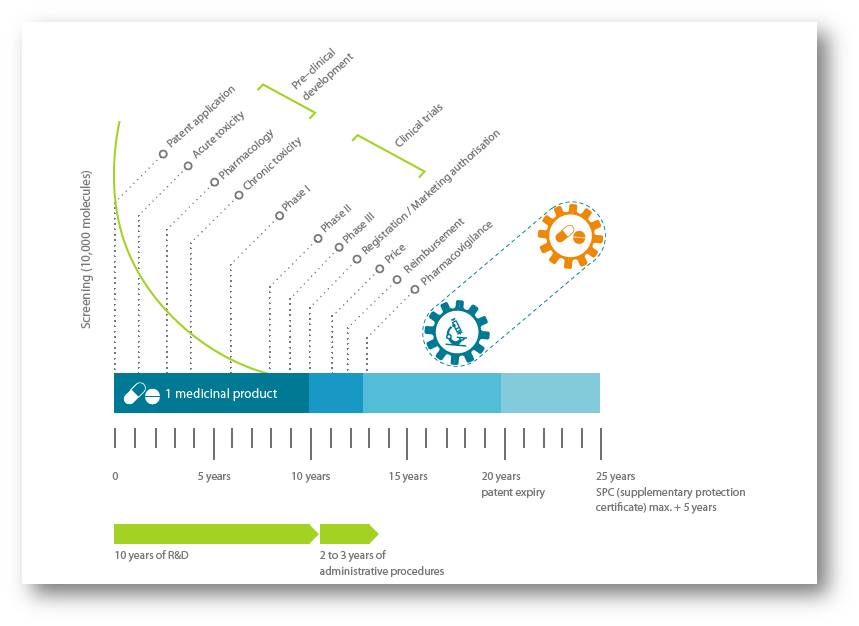

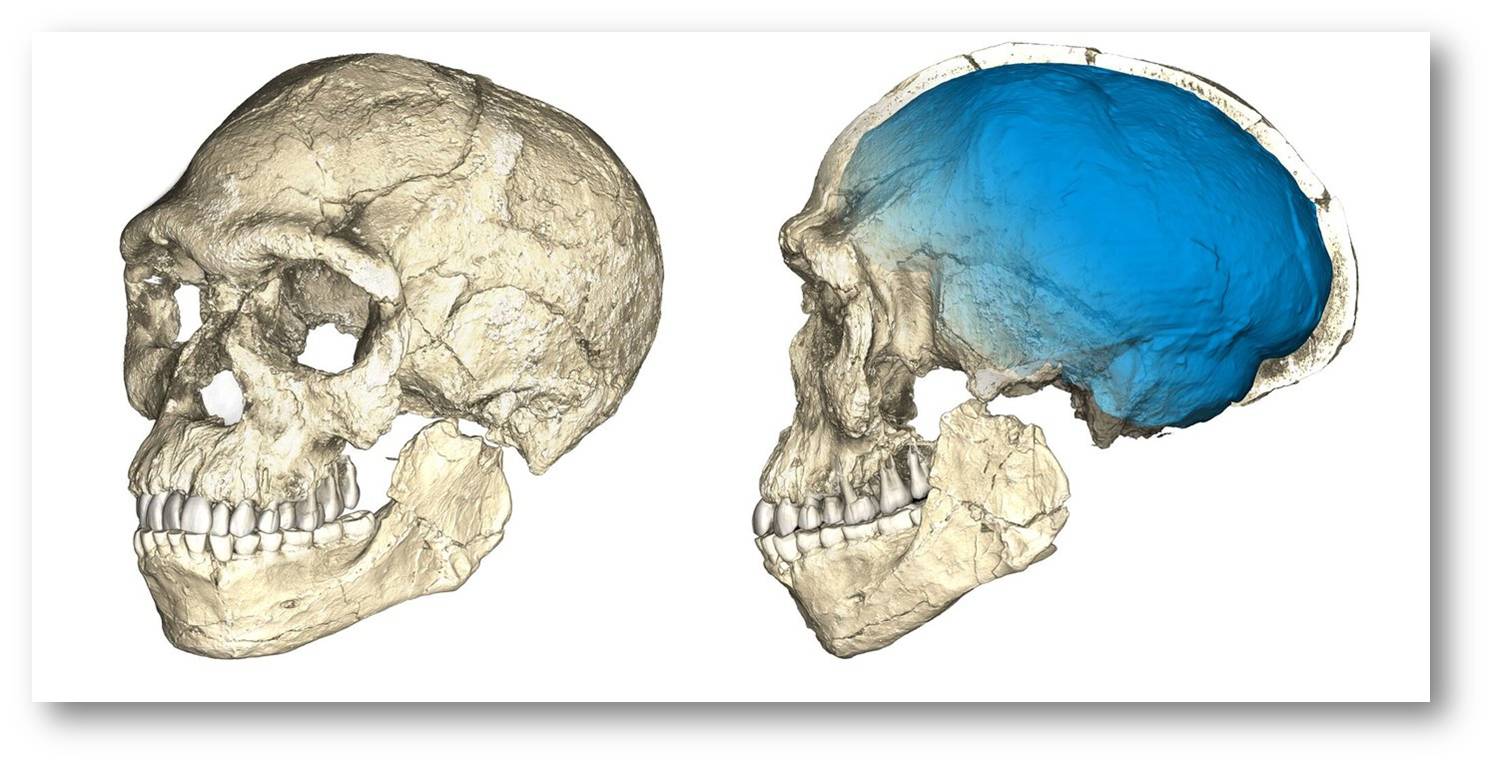

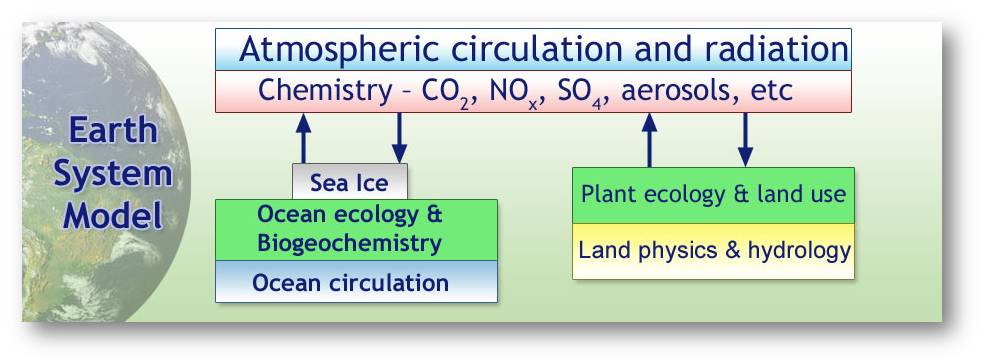

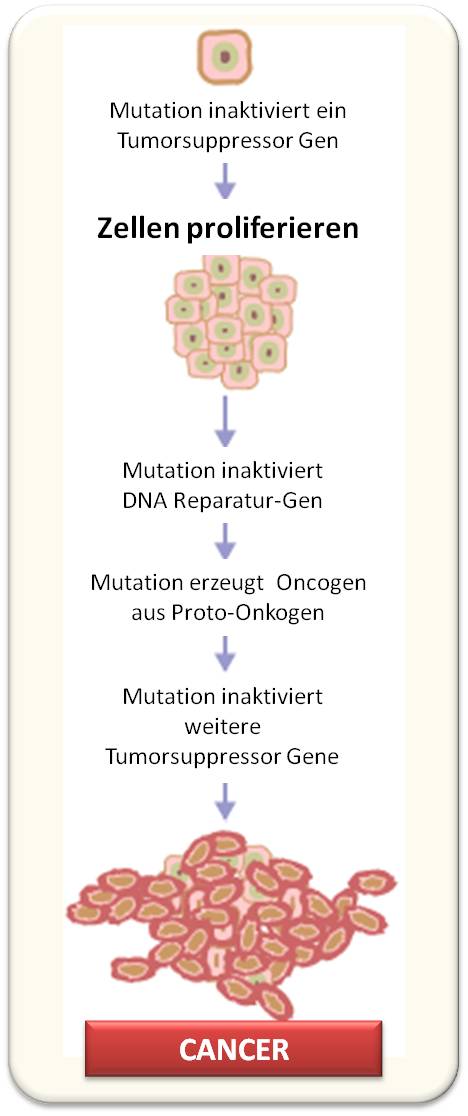

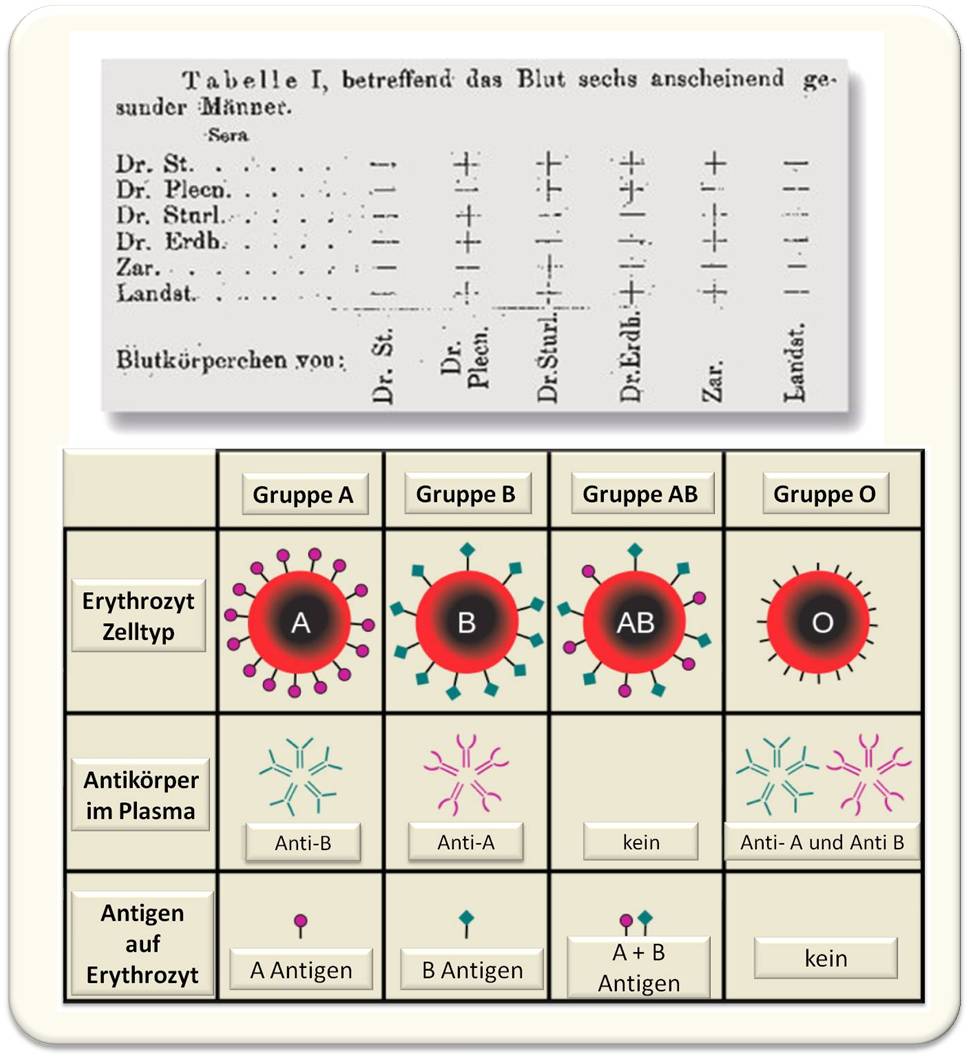

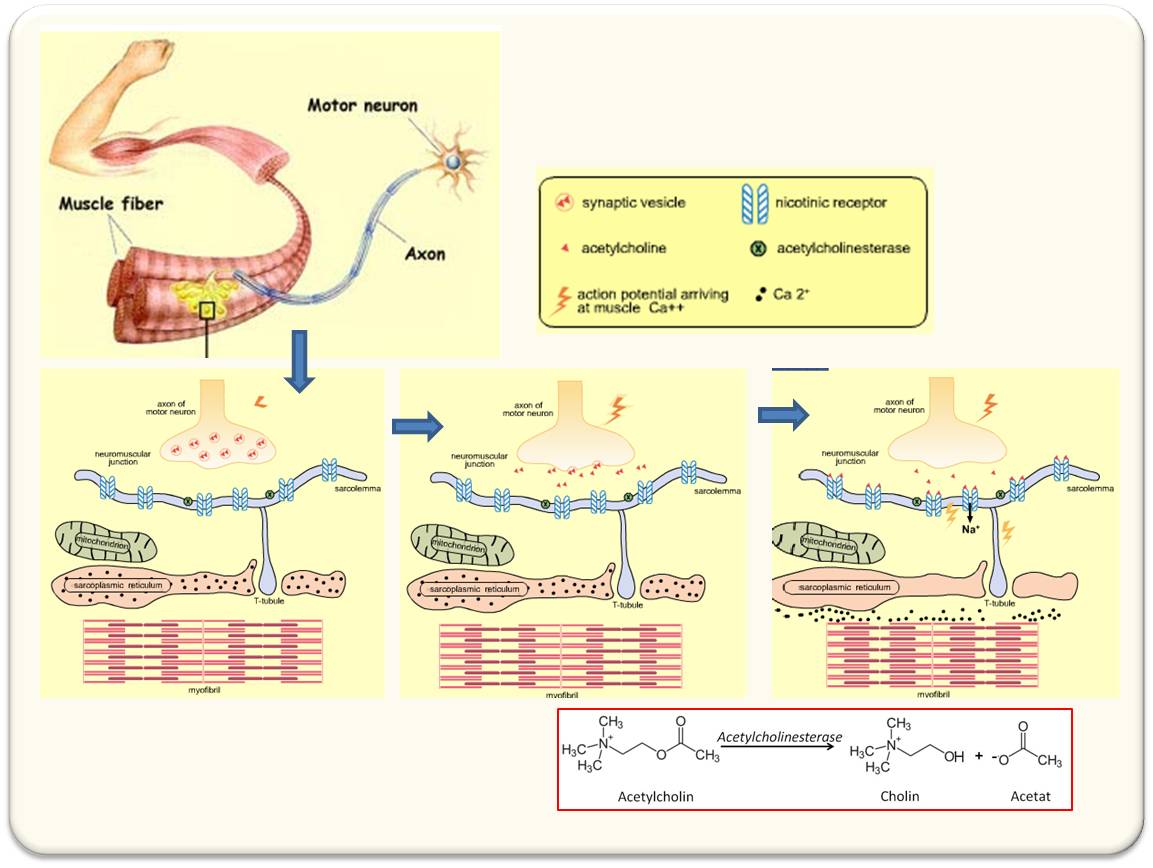

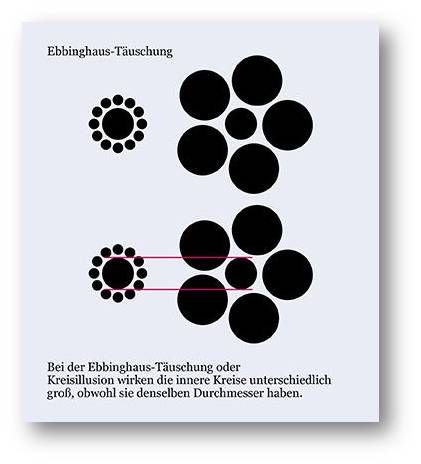

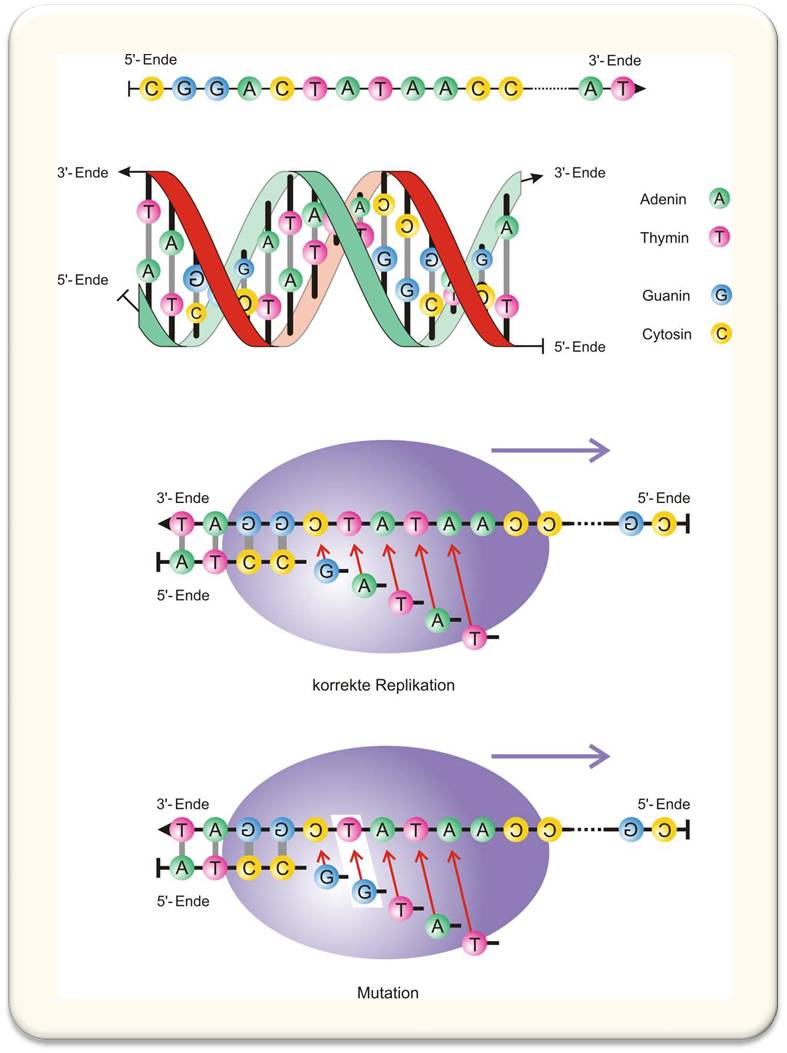

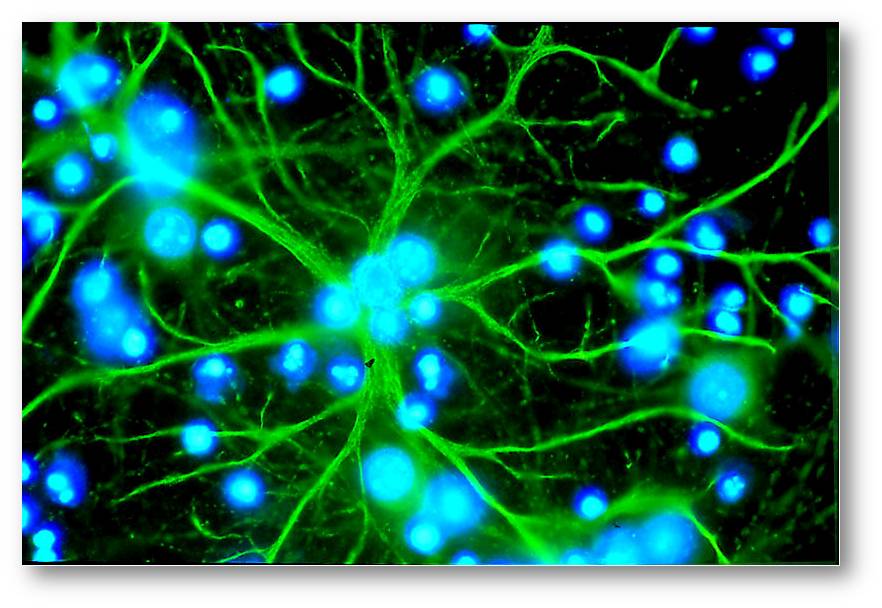

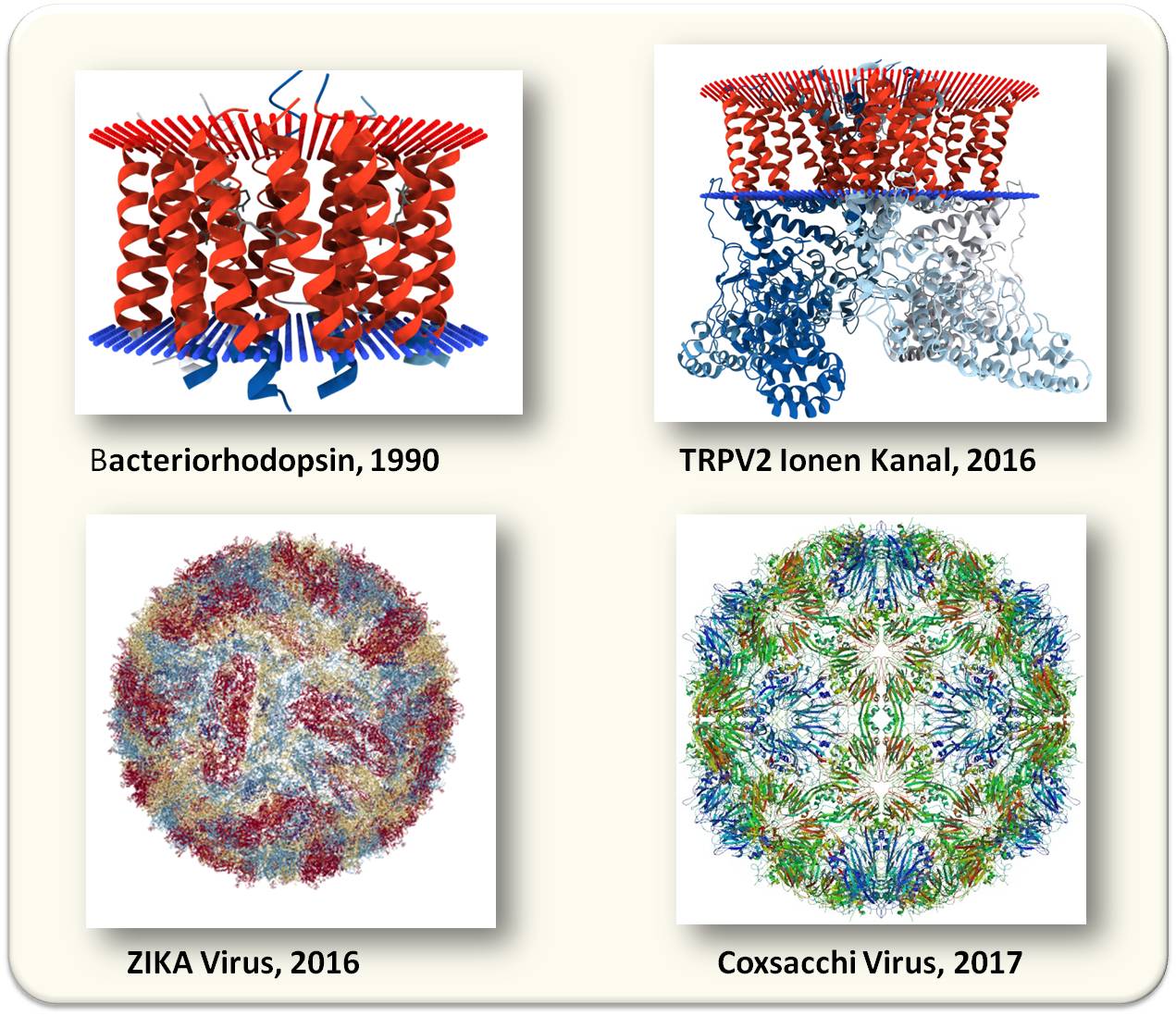

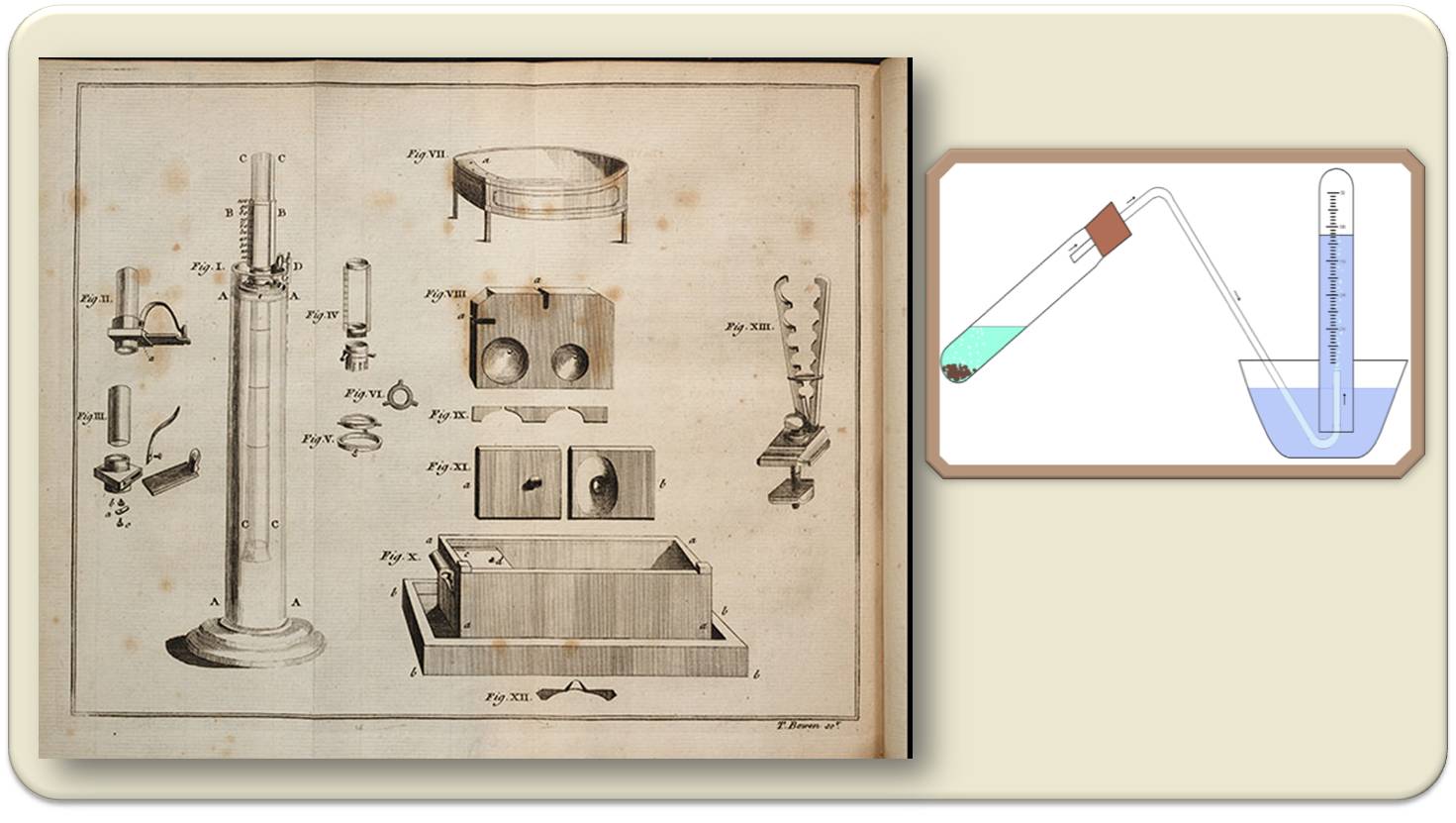

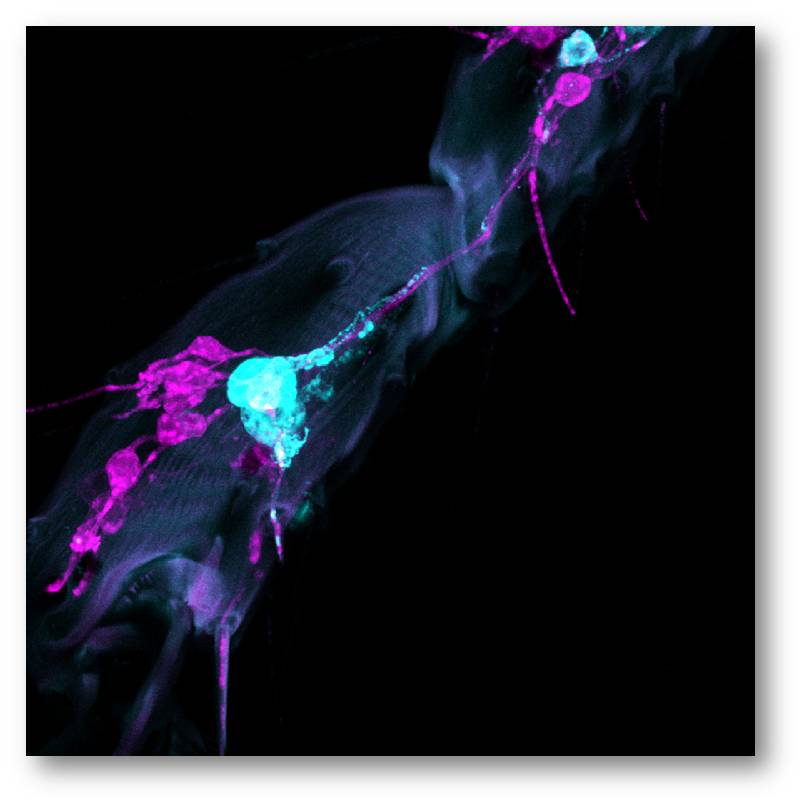

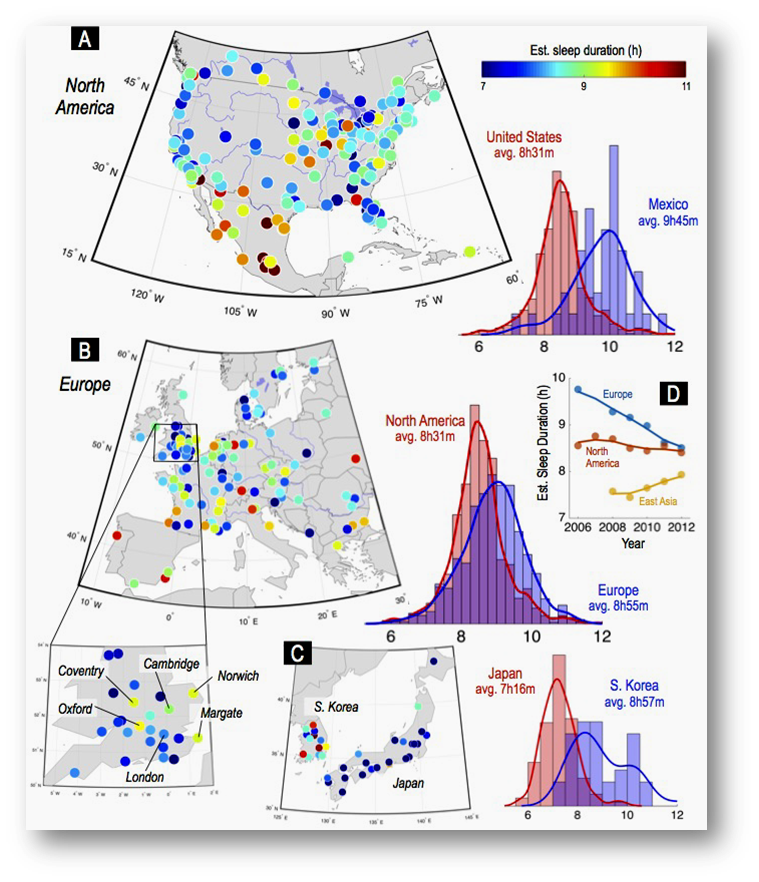

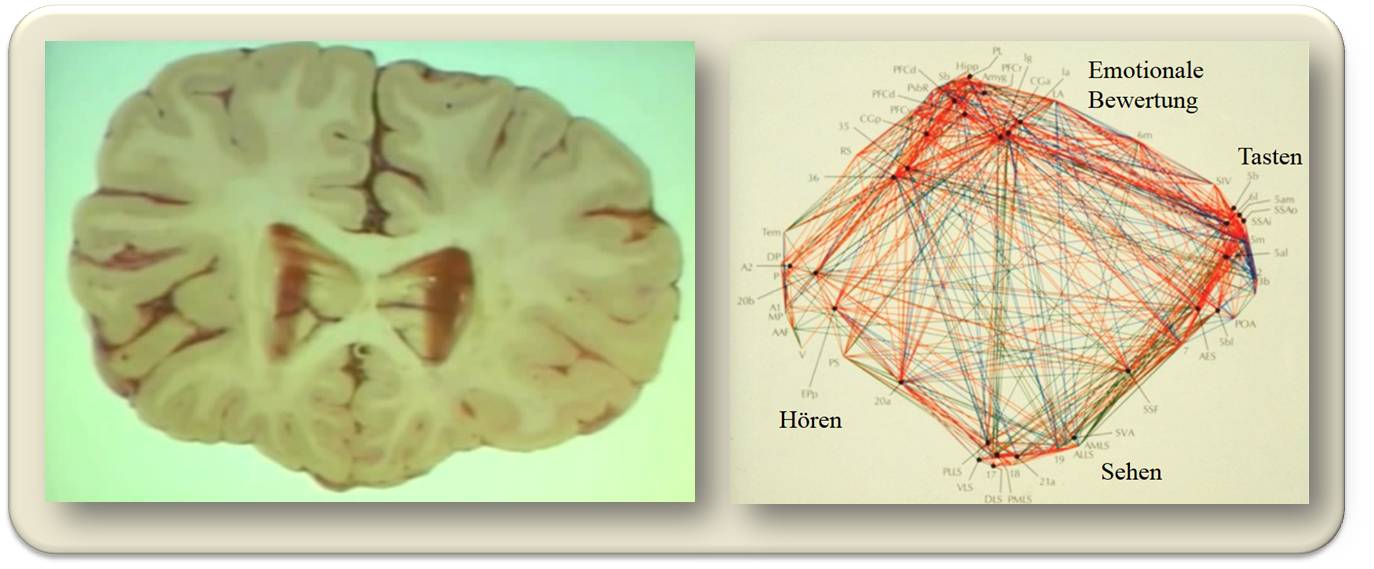

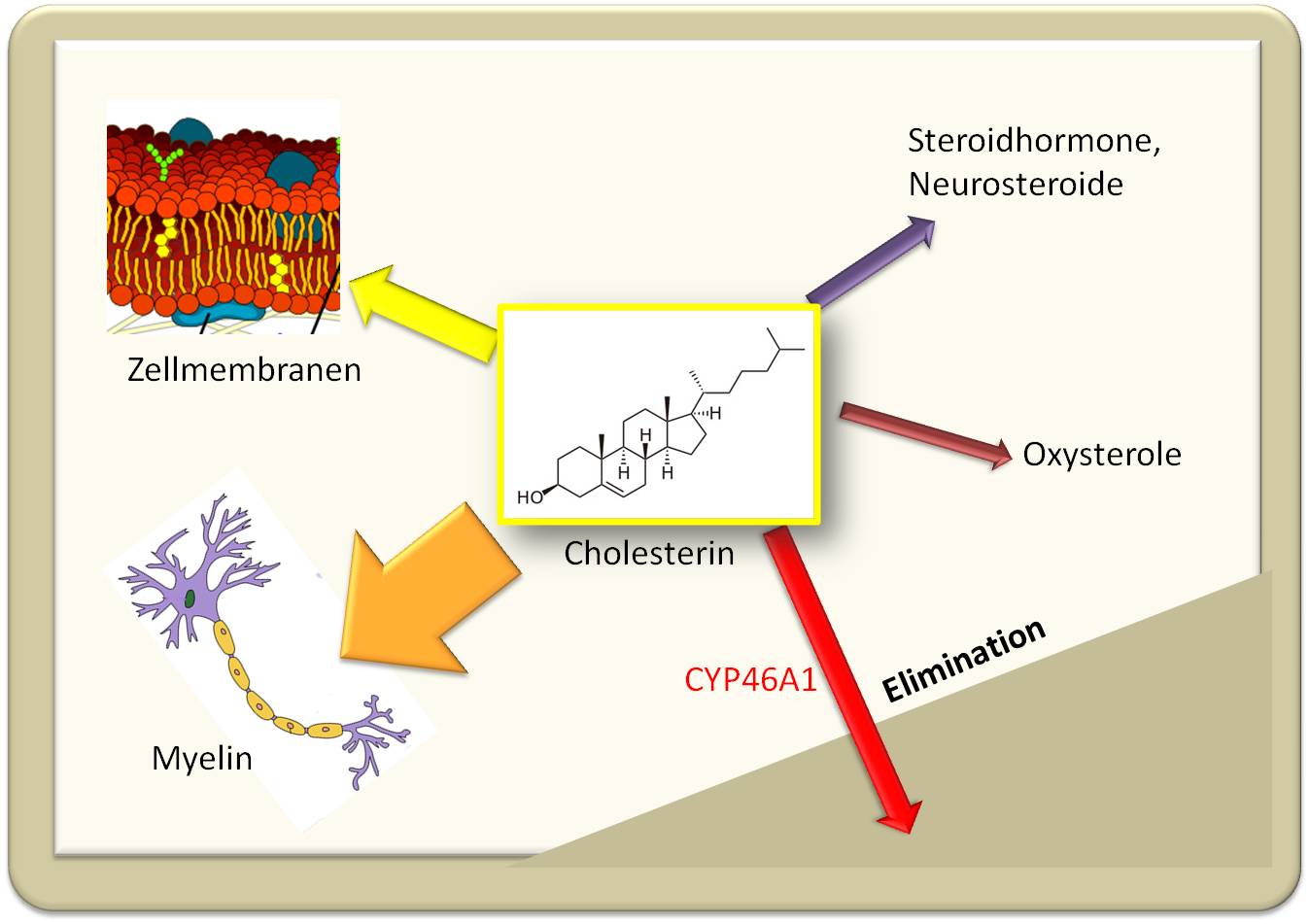

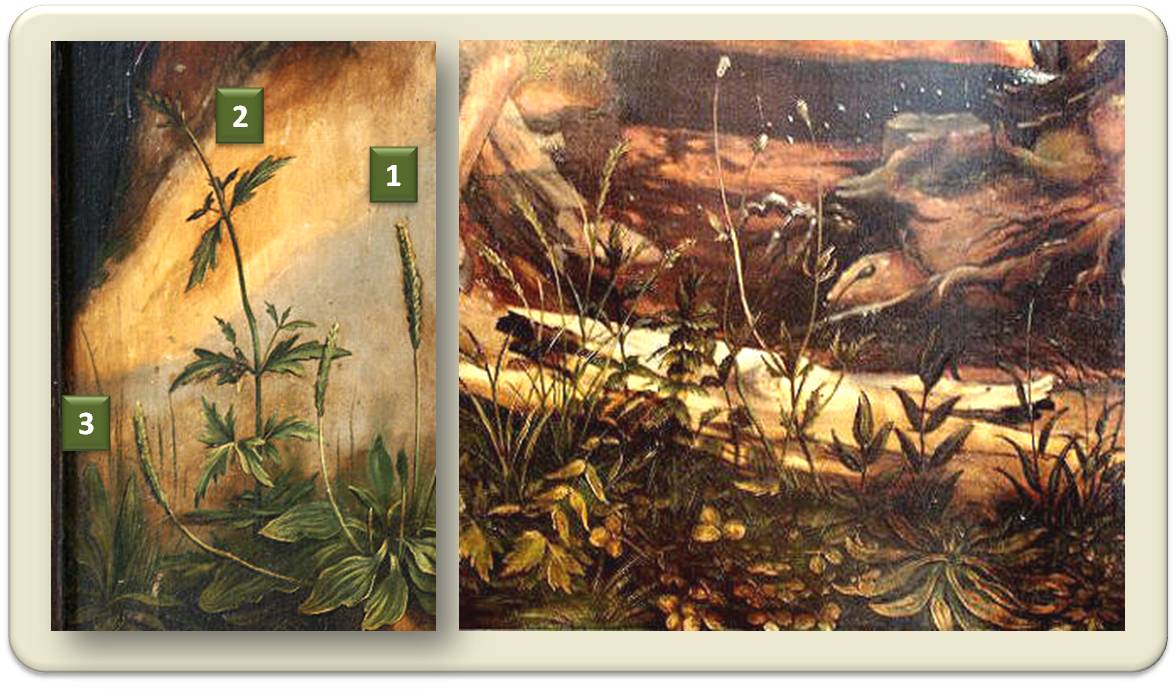

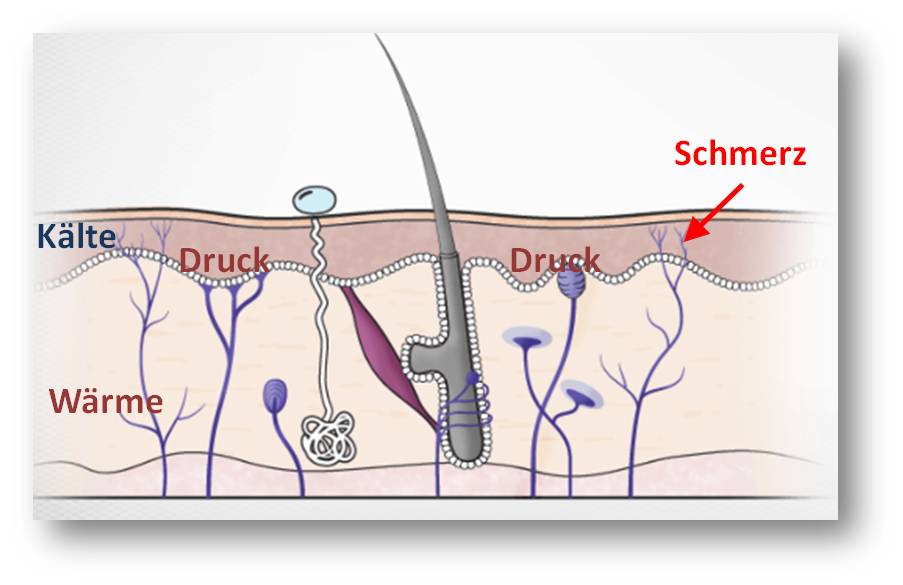

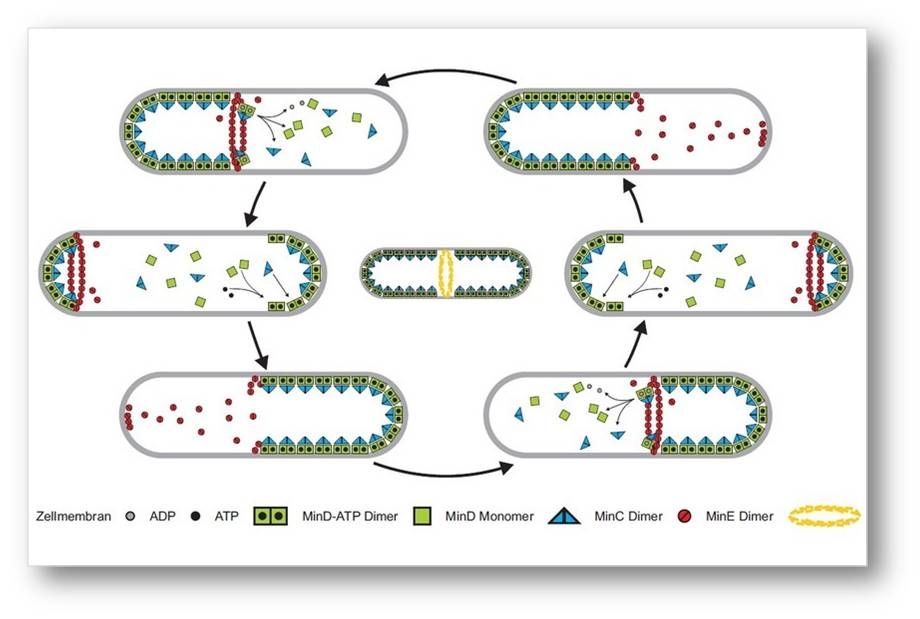

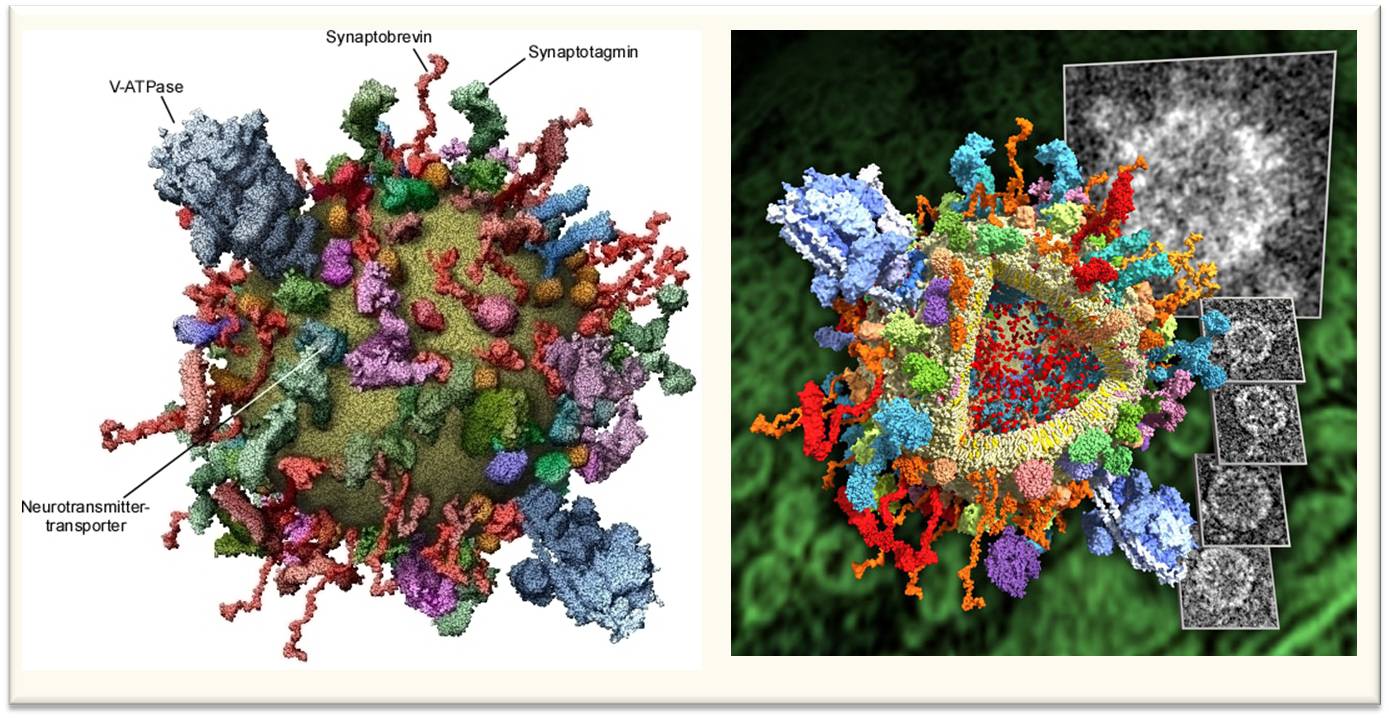

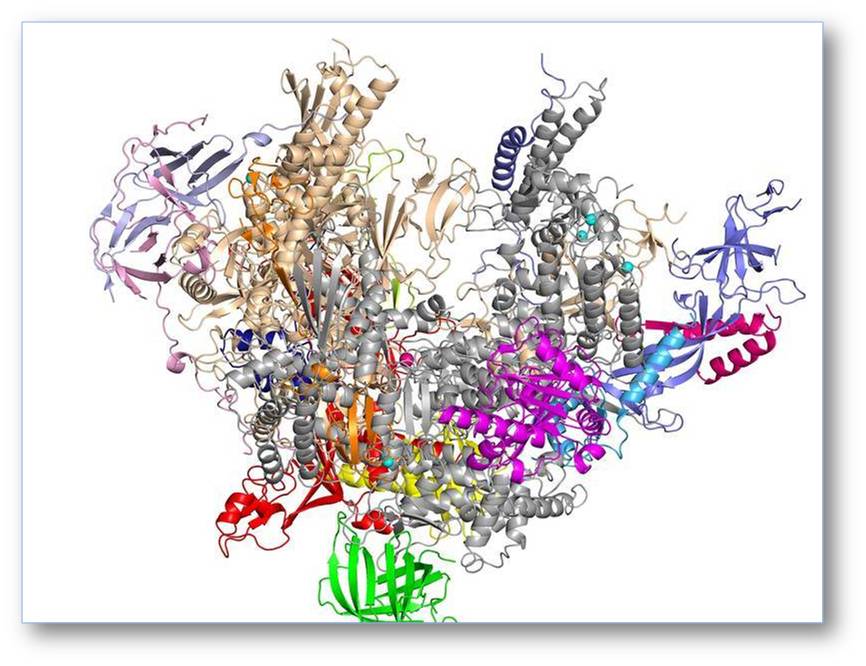

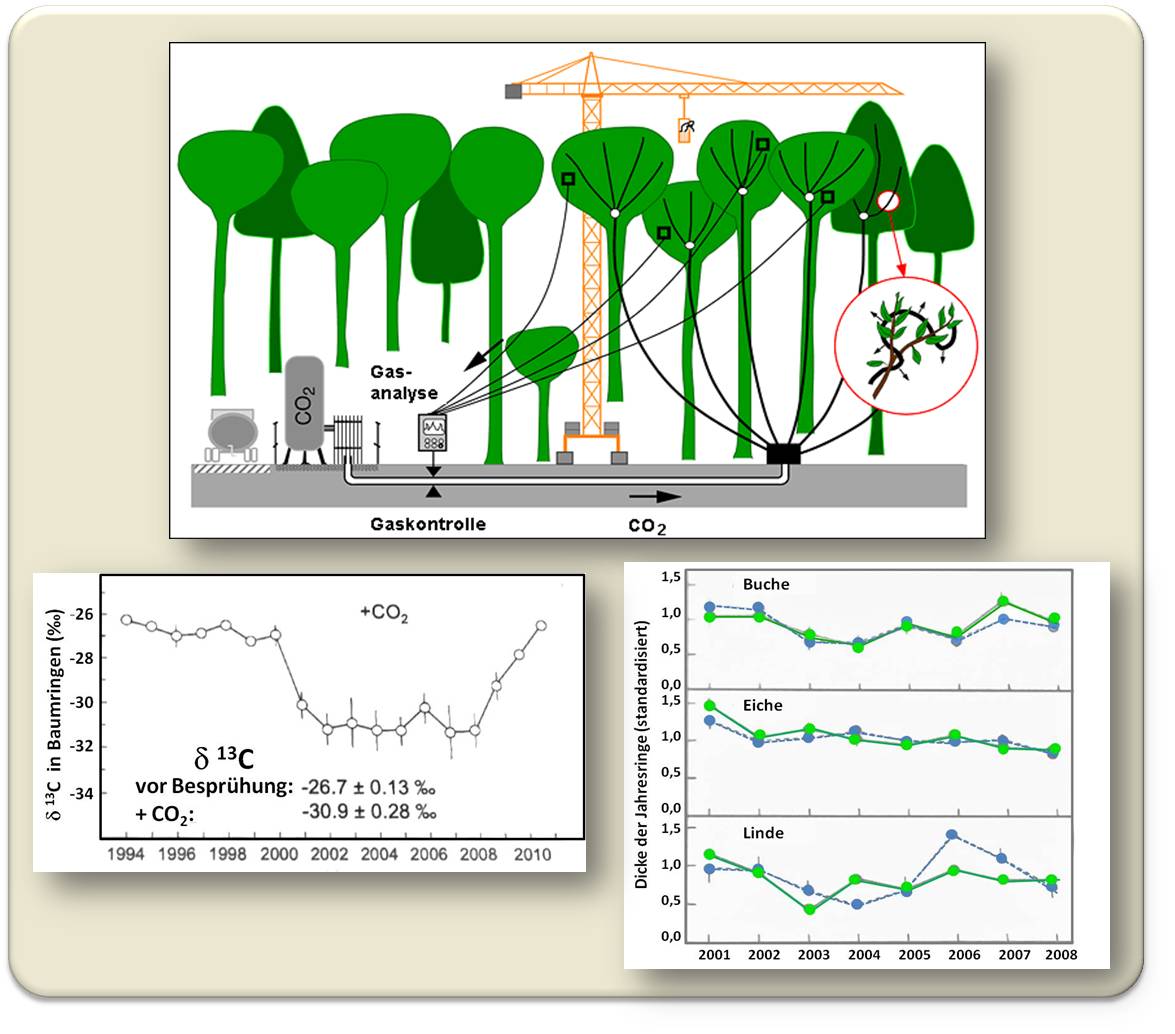

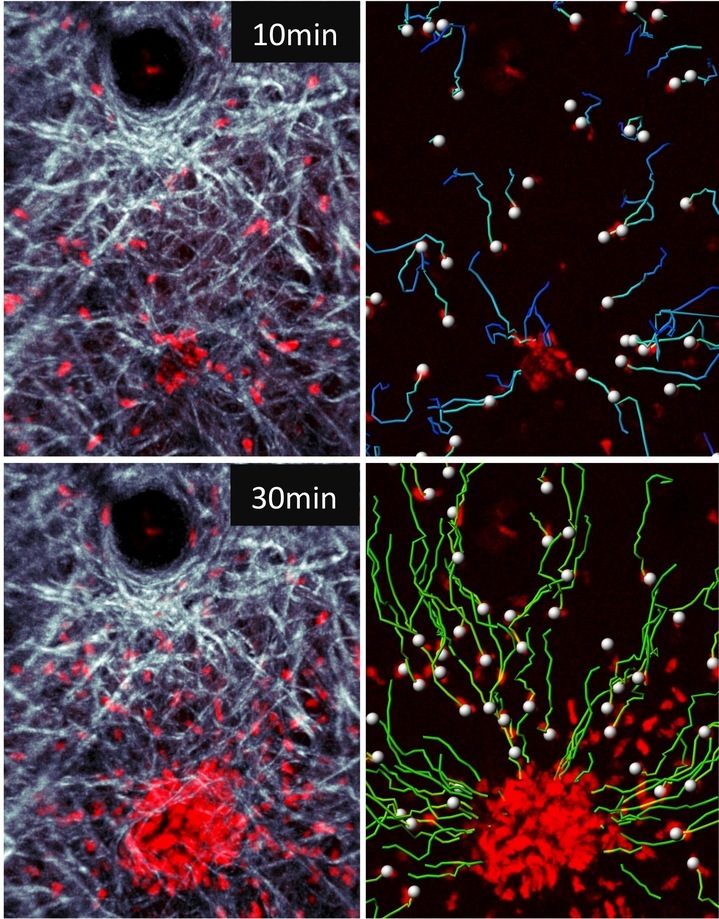

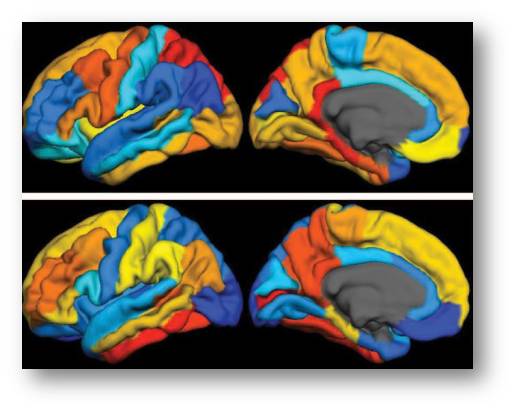

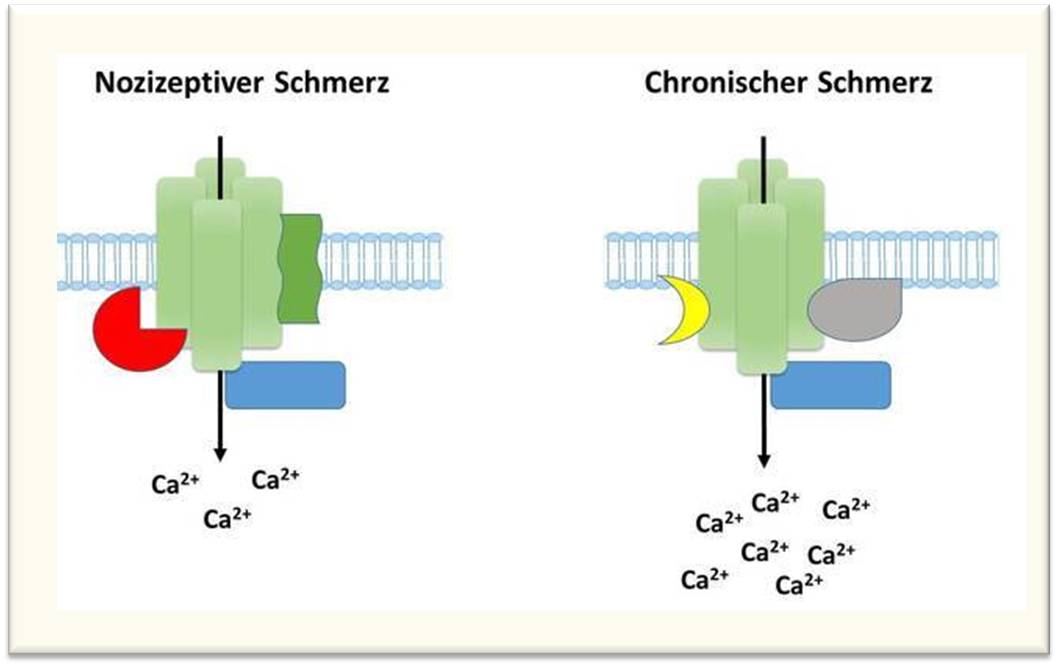

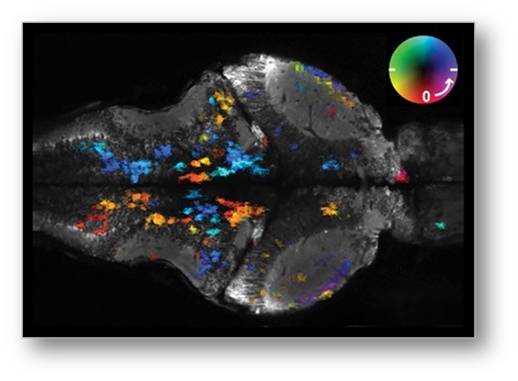

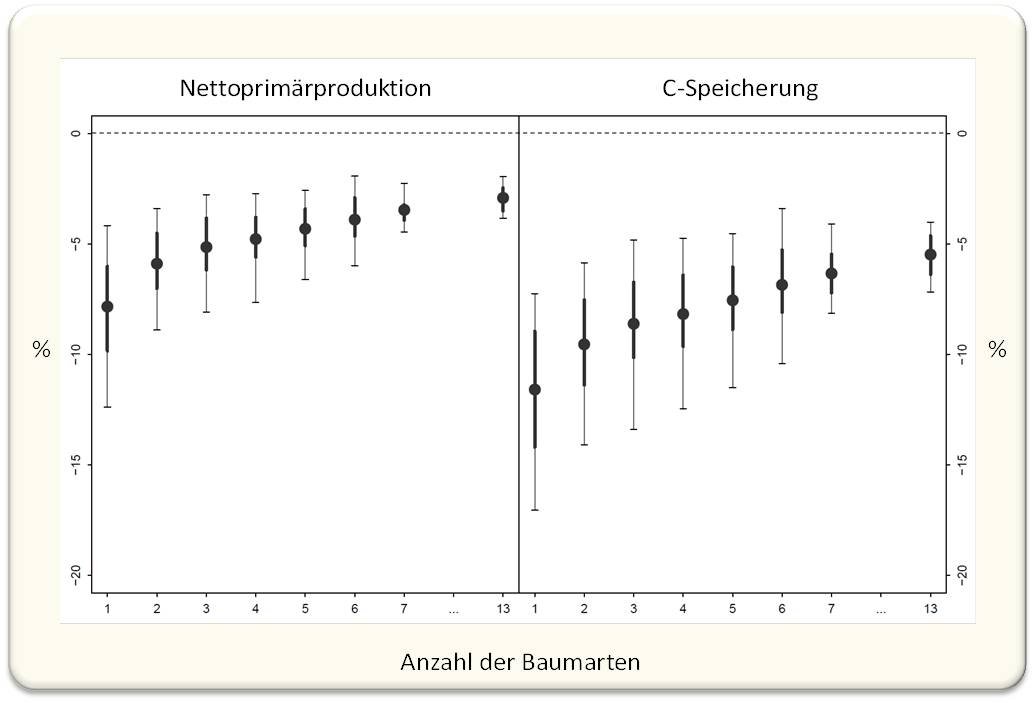

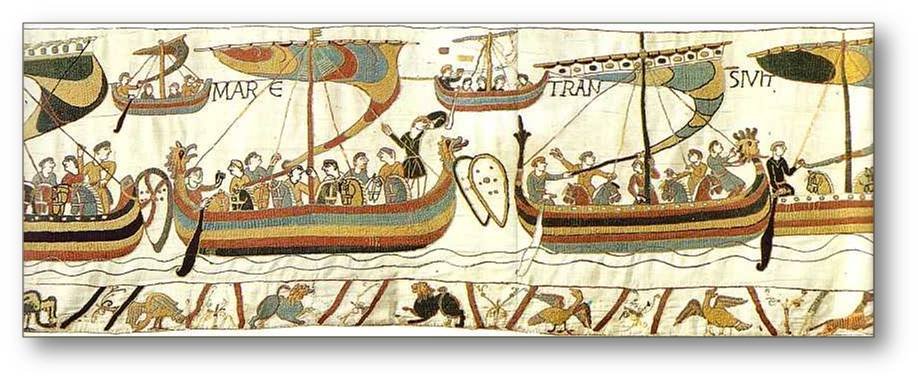

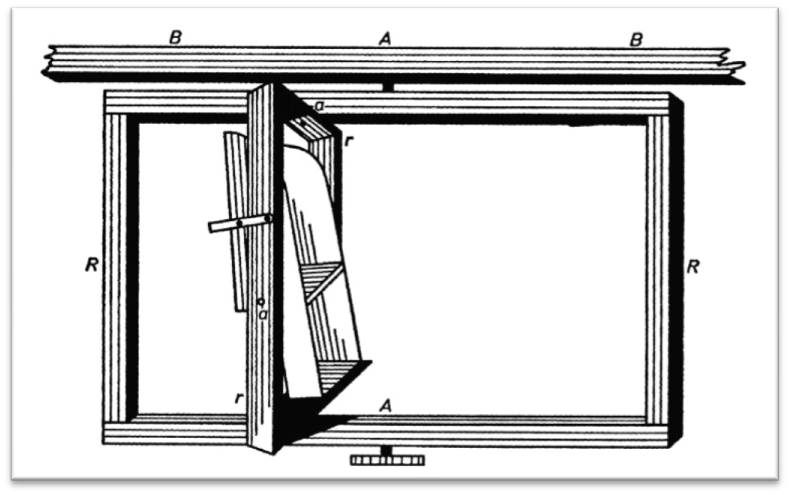

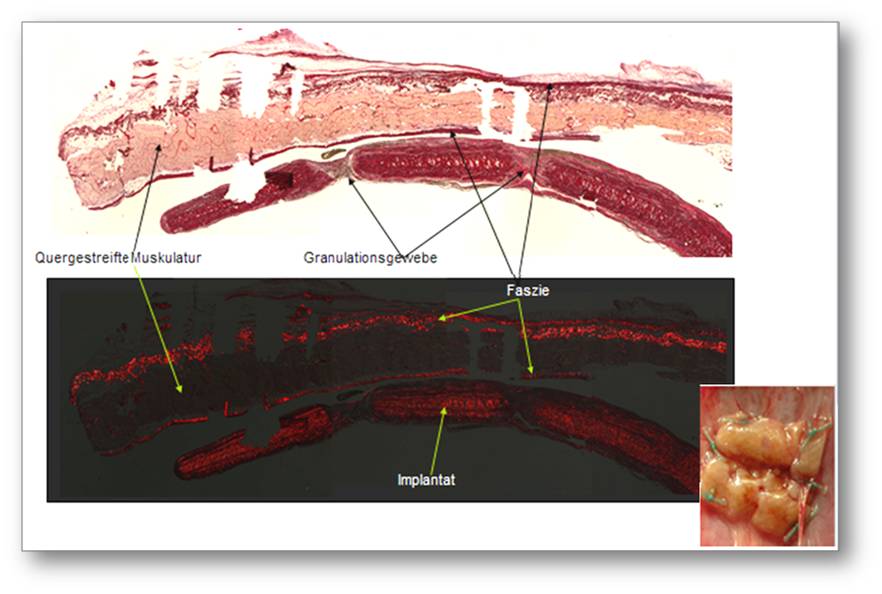

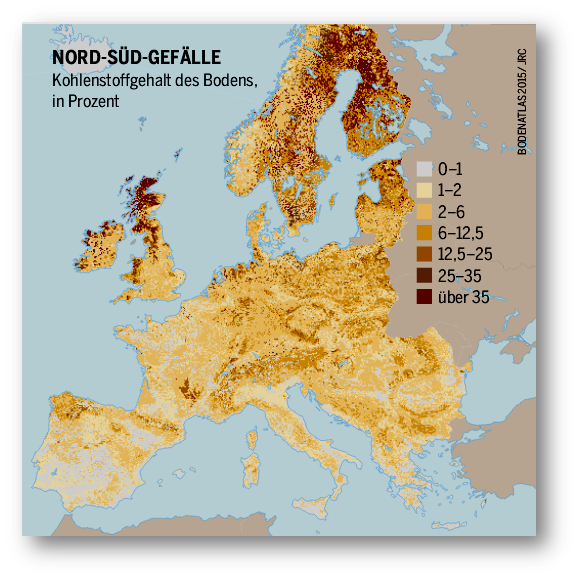

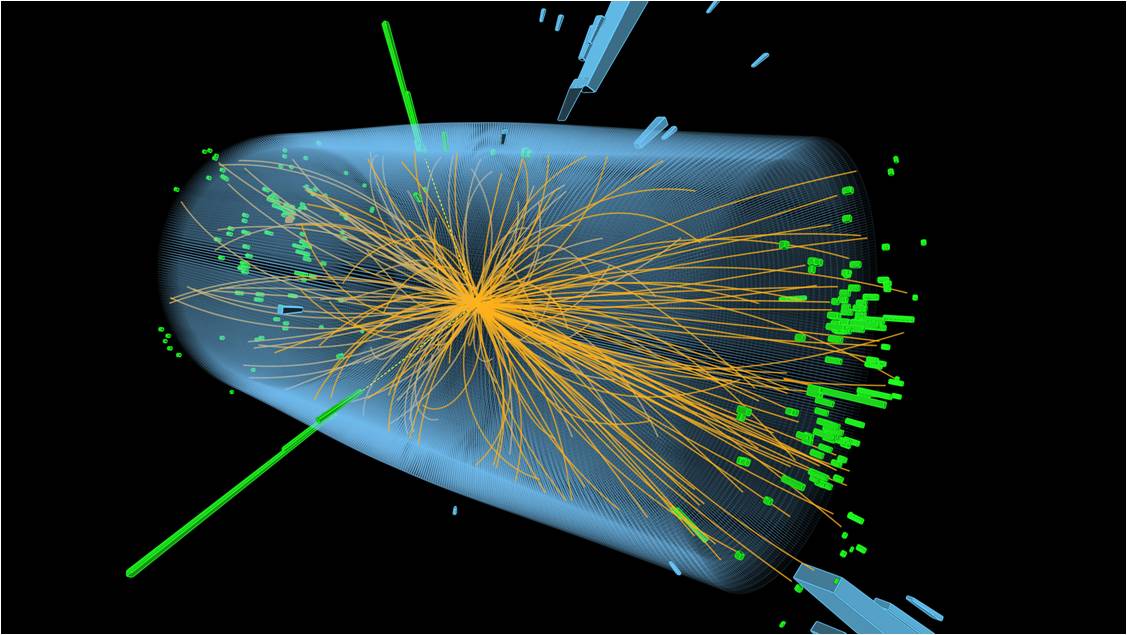

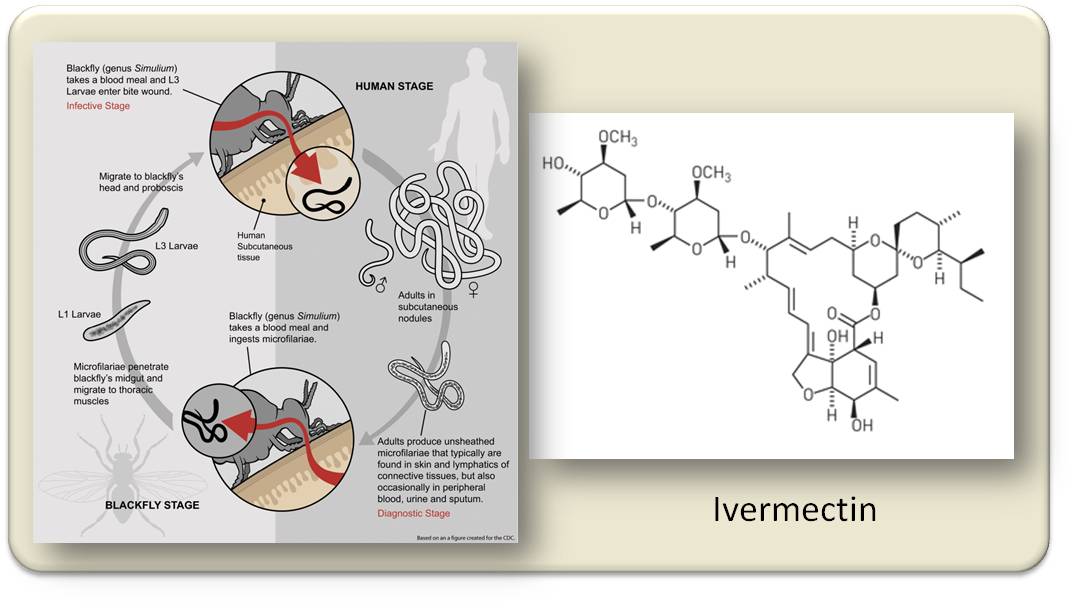

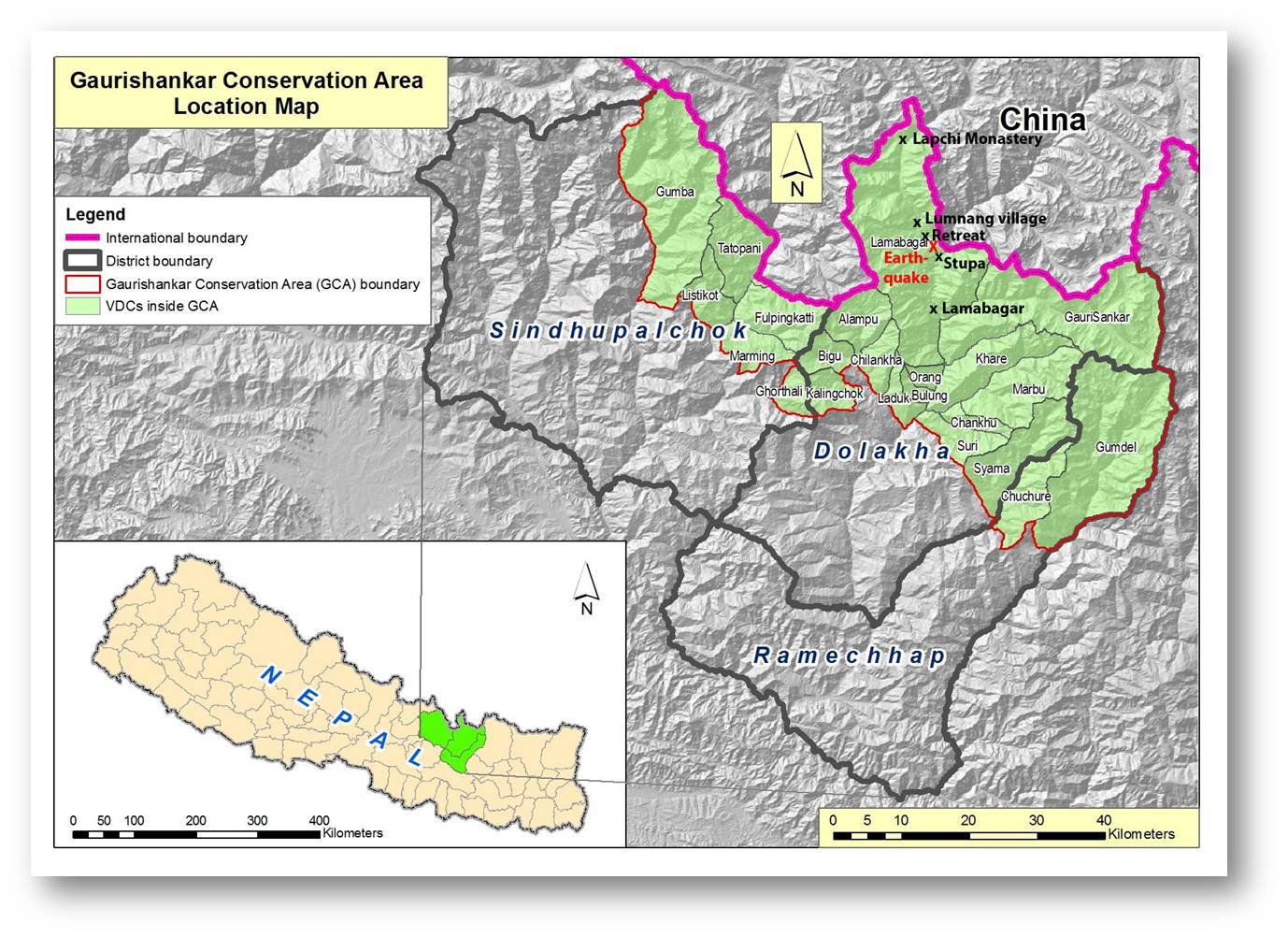

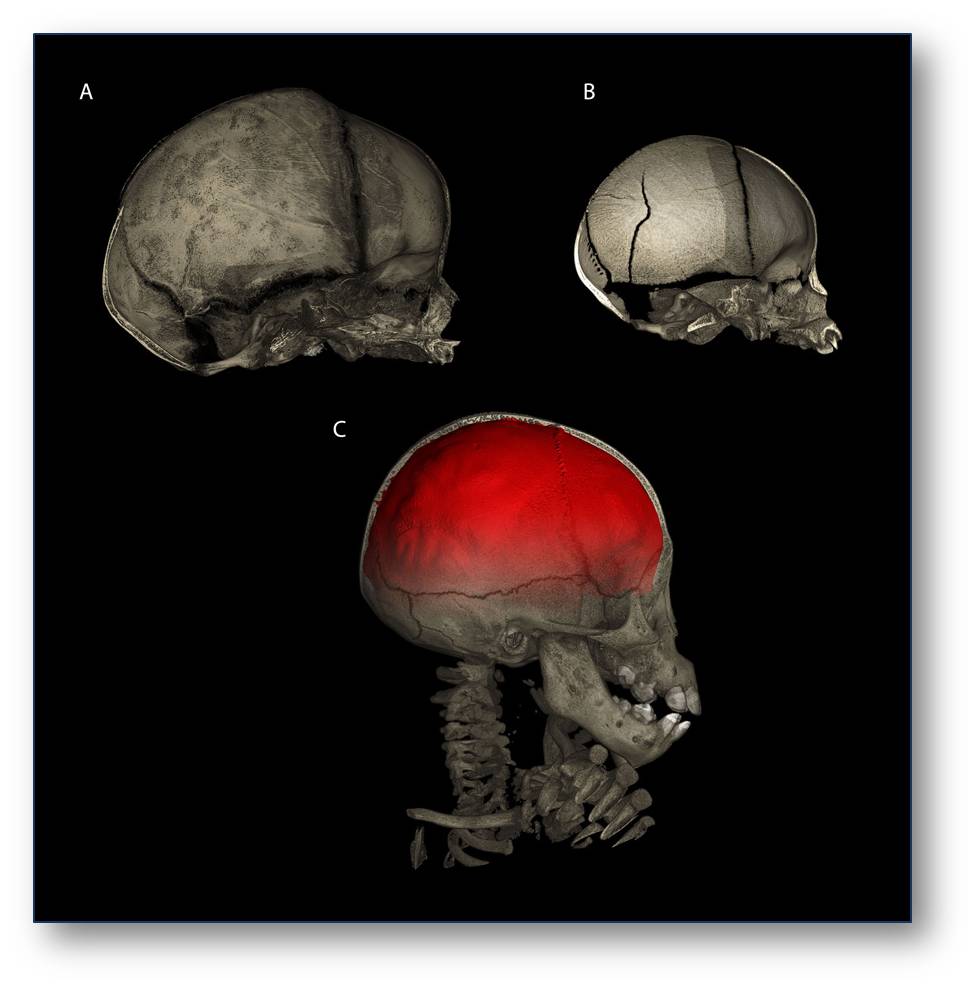

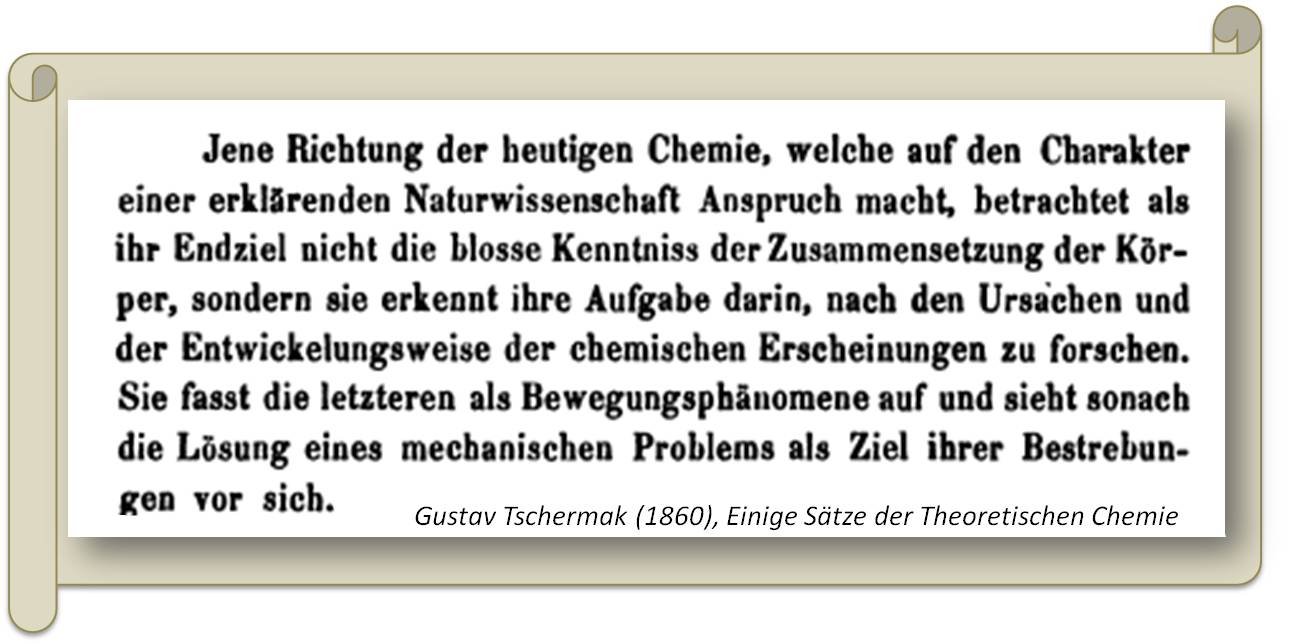

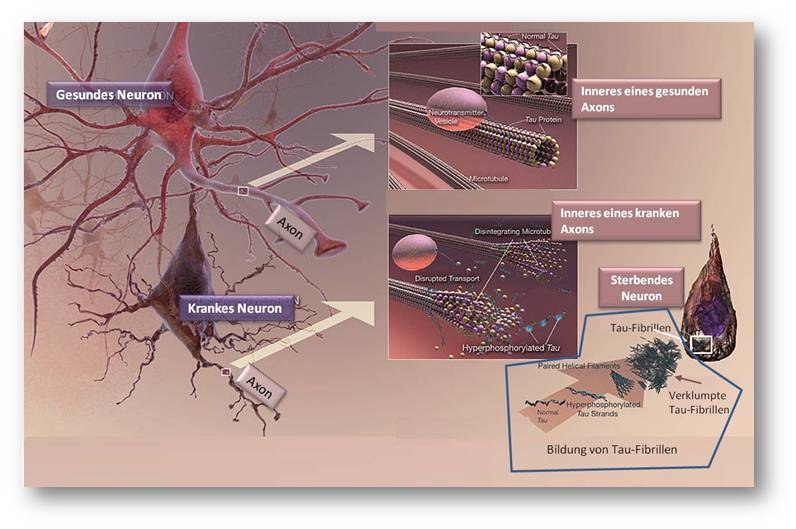

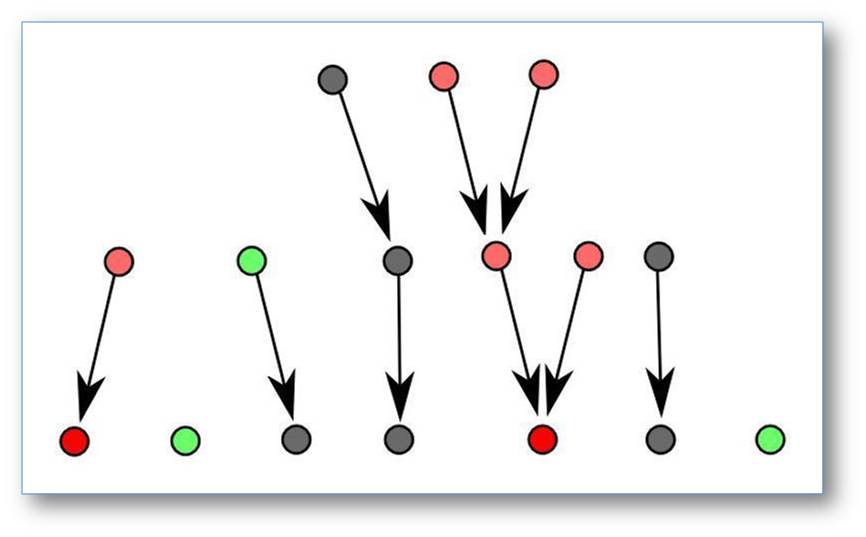

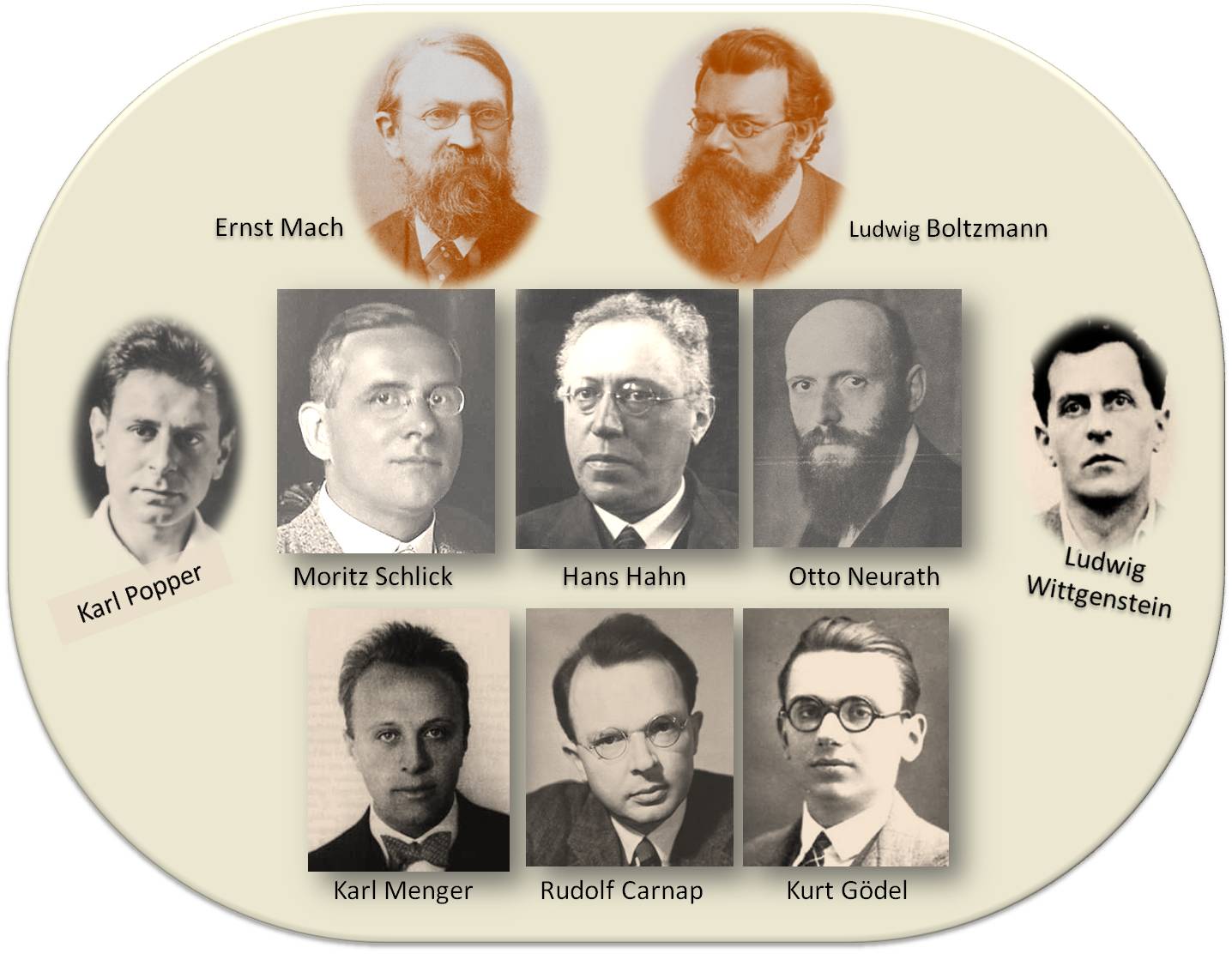

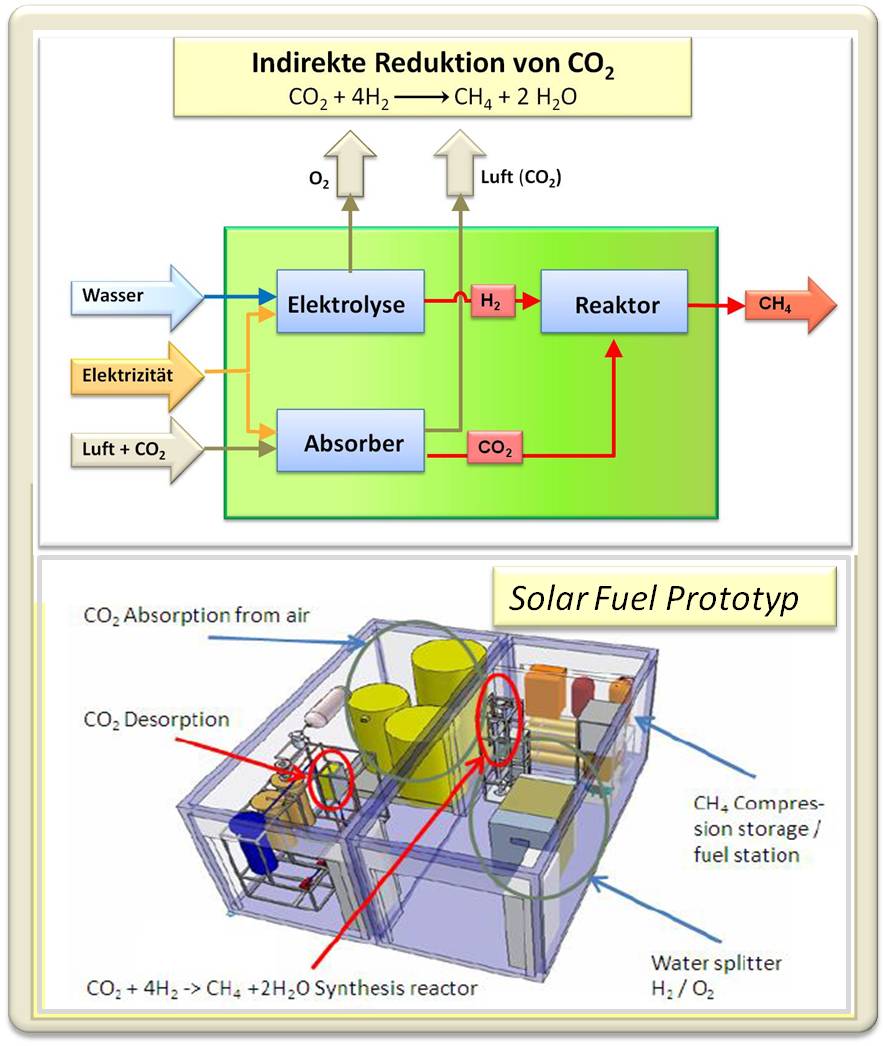

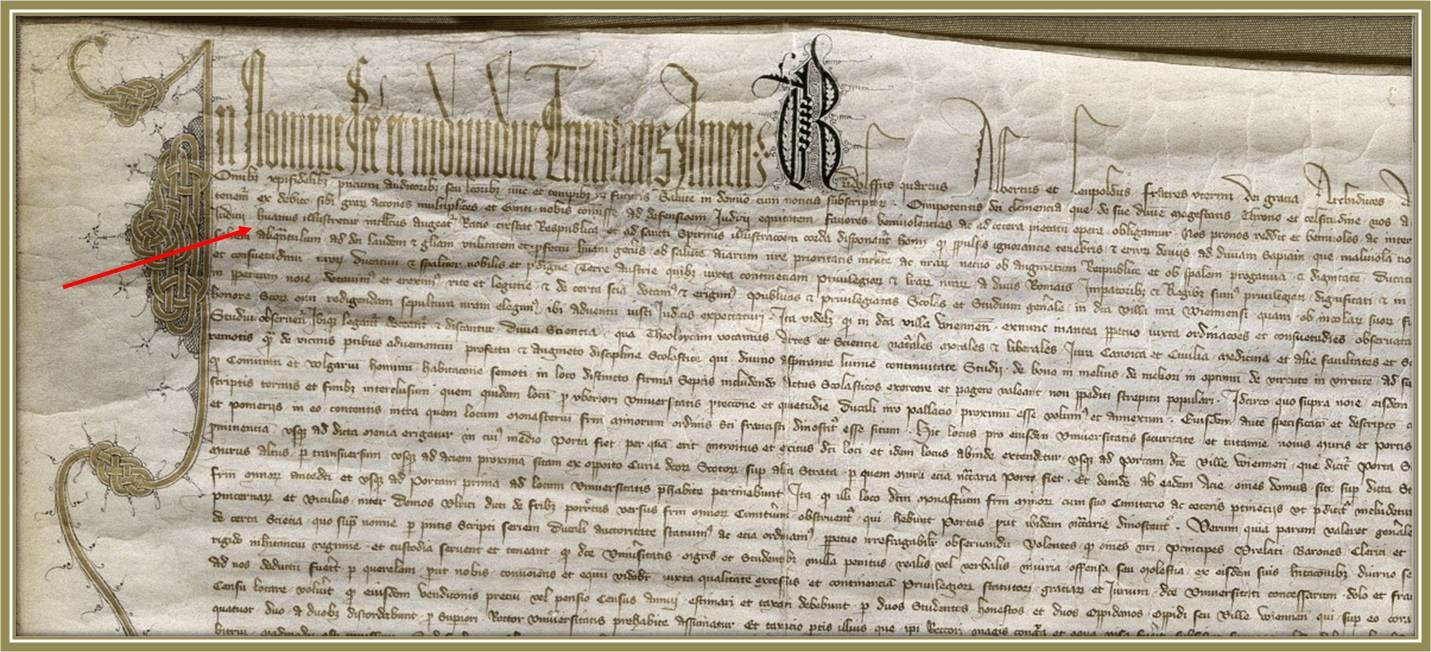

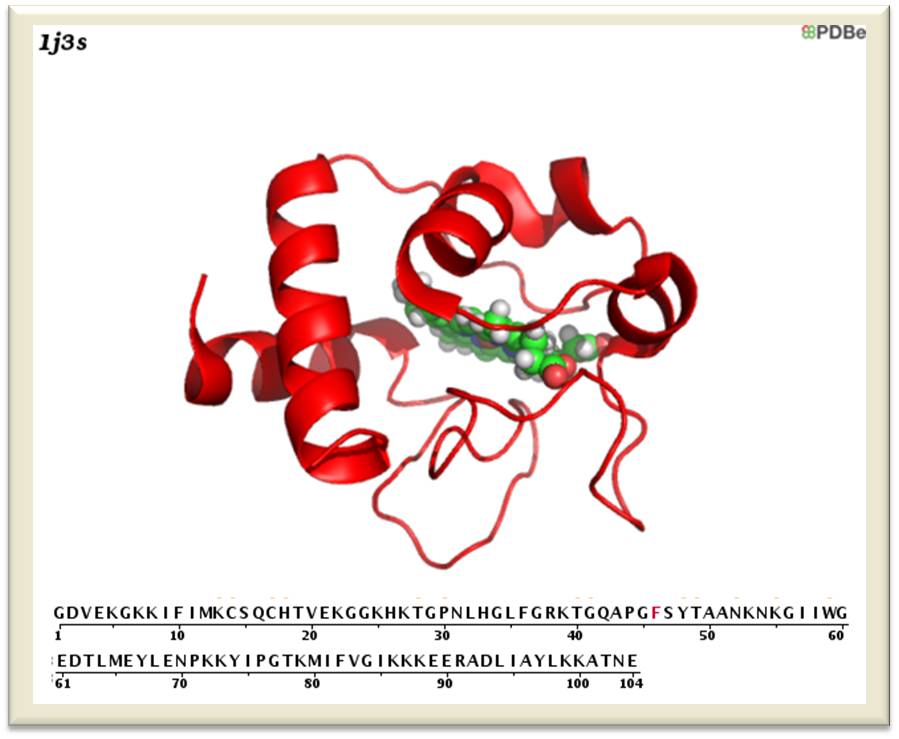

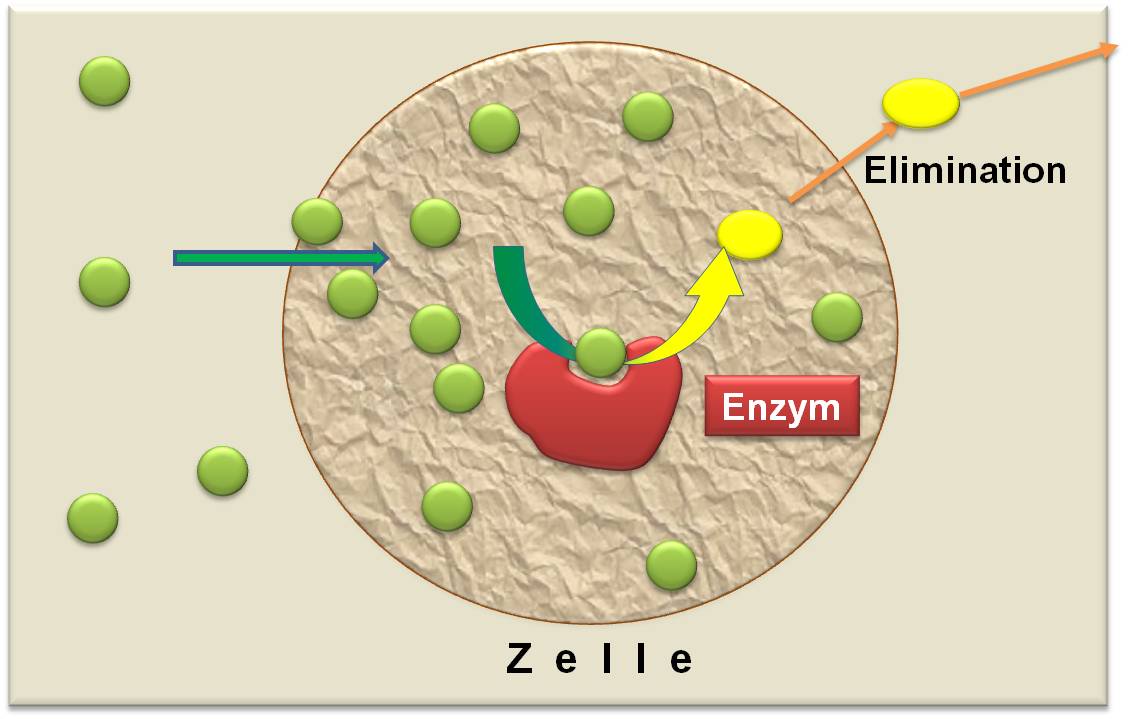

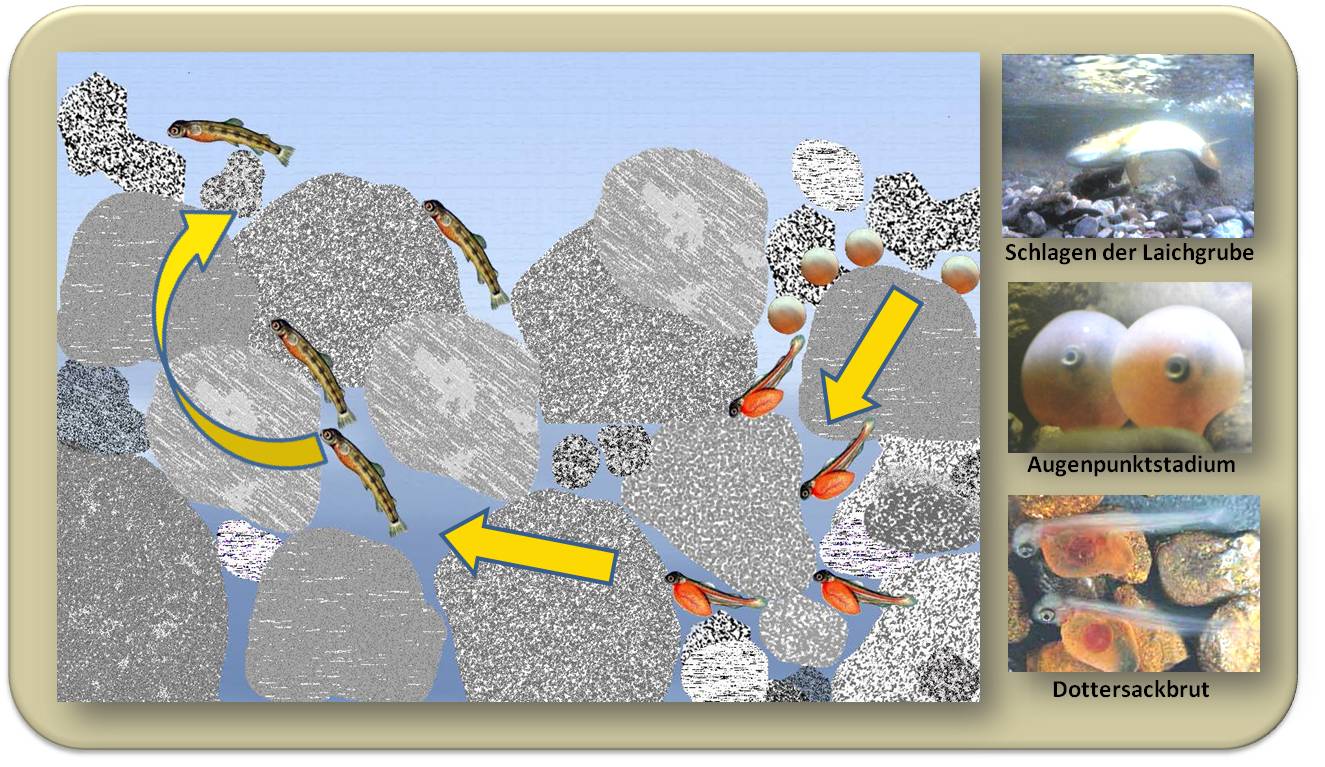

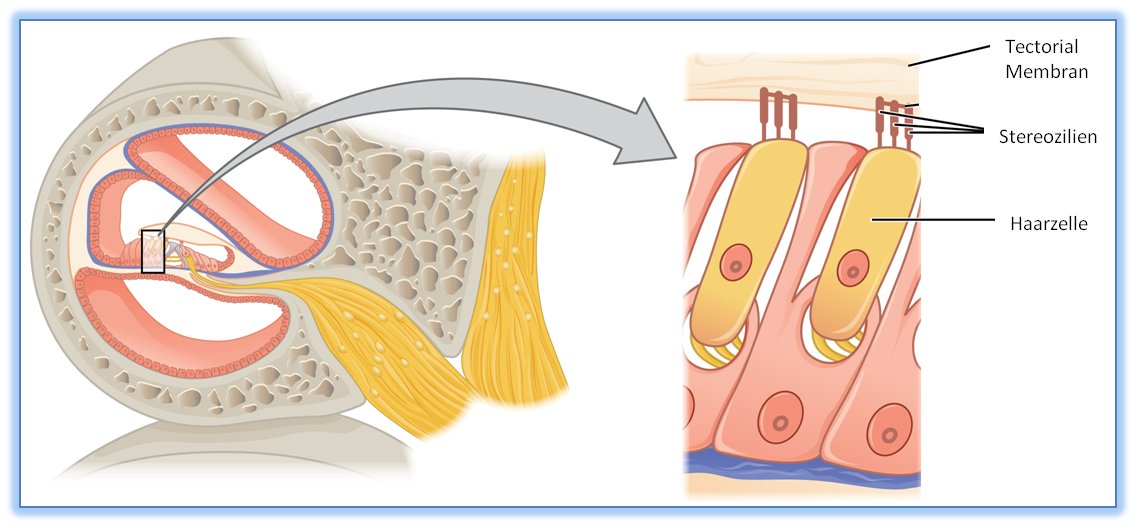

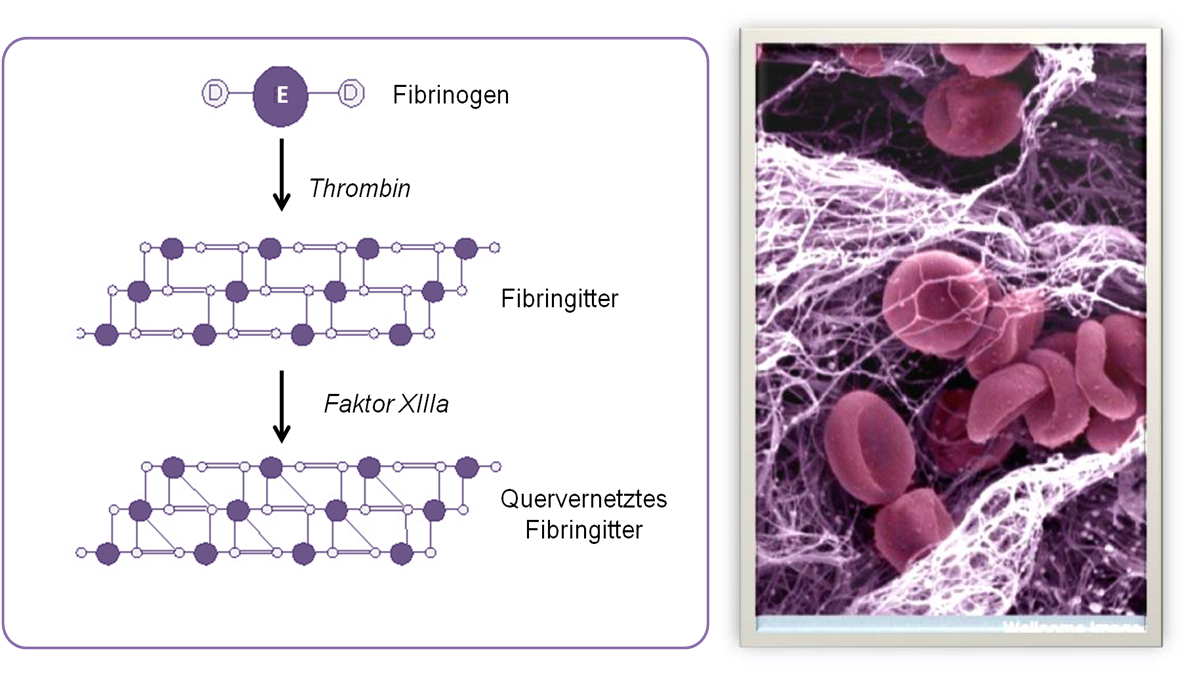

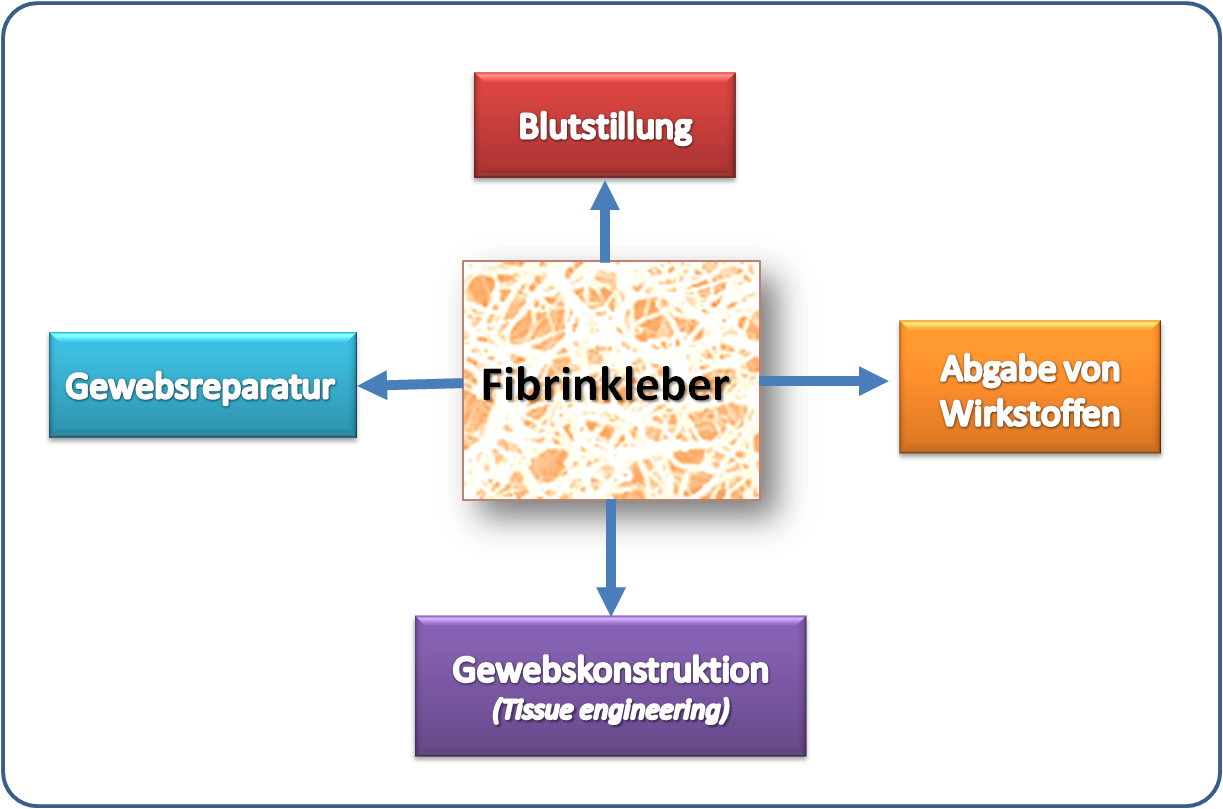

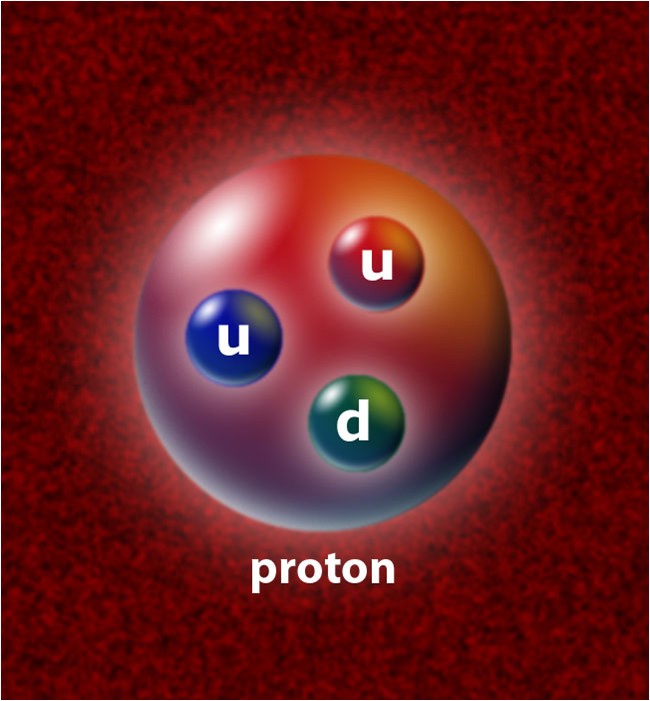

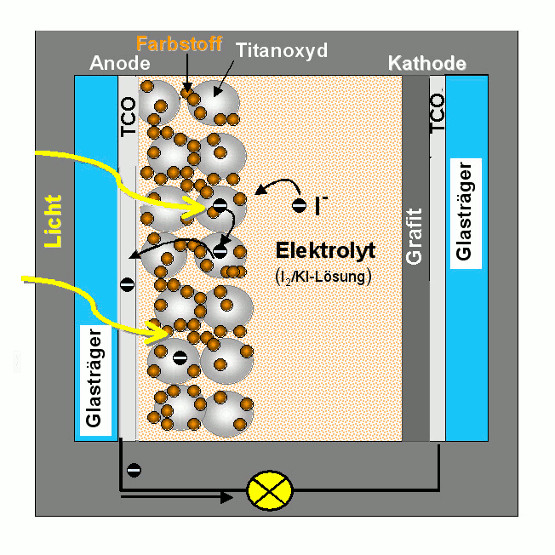

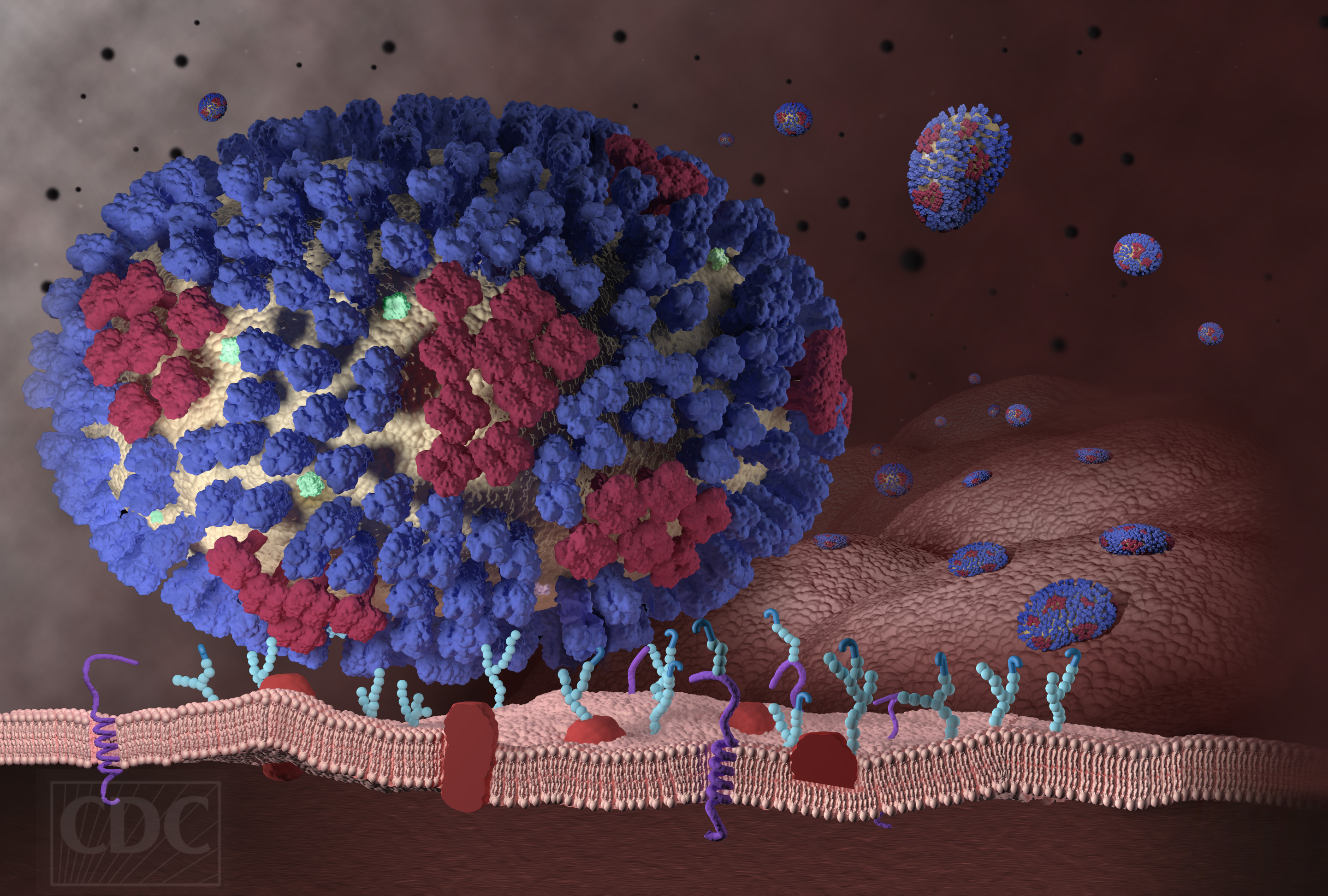

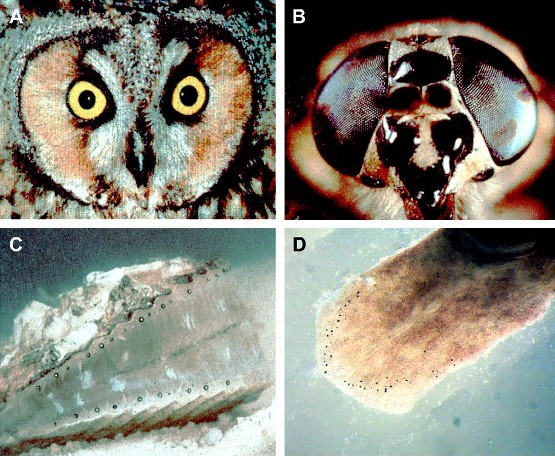

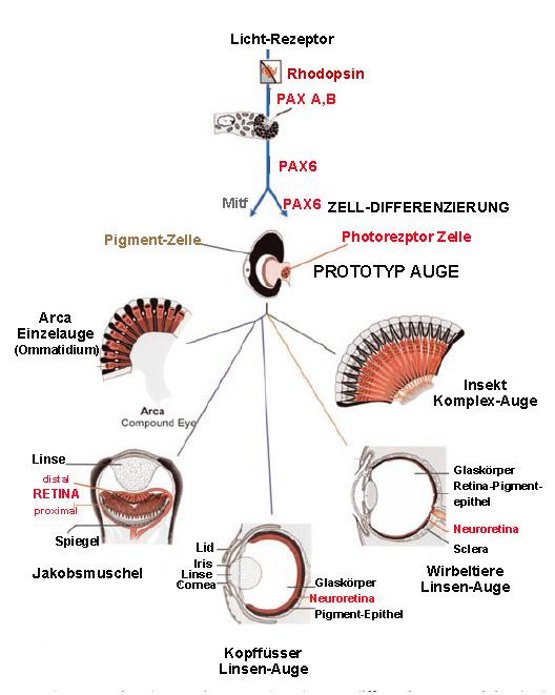

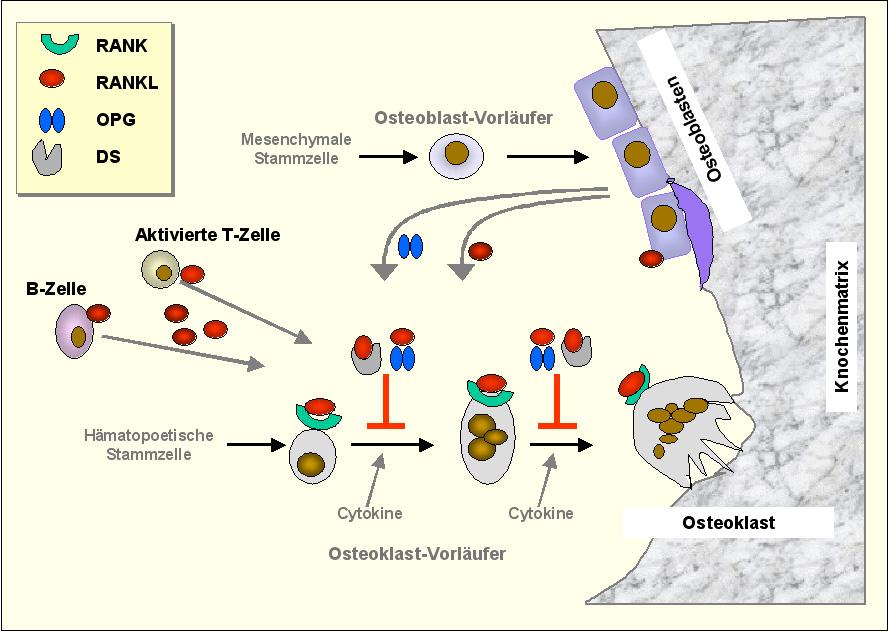

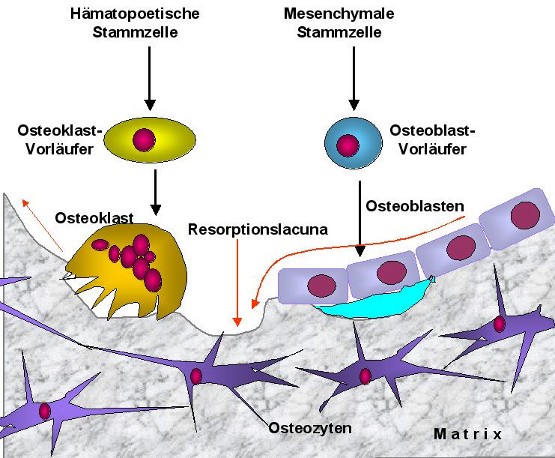

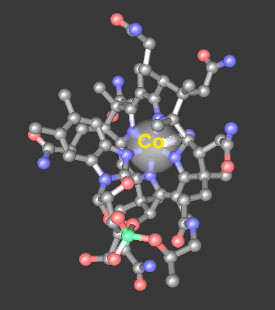

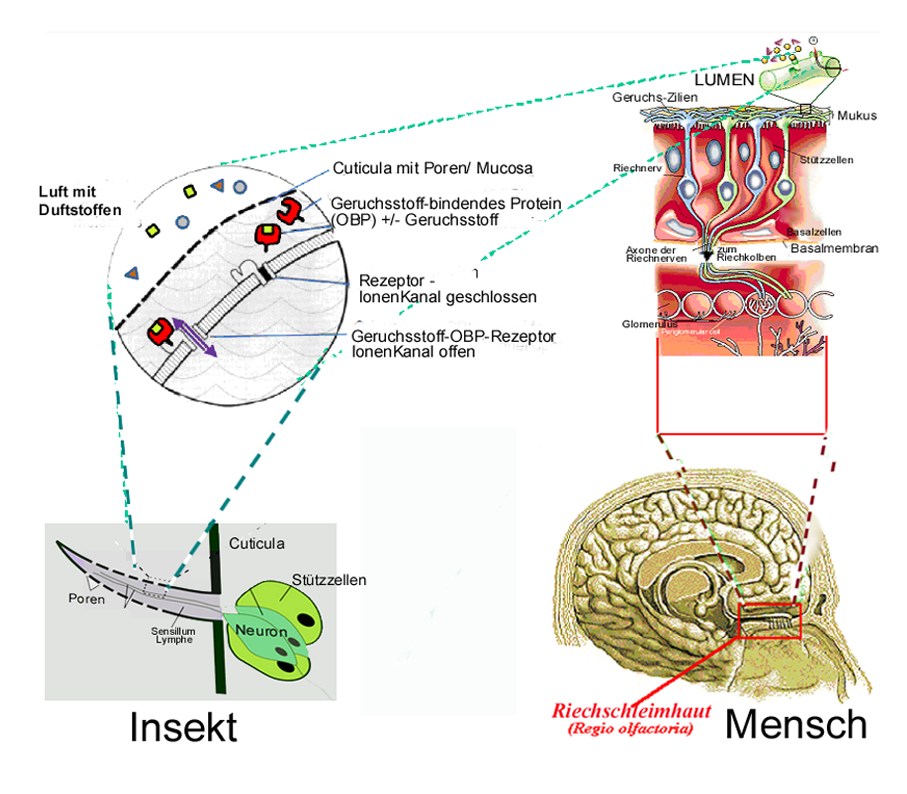

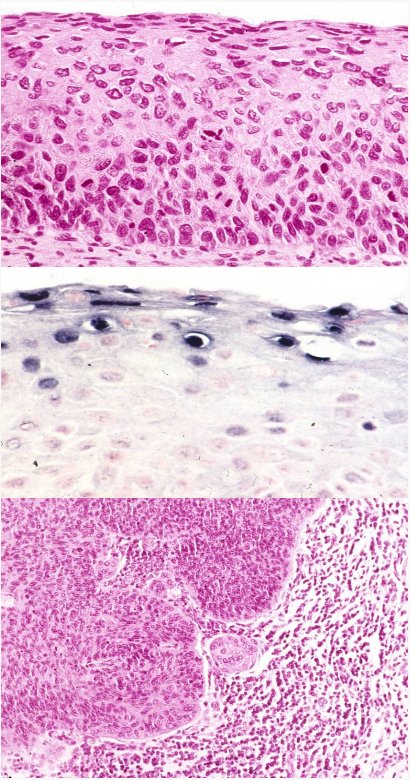

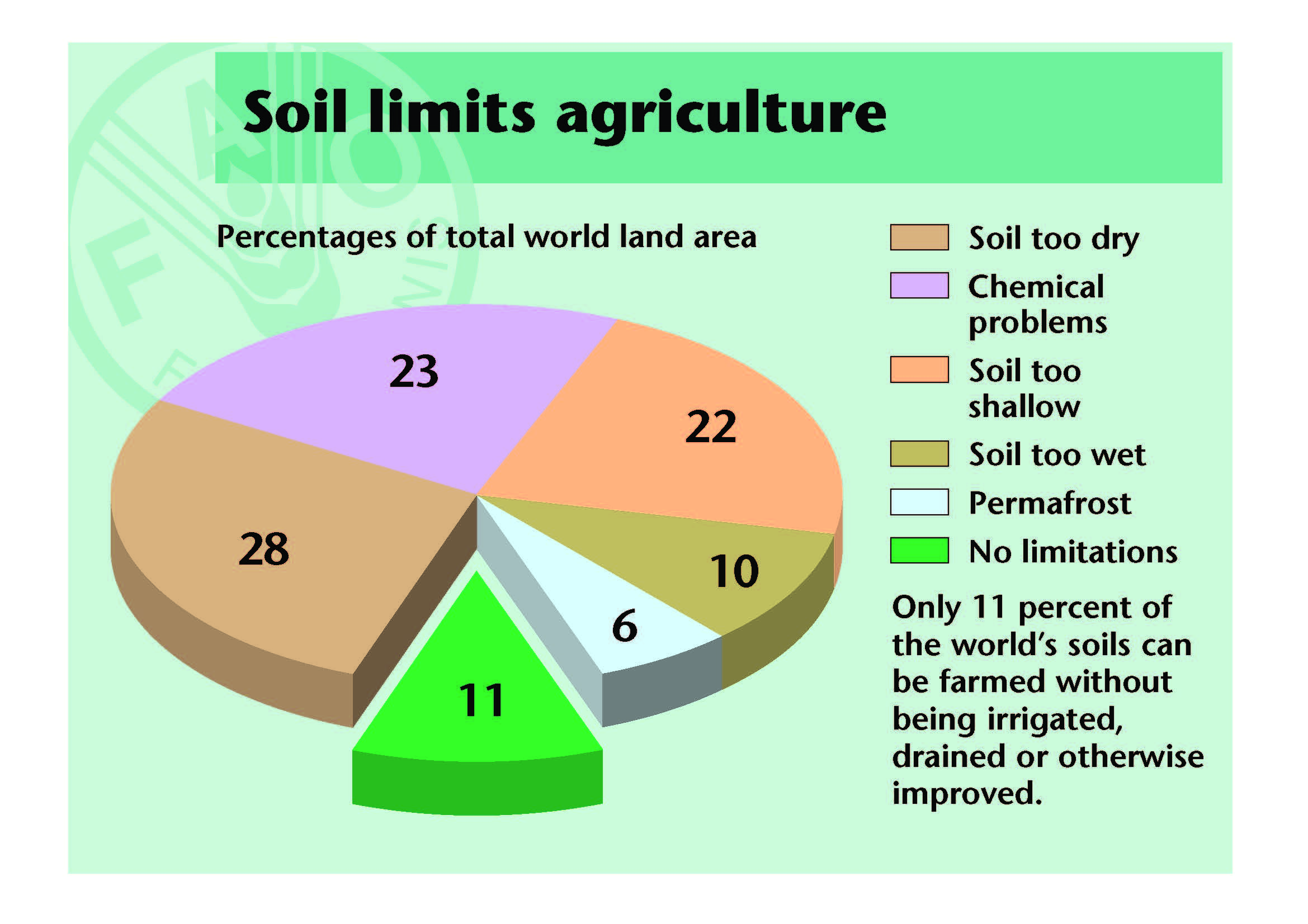

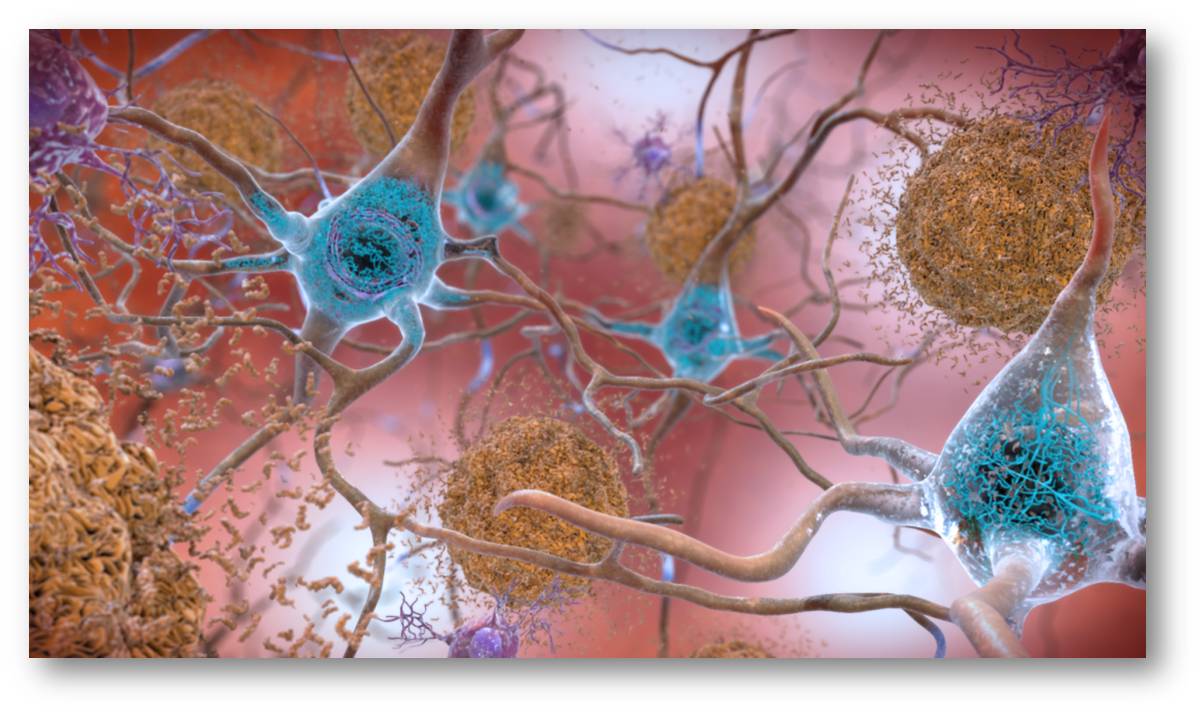

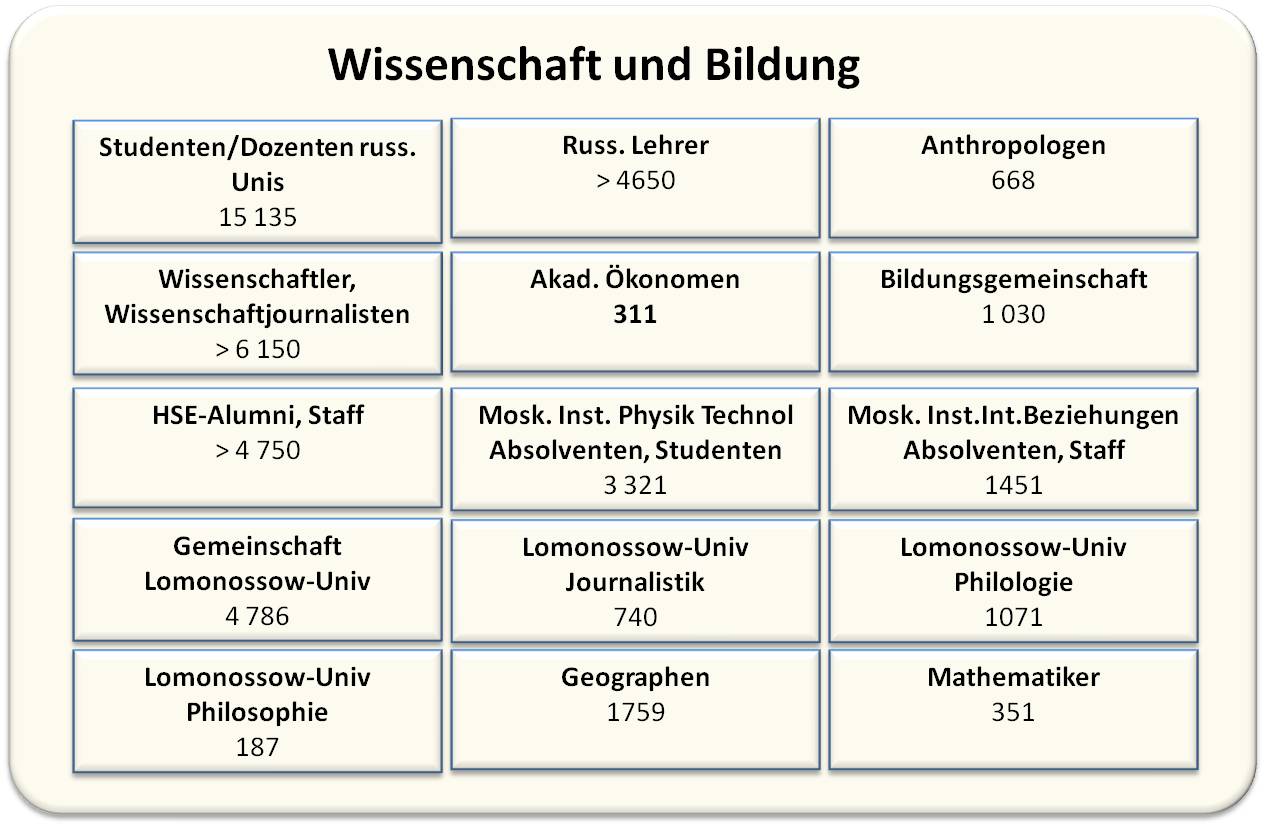

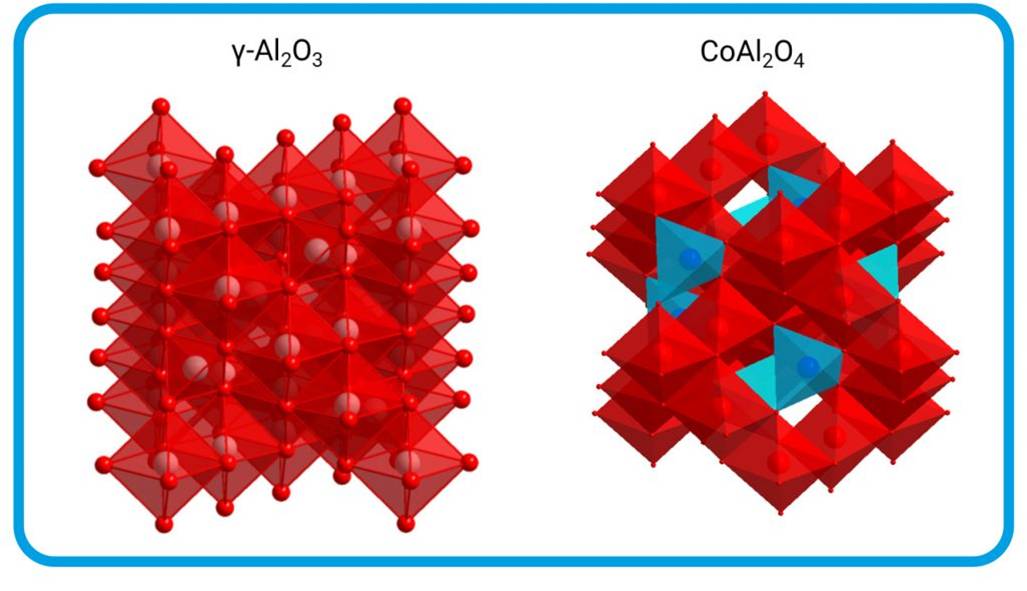

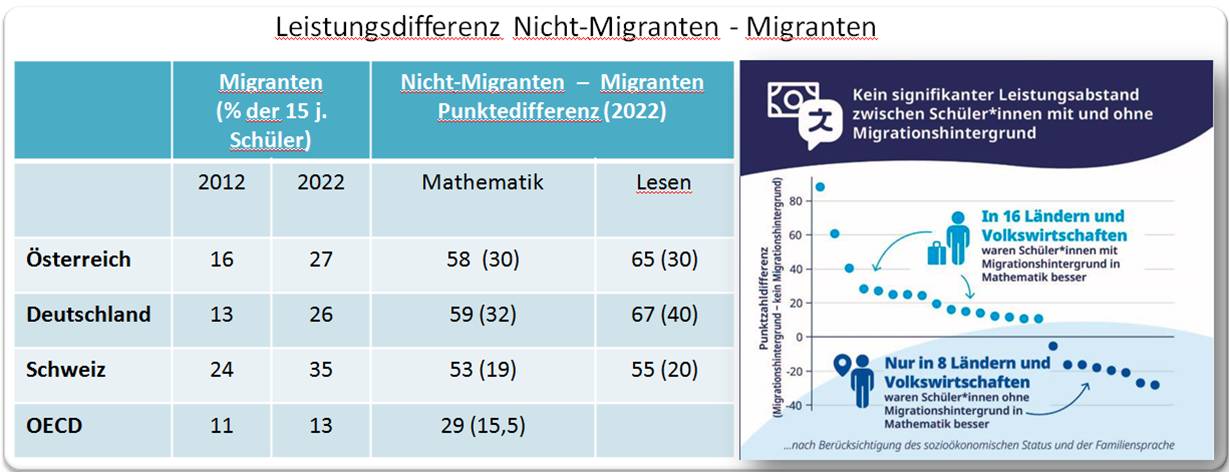

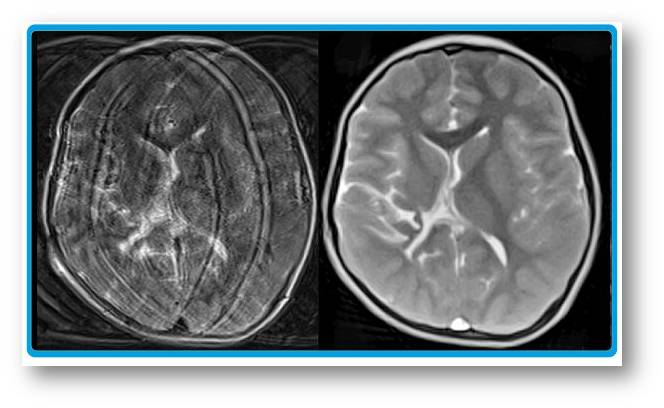

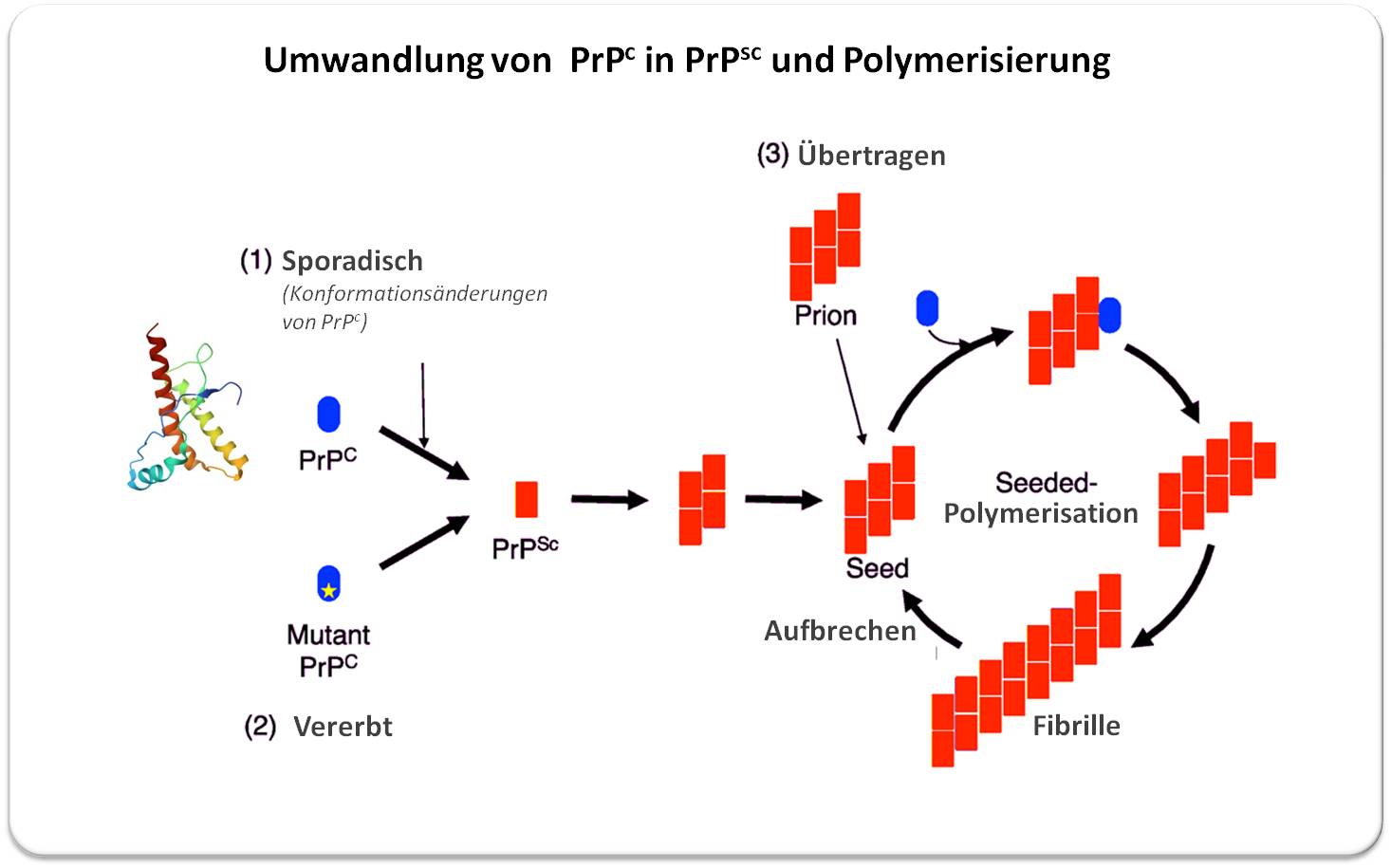

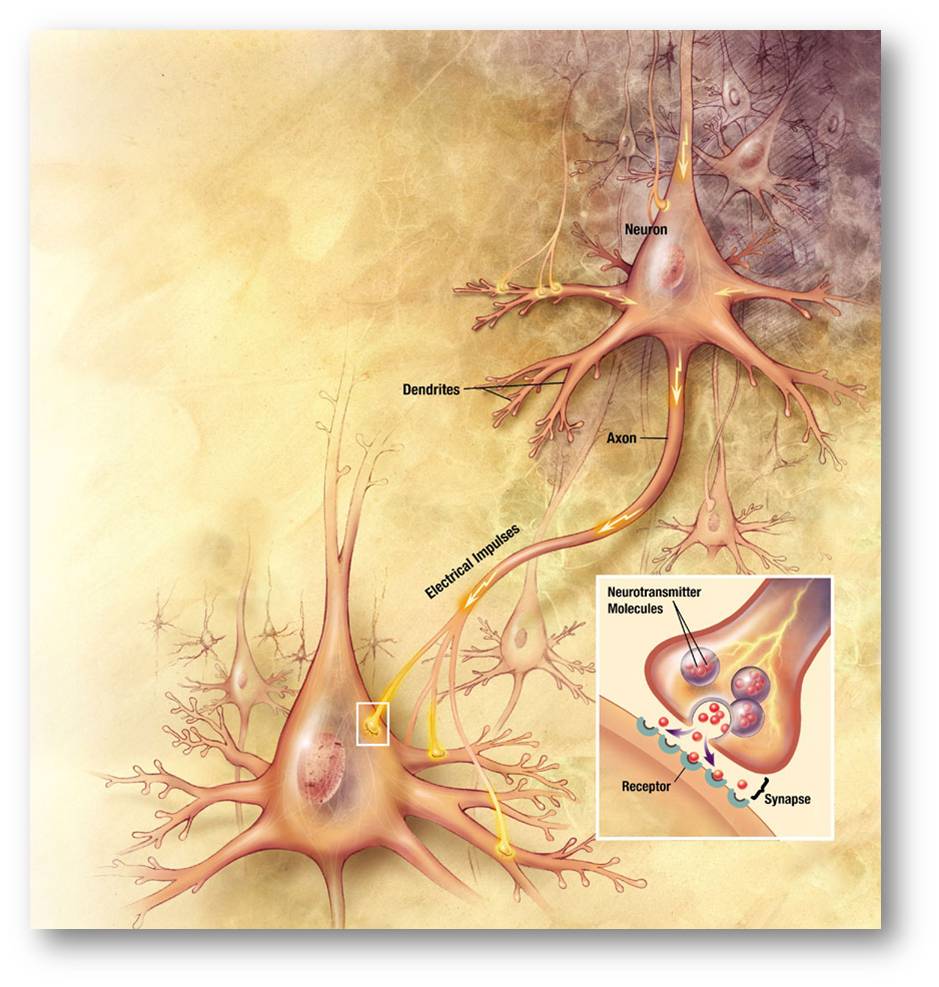

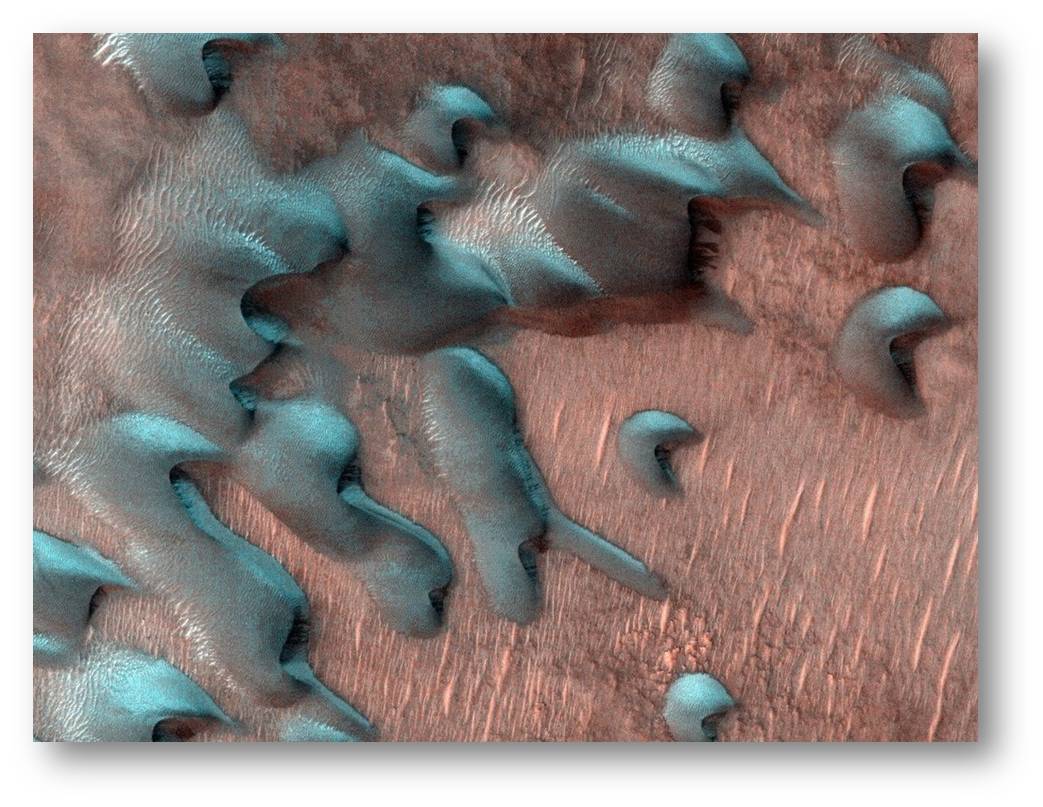

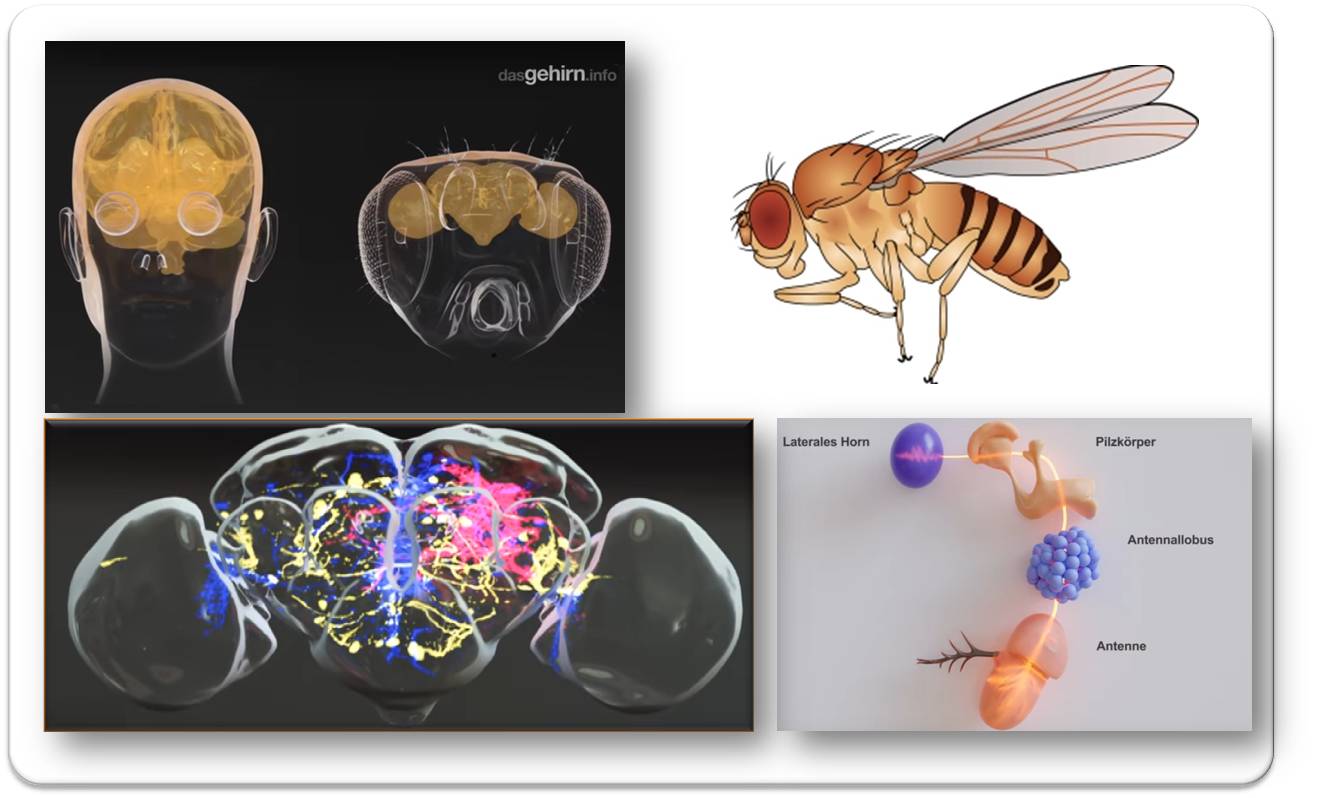

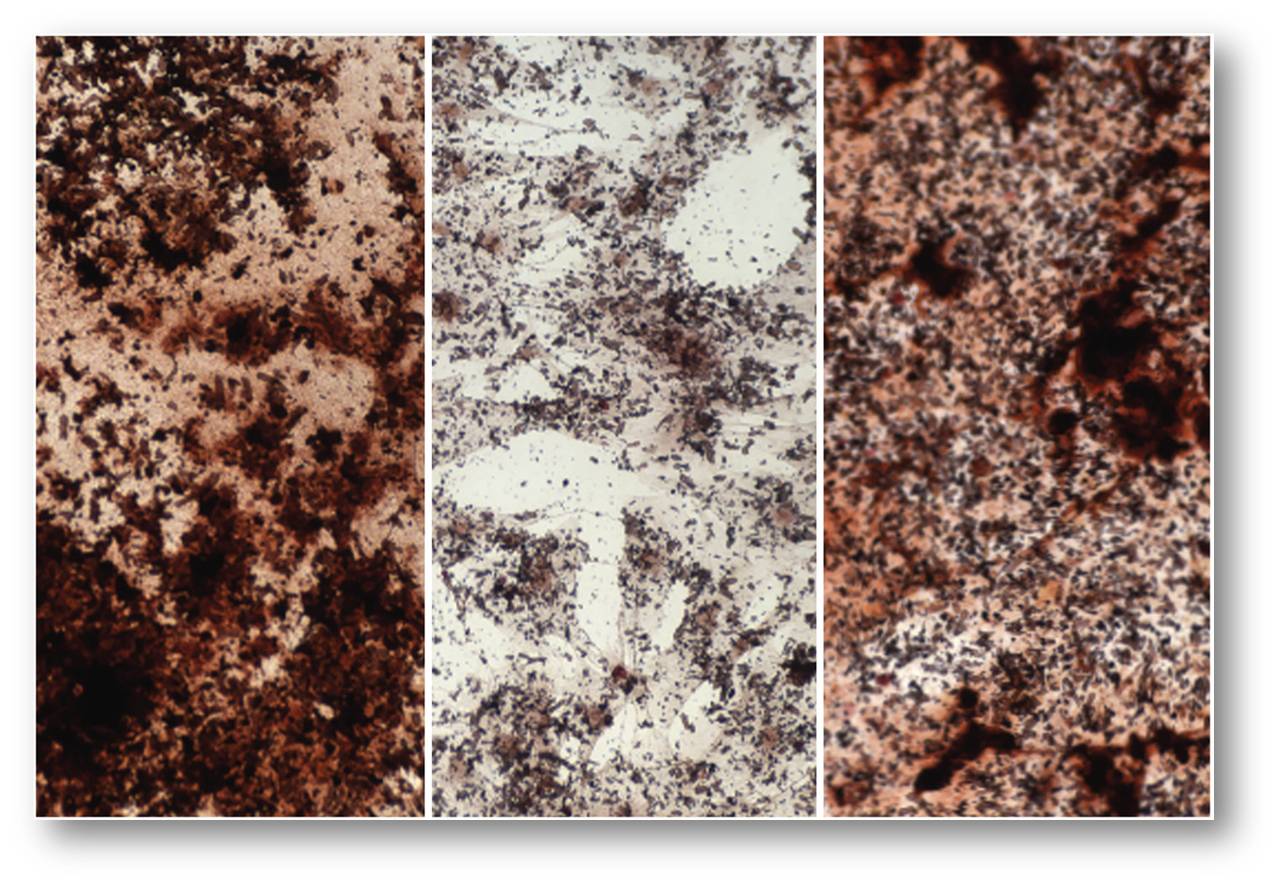

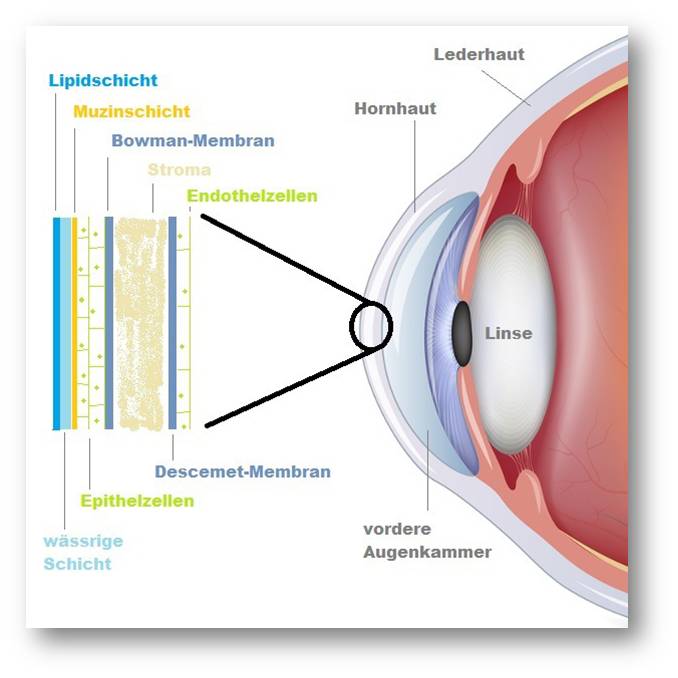

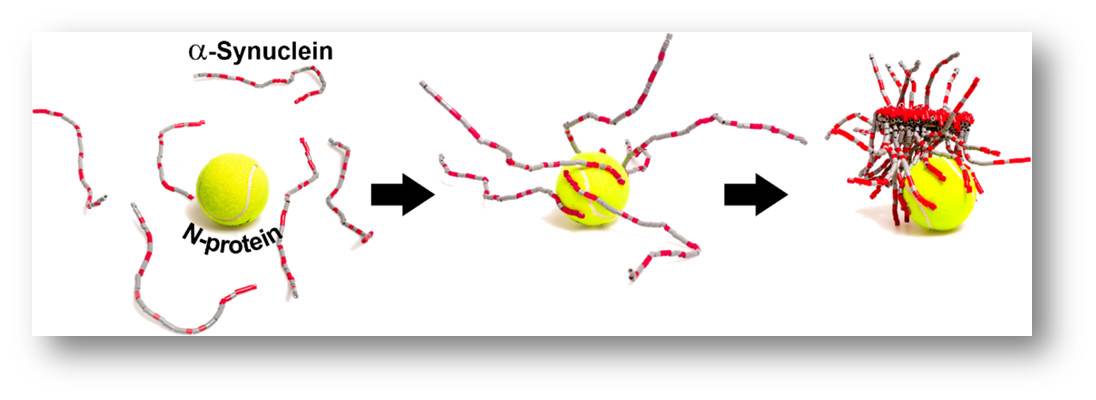

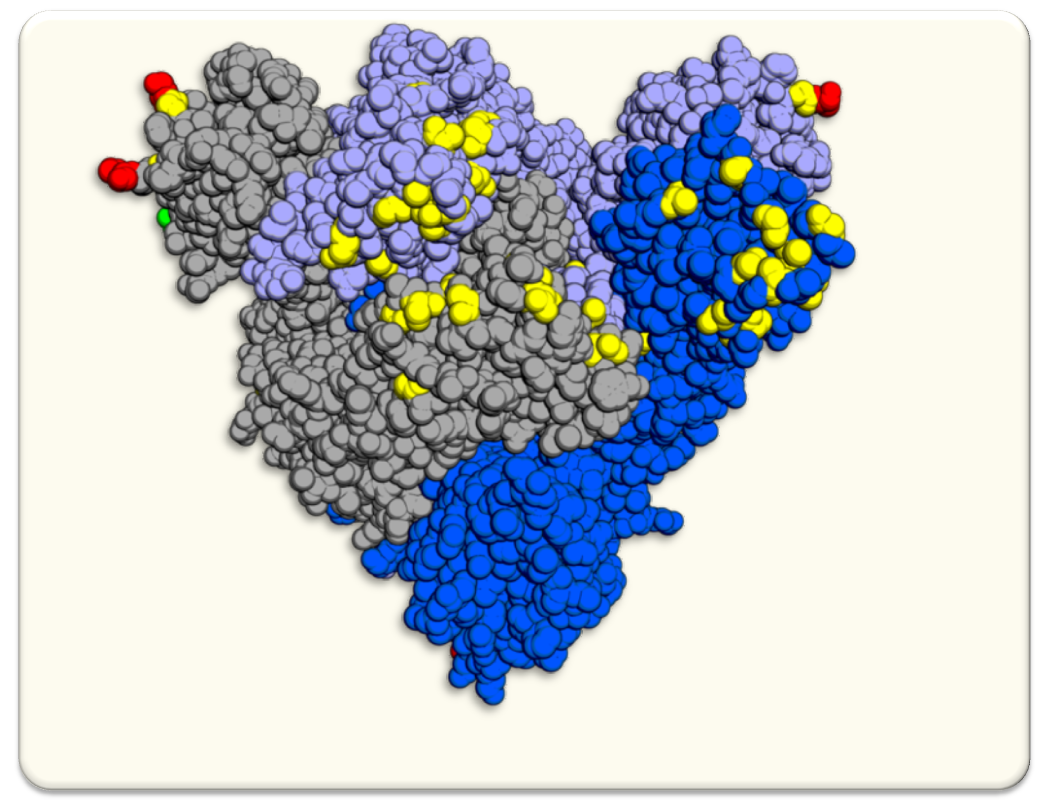

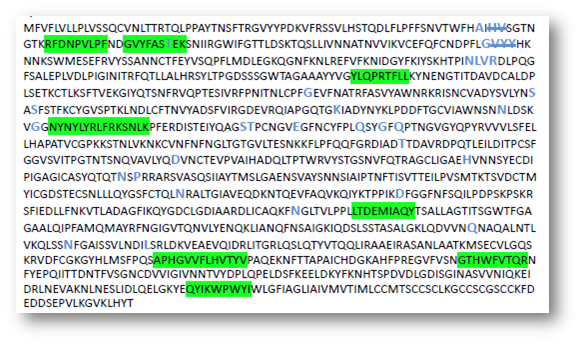

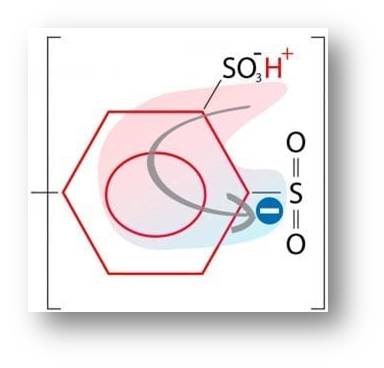

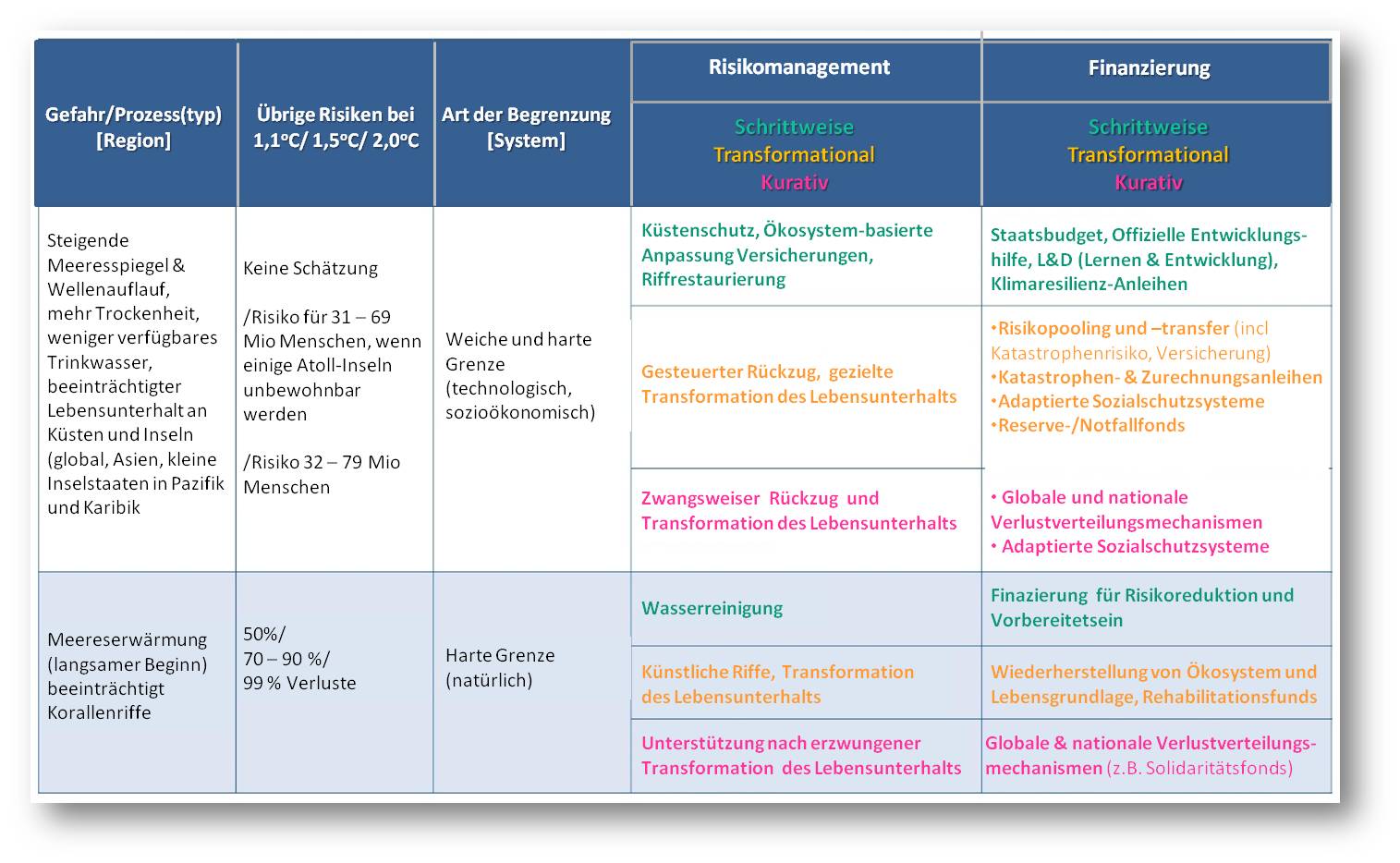

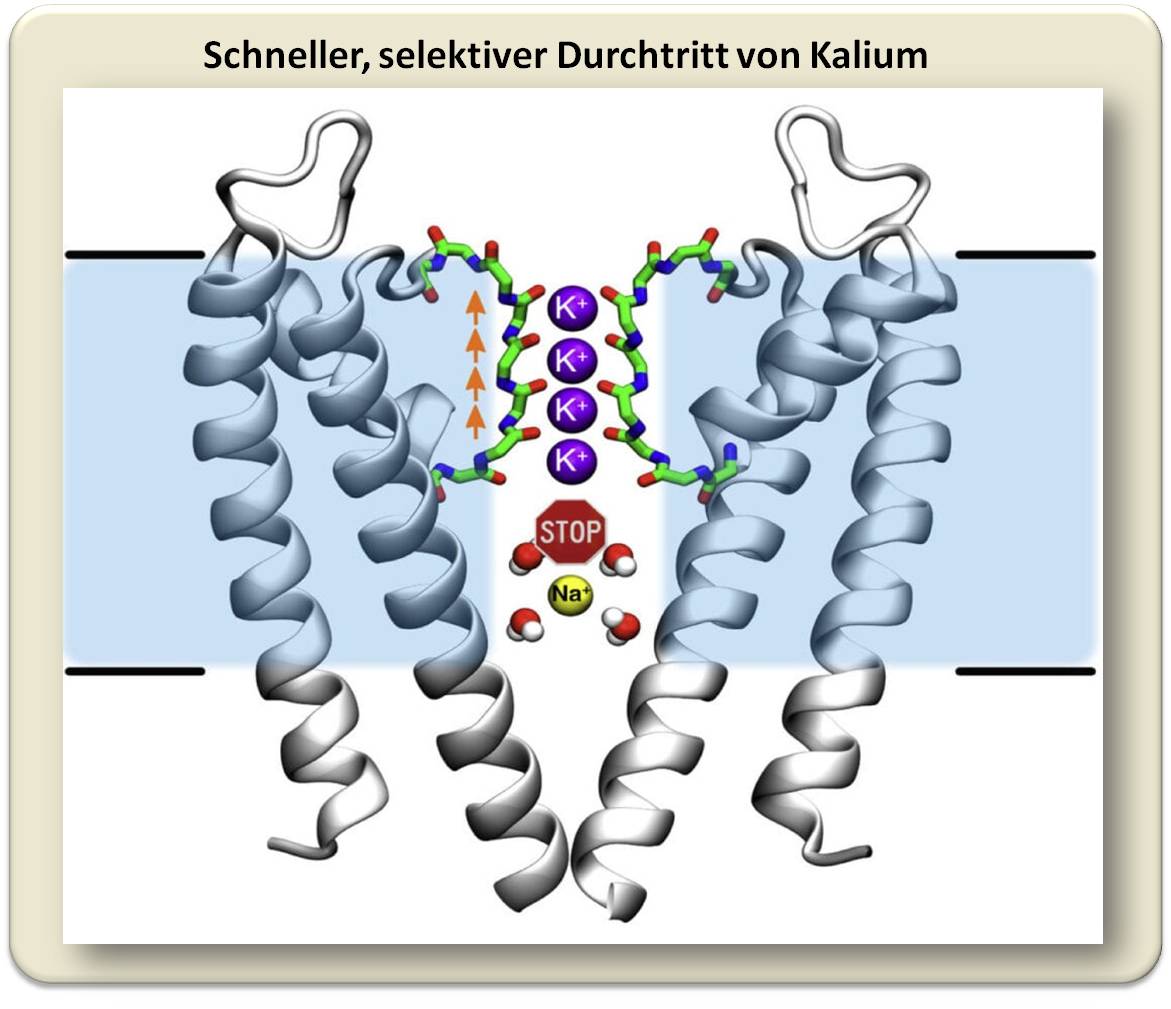

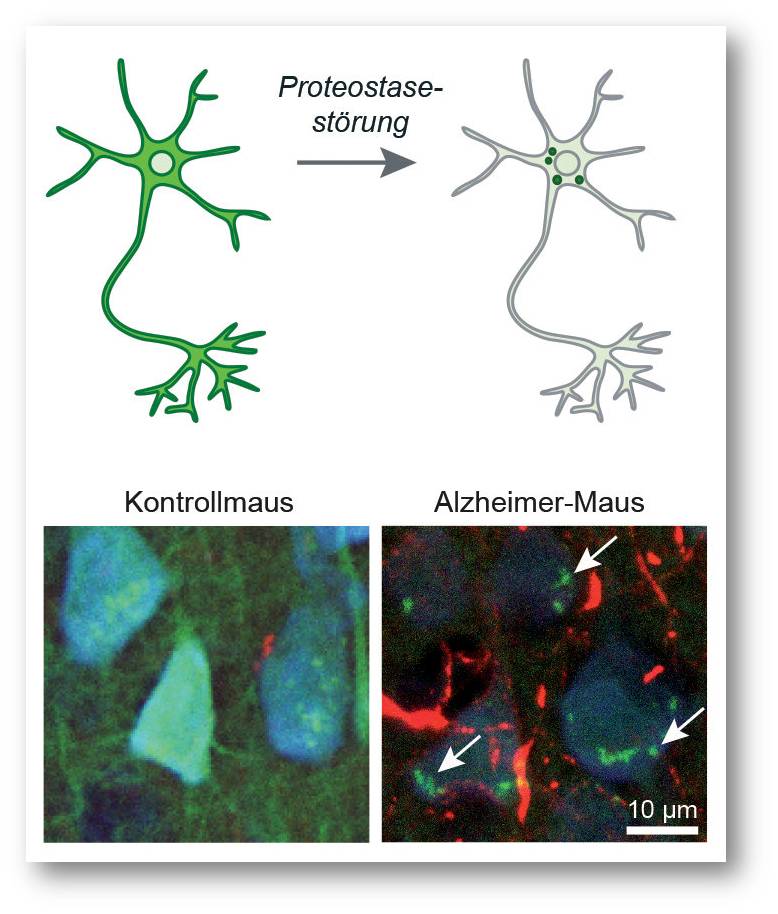

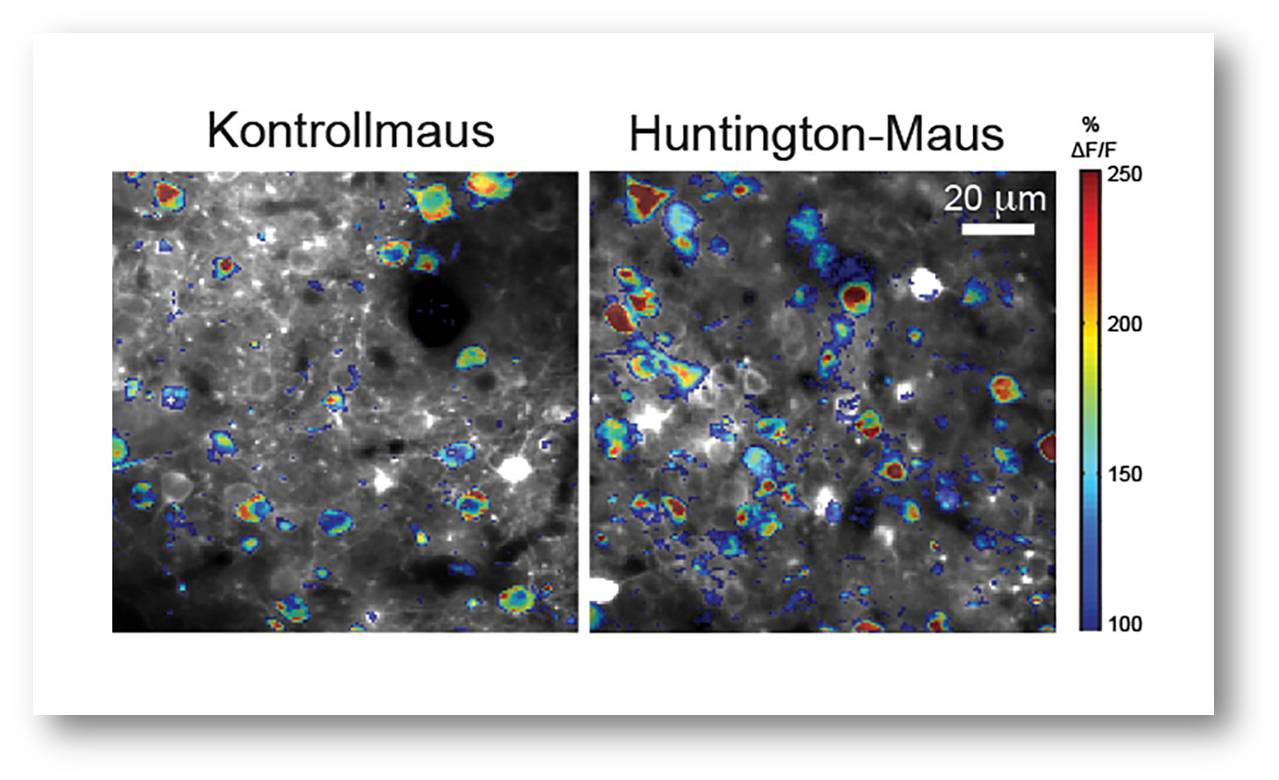

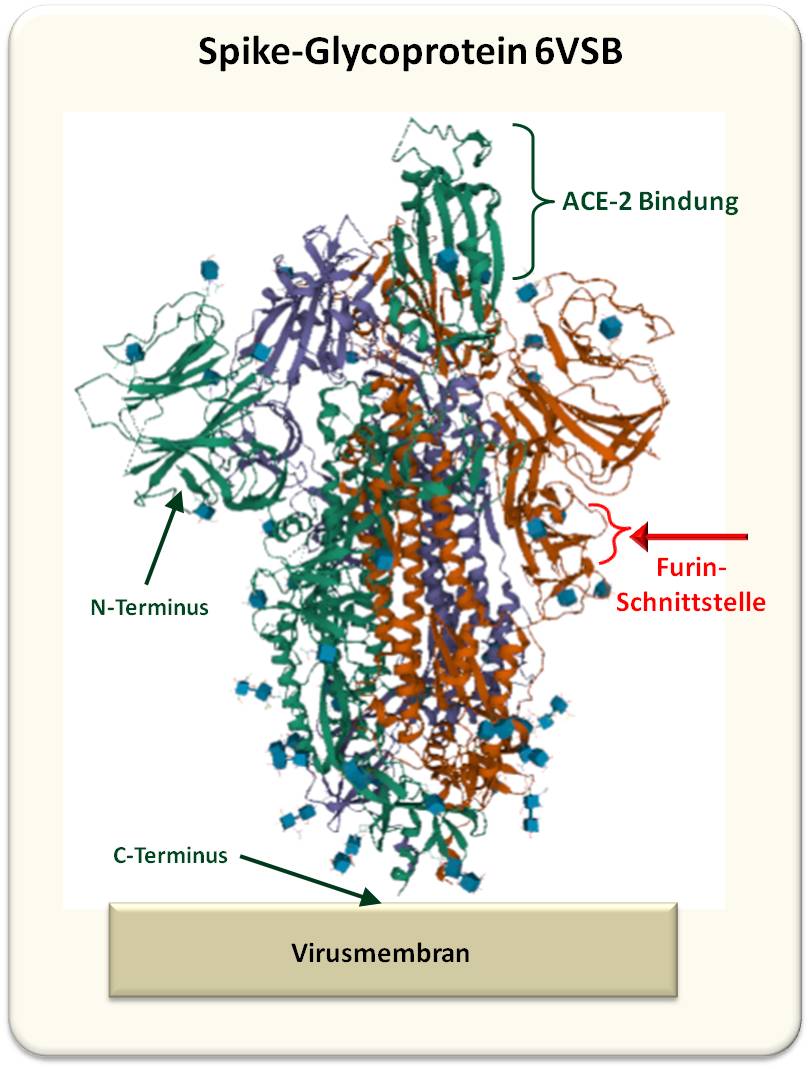

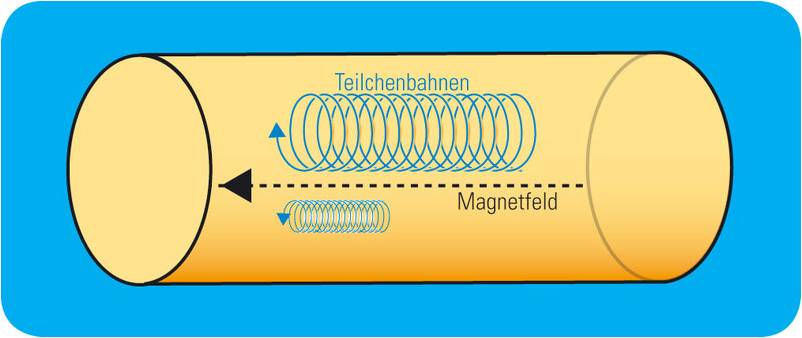

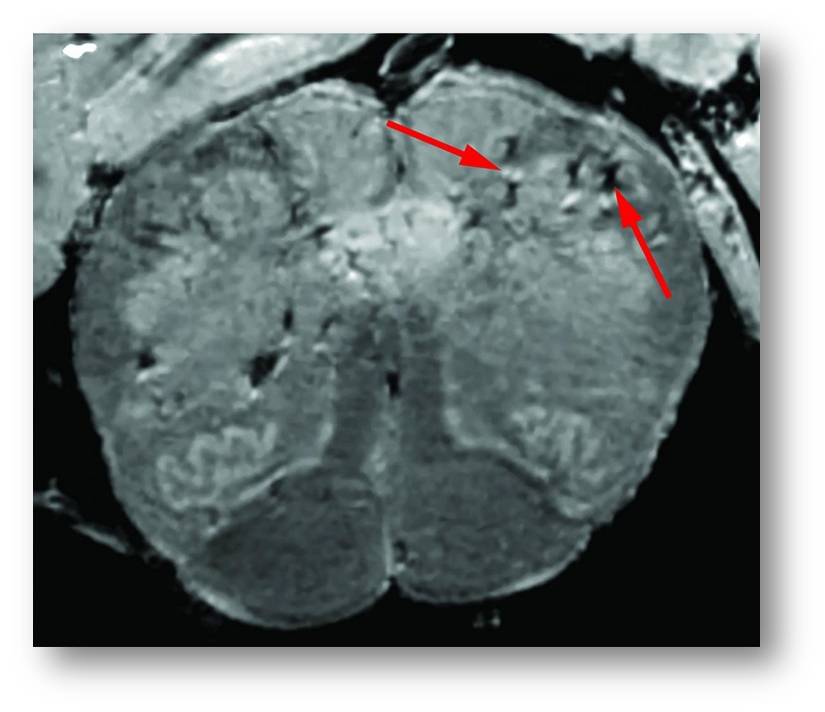

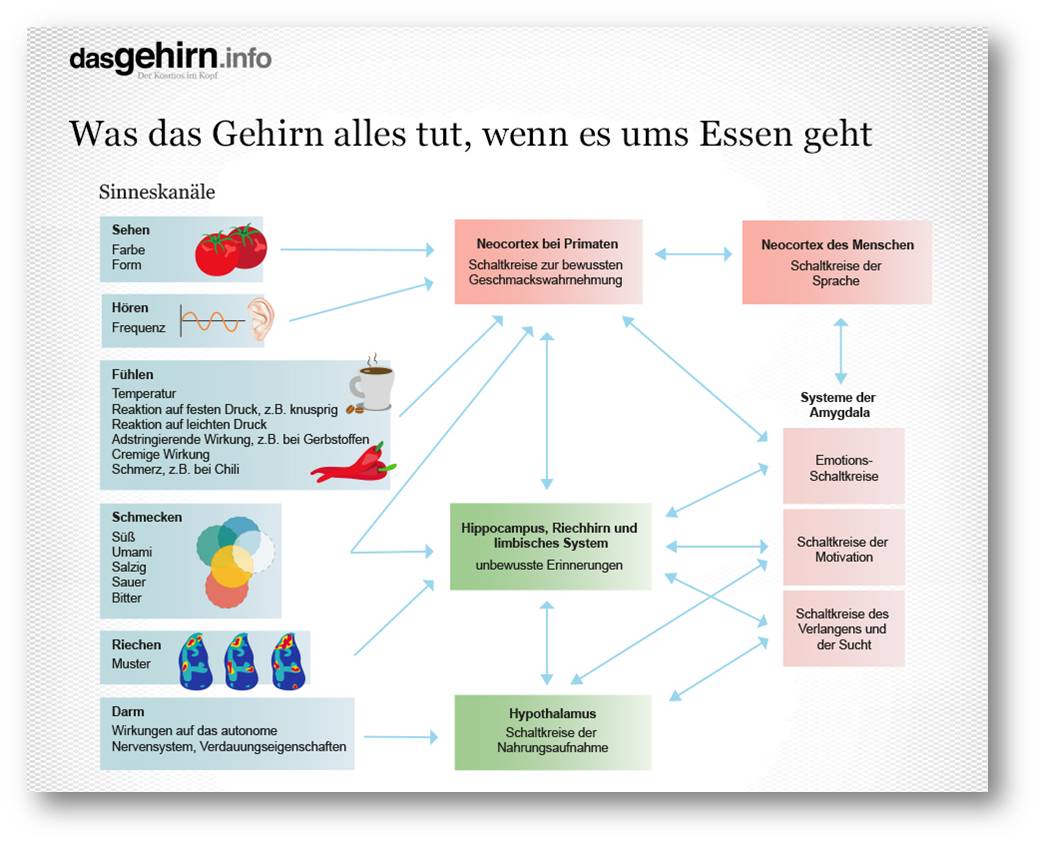

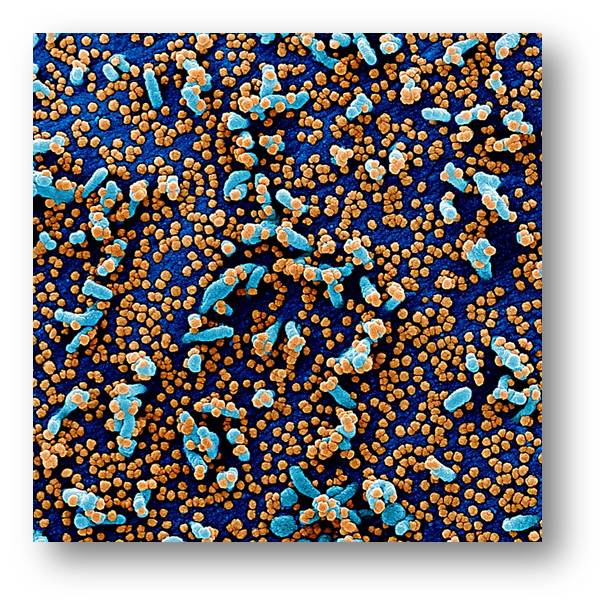

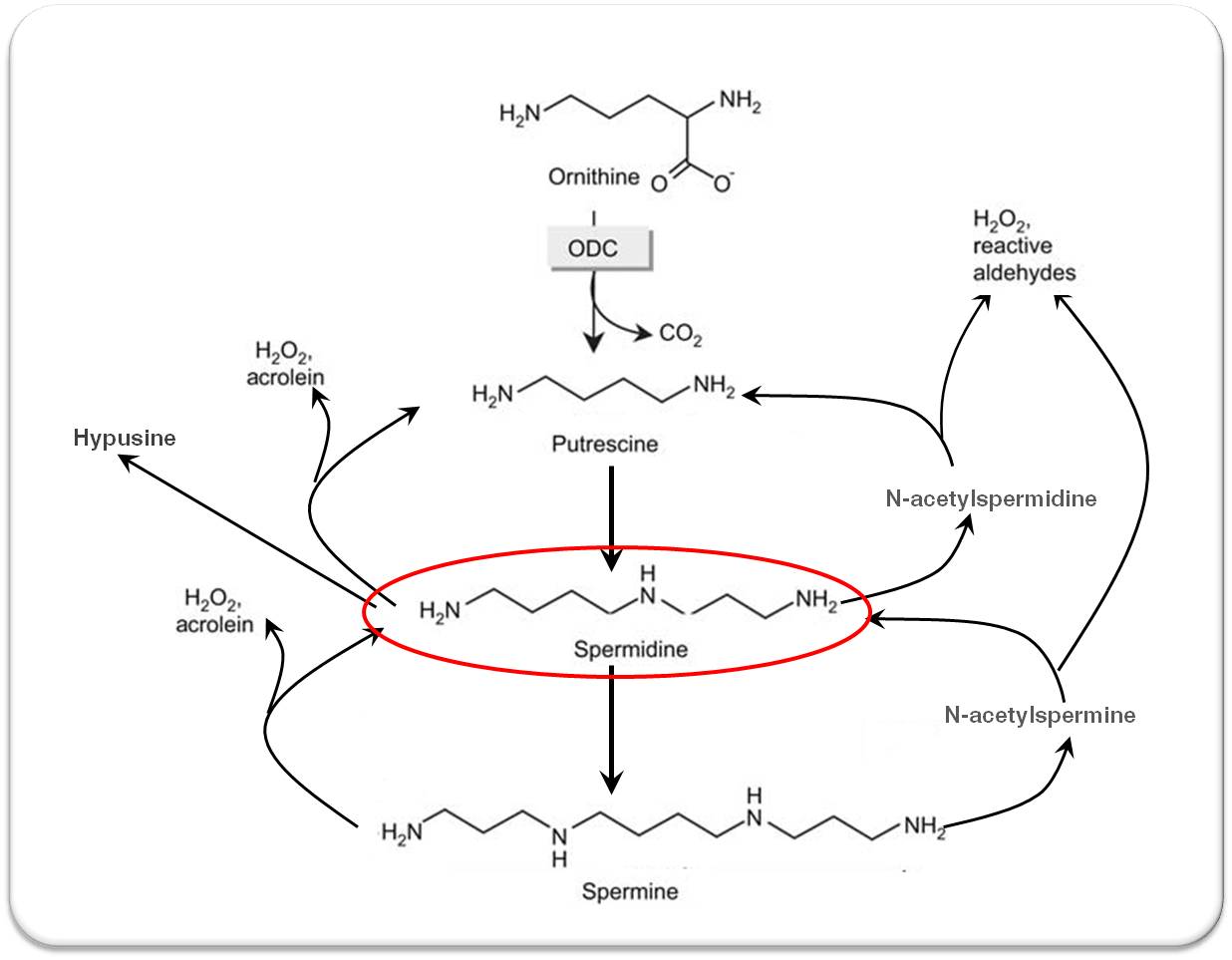

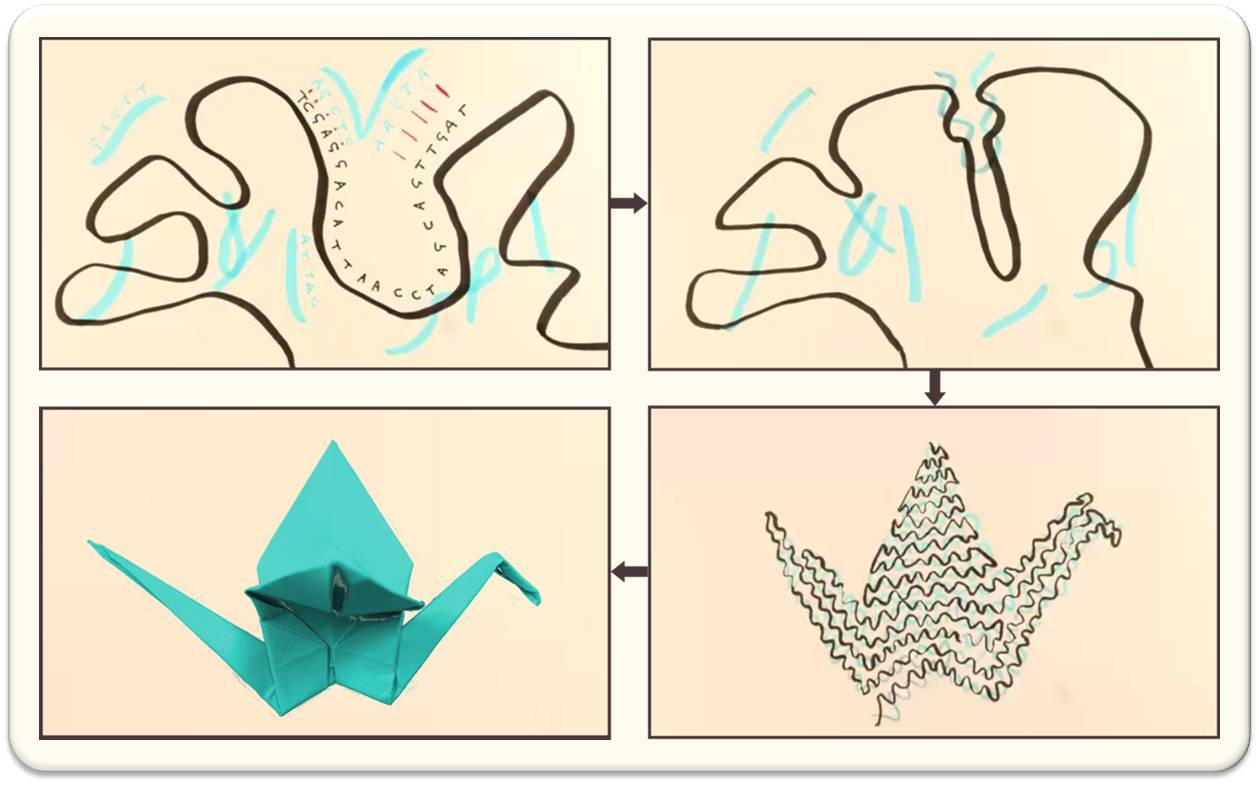

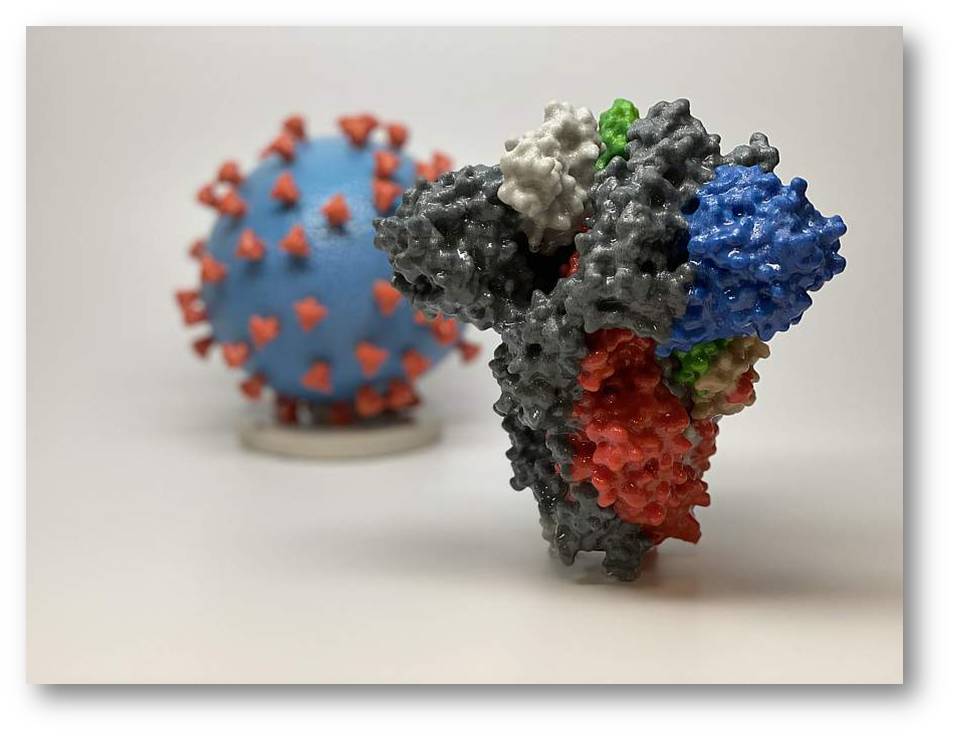

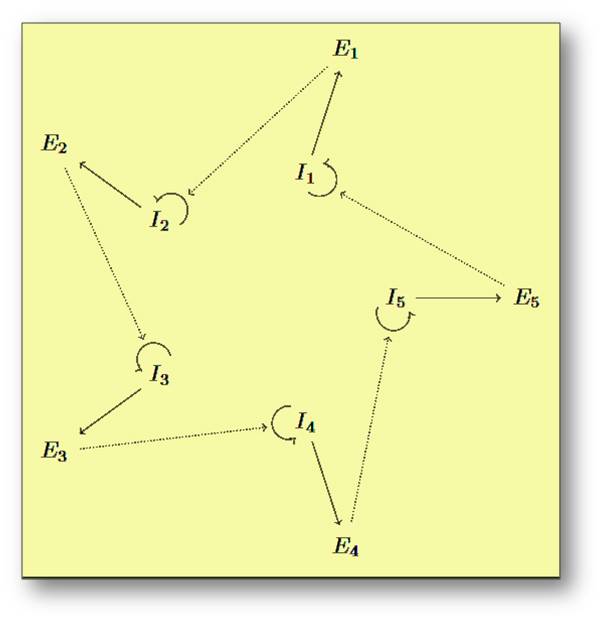

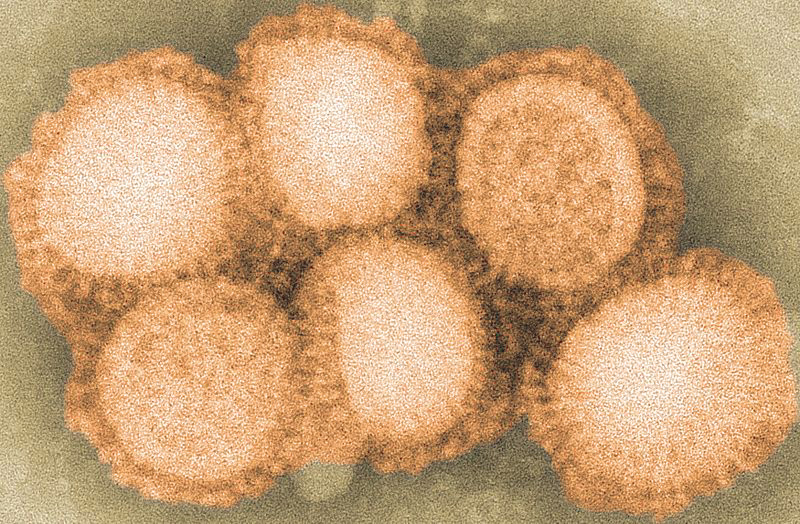

Sie hatte auch zwei Kopien der Christchurch-Mutation geerbt, einer seltenen Variante desApolipoprotein E (APOE)-Gens, benannt nach dem Ort, an dem es in Neuseeland entdeckt wurde. Die Christchurch-Genvariante verringert die Dichte der Tau-Fibrillen (Tangles), der anderen Art von Protein, das im Alzheimer-Gehirn aggregiert. Abbildung 1.

|

Abbildung 1 Stliisierte Darstellung der Amyloid-beta-Plaques (braun) im extrazellulären Raum zwischen den Neuronen und den Tau-Protein Knäueln (blau) in den Neuronen. |

Kürzlich haben Forscher der Washington University School of Medicine mit genetisch veränderten "humanisierten" Mäusen gezeigt, dass die Christchurch-Mutation die Wechselwirkung zwischen Amyloid-Beta und Tau unterbindet.

"Wenn Menschen altern, beginnen viele eine Amyloid-Anhäufung im Gehirn zu entwickeln. Anfangs bleiben sie kognitiv unauffällig. Nach vielen Jahren jedoch beginnt die Amyloidablagerung zu einer Anhäufung des Tau-Proteins zu führen. Wenn dies geschieht, kommt es bald zu kognitiven Beeinträchtigungen. Wenn wir einen Weg finden, die Auswirkungen der APOE-Christchurch-Mutation zu imitieren, können wir vielleicht verhindern, dass Menschen, die bereits auf dem Weg zur Alzheimer-Demenz sind, diesen Weg weiter fortsetzen", erklärt Dr. David M. Holtzman von der Universität Washington.

Könnte auf therapeutischem Weg die Bildung von Amyloid-Beta-Plaques von der Ablagerung von Tau-Fibrillen entkoppelt werden?

Das war's, was die Forscher herausfinden wollten, die nun ihre Ergebnisse im Januar 2024 in der Zeitschrift Cell veröffentlichten [2]. Der Übergang von der Amyloidbildung zur Wechselwirkung mit Tau-Protein ist kritisch und noch wenig verstanden. Der Fall von Aliria könnte hier zur Klöärung beitragen.

"Der Fall dieser Frau war sehr, sehr ungewöhnlich, da sie die Amyloid-Pathologie aufwies, aber kaum eine Tau-Pathologie und nur sehr leichte kognitive Symptome, die erst spät auftraten. Das legte uns nahe, dass sie Hinweise auf die Verbindung zwischen Amyloid und Tau bieten könnte", so Holtzman.

Allerdings: Aliria ist ein Einzelfall; weltweit die einzige Person, von der man weiß, dass sie die beiden Mutationen aufweist. Haben diese tatsächlich zusammengewirkt, oder ist ihr ungewöhnlicher , offensichtlich vor Alzheimer schützender Genotyp nur ein Zufall?

Um dieses Rätsel zu lösen, setzte das Team um Holtzman genetisch manipulierte Mäuse ein, die übermäßig viel Amyloid produzierten und dazu auch die menschliche Christchurch-Mutation aufwiesen. Dann injizierten sie menschliches Tau-Protein in die Gehirne der Mäuse. Da die Gehirne der Mäuse bereits voller Amyloid-"Keime" waren, hätten sich die Tau-Knäuel an den Injektionsstellen festsetzen und dann auf andere Hirnregionen ausbreiten müssen - aber das taten sie nicht. Es wurde nur sehr wenig Tau inmitten des reichlich vorhandenen Amyloids gefunden, das die Gehirne erstickte - es war ein Modell für Alirias zufällige Doppelmutation.

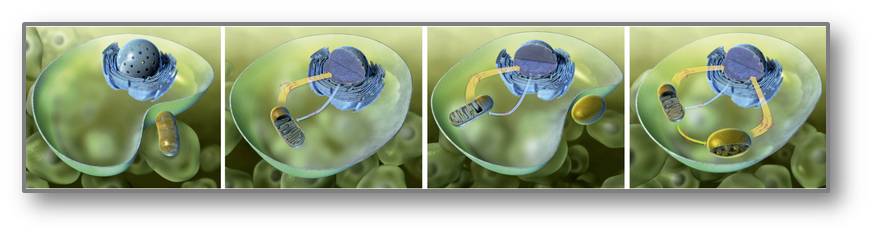

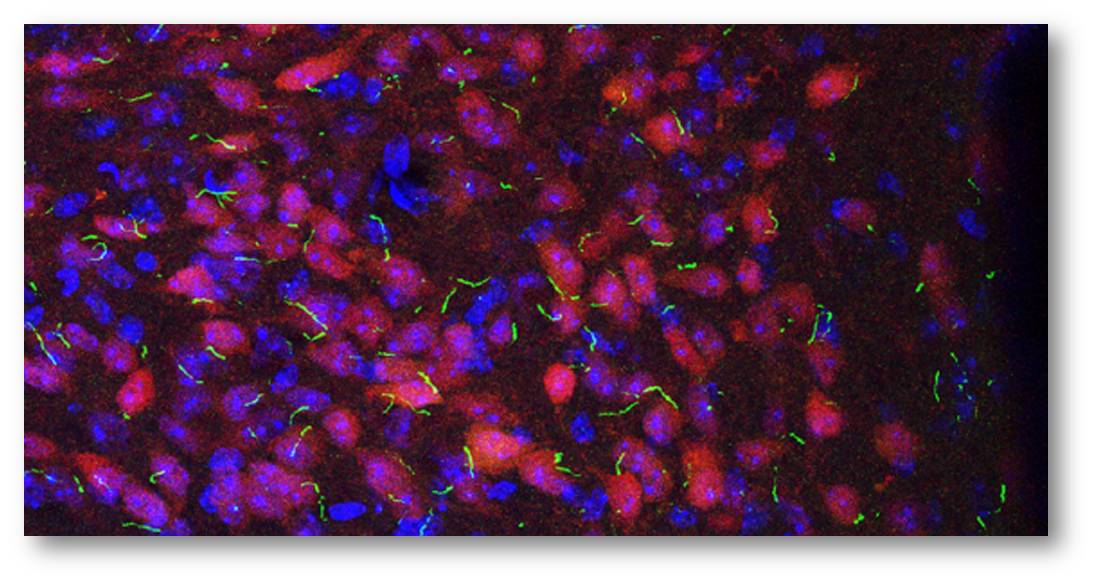

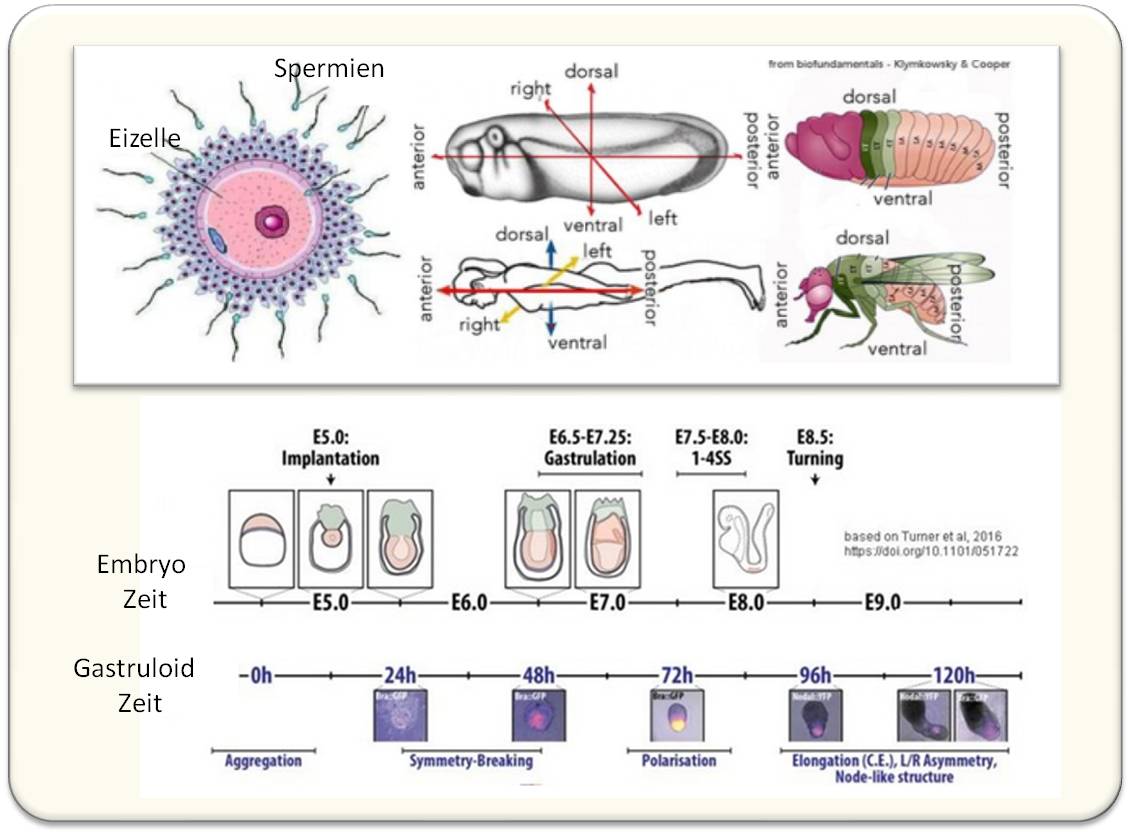

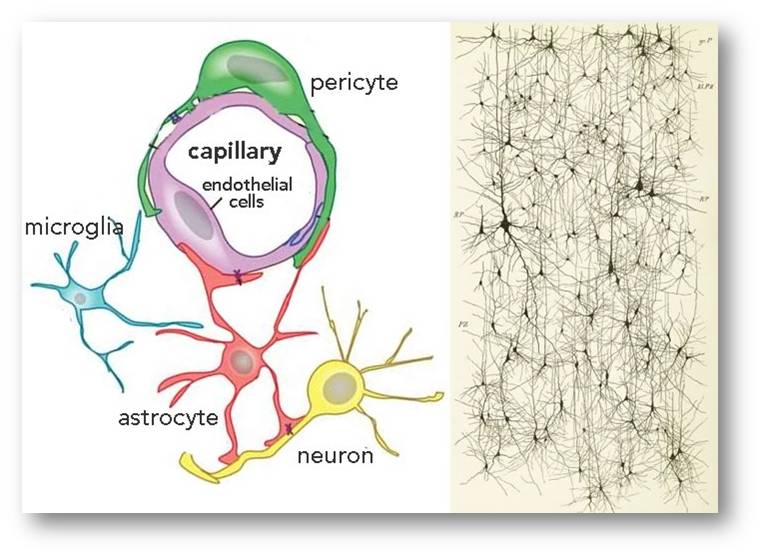

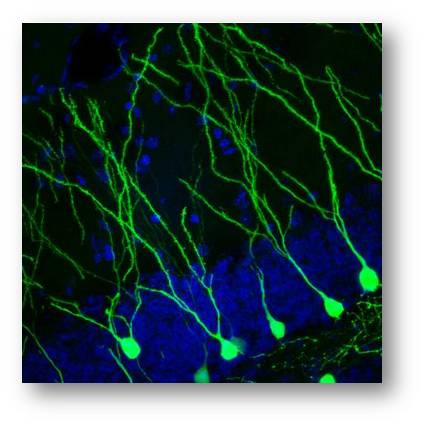

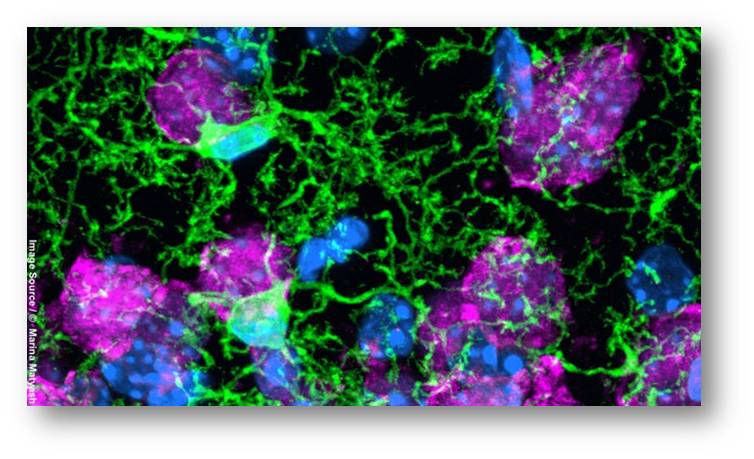

Die Mäuse zeigten auf, wie die Christchurch-Mutation schützend wirkte, nämlich durch die Aktivität der Mikroglia, die als Abfallbeseitigungszellen des Gehirns fungieren. Mikroglia sammeln sich um Amyloid-Plaques auf Gehirnzellen. Bei Alzheimer-Mäusen mit der APOE-Christchurch-Mutation liefen die Mikroglia, die die Amyloid-Plaques umgaben, auf Hochtouren, um die Tau-Aggregate zu verschlingen und zu zerstören.

"Diese Mikroglia nehmen das Tau auf und bauen es ab, bevor sich die Tau-Pathologie wirksam auf die nächste Zelle ausbreiten kann. Ohne Tau-Pathologie kommt es nicht zu Neurodegeneration, Atrophie und kognitiven Problemen. Wenn wir die Wirkung der Mutation nachahmen können, könnten wir die Amyloid-Ansammlung unschädlich machen oder zumindest viel weniger schädlich machen und die Menschen vor der Entwicklung kognitiver Beeinträchtigungen schützen", so Holtzman.

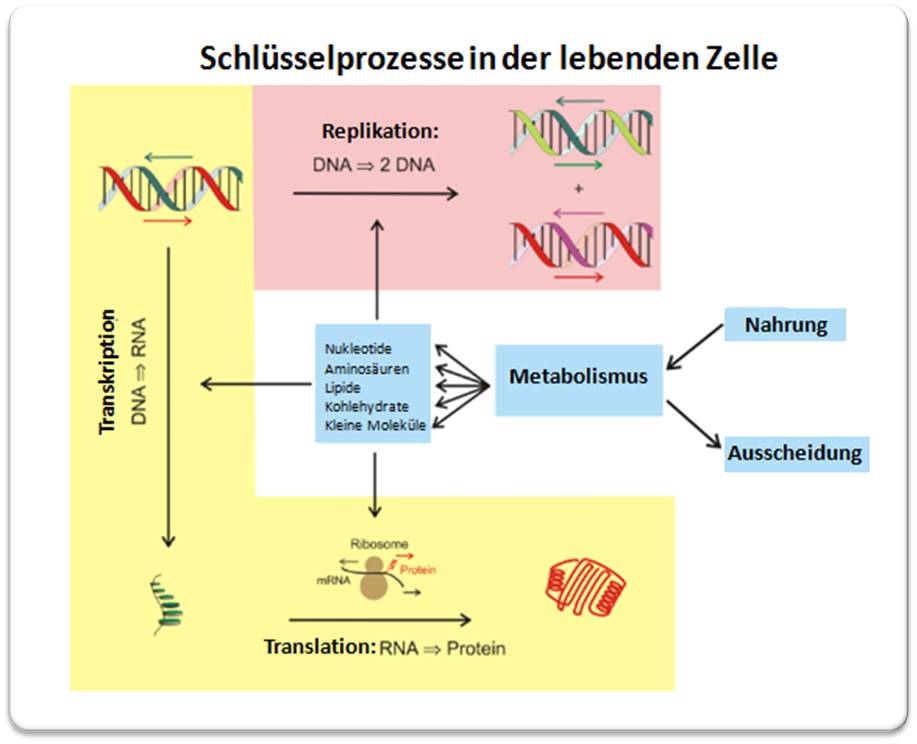

Gen Nr. 2: Reelin

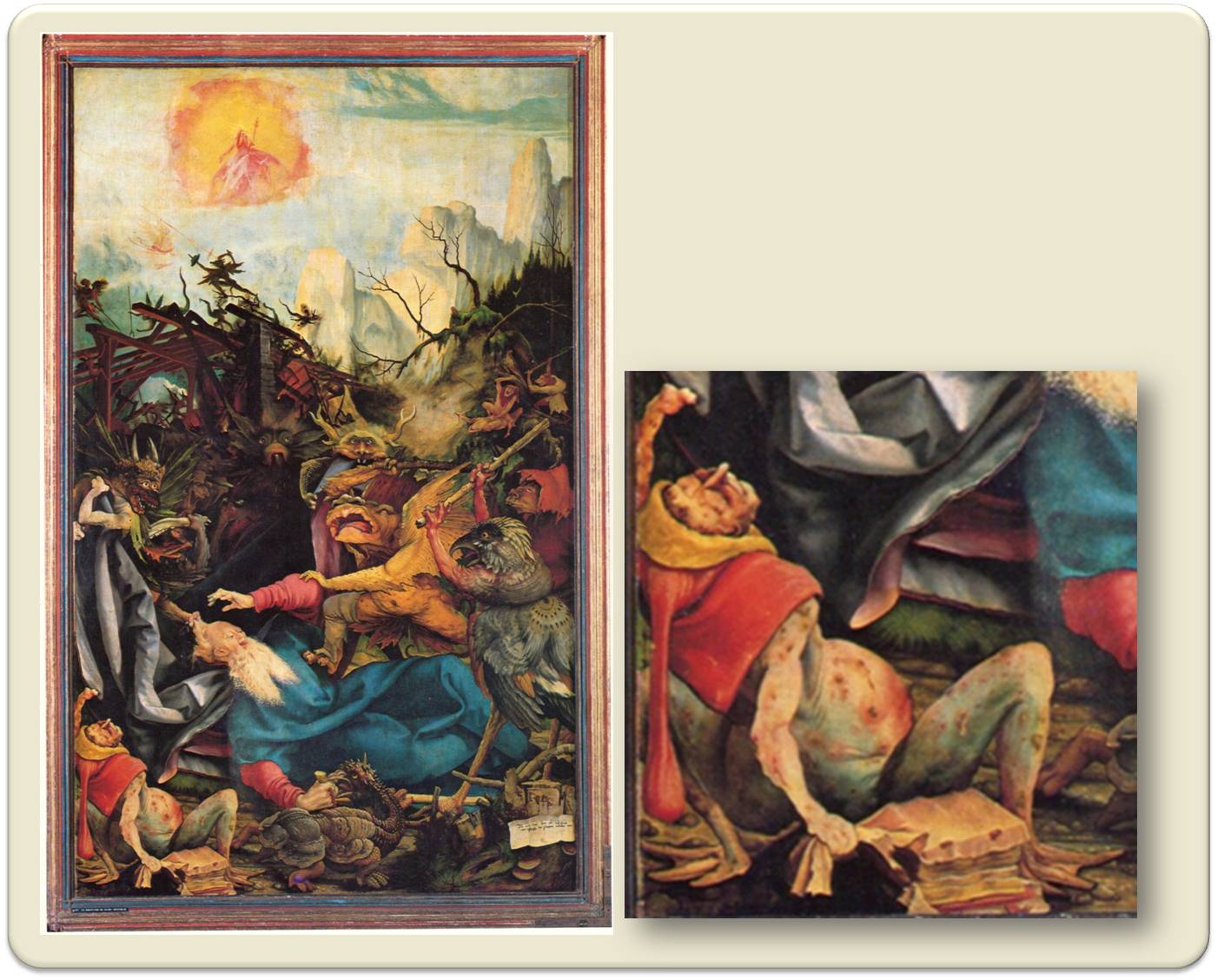

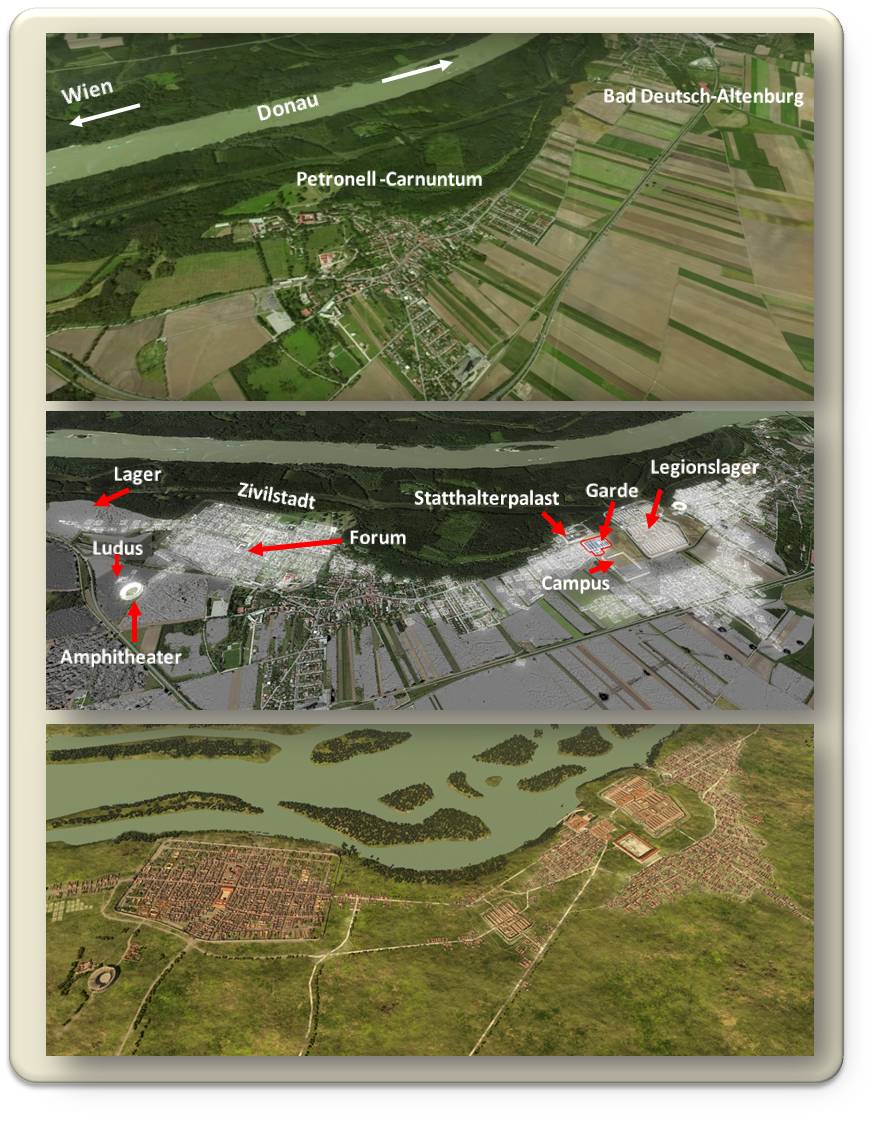

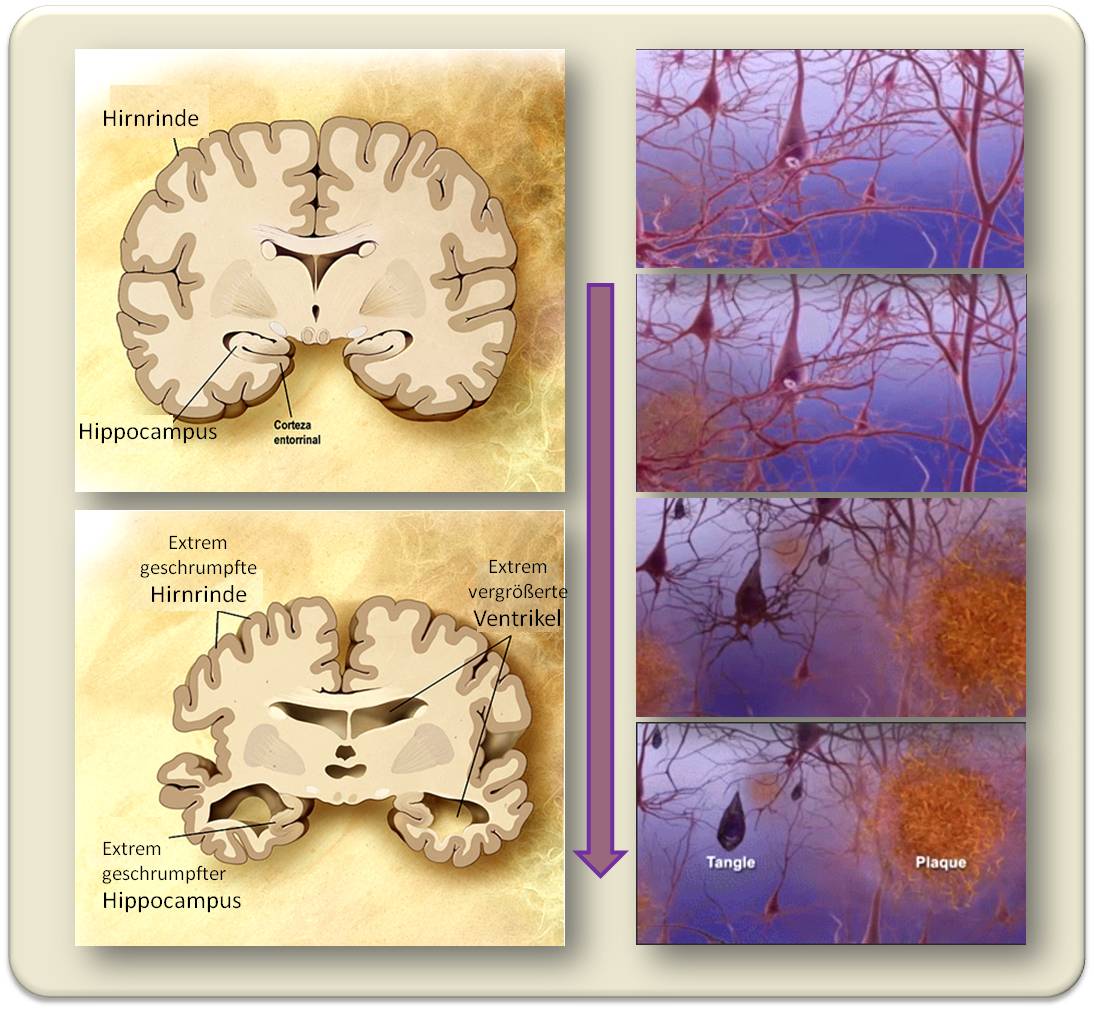

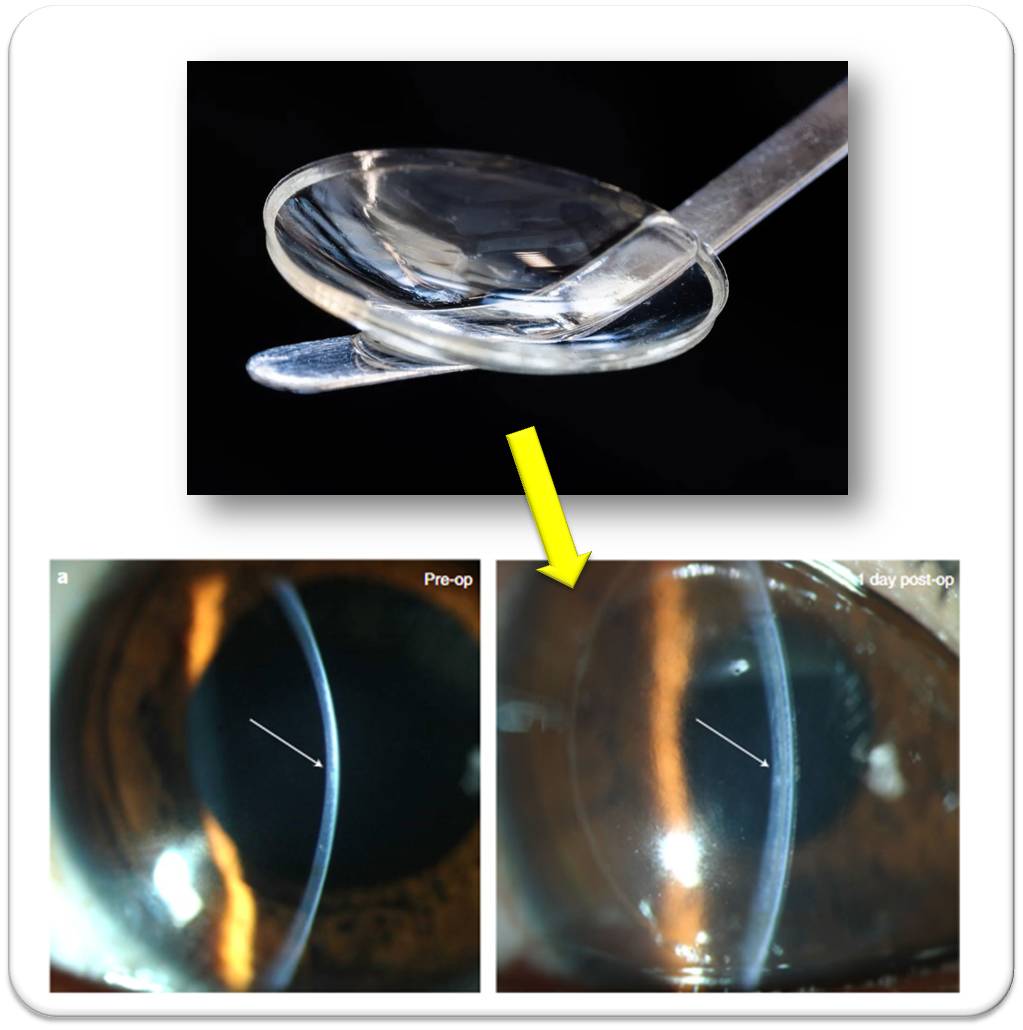

Die Forscher, die die große kolumbianische Familie untersuchten, zu der auch Aliria gehört, beschrieben in der Zeitschrift Nature Medicine vom 15. Mai 2023 "den weltweit zweiten Fall mit nachgewiesener extremer Resilienz gegenüber der autosomal dominanten Alzheimer-Krankheit". Wie Aliria behielt der Mann seine kognitiven Fähigkeiten bis zum Alter von 67 Jahren, obwohl er die starke PSEN1 E280A-Mutation hatte, die eine sehr früh einsetzende Alzheimer-Krankheit verursacht.

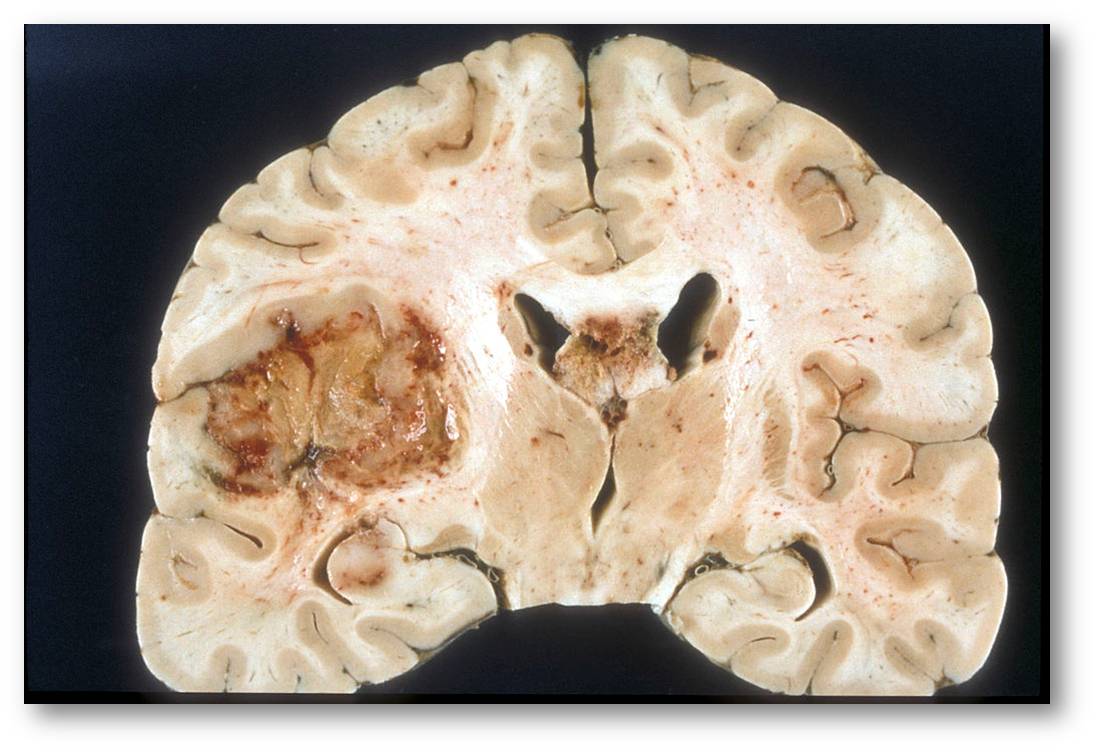

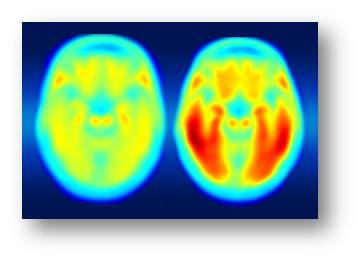

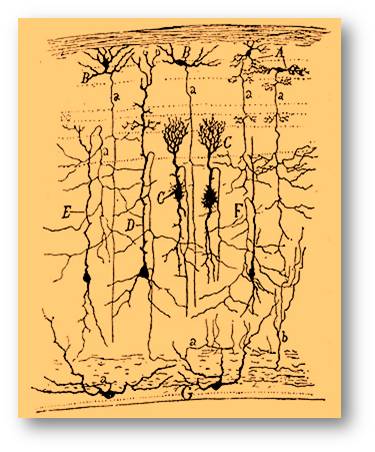

Im Alter von 73 Jahren zeigten Neuroimaging-Untersuchungen höhere Werte von Amyloid-Beta-Plaques als bei anderen Familienmitgliedern mit der Alzheimer-Mutation. Und obwohl sein Gehirn auch Tau-Knäuel aufwies, war der entorhinale Kortex - ein Gedächtniszentrum - vergleichsweise frei von Tau. Vielleicht ermöglichte diese ungewöhnliche Verteilung, dass seine kognitiven Fähigkeiten trotz des Ertränkens in Amyloid-Beta erhalten blieben.

Aber er hatte nicht die Christchurch-Mutation von Aliria.

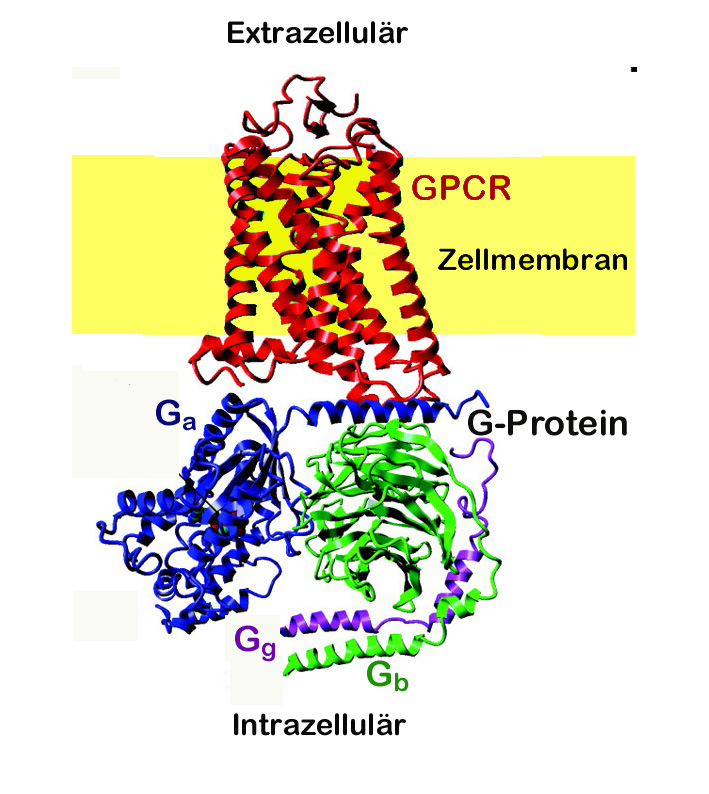

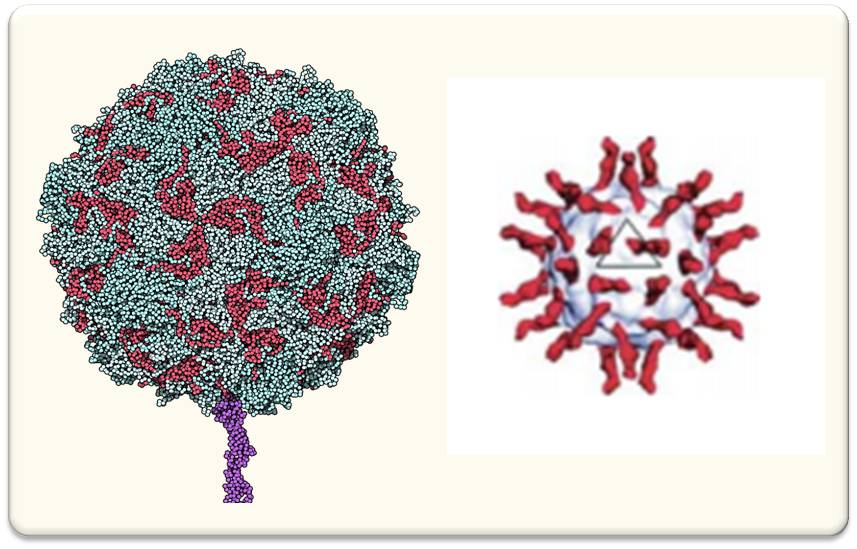

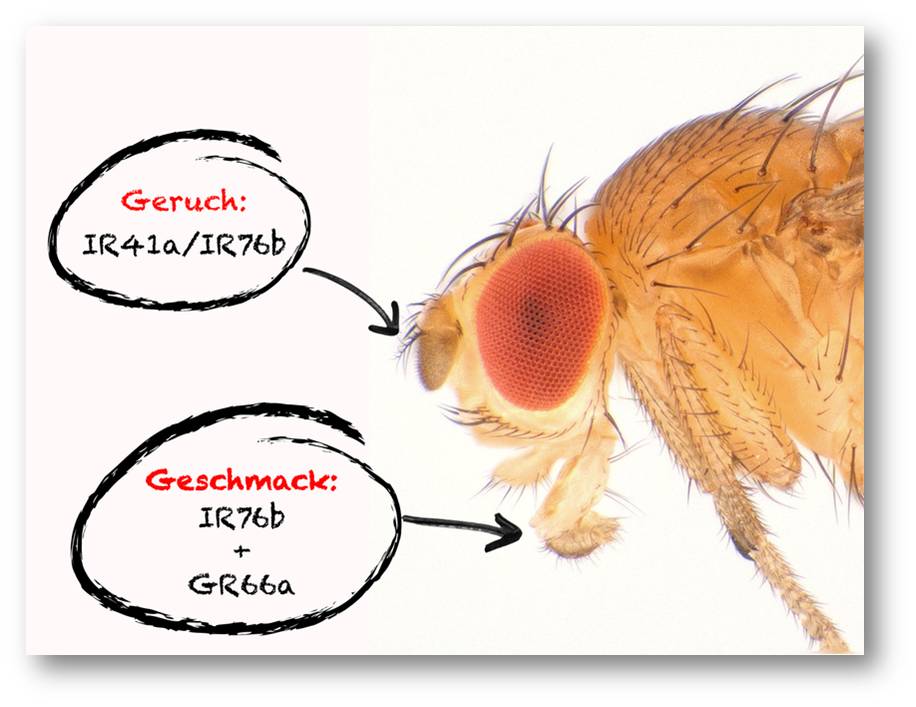

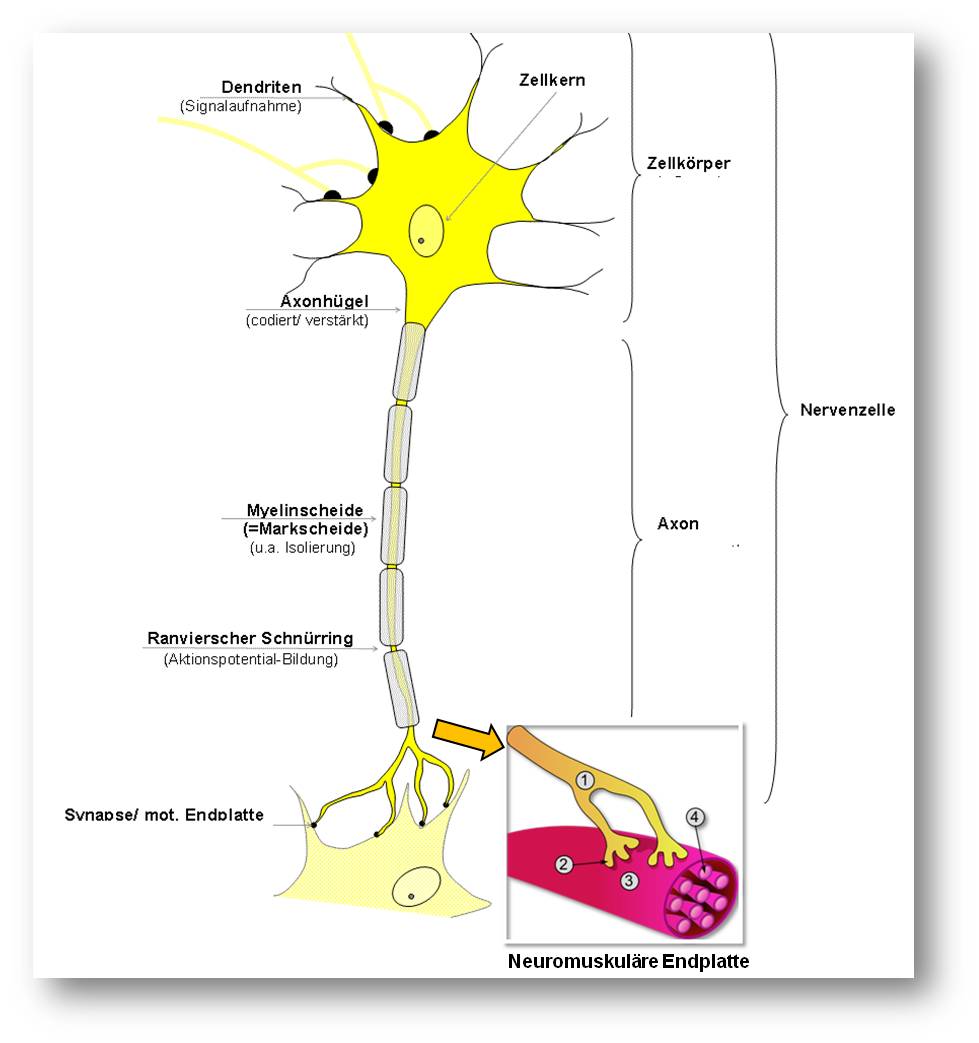

Stattdessen wurde der Mann offenbar durch eine seltene Variante eines anderen Gens, RELN, geschützt, das für das Protein Reelin kodiert. Dabei handelt es sich um ein gut untersuchtes Signalprotein, das bei verschiedenen neurologischen und psychiatrischen Erkrankungen wie Schizophrenie, bipolarer Störung und Autismus-Spektrum-Störung eine Rolle spielt.

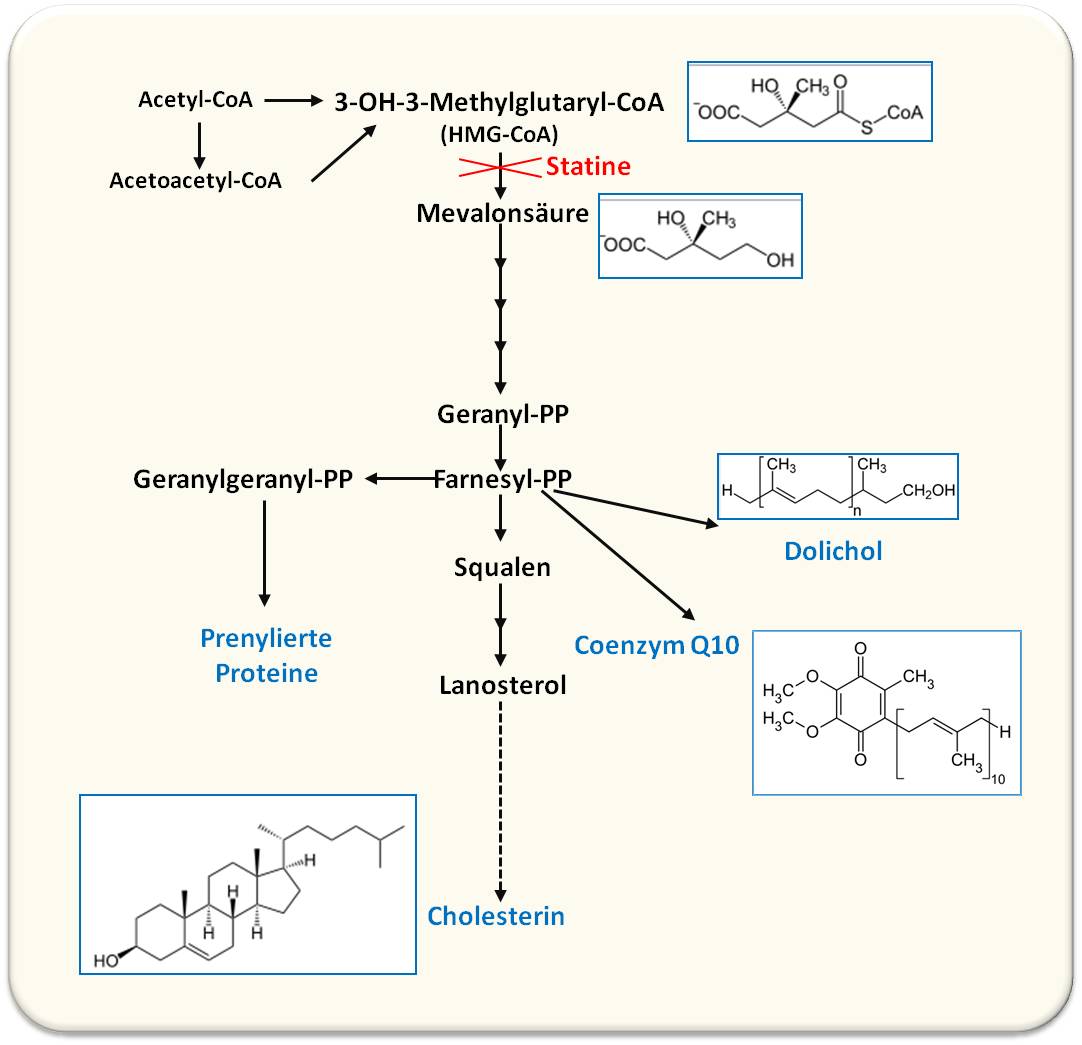

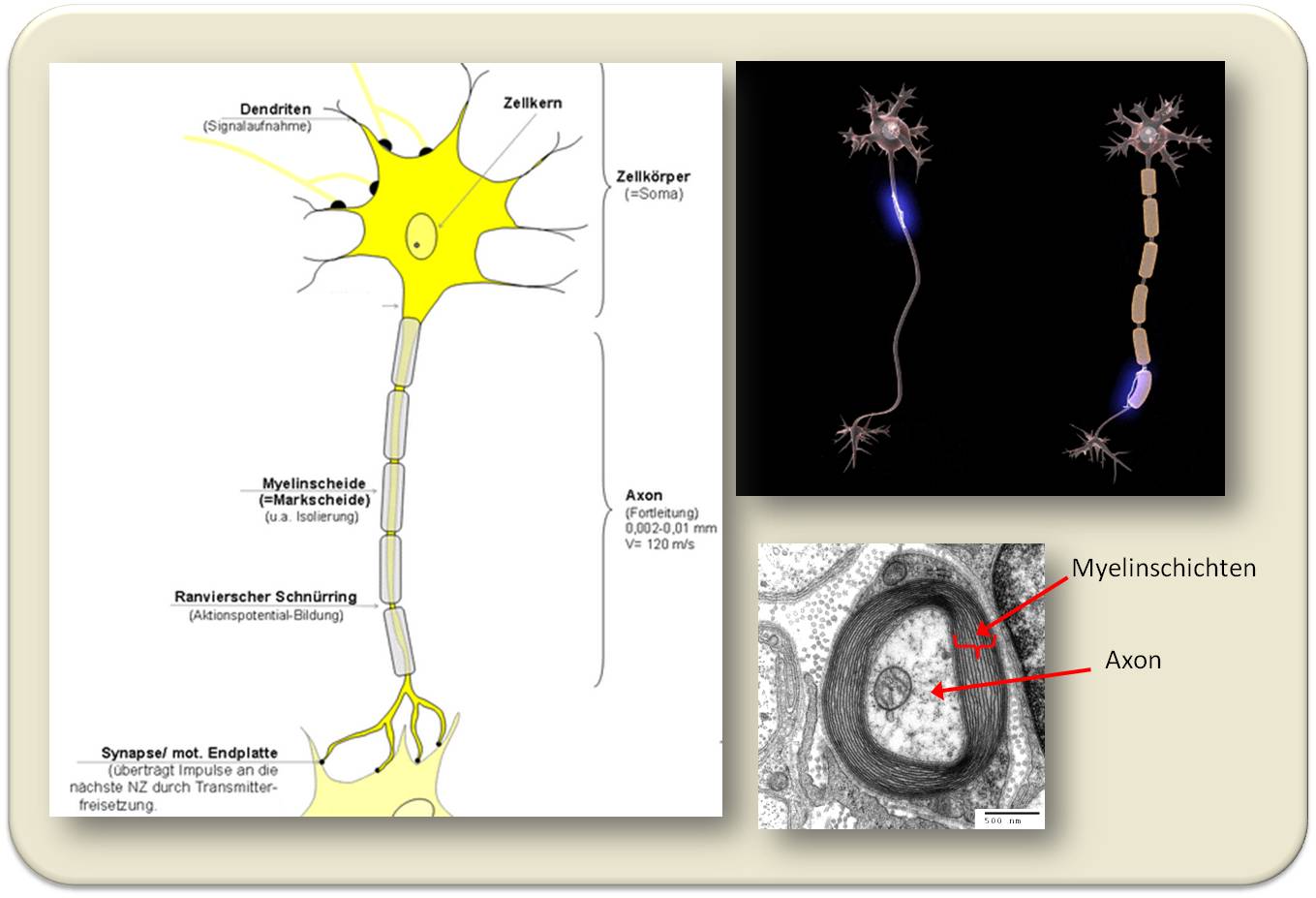

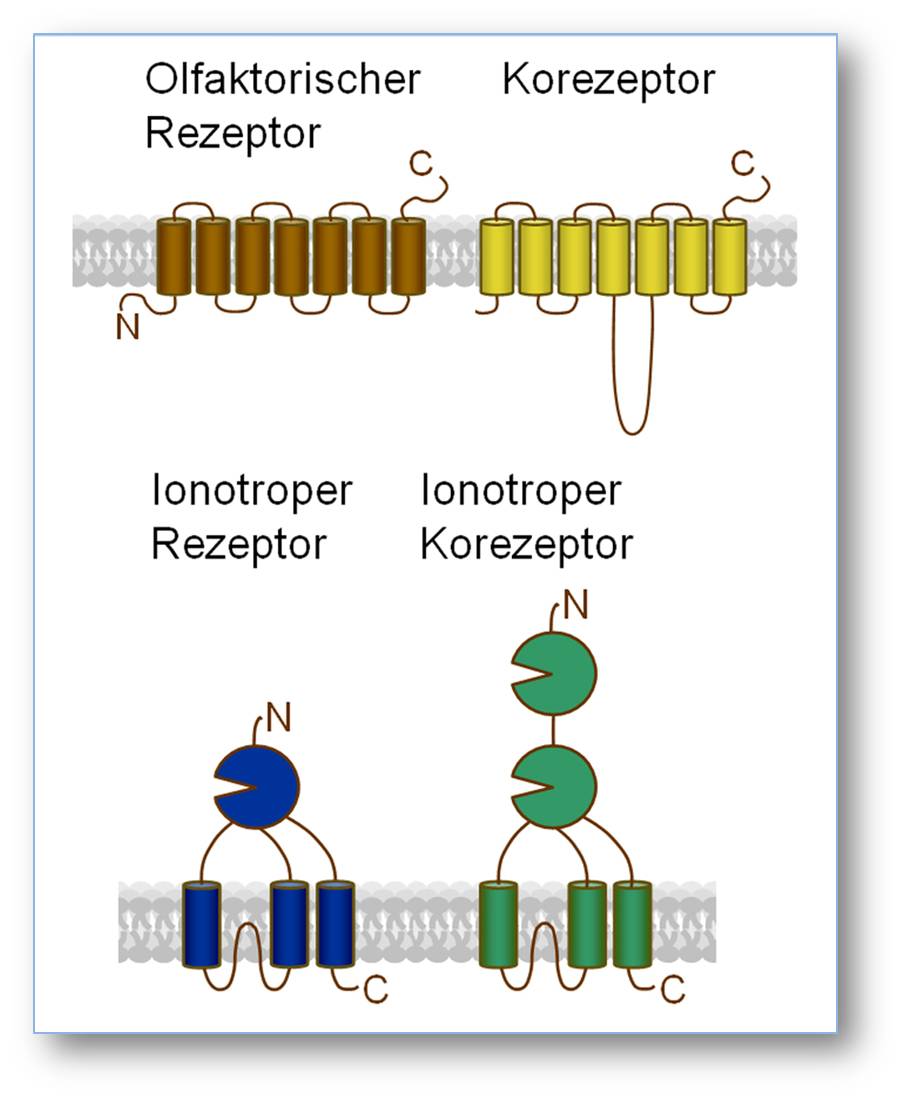

In Experimenten mit Mäusen zeigten die Forscher, dass diese Form von Reelin eine Gain-of-Function-Mutation ist, d.i. eine verbesserte Funktion im Vergleich zur häufigeren Variante des Gens besitzt. Wie Apolipoprotein E (APOE) bindet Reelin an Rezeptoren auf bestimmten Lipoproteinen, die Cholesterin transportieren. Dadurch wird die Aktivierung von Tau verringert, was offenbar das empfindliche Gleichgewicht zwischen Amyloid-Beta und Tau auf eine Weise stört, die die Alzheimer-Krankheit verlangsamt.

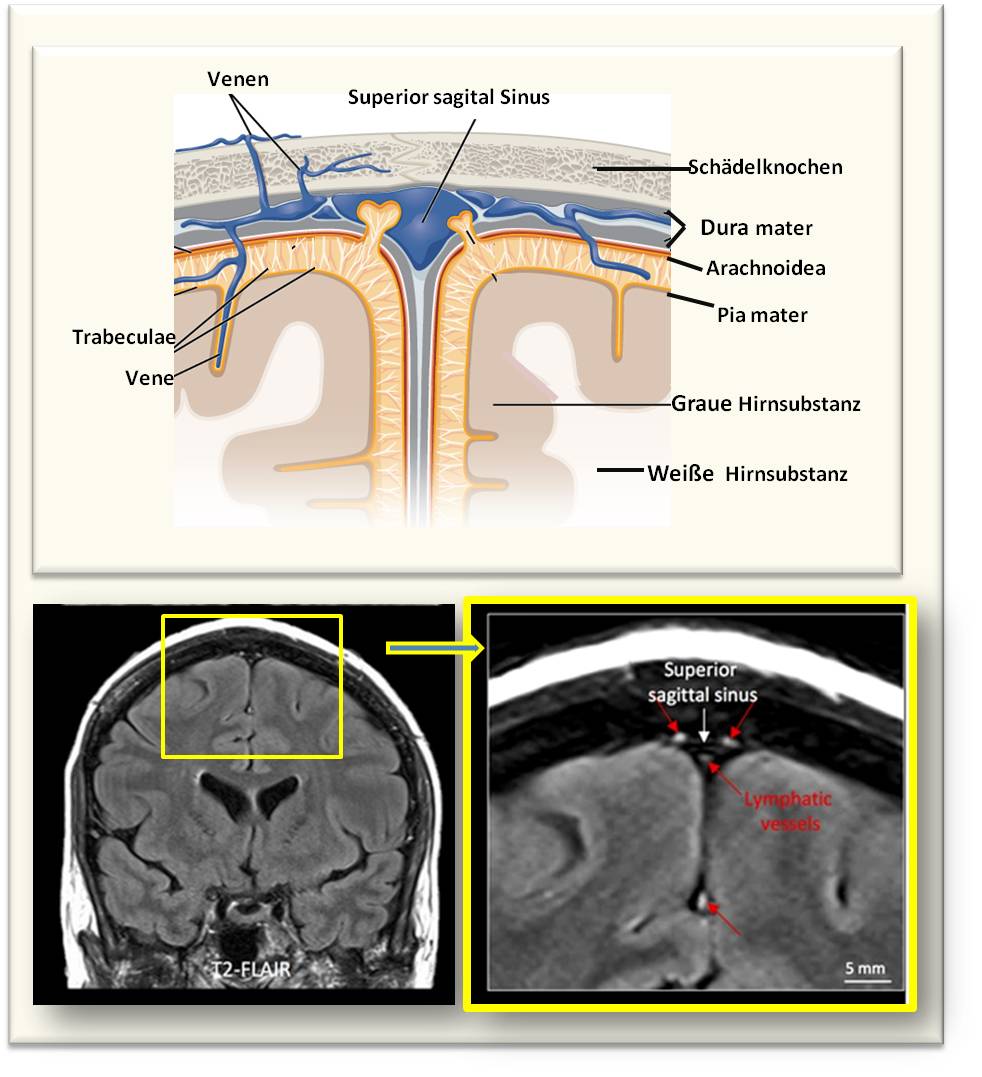

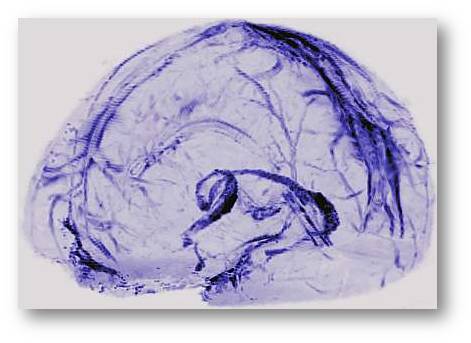

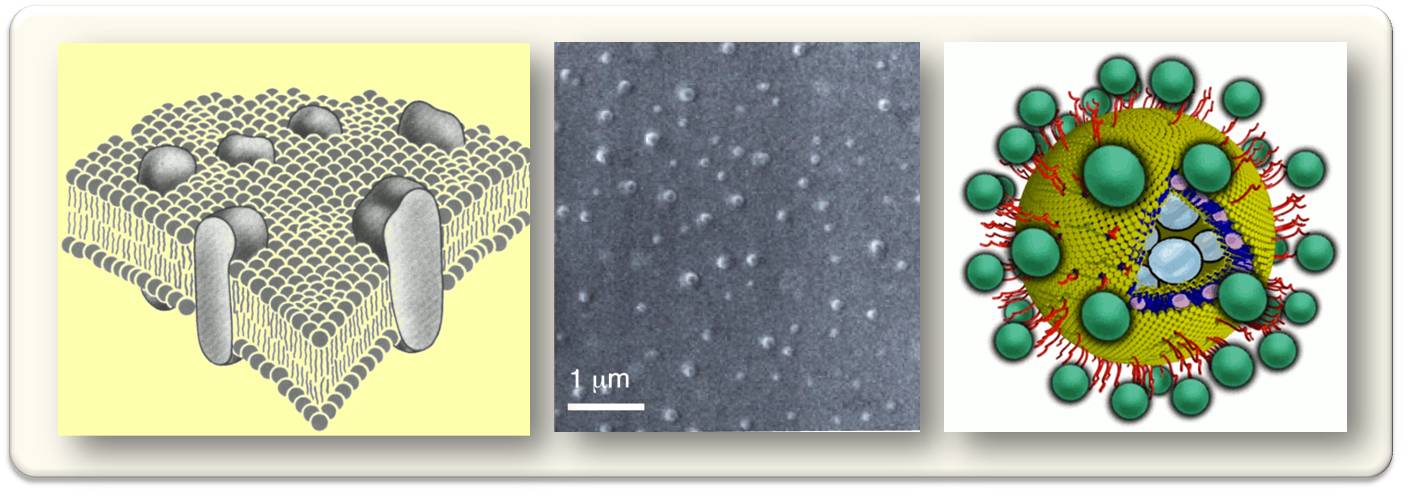

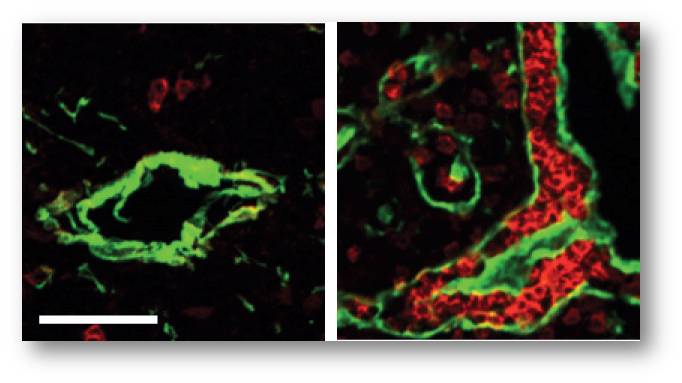

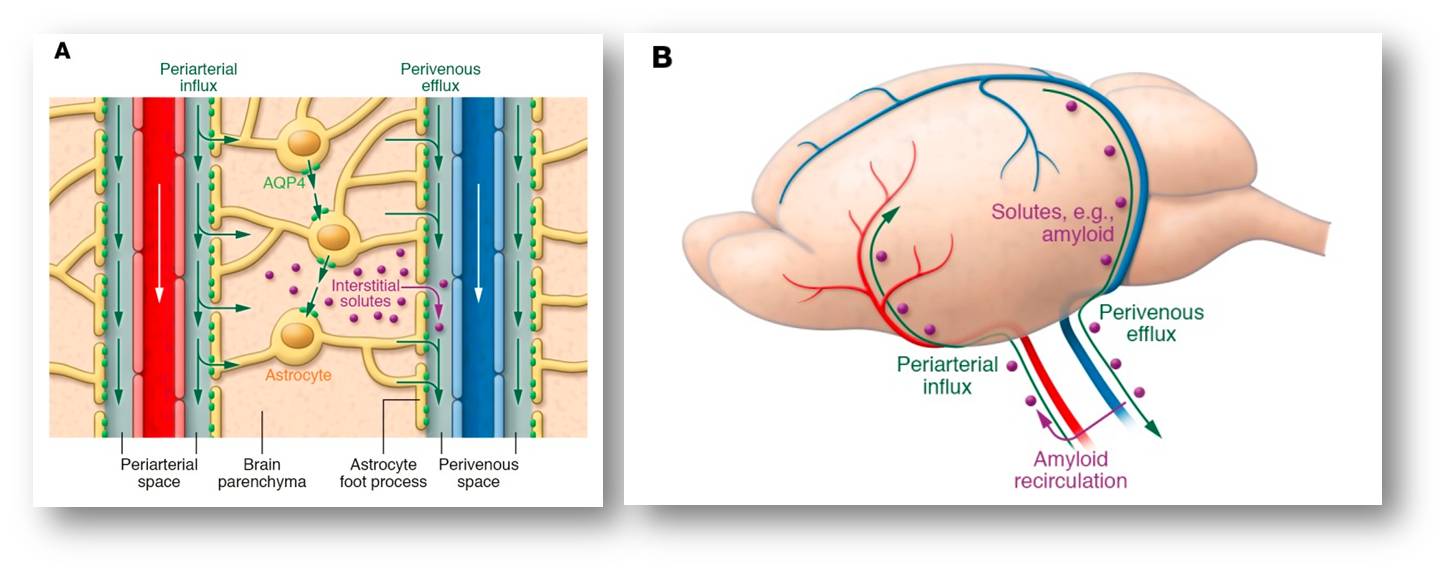

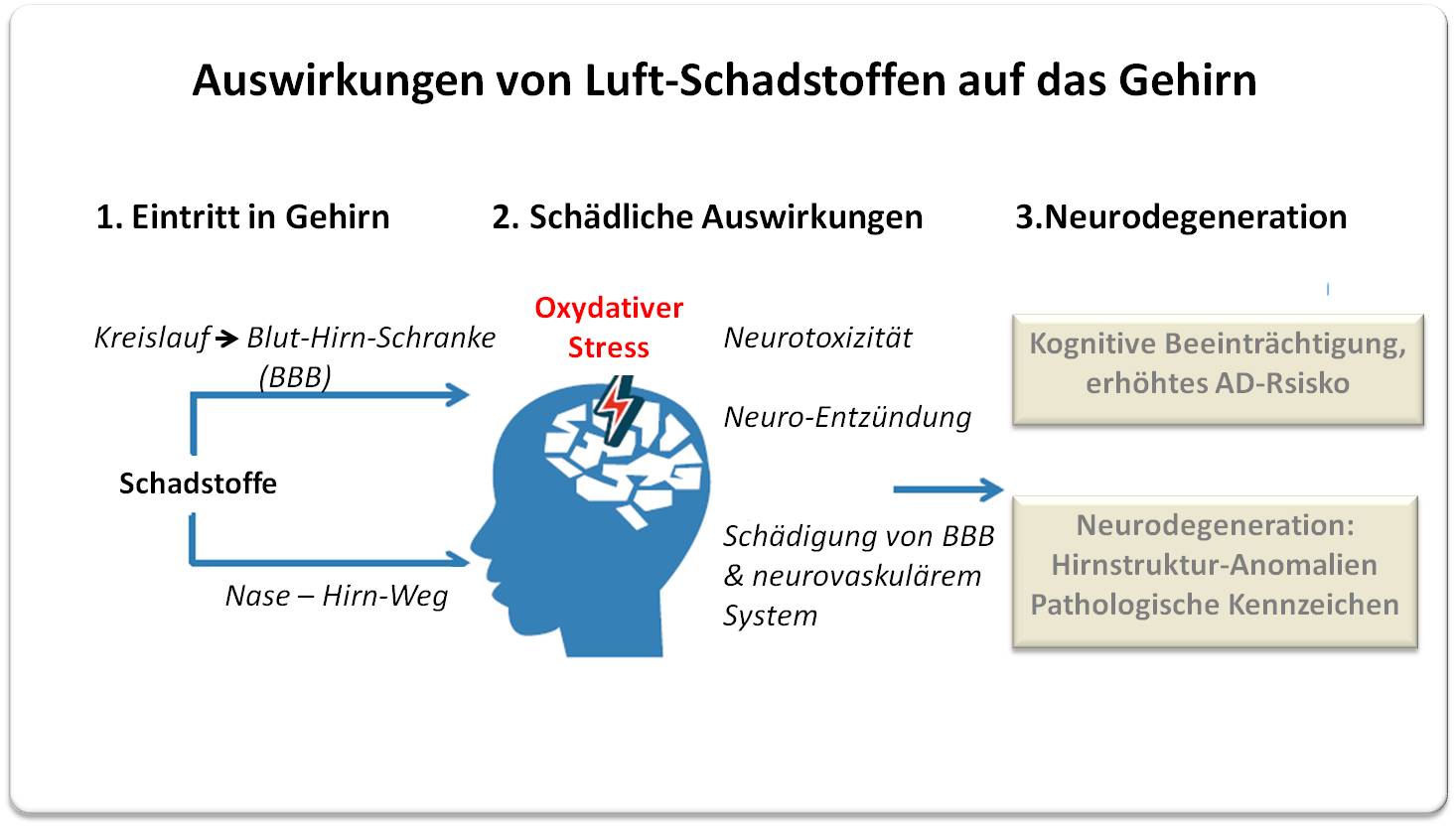

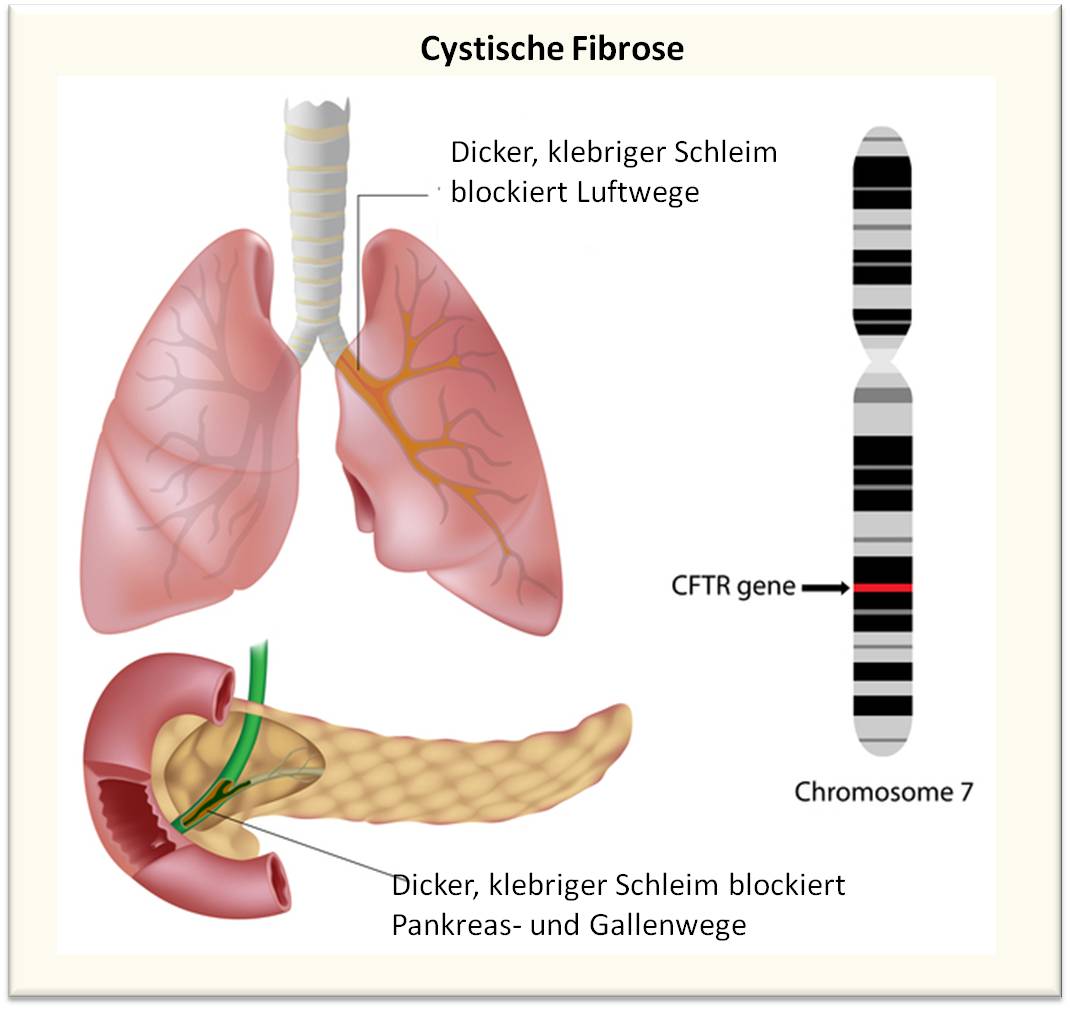

Gen Nr. 3: Veränderung von Fibronektin an der Blut-Hirn-Schranke

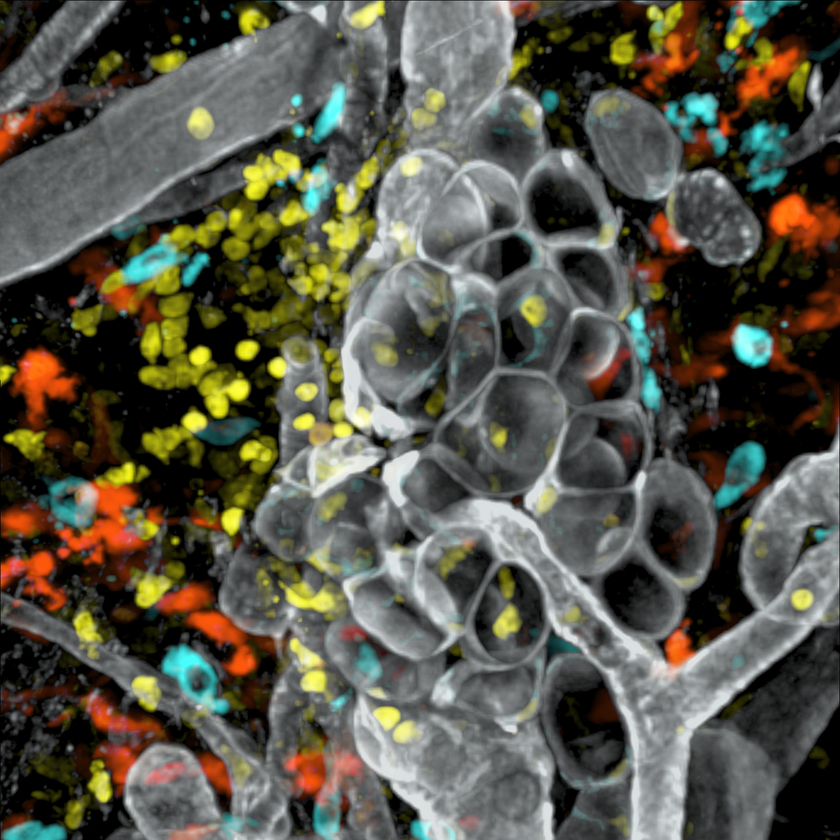

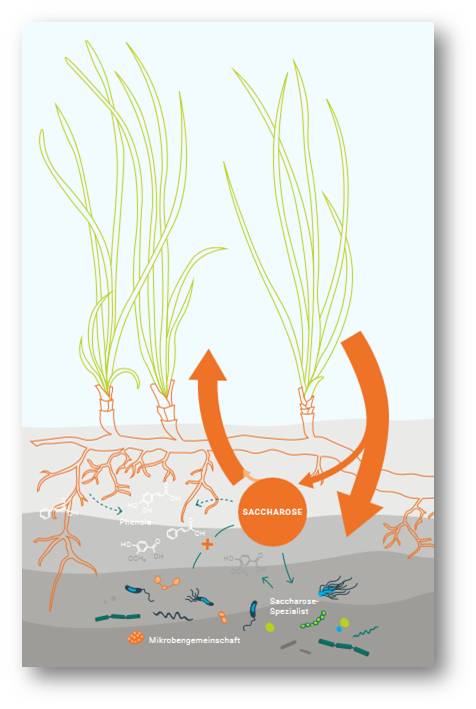

In jüngster Zeit haben sich Forscher der Columbia University auf eine andere, offenbar schützende Variante eins Gens konzentriert, das für das Protein Fibronektin kodiert. Es ist im gesunden Gehirn in nur sehr geringen Mengen vorhanden, eine hohe Konzentration wird aber mit einem erhöhten Risiko für die Entstehung von Alzheimer in Verbindung gebracht.

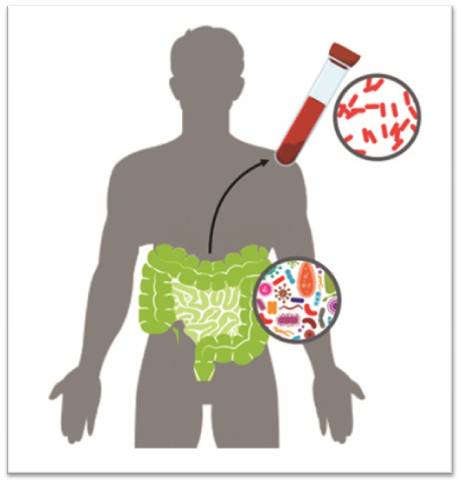

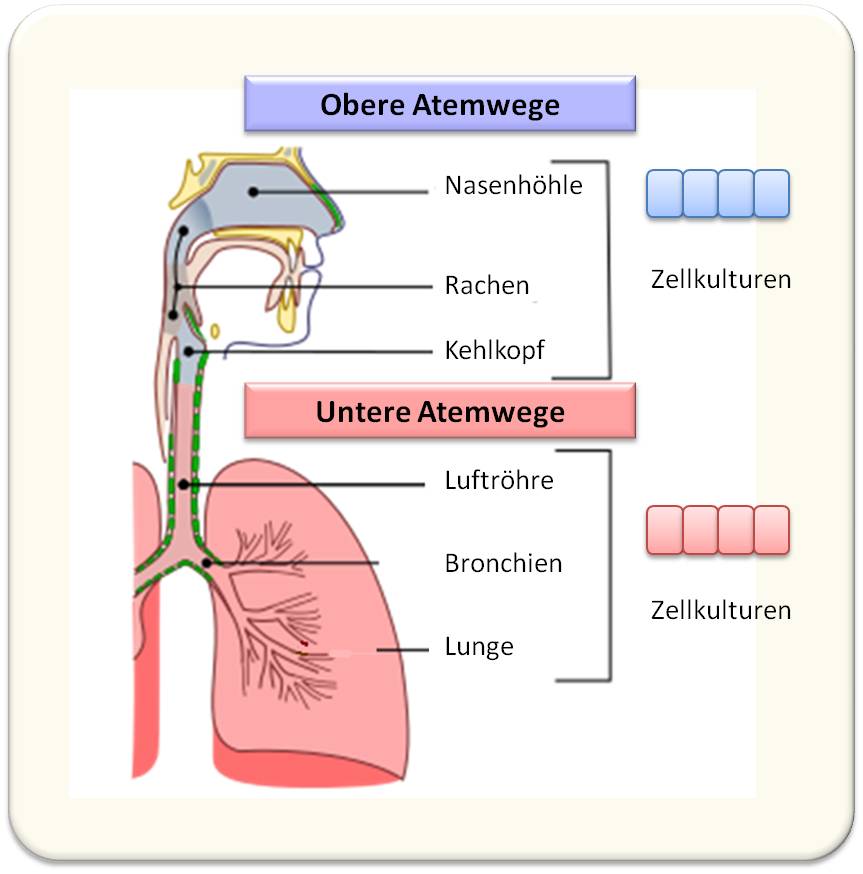

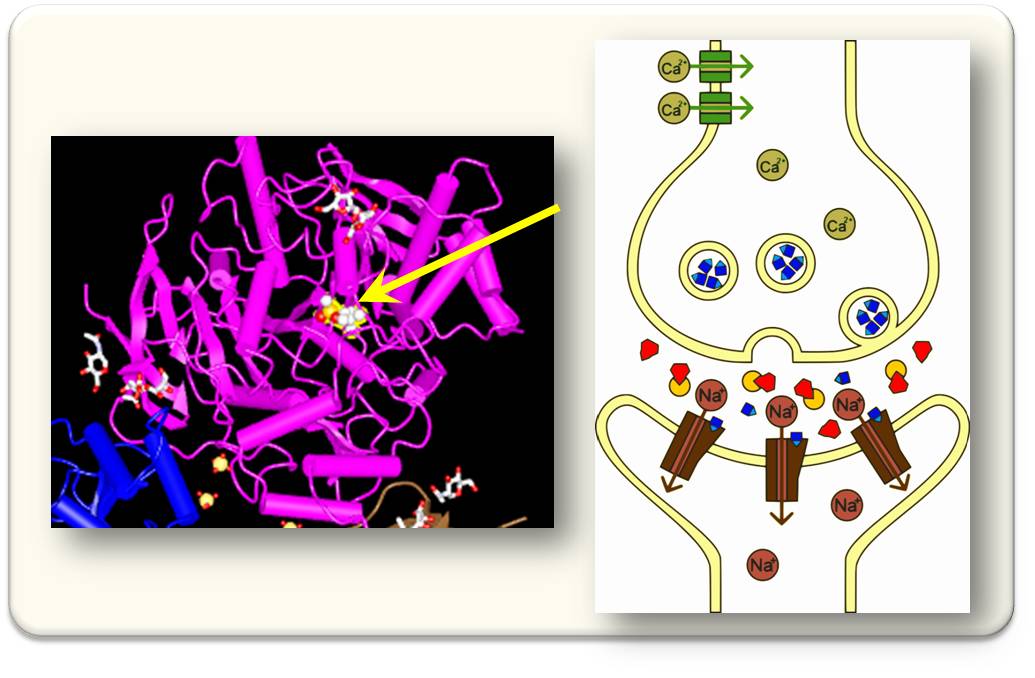

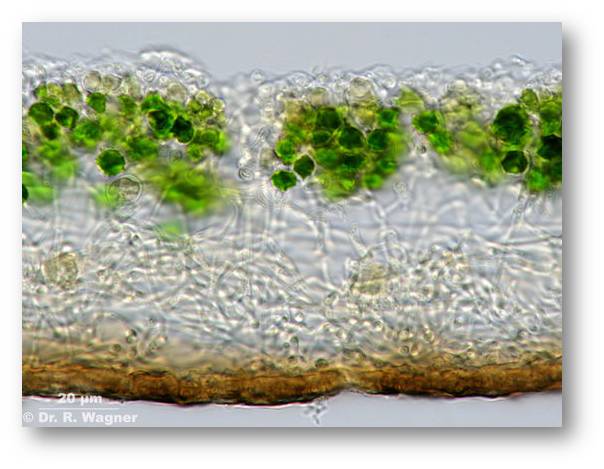

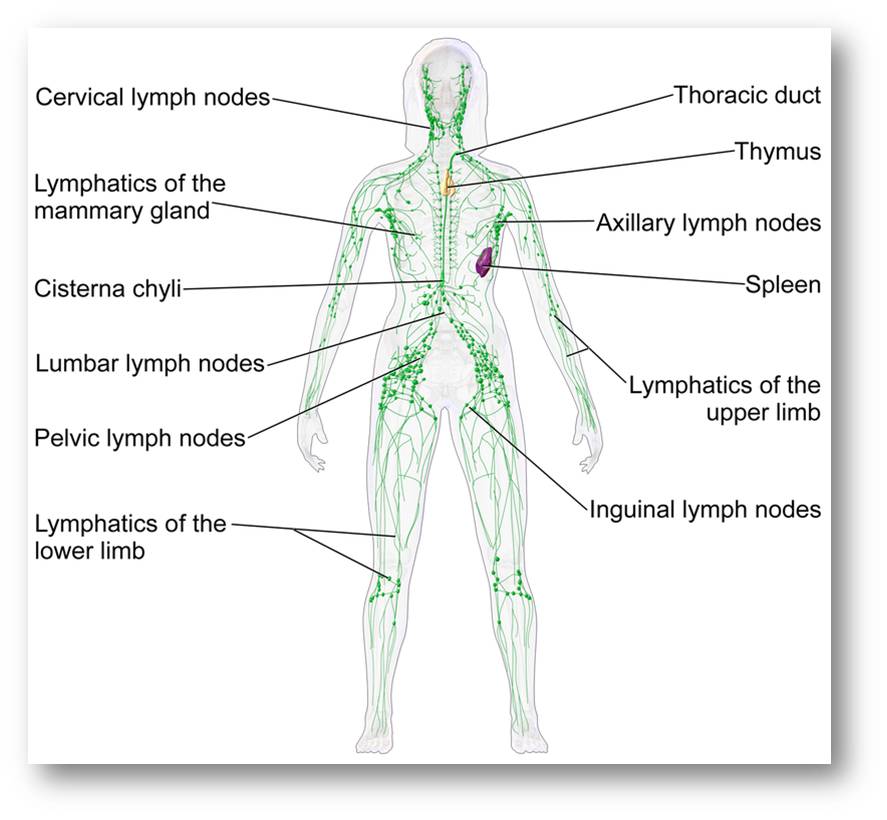

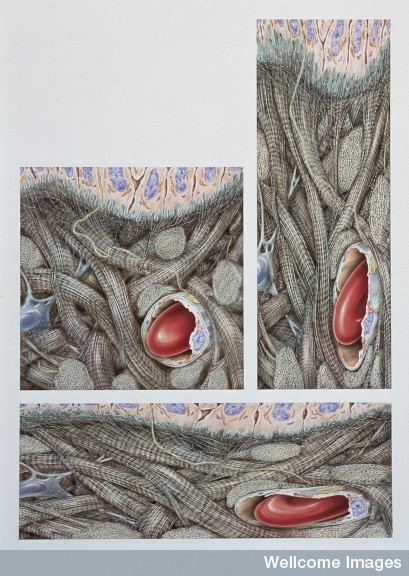

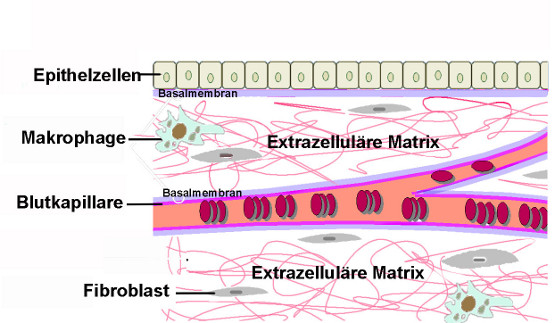

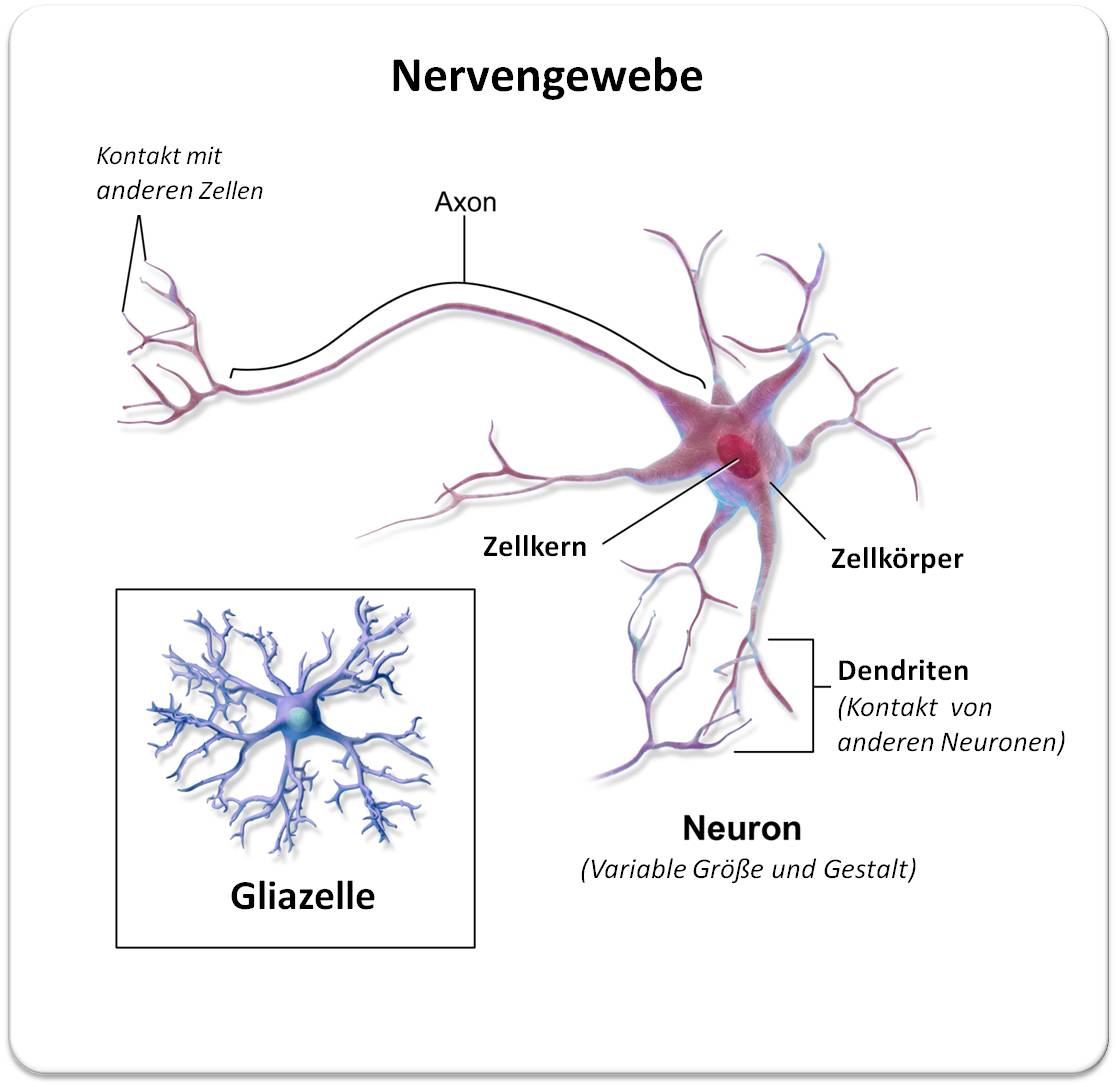

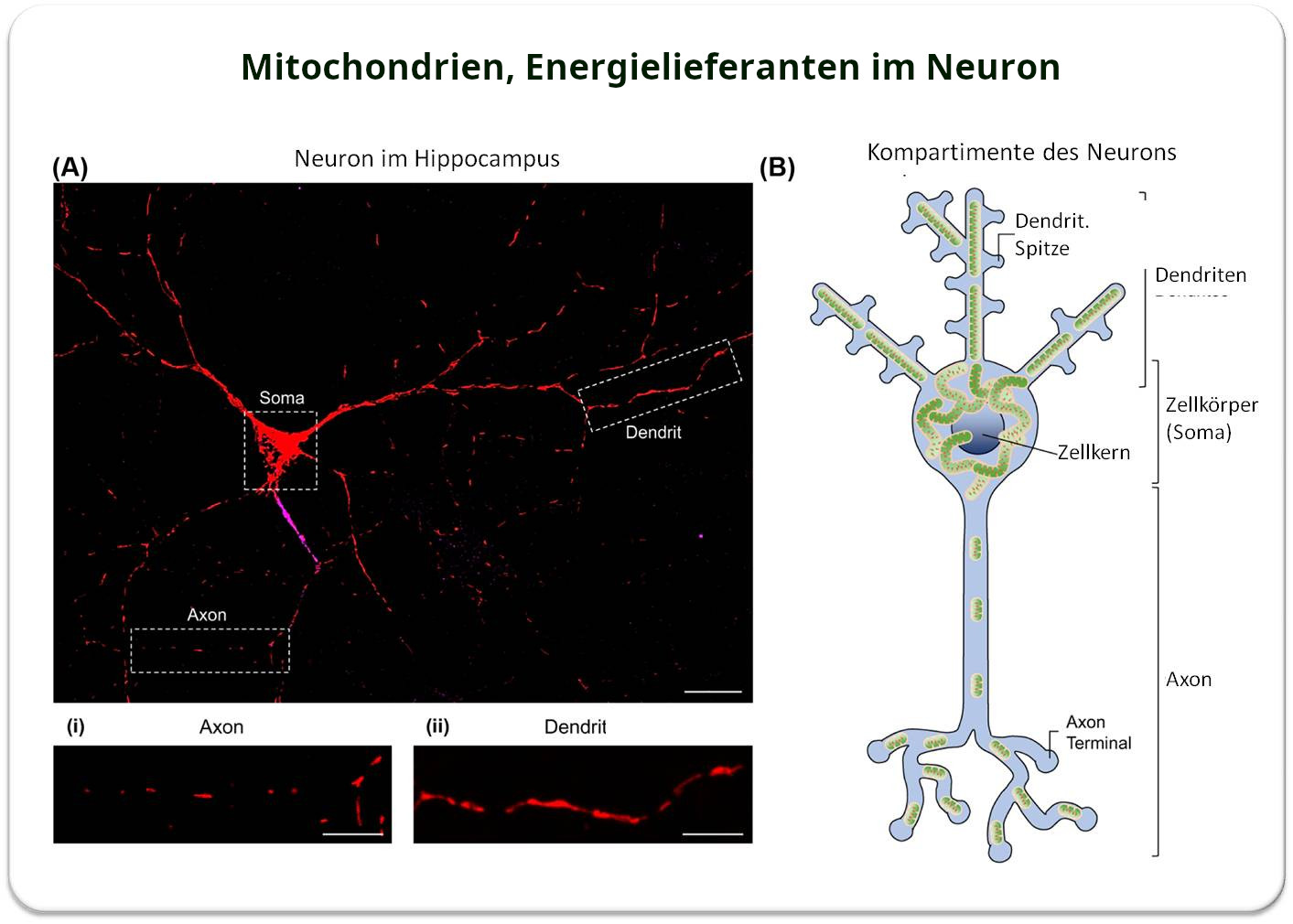

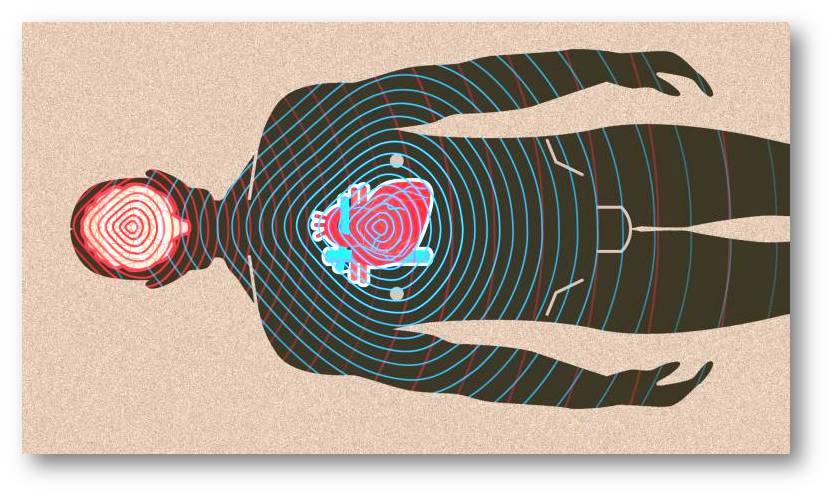

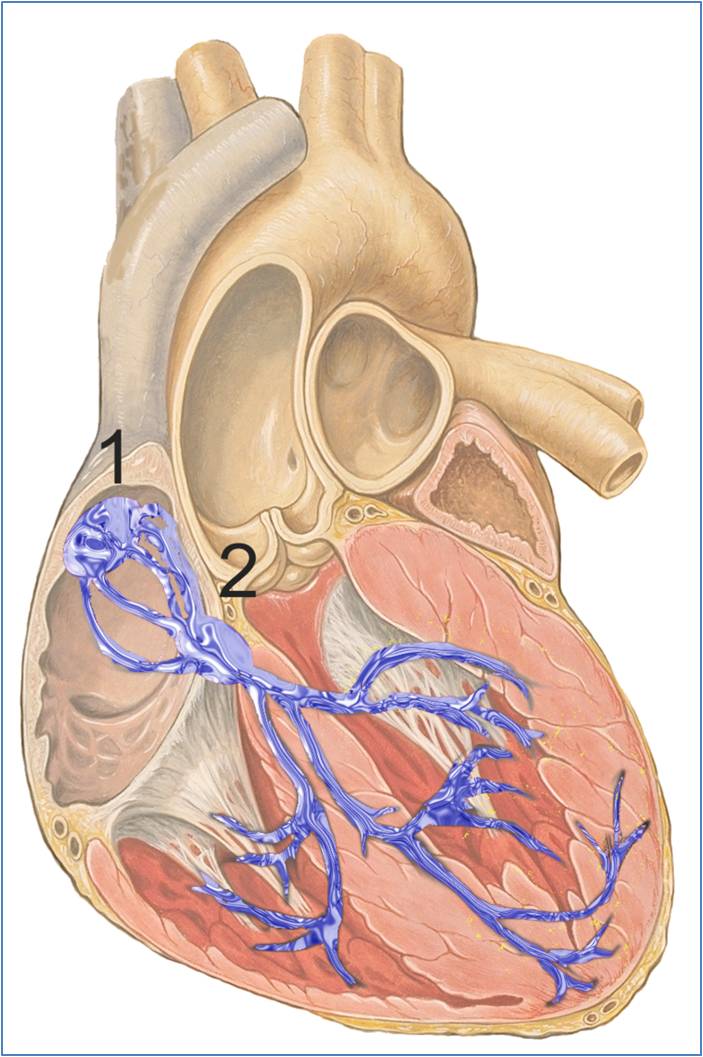

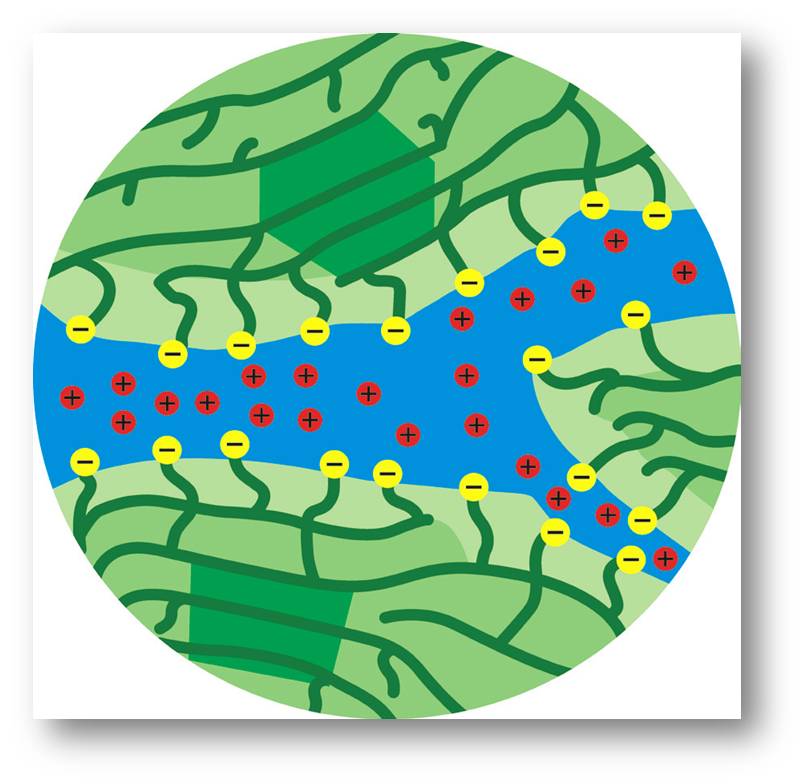

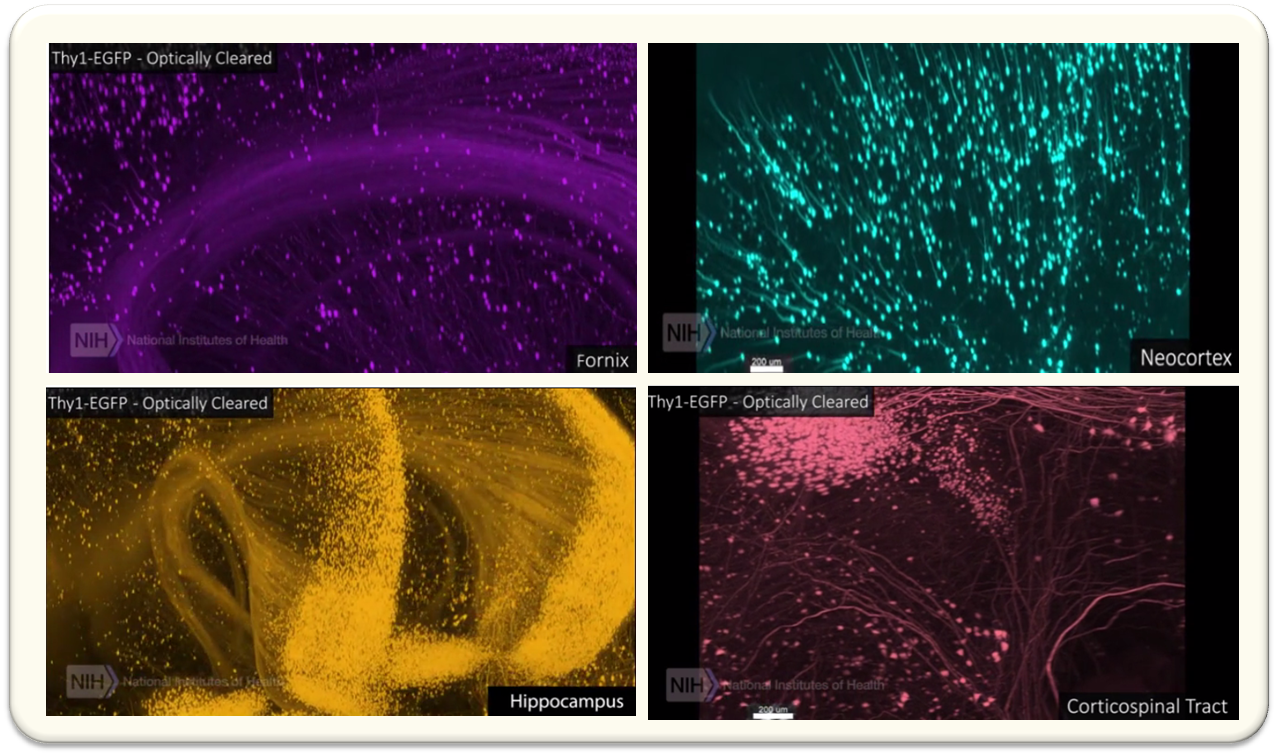

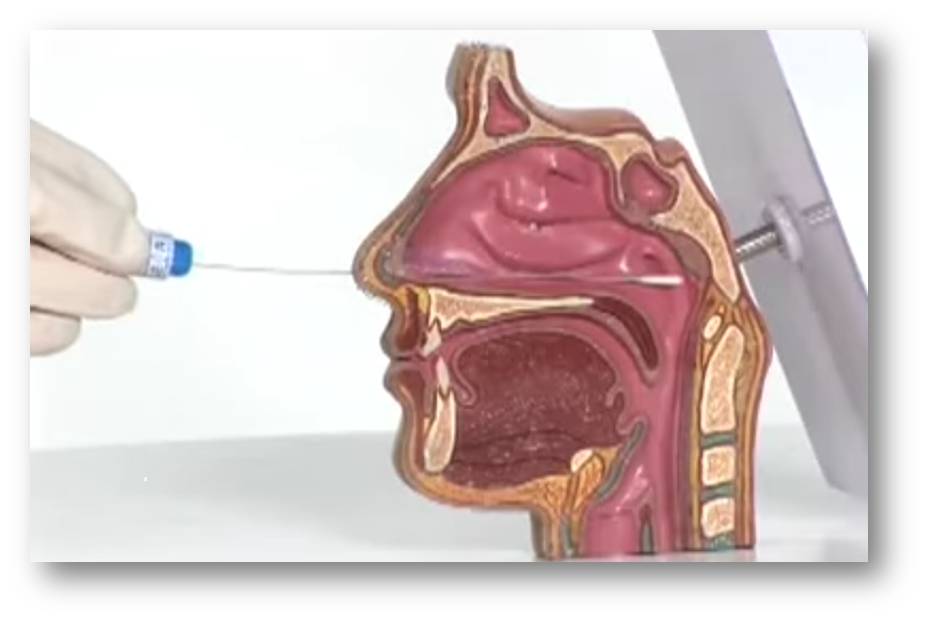

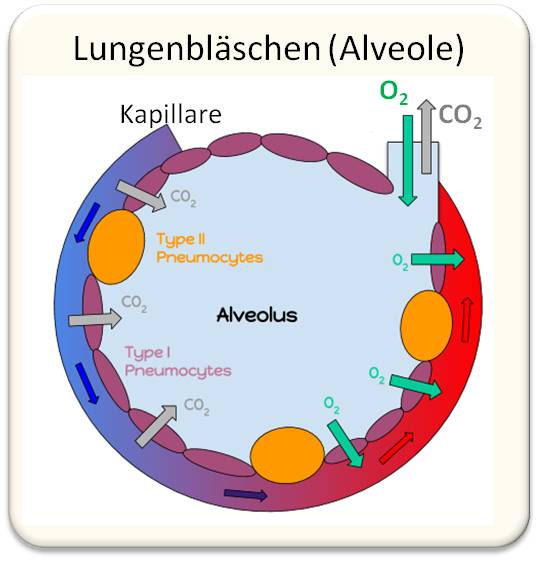

Fibronektin ist in die Blut-Hirn-Schranke eingebettet. Dieses 400 Meilen lange Labyrinth aus Kapillaren, den kleinsten Blutgefäßen, windet sich durch die Neuronen und Gliazellen, die die empfindliche Hirnsubstanz bilden.

Die aus einer einzelnen Zellschichte bestehenden Kapillarwände, das so genannte Endothel, bilden eine Auskleidung, die normalerweise so dicht gepackt ist, dass sie Giftstoffe aus dem Blutkreislauf fernhält, aber lebenswichtige Stoffe wie Sauerstoff ins Gehirn eintreten lässt. Die Schranke mildert auch biochemische Fluktuationen, die das Gehirn überfordern würden, wenn es ständig reagieren müsste, und überwacht den Gehalt an Neurotransmittern.

Zu verstehen, wie die Blut-Hirn-Schranke funktioniert, ist zentrales Thema der Arzneimittel-Forschung bei neurologischen Erkrankungen.

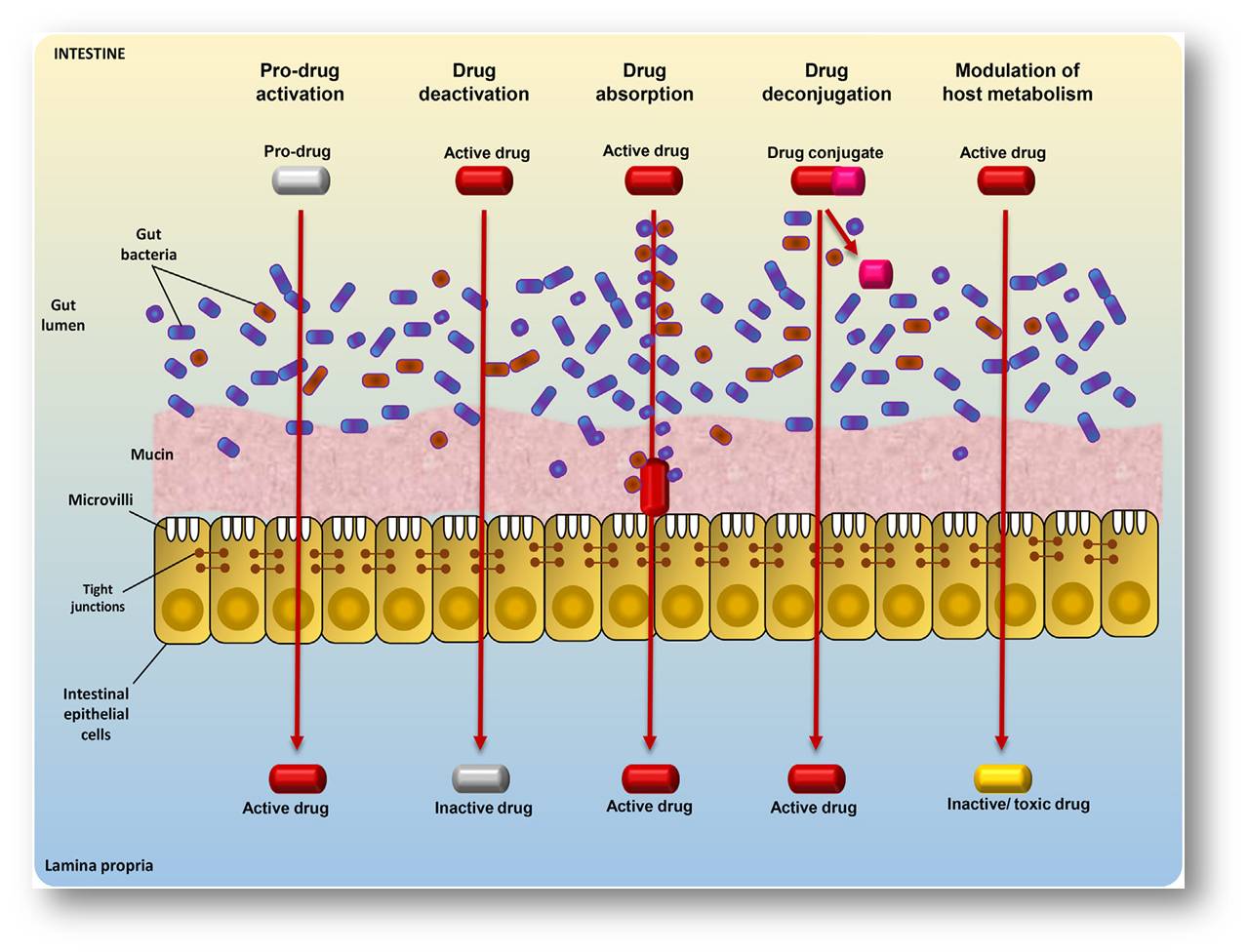

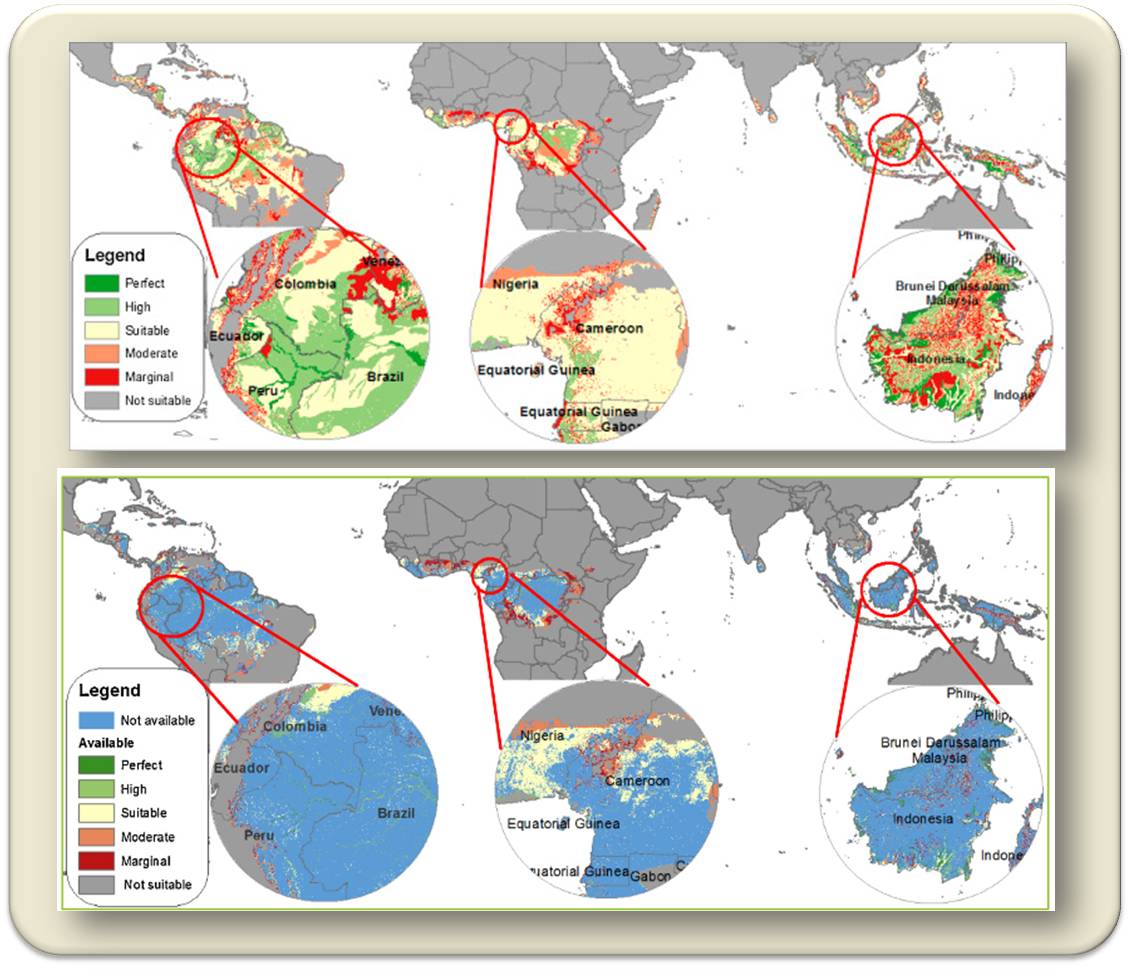

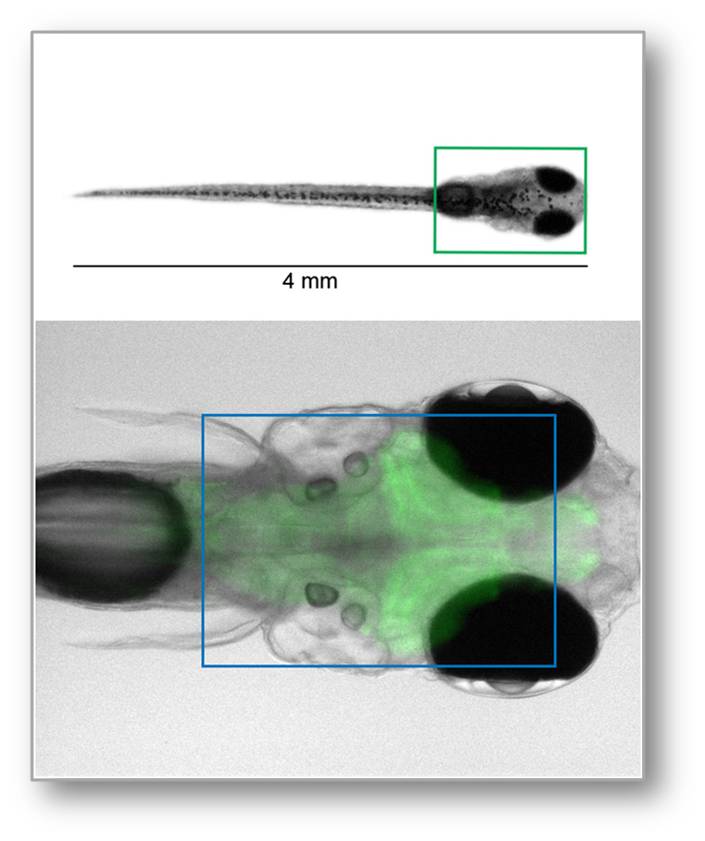

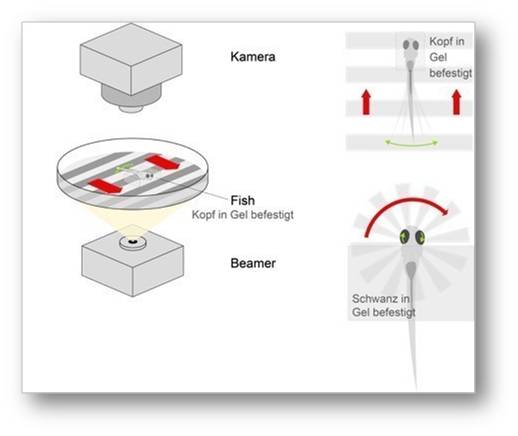

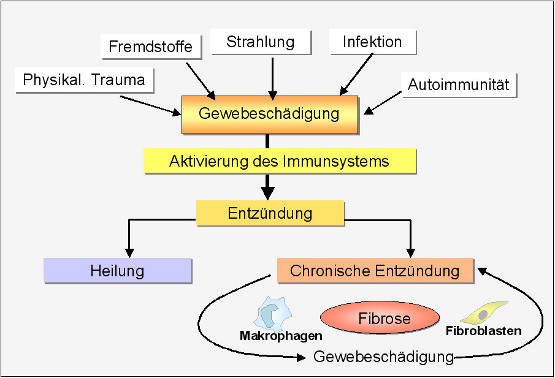

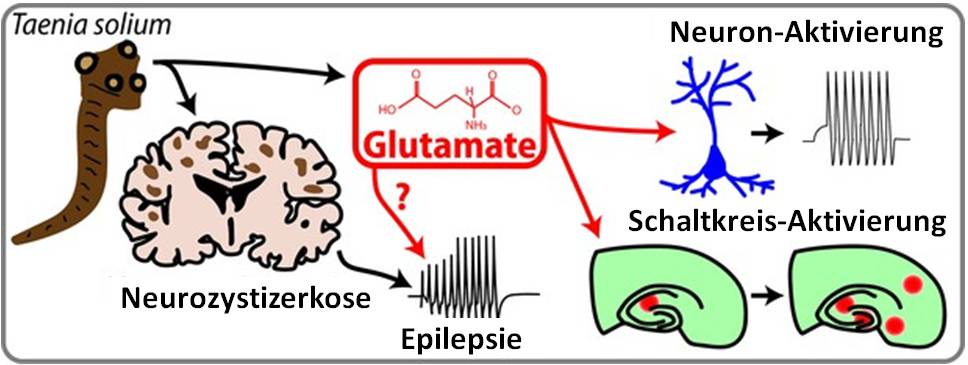

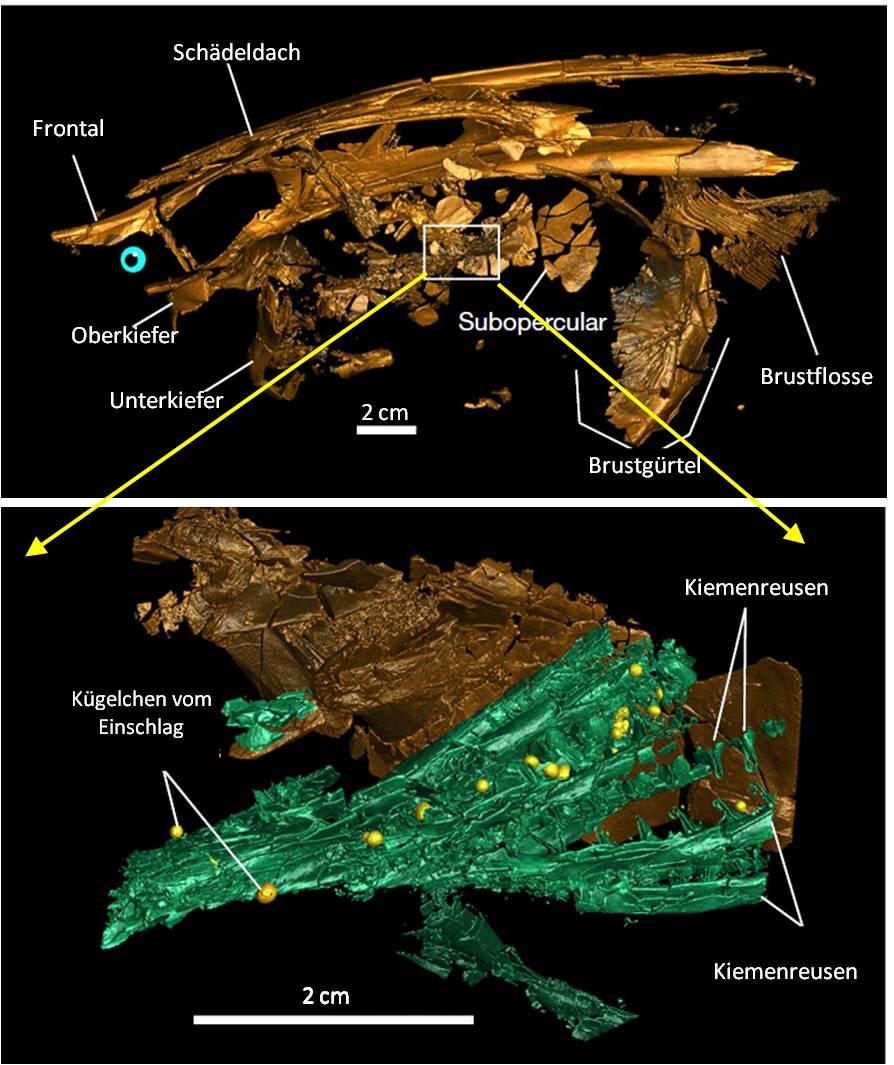

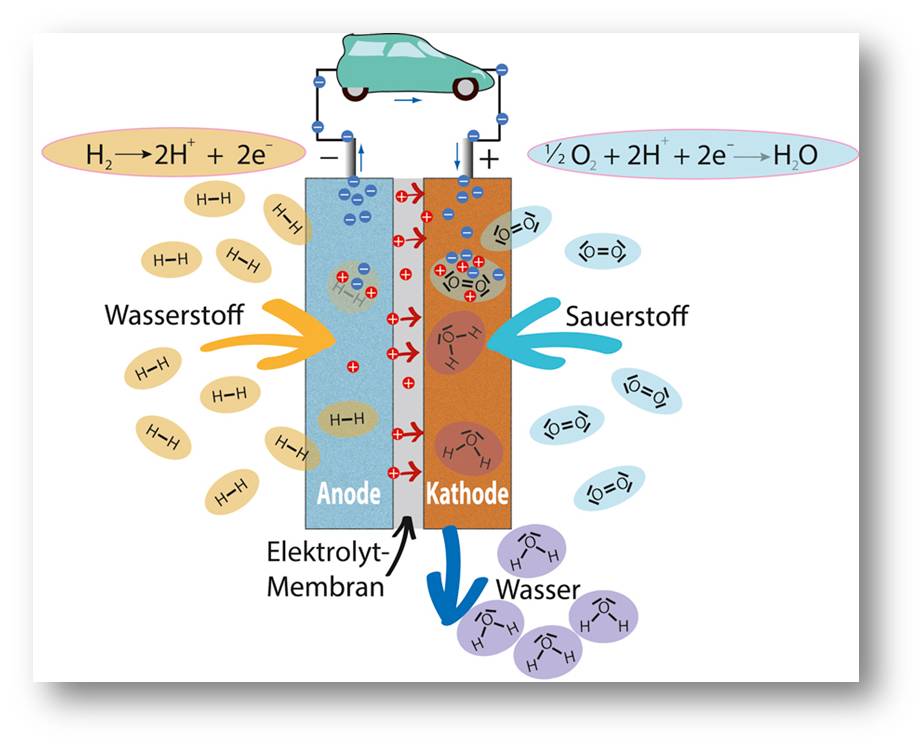

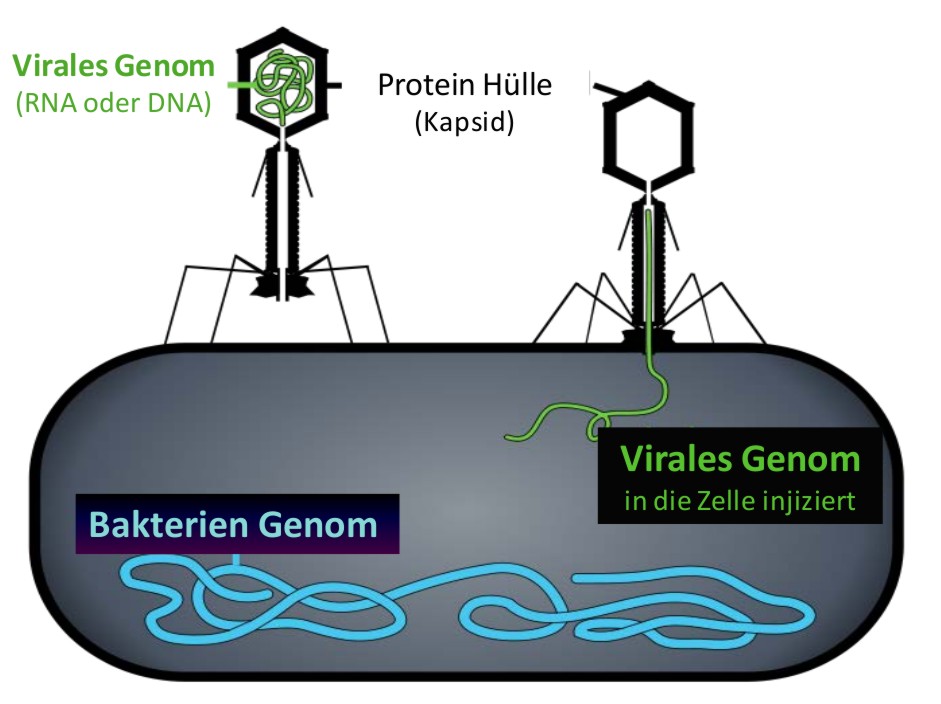

Aus Untersuchungen an Zebrafischen und Mausmodellen der Alzheimer-Krankheit haben die Forscher entdeckt, dass eine Variante des Fibronektin-Gens die Anhäufung von Fibronektin an der Blut-Hirn-Schranke verhindert. Überschüssiges Amyloid-Beta kann dann aus dem Gehirn in den Blutkreislauf eintreten, was das Risiko, an Alzheimer zu erkranken, verringert, so die Forscher. Ihre Forschungsergebnisse sind in Acta Neuropathologica [4] veröffentlicht.

Caghan Kizil, PhD, erklärt die Ergebnisse: "Die Alzheimer-Krankheit beginnt zwar mit Amyloid-Ablagerungen im Gehirn, aber die Krankheitsmanifestationen sind das Ergebnis von Veränderungen, die nach dem Auftreten der Ablagerungen stattfinden. Überschüssiges Fibronektin könnte die Beseitigung von Amyloidablagerungen im Gehirn verhindern. Unsere Ergebnisse deuten darauf hin, dass einige dieser Veränderungen in den Blutgefäßen des Gehirns stattfinden und dass wir in der Lage sein könnten, neue Arten von Therapien zu entwickeln, die die schützende Wirkung des Gens nachahmen, um die Krankheit zu verhindern oder zu behandeln."

Diese Strategie unterscheidet sich von einem direkten Angriff auf die Amyloid-Ablagerungen und einer verbesserten Beseitigung, die zu gering ausfallen und zu spät kommen dürften. "Wir müssen möglicherweise viel früher mit der Beseitigung von Amyloid beginnen, und wir glauben, dass dies über den Blutkreislauf geschehen kann. Deshalb freuen wir uns über die Entdeckung dieser Fibronektin-Variante, die ein gutes Target für die Entwicklung von Medikamenten sein könnte", so Richard Mayeux, Koautor der Studie.

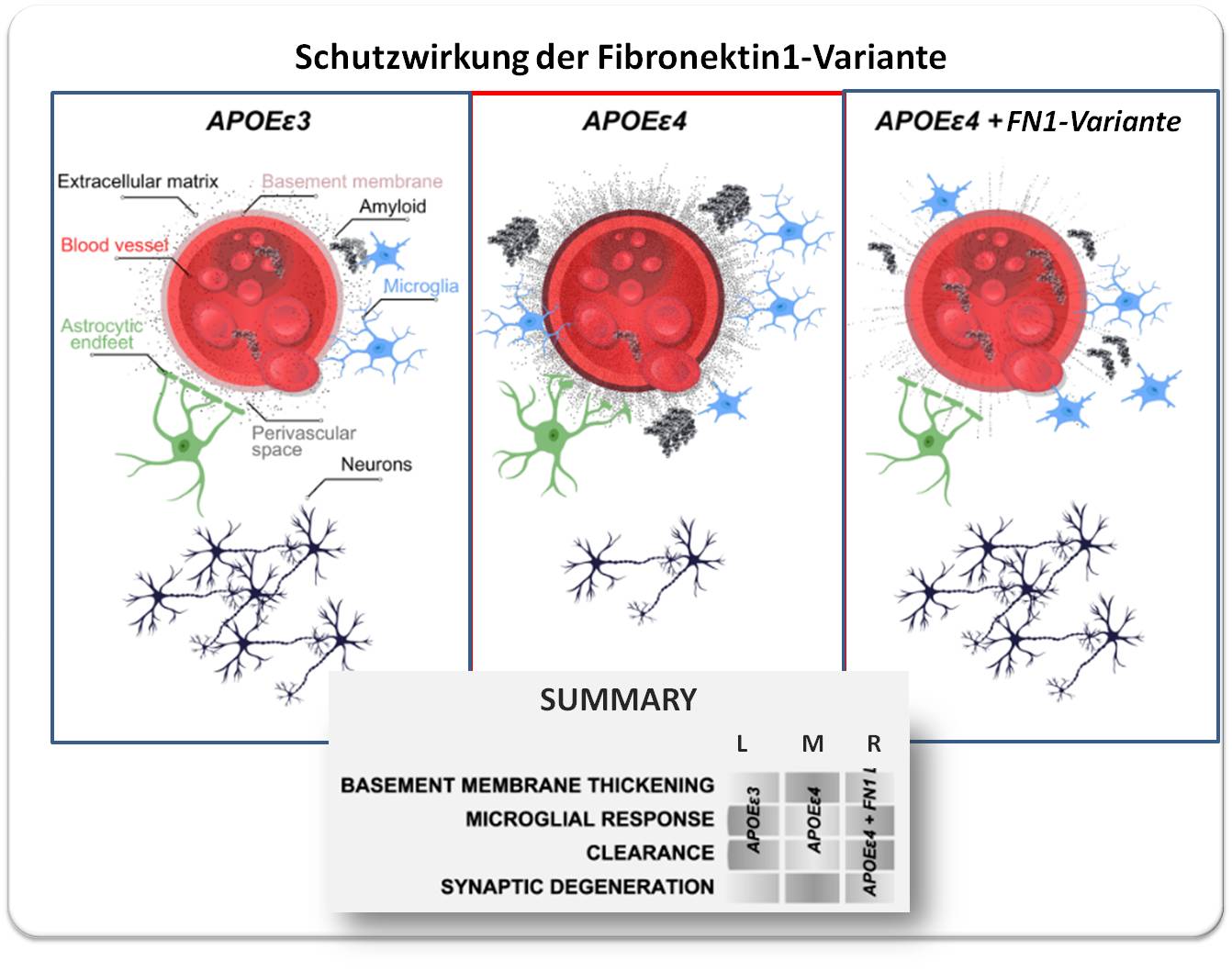

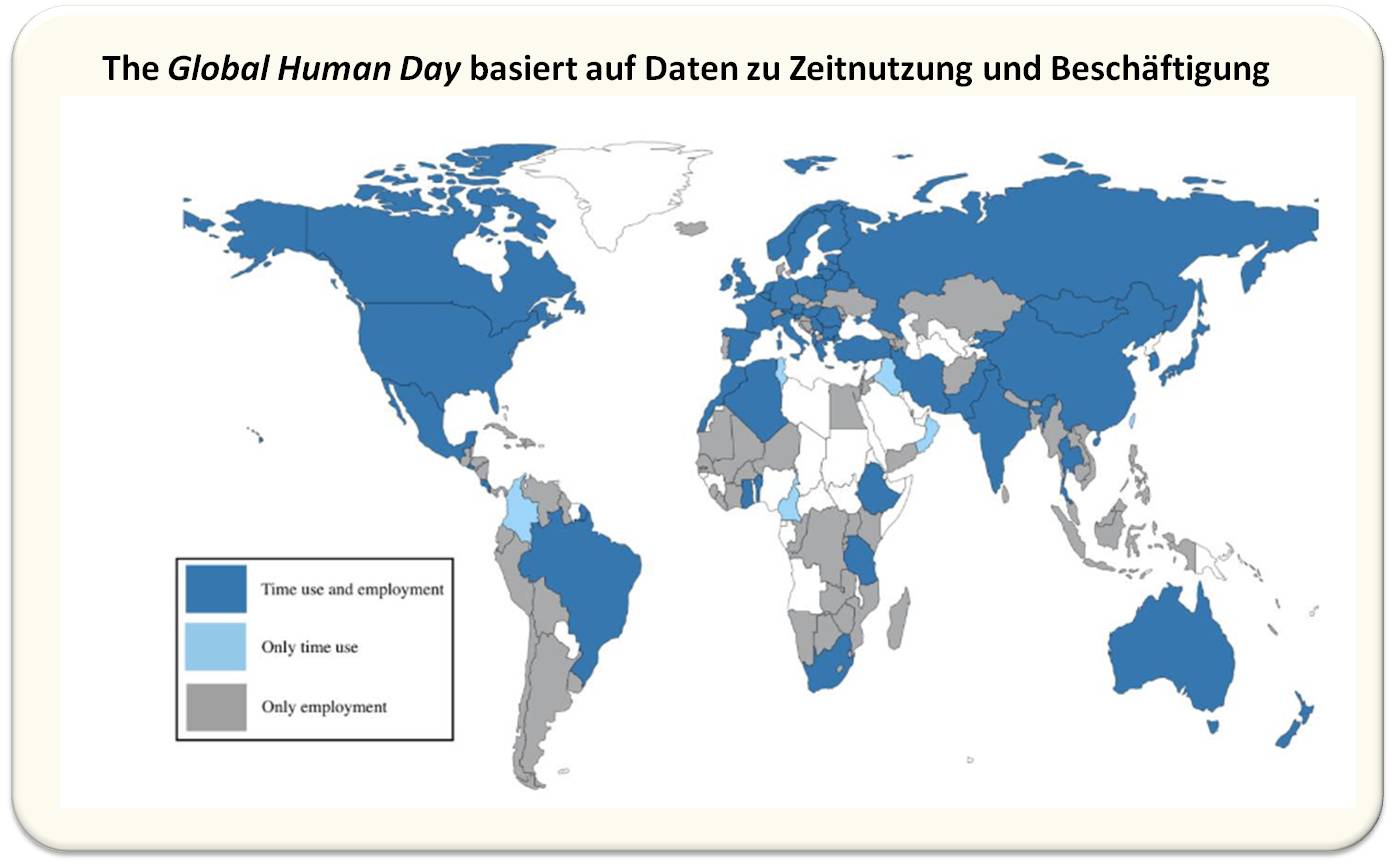

Nachdem die Forscher die Folgen einer Senkung des Fibronektins in Zebrafischen und Mäusen nachgewiesen hatten, haben sie das Protein bei Menschen untersucht, die eine Variante des APOE-Gens, das mit Alzheimer assoziierte APOEε4 geerbt haben, aber lange leben. Hat eine Variante des Fibronektin-Gens sie geschützt?

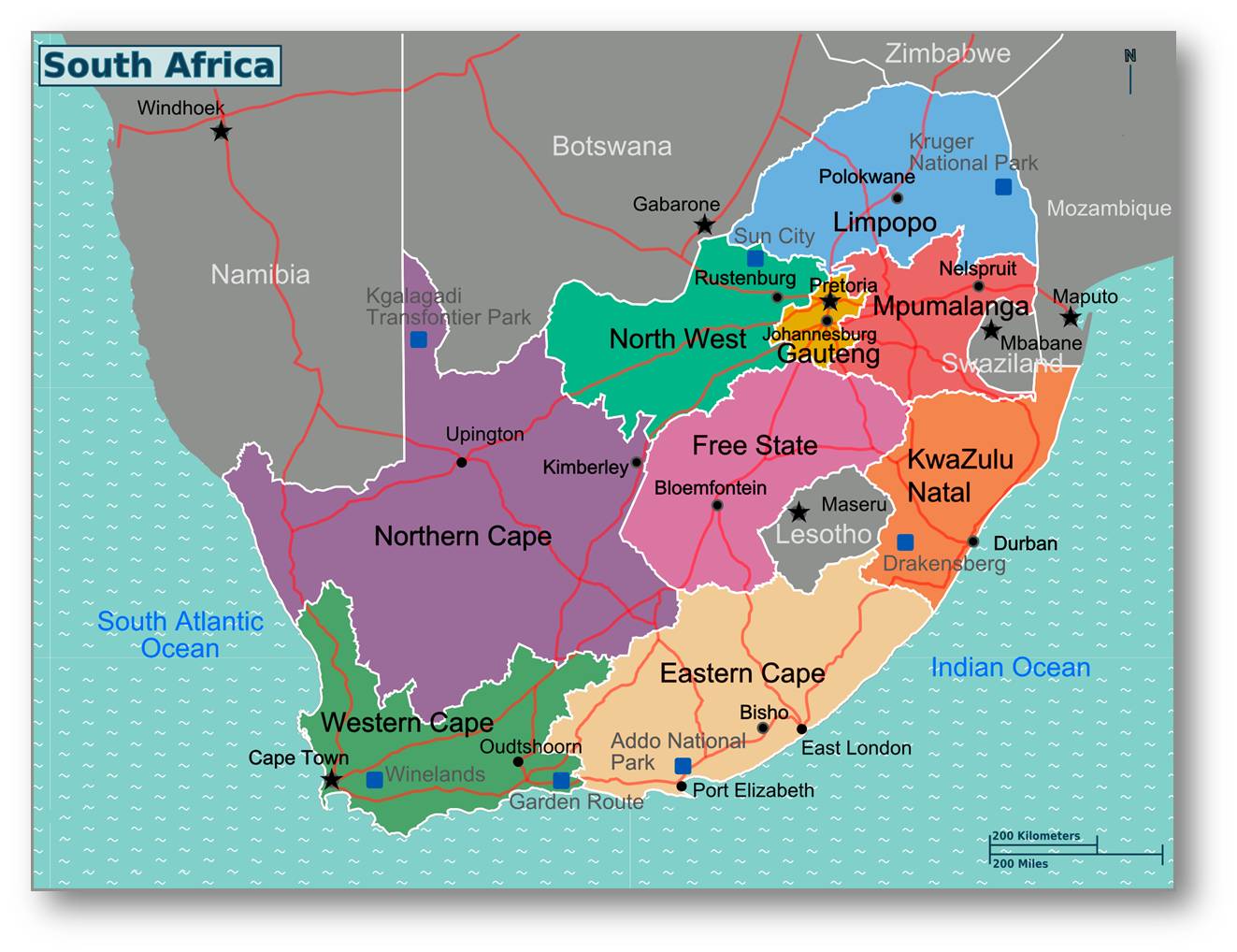

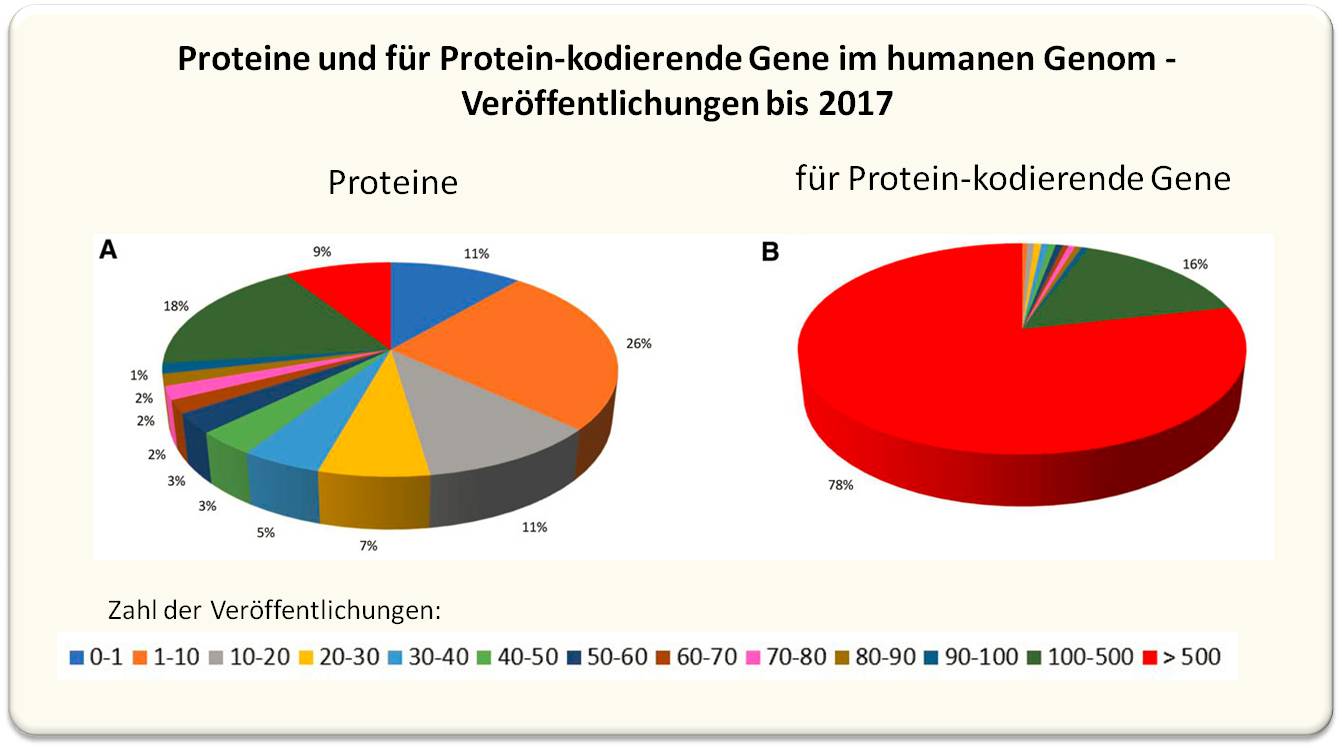

Um das herauszufinden, haben die Columbia-Forscher die Genome von mehreren hundert Personen mit APOEε4 untersucht, die älter als 70 Jahre und unterschiedlicher Herkunft waren. Einige von ihnen waren bereits an Alzheimer erkankt.

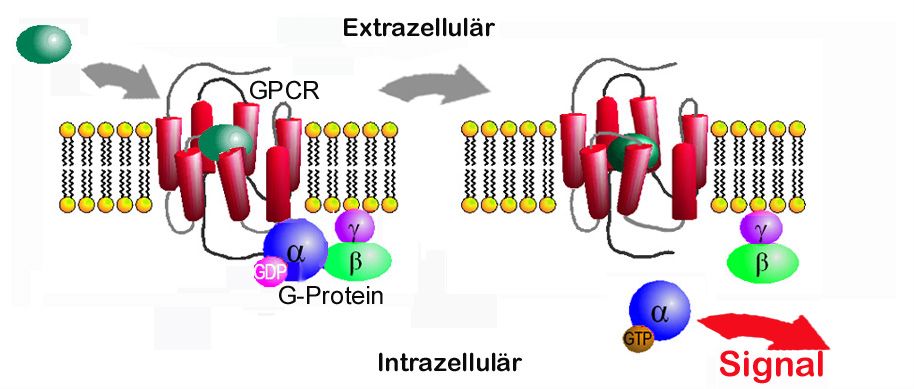

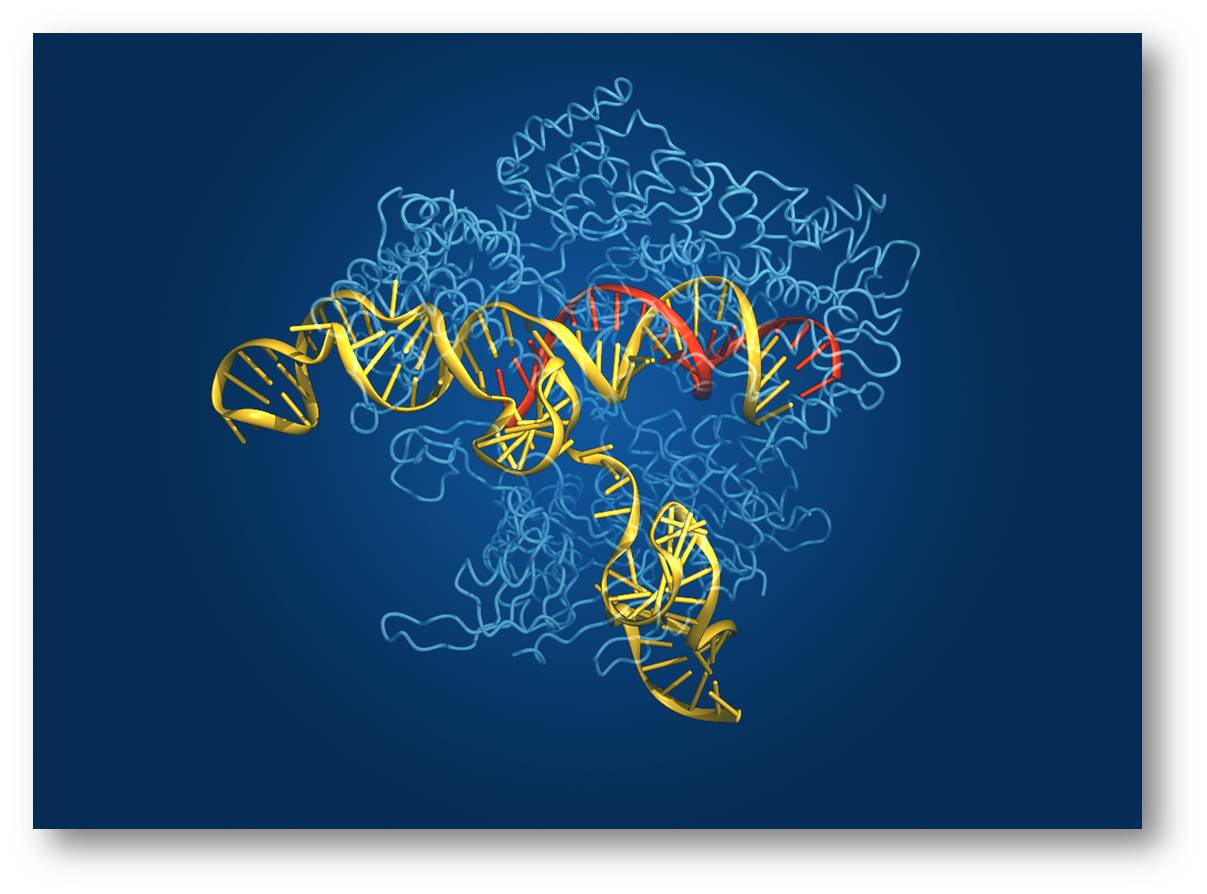

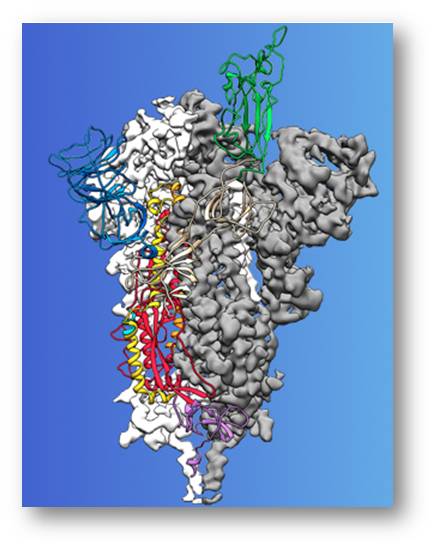

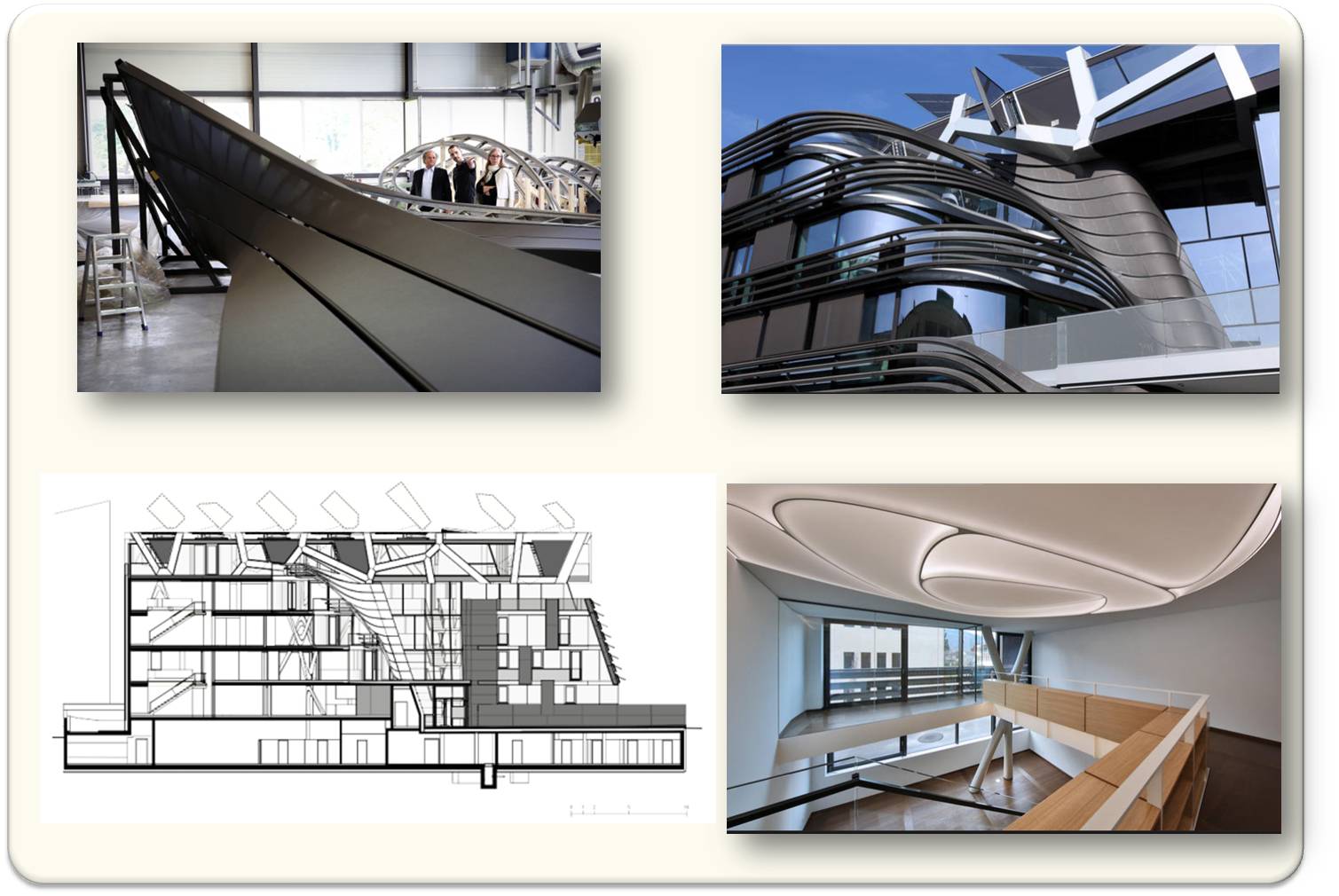

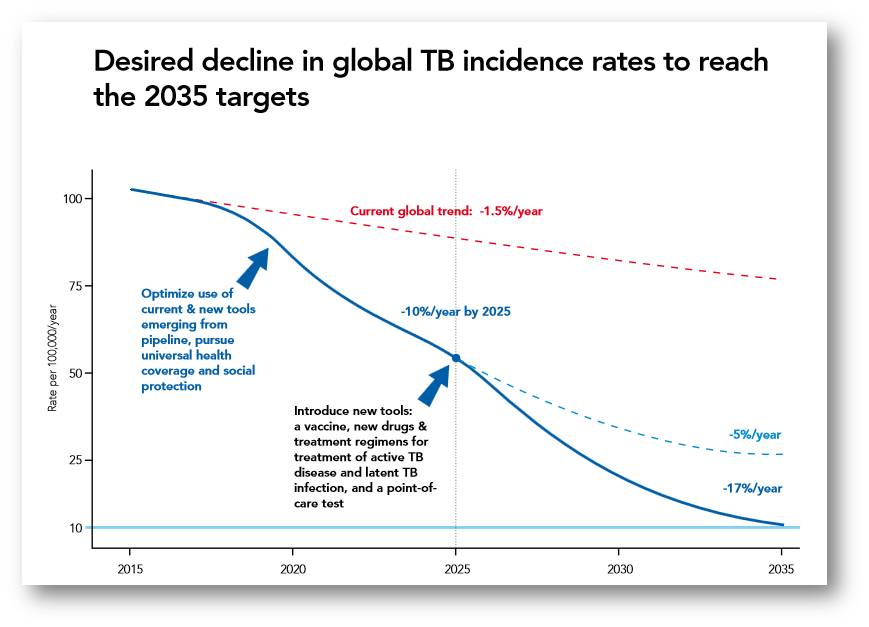

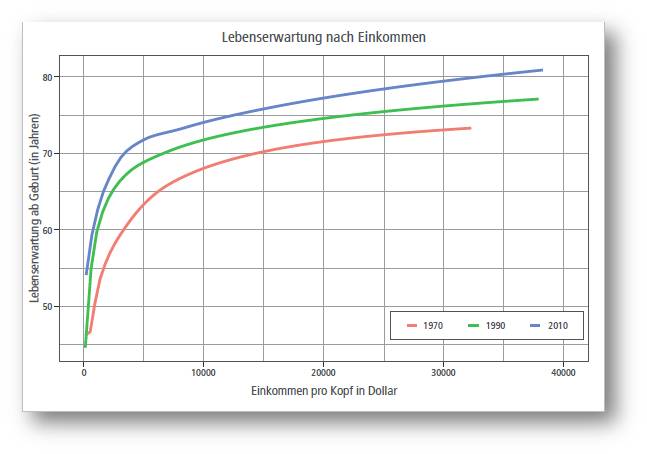

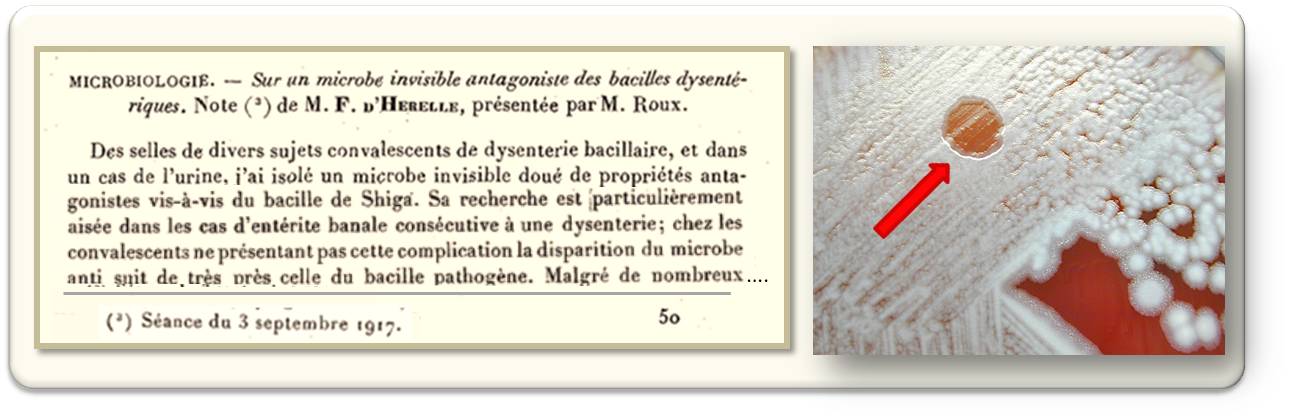

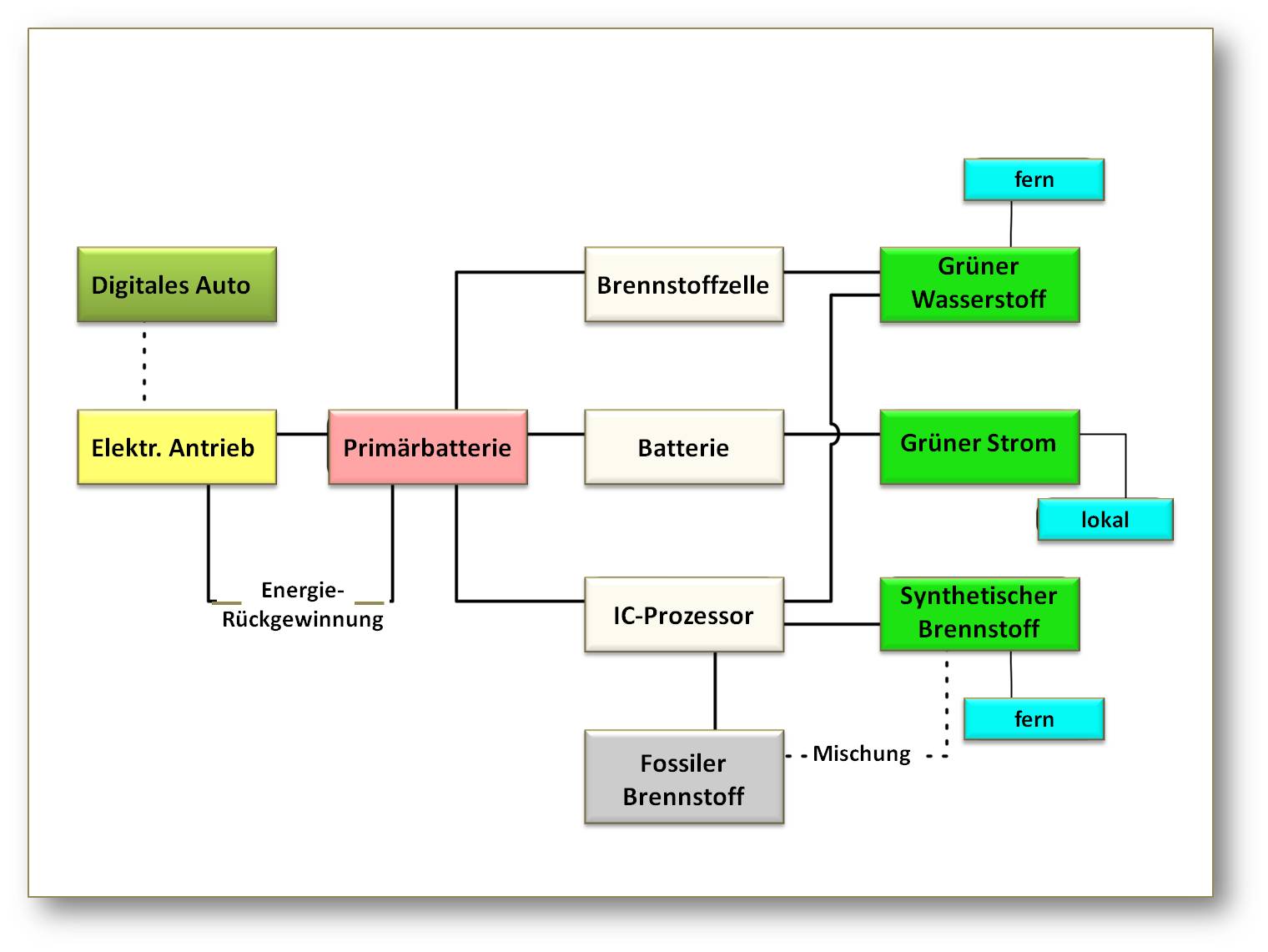

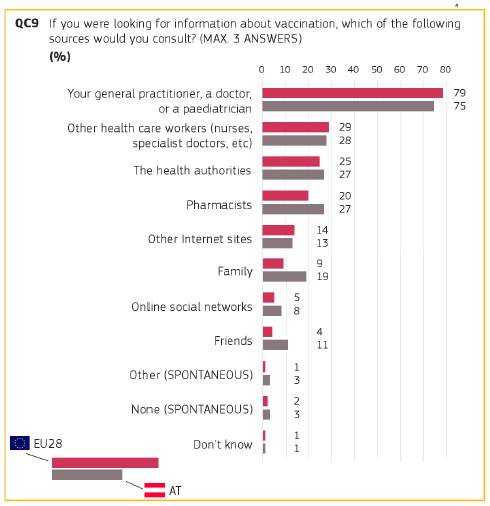

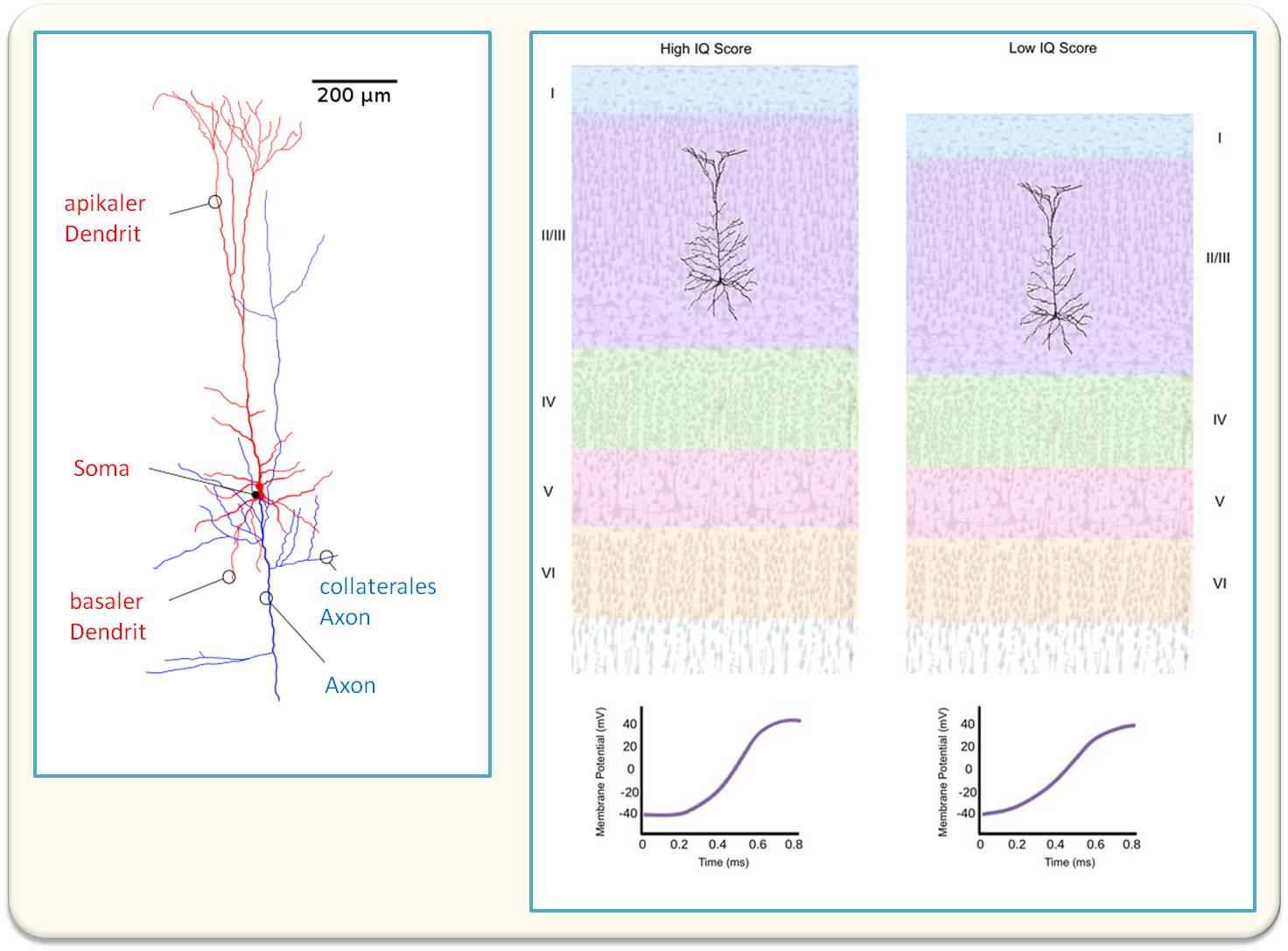

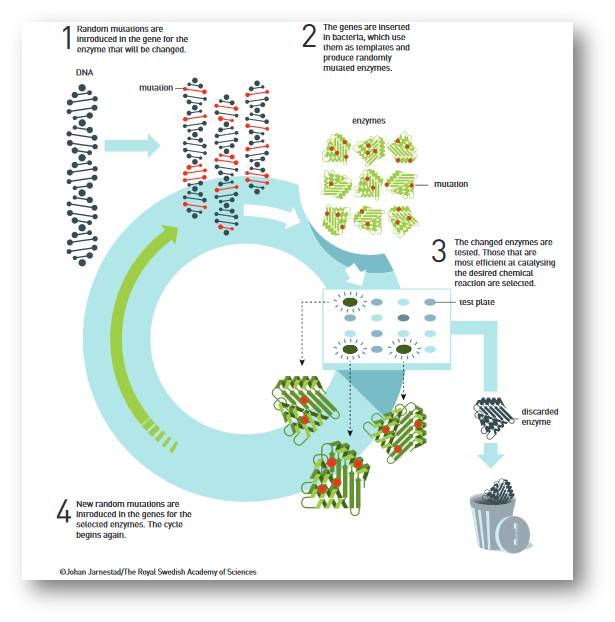

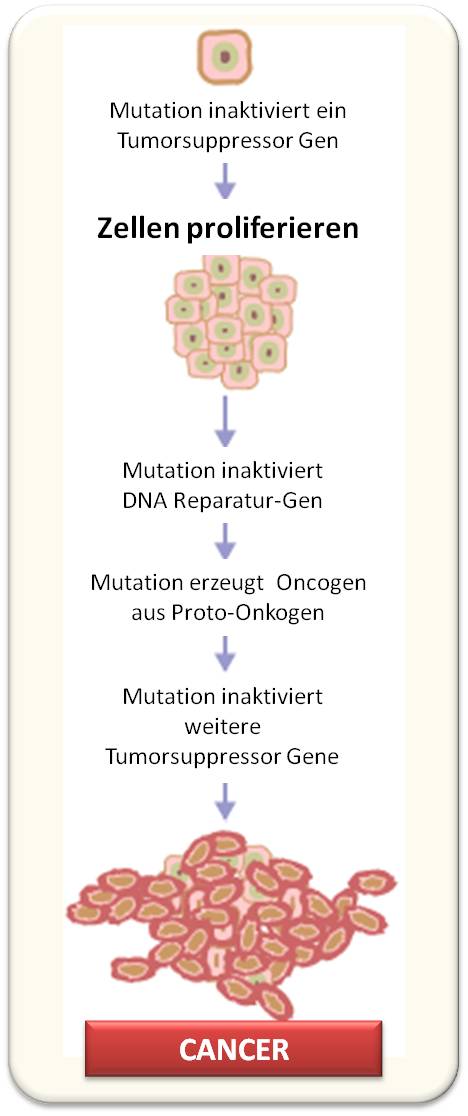

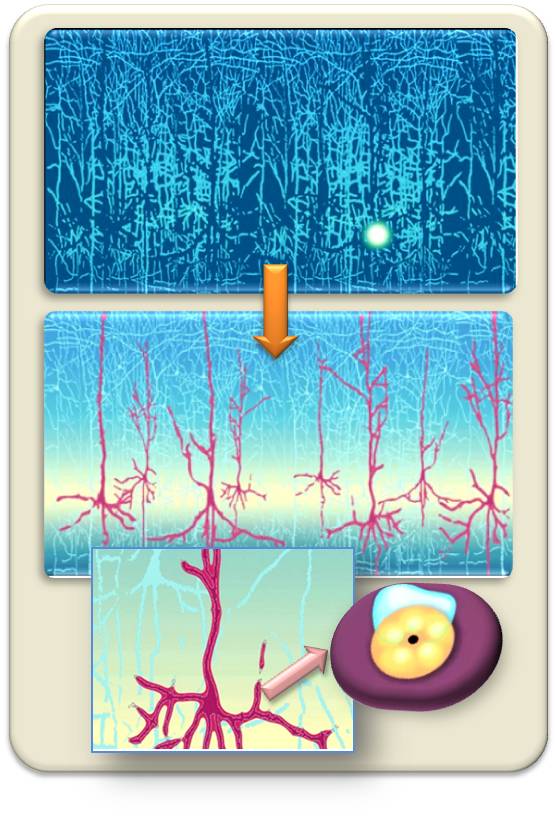

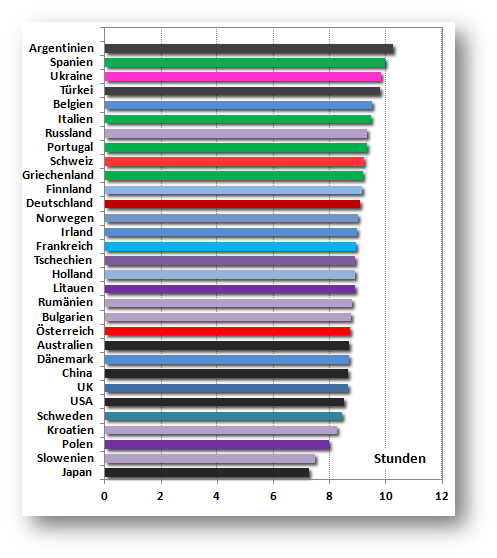

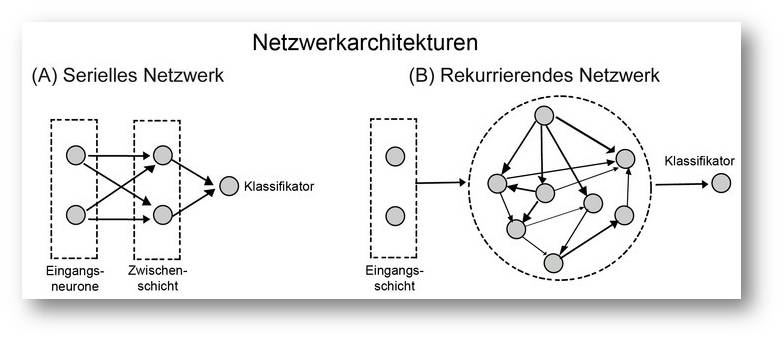

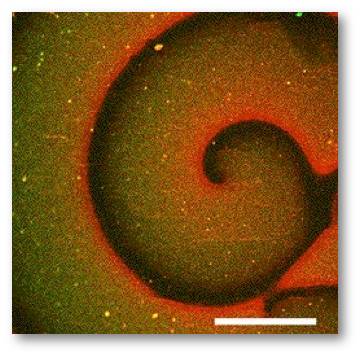

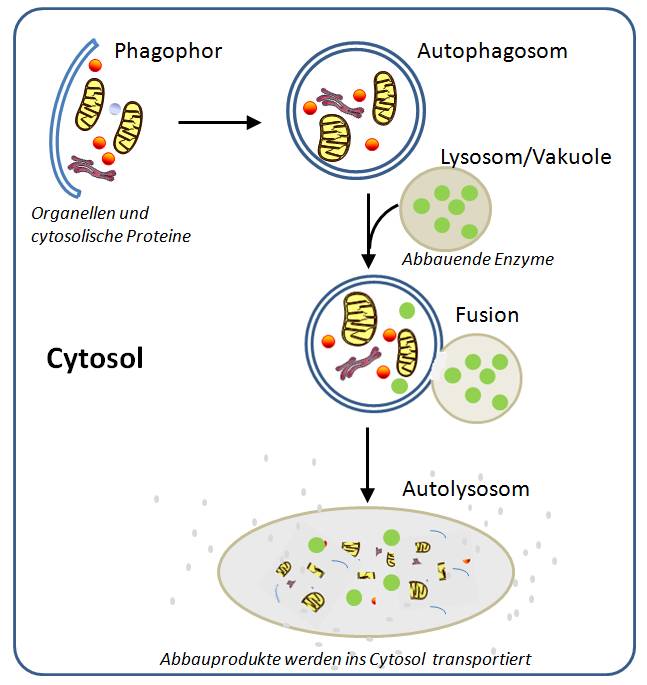

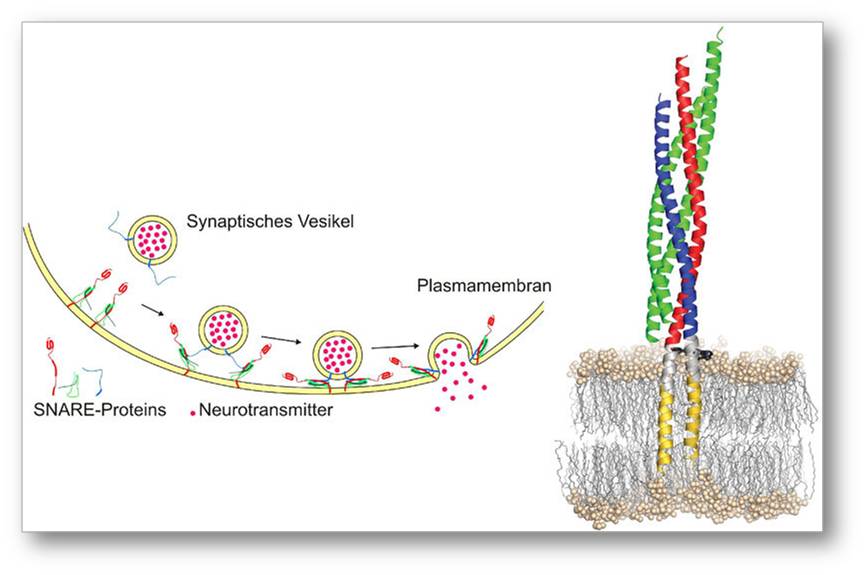

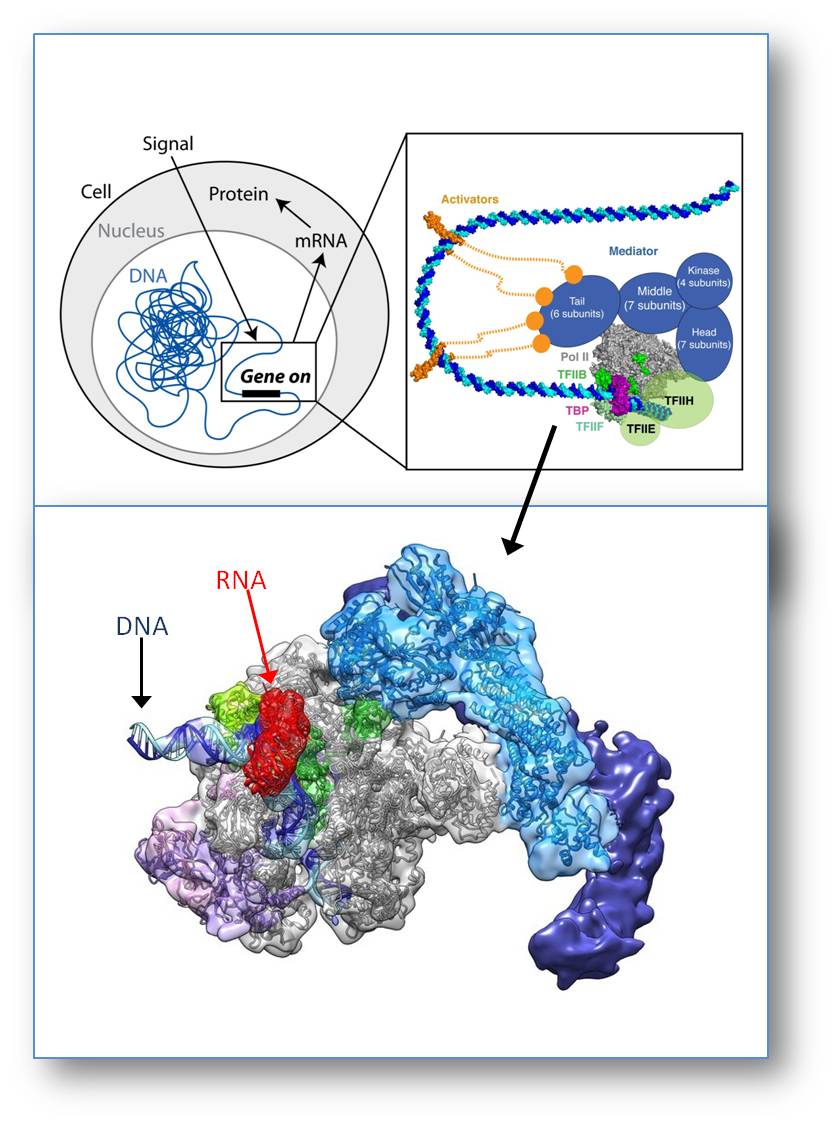

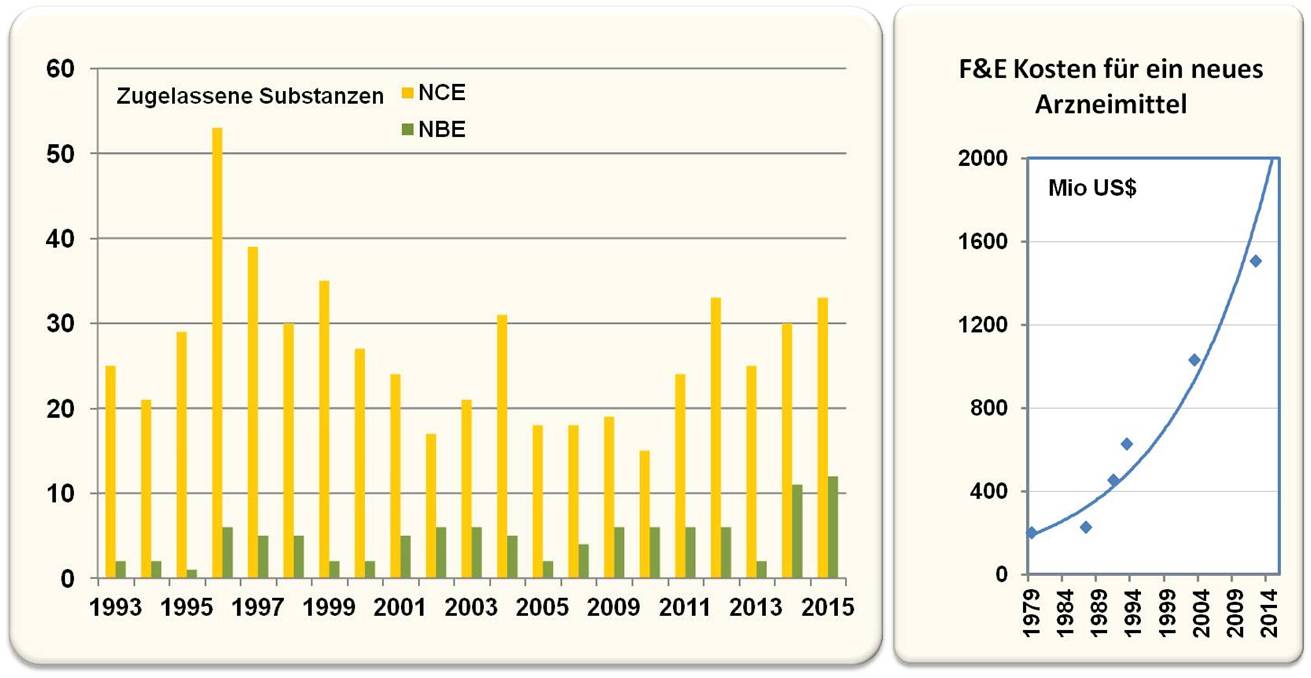

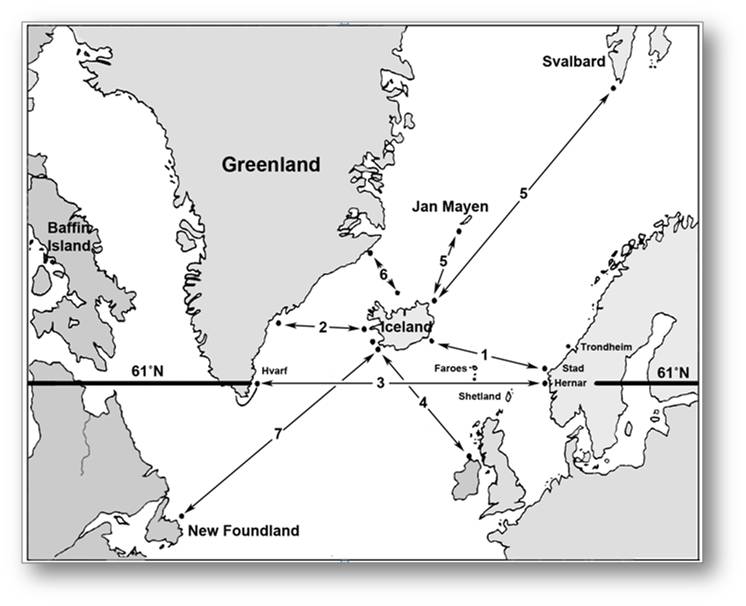

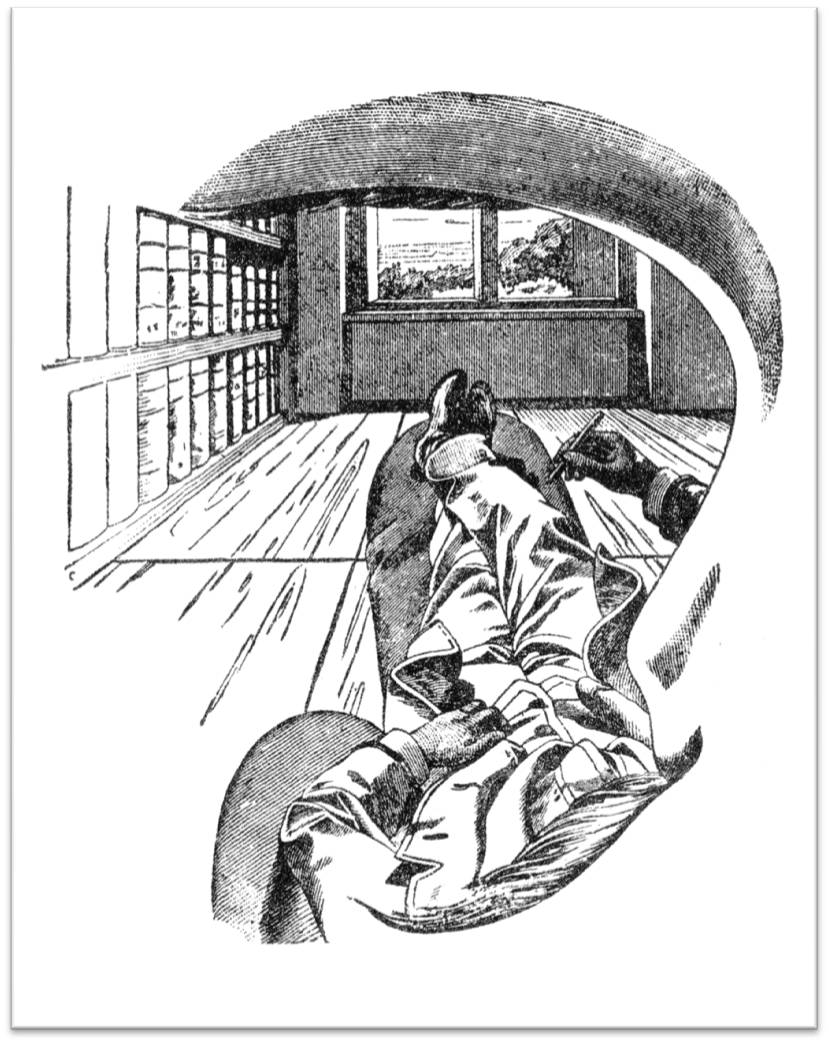

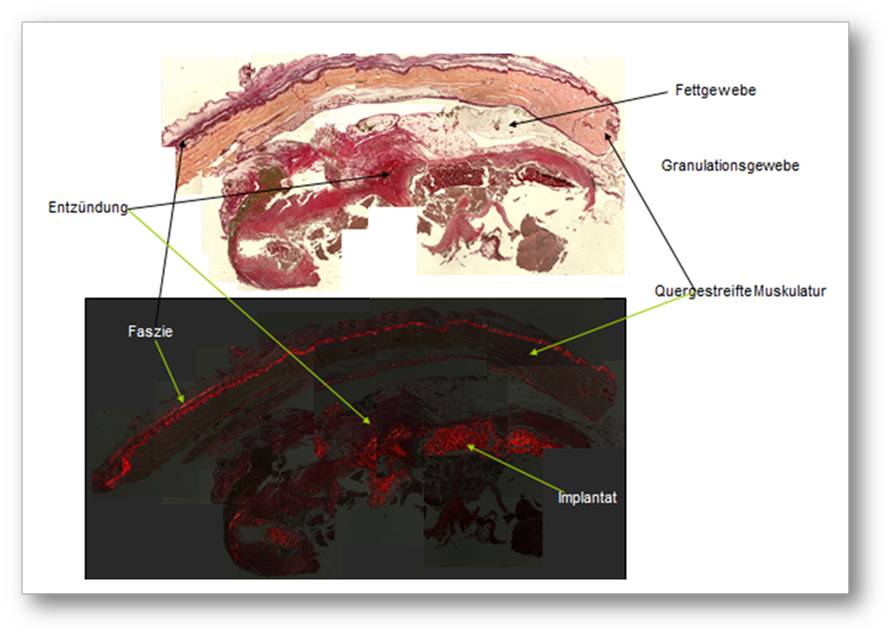

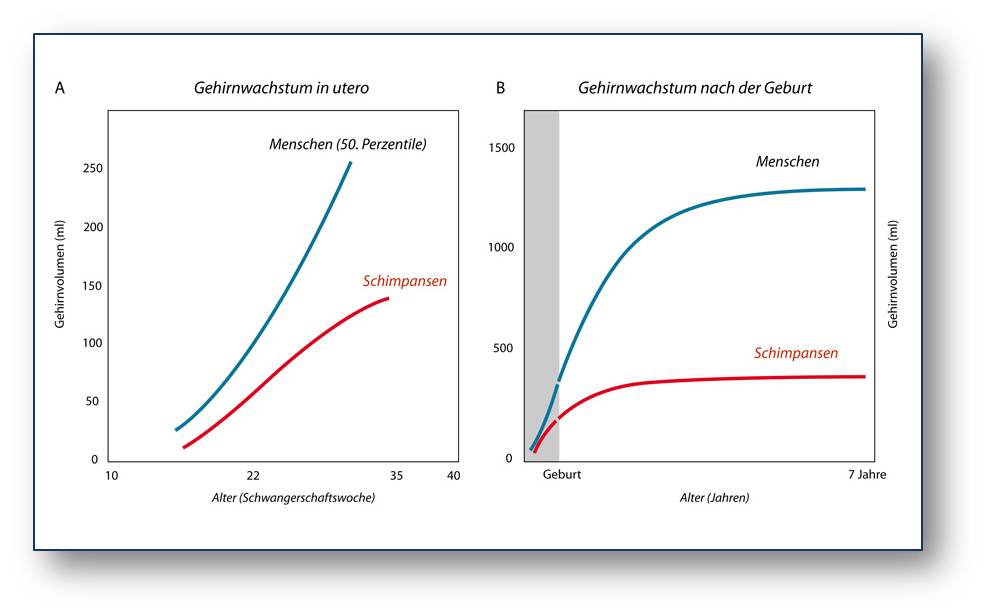

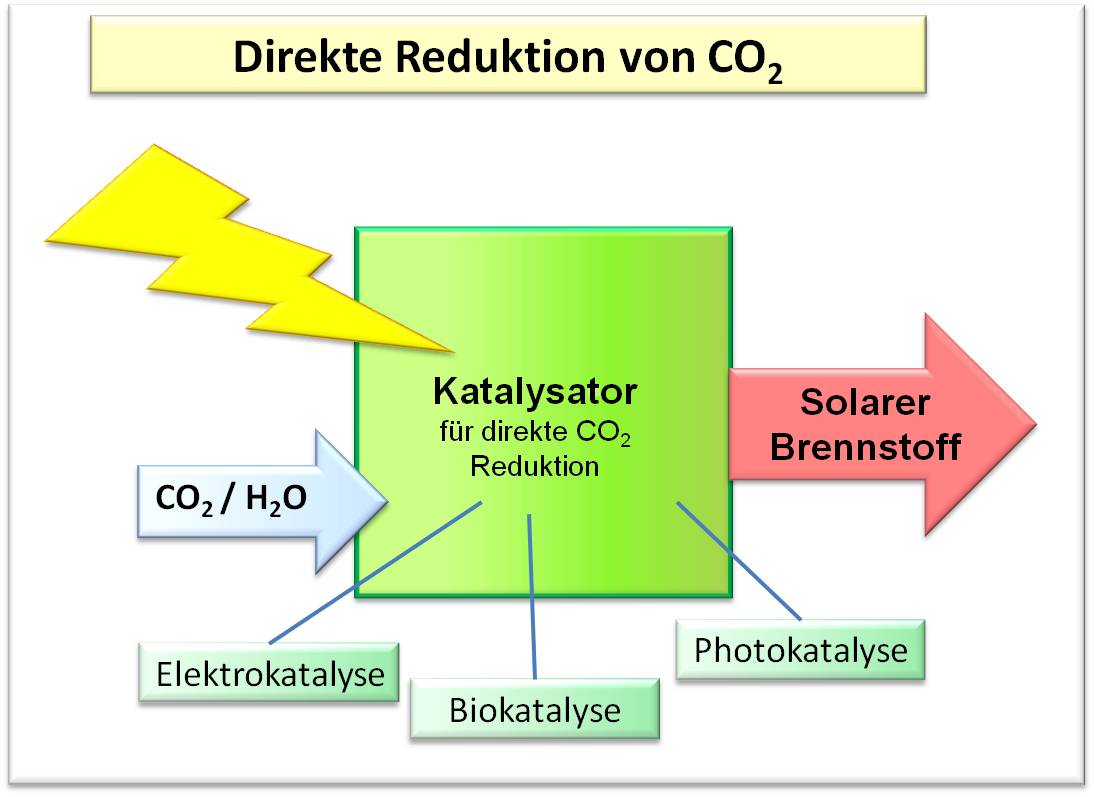

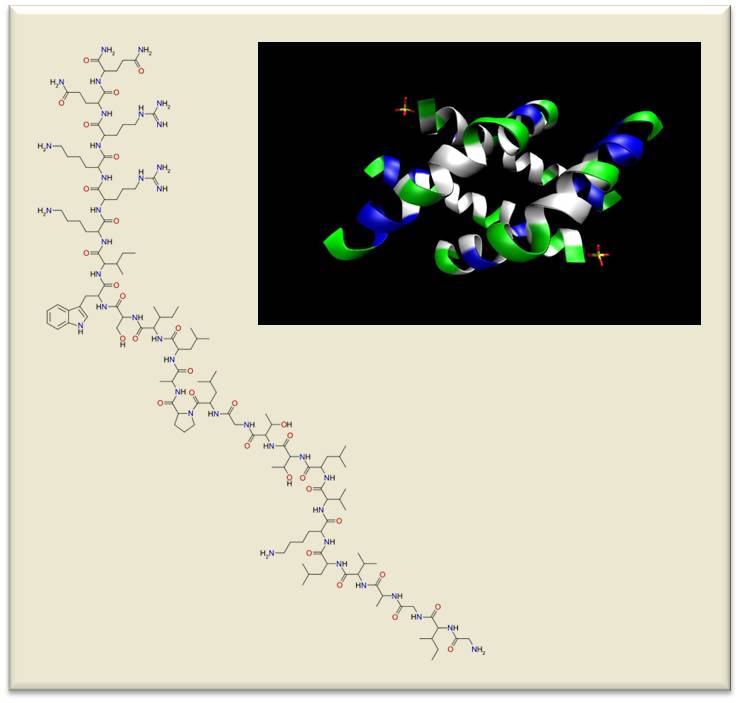

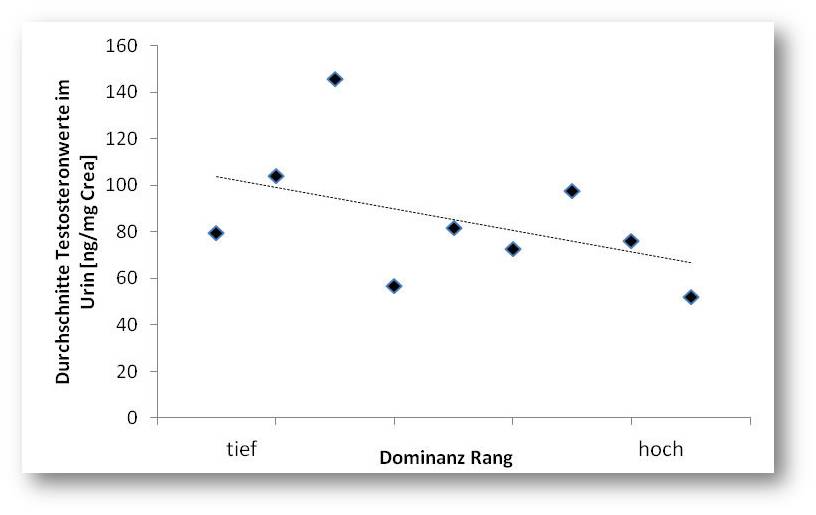

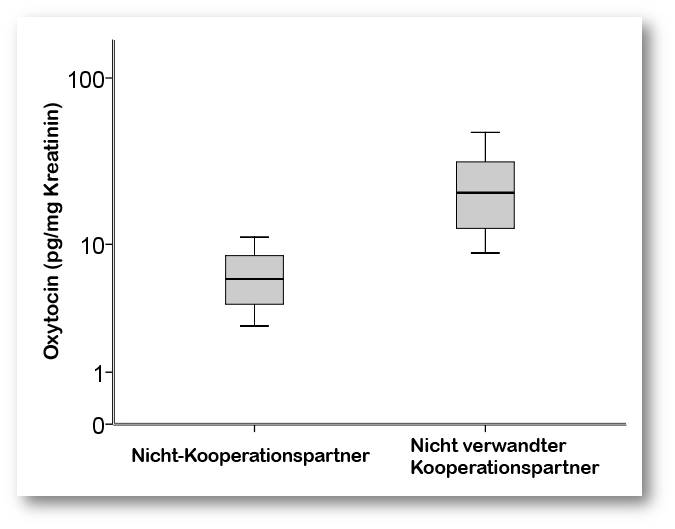

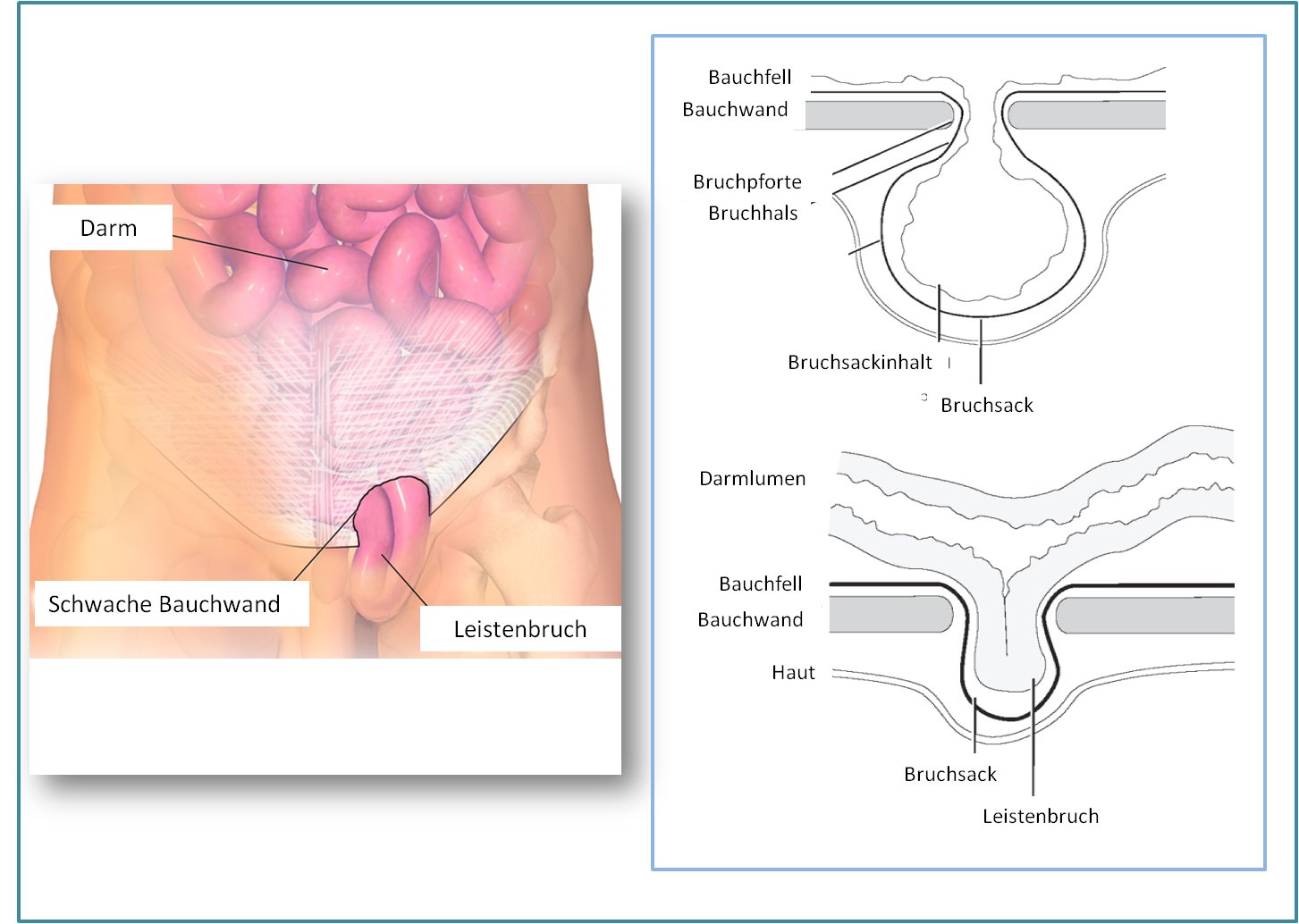

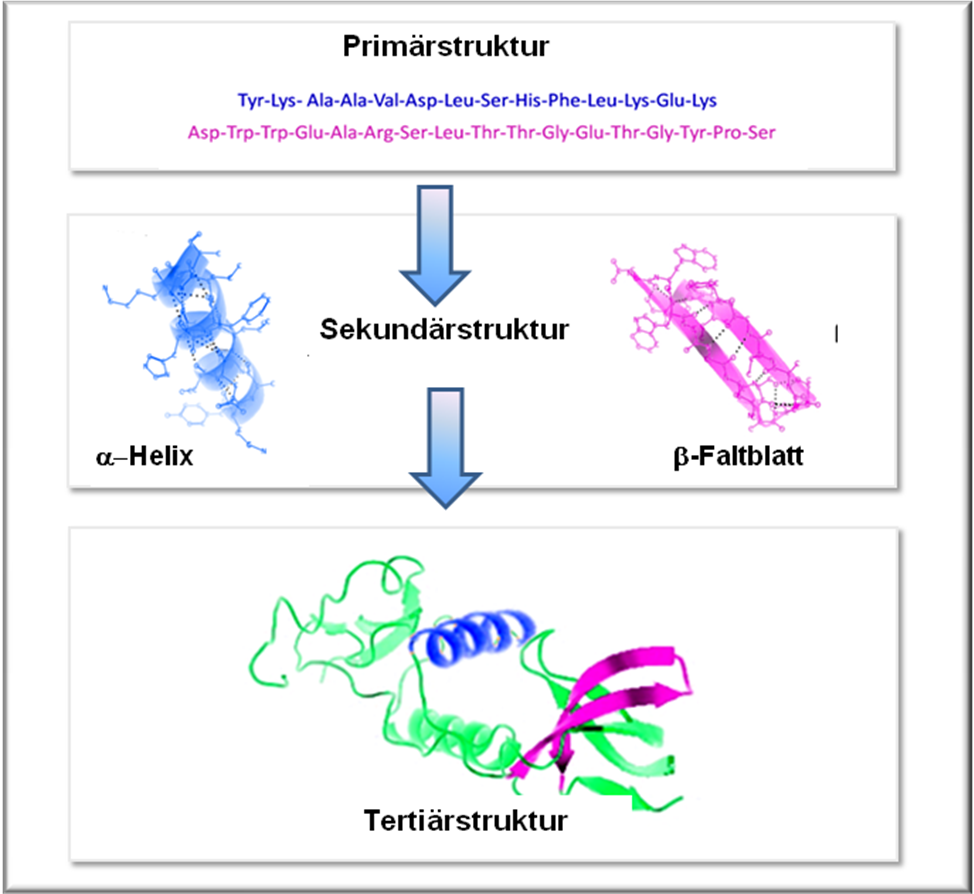

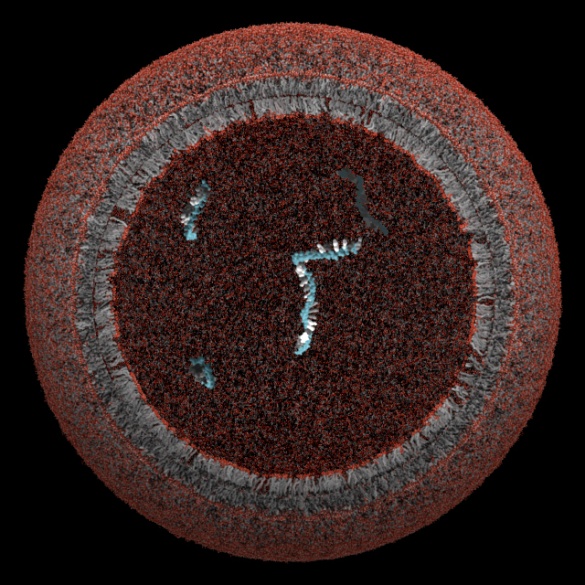

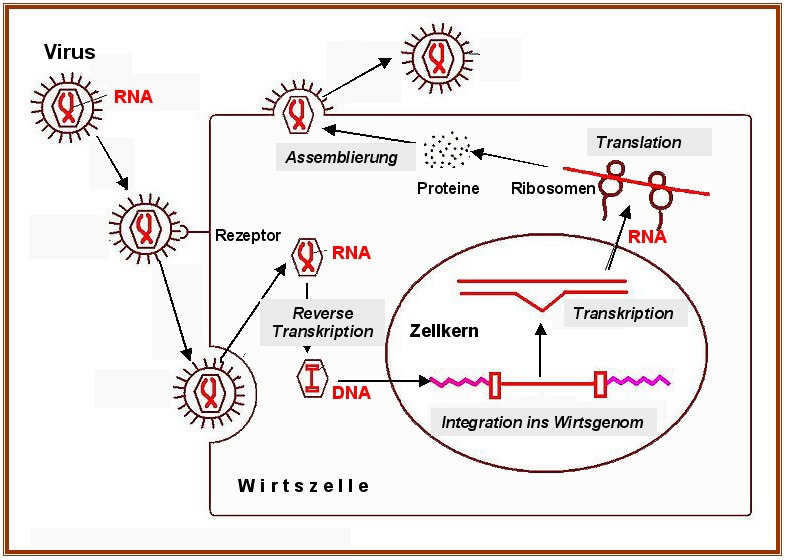

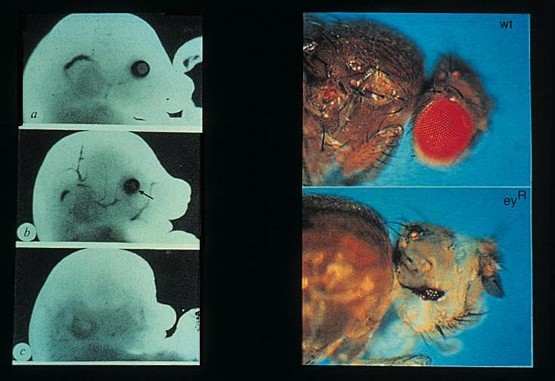

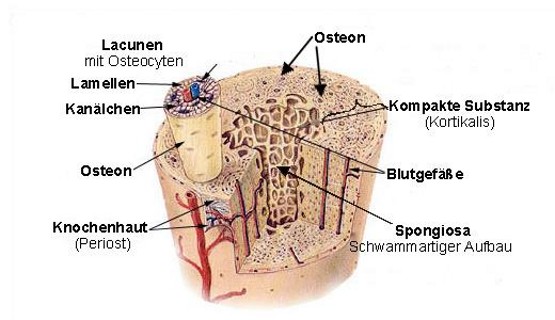

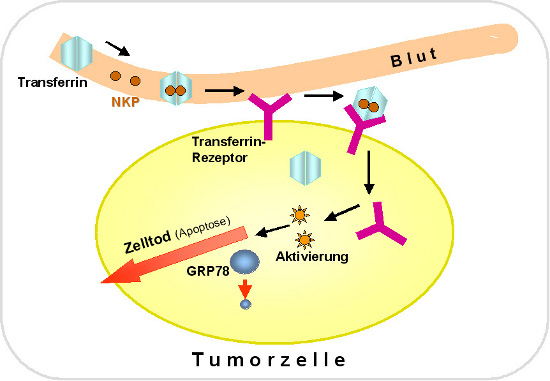

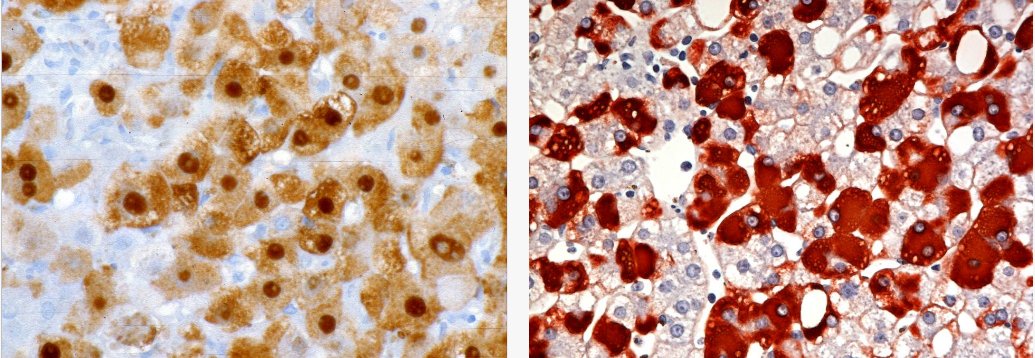

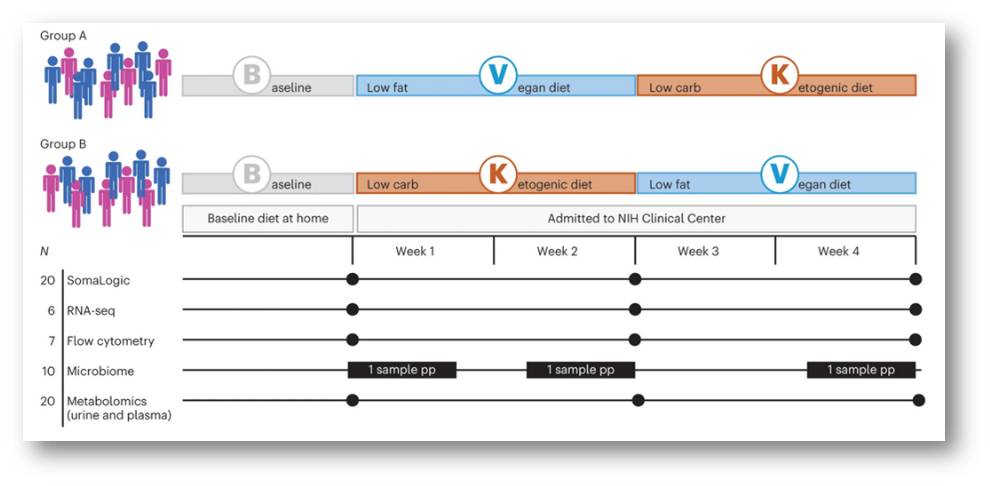

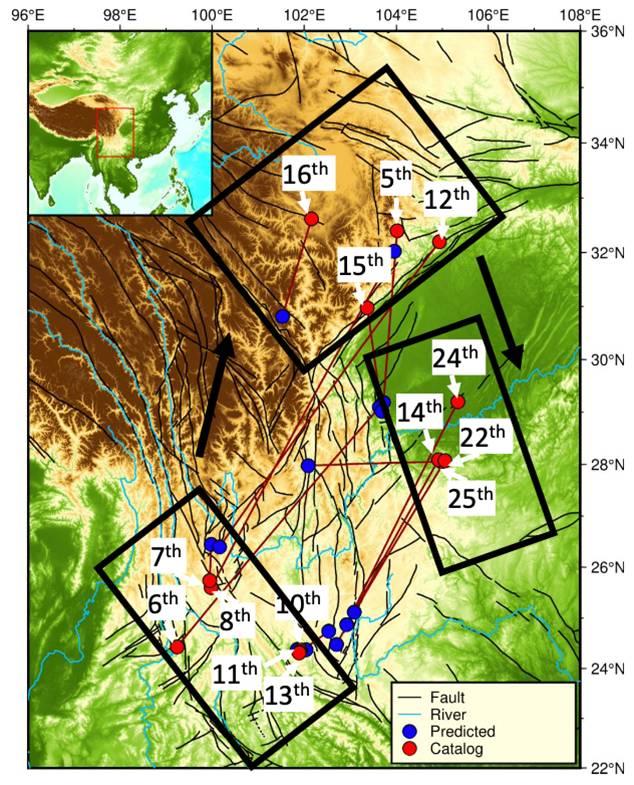

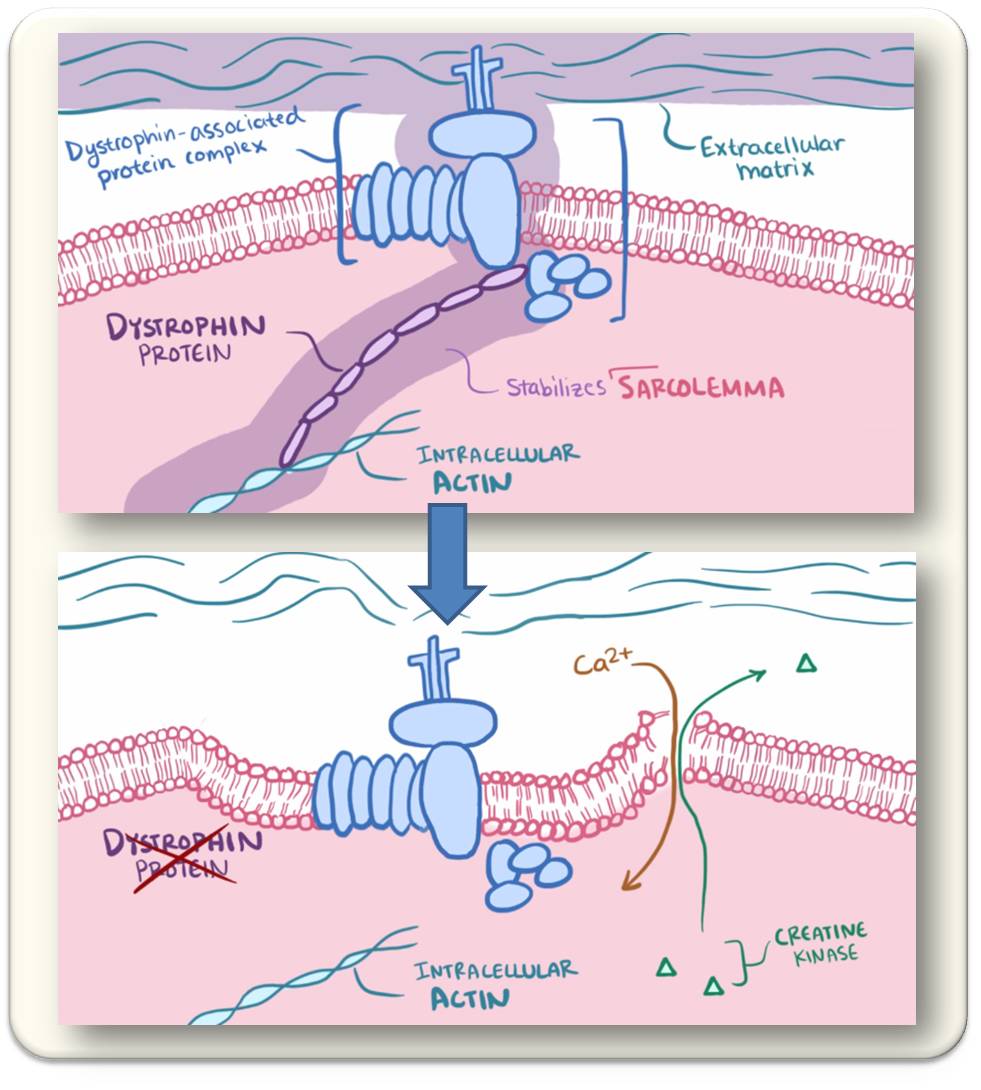

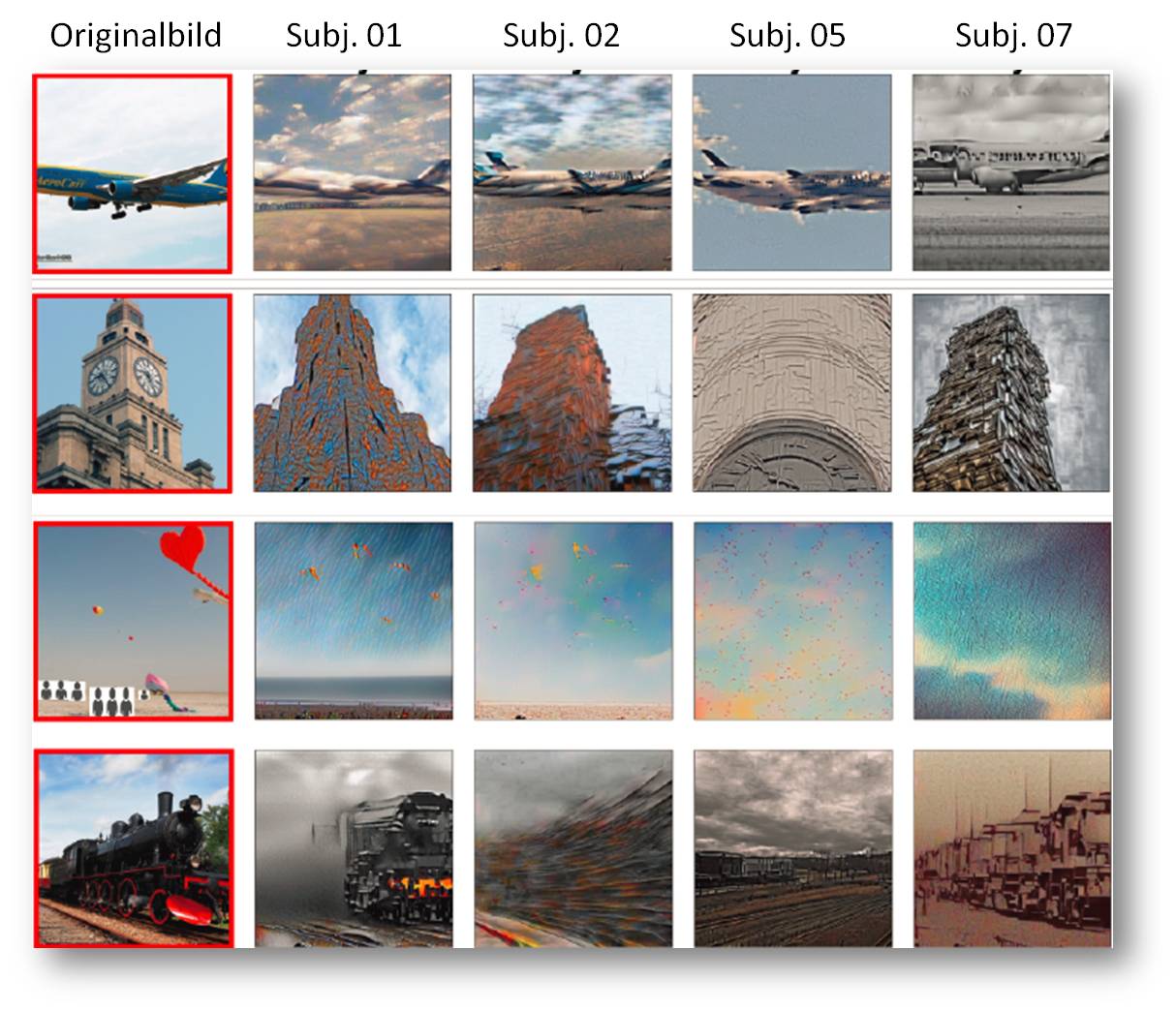

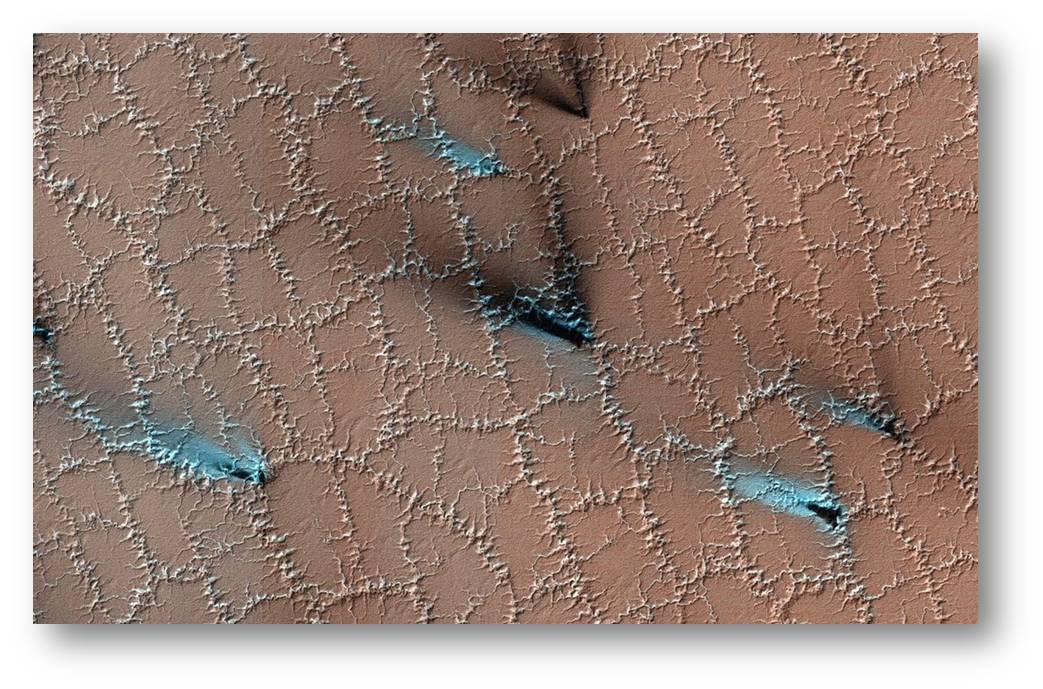

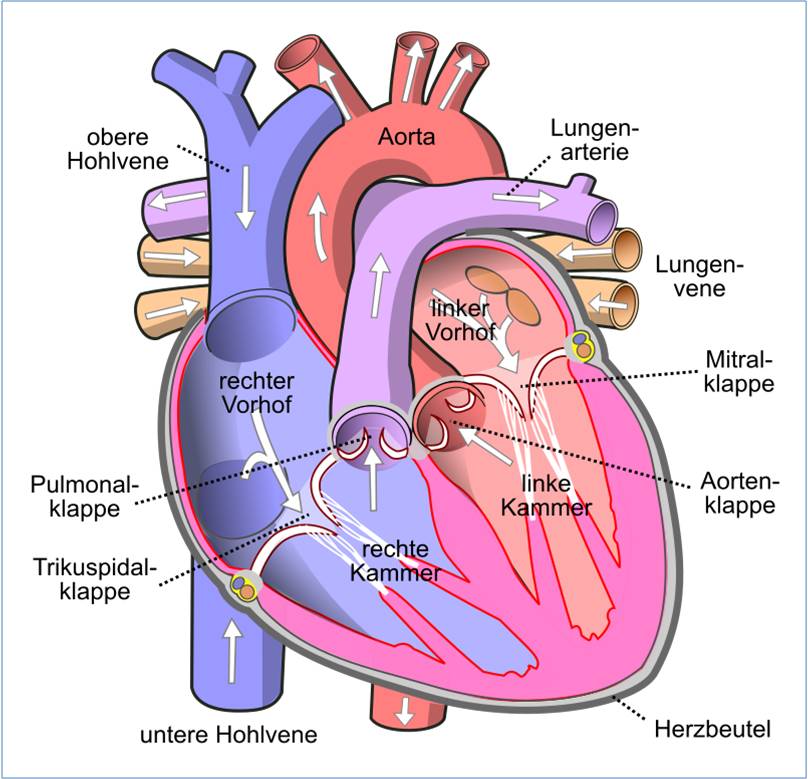

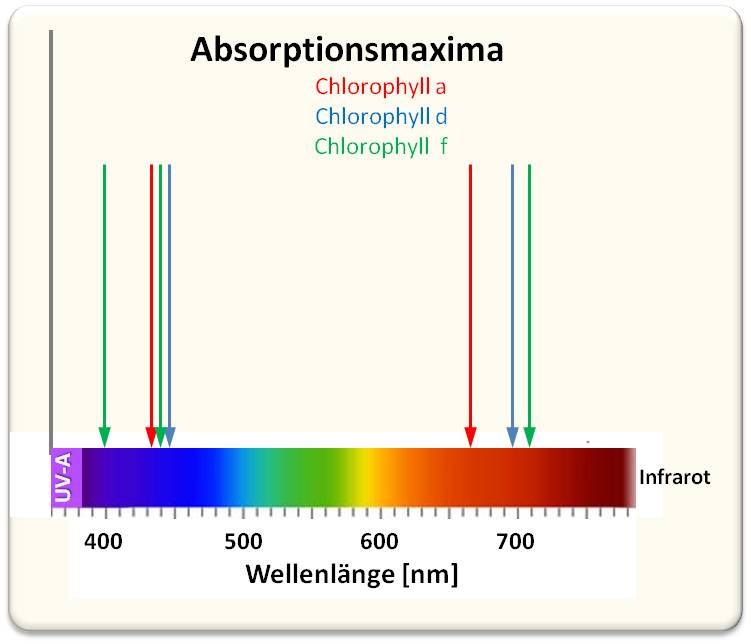

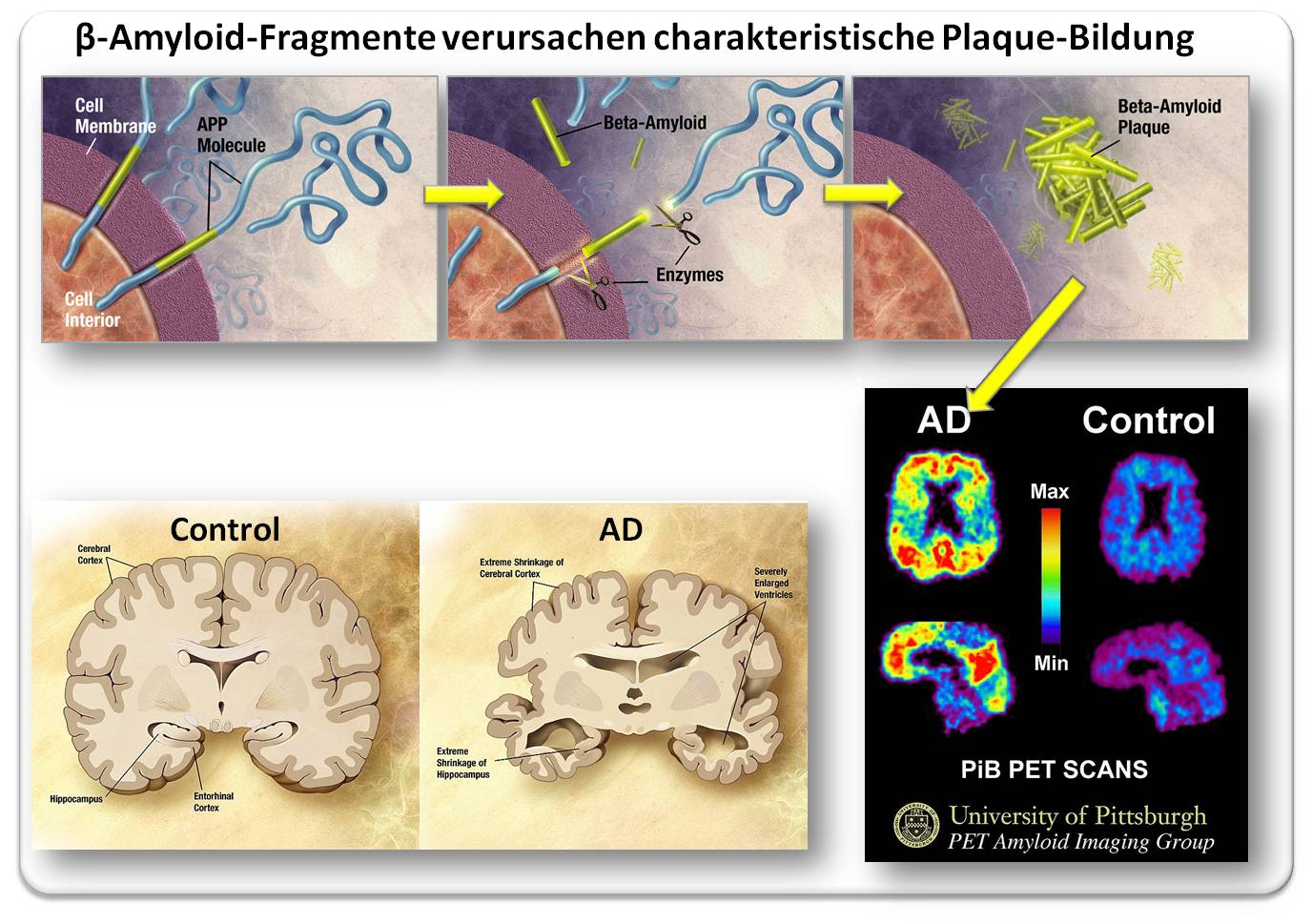

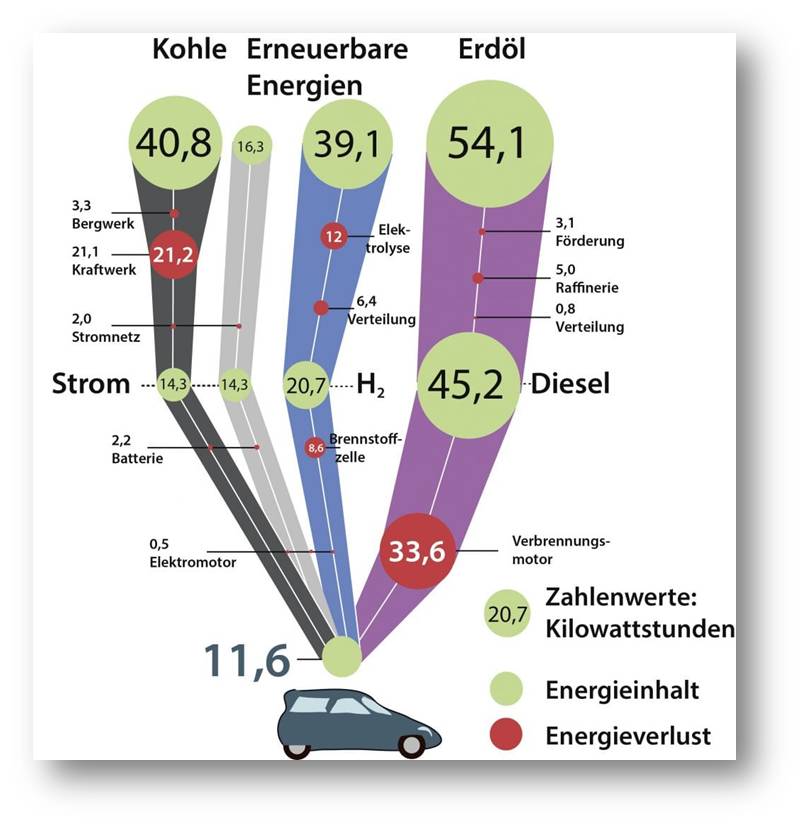

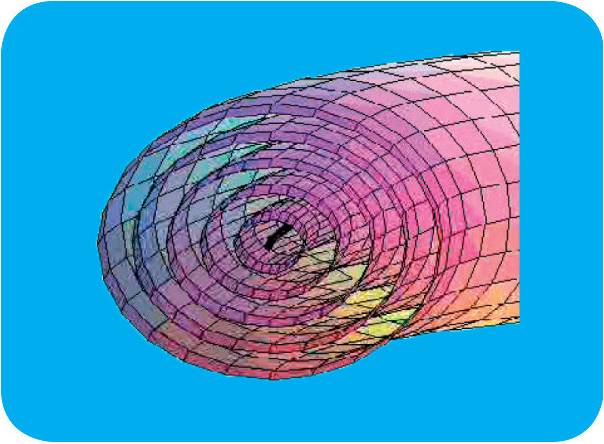

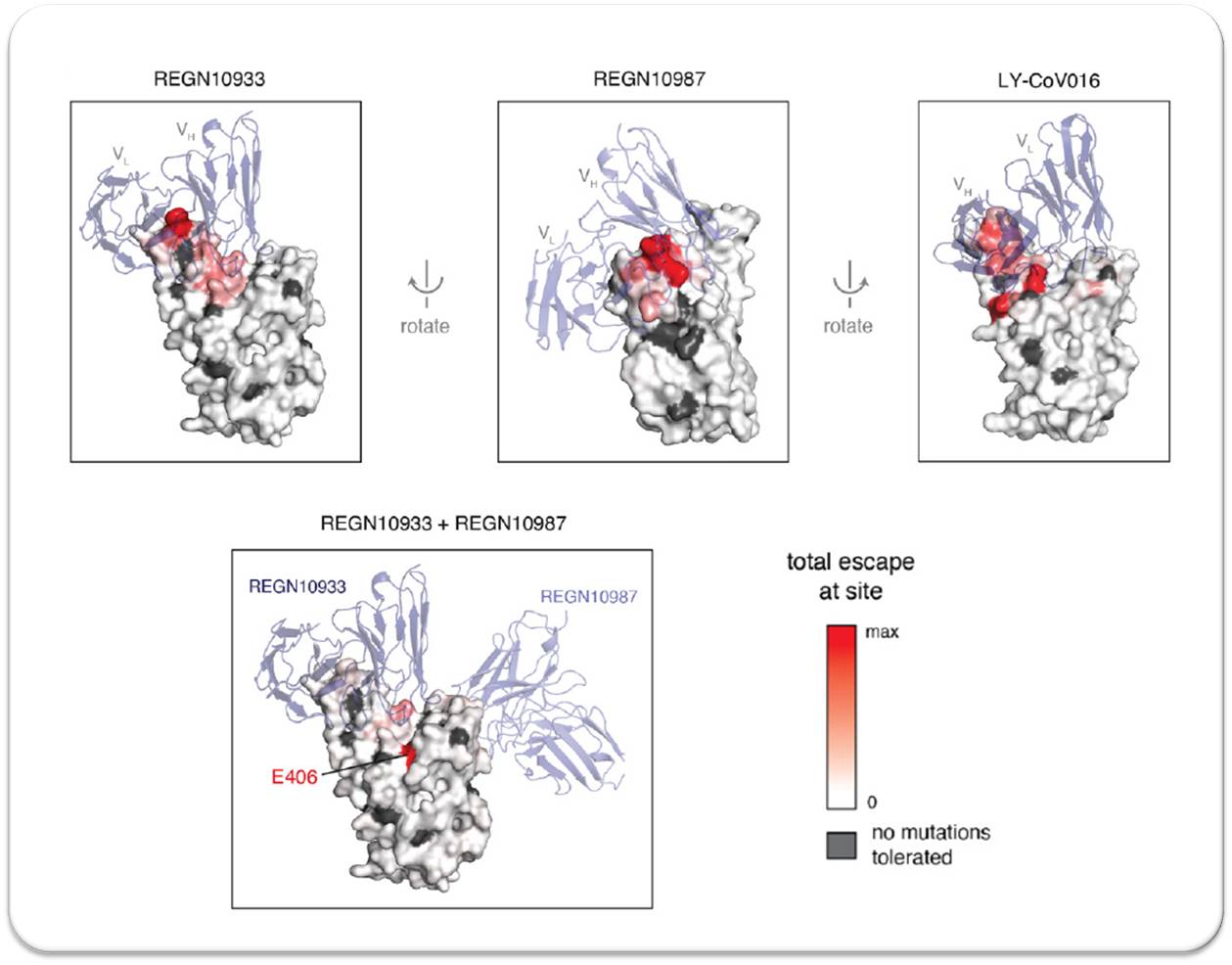

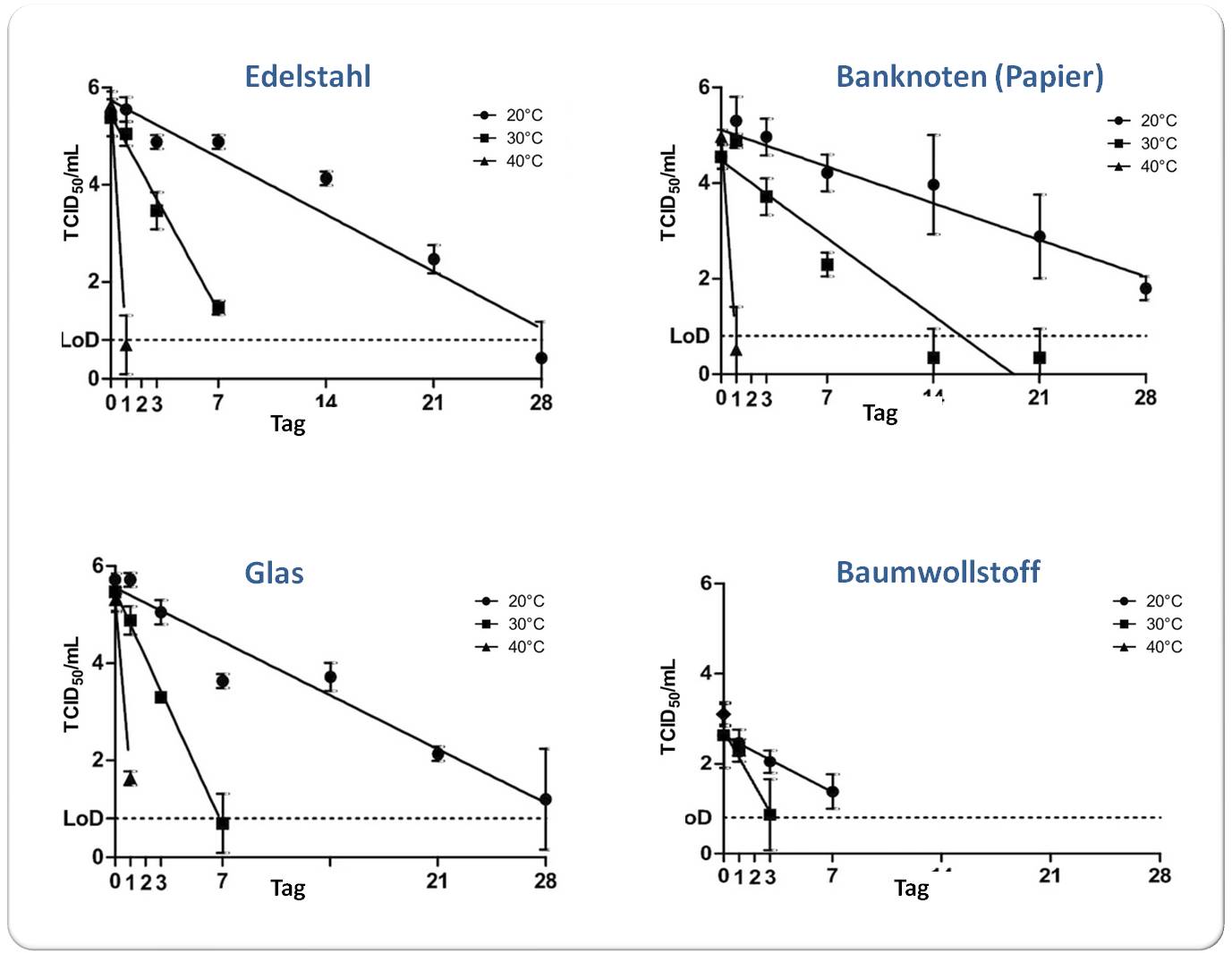

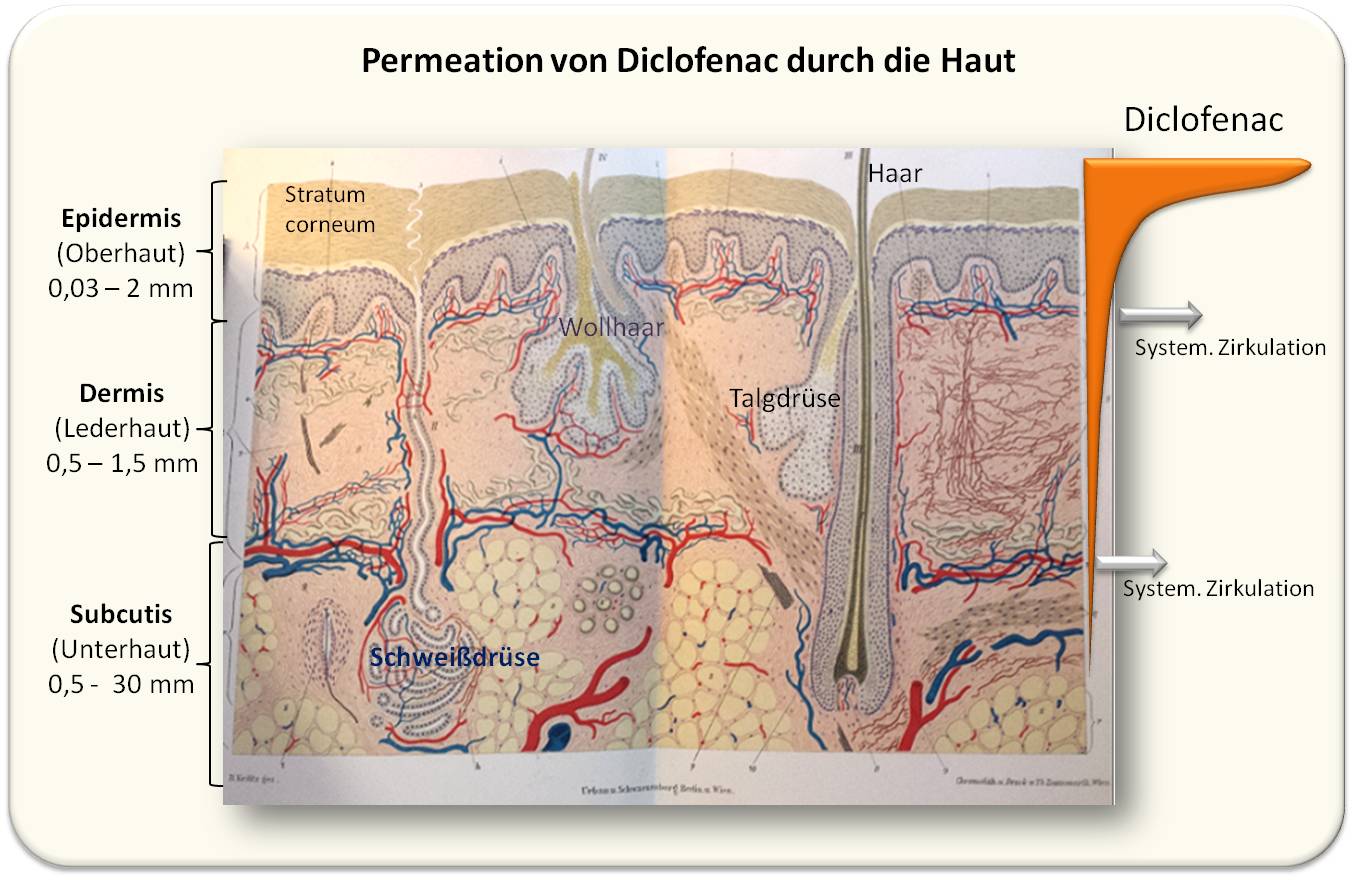

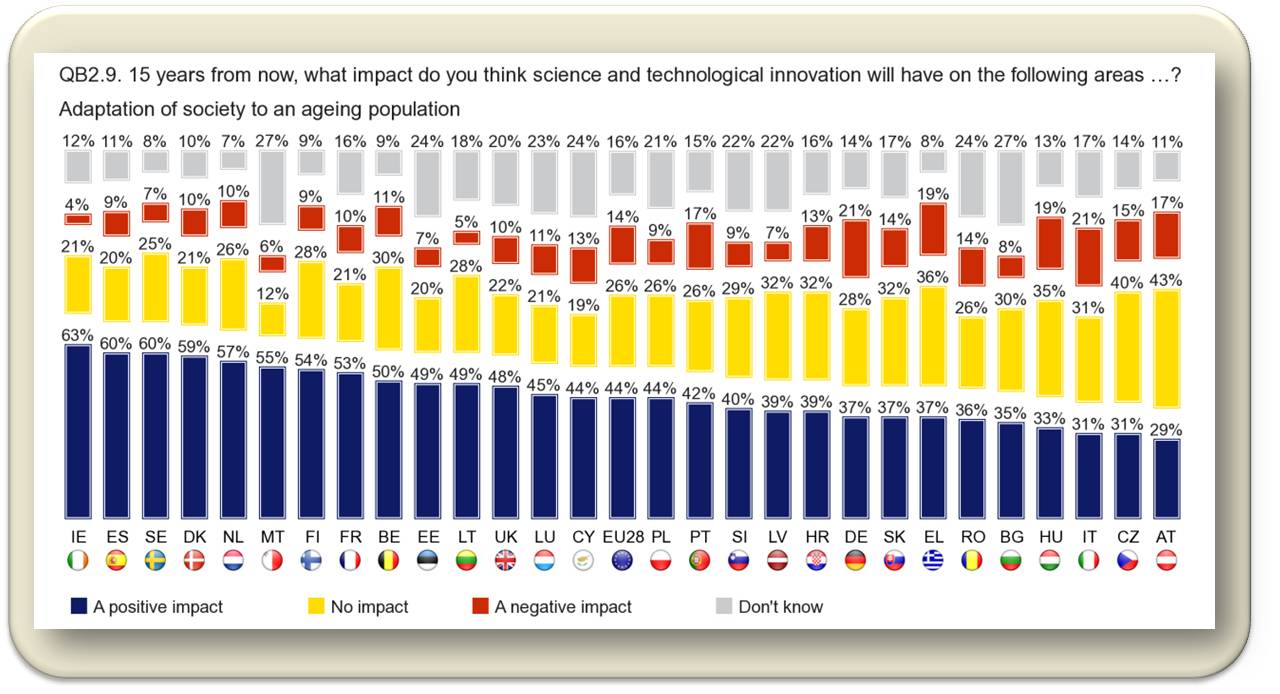

|

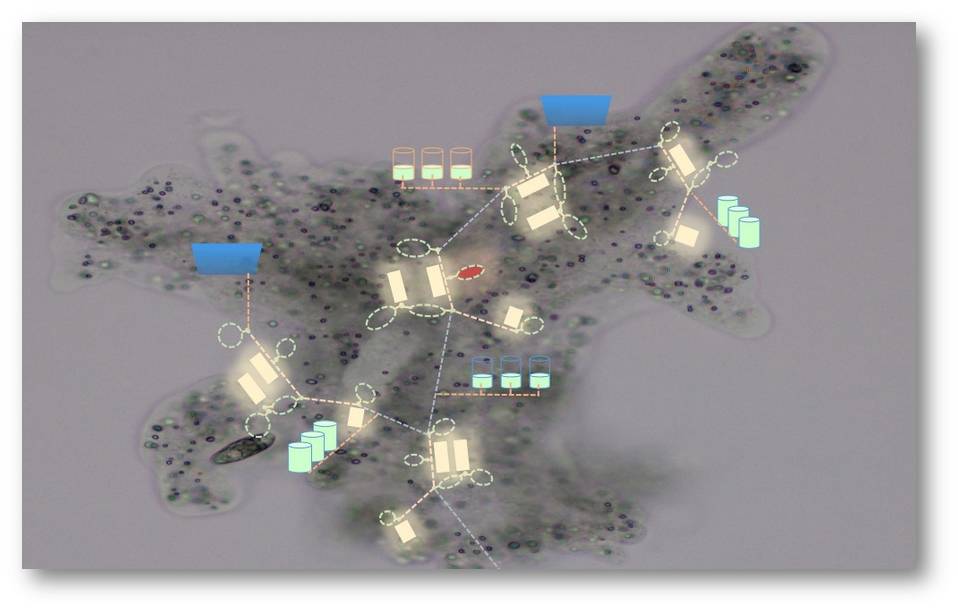

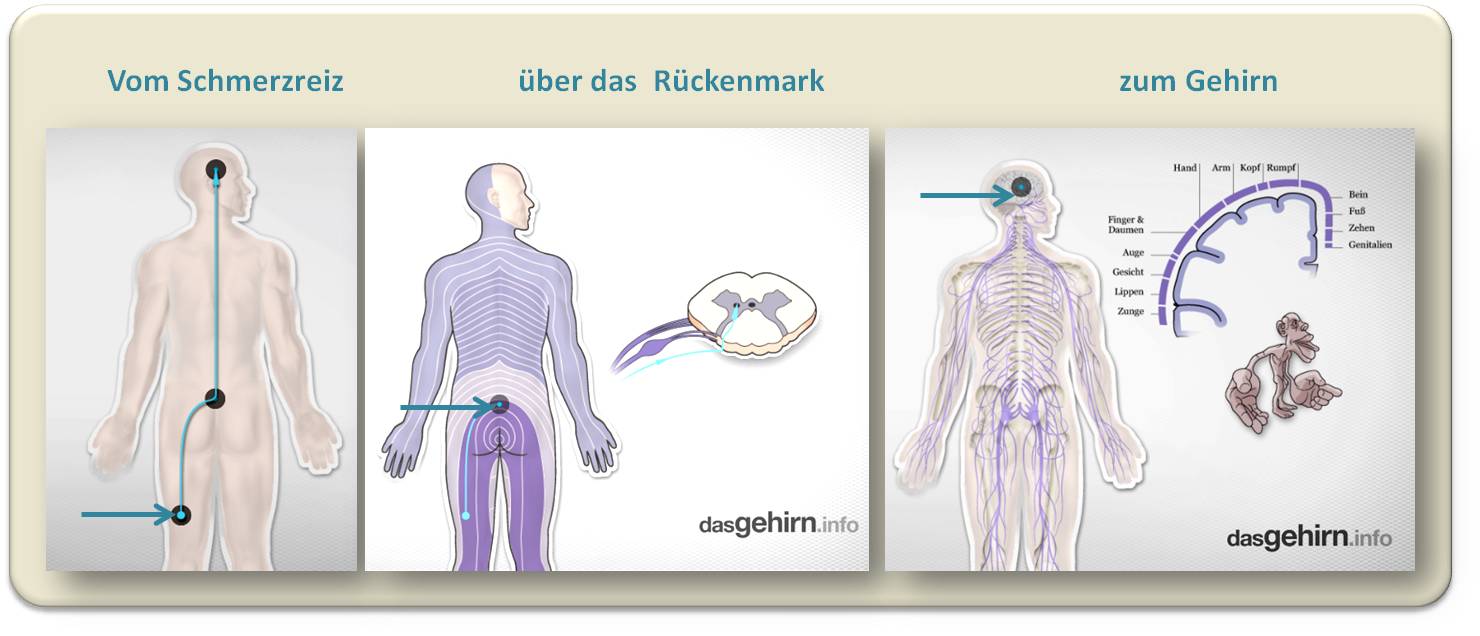

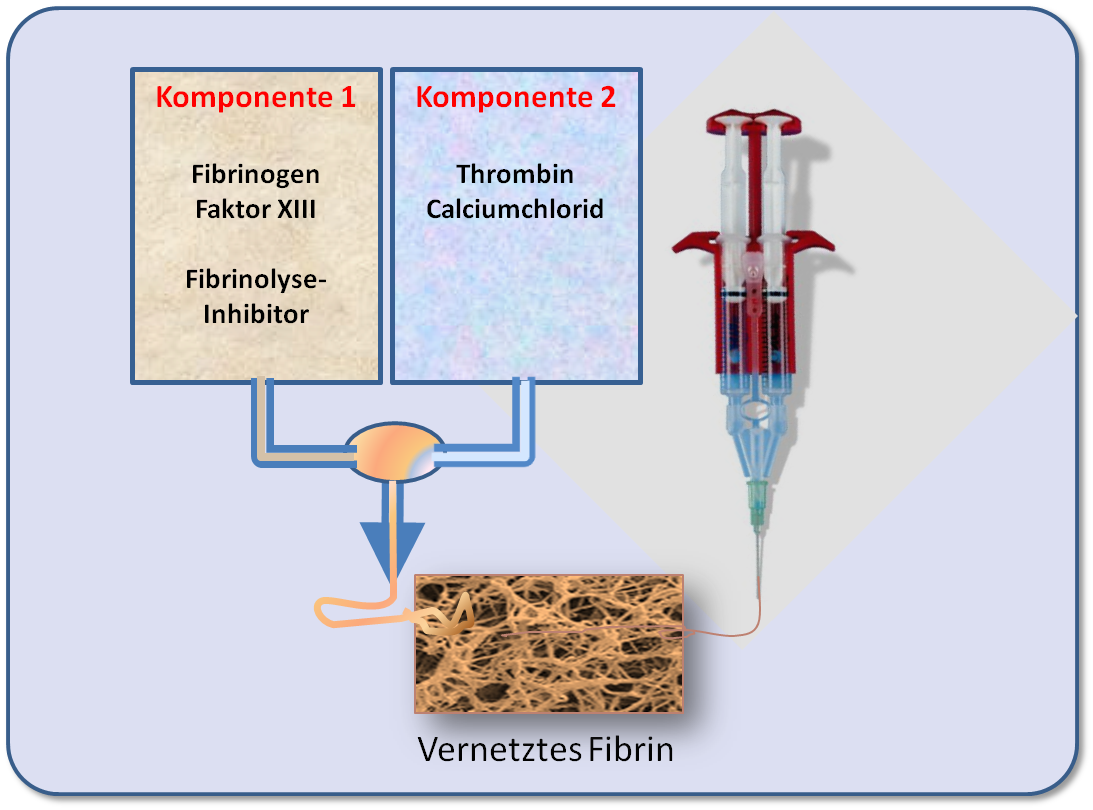

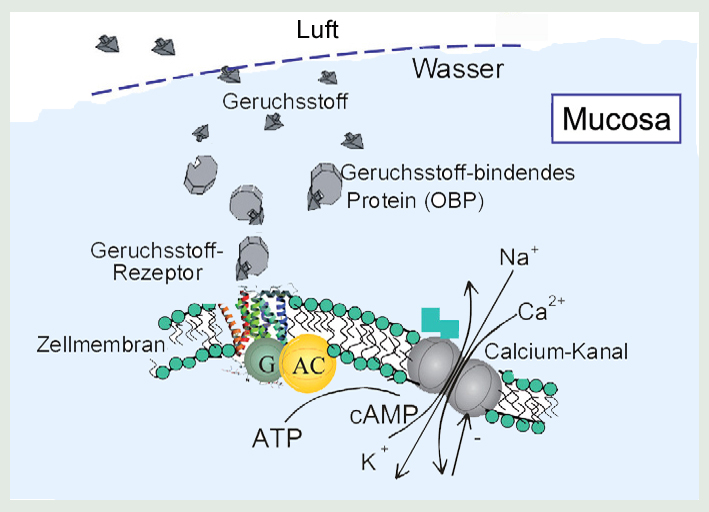

Abbildung 2 Die funktionell inaktive Fibronektin1-Variante schützt vor Alzheimer - Schematische Darstellung. Links: Situation im "normalen" Gehirn. Mit Apolipoprotein Eε4 (APOEε4 ) und nur geringen Mengen an Fibronektin werden Amyloid-Aggregate (Plaques) effizient von Microglia-Zellen abgebaut und die entstandenen Produkte über die Blut-Hirn-Schranke eliminiert ("Clearance"). Mitte: Situation bei Alzheimer - Genotyp APOEε4 zusammen mit einem Zuviel an Fibronektin. Fibronektin lagert sich in der Blut-Hirnschranke an und führt zu deren Verdickung. Abbau von Plaques und Eliminierung von Amyloidprodukten brechen zusammen, Neuronen werden geschädigt ("Synaptic Degeneration"). Rechts: Die funktionell inaktive ("Loss of Function") Fibronektin-Variante lagert sich nicht an der Blut-Hirn-Schranke ab. Die Eliminierung von Amyloidprodukten kann erfolgen. Die Bildung von Amyloid-Plaques erfolgt in reduziertem Ausmaß/verzögert. (Bild von der Redaktion eingefügt aus: Bhattarai, P et al., [4], https://doi.org/10.1007/s00401-024-02721-1 und leicht modifiziert. Lizenz: cc-by.) |

"Von den noch nicht erkrankten (resiliente)n Menschen können wir viel über die Krankheit erfahren und darüber, welche genetischen und nicht-genetischen Faktoren einen Schutz davor bieten könnten", sagt Badri N. Vardarajan, PhD, ein Coautor der Studie. Offensichtlich wirkt eine Variante des Fibronektin-Gens schützend.

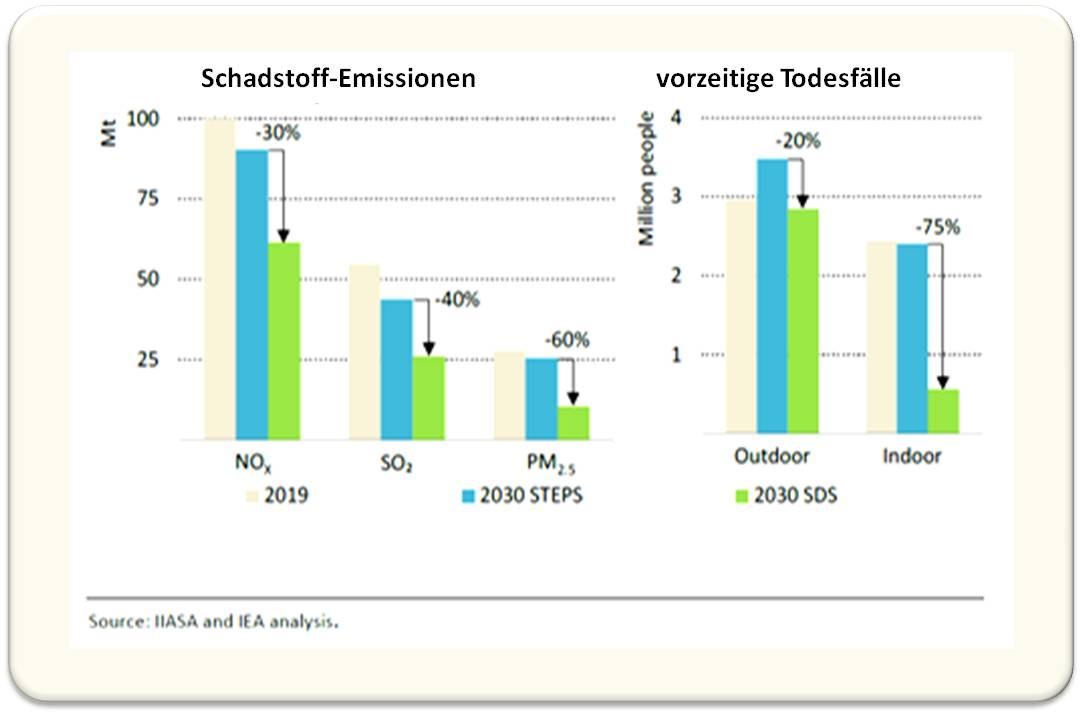

Als die Forscher den Preprint ihrer Ergebnisse veröffentlichten, haben andere Teams Daten aus anderen Bevölkerungsgruppen hinzugefügt, die diesen Zusammenhang stützten: Fibronektin schützt. Die Daten von mehr als 11 000 Personen zeigten, dass die Mutation die Wahrscheinlichkeit, an Alzheimer zu erkranken, bei APOEε4 -Trägern um 71 % verringert und den Ausbruch der Krankheit bei denjenigen, die sie entwickeln, um etwa vier Jahre verzögert. Abbildung 2.

Nur etwa 1 bis 3 Prozent der APOEε4 -Träger in den USA besitzen auch die schützende Fibronektin-Mutation, das sind immerhin 200.000 bis 620.000 Menschen, schätzen die Forscher. Dieser angeborene Schutzschild könnte die Forschung inspirieren und zur Entwicklung neuer Medikamente führen, die noch viel mehr Menschen helfen könnten.

Kizil fasst zusammen: "Es gibt einen signifikanten Unterschied im Fibronektinspiegel in der Blut-Hirn-Schranke zwischen kognitiv gesunden Menschen und Alzheimer-Patienten, unabhängig von ihrem APOEε4 -Status. Alles, was überschüssiges Fibronektin reduziert, sollte einen gewissen Schutz bieten, und ein Medikament, das dies tut, könnte ein bedeutender Fortschritt im Kampf gegen diese zehrende Krankheit sein."

[1] Arboleda-Velasquez JF et al., Resistance to autosomal dominant Alzheimer's disease in an APOE3 Christchurch homozygote: a case report. Nat Med. 2019 Nov;25(11):1680-1683. DOI: 10.1038/s41591-019-0611-3

[2] Chen Y et al., APOE3ch alters microglial response and suppresses Aβ-induced tau seeding and spread. Cell. 2024 Jan 18;187(2):428-445.e20. doi: 10.1016/j.cell.2023.11.029

[3] Lopera F. et al., Resilience to autosomal dominant Alzheimer’s disease in a Reelin-COLBOS heterozygous man. Nat Med 29, 1243–1252 (2023). https://doi.org/10.1038/s41591-023-02318-3

[4] Bhattarai, P., Gunasekaran, T.I., Belloy, M.E. et al. Rare genetic variation in fibronectin 1 (FN1) protects against APOEε4 in Alzheimer’s disease. Acta Neuropathol 147, 70 (2024). https://doi.org/10.1007/s00401-024-02721-1.

* Der Artikel ist erstmals am 18. April 2024 in PLOS Blogs - DNA Science Blog unter dem Titel "Mutations in Three Genes Protect Against Alzheimer’s" https://dnascience.plos.org/2024/04/18/mutations-in-three-genes-protect-against-alzheimers/ erschienen und steht unter einer cc-by Lizenz. Die Autorin hat sich freundlicherweise mit der Übersetzung ihrer Artikel durch ScienceBlog.at einverstanden erklärt, welche so genau wie möglich der englischen Fassung folgt. Abbildung 2 plus Text wurden von der Redaktion aus der zitierten Publikation [4] eingefügt.

Im ScienceBlog: Zur Blut-Hirn-Schranke

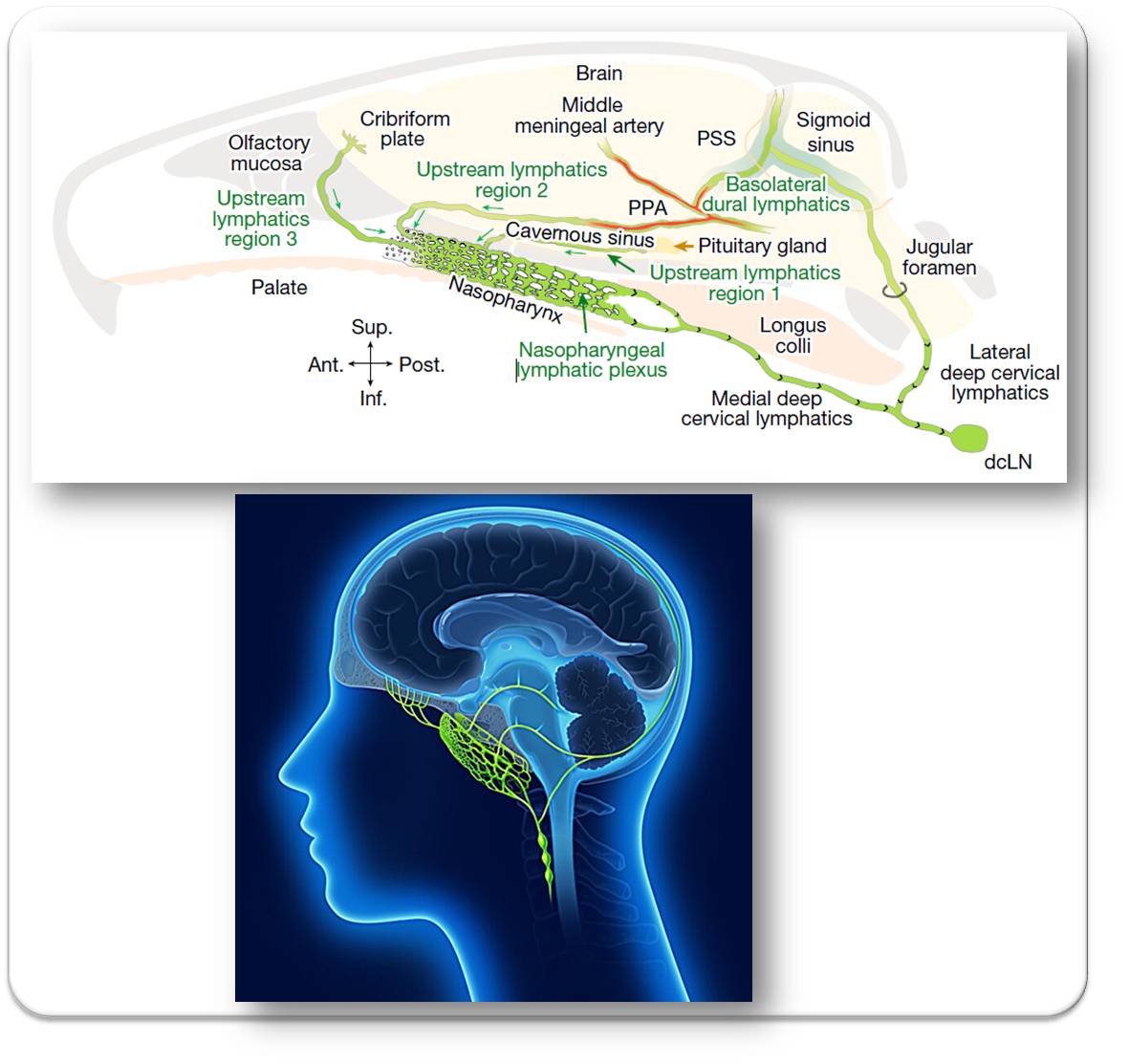

Inge Schuster, 12.02.2024: Zur Drainage des Gehirngewebes über ein Netzwerk von Lymphgefäßen im Nasen-Rachenraum

Redaktion, 06.02.2020:Eine Schranke in unserem Gehirn stoppt das Eindringen von Medikamenten. Wie lässt sich diese Schranke überwinden?

Redaktion, 10.10.2017: Ein neues Kapitel in der Hirnforschung: das menschliche Gehirn kann Abfallprodukte über ein Lymphsystem entsorgen.

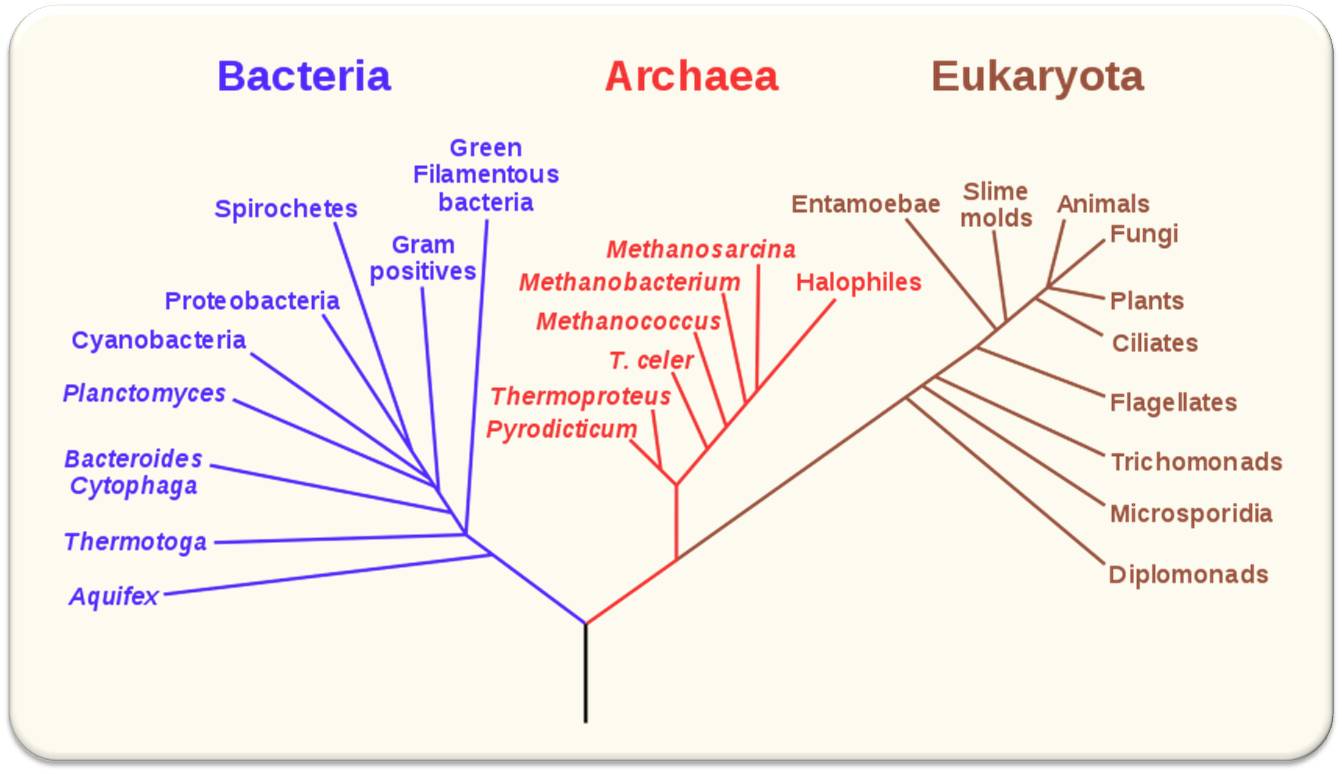

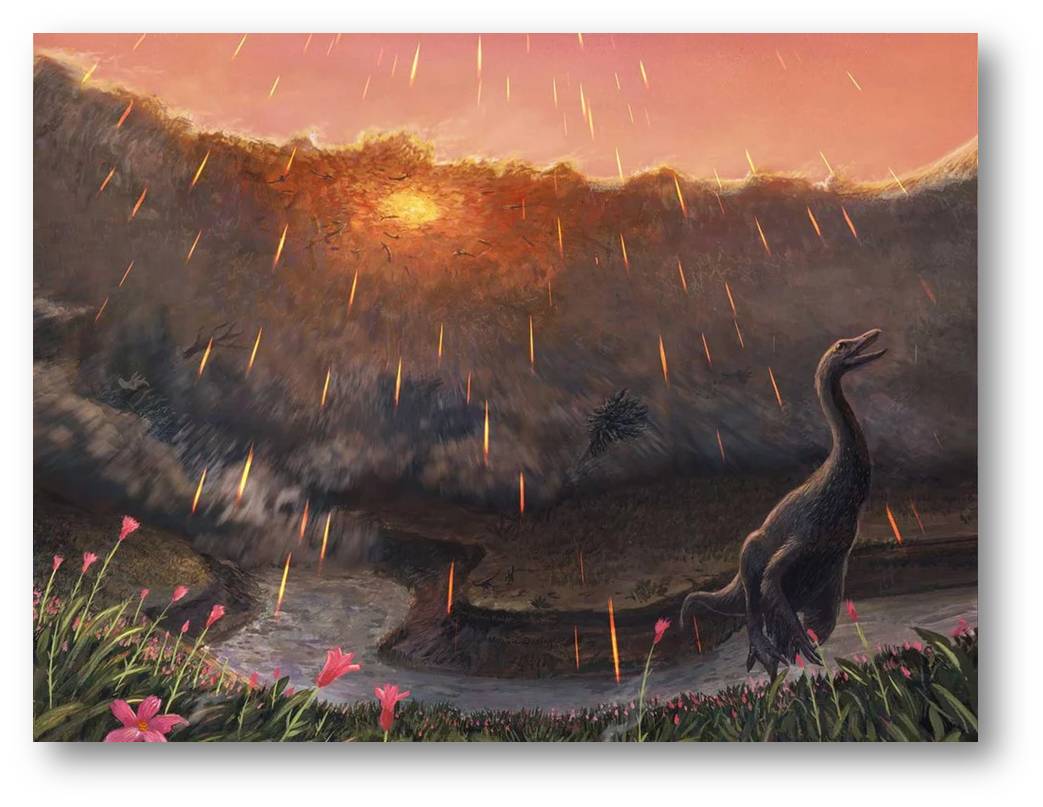

Zehn Mythen, welche die Anerkennung des Anthropozäns als neue geochronologische Epoche untergraben

Zehn Mythen, welche die Anerkennung des Anthropozäns als neue geochronologische Epoche untergrabenDo, 25.04.2024 — Redaktion

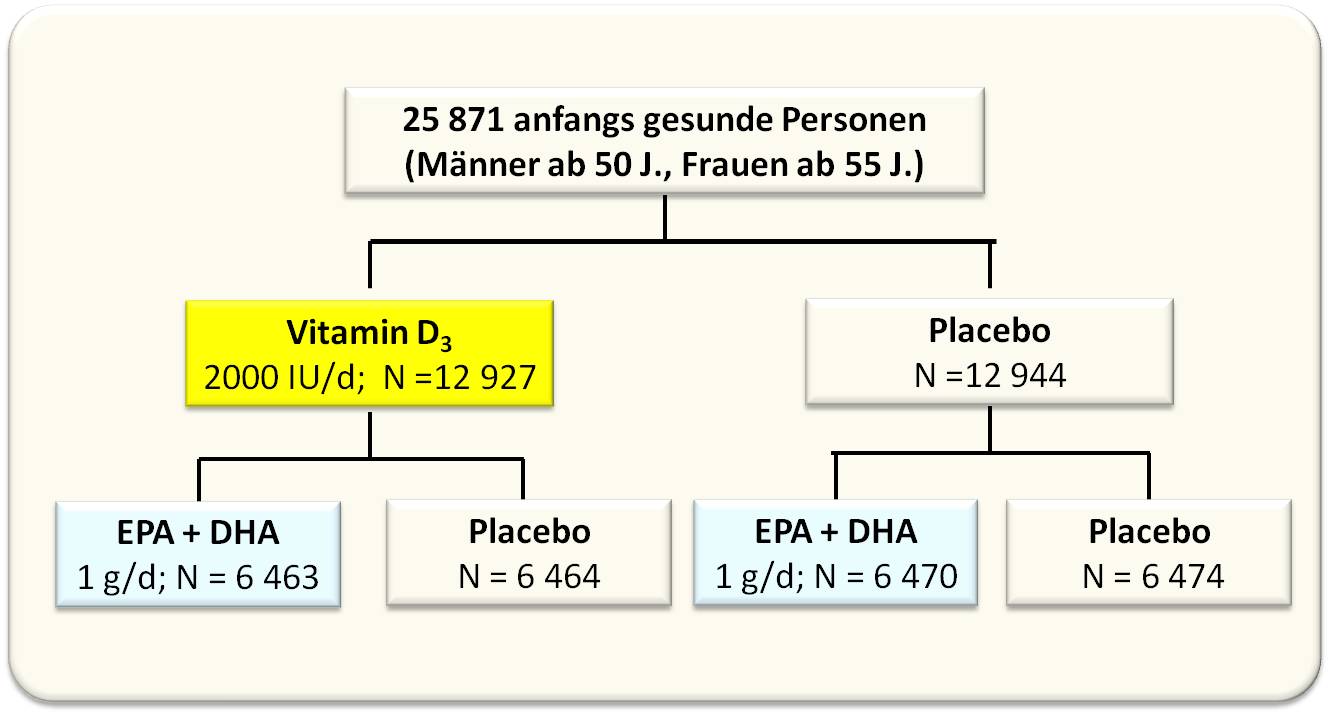

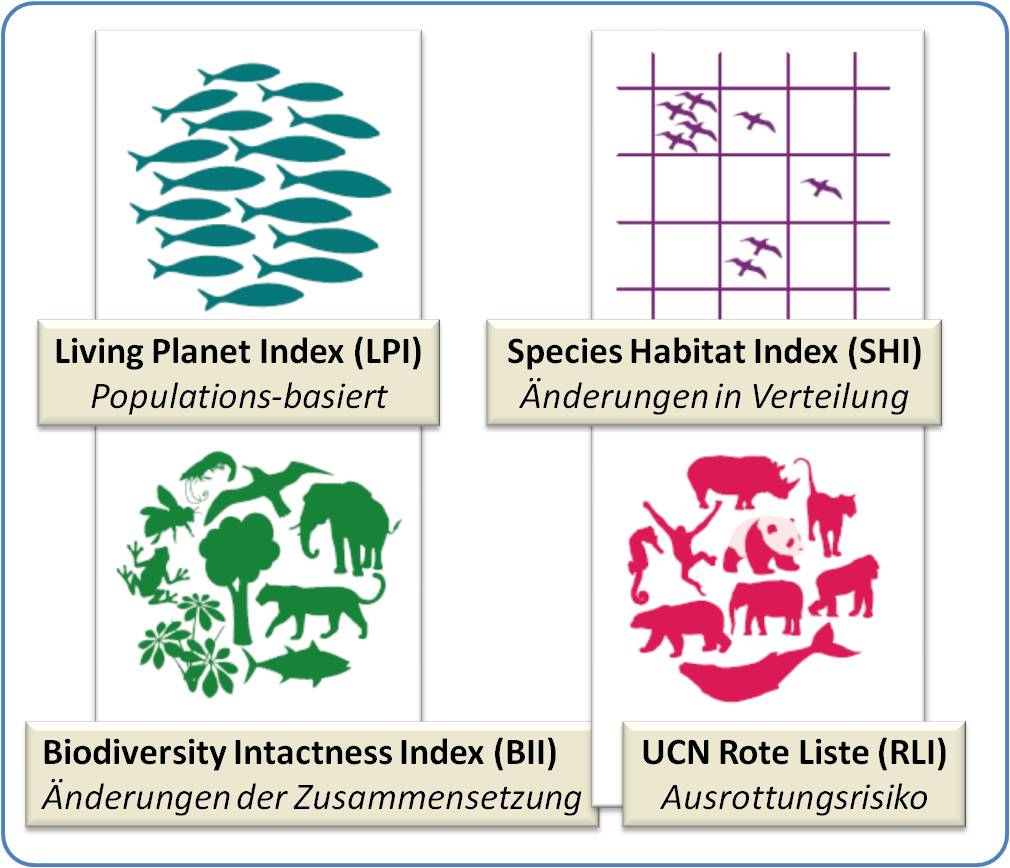

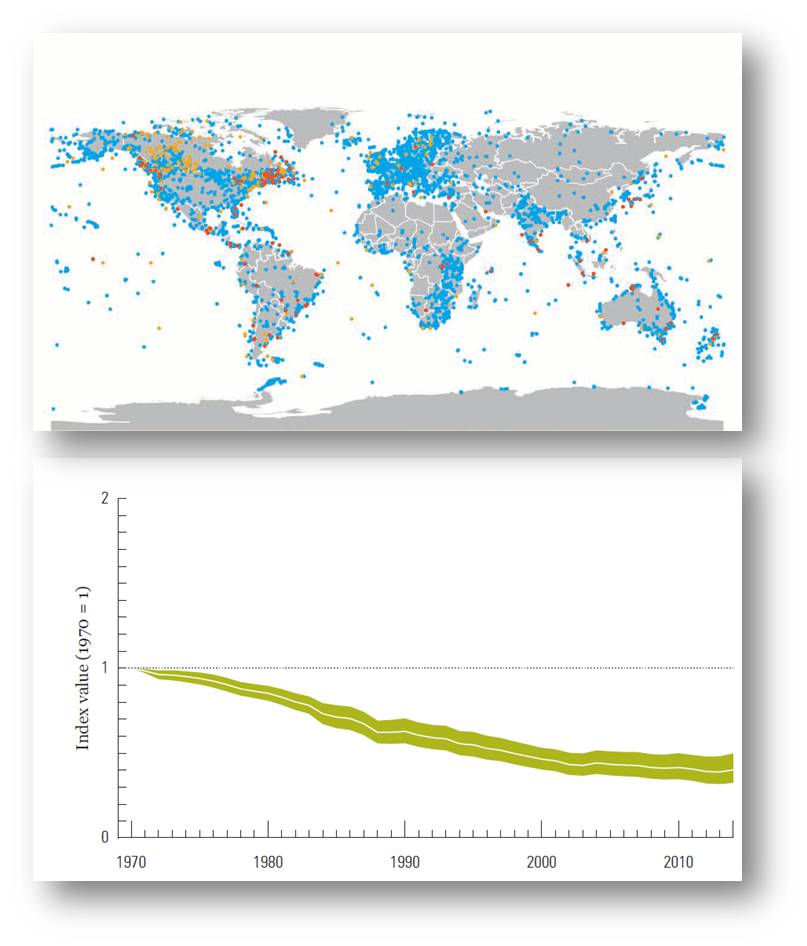

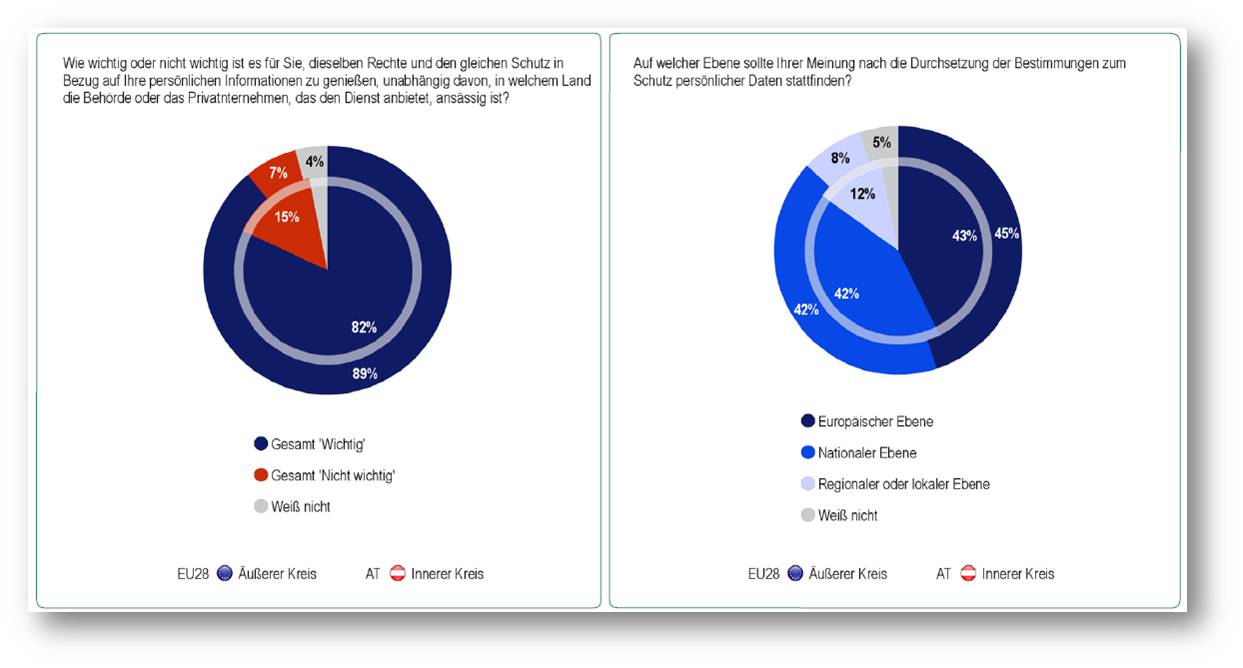

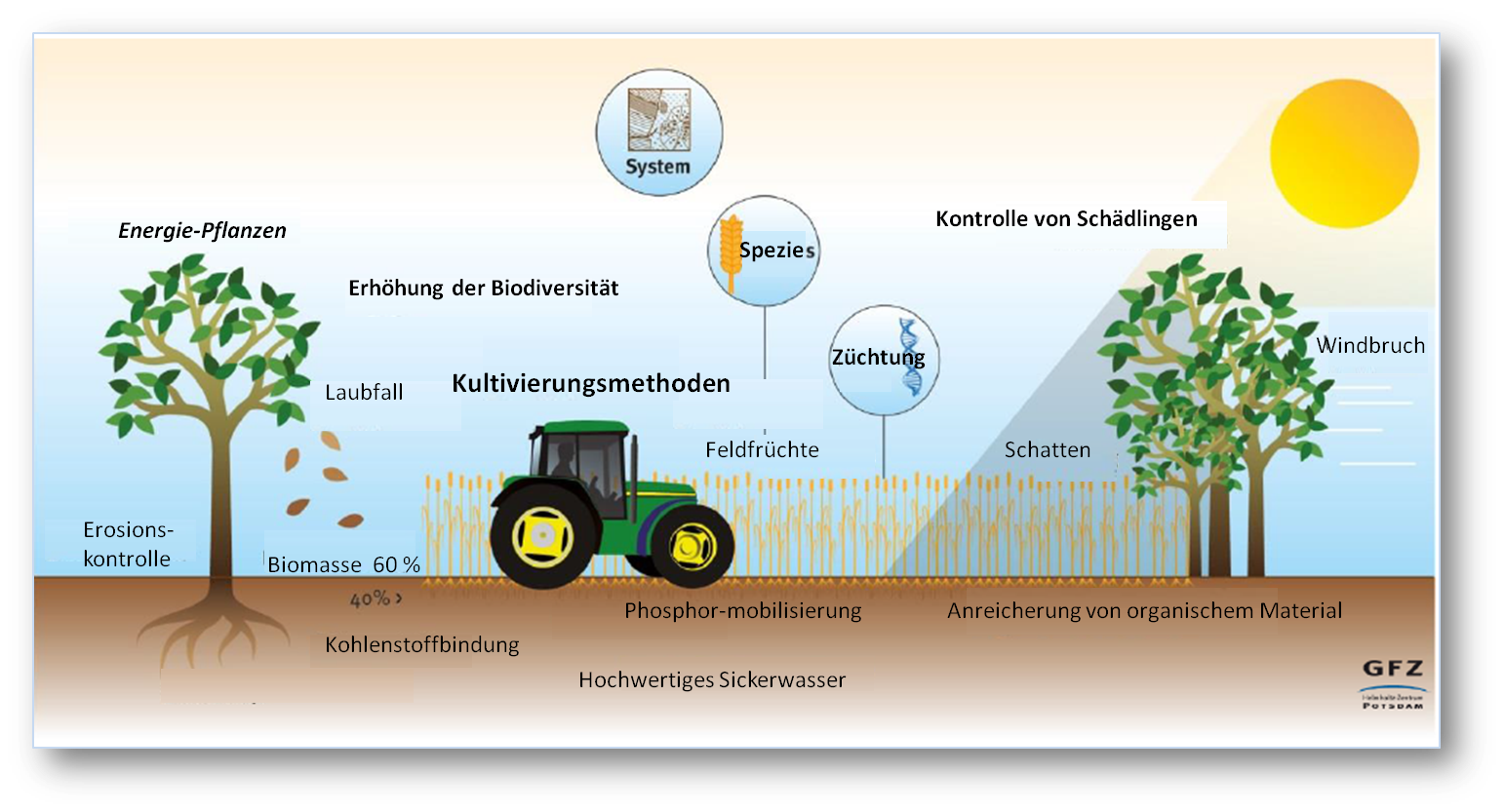

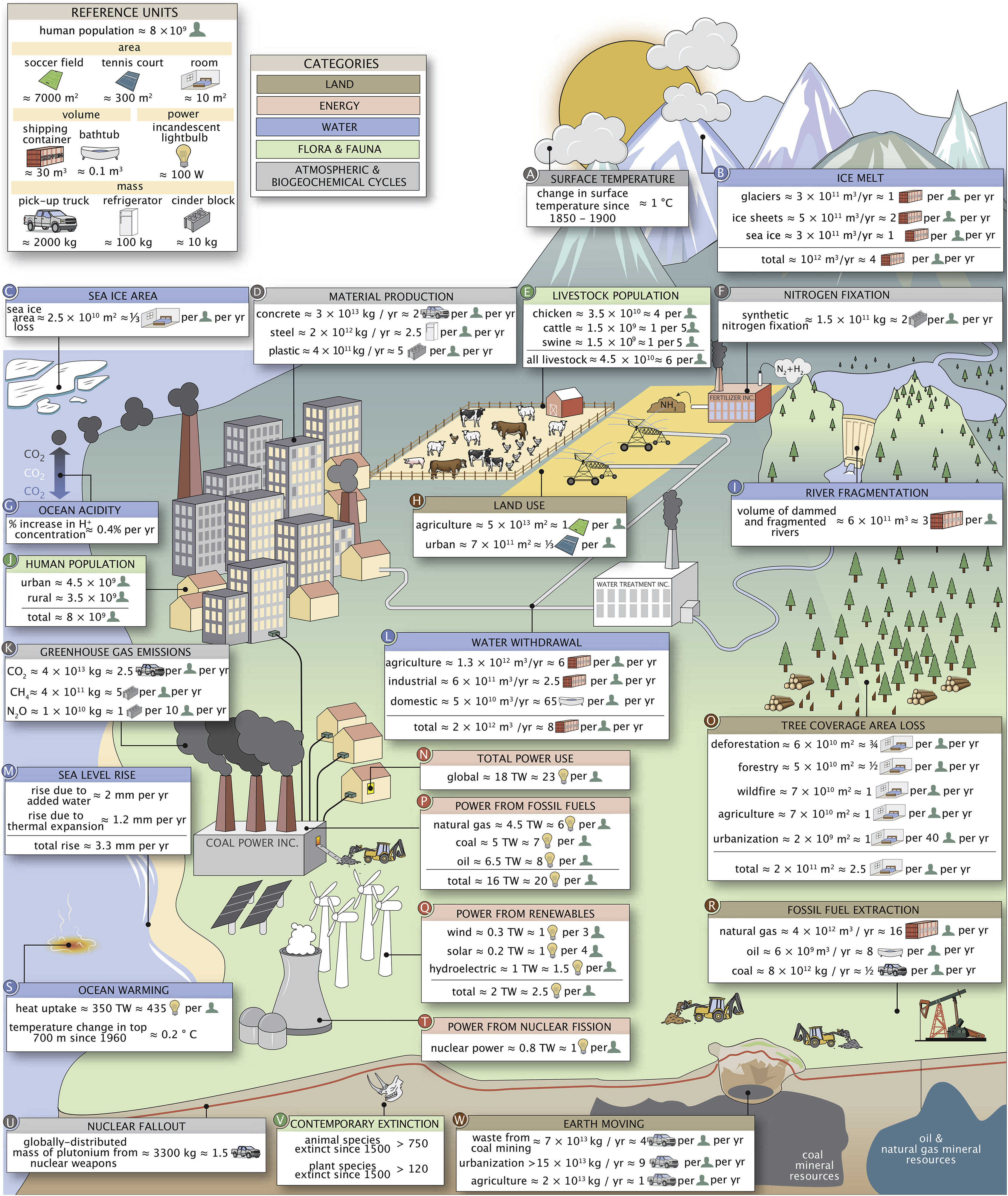

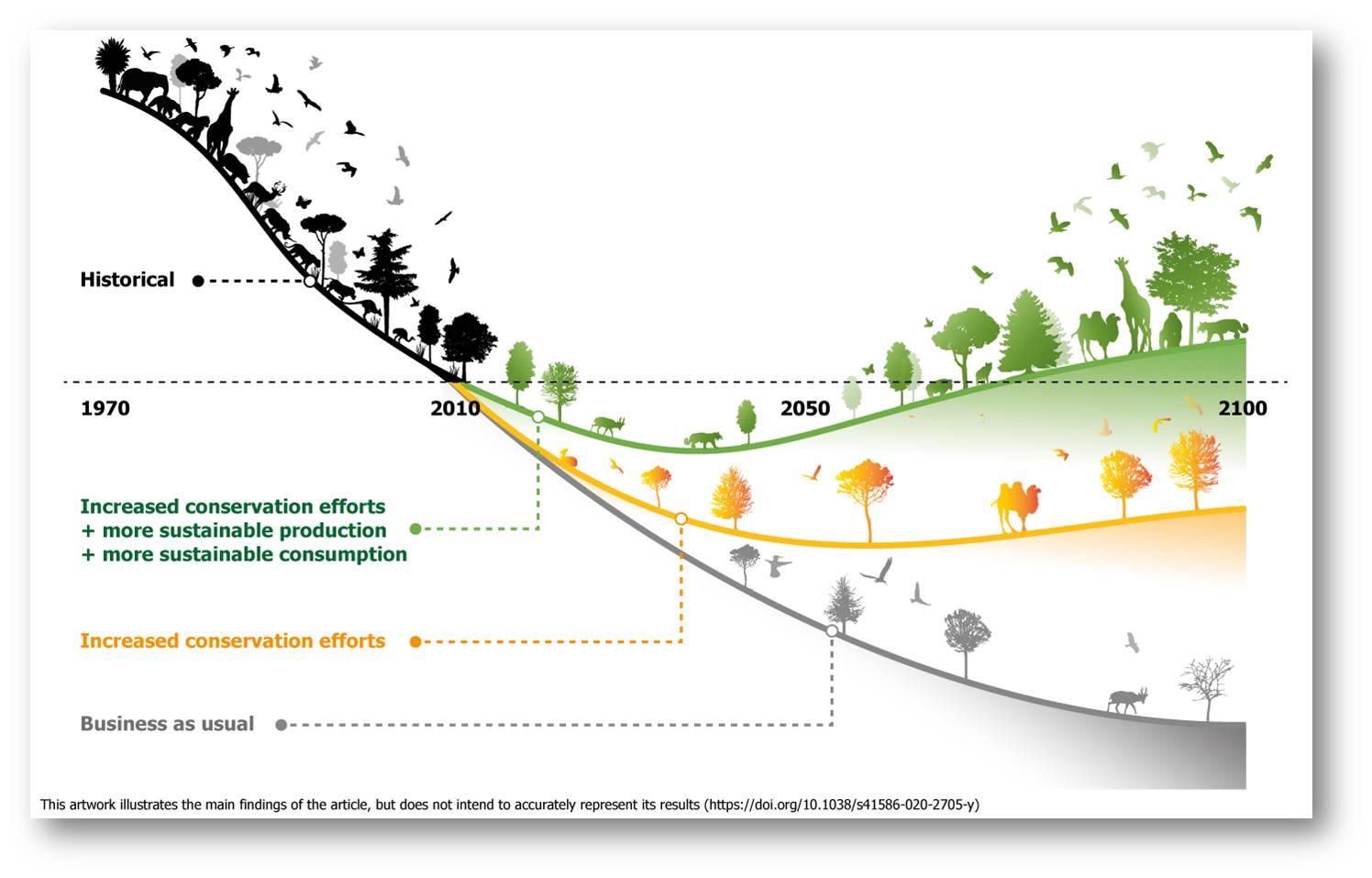

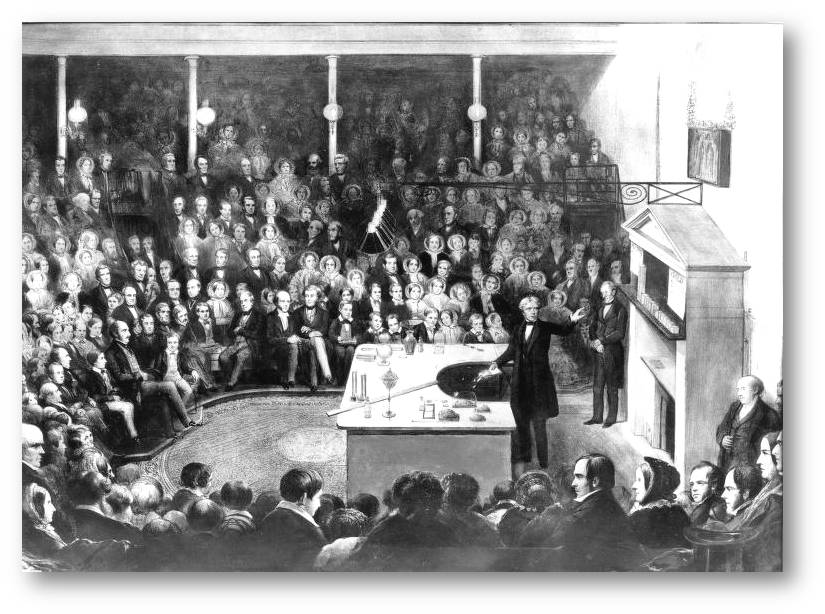

![]() Es ist unbestreitbar, dass menschliche Aktivitäten vor allem in den letzten 70 Jahren Klima, Natur, Erdoberfläche und damit die Bewohnbarkeit des Planeten für alle seine derzeit und künftig lebenden Organismen in negativem Sinne verändert haben. Ist damit das Anthropozän, ein neues "Zeitalter des Menschen" angebrochen? Die International Union of Geological Sciences hat 2009 eine Arbeitsgruppe eingerichtet, die prüfen sollte, ob das Anthropozän als neue formale erdgeschichtliche Epoche etabliert werden sollte. Nach eingehender Prüfung lagen 2023 genügend geologisch-stratigrafische Argumente für eine Anerkennung vor. Die Anerkennung sollte auch eine Perspektive implizieren, um mit der bereits drastisch veränderten Welt umzugehen. Dass ein Gutachtergremium im März 2024 entschied die Anerkennung abzulehnen, hat den Protest der Anthropozän-Arbeitsgruppe ausgelöst. Unter Federführung ihrer Vorsitzenden Jan Zalasiewicz (University of Leicester) und Scott Wing (Smithsonian Institution, Washington) hat die Arbeitsgruppe einen Artikel im Smithsonian Magazine verfasst, in dem zehn Trugschlüsse (Mythen) angesprochen werden, die herunter spielen, wie drastisch die Erde in den letzten Jahrzehnten verändert wurde.*

Es ist unbestreitbar, dass menschliche Aktivitäten vor allem in den letzten 70 Jahren Klima, Natur, Erdoberfläche und damit die Bewohnbarkeit des Planeten für alle seine derzeit und künftig lebenden Organismen in negativem Sinne verändert haben. Ist damit das Anthropozän, ein neues "Zeitalter des Menschen" angebrochen? Die International Union of Geological Sciences hat 2009 eine Arbeitsgruppe eingerichtet, die prüfen sollte, ob das Anthropozän als neue formale erdgeschichtliche Epoche etabliert werden sollte. Nach eingehender Prüfung lagen 2023 genügend geologisch-stratigrafische Argumente für eine Anerkennung vor. Die Anerkennung sollte auch eine Perspektive implizieren, um mit der bereits drastisch veränderten Welt umzugehen. Dass ein Gutachtergremium im März 2024 entschied die Anerkennung abzulehnen, hat den Protest der Anthropozän-Arbeitsgruppe ausgelöst. Unter Federführung ihrer Vorsitzenden Jan Zalasiewicz (University of Leicester) und Scott Wing (Smithsonian Institution, Washington) hat die Arbeitsgruppe einen Artikel im Smithsonian Magazine verfasst, in dem zehn Trugschlüsse (Mythen) angesprochen werden, die herunter spielen, wie drastisch die Erde in den letzten Jahrzehnten verändert wurde.*

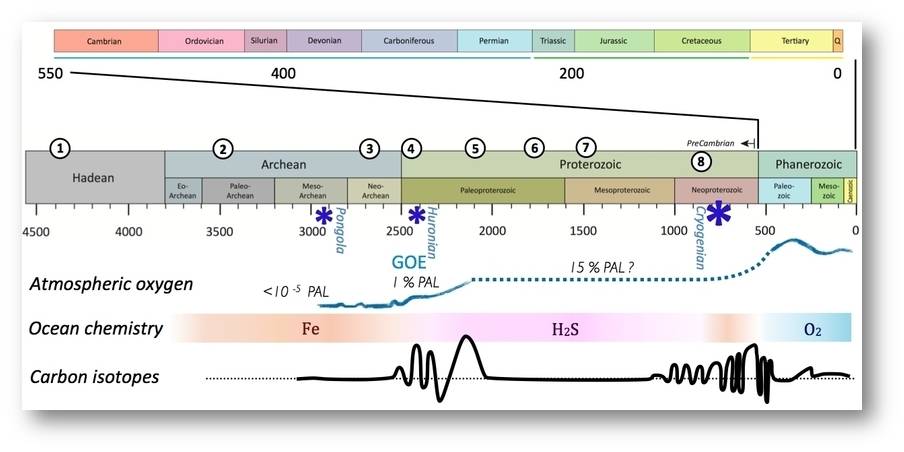

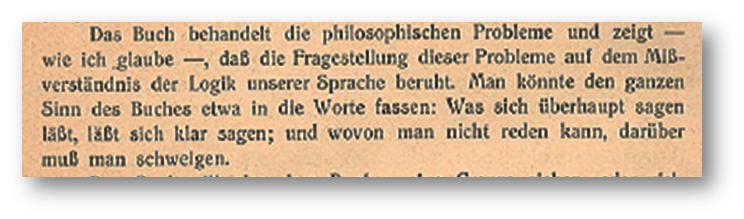

Der Begriff der Anthropozän-Epoche

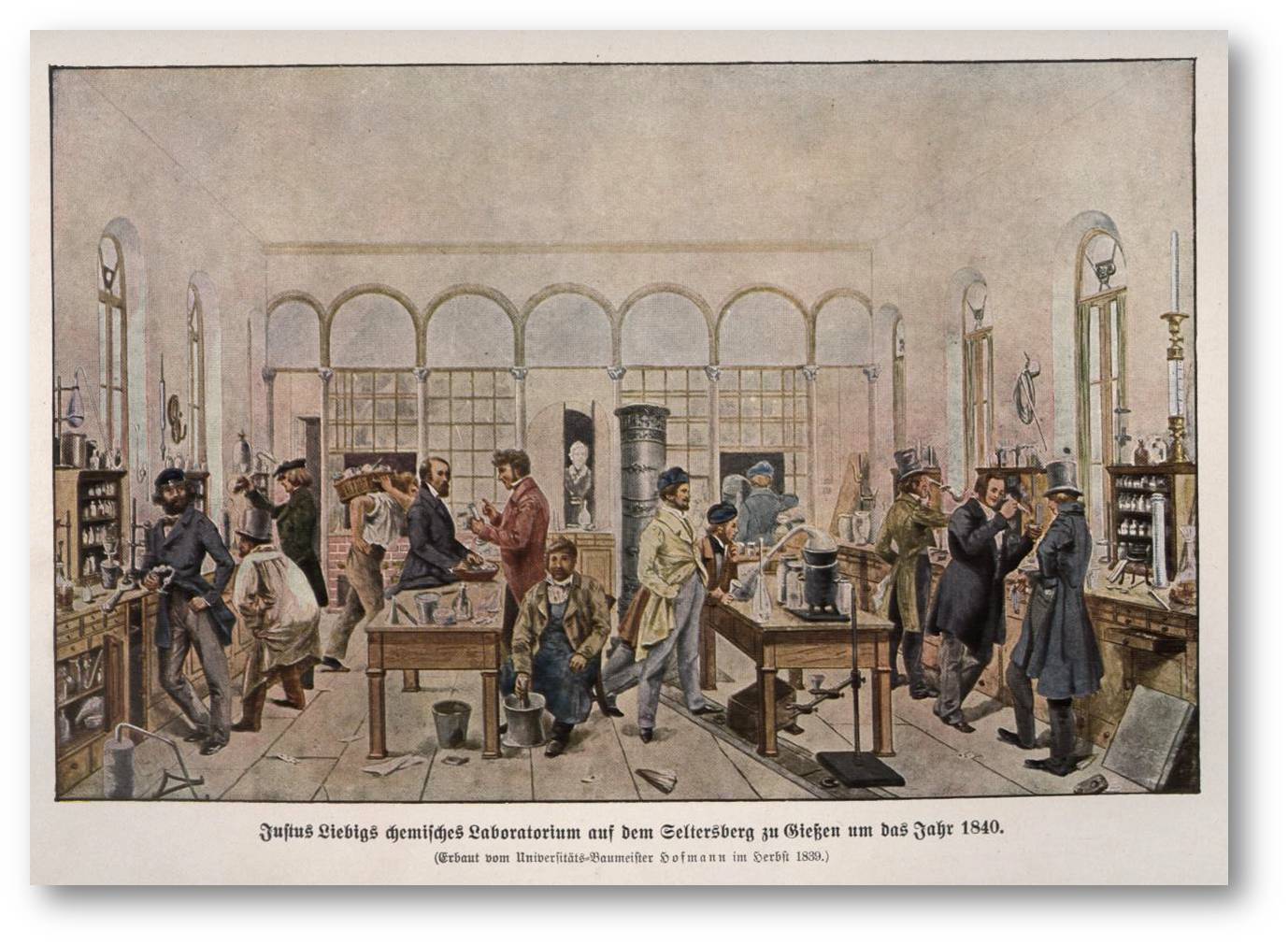

entstand im Februar 2000 aus einer spontanen Eingebung heraus. Der Chemiker und Nobelpreisträger Paul Crutzen hatte auf einer Tagung des International Geosphere-Biosphere Programme in Mexiko den Vorträgen zugehört. Den ganzen Tag über hatten Wissenschaftler Daten präsentiert, die zeigten, wie sich die vom Menschen verursachten Veränderungen des Klimas, der chemischen Zyklen und der Biologie der letzten Jahrzehnte auf krasse Weise von der relativen Stabilität des Holozäns, der geologischen Epoche, die vor 11.700 Jahren begann, unterschieden. Sie verwiesen immer wieder auf die bemerkenswert schnellen Umweltveränderungen des späten Holozäns.

Entnervt schaltete sich Crutzen schließlich in die Diskussion ein: "Wir befinden uns nicht mehr im Holozän, sondern im ... Anthropozän!" Die improvisierte Bezeichnung setzte sich unter Geowissenschaftlern schnell als grundlegendes Konzept durch, und in den letzten zehn Jahren hat sich das Wort auch in anderen Wissenschaften, der Kunst, den Geisteswissenschaften und der Populärkultur verbreitet.

Im Laufe der Zeit hat "Anthropozän" viele Bedeutungen und Schlussfolgerungen erhalten, die nichts mit Crutzens ursprünglichem Begriff zu tun haben oder ihm sogar widersprechen, so dass seine ursprüngliche Bedeutung verschwommen und manchmal sogar völlig unklar wurde. Was aber hat Crutzen mit dem Anthropozän gemeint, einem Konzept, das durch jahrelange wissenschaftliche Studien verbessert und verfeinert wurde?

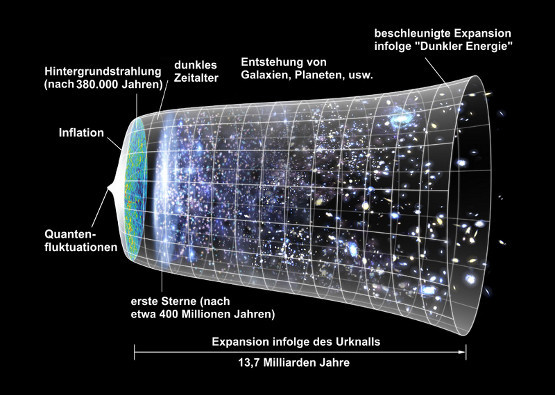

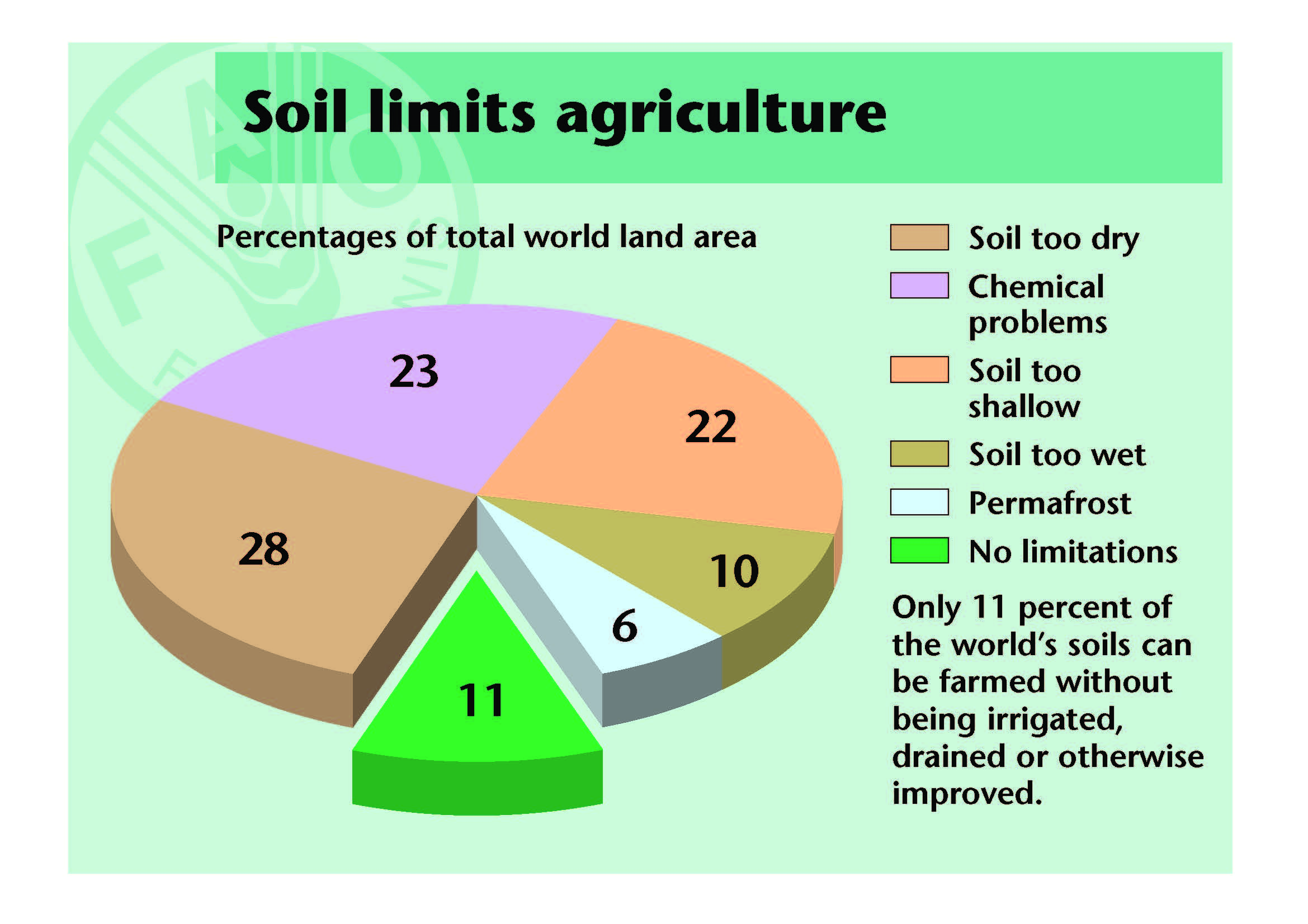

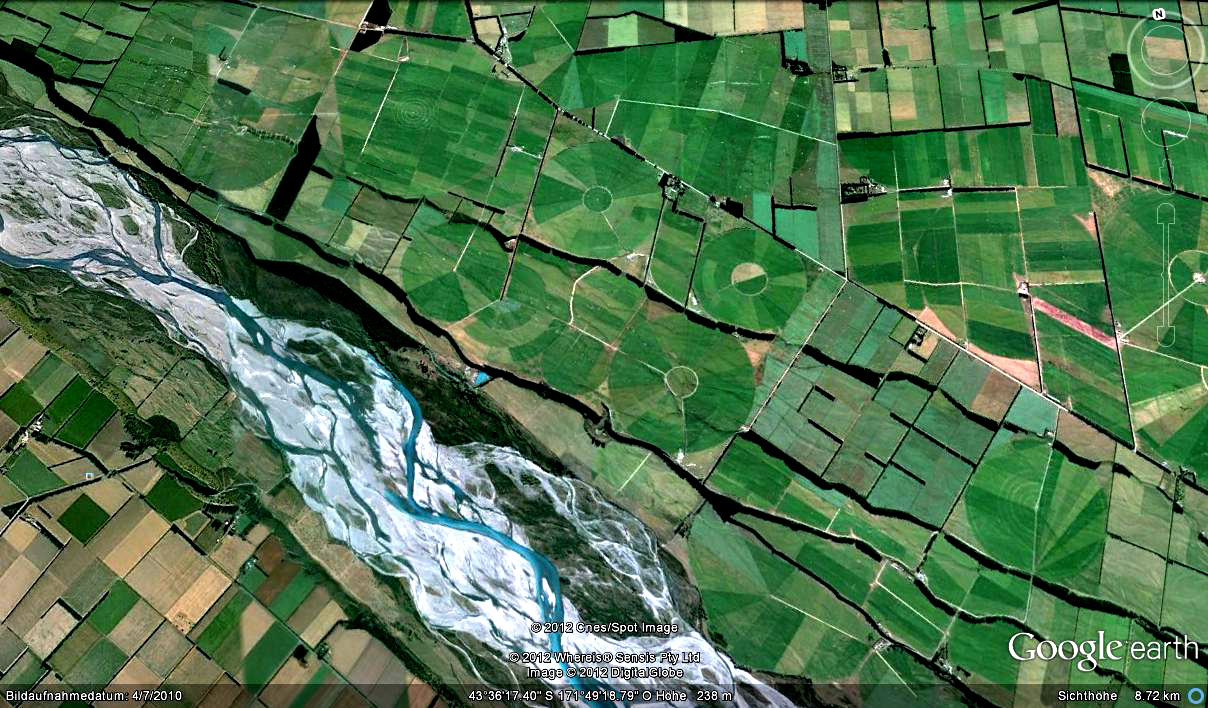

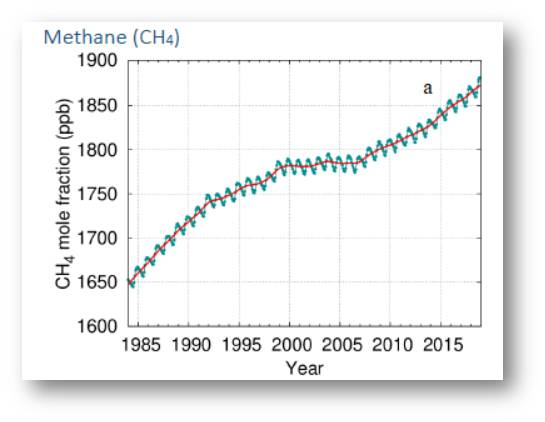

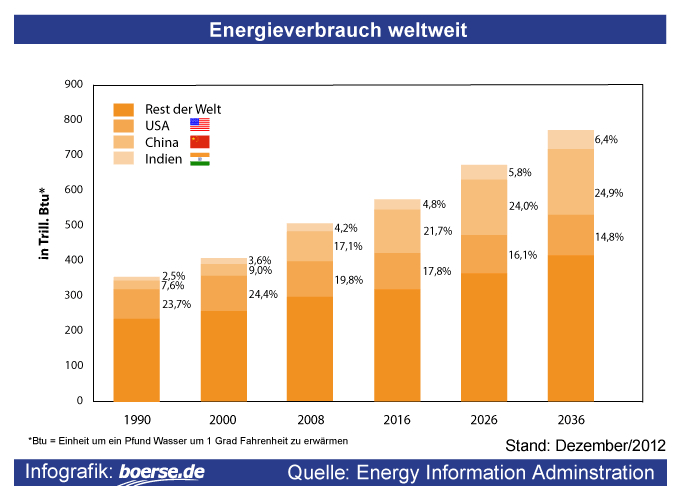

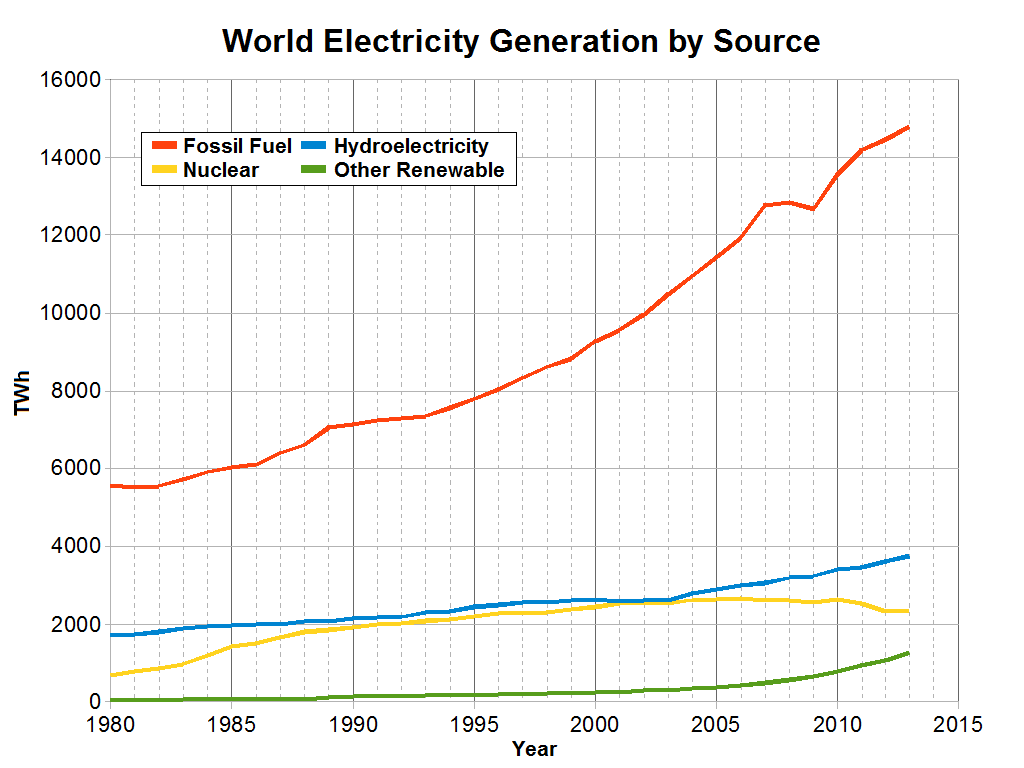

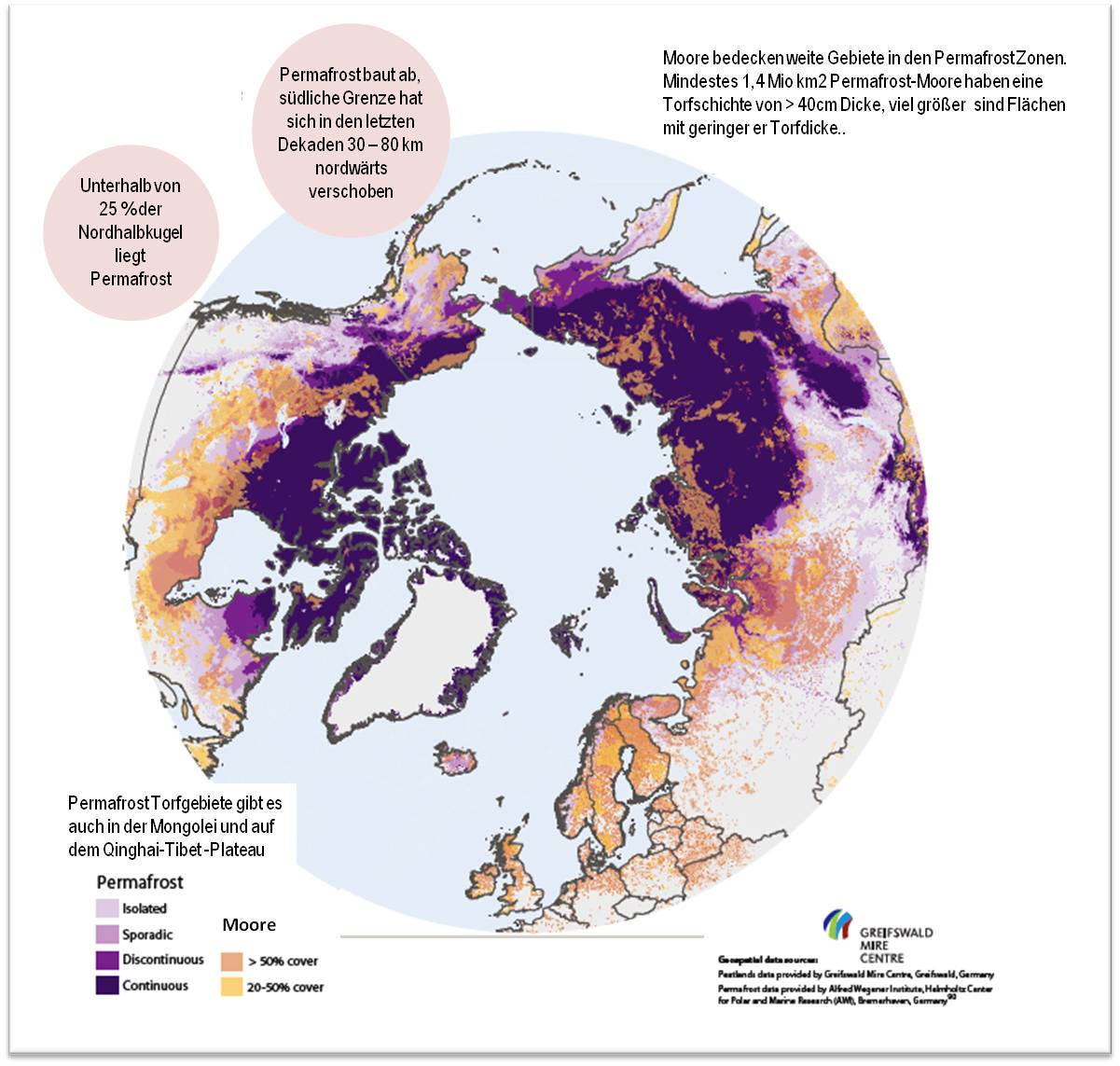

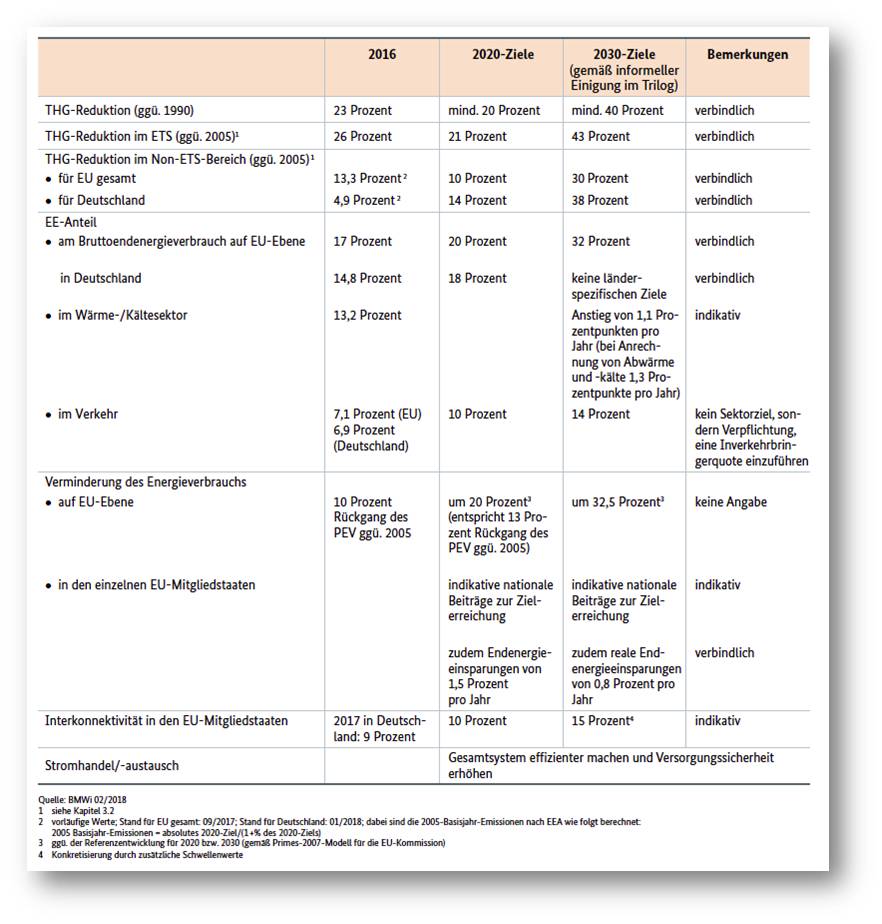

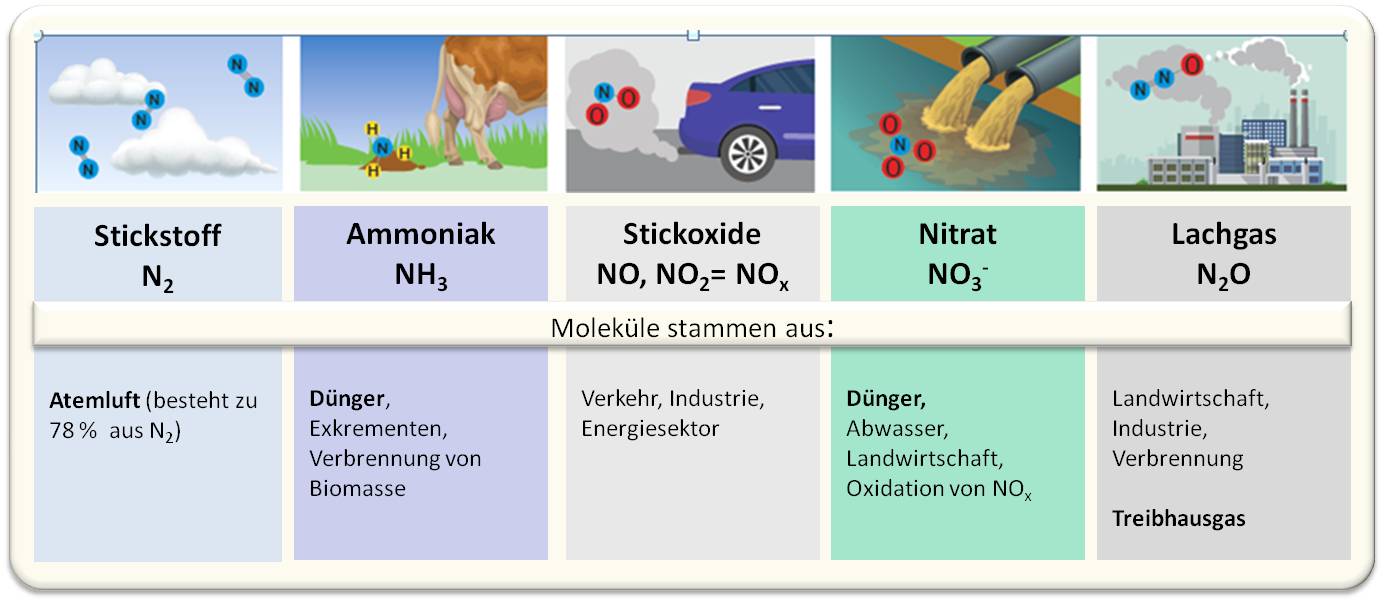

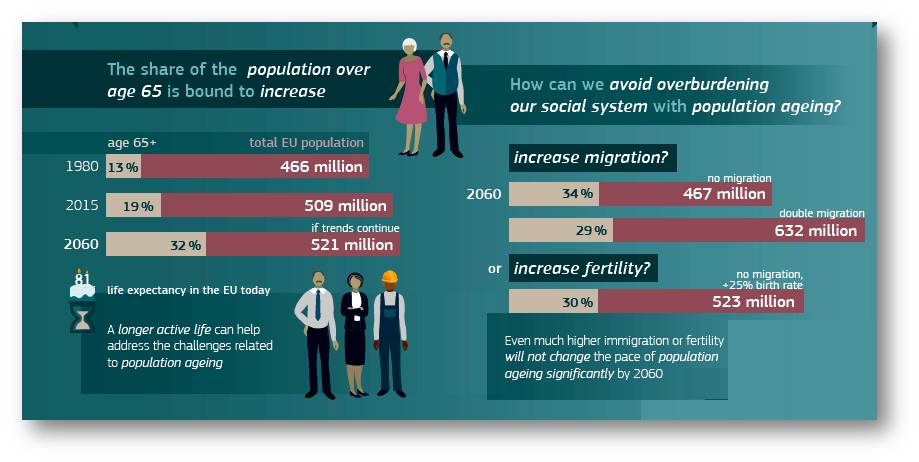

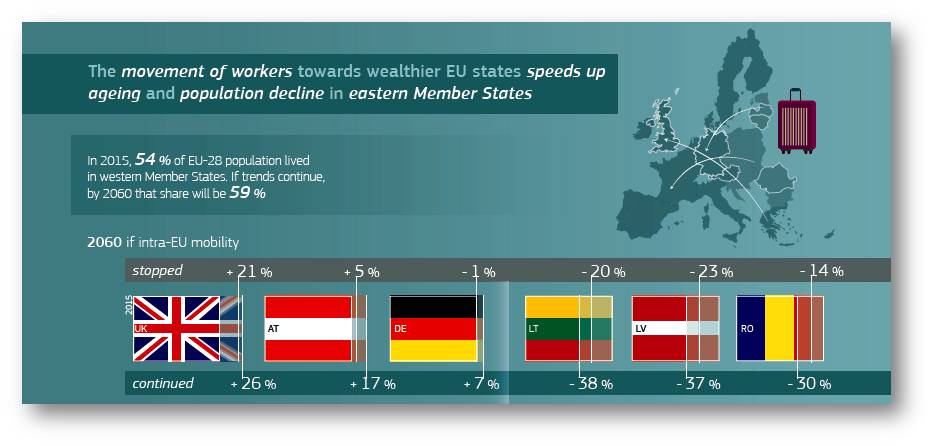

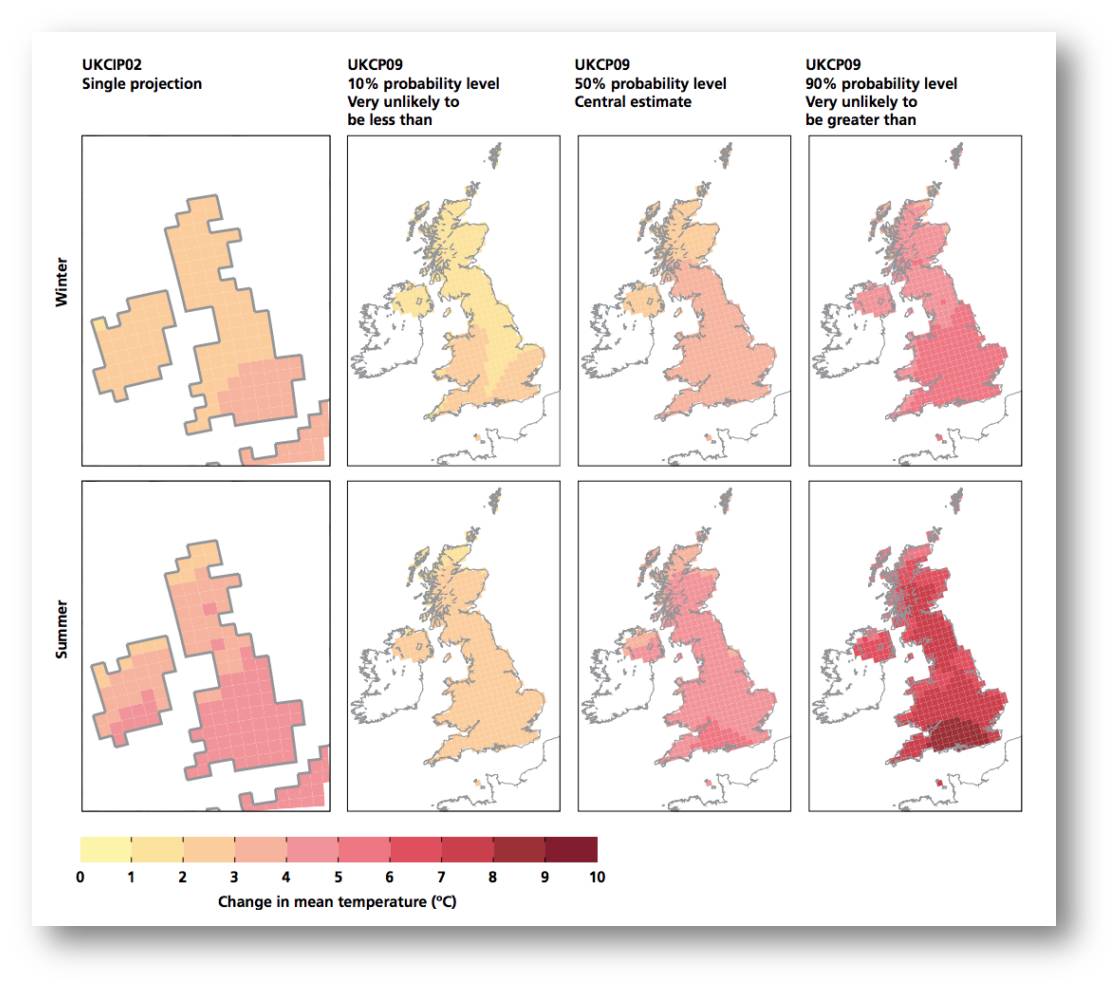

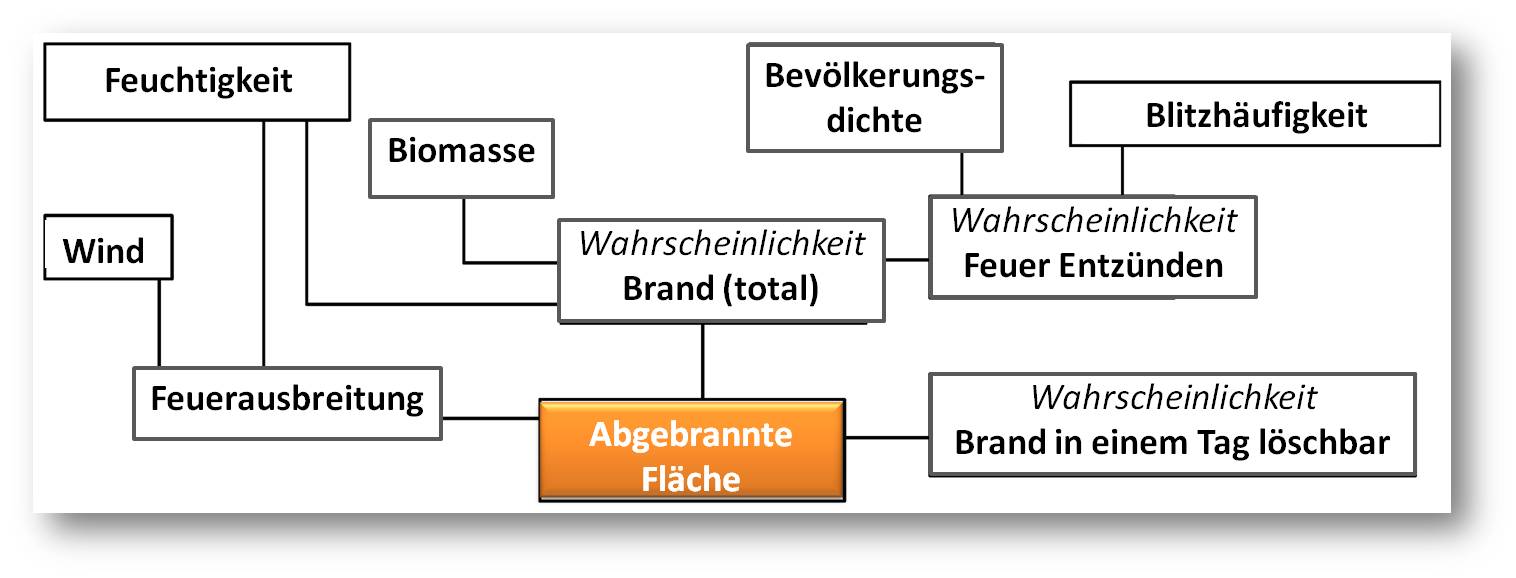

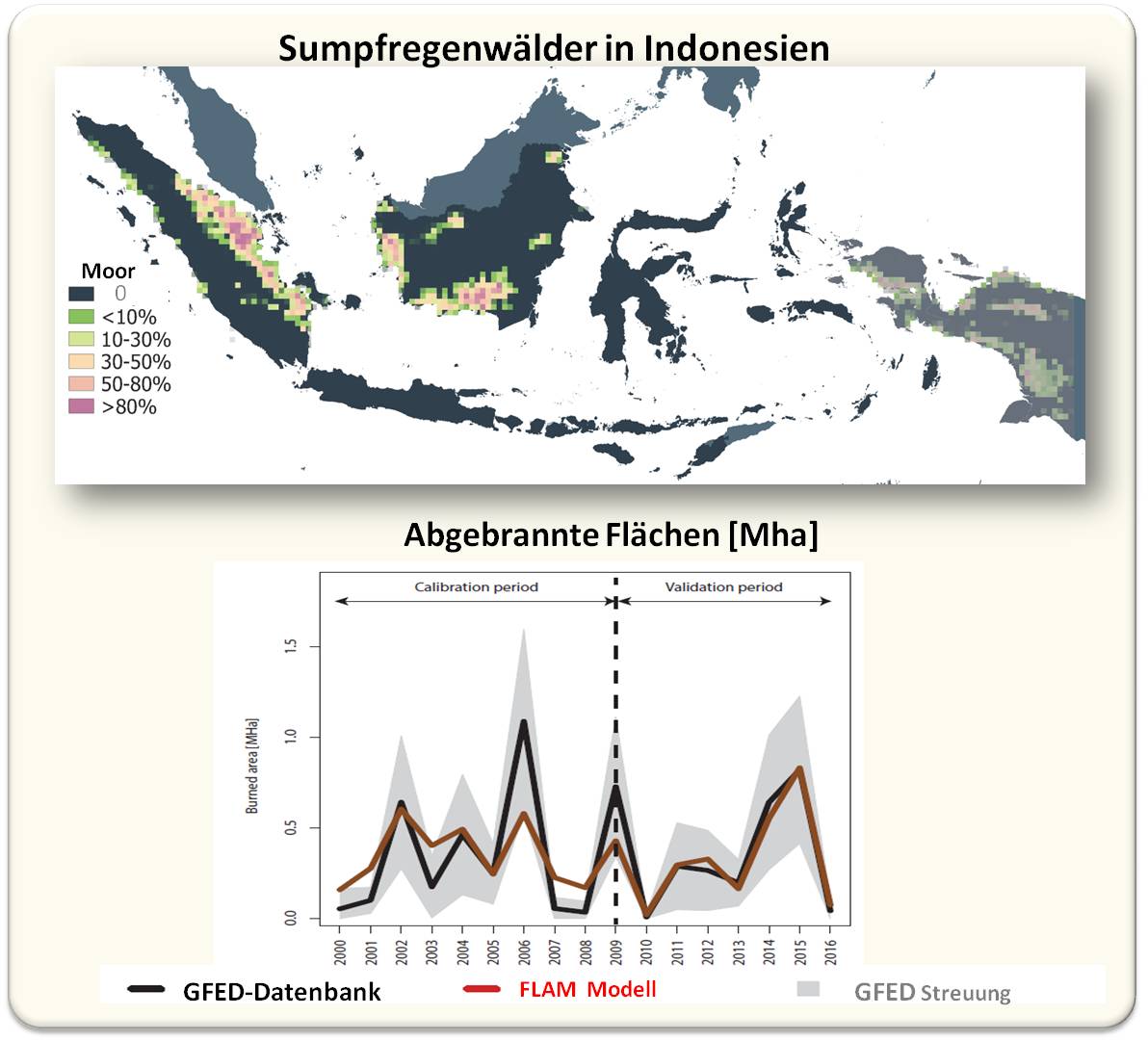

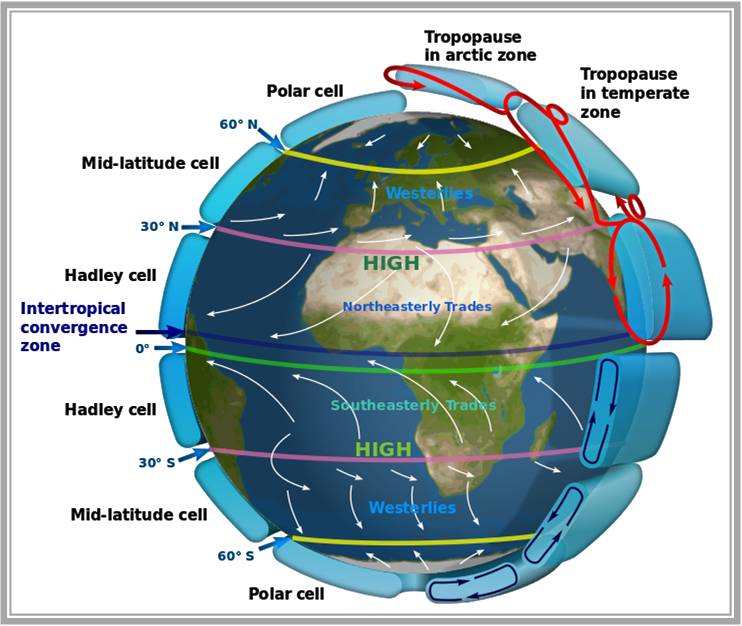

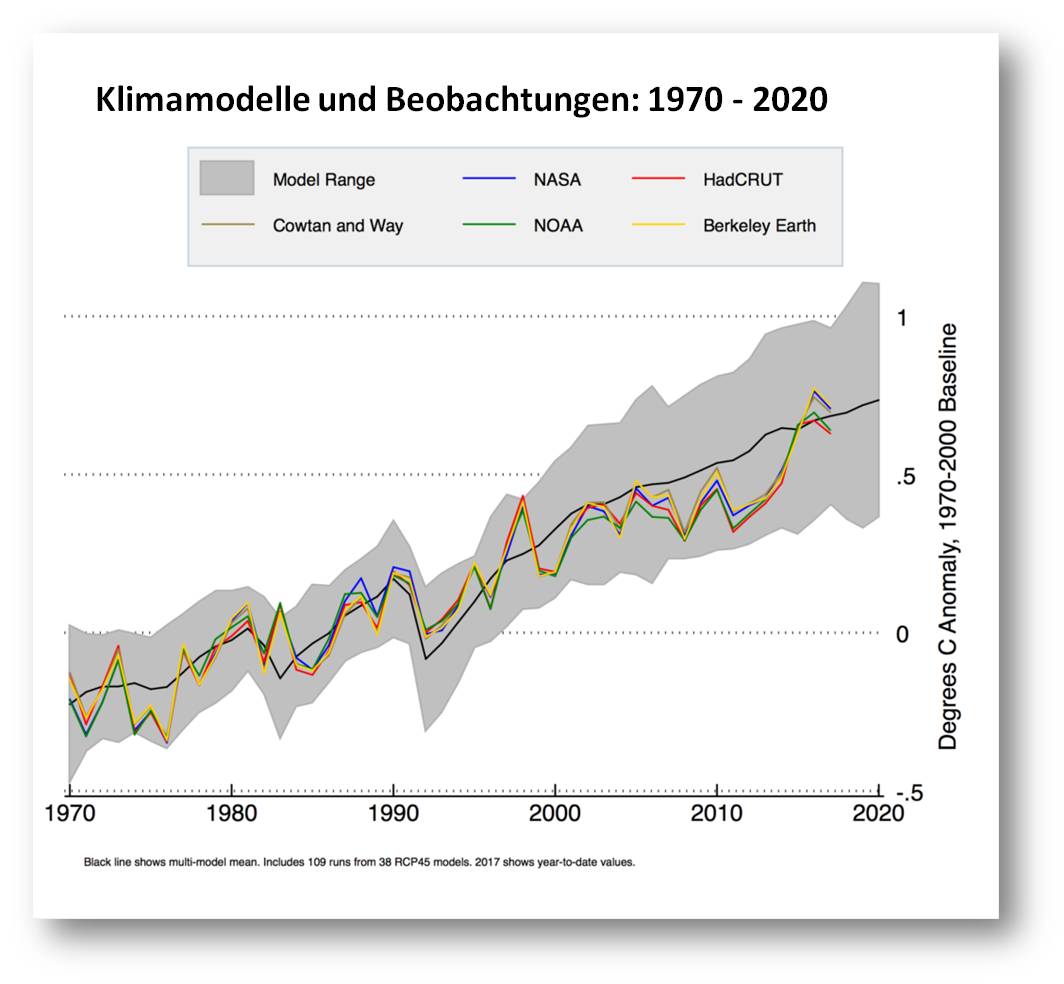

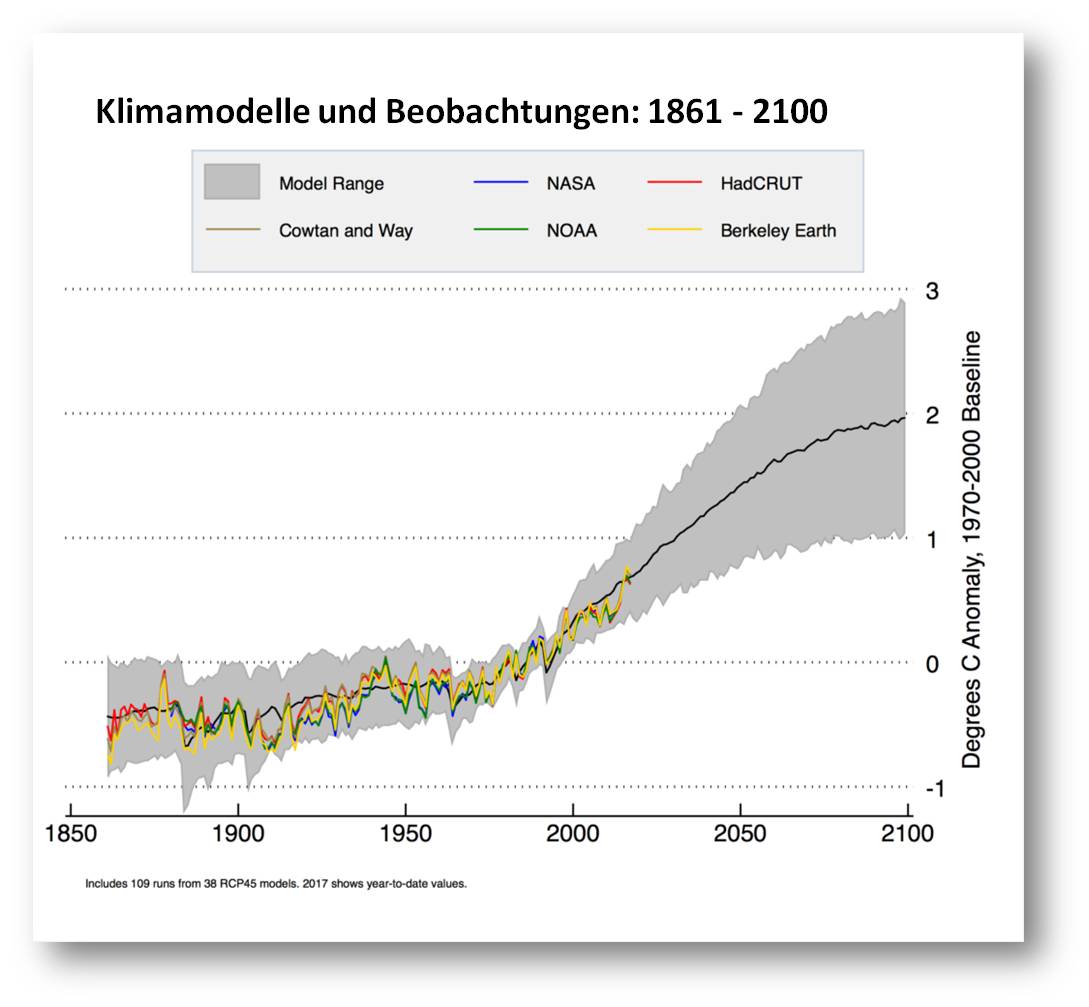

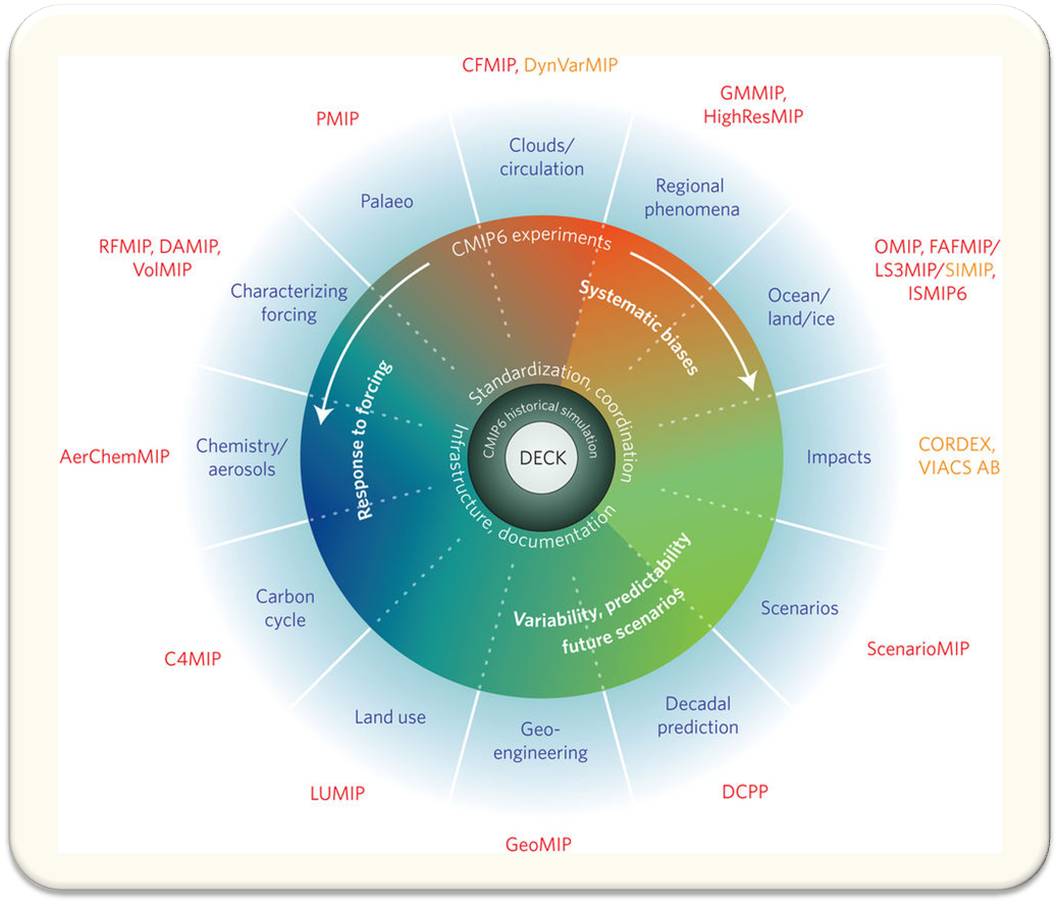

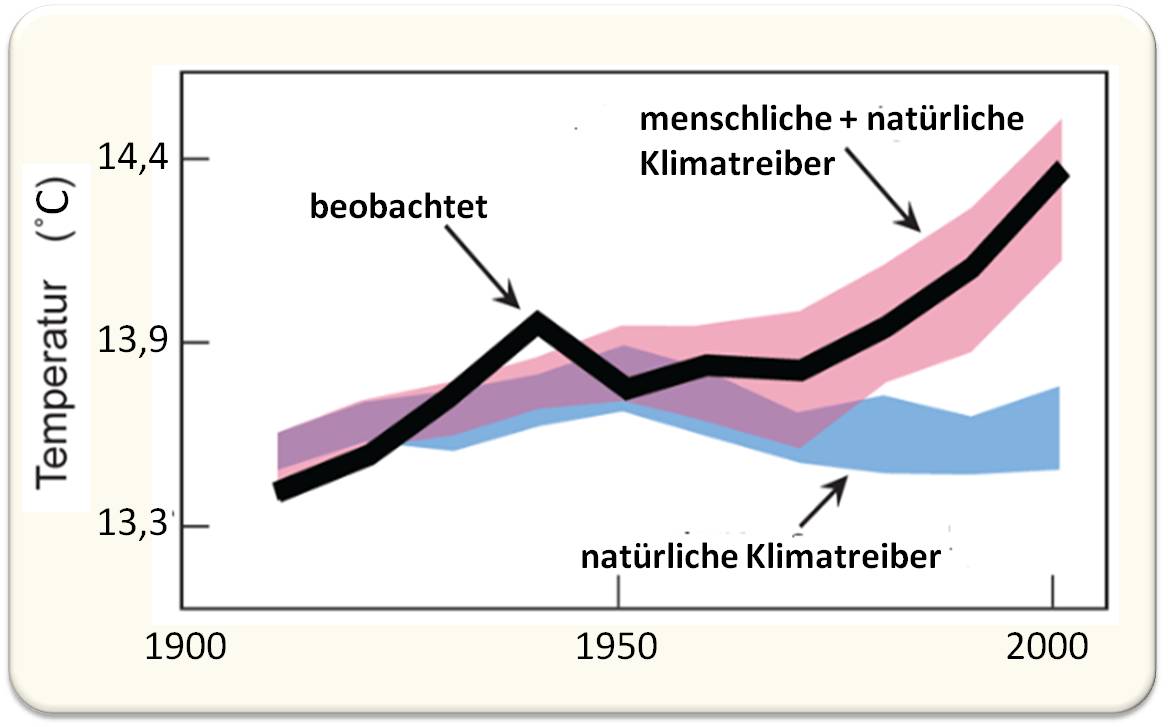

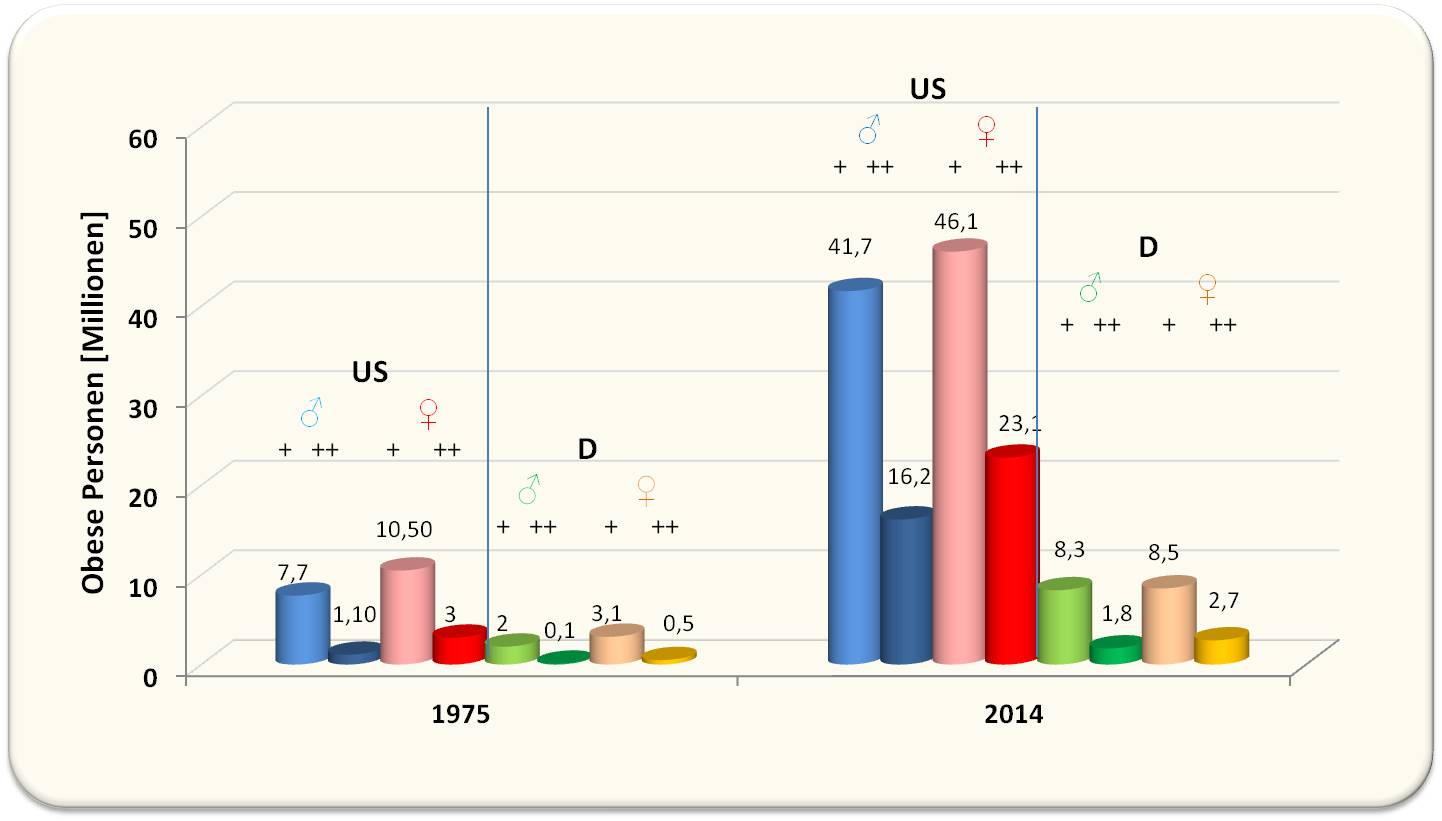

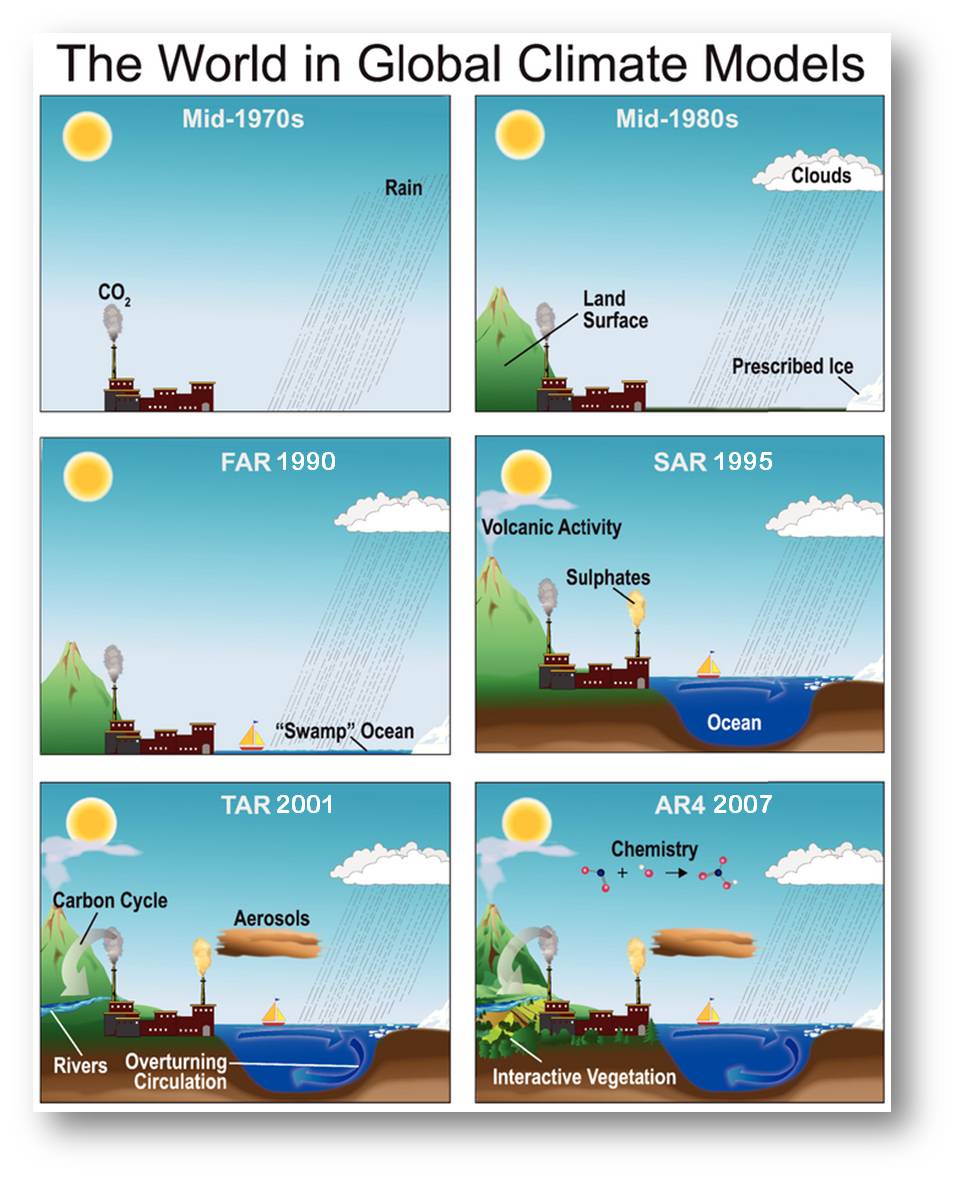

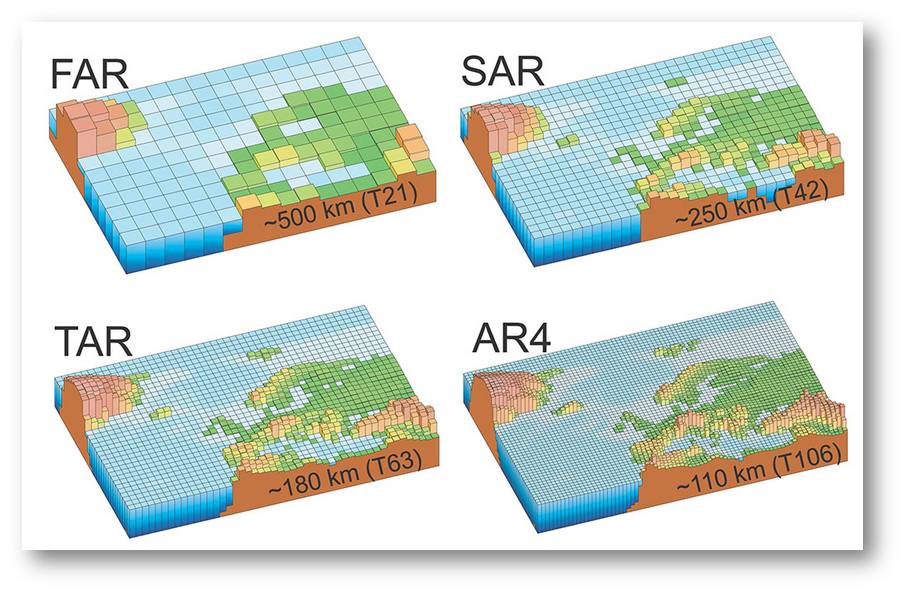

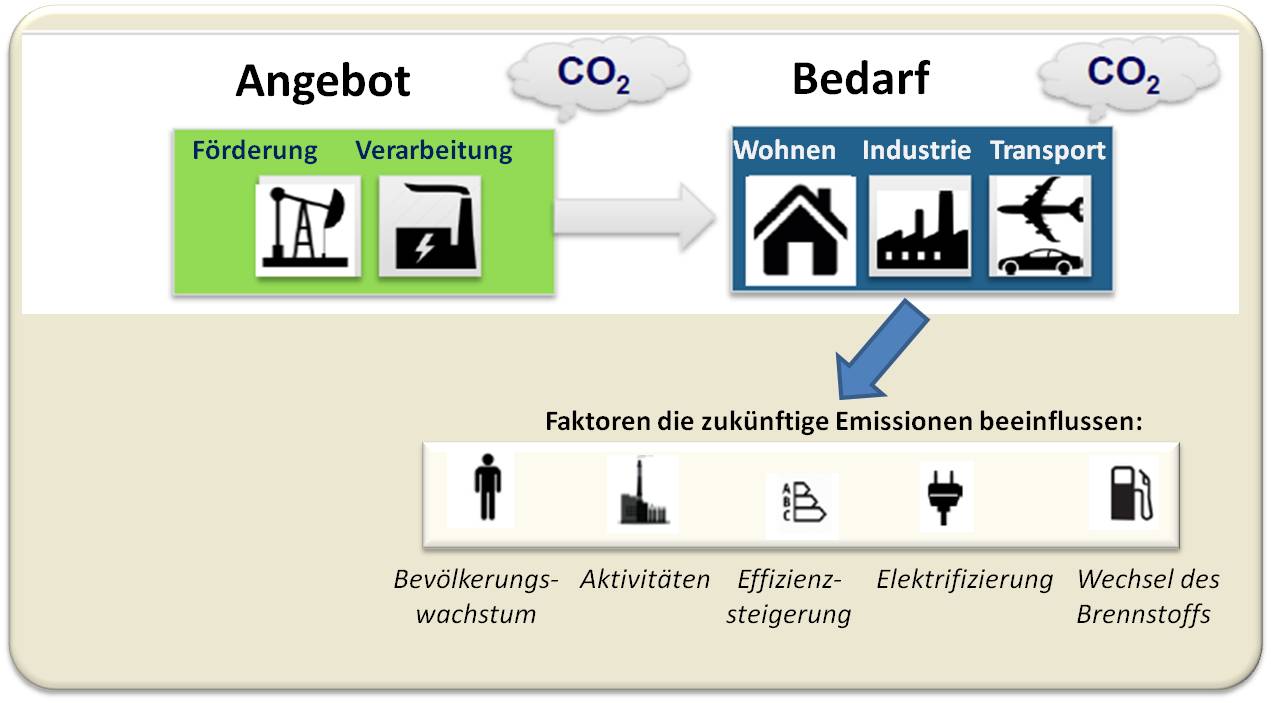

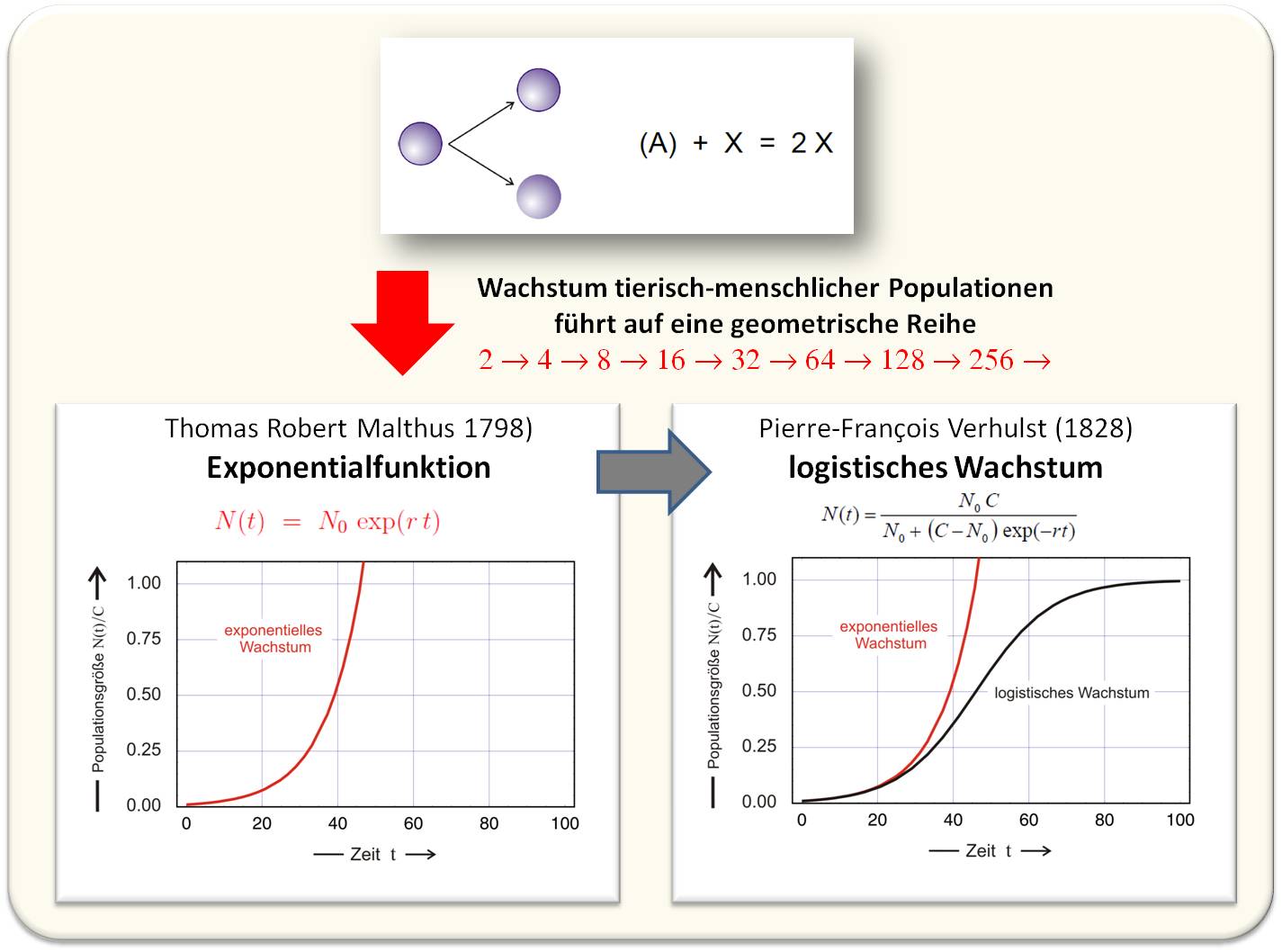

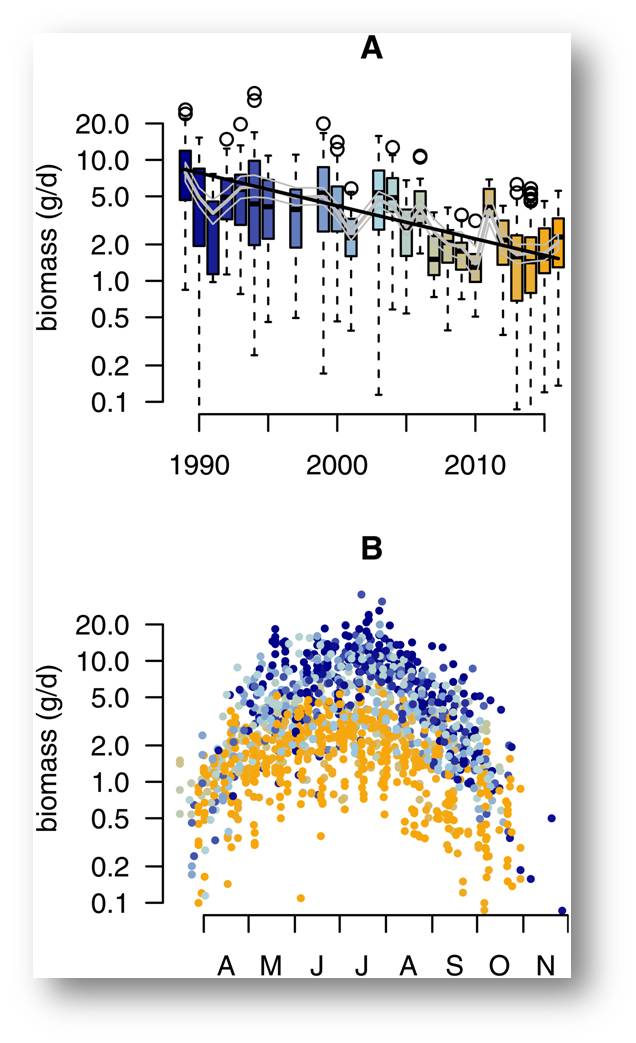

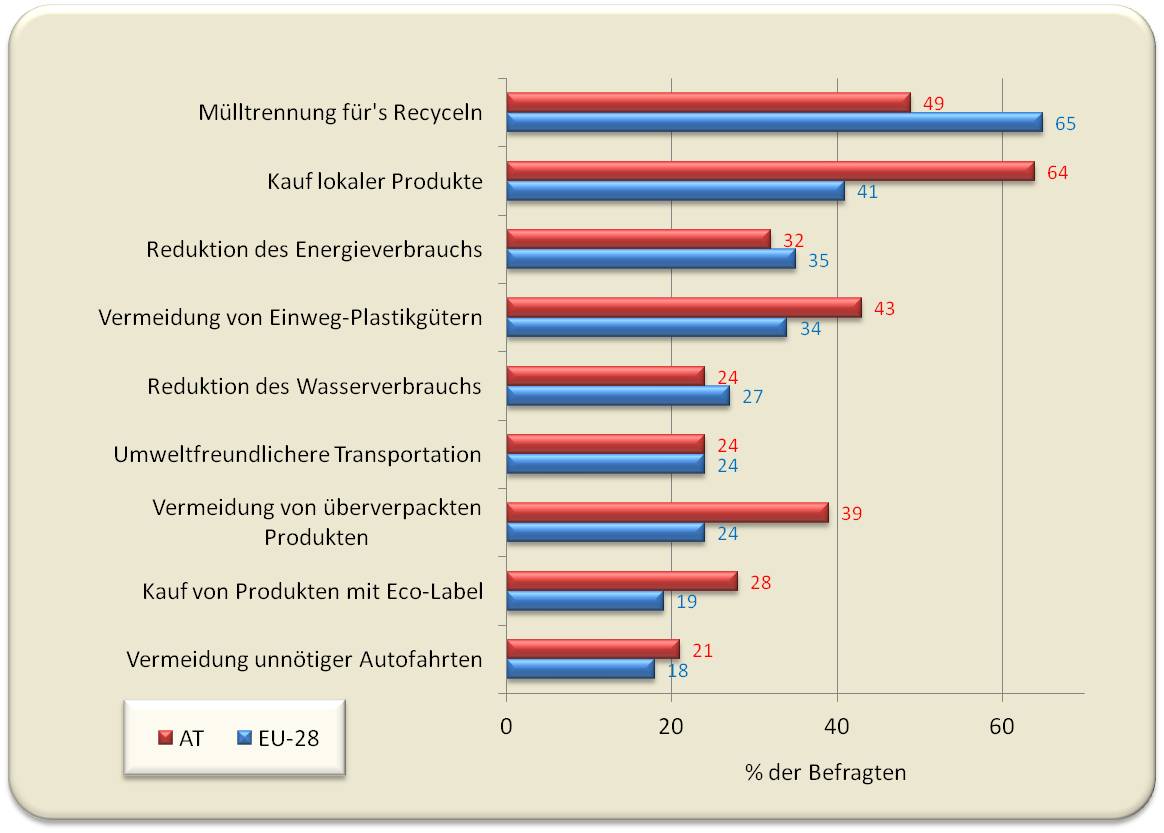

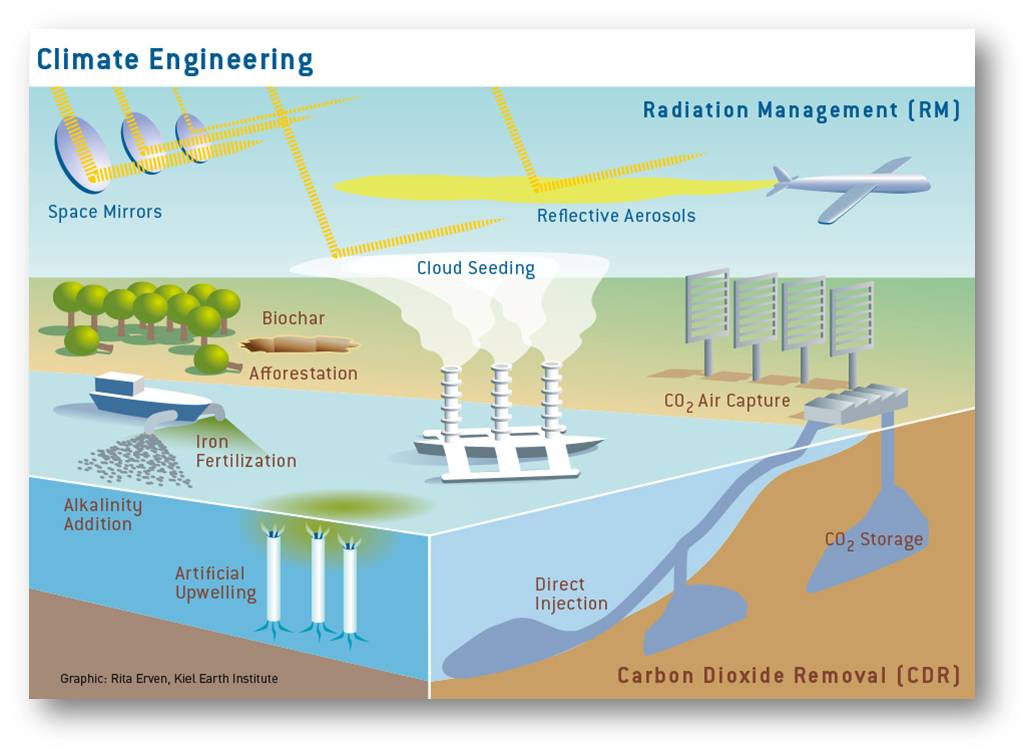

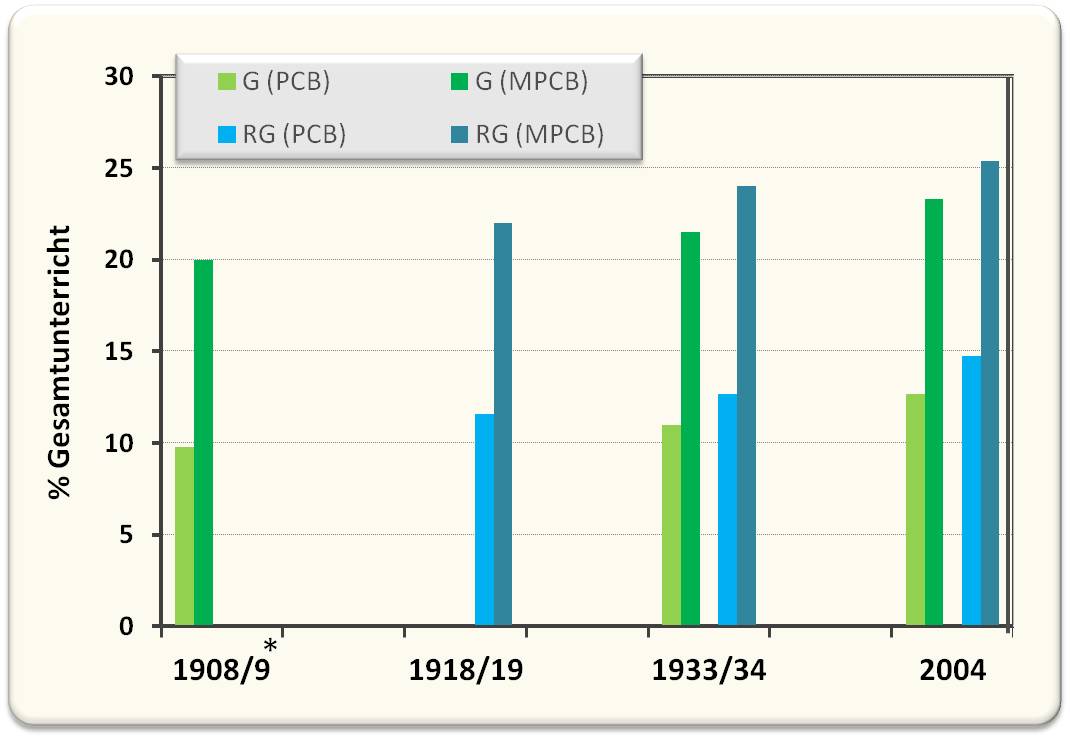

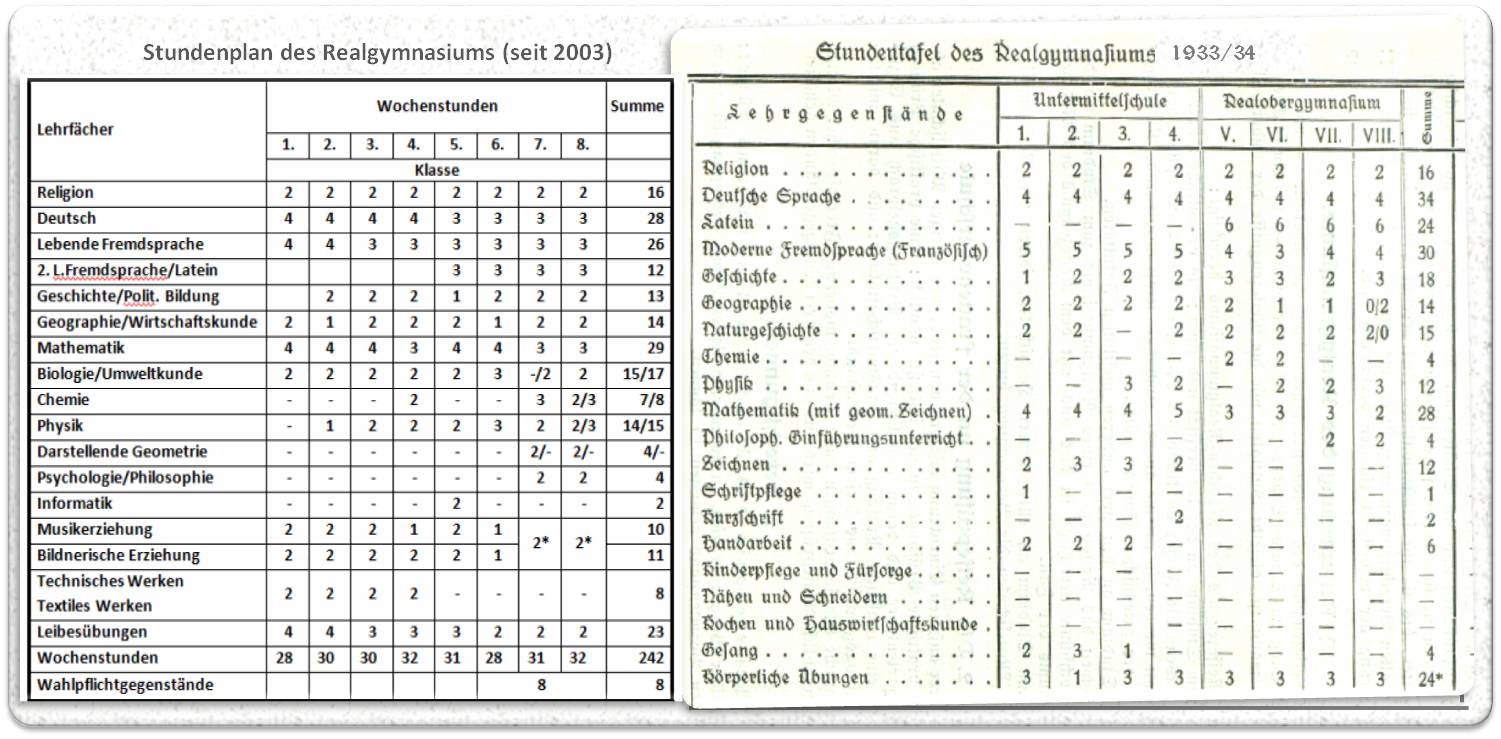

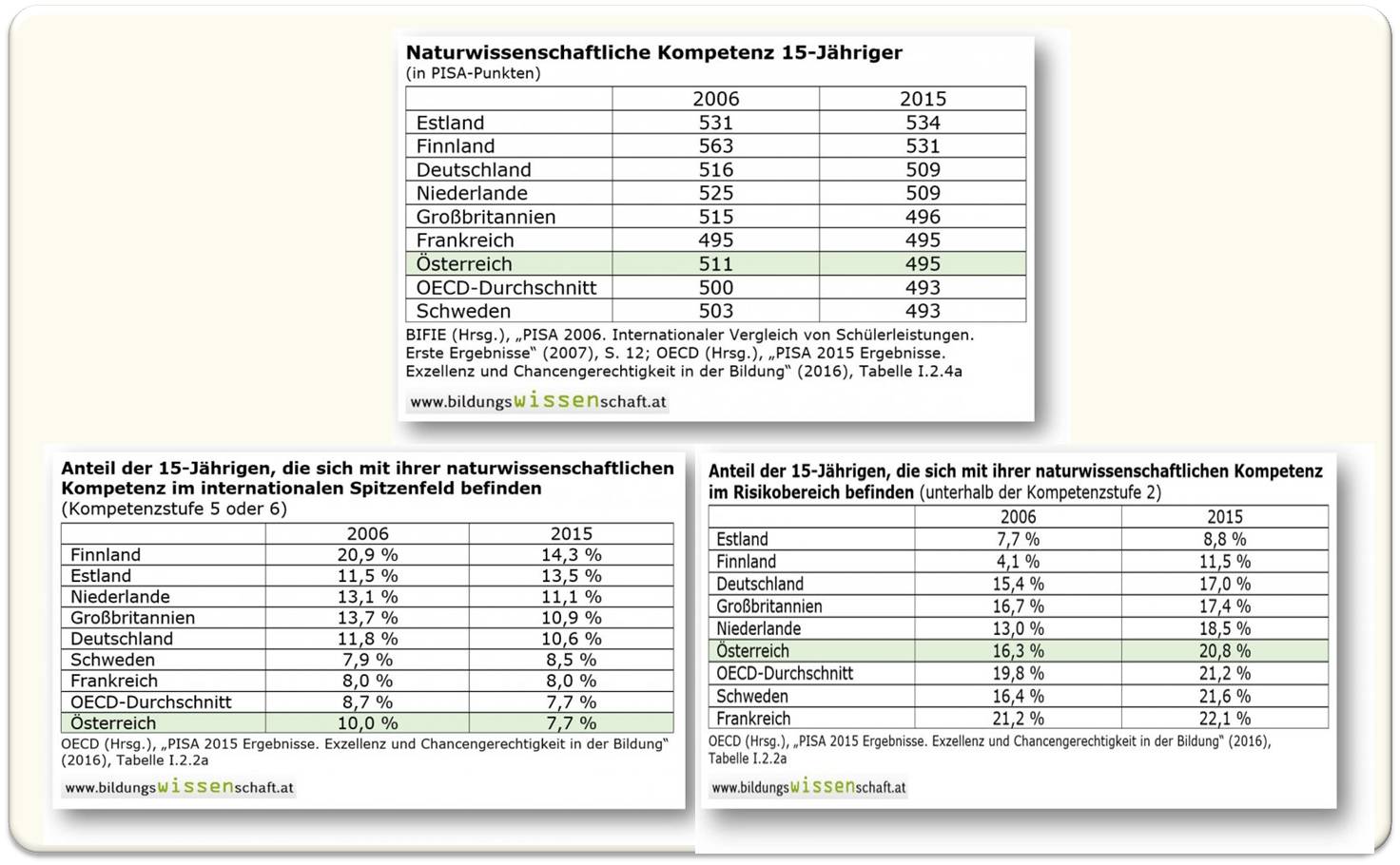

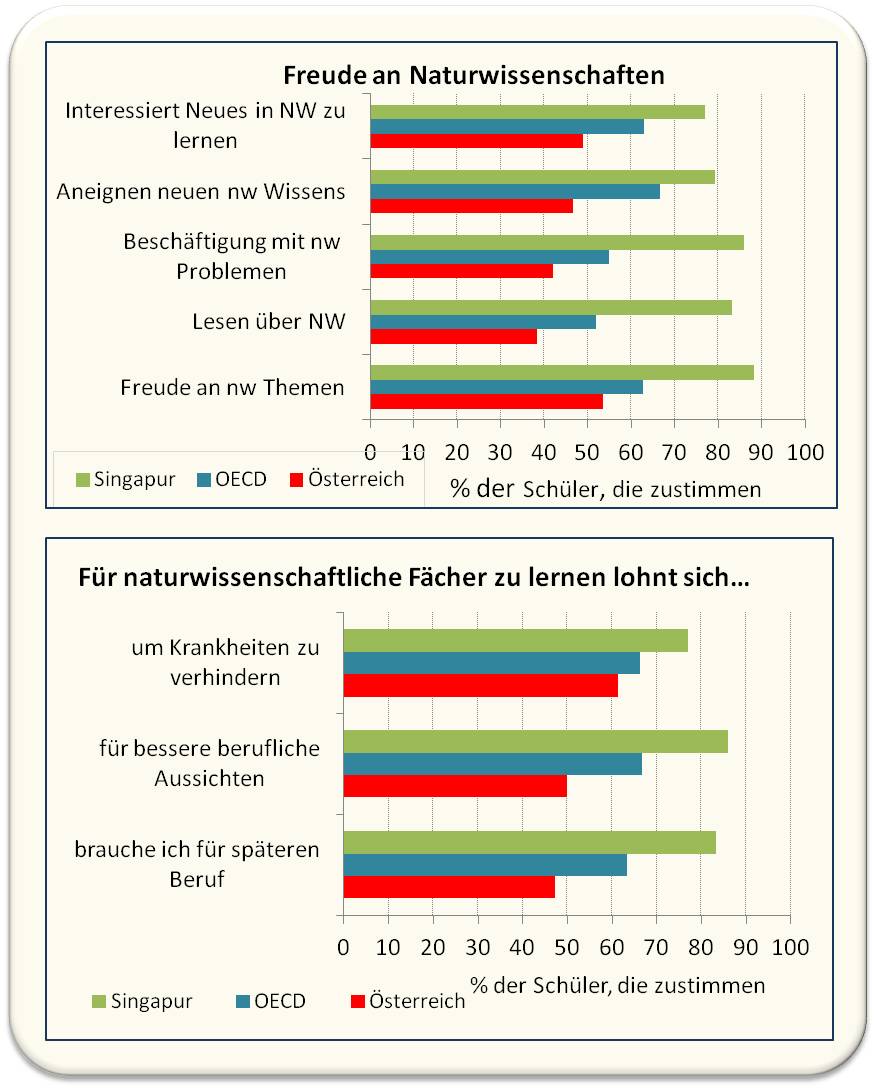

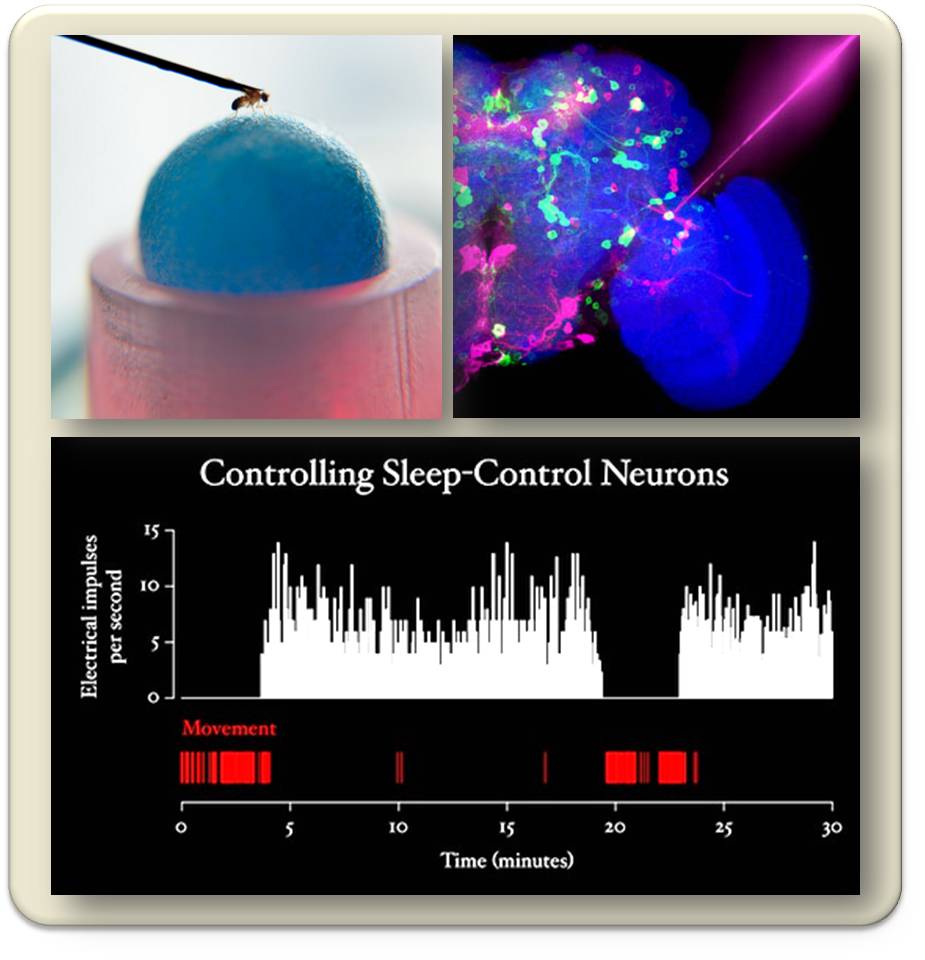

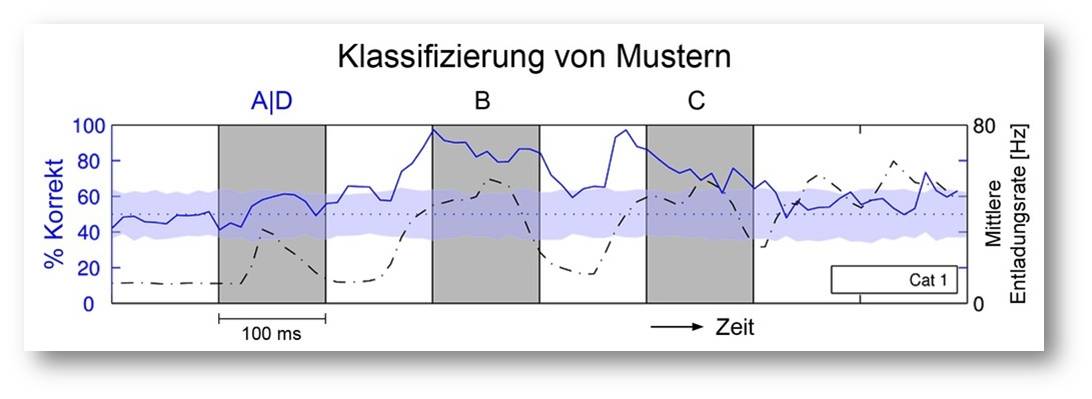

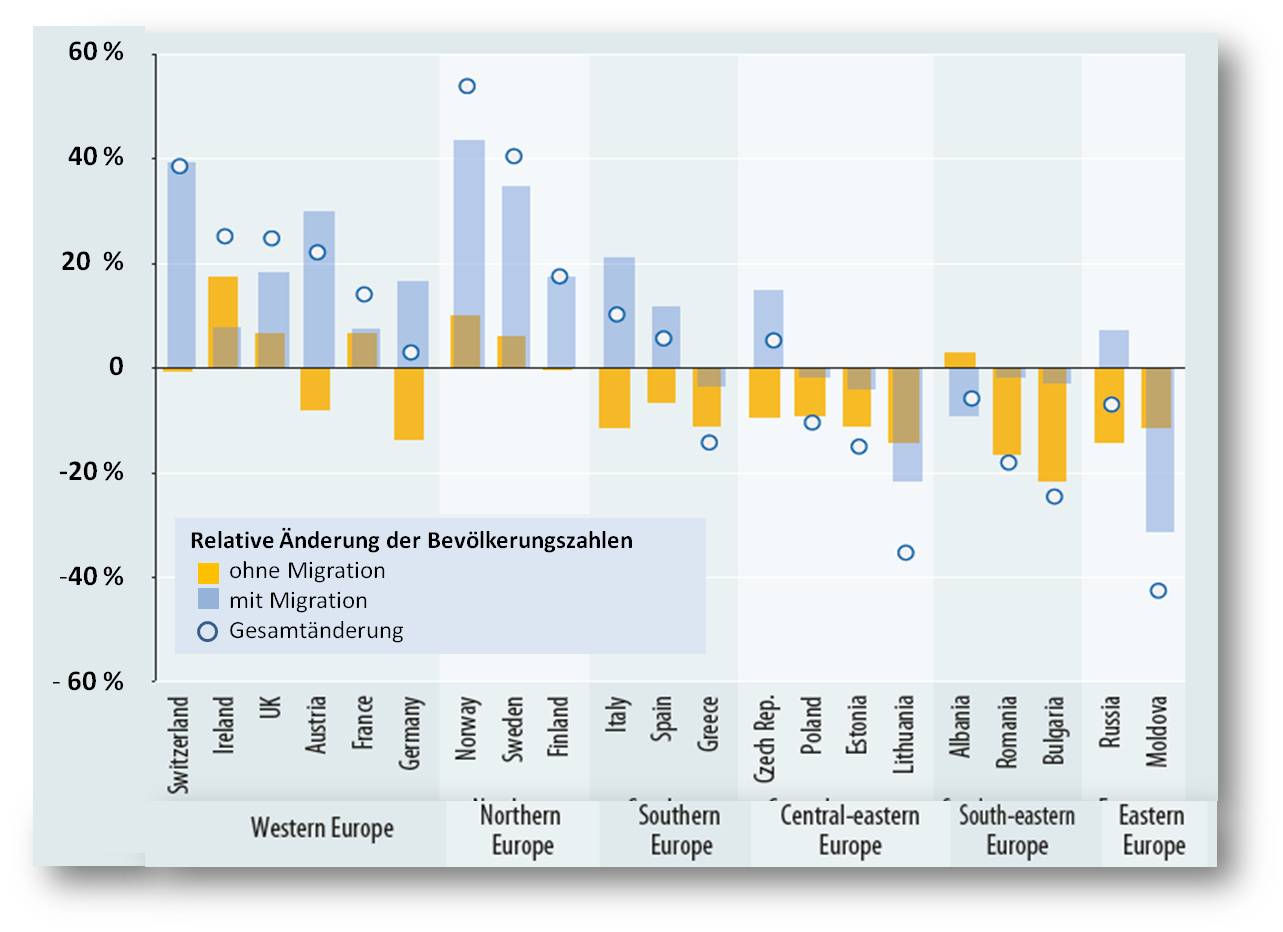

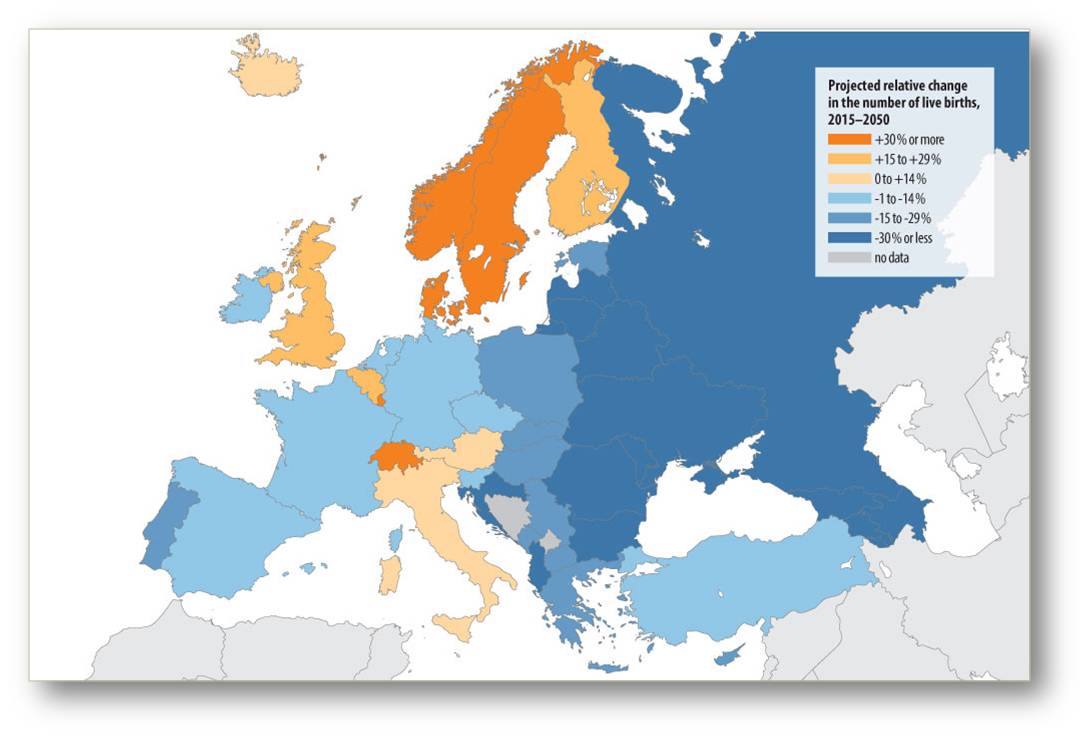

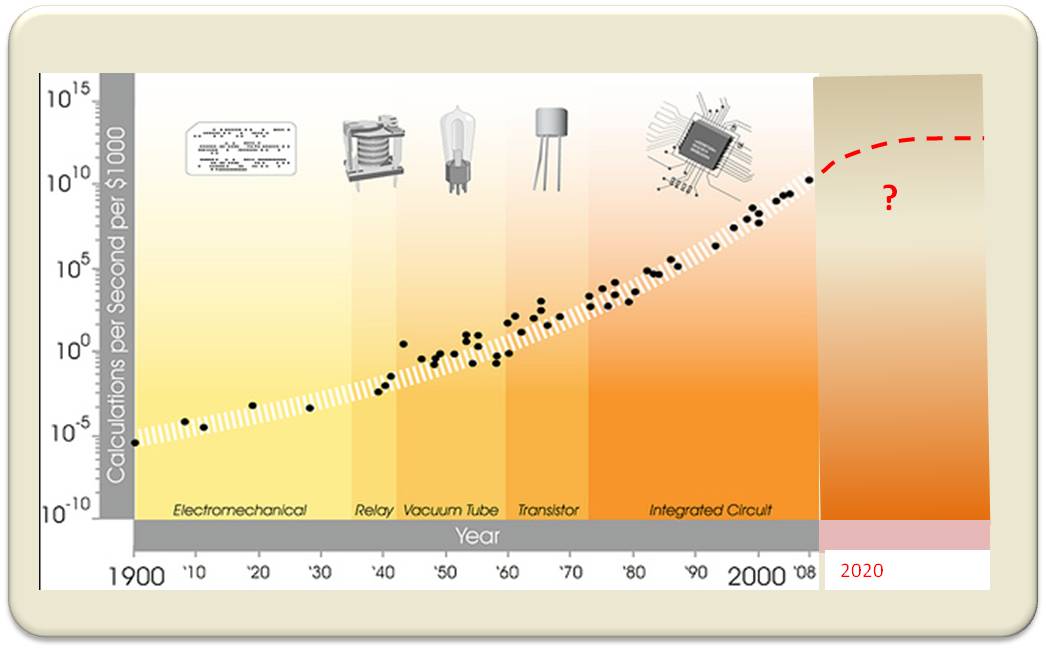

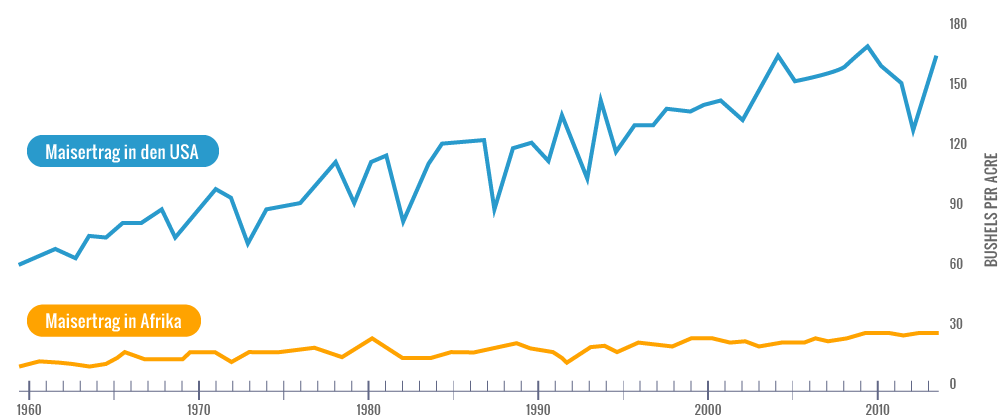

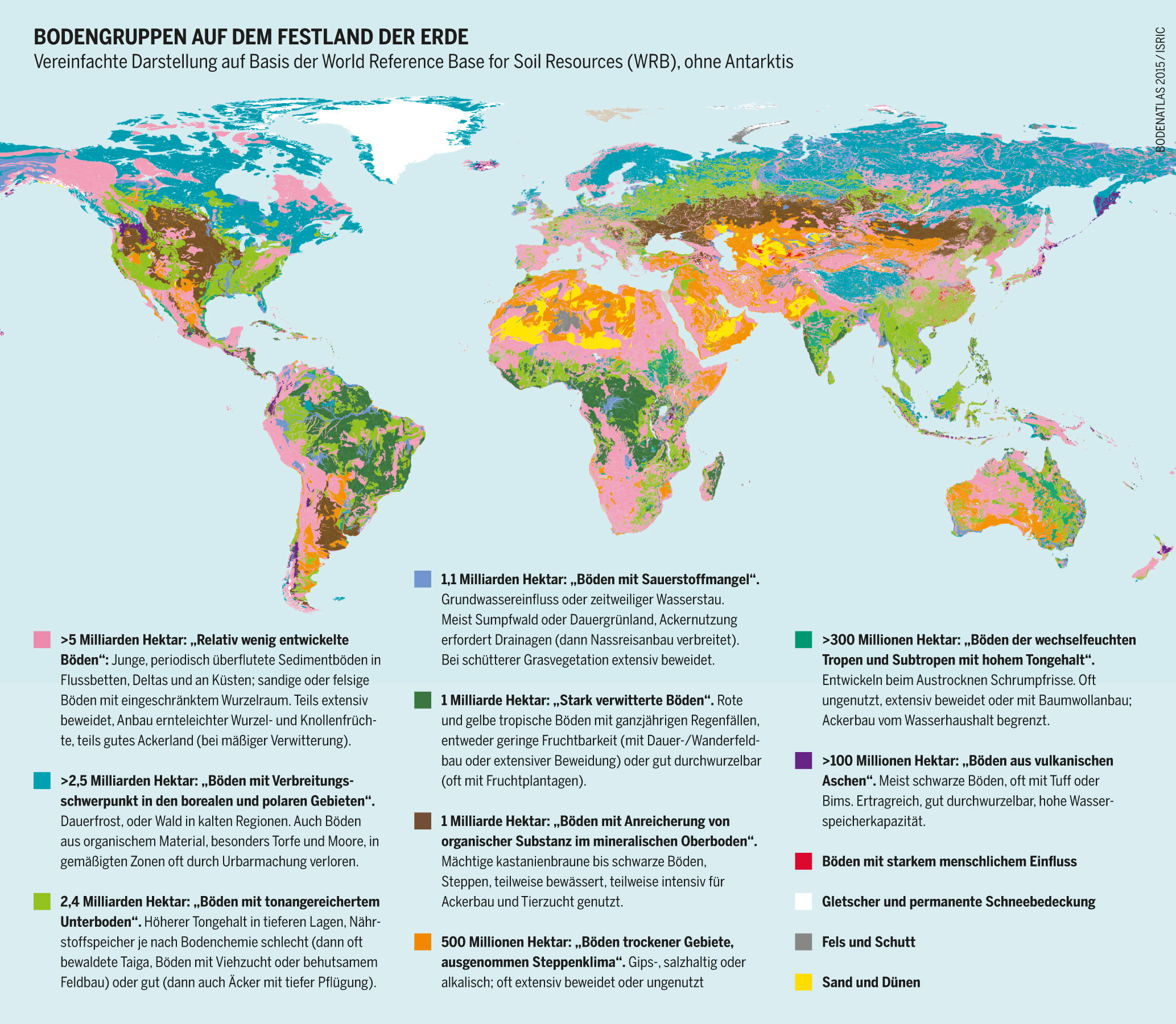

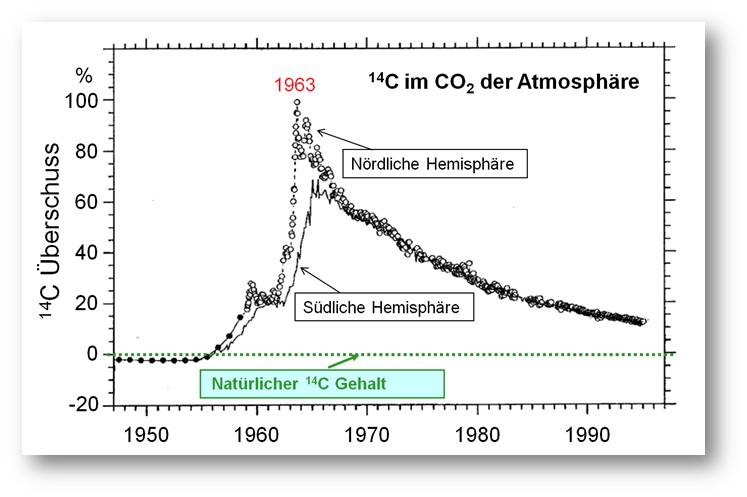

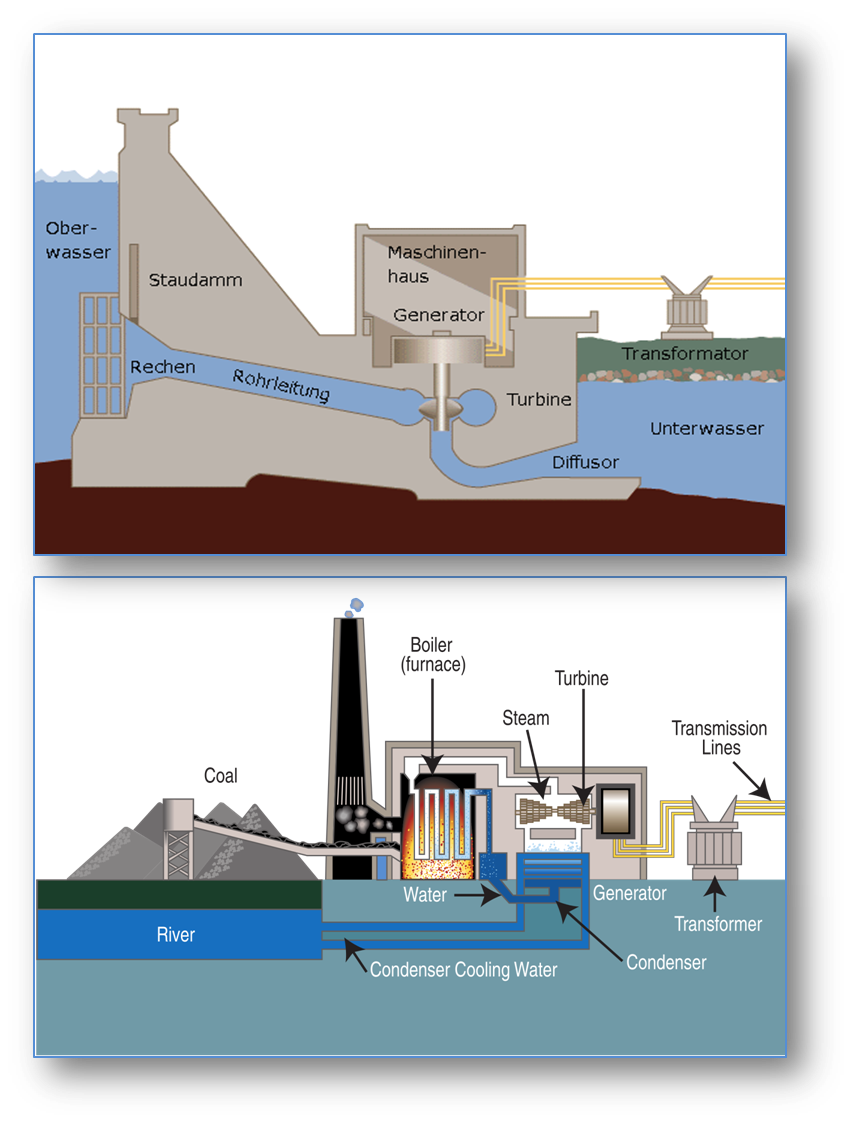

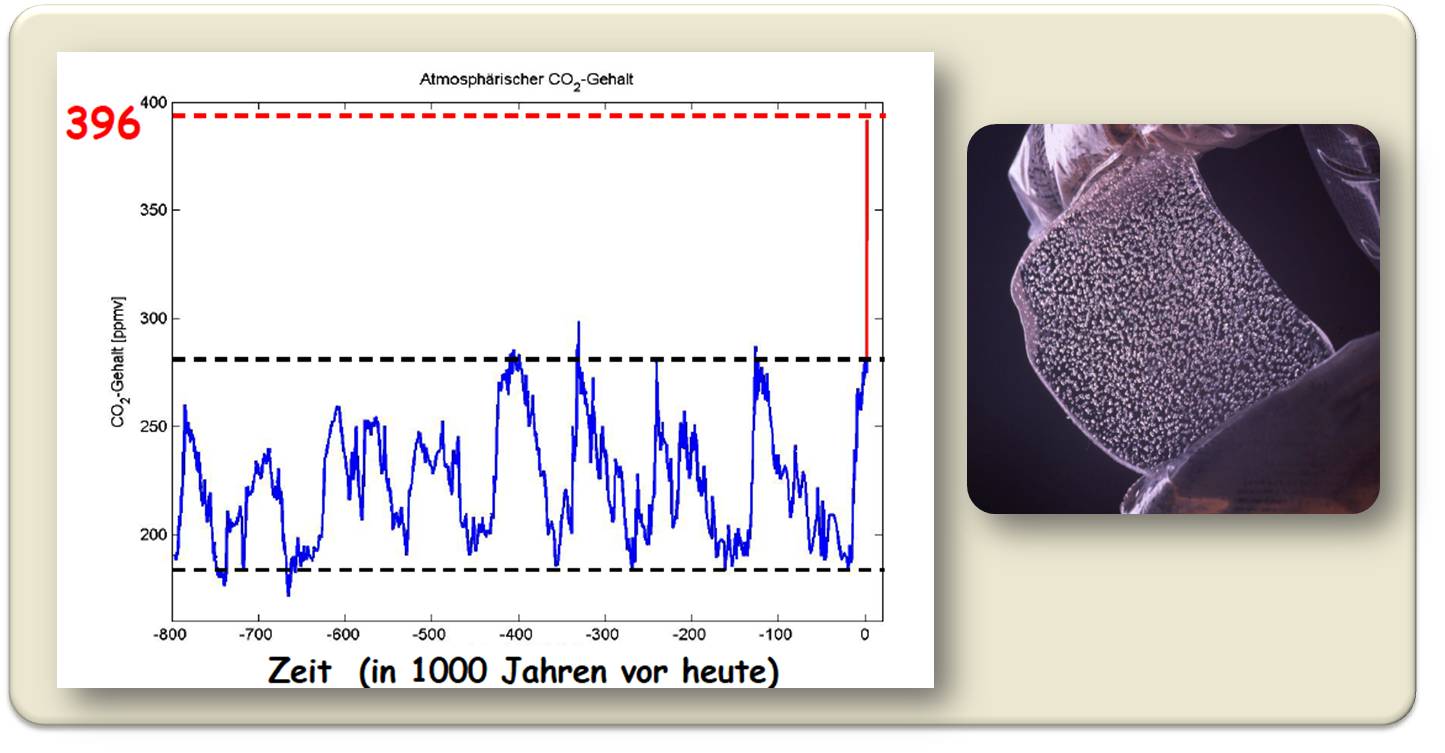

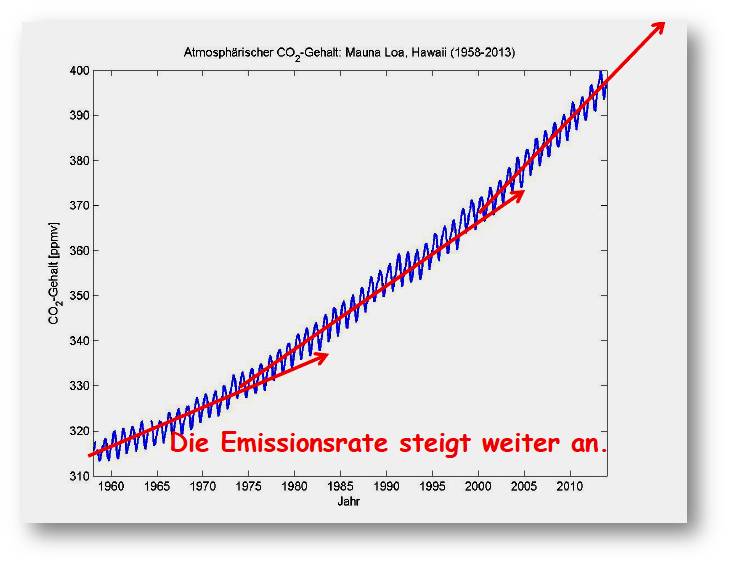

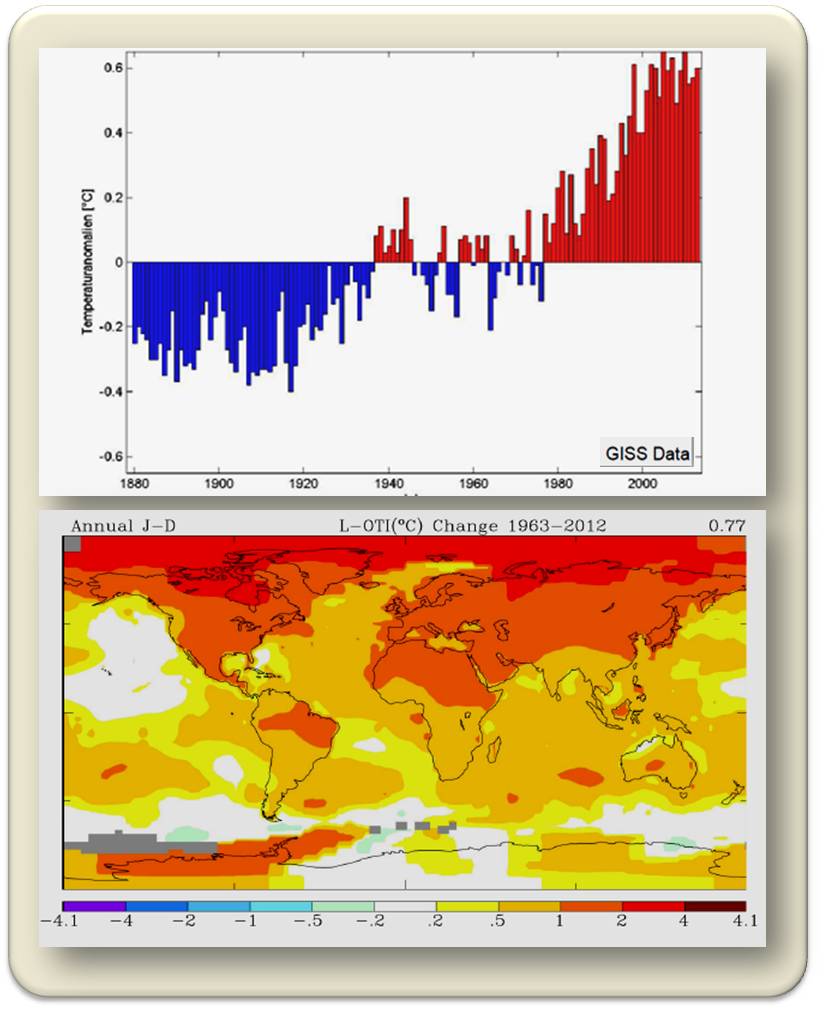

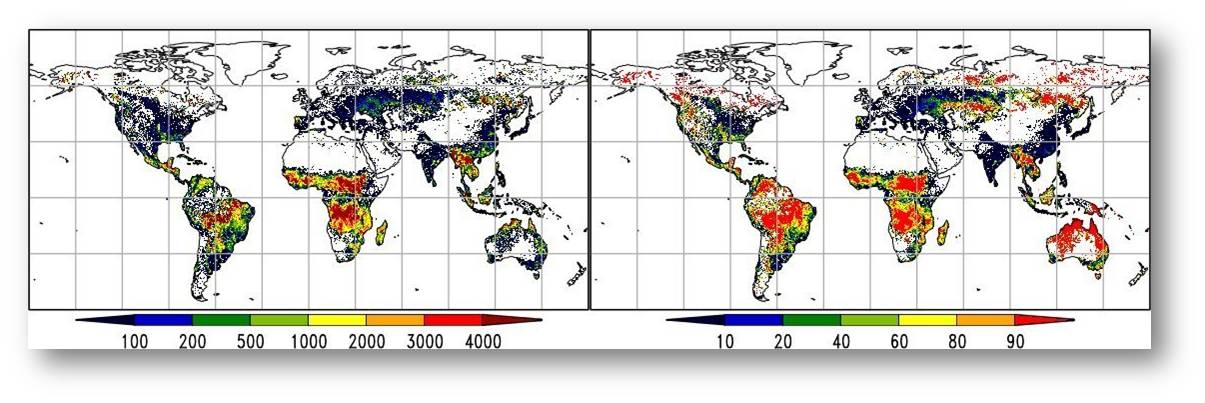

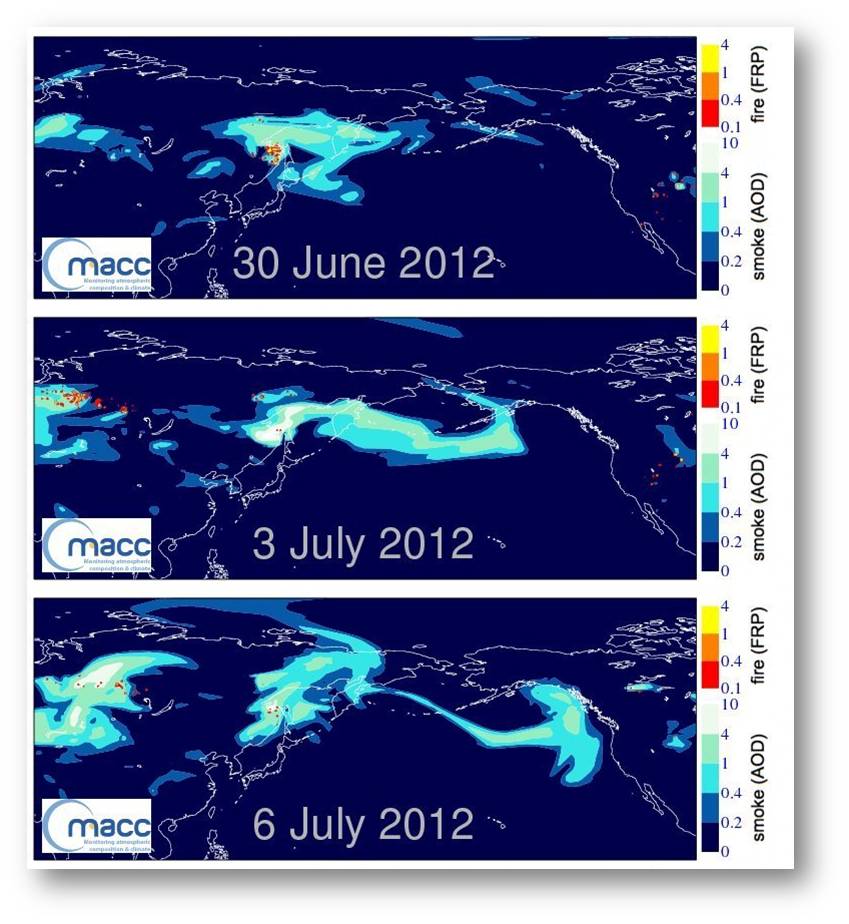

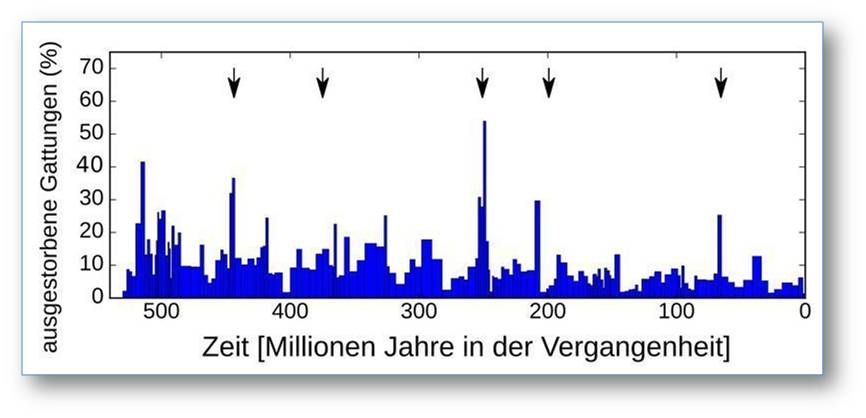

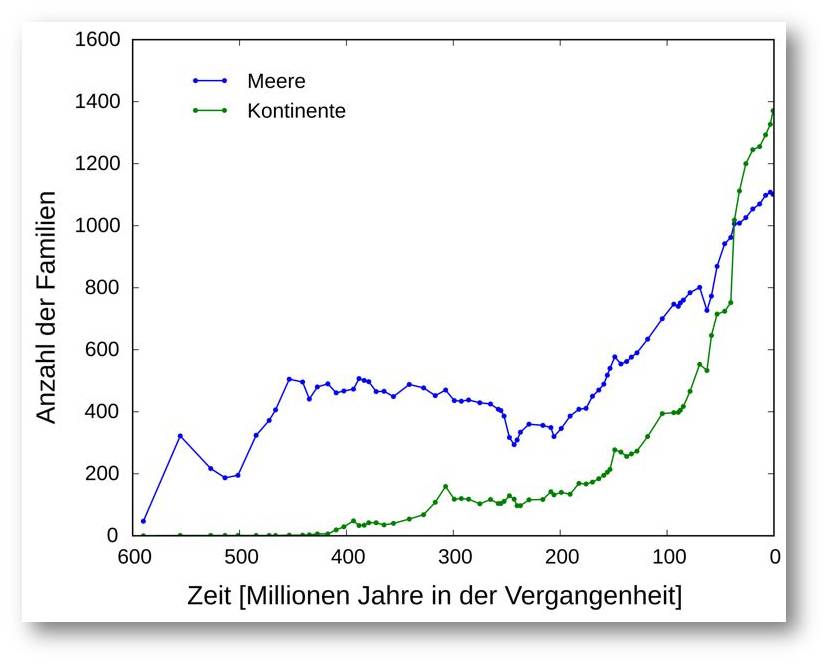

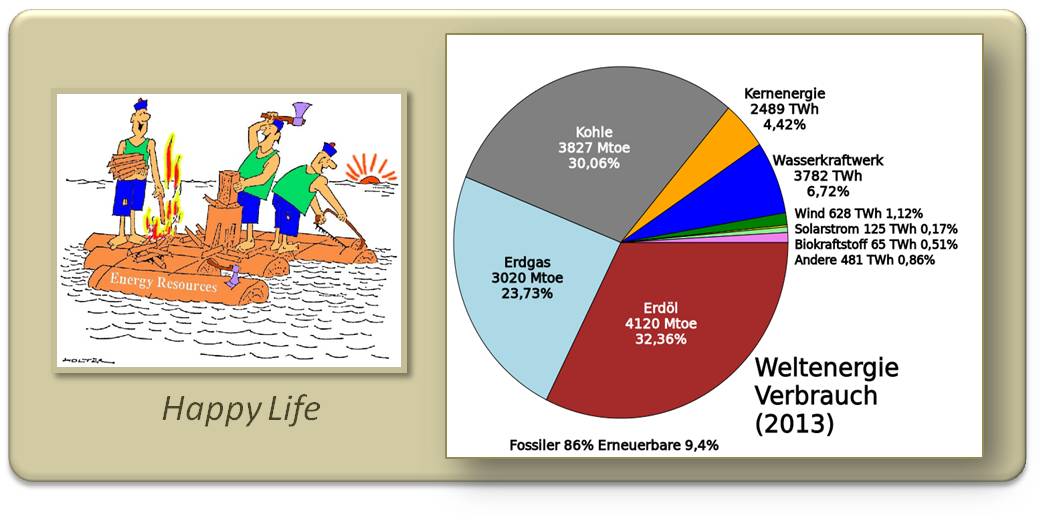

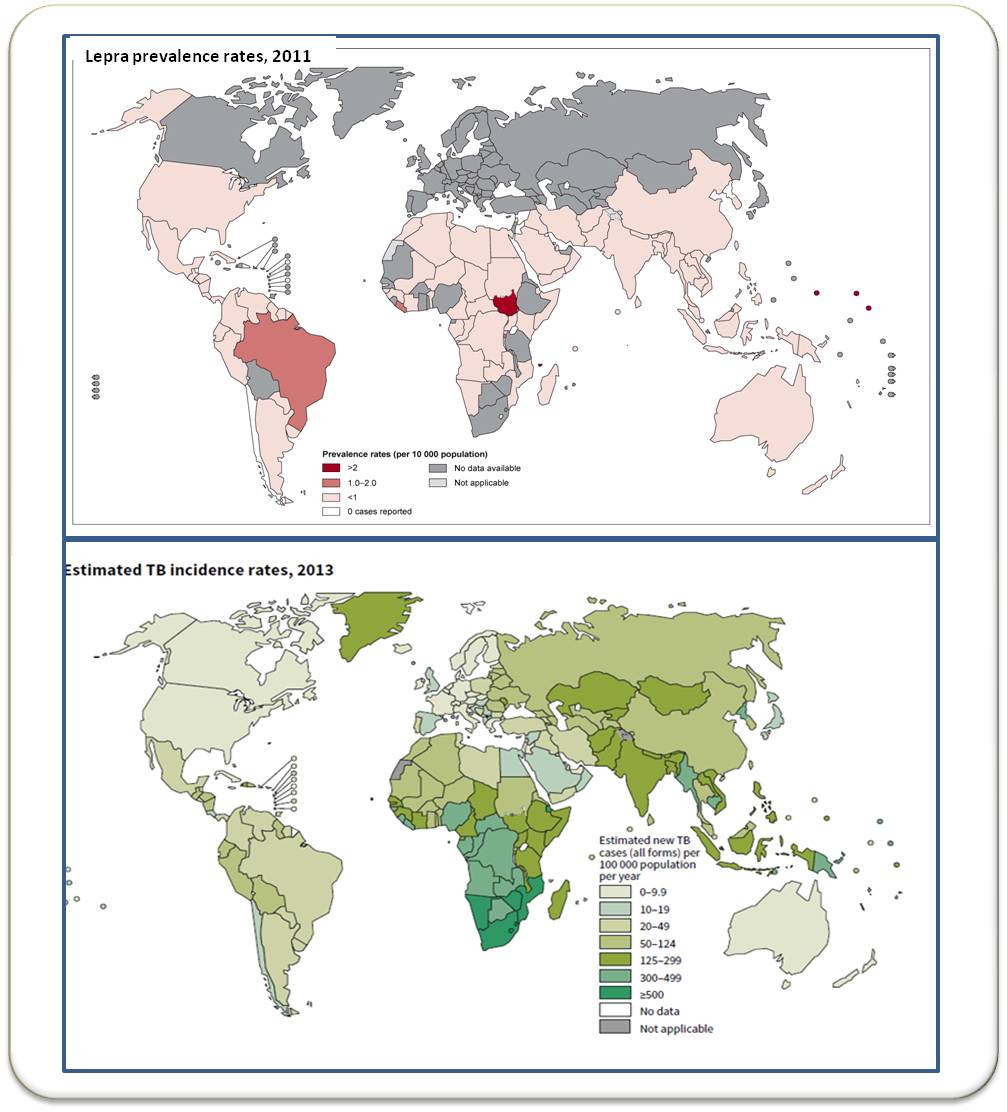

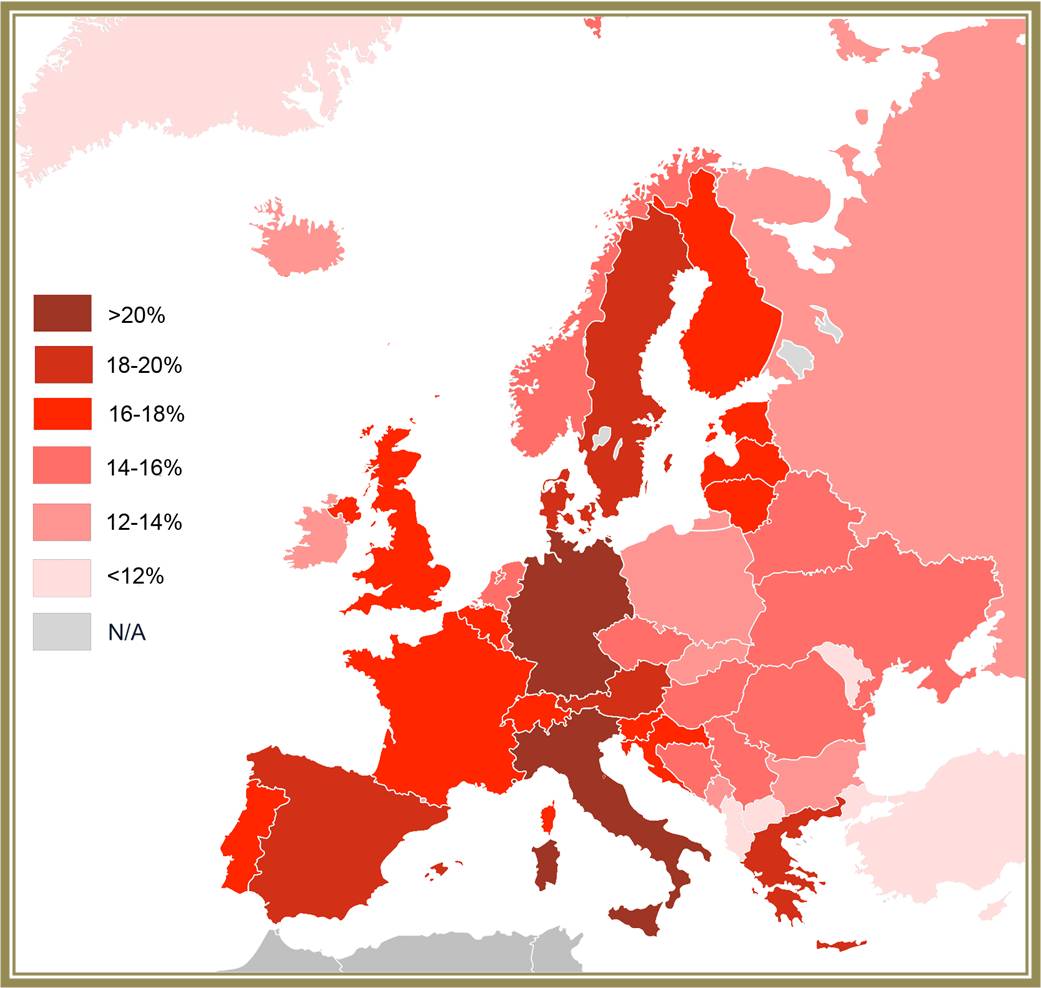

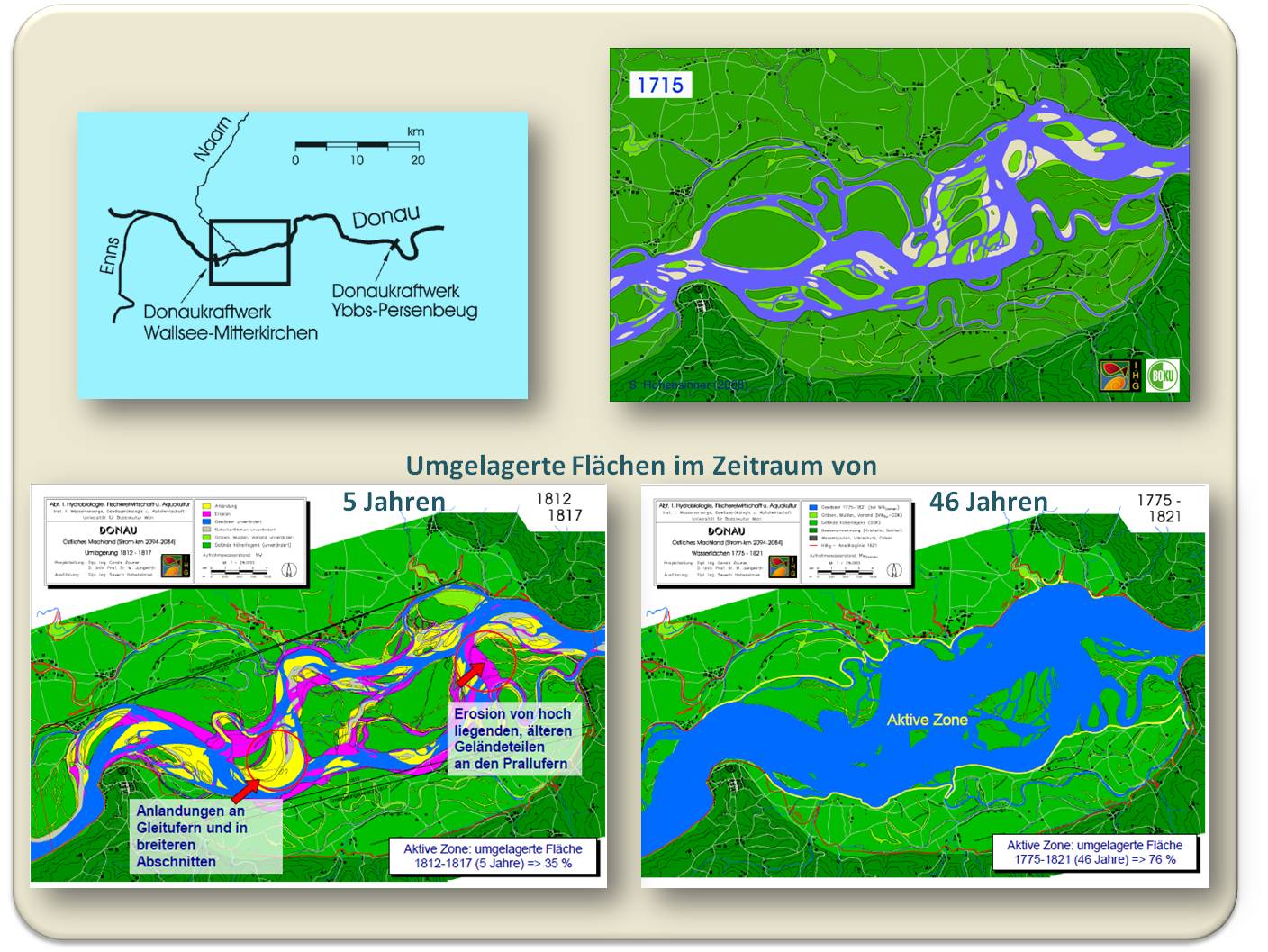

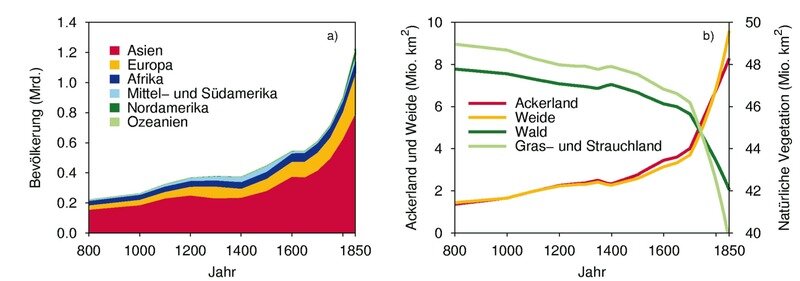

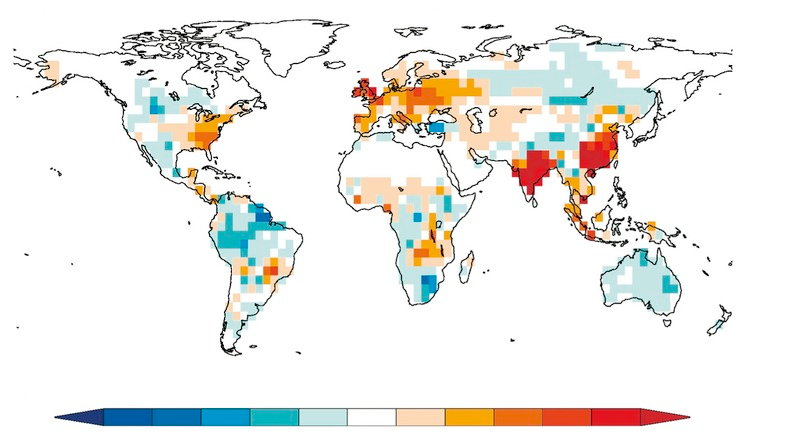

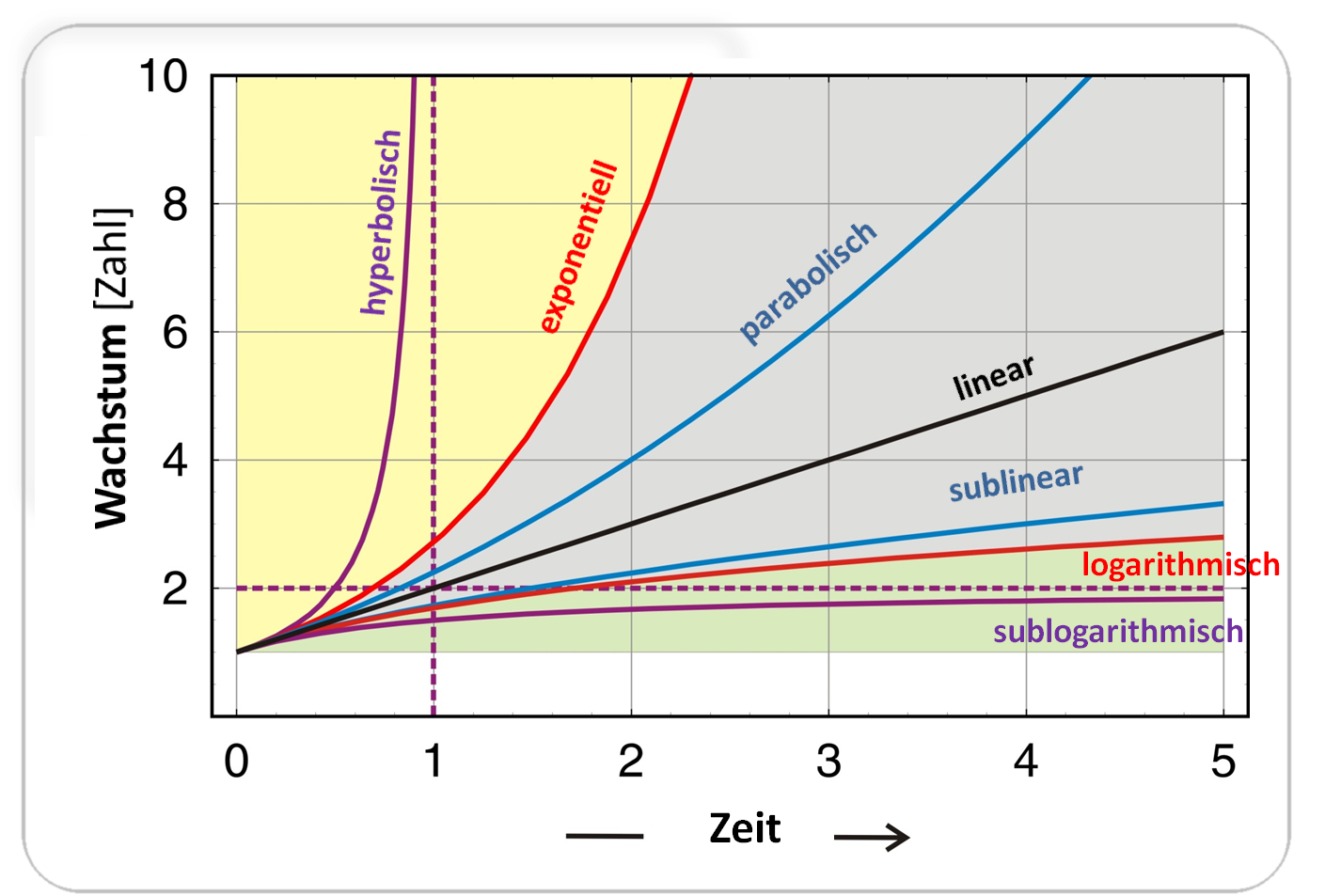

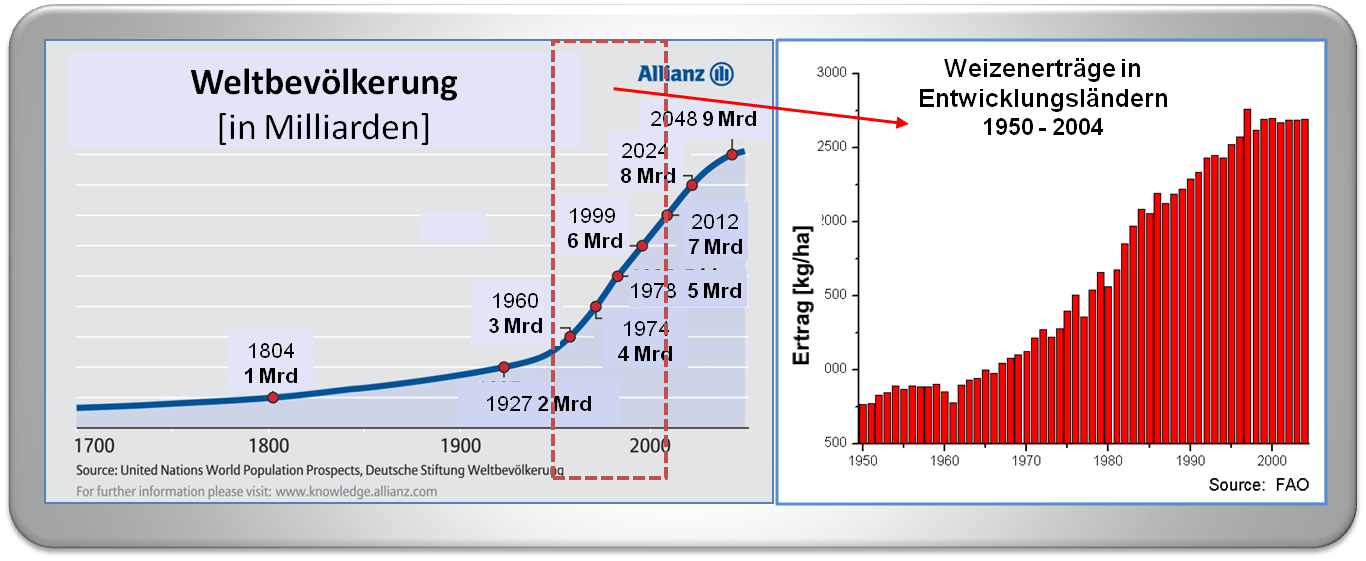

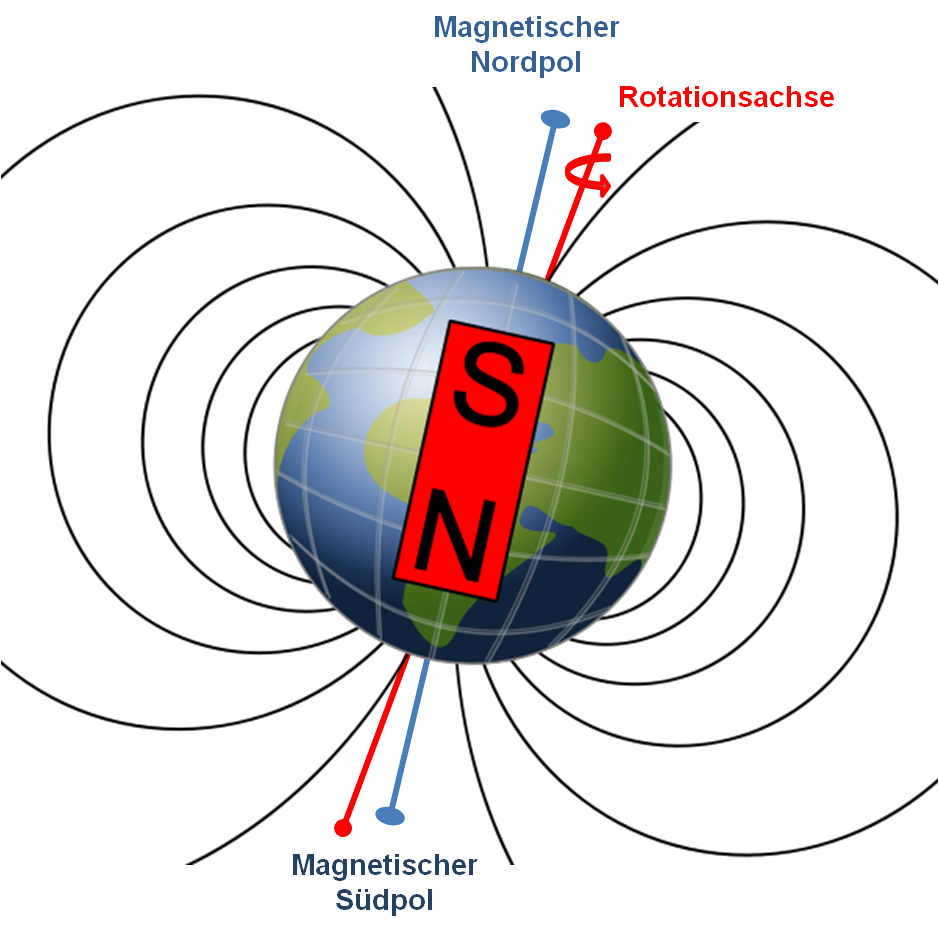

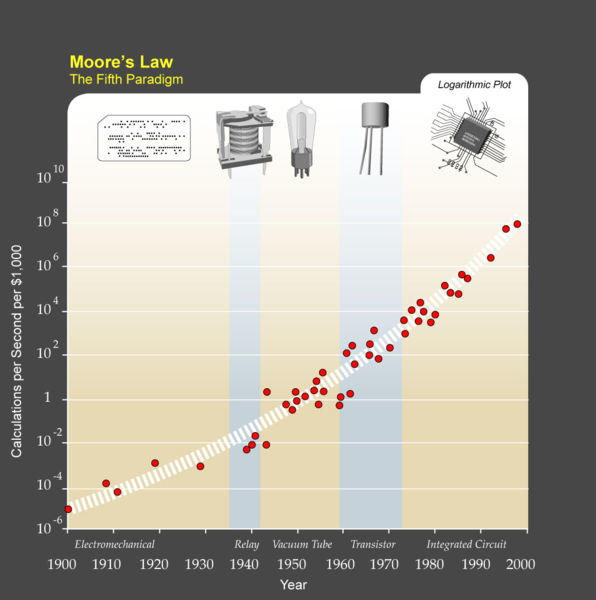

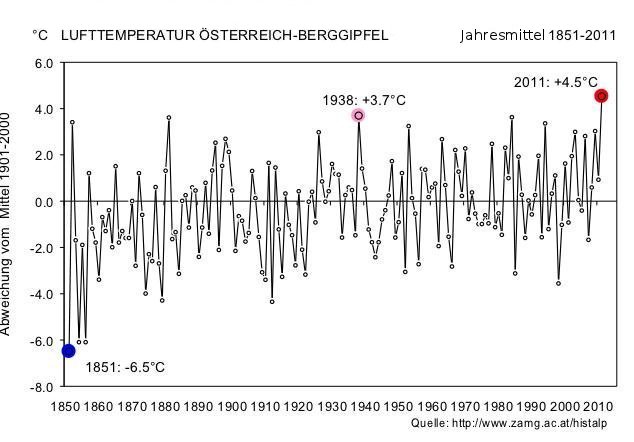

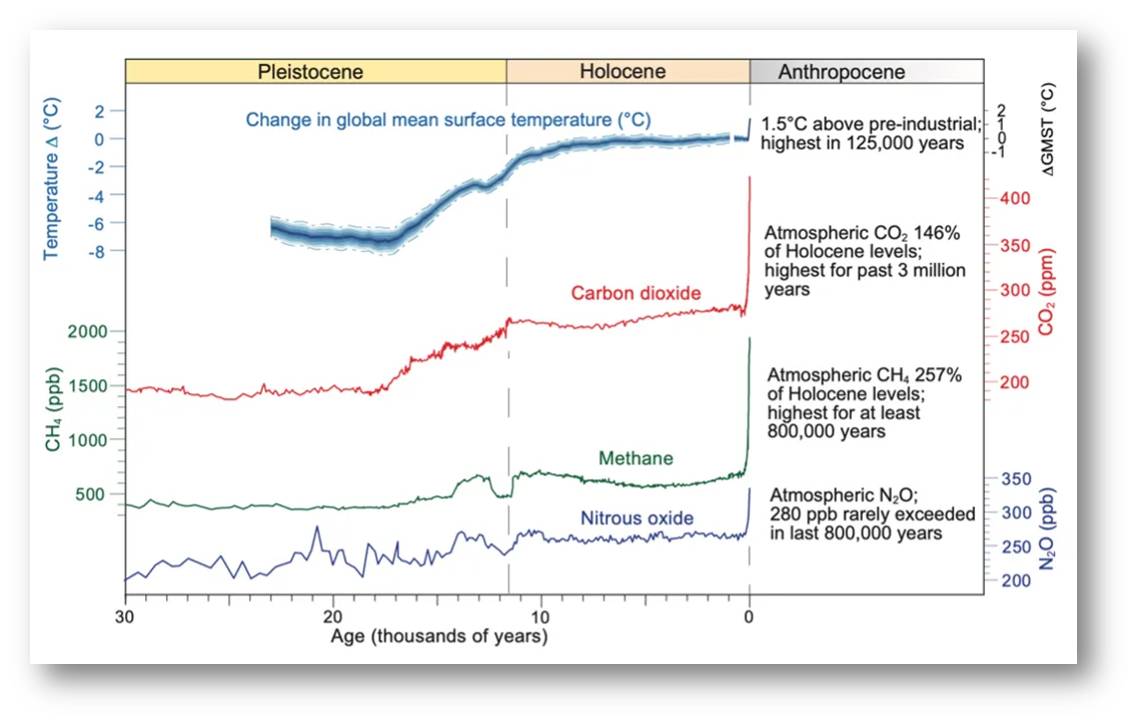

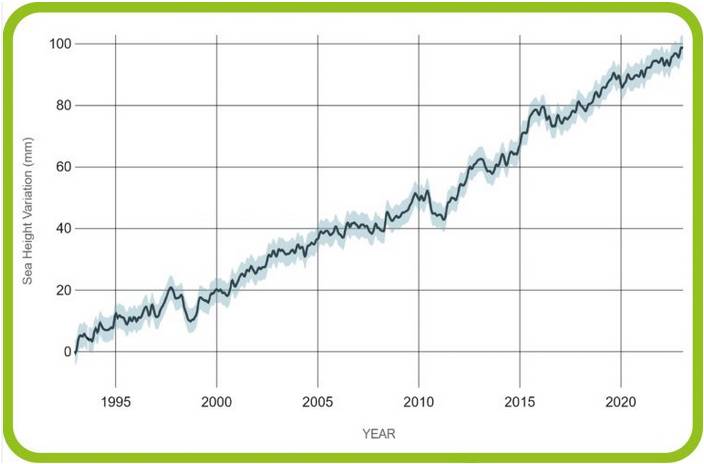

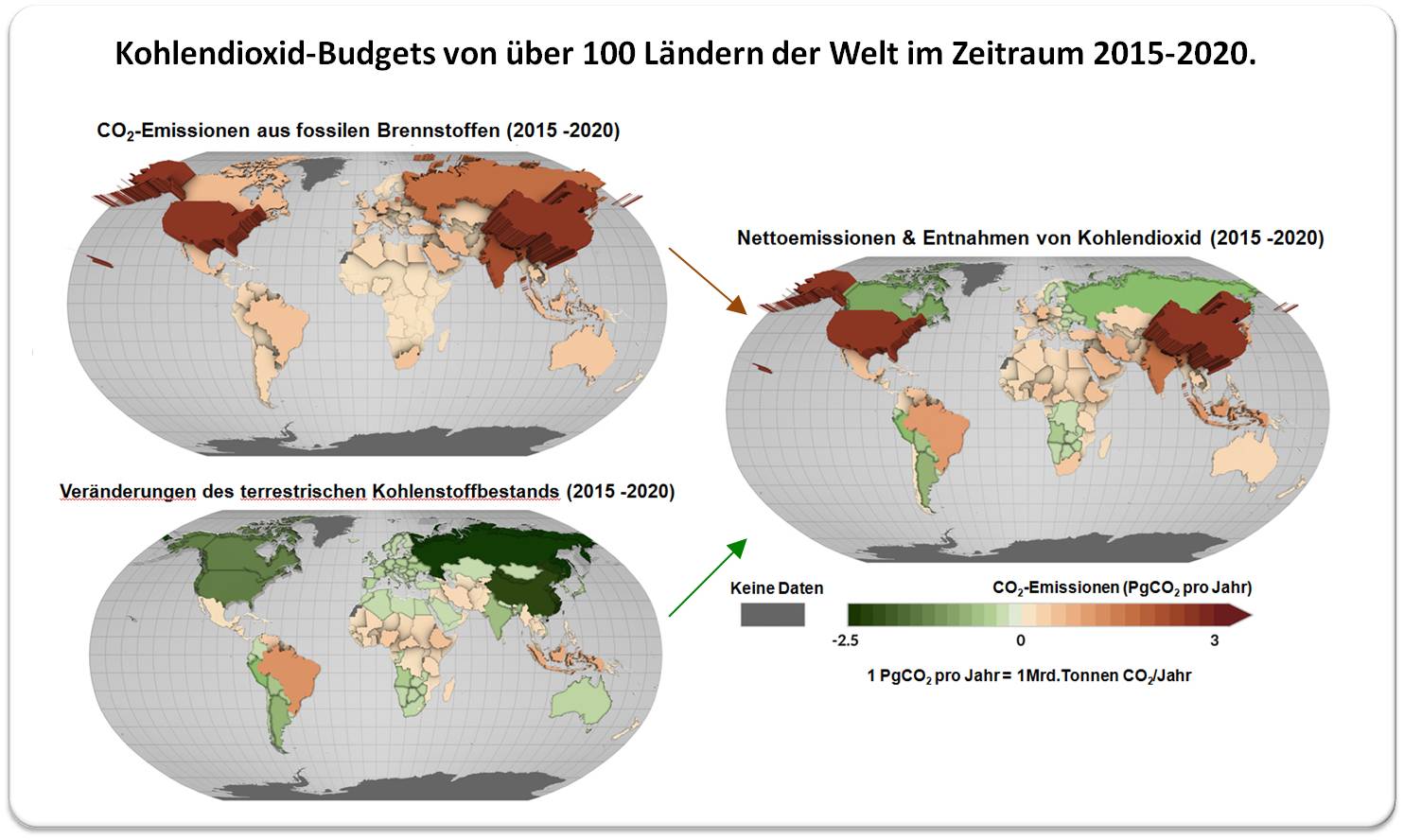

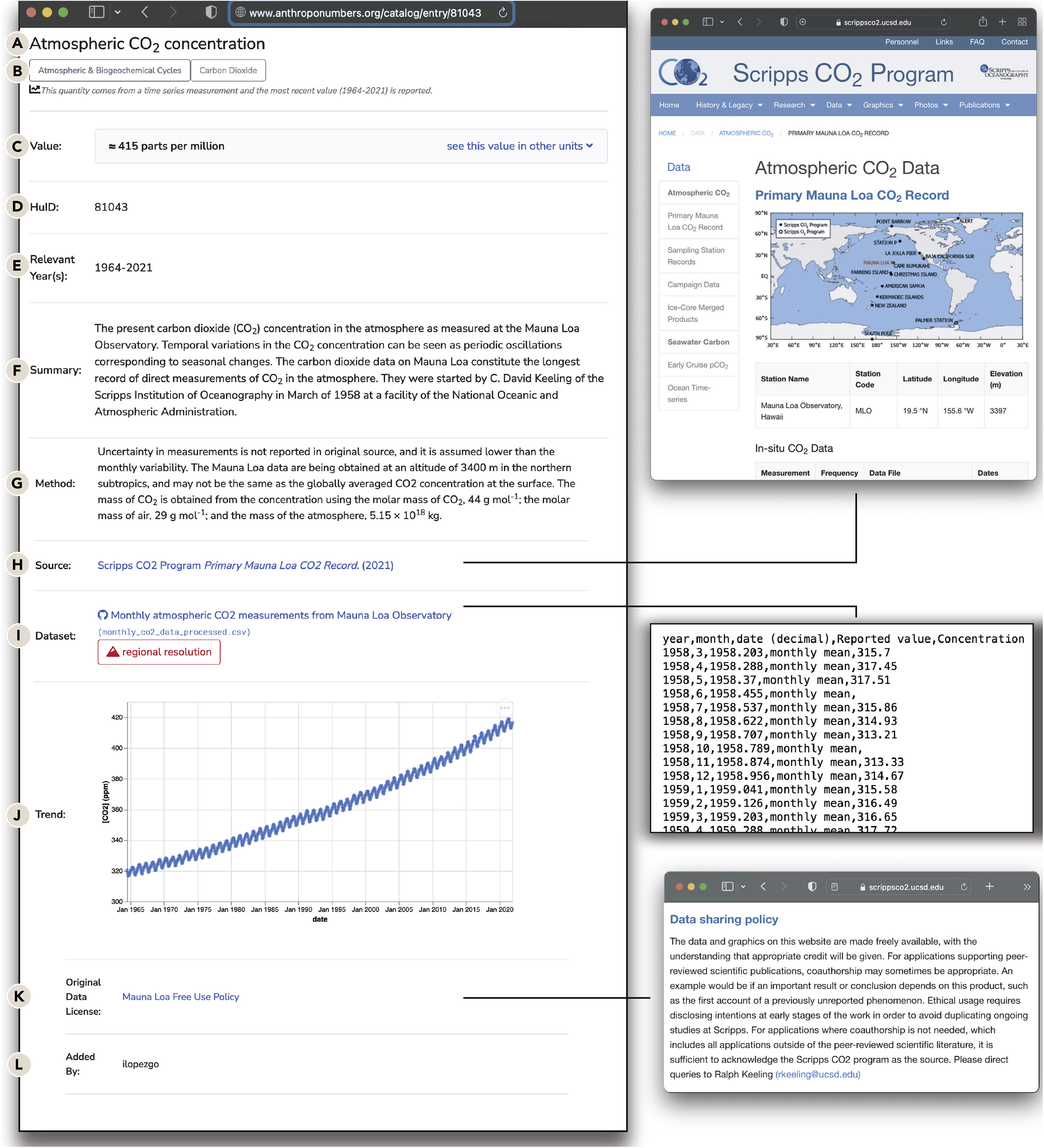

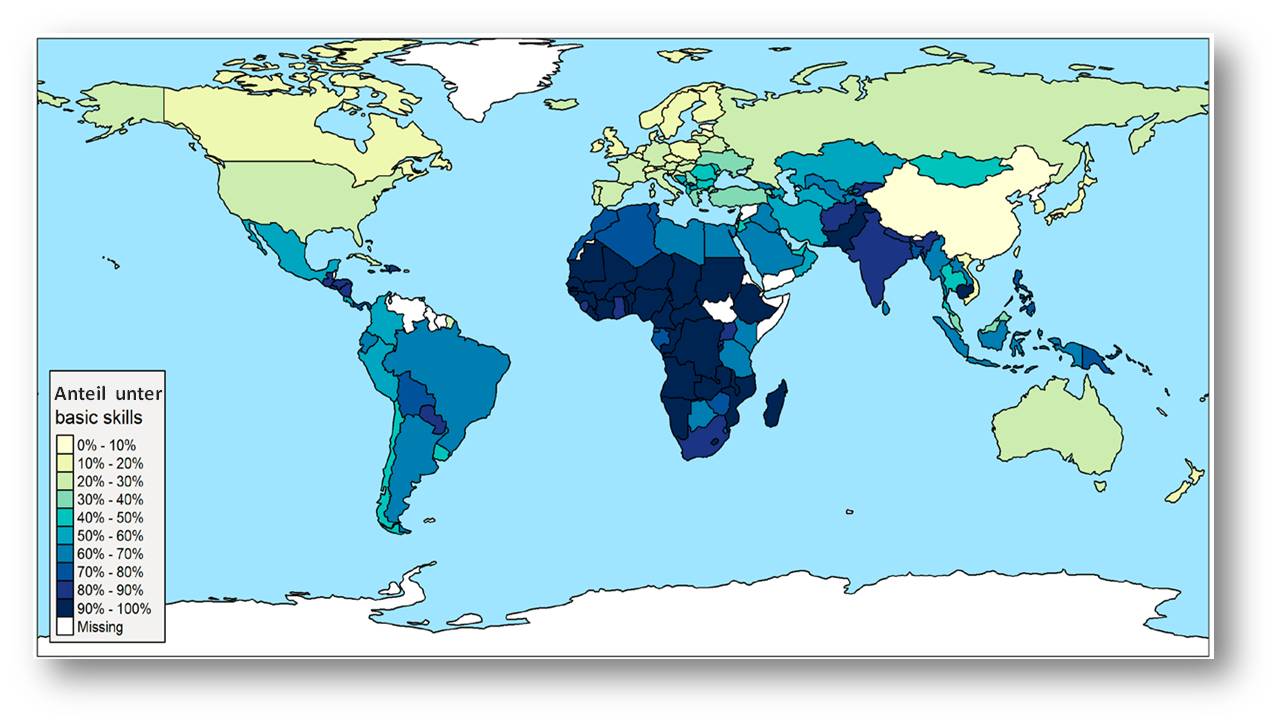

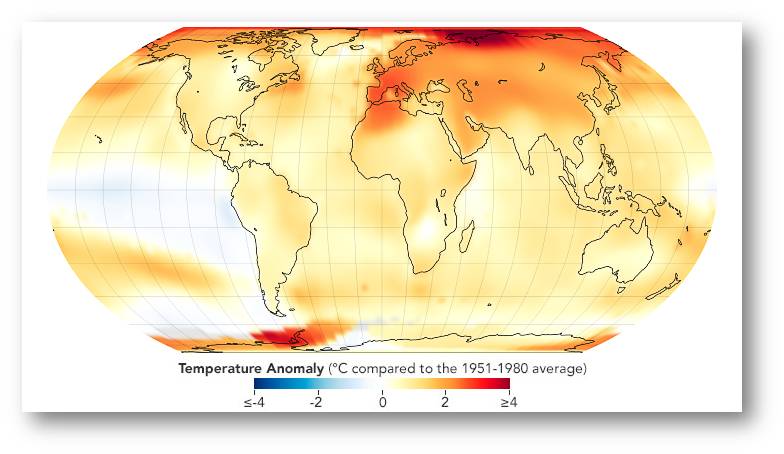

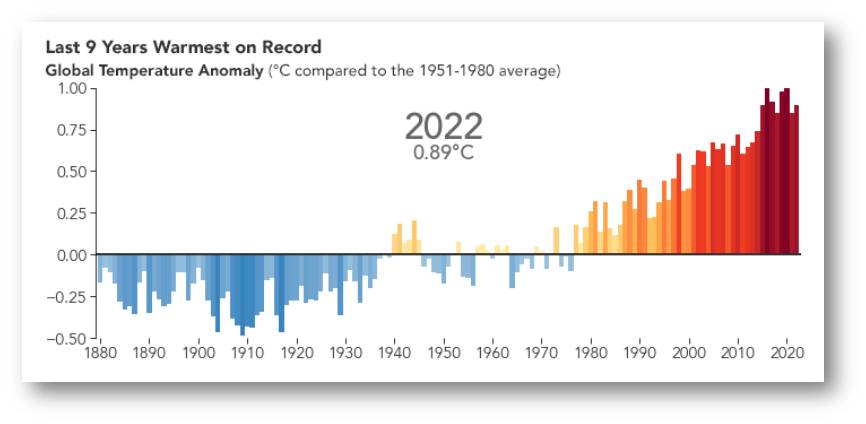

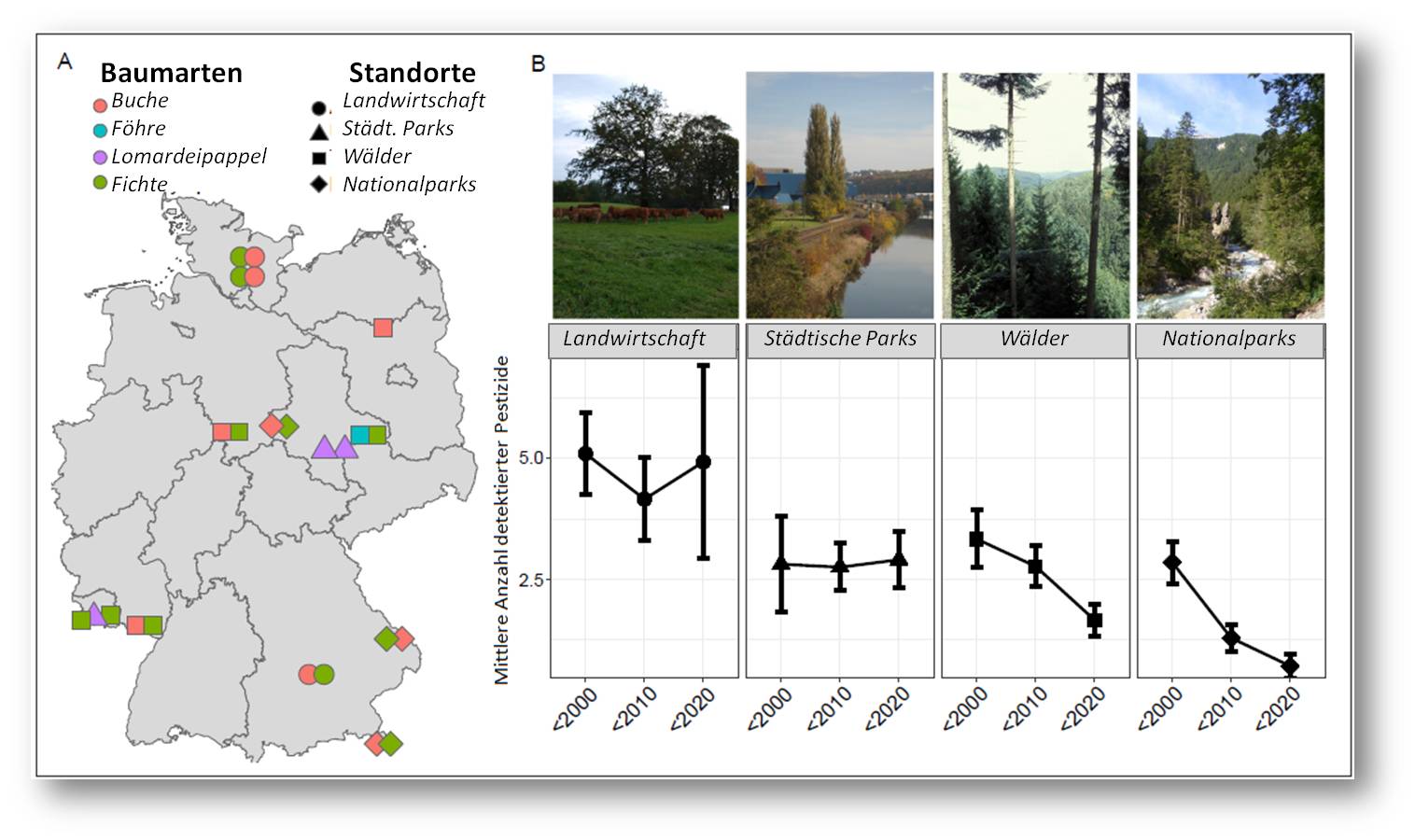

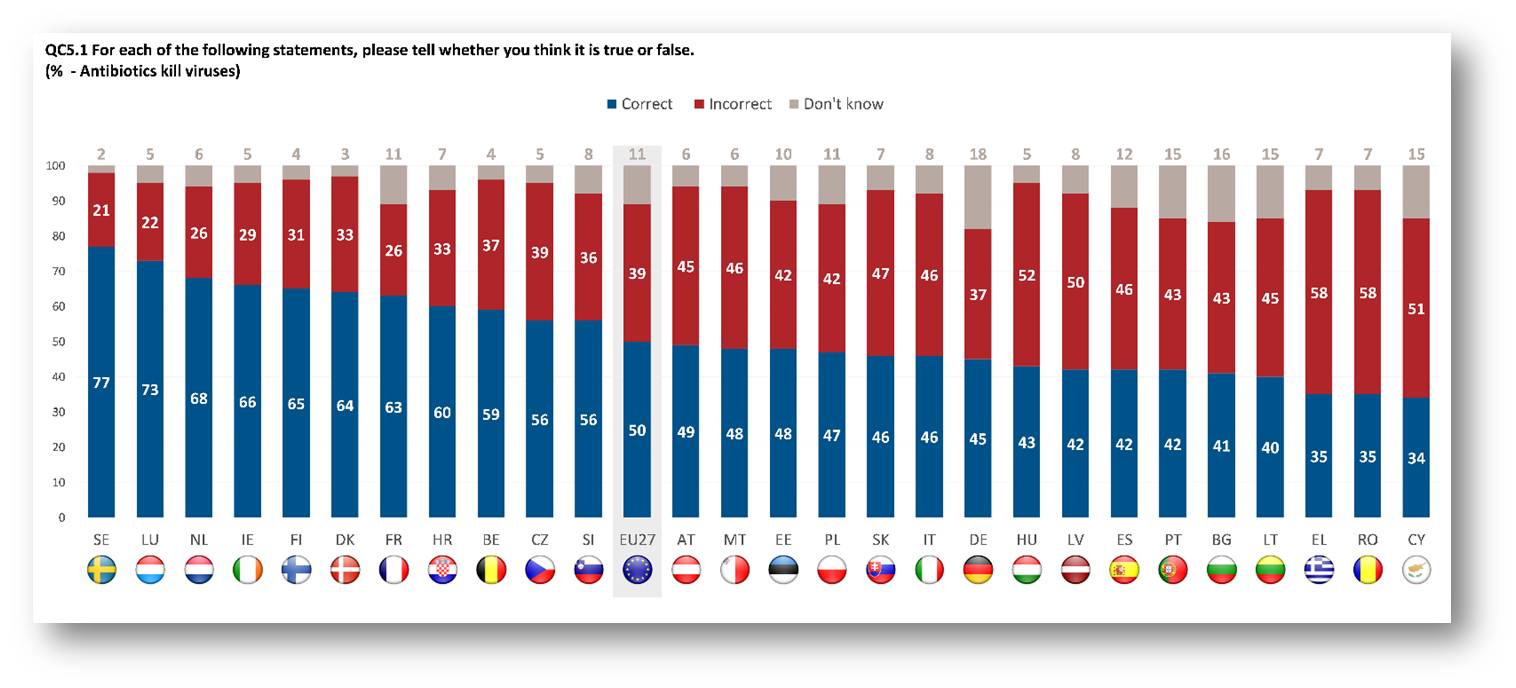

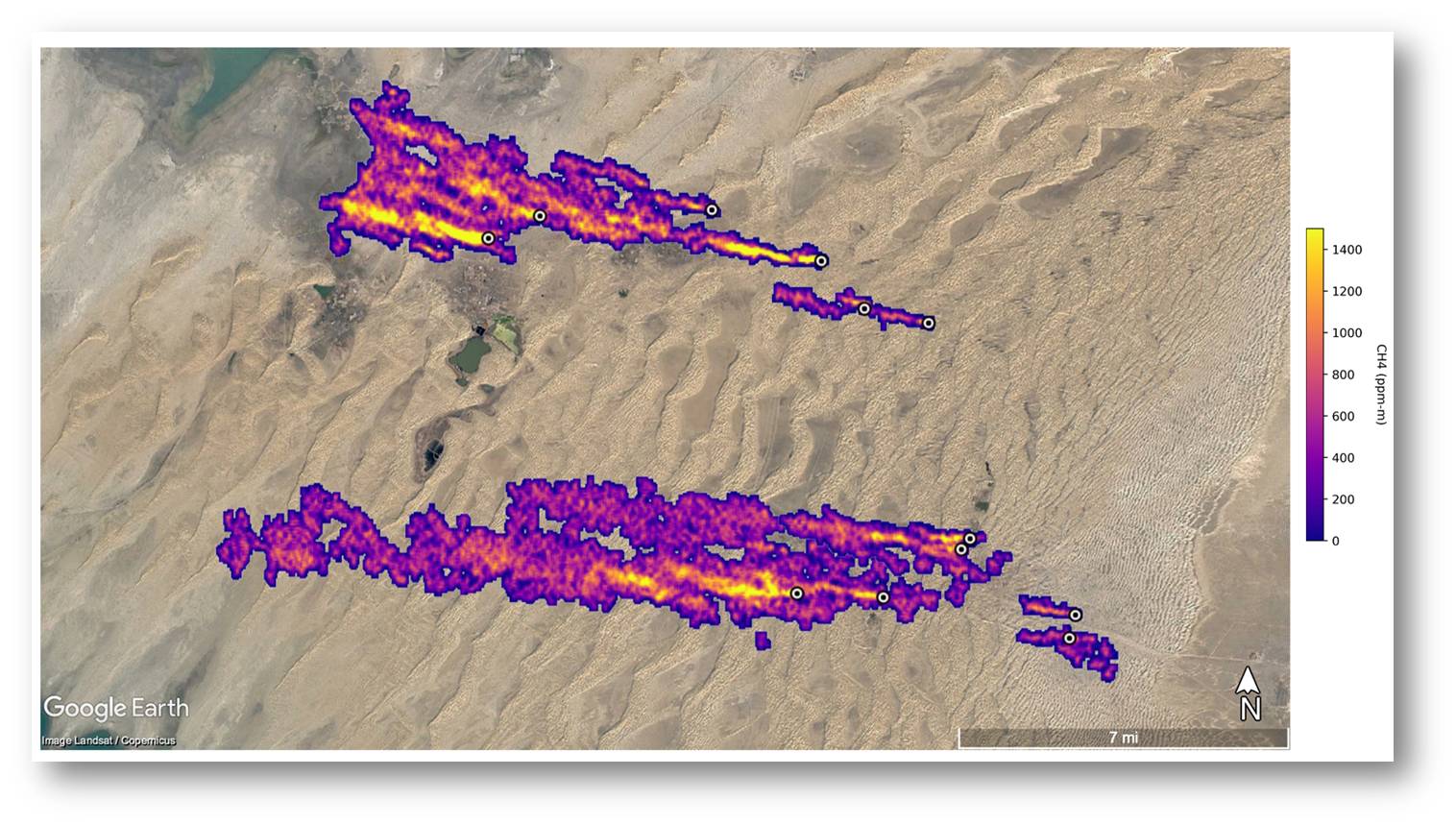

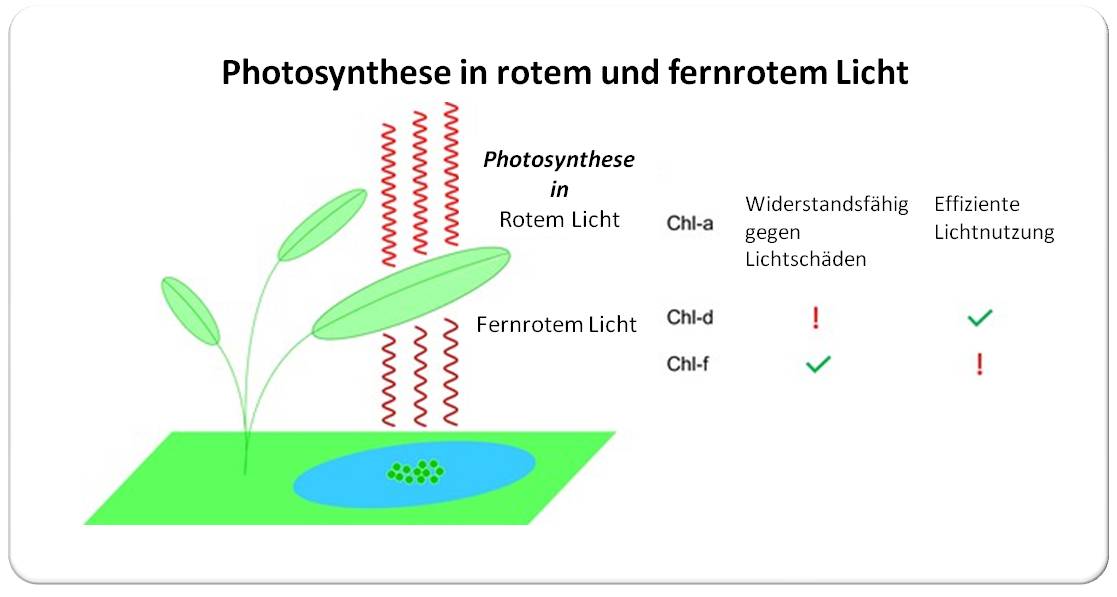

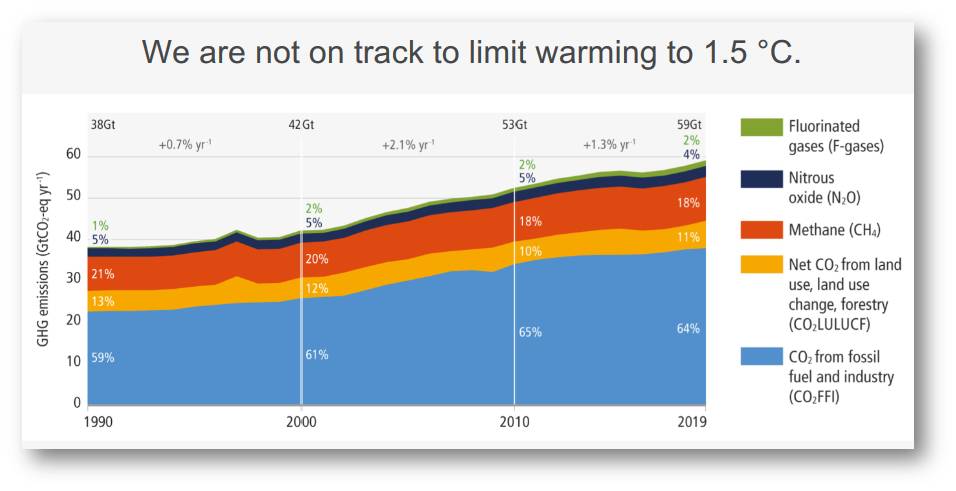

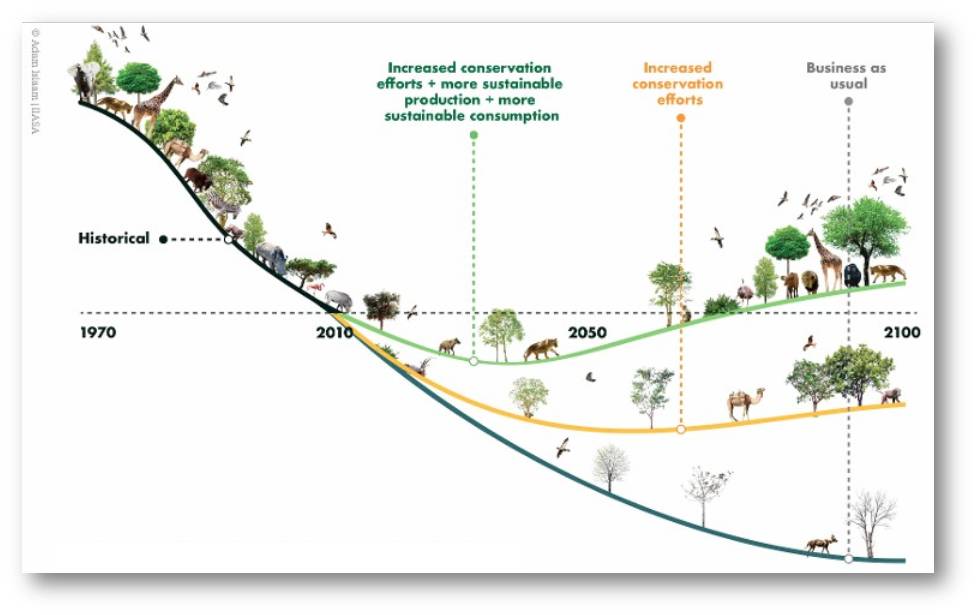

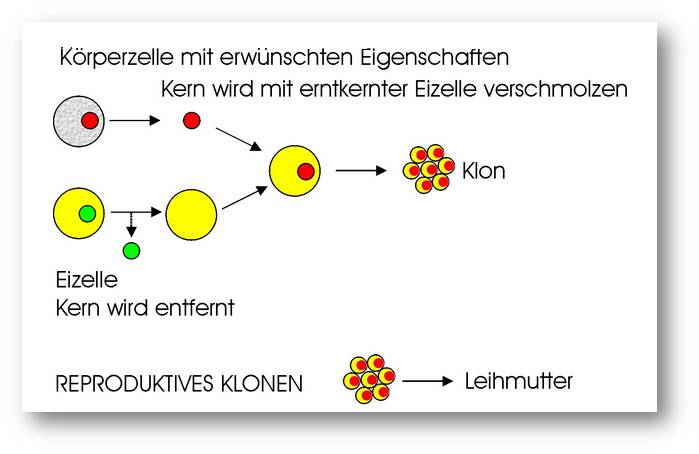

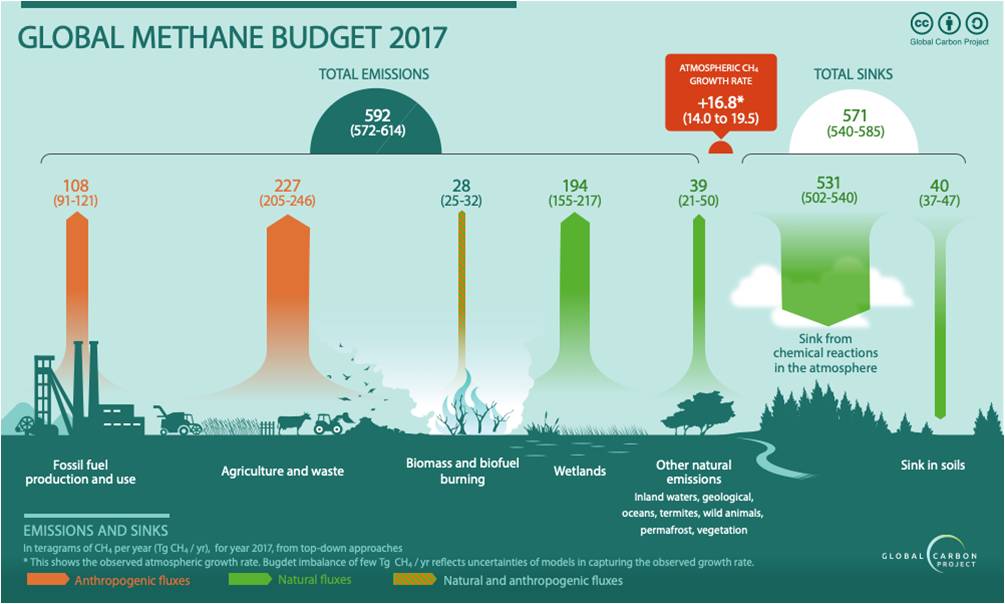

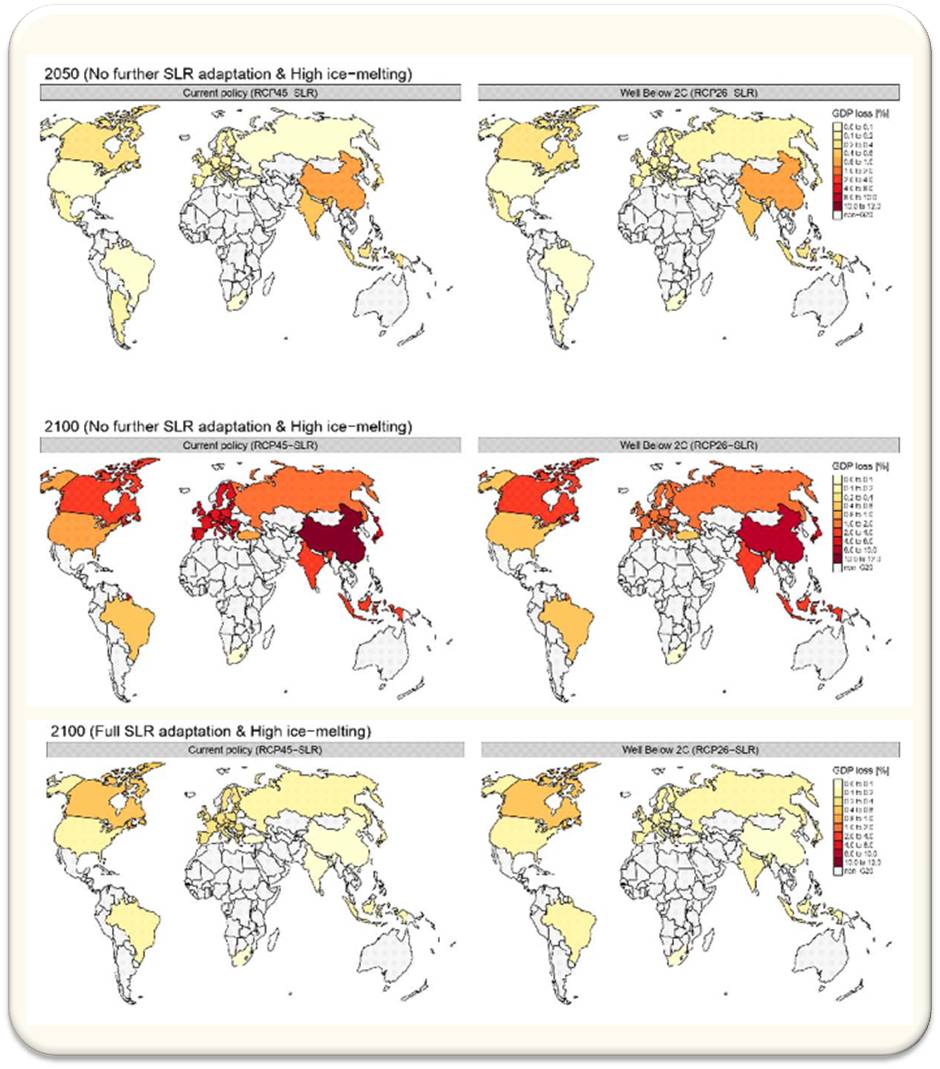

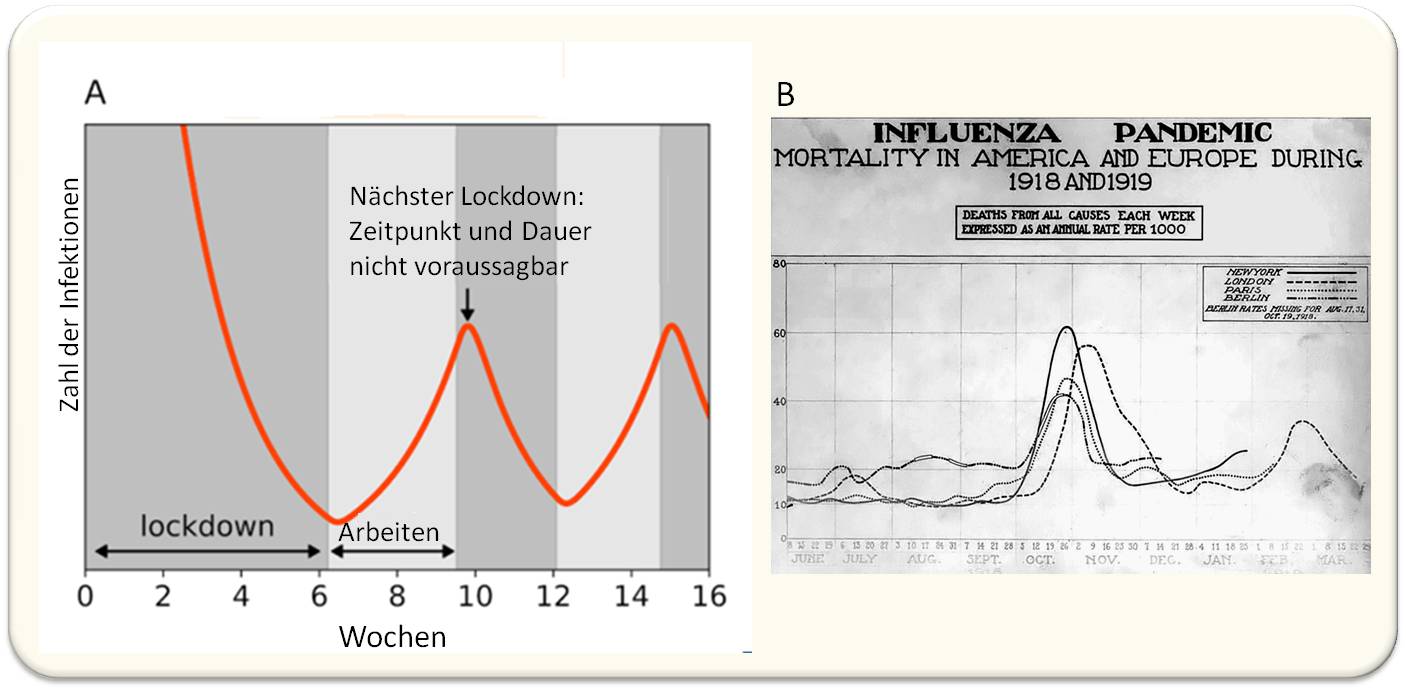

Es ist ganz einfach. Sieht man sich Diagramme an, die die Entwicklung der drei wichtigsten Treibhausgase und der globalen Temperatur in den letzten 30 Jahrtausenden aufzeigen, so steilt der Übergang vom Holozän zum Anthropozän wie eine Mauer auf. Alle vier kritischen planetarischen Parameter haben sich in den letzten 70 Jahren von nahezu horizontalen zu nahezu vertikalen Linien verschoben (Abbildung 1). Die Grafiken sind einfach, aber sie zeigen Veränderungen in der Atmosphärenchemie und - mit etwas Verspätung - in der Temperatur, die sich auf die Bewohnbarkeit des Planeten für alle seine Organismen, einschließlich des Menschen, auswirken. Auf einer Zeitskala von Jahrtausenden ähneln die Verschiebungen weniger einem Hockeyschläger als vielmehr einer Treppenstufe. Überdies betreffen diese Veränderungen die gesamte Atmosphäre und die Ozeane, so dass sie auf einer menschlichen Zeitskala im Grunde unumkehrbar sind. Künftige Generationen werden noch mit den planetarischen Veränderungen leben, welche die Menschen in einem einzigen Leben verursacht haben.

|

Abbildung 1. Die enormen Auswirkungen des Menschen auf die Atmosphäre lässt sich an der Konzentration dreier wichtiger Treibhausgase ablesen: Distickstoffoxid, Methan und Kohlendioxid. Diese Gase haben in den letzten 70 Jahren viel stärker zugenommen als in den vorangegangenen 30.000 oder mehr Jahren. Infolgedessen ist die globale Temperatur in die Höhe geschnellt, und sie wird weiter ansteigen, wenn die Auswirkungen der höheren Treibhausgaskonzentration voll zum Tragen kommen. Martin Kopf |

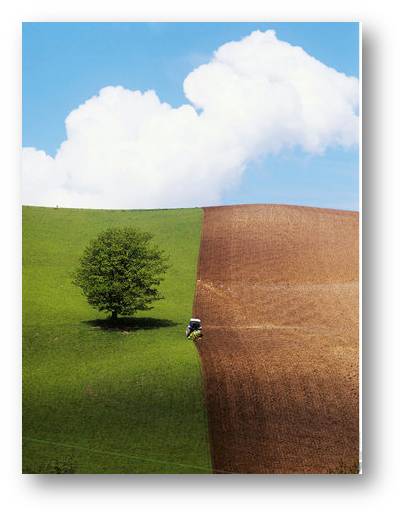

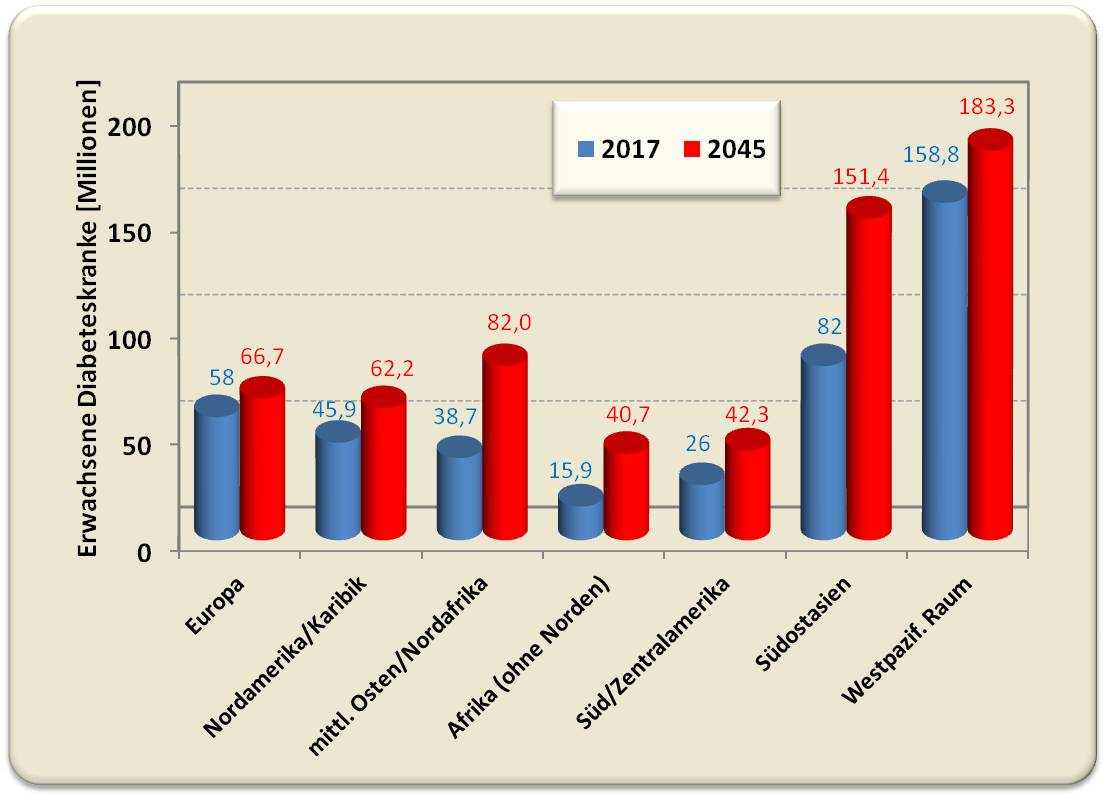

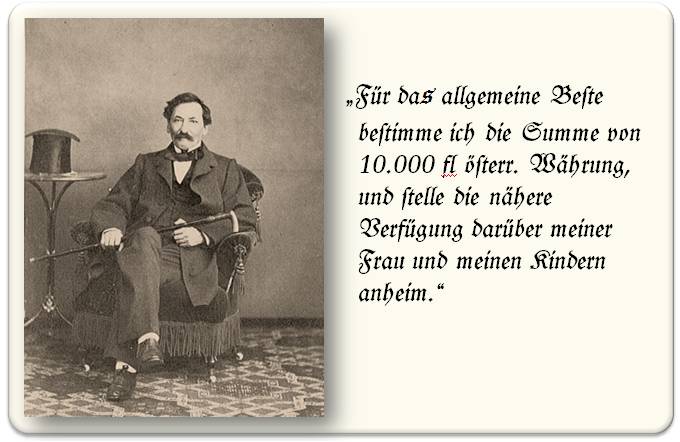

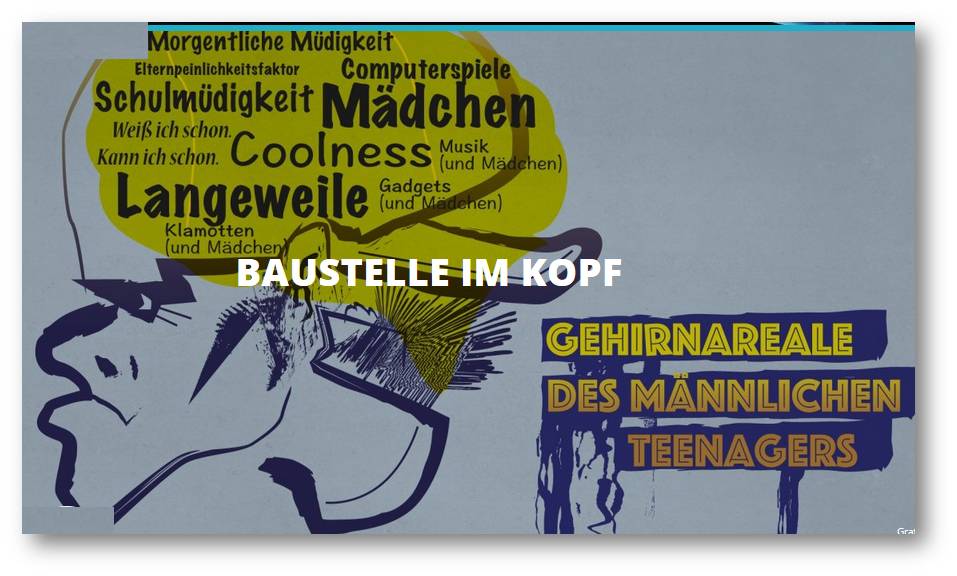

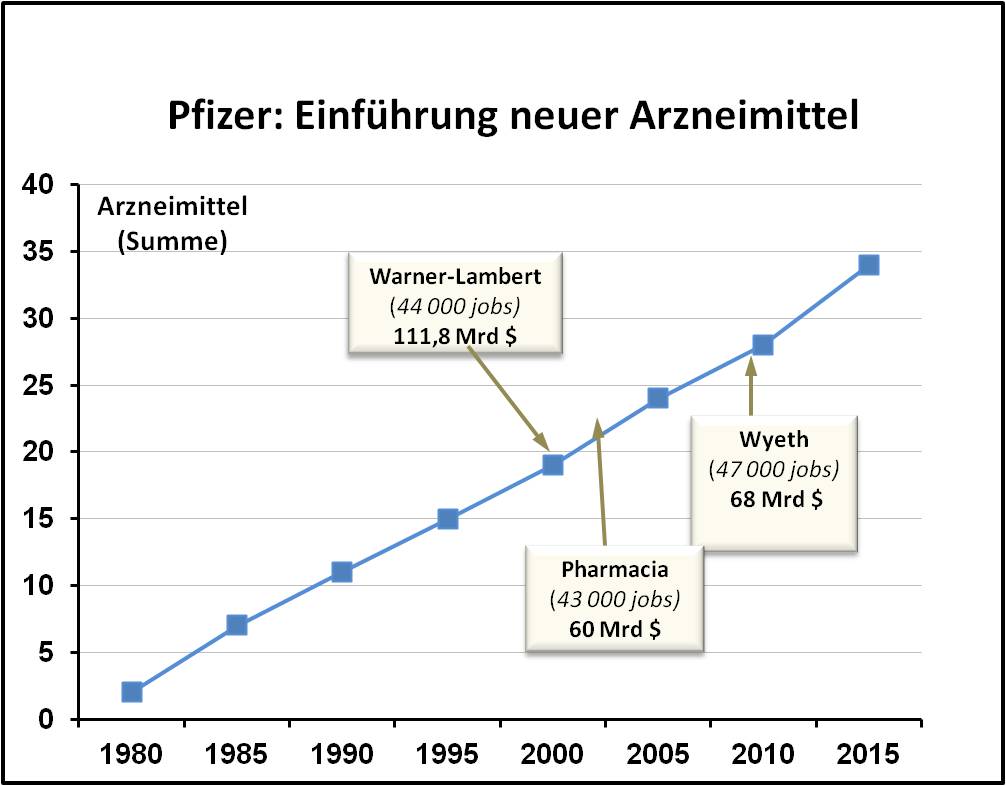

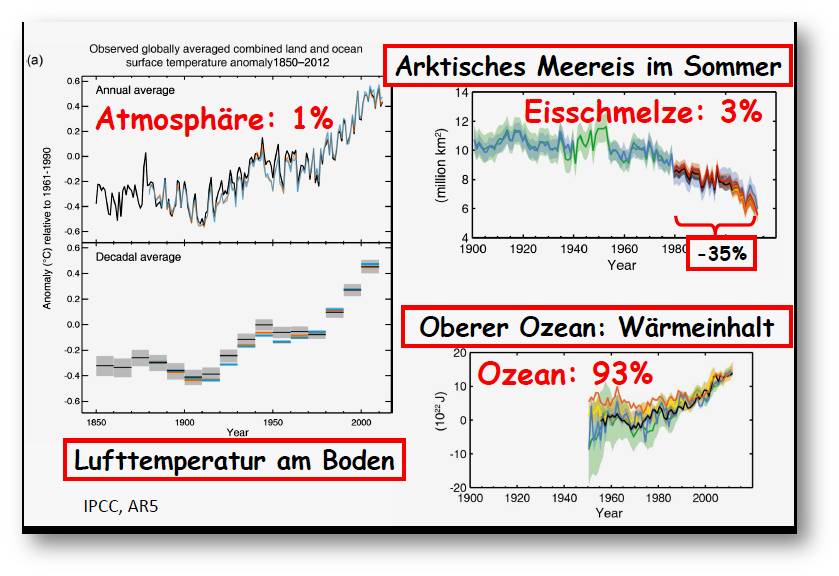

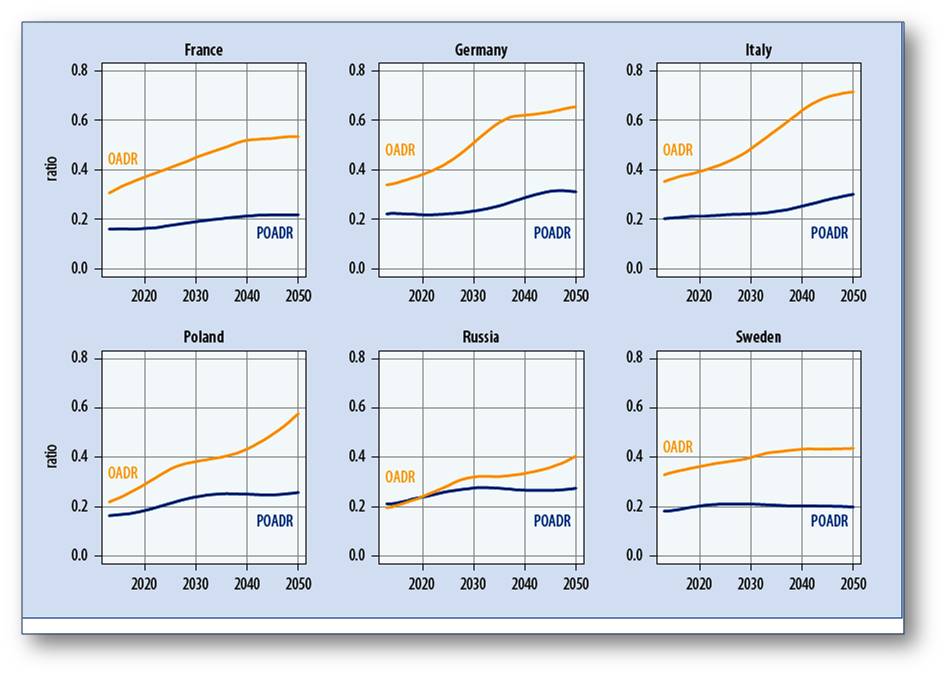

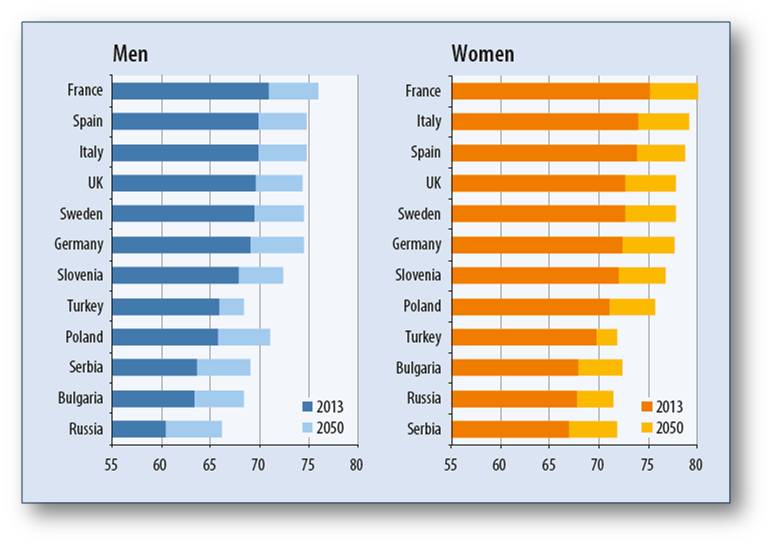

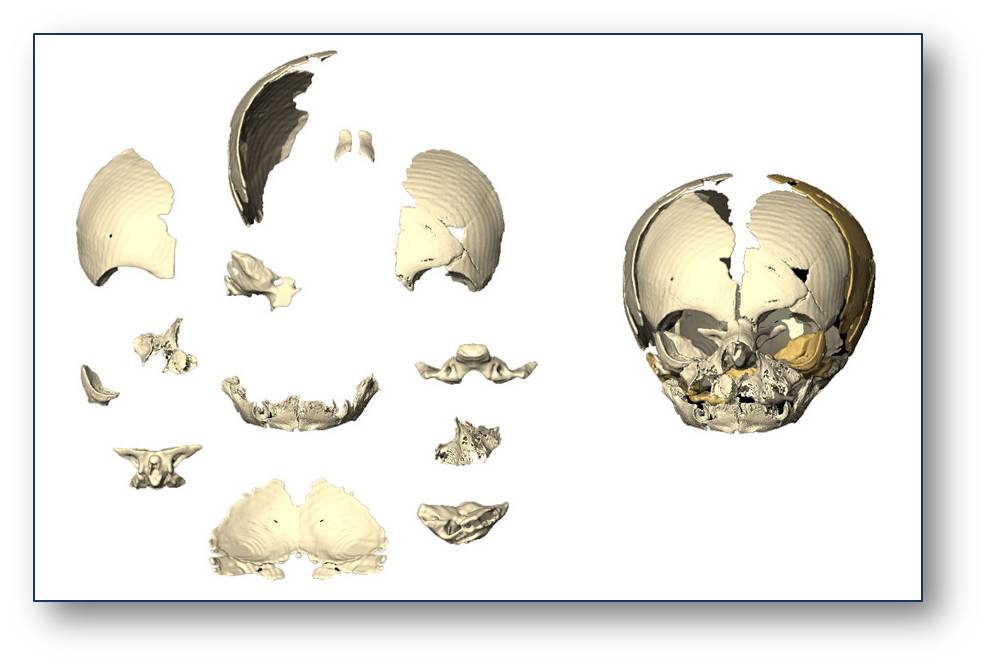

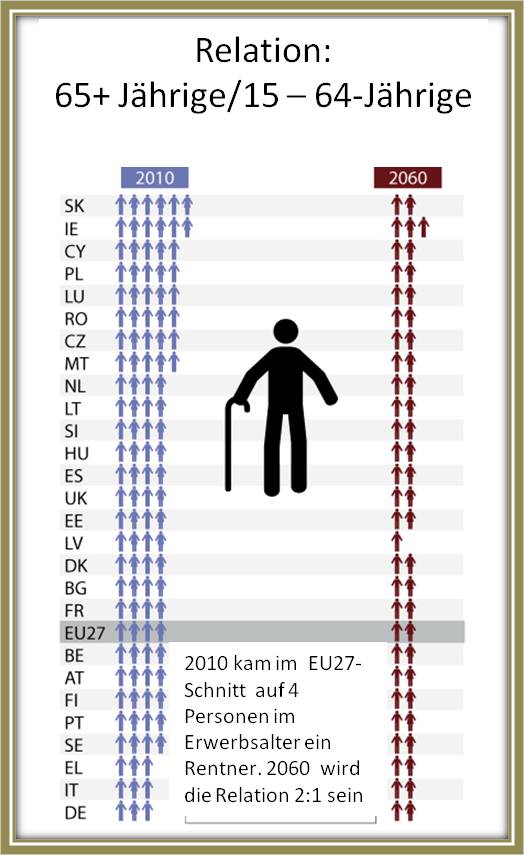

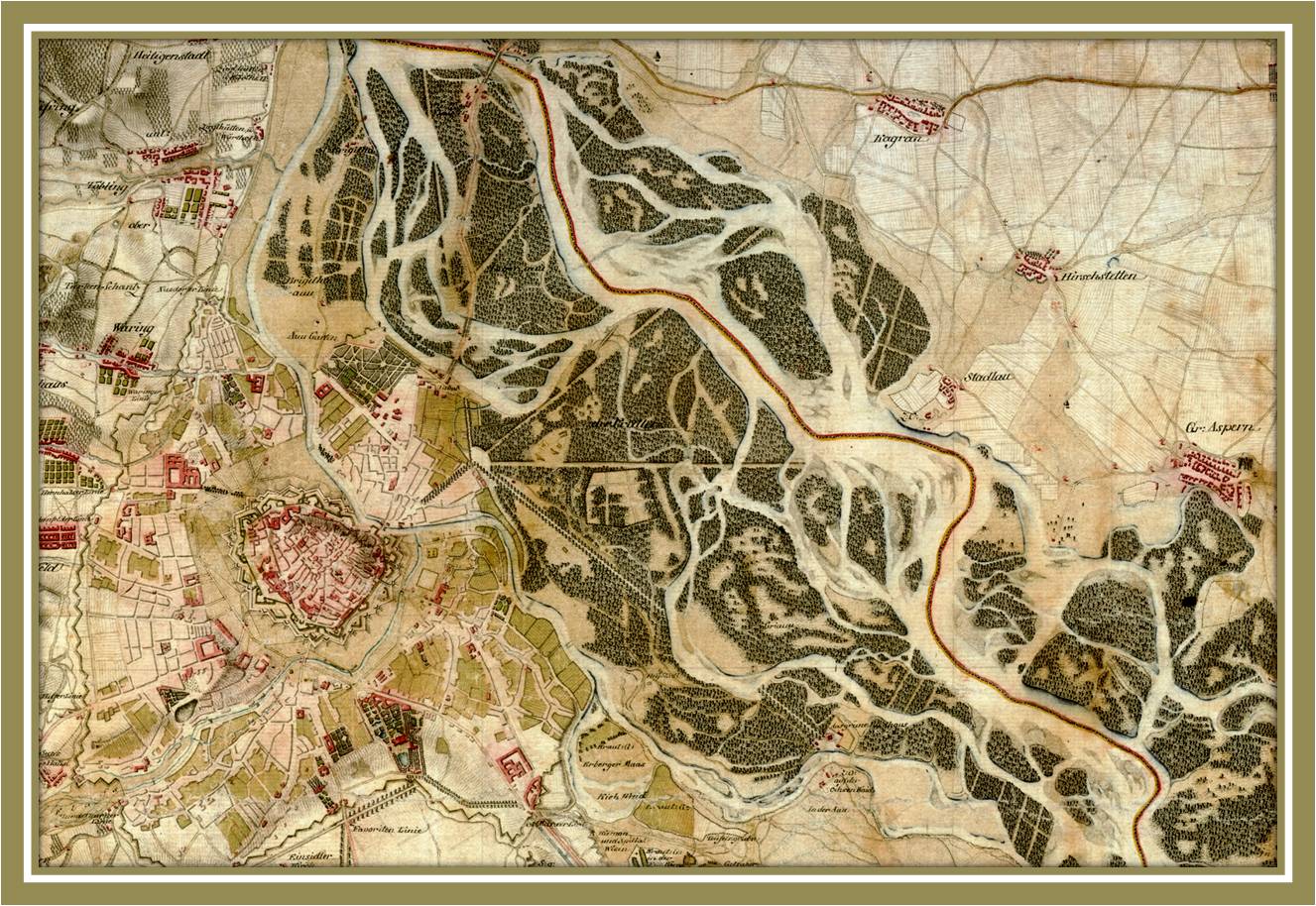

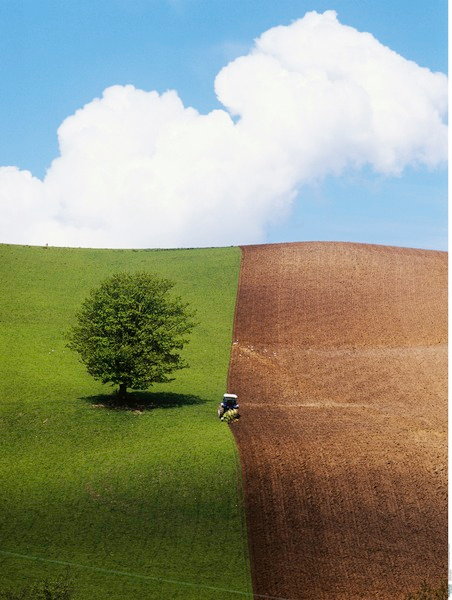

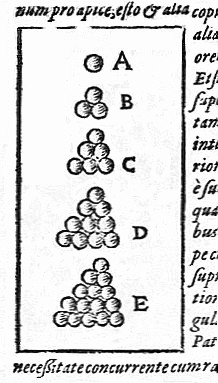

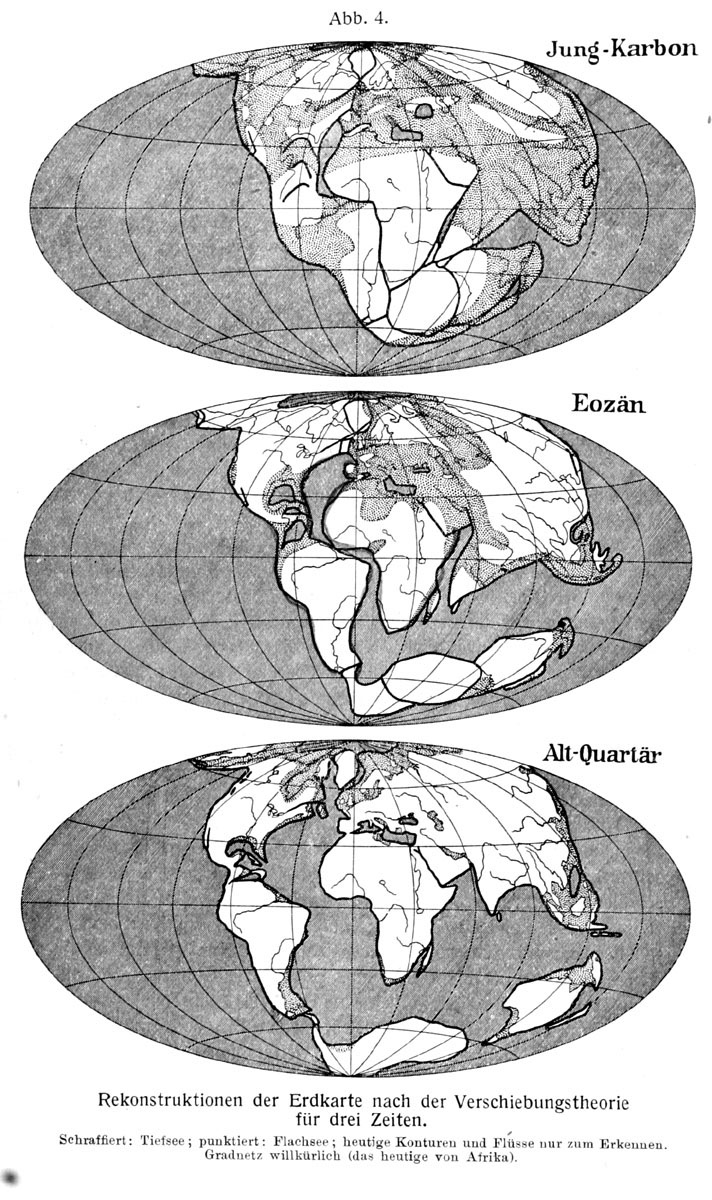

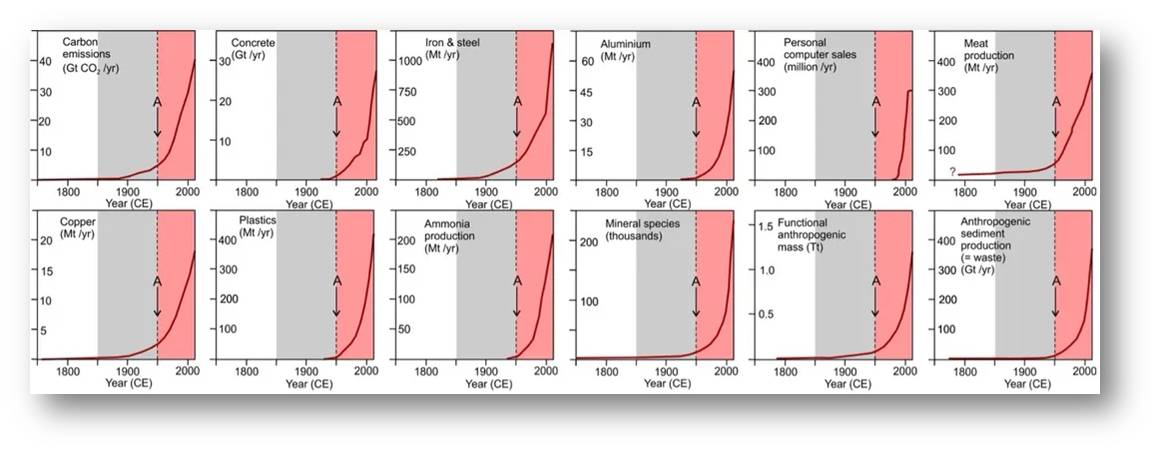

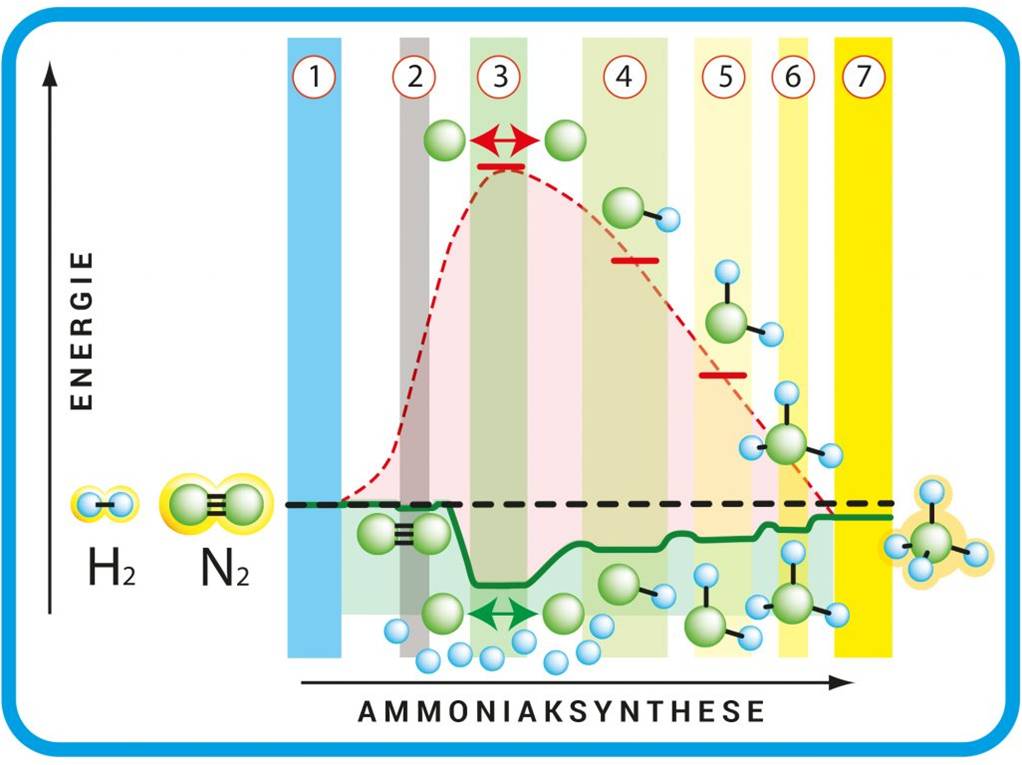

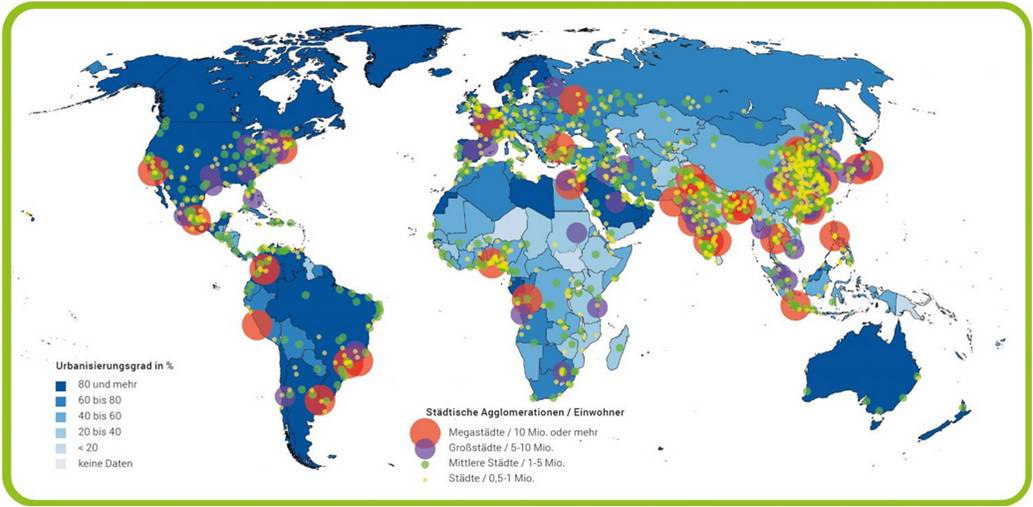

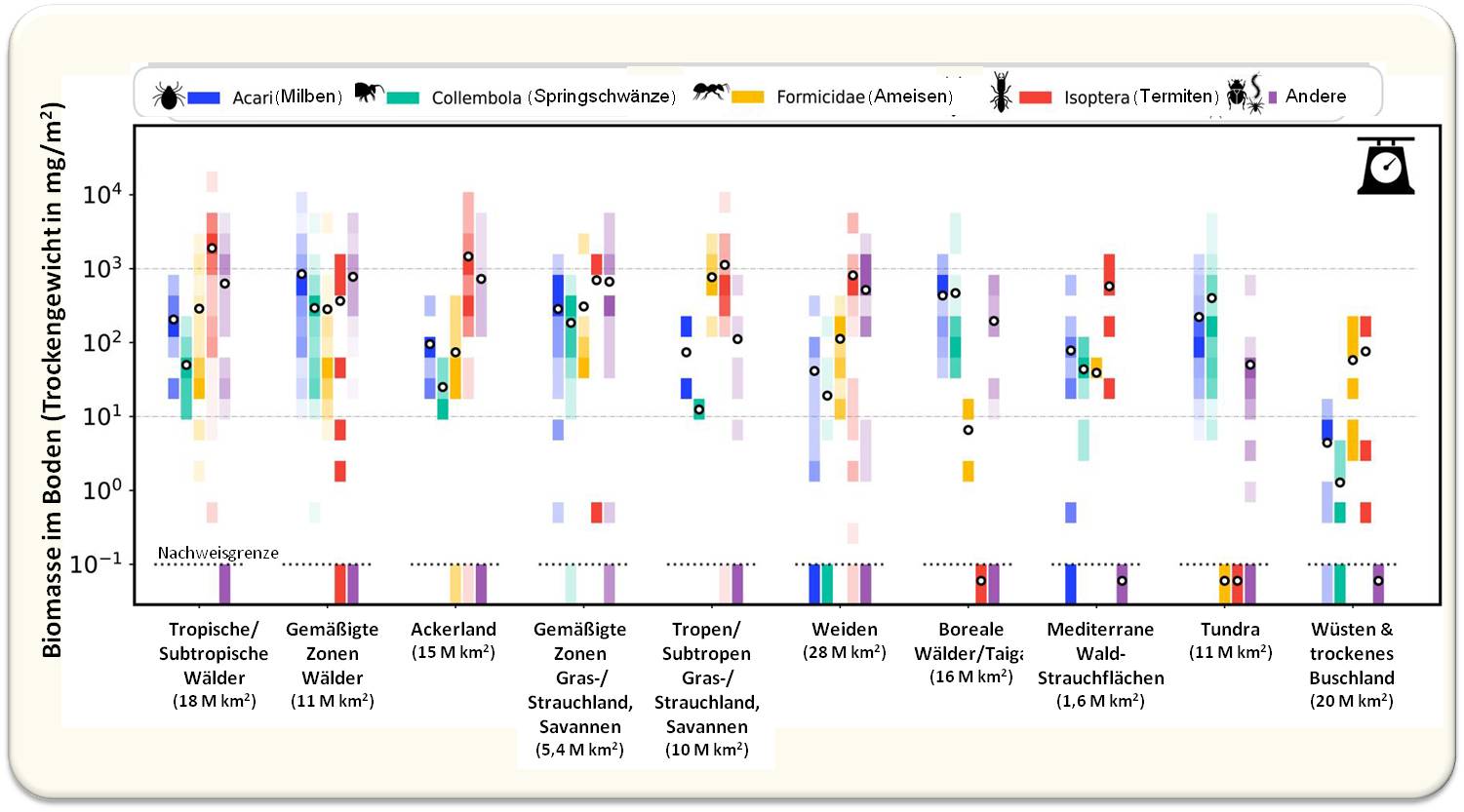

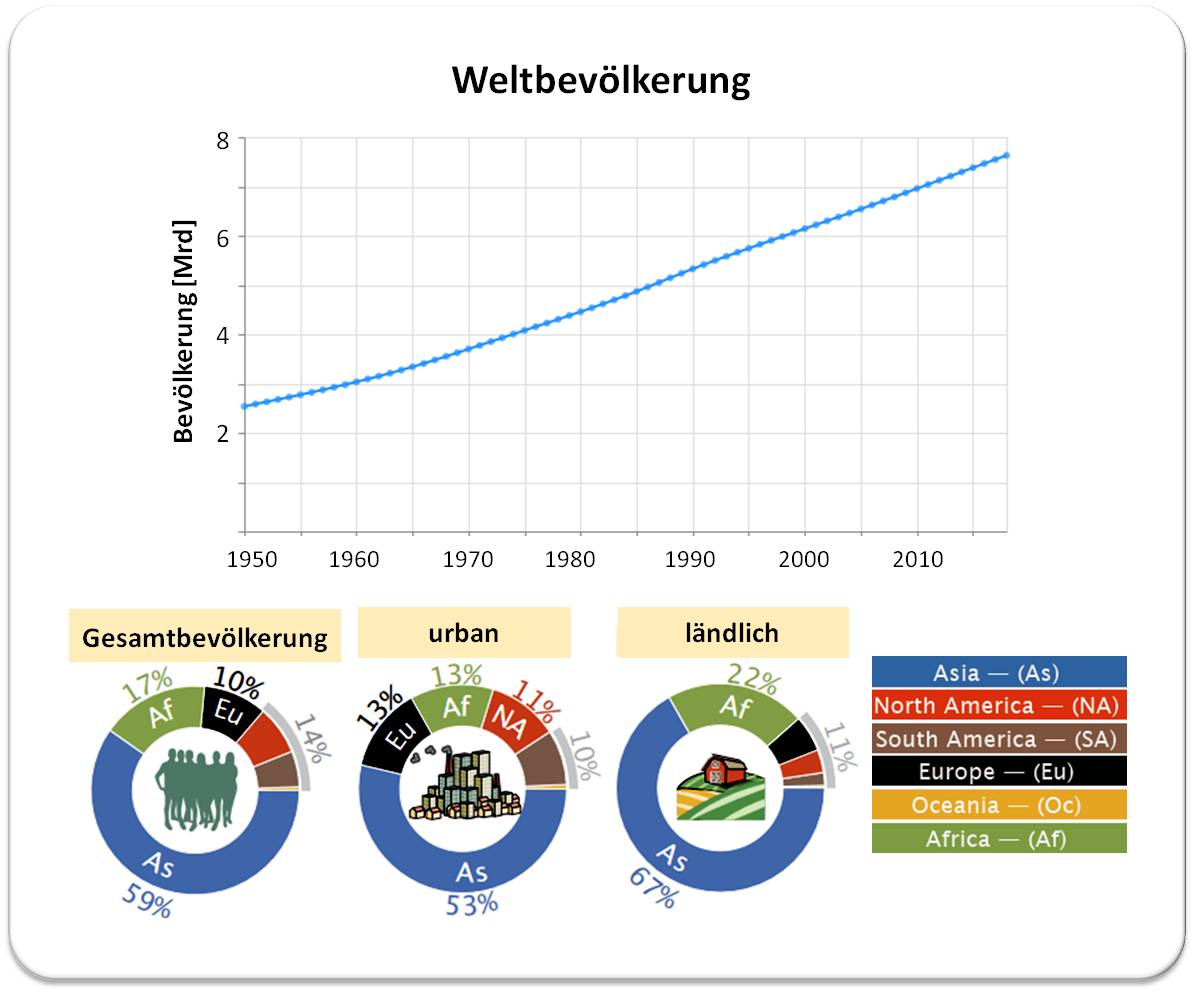

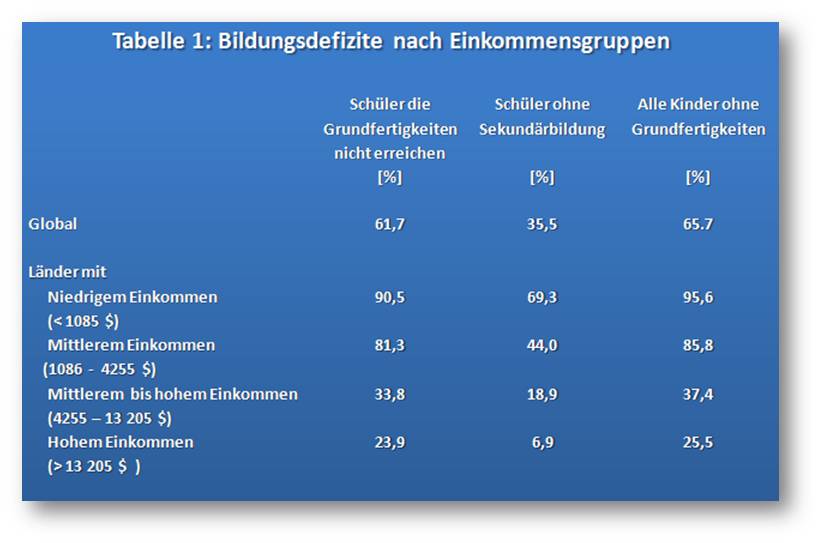

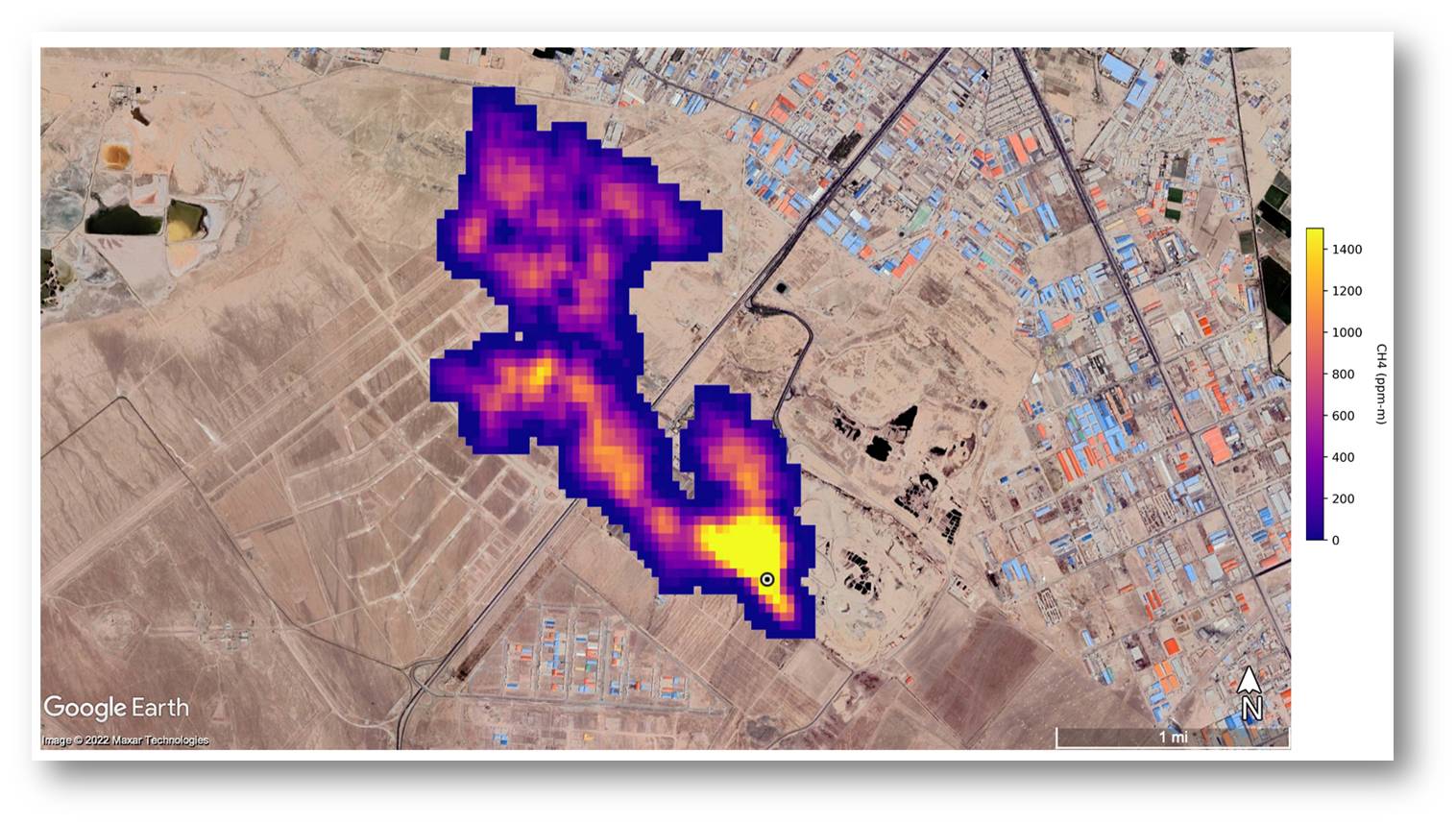

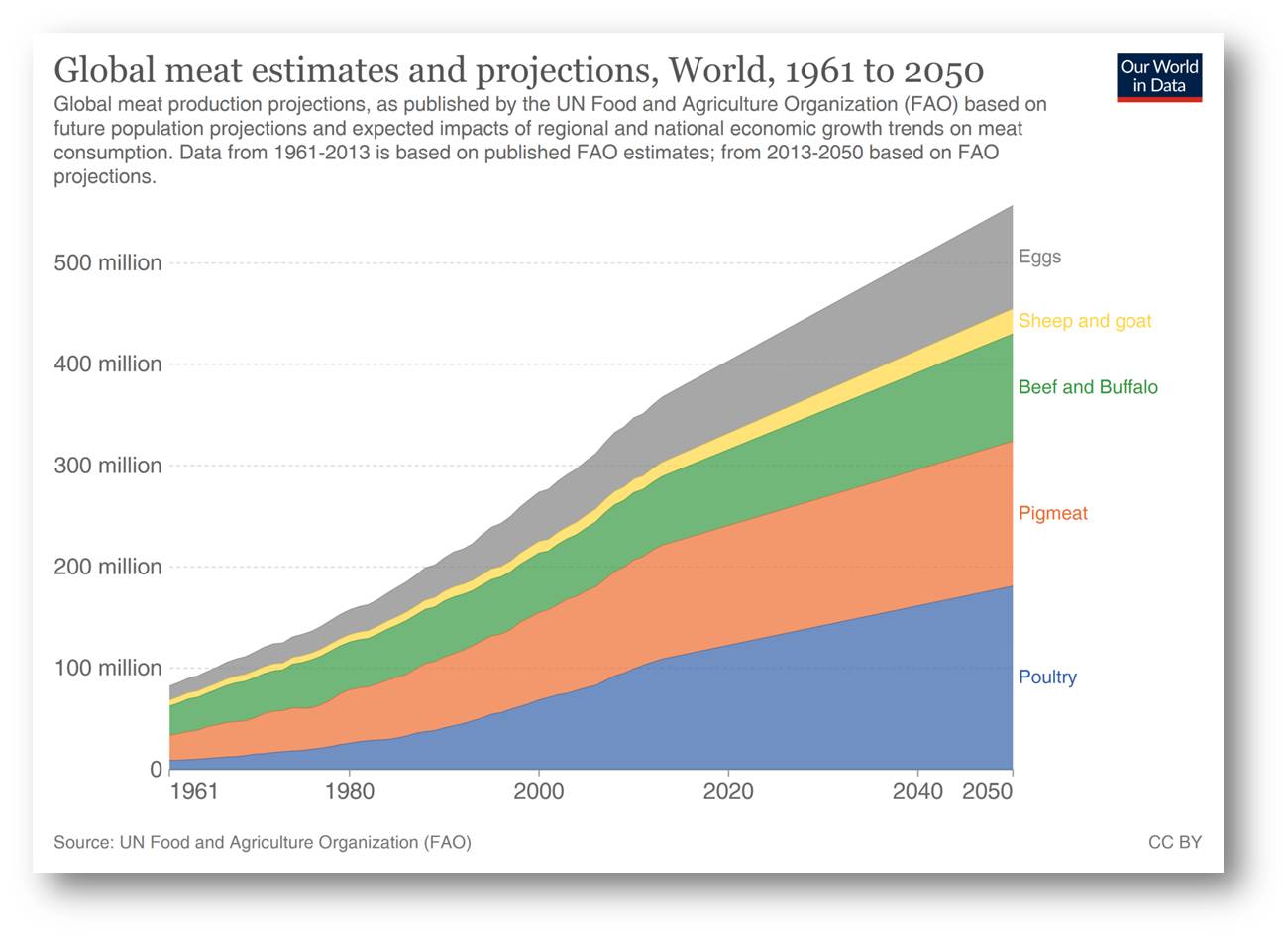

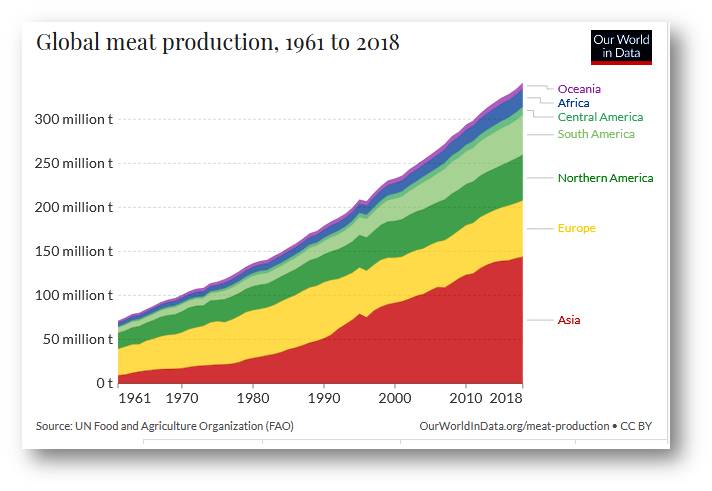

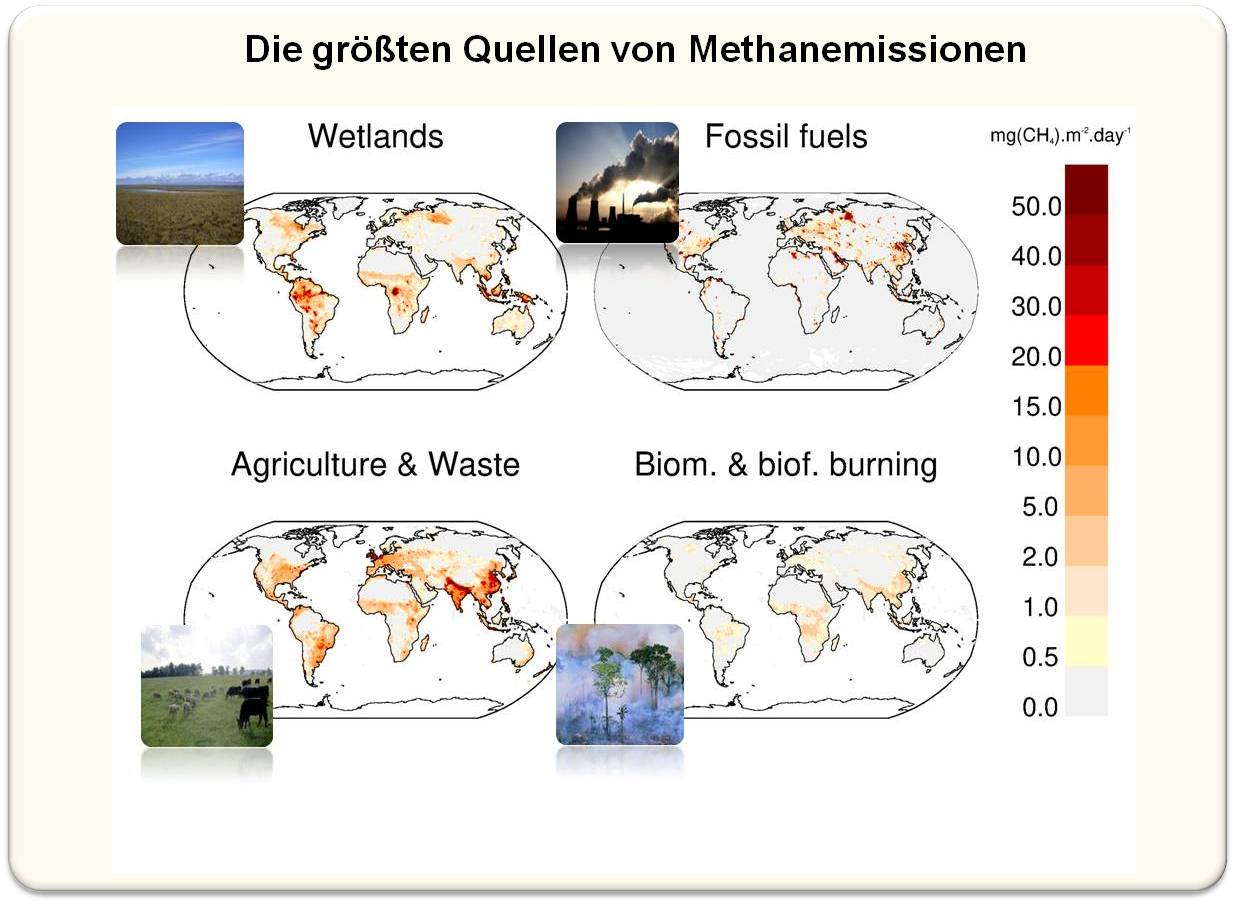

Betrachten wir nur die letzten 300 Jahre auf der Zeitachse,

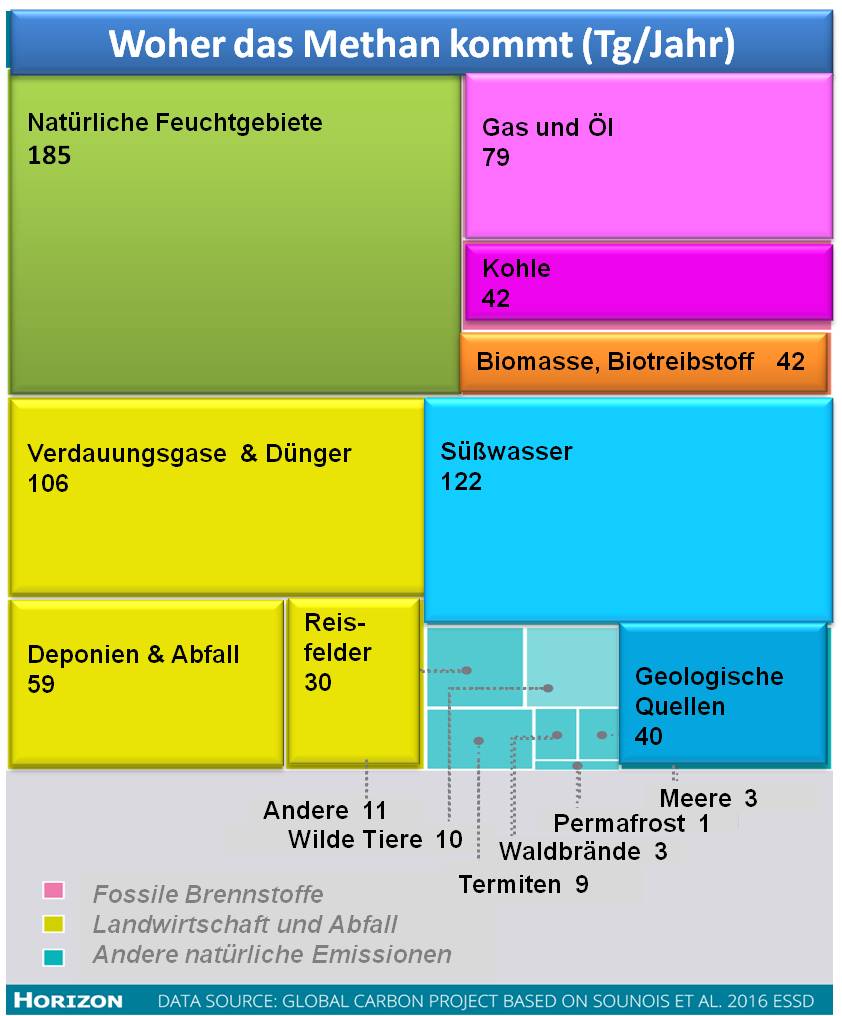

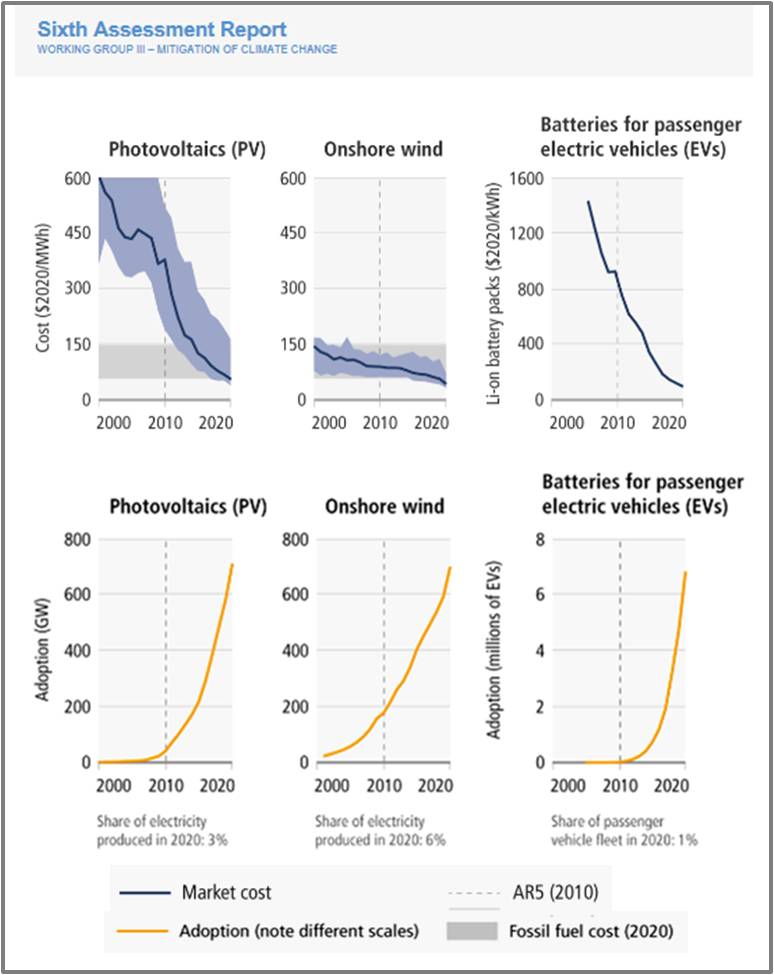

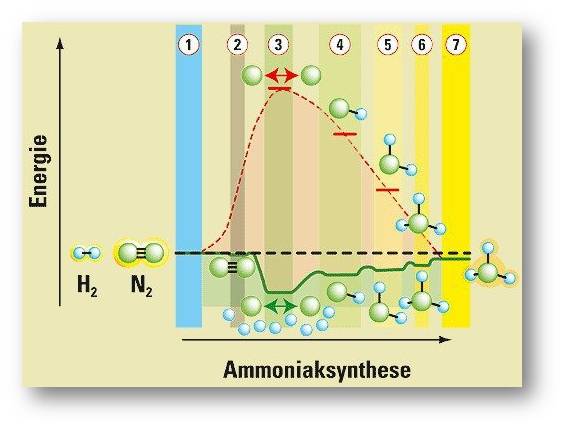

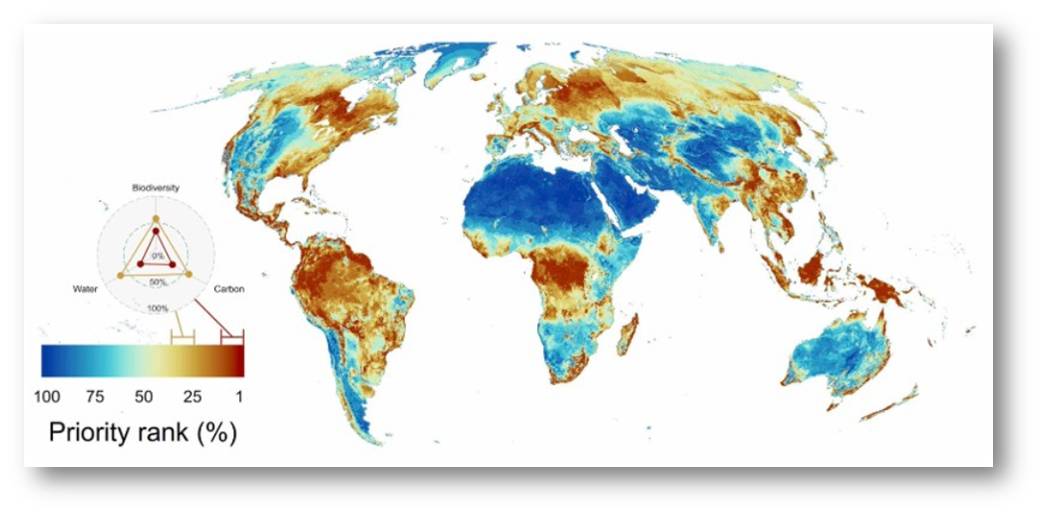

d.i. über zehn menschliche Generationen gehend, so sehen wir bemerkenswert große und schnelle Veränderungen bei einer ganzen Reihe von Faktoren, welche die Auswirkungen des Menschen auf globaler Ebene kennzeichnen: Es sind nicht nur die Kohlenstoffemissionen, sondern auch die Produktion von Metallen, Kunststoffen, Düngemitteln, Beton und Nutztieren und sogar eine gigantische Zunahme der ultimativen geologischen Währung, den Sedimenten. Abbildung 2. Die Menge an Ablagerungen, die der Mensch jedes Jahr mobilisiert, übersteigt inzwischen die Menge der durch nicht-menschliche Prozesse mobilisierten Sedimente um das 15-fache.

Wenn wir den Zeitrahmen so einengen, sehen wir, dass die globalen Veränderungen ab Mitte des 20 Jahrhunderts besonders rasch erfolgen.

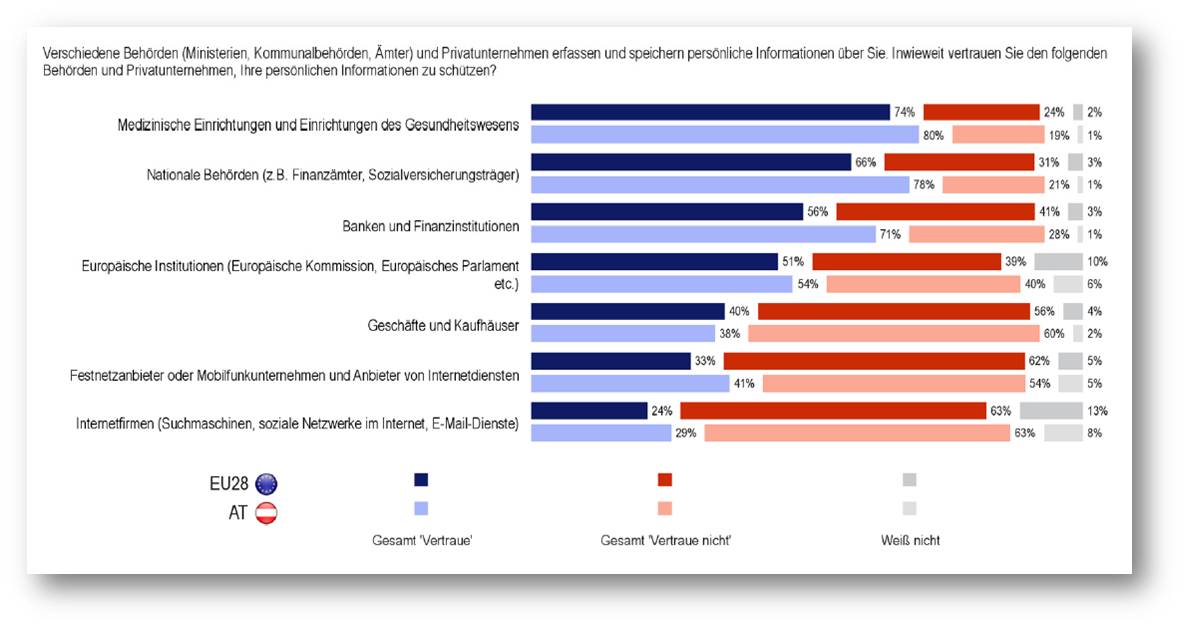

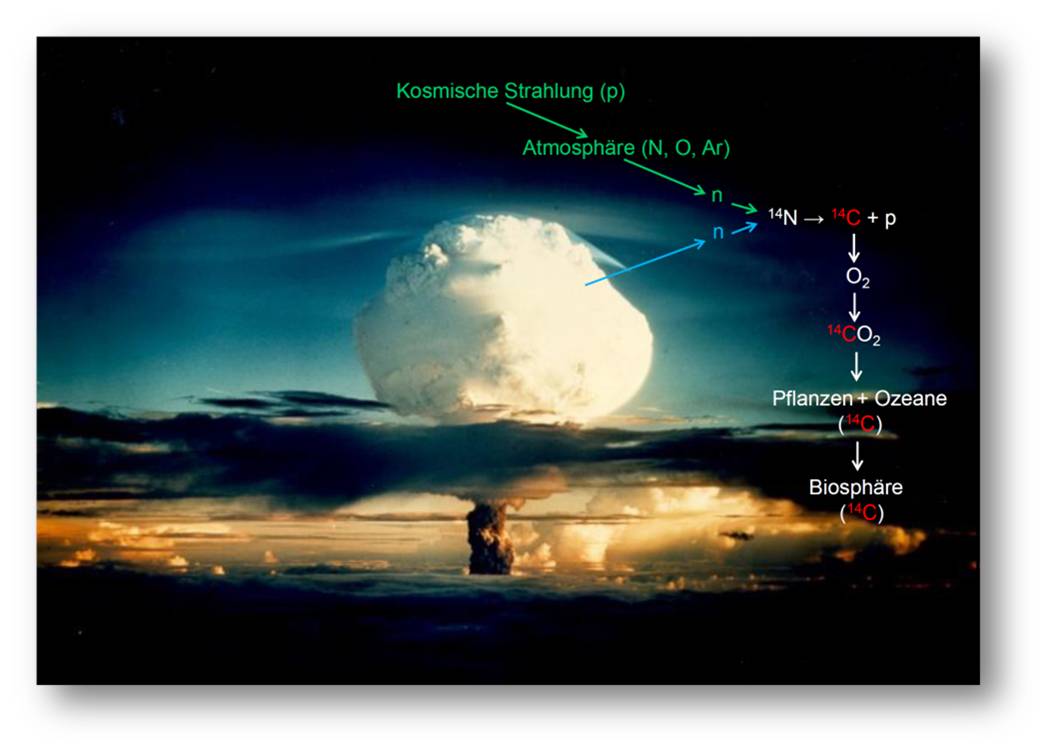

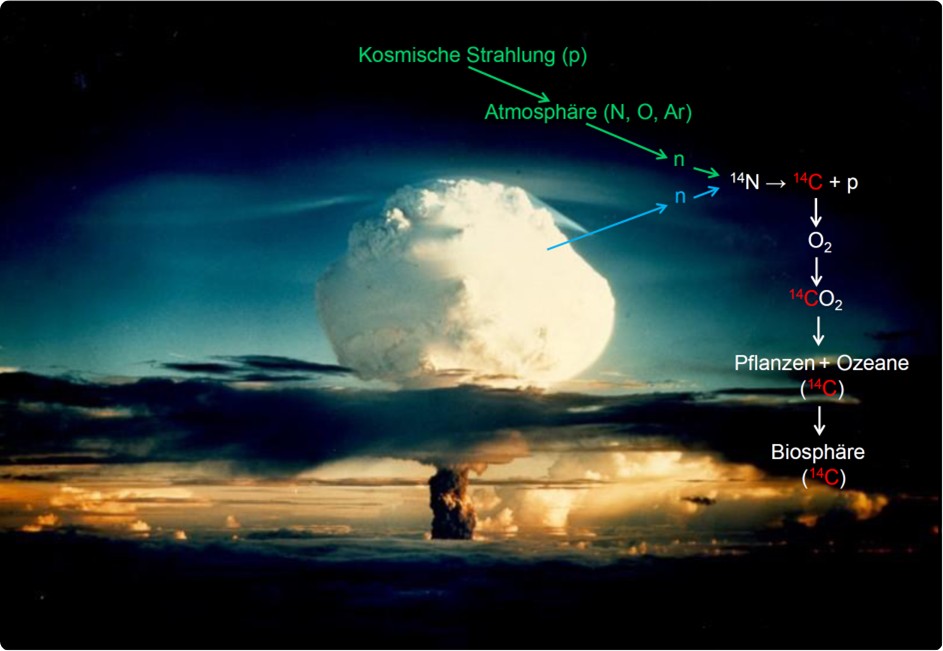

Die Anthropozän-Arbeitsgruppe,

ein Gremium von 34 Wissenschaftlern aus 14 Ländern, das 2009 von der Internationalen Kommission für Stratigraphie eingesetzt wurde, schlug vor, den Beginn einer neuen Anthropozän-Epoche auf das Jahr 1952 zu legen, als die Sedimente weltweit durch den ersten größeren Anstieg des Elements Plutonium gekennzeichnet wurden, das aus den ersten Tests mit thermonuklearen Waffen stammt.

|

Abbildung 2. Wissenschaftler schlugen vor, eine neue geologische Epoche - das Anthropozän - anzuerkennen, das durch sehr rasche Veränderungen ab Mitte des 20. Jahrhunderts gekennzeichnet ist. Die in den letzten 70 Jahren abgelagerten Sedimente sind durch eine Fülle künstlicher Materialien wie Beton, Metalle, Kunststoffe und Düngemittel gekennzeichnet. Auch die Ökosysteme haben sich durch den starken Anstieg der Düngemittelproduktion (Ammoniak) und der Viehzucht (Fleischproduktion) verändert. Auch der Mensch ist ein enormer Produzent von Sedimenten. Colin Waters |

Mit dem Vorschlag einer formellen, geologisch definierten Epoche des Anthropozäns wollte die Arbeitsgruppe eine genaue Definition für diesen jüngsten, großen, dauerhaften und raschen Übergang in den physikalischen, chemischen und biologischen Systemen der Erde liefern.

Der Vorschlag wurde von der internationalen Hierarchie der Stratigraphie, zu der auch die International Commission on Stratigraphy gehört, ohne Angabe von Gründen abgelehnt, aber die meiste öffentliche Kritik am Anthropozän kommt aus verschiedenen Quellen: von der Geologie bis hin zu den Sozial- und Geisteswissenschaften.

In vielen Disziplinen hat das Anthropozän einen Nerv getroffen - und oft auch verletzt: manchmal als Bauchgefühl auf eine beunruhigende neue Idee, manchmal mit Unbehagen angesichts ungewohnter gesellschaftspolitischer Implikationen. Aus welchen Gründen auch immer, das Anthropozän geriet unter Beschuss.

Das Sperrfeuer der Kritik konzentrierte sich jedoch häufig auf das, was das Anthropozän nicht ist, anstatt auf das, was es ist. Grundlegende Missverständnisse rund um das Konzept vernebeln seine Bedeutung.

Im Folgenden räumen wir mit zehn gängigen Mythen über das Anthropozän auf.

1. Das Anthropozän bildet nicht alle menschlichen Einflüsse ab.

Das ist zwar richtig, geht aber völlig an der Sache vorbei. Die Anerkennung eines Anthropozäns unterschlägt keineswegs die Auswirkungen, die der Mensch seit vielen Jahrtausenden durch die Jagd, den Ackerbau und den Bau von Städten und Handelsnetzen verursacht hat. Aber diese frühen Auswirkungen waren nicht global, liefen nicht synchron auf dem Planeten ab und haben die globale Umwelt nicht dauerhaft verändert. Der Grund für die Benennung einer neuen geologischen Epoche, sowohl in Crutzens ursprünglicher Formulierung als auch in dem sehr detaillierten Vorschlag der Arbeitsgruppe, besteht darin, den Abschied der Erde und ihrer Bewohner von dem stabilen System des Planeten im Holozän zu markieren. Die Epoche des Anthropozäns war nie dazu gedacht, alle anthropogenen Einflüsse zu erfassen.

2. Das Anthropozän ist zu kurz, um eine geologische Epoche zu sein - nur ein Menschenleben.

Die Dauer des Anthropozäns ist kurz, soweit stimmt das. Aber es ist das Holozän, das den größten Unterschied in der Dauer zu anderen Epochen aufweist: fast drei Größenordnungen (11 700 Jahre verglichen mit 2,57 Millionen Jahren für das voran gegangene Pleistozän). Der Unterschied in der Dauer zwischen Holozän und Anthropozän ist proportional geringer, und das Anthropozän stellt eine weitaus bedeutendere und dauerhaftere Veränderung des Planeten dar als das Holozän.

3. Das Anthropozän ist nur ein Augenblick in der Erdgeschichte.

Oder, wie die New York Times schreibt, nennt es ein ranghohes Mitglied der geologischen Zeitskala "ein Augenblick von einem Augenblick von einem Augenblick ". Was diese Sichtweise verkennt, ist, dass diese rund 70 Jahre den Planeten grundlegend verändert und eine neue Bahn einschlagen haben lassen. Schon jetzt sind viele geologische Anzeichen deutlicher und ebenso ausgeprägt wie die plötzliche Freisetzung von Kohlenstoff und die globale Erwärmung, die das Eozän vor 56 Millionen Jahren auslöste.

Man denke nur an die Klimaauswirkungen durch die Verbrennung fossiler Brennstoffe, von denen 90 Prozent in den letzten 70 Jahren verbrannt wurden. Diese Auswirkungen werden sich zumindest noch viele tausend Jahre lang über den Planeten breiten. Wir und viele künftige Generationen sind auf ein Klima festgelegt, das sich von dem des Holozäns unterscheidet. Das bereits in der Atmosphäre befindliche Kohlendioxid wird die Erde heißer machen, als sie es seit mindestens 3 Millionen Jahren war. Viele der biologischen Veränderungen der letzten 70 Jahre sind ebenfalls von Dauer: zweifellos das Aussterben von Arten, aber auch die Ausbreitung vieler Arten durch beabsichtigte und unbeabsichtigte Beihilfe des Menschen, mit einer weltweit veränderten Fauna und Flora als Folge. Die Biosphäre hat sich für immer verändert. Das ist keine Eintagsfliege.

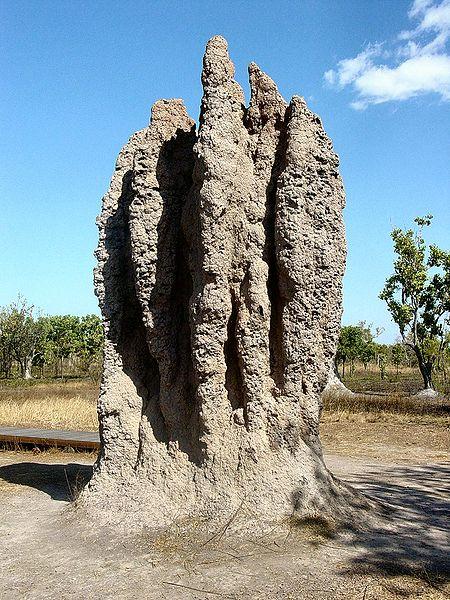

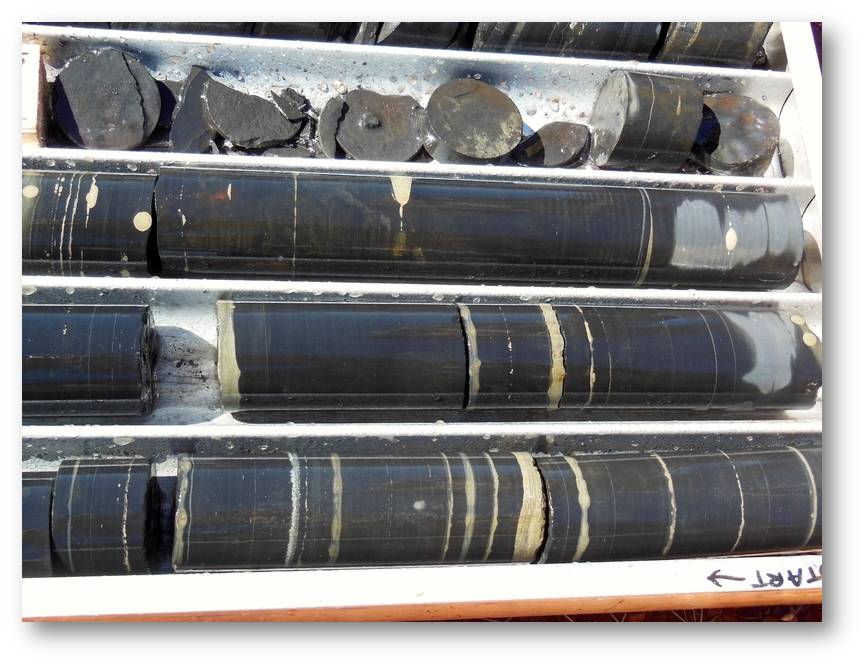

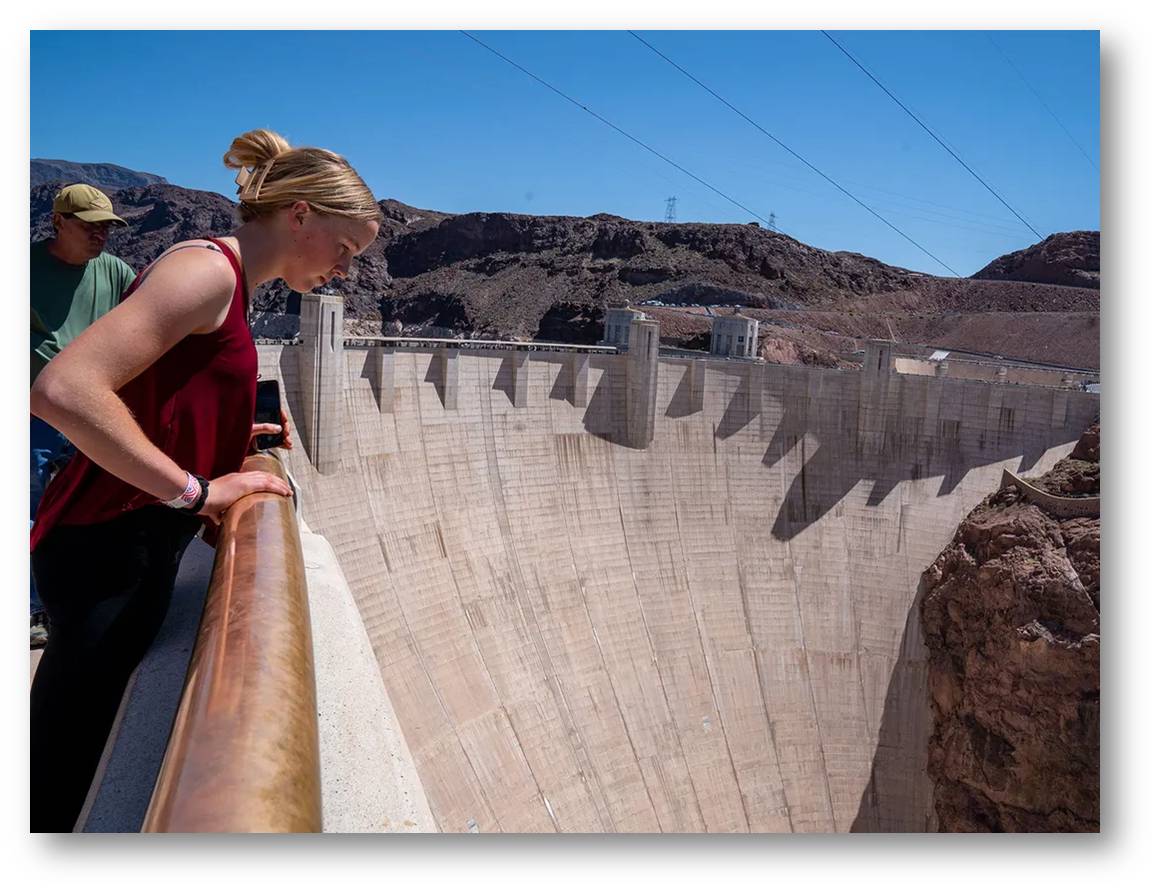

4. Anthropozän-Schichten sind "minimal" oder "vernachlässigbar".

|

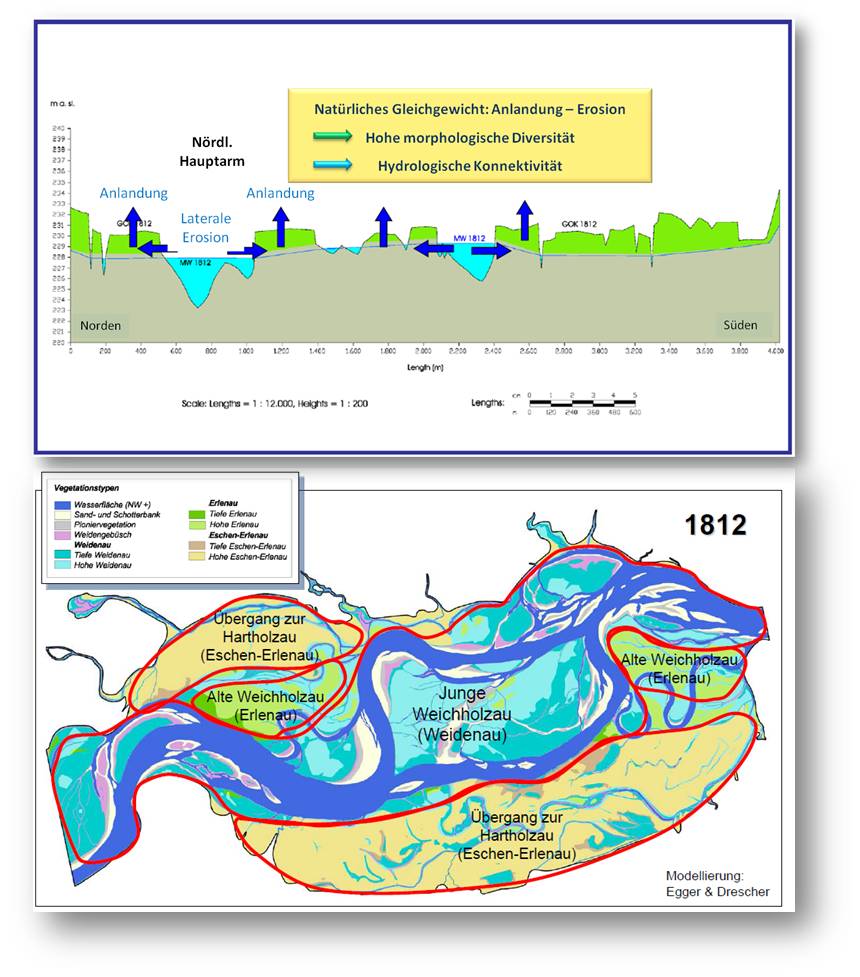

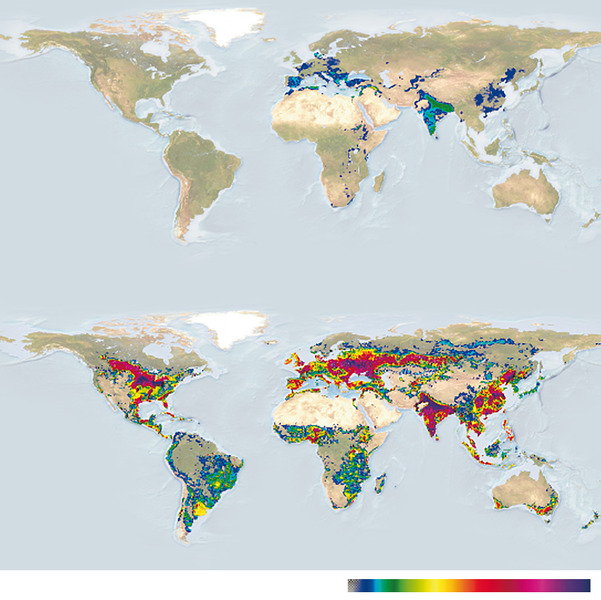

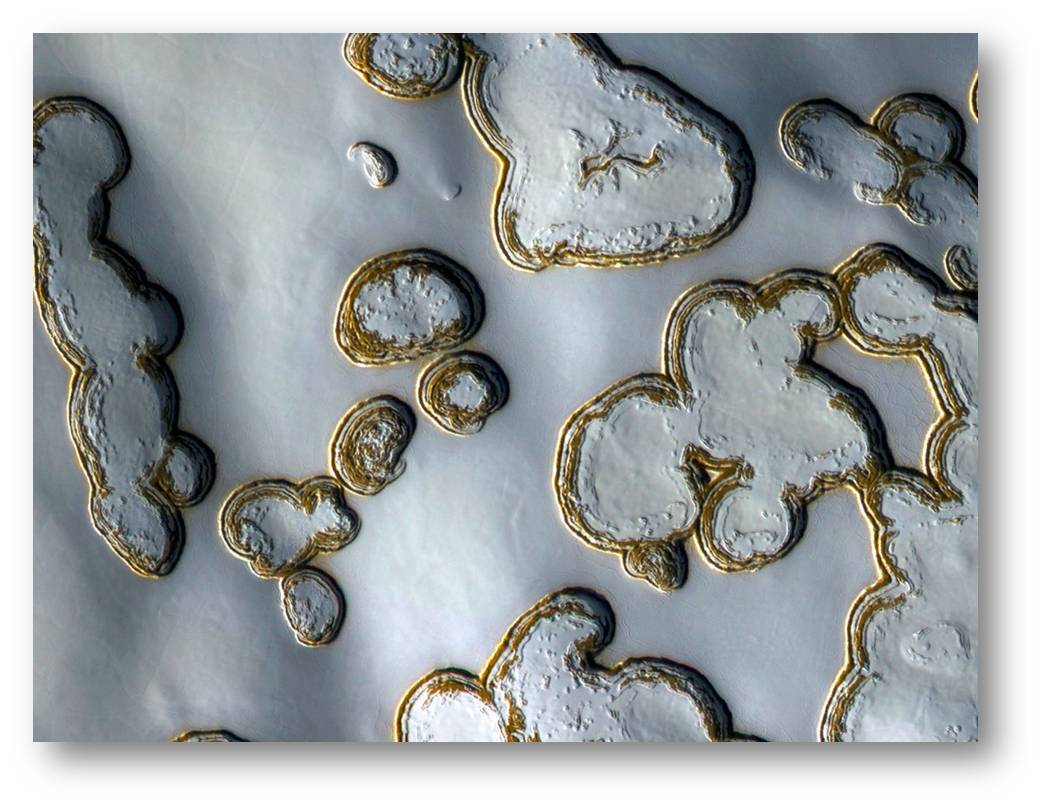

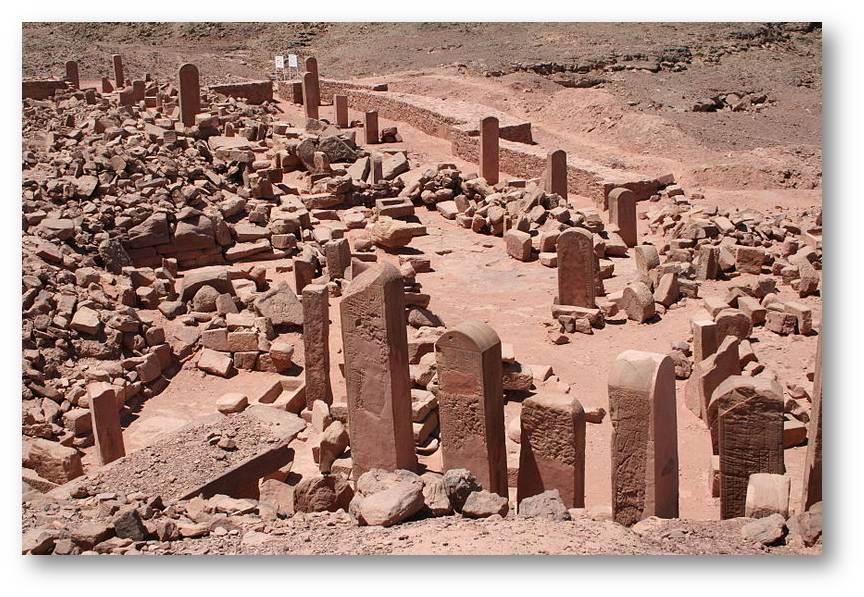

Abbildung 3. Touristen blicken auf den Hoover-Damm hinunter. Die Menge an Sedimenten, die sich hinter den Tausenden von großen Staudämmen der Welt ablagert, würde ganz Kalifornien bis zu einer Tiefe von fünf Metern bedecken. Robert Nickelsberg / Getty Images |

Das ist ein recht geologischer Einwand - aber er ist falsch. Seit Mitte des 20. Jahrhunderts hat der Mensch die Landschaft in ungeheurer Weise umgestaltet und Gestein und Sediment bewegt (inzwischen um mehr als eine Größenordnung mehr, als natürliche Sedimentverschieber wie Gletscher und Flüsse). Die Menge an Sedimenten, die sich hinter den Tausenden von großen Staudämmen auf der Welt abgesetzt hat, würde ganz Kalifornien bis zu einer Tiefe von fünf Metern bedecken (Abbildung 3), und diese Sedimente sind voll von charakteristischen Merkmalen wie Pestizidrückständen, Metallen, Mikroplastik und Fossilien von invasiven Arten. Um einen Zeitraum formal zu definieren, müssen Geologen charakteristische Marker in Sedimenten oder Gesteinen identifizieren, die sich weltweit zuordnen lassen - das Vorhandensein solcher Marker ist überall vorhanden. Abbildung 4. Die Geologie ist real.

|

Abbildung 4. Plastikmüll sammelt sich nach einem Regenschauer in der Nähe von Culver City, Kalifornien. Mikroplastik, das aus solchen Ablagerungen entsteht, findet sich oft im Sediment. Citizen of the Planet / UIG via Getty Images |

5. Die geologische Erfassung ist zu komplex und abgestuft, um eine einzige Grenze für das Anthropozän zu ziehen.

Die gesamte Geschichte (der Erde und des Menschen) ist komplex, verläuft stufenweise und variiert über Zeit und Raum. Dennoch legen Geologen Epochen fest, weil solche Zeiteinheiten für ihre Arbeit nützlich, ja unverzichtbar sind. In der Geologie wird jede Zeiteinheit durch einen "Goldenen Nagel"(Golden Spike) genau definiert - eine bestimmte Schichte in einer Sedimentabfolge an einem bestimmten Ort, der ausgewählt wird, weil er mit anderen Sedimentabfolgen rund um den Globus korreliert werden kann. Dieser Goldene Nagel identifiziert eine globale Zeitebene, aber der planetarische Übergang, der die Platzierung eines Goldenen Nagel motiviert, kann alles andere als einfach sein.

Die letzte Eiszeit des Pleistozäns wich im Laufe von etwa 13 000 Jahren holozänen interglazialen Bedingungen - und verlief auf der Nord- und Südhalbkugel unterschiedlich. Dennoch wird die definierte Holozän-Grenze innerhalb dieses Übergangs, die vor 11.700 Jahren lag, ohne Beanstandung akzeptiert und verwendet. Der Übergang vom Holozän zum Anthropozän ist viel schärfer und global synchroner und daher leichter zu definieren und zu erkennen.

6. Andere Tiere haben die Umwelt beeinflusst und geologische Veränderungen verursacht, das Anthropozän ist also nichts Besonderes.

Andere Tiere haben tatsächlich die Umwelt verändert, aber das kann bei der Erkennung von geologischen Zeitabschnitten eher hilfreich als hinderlich sein. So dient beispielsweise das Aufkommen agiler, muskulöser Tiere, die sich durch Sedimente wühlen konnten, als Grundlage für die Definition des Kambriumzeitalters. Aber keine dieser früheren Veränderungen hat sich so schnell über alle Lebensräume auf dem Planeten ausgebreitet - oder wurde von einem Tier ausgelöst, das sich der Veränderungen bewusst war, die es vornahm. Dieses Bewusstsein muss - wie wir anmerken - wirksam in Maßnahmen umgesetzt werden, um die schlimmsten Folgen dieser Veränderungen abzuwenden. Zu viele streben immer noch nach wirtschaftlicher und industrieller Entwicklung, ohne die langfristigen Kosten für die Gesundheit des Planeten zu bedenken.

7. Das Anthropozän gibt allen Menschen gleichermaßen die Schuld für die globalen Umweltkrisen.

Das Anthropozän weist weder Schuld noch Verdienst zu; es erkennt einfach eine große, abrupte und mehr oder weniger dauerhafte Veränderung im Verlauf der Erdgeschichte an. Es besteht kein Zweifel daran, dass einige Menschen, Gesellschaften, Institutionen und Nationalstaaten den Wandel viel stärker vorangetrieben haben als andere und dass die Vorteile und Kosten des Wandels ungleich verteilt waren und sind. Die gesellschaftliche Bedeutung des Anthropozäns besteht darin, dass es den eindeutigen wissenschaftlichen Nachweis erbringt, dass der Mensch die globale Umwelt dauerhaft verändert hat. Und es kann uns ermutigen zur Kenntnis zu nehmen, dass wir uns alle mit den raschen, dauerhaften, globalen Veränderungen, die im Gange sind, auseinandersetzen müssen.

8. Das Anthropozän bedeutet eine Niederlage für unsere Bemühungen, die Umweltveränderungen einzudämmen.

Der erste Schritt zur Lösung von Problemen besteht darin, sie zu diagnostizieren. Wir können die Erde nicht in den Zustand zurückversetzen, in dem unsere Großeltern oder eine andere Generation des Holozäns gelebt haben. Aber wir können klügere Entscheidungen für die Zukunft treffen, die den Wandel mildern und abschwächen. Das ist Realismus, nicht Defätismus.

9. Das Anthropozän nach dem Menschen zu benennen ist anmaßend.

Die planetarische Transformation, die das Anthropozän einläutete, wurde von Menschen verursacht. Man hätte es auch anders nennen können, aber Anthropozän hat die Phantasie vieler Menschen geweckt, weil seine Bedeutung offensichtlich und zutreffend ist.

10. Das Anthropozän ist nur ein Werbegag.

Wenn das nur wahr wäre. Zu akzeptieren, dass wir nicht mehr in einer Holozän-Welt leben, ist ein erster Schritt, um die Probleme anzugehen, denen sich Menschen und Nichtmenschen in der unmittelbaren Zukunft gegenübersehen.

Fazit

Diese Mythen haben sich in der wissenschaftlichen Gemeinschaft hartnäckig gehalten, obwohl sie in wissenschaftlichen Arbeiten der Anthropozän-Arbeitsgruppe und anderer systematisch widerlegt wurden. Dies deutet darauf hin, dass es sich wie bei allen Mythen um Reaktionen handelt, die eher auf Ideologie, Überzeugung oder persönlicher Philosophie als auf Beweisen beruhen. Diese falschen Vorstellungen liegen auch der jüngsten offiziellen Ablehnung des Anthropozäns durch die Hierarchie der internationalen Stratigraphie zugrunde.

Warum wurde das Anthropozän auf so viele Arten missverstanden und mythologisiert? Wahrscheinlich, weil es für viele zutiefst unangenehm ist. Es ist sehr kurz (bis jetzt). Es umfasst stinkende Mülldeponien als Schichten, die eine geologische Zeitskala durcheinander bringen, die für viele Geologen sakrosankt ist. Und es wirft das Schreckgespenst auf, dass die ruhigen Vorstellungen der geologischen Zeit auf die schwierigen Probleme stoßen, mit denen wir in Gegenwart und Zukunft konfrontiert sind.

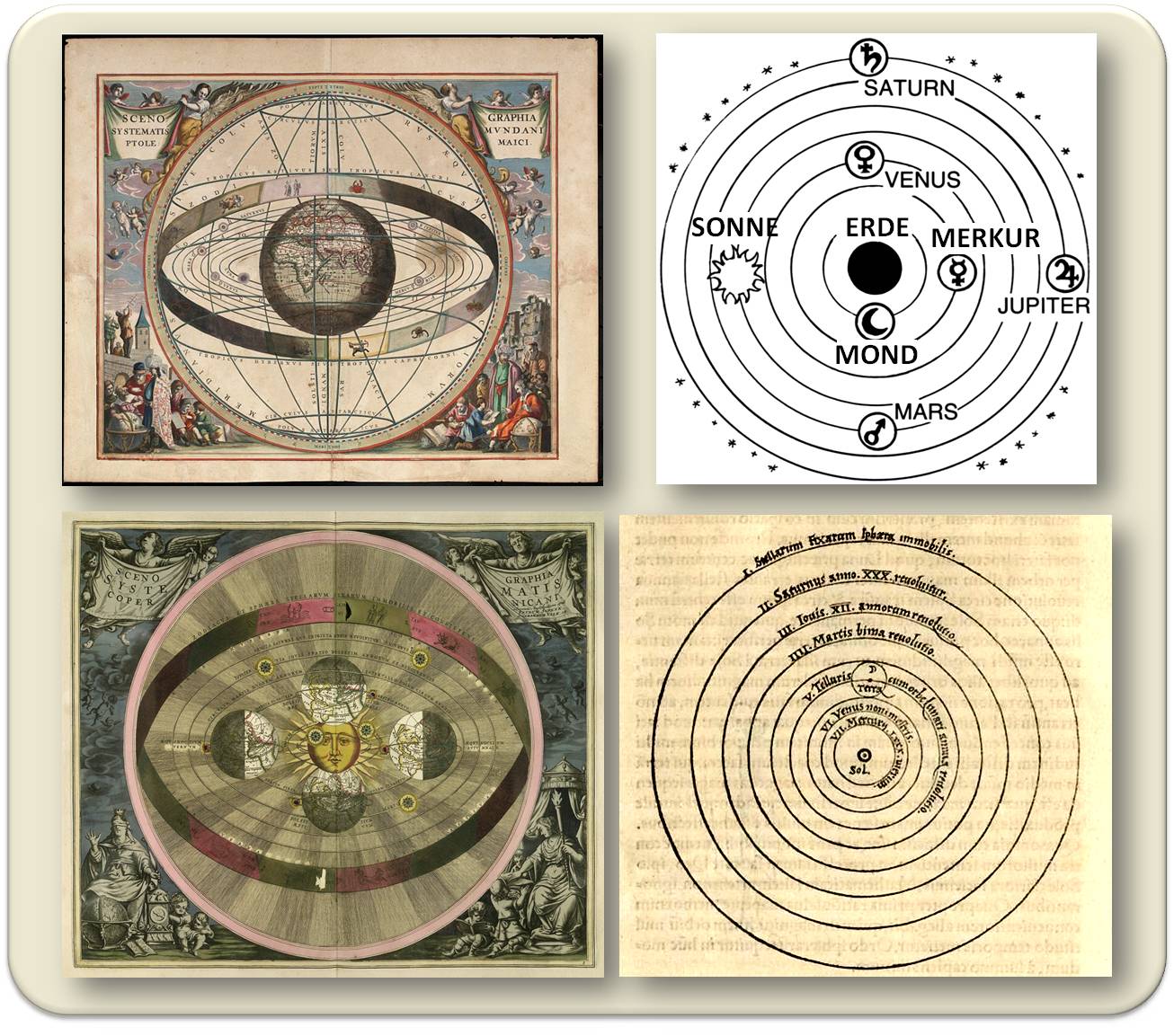

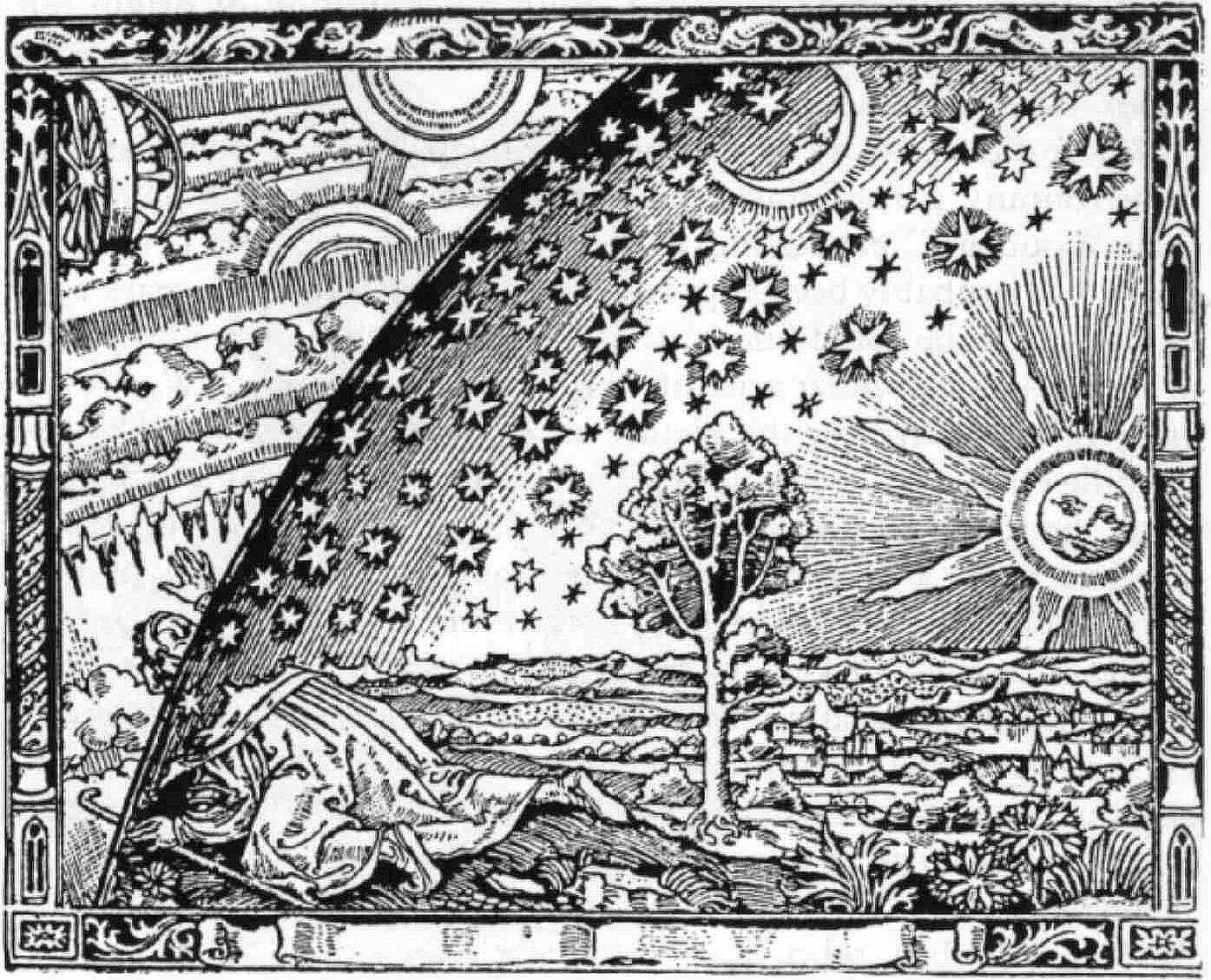

Veränderungen sind schwierig, und das Anthropozän ist ein unangenehmes Konzept. Es ist schwer zu akzeptieren, dass wir als Gesellschaft so viel Macht erlangt haben, um die Erde zu verändern, und dabei so wenig darüber nachgedacht haben, wie wir diese Macht nutzen. Wissenschaftliche Erkenntnisse können unsere Sichtweise verändern (man denke nur an den Heliozentrismus und die Evolution) - es ist also nicht überraschend, dass das Anthropozän schwer zu akzeptieren ist. Aber unsere Rolle zu erkennen, wie wir die Erde plötzlich in eine neue Zukunft führen, ist ein notwendiger erster Schritt, um sich mit den planetarischen Veränderungen auseinanderzusetzen, die wir in Gang gesetzt haben.

*Der Artikel "What Myths About the Anthropocene Get Wrong" ist erstmals am 18. April 2024 im Smithsonian Magazine erschienen https://www.smithsonianmag.com/smithsonian-institution/what-myths-about-the-anthropocene-get-wrong-180984181/. Autoren sind der langjährige Leiter der Anthropozän Arbeitsgruppe emer.Prof. Jan A. Zalasiewicz (University Leicester), Scott L. Wing (Kurator an der Smithsonian Institution) und alle weiteren 32, aus 14 Ländern stammenden Mitglieder der Arbeitsgruppe. Der Artikel wird ungekürzt, von der Redaktion möglichst wortgetreu ins Deutsche übersetzt (und mit einigen Untertiteln) wiedergegeben.

Smithsonian Institution (Smithsonian, https://www.si.edu/) ist eine bedeutende US-amerikanische Forschungs- und Bildungseinrichtung, die auch zahlreiche Museen, Galerien und den Nationalzoo betreibt. Das Smithsonian stellt seine komplette Sammlung nach und nach in elektronischer Form (2D und teilweise 3D) unter der freien cc-0-Lizenz kostenlos zur Weiterverbreitung zur Verfügung. Das Smithsonian Magazine (aus dem der obige Artikel stammt) bringt eine Fülle faszinierender, leicht verständlicher Artikelaus allen Bereichen der Natur und der Gesellschaften. https://www.smithsonianmag.com/?utm_source=siedu&utm_medium=referral&utm_campaign=home.

Das Anthropozän im ScienceBlog:

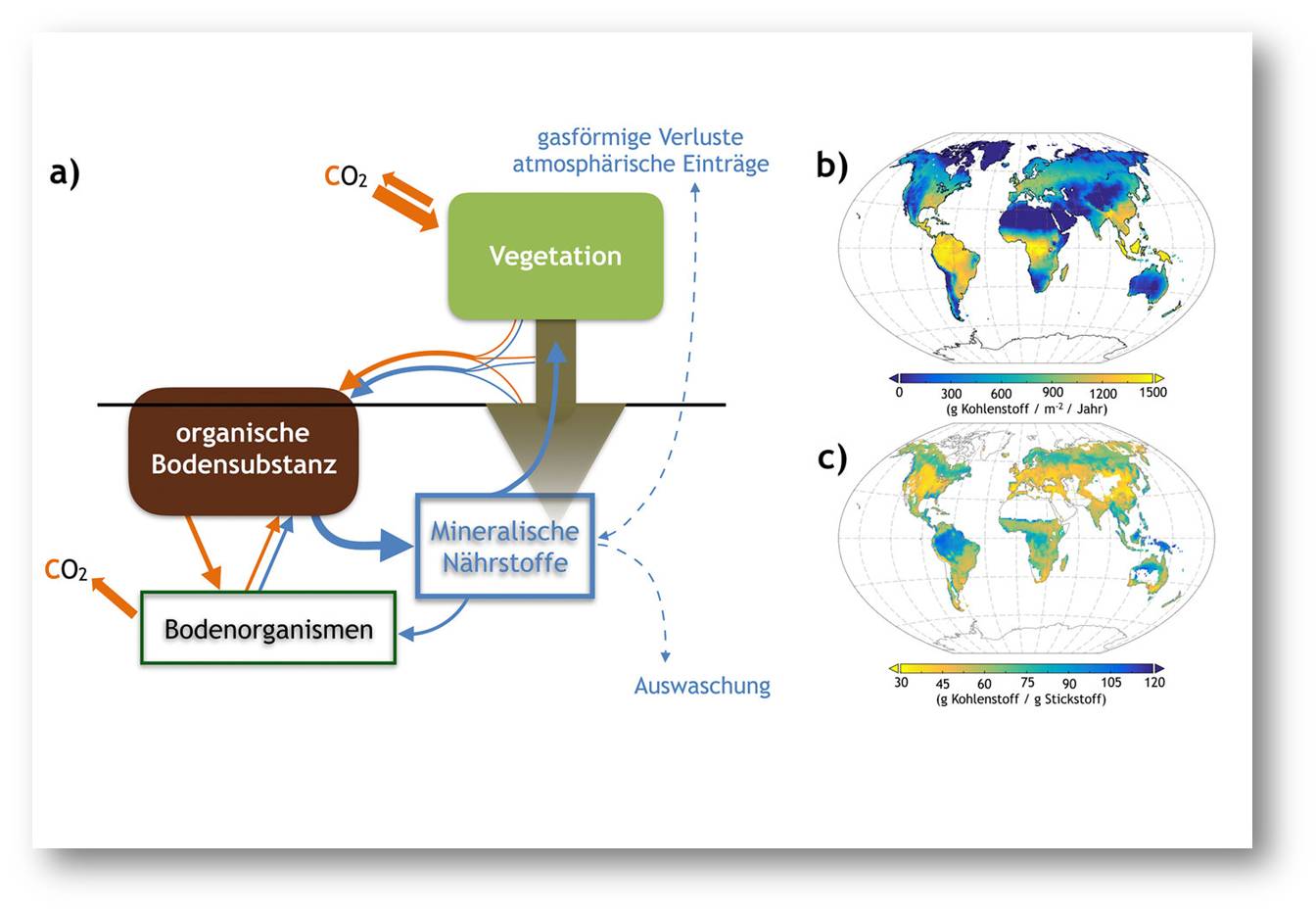

05.08.2021, Gerd Gleixner: Erdoberfläche - die bedrohte Haut auf der wir leben

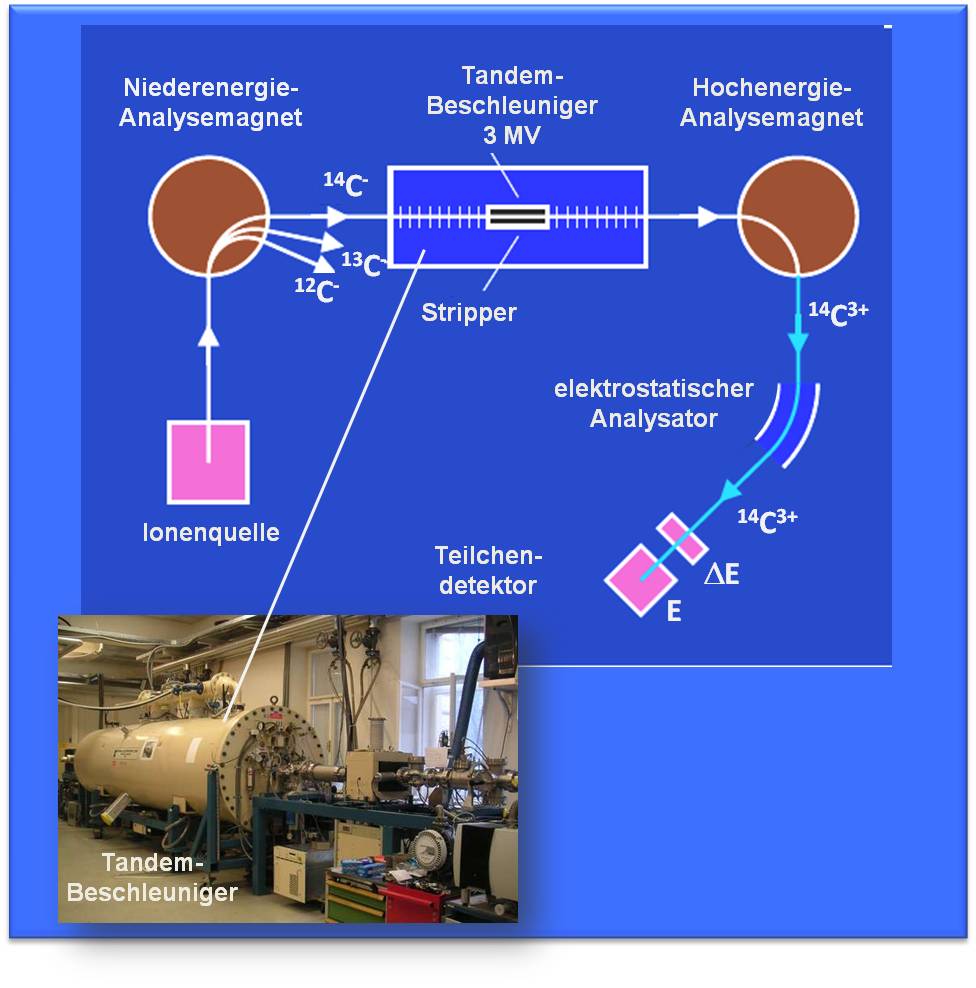

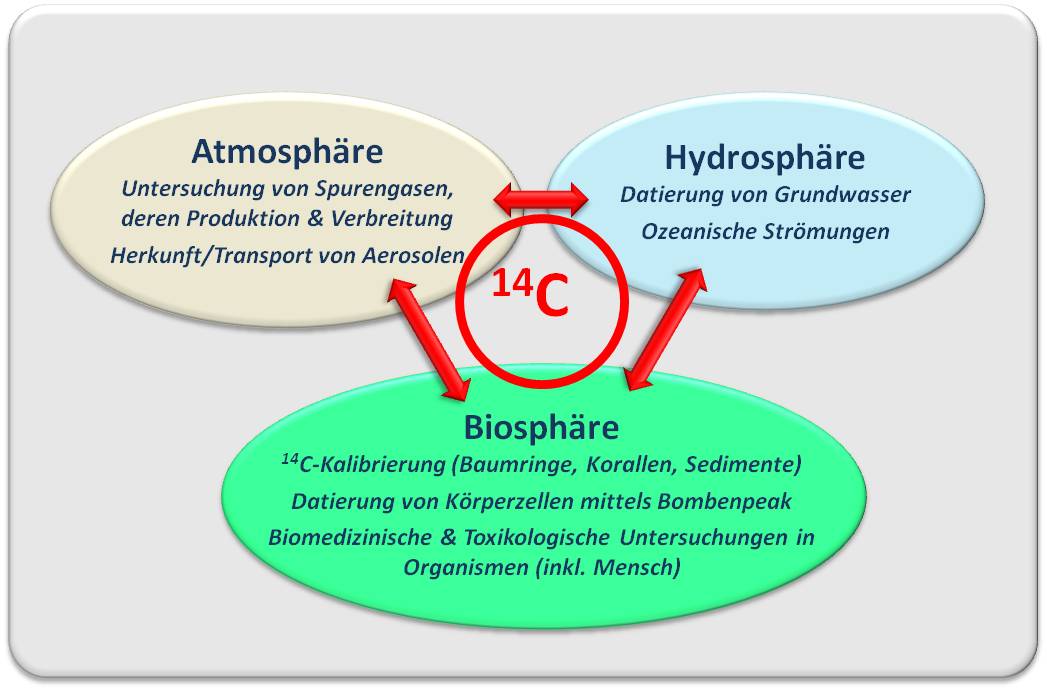

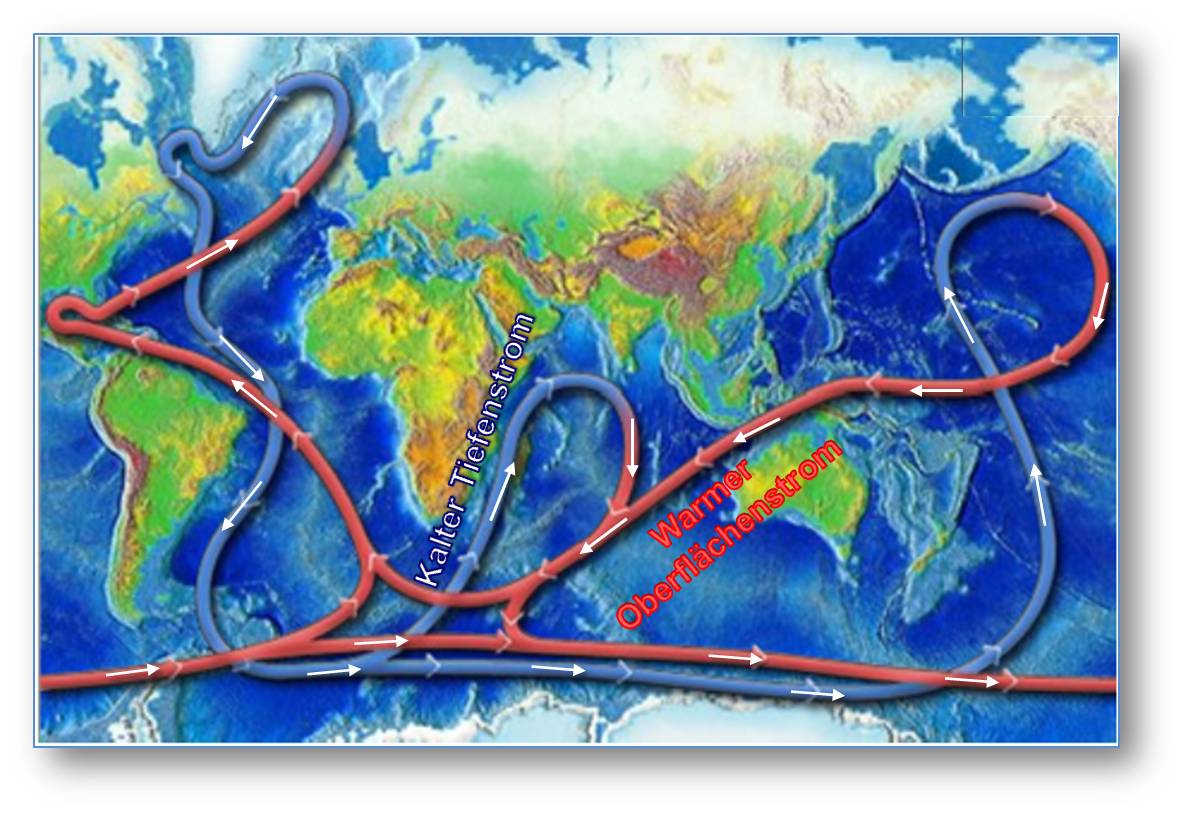

22.01.2016, Walter Kutschera: Radiokohlenstoff als Indikator für Umweltveränderungen im Anthropozän.

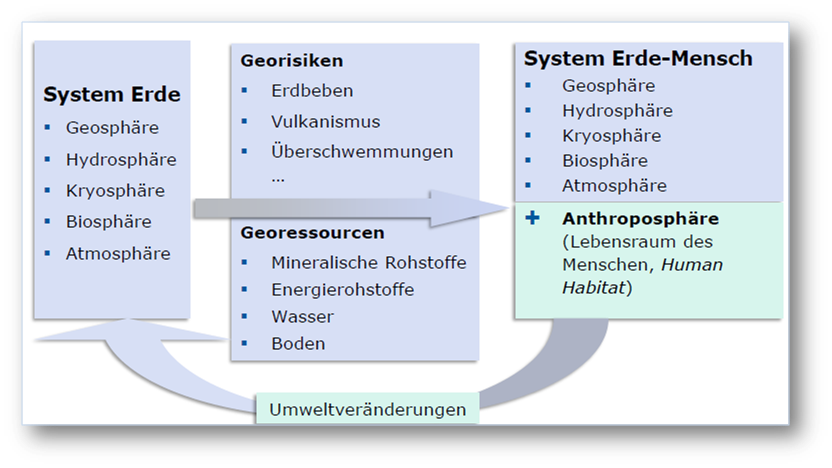

01.08.2014, Reinhard Hüttl: Vom System Erde zum System Erde-Mensch

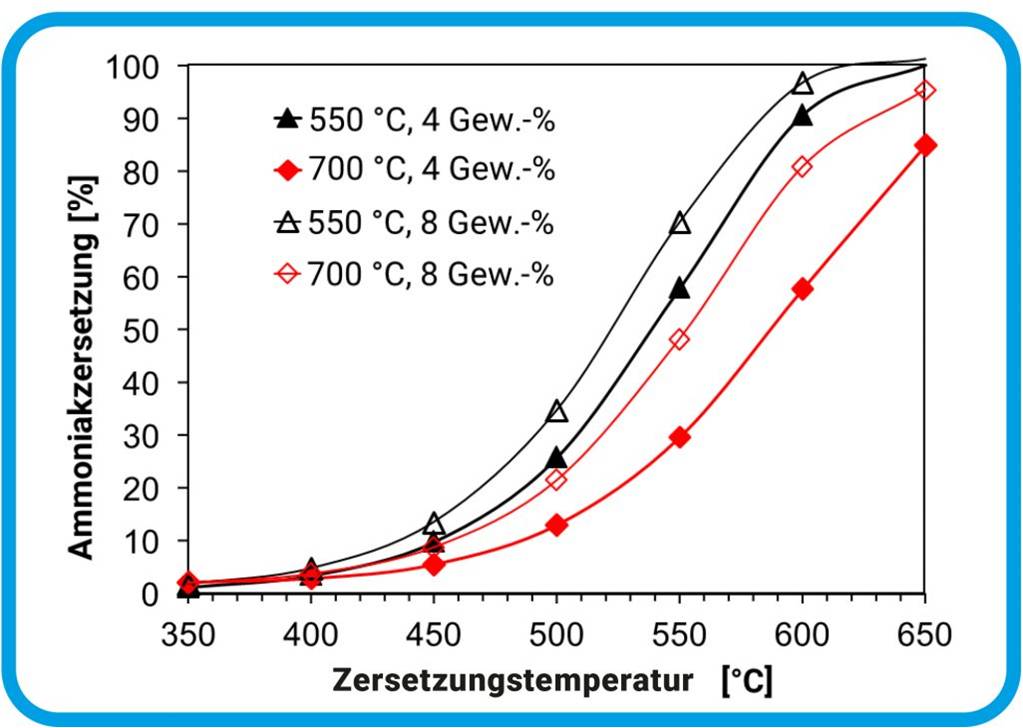

In den Bergen von Europas Metallabfällen lagern Reichtümer

In den Bergen von Europas Metallabfällen lagern ReichtümerDo,18.04.2024 — Redaktion

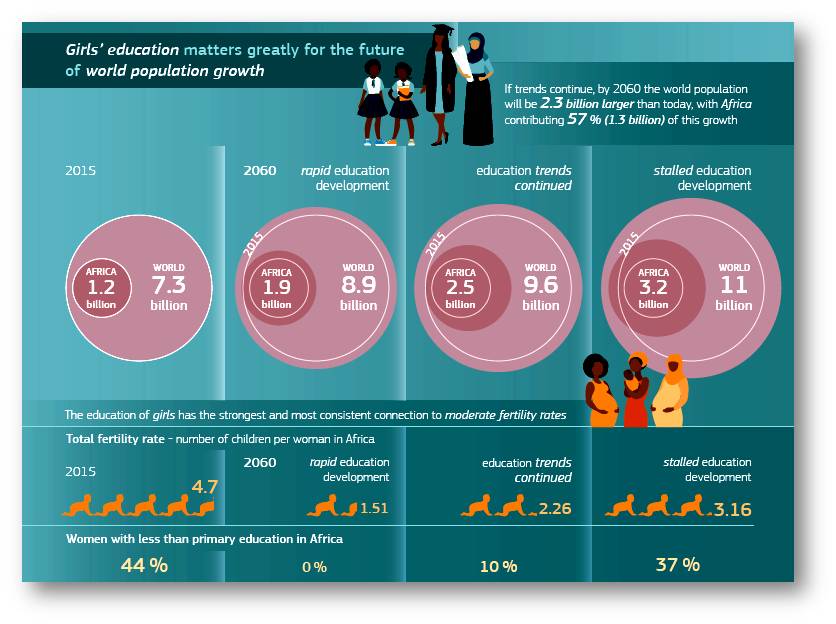

![]()

Metalle sind für neue Technologien unverzichtbar, doch ihre Gewinnung hinterlässt Berge von Abfällen, die eine potenziell gefährliche Umweltbelastung darstellen aber auch Rohmaterial für das Recycling dieser Metalle und die Schaffung wertvoller Industriematerialien bieten. 2 EU-finanzierte Projekte haben sich mit diesem Problemkreis befasst mit dem Ziel eine weitestgehende Wiederverwendung/Verwertung der Abfallberge zu erreichen und nahezu kostendeckend vorzugehen: In "MoveAL" wurden Technologien zur Aufwertung von Bauxitrückständen – dem Nebenprodukt der Aluminiumherstellung - vorgestellt. In "NEMO" ging es um die Gewinnung von Metallen aus sulfidischen Bergbauabfällen mittels modernster Technologien der Biolaugung.*

In der westirischen Stadt Limerick wird auf dem Gelände einer Aluminiumhütte eine 500 Meter lange gepflasterte Straße gebaut, basierend auf einem Experiment, das Europa helfen könnte, Industrieabfälle zu reduzieren. Die Betonstraße auf dem Gelände der Aughinish-Hütte hat einen Unterbau aus Materialien, die Bauxitrückstände enthalten, die auch als Rotschlamm bekannt sind.

Schlammige Materialien

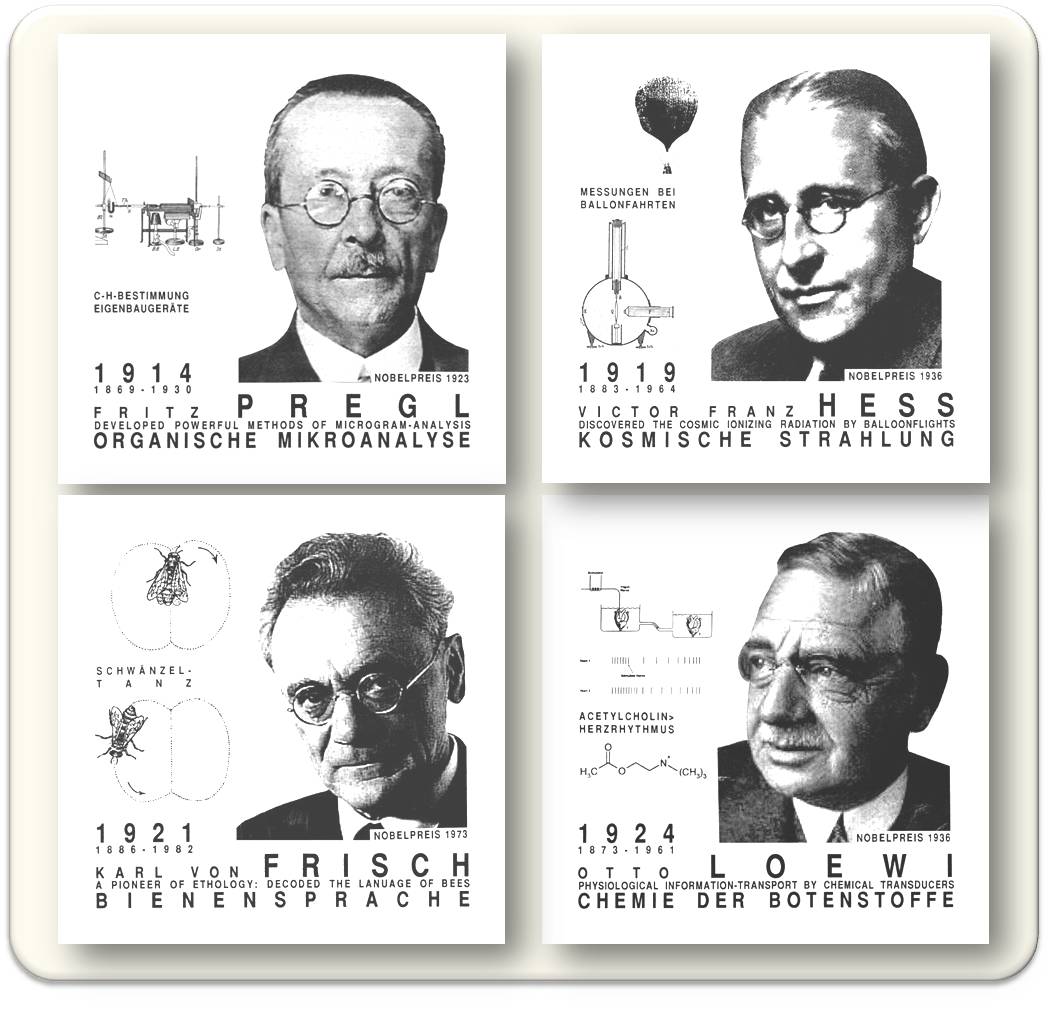

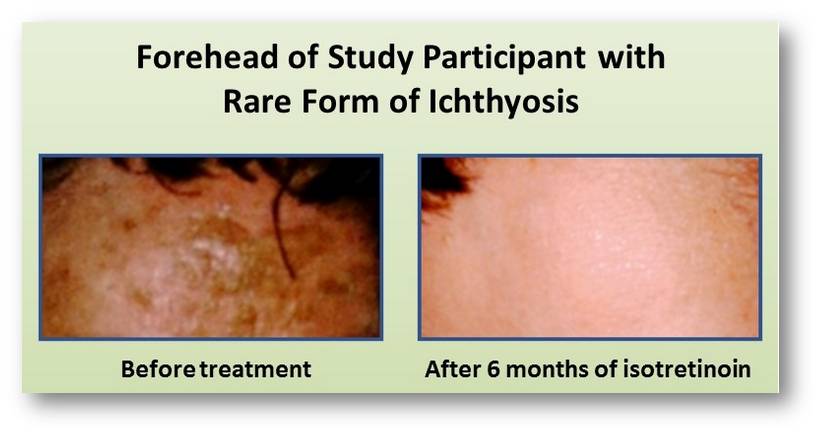

Rotschlamm ist das, was bei der Produktion von Aluminium übrig bleibt - dem Metall, das in allem und jedem - von Küchenfolie und Bierdosen bis hin zu Elektroautos und Flugzeugrümpfen - Anwendung findet. Aluminium wird aus Bauxit gewonnen, einem aluminiumhaltigen Gestein, das aus einem rötlichen Lehmboden entsteht. Während Aluminium im modernen Leben unzählige kommerzielle Verwendungsmöglichkeiten findet, ist dies bei Bauxitrückständen nicht der Fall. Der Schlamm landet in der Regel auf Mülldeponien, nimmt immer mehr Platz ein und stellt eine verpasste Recyclingmöglichkeit dar. Abbildung 1.

|

Abbildung 1. Rotschlamm, der bei der Aluminiumproduktion anfällt. EU-Forscher suchen nach industriellen Verwendungsmöglichkeiten. © Igor Grochev, Shutterstock.com |

Eine Gruppe von Forschern erhielt EU-Mittel, um diese Herausforderungen zu bewältigen, und kam auf die Idee, Bauxitrückstände für die Straße in der Aluminium-Hütte Aughinish zu verwenden. Ihr Projekt mit der Bezeichnung RemovAL (https://cordis.europa.eu/project/id/776469) hatte eine Laufzeit von fünf Jahren und lief bis April 2023.

"Deponierung ist eine Praxis, von der wir uns verabschieden wollen", sagte Dr. Efthymios Balomenos, der das Projekt koordinierte. "Selbst wenn die Umwelt nicht geschädigt wird, verbraucht man immer noch viel Platz und wirft die Hälfte des Materials weg."

Einfache Zahlen verdeutlichen die Problematik für Industrie und Gesellschaft:

Für jede Tonne Aluminium, die produziert wird, fallen etwa zwei Tonnen Bauxitrückstände an. Weltweit fallen jedes Jahr etwa 150 Millionen Tonnen Rotschlamm aus der Aluminiumproduktion an - das sind 20 Kilogramm pro Person weltweit. Davon werden nicht mehr als 3 % recycelt, der Rest kommt auf die Deponien. Weltweit lagern mehr als 4 Milliarden Tonnen Bauxitrückstände, und diese Zahl könnte sich bis 2050 auf 10 Milliarden Tonnen mehr als verdoppeln, so die Aluminium Stewardship Initiative (https://aluminium-stewardship.org/bauxite-residue-management-risks-opportunities-and-asis-role), eine standardsetzende Organisation, die auf "bahnbrechende Lösungen" für den Rotschlamm drängt.

Ideenlabors

Bauxit ist nach der französischen Stadt Les Baux benannt, in der das Erz 1821 entdeckt wurde.

In Europa fallen jährlich etwa 7 Millionen Tonnen Bauxitrückstände an. Der Rotschlamm wird zu künstlichen Hügeln aufgeschüttet, die der EU die Möglichkeit bieten, ihr Ziel einer Kreislaufwirtschaft mit mehr Recycling und weniger Abfall zu erreichen.

Am Projekt RemovAL waren eine Reihe akademischer und industrieller Teilnehmer beteiligt, darunter Aughinish Alumina, Rio Tinto in Frankreich und das griechische Bergbau- und Metallurgieunternehmen Mytilineos. Um Ideen für potenzielle kommerzielle Verwendungen von Bauxitrückständen zu testen, wurden Demonstrationsprojekte an Industriestandorten in Deutschland, Griechenland und Irland durchgeführt. Das primäre Ziel bestand darin, die Abfallmengen zu verringern und dies unter Vermeidung großer zusätzlicher Kosten.

"Unser Ziel war es, fast kostendeckend zu arbeiten und nahezu keine Abfälle zu erzeugen", so Balomenos, der als Berater bei Mytilineos tätig ist.

Straßen vorneweg

Das RemovAL-Team hat gezeigt, dass Bauxitrückstände als erste Fundamentschicht oder Unterbau für Straßen verwendet werden können. Der Unterbau einer Straße besteht in der Regel aus minderwertigem Schotter, liegt auf dem Boden auf und bildet einen stabilen Unterbau für die nächste, höherwertige Fundamentschicht.

Typischerweise bestehen Bauxitrückstände zu etwa zwei Fünfteln aus Eisenoxid, zu einem Fünftel aus Aluminiumoxid, zu 6 % aus Kieselsäure und zu 5 % aus Titan. Rotschlamm enthält sogar Seltene Erden - eine Gruppe von 17 Metallelementen mit besonderen Eigenschaften, die technologische Fortschritte in einer Reihe von Branchen ermöglichen.

"Das ist eine ganze Menge Material, selbst wenn man es nur als potenzielle Eisenquelle betrachtet", so Balomenos.

An den Standorten in Griechenland und Norwegen wurden im Rahmen des Projekts Bauxitrückstände in einem elektrischen Lichtbogenofen geschmolzen, um eine Eisenlegierung herzustellen, die sich für die Stahlherstellung eignet. RemovAL extrahierte auch die seltene Erde Scandium, die in der Luft- und Raumfahrtindustrie verwendet wird, um Festigkeit und Korrosionsbeständigkeit von Bauteilen sicherzustellen Anschließend wurde der verbleibende Rückstand zur Herstellung von Material verwendet, das der Zementmischung zugesetzt werden kann.

Die Vorführungen waren zwar ein technischer Erfolg, doch laut Balomenos gibt es noch immer Kostenhürden - vor allem, weil die Möglichkeiten zur Wiederverwendung von Bauxitrückständen weniger rentabel sind als die Verwendung von lokal beschafften "neuen" Rohstoffen.

"Letzten Endes ist die Deponierung die einzige finanziell tragfähige Option für die Industrie", sagt er.

Um den Aluminiumsektor umweltfreundlicher zu gestalten, müsse Europa Anreize wie Subventionen oder Vorschriften bieten, um die Verwendung von Bauxitrückständen und anderen metallurgischen Nebenprodukten gegenüber neu abgebauten Rohstoffen zu fördern, so Balomenos.

Weitere Metalle

Das Problem der Metallabfälle geht in Europa weit über das von Aluminium hinaus.

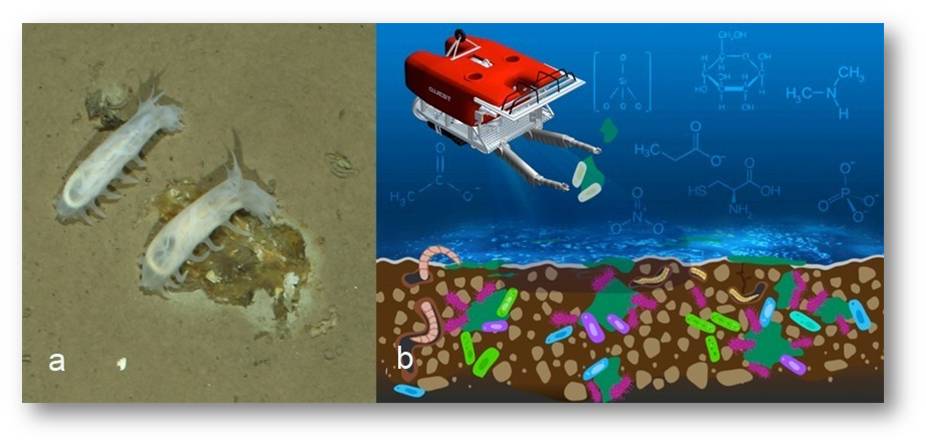

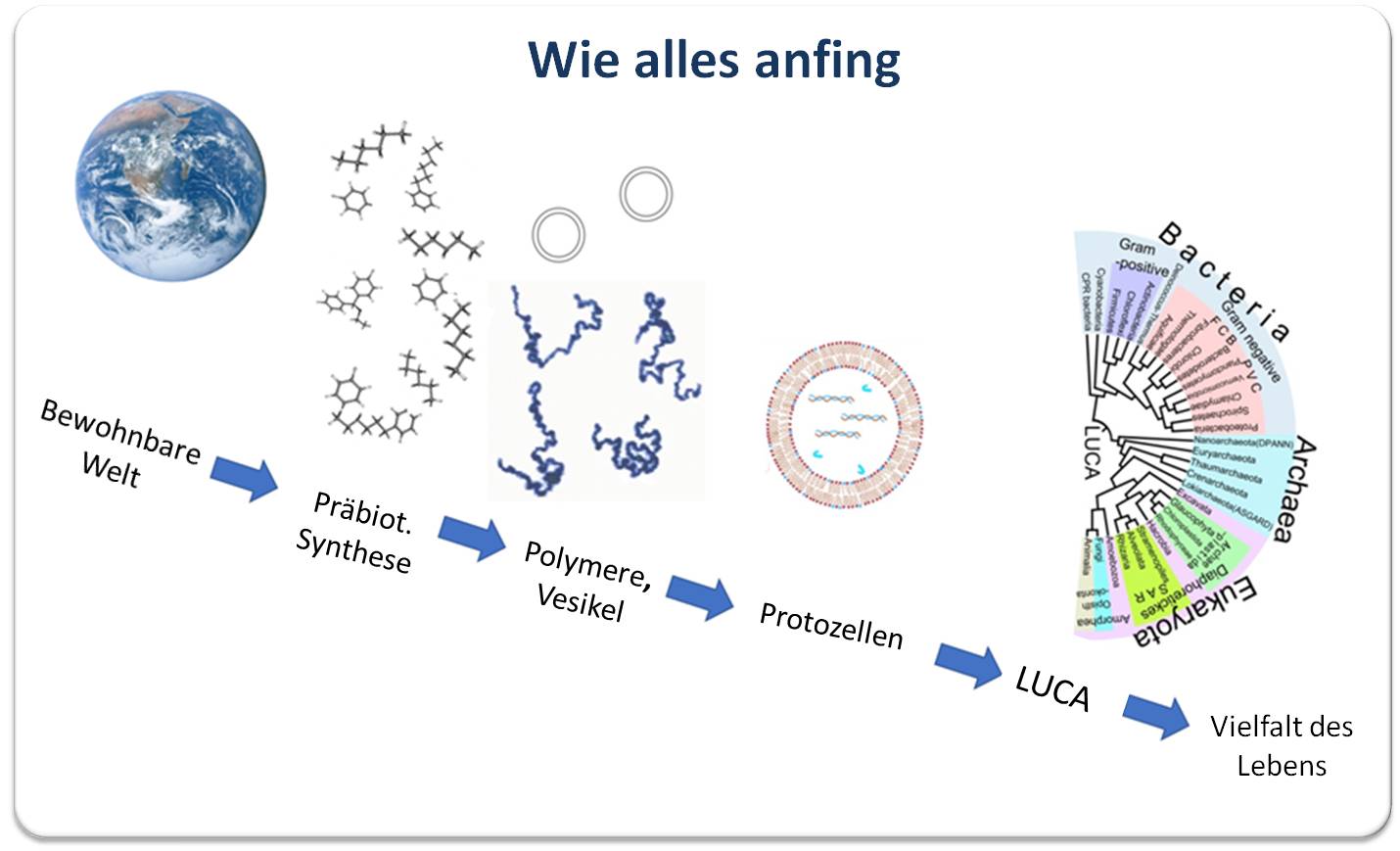

Andere von der EU unterstützte Forscher, zusammengeschlossen in einem Projekt namens NEMO (https://cordis.europa.eu/project/id/776846), haben versucht kommerzielle Verwendungsmöglichkeiten für Abfallhalden zu finden, die beim Abbau von Kupfer, Zink, Blei und Nickel anfallen.

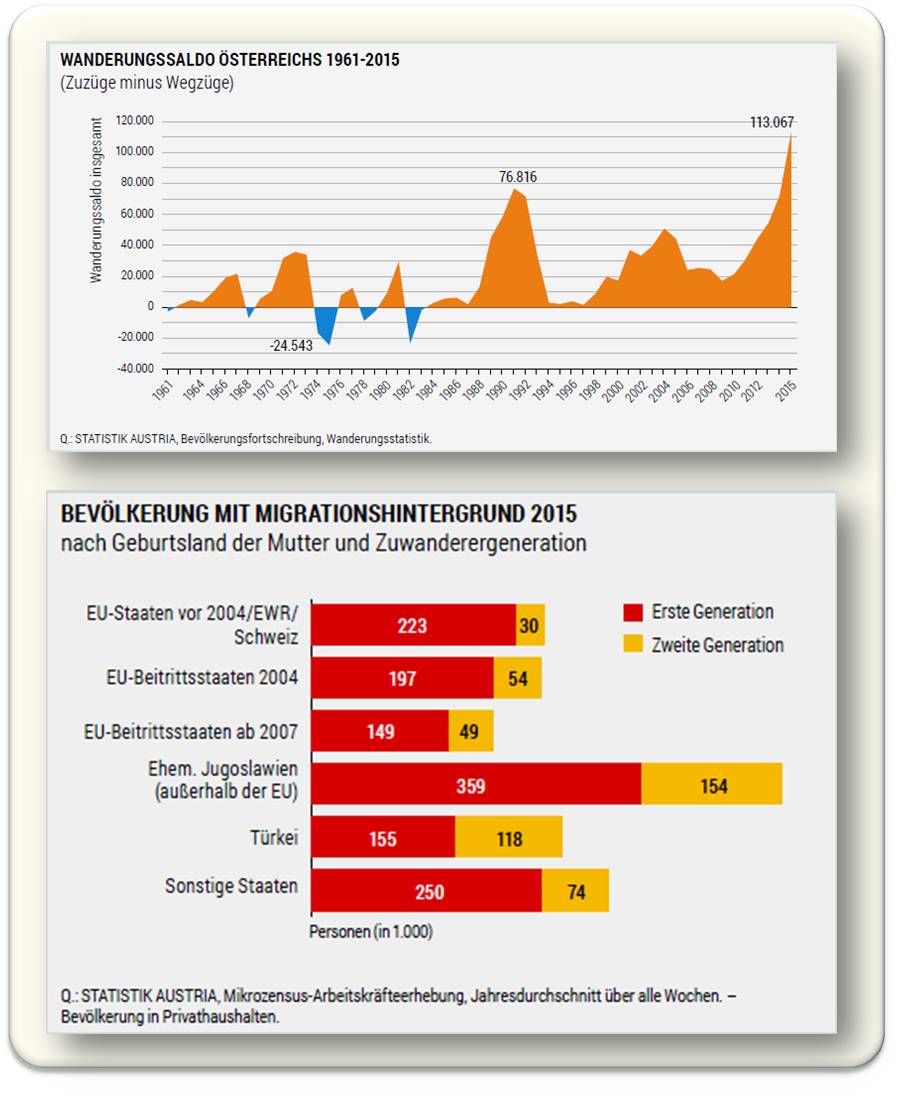

In Europa gibt es schätzungsweise 28 Milliarden Tonnen Erzrückstände, so genannte Tailings, aus der früheren Produktion dieser Metalle, und jedes Jahr fallen weitere 600 Millionen Tonnen an.

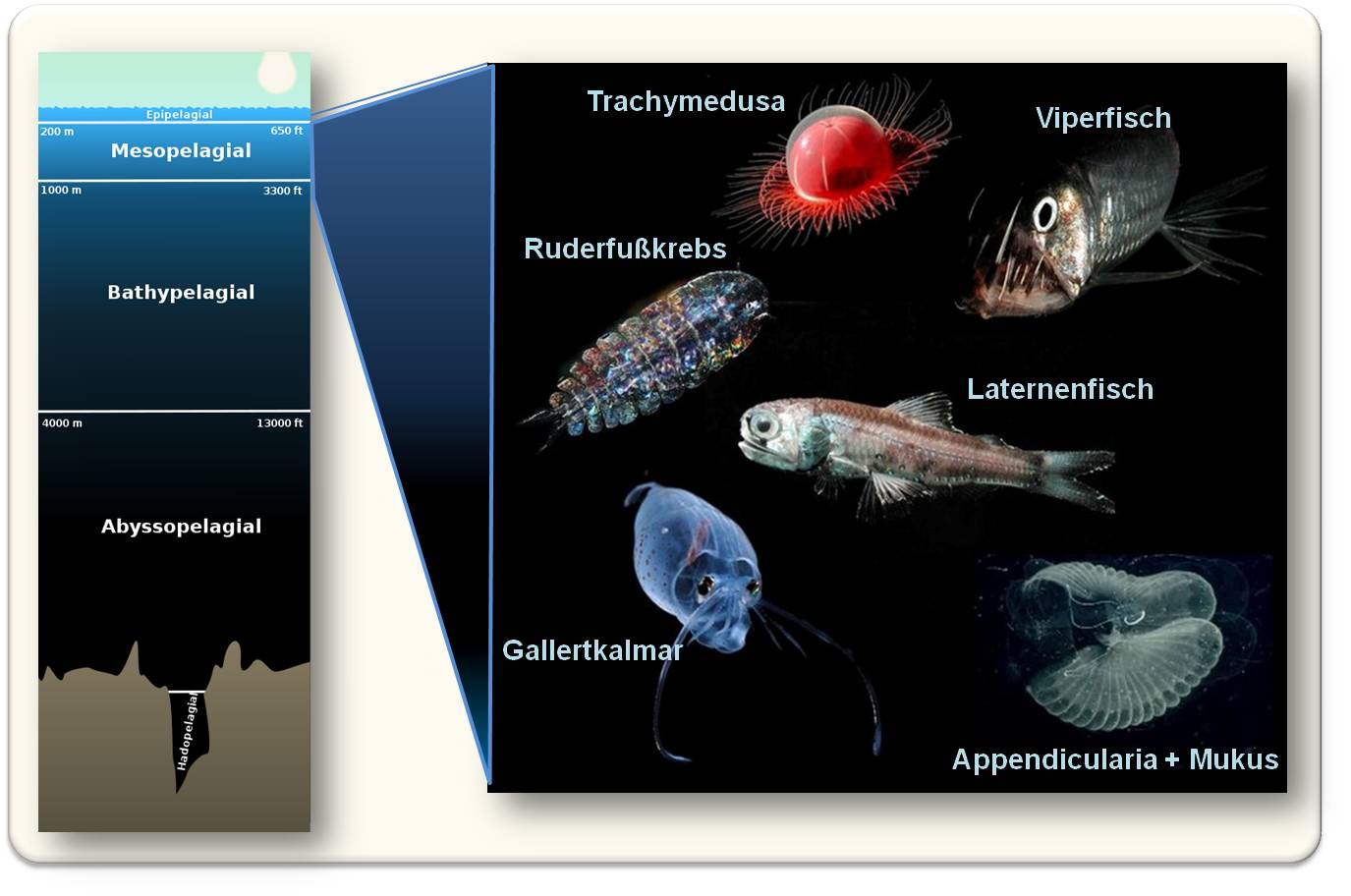

Kupfer, Zink, Blei und Nickel sind für die Energiewende in Europa unerlässlich. Ohne sie wären Windturbinen, Elektrofahrzeuge und viele andere saubere Technologien nicht möglich. Doch die Abraumhalden haben einen eigenen ökologischen Fußabdruck. Diese Abfälle werden häufig in Absetzteichen gelagert, enthalten Schwefel und erzeugen bei Regen Schwefelsäure.

"Diese Schwefelsäure kann potenziell gefährliche Elemente in die Umwelt, den Boden und das Wasser auswaschen", so Dr. Peter Tom Jones, Direktor des KU Leuven Institute for Sustainable Metals and Minerals in Belgien. "Die saure Drainage von Minen ist eines der größten Probleme der Bergbauindustrie beim Umgang mit sulfidischen Erzen".

Vielversprechende Technik

Jones war Teilnehmer von NEMO, das im November 2022 nach viereinhalb Jahren endete.

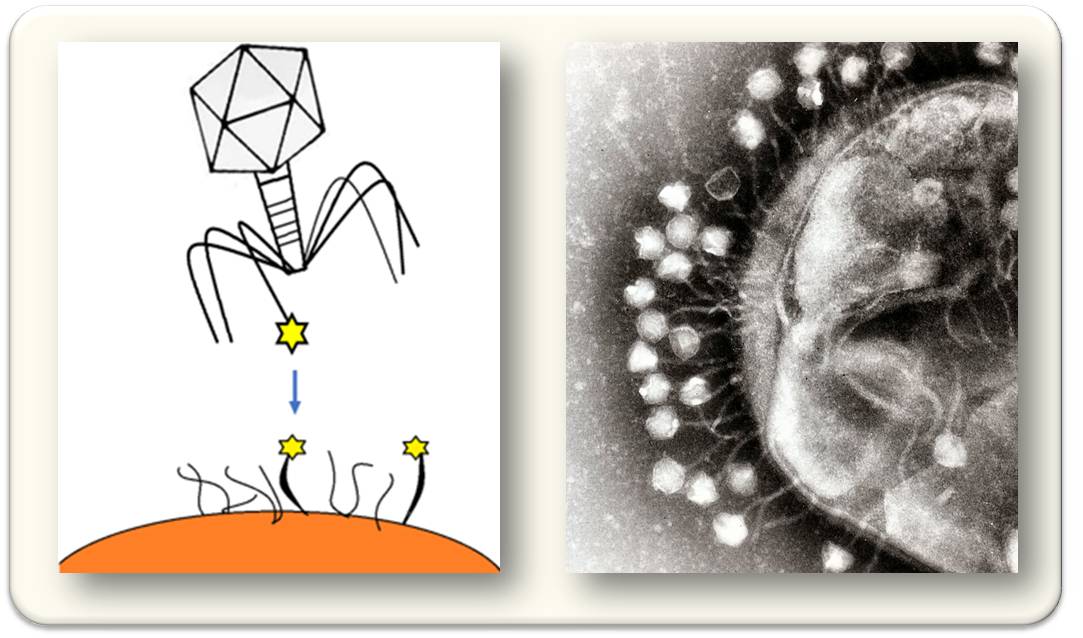

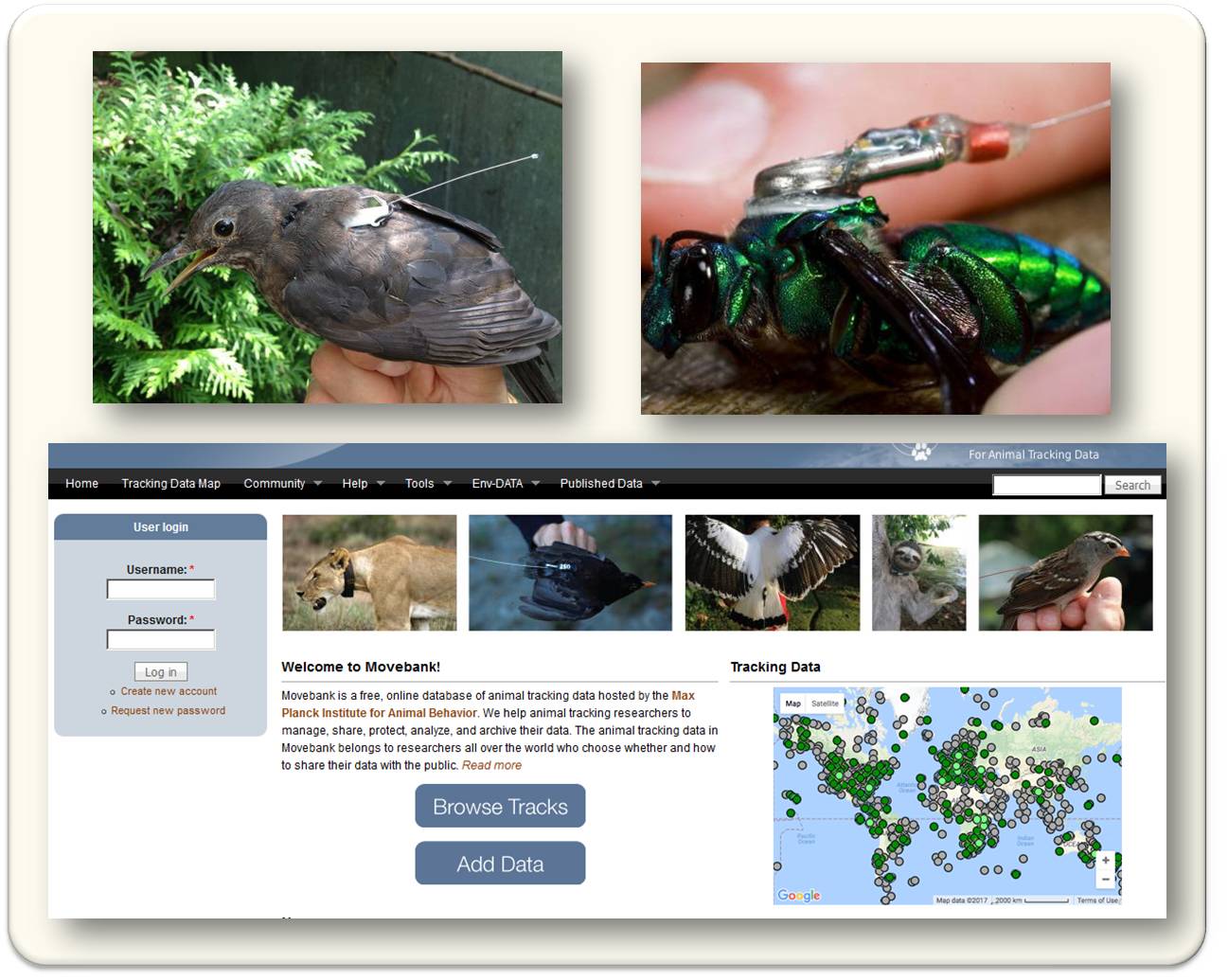

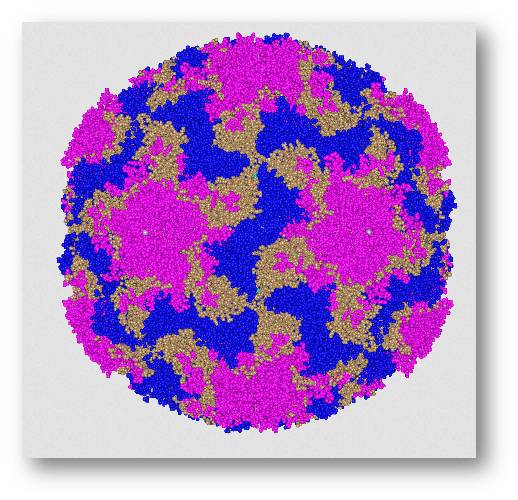

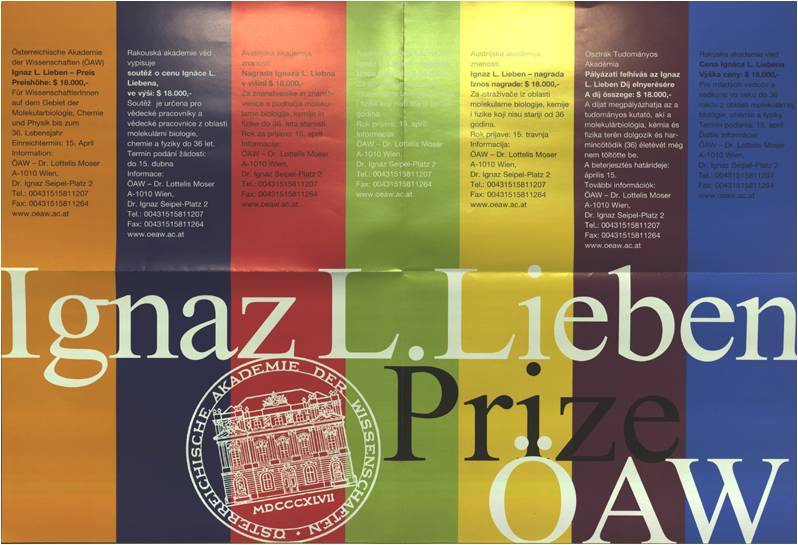

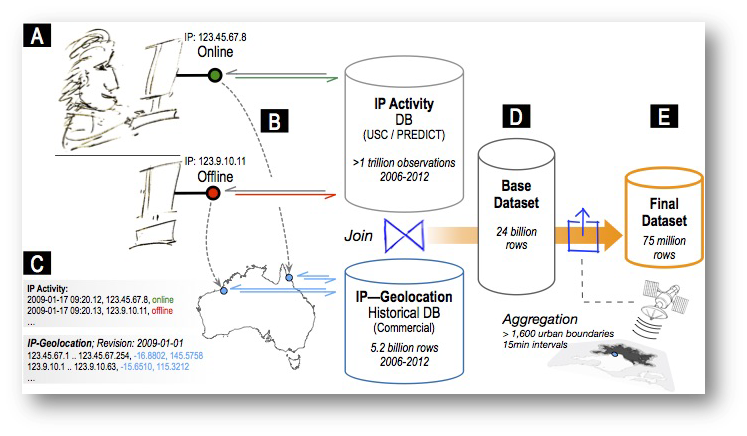

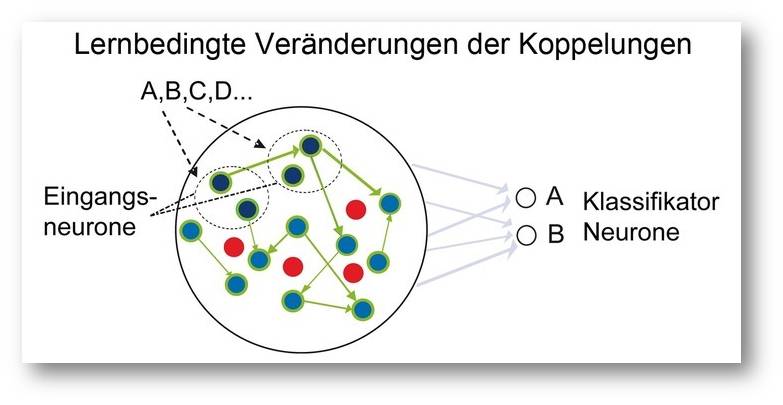

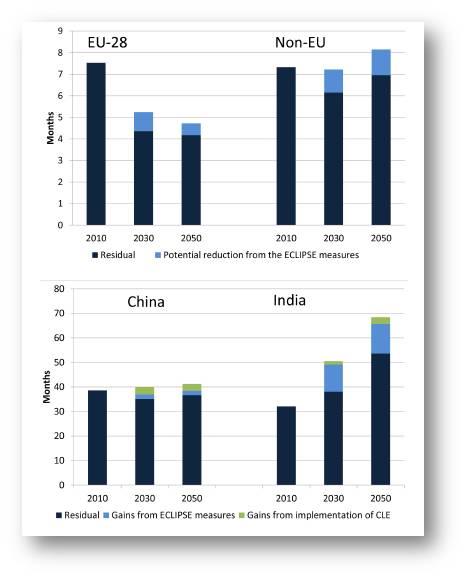

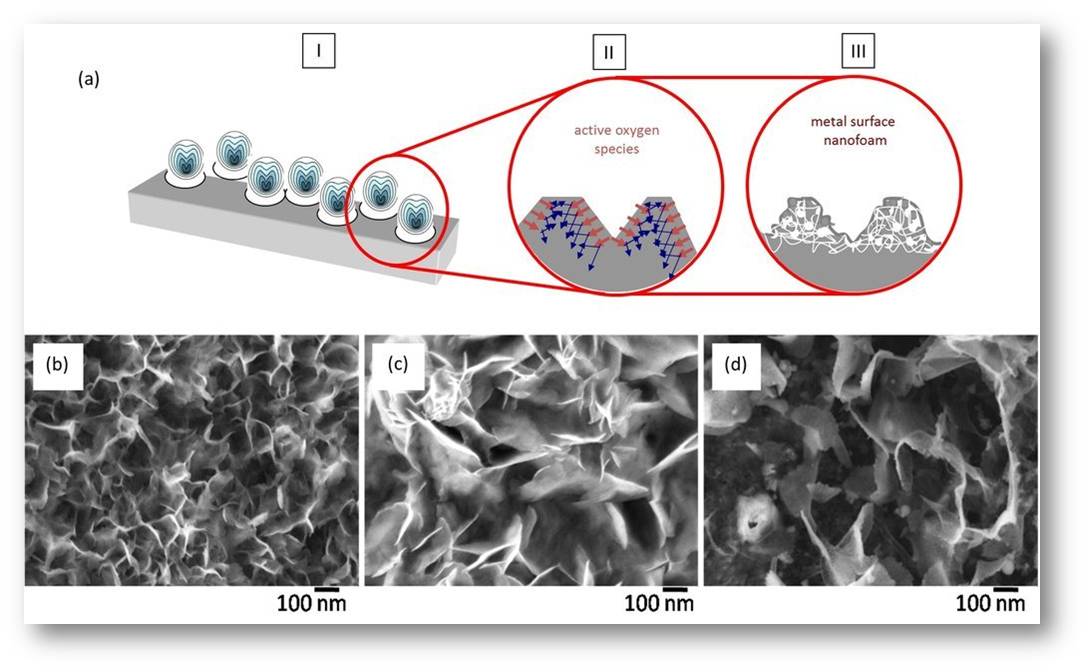

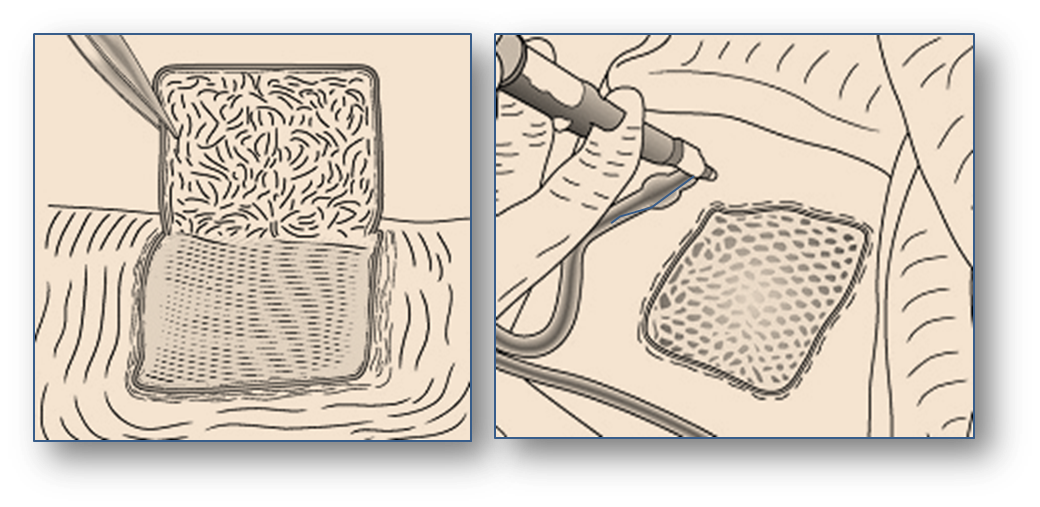

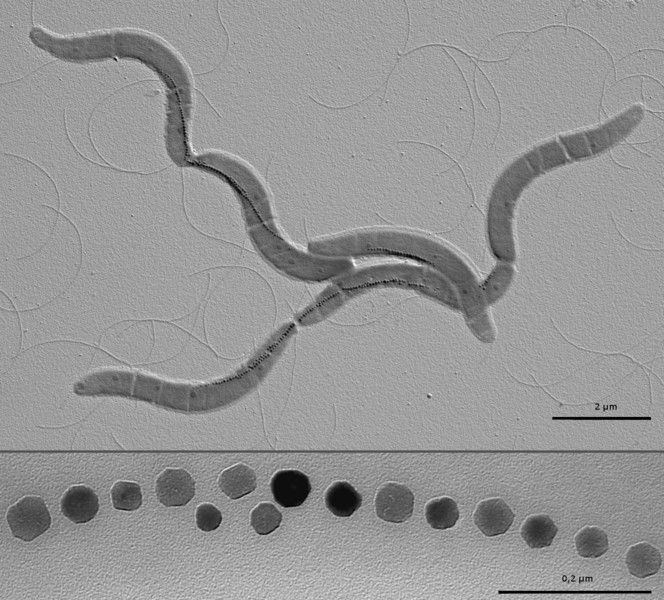

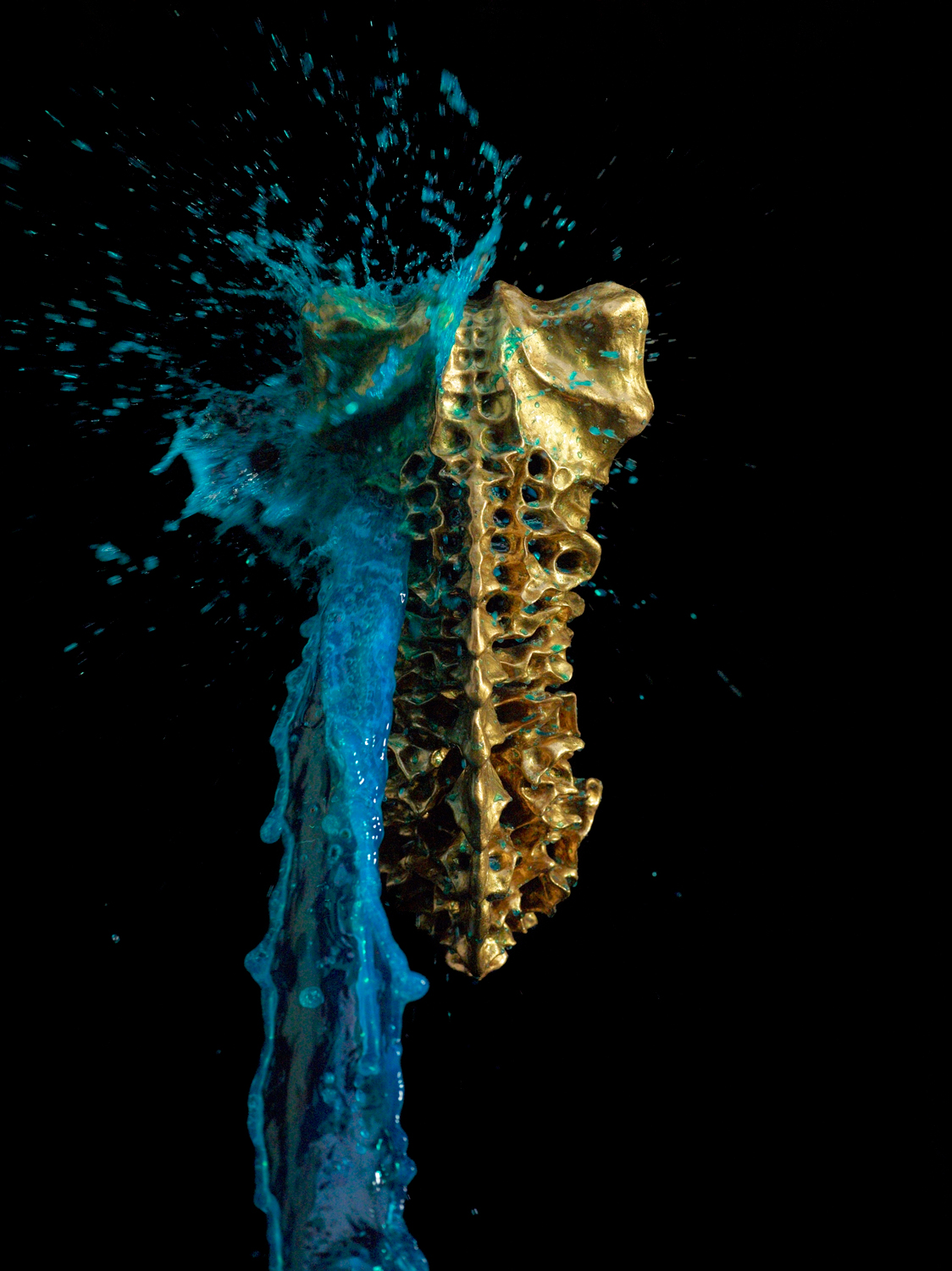

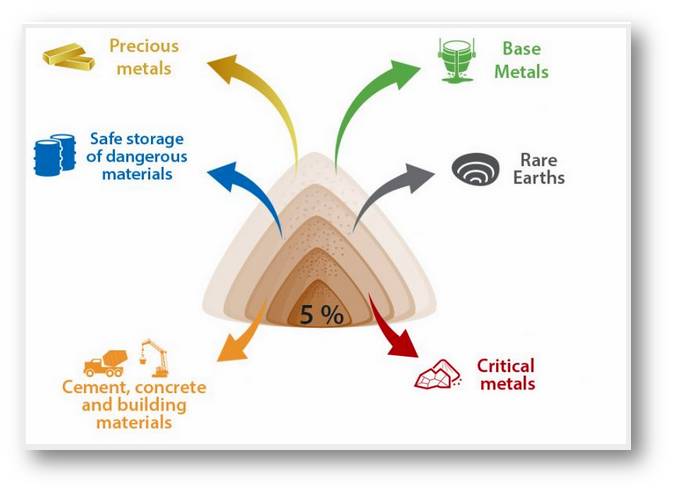

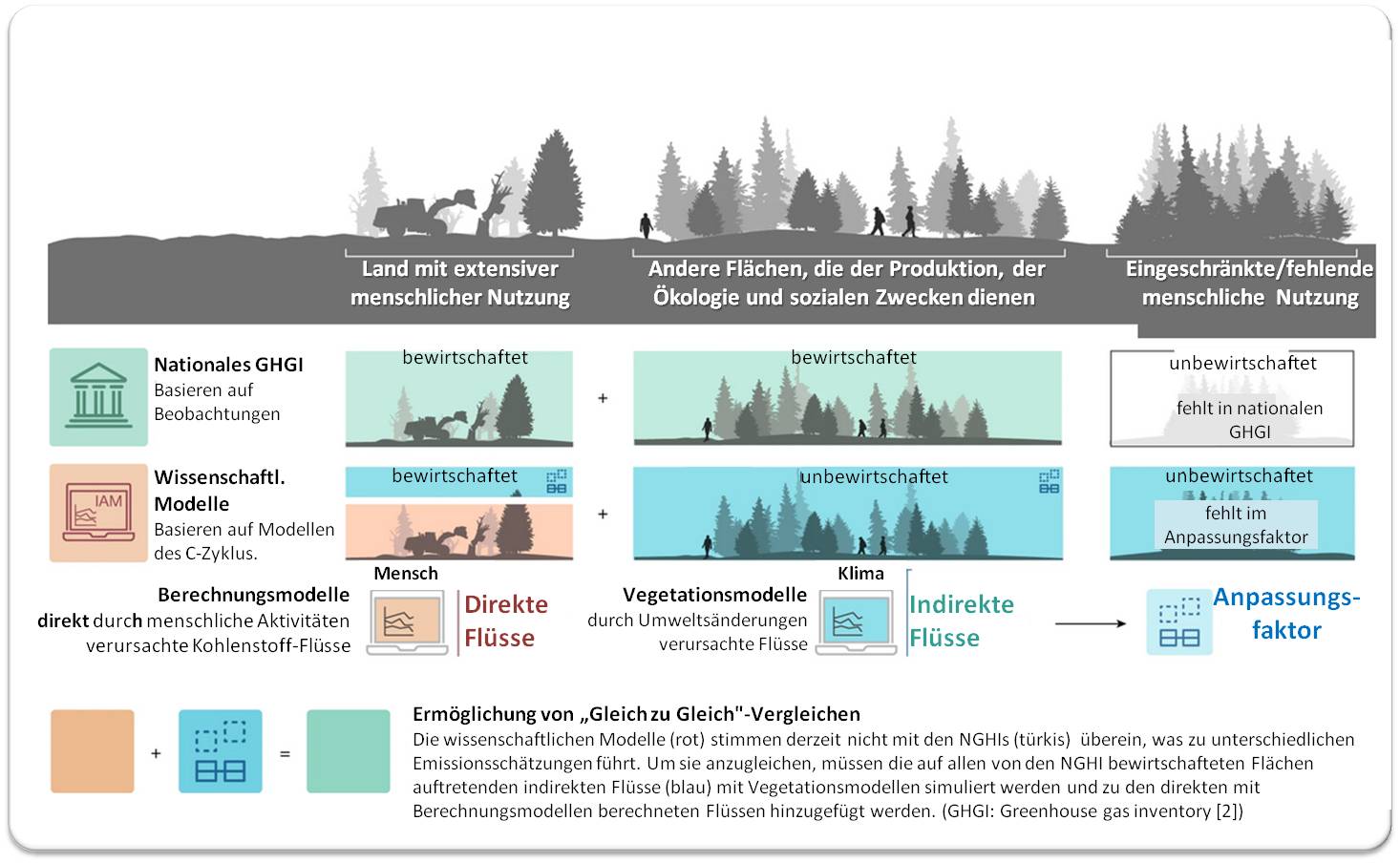

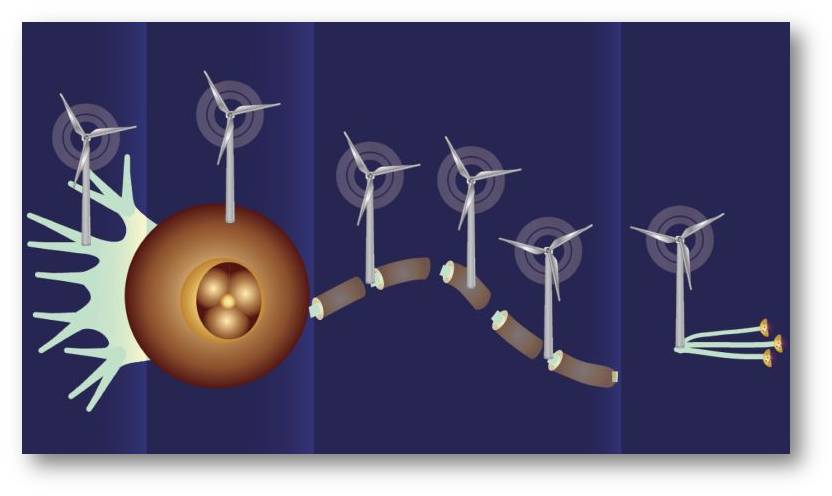

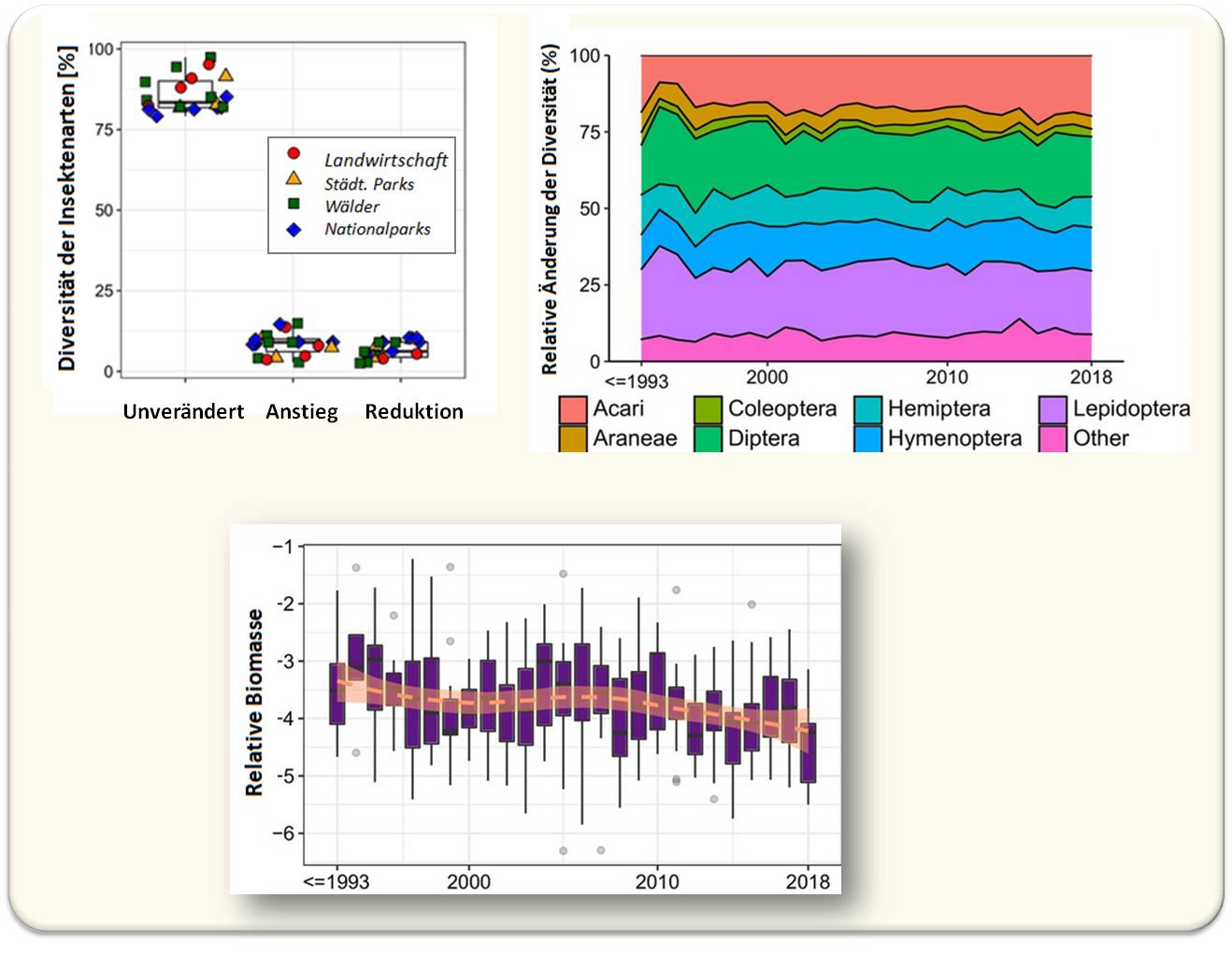

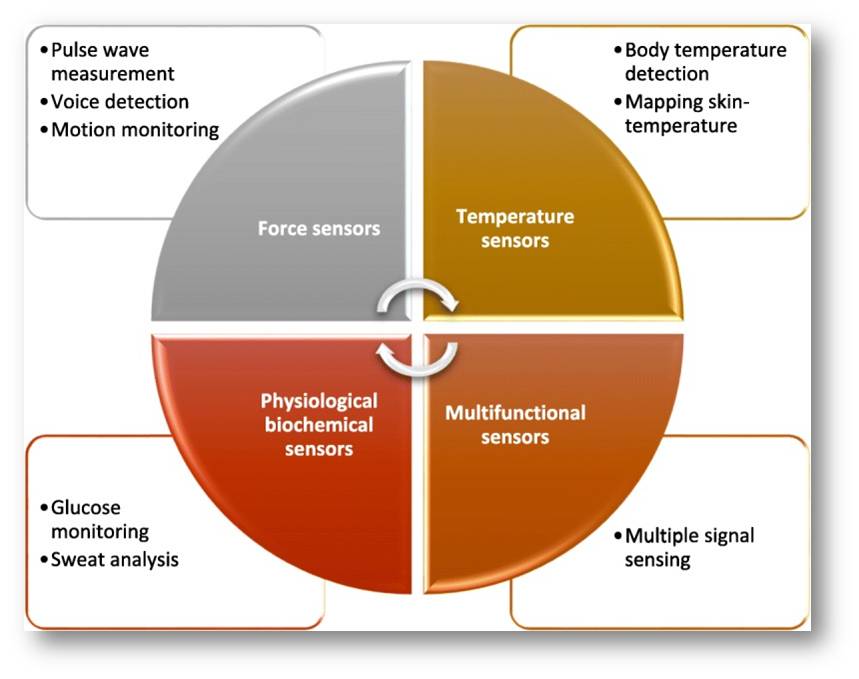

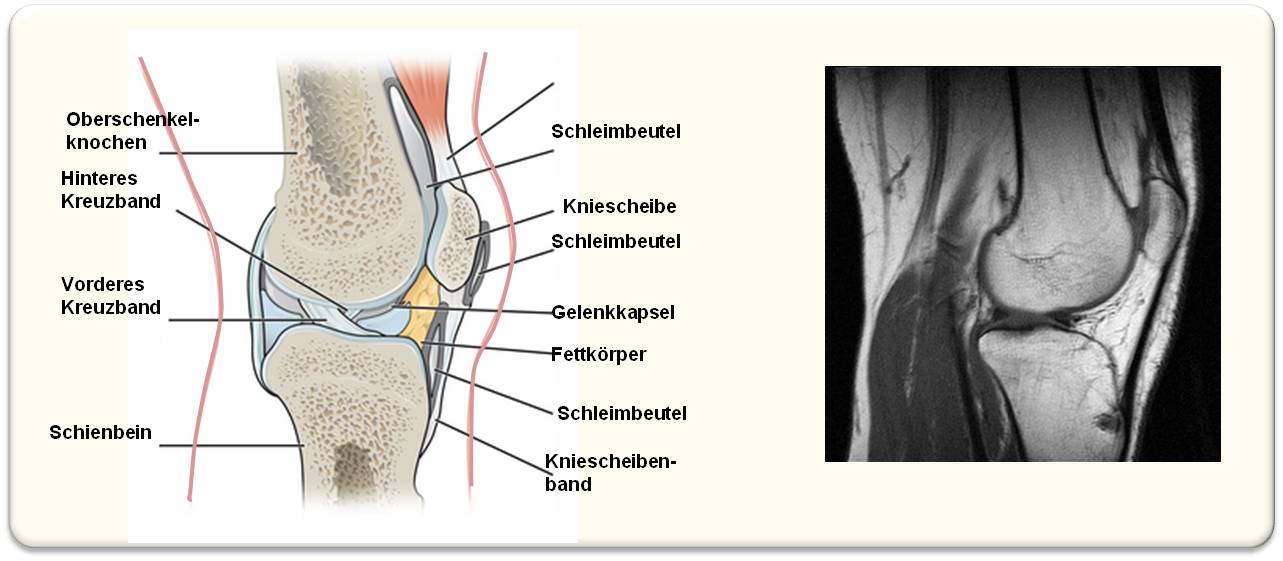

Die Forscher haben Standorte in Finnland und Irland genutzt, um die Durchführbarkeit einer als Biolaugung bekannten Technik zu testen, mit der wertvolle Metalle aus Bergwerksabfällen entfernt und die verbleibenden Abfälle in ein Material umgewandelt werden können, das nicht nur sicherer ist, sondern auch als Zusatzstoff bei der Zementherstellung dienen könnte. Abbildung 2.

|

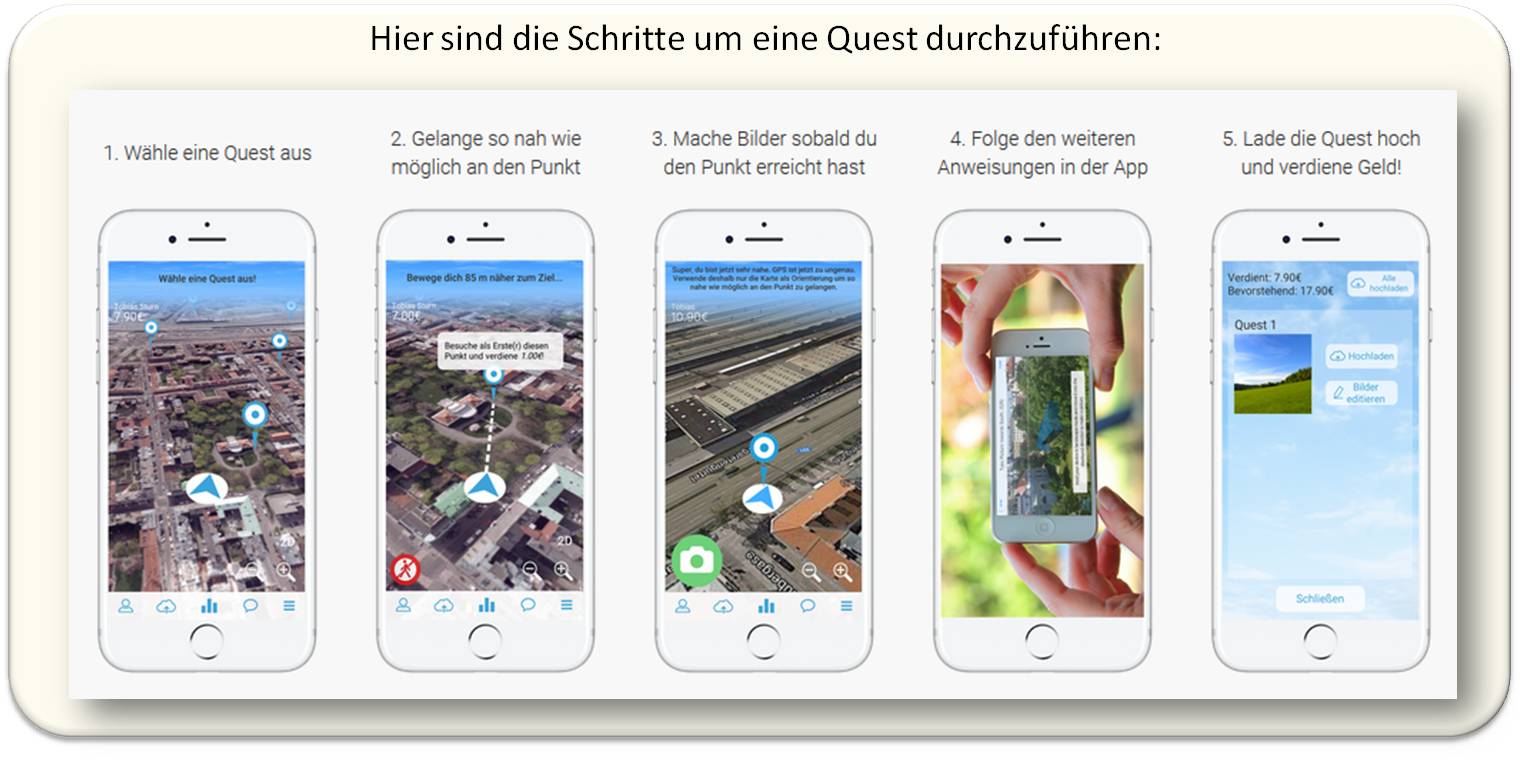

Abbildung 2. Das NEMO-Konzept. Sulfidhaltige Bergbaurückstände werden derzeit in der Regel in Haldenlagern abgelagert. NEMO zielt auf die weitere Behandlung dieser Rückstände ab, um wertvolle Metalle und Mineralien zu gewinnen, während gefährliche Elemente konzentriert und die Restmatrix in Zement und Baumaterialien verwendet werden. (Bild von Redn. Eingefügt. Quelle: https://h2020-nemo.eu/project-2/) |

Wertvolle Metalle können bereits durch ein Verfahren namens Auslaugung aus Abfällen zurückgewonnen werden. Dabei werden Chemikalien, in der Regel Säuren, eingesetzt, um die Metalle aufzulösen und aus dem Abfall herauszulösen, so dass sie zurückgewonnen werden können.

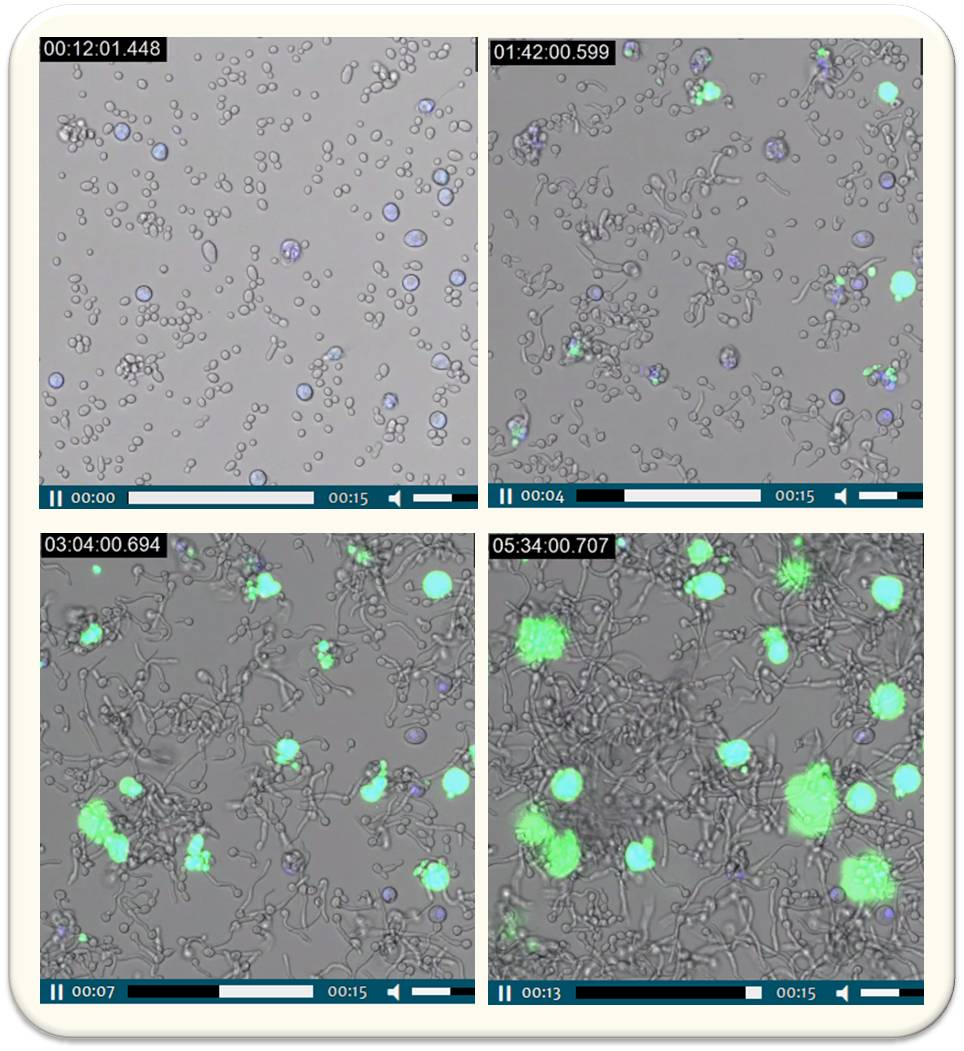

Die Biolaugung ähnelt zwar der chemischen Auslaugung, lässt aber lebende Organismen die Arbeit erledigen. Mikroben zehren von den Elementen in den Minenabfällen und schaffen dann eine saure Umgebung, die die Metalle auflöst. Das Verfahren hat das Potenzial, billiger und effektiver zu sein als die chemische Laugung.

Die Forscher haben gezeigt, dass die Biolaugung ein gangbarer Weg ist, um Metalle wie Nickel aus Abraum zu gewinnen. Die Qualität der Metalle wäre gut genug, um beispielsweise Batterien herzustellen. Sie fanden auch heraus, dass die Biolaugung mit zusätzlichen Rückgewinnungsverfahren wertvolle seltene Erden aus bestimmten Bergbauabfällen extrahieren könnte. Außerdem waren die Abfälle nach der Biolaugung weniger sauer und konnten zu einem Zusatzstoff für Zementmischungen verarbeitet werden.

Kostenfragen

Wie auch das RemovAL-Team stellten die NEMO-Forscher jedoch fest, dass diese Verfahren derzeit zu kostspielig sind, um kommerziell interessant zu sein.

"Es ist eine Sache, die Technologie zur Umwandlung von Abraum in wiedergewonnene Metalle und Baumaterialien zu entwickeln", so Jones. "Es ist etwas ganz anderes, dies auf eine Weise zu tun, die wirtschaftlich machbar ist."

Er sagt, dass die relativ geringen Mengen an kritischen Metallen in den Abgängen bedeuten, dass die Betriebskosten tendenziell höher sind als die potenziellen Einnahmen und dass daher der Abbau von Rohstoffen oft eine billigere Option ist, insbesondere wenn er in Niedriglohnländern erfolgt, in denen die Standards für Umwelt, Soziales und Unternehmensführung (ESG) niedriger sind.

Dennoch hat NEMO dazu beigetragen, Technologien zu entwickeln, die den Weg zu einer effizienten Rückgewinnung von Metallen aus abgebauten Materialien weisen und die Abfälle reinigen.

Mit dem richtigen Rechtsrahmen und den richtigen Anreizen könnten die Biolaugung und ähnliche neue Technologien wirtschaftlicher werden. In der Zwischenzeit können diese Verfahren Europa helfen, sein Ziel zu erreichen, die Versorgung mit kritischen Rohstoffen zu erweitern, indem Abraumhalden beseitigt und die Erzförderung verbessert wird.

*Dieser Artikel wurde ursprünglich am 12. April 2024 von Michael Allen in Horizon, the EU Research and Innovation Magazine unter dem Titel "The riches in Europe’s mountains of metals waste" https://projects.research-and-innovation.ec.europa.eu/en/horizon-magazine/riches-europes-mountains-metals-waste publiziert. Der unter einer cc-by-Lizenz stehende Artikel wurde von der Redaktion möglichst wortgetreu aus dem Englischen übersetzt. Abbildung 2 wurde von der Redaktion aus https://h2020-nemo.eu/project-2/ eingefügt.

Zur Verwertung der Abfallberge

EU-Research:

HORIZON: the EU Research & Innovation magazine: The riches in Europe’s mountains of metals waste (April 2024). Video 0:59 min. https://www.youtube.com/watch?v=gwiNoOPnf4E

- RemovAL: Removing the waste streams from the primary Aluminum production and other metal sectors in Europe. https://cordis.europa.eu/project/id/776469. Dazu: Aluminiumverarbeitung erstrahlt in neuem Glanz. https://cordis.europa.eu/article/id/436237-aluminium-processing-takes-on-new-lustre/de

- NEMO: Near-zero-waste recycling of low-grade sulphidic mining waste for critical-metal, mineral and construction raw-material production in a circular economy. https://cordis.europa.eu/project/id/776846. Dazu: Von Bergbauabfällen zum Schatz: nachhaltige Ressourcen für die Gesellschaft. https://cordis.europa.eu/article/id/436235-mine-tailings-to-treasure-providing-society-with-sustainable-resources/de

Aus der Max-Planck-Gesellschaft:

MPG: Grüner Stahl aus giftigem Rotschlamm (Jänner 2024). https://www.mpg.de/21440660/rotschlamm-aluminiumindustrie-gruener-stahl

Max-Planck-Gesellschaft: Grüner Stahl: Ammoniak könnte die Eisenproduktion klimafreundlich machen (2023). Video 2:10 min. https://www.youtube.com/watch?v=a_yUKX8zQfI

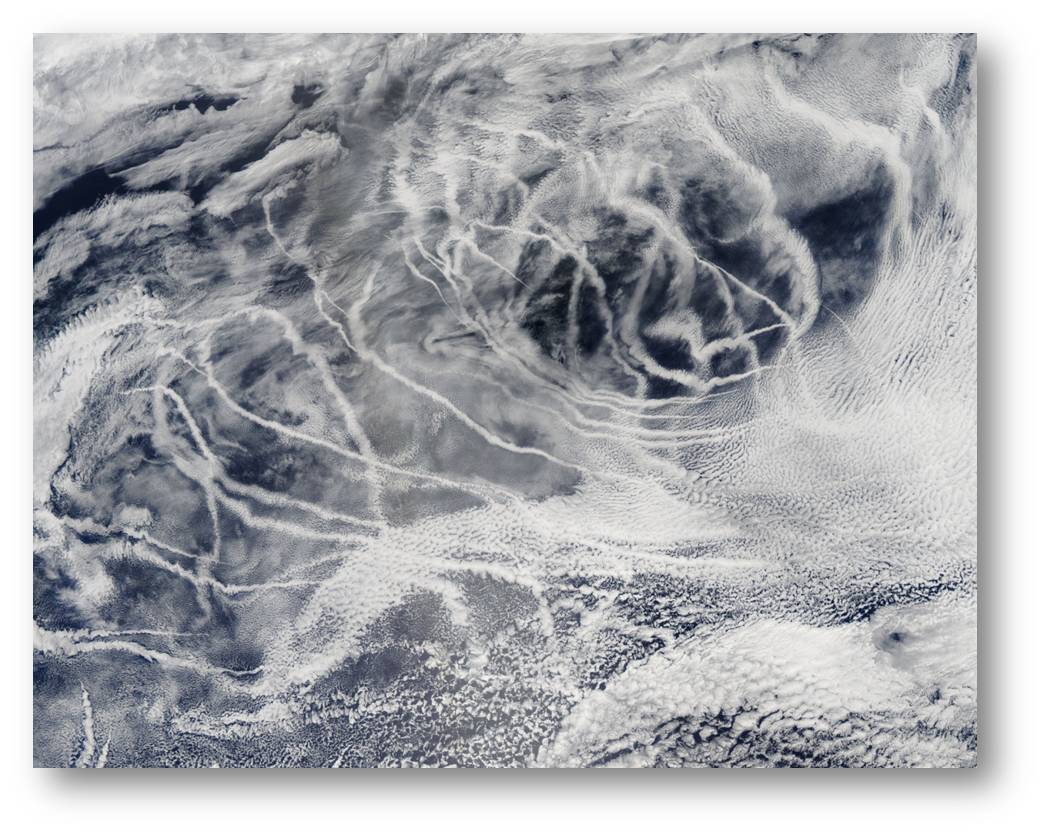

Passatwolken - ein neu entdeckter Feuchtigkeitskreislauf verstärkt den Schutz vor der Erderwärmung

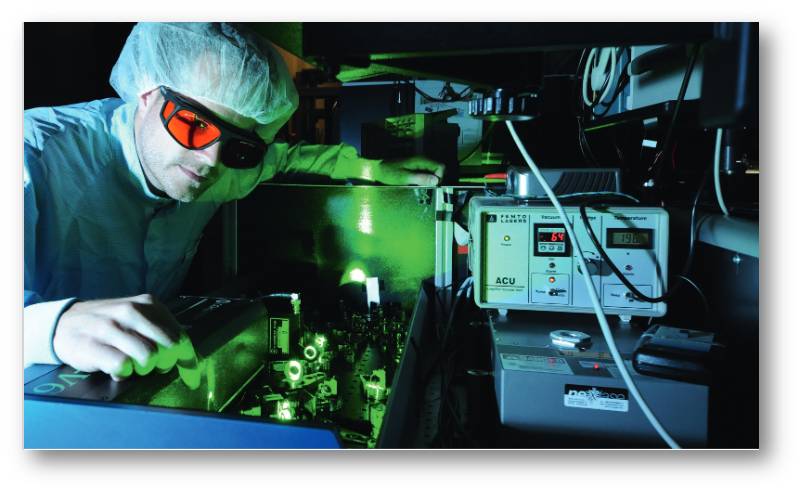

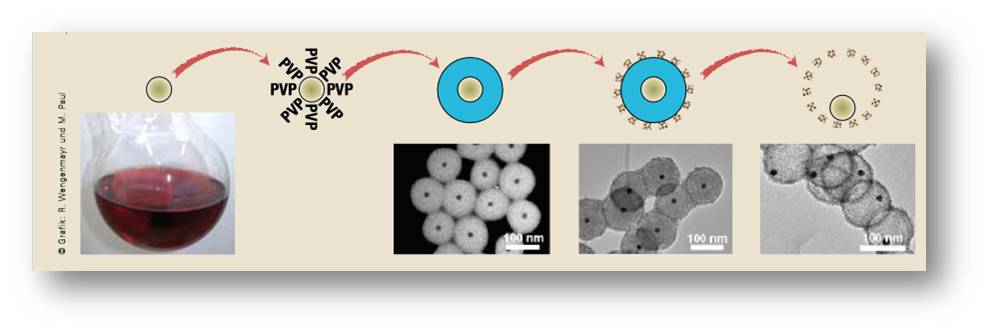

Passatwolken - ein neu entdeckter Feuchtigkeitskreislauf verstärkt den Schutz vor der ErderwärmungDo, 11.04.2024 — Roland Wengenmayr

Tropische Passatwolken wirken wie ein Kühlelement im Klimasystem: In der Äquatorzone dienen sie als Schutzschirm gegen die wärmende Sonnenstrahlung. Doch reduziert der menschengemachte Klimawandel möglicherweise ihre Dichte, sodass sich die Erderwärmung verstärkt? Der Physiker und Wissenschaftsjournalist Roland Wengenmayr berichtet über die Eurec4a-Feldstudie, die Bjorn Stevens, Direktor am Max-Planck-Institut für Meteorologie in Hamburg, mitinitiiert hat. Diese Studie hat mit vier Forschungsschiffen, fünf Flugzeugen und weiteren Instrumenten die tropischen Passatwolken untersucht und einen bislang unbekannten Feuchtigkeitskreislauf - die Flache Mesoskalige Umwälzzirkulation - entdeckt. Ein besseres Verständnis davon, wie sich in Passatwolken Niederschlag bildet und warum die Passatwolken verschiedene Formen annehmen, hilft Klimamodelle und ihre Prognosen zu präzisieren.*

Tropische Passatwolken wirken wie ein Kühlelement im Klimasystem: In der Äquatorzone dienen sie als Schutzschirm gegen die wärmende Sonnenstrahlung. Doch reduziert der menschengemachte Klimawandel möglicherweise ihre Dichte, sodass sich die Erderwärmung verstärkt? Der Physiker und Wissenschaftsjournalist Roland Wengenmayr berichtet über die Eurec4a-Feldstudie, die Bjorn Stevens, Direktor am Max-Planck-Institut für Meteorologie in Hamburg, mitinitiiert hat. Diese Studie hat mit vier Forschungsschiffen, fünf Flugzeugen und weiteren Instrumenten die tropischen Passatwolken untersucht und einen bislang unbekannten Feuchtigkeitskreislauf - die Flache Mesoskalige Umwälzzirkulation - entdeckt. Ein besseres Verständnis davon, wie sich in Passatwolken Niederschlag bildet und warum die Passatwolken verschiedene Formen annehmen, hilft Klimamodelle und ihre Prognosen zu präzisieren.*

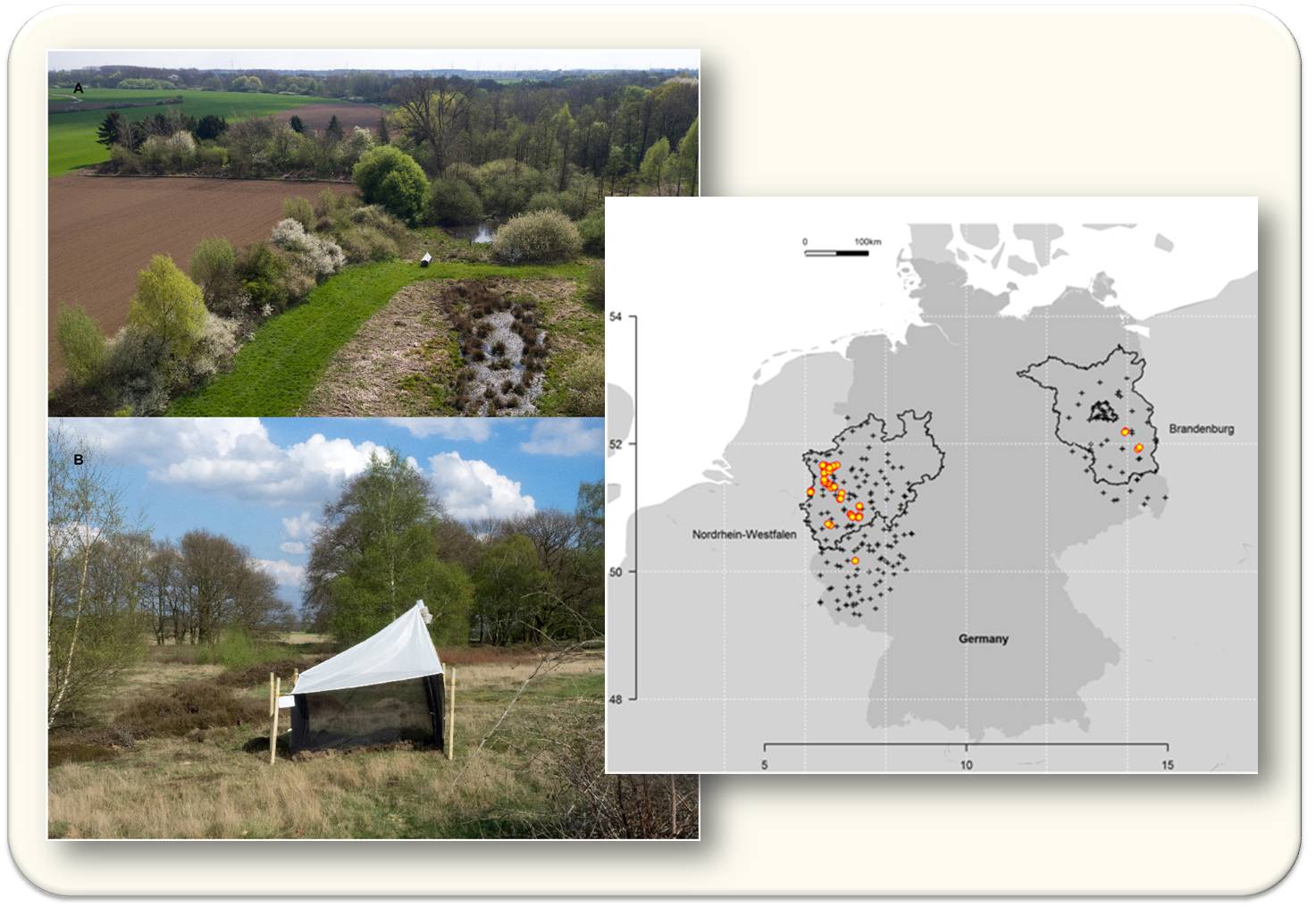

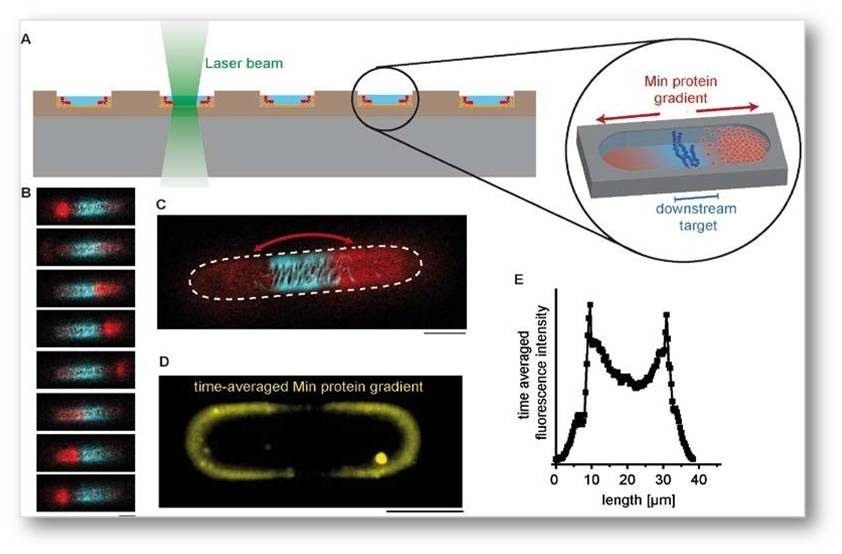

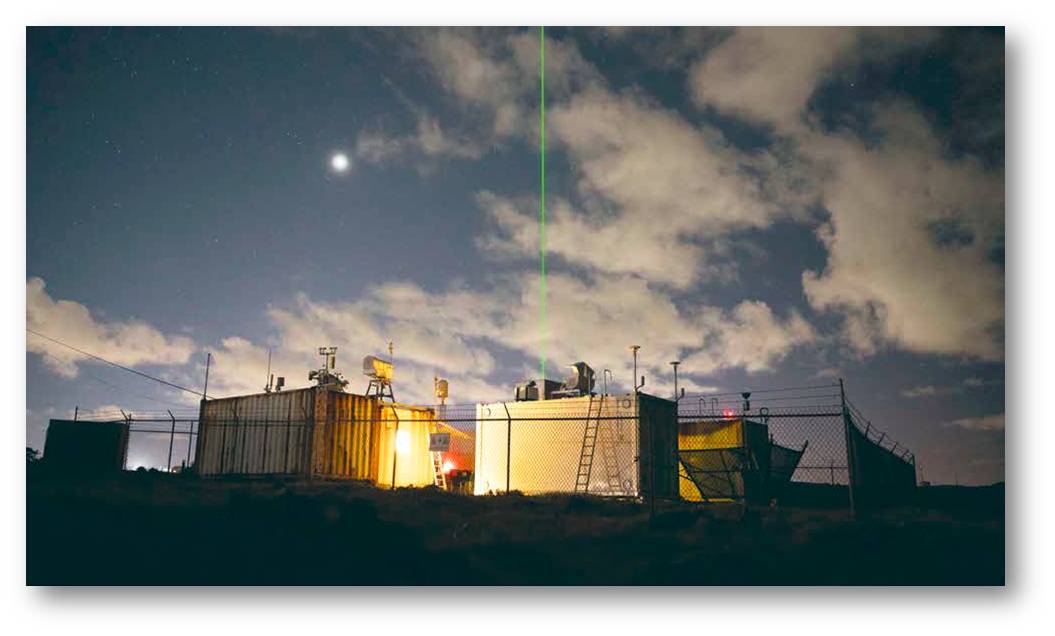

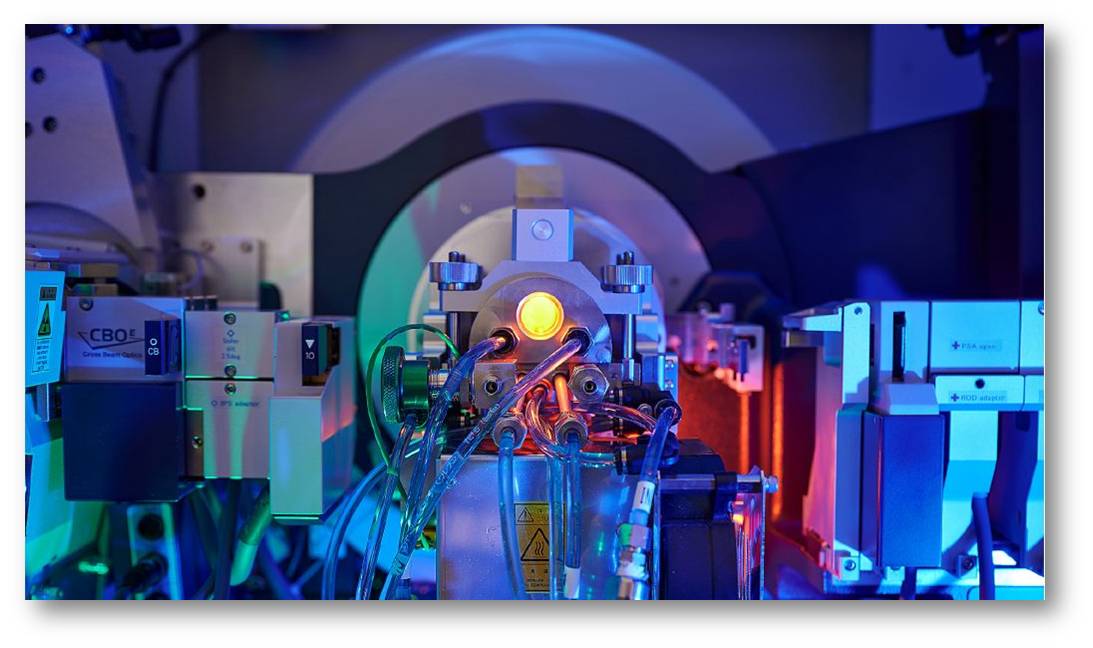

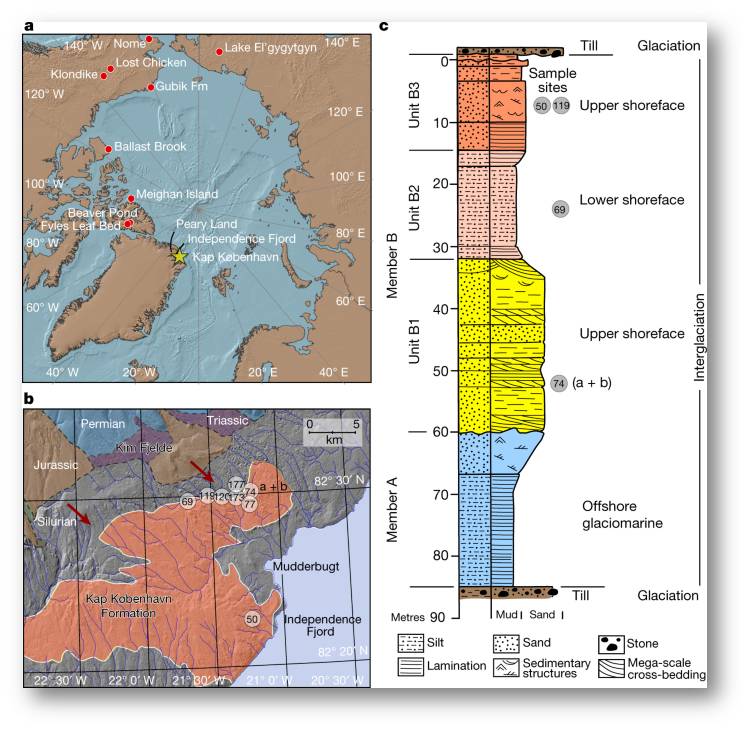

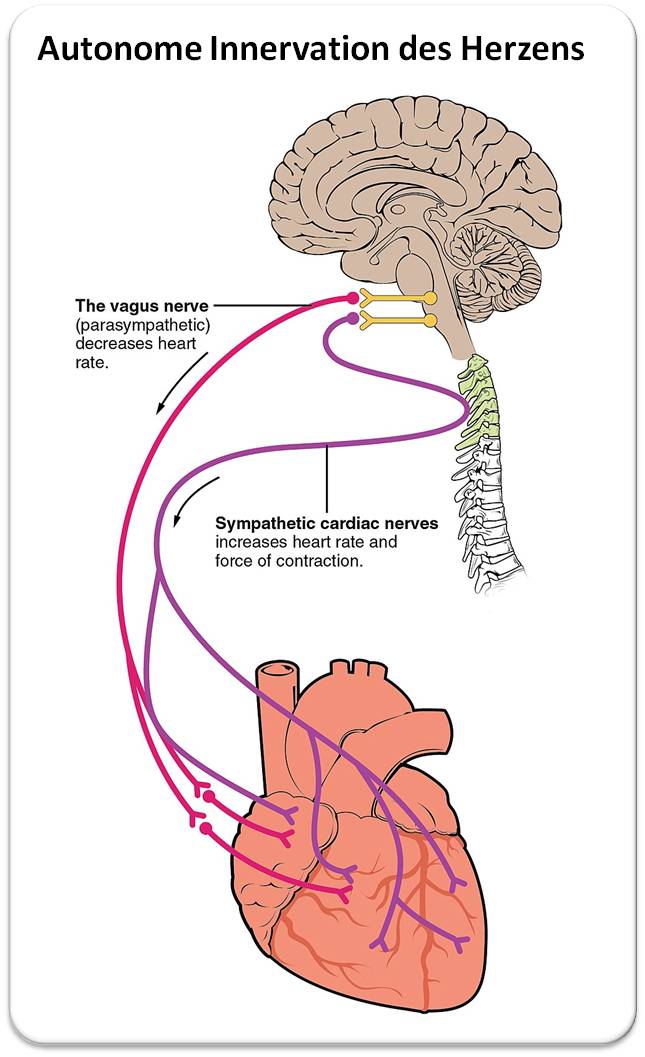

Anfang 2020 versammelte die Klimaforschung vor Barbados eine See- und Luftflotte, wie sie vorher nur selten an den Start gegangen war: Vier Forschungsschiffe, darunter die beiden deutschen Schiffe Meteor und Maria S. Merian, und fünf Forschungsflugzeuge, darunter der Jet Halo des Deutschen Zentrums für Luft- und Raumfahrt (DLR), eine französische ATR -42 und eine US-amerikanische Lockheed WP-3D Orion Hurricane Hunter, gingen in den Tropen auf Wolkenjagd. Auf Barbados nahm das große Wolkenradar Poldirad des DLR seinen Betrieb auf. Abbildung 1. Mehr als 300 Forschende aus 20 Nationen beteiligten sich an dieser Großoperation. Das Untersuchungsobjekt: die kleinen, niedrigen Passatwolken.

|

Abbildung 1: Aufbau des Wolkenradars Poldirad (Polarisations-Doppler-Radar) auf Barbados. © MPI-M |

Eurec4a hieß die vierwöchige Kampagne, das steht für „Elucidating the role of clouds-circulation coupling in climate“, also „Klärung der Rolle der Wolken-Zirkulations-Kopplung für das Klima“. Natürlich spielt der Name auch auf Archimedes an; der soll beim Baden das Gesetz des Auftriebs entdeckt und gerufen haben: „Heureka!“ - „Ich habs gefunden!“ Darauf weist Bjorn Stevens hin, denn: „Bei Wolken geht es wirklich um Auftrieb!“ Der Direktor am Max-Planck-Institut für Meteorologie in Hamburg hat die Eurec4a -Kampagne gemeinsam mit seiner französischen Kollegin Sandrine Bony, Direktorin am Centre National de la Recherche Scientifique in Paris, konzipiert und geleitet. Unterstützt wurden sie vor Ort durch David Farrell, Leiter des Caribbean Institute for Meteorology und Hydrology. Stevens hat auch gemeinsam mit Farrell das Barbados Cloud Observatory am östlichsten Punkt der Insel aufgebaut, das 2010 in Betrieb ging.

Aber warum treibt die Klimaforschung einen solchen Aufwand um kleine Wölkchen in den Tropen?

Passatwolken sind niedrige Wolken, sie bilden sich schon in etwa 700 Metern Höhe und dehnen sich – meist – nur bis in zwei Kilometer Höhe aus. Dennoch stellen sie ein Schwergewicht im Klimasystem dar, weil sie so viele sind. Sie sind gesellig wie eine Schafherde und bedecken mehr als 30 Prozent der Gesamtfläche der Passatwindzone, die wie ein Gürtel ein Fünftel der Erde in den Tropen und Subtropen umspannt. Damit bilden die Wolken zusammen einen großen Spiegel, der einen beträchtlichen Teil der Sonnenstrahlung ins All reflektiert und somit die Erde kühlt. Da die Passatwolken eine viel größere Fläche bedecken als das Polareis und zudem fast senkrechter Sonneneinstrahlung ausgesetzt sind, ist ihre Spiegelwirkung für die Wärmestrahlung viel gewichtiger als die der großen Eisflächen in der Arktis und der Antarktis.

Würde nun die Dichte der Passatwolken mit dem Klimawandel abnehmen, dann hätte das erhebliche Auswirkungen auf das Erdklima. Diese Besorgnis lösten die Ergebnisse einiger Klimastudien aus, insbesondere eine wissenschaftliche Arbeit, die 2014 in der britischen Fachzeitschrift Nature erschien. Zugespitzt gesagt, war das Ergebnis dieser Klimasimulationen, dass die Erderwärmung die Passatwolken teilweise wegtrocknen könnte. Die Folge wäre also eine Verstärkung der Erwärmung, was wiederum die Passatwolken-Bedeckung reduzieren würde. „Positive Rückkopplung“ ist der Fachbegriff für einen solchen Teufelskreis.

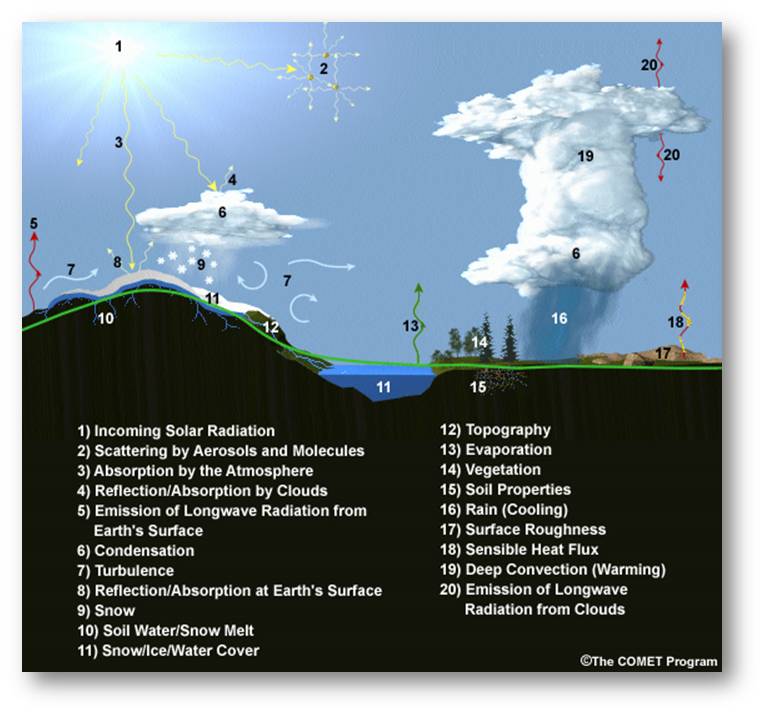

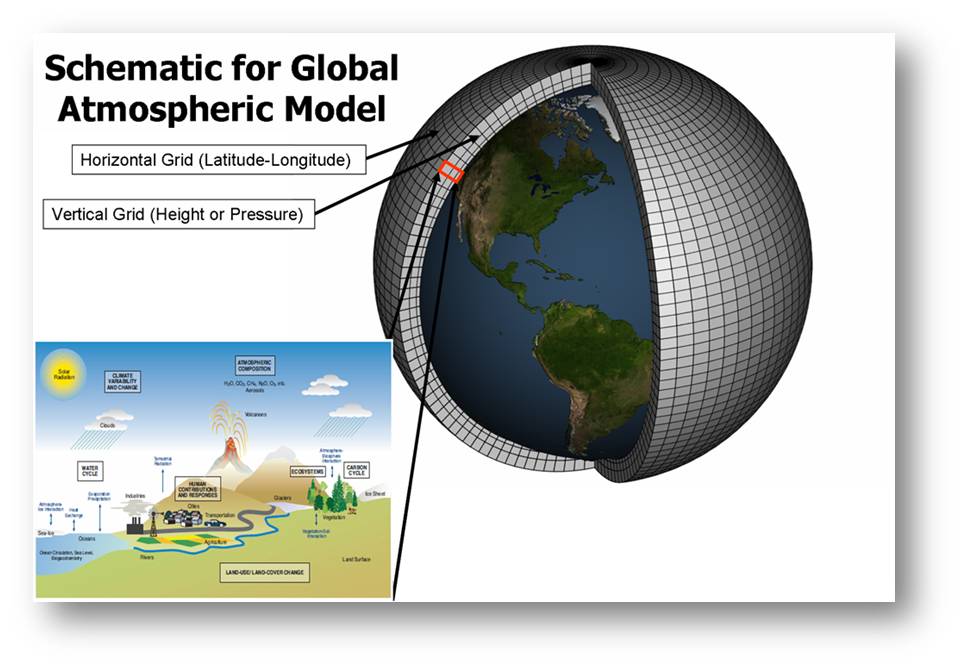

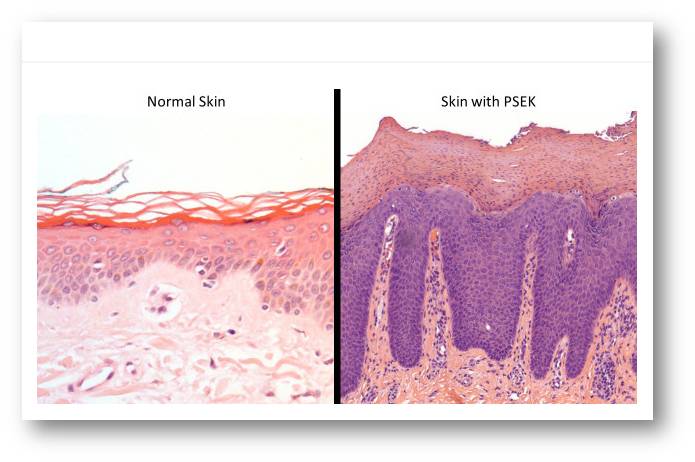

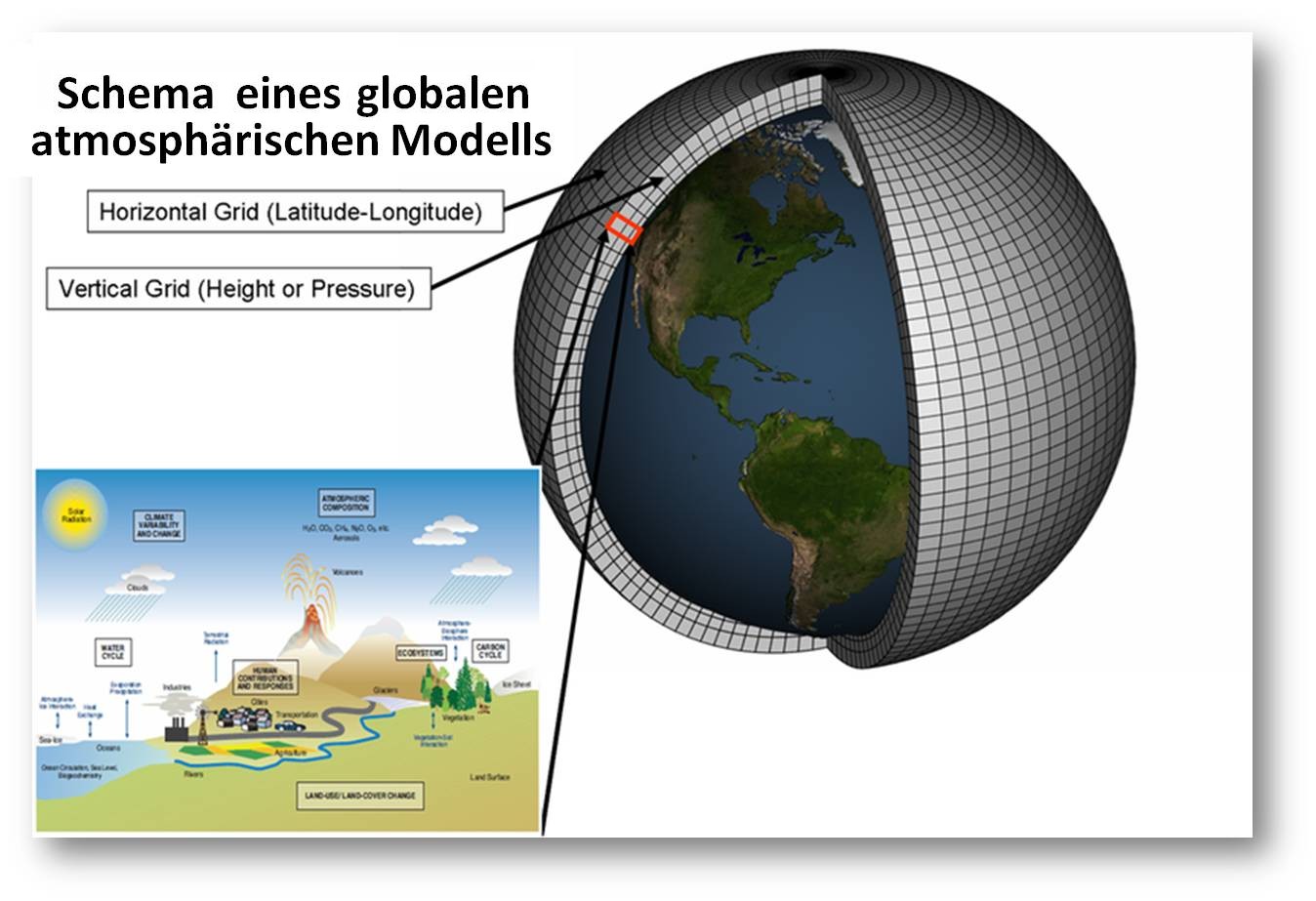

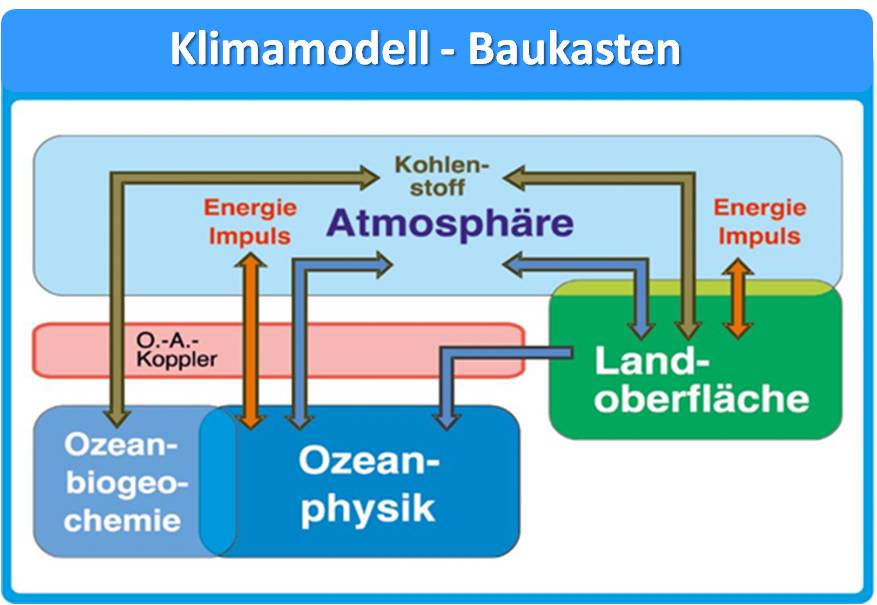

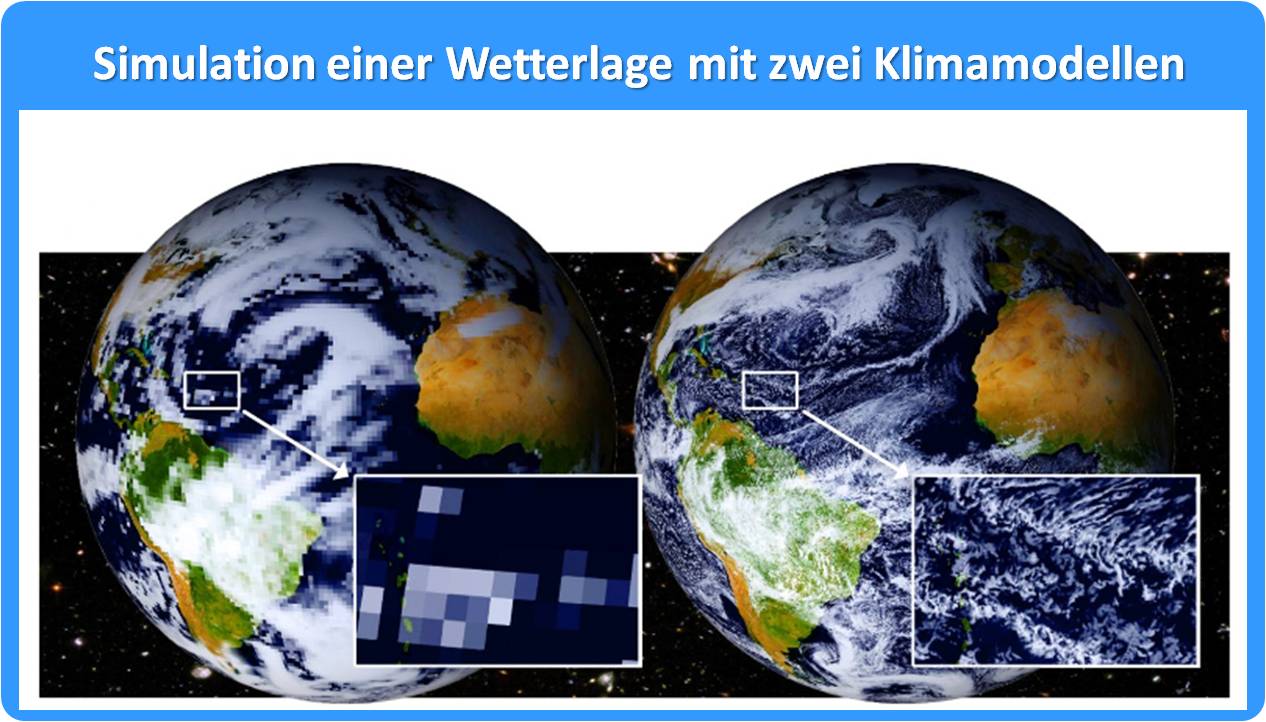

Nun ist es so, dass die großen, erdumspannenden Klimamodelle zwar sehr zuverlässig geworden sind, wenn es um die Simulation globaler Trends geht: Dass die Menschheit durch ihre Emissionen von Treibhausgasen die Erde erwärmt, steht wissenschaftlich außer Zweifel. Aber mit der Simulation der Wolkenbildung und folglich mit der Frage, wie Wolken auf die Erderwärmung antworten werden, tun sich heutige Klimamodelle recht schwer. Sie konnten die kleinteiligeren Prozesse, die dabei eine Rolle spielen, nicht erfassen. Und es gibt immer noch Wissenslücken, wenn es um ein genaueres Verständnis geht, wie Wolken entstehen und wie sie sich verhalten. Deshalb sollte Eurec4a die Passatwolken vor Ort durchleuchten. Die vierwöchige Kampagne sollte Daten über ihr Entstehen und Vergehen sammeln, über ihre Reaktion auf wärmere, kältere, trockenere und feuchtere Wetteränderungen. Dazu liefen diverse Forschungsaktivitäten parallel, eng aufeinander abgestimmt. Den Kern dieser Wolkenforschung bildete ein zylinderförmiges Volumen von rund 10 Kilometern Höhe und circa 220 Kilometern Durchmesser. In diesem Volumen versuchte das Team vor allem die Luftbewegungen möglichst lückenlos zu erfassen, zusammen mit der transportierten Feuchtigkeit. Grundsätzlich entstehen Kumuluswolken, umgangssprachlich: Quellwolken, aus Luft, die wärmer ist als ihre Umgebung und mehr verdunstendes Wasser aufnehmen kann. Da Wassermoleküle leichter als Sauerstoffmoleküle sind, sorgt ein höherer Feuchtegehalt sogar für mehr Auftrieb als eine höhere Temperatur. Die Luft steigt auf, Konvektion entsteht.

In etwa 700 Metern Höhe kondensiere dann der mittransportierte Wasserdampf zu Wolkentröpfchen, erklärt Raphaela Vogel. Sie hat an Eurec4a teilgenommen und ist heute wissenschaftliche Mitarbeiterin der Universität Hamburg. „Deshalb haben diese Kumuluswolken unten an der Basis so eine messerscharfe Kante“, erklärt sie. Das kann man auch in Europa bei schönem Sommerwetter gut beobachten. Vogel hat am Max-Planck-Institut für Meteorologie promoviert und war als Postdoktorandin in Bonys Gruppe auf Barbados dabei. Ihre Aufgabe war es damals, das Flugprogramm als leitende Wissenschaftlerin zu koordinieren. Dazu flog sie meist auf der französischen ATR -42 mit, gelegentlich auch auf der deutschen Halo. Es sei eine sehr aufregende Zeit gewesen, erzählt sie begeistert, die Kampagne habe das internationale Team zusammengeschweißt.

Flugzeuge für jedes Wolkenstockwerk

Der deutsche Jet Halo war zuständig für das höchste Stockwerk. Er flog den oberen Kreisabschnitt des Zylinders im Lauf der vier Wochen 72-mal ab, hinzu kamen 13 solcher Rundflüge mit der amerikanischen WP-3D. Und jedes Mal saß Geet George im Heck, damals Doktorand in Stevens’ Gruppe und heute Assistenzprofessor an der Technischen Universität Delft. Er kümmerte sich um eine zentrale Messung: Auf exakt zwölf Positionen des 360-Grad-Rundkurses, wie die Fünfminutenstriche auf einem Uhrenziffernblatt, schoss er Wurfsonden aus dem Flugzeug. Diese schwebten dann an Fallschirmen die zehn Kilometer hinunter zur Meeresoberfläche. Ihre Pappröhren enthielten einen Sender, drei Sensoren für Druck, Temperatur und den relativen Feuchtegehalt der Umgebungsluft sowie einen GPS-Empfänger. Auf ihrem etwa zwölfminütigen Weg nach unten sendeten zwei- bis viermal pro Sekunde ihre Messwerte und Positionen an Halo. Besonders wichtig waren die GPS-Daten, denn sie lieferten die Information, wie weit der auf der jeweiligen Höhe herrschende Wind die Sonden zur Seite blies. Aus diesen Daten errechnete George, welche Luftmassen durch die gedachte Wand in das umzirkelte Messvolumen hineinflossen – oder hinaus. Da die Erhaltungssätze der Physik verbieten, dass Luft einfach verschwindet oder hinzukommt, lässt sich daraus errechnen, wie sich die Konvektion innerhalb des Zylinders verhält.

|

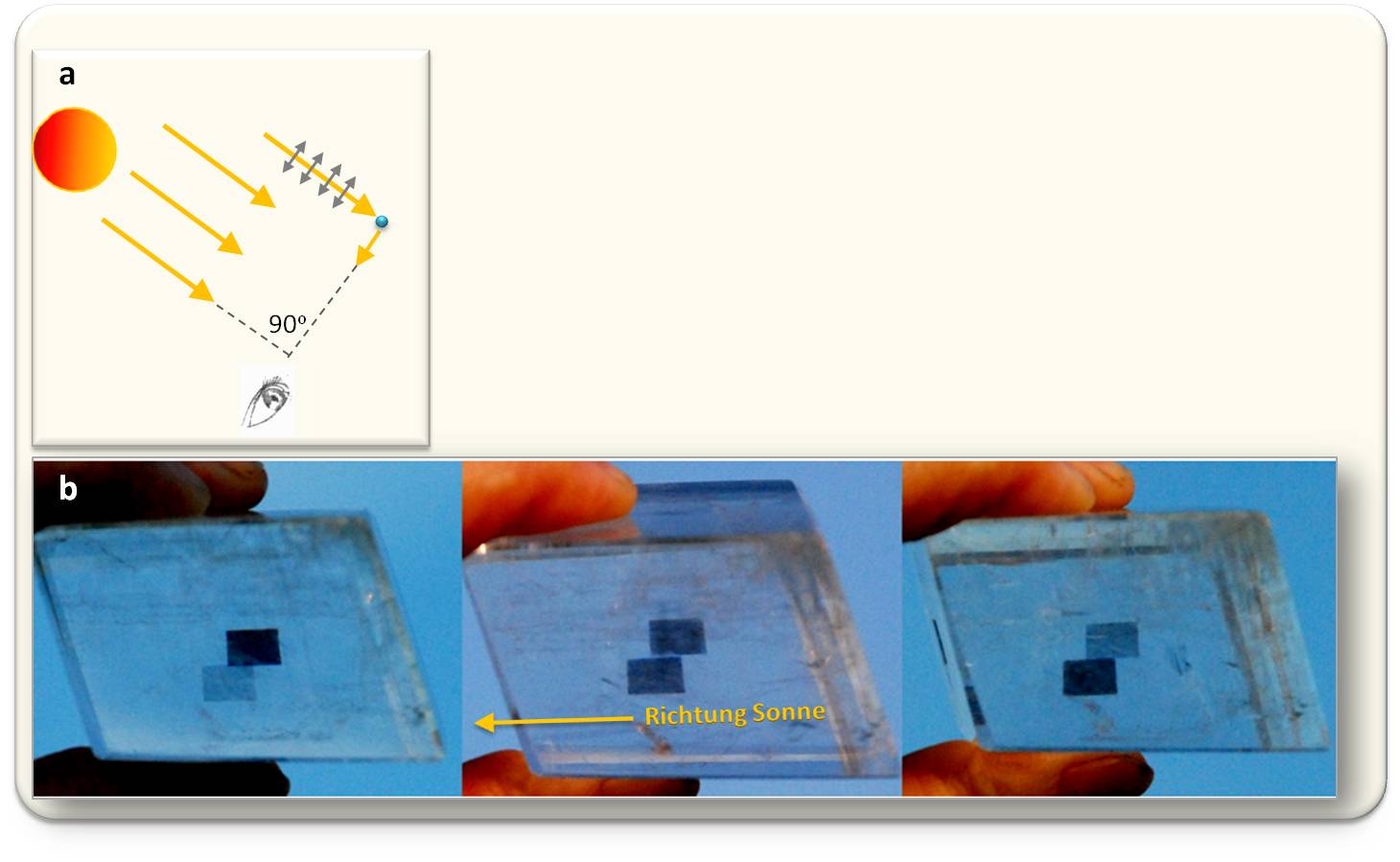

Abbildung 2: Mit einem Laser werden Eigenschaften der Wolken gemessen und daraus Temperatur und Feuchtigkeitsprofile abgeleitet. (Foto: MPI-M, F. Batier; © MPI-M ) |

Die französische ATR -42 hatte die Aufgabe, innerhalb des gedachten Messzylinders viel tiefer, auf Höhe der Wolkenbasis, zu fliegen. Besonders wichtig waren dabei Instrumente, die die Wolken seitlich mit Radar und Lidar, eine Art Laserscanner, abtasteten. Abbildung 2. Sie lieferten vor allem Informationen über die Wolkentröpfchen und deren Bewegungen. Damit diese Instrumente möglichst horizontal blickten, musste das Flugzeug waagerecht im Geradeausflug ausgerichtet sein. Daher flog die ATR -42 immer wieder einen Kurs ab, der wie bei einem römischen Wagenrennen aus zwei engen Kurven und langen geraden Streckenabschnitten bestand. Auch hier war Disziplin gefordert, selbst wenn es kaum Wolken gab, um in den vier Wochen ein Gesamtbild bei allen Wetterlagen zu erhalten. „Das war nicht immer leicht durchzusetzen“, erzählt Raphaela Vogel lachend, „wenn etwas weiter weg ein schönes Gewitter lockte.“ Im Nachhinein ist sie vor allem beeindruckt davon, wie zuverlässig die Eurec4a -Daten sind.

Aber was kam nun dabei heraus?

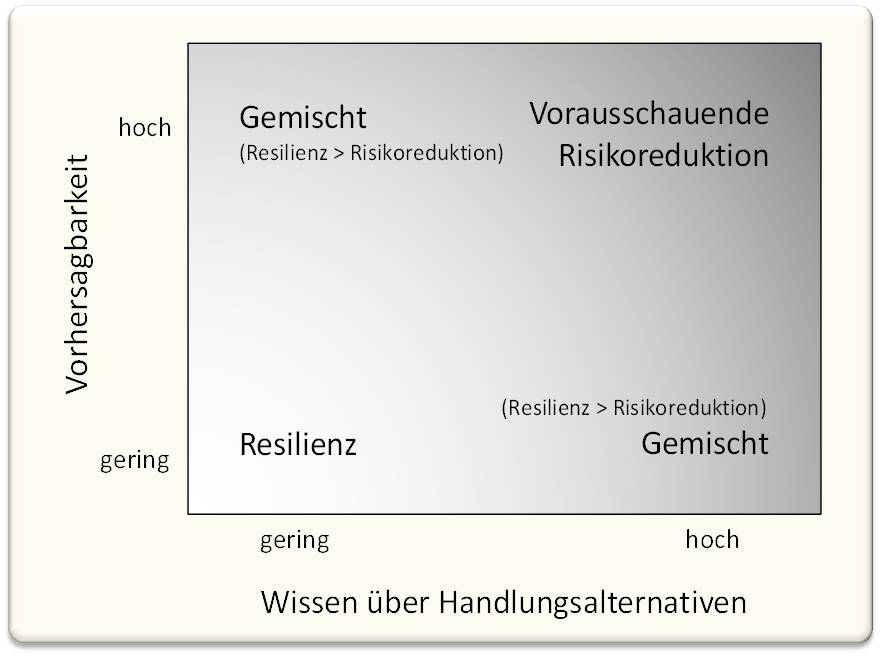

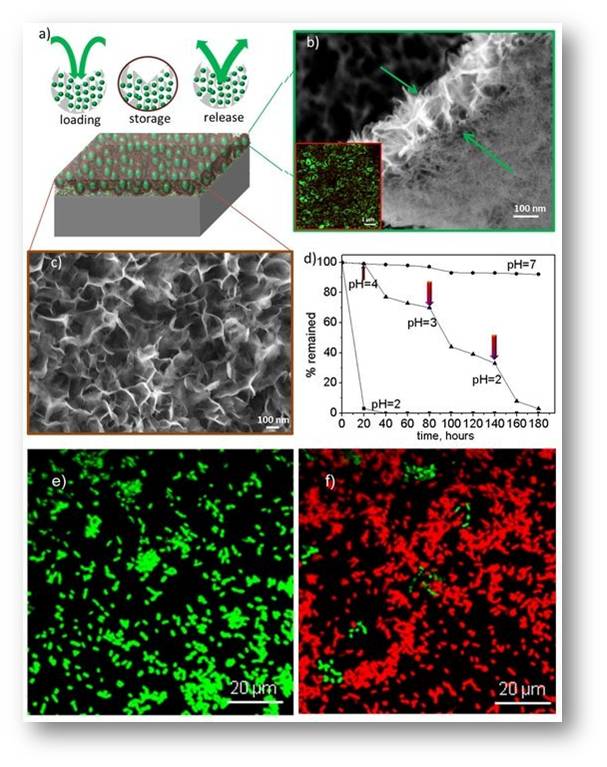

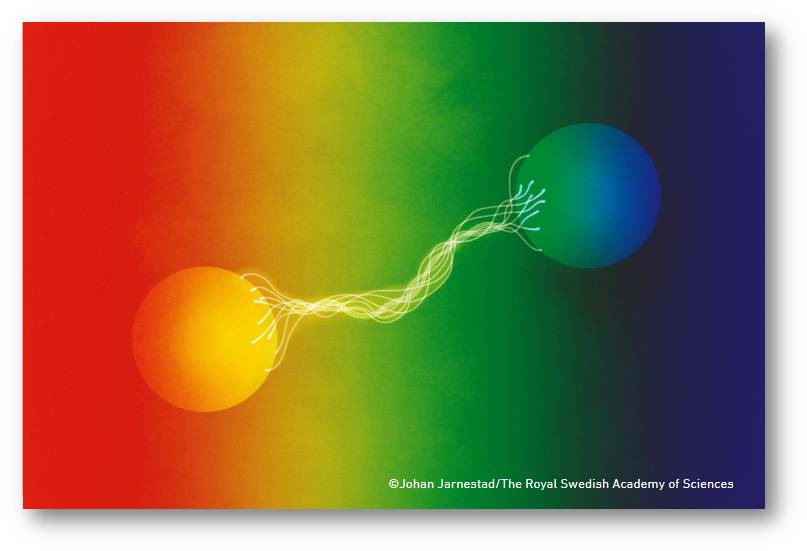

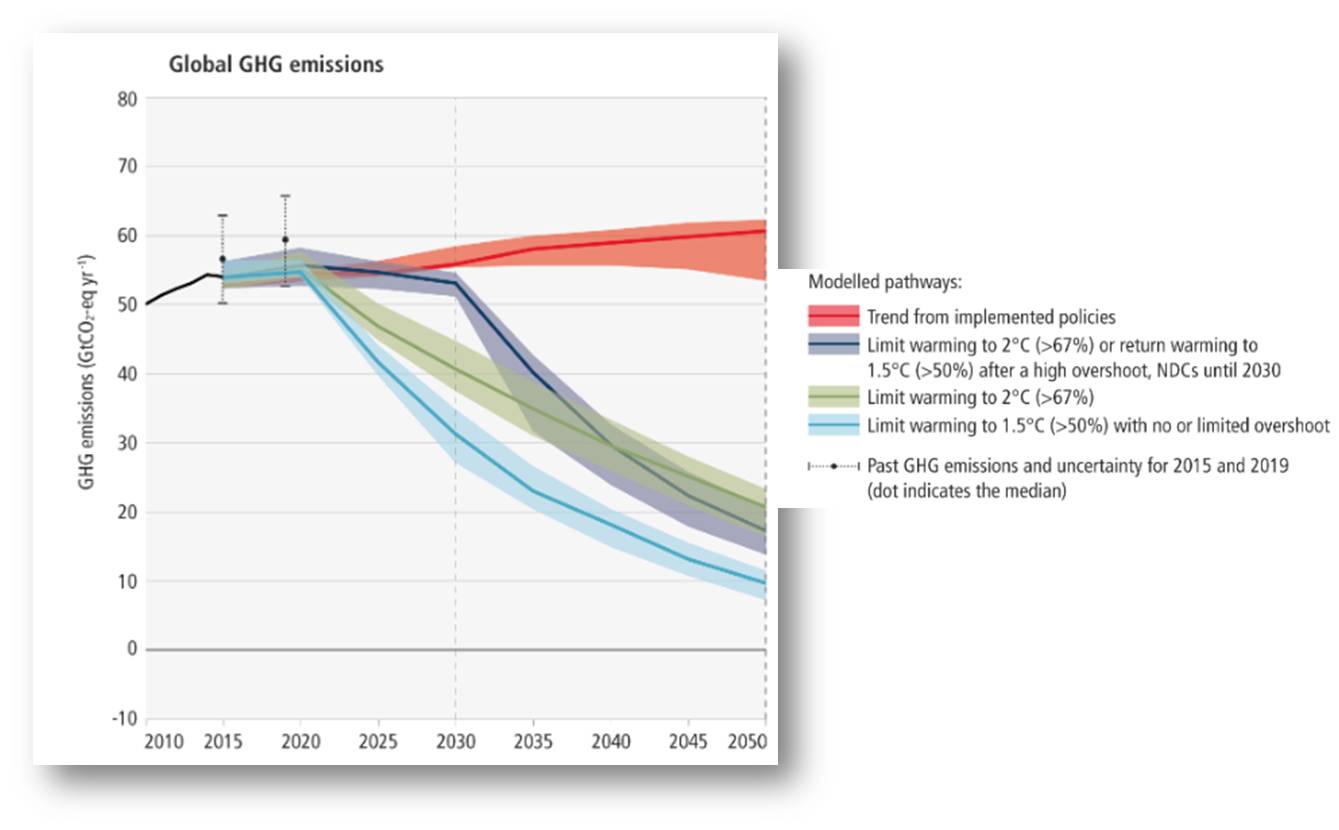

Dazu erklärt die Forscherin zunächst, was bei der Wolkenbildung grundsätzlich geschieht: Feuchte, von der Sonne erwärmte Luft steigt über dem Wasser auf, zum Ausgleich muss kühlere, trockene Luft aus größerer Höhe absinken. Wenn die feuchte Luft in diesem Konvektionsaufzug in die Höhe fährt, sinkt ihre Temperatur, und so kondensiert ein Teil des Dampfs zu Wolkentröpfchen. Diese feuchten, tröpfchenhaltigen Luftmassen vermischen sich mit den von oben kommenden trockeneren Luftmassen. Das lässt wieder einen Teil der Tropfen verdunsten. Dabei verschwindet das Wasser nicht, es wird nur wieder gasförmig und trägt so nicht zur Wolke bei. Ein wärmeres Klima allerdings könnte nun bewirken, dass sich weniger Wolkentröpfchen bilden, weil die von oben kommende Luft durch die Erderwärmung mehr Wasserdampf aufnehmen kann. Die Folge wäre, dass immer weniger Passatwolken entstehen, was wiederum – wegen der abnehmenden Spiegelwirkung – die Erderwärmung beschleunigen würde. Das wäre die bereits erwähnte positive Rückkopplung.

|

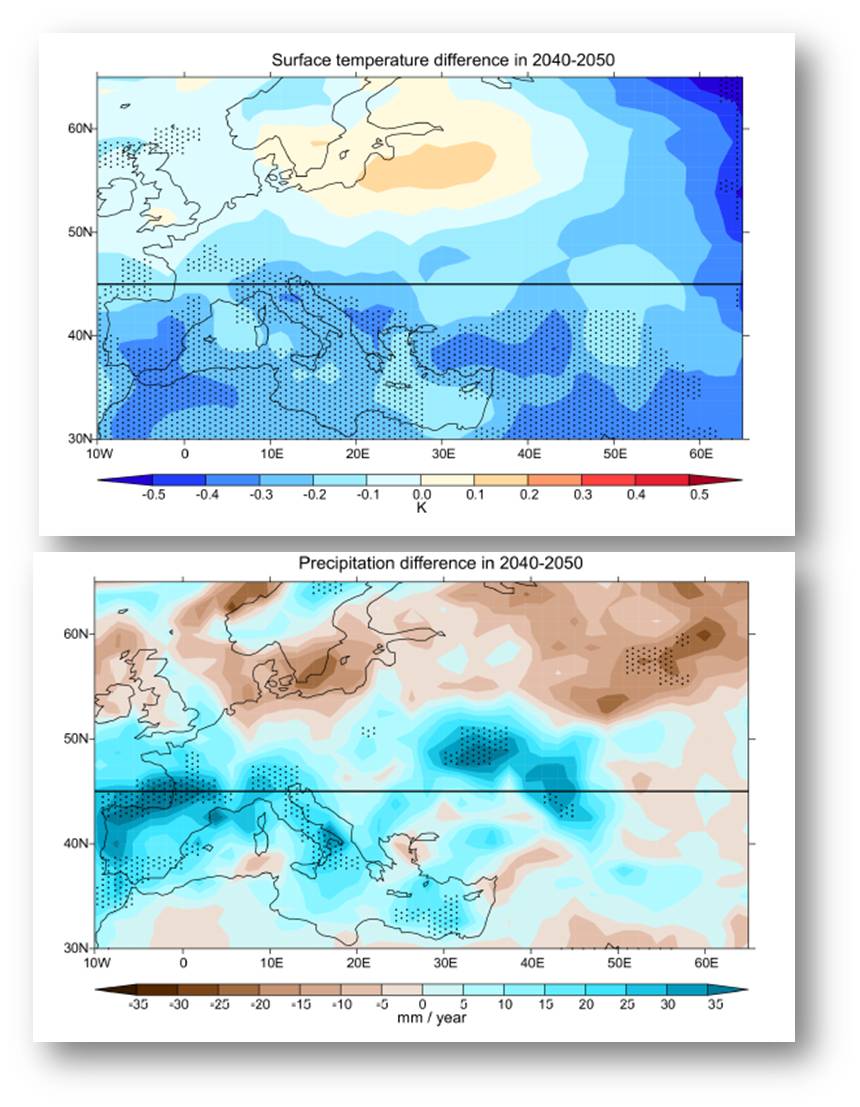

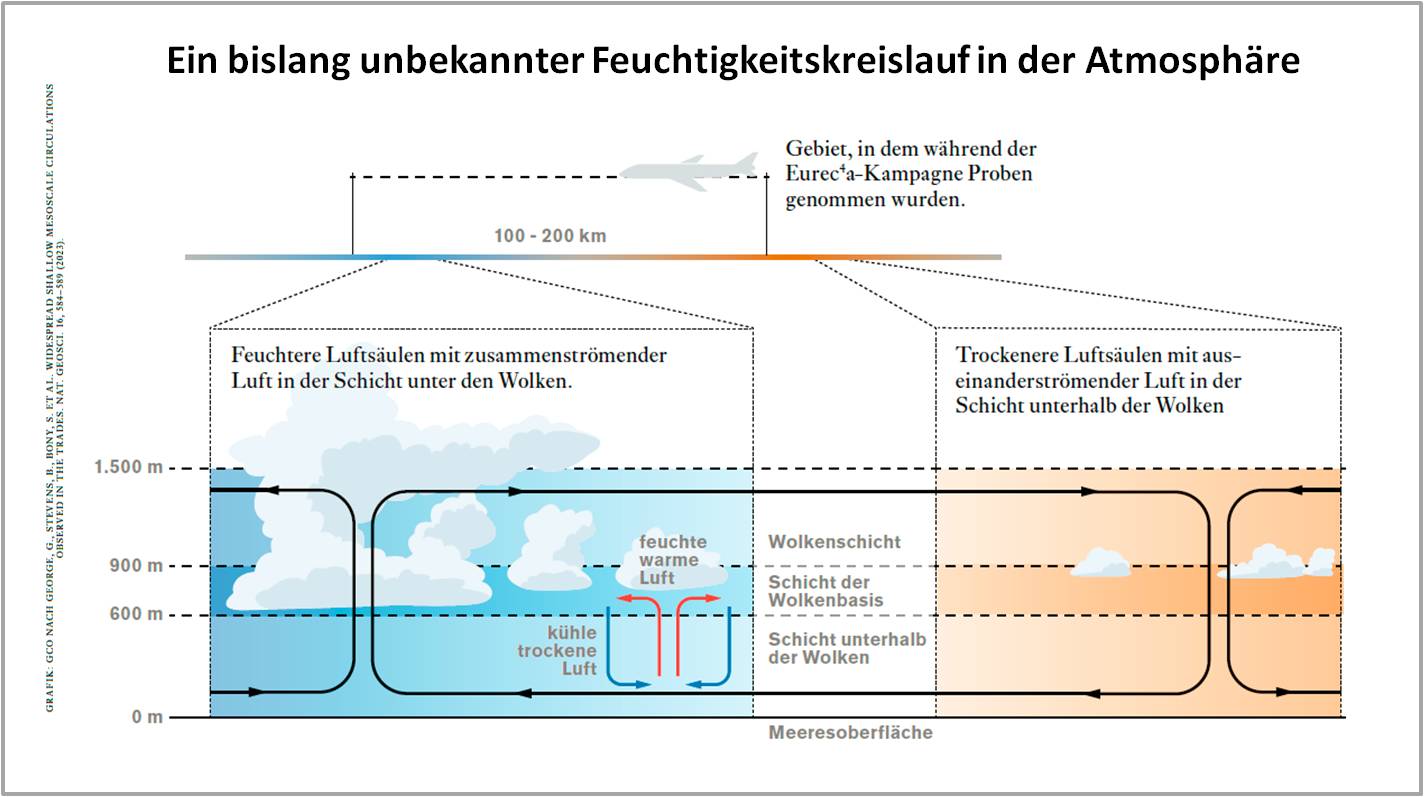

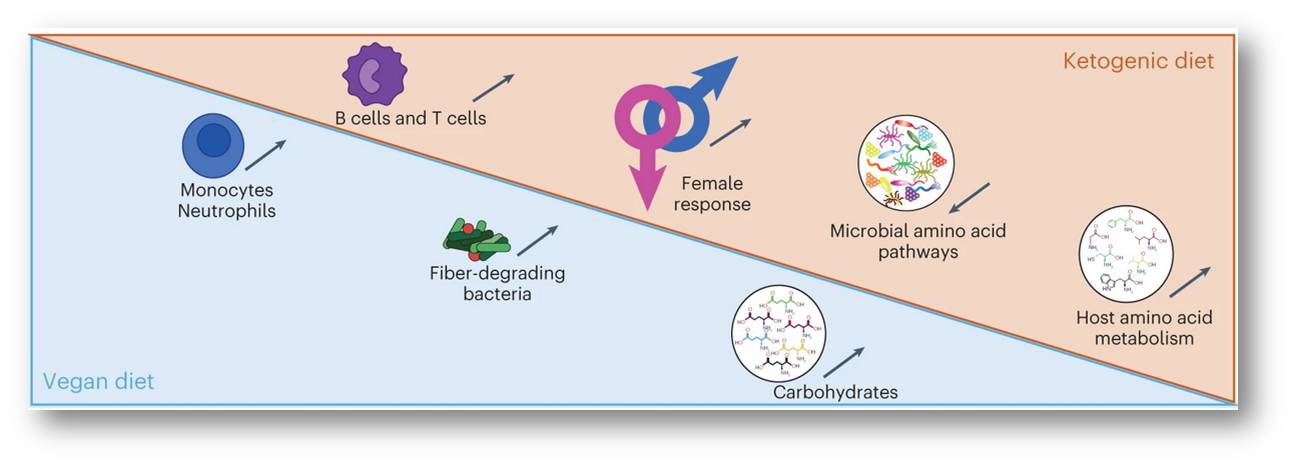

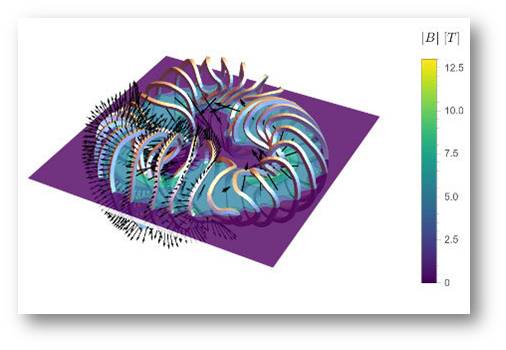

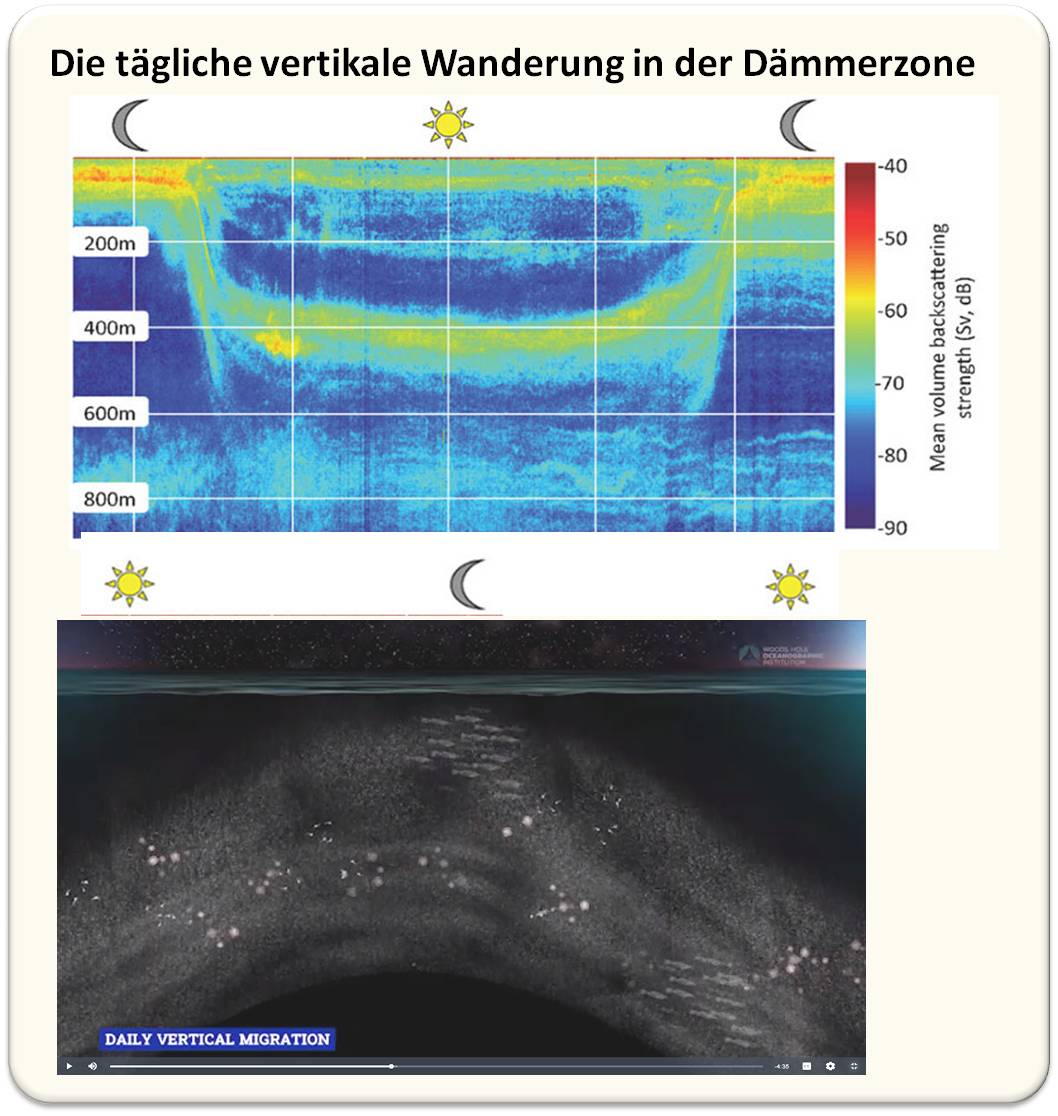

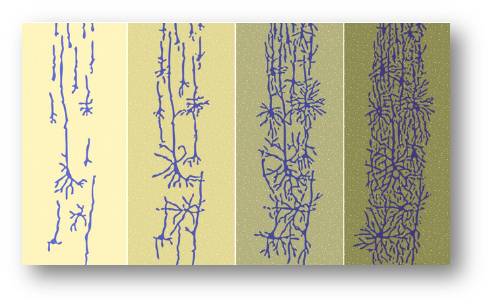

Abbildung 3. Quellwolken bilden sich dort, wo warme, feuchte Luft aufsteigt; zwischen den Wolken sinkt kühlere, trockene Luft hinab. Diese konvektive Strömung ist seit Langem bekannt. Im Eurec4a-Projekt haben Forschende nun eine mesoskalige Luftzirkulation über 100 bis 200 Kilometer entdeckt, die Feuchtigkeit dorthin bringt, wo die Wolken entstehen. Es ist daher nicht zu befürchten, dass die Passatwolken infolge der Erderwärmung wegtrocknen. © MPG |

Den Ergebnissen der Eurec4a -Kampagne zufolge ist diese Rückkopplung bei Weitem nicht so stark, wie einige Klimamodelle befürchten ließen. Abbildung 3. Das zeigte ein Team um Raphaela Vogel, zu dem auch Bjorn Stevens und Sandrine Bony gehörten, in einer Publikation über die wichtigsten Resultate der Feldstudie im Fachblatt Nature im Dezember 2022. „Das sind doch mal gute Neuigkeiten für uns Menschen“, sagt Raphaela Vogel. Warum das so ist, erklärt Geet George. Er war maßgeblich an einer zweiten wichtigen Veröffentlichung zu den Ergebnissen beteiligt, die im Juli 2023 in Nature Geoscience erschien. Entscheidend seien atmosphärische Zirkulationen, erklärt der Wissenschaftler, die so klein sind, dass sie durch das Raster bisheriger globaler Klimamodelle fallen.

Genug Nachschub an Feuchtigkeit

Diese „flachen mesoskaligen Umwälzzirkulationen“, englisch shallow mesoscale overturning circulations, erstrecken sich über Flächen in der Größenordnung des von Halo umflogenen Gebiets und reichen bis in etwa 1,5 Kilometer Höhe. „Mesoskalig“ bedeutet, dass es um Prozesse in mittelgroßen Räumen des Klimasystems von grob 100 bis 200 Kilometer Ausdehnung geht. Und diese Zirkulation durchmischt feuchte und trockene Luftmassen kräftiger, als einige globale Klimamodelle dies erwarten ließen. Grundsätzlich funktioniert sie wie die Konvektion, die Wolken entstehen lässt, nur dass sie sich genau in diesen mittelgroßen Räumen abspielt, die bei Barbados umflogen wurden. Sie liefert genügend Nachschub an Feuchtigkeit, um das Wegtrocknen der Wolkentröpfchen in einer wärmeren Umgebung weitgehend auszugleichen. Die aufsteigende, feuchte Luft und die fallende, trockene Luft bilden zusammen die aufsteigenden und absteigenden Teile der flachen, mesoskaligen Zirkulation – wie bei einem altmodischen Paternosteraufzug, der mit unterschiedlich besetzten Kabinen auf einer Seite hinauf- und daneben hinunterfährt.

„Wir haben ein neues Zirkulationssystem identifiziert, das die Variabilität in der Wolkenbedeckung beeinflusst“, bilanziert Bjorn Stevens. „Und dieser Mechanismus existiert in unseren bisherigen Klimamodellen nicht!“ Die Entdeckung, wie bedeutend diese flache Zirkulation in Räumen von etwa 100 bis 200 Kilometern für die heutige und zukünftige Existenz der Passatwolken ist, war die wichtigste Erkenntnis von Eurec4a.

Darüber hinausgab es noch andere neue Einsichten ins Wolkengeschehen, zum Beispiel wie Bewegung und Organisation der Passatwindwolken den Niederschlag aus ihnen beeinflussen. Unter welchen Bedingungen aus Wolkentröpfchen Regen, Schnee oder Hagel wird, kann die Klimaforschung noch nicht genau erklären, dies ist aber für Wettervorhersagen und Simulationen regionaler Klimaveränderungen relevant. Um die Niederschlagsbildung in Passatwolken besser zu verstehen, hat Jule Radtke als Doktorandin am Max-Planck-Institut für Meteorologie die Messungen von Poldirad auf Barbados ausgewertet. „Poldirad“ steht für Polarisations-Doppler-Radar. Dieser technische Terminus besagt im Kern, dass das Großgerät über das Radarecho sehr genau die Bewegungen der Tröpfchen in einer Wolke verfolgen kann. Normalerweise steht Poldirad am DLR-Standort in Oberpfaffenhofen. Mit finanzieller Unterstützung der Max-Planck-Förderstiftung wurde die Anlage für Eurec4a demontiert und auf einem Schiff über den Atlantik geschickt. Nach mehreren Monaten kam sie in Barbados an und blieb erst einmal in den Zollformalitäten stecken. Doch trotz aller Hindernisse gelang es dem Team, das Radargerät rechtzeitig in der Nähe des Barbados Cloud Observatory in Betrieb zu nehmen.

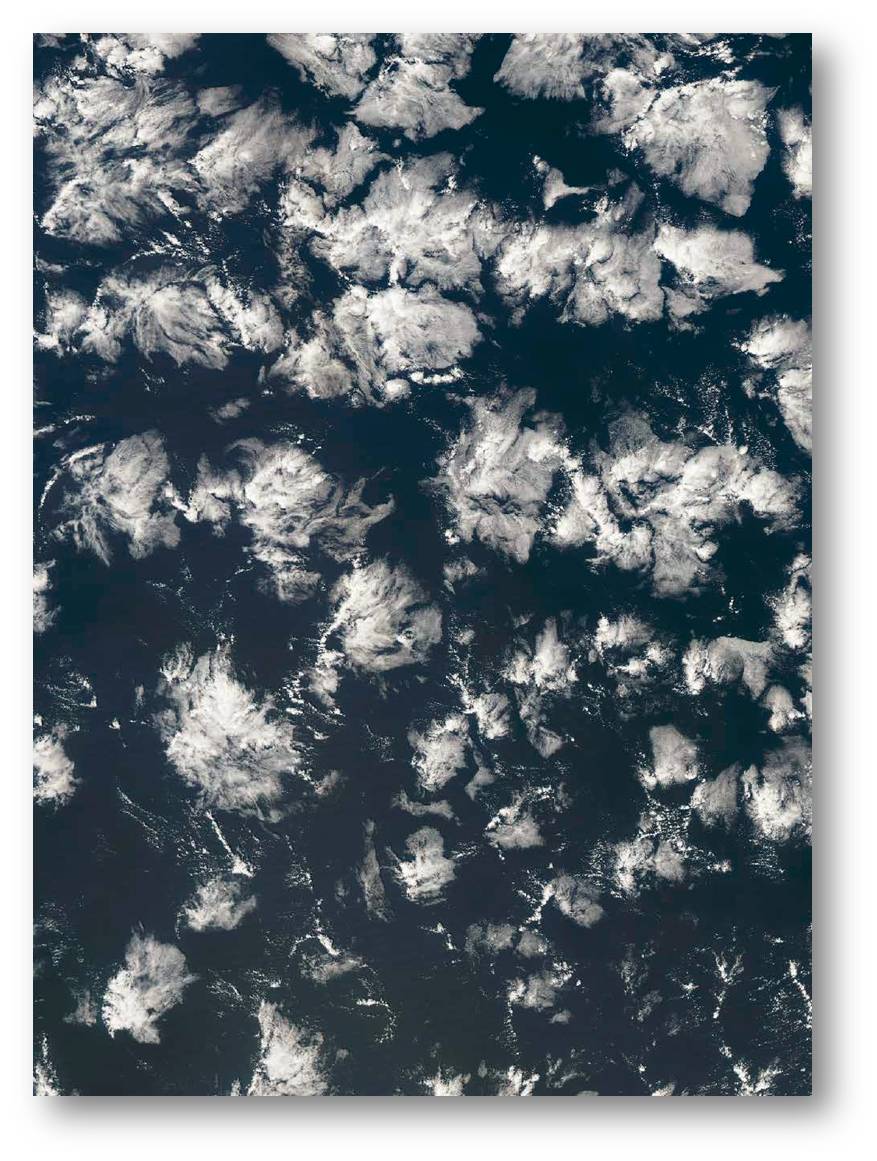

Blumen und Fische am Himmel

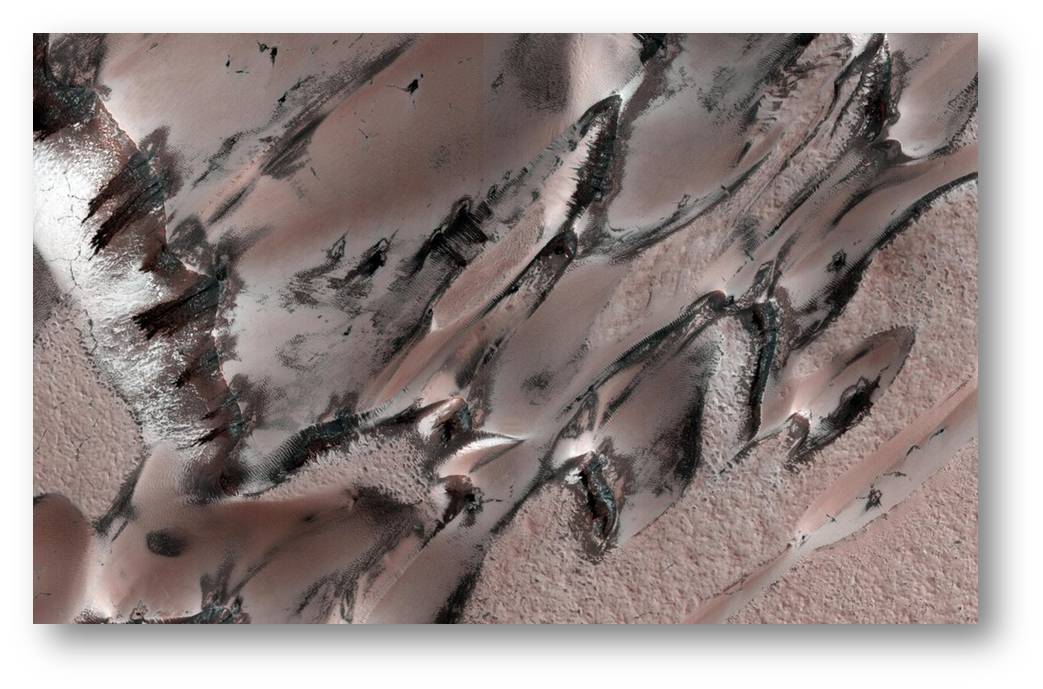

|

Abbildung 4. In den Tropen und Subtropen bilden sich in einem Gürtel, in dem der Passatwind vorherrscht, zahllose vielgestaltige Wolken, die das Klima kühlen, da sie Sonnenlicht reflektieren. Die hier gezeigten Formen werden als Blume bezeichnet. (Foto: MPI für Meteorologie / NASA World view.) |

Radtke untersuchte mit Daten von Poldirad, welchen Einfluss das Herdenverhalten der Passatwolken auf ihren Niederschlag hat. „Früher hieß es immer, dass diese kleinen Passatwindwolken Schönwetterwolken sind, die nicht hoch wachsen und daher auch nicht regnen“, sagt die Klimaforscherin, „und dass sie sich eher zufällig verteilen.“ Schon vor Eurec4a war aber klar, dass dieses Bild nicht stimmt. Radtke kam zu dem Ergebnis, dass der Herdentrieb einen deutlichen Einfluss auf das Regenverhalten der Wolken hat. Drängen sich die Wolken stärker zusammen, regnet es aus ihnen öfter. Denn offenbar schützen sie sich gegenseitig vor der Sonne. Das bewirkt eine feuchtere Atmosphäre und verhindert, dass Regentropfen wieder verdunsten, bevor sie den Boden erreichen. Dafür regnet es aus den Wolken in der Herde schwächer, weil in ihnen weniger Regen gebildet wird. „Das könnte daran liegen, dass da auch jüngere oder ältere Wolken mit herumhängen“, sagt Radtke lachend,„die noch nicht oder nicht mehr zum Niederschlag beitragen.“

Dass die Selbstorganisation der Wolken sehr komplex ist, hatte Bjorn Stevens’ Team schon in der Vorbereitungsphase zu Eurec4a entdeckt. Mithilfe von Maschinenlernen und Mustererkennung hatten die Hamburger in Satellitenbildern vier verschiedene Herdenmuster identifiziert, die sie „Zucker (Sugar)“, „Kies (Gravel)“, „Blumen (Flowers)“ und „Fisch (Fish)“ tauften. Letztere Struktur erinnert tatsächlich an ein Fischskelett. Gemeinsam mit Hauke Schulz, der heute an der University of Washington in Seattle forscht, untersuchte Stevens unter anderem, ob ein hochauflösendes Klimamodell, das auf ein kleineres Gebiet beschränkt ist, um Rechenleistung zu sparen, mit den Eurec4a -Daten diese Muster simulieren kann. Für „Fisch“ und „Kies“ gelang die Simulation schon recht gut, für „Blumen“ nicht. Wie wichtig es ist, dass zukünftige Klimamodelle diese Strukturen ganz genau simulieren können, das sei noch offen, betont Stevens. Zumindest die durchschnittliche Wolkenbedeckung müssen die Modelle jedenfalls möglichst genau berechnen, die Wolkenform könnte dabei ein relevanter Faktor sein. Abbildung 4. Die Lehre aus Eurec4a sei, dass Klimamodelle grundsätzlich viel feiner gestrickt sein müssen, um solche mesoskaligen Vorgänge auch in einem künftigen, wärmeren Klima simulieren zu können.

Bjorn Stevens ist optimistisch, dass die hochauflösenden Klimamodelle der Zukunft wesentlich genauere Vorhersagen für kleinräumige Vorgänge ermöglichen werden. Erst wenn Klimamodelle die Prozesse in der Atmosphäre noch besser erfassen, können sie etwa regionale Klimaveränderungen genauer prognostizieren. Dabei hilft sicher auch, dass der Klimaforschung immer leistungsfähigere Supercomputer zur Verfügung stehen. Die Feldforschung in der Natur werden aber auch diese Computer nicht ersetzen können. Im August und September 2024 läuft die Nachfolge-Feldstudie Orcestra, und wieder wird Barbados die Basis sein.

Vogel, R., Albright, A.L., Vial, J. et al. Strong cloud–circulation coupling explains weak trade cumulus feedback. Nature 612, 696–700 (2022).https://doi.org/10.1038/s41586-022-05364-y

George, G., Stevens, B., Bony, S. et al. Widespread shallow mesoscale circulations observed in the trades. Nat. Geosci. 16, 584–589 (2023). https://doi.org/10.1038/s41561-023-01215-1

* Der Artikel ist erstmals im Forschungsmagazin 1/2024 der Max-Planck-Gesellschaft unter dem Titel "Ein Schirm aus Blumenwolken"https://www.mpg.de/21738713/W004_Umwelt-Klima_052-057.pdf erschienen und wird mit Ausnahme des Titels und des Abstracts in praktisch unveränderter Form im ScienceBlog wiedergegeben. Die MPG-Pressestelle hat freundlicherweise der Veröffentlichung von Artikeln aus dem Forschungsmagazin auf unserer Seite zugestimmt. (© 2023, Max-Planck-Gesellschaft)

Klima/Klimawandel im ScienceBlog

ist ein Themenschwerpunkt, zu dem bis jetzt 52 Artikel erschienen sind.

Das Spektrum reicht von den Folgen des Klimawandels über Strategien der Eindämmung bis hin zu Klimamodellen: Klima & Klimawandel

Ewigkeitsmoleküle - die Natur kann mit Fluorkohlenstoff-Verbindungen wenig anfangen

Ewigkeitsmoleküle - die Natur kann mit Fluorkohlenstoff-Verbindungen wenig anfangenDo, 04.04.2024 — Inge Schuster

![]()

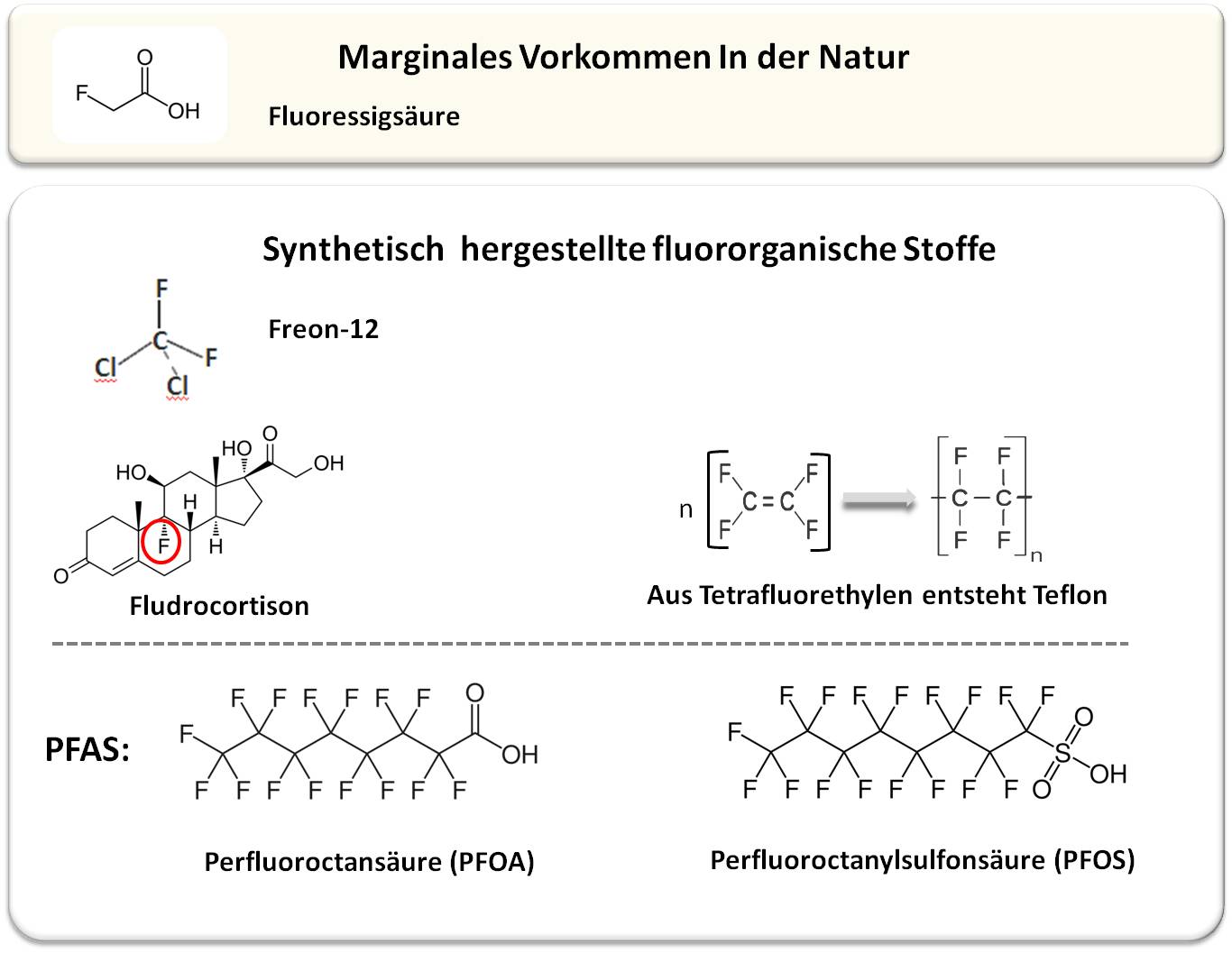

Obwohl Fluor zu den am häufigsten vorkommenden Elementen der Erdkruste zählt, hat die belebte Natur von der Schaffung fluorierter organischer Verbindungen abgesehen, da sie offensichtlich mit den über die Evolution entwickelten und erprobten Kohlenstoff-Wasserstoff-Systemen inkompatibel sind. Vor 70 Jahren haben synthetisch hergestellte fluororganische Verbindungen, insbesondere per- und polyfluorierte Alkylverbindungen (PFAS) ihren Siegeszug durch die Welt angetreten. Deren herausragende Eigenschaften - Widerstandsfähigkeit gegenüber chemischen Verbindungen aller Art, Hitze und Wasser - haben sich leider auch als enorm hohe Persistenz gegenüber natürlich entstandenen Abbaumechanismen erwiesen. Dass PFAS in Umwelt und Organismen akkumulieren, war den führenden Industrieunternehmen schon länger bekannt, im Bewusstsein der akademischen Welt und der Bevölkerung samt ihren zögerlich agierenden Vertretern ist das Problem erst im Jahr 2000 angekommen.

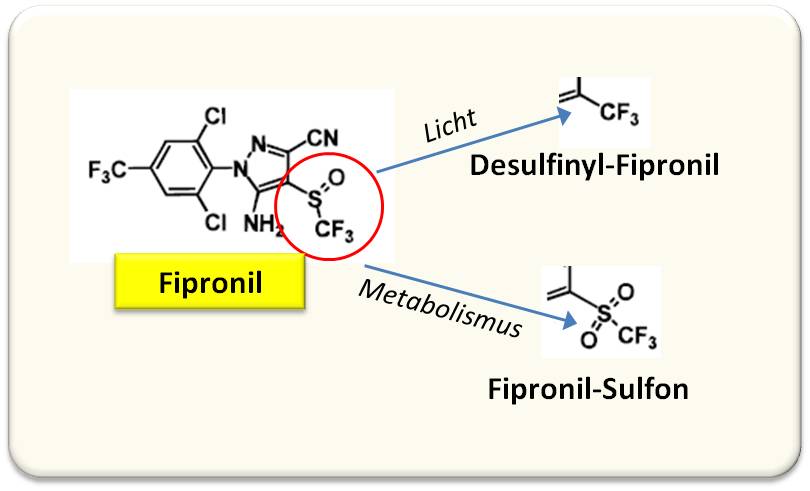

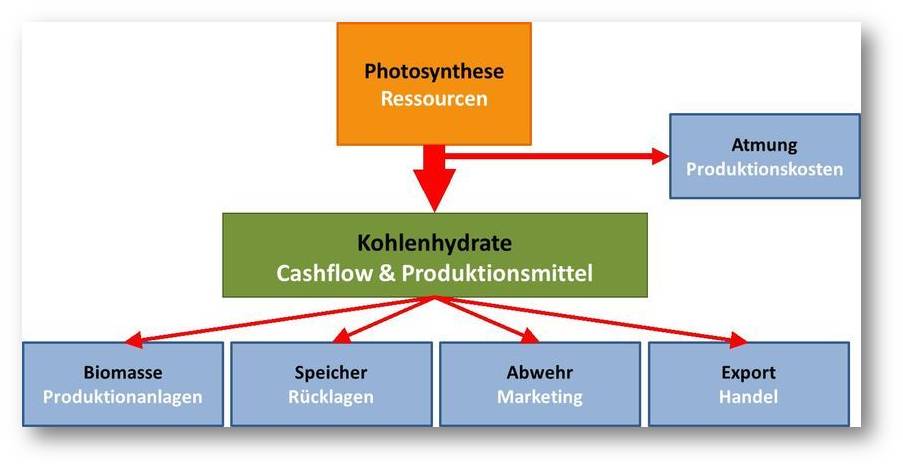

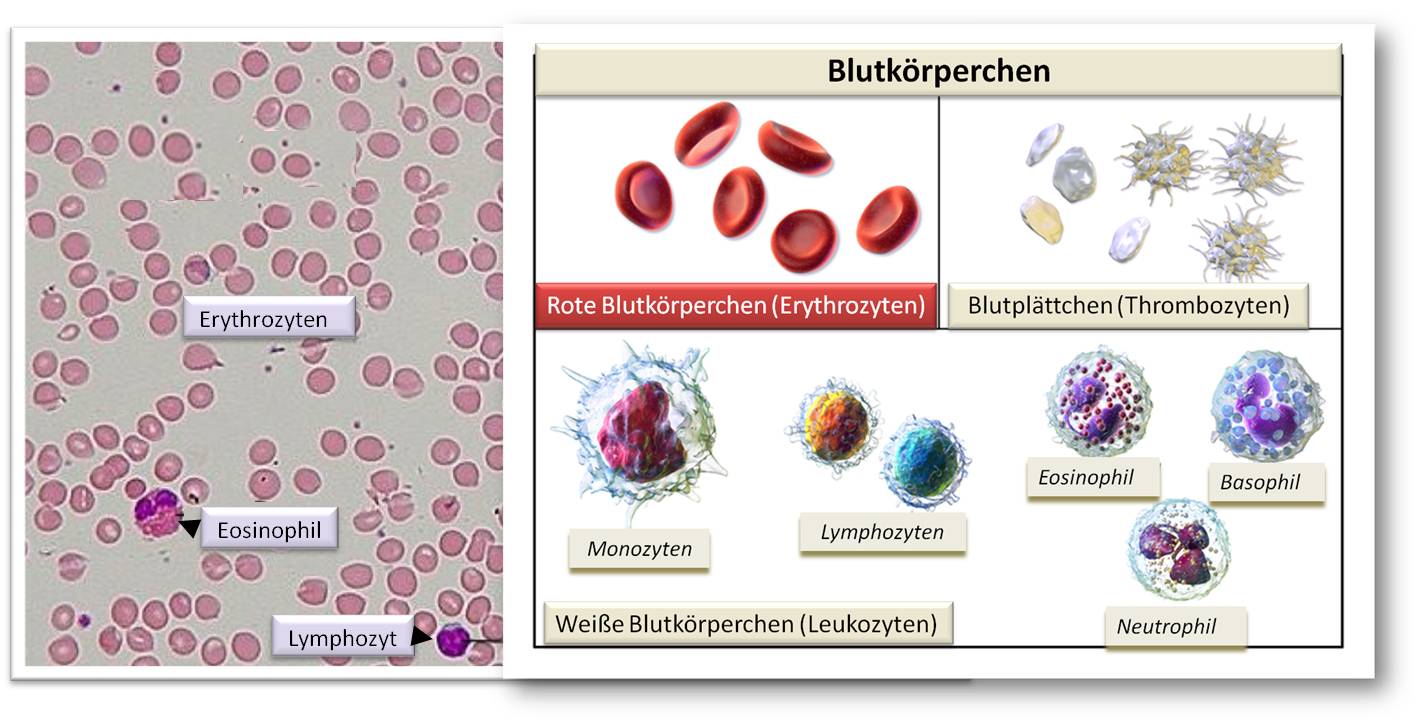

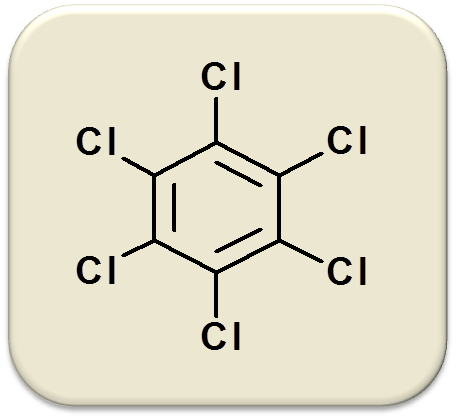

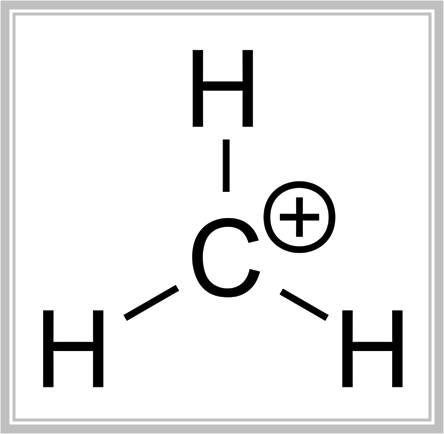

Fluor, das leichteste Element aus der Grupe der Halogene (7. Hauptgruppe im Periodensystem, die auch Chlor, Brom und Jod enthält) ist extrem reaktiv und bildet mit nahezu allen Elementen des Periodensystems enorm feste Verbindungen. In der Erdkruste gehört Fluor zu den am häufigsten vorkommenden Elementen und liegt hier in Form von anorganischen Verbindungen - in Mineralien wie u.a. Flussspat, Fluorapatit und Kryolith - vor. Von minimalen Ausnahmen abgesehen hat die belebte Natur allerdings für Fluor keine Verwendung gefunden: Seitdem vor rund 80 Jahren die erste natürlich entstandene Fluorkohlenstoff-Verbindung, die Fluoressigsäure (CH2FCO2H, Abbildung 1), entdeckt wurde, hat man trotz immer besser werdender Analysemethoden und einer immer größeren Fülle an untersuchbarer Spezies erst um die 30 natürlich entstandene Fluorkohlenstoff-(fluororganische)-Verbindungen gefunden, zumeist von der Fluoressigsäure abgeleitete Fluor-Fettsäuren und Fluoraminosäuren. Deren Vorkommen ist auf einige wenige Pflanzenarten, Bakterienstämme (Streptomyces) und eine Meeresschwammart beschränkt. Die bereits erwähnte Fluoressigsäure wird u.a. vom südafrikanischen Strauch Gifblaar synthetisiert und - offensichtlich zur Abwehr von Fressfeinden - in dessen Blättern gespeichert: es ist eine hochgiftige Verbindung, es heißt: "ein Blatt reicht um eine Kuh zu töten". Die Toxizität beruht auf der strukturellen Ähnlichkeit mit der Essigsäure, die eine zentrale Rolle im Stoffwechsel aller aerober Organismen spielt: Fluoressigsäure wird an deren Stelle in den Citratzyklus eingeschleust und bringt diesen zum Erliegen.

|

Abbildung 1: Fluororganische Verbindungen werden nahezu ausschließlich synthetisch durch Menschenhand hergestellt. Beschreibung der abgebildeten Substanzen im Text. |

Die Natur verzichtet auf fluororganische Verbindungen

Die Bindung von Fluor an Kohlenstoff ist die stärkste Einfachbindung in der organischen Chemie, bei weitem stärker als dessen Bindung zu den anderen Elementen Wasserstoff, Sauerstoff, Stickstoff, Schwefel und Phosphor und sie nimmt an Stärke noch zu, wenn mehrere Fluoratome am selben Kohlenstoff gebunden sind, wie beispielsweise im Tetrafluorkohlenstoff (CF4) mit einer Dissoziationsenergie von 130 kcal/mol oder in den künstlich hergestellten Per- und Polyfluoralkyl Stoffen.

Wird in einer Kohlenstoff-Wasserstoffbindung der Wasserstoff durch ein Fluoratom ersetzt, so ändert sich die Größe des gesamten Moleküls nur wenig, da der Atomradius von Fluor nicht viel größer als der von Wasserstoff ist. Das modifizierte Molekül wird meistens noch in die Bindungsstelle seines vormaligen Enzyms, seines vormaligen Rezeptors passen; allerdings haben sich seine Gesamteigenschaften verändert und damit die Spezifität und Stärke der Bindung und damit die Auswirkungen auf den vormaligen Rezeptor/das Enzym und dessen Funktion im Stoffwechsel verändert: i) Der Ersatz von Wasserstoff kann aber zu einer anderen Stereochemie des Moleküls geführt haben, wenn ein asymmetrisches (im Spiegelbild nicht deckungsgleiches - chirales) C-Atom entstanden ist. ii) Da Fluor das elektronegativste, d.i. das am stärksten Elektronen anziehende Element ist, weist die Kohlenstoff-Fluorbindung ein Dipolmoment (δ+C–δ−F) mit negativer Teilladung am Fluor auf. Fluor kann so mit (partiell) positiv geladenen Atomen wie dem an Sauerstoff oder Stickstoff gebundenen Wasserstoff Bindungen - Wasserstoffbrücken - ausbilden. (Auswirkungen eines teilweisen Einbaus von Fluor auf die Basenpaarungen der DNA oder auf die Wechselwirkungen zwischen Proteinen? Undenkbar) iii) Mit der Einführung von Fluor hat die Lipophilie der Verbindung und damit die Löslichkeit in und der Durchtritt durch Membranen zugenommen. iv) Wenn es vor allem um den Abbau/das Recyceln der fluorierten Verbindung geht - die Kohlenstoff-Fluor-Bindung lässt sich durch bereits entwickelte Enzymsysteme nicht so leicht wie eine Kohlenstoff- Wasserstoff-Bindung auflösen.

In Summe: fluorierte organische Verbindungen erweisen sich als nur wenig kompatibel mit den über die Evolution entwickelten und erprobten Kohlenstoff-Wasserstoff-Systemen.

Fluororganische Verbindungen sind also anthropogen

Die Produktion derartiger Stoffe begann vor 90 Jahren mit dem Halogenkohlenwasserstoff Freon-12 (Dichlordifluormethan - CCl2F2; Abbildung 1), einem ungiftigen, verflüssigbaren Gas, das als Kältemittel in Kühlsystemen und später auch als Treibgas in Sprühdosen eingesetzt wurde. Als erkannt wurde, dass Freon und weitere Halogenkohlenwasserstoffe auf die schützende Ozonschicht der Erde zerstörend wirken, wurde deren Herstellung und Verwendung ab 1987 über das Montreal Protokoll verboten.

Zwei Entwicklungen haben dann einen ungeahnten Boom an synthetisch produzierten Fluorverbindungen ausgelöst.

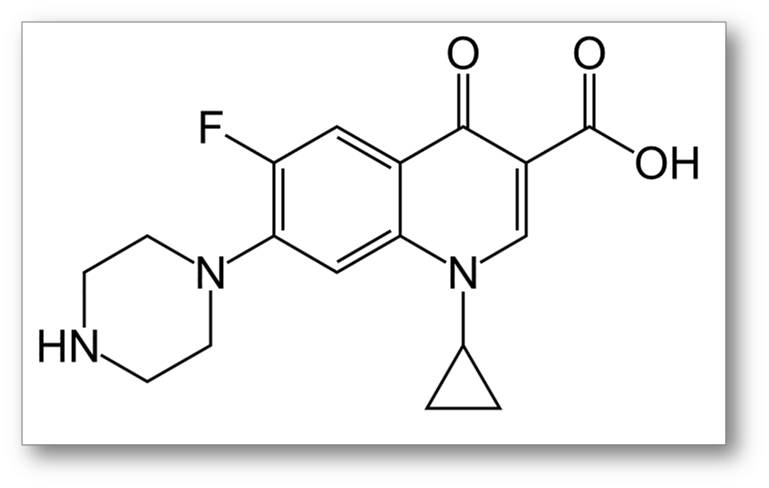

In der medizinischen Chemie

wurde 1954 mit dem Aldosteronderivat Fludrocortison (Abbildung 1) erstmals ein fluoriertes Pharmazeutikum erfolgreich auf den Markt gebracht, das von der WHO in die Liste der essentiellen Arzneimittel aufgenommen wurde. Die gezielte Einführung von Fluor gehörte bald zu den aussichtsreichsten Strategien der medizinischen Chemie, um die Wirkdauer und insgesamt die Wirksamkeit von Entwicklungssubstanzen zu optimieren. Zwei Fluor-Effekte sind dabei von besonderer Bedeutung: i) Fluorierung an Schwachstellen, d.i. an leicht metabolisierbaren Stellen eines Moleküls soll diese Reaktionen erschweren/verhindern und damit die biologische Stabilität der Verbindung und dadurch deren Blutspiegel und Wirkdauer erhöhen. ii) Fluorierung erhöht den lipophilen Charakter von Molekülen und soll so deren Durchtritt durch Lipidmembranen und damit deren Aufnahme in den Organismus und in seine Zellen erleichtern.

In den letzten 3 Jahrzehnten hat der Anteil der fluorierten Wirkstoffe besonders stark zugenommen - bis zu 50 % der neu registrierten synthetischen Pharmaka enthalten heute ein oder mehrere Fluorgruppen und insgesamt über 20 % aller derzeit im Handel erhältlichen Arzneimittel sind bereits Fluorpharmazeutika.

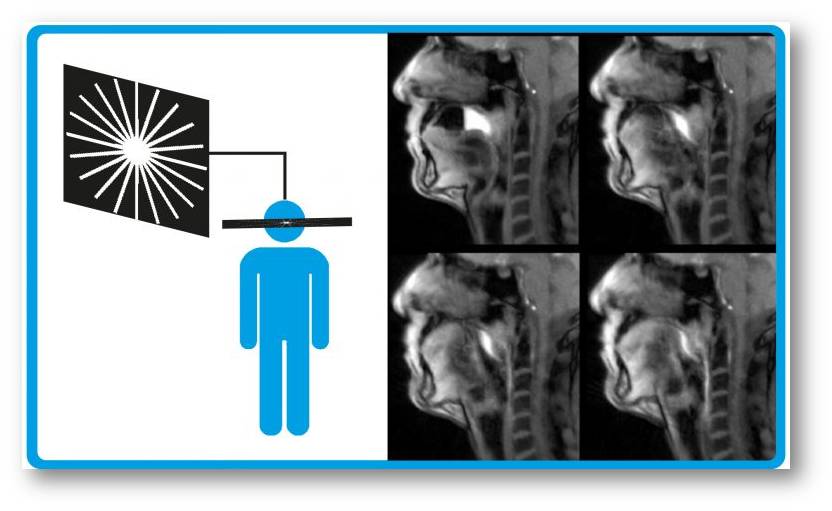

Neue Untersuchungen weisen allerdings auch auf eine Kehrseite der Fluorierung hin: In chemisch instabilen Molekülen und im Verlauf von enzymatischen Reaktionen kann auch die sehr feste Kohlenstof-Fluor-Bindung heterolytisch gespalten werden (d.i. die Bindungselektronen bleiben am Fluor) und Fluorid (F-) wird freigesetzt [Yue Pan, 2019]. Diese Freisetzung lässt sich sehr gut an verschiedenen, mit dem 18Fluor-Isotop markierten Verbindungen verfolgen, die zur Diagnose und auch zur Therapie diverser Tumoren in der Positron-Emissionstomographie (PET) eingesetzt werden (beispielsweise: [Ying-Cheng Huang et al.2016]).

Chronisch anhaltende Fluorid-Zufuhr von täglich mehr als 10 mg Fluorid kann zu schmerzhaften Veränderungen in Knochen und Gelenken (Skelettfluorose) führen. Ein klinisch belegtes Beispiel für die Freisetzung von Fluorid und dessen Folgen bietet das Antimykotikum Voriconazol, das bei Langzeittherapie zu erhöhten Fluoridspiegeln im Plasma und als Folge zu schmerzhaften Beinhautentzündungen und Knochenwucherungen führen kann.

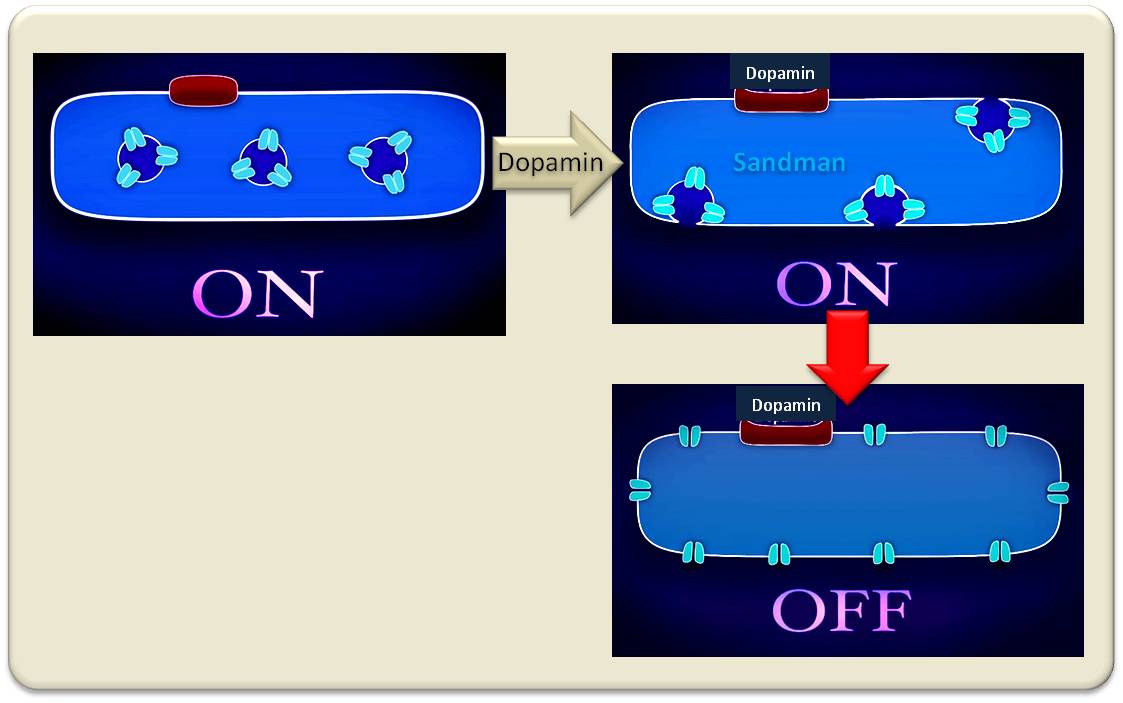

In industriellen Anwendungen

hat die Entdeckung von Teflon (Polytetrafluorethylen, Abbildung 1) und seinen herausragenden Eigenschaften seit den 1950er Jahren zur Entwicklung von mehr als 10 000 unterschiedlichen Stoffen aus der Kategorie der per- und polyfluorierten Alkylverbindungen (PFAS) geführt; dies sind Verbindungen an denen die Wasserstoffatome an den Kohlenstoffatomen ganz oder teilweise durch Fluoratome ersetzt sind (Abbildung 1). Aufgrund der Chemikalienbeständigkeit und wasser-, hitze-, und schmutzabweisenden Eigenschaften wurden und werden PFAS in diversesten Artikeln eingesetzt. Das Spektrum reicht von Feuerlöschschaum bis hin zu wasserdichter Bekleidung, von schmutzabweisenden Beschichtungen bis zu antihaftbeschichtetem Kochgeschirr, von Dichtungsmaterial bis hin zu in Chemielabors und in der Medizintechnik verwendeten inerten Materialien. Zwei der in verschiedenen Anwendungen am häufigsten verwendeten PFAS-Verbindungen sind Perfluoroctansäure (PFOA) und Perfluoroctansulfonsäure (PFOS) (Abbildung 1). Diese langkettigen Stoffe entstehen durch Umweltprozesse auch aus anderen instabileren PFAS.