Fr, 20.02.2015 - 08:04 — Peter Schuster

![]()

Die Biologie befindet sich im Wandel von einer beobachtenden zu einer quantifizierenden Wissenschaft. Stochastische Modellierungen ermöglichen komplexe biologische Systeme wie lebende Zellen und sogar ganze Organismen auf dem molekularen Niveau vollständig zu beschreiben. Der theoretische Chemiker Peter Schuster zeigt die zentrale Rolle auf, die Mathematik und Computerwissenschaften in den modernen Naturwissenschaften spielen*.

In den vergangenen 50 Jahren hat es in den Naturwissenschaften einen ungeheuren technischen Fortschritt gegeben. Es wurden neue experimentelle Techniken entwickelt und die Auflösung konventioneller Methoden enorm verbessert. Damit ist es möglich geworden in kleinste Einheiten des Raumes und der Zeit vorzustoßen: bei einer immer weiter verringerten Probengröße können nun Untersuchungen an einzelnen Molekülen ausgeführt werden. Spektroskopische Methoden erlauben bisher unvorstellbare Einblicke in Prozesse, die im Zeitbereich von 100 Attosekunden – 100 Trillionstel – Sekunden ablaufen. Viele Messdaten sind auch von ausreichender Genauigkeit, um Fluktuationen direkt bestimmen zu können.

Beobachtungen an einzelnen Partikeln sind heute bereits Routine geworden. Um nicht nur diese Prozesse erfolgreich analysieren und interpretieren zu können, bedarf es allerdings eines tieferen Verständnisses von Wahrscheinlichkeitsrechnung und Statistik – gleichgültig ob es sich nun um Versuchsansätze in Physik, Chemie oder Lebenswissenschaften handelt.

Dennoch werden Statistik und die Behandlung stochastischer Prozesse in der Ausbildung von Chemikern und Biologen häufig vernachlässigt. Die Konsequenz ist fatal: fehlt dem Experimentator eine diesbezügliche, solide mathematische Basis, führt das Erheben von Daten und deren Reproduktion zwangsläufig zu fehlerhaften Interpretationen.

Vom Beobachten zum Beschreiben realer Vorgänge

Reale Vorgänge sind komplex. Wegen der vielen Parameter, von denen sie abhängen, können wir niemals die volle Information zur ihrer Beschreibung ermitteln. Und selbst, wenn dies möglich wäre, bliebe alles im Rahmen quantenmechanischer Unschärfe unbestimmt. In derartigen Vorgängen können für die Abfolge einzelner Schritte daher nur Wahrscheinlichkeiten angegeben werden, es sind Zufallsprozesse- sogenannte stochastische Prozesse.

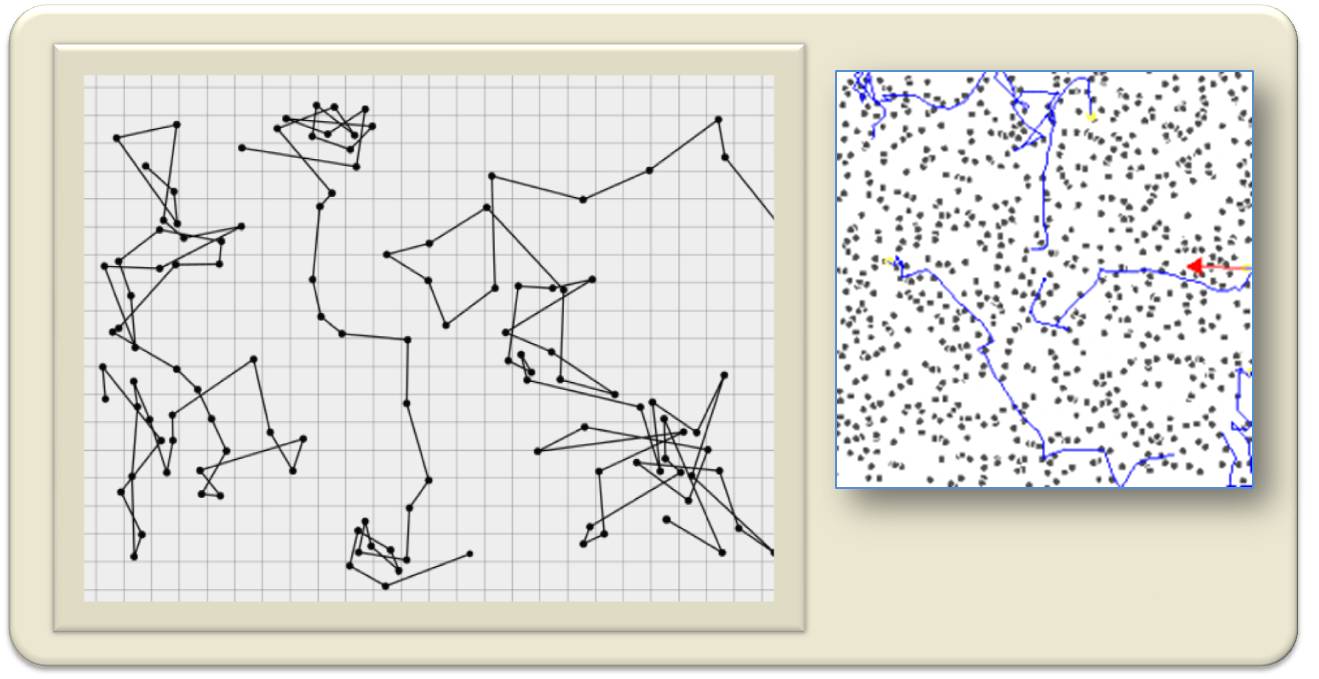

Die Brownsche Bewegung als Beispiel eines stochastischen Prozesses. Auf Grund der Wärmebewegung stoßen Moleküle aus allen Richtungen laufend mit größeren Teilchen zusammen und verursachen deren Richtungsänderungen, die unter dem Mikroskop beobachtet werden können. Links: Pfad von 3 Teilchen; historische Reproduktion (ced J.B. Perrin, "Mouvement brownien et réalité moléculaire," Ann. Chim Phys (VIII) 18, 5-114, 1909). Rechts : Computersimulation: Pfad (blau) von 5 größeren Partikel durch einen Set von 800 kleineren Partikeln. (Bilder : Wikipedia)

Die Brownsche Bewegung als Beispiel eines stochastischen Prozesses. Auf Grund der Wärmebewegung stoßen Moleküle aus allen Richtungen laufend mit größeren Teilchen zusammen und verursachen deren Richtungsänderungen, die unter dem Mikroskop beobachtet werden können. Links: Pfad von 3 Teilchen; historische Reproduktion (ced J.B. Perrin, "Mouvement brownien et réalité moléculaire," Ann. Chim Phys (VIII) 18, 5-114, 1909). Rechts : Computersimulation: Pfad (blau) von 5 größeren Partikel durch einen Set von 800 kleineren Partikeln. (Bilder : Wikipedia)

Natürlich gibt es auch Vorgänge, wo man offensichtlich auf Wahrscheinlichkeitsrechnung und Statistik verzichten kann – da die sogenannte deterministische Beschreibung zum Ziel führt . Hier ist jeder Schritt kausal von dem vorherigen abhängig und wird durch diesen vollständig bestimmt. Daher lässt die Kenntnis über einen Zustand eine präzise Vorhersage über andere Zustände zu. Zu deterministischen Vorgängen gehören beispielsweise die Bewegungen der Planeten und Monde, die sich mittels Differentialgleichungen darstellen lassen und als „Himmelsmechanik“ bereits den Beginn naturwissenschaftlicher Beschreibungen markierten. Die Fluktuationen sind so gering, dass sie nicht detektiert werden können, auch nicht mit Geräten höchster Präzision: Sonnenaufgang und –untergang, Sonnenfinsternisse können exakt vorhergesagt werden, praktisch ohne jede Streuung.

Ein weiteres deterministisches Beispiel ist die klassische Reaktionskinetik in der Chemie. Die Differentialgleichungen der Kinetik sind gleich anwendbar geblieben, ihre Ergebnisse haben auch im Licht der modernen Untersuchungen nichts an Überzeugungskraft eingebüßt. Dies ist darauf zurückzuführen, dass es sich hier um Prozesse mit sehr hohen Teilchenzahlen – zumeist sind es viele Trillionen von Teilchen – handelt. Daher bewegen sich Fluktuationen (proportional zu 1/Quadratwurzel aus der Teilchenzahl) in nicht mehr nachweisbar niedrigen Größenordnungen und Mittelwert-basierte Methoden sind zur Beschreibung geeignet. Was in der Kinetik jedoch enorm gesteigert werden konnte, ist die Auflösung der noch detektierbaren Materialmengen in Raum und Zeit. Dies verschafft tiefere Einblicke in die Reaktionsmechanismen und damit einen neuen Zugang zur Information über die Eigenschaften der Moleküle.

Der Wandel der Biologie…

Die Biologie befindet sich zurzeit im Umbruch: die Verbindung zur molekularen Wissenschaft Chemie hat die Erhebung biologischer Daten revolutioniert und bietet nun die Basis für eine neue theoretische Biologie.

In der Vergangenheit war die Biologie nahezu ausschließlich auf Beobachtungen basiert. Theoretische Überlegungen wurden nur in solchen Fällen angestellt, in denen beobachtete Regelmäßigkeiten augenscheinlich waren und durch eine Hypothese interpretiert werden konnten.

…zu einer quantifizierenden Wissenschaft

Die Entwicklung der Biochemie in der ersten Hälfte des 20.Jahrhunderts führte quantitatives Denken – in Form von chemischer Kinetik - in einigen Teilgebieten der Biologie ein. Auch den experimentellen Ansätzen der Biologie fügte die Biochemie eine neue Dimension hinzu: in vitro Untersuchungen an isolierten und gereinigten Biomolekülen.

Eine zweite Form, in der die Mathematik Einzug in die Biologie hielt, war die Populationsgenetik. Diese in den 1920er Jahren neu eingeführte theoretische Disziplin vereinigte Charles Darwins Prinzip der natürlichen Selektion und Gregor Mendels Vererbungsregeln. Es sollte noch zwanzig Jahre dauern, bis Evolutionsbiologen die „Synthetische Theorie der Evolution“ fertigstellten.

Von der zweiten Hälfte des 20. Jahrhunderts an begann die Molekularbiologie eine feste Brücke zwischen Chemie und Biologie zu bauen. Der enorme Fortschritt in den experimentellen Techniken schuf eine bis dahin unbekannte Situation für die Biologie. Auf die Sequenzierung der Proteine folgte die Sequenzierung der Nukleinsäuren, die Entschlüsselung der Genome unterschiedlichster Lebewesen und die Aufklärung der Gesamtheit aller Proteine – des Proteoms – in Organismen.

Ein ungeheures Volumen an Information, das die Kapazität menschlichen Überblickens überstieg, erforderte und erfordert weiterhin neue Verfahren im Umgang mit den Daten, mit deren Analyse und Interpretation.

Stochastische Methoden zur Modellierung komplexer biologischer Systeme

Wie Gene und Proteine im Kontext von Zellen funktionieren, wird durch die Analyse ihrer Prozesse ersichtlich. Wenn die Systembiologie anstrebt lebende Zellen und sogar ganze Organismen vollständig und zwar auf dem molekularen Niveau zu beschreiben, so sind es zig-Tausende molekulare player und noch mehr Wechselwirkungen zwischen diesen, die berücksichtigt und modelliert werden müssen.

Die Bewältigung der gegenwärtigen Datenflut, die sich von der Molekulargenetik und Genomik zur Systembiologie und Synthetischen Biologie ergießt, erfordert – außer den entsprechenden Hochleistungsrechnern – primär geeignete statistische Methoden und Wege Daten zu verifizieren und evaluieren. Die Analyse, Interpretation und schließlich das Verstehen der experimentellen Ergebnisse ist ohne Hilfe zweckentsprechender Modelle nicht möglich. In der Vergangenheit basierten derartige Modelle primär auf (deterministischen) Differentialgleichungen. Diese sind zweifellos ungeeignet, um komplexe Systeme zu beschreiben, in denen eine Vielzahl von Teilchensorten in nur wenigen Kopien vorkommt und damit hohen Fluktuationen unterliegt. Eine Erweiterung des Repertoires durch stochastische Modellierungen ist daher unabdingbar.

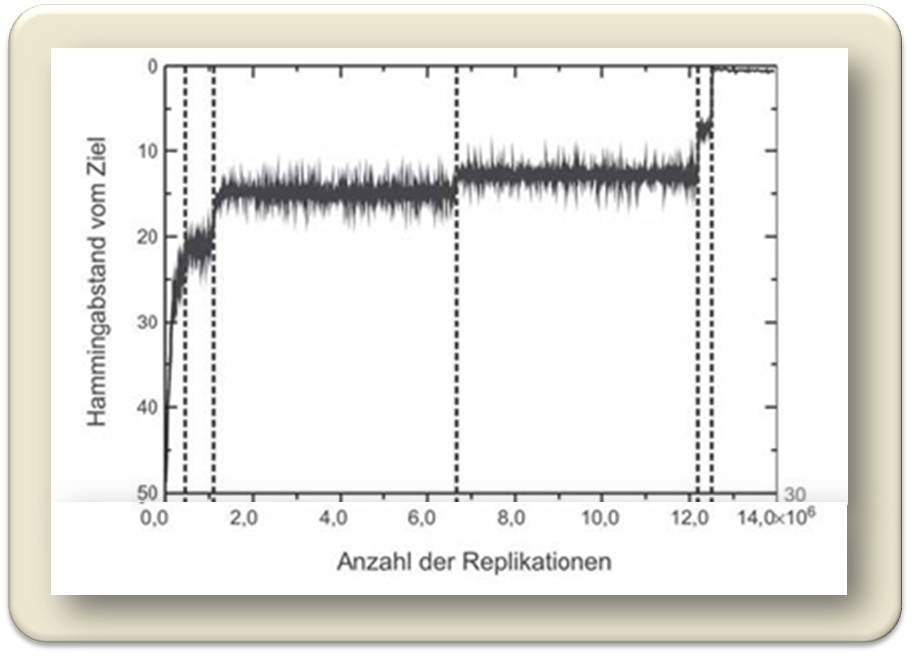

Der Pfad (Trajektorie) einer evolutionären Optimierung von RNA-Strukturen. In einer Population von N = 1000 RNA-Molekülen führen wiederholte Replikationen zur gewünschten Zielstruktur, die nach 14 Millionen Replikationen erreicht wird. Der mittlere Strukturabstand zu dieser Zielstruktur (Hammingdistanz) nimmt nicht kontinuierlich mit den Replikationen ab, sondern in ausgeprägten Stufen.

Der Pfad (Trajektorie) einer evolutionären Optimierung von RNA-Strukturen. In einer Population von N = 1000 RNA-Molekülen führen wiederholte Replikationen zur gewünschten Zielstruktur, die nach 14 Millionen Replikationen erreicht wird. Der mittlere Strukturabstand zu dieser Zielstruktur (Hammingdistanz) nimmt nicht kontinuierlich mit den Replikationen ab, sondern in ausgeprägten Stufen.

Darüber hinaus verlangt die außerordentlich hohe Komplexität der genetischen und metabolischen Netzwerke lebender Zellen nach gänzlich neuen Methoden der Modellierung, Methoden, die den Beschreibungen auf „mesoskopischem Niveau“ in der Festkörperphysik entsprechen (unter „mesoskopisch“ wird hier der Übergangsbereich zwischen etwa einem Nanometer und dem Mikrometerbereich verstanden).

Numerische Mathematik und Computer-Simulationen spielen heute eine entscheidende Rolle in stochastischen Modellierungen. Die Computerleistung – Rechenleistung und digitale Speicherkapazität – steigt seit den 1960er Jahren exponentiell an, mit einer Verdopplungsrate von 18 Monaten. Diese Steigerung wird von den Fortschritten in der numerischen Mathematik noch übertroffen und führt hier zu immer effizienteren Algorithmen.

Zentrale Rolle der Mathematik in den Lebenswissenschaften

In der Vergangenheit hatten Biologen oft mit „gemischten Gefühlen“ auf die Mathematik reagiert und waren überaus zurückhaltend, wenn „zu viel Theorie“ zur Anwendung kam. Die neuen Entwicklungen haben das Szenario völlig verändert. Die riesigen Datenmengen, die mit den neuen Techniken erhoben werden, können weder mit menschlichen Augen mehr gesichtet werden, noch mit menschlichen Gehirnen erfasst werden. Nur technisch ausgeklügelte Software kann dazu imstande sein und moderne Biologen müssen sich darauf verlassen. Die aktuellen Entwicklungen in der Molekularbiologie, Genomik und Biologie der Organismen scheinen diesen Umschwung im Denken der Biologen einzuleiten. Es besteht ja heute praktisch keine Möglichkeit mehr moderne Lebenswissenschaften ohne Mathematik und Computerwissenschaften zu betreiben.

Der berühmte britische Biologe und Nobelpreisträger Sidney Brenner hat 2002 diesen Wandel der Biologie und ihrer Forscher treffend mit dem diametralen Verhalten von Jägern und Sammlern verglichen:

„In der prägenomischen Ära wurde ich zum Jäger ausgebildet. Ich lernte wie man wilde Tiere erkennt und wie man hinausgeht, um sie zu jagen und zu erlegen. Jetzt zwingt man uns aber zu Sammlern zu werden, alles, was herumliegt einzusammeln und es in Lagerhäuser zu tragen. Eines Tages, nimmt man an, wird jemand kommen und die Lagerbestände sortieren, allen Mist entsorgen und die wenigen guten Funde behalten. Die einzige Schwierigkeit wird darin bestehen, diese zu erkennen.“

*Peter Schuster “Stochasticity in Processes. Fundamentals and applications to chemistry and biology” (Springer Verlag, Berlin 2016; im Erscheinen)

Weiterführende Links

Science Education: Computers in Biology. Website des NIH mit sehr umfangreichen, leicht verständlichen Darstellungen (englisch)

Magazin: systembiologie.de https://www.systembiologie.de/de/magazin

Matthias Rarey: An der Schnittstelle: Informatik trifft Naturwissenschaften ( Zentrum für Bioinformatik Hamburg (ZBH); Universität Hamburg). Sehr leicht verständliches Video (als Werbung für ein Bioinformatik Studium gedacht) 1:09:21 h.

Verena Wolf: Simulationen biochemischer Reaktionen (Cluster of Excellence MMCI, Saarbrücken) Video 5:26 min.

Artikel zu verwandten Themen im ScienceBlog:

Peter Schuster:

- 23.05.2015: Gibt es einen Newton des Grashalms?

- 28.03.2014: Eine stille Revolution in der Mathematik

- 03.01.2014: Computerwissenschafter — Marketender im Tross der modernen Naturwissenschaften

- 28.03.2013: Wie Computermethoden die Forschung in den Naturwissenschaften verändern

- 08.11.2012: Wie erfolgt eine Optimierung im Fall mehrerer Kriterien? Pareto-Effizienz und schnelle Heuristik

- 03.11.2011: Gibt es Rezepte für die Bewältigung von Komplexität?

Gerhard Weikum:

- 20.06.2014: Der digitale Zauberlehrling

- Printer-friendly version

- Log in to post comments