2023

2023 inge Thu, 05.01.2023 - 16:31Hämoglobin trägt zur Barrierefunktion unserer Haut bei

Hämoglobin trägt zur Barrierefunktion unserer Haut beiFr.29.12.2023 — Inge Schuster

Hämoglobin, der in den Erythrozyten zirkulierende Transporter von Sauerstoff, wird offensichtlich auch in anderen Zelltypen produziert. Eine neue Untersuchung zeigt erstmals, dass Hämoglobin in den obersten Schichten der Epidermis und auch in den Haarfollikeln gebildet wird. Es wird als Antwort auf oxidativen Stress - wie er beispielweise durch UV-Bestrahlung entsteht - in den Keratinozyten hochreguliert und kann dort die Generierung von reaktiven Sauerstoff-Spezies hemmen und die Zellen vor deren Folgen schützen. Die Expression von Hämoglobin ist somit eine neue Facette in der Barrierefunktion der Epidermis.

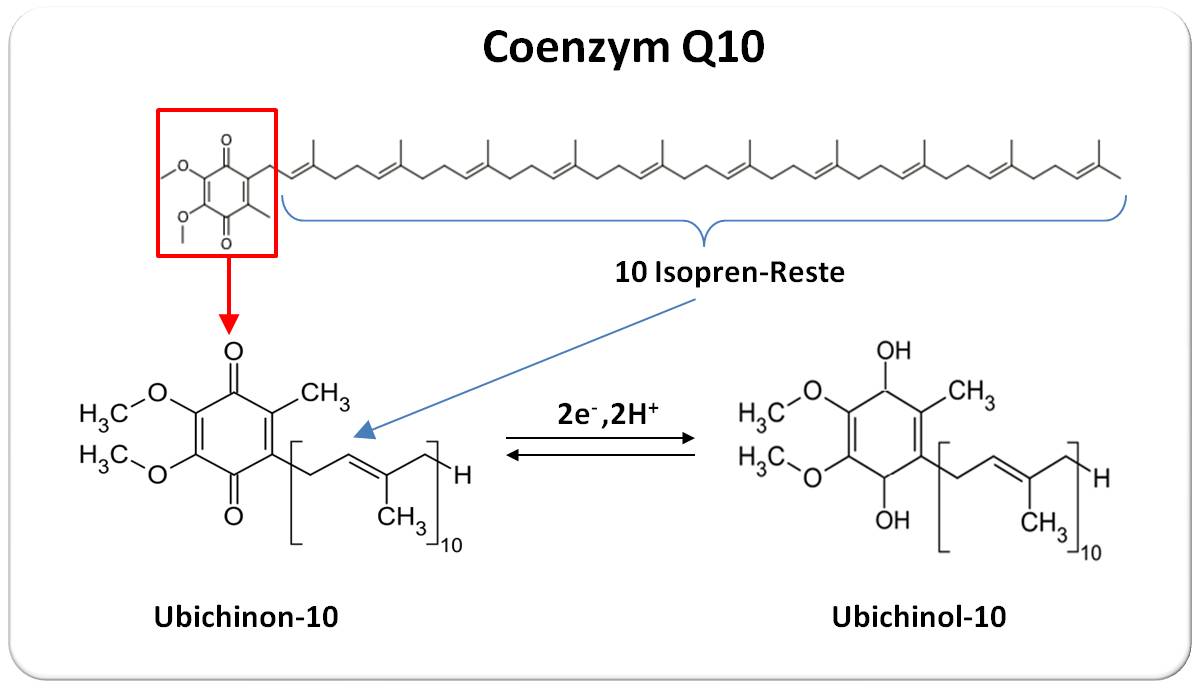

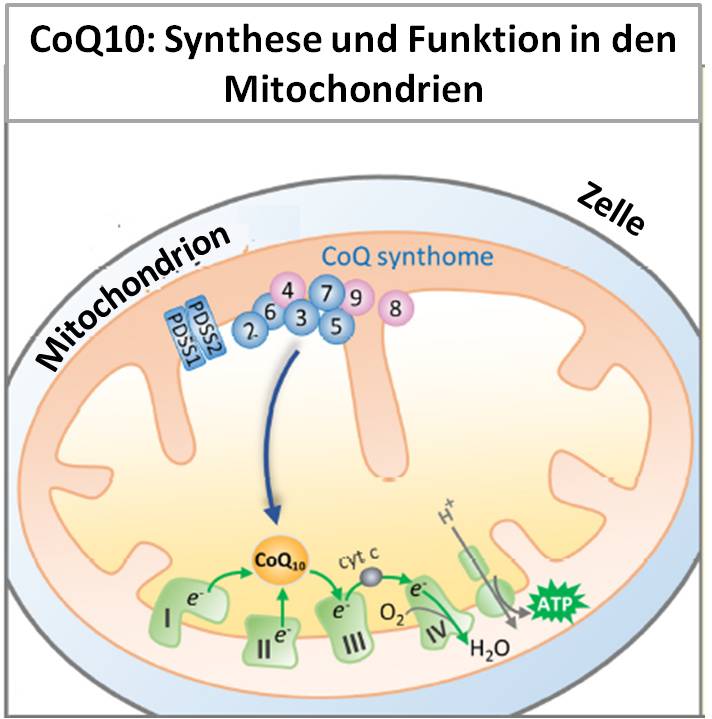

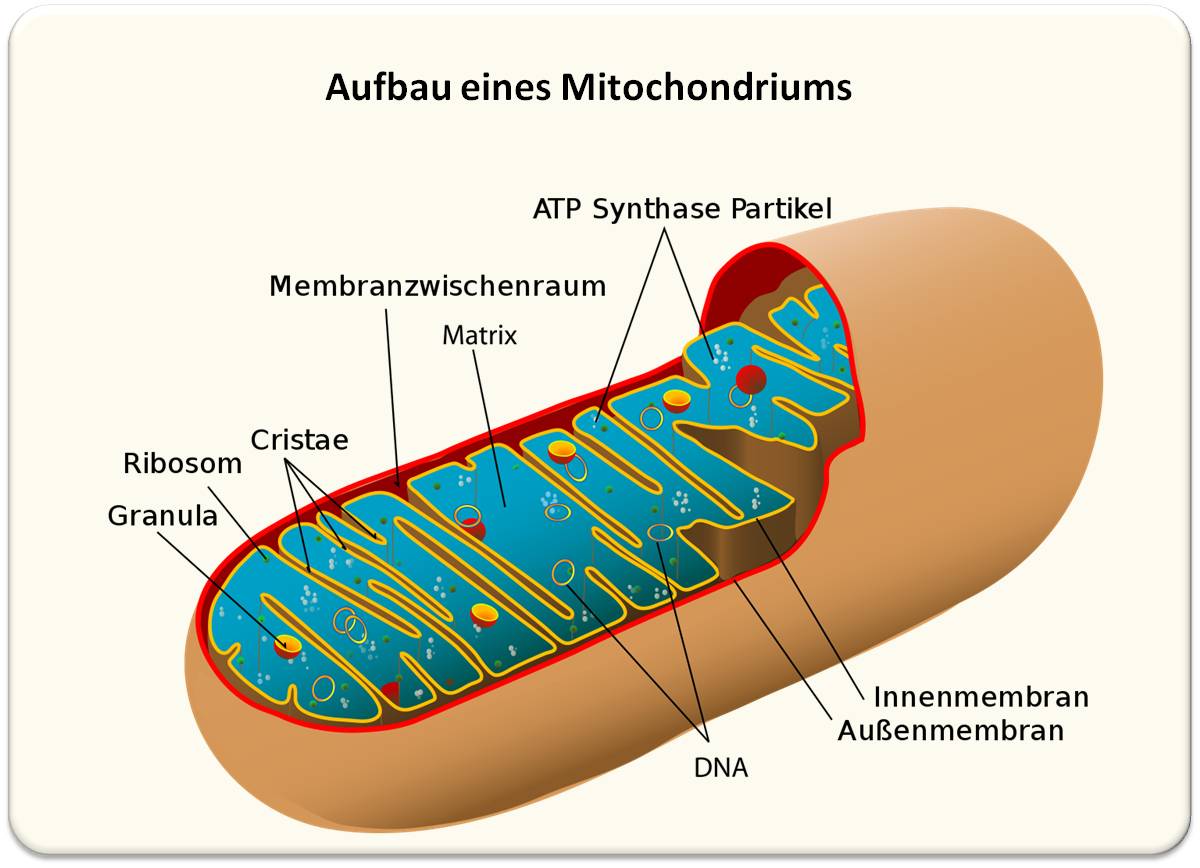

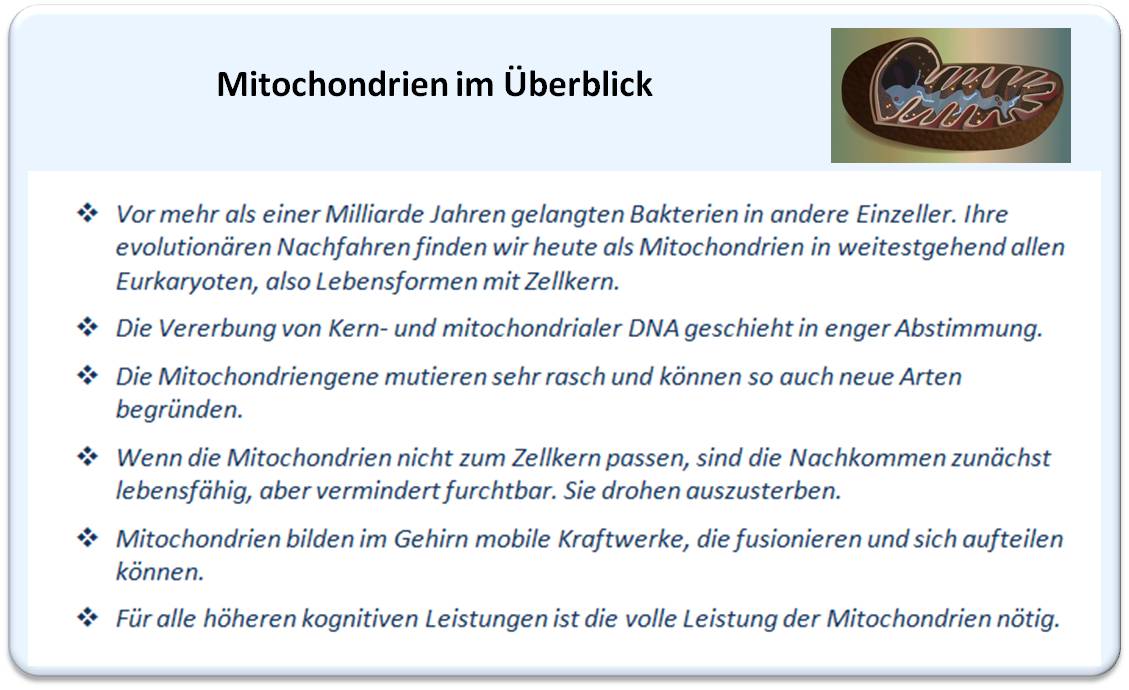

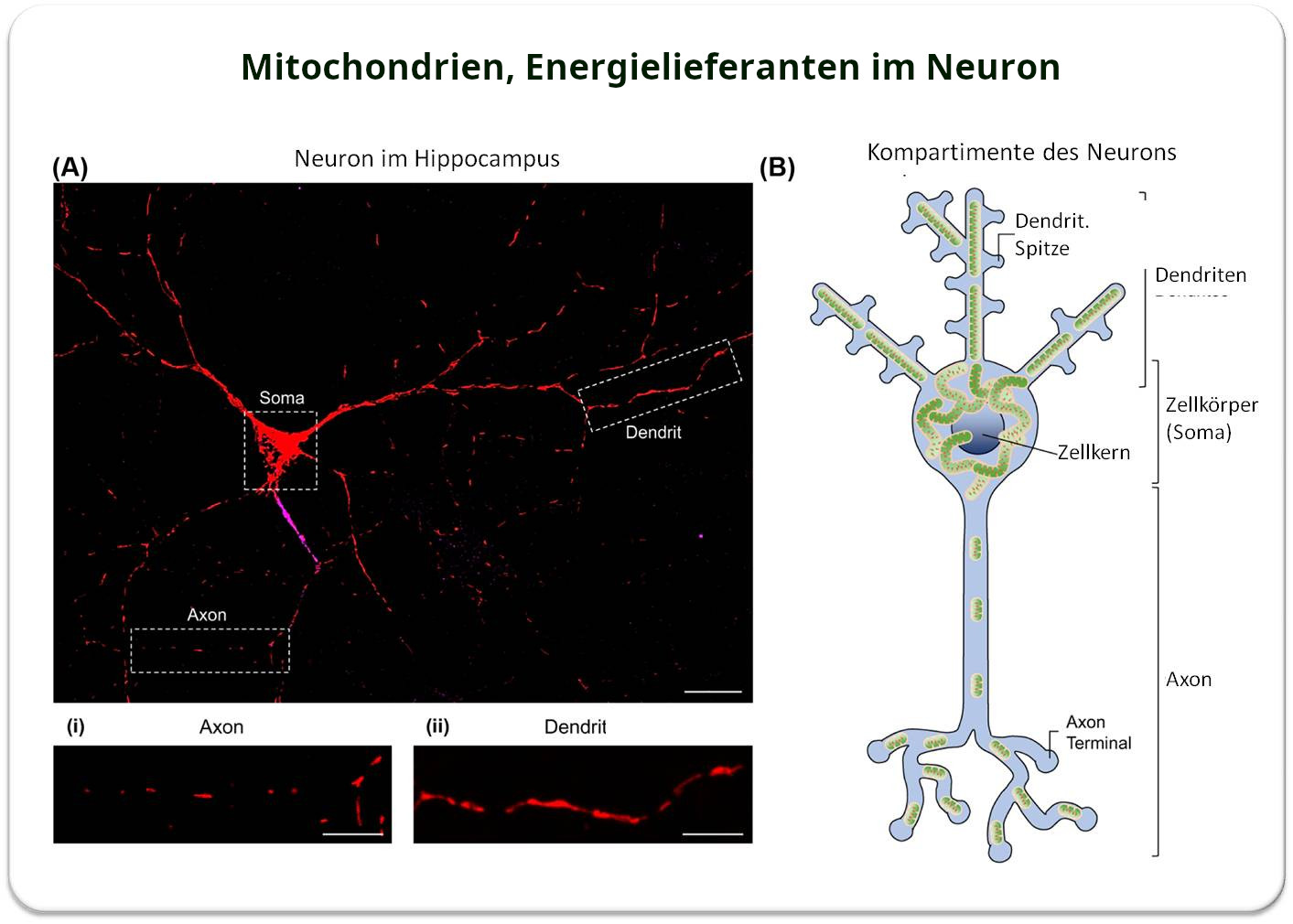

Mit Hämoglobin verbindet wohl jeder sofort den Blutfarbstoff in den roten Blutkörperchen, den Erythrozyten, der den in der Lunge eingeatmeten Sauerstoff (O2) über den Blutkreislauf zu den Zellen unserer Gewebe und Organe transportiert. Die ununterbrochene Versorgung mit Sauerstoff ist unabdingbar, um die zur Instandhaltung und zum Funktionieren unserer Körperzellen nötige Energie in den Mitochondrien (über Zellatmung und oxydative Phosphorylierung) zu erzeugen; Sauerstoff ist aber auch unentbehrlich, um die zahllosen Oxydationsvorgänge im Stoffwechsel - zu Synthese und Metabolismus von körpereigenen Substanzen und zum Abbau von Fremdstoffen - zu ermöglichen. Für den Sauerstofftransport steht dabei eine sehr hohe Kapazität zur Verfügung: Erythrozyten bestehen zu etwa 90 % (ihres Trockengewichts) aus Hämoglobin und machen bis zu 50 % des Blutvolumens aus; das entspricht 120 bis 180 Gramm Hämoglobin pro Liter (von insgesamt 5 Liter) Blut, wobei ein Gramm Hämoglobin 1,34 ml Sauerstoff binden kann, und ein Erwachsener bei körperlicher Ruhe rund 280 ml Sauerstoff pro Minute einatmet. Im Gegenzug zur Abgabe von Sauerstoff bindet Hämoglobin einen Teil (rund 23 %) des bei der Zellatmung freiwerdenden CO2, das dann über das Blut in die Lunge transportiert und dort abgeatmet wird.

Zur Charakterisierung von Hämoglobin

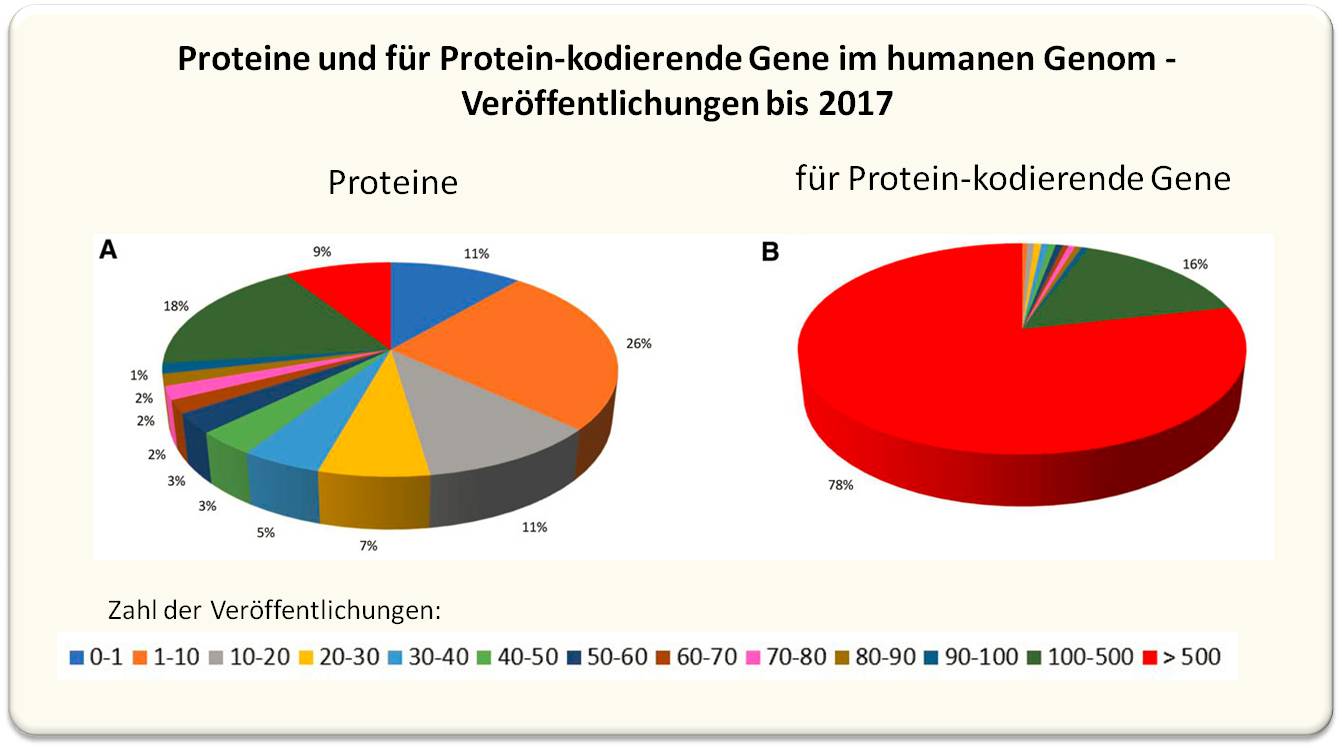

Seine lebensnotwendige Rolle und hohe Verfügbarkeit haben Hämoglobin zu einem der meistuntersuchten Proteine der letzten 150 Jahre gemacht. Dazu gehört auch, dass die ersten Röntgenkristall-Analysen von 3D-Proteinstrukturen an Hämoglobin (durch Max Perutz) und dem strukturverwandten, einfacher aufgebauten Myoglobin - dem Sauerstoff-Speicher in der Muskulatur - (durch John Kendrew) stattfanden und 1962 mit dem Nobelpreis ausgezeichnet wurden.

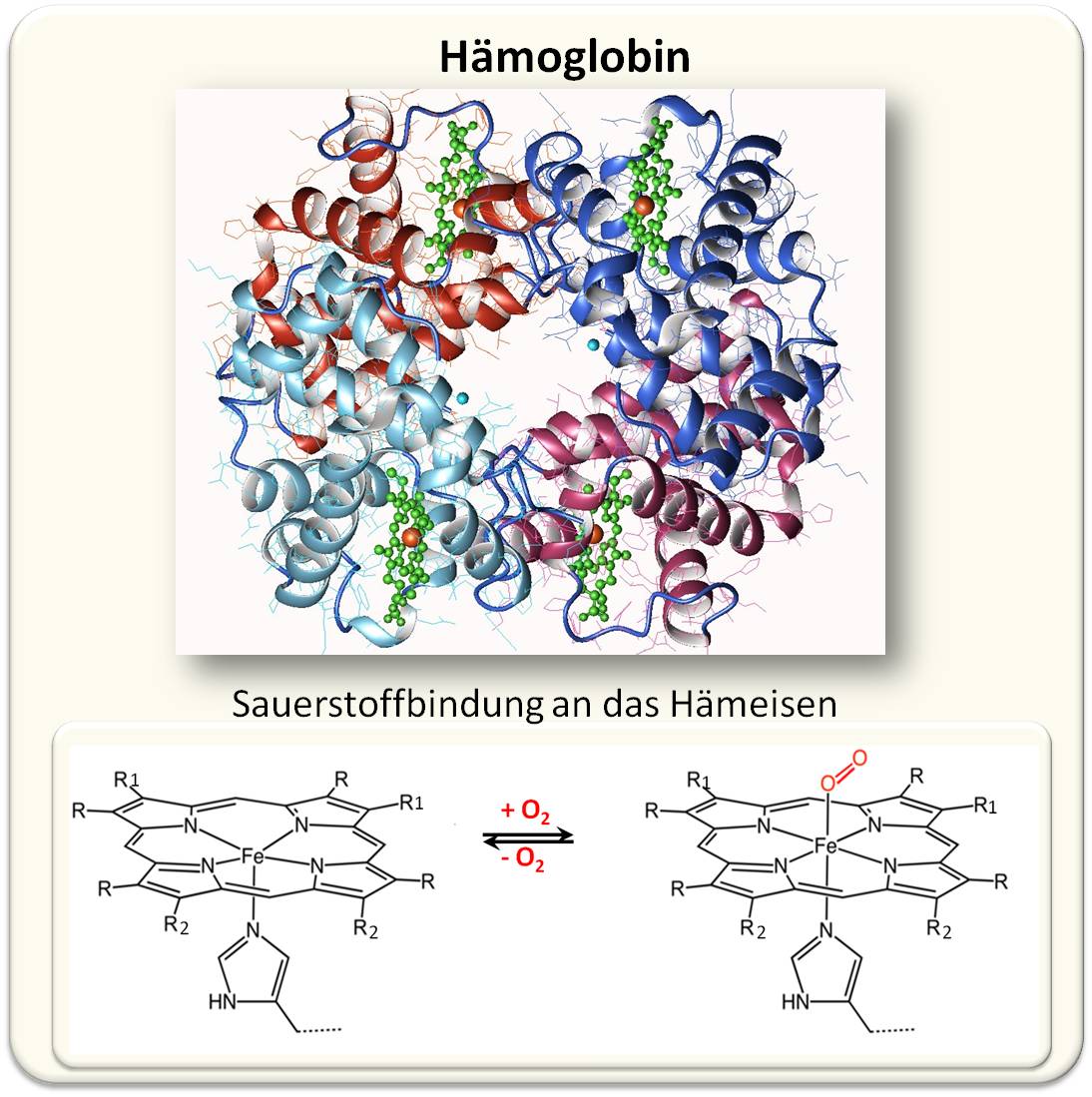

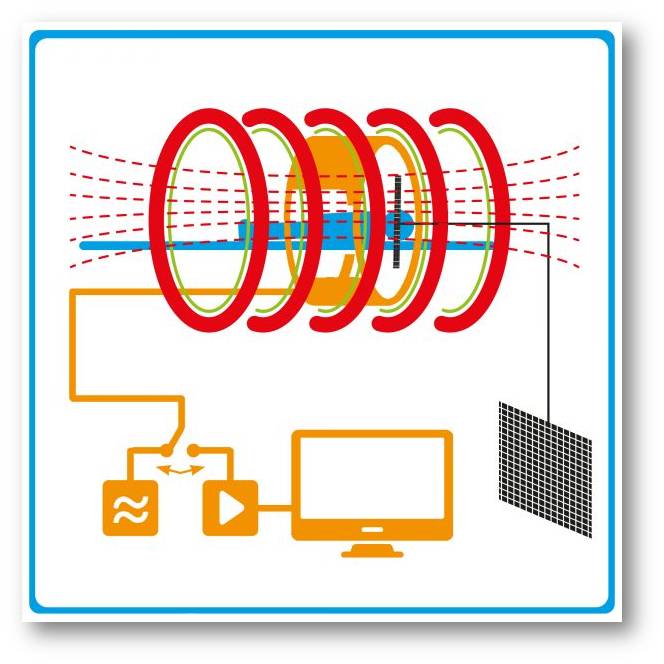

| Abbildung 1. Hämoglobin A (adulte Form - HbA) als Sauerstofftransporter. Das Bändermodell zeigt ein Tetramer aus je 2 αund 2 β Untereinheiten (Rot- und Blautöne), in die jeweils eine Hämgruppe - ein Protoporphyrin (grün) mit zentralem Eisenatom (rot) - über einen Histidinrest des Globins gebunden vorliegt. Sauerstoff bindet reversibel in der O2-Form an die 6. Koordinationsstelle des Hämeisens. (Bild: Fermi, G., Perutz, M.F. https://www.rcsb.org/structure/3hhb Lizenz: cc-by-sa) |

Demnach ist Hämoglobin aus 4 Untereinheiten aufgebaut; beim erwachsenen Menschen sind das jeweils 2 Hb α und 2 Hb β Globine. Jede dieser Untereinheiten besteht aus 142 bis 146 Aminosäuren langen Peptidketten, die jeweils 8 Helices bilden mit einer Tasche, in der das Häm - ein Porphyrin-Molekül mit einem Eisen Fe2+ als Zentralatom - eingebettet ist. Abbildung 1.

An Hämoglobin wurde in den 1960er-Jahren auch erstmals das Phänomen einer kooperativen Bindung entdeckt; im konkreten Fall: Wenn Sauerstoff als O2-Molekül an das Hämeisen einer Untereinheit bindet, induziert es darin eine Konformationsänderung, die sich auf die anderen 3 Untereinheiten überträgt und dort eine erleichterte Bindung der anderen 3 Sauerstoffmolküle zur Folge hat.

Hämoglobin kann auch andere chemische Gruppen binden und transportieren: Direkt an das Hämeisen binden beispielsweise Kohlenmonoxid (CO), Cyanid (CN-) oder Sulfid (S2-), hemmen dadurch die Bindung von Sauerstoff mit schwerwiegenden Folgen. An Aminogruppen der Globine binden Moleküle wie CO2 und das Signalmolekül Stickstoffmonoxid (NO), ein gefäßerweiterndes Gas.

Hämoglobin fungiert nicht nur als Transporter

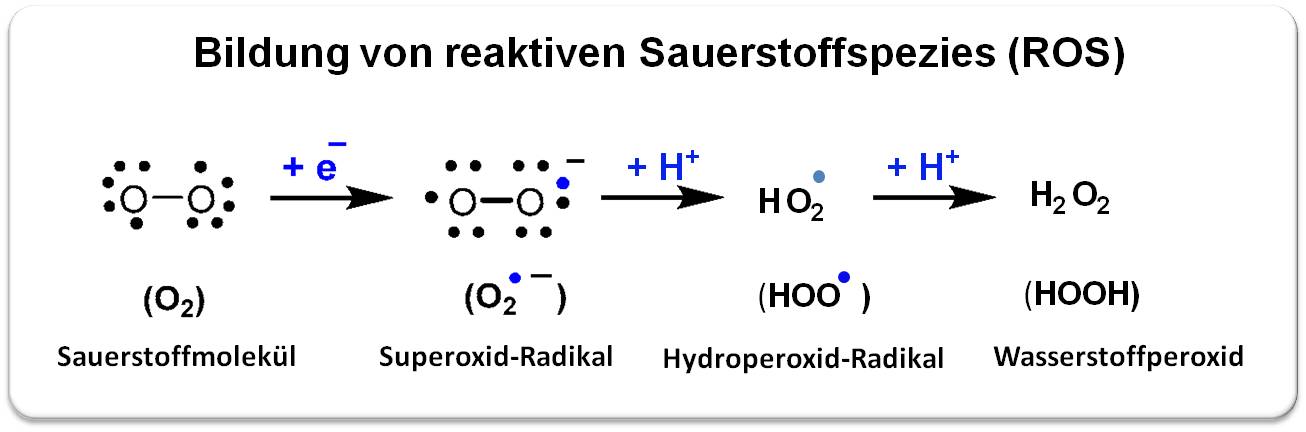

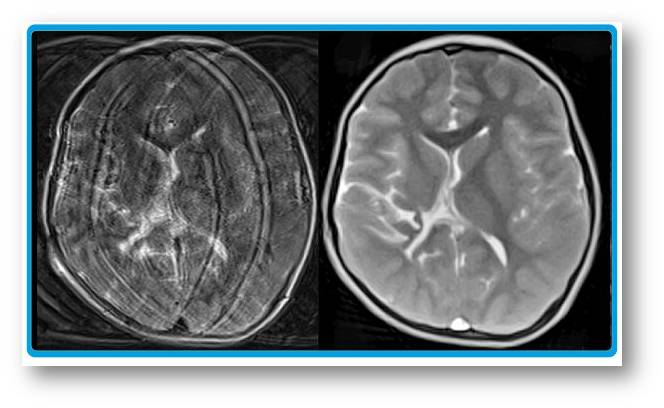

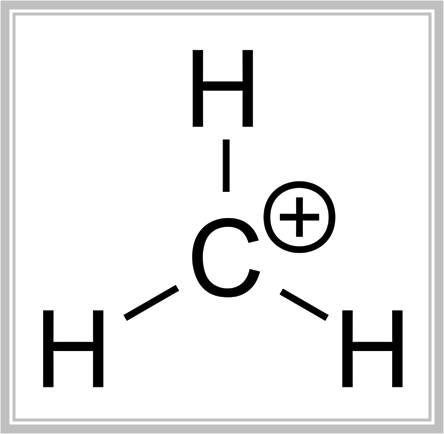

Es generiert auch reaktive Sauerstoffspezies. Bei der Bindung von Sauerstoff kommt es häufig zur Autooxidation von Hämoglobin: dabei wird das Hämeisen Fe2+ zu Fe3+ oxidiert (Methämoglobin) und gleichzeitig Sauerstoff zum Superoxid-Radikal reduziert, aus dem dann das Hydroperoxid-Radikal und in weiterer Folge Wasserstoffperoxid entstehen. Abbildung 2.

| Abbildung 2. Die Bindung von Sauerstoff an das Hämeisen führt häufig zur Generierung von reaktiven Sauerstoffspezies (ROS). Vereinfachte Darstellung. |

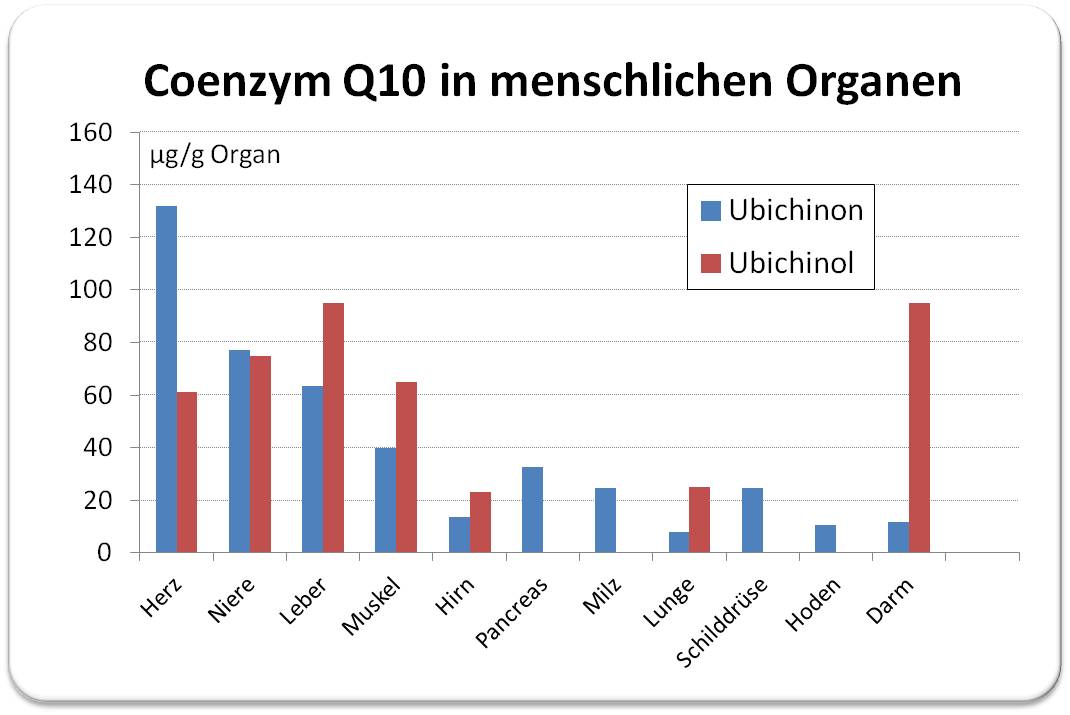

Die reaktiven Sauerstoffspezies reagieren (nicht nur) mit Hämoglobin und lösen eine Kaskade oxidativer Reaktionen aus, die zum Abbau des Häms, Freisetzung des Hämeisens (das freie Radikalreaktionen katalysiert), irreversiblen Vernetzungen der Globinketten und schlussendlich zum Abbau von Hämoglobin führen. Diese Reaktionen treten auch auf, wenn Hämoglobin oder Erythrocyten mit exogenem Wasserstoffperoxid reagieren, wie er bei anderen metabolischen Vorgängen (beispielsweise in den Mitochondrien) produziert wird und sogar, wenn Erythrozyten gelagert werden. Allerdings - solange Hämoglobin eingeschlossen in den Erythrozyten zirkuliert, schützt ein äußerst wirksames antioxidatives Abwehrsystem aus diversen Enzymen und endogenen niedermolekularen Substanzen wie Glutathion, Vitamin C, Coenzym Q10, etc. vor den kontinuierlich entstehenden reaktiven Sauerstoffspezies. Übersteigt die ROS-Produktion die Kapazität des Abwehrsystems, kommt es zu einer Beeinträchtigung der Sauerstoffzufuhr, Schädigung der Erythrozytenmembran verbunden mit dem Austritt von (geschädigtem) Hämoglobin und anderen Biomolekülen sowie ROS, die Entzündungsprozesse auslösen können.

Die Reaktion von Hämoglobin mit H2O2, die zur Zerstörung des Proteins führt, bedeutet gleichzeitig ein hochwirksame Neutralisierung von ROS und Schutz vor deren schädlichen Auswirkungen.

Hämoglobin wird auch außerhalb der Erythrozyten produziert.....

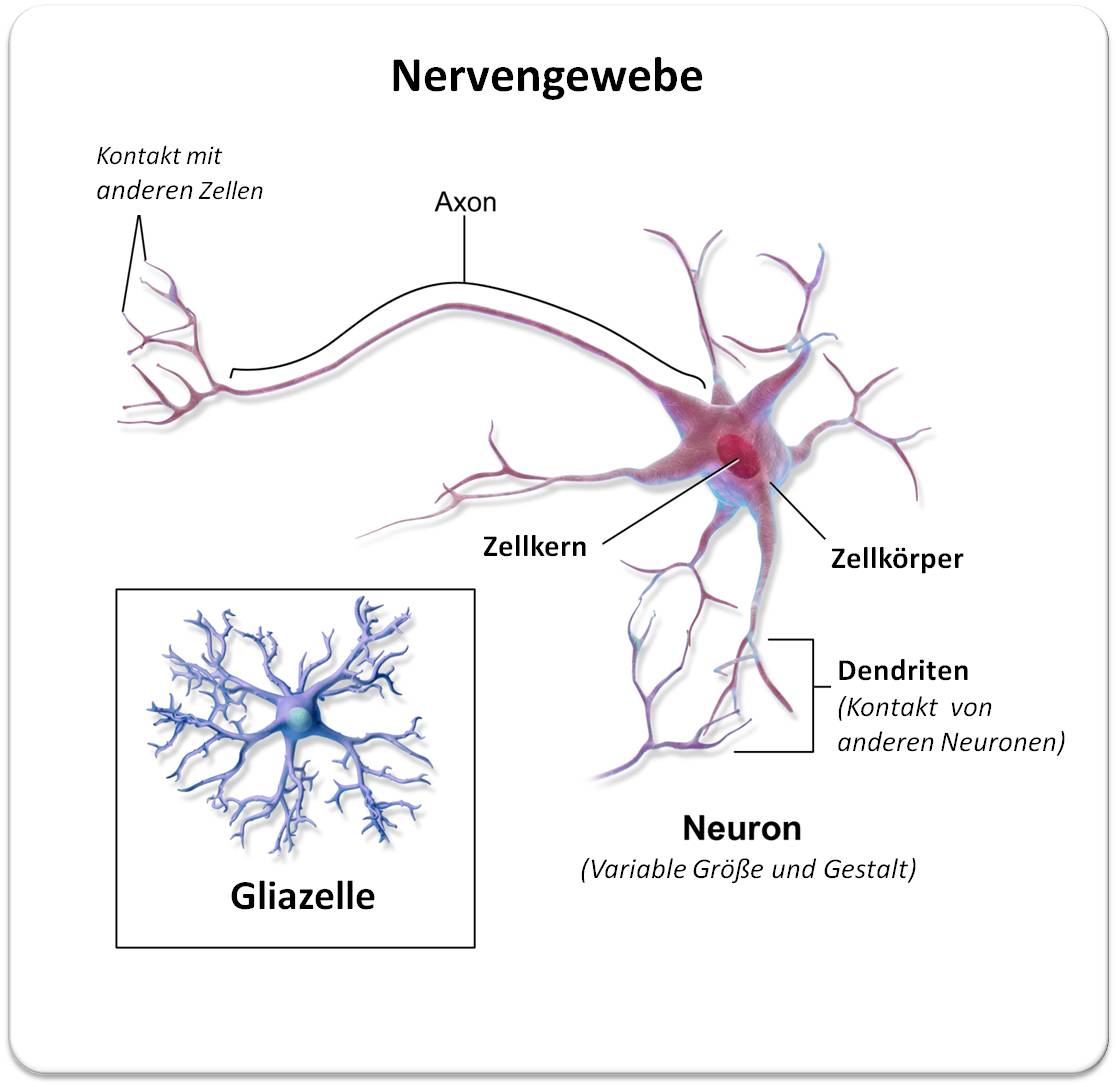

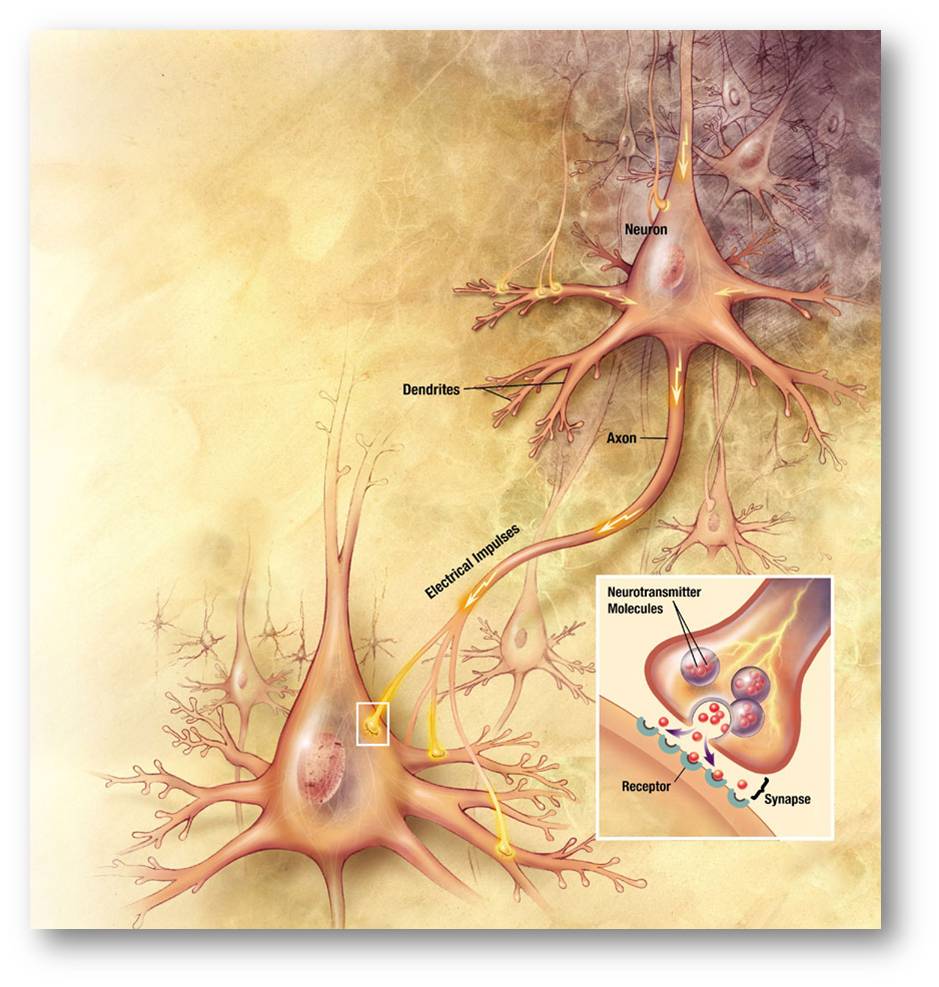

Dass Hämoglobin außerhalb der im Blutkreislauf zirkulierenden Erythrozyten eine Rolle spielt, war lange unbekannt. Erst in den letzten beiden Jahrzehnten zeigen mehr und mehr Untersuchungen, dass Hämoglobin in vielen, nicht den Erythrozyten oder ihren Vorläuferzellen angehörenden Zelltypen exprimiert wird [1]. Detektiert wurde Hämoglobin oder seine Untereinheiten Hb α und Hb β u.a. in Makrophagen, in Epithelzellen der Alveolen in der Lunge, im Pigmentepithel der Retina, in den Mesangialzellen der Niere, in Leberzellen, in Neuronen und Gliazellen, in der Schleimhaut der Gebärmutter und des Gebärmutterhalses, in den Chondrozyten des Knorpelgewebes und nun kürzlich in den Keratinozyten der obersten Hautschichten der Epidermis [2].

Die Funktion, die Hämoglobin in den einzelnen Zelltypen ausüben dürfte, reicht von Speicherung und Abgabe von Sauerstoff in spärlich durchbluteten Geweben (z.B. durch Hämoglobinkondensate in den Chondrozyten der Knorpelsubstanz [3]) über die Inaktivierung von reaktiven Sauerstoffmolekülen (H2O2, Hydroxyl-Radikal, Superoxid-Anion) bei oxidativem Stress (z.B: in Hepatozyten [1]) und von Stickoxiden (z.B. in der Lunge [4]) bis hin zu antibiotischen und antiviralen Eigenschaften von Peptiden, die durch Proteasen vom Hämoglobin abgespalten werden [5]. Je nach Zellstatus kann das Ausmaß der Hämoglobin-Expression variieren und bei erhöhtem Sauerstoffbedarf oder als Antwort auf oxidativen Stress/Entzündung hochreguliert werden.

... in Keratinozyten trägt es zur epidermalen Barriere gegen Umweltbelastungen bei....

Unsere Haut bildet eine hochwirksame Barriere gegen Umweltbelastungen - von Trockenheit, hoher Sauerstoffbelastung über Fremdstoffe, Mikroorganismen bis hin zur UV-Bestrahlung. Anpassung an diese Gegebenheiten haben im Laufe der Evolution die ausgeprägte mehrschichtige Struktur der obersten Hautschichte, der Epidermis geschaffen. Dieses hauptsächlich aus Keratinozyten bestehende Epithel, das bei uns Menschen unglaublich - im Mittel nur rund 0,1 mm - dünn ist [6], ist die eigentliche Barriere - die epidermale Barriere - gegen die Außenwelt. Die tiefste einzellige Schicht, das Stratum basale, besteht aus Keratinozyten, die sich aus Stammzellen heraus kontinuierlich und rasch teilen. Dadurch werden Zellen laufend nach außen in obere Schichten gedrängt, wobei sie aufhören sich zu teilen und einen Differenzierungsprozess durchlaufen, der sie innerhalb von rund einem Monat von Zellen des Stratum spinosum über Zellen des Stratum granulosum schließlich zu abgestorbenen verhornten Zellen im Stratum corneum umwandelt, die als Schuppen abgeschiefert werden (siehe dazu Abbildung 3 und auch [7]). Seit mehr als 50 Jahren wird über das Differenzierungsprogramm, die darin vom Stratum basale weg bis hin zur Verhornung involvierten Gene und die sich daraus entwickelnden Barrierefunktionen der epidermalen Schichten geforscht - viele Gene sind jedoch noch nicht entdeckt, weil es schwierig war terminal differenzierte Keratinozyten in ausreichender Menge für die Transkriptomanalyse zu erhalten.

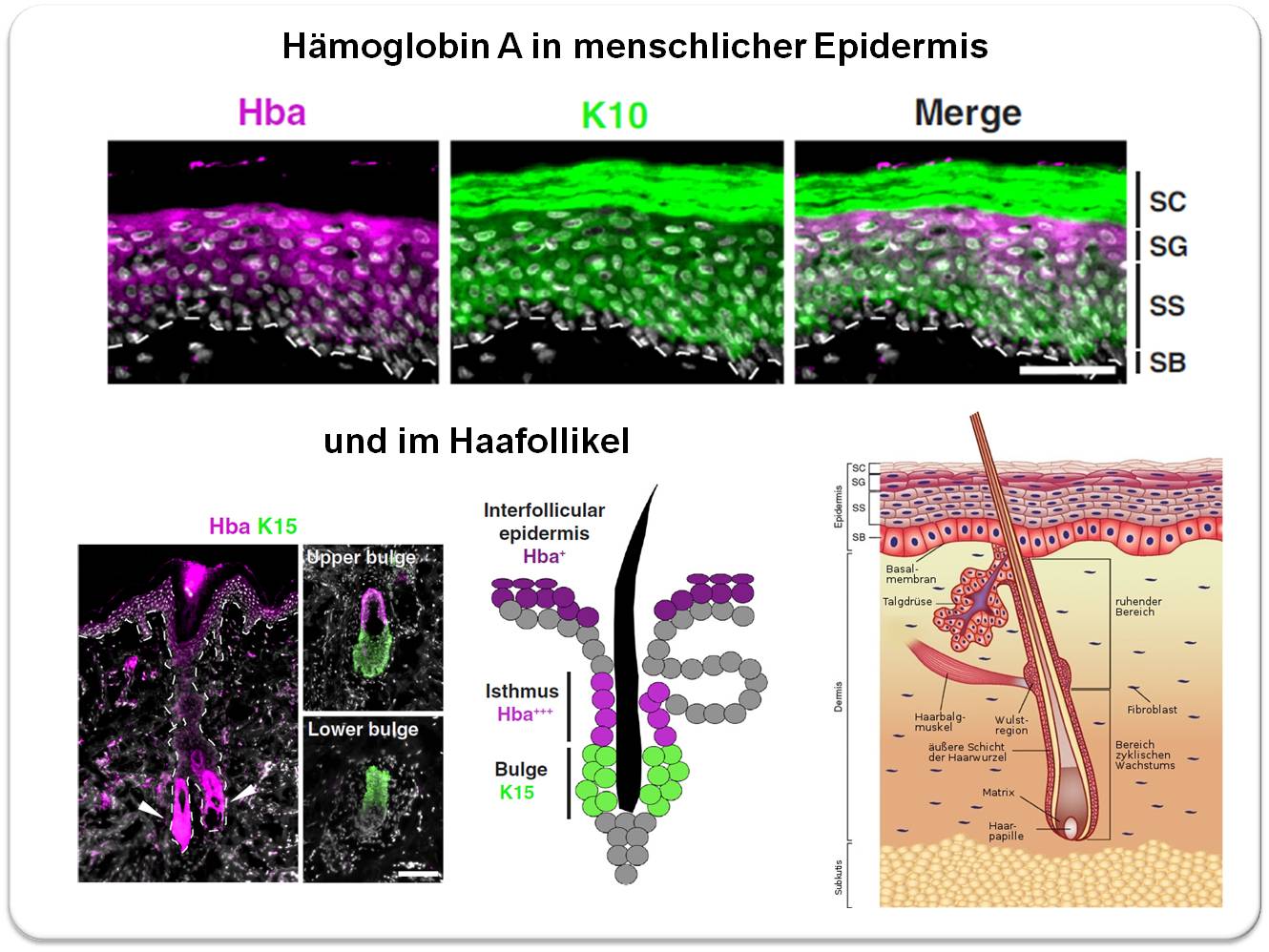

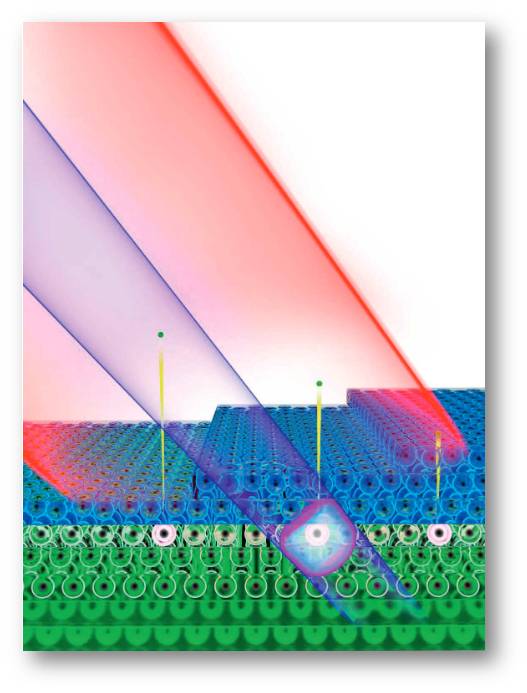

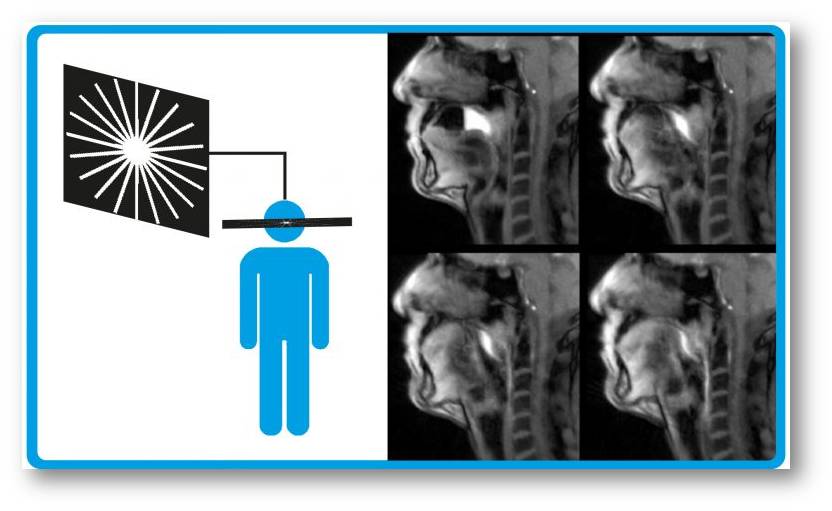

Ein japanisches Team um Masayuki Amagai (RIKEN Center for Integrative Medical Sciences, Yokohama) hat kürzlich über eine umfassende Untersuchung der Gene, die in den zunehmend differenzierten Schichten der oberen Epidermis exprimiert werden, berichtet [2]. Die Forscher haben dabei eine vergleichende Analyse der transkribierten Gene in der gesamten Epidermis und in ihren abgetrennten oberen Schichten aus Hautproben von Menschen und Mäusen durchgeführt. Ein unerwartetes Ergebnis war die Expression des Hämoglobin A Gens in der Epidermis, das in der oberen Epidermis im Vergleich zur gesamten Epidermis angereichert war. Mit immunhistochemischen Methoden wurde auch eine hohe, vom Stratum spinosum zum Stratum granulosum zunehmende Konzentration des Hämoglobin Proteins (HbA) bei Mensch und Maus nachgewiesen. Auch in den Keratinozyten von Haarfollikeln wird HbA produziert, insbesondere in der Isthmusregion, nicht aber in der Wulstregion, die Stammzellen (Marker Keratin 15) und prolifierende Keratinozyten enthält. Abbildung 3.

|

Abbildung 3. Lokalisierung von Hämoglobin A in Keratinozyten der menschlichen Epidermis und des Haarfollikels (Die Haut stammte von der Hüfte einer 62 jährigen Frau).Oben: Das lila angefärbte HbA-Protein wird mit zunehmender Differenzierung in den Zellen der oberen Schichten zunehmend stärker exprimiert, fehlt jedoch in den toten Zellen des verhornten Stratum corneum. Im Vergleich dazu wird Keratin 10 (K10) gezeigt (grün), das als Marker der Differenzierung in allen Zellen ab dem Stratum spinosum (SS) aufscheint und im toten verhornten Stratum corneum akkumuliert. Der weiße Balken entspricht einer Distanz von 0,05 mm. Unten: Im Haarfollikel ist HbA besonders stark in den Keratinozyten der Isthmus Region (d.i, zwischen Talgdrüse und Haarbalgmuskel) exprimiert, dagegen nicht im unteren Bereich der Wulstregion, der Stammzellen und proliferierende Keratinozyten (Indikator Keratin 15, grün) enthält. (Bilder aus Tahara U., et al. 2023; [2. Lizenz cc-by]). Rechts unten: Schematische Darstellung eines Haarfollikels in der Haut (Bild: A. Friedrich, https://de.wikipedia.org/wiki/Haar#/media/Datei:Anatomy_of_the_skin_de.jpg. Lizenz cc-by) SB, Stratum basale; SS, Stratum spinosum, SG, Stratum granulosum; SC, Stratum corneum. |

Wie früher erwähnt können von HbA abgespaltene Peptide antimikrobielle Aktivitäten aufweisen [5]. In Hinblick auf die ausgeprägte HbA-Expression im Isthmus des Haarfollikels könnte dies - nach Meinung der Autoren - auf den Bedarf an Stammzellschutz gegen die Invasion der Hautmikrobiota an der Follikelöffnung zurückzuführen sein.

...... und schützt vor allem gegen durch UV-Strahlung generierte reaktive Sauerstoffspezies

Die auf unsere Haut auftreffende UV-Strahlung des Sonnenlichts, besteht zu etwa 95 % aus UVA (350-400 nm) Strahlung, der Rest aus UVB (290-320 nm) Strahlung. Die energiereichere UVB-Strahlung verursacht direkte DNA-Schäden, UVA kann dagegen in viel stärkerem Maße als UVB ROS erzeugen.

In Primärkulturen menschlicher Keratinozyten und auch in einem 3D-Epidermis Modell haben die Forscher gesehen, das UVA-Bestrahlungen bereits bei der minimalen erythematischen Dosis, aber nicht UVB-Bestrahlungen die Expression von Hämoglobin hochregulierten. Gleichzeitig wurden durch die UVA-Bestrahlung Wasserstoffperoxid und andere ROS generiert, offensichtlich aber zum Großteil von Hämoglobin abgefangen/neutralisiert. Dies ging aus Versuchen hervor, in denen die Expression von Hämoglobin ausgeschaltet (mittels knockdown) war und die UV-induzierten ROS um ein Vielfaches anstiegen.

Diese Ergebnisse deuten darauf hin, dass die epidermale HbA-Expression durch oxidativen Stress induziert wird und als Antioxidans zur Barrierefunktion der Haut beiträgt; nach Meinung der Autoren stellt dies einen körpereigenen Schutzmechanismus gegen Hautalterung und Hautkrebs dar.

[1] Saha D., et al. Hemoglobin Expression in Nonerythroid Cells: Novel or Ubiquitous? International Journal of Inflammation, vol. 2014, Article ID 803237, https://doi.org/10.1155/2014/803237.

[2] Tahara U., et al. Keratinocytes of the Upper Epidermis and Isthmus of Hair Follicles Express Hemoglobin mRNA and Protein. J Invest. Dermatol. 143 (12) 2023, DOI: https://doi.org/10.1016/j.jid.2023.08.008.

[3] Zhang, F., et al. An extra-erythrocyte role of haemoglobin body in chondrocyte hypoxia adaption. Nature 622, 834–841 (2023). https://doi.org/10.1038/s41586-023-06611-6

[4] M.P.Sumi et al.,Hemoglobin resident in the lung epithelium is protective for smooth muscle soluble guanylate cyclase function. Redox Biology, 07,2023, 63, https://doi.org/10.1016/j.redox.2023.102717

[5] Olari L-R., et al., The C‑terminal 32‑mer fragment of hemoglobin alpha is an amyloidogenic peptide with antimicrobial properties. Cellular and Molecular Life Sciences (2023) 80:151. https://doi.org/10.1007/s00018-023-04795-8

[6] Lintzeri D.A. et al., Epidermal thickness in healthy humans: a systematic review and meta-analysis (2022) J. Eur.Acad.Dermatol. Venereol. 36: 1191 -1200. https://doi.org/10.1111/jdv.18123

[7] Inge Schuster, 17.07.2015: Unsere Haut - mehr als eine Hülle. Ein Überblick.

Verwandte Themen im ScienceBlog

Gottfried Schatz, 23.01.2015: Der besondere Saft

Inge Schuster, 06.09.2018: Freund und Feind - Die Sonne auf unserer Haut

Extreme Hitze und Dürre könnten in Europa schon früher auftreten als bislang angenommen

Extreme Hitze und Dürre könnten in Europa schon früher auftreten als bislang angenommenFr, 22.12.2023 — Redaktion

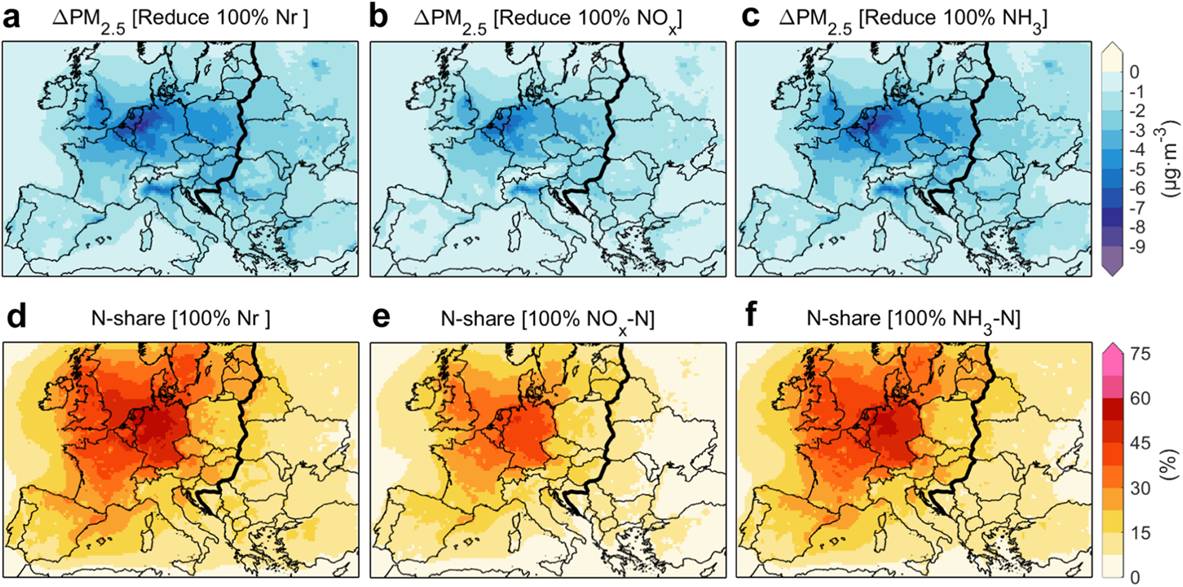

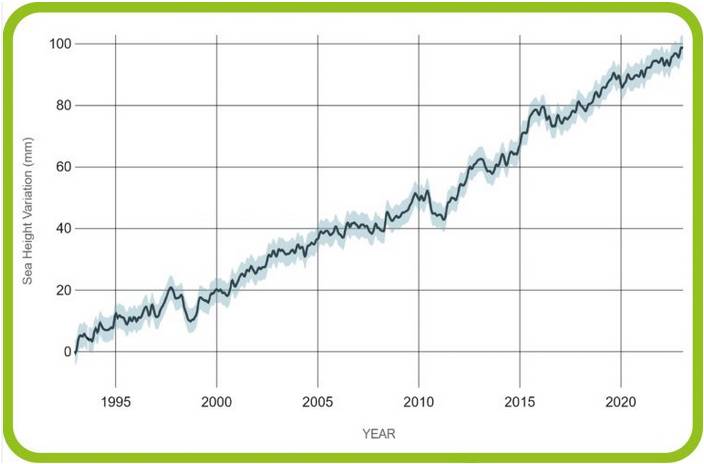

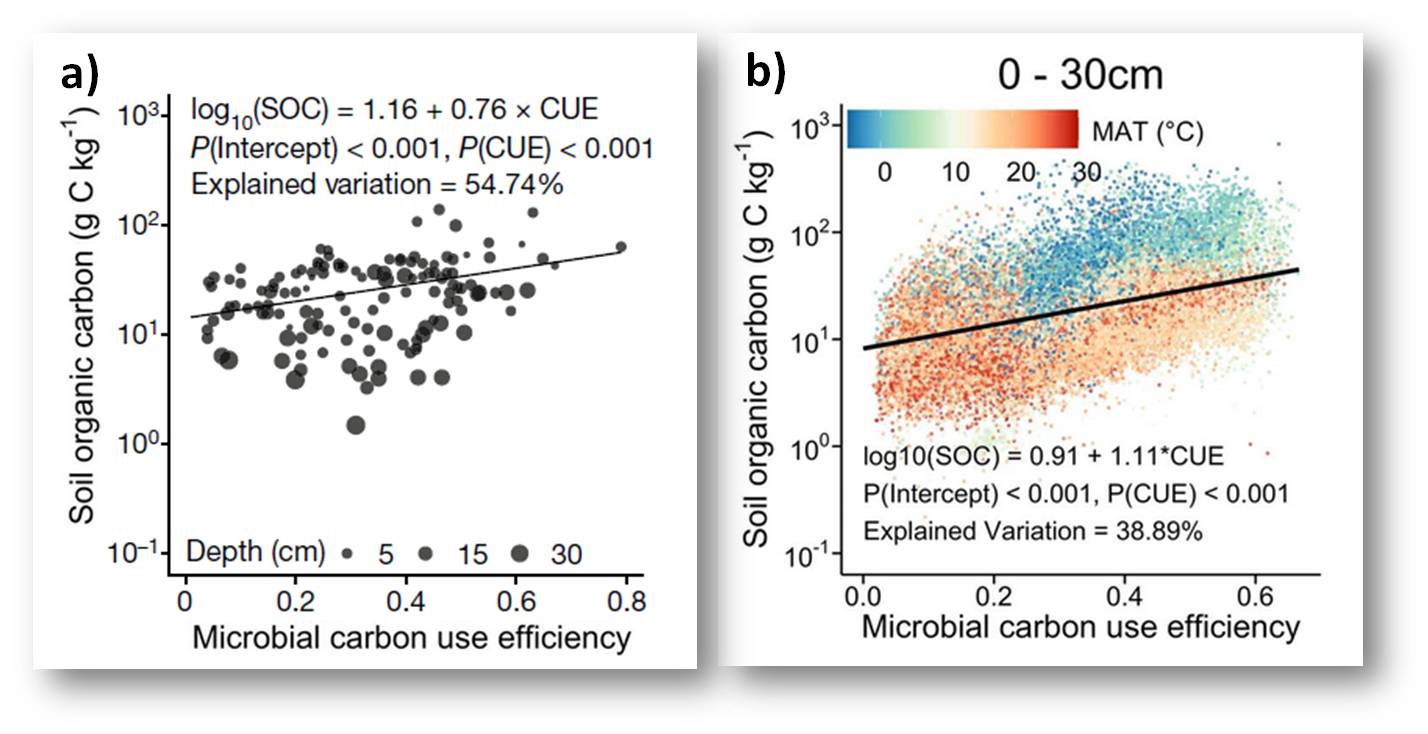

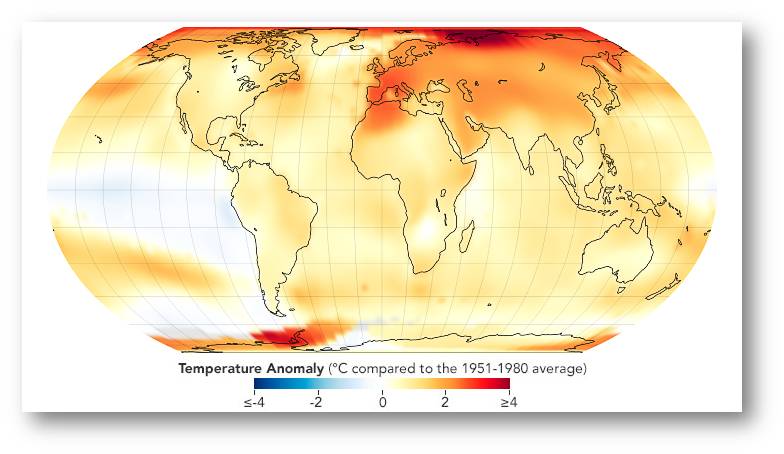

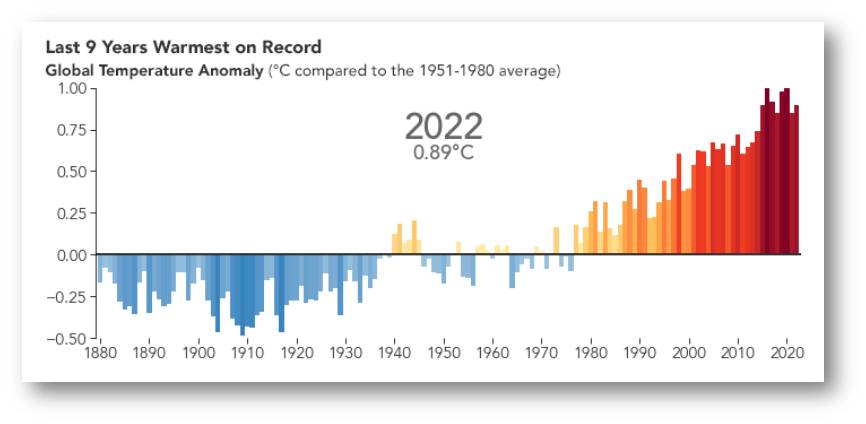

Extreme Hitze und Dürre, wie sie für das Klima am Ende des 21. Jahrhunderts typisch sein werden, könnten in Europa schon früher als angenommen auftreten und dies wiederholt in mehreren aufeinander folgenden Jahren. Das ist die kürzlich publizierte Schlussfolgerung eines Forscherteams vom Max-Planck-Institut für Meteorologie (Hamburg), das eines der weltweit besten hochkomplexen Erdsystemmodelle "MPI Grand Ensemble" für seine Berechnungen einsetzte. Demnach liegt die Wahrscheinlichkeit, dass Hitze und Dürre ein Niveau erreichen, wie man es für das Ende des Jahrhunderts angenommen hatte - selbst bei einer moderaten Erwärmung -, bereits in den 2030er Jahren bei 10 %. Um 2040 könnten ganze Dekaden mit Hitzestress ihren Anfang nehmen, wobei ein warmer Nordatlantik den Wandel beschleunigen wird.*

Wenn die Erderwärmung weiter zunimmt, wird abnorme Hitze häufiger auftreten und extremer werden. Dass Hitze, die unsere bisherige Anpassungsfähigkeit deutlich übersteigt, zu erhöhter Morbidität und Sterblichkeit führt, ist erwiesen - bei den Hitzewellen 2015 in Indien und Pakistan und 2003 in Europa sind Tausende Menschen gestorben. Die Lage wird verschärft, wenn zu extremer Hitze noch hohe Luftfeuchtigkeit, mangelnde nächtliche Abkühlung oder anhaltende Trockenheit hinzukommen. Höchsttemperaturen und zunehmende Schwankungen zwischen extremer Trockenheit und immensen Niederschlägen werden zudem massive Auswirkungen auf Sozioökonomie und Ökologie haben und ganze Landstriche unbewohnbar machen. Die Bedrohung für Mensch und Umwelt wird noch ärger, wenn solche extremen Ereignisse in aufeinanderfolgenden Jahren wiederholt auftreten. Wie sich bei zunehmender Erwärmung die Wahrscheinlichkeit einer solchen mehrjährigen Abfolge von extremer Hitze und Trockenheit verändert, ist allerdings unklar, auch wie bald solche Ereignisse bereits auftreten können und wie diese Wahrscheinlichkeiten außerdem von der internen Variabilität des Klimasystems - spontan erzeugt durch Prozesse und Rückkopplungen im Klimasystem selbst — beeinflusst werden.

Das MPI-GE-Ensemble

Diese interne Variabilität des Klimasystems stellt heute eine der größten Unsicherheiten bei der Beurteilung aktueller Klimaschwankungen und bei den modellbasierten Projektionen der zukünftigen Klimaentwicklung dar. Das Max-Planck-Institut für Meteorologie (MPI-M) in Hamburg entwickelt und analysiert hochkomplexe Erdsystemmodelle, welche die Prozesse in der Atmosphäre, auf dem Land und im Ozean simulieren. Das MPI Grand Ensemble (MPI-GE) ist eines der größten derzeit verfügbaren Ensembles für die Anfangsbedingungen eines umfassenden, vollständig gekoppelten Erdsystemmodells, mit dem u.a. die Unsicherheiten der internen Variabilität des Klimasystems untersucht werden können [1].

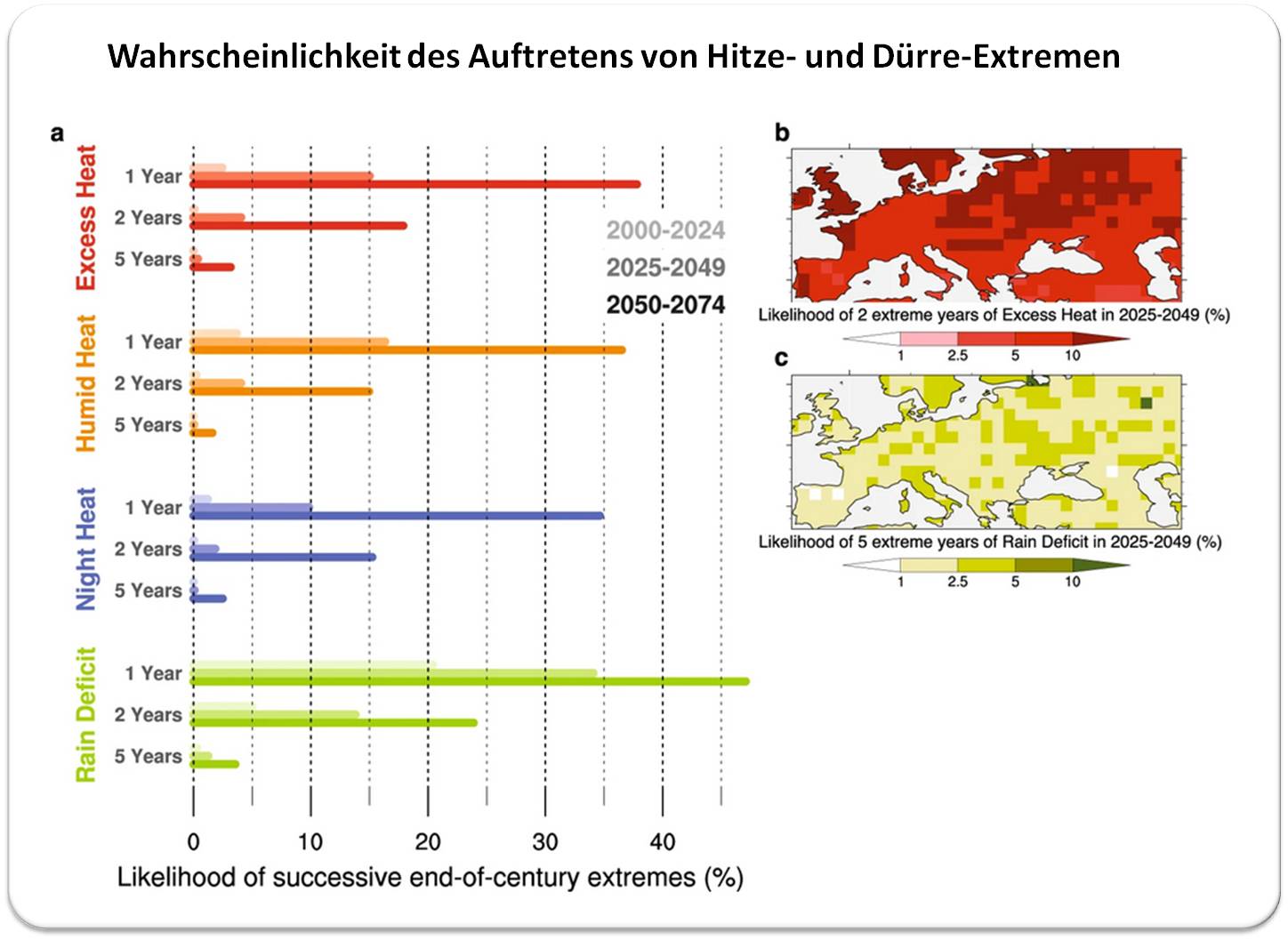

An Hand von hundert Simulationen mit diesem Erdsystem-Modell hat nun ein Forscherteam vom MPI für Meteorologie die Wahrscheinlichkeit für das (wiederholte) Auftreten von extremen Hitze- und Dürrestress berechnet. Die Ergebnisse wurden eben im Fachjournal Nature Communications Earth & Environment publiziert [2].

Die wichtigsten Aussagen

Selbst bei einer moderaten Erwärmung wird ein noch nie dagewesenes Ausmaß an Hitze- und Dürrestress, wie dies für das Klima am Ende des Jahrhunderts typisch sein wird, in naher Zukunft europaweit möglich sein.

Den Projektionen zufolge werden alle untersuchten Formen von Hitzestress bereits im Jahrzehnt 2030-2039 mit einer Wahrscheinlichkeit von 1:10 ein Niveau erreichen oder übertreffen, das vor 20 Jahren praktisch unmöglich war. Darüber hinaus wird der für das Ende des Jahrhunderts typische, wiederholt in aufeinanderfolgenden Jahren auftretende extreme Hitze- und Dürrestress bereits ab 2050 mit einer Wahrscheinlichkeit von mehr als 1:10 möglich sein (dergleichen war seit Beginn der Aufzeichnungen noch nie beobachtet worden). Bis dahin werden in 20 % der Fälle zwei aufeinanderfolgende Jahre mit für das Ende des Jahrhunderts typischen Niederschlagsdefiziten prognostiziert, und es besteht ein nicht zu vernachlässigendes Risiko für 5 Jahre anhaltende extreme Dürre. Abbildung.

| Wahrscheinlichkeit, dass es in Europa zu extremen, für das Ende des Jahrhunderts typischen Hitze- Dürreperioden kommt. a) Wahrscheinlichkeit für das Auftreten extremer Hitze (rot),verbunden mit hoher Luftfeuchtigkeit, mangelnder nächtlicher Abkühlung oder anhaltender Trockenheit in einem Jahr und in den folgenden 2 oder 5 Jahren, für die Zeiträume 2000-2024 (helle Farben), 2025-2049 (mittel-helle Farben) und 2050-2074 (dunkle Farben). Wahrscheinlichkeit von extremem Hitzestress in Europa in 2 aufeinanderfolgenden Jahren (b) und von extremer Hitze und Trockenheit in 5 aufeinanderfolgenden Jahren (c) im Zeitraum 2025-2049. (Quelle: L. Suarez-Gutierrez et al., https://doi.org/10.1038/s43247-023-01075-y [2]; Lizenz cc-by.) |

Bei gleichbleibender globaler Erwärmung wird nicht nur die Häufigkeit von Hitze- und Dürreextremen zunehmen, auch deren Bandbreite wird von Jahrzehnt zu Jahrzehnt größer werden.

Diese Spanne wird so groß werden, dass Hitze- und Dürreperioden, wie sie für das Klima am Ende des Jahrhunderts typisch sein werden, in Europa bereits im Jahr 2040 Realität werden könnten. Im günstigsten Fall werden dann die Höchtstemperaturen bei Tag und Nacht im Bereich der Werte des wärmsten bislang in Europa aufgezeichneten Jahrzehnts von 2010 - 2019 liegen; im schlimmsten Fall wird die Häufigkeit und Heftigkeit der extremen Hitze- und Dürreperioden die für das Ende des Jahrhunderts typischen Ereignisse bei weitem übersteigen.

Der Einfluss des Nordatlantiks

Jedes dieser verheerenden Ereignisse könnte durch die interne Variabilität des Klimasystems früher als erwartet nach Europa gebracht werden können. Die über Dekaden zunehmende Variabilität des europäischen Hitze- und Dürrestresses wird stark von der multidekadischen Variabilität des Nordatlantiks beeinflusst. Diese zyklisch auftretende Zirkulationsschwankung der Ozeanströmungen im Nordatlantik (atlantic multidecadal variability - AMV) hat eine Periodendauer von 50 bis 70 Jahren und besitzt „warme“ und „kalte“ Phasen mit veränderten Meeresoberflächentemperaturen des gesamten nordatlantischen Beckens, die sich auf die Temperatur der Atmosphäre auswirken. Die Simulationen am MPI-GE zeigen, dass bei gleichzeitig wärmerem Nordatlantik bereits im Jahr 2030 ein Überschreiten der für das Ende des Jahrhunderts typischen Werte für einfache und komplexe Hitze- und Dürreperioden doppelt so wahrscheinlich ist, als bei einem kalten Nordatlantik.

*Diese Forschung wurde im Rahmen des vom deutschen Bundesministerium für Bildung und Forschung geförderten Projekts ClimXtreme durchgeführt und durch das Rahmenprogramm Horizon Europe der Europäischen Union unter den Marie Skłodowska-Curie Maßnahmen kofinanziert.

„ClimXtreme – Klimawandel und Extremereignisse“ hat unter Beteiligung von 39 Forscherteams in einer ersten Phase von 2019 - 2023 erforscht, wie sich der Klimawandel auf die Häufigkeit und Intensität von Extremwetterereignissen auswirkt. Nun startet die zweite Phase, die auch Zukunftsprognosen für Anwender, wie etwa für den Katastrophenschutz, Versicherungen, Landwirtschaftsverbände, Hochwasservorsorge, etc. entwickeln wird., um das Angebot ihrer Leistungen auf kommende Schäden durch Extremwetter besser abschätzen zu können. https://www.fona.de/de/aktuelles/nachrichten/2023/231207_ClimXtreme_Phase_2_b.php

[1] Das Max-Planck-Institut Grand Ensemble – ein Instrument zur Untersuchung der internen Variabilität des Klimasystems: https://mpimet.mpg.de/kommunikation/detailansicht-news/das-max-planck-institut-grand-ensemble-ein-instrument-zur-untersuchung-der-internen-variabilitaet-des-klimasystems. (abgerufen am 20.12.2023)

[2] Suarez-Gutierrez, L., Müller, W.A. & Marotzke, J. Extreme heat and drought typical of an end-of-century climate could occur over Europe soon and repeatedly. Commun Earth Environ 4, 415 (2023). https://doi.org/10.1038/s43247-023-01075-y

Klimawandel im ScienceBlog

ist ein Schwerpunktsthema mit bis jetzt knapp 50 Artikeln, die vom Überblick über Klimamodelle bis zu den Folgen des Klimawandels und den Bestrebungen zu seiner Eindämmung reichen.

Eine chrononologische Lise der Artikel findet sich unter: Klima & Klimawandel

Wie haben 15-jährige Schüler im PISA-Test 2022 abgeschnitten?

Wie haben 15-jährige Schüler im PISA-Test 2022 abgeschnitten?Sa, 16.12.2023— Inge Schuster

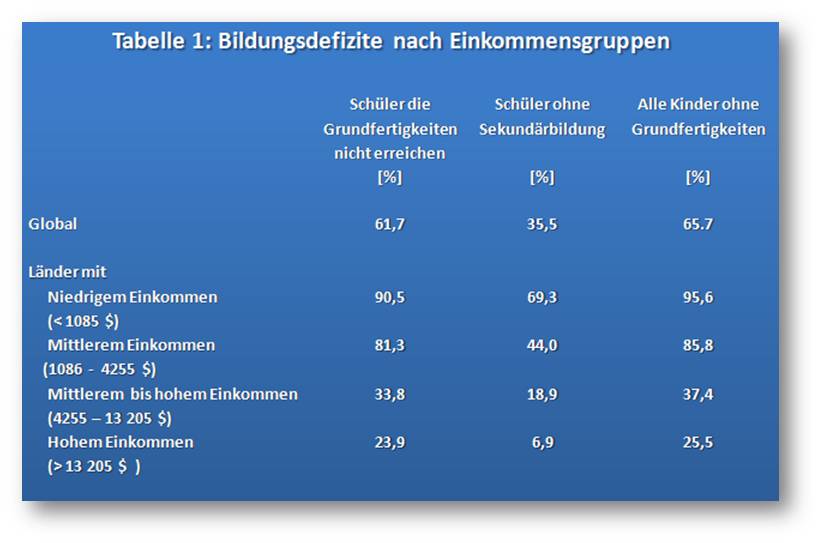

![]() Am 5. Dezember sind die Ergebnisse der neuen internationalen Schulleistungsstudie PISA veröffentlicht worden. PISA wird seit dem Jahr 2000 von der OECD weltweit in Mitgliedstaaten und Nicht-Mitgliedstaaten alle drei Jahre durchgeführt. Dabei wird evaluiert, inwieweit Schüler im Alter von 15 Jahren über die für eine volle gesellschaftliche Teilhabe unerlässlichen Schlüsselkenntnisse und -kompetenzen in den drei Bereichen Lesekompetenz, Mathematik und Naturwissenschaften verfügen. Das Ergebnis: Im OECD-Durchschnitt schnitten 15-Jährige wesentlich weniger gut ab als bei den PISA-Tests 2018 und vor zehn Jahren, wobei Im deutschsprachigen Raum zwar alle Bewertungen über dem OECD-35 Durchschnitt liegen, aber auf einen vhm. hohen Anteil Jugendlicher hinweisen, welche die Grundkompetenzen in den Fächern fehlen. Insgesamt gesehen bringen die Reports kaum Anhaltspunkte, wie weniger erfolgreiche Bildungssysteme verbessert werden könnten.

Am 5. Dezember sind die Ergebnisse der neuen internationalen Schulleistungsstudie PISA veröffentlicht worden. PISA wird seit dem Jahr 2000 von der OECD weltweit in Mitgliedstaaten und Nicht-Mitgliedstaaten alle drei Jahre durchgeführt. Dabei wird evaluiert, inwieweit Schüler im Alter von 15 Jahren über die für eine volle gesellschaftliche Teilhabe unerlässlichen Schlüsselkenntnisse und -kompetenzen in den drei Bereichen Lesekompetenz, Mathematik und Naturwissenschaften verfügen. Das Ergebnis: Im OECD-Durchschnitt schnitten 15-Jährige wesentlich weniger gut ab als bei den PISA-Tests 2018 und vor zehn Jahren, wobei Im deutschsprachigen Raum zwar alle Bewertungen über dem OECD-35 Durchschnitt liegen, aber auf einen vhm. hohen Anteil Jugendlicher hinweisen, welche die Grundkompetenzen in den Fächern fehlen. Insgesamt gesehen bringen die Reports kaum Anhaltspunkte, wie weniger erfolgreiche Bildungssysteme verbessert werden könnten.

Durch die Corona-Pandemie bedingt wurde die für 2021 geplante PISA-Studie (Programme for International Student Assessment) auf 2022 verschoben. Der Schwerpunkt der Erhebung lag dieses Mal auf Mathematik; untergeordnet waren die Bereiche Naturwissenschaften und Lesekompetenz (neu hinzugekommen ist ein Bereich kreatives Denken, dessen Ergebnisse aber erst 2024 berichtet werden sollen).

An der Studie haben mehr Staaten und Volkswirtschaften - 37 OECD Mitglieder, 44 Partnerländer - als je zuvor teilgenommen. Stellvertretend für die etwa 29 Millionen 15-jährigen Schüler dieser Länder haben sich rund 690 000 Schüler den Tests unterzogen. In den meisten Ländern wurden zwischen 4000 und 8 000 Schüler aus repräsentativen Stichproben getestet.

Konkret haben die Schüler während zwei Stunden Tests in zwei Bereichen (Mathematik & Naturwissenschaften oder Mathematik & Lesekompetenz) am Computer absolviert und danach in rd. 35 Minuten einen Fragebogen zu ihrem sozioökonomischen Status und zu anderen Fragen ausgefüllt. Dabei wurden Zusammenhänge zwischen Leistungen und sozioökonomischem Status, Geschlecht sowie Migrationshintergrund und auch zu den Auswirkungen der Corona-Pandemie untersucht.

Ein Mammutprojekt, was den Umfang der Ergebnisse betrifft.

Diese liegen nun in zwei insgesamt rund 1000 Seiten umfassenden Publikationen "Lernstände und Bildungsgerechtigkeit" [1] und "Learning During – and From – Disruption" [2] vor, weitere 3 Publikationen sind für 2024 geplant. Zusätzlich gibt es Zusammenfassungen für die einzelnen teilnehmenden Länder (https://www.oecd.org/publication/pisa-2022-results/country-notes/), eine Zusammenfassung "PISA 2022: Insights and Interpretations" [3] und auf 2 Seiten in Bildern "PISA 2022 key results (infographic)"[4].

Leider gibt es Ungereimtheiten bei den Aussagen und Interpretationen und es werden wenig Anhaltspunkte zur Verbesserung weniger erfolgreicher Systeme geboten.

Wie werden PISA-Tests analysiert/bewertet?

Vorweg eine kurze Zusammenfassung, um mit den Zahlen in den nächsten Abschnitten etwas anfangen zu können:

Die Testergebnisse werden einer Normalverteilung entsprechend skaliert mit Mittelwerten von etwa 500 Punkten und Standardabweichungen von etwa 100 Punkten. Bei den ersten schwerpunktmäßig getesteten Bereichen (Lesen: PISA 2000; Mathematik: PISA 2003; Naturwissenschaften: PISA 2006) haben 2/3 der Schüler demnach einen Wert zwischen 400 und 600 Punkten, 95 % der Schüler zwischen 300 und 700 Punkten erreicht.

Die verschiedenen Schwierigkeitsgrade in den Testbeispielen werden auf nach oben und unten offenen, in Kompetenzstufen unterteilten Skalen dargestellt. In Mathematik entspricht jede Kompetenzstufe einer Spanne von etwa 62 Punkten (Schwellenwerte der Kompetenzstufen in Zahlen: 1c = 233,1b = 295, 1a = 358, 2 = 420, 3 = 482, 4 = 545, 5 = 607, 6 = 669) (Tab. I.3.1 [1]). In Naturwissenschaften beträgt die Spanne etwa 75 Punkte, in Lesekompetenz ungefähr 73 Punkte.

Stufe 2 gilt als Grundkompetenzniveau, um in vollem Umfang am gesellschaftlichen Leben teilzuhaben. Schüler, die diese Stufe nicht erreichen - in Mathematik 420 Punkte, in Naturwissenschaften 410 Punkte, in Lesen 407 Punkte - werden als leistungsschwach bezeichnet, Schüler, die die Kompetenzstufen 5 oder 6 erreichen als leistungsstark.

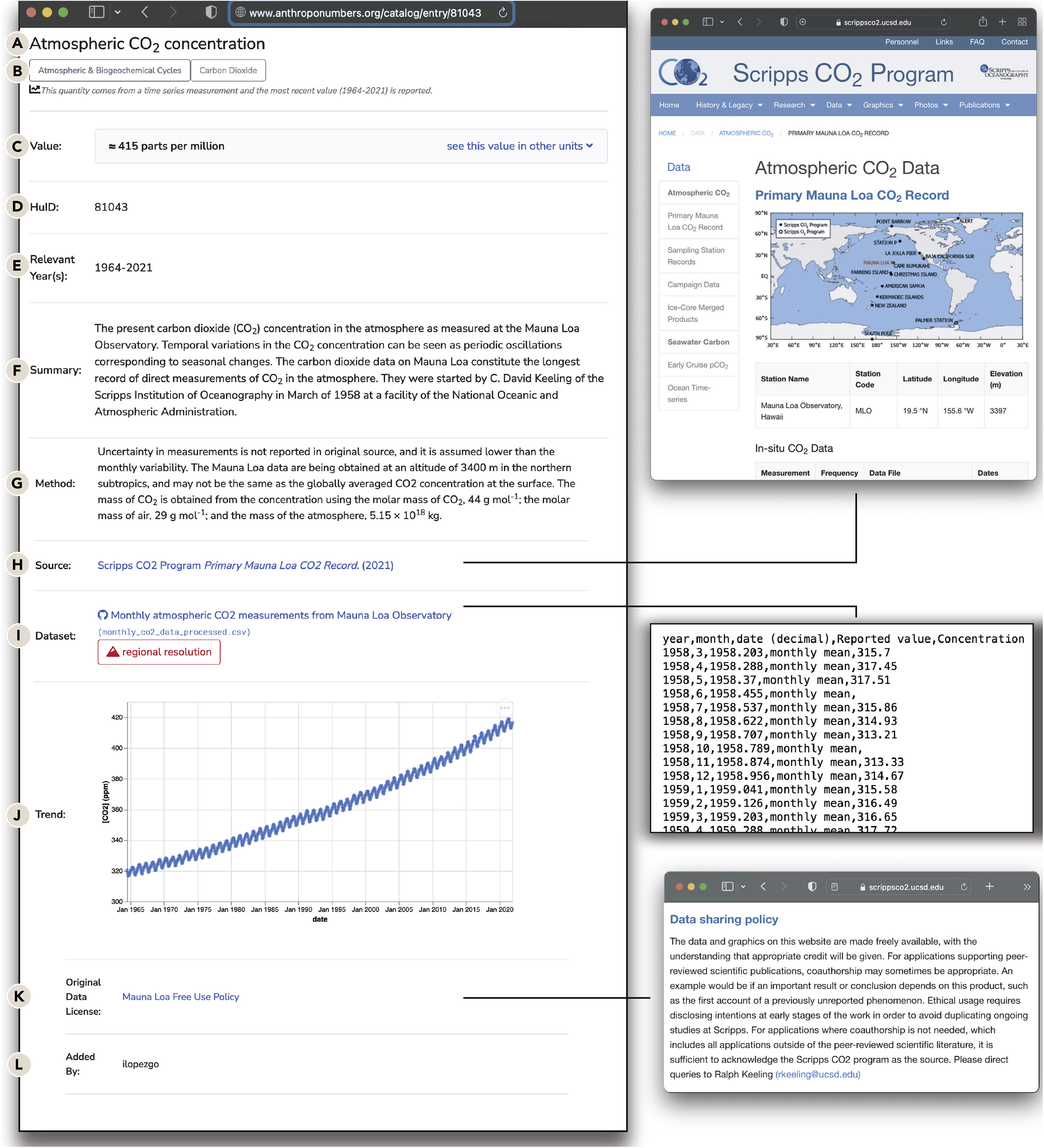

Globale PISA-Ergebnisse 2022

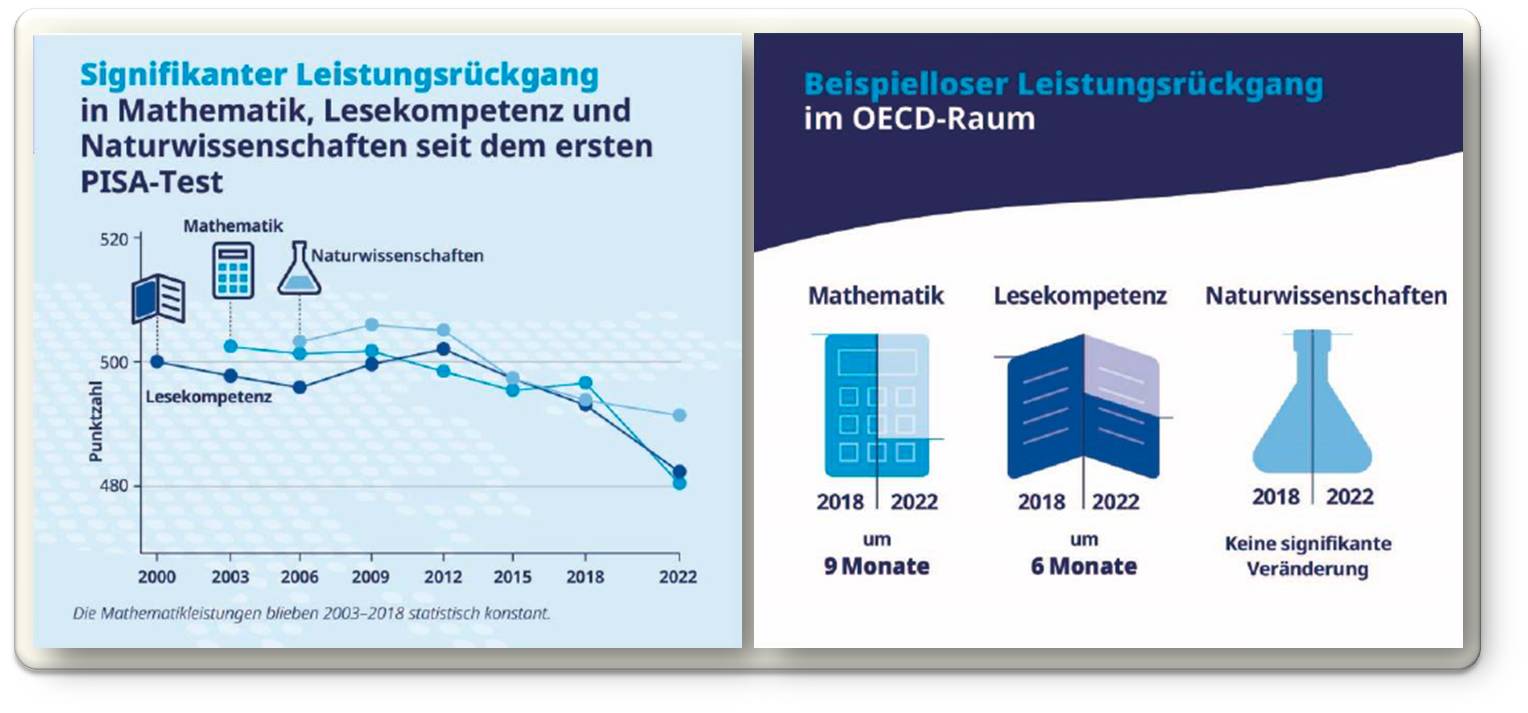

Seit dem Beginn der PISA-Erhebungen haben die durchschnittlichen Schülerleistungen weltweit in allen 3 Bereichen abgenommen. Wurde ursprünglich ein OECD-Leistungsdurchschnitt in den drei Bereichen von jeweils 500 Punkten festgelegt, so liegen nun die Durchschnitte von 35 OECD Ländern bei 472 Punkten in Mathematik, 485 Punkten in Naturwissenschaften und 472 Punkten in Lesekompetenz. Am stärksten ist der OECD-Leistungsdurchschnitt in Mathematik seit 2018 gesunken (Rückgang um fast 15 Punkte, d.i. dreimal so hoch wie jede der vorherigen Veränderungen) und in der Lesekompetenz (um 10 Punkte). Der Rückgang in den Naturwissenschaften (um 4 Punkte) fiel wesentlich geringer aus und war statistisch nicht signifikant. In den Key Results-Infografik ([1], [4]) wird der Rückgang und auch dessen Interpretation im Stil der in Zeitungen üblichen Clickbaits dargestellt (Abbildung 1).

| Abbildung 1. Durchschnittliche Punktezahl in 22 OECD-Ländern seit dem Beginn der Pisatestungen und durchschnittlicher Rückgang im Lernfortschritt seit 2018 in Schuljahren. Ursprünglich wurde der Mittelwert in den OECD-Ländern auf 500 Punkte festgelegt. Die Grafik stammt aus PISA 2022 Key Results (infographic) [4]. Lizenz: cc-by-nc-sa). Caveat: Durchschnitt aus nur 23 Ländern! Zahlen stimmen nicht mit den tatsächlichen OECD-Durchschnittswerten seit 2000 überein. |

Der Rückgang in Mathematik seit 2018 wird in den Key Results mit einem Lernrückschritt von etwa einem Dreivierteljahr gleichgesetzt, der Rückgang in Lesekompetenz mit einem halben Schuljahr (Abbildung 1). Als Basis dafür wurde ein aus aktuellen Schätzungen stammender Referenzwert von 20 Punkten für das durchschnittliche jährliche Lerntempo der 15-Jährigen in den Ländern der PISA-Teilnehmer angewandt (Kasten I.5.1 in Kapitel 5 [1]). Im selben Absatz warnt die OECD allerdings gleichzeitig davor "diesen Wert zu verwenden, um Punktezahldifferenzen in Äquivalente von Schuljahren (oder Schulmonaten) umzurechnen. Denn zum einen variiert das Lerntempo in einem bestimmten Alter von Land zu Land erheblich,..... Und zum anderen gibt es keinen Grund zur Annahme, dass das Lerntempo im Zeitverlauf konstant bleibt."

Die obige Quantifizierung des Lernrückschritts erscheint nicht nur auf Grund unterschiedlicher OECD Aussagen fragwürdig - beispielsweise wendet der Schweizer PISA-2022 Nationalbericht auf Basis anderer Schätzungen die Faustregel an, dass ungefähr 40 Leistungspunkte dem Lernfortschritt von einem Schuljahr entsprechen [5].

Wie ist nun der Abwärtstrend der OECD-Durchschnittsleistungen - insbesondere seit 2018 - zu bewerten?

In Anbetracht der hohen Punktedifferenzen zwischen leistungsschwachen und leistungsstarken Schülern innerhalb eines Landes und dem durchschnittlichen Leistungsabstand zwischen den leistungsstärksten und leistungsschwächsten Ländern (beispielsweise liegen in OECD-Ländern 153 Punkte zwischen Japan und Kolumbien, unter allen PISA-Teilnehmern 238 Punkte zwischen Singapur und Kambodscha) ist der Abwärtstrend zwar als eher klein aber als Warnsignal anzusehen:

Insgesamt gesehen sind seit 2018 die PISA-Punktzahlen im OECD-Durchschnitt sowohl bei den besonders leistungsstarken als auch bei den leistungsschwachen Schülern zwischen 2012 und 2022 zurückgegangen, d.i. der Anteil der leistungsschwachen Schüler hat zugenommen, der Anteil der leistungsstarken Schüler abgenommen.

In den OECD-Mitgliedstaaten haben 2022 rund 31 % der 15-Jährigen in Mathematik die Kompetenzstufe 2 nicht erreicht, das heißt es fehlt ihnen die Fähigkeit Mathematik in einfachen Alltagssituationen anzuwenden, 26 % erwiesen sich als leistungsschwach in der Lesekompetenz - sie können einfache Texte nicht interpretieren und 24 % sind leistungsschwach in den Naturwissenschaften, d.i. sie können nicht auf aus dem Alltag stammendes konzeptuelles Wissen zurückgreifen, um Aspekte einfacher Phänomene zu erkennen (siehe auch Tabelle 2).

Bei vielen Nicht-OECD-Mitgliedern fallen die Schülerleistungen noch negativer aus - in 18 Ländern und Volkswirtschaften - darunter 3 Balkanländern - sind mehr als 60 % der 15-Jährigen in allen drei Fächern leistungsschwach (Panama, Saudi-Arabien, Georgien, Nordmazedonien, Indonesien, Albanien, Jordanien, El Salvador, Paraguay, Guatemala, Marokko, Dominikanische Republik, Philippinen, Usbekistan, Kosovo, Kambodscha, Baku, Palästinenser-Gebiete).

Es gibt aber auch positive Entwicklungen.

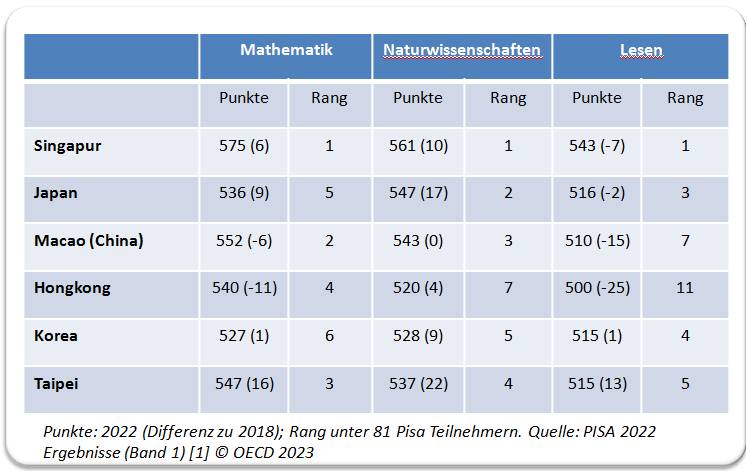

| Tabelle 1. Durchschnittliche Schülerleistungen in Punktezahlen (in Klammer: Veränderung seit 2018) in ostasiatischen Staaten/Volksgemeinschaften. Diese nehmen die Spitzenplätze aller Wertungen in den 81 getesteten Ländern/Volkswirtschaften ein. . |

Einige ostasiatische Staaten und Volkswirtschaften haben sich zu besonders leistungsstarken Gebieten entwickelt, die ihre bereits 2018 sehr hohen Leistungen z.T. noch steigern konnten und nun die Weltranglisten in allen 3 Disziplinen anführen: Singapur, Hongkong (China), Japan, Korea, Macau (China) und Chinesisch Taipei. Tabelle 1.

Was im Report nicht Platz findet: Es sind Gesellschaften, die vor allem vom Konfuzianismus geprägt sind, der eine prinzipiell positive Einstellung zum Lernen hat.

Ist die COVID-Pandemie am Leistungsabfall seit 2018 schuld?

Das wäre eine einfache Erklärung - allerdings kann der Leistungsabfall nur zum Teil durch die mit der COVID-19-Pandemie einhergehenden Schulschließungen und Problemen bei der Umstellung auf den digitalen Distanzunterricht erklärt werden. Der Zeitverlauf der PISA-Daten zeigt deutlich, dass der Abwärtstrend in zahlreichen Ländern bereits vor 2018 begonnen hatte (siehe auch Abbildung 3).

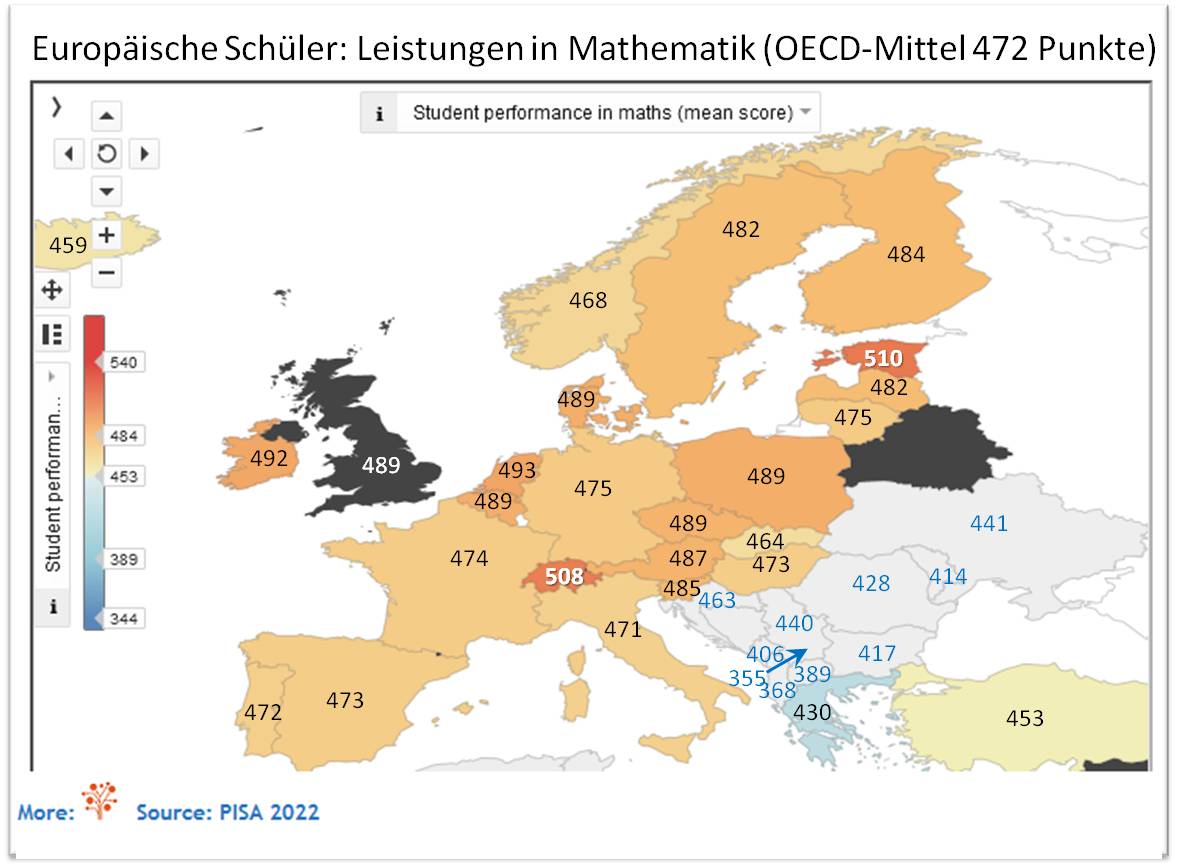

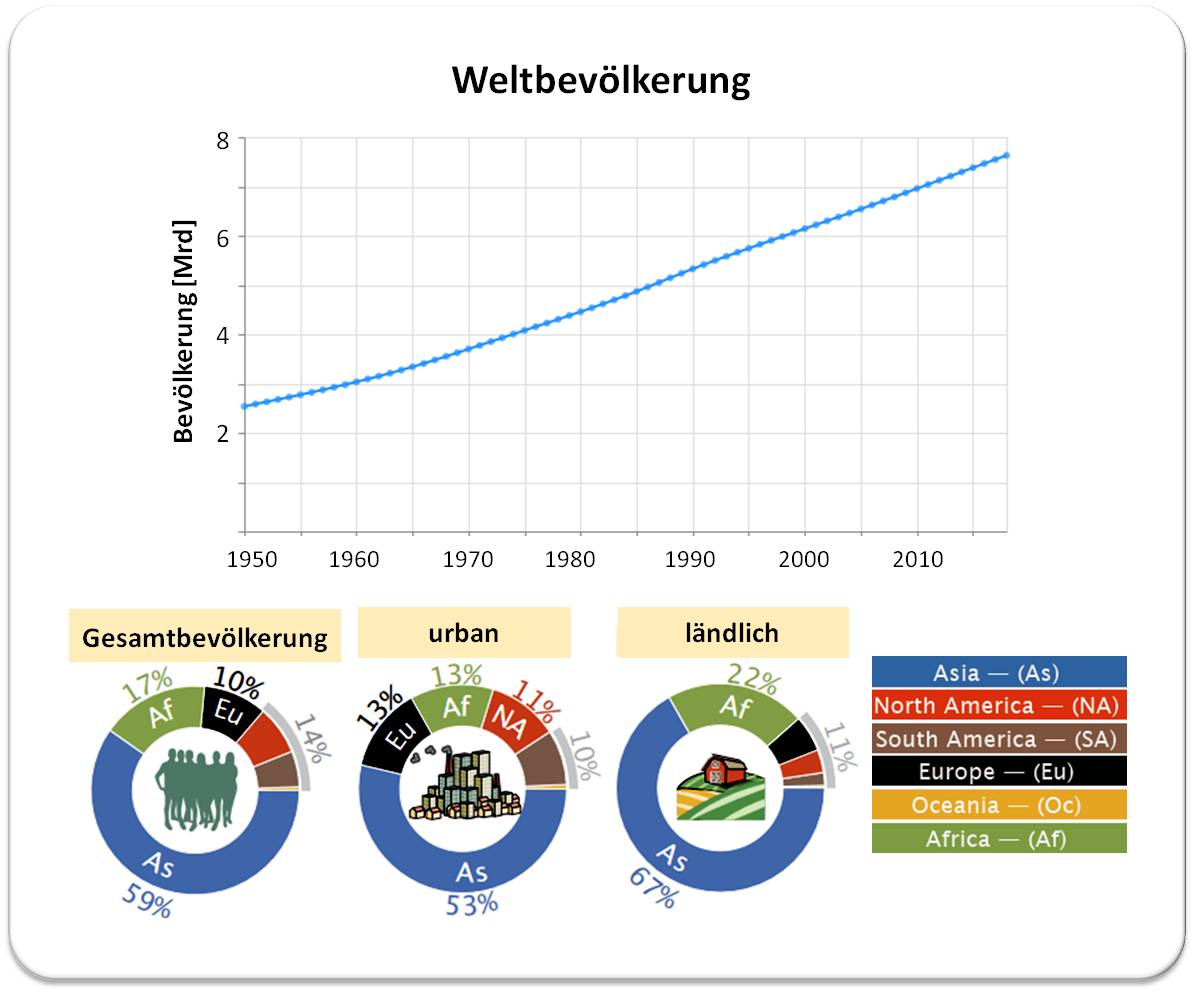

PISA-2022 in Europa

Dass Europa durch einen Bildungsvorhang in zwei Teile getrennt ist, ist nicht neu aber in den PISA 2022-Reports kein Thema. Abbildung 2 zeigt diese Spaltung am Beispiel der durchschnittlichen Mathematikleistung - die Ergebnisse in Naturwissenschaften und Lesekompetenz geben ein ganz ähnliches Bild. Auf der einen Seite steht der Block von 24 OECD-Staaten, auf der anderen Seite der Block der Balkanländer und daran angrenzend Moldawien und die Ukraine; Kroatiens Durchschnittsleistungen in allen 3 Bereichen, lassen das Land als Teil des OECD-Blocks erscheinen.

| Abbildung 2. PISA 2022: Ein Bildungsvorhang trennt die europäischen Staaten. Durchschnittsleistungen in Mathematik; schwarze Zahlen: OECD-Länder, blaue Zahlen Nicht-OECD-Länder.(Quelle: https://factsmaps.com/pisa-2022-worldwide-ranking-average-score-of-mathematics-science-and-reading/. Daten aus Table 1.B1.2.1. [1]) |

In Mathematik liegen die Durchschnittsleistungen von 24 Ländern des OECD-Blocks im Bereich der OECD-Durchschnittsleistung von 472 Punkten oder darüber und diese haben damit im Durchschnitt mindestens die Grundkompetenzstufe 2 (Spanne 420 - 482 Punkte) erreicht. Am besten schnitten Estland (510 Punkte) und knapp dahinter die Schweiz (508 Punkte) ab - 51 Punkte trennen die Nummer 1 von Island (459 Punkte), dem Land mit der niedrigsten Durchschnittsleistung, das einst mit Finnland und Schweden zu den Vorreitern im Bildungsbereich gehörte. Seit 2018 sind die Leistungen in allen europäischen OECD-Ländern gesunken, in vielen davon um mehr als 20 Punkte.

Die Mathematikleistungen des Balkanblocks liegen im Durchschnitt um 80 Punkte unter denen des OECD-Blocks, wobei der Kosovo (355 Punkte), Albanien (368 Punkte) und Nordmazedonien (389 Punkte) die schlechtesten Wertungen erhielten, im Durchschnitt Kompetenzstufe 2 nicht erreichten. Auch in Naturwissenschaften und Lesen schnitten diese und die anderen Länder des Balkanblocks ganz ähnlich ab wie in Mathematik.

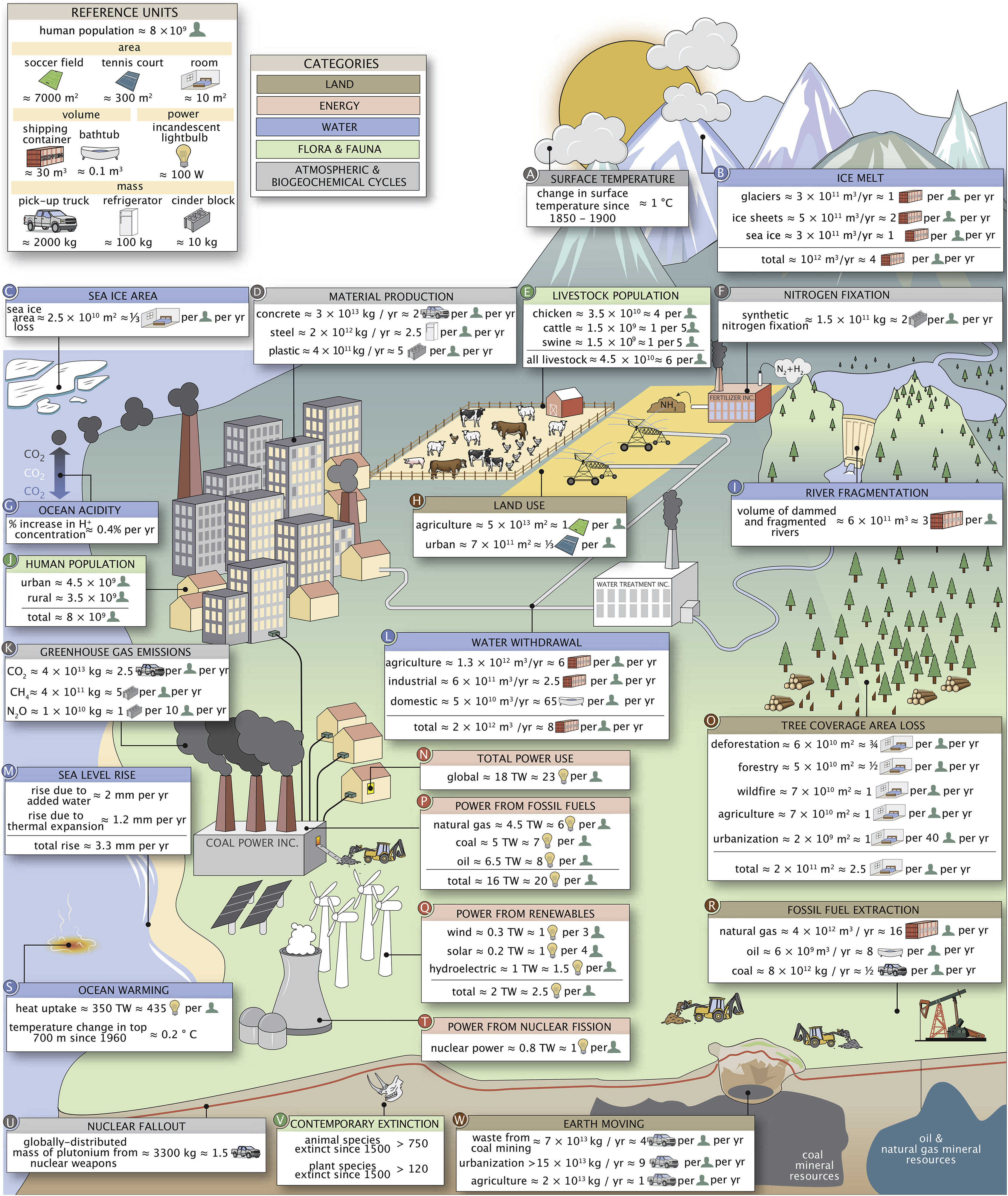

Leistungstrends in Österreich und Vergleichsländern

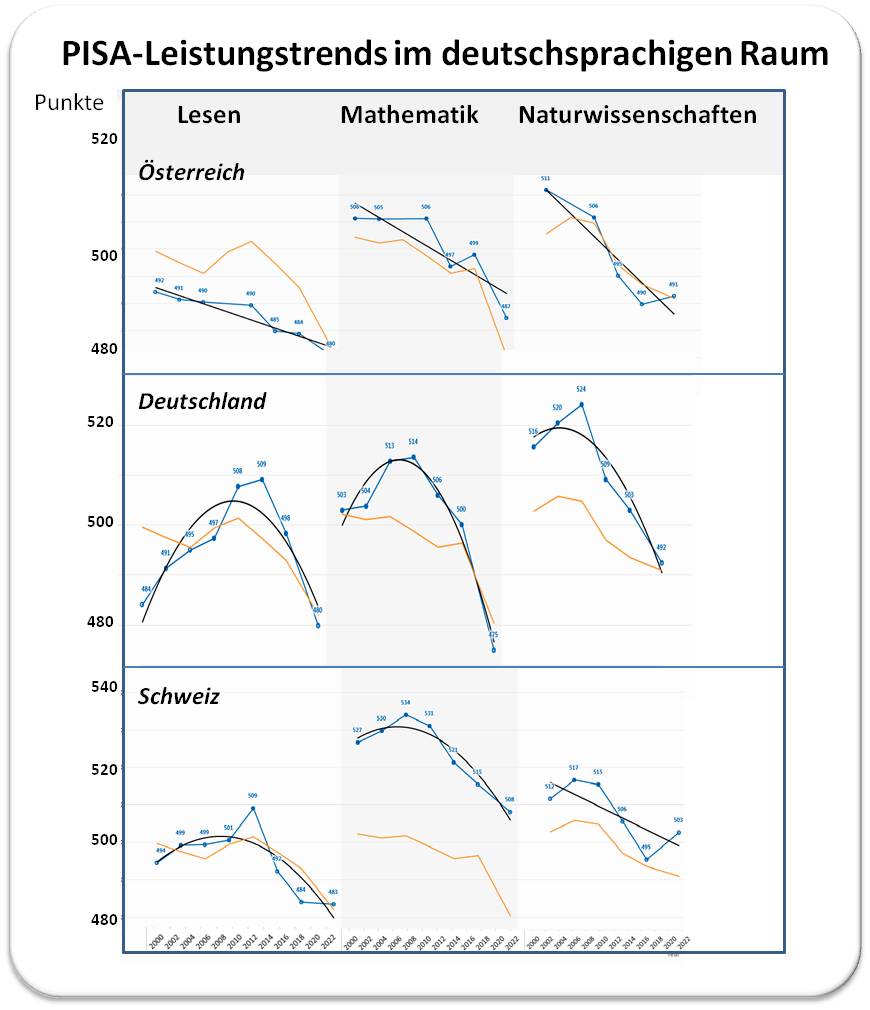

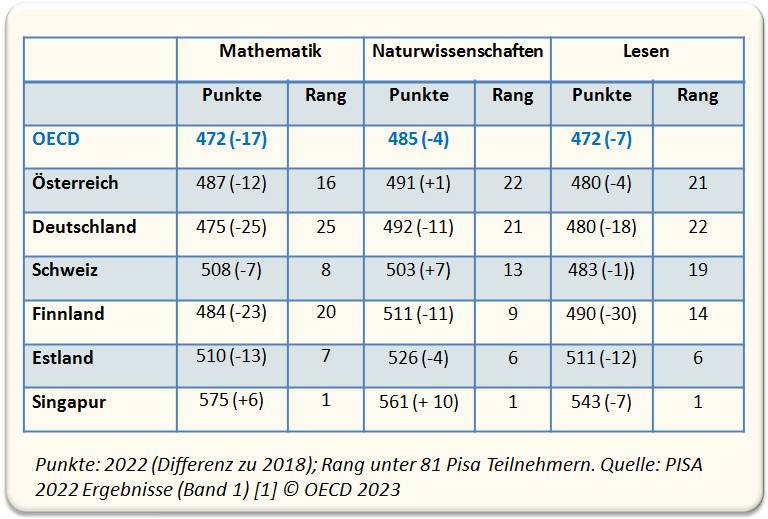

Die Durchschnittsergebnisse in Mathematik, Naturwissenschaften und Lesekompetenz fielen in Österreich, Deutschland und der Schweiz schwächer aus als in den Jahren davor. Abbildung 3.

| Abbildung 3. Wie haben Schüler in Österreich, Deutschland und der Schweiz in den drei Testbereichen seit 2000 abgeschnitten? Punkte: Durchschnittsleisung, Schwarze Linien: bester Trend, orange Linien: OECD-Durchschnittsleistung (aus nur 23 Ländern! - die Kurven stimmen nicht mit den tatsächlichen OECD-Werten seit 2000 überein.) Quelle: https://www.oecd.org/publication/pisa-2022-results/country-notes/. Lizenz cc-by-nc-sa. |

In den drei Ländern ist der Leistungsdurchschnitt in allen Bereichen seit Beginn der PISA-Tests massiv zurückgegangen, die Länder liegen dennoch über oder am OECD-Durchschnitt: über dem Durchschnitt sind in Mathematik die Schweiz um 36 Punkte, Österreich um 15 Punkte, Deutschland um 3 Punkte; in den Naturwissenschaften um 6 resp. 7 Punkte in Österreich und Deutschland und um 18 Punkte in der Schweiz und schließlich in der Lesekompetenz um jeweils 8 Punkte in Österreich und Deutschland und um 11 Punkte in der Schweiz (siehe auch Tabelle 2).

Wo liegen damit die drei Länder in der globalen Bewertung?

Als Vergleichsländer sollen das frühere Vorzeigeland Finnland, die derzeitige Nummer 1 in Europa, Estland und die globale Nummer 1 Singapur dienen (Tabelle 2).

Auch in Finnland und Estland sind die Leistungen seit 2018 in allen Gebieten zurückgegangen, in Singapur dagegen in Mathematik und Naturwissenschaften noch gestiegen - dort liegen diese nun um bis zu 100 Punkten über den Bewertungen unserer Länder.

| Tabelle 2. Durchschnittliche Schülerleistungen in den deutschsprachigen Ländern und Vergleichsländern. |

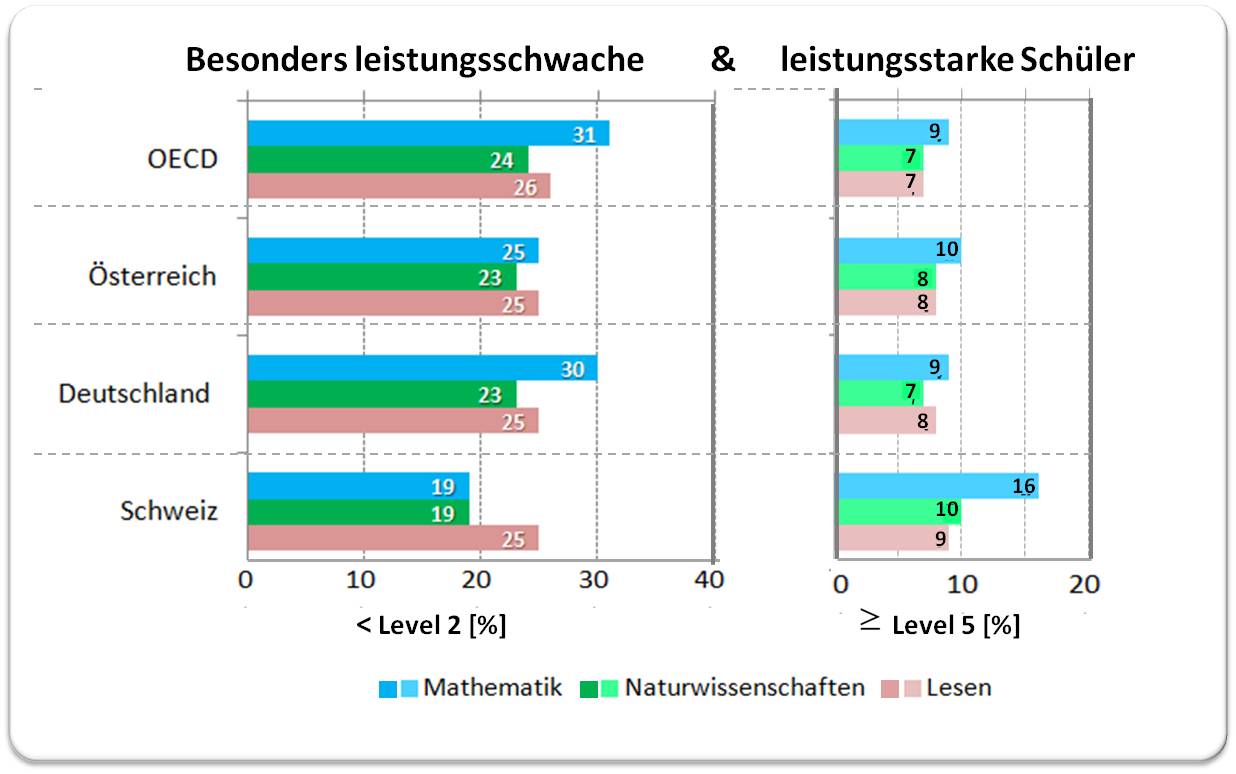

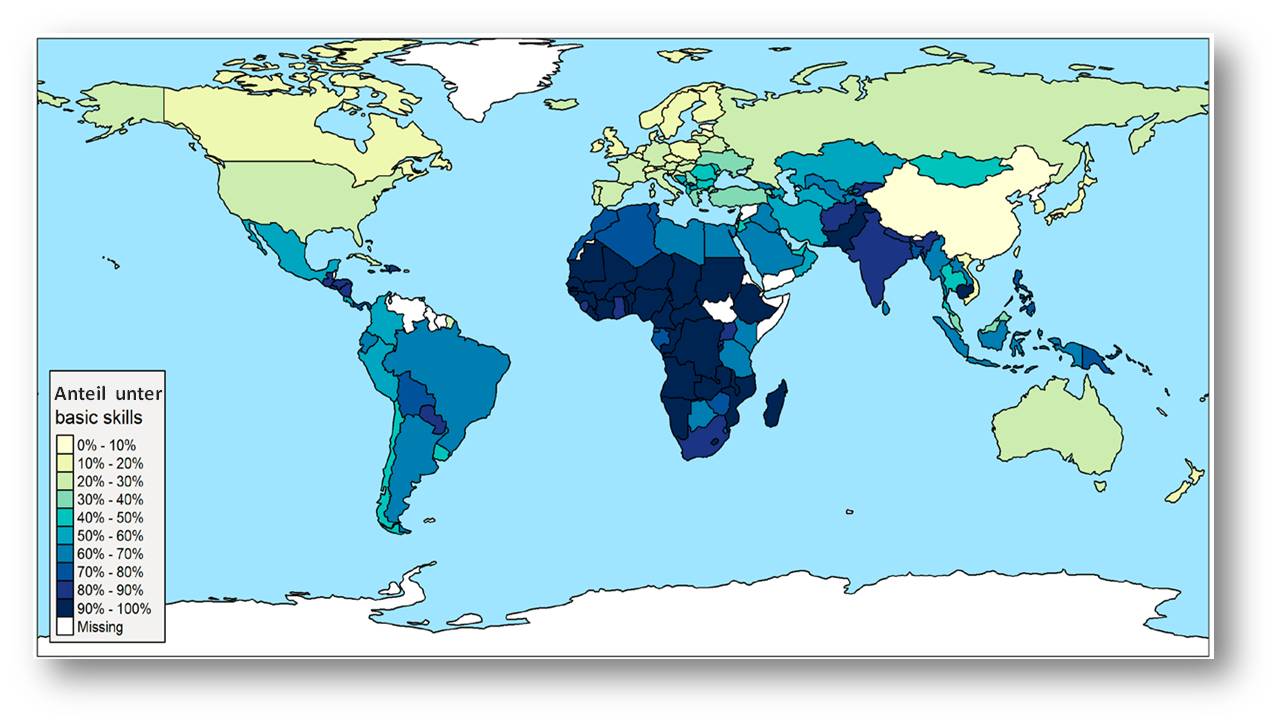

Leistungsschwache und leistungsstarke Schüler

Wie bereits früher erwähnt, liegt der Anteil der Schüler die die Grundkompetenzstufe 2 nicht erreichen im OECD-Durchschnitt bei rund einem Viertel in Naturwissenschaften und in Lesekompetenz und bei fast einem Drittel in Mathematik. Etwa 9 % der Schüler erreichten die höchsten Leistungsniveaus in Mathematik und rund 7 % in Naturwissenschaften und Lesekompetenz. Der Anteil leistungsschwacher und leistungsstarker Schüler ist in Deutschland in allen Fächern etwa gleich hoch wie im OECD-Durchschnitt, schwache und starke Leseleistung liegen auch in Österreich und der Schweiz im OECD-Durchschnitt. Österreich und vor allem die Schweiz haben einen niedrigeren Anteil an sehr schwachen und einen höheren Anteil an starken Mathematik-Schülern. In Naturwissenschaften liegt Österreich etwas, die Schweiz stärker über dem OECD-Durchschnitt. Abbildung 4. Der Anteil der leistungsschwachen Schüler ist in Österreich seit 2012 um jeweils 6 % in Mathematik und in den Naturwissenschaften und um 5 % in Lesekompetenz gewachsen.

| Abbildung 4. Anteil der Schüler [%], welche die Grundkompetenzstufe 2 nicht erreichten und welche mindestens Kompetenzstufe 5 erzielten. Quelle: PISA-2022-Datenbank, Tabelle I.B1.5.1–12, I.B1.5.19, I.B1.5.20 und I.B1.5.21[1] |

Im Vergleich dazu:

Estland, die Nummer 1 in Europa weist mit 15 % in Mathematik, 10 % in Naturwissenschaften und 14 % im Lesen wesentlich niedrigere Anteile an sehr schwachen und mit 13 % in Mathematik, 12 % in Naturwissenschaften und 11% im Lesen höhere Anteile an leistungsstarken Schülern auf als die deutschsprachigen Länder.

In Mathematik nimmt Singapur die globale Spitzenposition ein: 8 % liegen unter Kompetenzstufe 2 und 41 % erreichten Stufe 5, 6. Spitzenleistungen in Mathematik erzielten auch die anderen ostasiatischen Staaten/Volkswirtschaften Taipei (32%), Macao (China) (29%), Hong Kong (27%), Japan (23%) und Korea (23%).

Insgesamt gesehen und für das weitere Berufsleben entscheidend ist der Anteil der 15-Jähringen, die in allen 3 Fächern die Grundkompetenzstufe nicht erreichen: im OECD-Raum liegt dieser bei 16,4 %, in Deutschland (16,7 %) vergleichbar hoch, in Österreich (15,5 %) kaum viel niedriger und auch in der Schweiz mit 12,4 % noch zu hoch. In Estland sind es dagegen nur 5,2 % (Tabelle 1.1[1]).

Wie lässt sich der Rückgang der Schülerleistungen seit 2018 erklären?

Wie oben bereits erwähnt - sicherlich nicht ausschließlich durch die Folgen der Corona-Pandemie. Auf keinen Fall auch durch die weltweiten, seit langem bestehenden Leistungsunterschiede: Buben in Mathematik besser als Mädchen, Mädchen in Lesekompetenz besser als Buben.

Ein wichtiger Prädikator der Schülerleistungen ist der sozioökonomische Status - ESCS -, d.i. der wirtschaftliche, soziale und kulturelle Background der Schüler (ein Index, der sich aus der höchsten Bildungsstufe der Eltern, deren höchster beruflicher Stellung und dem materiellen Wohlstand der Familie zusammensetzt). Wie auch in früheren Studien gezeigt, schneiden sozioökonomisch begünstigte Schüler besser ab als benachteiligte Schüler. Im OECD-Durchschnitt liegt beispielsweise der Leistungsunterschied von begünstigten vs. benachteiligten Schüler in Mathematik bei 93 Punkten. Der aktuelle Punkteabstand in Österreich sind 106 Punkte, in Deutschland 111 Punkte und in der Schweiz 117 Punkte - kein Unterschied zum globalen Top-Performer Singapur bei 112 Punkten.

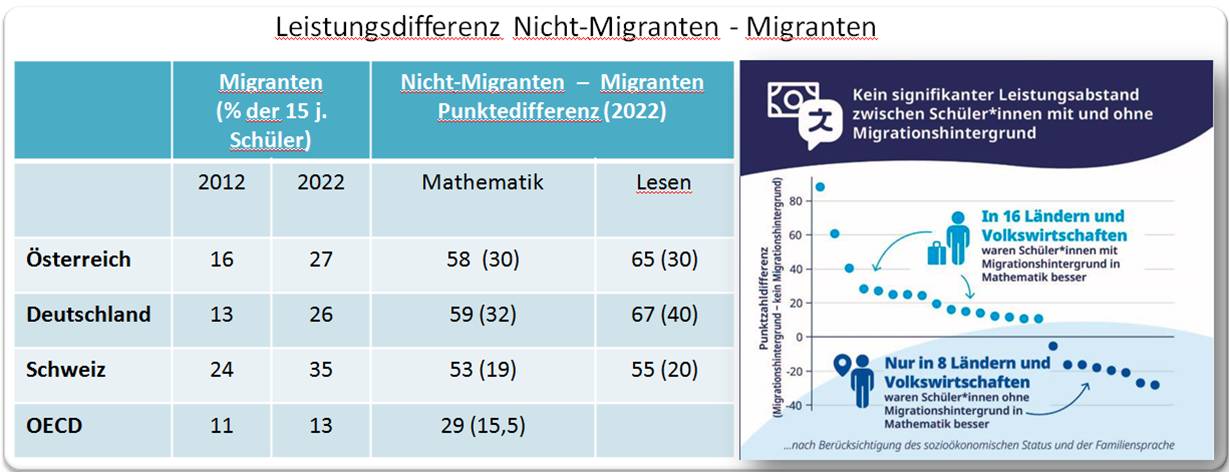

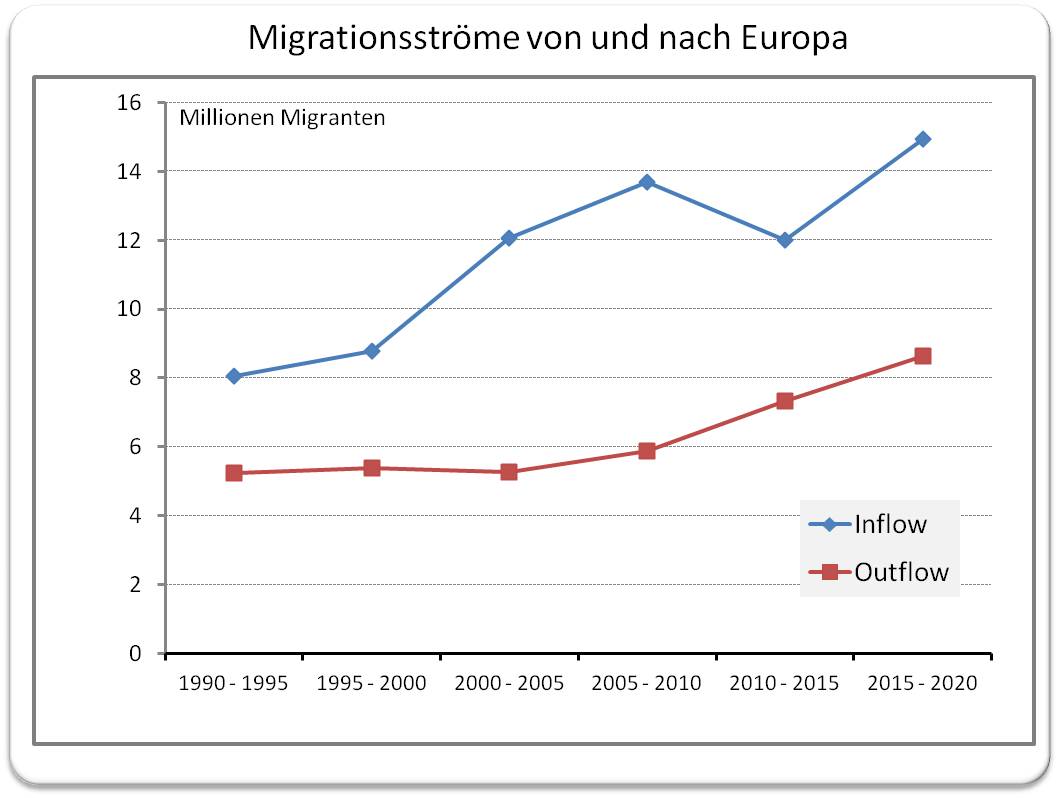

Ein wesentlicher Unterschied liegt allerdings in der Zuwanderung von sozioökonomisch-kulturell unterschiedlich geprägten Menschen. Der Report [1] schreibt dazu "Der Anteil der Schüler mit Migrationshintergrund hat sich in den meisten PISA-Teilnehmerländern seit 2012 nicht nennenswert verändert; in 20 Ländern bzw. Volkswirtschaften ist er jedoch gestiegen und in 5 anderen gesunken. Im OECD-Durchschnitt beträgt der Anteil der 15-jährigen Schüler mit Migrationshintergrund 13 %. In 40 Ländern und Volkswirtschaften machen die Schüler mit Migrationshintergrund weniger als 5 % der Grundgesamtheit der 15-jährigen Schüler, in 11 ist er höher als 25 %."

Zu diesen 11 Ländern gehören Österreich, Deutschland und die Schweiz. In Europa weisen sie die höchsten Anteile von 15-jährigen Schülern mit Migrationshintergrund auf und deren Anteil ist seit 2012 enorm gestiegen. Abbildung 5.

| Abbildung 5.Der Anteil der migrantischen Schüler ist zwischen 2012 und 2022 in den deutschsprachigen Ländern im Vergleich zum OECD-Raum enorm gestiegen. Die Leistungsdifferenz kann nur teilweise durch den unterschiedlichen sozioökonomischen Background erklärt werden. Punktedifferenz: nicht-migrantische vs migrantische Schüler- in Klammer nach Berücksichtigung der soziökonomischen Unterschiede. (Daten aus [1], Bild rechts aus Key Results Infografic [4], Lizenz: cc-by-nc-sa) |

Der PISA-Report fährt fort: "Der Anteil der sozioökonomisch benachteiligten Schüler ist im OECD-Durchschnitt unter den Schülern mit Migrationshintergrund größer (37 %) als unter denen ohne (22 %)" [1]. In den meisten Ländern schneiden daher Schüler ohne Migrationshintergrund in allen PISA-Erhebungsbereichen besser ab. Erschwerend kommt noch die Sprachbarriere hinzu - Schüler mit Migrationshintergrund sprechen zu Hause überwiegend eine andere Sprache als die Schulsprache - In Österreich, Deutschland und der Schweiz sind dies mehr als 60 %.

Die hohen Migrationsströme in die deutschsprachigen Länder haben zweifellos zu einem Rückgang der Durchschnittsleistungen beigetragen; im Vergleich dazu gibt es in der Nummer 1 in Europa, Estland, nur 8,7 % Schüler mit Migrationshintergrund, die sich zudem in den Leistungen von den anderen Schülern weniger unterscheiden.

Die mit "Kein signifikanter Unterschied zwischen Schüler*innen mit und ohne Migrationshintergrund" übertitelte Infografik in Abbildung 5 ist wiederum ein clickbait, der nicht die reale Situation, sondern bloß ein Wunschdenken der OECD vermittelt: "Wenn die Bildungspolitik sozioökonomische Benachteiligung und Sprachbarrieren bei Schüler*innen mit Migrationshintergrund ausgleicht (u. a. durch einen gezielten Einsatz von Bildungsressourcen zugunsten sozioökonomisch benachteiligter Schüler*innen mit Migrationshintergrund), können die Länder und Volkswirtschaften die Leistungen ihrer Schüler*innen mit Migrationshintergrund beträchtlich steigern."[1]

Ein wenig ermunternder Ausblick

den Andreas Schleicher, Direktor für Bildung und Kompetenzen bei der OECD, in dem Report Insights and Interpretations gibt [3]."Die Ergebnisse bieten eine Momentaufnahme der Bildungssysteme zu einem bestimmten Zeitpunkt; aber sie zeigen nicht - sie können nicht zeigen - wie die Schulsysteme zu diesem Punkt gekommen sind oder die Institutionen und Organisationen, die den Fortschritt gefördert oder behindert haben könnten. Außerdem sagen die Daten nicht wirklich viel über Ursache und Wirkung aus. Wir wissen zwar besser, was erfolgreiche Systeme tun, aber das sagt uns nicht unbedingt, wie wir weniger erfolgreiche Systeme verbessern können."[3]

Vielleicht hätte Schleicher auf die OECD-Definition des sozioökomischen Profils Bezug nehmen sollen, das durch den PISA-Index des ökonomischen, sozialen und kulturellen Status gemessen wird. Was die als Sieger im PISA-Test hervorgehenden ostasiatischen Länder auszeichnet, ist eine Weltanschauung, die auf Lernen und Leistung ausgerichtet ist. Um dazu den Lehrmeister Konfuzius zu zitieren:

Etwas lernen und mit der Zeit darin immer geübter werden,

ist das nicht auch eine Freude? [6].

[1] OECD (2023), PISA 2022 Ergebnisse (Band I): Lernstände und Bildungsgerechtigkeit, PISA, OECD Publishing, Paris, , https://doi.org/10.1787/b359f9ab-de.

[2] OECD (2023), PISA 2022 Results (Volume II): Learning During – and From – Disruption, PISA, OECD Publishing, Paris, https://doi.org/10.1787/a97db61c-en.

[3] Andras Schleicher: Insights and Interpretations: https://www.oecd.org/pisa/PISA%202022%20Insights%20and%20Interpretations.pdf

[4] PISA 2022 key results (infographic): https://www.oecd-ilibrary.org/sites/afda44bb-en/index.html?itemId=/content/component/afda44bb-en

[5] Erzinger, A. B., et al., (Hrsg.) (2023). PISA 2022. Die Schweiz im Fokus. Universität Bern. https://dx.doi.org/10.48350/187037

[6] Konfuzius-Aussprüche: https://www.aphorismen.de/zitat/3971, abgefragt am 10.12.2023

Artikel zum Thema im ScienceBlog:

Inge Schuster, 04.02.2023: Enorme weltweite Bildungsdefizite - alarmierende Zahlen auch in Europa.

Inge Schuster, 30.10.2021: Eurobarometer 516: Umfrage zu Kenntnissen und Ansichten der Europäer über Wissenschaft und Technologie - blamable Ergebnisse für Österreich

Inge Schuster, 03.10.2021: Special Eurobarometer 516: Interesse der europäischen Bürger an Wissenschaft & Technologie und ihre Informiertheit

Inge Schuster, 10.08.2017: Migration und naturwissenschaftliche Bildung

Roboter lernen die Welt entdecken

Roboter lernen die Welt entdeckenSa, 02.12.2023 — Roland Wengenmayr

Roboter können den Menschen heute bereits bei manchen alltäglichen Aufgaben unterstützen. Doch unbekannte Umgebungen oder auch kleine Abweichungen in den Aufgaben, auf die sie trainiert sind, überfordern sie. Damit sie rascher lernen, sich auf Neues einzustellen, entwickeln die Forschungsgruppen von Michael Mühlebach und Jörg Stückler am Max-Planck-Institut für Intelligente Systeme in Tübingen neue Trainingsmethoden für die Maschinen. Ihre Roboter müssen sich dabei auch im Pingpong oder Bodyflying bewähren.*

|

Anspruch und nicht Wirklichkeit: Bis Roboter so geschmeidig wie Menschen tanzen und dabei auch Bewegungen improvisieren können wie auf diesem mit KI erstellten Foto, wird es noch eine Weile dauern. Ihnen eine Art Körpergefühl zu vermitteln, ist ein Schritt in diese Richtung |

Intelligent handelnde Roboter waren schon ein Technikmythos, ehe es Maschinen gab, die diese Bezeichnung auch nur annähernd verdienten. Doch was können Roboter heute wirklich? Wie weit sind sie noch von Science-Fiction-Ikonen wie dem amüsant menschelnden C-3PO aus Star Wars entfernt? Bei der Suche auf Youtube landet man schnell bei einem Video der US-amerikanischen Roboterfirma Boston Dynamics. Darin verblüfft der humanoide Roboter Atlas mit Saltos, er rennt und hüpft mit einem Zwillingsbruder über einen anspruchsvollen Trainingsparcours oder unterstützt einen Menschen auf einem Baugerüst (Links zu Videos im Anhang; Anm. Redn.). Doch so beeindruckend leichtfüßig und fast unheimlich menschenähnlich sich diese Roboter auch bewegen können: Sie tun dies in einer vertrauten Umgebung, auf die sie trainiert worden sind. Wozu Atlas und Konsorten tatsächlich fähig wären, wenn sie sich in einem für sie komplett neuen Umfeld orientieren und selbstständig handeln müssten, das erfährt man nicht – Firmengeheimnis.

Joachim Hertzberg, wissenschaftlicher Direktor am Deutschen Forschungszentrum für Künstliche Intelligenz und Professor an der Universität Osnabrück, ist beeindruckt von der komplexen Bewegungsfähigkeit der Roboter von Boston Dynamics. Doch er wendet auch gleich ein: Würde man einem heutigen Roboter den Befehl geben, in einer ihm unbekannten Umgebung einen Auftrag selbstständig und planvoll auszuführen, und sei es nur, einen Kaffee zu holen, sähe das Resultat deutlich weniger spektakulär aus. „Das Gebiet heißt zwar künstliche Intelligenz, aber es kommt auf Intelligenz an, die wir selber für völlig unintelligent halten“, sagt Hertzberg, „also die Fähigkeit, sich in einer Umgebung vernünftig zurechtzufinden, Aufgaben zum ersten Mal zu machen, ohne sie zuvor geübt zu haben, situations- und zielangemessen zu handeln.“

Flexible Algorithmen

Einen Schritt hin zu Robotern, die auch in unbekannten Umgebungen und bei neuen Aufgaben die Orientierung behalten, machen Maschinen, die permanent lernen – und das möglichst schnell. An solchen Systemen arbeiten zwei Teams am Max-Planck-Institut für Intelligente Systeme in Tübingen. Anders als Unternehmen oder anwendungsorientierte Forschungseinrichtungen reduzieren die Forschenden die Komplexität der Aufgaben, die ihre Maschinen bewältigen müssen, um diesen zunächst elementare Aspekte der Orientierung beizubringen. Michael Mühlebachs Gruppe beschäftigt sich mit der Frage, wie Roboter durch Vorwissen über ihre eigenen physikalischen Eigenschaften, vermenschlicht ausgedrückt, eine Art Körpergefühl trainieren können. Denn dieses brauchen sie, um sich in einer unbekannten Umgebung bewegen und Befehle präzise ausführen zu können. Darum geht es auch in Jörg Stücklers Gruppe, die daran arbeitet, Robotern das Sehen beizubringen. Zum Sehen gehört, dass Roboter lernen, Objekte – ruhend und bewegt – in beliebiger Umgebung zu erkennen. Das Erkennen beschränkt sich hier allerdings auf rein physikalische Eigenschaften der Objekte, etwa ihre Größe, Form und Farbe, was allein schon eine gewaltige Herausforderung ist.

Ein permanent lernender Algorithmus steckt etwa im Tischtennisroboter Pamy, dessen Hardware weitgehend die Gruppe von Dieter Büchler am Tübinger Max-Planck-Institut entwickelt hat. Auf Veränderungen im Spiel muss Pamy nämlich flexibel reagieren. Einstweilen trainiert der einarmige Roboter mit einer Ballmaschine, um die künftige Flugbahn eines Balls richtig einschätzen zu lernen. Das Experiment befindet sich in einem Labor, in das Michael Mühlebach führt. Dort empfängt uns sein Doktorand Hao Ma in einer Geräuschkulisse, als wären wir im Trainingscamp einer Luftpumpenmannschaft gelandet.

Hao Ma muss angesichts des verblüfft dreinschauenden Gasts grinsen und deutet auf einen abgesperrten Bereich. Dort vollführt ein einzelner Roboterarm – Pamy ist einarmig – auf einer Art Podest mit einem Pingpong-Schläger laut schnaufend wilde Trockenübungen ohne Ball. Abbildung. Zwei Aluminiumrohre, verbunden mit Kunststoffgelenken, bilden Ober- und Unterarm, die Hand besteht aus einem Gelenk mit festgeschraubtem Schläger. Zu den Gelenken führen Luftschläuche, die unten im Podest an eine Batterie von Pneumatikzylindern angeschlossen sind. In den transparenten Zylindern sieht man Kolben auf und ab stampfen. Sie drücken Luft in die pneumatisch angetriebenen Gelenke hinein oder saugen sie ab und bewegen so den Arm.

|

Anspruch und nicht Wirklichkeit: Bis Roboter so geschmeidig wie Menschen tanzen und dabei auch Bewegungen improvisieren können wie auf diesem mit KI erstellten Foto, wird es noch eine Weile dauern. Ihnen eine Art Körpergefühl zu vermitteln, ist ein Schritt in diese Richtung. (Foto: Wolfram Scheible für MPG. © 2023, MPG) |

Solche luftdruckbetriebenen Muskeln erlauben eine sehr leichte Bauweise ohne Elektromotoren an den Gelenken, weshalb ein Roboterarm schnelle Bewegungen ausführen kann. Diese Konstruktion hat allerdings einen Nachteil: Der Arm federt sichtlich nach. Dieses elastische Verhalten muss die Steuerung genau kennen, um einen Tischtennisball präzise retournieren zu können. Das dafür nötige Körpergefühl erlernt Pamy gerade durch das Luft-Pingpong mithilfe von Kameras, Winkel- und Drucksensoren, die seine Bewegungen live verfolgen. Bei diesem Lernprozess kommt ein zentraler Forschungsansatz von Mühlebachs Team ins Spiel. Damit die Steuerung des Arms nicht mühsam bei null beginnen muss, wenn sie dessen Eigenschaften erlernt, hat das Team Pamy bereits mit einem einfachen physikalischen Modell programmiert. Es repräsentiert den Arm mit ideal steifen Stäben und idealisierten Gelenken. „Schwierig zu beschreiben ist aber das Verhalten der ,Muskeln‘ aus den Plastikbehältern, die sich mit Luft füllen“, erklärt Mühlebach: „Dafür setze ich maschinelles Lernen ein.“ Der dafür verwendete Algorithmus nutzt Kameraaufnahmen nur noch, um das Nachfedern der pneumatischen Bewegungen zu erlernen. Das spart viel Rechenzeit. Ohne das Vorwissen durch das physikalische Modell würde Pamy sechzehn Stunden benötigen, um eine Art Körpergefühl erlernen, sagt Mühlebach. „Mit dem Modell kriegen wir das in ungefähr einer Stunde hin.“ Roboterlernen durch physikalisches Vorwissen zu beschleunigen, ist dabei eine zentrale Strategie in Mühlebachs und Stücklers Forschung. Ma führt im Labor an eine Tischtennisplatte. Dort darf nun das Vorgängermodell des Roboterarms, der noch mit Luft-Pingpong beschäftigt ist, zeigen, was es kann. Eine drehbare Ballmaschine schießt einen Tischtennisball über die Platte, der springt in Pamys Feld einmal auf, ehe die Maschine ihn sauber zurückschlägt. Sie tut dies beeindruckend zuverlässig mit jedem neuen Ball. Ma zeigt auf vier Kameras, die oben über dem Tisch befestigt sind. Sie verfolgen die Bahn der leuchtend orangefarbenen Bälle. Ein Algorithmus hat inzwischen gelernt, die künftige Flugbahn eines Balls aus der bisherigen Bahnkurve so genau vorherzusagen, dass der Roboterarm wie ein geübter menschlicher Spieler reagiert und richtig trifft.

„In einer neuen Version der Ballvorhersage haben wir auch einbezogen, wie der Ball abgeschossen wird“, sagt Jörg Stückler. Das wäre bei einem menschlichen Gegner zwar ungleich schwieriger, doch die Erfahrung mit der Ballmaschine zeigt, wie das im Prinzip gehen könnte. Pamy kann nämlich auch auf Vorwissen über die Ballmaschine zurückgreifen. Das hat Jan Achterhold, Doktorand in Jörg Stücklers Team, dem Roboter beigebracht. Das entsprechende Modell berücksichtigt sogar, dass diese Maschine dem Ball einen Spin geben kann. Dadurch wird der Ball nach dem Aufsetzen im Feld des Roboterarms seitlich abgelenkt. Darauf muss Pamy sofort reagieren, was für den Roboter eine große Herausforderung ist.

Härtetest Bodyflying

Als Modell der Ballmaschine verwendeten Achterhold und Stückler dabei ein Grey-Box-Modell. Stückler erklärt, dies sei ein Zwischending zwischen einem Blackund einem White-Box-Modell. Das Black-Box-Modell steht für Maschinenlernen ohne jegliches Vorwissen, also mühsames Ausprobieren. Ein White-Box-Modell wäre das Gegenteil: ein unveränderlich programmiertes physikalisches Modell, das nicht lernfähig ist. In einer einfachen, mechanisch idealen Welt würde das auch funktionieren, denn der Ablauf inklusive Flugbahn ließe sich exakt berechnen. Doch bei einer echten Ballmaschine treten immer Effekte auf, an denen das unflexible White-Box-Modell scheitern würde. Das Team um Achterhold setzt daher auf ein physikalisch vorgebildetes Maschinenlernen. Zu diesem Zweck entwarfen die Forschenden zunächst ein physikalisches Modell und kombinierten es mit einem ausgefeilten Lernalgorithmus, der das System befähigt, die realen Eigenschaften der Ballmaschine zu erlernen. Das Team nutzte also die Vorteile des Black- und des White-Box-Ansatzes. „Deshalb wird der Ansatz Grey Box genannt“, erklärt Stückler. Im Gespräch mit den Roboterforschern wird immer wieder deutlich, welche Herausforderungen scheinbar simple Aktionen, die wir Menschen unbewusst und selbstverständlich ausführen, für die Robotik darstellen. Dabei will Michael Mühlebach es wirklich wissen. „Ich bin fasziniert vom Bodyflying, von der Akrobatik, den Drehungen und Kunststücken“, sagt er lachend: „Und da dachte ich: Es wäre doch super, das mit Robotern zu machen!“ Beim Bodyflying, auch Indoor Skydiving genannt, schweben Menschen im starken Luftstrom eines senkrecht nach oben gerichteten Windkanals. Wie beim Fallschirmsprung müssen sie lernen, wie sie ihr Flugverhalten auf dem Luftpolster durch Veränderungen ihrer Körperhaltung und damit der Aerodynamik gezielt steuern können.

Das soll in Tübingen nun ein leichter Flugroboter, kaum größer als eine Hand, über einem Miniwindkanal erlernen. Doktorand Ghadeer Elmkaiel tüftelt in seinem Labor gerade an dem selbst entwickelten Windkanal, der mit sechs kreisförmig angeordneten Propellern einen möglichst gleichmäßigen Luftstrom erzielen soll. Über der öffnung des Windkanals befindet sich eine Haltevorrichtung für den kleinen Flieger. Beim Training löst sich der Roboter davon und versucht, ohne Verbindung zu einem Computer zu schweben. Dabei soll er nach und nach vorgegebene Flugfiguren erlernen. Noch ist es nicht so weit, aber auch hier soll das Vorwissen eines einfachen physikalischen Modells den Lernprozess des Flugroboters beschleunigen.

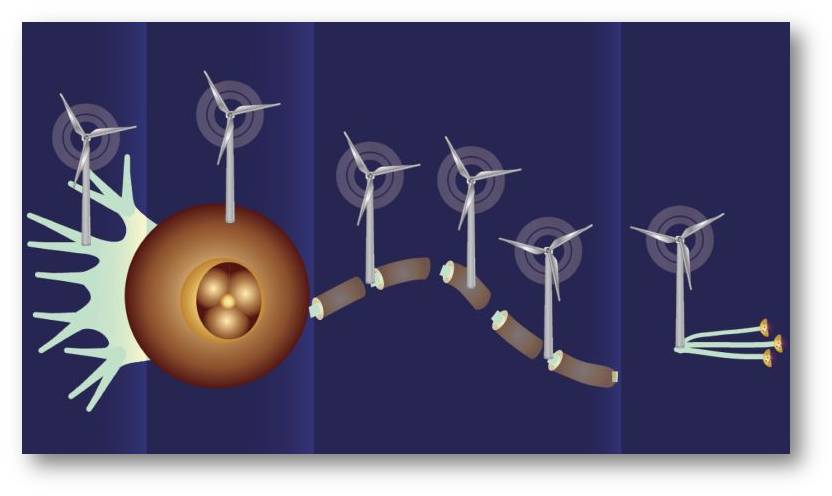

Was Mühlebachs Team bei dem Härtetest der Orientierungsfähigkeit von Robotern lernt, könnte auch in ganz anderen Bereichen Anwendung finden – etwa bei intelligenten Stromnetzen. Sie sollen die Stromproduktion und -verteilung möglichst gut an den jeweiligen Bedarf anpassen. Das wird beim Ausbau dezentraler Windkraftund Solaranlagen, deren Stromproduktion zudem vom Wetter abhängt, immer wichtiger und anspruchsvoller. In einem solchen Netzwerk gibt es ebenfalls Elemente, die sich gut durch physikalische Modelle beschreiben lassen, und solche, deren Verhalten nur durch Lernerfahrung vorhersagbar wird. In die erste Kategorie fallen etwa Großkraftwerke, deren Stromproduktion sich physikalisch gut modellieren lässt. Der Strommarkt und das Verhalten der Endverbraucher hingegen sind erst durch Erfahrung, zum Beispiel über Jahreszeiten, vorhersagbar. „Dort gibt es ein Riesenpotenzial für maschinelles Lernen“, sagt Mühlebach. Doch zurück zur Orientierung. Jörg Stücklers Gruppe arbeitet zum Beispiel an der Weiterentwicklung einer Technik, welche Kameradaten kombiniert mit den Daten von Beschleunigungssensoren, wie sie auch in Smartphones eingebaut sind. Die Beschleunigungssensoren geben einem Roboter sozusagen einen Gleichgewichtssinn, erklärt Stückler. Durch die Kombination mit Kameradaten soll der Roboter ein Wissen darüber entwickeln, wie sein realer Körper auf einen Befehl reagiert. Soll er zum Beispiel losfahren, braucht er ein Gefühl dafür, dass er seine Masse zunächst auf die vorgegebene Geschwindigkeit beschleunigen muss. Dieses Körpergefühl entwickelt der Roboter viel schneller, wenn er mit einem einfachen physikalischen Modell von sich programmiert wurde.

Wenn ein Roboter mit Gegenständen hantieren soll, braucht er nicht nur ein gutes Gefühl für seine eigenen Bewegungen, er braucht auch eine Vorstellung von den Objekten und ihren Eigenschaften. Dass er diese allein durch Beobachtungen erkennen kann, ist das Ziel von Doktorand Michael Strecke. Da die Kameradaten verrauscht, also unscharf sind, lässt sich aus ihnen nicht einfach die Form oder die Größe eines Objekts herauslesen. Beobachtet der Roboter allerdings, wie eine immer wieder geworfene Kugel gegen eine Wand dotzt, zurückprallt und zu Boden fällt, lernt er trotzdem etwas über die Eigenschaften der Kugel. Er begreift allmählich, wie groß die Kugel ist und dass sie daher auf eine bestimmte Weise zurückprallt. So lernt er allein durch die Anschauung einzuschätzen, wie sich ein solches Objekt voraussichtlich verhalten wird.

Grundsätzlich lässt sich also aus dem reinen Beobachten des mechanischen Kontakts eines Objekts mit einem anderen auf deren Eigenschaften schließen. Kleinkinder lernen auf diese Weise, wenn sie Gegenstände herumschmeißen und diese beobachten. Wenn Computer sehen, funktionierte diese Kontaktmethode bislang nur für steife Objekte und auch nur für solche mit sehr einfacher Geometrie. Strecke und Stückler ist es jetzt mit einer neuen Optimierungsmethode gelungen, auch das maschinelle Erlernen komplexerer Formen voranzubringen. Sie veranschaulichen dies mit einem etwas absurden Beispiel: Eine Maschine beobachtet ein Objekt, das auf ein anderes fällt, und hält es zunächst für eine Kuh. Im Laufe mehrerer Zusammenstöße der beiden Objekte verwandelt sich die Kuh in der Maschinenwahrnehmung allmählich in eine Art „Badeentenschwimmring“, der wie bei einem Wurfringspiel mit seinem Loch in der Mitte auf einen Stab fällt. Was weit hergeholt erscheint, entspricht einer Situation, in der auch Menschen sich erst einmal völlig neu orientieren müssen. Roboter stehen hier noch ganz am Anfang, sozusagen im Stadium eines Kleinkinds, für das jedes Objekt in seiner Umwelt ganz neu ist. Mit ihren neuen Trainingsmethoden wollen Jörg Stückler und Michael Mühlebach den Maschinen helfen, sich in unbekannten Situationen schneller zu orientieren. Doch der Weg bis zu einem C-3PO, der sich in einem Star-Wars-Abenteuer bei seinem Begleiter R2-D2 beschwert, dass sie schon wieder in ein Schlamassel geraten seien, dürfte noch recht weit sein.

* Der kürzlich im Forschungsmagazin 3/2023 der Max-Planck Gesellschaft unter dem Titel "Roboter entdecken die Welt" erschienene Artikel https://www.mpg.de/20899916/MPF_2023_3.pdf wird - mit Ausnahme des Titels in praktisch unveränderter Form im ScienceBlog wiedergegeben. Die MPG-Pressestelle hat freundlicherweise der Veröffentlichung von Artikeln aus dem Forschungsmagazin auf unserer Seite zugestimmt. (© 2023, Max-Planck-Gesellschaft)

Videos zu Boston Dynamics

Blue Light Technology: Boston Dynamics' Atlas Bot SHOCKS Investors (2023). Video 8:37 min. https://www.youtube.com/watch?v=QKUosKzUCf8

Boston Dynamics: Do You Love Me? (2021). Video 2:54 min. https://www.youtube.com/watch?v=fn3KWM1kuAw&t=138s

Atlas Gets a Grip | Boston Dynamics (2023). Video 1:20 min. https://www.youtube.com/watch?v=-e1_QhJ1EhQ

Ähnliche Inhalte im ScienceBlog:

Paul Rainey, 02.11.2023: Können Mensch und Künstliche Intelligenz zu einer symbiotischen Einheit werden?

Inge Schuster, 12.12.2019: Transhumanismus - der Mensch steuert selbst seine Evolution

Georg Martius, 09.08.2018: Roboter mit eigenem Tatendrang

Francis S. Collins, 26.04.2018: Deep Learning: Wie man Computern beibringt, das Unsichtbare in lebenden Zellen zu "sehen".

Ilse Kryspin-Exner, 31.01.2013: Assistive Technologien als Unterstützung von Aktivem Altern.

Vor der Weltklimakonferenz COP28: durch Landnutzung entstehende Treibhausgas-Emissionen werden von Ländern und IPCC unterschiedlich definiert

Vor der Weltklimakonferenz COP28: durch Landnutzung entstehende Treibhausgas-Emissionen werden von Ländern und IPCC unterschiedlich definiertFr, 24.11.2023 — IIASA

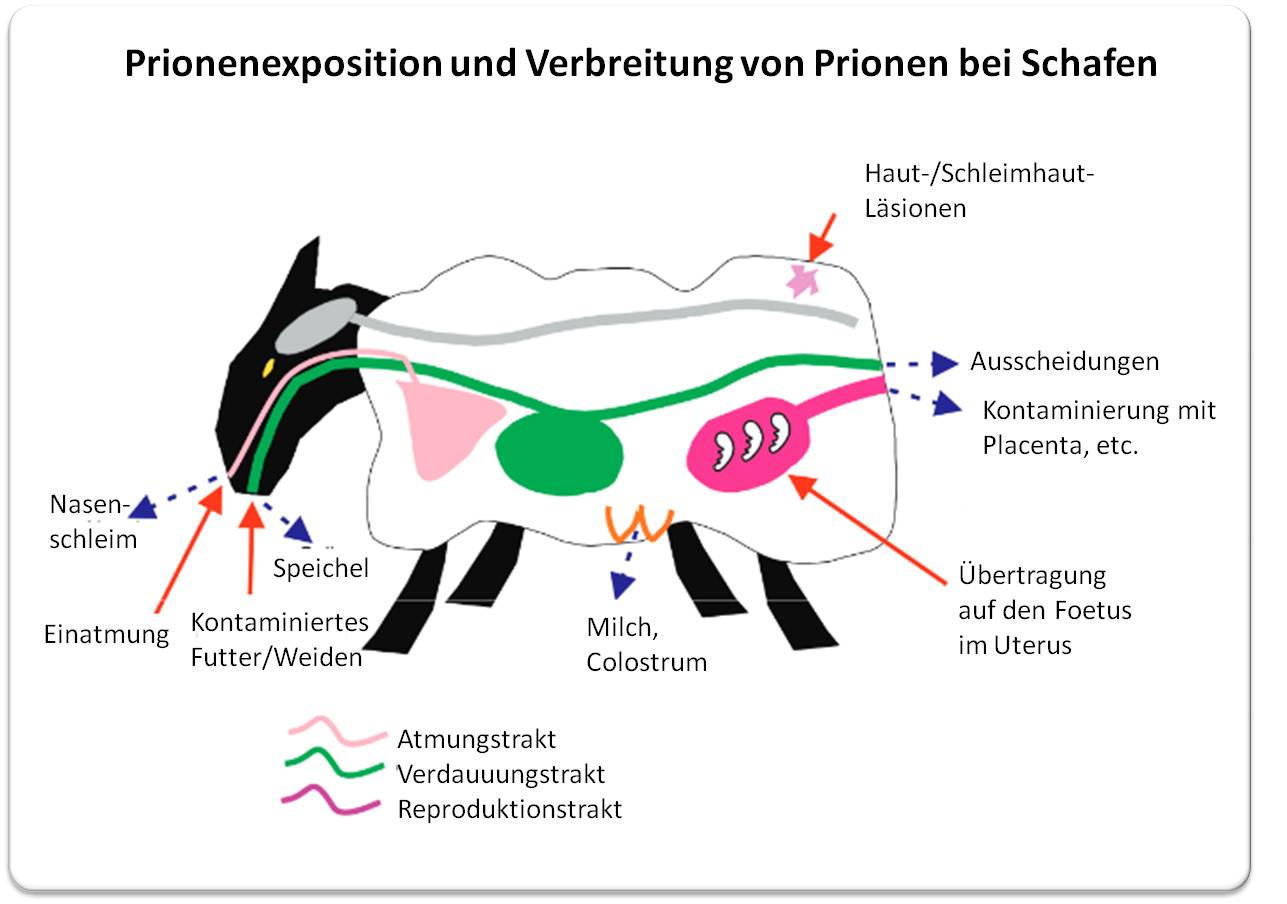

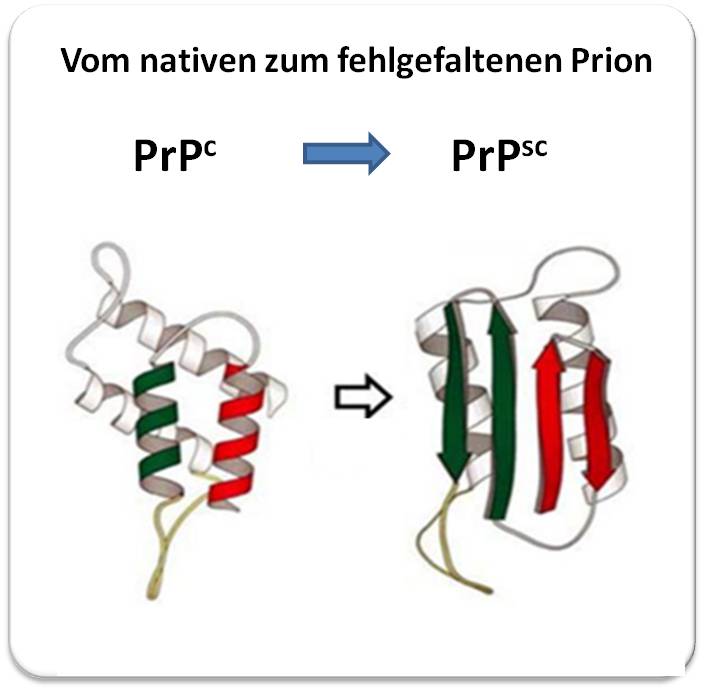

Der Sektor Landnutzung, Landnutzungsänderung und Forstwirtschaft spielt eine wesentliche Rolle bei der Erreichung der globalen Klimaziele - allerdings klafft eine beträchtliche Lücke darin, wie in diesem Sektor die Emissionen durch globale wissenschaftsbasierte Modellierungen abgeschätzt werden und in welcher Weise die Staaten diese berichten. In einer neuen Studie zeigt ein u.a. am Internationalen Institut für Angewandte Systemanalyse (IIASA, Laxenburg bei Wien) arbeitendes Forscherteam auf, wie sich die Benchmarks für die Minderung der Emissionen ändern, wenn die Szenarien des Weltklimarats (IPCC) aus der Perspektive der nationalen Bestandsanalysen bewertet werden; demnach sollten die Netto-Null-Ziele bis zu fünf Jahre früher erreicht werden, und die kumulativen Emissionen bis zum Netto-Null-Ziel um 15 bis 18 % weniger betragen.*

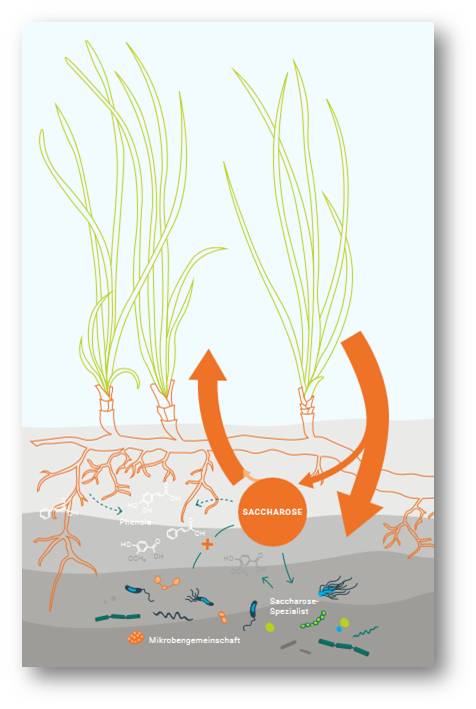

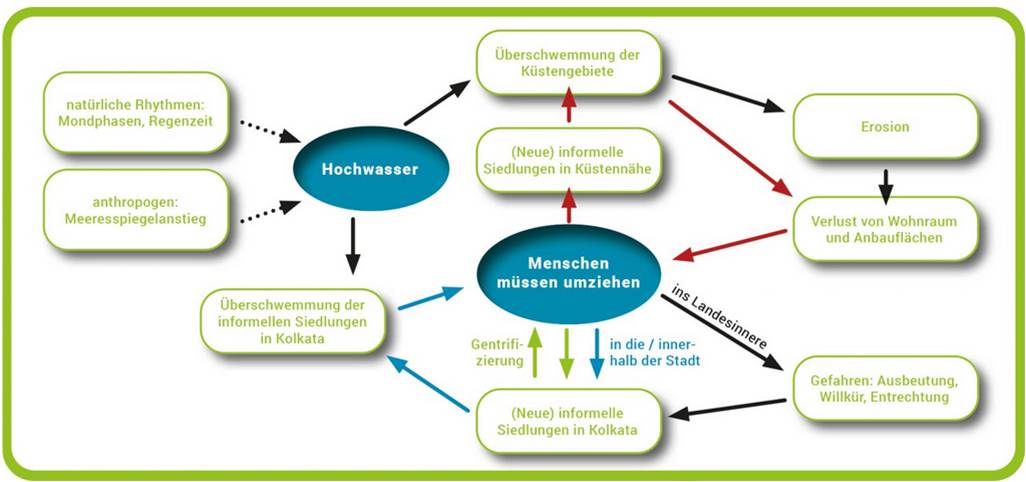

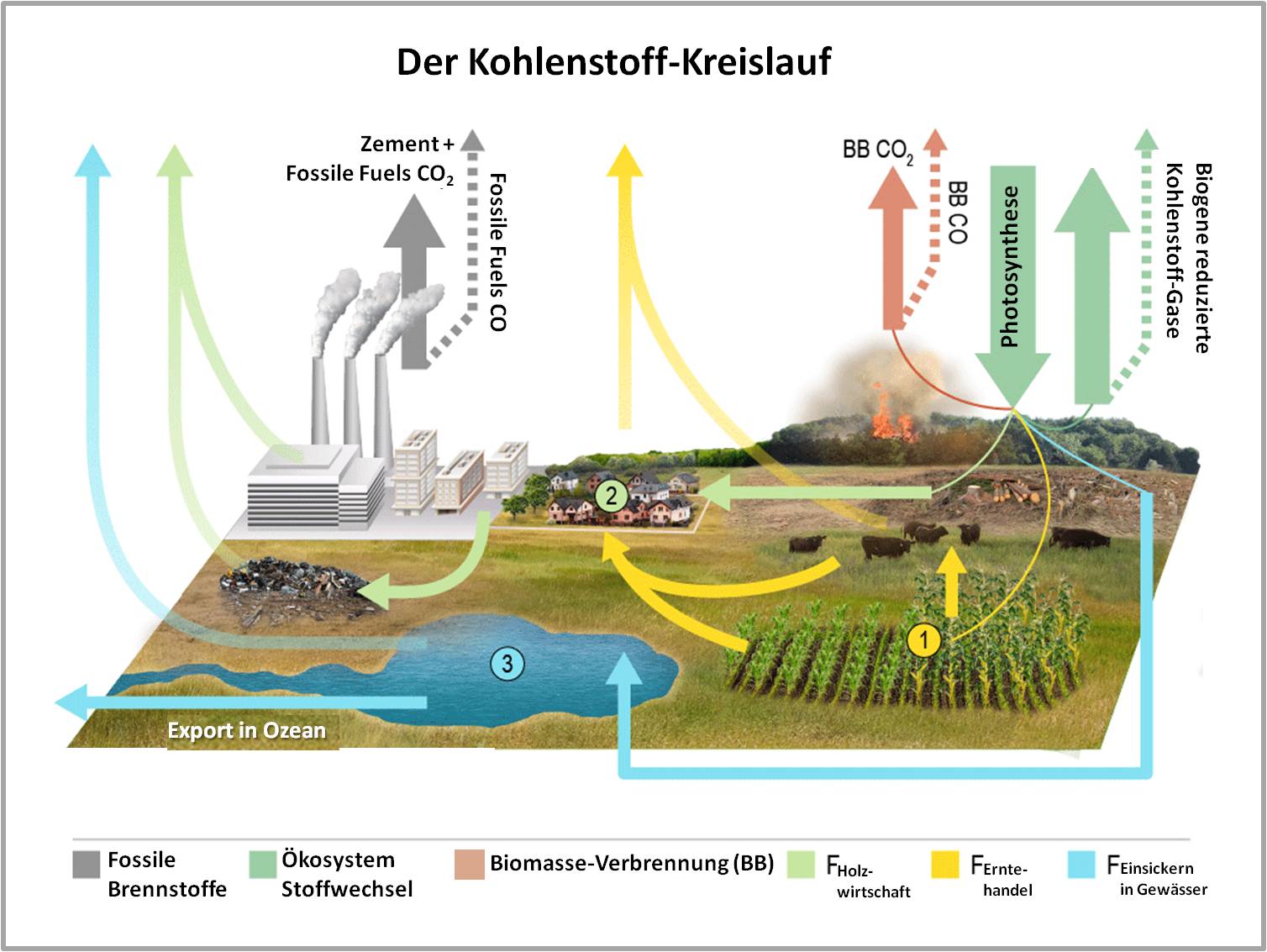

Eine effektive Landnutzung, sei es für Landwirtschaft, Wälder oder Siedlungen, spielt eine entscheidende Rolle bei der Bewältigung des Klimawandels und bei der Erreichung künftiger Klimaziele. Strategien zur Abschwächung des Klimawandels im Bereich der Landnutzung sehen den Stopp der Entwaldung und eine bessere Waldbewirtschaftung vor. Den Staaten ist die Bedeutung des Sektors Landnutzung, Landnutzungsänderung und Forstwirtschaft (Land use, land use change and forestry: LULUCF) bewusst. 118 von 143 Staaten haben die Reduzierung der durch Landnutzung entstehenden Emissionen und deren Entfernung aus der Atmosphäre in ihre national festgelegten Verpflichtungen (Nationally Determined Contributions - NDCs) aufgenommen; diese NDCs sind das Herzstück des Pariser Abkommens zur Erreichung der langfristigen Klimaziele.

Unterschiedliche Schätzungen der Land-basierten Emissionen

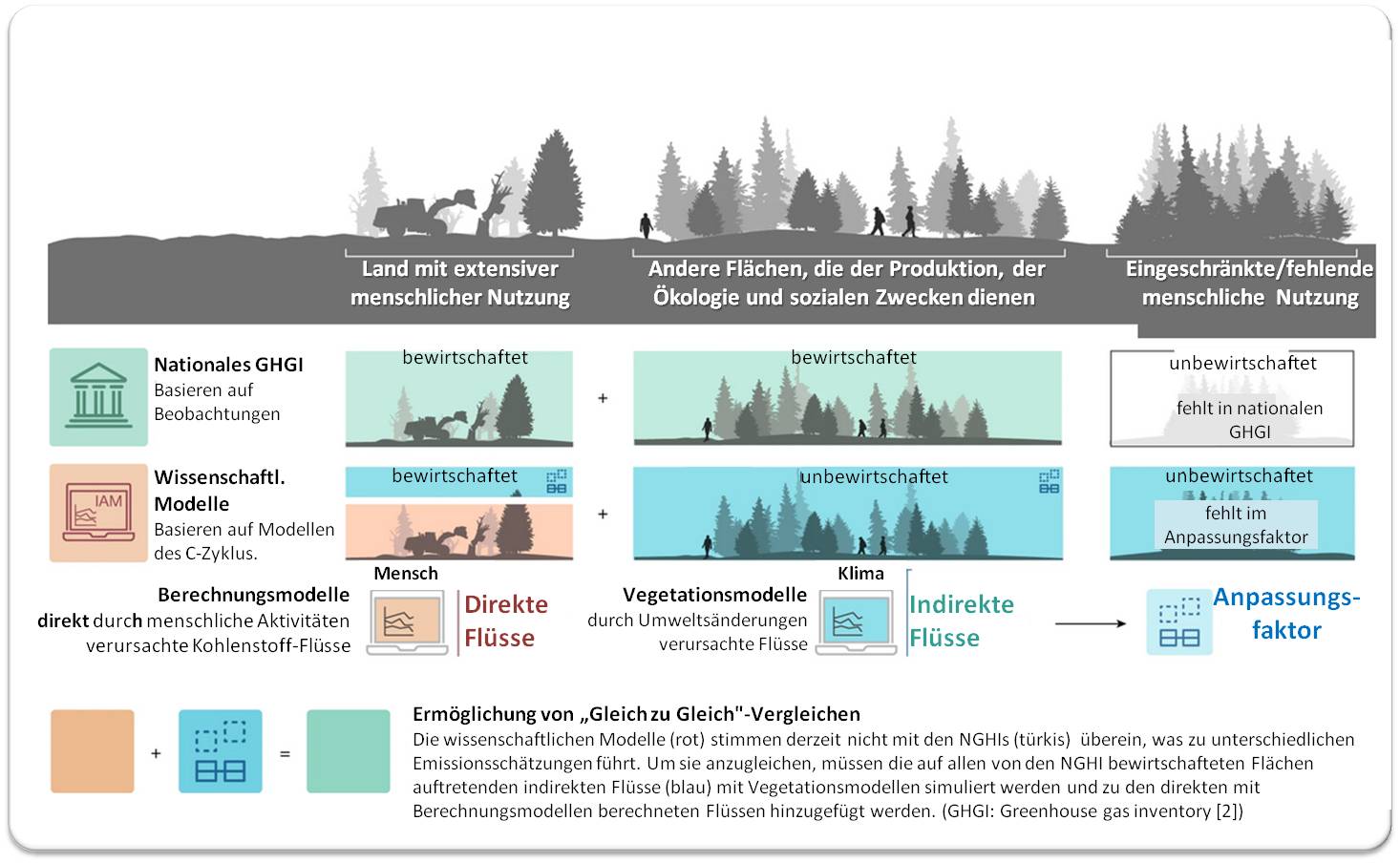

Wie eine neue, im Fachjournal Nature veröffentlichte Studie zeigt, differieren die Schätzungen der von Landnutzung ausgehenden aktuellen Emissionen, wie sie auf Grund wissenschaftsbasierter Untersuchungen (Modellen der IPCC-Sachstandsberichte) erhoben werden und wie sie Staaten in nationalen Treibhausgasbilanzen (Treibhausgasinventaren) berichten [1]. Der Grund liegt darin, dass unterschiedlich definiert wird, was als "bewirtschaftetes" Land und was als vom Menschen durch Landnutzung verursachte (anthropogene) und aus der Atmosphäre entfernte Emissionen angesehen wird; die Studie zeigt auch, wie sich die globalen Benchmarks der Emissionsminderung ändern, wenn mit den wissenschaftlichen Klimamodellen die LULUCF-Flüsse aus der Perspektive der nationalen Treibhausgasbilanzen abgeschätzt werden. Um Fortschritte im Pariser Klimaabkommen zu bewerten, ist es nach Ansicht des Forscherteams notwendig Gleiches mit Gleichem zu vergleichen - dabei müssen die Staaten ehrgeizigere Klimaschutzmaßnahmen ergreifen, wenn sie ihre nationalen Ausgangspunkte mit globalen Modellen vergleichen.

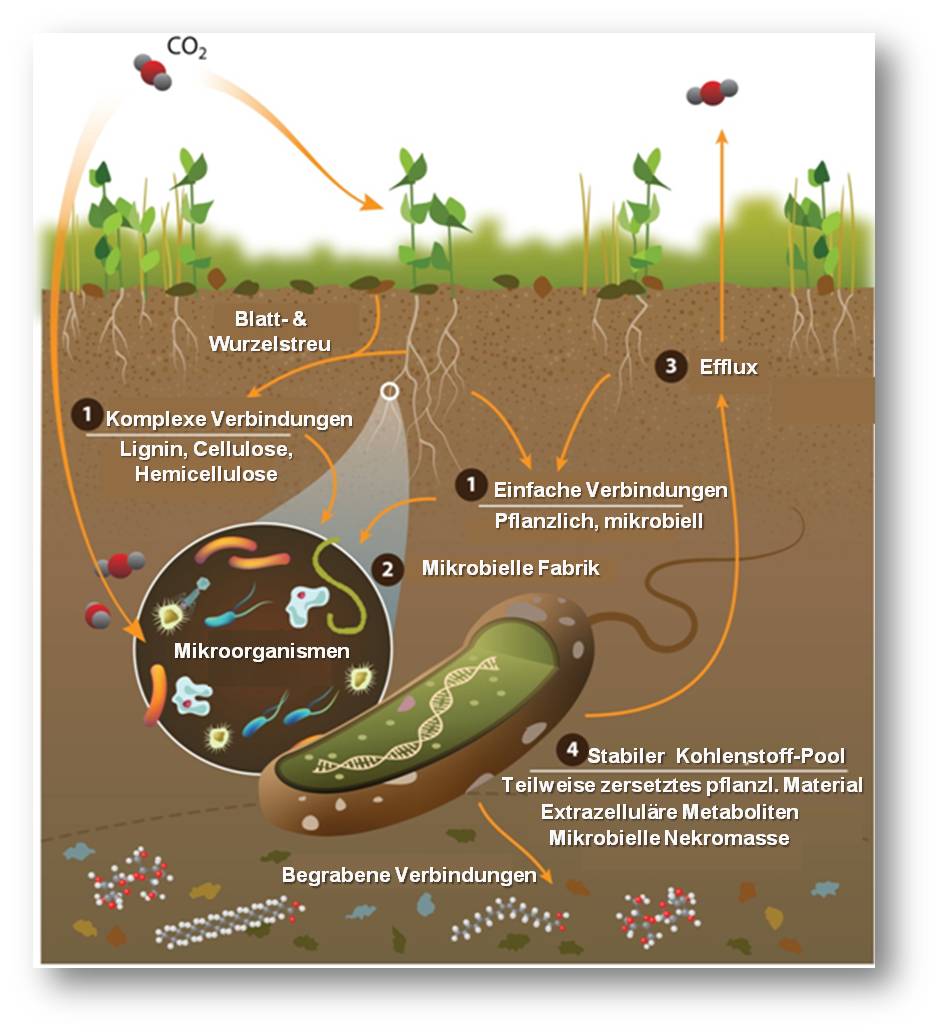

"Die Staaten schätzen ihre LULUCF-Flüsse (Emissionen und Entnahme aus der Atmosphäre) auf unterschiedliche Weise. Direkte Flüsse sind das Ergebnis direkter menschlicher Eingriffe, wie beispielsweise in der Landwirtschaft oder der Holzernte. Die Modelle in den Bewertungsberichten des Weltklimarates (IPCC) verwenden diesen Bilanzierungsansatz, um das verbleibende Kohlenstoffbudget und den Zeitplan für das Erreichen von Netto-Null-Emissionen zu bestimmen. Indirekte Flüsse sind die Reaktion des Bodens auf indirekte, vom Menschen verursachte Umweltveränderungen, wie z. B. die Zunahme des atmosphärischen CO2 oder die Stickstoffablagerung, die beide die Kohlenstoffentnahme aus der Atmosphäre erhöhen", erklärt Giacomo Grassi, ein Mitautor der Studie und Forscher am Joint Research Centre der Europäischen Kommission.

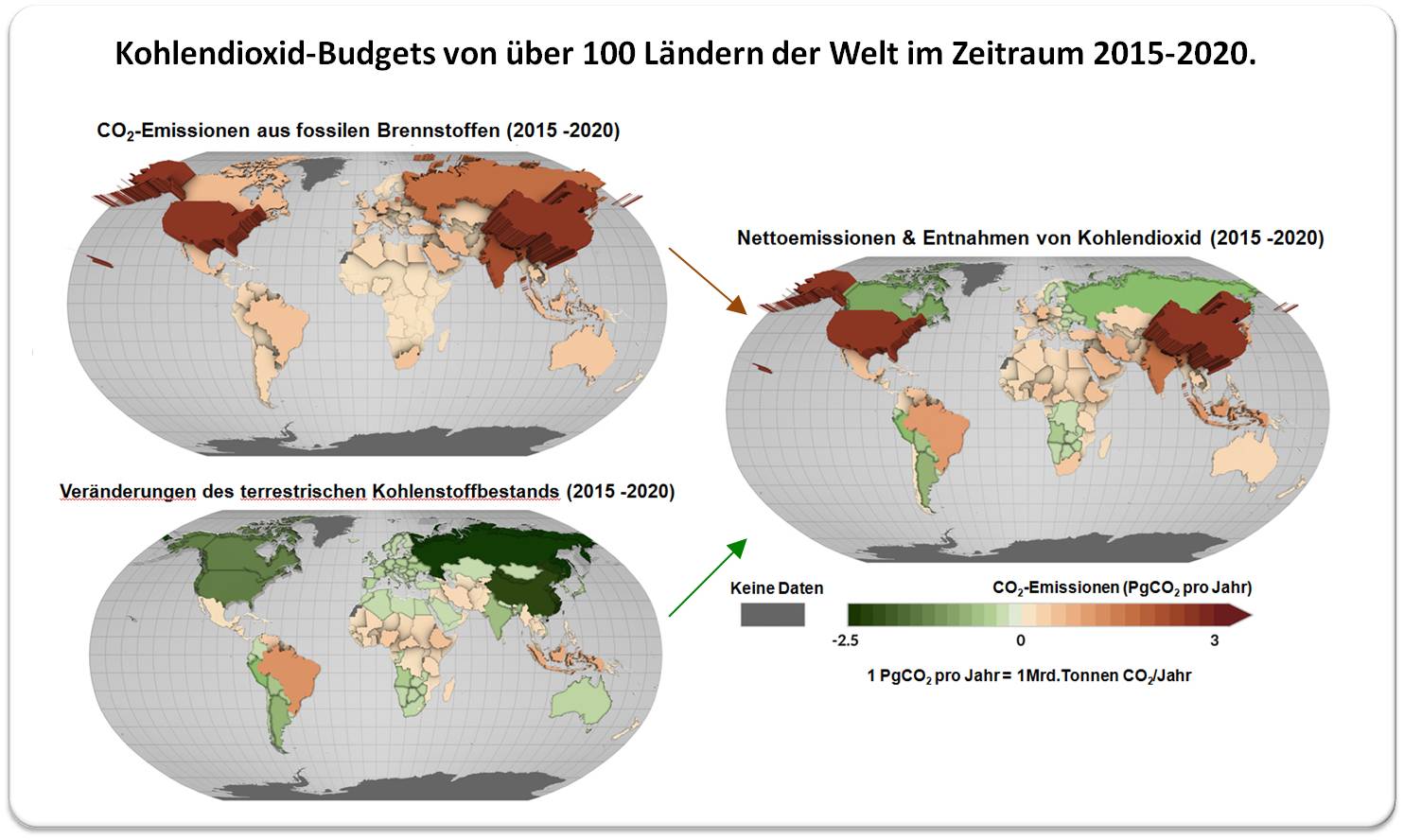

Grassi weist darauf hin, dass es praktisch nicht möglich ist, direkte und indirekte Flüsse durch Beobachtungen wie nationalen Waldinventaren oder Fernerkundungen voneinander zu separieren. Daher folgen die nationalen Methoden zur Treibhausgasinventarisierung Normen, die anthropogene Flüsse anhand eines landbasierten Ansatzes definieren, wobei alle auf bewirtschafteten Flächen auftretenden Flüsse als anthropogen gelten. Im Gegensatz dazu werden die Treibhausgasflüsse auf unbewirtschafteten Flächen nicht in die Berichterstattung einbezogen. Abbildung.

Eine Lücke von 4 - 7 Gigatonnen CO2

Weltweit ergibt sich zwischen den Berechnungsmodellen und den Treibhausgasbilanzen der Länder ein Unterschied von etwa 4 - 7 Gigatonnen CO2 oder rund 10 % der heutigen Treibhausgasemissionen, allerdings variiert dieser Unterschied von Land zu Land.

| Abbildung. Flüsse aus Landnutzung, Landnutzungsänderung und Forstwirtschaft (LULUCF): Anpassung von konventionellen wissenschaftlichen Modellen und nationalen Treibhausgasbilanzen. Abweichungen ergeben sich aus den Unterschieden, welche Flächen als bewirtschaftet gelten und ob Flüsse im Zusammenhang mit Umwelt- und Klimaveränderungen einbezogen werden.NGHGI: nationales Treibhausgasinventar [2].(Bild modifiziert aus Gidden et al., [1], Lizenz cc-by) |

Die Forscher haben die wichtigsten Klimaschutz-Benchmarks anhand des Bestandsaufnahme-basierten LULUCF-Ansatzes bewertet. Sie sind zu dem Ergebnis gelangt, dass zur Erreichung des langfristigen Temperaturziels des Pariser Abkommens von 1,5 °C die Netto-Null-Emissionen ein bis fünf Jahre früher als bisher angenommen erreicht werden müssen, die Emissionssenkungen bis 2030 um 3,5 bis 6 % stärker ausfallen und die kumulativen CO2-Emissionen um 55 bis 95 Gt CO2 geringer sein müssen. Das Forscherteam betont, dass die Ergebnisse nicht im Widerspruch zu den vom IPCC festgelegten Benchmarks stehen, sondern die gleichen Arten von Benchmarks mit einem Bestandsaufnahme-basierten Ansatz bewertet werden.

"Um die globale Temperaturreaktion auf anthropogene Emissionen zu berechnen, verwenden die IPCC-Sachstandsberichte direkte, landbasierte Emissionen als Input und beziehen die indirekten Emissionen aufgrund von Klima- und Umweltreaktionen in ihre physikalische Klimaemulation ein. In unserer Analyse machen wir deutlich, dass wir diese beiden Arten von Emissionen getrennt betrachten. Das Klimaergebnis jedes der von uns bewerteten Szenarien bleibt dasselbe, aber die Benchmarks - betrachtet durch die Linse der nationalen Konventionen zur Bilanzierung von Treibhausgasinventaren - verschieben sich. Ohne Anpassungen könnten die Länder in einer günstigeren Lage erscheinen, als sie tatsächlich sind", erklärt Thomas Gasser, Mitautor der Studie und leitender Forscher in den beiden IIASA-Programmen Advancing Systems Analysis und Energy, Climate, and Environment.

"Unsere Ergebnisse zeigen die Gefahr auf, Äpfel mit Birnen zu vergleichen: Um das Pariser Abkommen zu erreichen, ist es entscheidend, dass die Länder das korrekte Ziel anstreben. Wenn Länder bei nationaler Bilanzierung modellbasierte Benchmarks anstreben, werden sie das Ziel verfehlen", sagt Matthew Gidden, Studienautor und leitender Forscher im IIASA-Programm Energy, Climate, and Environment.

Im Vorfeld der UN-Klimakonferenz COP28

(die vom 30. November - 12 Dezember 2023 in Dubai stattfindet) und der ersten globalen Bestandsaufnahme - ein Prozess, der es den Ländern und anderen Interessengruppen ermöglicht zu sehen, wo sie gemeinsam Fortschritte bei der Erfüllung der Ziele des Pariser Abkommens machen und wo nicht - drängen die Forscher auf detailliertere nationale Klimaziele. Sie empfehlen separate Ziele für den Klimaschutz an Land, getrennt von Maßnahmen in anderen Sektoren.

"Länder können Klarheit über ihre Klimaziele schaffen, indem sie ihre geplante Nutzung des LULUCF-Sektors getrennt von Emissionsreduktionen in anderen Sektoren kommunizieren. Während Modellierer und Praktiker zusammenkommen können, um die Vergleichbarkeit zwischen den globalen Pfaden und den nationalen Bilanzierungen zu verbessern, ist es wichtig die Botschaft, dass in diesem Jahrzehnt erhebliche Minderungsanstrengungen erforderlich sind, nicht in den Details der technischen Berichterstattung untergehen zu lassen", schließt Gidden.

[1] Gidden, M., Gasser, T., Grassi, G., Forsell, N., Janssens, I., Lamb, W., Minx, J., Nicholls Z., Steinhauser, J., Riahi, K. (2023). Aligning climate scenarios to emissions inventories shifts global benchmarks. Nature DOI: 10.1038/s41586-023-06724-y

[2] FAO elearning academy: The national greenhouse gas inventory (NGHGI) for land use. https://elearning.fao.org/course/view.php?id=650

*Die Presseaussendung "Mind the gap: caution needed when assessing land emissions in the COP28 Global Stocktake" https://iiasa.ac.at/news/nov-2023/mind-gap-caution-needed-when-assessing-land-emissions-in-cop28-global-stocktake ist am 22. November 2023 auf der IIASA Website erschienen. Der Artikel wurde von der Redaktion möglichst wortgetreu übersetzt und mit Untertiteln ergänzt. IIASA hat freundlicherweise der Veröffentlichung der von uns übersetzten Inhalte seiner Website und Presseaussendungen in unserem Blog zugestimmt.

Gentherapie der Duchenne-Muskeldystrophie (DMD) - ein Rückschlag

Gentherapie der Duchenne-Muskeldystrophie (DMD) - ein RückschlagFr 17.11.2023 — Ricki Lewis

Tausende Erkrankungen werden durch schadhafte Gene ausgelöst. Bereits vor Jahrzehnten gab es erste Ansätze, um diese Gene durch Gentherapie - reparierte Gene oder intaktes genetisches Material - auszutauschen; man erwartete damit viele der zumeist ererbten Krankheiten nicht nur behandeln, sondern auch wirklich heilen zu können. Obwohl enorme Anstrengungen zur Umsetzung dieser Strategie gemacht und mehrere Tausende klinische Studien dazu durchgeführt wurden, ist der Erfolg bescheiden - von der FDA wurden bislang 6 gentherapeutische Produkte zugelassen - und immer wieder von Rückschlägen bedroht geblieben. Über enttäuschte Hoffnungen und den jüngsten Rückschlag bei einer Gentherapie von Duchenne Muskledystrophie berichtet die Genetikerin Ricki Lewis.*

Im letzten Kapitel meines 2012 erschienenen Buches The Forever Fix: Gene Therapy and the Boy Who Saved It, habe ich prophezeit, dass sich diese Technologie bald weit über die Welt der seltenen Krankheiten hinaus ausbreiten würde. (Anm. Redn.: von einer seltenen Krankheit sind weniger al 0,5 Promille der Bevölkerung betroffen.)

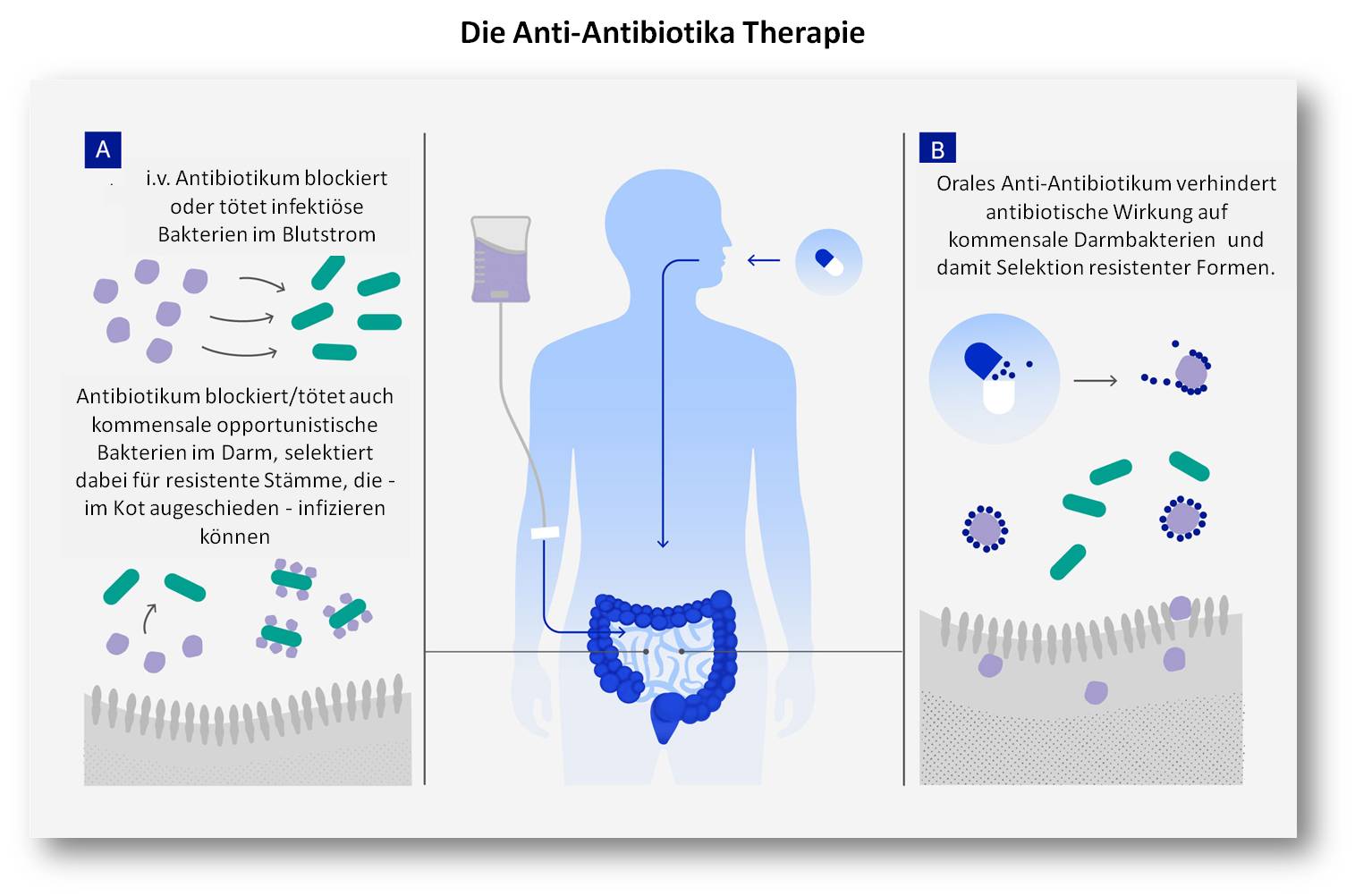

Ich war zu optimistisch. Es hat sich herausgestellt, dass die Gentherapie keinen großen Einfluss auf die Gesundheitsversorgung hatte, da sie nur einigen wenigen Menschen mit seltenen Krankheiten extrem teure Behandlungen offeriert. Wir sind immer noch dabei zu lernen, welche Folgen es haben kann, wenn Millionen von veränderten Viren in einen menschlichen Körper eingeschleust werden. Können sie heilende Gene liefern, ohne eine überschießende Immunreaktion auszulösen?

Ein Bericht im New England Journal of Medicine vom 28. September 2023 beschreibt einen jungen Mann mit Duchenne-Muskeldystrophie (DMD), der nur wenige Tage nach einer Gentherapie starb [1]. Die Einzelheiten erinnern in beunruhigender Weise an den berühmten Fall von Jesse Gelsinger, der im September 1999 an einer überschießenden Immunantwort auf eine experimentelle Gentherapie starb.

Jesse war 19 Jahre alt und litt an einer Defekt im Harnstoffzyklus (Ornithintranscarbamylase-Defizienz). Er wurde an einem Montag behandelt und starb am Freitag infolge eines Multiorganversagens. Die Viren, mit denen die Gene übertragen wurden, hatten ihr Ziel verfehlt und drangen in nicht dafür vorgesehene Zelltypen der Leber ein, was den Alarm der Immunabwehr auslöste.

Es gibt erst wenige Gentherapie-Zulassungen

Auch wenn bereits einige hundert Menschen dem Ende 2017 zugelassenen Luxturna das Sehvermögen verdanken, ist die Liste der Gentherapien, die die Hürden der FDA nehmen konnten, noch kurz geblieben. Zu den enorm hohen Kosten und den kleinen Märkten kommt dazu, dass man die Reaktionen der Patienten nicht vorhersehen konnte. Man braucht ein besseres Verfahren, um Patienten zu identifizieren, die am ehesten auf eine bestimmte Behandlung ansprechen.

Denken wir an Zolgensma, eine Gentherapie, die 2019 zur Behandlung der spinalen Muskelatrophie zugelassen wurde. Betroffene Kinder überleben selten das Säuglingsalter. Deshalb waren die Videos eines kleinen Mädchens namens Evelyn, das nach der Behandlung mit Zolgensma tanzte, so erstaunlich - ihre Schwester war an der Krankheit gestorben. Ein aktuellerer Fall war ein Säugling, der 2021 die 2,25 Millionen Dollar teure einmalige Anwendung von Zolgensma erhielt und im Alter von acht Monaten nur in der Lage war, seinen Kopf für ein paar Sekunden zu heben.

Die FDA hat 6 Gentherapien zugelassen - begraben in einer Liste von 32 zugelassenen Produkten von Zell-und Gentherapien [2]. Gentherapien und Zelltherapien in einen Topf zu werfen, ist nicht sehr hilfreich - bei den zellbasierten Produkten handelt es sich meist um manipulierte T-Zellen zur Behandlung von Krebs. Darunter sind zwei interessante Produkte sind eine Behandlung für Knieschmerzen, die aus Knorpelzellen eines Patienten besteht, die auf Schweinekollagen gezüchtet werden, und 18 Millionen eigene Fibroblasten, die unter die Haut injiziert werden, um "Nasolabialfalten" aufzufüllen.

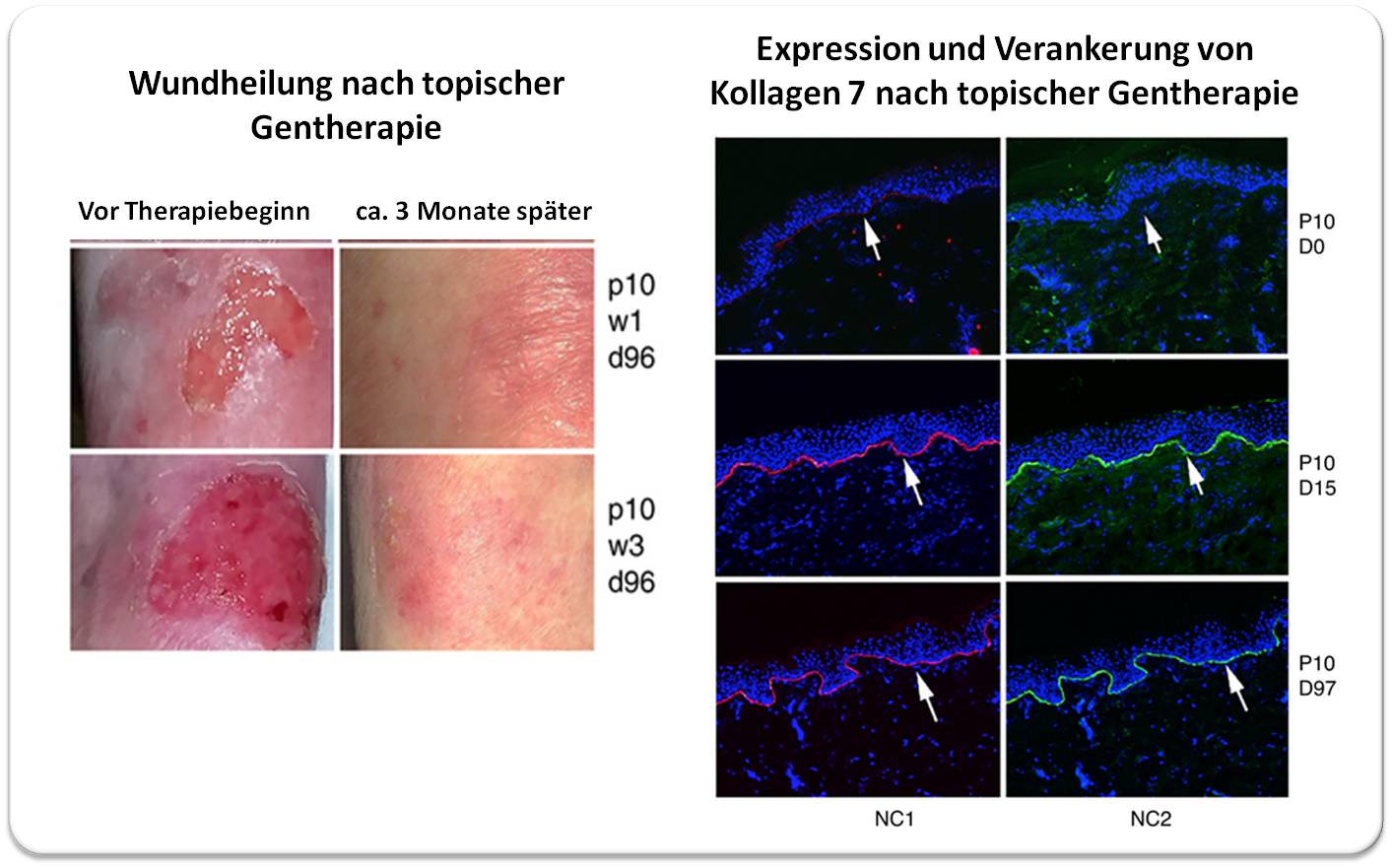

Die zugelassenen Gentherapien sind bestimmt für:

- die Gerinnungsstörungen Hämophilie A und B

- die schwere Form der Hautablösung, dystrophische Epidermolysis bullosa

- Netzhautblindheit

- Spinale Muskelatrophie

- Duchenne Muskeldystrophie (DMD)

Die Gentherapie zur Behandlung von DMD ist allerdings nur fürJungen im Alter von 4 bis 5 Jahren vorgesehen, die noch gehen können. In der Packungsbeilage des Medikaments, Elevidys, wird vor unerwünschten Nebenwirkungen wie akuten Leberschäden und Entzündungen im Bereich des Herzens und der Muskeln gewarnt. Lungenschäden, die zu dem jüngsten Todesfall geführt haben, werden nicht erwähnt.

Ein riesengroßes Gen einschleusen

Der 27-Jährige Mann mit DMD hatte von seiner Mutter eine Mutation in einem Gen auf dem X-Chromosom geerbt.

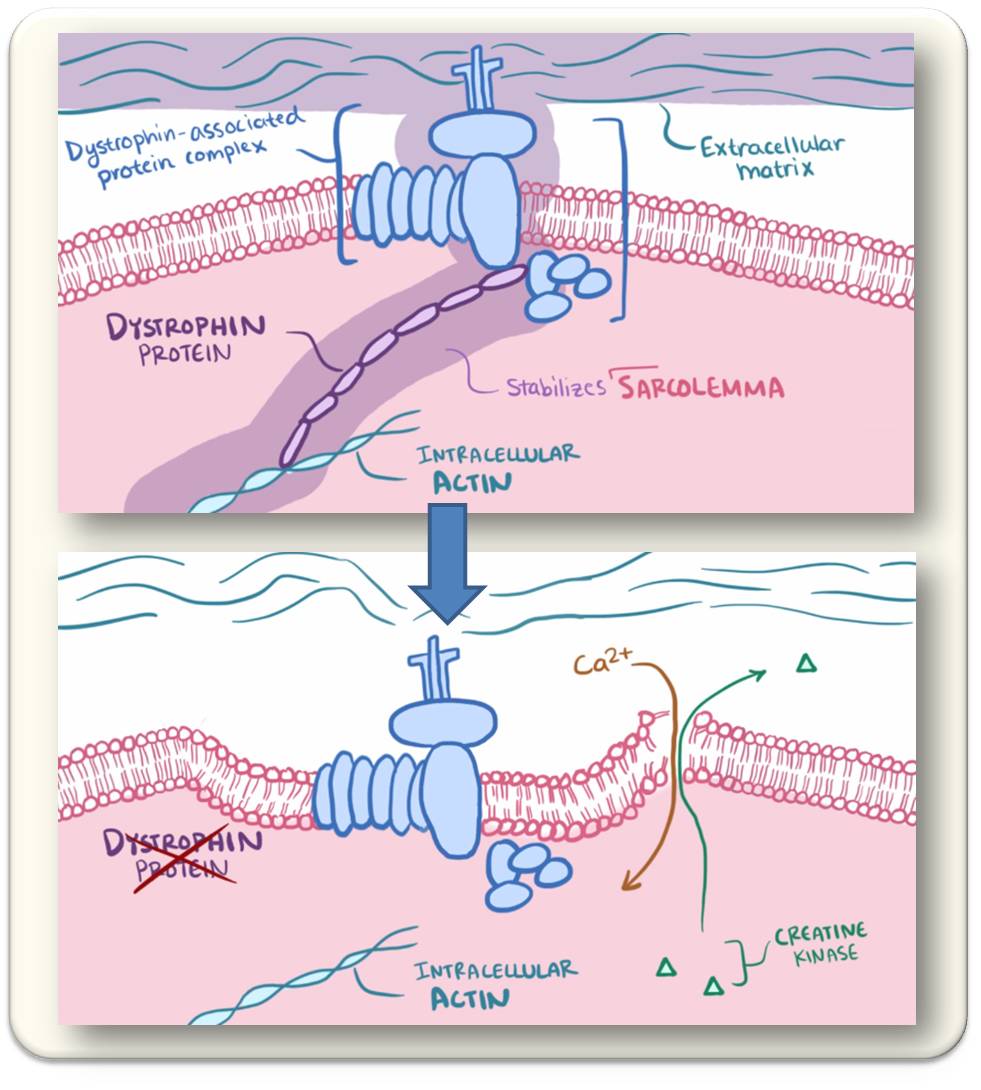

Bei dem betroffenen Gen handelt es sich um das mit 2,2 Millionen DNA-Basen größte im menschlichen Genom. Es kodiert für das Protein Dystrophin, das im Vergleich zu den Aktin- und Myosin-Filamenten, aus denen die Muskelmasse besteht, in verschwindend geringer Menge vorhanden ist, aber als essentielle Stütze fungiert (Abbildung).

| Abbildung. In Muskelzellen ist Dystrophin das Bindeglied zwischen den kontraktilen Actinfasern und der Zellmembran (Sarcolemma), die wiederum über einen Proteinkomplex an das umgebende Bindegewebe (extrazelluläre Matrix) gekoppelt ist (oben). Fehlt Dystrophin, so verliert die Muskelzelle ihre Stabilität, die Membran bekommt Risse, Calcium strömt permanent ein (unten) und dies führt zur Dauerkontraktion.(Bild von Redn. eingefügt: Screenshots aus open.osmosis.org,Duchenne and Beckermuscular dystrophy [3]; Lizenz CC-BY-SA) |

Wird die Fähigkeit, Dystrophin zu bilden zerstört, wie es bei DMD der Fall ist, so fallen Skelett- und Herzmuskelfasern auseinander. Die Muskeln hören zu arbeiten auf. Den betroffenen Personen fehlen Teile des Gens oder das gesamte Gen.

Die DMD-Gentherapie liefert eine verkürzte Version des Dystrophin-Gens, nur 4.558 DNA-Basen. Zwei weitere Design-Strategien sorgen für Präzision:

i) Das Adeno-assoziierte Virus (AAV) ist Vektor für das Gen und nicht das Adenovirus (AV), das in Jesses Leberzellen eingedrungen war, die nicht das Ziel waren. Seit dem tragischen Fall von Jesse ist die Verwendung von AV in der Gentherapie eingeschränkt worden und AAV wird häufiger als Übertragungsvektor verwendet.