2025

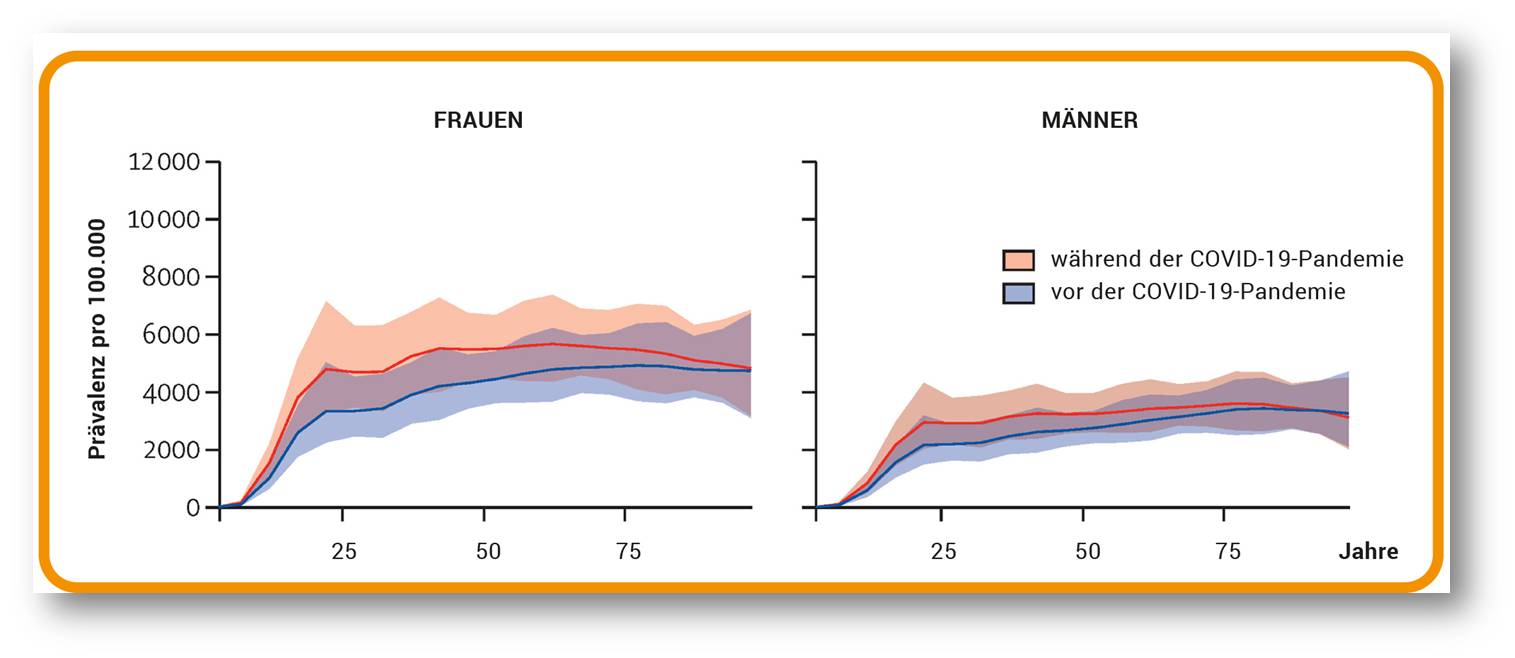

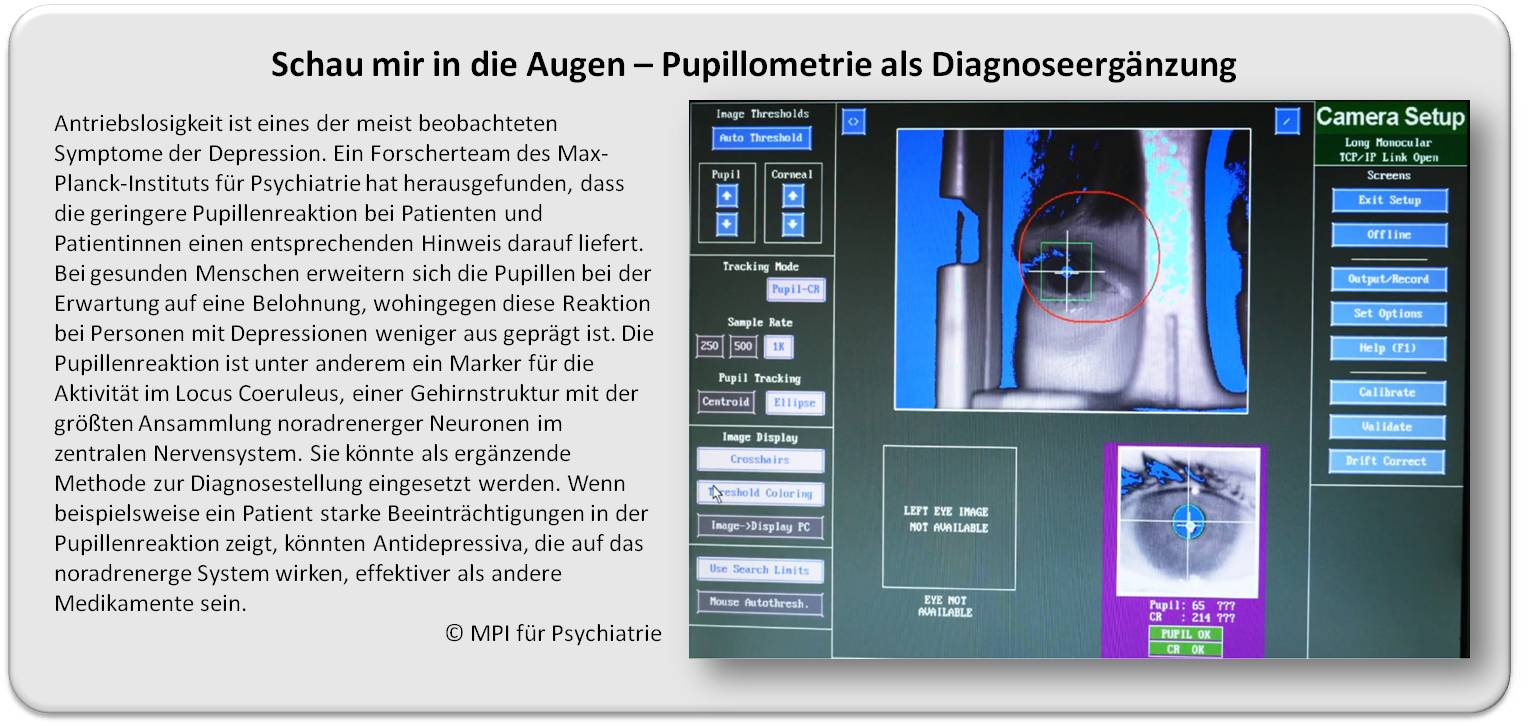

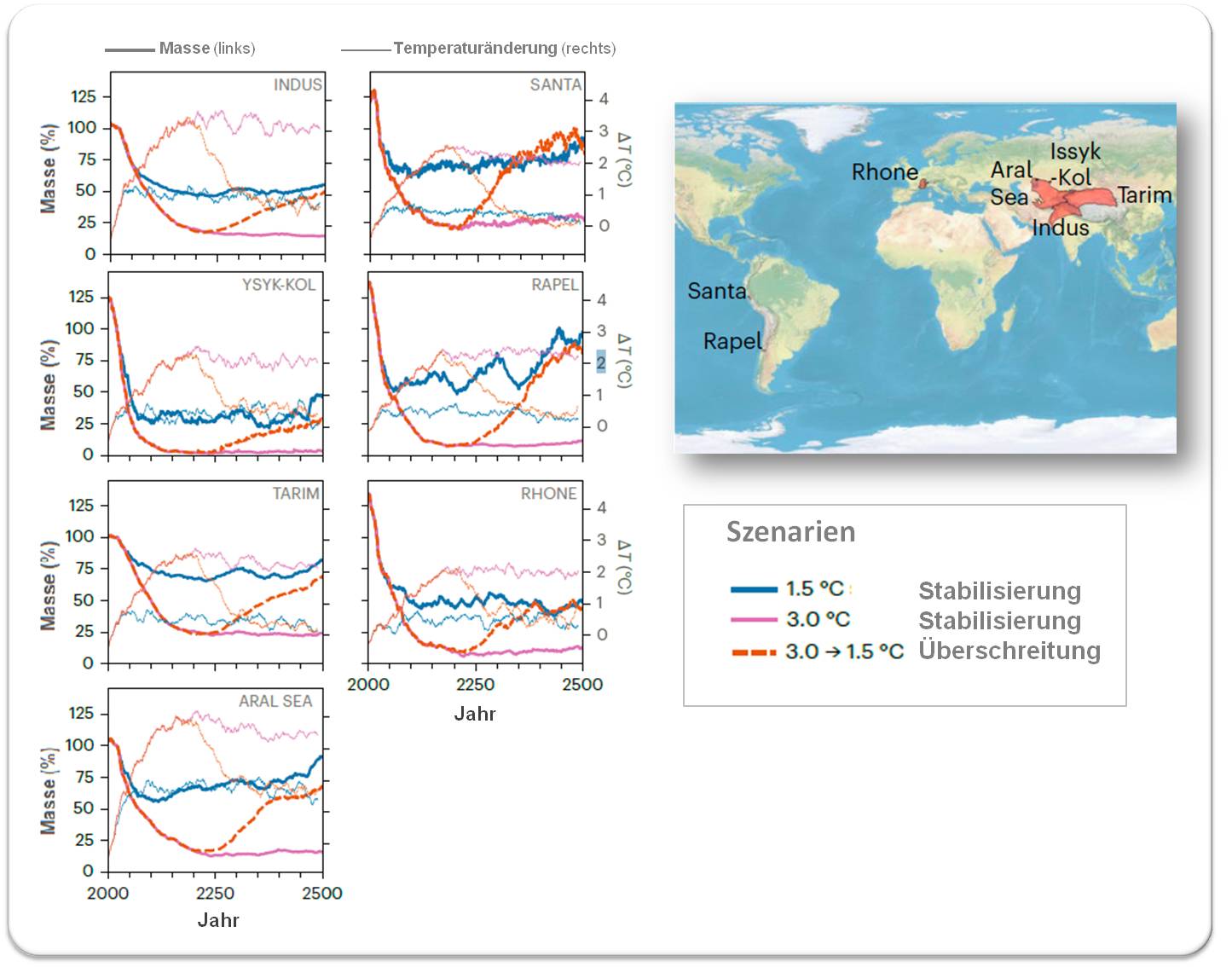

2025 inge Thu, 09.01.2025 - 13:56Die Sterne und der Raum - eine populärwissenschaftliche ("Weihnachts"-)Vorlesung in Wien vor 100 Jahren

Die Sterne und der Raum - eine populärwissenschaftliche ("Weihnachts"-)Vorlesung in Wien vor 100 JahrenSa, 27.12.2025 — Samuel Oppenheim

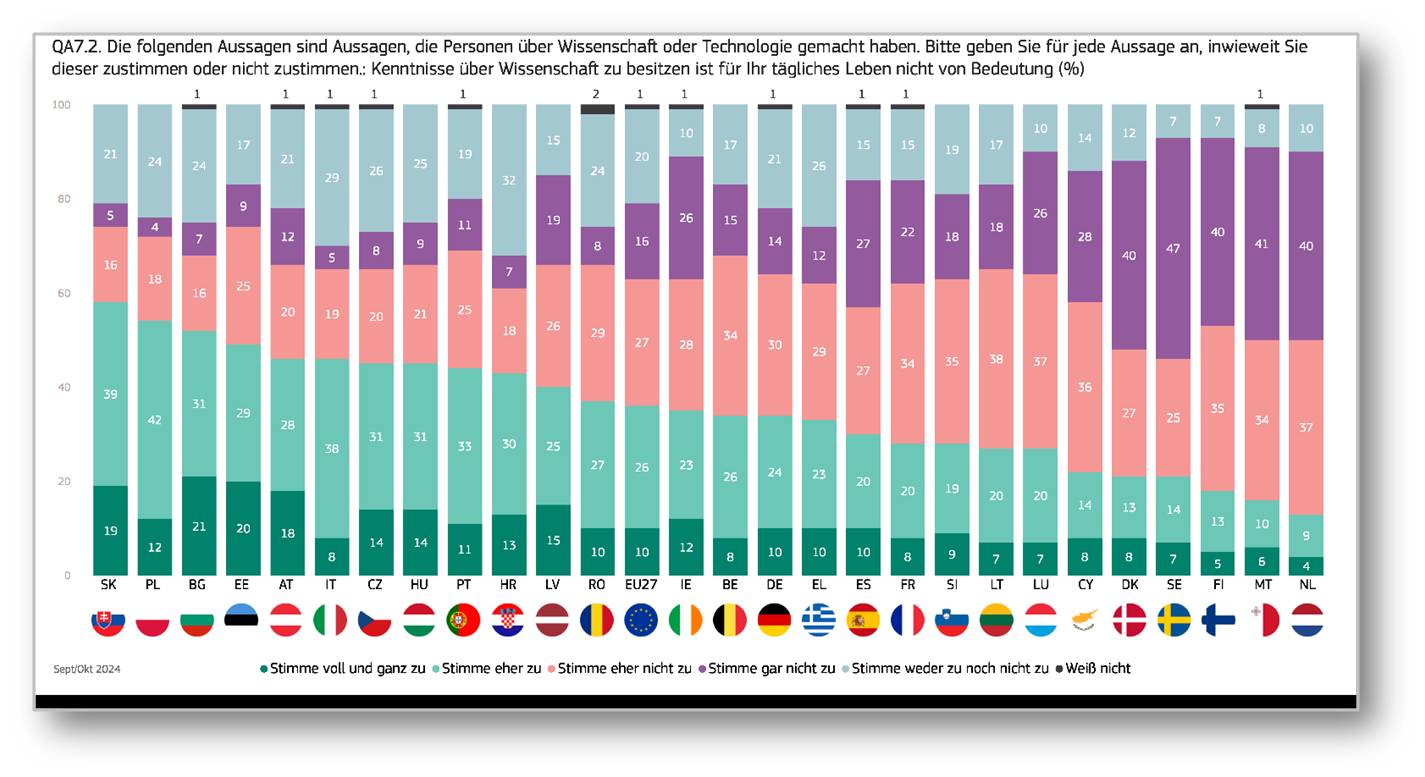

Ist das Weltall endlich oder unendlich groß? Dieses Problem hat der österreichische Astronom Samuel Oppenheim in einem populärwissenschaftlichen Vortrag im Verein zur Verbreitung naturwissenschaftlicher Kenntnisse in Wien diskutiert - zu einer Zeit als es die Big Bang Theorie noch nicht gab und die Leistungsfähigkeit der Fernrohre noch sehr beschränkt war. Oppenheim hat bedeutende Beiträge zur Himmelsmechanik, zur Sternkinematik, der Berechnung von Kometen- und Kleinplanetenbahnen und zum Einfluss der Gravitation geleistet.*

1860 wurde in Wien der (auch heute noch existierende) Verein zur Verbreitung naturwissenschaftlicher Kenntnisse gegründet. In dessen Rahmen wurden frei zugängliche, populäre Vorträge von Experten aus allen Fächern der Naturwissenschaften gehalten, deren Drucklegung und weite Verbreitung festgelegt war [1]. Zahlreiche berühmte Wissenschafter- beispielsweise Eduard Süess, Karl von Frisch, Stefan Meyer, Hermann Mark - haben hier Beiträge geliefert. Am 16. Dezember 1925 hat der bedeutende österreichische Astronom Samuel Oppenheim in diesem Verein über "Die Sterne und der Raum" berichtet [2].

|

Titelblatt des Vortrags (https://www.zobodat.at/pdf/SVVNWK_66_0019-0032.pdf) und Foto von Samuel Oppenheim (https://kuffner-sternwarte.at/sternwarte/vks_ksw_astronomen.php) |

Bau und Struktur des Raumes zu erforschen sowie die Frage nach seiner Endlichkeit und Unendlichkeit zu beantworten, ist eines der Hauptprobleme der modernen Astronomie, aber auch eines der schwierigsten. Es wäre am vollständigsten zu lösen durch eine Durchwanderung des ganzen Raumes, aber wir Menschen sind an die Erde gebunden und selbst mit unseren besten Flugzeugen können wir uns von ihr nur auf Strecken entfernen, die im Vergleiche zu den Dimensionen des ganzen Weltraumes als verschwindend zu betrachten sind. So sind wir nicht in der Lage, eine solche Wanderung auszuführen und auf ihr Beobachtungen zu sammeln, wie wir es auf der Erde ohne Schwierigkeit zu tun gewohnt sind und daher genötigt, nach einem anderen Wanderer Umschau zu halten, aus dessen hiebei gemachten Erfahrungen wir zu schöpfen und unsere Kenntnisse stetig zu vervollständigen haben.

Der Lichtstrahl

Ein solcher Wanderer ist der Lichtstrahl. Von den fernsten Himmelsräumen kommt er an unser Auge und erzählt uns in einer Sprache, die wir nur verstehen müssen, von den Sternen, die er auf seinem Wege getroffen. Er verkündet uns damit nicht bloß ihre Existenz, sondern auch die Richtung, in der sie zu sehen sind, auf deren Auffassung sich die Bestimmung ihres Ortes am Himmel gründet. Er erzählt uns ebenso, wenn wir ihn in einem Glasprisma analysieren, von der chemischen Beschaffenheit der Sterne und ihrer materiellen Zusammensetzung. Und was für uns heute die Hauptaufgabe ist, er erzählt uns auch einiges über die Länge des Weges, den er vom Sterne bis an unser Auge zurückgelegt hat, und damit über die Erstreckung der ganzen Sternenwelt, ob sie endlich oder unendlich ist, ob begrenzt oder unbegrenzt.

Das zur Beantwortung der letzten Frage notwendige Beobachtungsmaterial muß jedoch ein doppeltes sein. Es genügt nicht, einzig Distanzmessungen vorzunehmen, und aus ihnen die Ausdehnung des Sternraumes festzustellen, sondern es müssen noch rein statistische Abzählungen der Sterne hinzukommen, zur Festlegung des Gesetzes, nach dem deren Zahl mit der Größe zunimmt, um so über die Sternerfüllung des Raumes Auskunft zu geben.

Schätzung von Größe und Zahl der Sterne

Jeder Stern sendet uns nämlich eine bestimmte Menge Licht zu. Er hat eine. gewisse Leuchtkraft, wie man auch sagt eine bestimmte Größe. Sie ist für verschiedene Sterne verschieden und der Grund für diese Verschiedenheit entspringt zwei Ursachen. Der Stern kann an sich eine geringe Leuchtkraft haben, denn nichts sagt uns, daß alle Sterne gleiche; sogenannte absolute Leuchtkraft haben müssen, sowie wir auch auf der Erde Lichtquellen verschiedener Helligkeit besitzen, oder aber er kann recht hell sein und erscheint uns nur wegen seiner größeren Entfernung von der Erde schwächer als ein anderer, da die Helligkeit des Lichtes, wie bekannt, mit der Entfernung abnimmt. Darnach ist auch die Wirkung eines Fernrohrs, mit dessen Hilfe wir ja den Sternenhimmel durchforschen wollen, eine doppelte. Sie ist eine mehr raumdurchdringende, indem es uns schwächere Sterne zeigt, die nur wegen ihrer großen Entfernung von der Erde so erscheinen, und dann eine nachlesende, indem es uns auch tatsächlich lichtschwache Sterne zeigt.

|

Abbildung 2. Ein aktueller Blick ins ferne Universum: Die ersten Aufnahmen mit dem James Webb Teleskop (2022) zeigen die bislang tiefsten und schärfsten Infrarotbilder Tausender Galaxien im Sternhaufen SMACS 0723, wie sie vor 4,6 Milliarden Jahren erschienen. (Credit: NASA, ESA, CSA und STScI) |

Beobachten wir also den Sternenhimmel mit immer größeren Fernrohren, so wird die Zahl der Sterne stets zunehmen, aus dem einen wie aus dem anderen Grunde, und bei unbegrenztem und unendlichem Himmel auch ins Unendliche anwachsen. Ist aber die Sternenwelt endlich und begrenzt, so muß einmal die eine, und zwar die raumdurchdringende Kraft des Fernrohres ein Ende haben und nur die zweite Kraft wird noch vorhanden sein. Es muß sich an der Grenze der Sternenwelt eine Änderung des Gesetzes für die Zunahme der Sterne zeigen. Denn neue sehr helle Sterne, die nur wegen ihrer großen Entfernung von uns schwach erscheinen, sind nicht mehr da, sondern nur mehr an sich schwache, die uns eben unser großes lichtstarkes Fernrohr noch sichtbar macht.

Die Beobachtungen lassen nun tatsächlich eine solche Änderung des Gesetzes in den Abzählungen der Sterne erkennen. Während, wie es die folgende Tabelle zeigt, die neben der Größe der Sterne (m) deren Gesamtzahl (stets von der Größe 0 angefangen) und ihre Zunahme (Verhältniszahl) angibt, diese Zunahme für die Sterne von der Größe 2,5 bis etwa 9,5 oder 10,5 noch als konstant, im Mittel zwischen 3,35 bis 2,83 angesehen werden kann, nimmt sie von da ab rasch ab (von 2,83 bis 2,07) und deutet damit an, daß etwa von der Größenklasse 10,5 ab die raumdurchdringende Kraft des Fernrohres erschöpft ist und, was nachher in ihm noch sichtbar wird, nur mehr Nachzügler sind, wirklich schwach leuchtende Sterne, die eben noch für unser Fernrohr erreichbar sind. (Anm. Redn.: Sternengrößen konnten vor 100 Jahren nur an Hand ihrer scheinbaren Größe -Helligkeit - (m) klassifiziert werden, wobei m = 1 die höchste Helligkeit, die folgenden Stufen jeweils 2,5 Mal geringere Helligkeit aufweisen.)

|

Scheinbare Größe (m) der Sterne, deren Zahl und die Relation von Größe und Zahl. |

Hiemit ist erwiesen, daß das sichtbare Sternsystem ein begrenztes ist, eine Insel im sonst vielleicht unendlichen Raum, und diese Begrenztheit ist nicht etwa der Ausdruck einer Beschränktheit in der Leistungsähigkeit des Fernrohres. Denn von Galilei an, der zum ersten Male ein Fernrohr gegen den Himmel richtete, bis auf Herschel, der mit seinem Riesenteleskop den Himmel durchmusterte und an verschiedenen Stellen Sternzählungen ausführte, hat die Zahl der Sterne mit wachsender Größe des Fernrohrs stets zugenommen. Erst neuestens, trotz Verwendung photographischer Daueraufnahmen, die oft Sterne bis zur 17—18ten Größe bringen, hat sich jedoch diese Vergrößerung nicht mehr in der gleichen Weise vollzogen. Sie wird immer geringer und strebt damit einer endlichen Grenze zu. Wie groß diese ist, läßt sich heute noch nicht mit einiger Sicherheit angeben. Im übrigen hat es wenig auf sich, ob sie an die 80, 90 oder gar 100 Millionen heranreicht. Das Wesentliche bleibt die Endlichkeit des ganzen Systems, was die Zahl der in ihm sichtbaren Einzelkörper anlangt.

Doch neben den Sternen zeigt uns der Himmel noch andere Körper, vorerst die Nebel in den verschiedensten teils regelmäßigen, teils ganz bizarren Formen, teils solche spiraliger Struktur, sowie endlich die Sternhaufen. Gehören auch sie, entsteht da die neue Frage, dem Sternsystem an, das wir als unser weiteres Vaterland zu betrachten haben — unser engeres ist das spezielle Sonnensystem — oder sind sie im Gegenteile von ihm ganz unabhängige Gebilde?

Distanz zur Erde

Diese Frage kann nur durch Ermittlung ihrer Distanz von der Erde entschieden werden. Hiezu stehen den Astronomen bekanntlich mehrere Wege offen. Sie beruhen teils auf Winkelmessungen (trigonometrische Parallaxen), teils und gerade in neuerer Zeit auf Untersuchungen der Spektra der Sterne (spektroskopische Parallaxen), teils werden sie auch aus der Größe der Eigenbewegungen abgeleitet. Speziell für die Sterne ergaben sich die in der folgenden Tabelle enthaltenen Mittelwerte der Parallaxen ihrer einzelnen Größenklassen und damit ihrer Entfernung von der Erde, ausgedrückt in Lichtjahren, als dem Weg, den das mit einer Geschwindigkeit von 300.000 km in der Sekunde sich bewegende Licht in einem Jahre zurücklegt und der etwa 10 Billionen km beträgt.

|

Zahlen, die einen Überblick über die räumliche Ausdehnung des Milchstraßensystems geben. |

Die gleichen Methoden, angewandt auf Nebel und Sternhaufen, gaben nun folgende Einzelwerte:

für den berühmten Orionnebel: π= 0"0054 = 600 Lichtjahre,

für den Sternhaufen der Plejaden: π = 0'-032 = 100 Lichtjahre,

für den Sternhaufen des Krebses: π= 0 , 0 2 4 = 135 Lichtjahre.

Aus ihnen ist zu schließen, daß diese wie viele andere unserem Sternsystem, angehören. Dagegen errechnete man:

für den schönen Kugelliaufen im Sternbild des Sobieskischen Schildes: π = 0"-0008 = 4000 Lichtjahre,

für den Kugelhaufen im Sternbild des Zentaurus: π = 0" 00015 = 21.000 Lichtjahre,

und als Mittelwert aus 69 solchen Kugelhaufen: π = 0" 000044 = 74.000 Lichtjahre.

Noch größere Distanzwerte erhielt man für die Spiralnebel, so für den schönen Spiralnebel im Sternbild der Andromeda π = 0,0000054 == 600.000 Lichtjahre, und, fügt man hinzu, daß dieser Nebel uns am Himmel in einer Größe von mehr als einem Grad erscheint, so folgt für seine lineare Ausdehnung ein Wert von 23.000 Lichtjahren oder einer Parallaxe von π=0,00014 von einem Ende bis zum andern, eine Ausdehnung, die weit die unseres Sternsystems übertrifft. Noch größere Werte für die Distanzen erhielt man für andere Spiralnebel.

Es unterliegt damit keinem Zweifel, daß diese, besonders die Spiralnebel neue Sternsysteme sind, unabhängig von unserem speziellen, und von ihm durch nach 10.000 von Lichtjahren zählende Distanzen getrennt. Ist auch deren Zahl endlich, sowie die Anzahl der Sterne in unserem System eine endliche ist, oder ist sie unendlich? Auf diese Frage gibt die Beobachtung bis nun keine Antwort. Sie sagt wohl, daß die Zahl der am Himmel sichtbaren Spiralnebel eine sehr große, aber immerhin nur eine endliche ist. Indes ob dies einer Unzulänglichkeit in der optischen Tragweite unserer Fernrohre zuzuschreiben ist oder einer tatsächlichen Beschränktheit ihrer Zahl, ist zur Zeit nicht zu entscheiden.

|

Abbildung 3. Aktueller Blick auf die Spiralgalaxie NGC 5584, die 72 Millionen Lichtjahre von der Erde entfernt ist. Unter den leuchtenden Sternen von NGC 5584 befinden sich pulsierende Sterne, sogenannte Cepheiden-Variable, und Supernovae vom Typ Ia, eine besondere Klasse explodierender Sterne, die. als zuverlässige Entfernungsmarker dienen, um die Expansion des Universums zu messen. (Credit: NASA, ESA, CSA, and A. Riess (STScI).) |

Ist aber das letztere der Fall, dann haben wir den Raum als von endlicher Große aufzufassen und die Vorstellung eines unendlichen Raumes ist zu verwerfen. Doch tritt hiebei die neue Frage nach seiner Begrenzung auf. Der unendliche Raum ist natürlich unbegrenzt, aber der endliche müßte an irgendeiner Stelle eine Grenze oder Schranke aufweisen. Wo ist diese und wie mag sie sich allenfalls in den Beobachtungen äußern?

Endlicher - unendlicher - gekrümmter Raum?

Es ist nun von Interesse zu hören, daß die Annahme einer endlichen Welt nicht notwendig auf die Existenz von Grenzen für ihn führt, sondern daß es auch einen endlichen und trotzdem unbegrenzten Raum geben, kann. Denke man sich eine Gerade, die ja nach zwei entgegengesetzten Richtungen ins Unendliche geht, ein ganz klein wenig aber stets in einem Sinne gekrümmt, denke man sich ferner eine Ebene, die ebenfalls ins Unendliche verläuft, in gleicher Art ein wenig und stets in einem Sinne gekrümmt, so heißt dies ein Wanderer längs der Geraden gehend, ebenso ein Wanderer auf der Ebene in irgendeiner Richtung vorwärts schreitend, wird wieder zu seinem Ausgangspunkte zurückkehren, ohne eine Grenze oder Schranke gefunden zu haben. Die Gerade schließt sich nämlich zu einem Kreise, die Ebene zu einer Kugel. Ein Beispiel hiefür ist das Reisen auf der Erdoberfläche. Jeder Horizont in jedem Punkte der Erde erscheint uns eben, und von der verschiedenen Lage dieser Horizonte an den aufeinanderfolgenden Stellen unserer Wanderung merken wir nichts, wenn wir unser Auge nur gegen die Erde gesenkt halten, sondern erst dann, wenn wir es nach dem Himmel richten und die Veränderungen beobachten, die hiebei viele Erscheinungen des Sternenhimmels zeigen.

Ähnlich kann es auch beim Raum sein. Durch die Annahme einer ganz geringen Krümmung für ihn kann erzielt werden, daß er sich schließt, wie die Gerade zu einem Kreise, die Ebene zu einer Kugel, und daß ein Wanderer, der jetzt die Erde verläßt und im Raume sich fortbewegt, wieder zu seinem Ausgangspunkt zurückkehrt oder, da ein solcher Wanderer nur das Licht sein kann, daß alle Lichtstrahlen geschlossene Linien sind. Ein solcher Raum würde uns das Bild einer Endlichkeit und doch Unbegrenztheit geben.

Wenn nicht wieder eine neue Schwierigkeit hinzukäme. Sie liegt in der merkwürdigen Eigenschaft eines solchen Raumes, daß sich in ihm; zwei Gerade nicht wie in einem ebenen Räume in einem, sondern in zwei Punkten schneiden. Daß dies der Fall ist, wird uns aus der Analogie mit der Kugel klar. Gehen auf einer solchen zwei Wanderer von einem Punkte aus, so entfernen sie sich anfangs voneinander bis zu einer gewissen maximalen Distanz, nähern sich sodann wieder, treffen sich in einem Punkte auf der entgegengesetzten Seite der Kugel, dem sogenannten Gegenpunkte, entfernen sich wieder voneinander bis zu einem gewissen Maximum, um dann erst in ihrem Ausgangspunkt zusammenzukommen. Ebenso ist es im gekrümmten Raum. Zwei Lichtstrahlen, die von einem leuchtenden Punkte ausgehen, treffen sich außer im Ausgangspunkte, auch noch im entgegengesetzt gelegenen, und da jeder leuchtende Punkt durch die von ihm ausgehenden Lichtstrahlen sichtbar wird, so entspricht ihm noch ein zweiter, der Gegenpunkt, in dem sich die Strahlen abermals vereinigen. Jeder Beobachter muß also jede Lichtquelle doppelt sehen, einmal in der Richtung des kürzeren Lichtweges, das Original, dann in der entgegengesetzten des längeren, sein Gegenbild. Alle Sterne müßten doppelt auftreten, als wirkliche und als Gegenbilder. Aber welcher uns sichtbare Stern der reelle, welcher nur sein Gegenbild ist, wäre uns natürlich unbekannt. Ebenso auch die Sonne und ihr Gegenbild, die Gegensonne, und fragen wir, wie hell diese Gegenbilder, also auch die Gegensonne sein müßte, so wäre die Antwort darauf: ebenso hell wie das Original. Denn eine kleine Fläche, wie die Pupille unseres Auges, die dem Lichtstrahle sich entgegenstellt, wird offenbar von einem Bündel von Lichtstrahlen, das von der realen Lichtquelle kommt, ebenso stark beleuchtet wie von einem, das vom Gegenbilde stammt. Bild und Gegenbild würden also in gleicher Helligkeit erstrahlen. Kurz wir hätten neben einer Sonne des Tages auch eine Sonne der Nacht.

Doch diese Überlegungen bedürfen einer Verbesserung. Sie sind nur dann vollauf richtig, wenn die Sonne und die Sterne im Raume ruhen. Wie die Beobachtungen erkennen lassen, ist dies, nicht der Fall. Vielmehr bewegen sie sich mit verschiedenen Geschwindigkeiten nach den verschiedensten Richtungen, die Sonne z. B. mit 20 km in der Sekunde nach dem Sternbild des Herkules. Dies hat zur Folge, daß, da die von der Sonne oder den Sternen ausgehenden Lichtstrahlen an dieser Bewegung nicht teilnehmen, die entsprechenden Gegenbilder sich im Räume verschieben, namentlich aber ihre Helligkeit sehr bedeutend geschwächt wird und sie vielleicht ganz unsichtbar sein können. Hiezu kommt außerdem noch die Möglichkeit einer Absorption des Lichtes durch den Sternen vorgelagerte Nebelmassen, die ebenfalls eine Schwächung besonders in der Helligkeit der Gegenbilder der Sterne bei dem langen und um den gekrümmten Raum zurückzulegenden Kreislauf des Strahles hervorrufen kann.

Damit erscheint die neue Auffassung über den Raum wieder gerettet; wohl macht sie dem Verständnis viele Schwierigkeiten und die Analogie mit der Kugel gibt nur einen schwachen Ersatz dafür ab, von ihm ein anschauliches Bild zu erlangen. Aber sie bietet doch viele Vorteile gegenüber der gebräuchlichen Vorstellung des unendlichen euklidschen Raumes, daß die Menschen sich bald werden bequemen müssen, sie als die richtigere, d. h. den physikalischen Erscheinungen entsprechendere anzusehen.

*Der vorliegende Artikel ist die ungekürzte Fassung des Manuskripts des Vortrags, den Samuel Oppenheimer am 15.12.1925 im Verein zur Verbreitung naturwissenschaftlicher Kenntnisse in Wien gehalten hat. Die ursprüngliche Schreibweise wurde beibehalten, es wurden aber von der Redaktion mehrere Untertitel und 2 aktuelle, vom James-Webb Teleskop ezeugte Blicke auf Ausschnitte des Universums eigefügt.

[1] Redaktion, 26.12.2014: Popularisierung der Naturwissenschaften im 19. Jahrhundert

[2] Verein zur Verbreitung naturwissenschaftlicher Kenntnisse: https://www.zobodat.at/pdf/SVVNWK_66_0019-0032.pdf (download unter www.biologiezentrum.at)

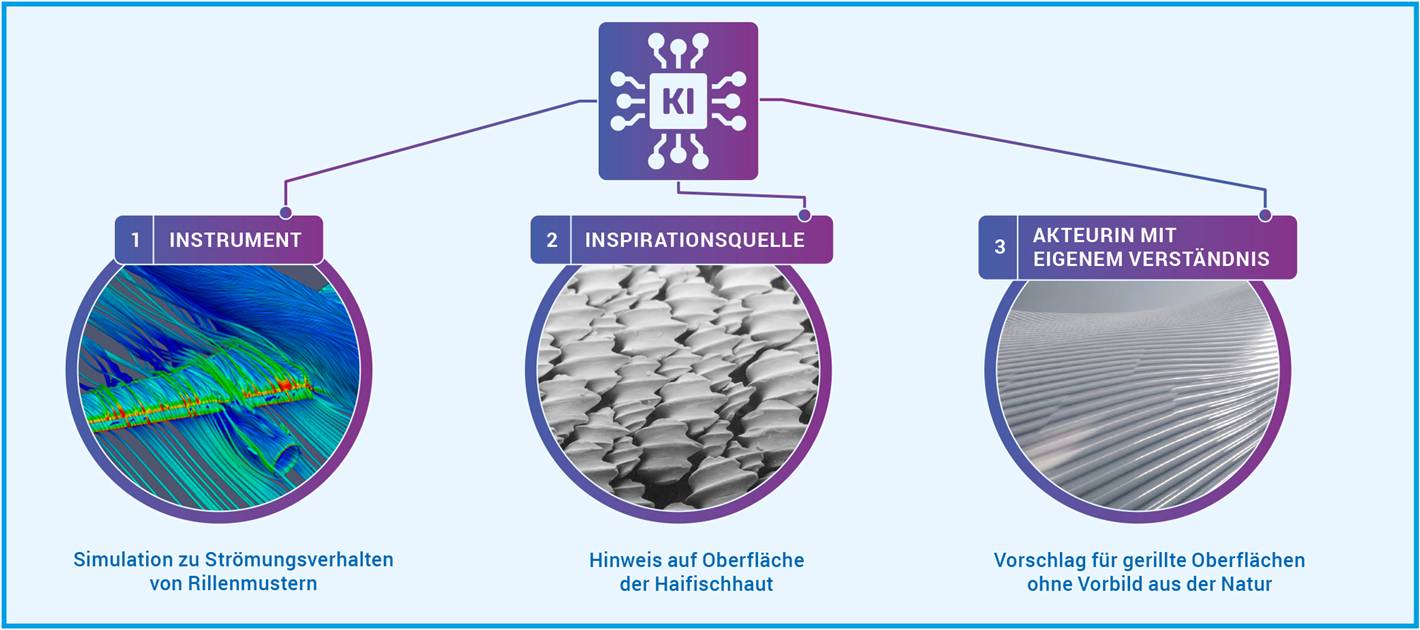

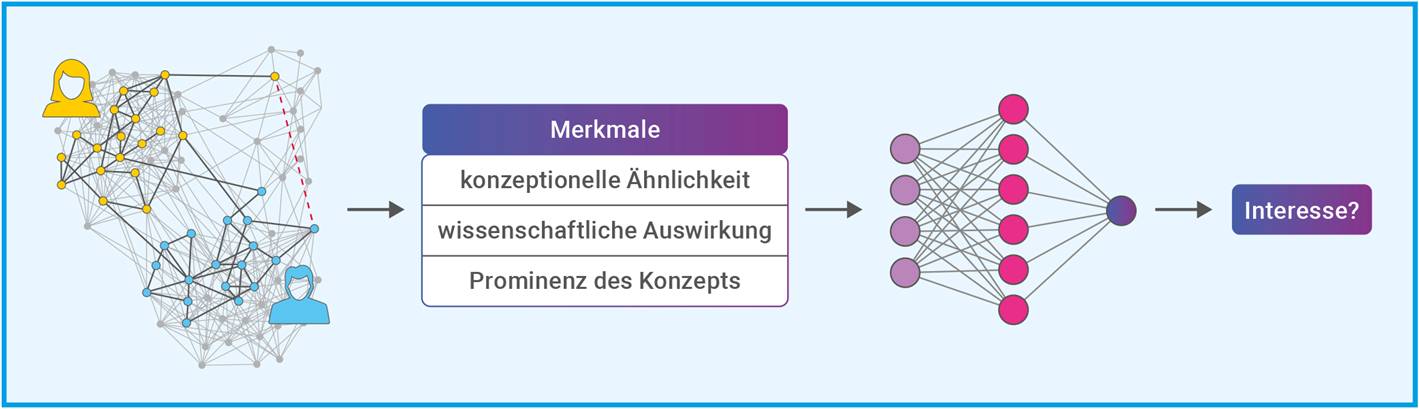

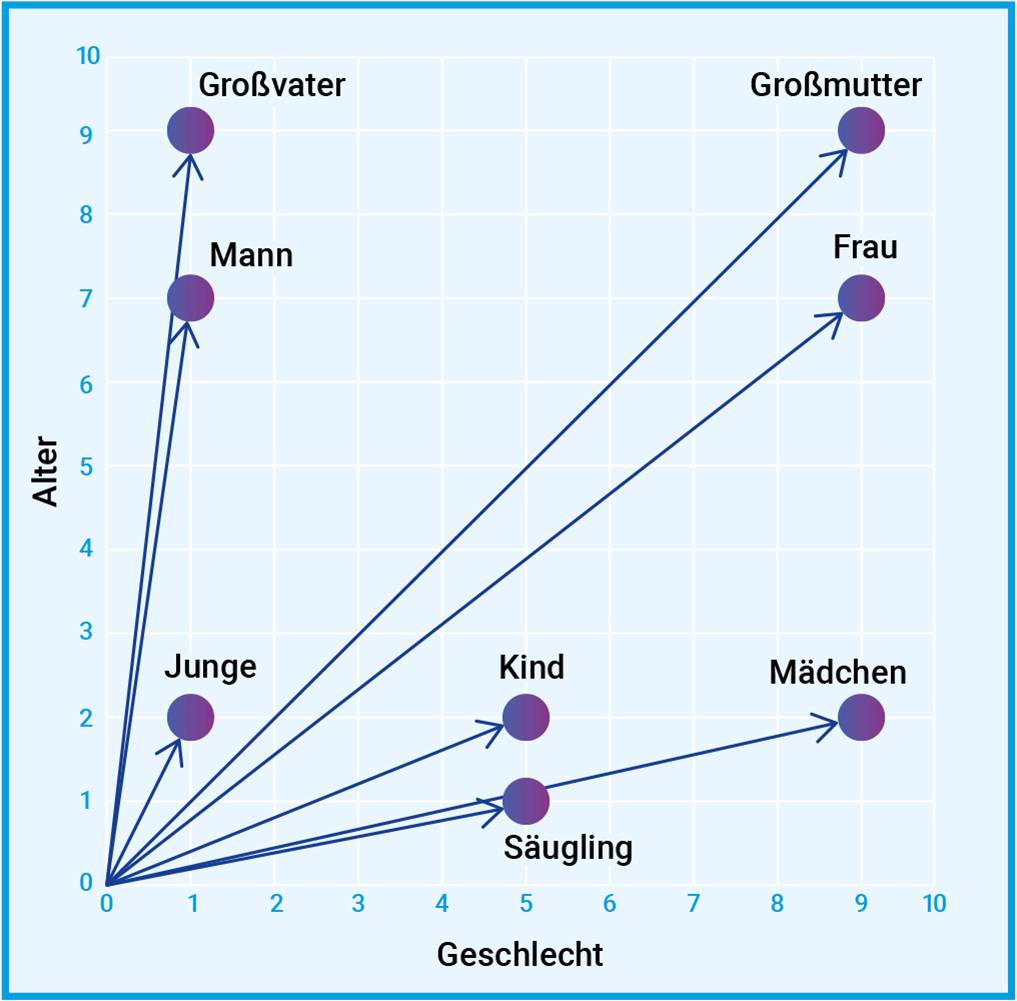

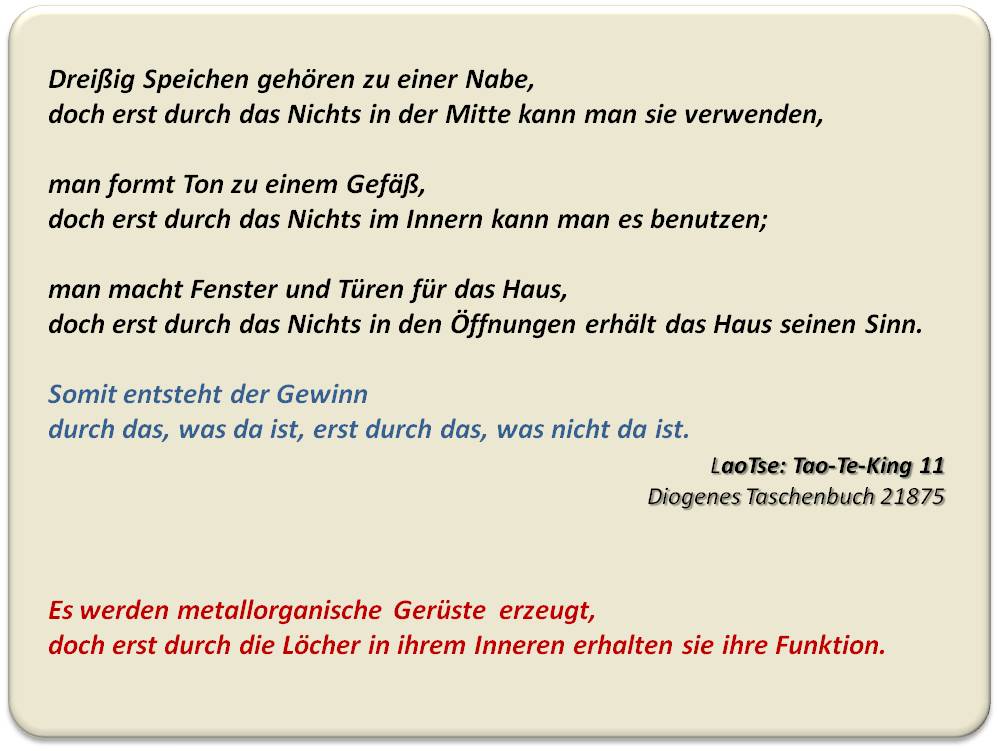

Strömungsforschung für eine verbesserte Effizienz von Windkraftanlagen

Strömungsforschung für eine verbesserte Effizienz von WindkraftanlagenMi, 17.12.2025 — Andreas Merian

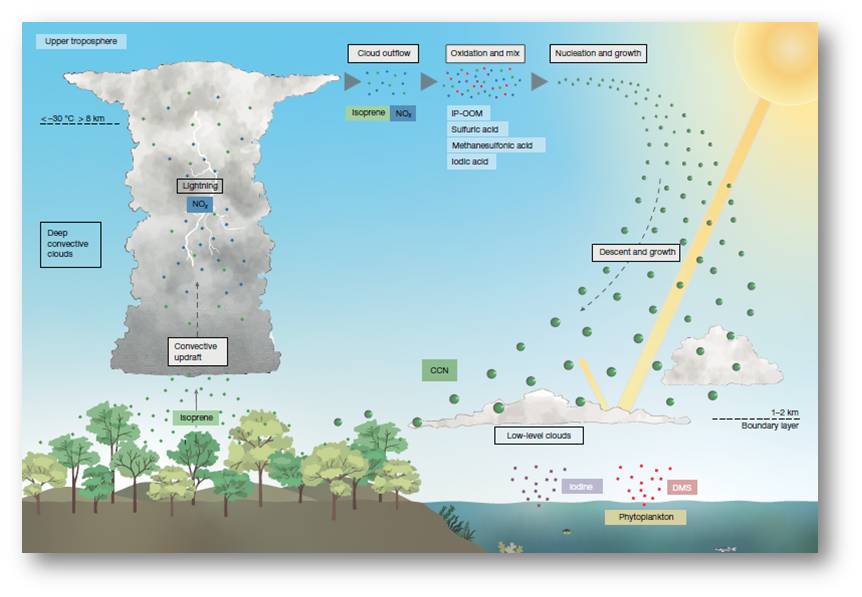

Windräder können sich gegenseitig den Wind klauen. Denn direkt hinter einem Windrad ist die Luftströmung turbulent und enthält weniger Energie. Das wird bei der Planung von Windparks zwar bereits berücksichtigt, doch neue Erkenntnisse wie die von Claudia Brunners Team am Max-Planck-Institut für Dynamik und Selbstorganisation in Göttingen könnten helfen, die Verluste weiter zu minimieren. Die Untersuchungen knüpfen an die Anfänge der Strömungsforschung in Göttingen an, die zur Gründung des Instituts vor 100 Jahren führten.*

An der Strömungsforschung kommt man in Göttingen kaum vorbei. Geht man vom Bahnhof aus Richtung Innenstadt stößt man vor dem Michaelishaus auf ein Hinweisschild: „Hier startete 1904 Ludwig Prandtl, der, Vater der Aerodynamik‘, seine wissenschaftliche Tätigkeit in Göttingen“. Mit seinen Arbeiten an der Schnittstelle zwischen Mathematik, Physik und den Ingenieurswissenschaften prägt Prandtl die Strömungs- und Turbulenzforschung bis heute. In seiner Forschung gingen grundlegende Untersuchungen Hand in Hand mit technischen Anwendungen: Wie verhält sich Luft, die ein Hindernis umströmt? Was lässt sich daraus für die Konstruktion eines Flugzeugs lernen? Die Erkenntnisse stießen spätestens im Ersten Weltkrieg auf großes Interesse. Damals spielten Flugzeuge zum ersten Mal eine militärisch wichtige Rolle. Prandtl erforschte zusammen mit seinen Mitarbeitern bereitwillig, wie Flugzeugflügel oder auch Bomben strömungsmechanisch verbessert werden können.

Seine wissenschaftliche Prominenz nutzte Prandtl, sodass er bald ein großes Forschungsinstitut führte: die „Aerodynamische Versuchsanstalt“ und später das 1925 eingeweihte „Kaiser-Wilhelm-Institut für Strömungsforschung verbunden mit der Aerodynamischen Versuchsanstalt“. An diesen Instituten schuf Prandtl mit mehreren Windkanälen auch die experimentellen Voraussetzungen für hervorragende Forschung. Nachdem er und seine Forschung während des NS-Regimes und des Zweiten Weltkriegs wieder eine wichtige Rolle spielten, wurde das Institut 1945 von der britischen Militärregierung geschlossen und überprüft. Als Einrichtung der Grundlagenforschung durfte das Kaiser-Wilhelm-Institut für Strömungsforschung weiterbestehen.

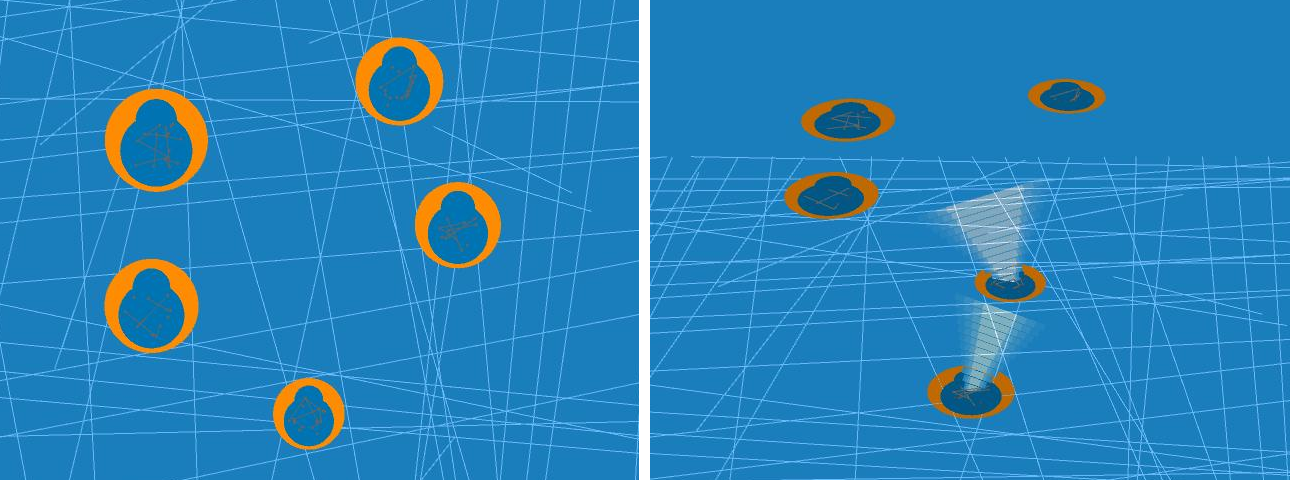

Nach der Gründung der Max-Planck-Gesellschaft als Nachfolge-Organisation der Kaiser-Wilhelm-Gesellschaft setzte es ab 1948 seine Arbeit als „Max-Planck-Institut für Strömungsforschung“ fort. Auch personell gab es nach dem Zweiten Weltkrieg keinen Bruch: Bis 1946 führte Ludwig Prandtl das Institut und übergab anschließend an seinen ehemaligen Doktoranden Albert Betz, der bereits jahrelang die Aerodynamische Versuchsanstalt geleitet hatte. Ab 1969 verlor die Strömungsforschung am Institut immer mehr an Bedeutung, bis sie 1993 gänzlich eingestellt wurde. Erst mit der Berufung der Direktoren Stephan Herminghaus und Eberhard Bodenschatz 2003 kam die Strömungsforschung ans Institut zurück, wurde aber in den größeren Zusammenhang nicht-linearer und selbstorganisierter Phänomene gestellt. Dies spiegelt auch der neue Name des Instituts wider, das seitdem Max-Planck-Institut für Dynamik und Selbstorganisation heißt. Bodenschatz erforscht mit seiner Abteilung unter anderem die Physik von Wolken und Turbulenz. Mit Claudia Brunner und ihrer 2023 etablierten Forschungsgruppe Turbulenz und Windenergie kehrt das Institut einerseits zurück zu seinen Anfängen und leistet andererseits Grundlagenforschung für die Zukunft. „Wir erforschen die Strömung an Windrädern und in Windparks, und das vom Millimeterbereich an der Kante der Rotorblätter bis hin zum Nachlauf, der sich über Hunderte Meter bis zu einigen Kilometern zieht“, sagt Claudia Brunner. Ziel ist es, die Strömungsmechanik von Windkraftanlagen besser zu verstehen und diese letztlich effizienter zu machen.

Die Grundlagen des Windstroms

|

Turbulenz im Windpark: Hinter Windrädern bilden sich Wirbel, die den Wind bremsen. Das muss bei der Planung der Anlagen berücksichtigt werden. (Foto: Vattenfall/ Christian Steiness.© Max-Planck-Gesellschaft) |

Schon in den Jahren nach dem Ersten Weltkrieg wurde in Göttingen intensiv an Windrädern geforscht. Denn durch den Versailler Friedensvertrag war Luftfahrtforschung in Deutschland verboten. Albert Betz, der sich bis dahin mit Propellern beschäftigt hatte, forschte in der Folge an Windrädern. Diese Forschung gewann zusätzlich an Bedeutung, weil Kohle im Deutschen Reich knapp und teuer wurde und alternative Energiequellen gefragt waren. Mit seiner Forschung legte er wichtige Grundlagen, beispielsweise das Betzsche Gesetz. Es besagt, dass ein Windrad maximal knapp 60 Prozent der Energie ernten kann, die der Wind, der auf seine Rotorfläche trifft, mit sich bringt. Seitdem hat sich viel getan, und die Windenergie ist mit einem Anteil von etwa 30 Prozent der wichtigste Energieträger in Deutschland geworden. Doch obwohl die Nutzung der Windenergie über viele Jahre optimiert wurde, gibt es noch zahlreiche offene Forschungsfragen, die auch für den Betrieb von Windrädern und Windparks bedeutsam sind. Dies betrifft vor allem die Wirbel, die an beziehungsweise hinter Windrädern auftreten. Denn turbulente Strömungen sind äußerst komplex und können von der Physik bislang noch nicht im Detail beschrieben werden.

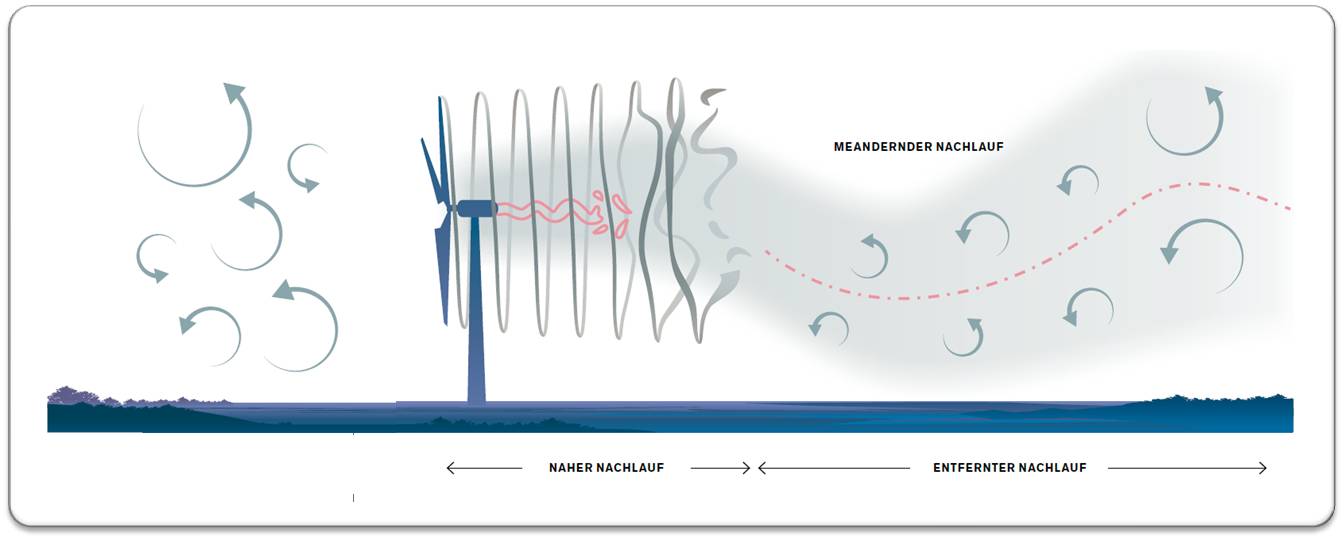

Eine turbulente, das heißt von Wirbeln geprägte Strömung bildet sich, wenn Gase oder Flüssigkeiten auf ein Hindernis treffen. Bei Schiffen, die durchs Wasser pflügen, geschieht das im Kielwasser. Der gleiche Effekt in der Luft wird als Nachlauf bezeichnet, oftmals wird aber auch das englische Wort Wake verwendet. Der Wake-Effekt tritt auch hinter Windrädern auf und spielt vor allem in Windparks eine große Rolle. Denn im Nachlauf eines Windrads trägt der Wind weniger Energie in sich. Die Windräder in den hinteren Reihen können somit weniger Strom erzeugen als die in der ersten Reihe. In großen Windparks kann das zu Verlusten von bis zu zehn Prozent führen. Erst in größerem Abstand zum Windrad nimmt die Strömung auf dessen Höhe wieder Fahrt auf. Dann schiebt die gerichtete und schnellere Strömung aus größerer Höhe die Luft in den oberflächennahen Schichten an. „Wann das genau passiert und wovon das abhängt, ist bisher noch nicht ganz klar. Denn hinter einem Windrad können ziemlich stabile Wirbel auftreten, und erst wenn diese zusammenbrechen, kann die energiegeladene Luft aus höheren Schichten einströmen“, sagt Claudia Brunner. Daher untersuchten sie und ihr Team, von welchen Bedingungen der Zusammenbruch der stabilen Wirbel abhängt.

|

Geschwächte Strömung: Die Wirbel, die sich an den Spitzen der Rotorblätter und hinter der Gondel im Zentrum des Rotors bilden, lösen sich hinter großen Windrädern erst nach einigen Hundert Metern auf. Wie lange das dauert, hängt auch vom Abstand der Schraubenlinien und damit vom Verhältnis der Rotor- zur Windgeschwindigkeit ab.(werGRAFIK:GCO nach Porte-Agel. et al., Wind-Turbine and Wind-Farm Flows: A Review. Boundary-Layer Meteorol.174, 1–59 (2020)). |

Während es für typische Hindernisse wie Flugzeugflügel oder Autokarosserien verlässliche experimentelle Werte gibt, stellen moderne Windräder eine Herausforderung für die Forschenden dar. Denn: „Die Windräder sind in den letzten Jahren über unser grundlegendes Verständnis hinausgewachsen, gerade in den Offshore-Windparks“, erklärt Claudia Brunner. Dort erreichen die größten Windräder aktuell eine Nabenhöhe von 145 Metern, eine Rotorblattlänge von gut 115 Metern und liefern maximal 15 Megawatt elektrische Leistung. Für die Betreiber der Windräder ist die Rechnung einfach. Die Leistung, die ein Windrad produzieren kann, wächst quadratisch mit der Länge der Rotorblätter. Ein Windrad mit doppelt so langem Rotor kann also viermal so viel Strom produzieren. Das Strömungsverhalten dieser Riesen ist für die Forschenden dagegen nicht so einfach zu verstehen. Um nachzuvollziehen, warum die Anlagen nicht durch die bisherige Strömungsmechanik abgedeckt sind, hilft die Reynoldszahl. Sie beschreibt, wie sich eine Strömung von Fluiden wie Flüssigkeiten oder Gasen an einem Hindernis verhält. Die Reynoldszahl hängt von der Größe des umströmten Körpers sowie der Dichte, Viskositätund Geschwindigkeit des strömenden Fluids ab. Für Forschende wie Claudia Brunner ist entscheidend: Bei gleicher Reynoldszahl ähnelt sich das Strömungsverhalten geometrisch ähnlicher Körper. Solange also die Reynoldszahl vergleichbar bleibt, liefern Versuche im Windkanal mit einem verkleinerten Modell realistische Ergebnisse.

Windkanal mit aktivem Gitter

Doch hier kommt der Haken: Die Reynoldszahl für große Windräder ist sehr hoch und liegt im Bereich von 3 und 200 Millionen (die Reynoldszahl hat keine Einheit). Um diese in einem Windkanal zu erreichen und die Strömung an einem Modellwindrad im kleineren Maßstab genau zu untersuchen, müssen die Forschenden tricksen. Denn man kann derart hohe Reynoldszahlen zwar durch Strömungsgeschwindigkeiten nahe der Schallgeschwindigkeit erreichen. Doch bei solchen Geschwindigkeiten verhalten sich Luftströmungen grundsätzlich anders als bei Windgeschwindigkeiten, die auf der Erde üblich sind. Die Lösung: Die Luft muss durch ein wesentlich dichteres Gas ersetzt werden. Bei gleicher Geschwindigkeit vervielfacht sich so die Reynoldszahl. Am Göttinger Institut nutzen die Forschenden das Gas Schwefelhexafluorid (SF6), das etwa sechsmal so dicht ist wie Luft, und setzen dieses auch noch unter Druck.

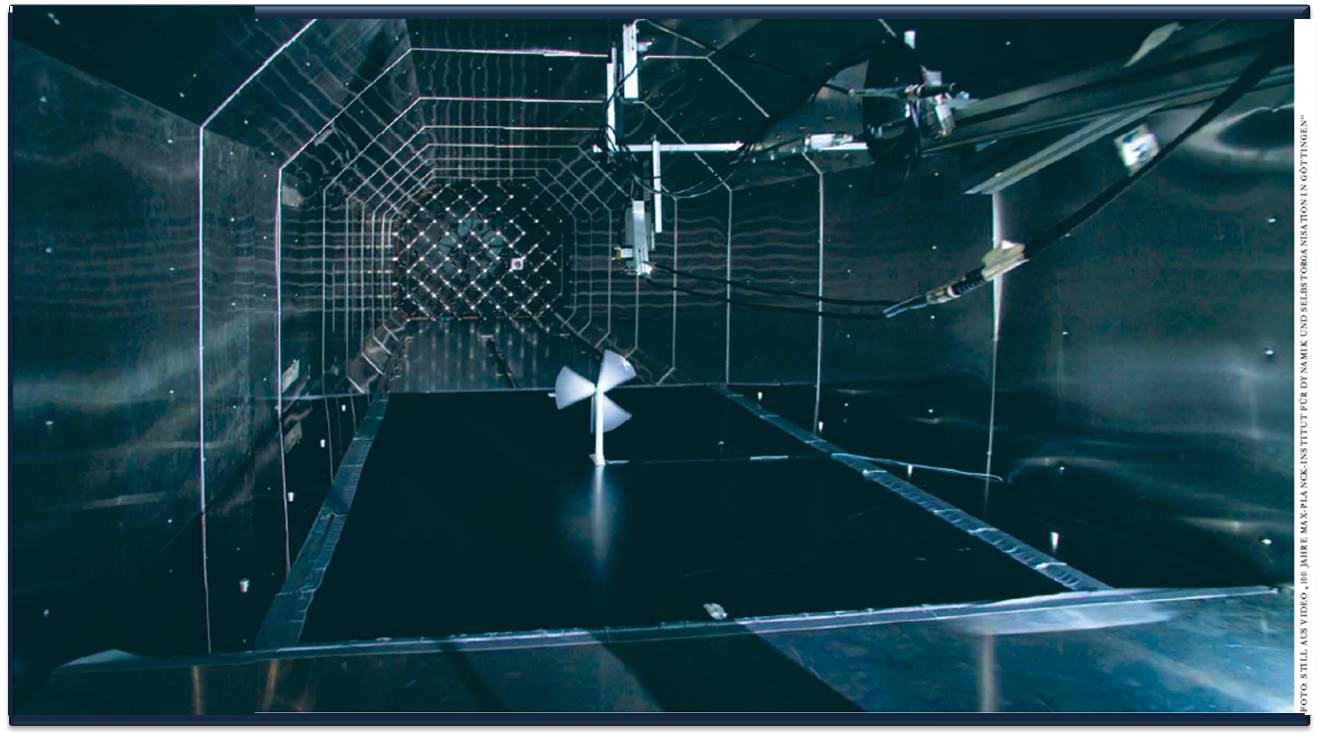

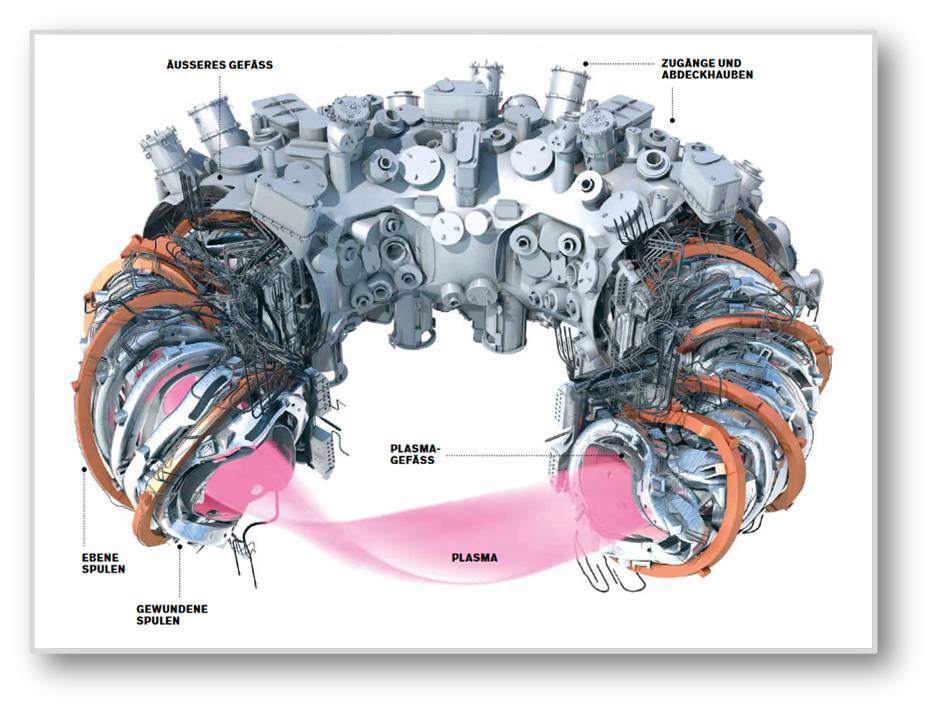

Dafür hat Eberhard Bodenschatz mit dem Variable Density Turbulence Tunnel (VDTT) am Max-Planck-Institut für Dynamik und Selbstorganisation eine weltweit einzigartige Versuchsanlage eingerichtet. Der Windkanal erinnert an ein auf der Seite stehendes, rotes Schlauchboot. Denn der fast 20 Meter lange und zwei Meter durchmessende Kanal aus rot lackiertem, massivem Stahl ist in sich geschlossen. So lässt er sich mit SF6 bei einem Druck von bis zu 15 bar und Strömungsgeschwindigkeiten bis 5,5 Metern pro Sekunde betreiben. Eine Besonderheit der Anlage ist, dass sich die Strömung durch ein aktives Gitter kontrollieren lässt. Dieses Gitter nimmt an einer Stelle den gesamten Kanal ein und besteht aus mehr als 100 Klappen, die sich einzeln öffnen und schließen lassen. Dadurch können die Forschenden im SF6-Strom, der durch einen Ventilator angetrieben wird, gezielt Turbulenzen erzeugen. Insgesamt lassen sich damit in diesem Druckwindkanal komplexe Strömungsverhalten und Turbulenzphänomene in einem 130-fach kleineren Maßstab beobachten. Claudia Brunner nutzt diese Anlage für ihre Untersuchungen des Wake-Effekts hinter einem Windrad.

Wo brechen die Wirbel zusammen?

Dazu hat Mano Grunwald, Mitglied in Brunners Team, ein Windradmodell im Windkanal installiert. Durch die besonderen Bedingungen, die der Kanal bietet, können die Forschenden mit einem Modell, das bis zur Nabe einen halben Meter hoch ist und dessen Rotorblätter 30 Zentimeter lang sind, bei einer Reynoldszahl von drei Millionen genaue Messungen machen. Mano Grunwald hat die Windgeschwindigkeit hinter dem Windrad für unterschiedliche Windverhältnisse mit hoher räumlicher und zeitlicher Auflösung bestimmt. Dank des aktiven Gitters konnte er mit realistischen Scherwinden und Turbulenzen im Luftstrom experimentieren, der auf das Windrad trifft. Scherwinde sind Strömungen, die nicht überall gleich schnell sind, im Fall des Windrads strömt die Luft unten langsamer als oben. Außerdem variierten die Forschenden das Verhältnis zwischen der Geschwindigkeit der Rotorspitzen und der Windgeschwindigkeit. Dieses Verhältnis wird Schnelllaufzahl genannt und ist eine wichtige Kennzahl für Windräder. In ihren Messdaten analysieren die Forschenden insbesondere, wo die Wirbel hinter dem Windrad zusammenbrechen.

|

Miniatur: In ihrem Windkanal experimentieren die Göttinger Forschenden mit kleinen Windrädern. Da sie dabei das sehr dichte Schwefelhexafluorid statt Luft verwenden, gelangen sie trotzdem zu realistischen Ergebnissen. Mit dem aktiven Gitter im Hintergrund lassen sich die Strömungen modulieren. (FOTO: Aus Video „100 Jahre Max-Planck-Institut für Dynamik und Selbstorganisation in Göttingen.) |

Die stabilen Wirbel entstehen an den Spitzen der drei Rotorblätter. Durch die ständige Drehung des Windrads und die weiterströmende Luft bildet sich eine Helix aus drei Wirbeln, die sich im Nachlauf in Windrichtung schrauben. Abhängig von den exakten Bedingungen ist diese Helix über größere Distanzen stabil. Im Bereich direkt hinter dem Windrad, bis zum Abstand von etwa einer Rotorblattlänge, verändert sich die Helix kaum. Anschließend bricht sie zusammen, doch das zieht sich über einen Bereich von vier bis acht Rotorblattlängen. Im Fall von großen Windrädern sind das mehrere Hundert Meter bis etwa ein Kilometer. Die Experimente zeigten, dass eine größere Schnelllaufzahl den Zusammenbruch beschleunigt. Denn je schneller das Windrad im Vergleich zur Windgeschwindigkeit rotiert, desto enger liegen die Schraubenlinien der Helix zusammen. Und je dichter beieinander die Schraubenlinien der Wirbel liegen, desto stärker bringen sie sich gegenseitig durcheinander und desto schneller brechen sie zusammen. Schließlich löst sich die Turbulenz langsam ganz auf, und die eigentliche Strömung des Winds dominiert wieder. Hinter Windrädern, die sich verhältnismäßig schneller drehen, nimmt der Wind also schneller wieder Fahrt auf. Aktuell wird die Schnelllaufzahl von den Betreibern so gewählt, dass ein einzelnes Windrad die Windenergie optimal erntet und die maximal mögliche elektrische Leistung erzeugt. „Wir haben zum ersten Mal in detaillierten Experimenten gezeigt, dass die Schnelllaufzahl auch bei realistischen, turbulenten Bedingungen beeinflusst, wie schnell die Blattspitzenwirbel zusammenbrechen. In Windparks könnte es also gewinnbringend sein, die Schnelllaufzahl zu erhöhen, um den Wake-Effekt abzumildern“, sagt Claudia Brunner.

Partikel-Tracking im Feldversuch

Die hochaufgelösten Messungen der Windgeschwindigkeit lassen zwar Rückschlüsse auf die Strömungen und Turbulenzen hinter dem Windrad zu. Sie zeigen aber nicht genau, wie die entstehenden Wirbel aussehen und miteinander wechselwirken. Diese Feinheiten lassen sich in einem Fluid erst studieren, wenn man kleinste Partikel hinzufügt und genau beobachtet. In seinen Grundzügen verfolgte diesen Ansatz auch schon Ludwig Prandtl vor mehr als 100 Jahren: In seinen Wasserkanälen verwendete er beispielsweise Eisenglimmer und in seinen Windkanälen Rauch, um das Strömungsverhalten sichtbar zu machen. Heute bringt Claudia Brunners Team kleinste Glaskügelchen in den SF6-Strom ein und beleuchtet diesen Bereich mit extrem hellen LEDs. Vier moderne Hochgeschwindigkeitskameras zeichnen die Partikelbewegungen aus unterschiedlichen Blickwinkeln mit einer Bildrate von 5000 Bildern pro Sekunde auf. So können die Forschenden auch kleinste Details im Strömungsverhalten an Windrädern aufklären. Gerade haben sie auch begonnen, das Partikel-Tracking in Feldversuchen mit echten Windrädern einzusetzen. Denn so realistisch die Strömung im Göttinger Windkanal durch den Einsatz von SF6 und das aktive Gitter auch ist, die ganze Komplexität der Luftbewegungen, die in Wirklichkeit auftreten, spiegelt sie nicht wider. Deshalb tüftelt Claudia Brunner mit ihrem Team an einer ganz besonderen Drohne. Der Multikopter ist so ausgestattet, dass er in den Bereich vor dem Windrad fliegen und dort viele Seifenblasen produzieren kann. Welchen Weg diese Seifenblasen dann im Einzugsbereich und im Nachlauf des Windrads nehmen, können Kameras einfangen. Auch Ballone setzen die Forschenden ein, um Luftströmungen in Windparks über eine Länge bis zu 30 Kilometern zu untersuchen. „Durch die Kombination von Messungen im Windkanal und in Feldversuchen stellen wir sicher, dass unsere Ergebnisse realistisch und übertragbar sind“, sagt Claudia Brunner. Die Geschichte der Strömungsforschung in Göttingen geht also auch mehr als 100 Jahre nach ihren Anfängen weiter.

*Der Artikel ist unter dem Titel "Wirbel im Windschatten" im Wissenschaftsmagazin - MaxPlanck-Forschung 04/2025 https://www.mpg.de/25885564/MPF_2025_4 im Dezember 2025 erschienen und wird - mit Ausnahme des Titels und eines fehlenden Fotos - hier unverändert wiedergegeben . Die MPG-Pressestelle hat freundlicherweise der Verwendung von Magazin-Beiträgen im ScienceBlog zugestimmt. (© Max-Planck-Gesellschaft)

Große Physik und große Verantwortung: zum 100-jährigen Bestehen des Instituts für Strömungsforschung in Göttingen (heute: Max-Planck Institut für Dynamik und Selbstorganisation): https://www.mpg.de/25050354/100-jahre-max-planck-institut-fuer-dynamik-und-selbstorganisation

Alle Gebäude dieser Welt - Der GlobalBuildingAtlas

Alle Gebäude dieser Welt - Der GlobalBuildingAtlasSa, 13.12.2026. — Redaktion

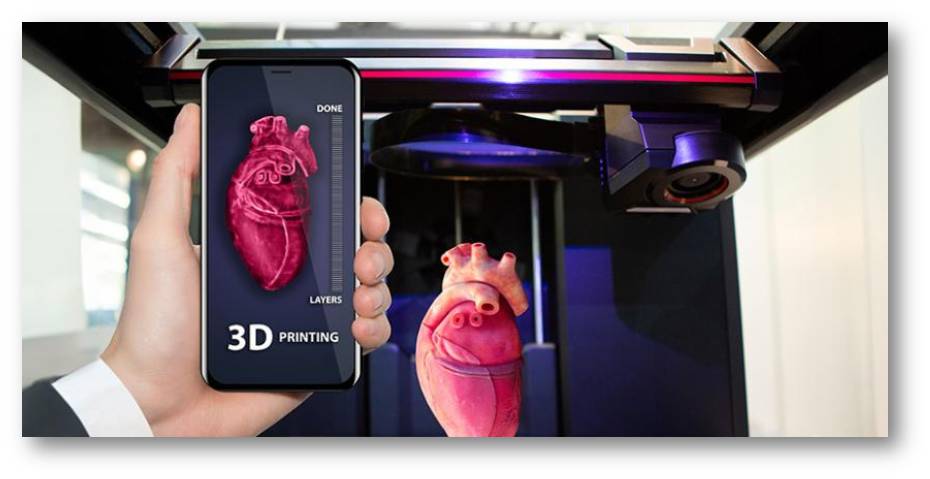

![]() Wie viele Gebäude gibt es auf unserer Erde, wie groß sind sie und wie sehen sie in 3D aus? Basierend auf Satellitenaufnahmen hat ein Forscherteam der Technischen Universität München (TUM) erstmals eine hochauflösende 3D-Karte (nahezu) aller Gebäude weltweit erstellt. Der riesige Datensatz dieses Global Building Atlas umfasst 2,75 Milliarden Gebäude und ist frei zugänglich. Die Daten liefern eine fundierte Grundlage für die Analyse und Entwicklung von Urbanisierung und Infrastruktur und für das Modellieren von Energieverbrauch und Emissionen. Die Kenntnis von Gebäudestruktur und -dichte ermöglicht auch eine bessere Risikobewertung von lokalen bis hin zu globalen Umweltauswirkungen und ein effizienteres Katastrophenmanagement.

Wie viele Gebäude gibt es auf unserer Erde, wie groß sind sie und wie sehen sie in 3D aus? Basierend auf Satellitenaufnahmen hat ein Forscherteam der Technischen Universität München (TUM) erstmals eine hochauflösende 3D-Karte (nahezu) aller Gebäude weltweit erstellt. Der riesige Datensatz dieses Global Building Atlas umfasst 2,75 Milliarden Gebäude und ist frei zugänglich. Die Daten liefern eine fundierte Grundlage für die Analyse und Entwicklung von Urbanisierung und Infrastruktur und für das Modellieren von Energieverbrauch und Emissionen. Die Kenntnis von Gebäudestruktur und -dichte ermöglicht auch eine bessere Risikobewertung von lokalen bis hin zu globalen Umweltauswirkungen und ein effizienteres Katastrophenmanagement.

Derzeit leben über 50 % der Weltbevölkerung in Städten und mit der fortschreitenden Urbanisierung wird dieser Anteil bis 2050 voraussichtlich auf fast 70 % steigen (Vereinte Nationen, 2024). Für die Gestaltung einer nachhaltigen Zukunft bedeutet dies große Herausforderungen, insbesondere für eine nachhaltige Stadtplanung, die darauf abzielt, Armut und Ungleichheiten zu reduzieren, Versorgungssicherheit in Hinblick auf Ernährung und Energie zu gewährleisten und Bedrohungen durch Klimawandel und Umweltveränderungen wirksam abzumildern. Um Fortschritte auf diesem Weg zu überwachen, wird als einer der wichtigsten Indikatoren das Verhältnis zwischen Landverbrauch - auf der Basis der verbauten Fläche - und Bevölkerungswachstum herangezogen. Dieser Indikator kann zwar Einblicke in die regionale und globale Verteilung von Bauwerken liefern, führt aber auf Grund seiner zweidimensionalen Informationen zu verzerrten Darstellungen von Städten, wo mehr-/vielstöckige Bauten den Raum auch vertikal nutzen. Erdbeobachtungen aus dem Weltall können nun genutzt werden, um weltweit, insbesondere in schnell wachsenden städtischen Gebieten, ausreichende aktuelle Daten auf dreidimensionaler Ebene zu erheben.

Der GlobalBuildingAtlas (GBA)

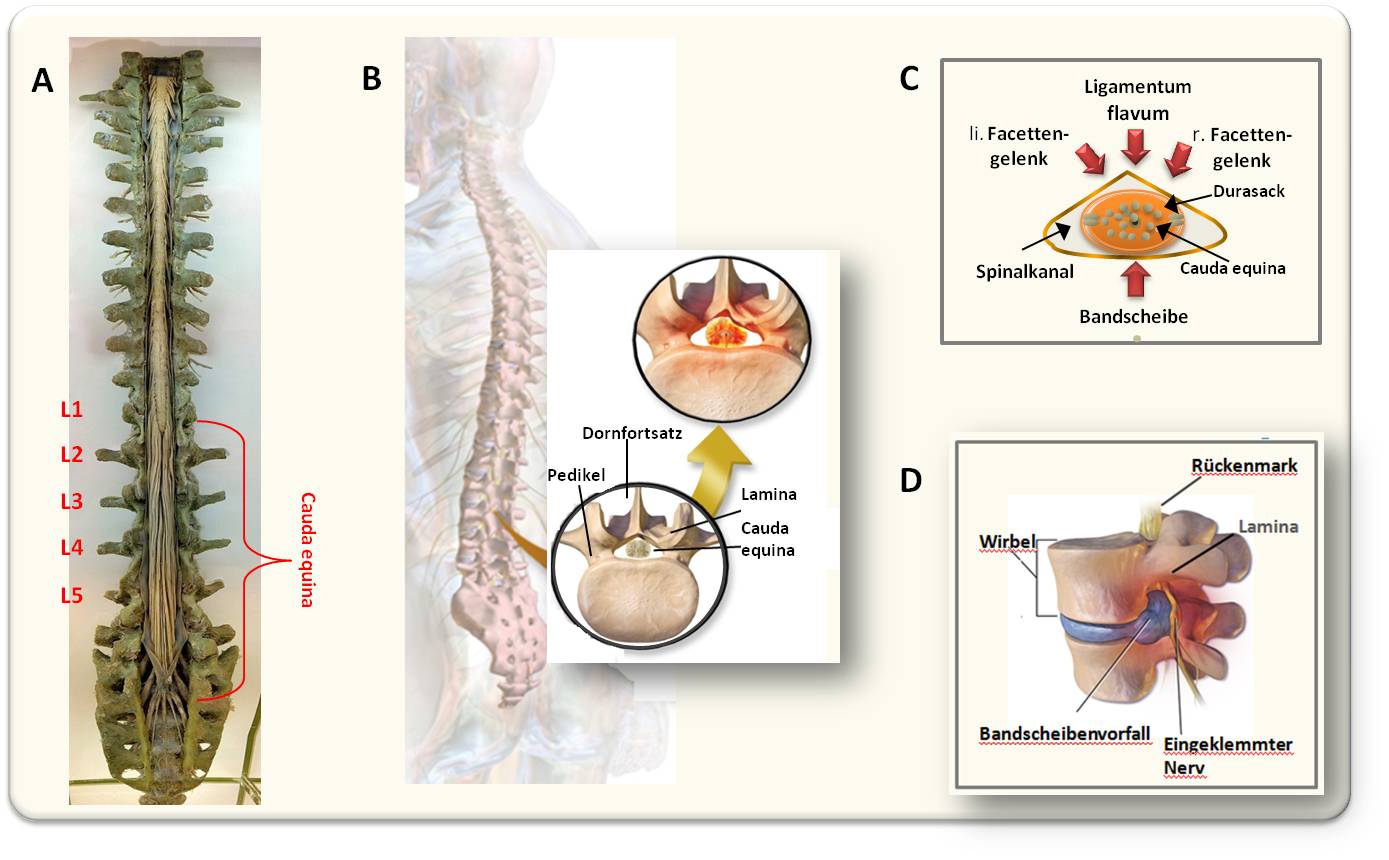

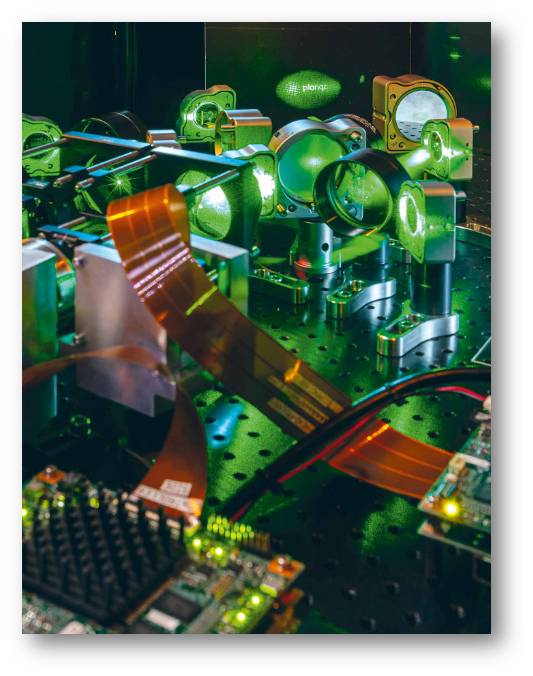

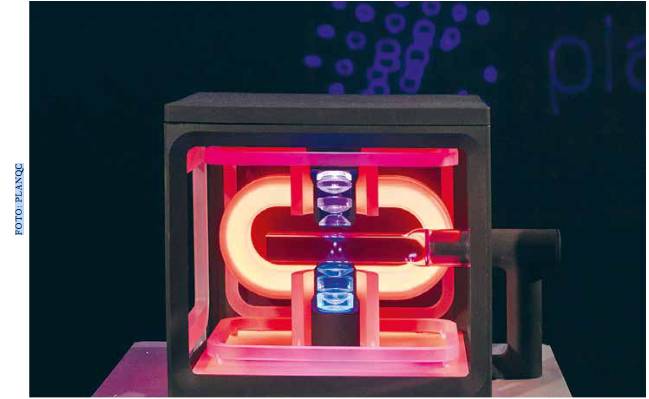

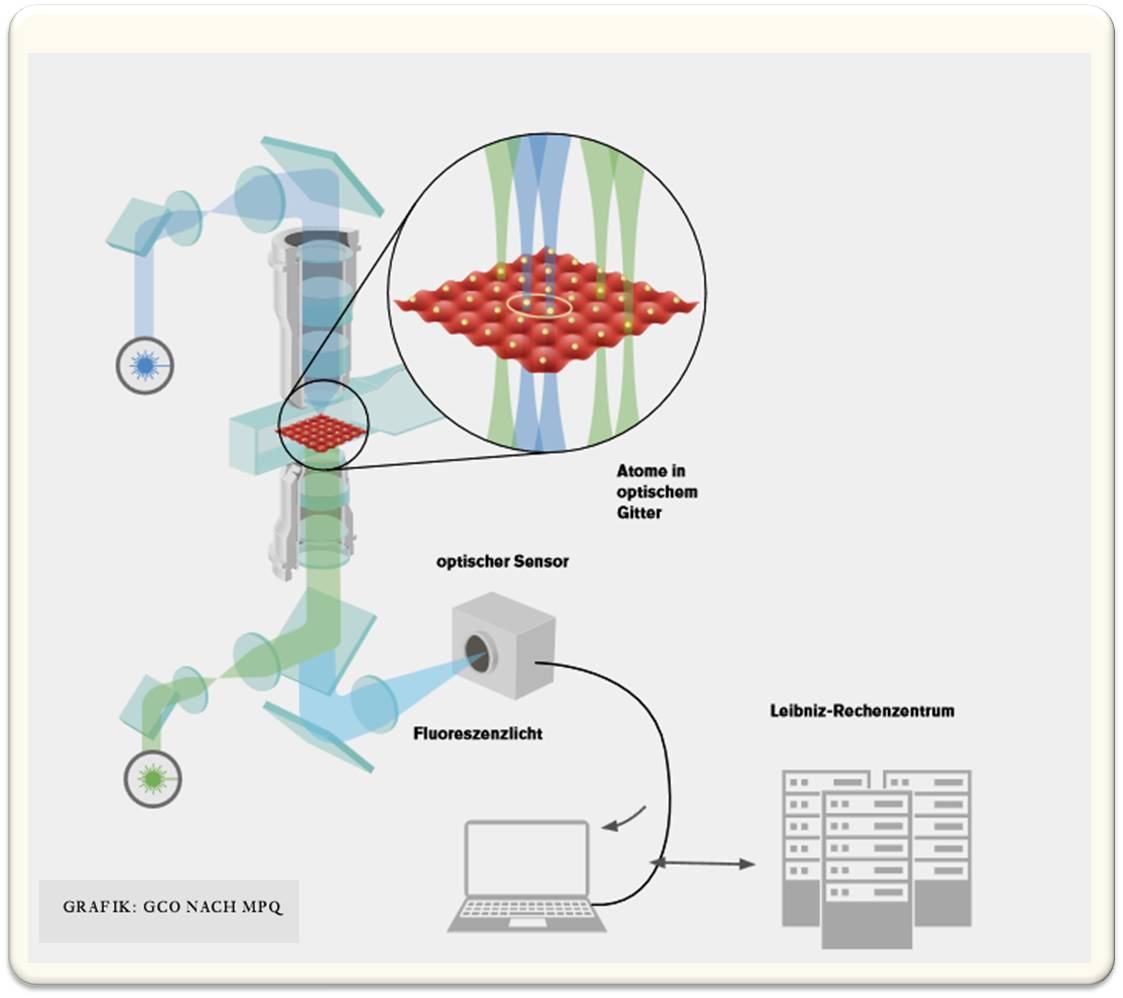

Ein Forscherteam um Xiao Xiang Zhu, die Professorin für Datenwissenschaft in der Erdbeobachtung an der Technischen Universität in München (TUM) ist, hat nun erstmals eine vollständige 3D-Karte aller Gebäude unserer Erde erstellt: Den Global Building Atlas. Die Forscher nutzten dazu optische Aufnahmen von PlanetScope - einer aus bis zu mehreren Hundert CubeSats bestehenden Satellitenkonstellation -, die in mehreren Wellenlängen von sichtbarem und infrarotem Licht täglich praktisch den gesamten Globus erfasst und sich durch sehr hohe räumliche Auflösung (3 Meter) auszeichnet. Zusätzlich haben die Forscher verschiedene digitale Karten ausgewertet, aus denen sie die Flächen der Gebäude extrahierten und mit Hilfe der Lidar Technologie (Airborne Laser Scanning) dreidimensionale räumliche Informationen über die Höhe von Gebäuden erhoben. Das Verarbeiten und Analysieren der enormen Datenmengen erforderte neue Signalverarbeitungsmethoden und maschinelles Lernen.

Die Ergebnisse dieses mit einem ERC-Starting Grant geförderten Projekts wurden vor wenigen Tagen im Fachjournal Earth System Science Data veröffentlicht (Xiao Xiang Zhu et al., 2025), der komplette 36 TB große Datensatz ist auf GitHub (https://github.com/zhu-xlab/GlobalBuildingAtlas) sowie auf mediaTUM (https://mediatum.ub.tum.de/1782307) frei zugänglich.

2,75 Milliarden Gebäude

| Abbildung 1: Das Zentrum von München. Ein repräsentatives Beispiel für die Darstellung von Gebäuden in Form von LoD1-Modellen. (Quelle: Representative Dataset, rsync rsync://m1782307.rep@dataserv.ub.tum.de/m1782307.rep. Lizenz cc-by-nc.) |

Der GlobalBuildingAtlas ist die bislang präziseste Kartierung von Gebäuden. Mit einer beispiellosen räumlichen Auflösung von 3 Metern x 3 Metern - 30-mal besser als bisherige Kartierungen - werden alle Bauwerke erfasst, von denen Satellitenbilder aus dem Jahr 2019 vorliegen. Insgesamt sind dies 2,75 Milliarden Gebäude - um rund 1 Milliarde mehr als in der bisher größten Datenbank enthalten sind. In früheren Kartierungen fehlen vor allem Gebäude-Daten aus Regionen in Afrika, Südamerika und besonders aus ländlichen Gebieten, die im GBA nun erfasst sind.

97 % der Gebäude im GBA liegen als sogenannte LoD1 (Level of Detail 1)-3D-Modelle vor: Es sind dies vereinfachte, vektorbasierte dreidimensionale Darstellungen von Gebäuden, welche die Grundform und Höhe jedes Gebäudes und damit das Gebäudevolumen wiedergeben und sich besonders gut in Computermodelle für diverse Anwendungen (wie für Analysen von Stadtstrukturen, und Infrastrukturplanung) integrieren lassen. Wie solche LoD1-Modelle aussehen ist an Hand eines Ausschnitts vom Zentrum Münchens in Abbildung 1 dargestellt.

Das Gebäudevolumen

Mit der umfassenden globalen Abdeckung und der 3D-Darstellung der Gebäude ermöglicht der GBA detaillierte Analysen zu Anzahl, Fläche und Volumen von Gebäuden und bietet damit neuartige Einblicke wo und wie Menschen auf regionaler und globaler Ebene wohnen. Abbildung 2.

Insgesamt bedecken die 2,75 Milliarden Bauten rund 506 Milliarden m2 der Erdoberfläche (bei einer terrestrischen Erdoberfläche von rund 149 Billionen m2) und haben ein Volumen von 2,85 Billionen Kubikmetern. Die globale Karte des Gebäudevolumens zeigt dabei, dass sich dieses vor allem auf den Südosten Asiens, auf Mitteleuropa und den Osten von Nordamerika konzentriert.

| Abbildung 2: Überblick über das Datenset des GlobalBuildingAtlas. Oben links: Zahl der Gebäude in Asien, Europa, Nordamerika, Afrika , Südamerika und Ozeanien. Oben Mitte: Bebaute Fläche ( Mrd m2) auf den einzelnen Kontinenten. Oben rechts: Gebäudevolumina (Mrd m3) auf den einzelnen Kontinente. Unten: Globale Verteilung des Gebäudevolumens (Raster 480 m x 480 m). (Quelle: Figure 3 in Xiao Xiang Zhu et al. 2025, modifiziert. Lizenz cc-by.) |

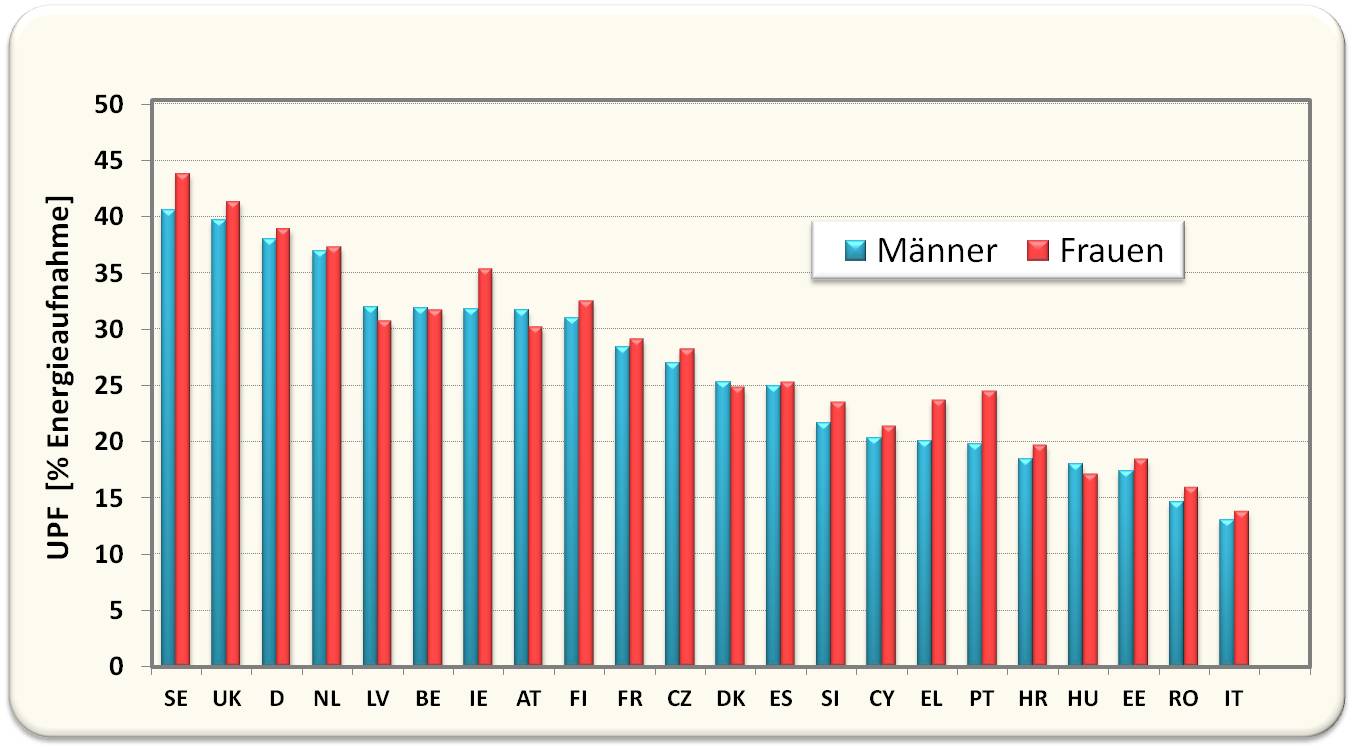

Dass in Asien, das rund 60 % der Weltbevölkerung aufweist, auch die meisten Bauten stehen - rund 44,4 % aller Gebäude -, die größte Fläche - 43,2 % der globalen Baufläche - überbaut ist und es mit 44, 6 % des globalen Gebäudevolumens auch hier an der Spitze liegt, verwundert nicht (Abbildung 2: oben). Afrika (Bevölkerung rund 1,55 Milliarden) besitzt zwar mit 540 Millionen Gebäuden hinter Asien mit 1,22 Milliarden Gebäuden (rund 5 Milliarden Bewohner) die zweithöchste Zahl an Bauwerken, die überbaute Fläche und das Gebäudevolumen zeigen aber, dass es sich dabei um kleine niedrige Bauten handelt.

Das Gebäudevolumen spielt eine zentrale Rolle im GBA, das Verhältnis Gebäudevolumen pro Kopf kann als aussagekräftiger neuer globaler Indikator für Stadtplanung, Ressourcenmanagement, Katastrophenschutz und Klimaforschung herangezogen werden.

„3D-Gebäudeinformationen liefern ein deutlich genaueres Bild von Urbanisierung und Armut als klassische 2D-Karten“, so Xiao Xiang Zhu. „Durch das 3D-Modell wird nicht nur die Fläche, sondern auch das Volumen des Gebäudes ersichtlich. Dadurch lassen sich viel präzisere Schlüsse über die Wohnverhältnisse ziehen. Wir führen damit einen neuen globalen Indikator ein: das Gebäudevolumen pro Kopf, also die gesamte Gebäudemasse im Verhältnis zur Bevölkerung – ein Maß für Wohnraum und Infrastruktur, das soziale und wirtschaftliche Unterschiede sichtbar macht. Dieser Indikator unterstützt die Umsetzung nachhaltiger Stadtentwicklung und hilft, Städte inklusiver und widerstandsfähiger zu gestalten.“ (Pressemitteilung der TUM)

Die Daten des GBA stoßen bereits auf sehr großes Interesse. Laut GitHub hat der Web-Server in den letzten Tagen über 280 000 Zugriffsanfragen erhalten, und die TUM teilt mit: "So prüft das Deutsche Zentrum für Luft- und Raumfahrt (DLR) den Einsatz des GlobalBuildingAtlas im Rahmen der „Internationalen Charter: Space and Major Disasters“.

Xiao Xiang Zhu et al., GlobalBuildingAtlas: an open global and complete dataset of building polygons, heights and LoD1 3D models. Earth Syst. Sci. Data, 17, 6647–6668, 2025. h https://doi.org/10.5194/essd-17-6647-2025

Pressemitteilung der TUM (2.12.2025): Erstmals alle Gebäude der Welt als 3D-Modell verfügbar. https://www.tum.de/aktuelles/alle-meldungen/pressemitteilungen/details/erstmals-alle-gebaeude-der-welt-als-3d-modell-verfuegbar

Ein Metabolit des Mikrobioms ist Treiber und therapeutisches Target von Atherosklerose

Ein Metabolit des Mikrobioms ist Treiber und therapeutisches Target von AtheroskleroseDo, 04.12.2025— Inge Schuster

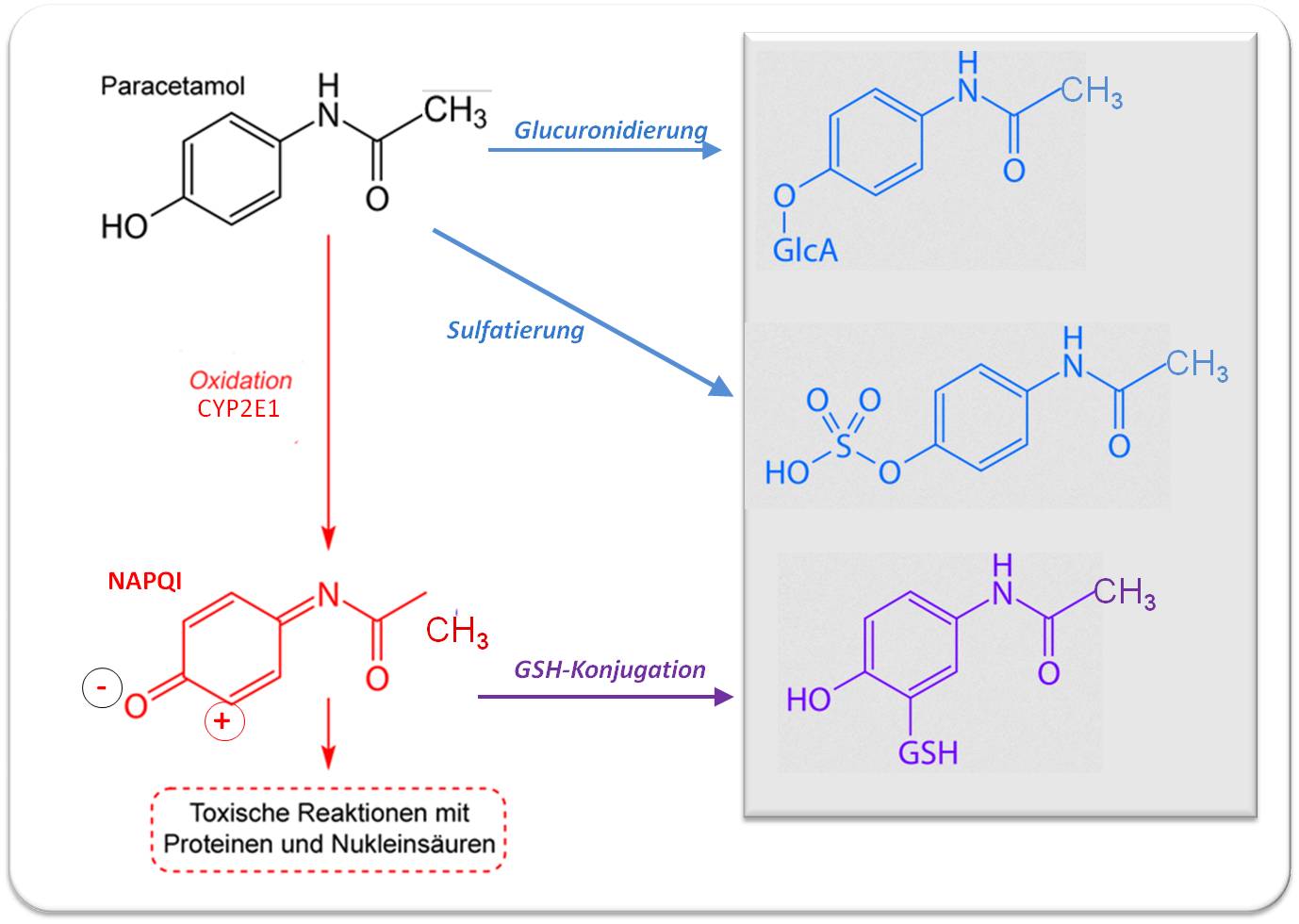

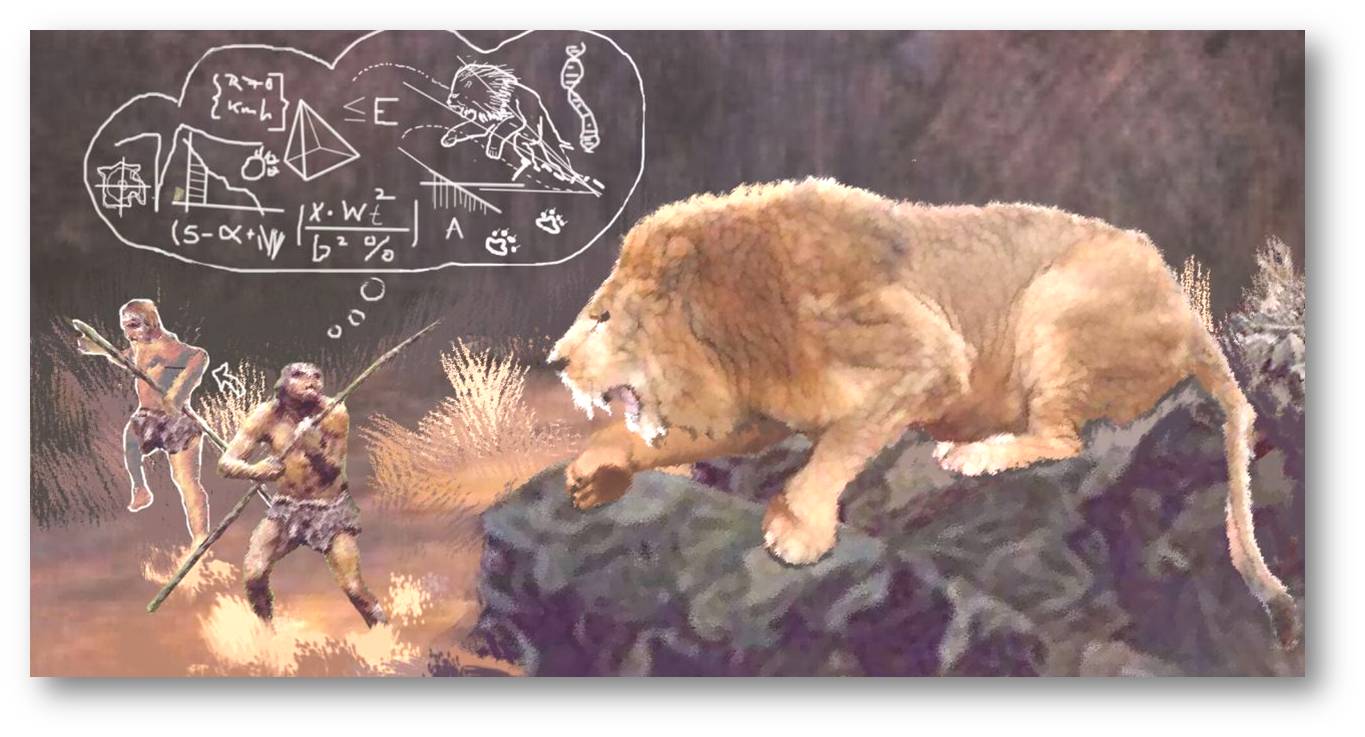

Weltweit sind Herz-Kreislauferkrankungen die häufigste Todesursache und Atherosklerose ist deren Hauptursache. In deren Entstehung spielen laut aktuellen Untersuchungen chronische Entzündungen und Stoffwechselprodukte des Darmmikrobioms - hier insbesondere das von bestimmten Bakterien aus Histidin produzierte Imidazolpropionat (ImP) - eine wichtige Rolle. Eine neue Studie zeigt, dass in einem etablierten Atherosklerose Modell an der Maus ein kausaler Zusammenhang zwischen hohen ImP-Konzentrationen und Induktion von Atherosklerose besteht: Der auf Immunzellen lokalisierte I1-Imidazolinrezeptor (I1R) fungiert als ImP-Rezeptor. ImP aktiviert über I1R die Immunzellen, dies führt zu deren Freisetzung von Entzündungsfaktoren, welche die Zell-Infiltration in der innersten Wandschicht der Aorta und Ansammlung im Atherom-Plaque starten. Wird I1R blockiert oder ausgeschaltet, so wird die ImP-induzierte Atherosklerose vollständig verhindert. In Langzeitstudien an scheinbar gesunden Personen wurden erhöhte ImP-Blutspiegel auch bei subklinischer Atherosklerose, also in deren Anfangsstadien nachgewiesen. Die Bestimmung von ImP könnte somit ein früher Indikator für das Erkrankungs-Risiko sein, ImP selbst und sein Rezeptor ein vielversprechendes neues Target für therapeutische Maßnahmen darstellen.

Fragte man in den 1970er Jahren Experten, die über die Aufnahme von Nahrung im Verdauungstrakt forschten, welche Rolle die dort ansässigen Mikroorganismen dabei spielten, so war die einhellige Antwort: "Das wissen wir nicht". Erst in den letzten beiden Jahrzehnten konnten mit Hilfe modernster Techniken der Genomsequenzierung, der Probenanalytik und der Speicherung und Analyse gigantischer Datenmengen erste Einblicke in das Zusammenleben mit unserem Mikrobiom, in seine Vielfalt und seine Bedeutung für den Erhalt von Gesundheit und ebenso für die Entwicklung chronischer Erkrankungen gewonnen werden. Mit dem Ziel Forschungsressourcen für das neue Gebiet zu entwickeln haben die US-National Institutes of Health (NIH) im Jahr 2007 das Human Microbiome Project ins Leben gerufen. Diese über 10 Jahre laufende, 215 Millionen Dollar teure Initiative wirkte als Katalysator auf die Mikrobiomforschung: So verzeichnet die US-Literaturdatenbank PubMed unter "microbiome AND food" seit 2015 einen rasanten Anstieg auf über 50 000 Veröffentlichungen. Viele dieser Studien haben sich mit unverdaulichen Ballaststoffen (Präbiotika) befasst, mit deren Auswirkungen auf Zusammensetzung und Eigenschaften des Mikrobioms und deren Fermentation zu kurzkettigen Fettsäuren, die mit positiven Effekten auf Stoffwechsel, Immunsystem und insgesamt auf die Gesundheit assoziiert sind.

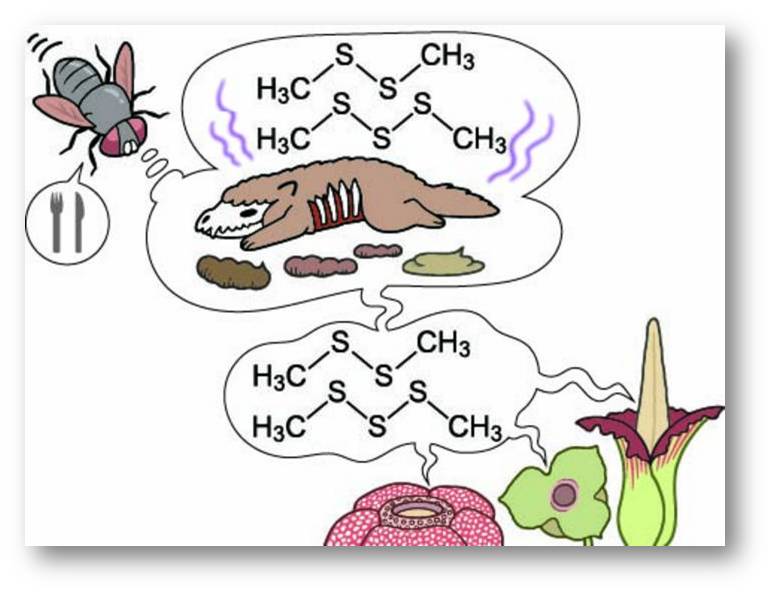

Schädliche Produkte unseres Mikrobioms

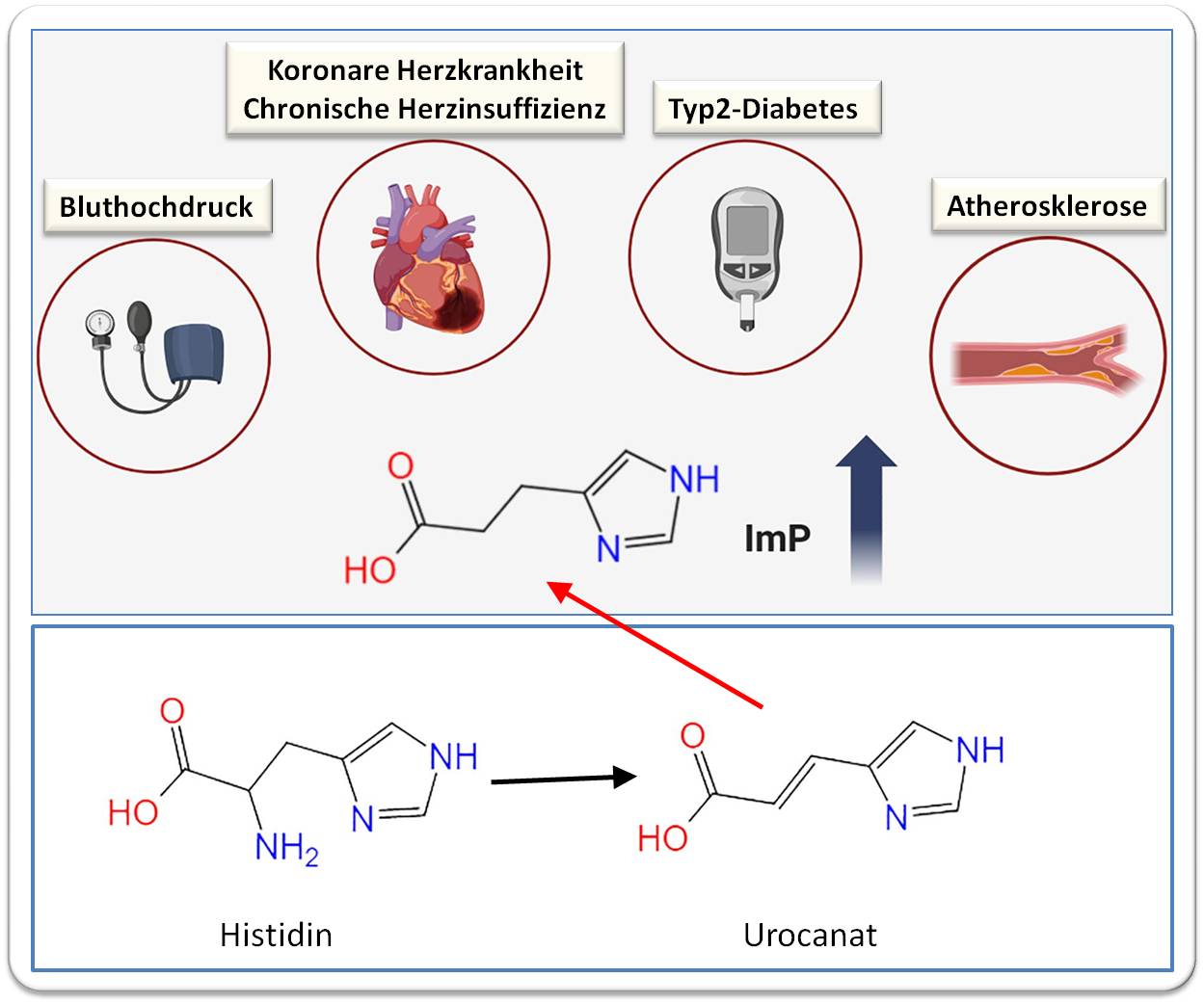

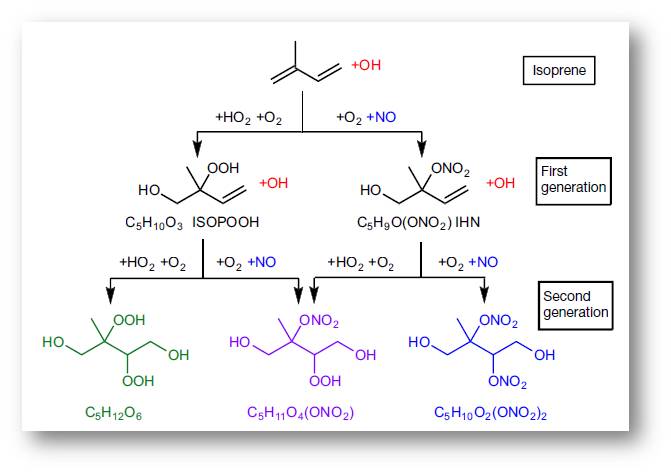

Neben den vorteilhaften Aspekten unserer Symbiose mit Mikroorganismen, können diese auch eine Fülle schädlicher Substanzen generieren - aus dem Abbau unserer Stoffwechselprodukte, dem Abbau von Nahrungsbestandteilen, aber auch aus aufgenommenen Umweltstoffen -, welche die Entstehung von Krankheiten begünstigen, vielleicht auch auslösen können. Beispiele dafür sind u.a. das von bestimmten E.coli Stämmen produzierte gentoxische Colibactin, das mit einem erhöhten Risiko von Darmkrebs einhergeht, das aus Cholin oder Carnitin gebildete Trimethylamin-N-oxid, das ebenfalls das Risiko für Darmkrebs, aber auch für Herz-Kreislauf- und Nierenerkrankungen erhöht und eine Fülle von Verbindungen, die aus Aminosäuren entstehen. In den letzten Jahren hat der aus der Aminosäure Histidin entstehende Metabolit Imidazolpropionat (ImP) auf Grund seiner engen Korrelation mit Stoffwechselstörungen und Herz-Kreislauferkrankungen besonderes Interesse erregt.

Imidazolpropionat - Entstehung und Auswirkungen

|

Abbildung 1. .Die Blutspiegel des bakteriellen Metaboliten Imidazolpropionat sind bei Stoffwechsel- und Herz-Kreislauferkrankungen erhöht. Stark vereinfachtes Schema. (Quelle: modifizierter Ausschnitt von Figure 2 in Quian Xu et al., Front. Immunol., 15:1454210. https://doi.org/10.3389/fimmu.2024.1454210. Lizenz: cc-by.) |

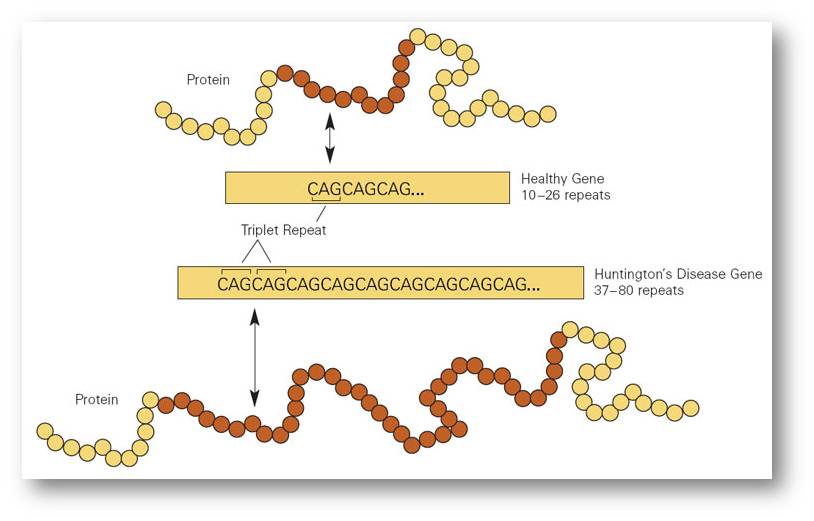

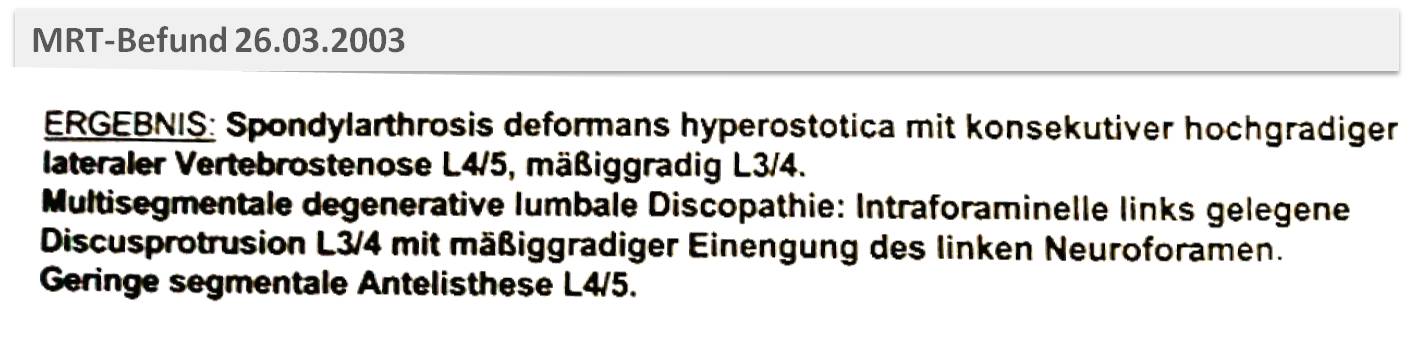

Histidin ist eine essentielle Aminosäure, die unser Körper nicht selbst synthetisieren kann und daher mit proteinreicher Nahrung zugeführt werden muss. Das aus den Proteinen freigesetzte Histidin wird zur Biosynthese neuer Proteine und Peptide eingesetzt, zum Neurotransmitter/Gewebshormon Histamin abgebaut und in mehreren Schritten zur Glutaminsäure umgebaut. Dieser Umbau beginnt mit der enzymatischen Abspaltung (durch Histidase) der Aminogruppe; das daraus entstehende Produkt (Urocaninsäure/Urocanat) wird durch ein Enzym (Urocanatreduktase), das nur bestimmte Bakterienarten, nicht aber der Wirtsorganismus besitzen, zu ImP reduziert, einer nicht mehr verstoffwechselbaren Verbindung, die aus dem Darm in den Blutkreislauf aufgenommen wird. (Strukturformeln der Metabolite: Abbildung 1). Unter physiologischen Bedingungen erreichen die ImP-Blutspiegel maximal wenige Nanogramm pro ml, unter pathologischen Bedingungen - im Fall von Stoffwechsel- oder kardiovaskulären Erkrankungen - können sie auf das Hundertfache ansteigen. Die Höhe der Spiegel wird in erster Linie nicht von der Menge des zugeführten Histidin bestimmt, sondern von Zusammensetzung und enzymatischer Aktivität der Bakterienpoulation.

Im Jahr 2018 hat ein Team von Universität und Universitätskrankenhaus Gotheburg (Schweden) erstmals einen engen Zusammenhang zwischen Diabetes Typ2 und einer erhöhten Produktion von ImP bei den Erkrankten festgestellt und die dafür verantwortlichen Bakterien identifiziert (Koh et al., 2018). Es zeigte sich, dass ImP offensichtlich den Signalweg des Insulins über den Insulinrezeptor inhibiert und in der Folge zu gestörtem Glukosestoffwechsel und Insulinresistenz führt. In der Folge weisen nun immer mehr klinische Studien und Versuche an Tiermodellen auf die enge Korrelation von Blutspiegeln des ImP und - über Typ-2-Diabetes hinaus - anderen Stoffwechselstörungen und Herz-Kreislauferkrankungen hin. Ein vereinfachtes Schema der pathologischen Auswirkungen von ImP ist Abbildung 1 dargestellt.

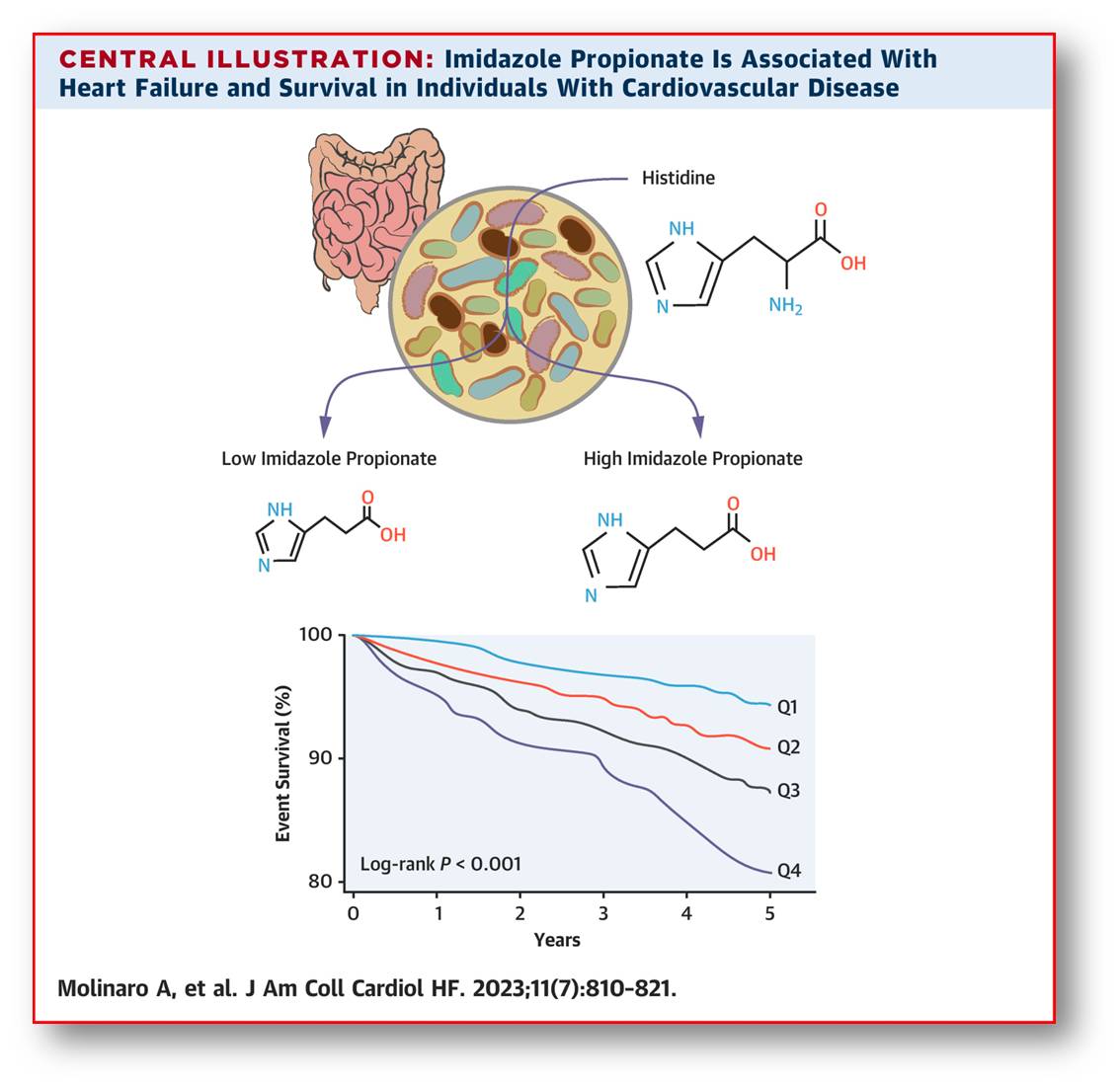

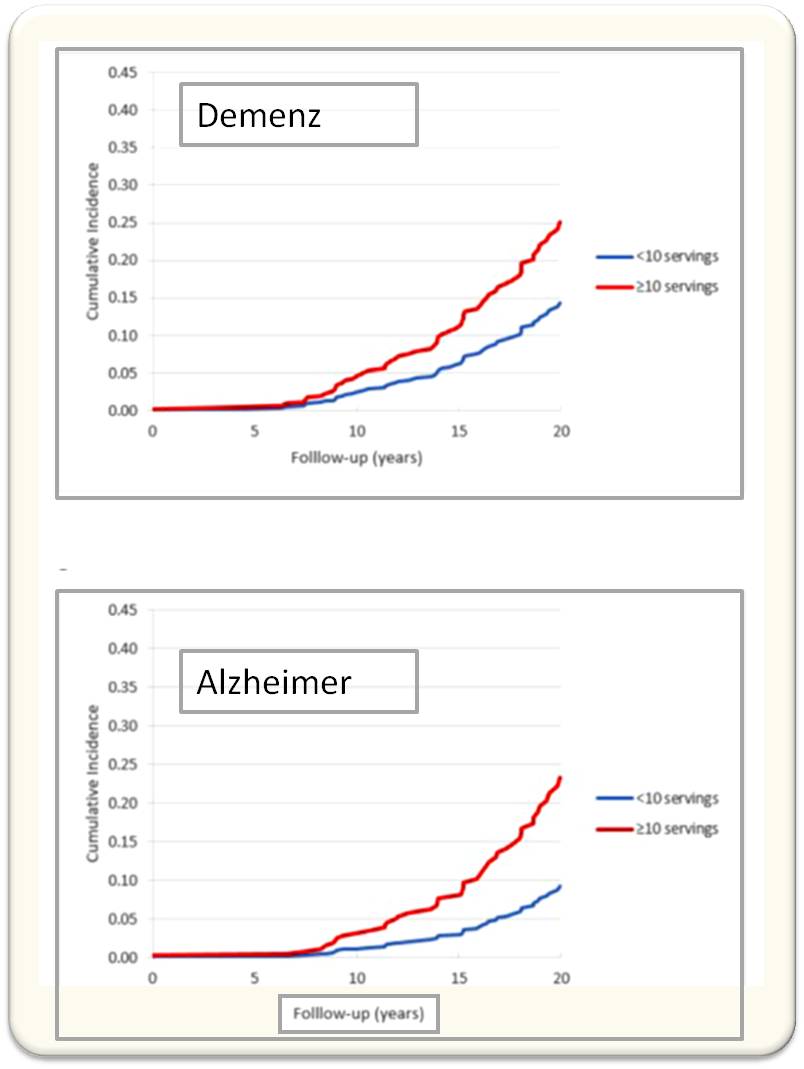

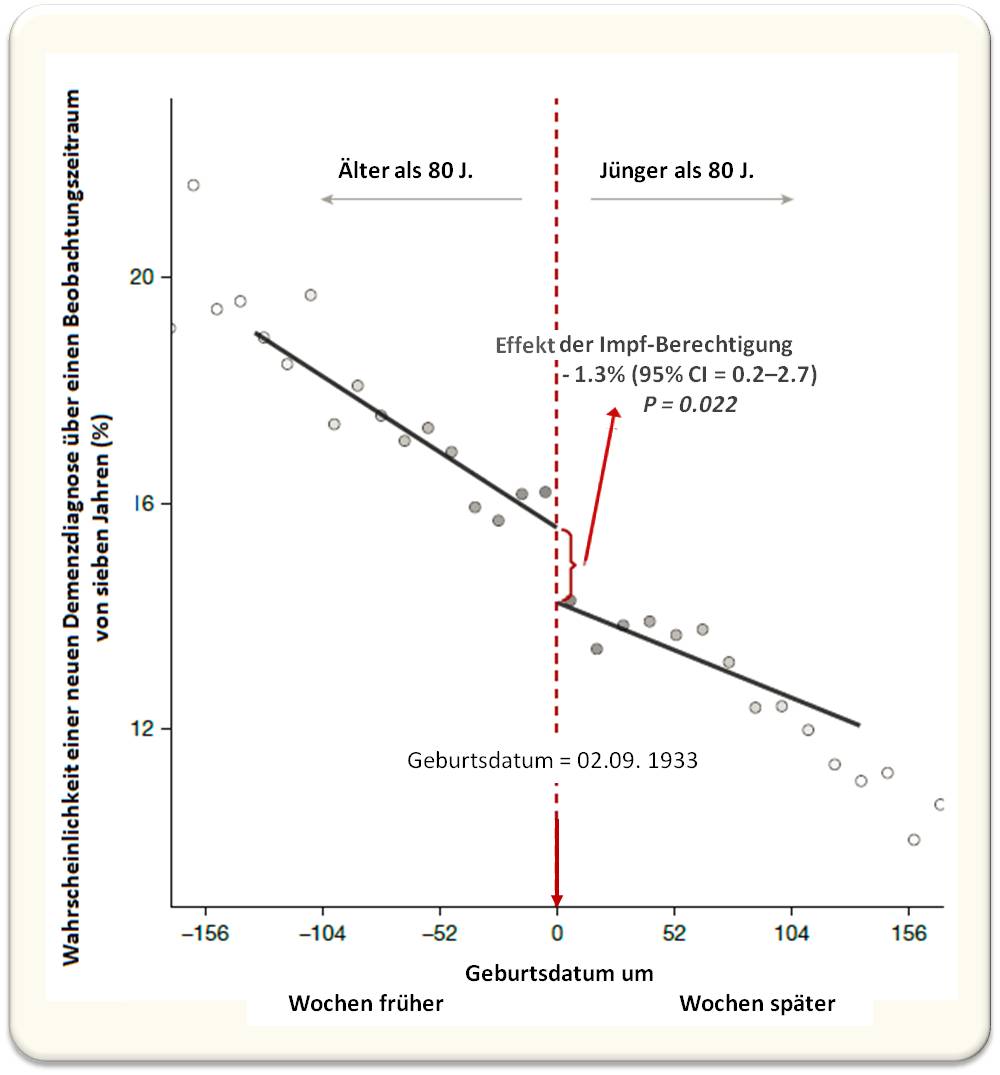

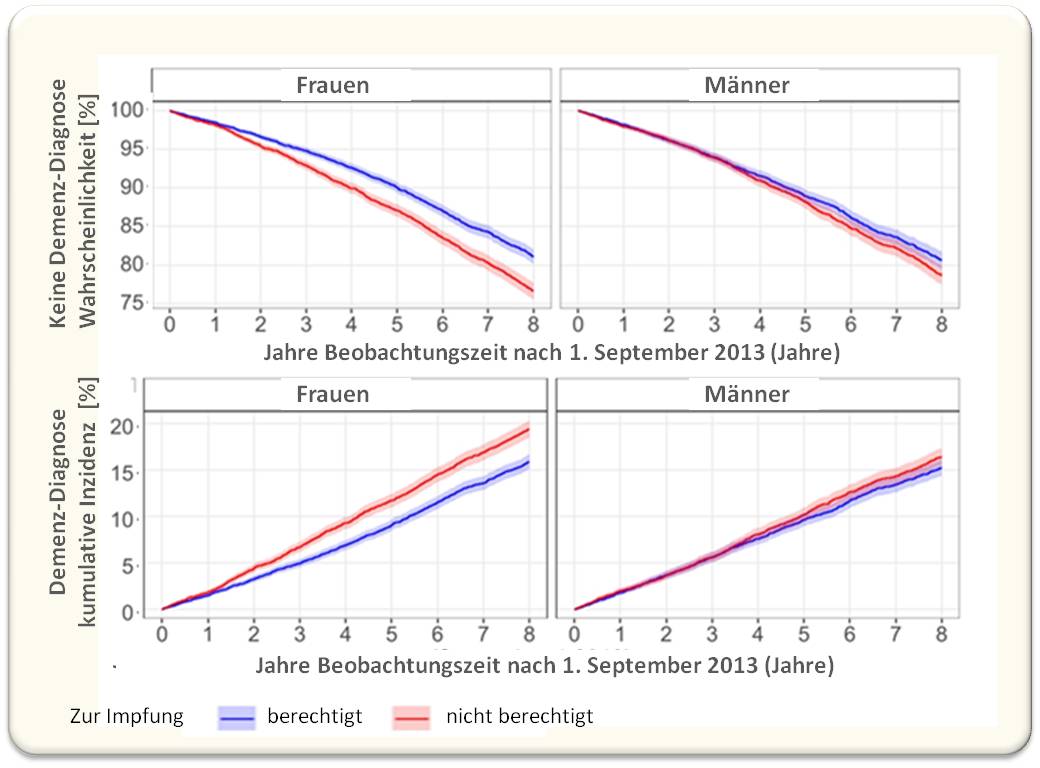

Eine 2023 veröffentlichte Studie hat den Zusammenhang zwischen Blutspiegeln von ImP, Herz-Kreislauferkrankungen und Mortalitätsrisiko von Erwachsenen untersucht (Molinaro et al., 2023). Die Studie stützte sich auf zwei große, unabhängige Kohorten - die europäische MetaCardis-Kohorte mit knapp 2000 Personen und die nordamerikanische GeneBank-Kohorte mit rund 2160 Personen -, mit verschiedenen Schweregraden von Herz-Kreislauf-Erkrankungen, einschließlich Herzinsuffizienz. Die Studie zeigte in überzeugender Weise, dass auf beiden Kontinenten, in beiden Kohorten und unabhängig von traditionellen Risikofaktoren die ImP-Spiegel mit Herz-Kreislauferkrankungen , einer reduzierten Ejektionsfraktion, erhöhten natriuretischen Peptidwerten und Herzinsuffizienz assoziiert sind. Erhöhte ImP-Spiegel Werte erwiesen sich als signifikanter unabhängiger Prädiktor für die 5-Jahres-Mortalität . Abbildung 2.

|

Abbildung 2. Das Darmmikrobiom produziert Imidazolpropionat aus Histidin. Mit steigenden ImP-Spiegeln (Quartil 1 - 4) steigt das Risiko an Herzinsuffizienz zu sterben. (Quelle: Molinaro et al., 2023, doi: 10.1016/j.jchf.2023.03.008 Lizenz cc-by.) ) |

Von Mäusen zu Menschen: Wie aber beginnt Atherosklerose ..................

Um zu verstehen, wie Atherosklerose beginnt und frühe Biomarker in noch symptomlosen Menschen zu fnden, hat ein Team um David Sancho vom Centro Nacional de Investigaciones Cardiovasculares (CNIC) in Madrid vor 15 Jahren eine Langzeitstudie an 2 Kohorten von insgesamt mehr als 2 000 scheinbar gesunden Personen, Mitarbeitern der Banco Santander, im Alter von 40 - 55 Jahren gestartet. 2D- oder 3D-Gefäßsonographie, Computertomographie ohne Kontrastmittel und Positronen-Emissions-Tomographie (PET) ermöglichten bereits sehr frühe Stadien der Atherosklerose zu detektieren und quantitative Bestimmung der Konzentrationen von ImP (und anderen Metaboliten) ließen den Zusammenhang mit der Entstehung der Atherosklerose prüfen.

Es zeigte sich, dass in beiden Kohorten hohe ImP-Spiegel mit atherosklerotischen Veränderungen korreliert waren, wobei Personen mit metabolisch aktiven Plaques (mittels PET festgestellt) höhere ImP-Spiegel hatten als solche mit inaktiven Plaques. Des Weiteren untersuchten die Forscher, wie sich unterschiedliche Diäten auf die Zusammensetzung des Mikrobioms, speziell auf ImP-produzierende Bakterien auswirken, wie ImP mit Risikofaktoren (Blutdruck, Body-Mass-Index, C-reaktives Protein, LDL-/HDL-Cholesterin) von Herz-Kreislauferkrankungen zusammenhängt.

Eingehende Studien zur Rolle von ImP in der Entstehung von Atherosklerose an Mäusemodellen unterstützten die am Menschen erzielten Ergebnisse und konnten vor allem aufklären, wie ImP auf molekularer Ebene wirken dürfte. Diese vielerorts als Durchbruch gefeierte Studie wurde kürzlich im Fachjournal Nature publiziert (Mastrangelo et al., 2025).

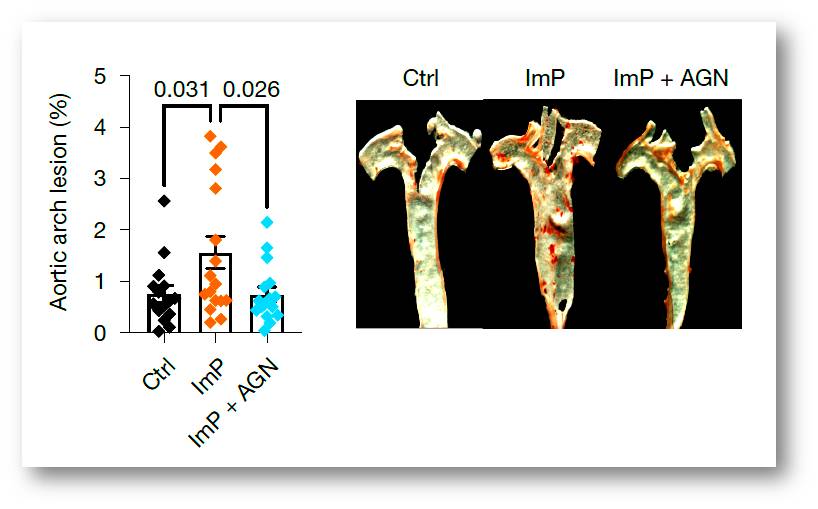

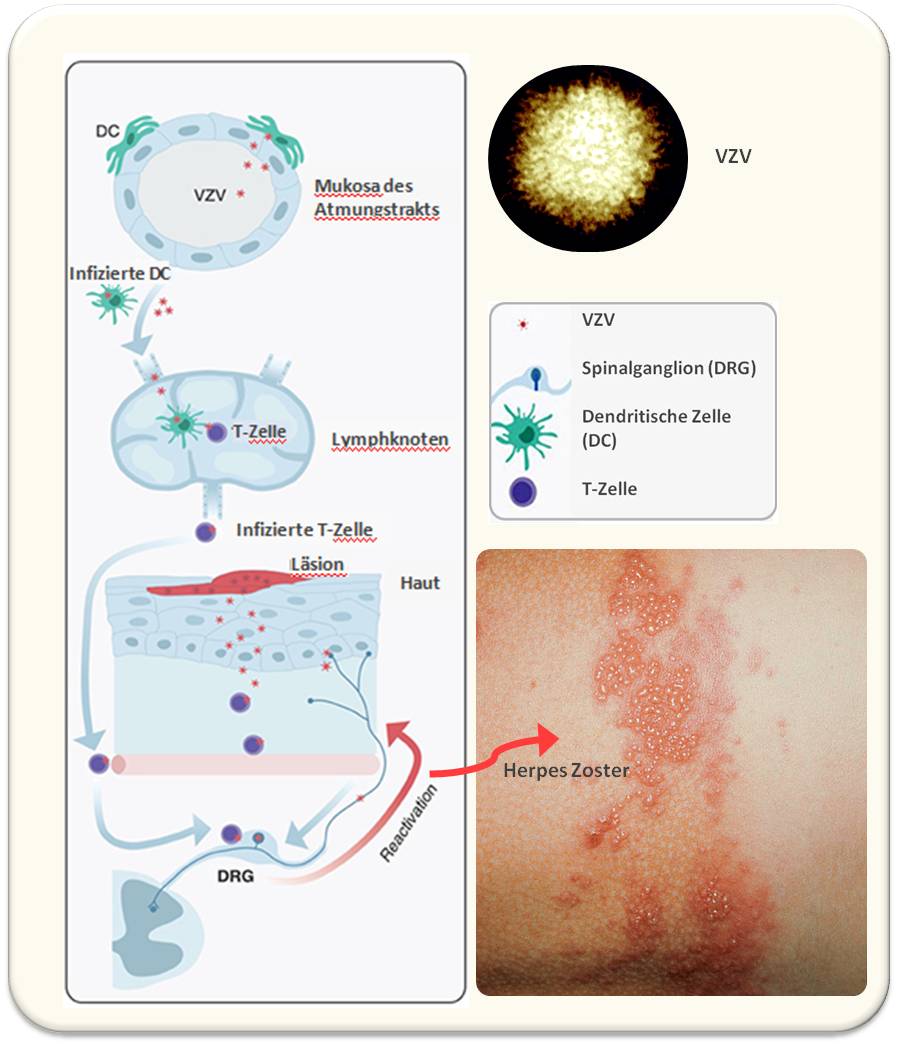

.......und welche Rolle spielt dabei ImP?

Tierversuche an etablierten Atherosklerose Modellen der Maus zeigten, dass bei ansonsten normaler Diät die Zufuhr von ImP im Trinkwasser über 8 Wochen ausreicht, um Atherosklerose in der Aorta hervorzurufen (Abbildung 3: Kontrolle (Ctrl) versus ImP), ohne dass sich das Lipidprofil, speziell der Cholesterinspiegel verändert hätte, d.i. auch bei physiologischen Cholesterin Konzentrationen entwickelten die mit ImP behandelten Tiere Atherosklerose.

Einzelzell-Sequenzierungsanalysen des Aortengewebes ergaben, dass ImP in Immunzellen und Fibroblasten Signalwege aktivierte, die darauf mit der Freisetzung von Entzündungsfaktoren antworteten. Histologische Analysen der Aorta zeigten eine erhöhte T-Zell-Infiltration in der innersten Wandschicht der Aorta und vermehrt entzündliche Makrophagen im Atherom-Plaque.

|

Abbildung 3. .Die Blutspiegel des bakteriellen Metaboliten Imidazolpropionat sind bei Stoffwechsel- und Herz-Kreislauferkrankungen erhöht. Stark vereinfachtes Schema. (Quelle: modifizierter Ausschnitt von Figure 2 in Quian Xu et al., Front. Immunol., 15:1454210. https://doi.org/10.3389/fimmu.2024.1454210; Lizenz: cc-by.) |

Die Vermutung der Forscher, dass ImP mit seinem Imidazolrest an einen in Zellmembranen lokalisierten Imidazolinrezeptor (IR) binden und damit das Entzündungssignal auslösen könnte, bestätigte sich: Wurde einerseits ein vom Team entwickelter hochpotenter Antagonist (AGN192403) des Imidazolin-1-rezeptors (I1R) gleichzeitig mit ImP verabreicht (Abbildung 3: ImP versus AGN), oder die Expression von I1R verhindert (in I1R-knockout Tieren), so wurde auch das Entzündungssignal blockiert und die Atherogenese verhindert. Die Blockierung der I1R-ImP-Achse hemmte auch die durch hohes Cholesterin induzierte Entstehung von Atherosklerose.

Fazit

Die CNIC-Studie zeigt, dass bereits im Frühstadium der Atherosklerose, bei symptomfreien Personen die ImP-Blutspiegel erhöht und mit dem Fortschreiten der Veränderungen eng korreliert sind. Im Tiermodell wurde I1R als Rezeptor für ImP identifiziert. ImP löst über den I1R Entzündungssignale in Immunzellen aus, die zu deren Infiltration in der Aortawand und Ansammlung in abgelagerten Plaques führen. Die Bestimmung von ImP könnte somit ein früher Indikator für das Erkrankungs-Risiko sein, ImP selbst und sein Rezeptor ein vielversprechendes neues Target für therapeutische Maßnahmen darstellen.

Dass die ImP induzierte Atherosklerose auch bei Tieren mit niedrigem Cholesterinspiegel erfolgt, lässt an dem Paradigma von Cholesterin als Hauptschuldigem für die Entstehung der Atherosklerose zweifeln.

Koh A., et al., Microbially Produced Imidazole Propionate Impairs Insulin Signaling through mTORC1. Cell (2018) 175, 4, 947 - 961.e1. DOI: 10.1016/j.cell.2018.09.055

Molinaro A. et al. Microbially produced imidazole propionate is associated with heart failure and mortality. JACC Heart Fail. (2023) 11:810–21. doi: 10.1016/j.jchf.2023.03.008

Mastrangelo, A. et al. Imidazole propionate is a driver and therapeutic target in atherosclerosis. Nature https://doi.org/10.1038/s41586-025-09263-w

Atherosklerose im ScienceBlog

Georg Wick, 09.08.2013:Atherosklerose, eine Autoimmunerkrankung: Auslöser und Gegenstrategien.

Auf dem Weg zu einem antiviralen Breitband-Wirkstoff

Auf dem Weg zu einem antiviralen Breitband-WirkstoffFr.21.11.2025 — Redaktion

![]() Virale Pandemien sind eine Bedrohung für die globale Gesundheit. Anders als bei bakteriellen Infektionen fehlen Breitband-Wirkstoffe, die ein schnelles Reagieren auf neu auftretende, gefährliche Viren ermöglichen würden. Proteine auf der Virusoberfläche sind als Zielstrukturen für die Entwicklung von Breitband-antiviralen Stoffen ungeeignet, da sie zu unterschiedlich sind und sich überdies zu schnell verändern. Eine neue Studie zeigt eine andere Strategie: Kleine synthetische Moleküle (SCRs), die an Kohlenhydrate auf Virusoberflächen binden, konnten Infektionen von Epithelzellen durch unterschiedliche Arten von Hochrisiko-Viren blockieren. Die Wirksamkeit derartiger Verbindungen konnte in vivo an einem Tiermodell bestätigt werden. Diese Ergebnisse lassen es möglich erscheinen, ein antivirales Breitbandmedikament zur Bekämpfung schwerer Virusinfektionen zu entwickeln.*

Virale Pandemien sind eine Bedrohung für die globale Gesundheit. Anders als bei bakteriellen Infektionen fehlen Breitband-Wirkstoffe, die ein schnelles Reagieren auf neu auftretende, gefährliche Viren ermöglichen würden. Proteine auf der Virusoberfläche sind als Zielstrukturen für die Entwicklung von Breitband-antiviralen Stoffen ungeeignet, da sie zu unterschiedlich sind und sich überdies zu schnell verändern. Eine neue Studie zeigt eine andere Strategie: Kleine synthetische Moleküle (SCRs), die an Kohlenhydrate auf Virusoberflächen binden, konnten Infektionen von Epithelzellen durch unterschiedliche Arten von Hochrisiko-Viren blockieren. Die Wirksamkeit derartiger Verbindungen konnte in vivo an einem Tiermodell bestätigt werden. Diese Ergebnisse lassen es möglich erscheinen, ein antivirales Breitbandmedikament zur Bekämpfung schwerer Virusinfektionen zu entwickeln.*

Breitbandantibiotika sind in der Lage ein weites Spektrum von Bakterien zu bekämpfen, die Infektionen in verschiedenen Körperregionen verursachen. Die Verbindungen wirken, indem sie essentielle Zielstrukturen angreifen, die vielen verschiedenen infektiösen Bakterien gemeinsam sind. Bislang gibt es jedoch keinen vergleichbaren, für die Anwendung am Menschen zugelassenen Breitband-Wirkstoff gegen Viren.

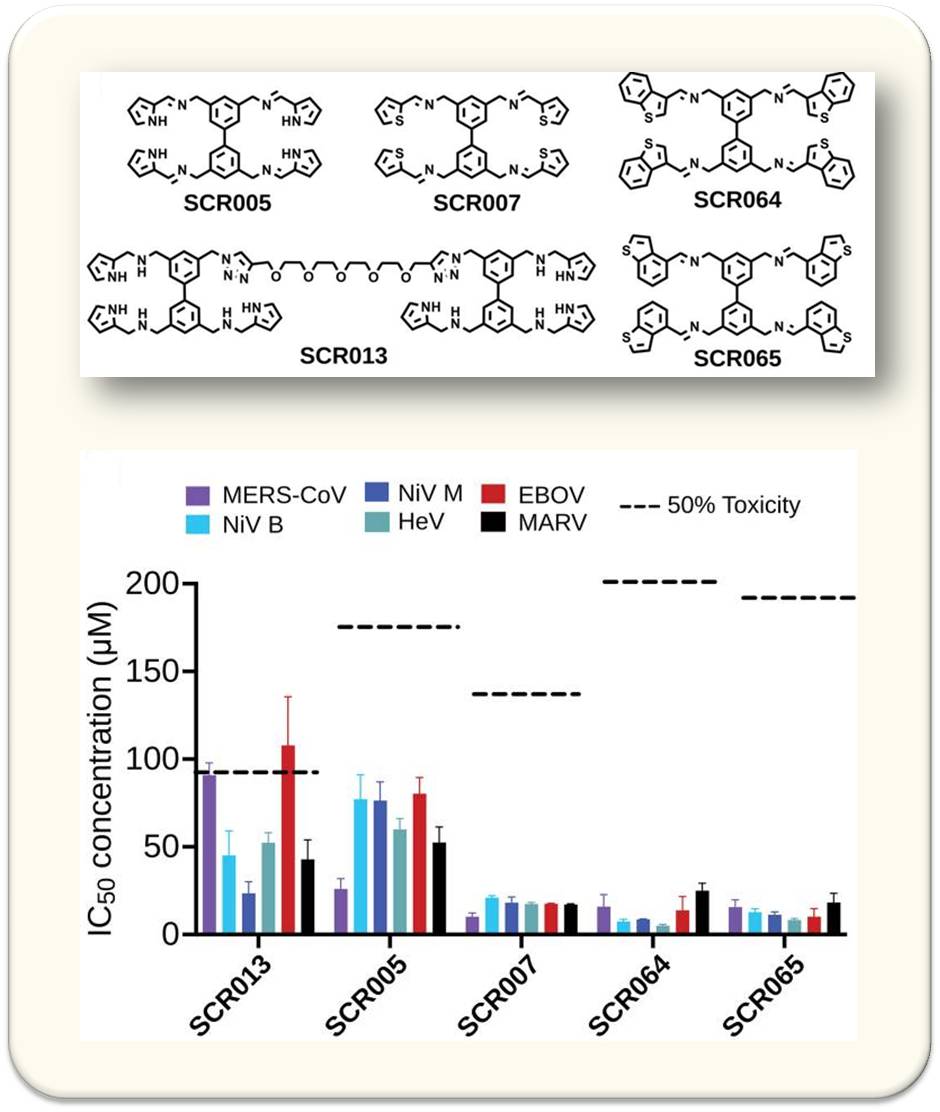

| Abbildung 1: SRCs können das Eindringen unterschiedlicher Viren (SARS-CoV-2, SARS-CoV-1, MERS-CoV, Nipah-, Hendra-, Ebola- und Marburg-Viren) in Zellkulturen blockieren. Oben: Chemische Strukturen von SCRs mit breitem antiviralen Wirkungsspektrum, SRC013 ist als inaktive Kontrollverbindung angeführt. Unten: Infektionswerte (IC50) und Toxizität in Epithelzellen (Vero E-6), die mit SCRs (10 µM) vorbehandelt und dann mit Pseudoviren infiziert wurden. (Bild von der Redaktion modifiziert eingefügt aus: Ezzatpour S., et al.,2025, DOI: 10.1126/sciadv.ady3554; Lizenz cc-by-nc.) |

Dass es so schwierig ist ein antivirales Breitbandmedikament zu entwickeln, liegt darin begründet, dass die auf der Oberfläche von Viren lokalisierten Proteine sehr unterschiedlich sind, sich überdies zumeist rasch verändern und daher als Zielstrukturen für breit wirkende antivirale Stoffe nicht geeignet sind. Daher sind die derzeitigen antiviralen Arzneimittel nur eingeschränkt wirksam und lediglich gegen wenige, sehr spezifische Virusinfektionen von Nutzen.

In einer neuen Studie haben Forscher unter der Leitung von Adam Braunschweig von der City University of New York und Hector Aguilar-Carreno von der University of California, Los Angeles, die Idee von der Entwicklung eines Breitband-Antivirenmittels experimentell untersucht. Ihr Fokus lag dabei auf kleinen synthetischen Molekülen, sogenannten Kohlenhydratrezeptoren (SCRs), die Kohlenhydrate binden. Viele Viren, darunter auch solche, die schwere Erkrankungen und zukünftige Pandemien auslösen können, tragen Kohlenhydrate, sogenannte Glykane, auf ihrer Oberfläche.

Bereits frühere Studien hatten darauf hingewiesen, dass SCRs Kohlenhydrate auf bestimmten Viren binden können. Sie könnten daher als aussichtsreiche antivirale Medikamente betrachtet werden.

Die Ergebnisse der neuen Studie wurden am 27. August 2025 in Science Advances veröffentlicht [Ezzatpour S, et al., 2025].

Untersuchungen an Zellkulturen

Um zu prüfen, ob derartige Substanzen gegen ein breiteres Spektrum von Viren wirken könnten, haben die Forscher ein Set von 57 verschiedenen SCRs gegen sechs Hochrisiko-Viren aus drei verschiedenen Virusfamilien geprüft. Dazu gehörten SARS-CoV-1 und -2, MERS-CoV, Nipah-, Hendra- und Ebola-Viren. Abbildung 1.

Dabei stellten die Forscher fest, dass mehrere der SCRs das untersuchte Zellmodell vor einer Infektion mit allen sechs Virenarten schützten. Vier der SCRs erwiesen sich als besonders vielversprechend für die Verhinderung aller getesteten Virusinfektionen.

| Abbildung 2: SCR005 und SCR007 verringern die Morbidität und Mortalität im hACE2-Mausmodell der SARS-CoV-2-Infektion bei minimaler Toxizität. Oben: Die Versuchsführung. Mäuse (n = 8 -10 pro Behandlungsgruppe) wurden nach Infektion mit SCRs behandelt und die Gewichtsänderung, Überlebenswahrscheinlichkeit und Virenbelastung in Lungen-und Hirngewebe im Vergleich zur Kontrollgruppe bestimmt. 2. Reihe: Gewichtsänderung. 3.Reihe: Überlebenswahrscheinlichkeit. Ganz unten: Viruslast in Lunge und Hirn nach 14 Tagen. (Bild von der Redaktion modifiziert und eingefügt aus: Ezzatpour S., et al.,2025, DOI: 10.1126/sciadv.ady3554; Lizenz cc-by-nc.) |

Untersuchungen am Tiermodell

Auf der Grundlage der an Zellkulturen erzielten Ergebnisse wurden zwei SCRs, SCR005 und SCR007, für in-vivo-Untersuchungen an einem schweren humanisierten ACE2 (hACE2)-Mäusemodell der SARS-CoV-2-Erkrankung ausgewählt.

Intranasal verabreicht boten die Verbindungen Schutz vor der SARS-CoV-2-Infektion. Mit einem der SCRs - SCR007 - überlebten etwa 90 % der behandelten Mäuse mindestens zwei Wochen, im Vergleich zu keinem einzigen Tier in der Kontrollgruppe.

Die antivirale Substanz wirkte bereits nach einer einzigen Dosis und, was besonders wichtig ist, bei den antiviral wirksamen Konzentrationen ohne jegliche Anzeichen von Toxizität. Abbildung 2.

| Abbildung 3: Wirkungsmechanismus von SRCs, Schematische Darstellung. Durch ihre Bindung an die Glykane von viralen Glykoproteinen, blockieren SRCs deren Bindung an Rezeptoren der Wirtszelle und in Folge die Fusion des Virus mit der Zelle. (Bild von der Redaktion modifiziert und eingefügt aus: Ezzatpour S., et al.,2025, DOI: 10.1126/sciadv.ady3554; Lizenz cc-by-nc.) |

Untersuchungen zum Wirkungsmechanismus

Das Team untersuchte dann mit einem Set aussagekräftiger Methoden den Mechanismus der antiviralen Aktivität.

Die Ergebnisse bestätigten die Annahme, dass SCRs den Lebenszyklus der Viren hemmen, indem sie an die Glykane auf den Glykoproteinen der Virushülle binden. Dies verhindert das Andocken des Virus an Rezeptoren der Wirtszelle und damit die Membranfusion und den Eintritt des Virus in die Zelle. Abbildung 3 zeigt eine vereinfachte schematische Darstellung.

Fazit

Die Ergebnisse legen nahe, dass es möglich ist Breitband-Antivirenmittel zu entwickeln, indem man virale Glykane anstelle von Proteinen als Zielstrukturen angreift. Solche Medikamente könnten nicht nur Infektionen mit bereits existierenden Viren behandeln, sondern auch zur Prävention von Infektionen mit neu auftretenden Viren eingesetzt werden.

Die Forscher planen nun, die Sicherheit und Wirksamkeit von SCRs bei der Prävention von Virusinfektionen und deren Übertragung auf Tiere und Menschen zu prüfen.

„Das ist genau die Art von antiviralem Mittel, die die Welt dringend braucht“, sagt Braunschweig. „Wenn morgen ein neues Virus auftaucht, haben wir derzeit nichts, was wir einsetzen könnten. Diese Verbindungen bieten das Potenzial, eine solche erste Verteidigungslinie zu bilden.“

----------------------------------------------------------------------------------

Ezzatpour S, et al., Broad-spectrum synthetic carbohydrate receptors (SCRs) inhibit viral entry across multiple virus families. Science Advances. 2025 Aug 29;11(35):eady3554. DOI: 10.1126/sciadv.ady3554 Epub 2025 Aug 27. PMID: 40864723.

*Der von Kendall K. Morgan stammende, am 9. September 2025 auf der NIH-Webseite "NIH Research Matters" erschienene Artikel "Progress toward a broad-spectrum antiviral" (https://www.nih.gov/news-events/nih-research-matters/progress-toward-broad-spectrum-antiviral) wurde von der Redaktion übersetzt und durch Untertitel und 3 Abbildungen aus der zitierten Originalarbeit (Ezzatpour S, et al. 2025) ergänzt. Artikel auf der NIH-Webseite sind generell gemeinfrei.

Die Entdeckung ferner Welten: Exoplaneten

Die Entdeckung ferner Welten: ExoplanetenFr. 14.11.2025 — Helmut Hornung

In der Atmosphäre einer tiefblauen Welt regnet es gefährliche Glassplitter, eine andere hat die Konsistenz von Zuckerwatte, eine dritte besteht zum großen Teil aus Diamant. Alle diese seltsamen Orte mit so komplizierten Namen wie HD 189733b, WASP-193b und 55 Cancri sind nicht irgendwelchen Science-Fiction-Filmen entsprungen, sondern sie existieren in den Weiten des Weltalls tatsächlich: Es handelt sich um Exoplaneten, die fremde Sterne umlaufen. Wie aber können Forschende solche Himmelskörper untersuchen? Wie lassen sie sich überhaupt aufspüren? Gibt es womöglich eine zweite Erde? Und was hat das James-Webb-Teleskop damit zu tun?*

Anfang Oktober 1995 brach in Florenz eine neue Ära der Astronomie an. Michel Mayor und Didier Queloz von der Universität Genf hielten auf einem Kongress in der toskanischen Stadt einen bemerkenswerten Vortrag. Darin präsentierten sie nichts weniger als die Entdeckung eines Planeten außerhalb unseres Sonnensystems. Ihre Ergebnisse hatten sie ein Jahr zuvor am Observatorium Haute-Provence in Frankreich gewonnen. Im Fokus des dortigen Teleskops mit 1,93 Metern Spiegeldurchmesser stand ein unscheinbares, mit bloßem Auge gerade noch sichtbares Lichtpünktchen in der Konstellation Pegasus: der 50 Lichtjahre von der Erde entfernte, sonnenähnliche Stern 51 Pegasi. Für die Messungen nutzten die beiden Forscher einen am Teleskop montierten Spektrografen, der das Licht kosmischer Objekte in die Spektralfarben aufspaltet.

Im Spektrum eines Sterns finden sich viele dunkle Linien. Sie entstehen, wenn die Strahlung aus tiefer gelegenen, heißen Gasschichten durch kühlere geht. Dann schlucken die Elemente im Gas der kühleren Schichten das Licht bei bestimmten Wellenlängen und prägen dem Spektrum ihre Absorptionslinien auf. Anhand derer lässt sich die chemische Zusammensetzung eines Sterns bestimmen, denn jedes Element erzeugt einen charakteristischen Strichcode. Zudem können die Forschenden aus einem Spektrum auch Parameter wie Temperatur, Dichte oder die Dynamik des Gases herauslesen. Mayor und Queloz interessierten sich jedoch für die Bewegungen von Sternen, die Radialgeschwindigkeiten. Mayors Doktorand Didier Queloz hatte ein Computerprogramm geschrieben, das die gewonnenen Daten innerhalb kürzester Zeit verarbeitete. Aber welche Daten waren das?

Wenn Sterne tanzen

Wird ein Stern von einem Planeten umlaufen, wandern streng genommen beide Himmelskörper um den gemeinsamen Schwerpunkt. Dabei „zerrt“ der Planet aufgrund der gemeinsamen gravitativen Wechselwirkung rhythmisch am Stern. Blickt man seitlich auf das System, macht sich dessen Wackeln als Geschwindigkeitskomponente auf die Erde zu oder von ihr weg bemerkbar. Diese Radialgeschwindigkeit lässt sich anhand des Dopplereffekts messen. Den kennt jeder aus dem Alltag: Stehen wir auf einem Autobahnparkplatz, dann ändert sich die Tonhöhe eines schnell vorbeifahrenden Autos. Kommt das Fahrzeug auf uns zu, nehmen wir die Schallwellen als gestaucht wahr, unsere Ohren registrieren einen höheren Ton. Ist das Auto vorbeigeschossen, erscheinen uns die Schallwellen als gedehnt, der Ton klingt tiefer. Analog dazu zeigt das Licht eines Sterns, der sich uns nähert, wegen der kürzeren Wellenlänge eine Blauverschiebung; entfernt er sich von uns, erscheint das Licht aufgrund der längeren Wellenlänge rotverschoben (Abbildung 1).

| Abbildung 1: Radialgeschwindigkeitsmethode. Der Planet „zerrt“ an seinem Mutterstern. Dadurch bewegt sich dieser um den gemeinsamen Schwerpunkt des Systems. Sein Licht erscheint abwechselnd blau- und rotverschoben. Die Radialgeschwindigkeitsmethode misst diesen Dopplereffekt. © Verändert nach European Southern Observatory // CC BY 4.0 |

Was sich in der Theorie einfach anhört, ist in der Praxis umso schwerer. Denn die „Tanzschritte“ eines Sterns, die ein Planet hervorruft, sind im astronomischen Maßstab klein und laufen recht langsam ab. Doch die beiden Schweizer Wissenschaftler hatten die Präzision ihres Spektrografen derart ausgereizt, dass sie bei dem Stern 51 Pegasi eine Radialgeschwindigkeit von lediglich wenigen Dutzend Metern pro Sekunde registrieren konnten. Trotzdem bewegten sich die Daten an der Grenze des Messbaren. Dies führte dazu, dass manche Tagungsteilnehmer in Florenz mit Skepsis reagierten. Doch bereits eine Woche später bestätigte ein US-amerikanisches Forschungsteam, das in Konkurrenz zu Mayor und Queloz stand, deren Ergebnisse: Der erste „echte“ Exoplanet war gefunden!

Tatsächlich hatten der polnische Astronom Aleksander Wolszczan und sein kanadischer Kollege Dale Frail bereits im Jahr 1992 die ersten beiden Planeten außerhalb des Sonnensystems aufgespürt. Doch diese Himmelskörper umkreisen nicht eine ferne Sonne, sondern den Pulsar PSR B1257+12 im Sternbild Jungfrau. Pulsare sind die Kerne von explodierten, sehr massereichen Sternen. Diese Neutronensterne besitzen Durchmesser von nur rund 20 Kilometern und bestehen, wie ihr Name verrät, vor allem aus Neutronen. Ein solcher stellarer „Zombie“ rotiert rasend schnell – PSR B1257+12 dreht sich 161-mal pro Sekunde um seine Achse – und sendet dabei über seine Pole gebündelte Strahlenkegel ins All, ähnlich einem Leuchtturm am Meer. Überstreichen sie die Erde, empfangen wir kurze, zeitlich begrenzte Pulse, daher die Bezeichnung Pulsar.

Ein Heißer Jupiter geht ins Netz

Der Stern 51 Pegasi trägt mittlerweile den Namen Helvetios. Sein Planet heißt Dimidium, was im Lateinischen so viel wie „Hälfte“ bedeutet, weil er knapp eine halbe Jupitermasse (0,46) aufweist. Er umläuft seinen Mutterstern in rund 4,2 Tagen im Abstand von ungefähr sieben Millionen Kilometern und ist ein Gasplanet mit einer Oberflächentemperatur von um die 1000 Grad Celsius. Dimidium war der erste Exoplanet vom Typ „Heißer Jupiter“, der gefunden wurde. Für ihre bahnbrechende Entdeckung erhielten Michel Mayor und Didier Queloz im Jahr 2019 den Nobelpreis für Physik. Zugleich eröffneten die beiden ein neues Forschungsfeld, das zu den spannendsten der modernen Astronomie gehört.

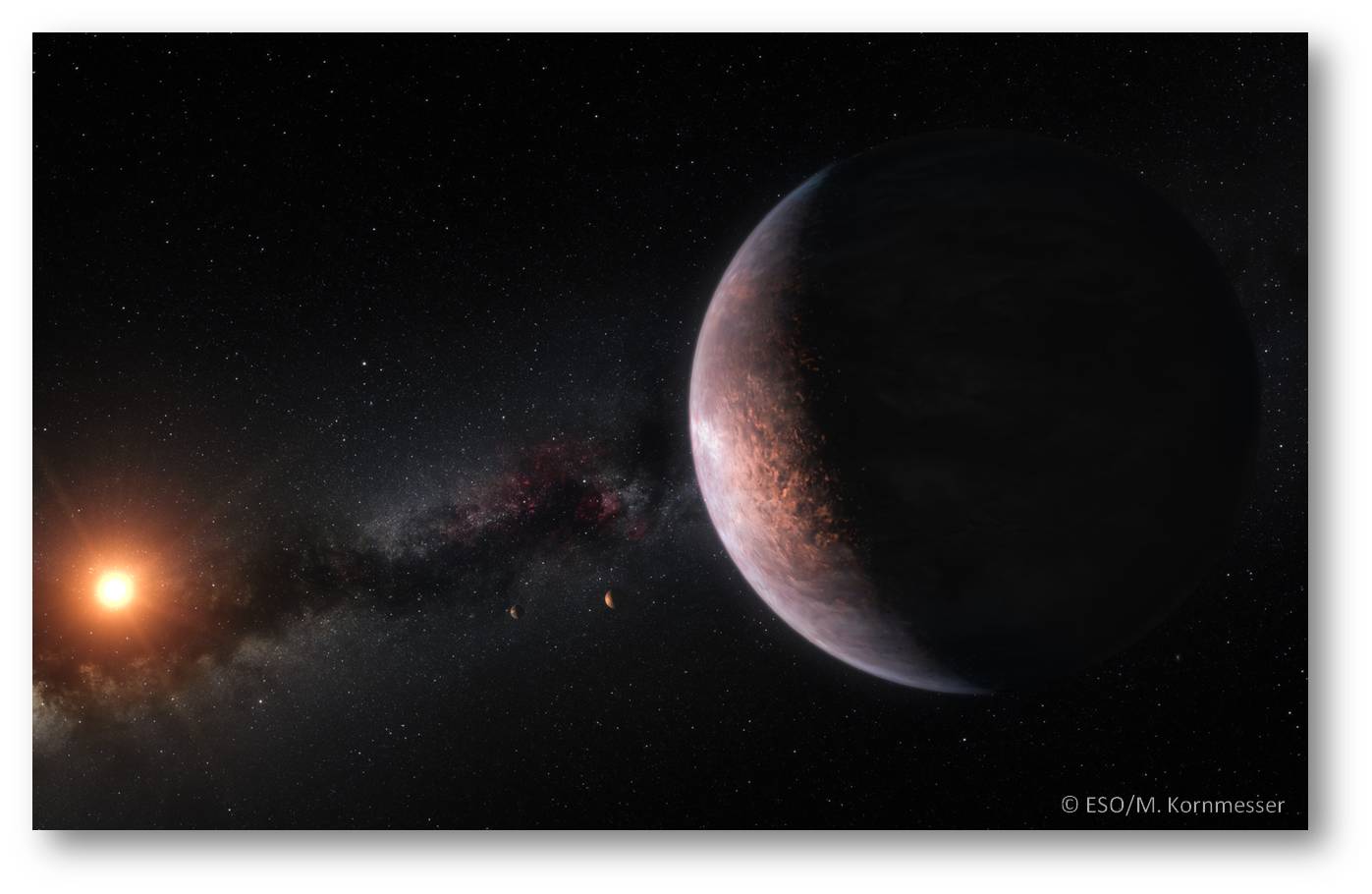

Bis zum Sommer 2025 waren laut dem NASA Exoplanet Archive rund 6000 Planeten bei fremden Sternen bekannt. Etwa 1000 befinden sich in Systemen mit mehreren Planeten. So etwa kreisen um den rund 40 Lichtjahre entfernten Stern Trappist-1 gleich sieben erdgroße Himmelskörper (s. Bild oben) . Viele Exoplaneten wurden mit der beschriebenen Methode der Radialgeschwindigkeitsmessung gefunden, einige auch mit anderen Verfahren wie dem sogenannten Mikrolinseneffekt. Dieser beruht darauf, dass nach der Allgemeinen Relativitätstheorie von Albert Einstein große Massen die Raumzeit verzerren und das Licht ablenken. Das wurde erstmals bei der totalen Sonnenfinsternis am 29. Mai 1919 beobachtet. Der Effekt tritt auch auf, wenn ein Stern mit einem Exoplaneten zwischen der Erde und einem fernen Hintergrundstern steht. Dann wird das Licht des Hintergrundsterns aufgrund der Gravitation des Planetensystems wie durch eine Linse gebündelt, und der Hintergrundstern erscheint für eine gewisse Zeit heller. Dadurch zeigt sich in der aufgezeichneten Lichtkurve eine zweite kleinere Spitze für den Exoplaneten. Allerdings muss dabei die Geometrie stimmen, das heißt, Beobachter, Planetensystem und Hintergrundstern müssen mehr oder weniger auf einer Linie stehen. Das ist selten der Fall, bisher wurden 260 Exoplaneten damit aufgespürt.

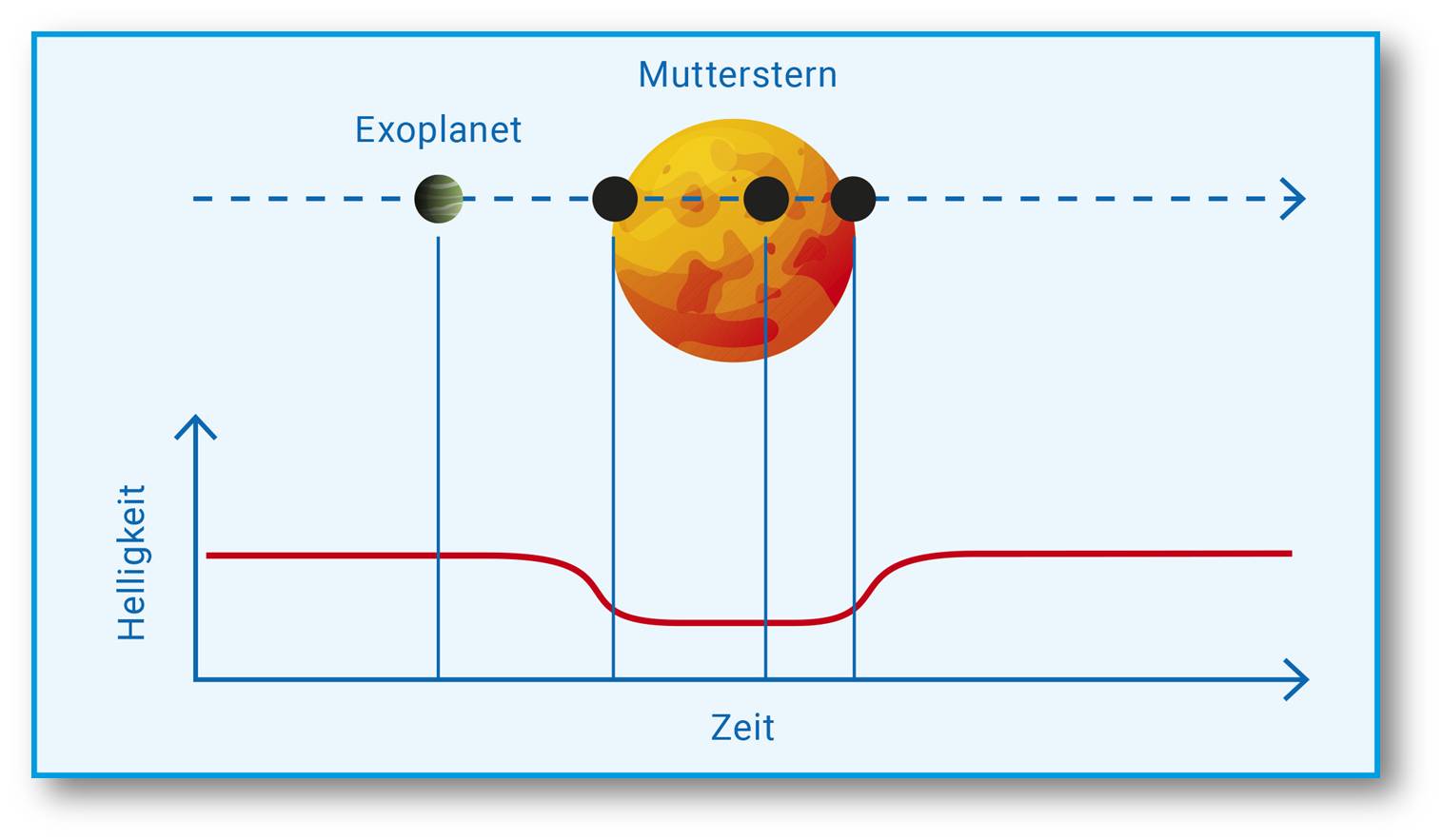

| Abbildung 2: Transitmethode. Läuft der Planet vor seinem Mutterstern vorüber, spiegelt sich das im regelmäßigen Abfall und Anstieg der Helligkeitskurve. © Verändert nach NASA Ames // Public Domain ) |

Einen ungleich größeren Teil fanden die Forschenden mit der Transitmethode (Abbildung 2) . Dabei wird direkt gemessen, wie sich die Helligkeit eines Sterns ändert, wenn ein dunklerer Begleiter vor ihm vorüberzieht. Das funktioniert nur, wenn der irdische Beobachter von der Seite auf die Umlaufbahn blickt. Im Grunde passiert dasselbe wie bei einer Sonnenfinsternis, wenn der Neumond über die Scheibe der Sonne wandert. Dabei ist die Lichtschwächung allerdings beträchtlich, weil Sonne und Mond von uns aus gesehen ähnlich groß am Himmel erscheinen und der Mond die Sonne im Idealfall vollständig abdeckt. Doch viele Lichtjahre von der Erde entfernte Exoplaneten sind winzig im Vergleich zu ihrem Mutterstern und reduzieren bei ihrem Durchgang dessen Licht nur wenig, erdgroße Planeten etwa im Promillebereich. Daher stoßen selbst Fotometer, welche die Intensität und den Helligkeitsverlauf von Sternenlicht messen, bei der Suche nach Exoplaneten an ihre Leistungsgrenze. Trotzdem waren und sind entsprechend ausgerüstete Satellitenobservatorien sehr erfolgreich. Allein das Weltraumteleskop Kepler hat während seiner Betriebszeit von 2009 bis 2018 rund 190.000 Sterne mit der Transitmethode untersucht und dabei mehr als 2500 bestätigte Planeten sowie Tausende Planetenkandidaten aufgespürt. Aktuell sucht sein Nachfolger TESS (Transiting Exoplanet Survey Satellite) ebenfalls mit der Transitmethode nach fernen Welten.

Die Vermessung des Unbekannten

Ende des Jahres 2026 soll PLATO (PLAnetary Transits and Oscillation of stars) starten. Der europäische Satellit trägt 26 Kameras und wird in ausgewählten Himmelsfeldern die Helligkeitsabfälle von Sternen aufzeichnen, die Exoplaneten beim Transit verursachen. Zusammen mit Folgebeobachtungen von Teleskopen auf der Erde können dabei grundlegende Eigenschaften der Sterne und ihrer Planeten wie Radius, Masse und Alter exakt bestimmt werden. „Genaue Sternparameter sind unerlässlich für die korrekte Interpretation von Planetentransits, die Charakterisierung von Exoplaneten und das Verständnis der Architektur von Planetensystemen. So können wir bestimmen, welche Planeten bewohnbare, also lebensfreundliche Welten sind“, sagt Laurent Gizon, Direktor am Göttinger Max-Planck-Institut für Sonnensystemforschung. Sein Institut wird das Datenzentrum der Mission betreiben.

Längst sind die Zeiten vorbei, da man einfach nur neue Planeten entdecken wollte. Heute möchten Forschende die fernen Welten auch klassifizieren – wie Luis Thomas, Wissenschaftler in der Gruppe von Ralf Bender am Garchinger Max-Planck-Institut für extraterrestrische Physik. Obwohl die Bestimmung der Radialgeschwindigkeit schon länger als drei Jahrzehnte eingesetzt wird, leistet sie noch immer wertvolle Beiträge. Auch Thomas arbeitet damit. Er nutzt einen Spektrografen am Zwei-Meter-Teleskop der Universitätssternwarte München auf dem Gipfel des Wendelsteins in den bayerischen Alpen. „Mit dem Transitverfahren lassen sich zwar sehr viele Sterne gleichzeitig beobachten, aber es liefert nur den Radius eines Exoplaneten“, sagt der Forscher. Die Radialgeschwindigkeit hingegen erlaubt es, die Masse zu bestimmen. Beide Methoden ergänzen sich. „Und aus Masse und Radius können wir auf die Dichte des Planeten schließen“, so Luis Thomas. Die Parameter Dichte, Größe und Masse dienen der Beschreibung eines Exoplaneten. Tatsächlich unterscheiden die Forschenden mehrere Typen (s. Box). Hervorheben möchte Thomas die Subneptune: „Solche Objekte kennen wir in unserem Sonnensystem nicht, daher sind sie besonders interessant“, sagt er.

Die allermeisten der bisher bekannten Exoplaneten haben die Forschenden mit trickreichen Methoden indirekt nachgewiesen. Direkt beobachtet haben sie bisher lediglich wenige Dutzend. Das liegt daran, dass die Planeten nicht selbst leuchten und von ihren Muttersonnen überstrahlt werden wie ein Staubkörnchen von einer hellen Glühlampe. Das Weltraumteleskop James-Webb hat im Jahr 2024 seinen ersten Exoplaneten abgebildet – einen „Super-Jupiter“ bei dem zwölf Lichtjahre entfernten Stern Epsilon Indi. Gelungen war diese Entdeckung einem Team um Elisabeth Matthews vom Max-Planck-Institut für Astronomie in Heidelberg. Die Forschenden hatten das Bild mit einer Kamera aufgenommen, die den Stern mithilfe einer lichtundurchlässigen Maske bedeckte, auf diese Weise dessen Licht abschattete und somit gleichsam eine künstliche „Sternenfinsternis“ erzeugte. Derartige Aufnahmen haben noch Seltenheitswert.

Nicht so sehr um die bildliche Darstellung, sondern vielmehr um minutiöse Messungen geht es der Gruppe von Laura Kreidberg am Heidelberger Institut. Sie nutzt dazu ebenfalls das James-Webb-Teleskop, das seit dem Jahr 2022 mit seinem Sechs-Meter-Spiegel das All durchmustert. Damit gewinnt sie Transmissionsspektren (Abbildung 3) der Atmosphären von Exoplaneten, wie etwa von heißen Gasriesen. Diese Methode funktioniert folgendermaßen: Zieht ein Planet vor seinem Mutterstern vorbei, fällt dessen Licht durch die mehr oder weniger dünne Atmosphäre des Planeten. Die darin enthaltenen Elemente und Verbindungen hinterlassen im Sternspektrum ihre Fingerabdrücke. Die Kunst besteht nun darin, diese in den Daten aufzuspüren und den Stoffen zuzuordnen.

| Abbildung 3: Transmissionsspektrum des heißen Jupiter WASP-39b. Das Diagramm zeigt die prozentuale Abschwächung des Sternlichts durch die Planetenatmosphäre in verschiedenen Wellenlängen, wenn der Planet WASP-39b vor dem Stern vorbeizieht (schwarze Punkte: Messwerte; dazugehörige Linien: Messunsicherheiten). Computerberechnungen (s. farbige Flächen) ergeben, dass vor allem Wasser, Kohlenstoffdioxid und Kohlenstoffmonoxid vorkommen. © Z. Rustamkulov et al., Nature Vol. 614, 659 (2023) // CC BY 4.0 |

Lebensspuren im Weltall

Hier setzen die Forschungen der Abteilung APEx (Atmosphärenphysik der Exoplaneten) von Laura Kreidberg an. „Die Zusammensetzung der Atmosphäre und das Klima auf einem fernen Planeten zu erforschen, stellt höchste Ansprüche an die Beobachtungstechnik, was mich sehr fasziniert“, sagt sie. Das James-Webb-Teleskop beobachtet im langwelligen, infraroten Spektralbereich und kann so zu kühleren, vielleicht sogar bewohnten Welten vordringen. Denn die Absorptionslinien in den Infrarotspektren stammen nicht nur von Atomen, sondern auch von Molekülen. Und diese können auf organischen Ursprung hinweisen. Einer der Arbeitsschwerpunkte der Wissenschaftlerin ist das Studium von Supererden und erdähnlichen Exoplaneten. Wie entsteht die Vielfalt der Planetensysteme? Wie sehen die Planeten heute aus? Wie haben sie sich im Laufe der Zeit verändert? Gibt es eine belebte Erde 2.0?