2018

2018 Redaktion Wed, 20.03.2019 - 01:05Als fossile Brennstoffe in Österreich Einzug hielten

Als fossile Brennstoffe in Österreich Einzug hieltenDo, 20.12.2018 - 11:55 — Robert Rosner

![]() Es ist erst wenige Generationen her, das man in unseren Breiten fossile Brennstoffe - Kohle und später Erdöl - zu nutzen begann. Vorerst dienten diese hauptsächlich Beleuchtungszwecken: Gaswerke versorgten die Bevölkerung mit aus Kohle destilliertem Leuchtgas, die reichen Erdölvorkommen im Kronland Galizien dienten vorwiegend der Produktion von Petroleum (Nebenprodukte wie Teer und Benzin fanden dagegen damals kaum Verwendung). Der Chemiker und Wissenschaftshistoriker Robert Rosner gibt einen Überblick über diese Entwicklung, die bereits einige Jahrzehnte später- durch den Siegeszug des elektrischen Lichts und die Erfindung des Verbrennungsmotors - eine völlige Wende erfahren sollte, sowohl in Hinblick auf das Ausmaß als auch auf die Art und Weise wie fossile Brennstoffe eingesetzt wurden.

Es ist erst wenige Generationen her, das man in unseren Breiten fossile Brennstoffe - Kohle und später Erdöl - zu nutzen begann. Vorerst dienten diese hauptsächlich Beleuchtungszwecken: Gaswerke versorgten die Bevölkerung mit aus Kohle destilliertem Leuchtgas, die reichen Erdölvorkommen im Kronland Galizien dienten vorwiegend der Produktion von Petroleum (Nebenprodukte wie Teer und Benzin fanden dagegen damals kaum Verwendung). Der Chemiker und Wissenschaftshistoriker Robert Rosner gibt einen Überblick über diese Entwicklung, die bereits einige Jahrzehnte später- durch den Siegeszug des elektrischen Lichts und die Erfindung des Verbrennungsmotors - eine völlige Wende erfahren sollte, sowohl in Hinblick auf das Ausmaß als auch auf die Art und Weise wie fossile Brennstoffe eingesetzt wurden.

Es begann mit Gaslaternen und Petroleumlampen

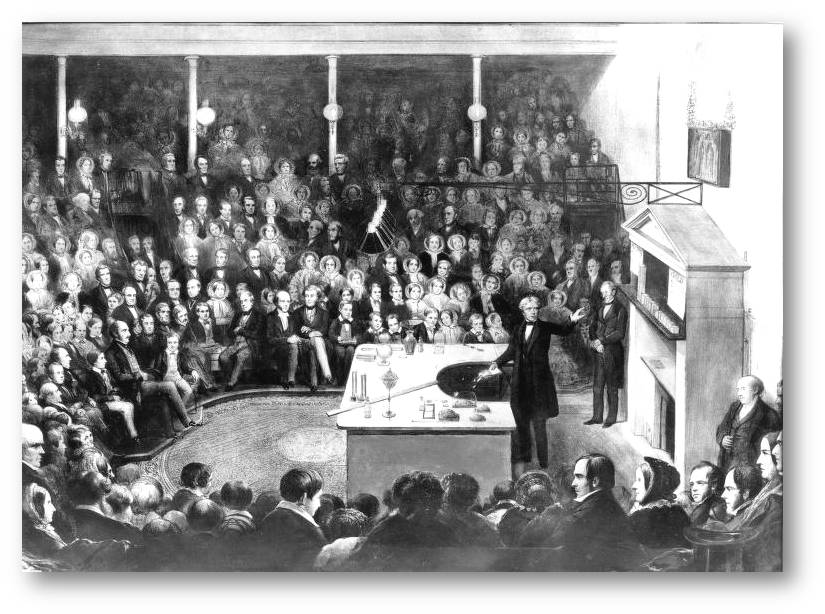

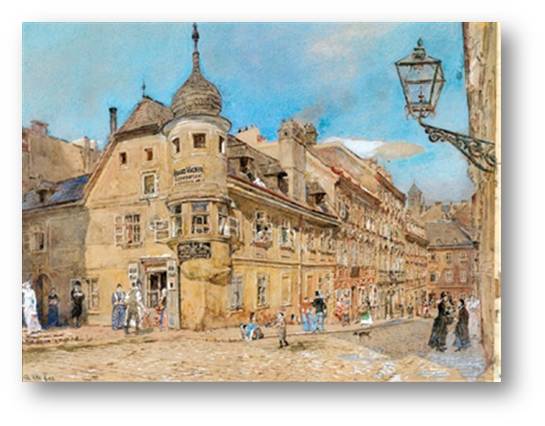

Ab der Mitte des 19.Jahrhundert begann man ganz allgemein Produkte für die Beleuchtung zu verwenden, welche erstmals fossile Brennstoffe als Ausgangsmaterial hatten. Das aus Kohle gewonnene Leuchtgas wurde anfangs vorwiegend für die städtische Beleuchtung und zur Beleuchtung großer Säle, Fabriken usw. eingesetzt und später mehr und mehr auch für die privaten Haushalte. Abbildung 1.

Abbildung 1. Laterne am Spittelberg in Wien, 1892: "Das Faßzieherhaus am Spittelberg", Aquarell von Rudolf von Alt (1812 - 1905). Das Bild ist gemeinfrei.

Abbildung 1. Laterne am Spittelberg in Wien, 1892: "Das Faßzieherhaus am Spittelberg", Aquarell von Rudolf von Alt (1812 - 1905). Das Bild ist gemeinfrei.

Bei allen früher verwendeten Lichtquellen, gleichgültig ob es sich um einen Kienspan, eine Kerze, das Öl eines Öllämpchens oder Petroleum in einer Petroleumlampe handelte, war das Leuchten auf Rußteilchen zurückzuführen, die in der Flamme erhitzt wurden. Diese Rußteilchen, die beim Verbrennen organischer Brennstoffe in der Flamme entstehen, werden bei den in der Flamme erreichten Temperaturen zur Weißglut erhitzt und strahlen sichtbares Licht aus. So dienen sie als die eigentlichen Lichtquellen. Das durch trockenen Destillation von Kohle gewonnene Erdgas enthält etwa 5 % Äthylen, das im Zuge des Verbrennungsprozesses leicht Ruß absondert - es waren also auch im Leuchtgas die Rußteilchen, die das Leuchten ermöglichten.

In Wien war die Straßenbeleuchtung in der Inneren Stadt 1845 eingeführt und 1852 auf ganz Wien ausgedehnt worden. In Folge begannen gegen Ende der 1850er Jahre die größeren Städte in der ganzen Monarchie die Straßen mit Gaslaternen zu beleuchten, zuerst in den Stadtzentren und allmählich auch in den Vorstädten und Vororten. Dann entstanden Gaswerke auch in den kleineren Städten. Linz richtete eine Gasbeleuchtung 1858 ein, Innsbruck und Salzburg 1859 und Klagenfurt 1861.

Außerhalb der Städte wurde die Beleuchtung auf Petroleumlampen umgestellt, die ein wesentlich besseres Licht gaben als die vorher verwendeten Kerzen.

Die Industrie, welche die für die Beleuchtung verwendeten Stoffe erzeugte oder die dabei entstandenen Nebenprodukte verwertete, konnte sich in dieser Zeit rasch entwickeln.

Gaswerke zur Produktion von Leuchtgas

Vor der Übernahme der Gaswerke durch die Gemeinde gab es in Wien zwei Gesellschaften, welche die Stadt mit Leuchtgas versorgten. Die größere Gesellschaft war das englische Unternehmen, die k.k. priv. Gasbeleuchtungsanstalt der Imperial-Continental-Gas Association, die mehrere Gaswerke betrieb. Im Jahr 1881 lieferten die Gaswerke dieses Unternehmens 52,8 Millionen Kubikmeter Gas, von denen 5,4 Millionen Kubikmeter für die Straßenbeleuchtung verwendet wurden. In den darauffolgenden Jahren weigerte sich die Firma ihre Produktionszahlen zu veröffentlichen.

Das andere Unternehmen in Wien war die Wiener Gasindustrie Gesellschaft. Diese versorgte die westlichen Vororte und die Hofoper mit Leuchtgas. In ihrem Gaswerk in Gaudenzdorf wurden etwa 3,6 Millionen Kubikmeter erzeugt. Als 1887 die Wiener Hofoper von Gasbeleuchtung auf elektrische Beleuchtung umstieg, konnte dieser Verlust durch die Ausdehnung des Gasnetzes auf Altmannsdorf, Hetzendorf , Inzersdorf und Atzgersdorf kompensiert werden.

Die Wiener Gaswerke

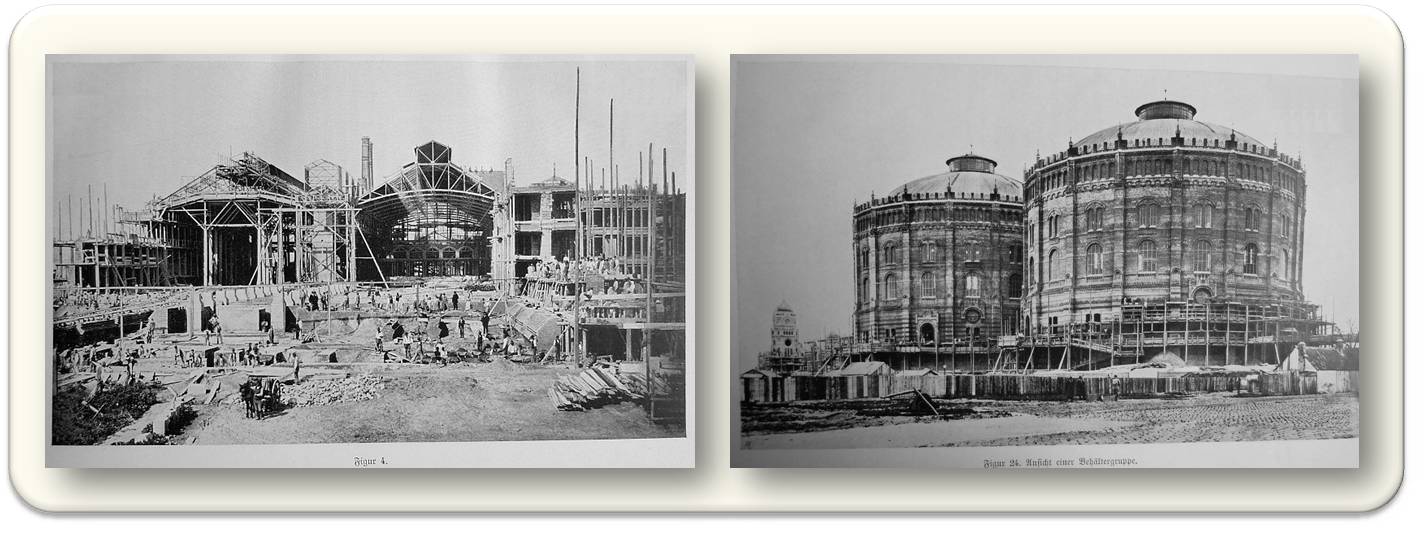

Aufgrund eines Gemeinderatsbeschlusses übernahmen im Jahr 1899 die Wiener Städtischen Gaswerke (Abbildung 2) die Belieferung der Gemeindebezirke 1 - 11 und 20 mit Leuchtgas. Die Versorgung der Bezirke 12 - 19 wurde bis zum Jahr 1911 vertragsgemäß von der Imperial-Continental-Gas Association durchgeführt. Die Wiener Gaswerke verwendeten für die Stadtbeleuchtung sofort das Auer Gas-Glühlicht (den Auerbrenner), das ein wesentlich besseres Licht gab.

Abbildung 2. Die Erbauung des Wiener städtischen Gaswerkes in Simmering, des damals europaweit größten Gaswerkes. Links: Bau des Ofenhauses 1901, rechts: zwei Gasometer, 1901. Das Leuchtgas (Stadtgas) wurde im Ofenhaus durch Trockendestillation von Steinkohle ("Kohlevergasung") und anschließende Gaswäsche im Waschhaus gewonnen und in den Gasometern gespeichert, bevor es zum Verbrauch in das Gasnetz abgegeben wurde. Mit der Umstellung auf das wesentlich billigere Erdgas in den 1970er Jahren gingen die Gasometer außer Betrieb. (Fotos sind gemeinfrei)

Eine Statistik aus dem Jahr 1900 besagt, dass die Wiener Gaswerke mehr als 73 Millionen Kubikmeter Leuchtgas erzeugten, von denen etwa 7 Millionen für die Straßenbeleuchtung, 59 Millionen für die private Beleuchtung und 5,6 Millionen für Heiz-, Koch- und Industriezwecke verwendet wurden. Für eigene Einrichtungen benötigte die Gemeinde Wien 1,2 Millionen Kubikmeter Leuchtgas. Obwohl die städtischen Gaswerke nur einen Teil der Stadt versorgten, erzeugten sie wesentlich mehr Gas als 20 Jahre vorher für ganz Wien produziert worden war.

Im Jahr 1912 wurden bereits 168 Millionen Kubikmeter für private Zwecke benötigt und 15 Millionen für die Straßenbeleuchtung. (Zum Vergleich: Der aktuelle Bedarf an Erdgas, das ja heute nicht zur Beleuchtung sondern zur Wärme-und Stromproduktion und als Kraftstoff eingesetzt wird, liegt laut E-Control Statistikbericht 2018 für ganz Österreich bei 8500 Millionen Kubikmeter im Jahr; Anm. Redn.)

In Wien hatte also zur Jahrhundertwende die Beleuchtung mit Gas auch in privaten Haushalten schon eine so große Bedeutung bekommen, dass nur etwa 10 % der Gesamtproduktion für die Straßenbeleuchtung verwendet wurden. In den kleineren Städten war dies noch nicht der Fall. In Baden war bei einer Produktion von 612000 Kubikmetern der Anteil der Straßenbeleuchtung noch 23 % und in St. Pölten 18 % bi einer Produktion von 499 000 Kubikmetern.

Nebenprodukte der Gaserzeugung fanden im Kaiserreich leider kaum Verwendung

Bei der Gaserzeugung fielen in Wien mehr als 10000 Tonnen Teer an, die in einem Werk in Angern (Niederösterreich) verarbeitet wurden. Vorwiegend wurden dort Benzol, Anthracen und Phenole ("Karbolsäuren") aus dem Teer gewonnen.

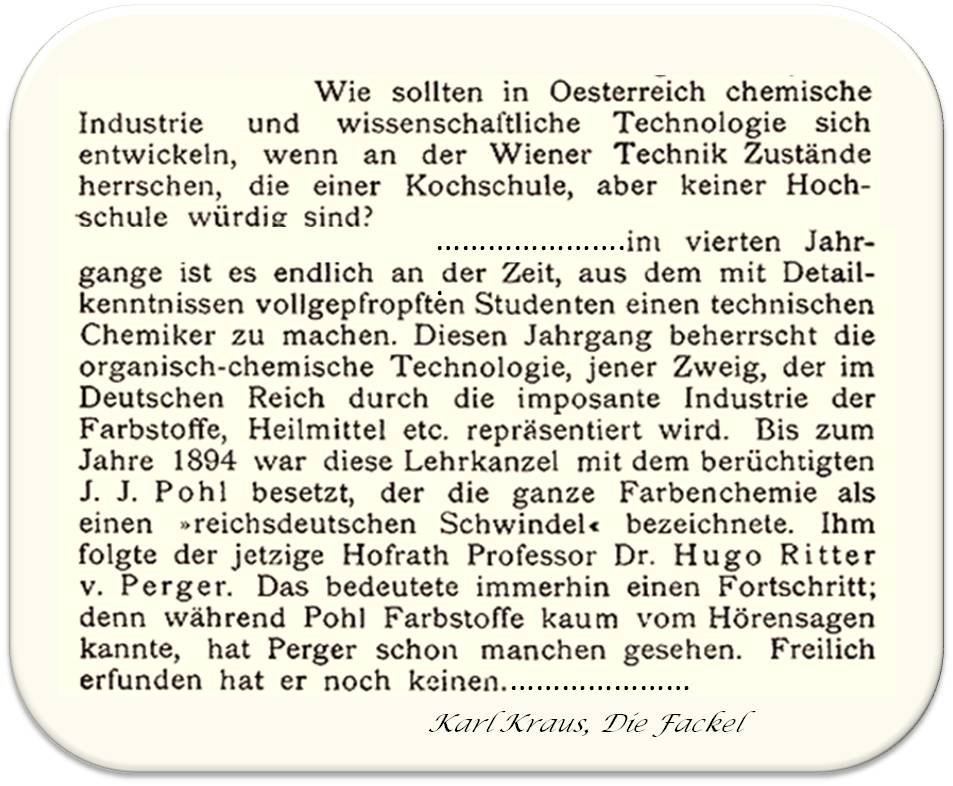

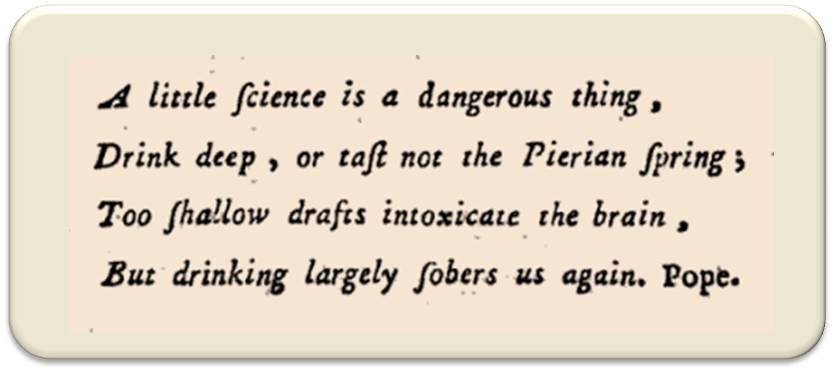

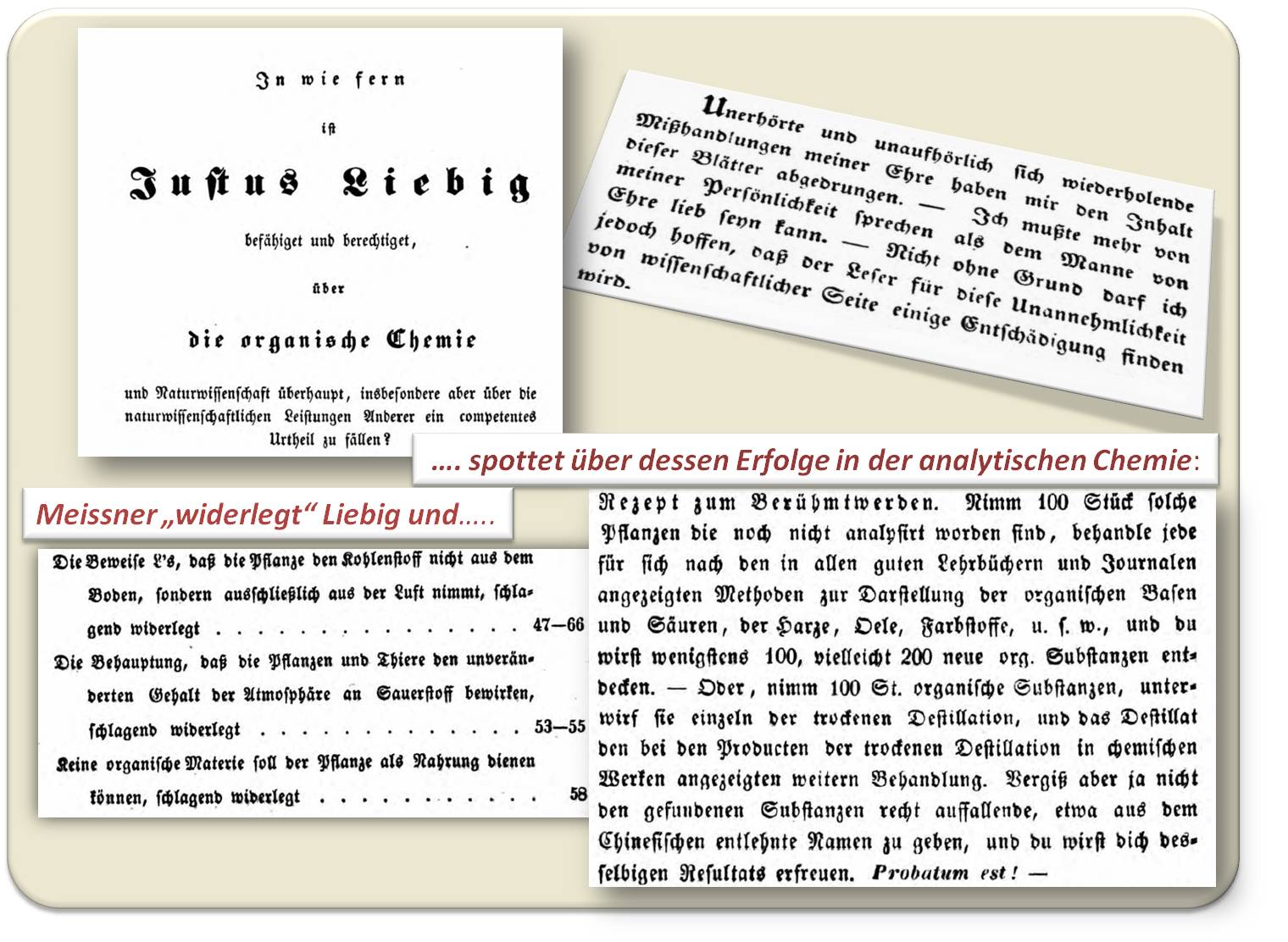

Da es im Kaiserreich aber keine Farbenfabriken gab, welche die Hauptabnehmer für Benzol und Anthracen gewesen wären, wurden diese Produkte zu sehr tiefen Preisen nach Deutschland exportiert. (Dazu kritische Anmerkungen des berühmten österreichischen Schriftstellers Karl Kraus: Abbildung 3).

Abbildung 3. Karl Kraus, einer der bekanntesten österreichischen Schriftsteller, kritisiert in seiner Zeitschrift "Die Fackel" die fehlende Ausbildung in organisch-technischer Chemie, die damals in Deutschland die Farben- und Heilmittelindustrie entstehen ließ. (Ausschnitte aus Die Fackel, Heft 31, 2 (1900) und Heft 74,4 (1901))

Abbildung 3. Karl Kraus, einer der bekanntesten österreichischen Schriftsteller, kritisiert in seiner Zeitschrift "Die Fackel" die fehlende Ausbildung in organisch-technischer Chemie, die damals in Deutschland die Farben- und Heilmittelindustrie entstehen ließ. (Ausschnitte aus Die Fackel, Heft 31, 2 (1900) und Heft 74,4 (1901))

In manchen Jahren war der erzielbare Preis für die Teerprodukte aber so niedrig, dass der Teer verbrannt wurde.

Fallweise gab es für Karbolsäuren auch einen inländischen Markt als Desinfektionsmittel, besonders in Jahren, in denen es eine größere Zahl an Cholerafällen gab oder eine Grippeepidemie auftrat.

Der Beginn der österreichischen Erdölindustrie in Galizien.......

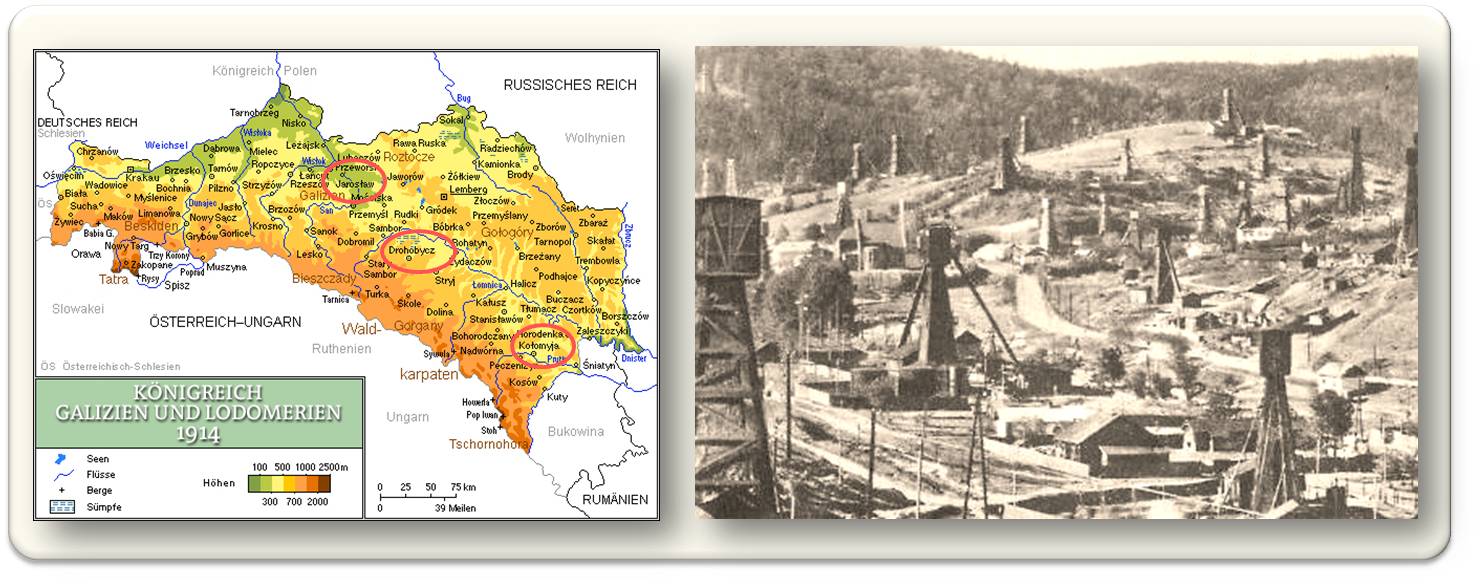

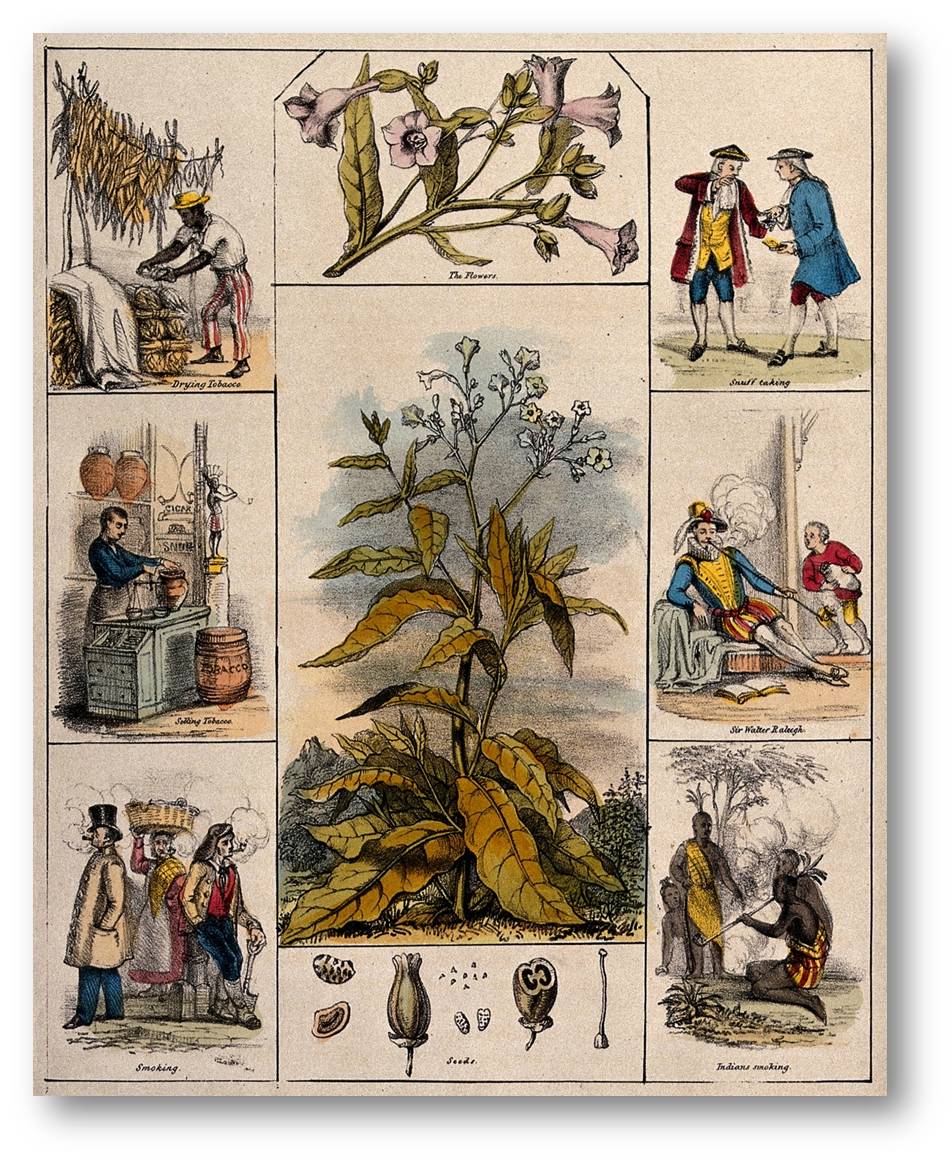

Die ersten Versuche, Stoffe die durch Destillation des galizischen Erdöls gewonnen wurden, für Leuchtzwecke zu verwenden, wurden 1852 von Abraham Schreiner aus Drohobycz in einer Schnapsbrennerei durchgeführt. Nach einem Unfall setzte Schreiner seine Versuche gemeinsam mit dem Apotheker Ignaz Lukasiewicz aus Lemberg fort. Lukasiewicz gelang es erstmals Petroleum durch Destillation von Erdöl gewerbsmäßig herzustellen. Zuerst errichtete er 1859 eine kleine Raffinerie und dann 1865 eine größere Raffinerie in Westgalizien, die bis zur Jahrhundertwende existierte. Abbildung 4.

Abbildung 4. Erdölfelder (rote Kreise) im Kronland Galizien (heute gehört der kleinere, westliche Teil zu Polen und Ostgalizien zur Ukraine), Bohrtürme (1909) standen in sehr dichtem Abstand.(Bilder aus Wikipedia: Mariusz Pazdziora (links; cc-by) und Postkarte,1909 von Wikiwand.com).

Bevor Galizien mit dem westlichen Teil der Monarchie durch eine Bahnlinie verbunden wurde, gab es nur eine sehr langsame Entwicklung der Petroleumindustrie. Hingegen kam amerikanisches Petroleum von Hamburg und Bremen auf dem Wasserweg nach Böhmen und von dort nach Wien. Die 1869 in Wien-Favoriten von Gustav Wagenmann gegründete Raffinerie, die bis 1904 bestand, verwendete galizisches Erdöl vorzugsweise zur Erzeugung von Schmierölen und verschnitt die Petroleum-Fraktion mit importiertem amerikanischem Petroleum. Dieses Unternehmen erweiterte sein Produktionsprogramm in den folgenden Jahrzehnten mit Wachsprodukten der verschiedensten Art. Paraffin wurde aus galizischem Erdwachs hergestellt, dann wurde eine Produktion von Stearin begonnen und etwas später von Ceresin.

Um die galizische Erdölproduktion zu fördern, wurde 1872 ein Schutzzoll von 75 Kreuzer für raffiniertes Petroleum eingeführt, der in den folgenden Jahrzehnten mehrmals erhöht wurde. Obwohl 1873 die erste Bahnlinie nach Ostgalizien fertig gestellt worden war, gelang es nicht die Erdölproduktion in Galizien wesentlich zu steigern, da die Frachtspesen für Petroleum von Galizien in die industrialisierten Teile des Reichs zu hoch waren. Im Jahr 1880 kostete die Fracht von 100 kg Petroleum von Drohobycz nach Wien 3,24 Gulden, von Bremen2,34 Gulden, von Stettin 1,87 Gulden und von Triest 1,18 Gulden.

Erst das Jahr 1883 brachte eine grundlegende Veränderung. In diesem Jahr führte der Kanadier William H. MacGarvey ein Bohrsystem ein, das sich für das galizische Bohrfeld besonders geeignet erwies. In diesem Jahr nahm eine Bahnlinie ihren Betrieb auf, die das ganze Ölgebiet erschloss. Die Regierung erhöhte den Zoll auf 10 Gulden pro Zentner, wodurch das ausländische Petroleum wesentlich verteuert wurde. Damit begann die Entwicklung der österreichischen Erdölindustrie. Zur Unterstützung der galizischen Petroleumindustrie wurden auch die Frachtspesen auf den Staatsbahnen von Galizien nach Wien sehr reduziert. Da es keine entsprechende Reduktion in der Gegenrichtung gab, wurde diese Maßnahme von den Wiener Raffinerien bekämpft.

…und das "Kunstöl" der Konkurrenz

Inzwischen hatte sich auch die russische Erdölindustrie im Raum Baku sehr stark entwickelt und Russland versuchte seine Erdölprodukte in Österreich abzusetzen. Um den hohen Zoll für raffiniertes Öl zu umgehen, exportierte Russland Petroleum mit einem Zusatz von Destillationsrückständen. Diese Gemisch - als Kunstöl bezeichnet - enthielt 90 -95 % Petroleum, Trotzdem konnte es mit dem niederen Zollsatz eines Rohöls importiert werden. So entstanden erst im ungarische Fiume (heute Rijeka) und dann in Triest Raffinerien, die sich auf die Verarbeitung von Kunstöl spezialisierten. Auch die Raffinerien in Wien und anderen Städten dehnten ihre Anlagen aus, um Kunstöl zu verarbeiten.

Die Herstellungskosten von Petroleum aus Kunstöl waren etwa ein Drittel der Raffinierungskosten von Rohöl und außerdem konnte der Rückstand sofort als Schmieröl für die Eisenbahnwaggonachsen verwendet werden. So wurde der Ausbau der Erdölindustrie in Galizien durch die Konkurrenz des Kunstöls sehr erschwert.

Bei der Raffinierung des Rohöls aus Galizien fielen auch beträchtliche Mengen an Benzin an, für das es zu dieser Zeit wenig Verwendung gab. Benzin wurde bis zum Beginn der Motorisierung vorwiegend als Lösungsmittel, etwa bei der Entfettung von Knochen, verwendet.

Noch im Jahr 1895 wurde berichtet, dass im Inland nicht genug Benzin abgesetzt werden konnte und es zu sehr gedrückten Preisen exportiert werden musste. Doch zehn Jahre später hatte sich die Situation völlig geändert. Etwa von 1908 an wird von einem kolossalen Aufschwung des Bedarfs an Benzin berichtet und darüber geklagt, dass im galizischen Rohöl die Benzinfraktion zu gering wäre und daher Benzin aus Niederländisch-Indien importiert werden müsse.

Die galizischen Produzenten von Erdöl errichteten eigene Raffinerien, um die Konkurrenz gegen die anderen Raffinerien aufzunehmen, die Kunstöl verarbeiteten. Dadurch gelang es allmählich die Produktion von Erdöl zu steigern. Im Jahr 1897 entwickelte Mc Garfey eine neue Bohrmeißel, mit deren Hilfe man Tiefen von 800 - 1000 Meter und dann sogar bis 1200 Meter erreichen konnte. Dabei wurden ergiebige Ölschichten angebohrt und der Rohölpreis sank auf 1 Krone pro 100 kg.

Die Petroleumerzeugung in den 1890er Jahren war durch wirtschaftliche Kämpfe zwischen den nördlichen Raffinerien, die galizisches Erdöl verarbeiteten, und den südlichen Raffinerien, die importiertes Kunstöl raffinierten, geprägt. Es kam zu Preisabsprachen und zur Ausbildung von Kartellen, die aber nie sehr lange Bestand hatten. Erst als 1900 der Zoll auf Rohöl von 1,10 auf 3,50 Gulden erhöht wurde, konnte die Einfuhr von Kunstöl gebremst werden.

Die Rohölproduktion in Galizien stieg von 89 000 Tonnen im Jahr 1890 auf 316 000 Tonnen im Jahr 1900 und 1,188 000 Tonnen im Jahr 1907. Zwar stieg in dieser Zeit auch der Inlandskonsum von Petroleum, doch konnten ab 1900 auch beträchtlichen Mengen Petroleum exportiert werden. Im Ausland stand Österreich in Konkurrenz zu Russland und Amerika.

Der Umstieg auf elektrische Beleuchtung

Ab Ende der 1880er Jahre wurde - zuerst in zentralen Institutionen wie beispielsweise in Theatern oder Banken - eine elektrische Beleuchtung eingeführt, die in den 1890er Jahren immer mehr an Umfang zunahm. Zur Kompensation des Verlustes an Abnehmern dehnten die Gaswerke das Rohrnetz aus, sodass in verstärktem Ausmaß auch Vororte mit Leuchtgas versorgt wurden.

Durch den von Carl Auer von Welsbach (1858 - 1929) erfundenen Glühstrumpf - ein als Strumpf ausgeformtes Netz aus Metalloxiden, der bei Erhitzung ein strahlendes Licht abgab - wurde die Qualität der Gasbeleuchtung wesentlich verbessert (s.u.: weiterführende Links). Das ermöglichte auch weiterhin eine Zunahme des Leuchtgasverbrauchs.

Die elektrische Beleuchtung, die sich gegen Ende des 19. Jahrhunderts durchzusetzen begonnen hatte, beruhte auf der von Thomas A. Edison 1879 entwickelten Kohlenfaden-Glühlampe, die allerdings einen hohen Stromverbrauch und eine geringe Lebensdauer hatte. Um diese Eigenschaften zu verbessern, experimentierte Auer von Welsbach mit verschiedenen hochschmelzenden Metallen wie u.a. mit Osmium (Osmium - Glühbirne). Schließlich resultierte daraus die Wolfram-Glühbirne, die rund 100 Jahre den Weltmarkt beherrschen sollte (s.u.: weiterführende Links).

Mit seinen Erfindungen des Glühstrumpfs für die Gasbeleuchtung anfangs der 1890er Jahre und der Metallfadenlampe für die elektrische Beleuchtung am Beginn des 20. Jahrhunderts hat Auer von Welsbach das Beleuchtungswesen der ganzen Welt neu gestaltet.

Weiterführende Links

Robert W. Rosner, Chemie in Österreich 1740 - 1918, Lehre, Forschung, Industrie (Hsg. W. Kerber und W. Reiter, Böhlau Verlag Wien, 2004)

Inge Schuster, 23.08.2012: Carl Auer von Welsbach: Vorbild für Forschung, Entwicklung und Unternehmertum.

Die sich vereinigenden Nationen der Naturwissenschaften und die Gefahr der Konsensforschung

Die sich vereinigenden Nationen der Naturwissenschaften und die Gefahr der KonsensforschungDo, 27.12.2018 - 15:00 — Redaktion

![]()

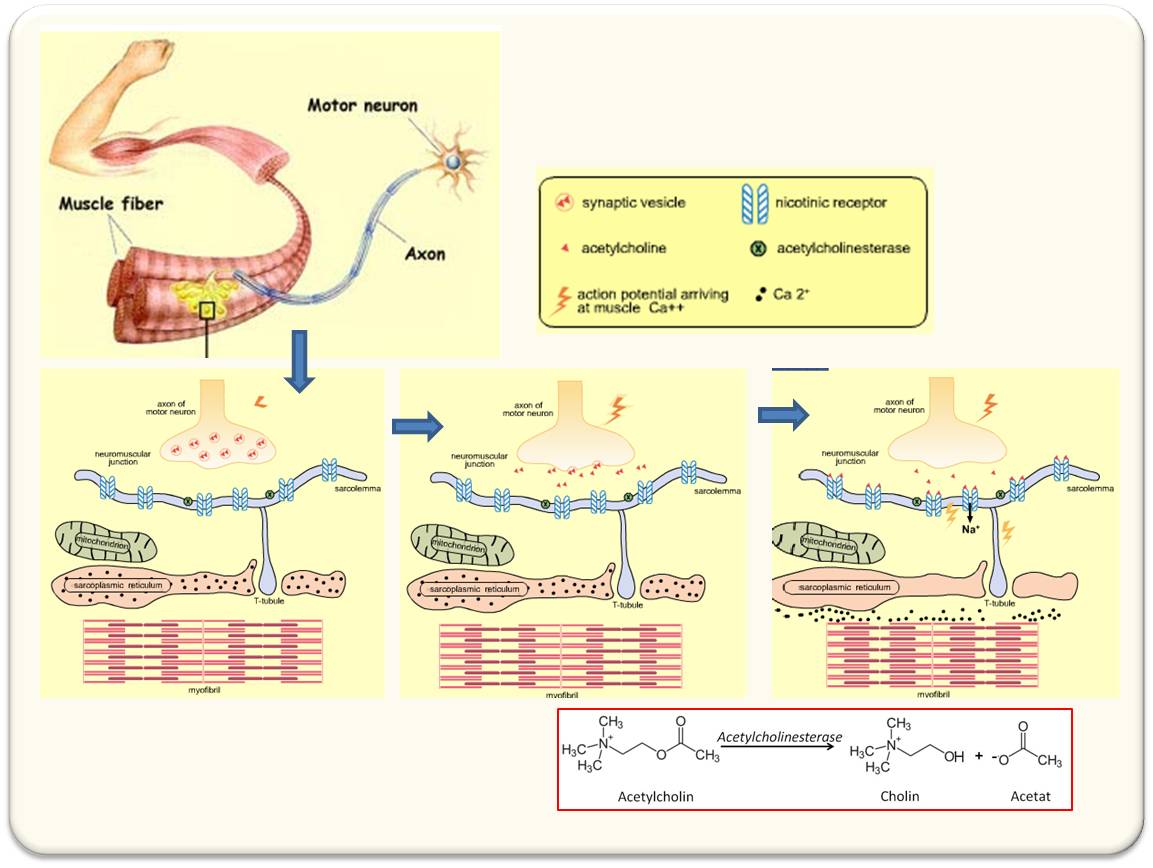

Die Welt wird immer kleiner und einheitlicher. Die blitzschnelle globale Wissenschaftskommunikation schafft enorme Möglichkeiten aber auch einen starken Impuls in Richtung Konsensforschung, der Wissenschaftler auf der ganzen Welt dazu drängt, dieselben Probleme als interessant zu betrachten und die gleichen Ansätze und Methoden in ihrer Forschung einzusetzen. Die US-amerikanische Neurobiologin Eve Marder (Brandeis University) weist in ihrem eben im Journal e-Life erschienenen Artikel "Living Science: Uniting the Nations of Science" auf die Gefahr eines Verlusts der Vielfalt in unserer wissenschaftlichen Kultur hin und ruft zu mehr Raum für Kreativität auf*. (Der Artikel wurde von der Redaktion übersetzt)

Wer eine der TV-Dokumentationen gesehen hat, in denen der amerikanische Koch und Autor Anthony Bourdain die Welt bereiste und Menschen aller Nationalitäten beim Essen und Gesprächen mit ihm filmte, war zweifellos von der Fülle an allgemein Gültigem menschlicher Erfahrung beeindruckt. Gleichzeitig war man aber auch von den Bildern und Klängen der einzelnen Orte beeindruckt. Trotz der weltweiten Ausbreitung von iPhones und Coca Cola unterscheiden sich auch im Jahr 2018 Straßen und Ansichten von Provincetown am Cape Cod (Massachusetts) sehr stark von denen in Kenia, Nepal und Lissabon. Die Verschiedenheiten bestehen, auch wenn bestimmte Markenprodukte in so vielen Teilen der Welt enorm zugenommen haben.

Traditionen bestimmen, wie Naturwissenschaften betrieben werden

Während die Wissenschaft selbst allgemein gültig ist, gibt es weitreichende kulturelle und historische Traditionen, die selbst in dieser Ära von Skype und E-Mail beeinflussen, in welcher Weise Naturwissenschaften und naturwissenschaftliche Ausbildung auf der ganzen Welt betrieben werden.

Erhebliche Unterschiede bestehen sogar zwischen kanadischen, britischen, australischen und amerikanischen Wissenschafts- und Bildungskulturen. Diese Unterschiede verblassen im Vergleich zu den Ländern, in denen die erste gesprochene Sprache nicht Englisch ist und deren erste schulische Erfahrungen sich wesentlich von denen in den USA oder Großbritannien unterscheiden.

Diese kulturell und historisch bedingten Unterschiede tragen nach wie vor dazu bei, wie wir an einige der grundlegendsten Probleme der Biologie herangehen.

Natürlich ermöglicht das Internet, dass Schüler auf der ganzen Welt mich bei einem Vortrag sehen oder, dass sie sich lineare Algebra selbst beibringen können. Gibt mir aber ein einwöchiger Besuch von Labors und Universitäten in Indien, China oder Chile mehr als ein sehr oberflächliches Verständnis der dortigen wissenschaftlichen Kultur? Meine eigene, lange Zeit zurückliegende Erfahrung als Postdoc in Paris war, dass ich länger brauchte, um die dortigen Unterschiede in Bezug auf Karrierewege zu verstehen und wie man an ein wissenschaftliches Problem herangehen sollte, als passende Schimpfwörter auf Französisch zu lernen.

Naturwissenschaften - lokale Angelegenheiten…

Vor vielen Jahren sagte der Bostoner Politiker Tip O’Neill: "Alle Politik ist eine gänzlich lokale Angelegenheit". Natürlich ist das im Jahr 2018 sowohl wahr als auch nicht wahr.

Dasselbe gilt für Naturwissenschaften.

Jeder Naturwissenschaftler betreibt sein Gebiet und /oder ist Teil eines Bildungssystems in einer lokalen Umgebung. Sogar die Grundlagen, die in einem Studienplan für die Ausbildung eines Biologen gefordert werden, sind in Institutionen, Bundesstaaten, Provinzen und Ländern sehr unterschiedlich.

Offensichtlich scheinen auch die Ansätze für die Elementar- und Sekundärbildung in der Welt recht unterschiedlich sein, ebenso wie die Einstellung der Gesellschaft zu Kindern, die Schwierigkeiten haben Lesen oder Rechnen zu lernen.

Diese Unterschiede sind vielleicht noch mehr ausgeprägt, wenn wir die Hochschulausbildung betrachten - die enormen Unterschieden zwischen einer sehr persönlichen Ausbildung, wie sie Elite-Einrichtungen in einigen Ländern anbieten und eine Ausbildung anderswo, die öffentliche Universitäten mit einer hohen Zahl inskribierter Studenten vermitteln.

…Spezialisierungen…

Die Amerikaner sind sich leider darüber im Klaren, dass viele Länder, die viel kleiner als unsere sind, Mathematik und Physik besser unterrichten als wir.

Einige Standorte sind spezialisiert für die Ausbildung von Informatikern und andere für die von Pflanzenbiologen. Es gibt viele Universitäten, an denen niemand weiß, wie man Schmetterlinge erkennt, aber es gibt hoffentlich auch andere Institutionen, in denen Wissen über Moose, Farne und Spinnen besteht.

Einige solcher Spezialisierungen in Wissenschaftsbereichen werden durch Bedingungen des Umfelds bestimmt. Institutionen können unter dem Druck stehen wichtige technologische Herausforderungen zu lösen oder eine Belegschaft mit definierten Vorgaben zu schaffen. Es gibt Länder, die sich mit der Bekämpfung infektiöser Erreger von Kulturpflanzen oder Menschen befassen müssen und vielleicht nicht das Gefühl haben, den Luxus einer Grundlagenforschung betreiben zu können, die nicht direkt zur Lösung landwirtschaftlicher oder gesundheitlicher Interessen beiträgt.

…und Exzellenzzentren

Als ich in der Wissenschaft anfing, gab es auf einigen Gebieten starke Traditionen für Spitzenleistungen - beispielsweise, dass man Exzellenz in der Neuroethologie von Insekten in Deutschland finden könne, Exzellenz in der Pflanzenbiologie jedoch anderswo. Da Exzellenz die besten Studenten anzieht, ist es verständlich, dass diese Art der wissenschaftlichen Spezialisierung zu Exzellenzzentren geführt hat, die auf der ganzen Welt unterschiedlich verteilt waren.

Erstaunlicherweise gibt es auch heute noch Reste lokaler wissenschaftlicher Traditionen aus den letzten 150 Jahren, die in der Art und Weise, wie Wissenschaft betrieben wird, Bestand haben.

Globale Wissenschaftskommunikation und Gefahr einer Konsensforschung

Als ich im Alter von 20 Jahren zum ersten Mal in Europa herumreiste, konnte man anhand von Schuhen, Kleidung und Haarschnitten die Nationalität von Menschen meines Alters erkennen.

Das ist heute fast unmöglich geworden.

Der Vorteil von Open Access-Zeitschriften, bioRxiv und elektronischer Kommunikation ist, dass Informationen sehr schnell übertragen werden und - wie Starbucks - fast überall eindringen können.

Der Nachteil von all dem in der Wissenschaft ist, dass damit ein starker Impuls in Richtung Konsensforschung gesetzt wird, in anderen Worten: dass Wissenschaftler auf der ganzen Welt dazu gedrängt werden, dieselben Probleme als interessant zu betrachten und die gleichen Ansätze und Methoden in ihrer Forschung einzusetzen.

Als die Kommunikation zwischen Wissenschaftlern auf der ganzen Welt noch langsam und mit Unterbrechungen verlief, konnten kleine, halb-isolierte Gemeinschaften ihre eigenen Normen und Ansichten darüber festlegen, welche Probleme interessant waren und welche Methoden als notwendig und ausreichend erachtet wurden.

In der heutigen Welt der blitzschnellen Kommunikation haben viele Wissenschaftsbereiche Rezepte dafür entwickelt, was eine Untersuchung alles enthalten muss, um ausreichende Qualität für die Veröffentlichung in einer ausgezeichneten Zeitschrift aufzuweisen. Einige der Rezeptzutaten sind sinnvoll (z.B. alle Untersuchungen sollten über geeignete Statistiken und ausreichende Probenzahlen verfügen), anderen Zutaten folgen Autoren, Gutachter und Herausgeber in sklavischer Manier, ohne zu überlegen, ob diese für das anstehende Problem Relevanz haben.

Ich befürchte, dass das Streben nach Exzellenzstandards unbeabsichtigt dazu führen kann, dass Arbeiten, die neue Erkenntnisse bieten ohne notwendigerweise alle Zutaten zu enthalten, die man bei einer Veröffentlichung in einem bestimmten Bereich erwartet, gering geschätzt werden. In letzter Konsequenz sollten aber kreative Wissenschaftler, die neue Ansätze für wissenschaftliche Fragestellungen formulieren, dahingehend beurteilt werden, welche neuen Erkenntnisse sie mit ihrer Arbeit geschaffen haben, und nicht nur danach, ob ihre Arbeit alle Ingredienzien oder Eigenschaften aufweist, welche das Gebiet erwartet.

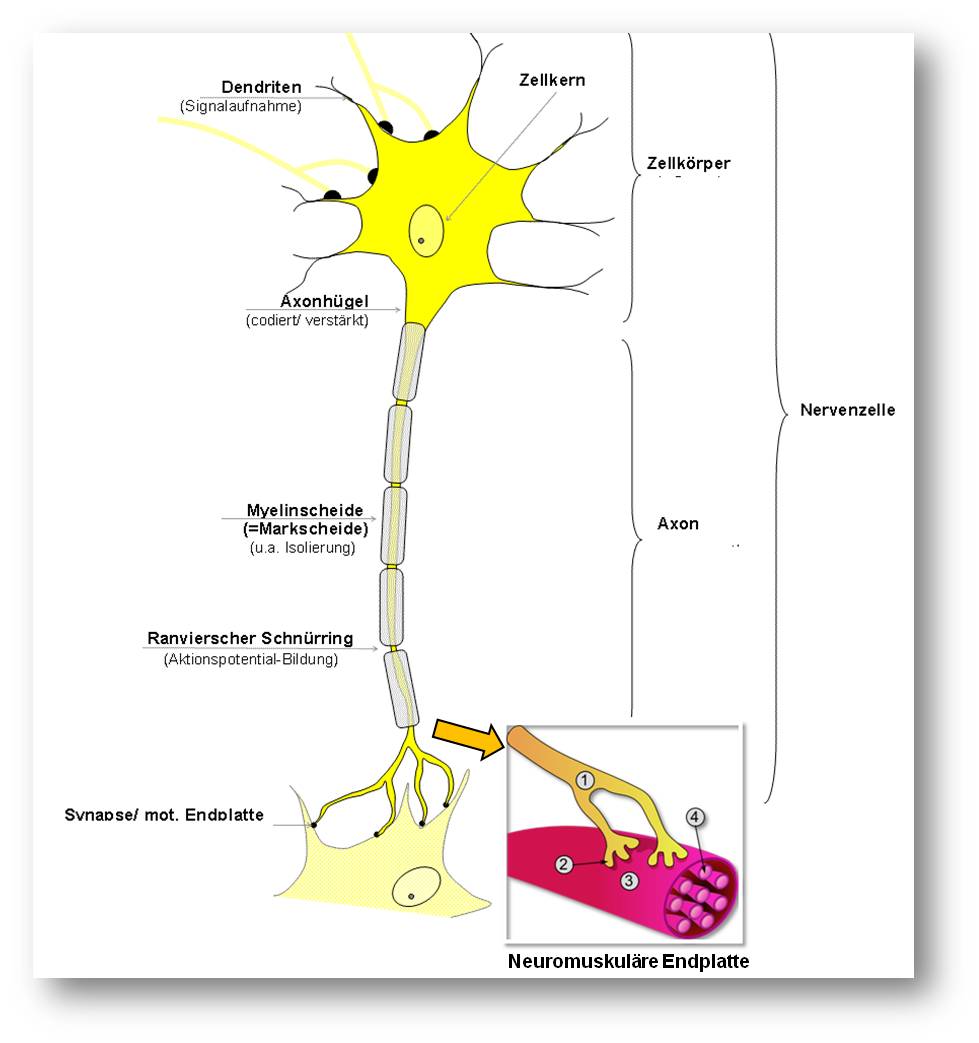

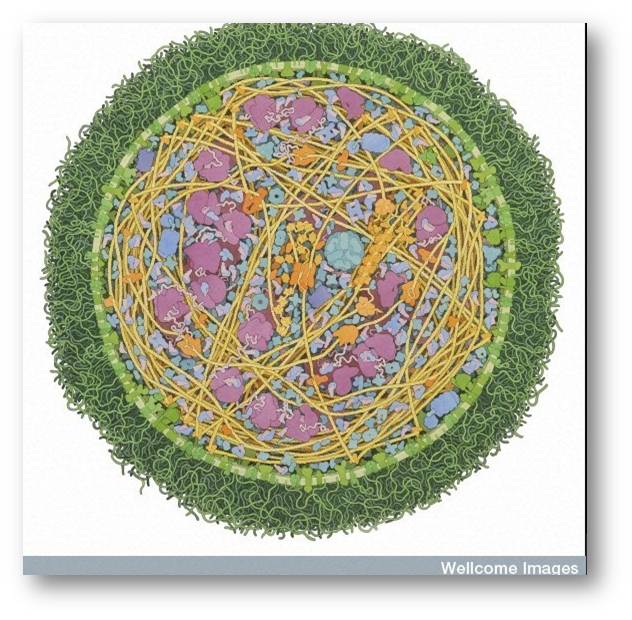

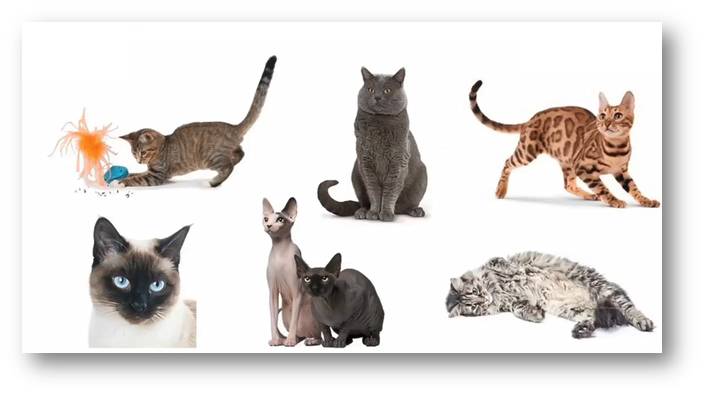

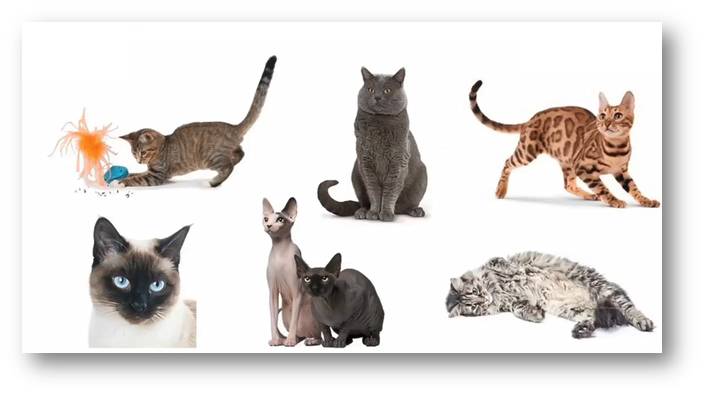

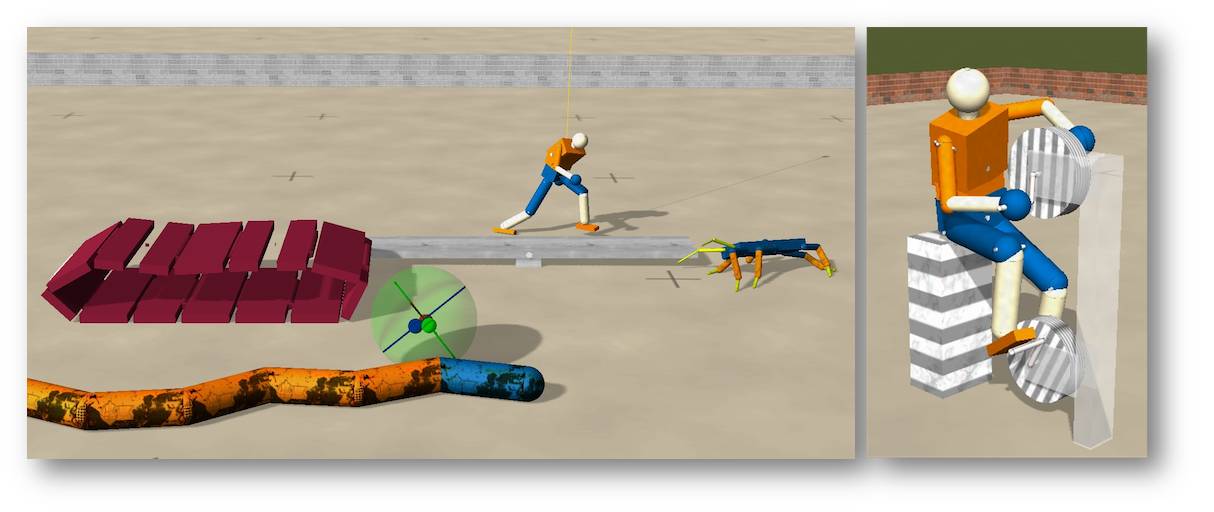

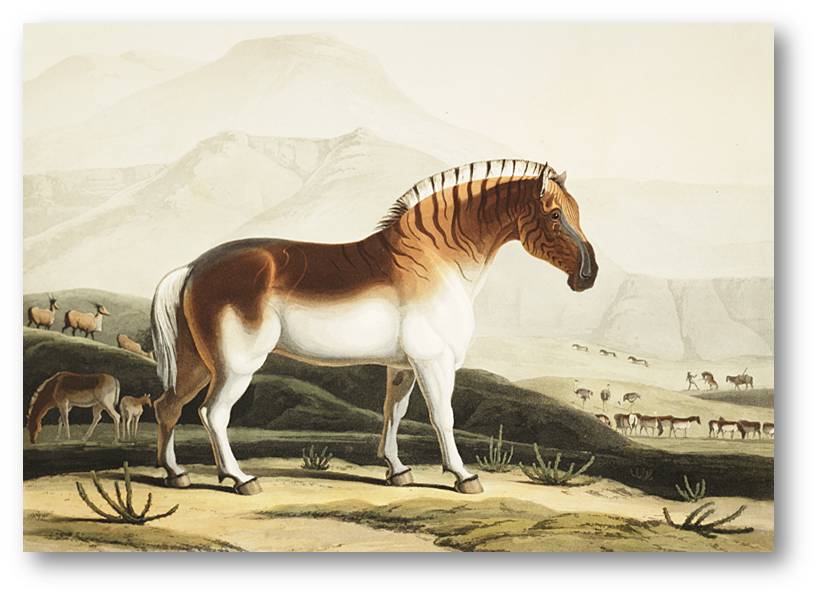

Abbildung 1. So wie Biologen gelehrt werden, in der im Evolutionsprozess entstandenen Artenvielfalt zu schwelgen, so sollten sie auch die Vorteile schätzen, die sich aus verschiedenen Ansätzen für Bildung und Forschung ergeben. Abbildung: Ben Marder.

Abbildung 1. So wie Biologen gelehrt werden, in der im Evolutionsprozess entstandenen Artenvielfalt zu schwelgen, so sollten sie auch die Vorteile schätzen, die sich aus verschiedenen Ansätzen für Bildung und Forschung ergeben. Abbildung: Ben Marder.

So wie es mir weh tut, Coca Cola überall zu sehen, wohin ich reise, so wäre es äußerst traurig, wenn die gesteigerte Kommunikation zwischen Biologen dazu führen würde, dass die Erforschung von hochspezifischen Fragestellungen oder von Spezies, die nur in einigen Gebieten zu finden sind, verloren ginge.

Biologen lernen, in der Artenvielfalt zu schwelgen, die aus der Evolution resultiert. Ebenso sollten wir die Chancen bewahren grundlegende biologische Prinzipien zu verstehen, die sich aus der Diversität unserer Bildung und Forschung ergeben. Abbildung 1.

Viele Menschen tragen finanziell und mit ihrer Zeit dazu bei, bedrohte Arten in der Welt zu erhalten. Vielleicht sollten mehr Wissenschaftler darüber nachdenken, was wir verlieren, wenn wir den Verlust der Vielfalt in unserer wissenschaftlichen Kultur zulassen!

Anthony Bourdain ließ das Universum glänzen, ob er nun in einem feinen Restaurant speiste oder auf einem belebten asiatischen Markt Street Food verzehrte. Ebenso sollten wir in der Lage sein, die Lehren aus Experimenten und Messungen kluger und kreativer Menschen zu schätzen und zu verstehen, unabhängig davon, ob sie den Rezepten der Konsenswissenschaft folgen oder nicht.

*Eve Marder: Living Science: Uniting the Nations of Science (feature article, Dec. 20, 2018) e-Life DOI:10.7554/eLife.44441. Der unter einer cc-by Lizenz stehende Artikel wurde von der Redaktion ins Deutsche übersetzt und es wurden einige Untertitel eingefügt.

Eve Marder ist eine renommierte, hochdekorierte Neurobiologin an der Brandeis University, die u.a. auch als Deputy Editor von eLife fungiert. Sie schreibt auch über Wissenschaft, Politik und Gesellschaft. homepage: https://blogs.brandeis.edu/marderlab/ ; ausführliche Darstellung: https://en.wikipedia.org/wiki/Eve_Marder

Anhaltspunkte für Langlebigkeit aus dem Genom einer Riesenschildkröte

Anhaltspunkte für Langlebigkeit aus dem Genom einer RiesenschildkröteDo, 13.12.2018 - 13:00 — Ricki Lewis

![]()

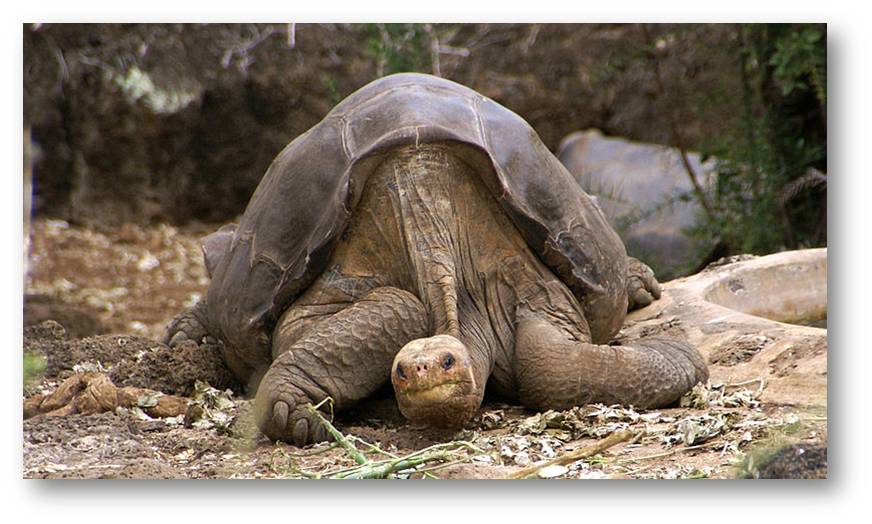

Der letzte Vertreter der Pinta-Riesenschildkröten - Lonesome George - starb 2012 im Alter von 100 Jahren . Kürzlich wurde der Vergleich seines Genoms mit dem anderer Spezies veröffentlicht: dieser zeigt Gen-Varianten, die u.a. Selektionsvorteile für Langlebigkeit, Abwehr von Infektionen, Resistenz gegenüber Krebserkrankungen bieten und damit neue Wege für die medizinische Forschung eröffnen [1]. Die Genetikerin Ricki Lewis, die zu Riesenschildkröten eine besondere Beziehung hat, berichtet über diese bahnbrechenden Befunde.*

Eine lange Beziehung zu Schildkröten

Für Schildkröten hege ich eine besondere Vorliebe.

Vor vielen Jahren kaufte ich anlässlich einer Reptilienschau eine Sulcata-Schildkröte. Was ich nicht wusste als ich damals die winzige Speedy in einer McDonalds Burger-Box nachhause brachte war, dass sie über 100 Jahre alt werden konnte.

Speedy wuchs und das sehr schnell. Nachts vergnügte sie sich damit die Möbel herum zu schubsen. Das Reinigen ihrer wöchentlichen Ausscheidungen kostete mich einige Stunden, Speedy selbst verabscheute die Badewanne. Sie liebte es den Sommer im Freien zu verbringen - als eine Art Reptilien-Rasenmäher, im Winter fiel sie dagegen in Depression und hockte wie eine deplatzierte Aktenkiste in einem Winkel meines Büros.

Ich verzweifelte. Das Googeln führte dann zu Artikeln, welche verächtlich über Idioten im Nordosten herzogen, die sich mit Leguanen und Riesenschildkröten anfreunden und dann mit deren unabwendbarem Wachstum konfrontiert sind.

Ich musste meine geliebte Speedy umsiedeln.

Ich las die ausführlichen Anleitungen im Internet und platzierte Speedy in die erforderlichen zwei Plastikwannen mit viel Platz und dem Etikett "Ich bin keine Schlange". Dann ging es zur Post. Ich hatte sicher gestellt, dass Airborne Express sie versenden würde, wohingegen FedX und DHL kein lebendes Reptil anrühren würden. Aber ich kam fünf Minuten zu spät, und der Airborne-Angestellte war bereits gegangen.

Es war dies Montag, der 10. September 2001.

Wäre Speedy pünktlich abgereist, wäre sie zweifellos irgendwo auf einem Rollfeld umgekommen, das die USA nach den Terroranschlägen schlossen. Der Besitzer des Postversands erzählt bis heute die Geschichte seiner interessantesten Postsendung, der Schildkröte Speedy.

Ich behielt Speedy für einen weiteren Monat und schickte sie dann ab. Ich erfuhr bald, dass der Airborne-Mann in Kalifornien - nachdem er festgestellt hatte, dass Speedy keine Schlange war - sie herausgenommen hatte und auf dem Platz neben ihm sitzen ließ. Speedy landete auf einer Schildkrötenfarm in Apple Valley, Kalifornien, zusammen mit anderen großen, übersiedelten Yankee-Reptilien. Speedy hatte bald einen Freund, einen wohlhabenden Sulcata, der mit einem Privatjet von Sonoma eingeflogen worden war. Wir haben jedoch den Kontakt verloren.

Das genomische Vermächtnis der Riesenschildköte Lonesome George

Ein am 3. Dezember 2018 in dem Journal Nature Ecology & Evolution erschienener Artikel [1] erregte mein Interesse.

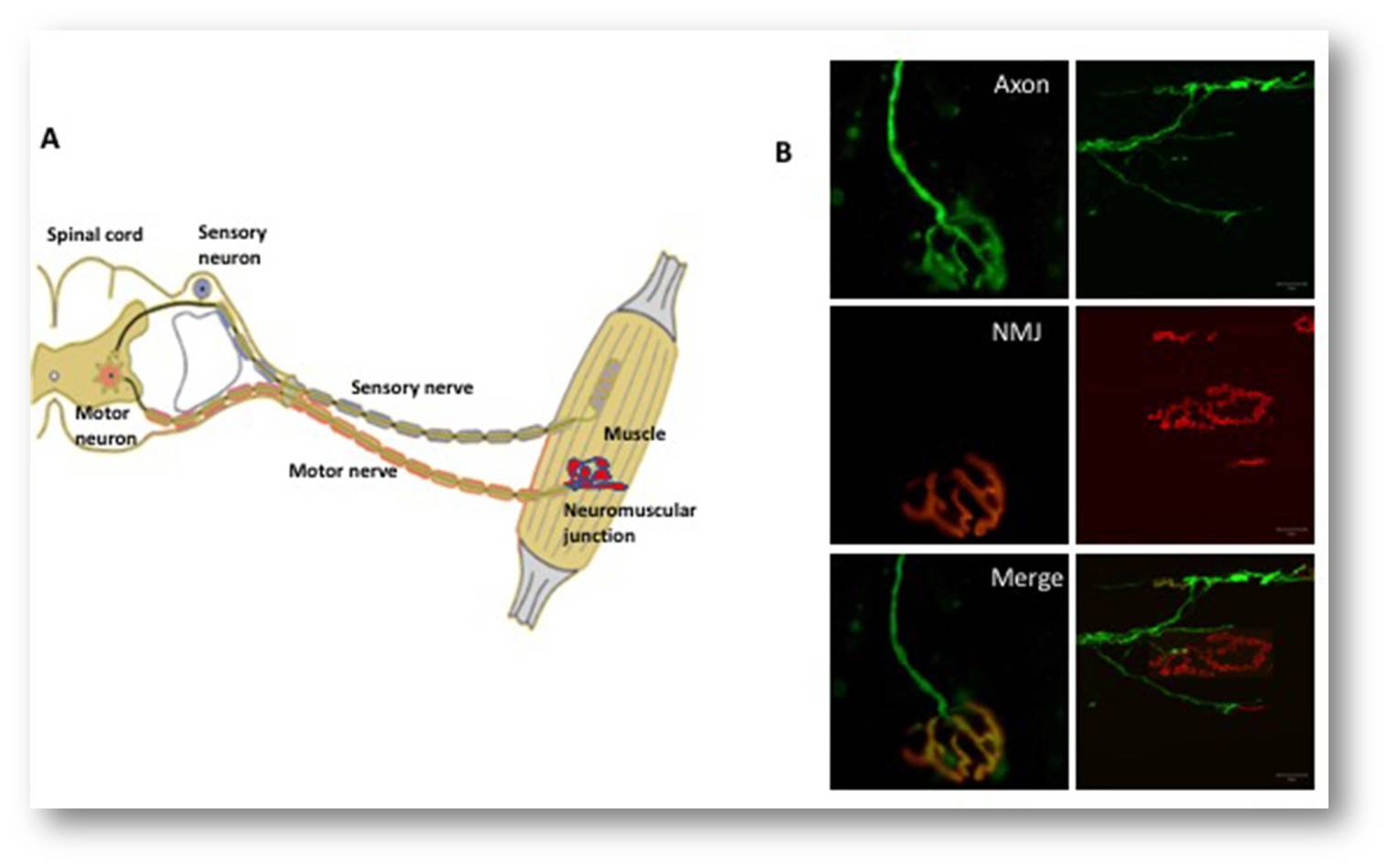

Es handelt sich dabei um eine von Forschern der Yale University, der University of Oviedo in Spanien, der Galapagos Conservancy und des Galapagos National Park Service stammende Untersuchung. Diese besagt: „Genome von Riesenschildkröten bieten Erkenntnisse zu Langlebigkeit und altersbedingten Erkrankungen“. Zentrale Figur der Untersuchung war Lonesome George, der berühmteste Bewohner der Galapagos-Inseln. Die Forscher verglichen das Genom von George mit dem der Aldabra-Riesenschildkröte (Aldabrachelys gigantea) des Indischen Ozeans und auch mit einigen Genen anderer Spezies, inklusive unserer eigenen.

Das Projekt hat insgesamt recht lang gedauert. 2010 fing Adalgisa Caccone (Yale University) mit den Sequenzierungen an und Carlos Lopez-Otin (Universität Oviedo) leitete die Datenanalyse, um nach Genvarianten zu suchen, die mit Langlebigkeit in Zusammenhang stehen.

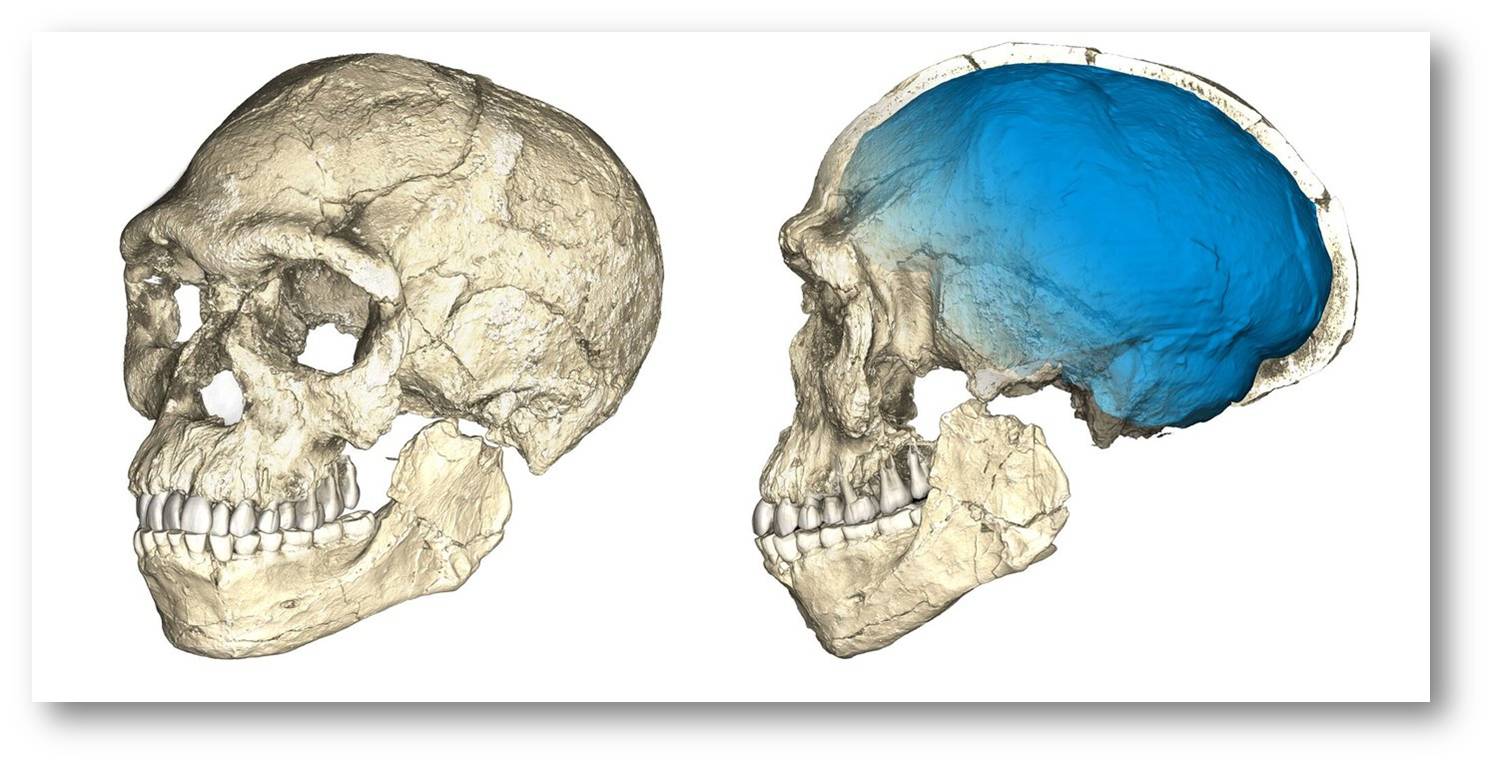

Als Lonesome George 2012 starb, war er das letzte lebende Mitglied der Chelonoidis abingdonii. Er lebte auf der Insel Pinta und wog nach seinem Tod im Alter von etwa einem Jahrhundert 195 Pfund. Abbildung 1.

Abbildung 1. "Lonesome George", der letzte Vertreter der Pinta Riesenschildkröten (Chelonoidis abingdonii) wurde etwa 100 Jahre alt und starb 2012. Sein Genom eröffnet u.a. neue Wege für die Alternsforschung (Bild: Wikipedia, putneymark - originally posted to Flickr; cc-by-sa Lizenz)

Unter Berücksichtigung bekannter Mutationsraten zeigt der Vergleich spezifischer DNA-Sequenzen, dass der letzte gemeinsame Vorfahren der beiden Schildkrötenarten vor 40 Millionen Jahren lebte. Beide Arten trennten sich von der zum Menschen führenden Linie vor mehr als 300 Millionen Jahren. Die Ankunft von Menschen auf den Galapagos-Inseln beschleunigte den Rückgang der Populationen der Lonesome George-Nachkommen - die Matrosen an Bord der durch Darwin berühmt gewordenen Beagle sollen mindestens 30 Tiere verzehrt haben.

Evolution durch Positive Selektion

Die aktuelle Untersuchung [1] verwendet leider den Begriff "Evolutionsstrategien", gerade so als würden die Tiere darüber nachdenken, was genau zu tun ist oder nicht, um einen weiteren Tag fort zu existieren. Dies ist nicht die Art und Weise wie Evolution durch natürliche Auslese funktioniert. Um es korrekter auszudrücken: jene Individuen, die das Glück hatten, vernünftige, zur Fortpflanzung gut geeignete Genvarianten geerbt zu haben, hinterließen mehr Nachwuchs und ließen somit diese Gene fortbestehen.

Heute untersuchen Forscher die Evolution auf der Basis vorteilhafter, in den Genen verankerter Veränderungen. Insbesondere suchen sie nach Anzeichen einer „positiven Selektion“ - d.i. nach Aminosäuresequenzen in Proteinen, welche von Genen codiert werden, die sich von denen verwandter Spezies unterscheiden und mit einem Vorteil (einer Anpassung) verbunden sind.

Das Beispiel für eine positive Auswahl, das ich in meinem Lehrbuch für Humangenetik verwende, ist die Höhenanpassung der Eingeborenen des tibetischen Hochlands, die mehr als zwei Meilen über dem Meeresspiegel leben. Diese Hochländer haben eine Version eines Gens namens EPAS1 (Hypoxie-induzierbarer Faktor 2) sowie Varianten in zwei anderen Genen, mit denen sie in der dünnen Luft gedeihen können. Zu den Arten von adaptiven genetischen Veränderungen gehören

- das Ersetzen von Aminosäuren in den entsprechenden Proteinen,

- das Entfernen von Teilen von Genen und

- - einfacher - das Duplizieren von Schlüsselgenen. Das Kopieren von funktionierenden Genen ist ein dauerndes Thema in der Evolution.

Was zeigt uns das Genom von Lonesome George?

In der eben erschienenen Studie wurden 43 Gene in der Spezies des Lonesome George gefunden, die Hinweise auf eine „Riesenschildkröten-spezifische positive Selektion“ zeigen. Sie haben den Tieren ermöglicht ein Jahrhundert und länger zu leben, Infektionen und Verletzungen zu vermeiden oder leicht bekämpfen zu können und nie Krebs zu bekommen.

"Lonsome George erteilt uns immer noch Lektionen", sagte Algisia Caccone in einer Pressemitteilung.

Es ist nicht überraschend, dass die Schildkröte zahlreiche Gene für die schuppigen Keratinproteine besaß, die seine Hülle bildeten, und keine Gene für Zähne hatte. (Ich habe noch nie eine Schildkröte mit Zähnen gesehen.)

Zusätzliche Kopien für Gene des Immunsystems…

Im Vergleich zu Säugetieren ist im Genom des Lonesome George eine Fülle von 861 Genen vervielfältigt, welche für die Immunantwort sorgen. George hatte ein Dutzend Kopien des Gens für Perforin, dessen Proteinprodukt die Zellen von Krankheitserregern zerstört, und zusätzliche Granzyme, Enzyme, die Krankheitserreger abtöten. Andere Gene des Immunsystems, die in Lonesome Georges Genom überrepräsentiert sind, sind solche die spezifisch Viren, Bakterien, Pilze und Parasiten vernichten. Auch die Gene des Major Histocompatibility Complex (für die Immunerkennung codierende Gene; MHC) sind doppelt vorhanden.

…Varianten für metabolische Regulierung, DNA-Reparatur und Sauerstoff-Bindung…

Die Gene, die den Blutzucker und die Reparatur der DNA regulieren, unterscheiden sich von denen anderer Spezies. Lonesome George und seine Brüder besaßen die acht Arten von Globin-Molekülen - Sauerstoff bindenden und transportierenden Molekülen -, die allen Wirbeltieren gemeinsam sind, jedoch hatten sie Varianten, die sie vor sauerstoffarmen Bedingungen schützten. Es war dies eine Eigenschaft, die wahrscheinlich von ihren Wasserschildkröten Vorfahren weitergegeben wurde.

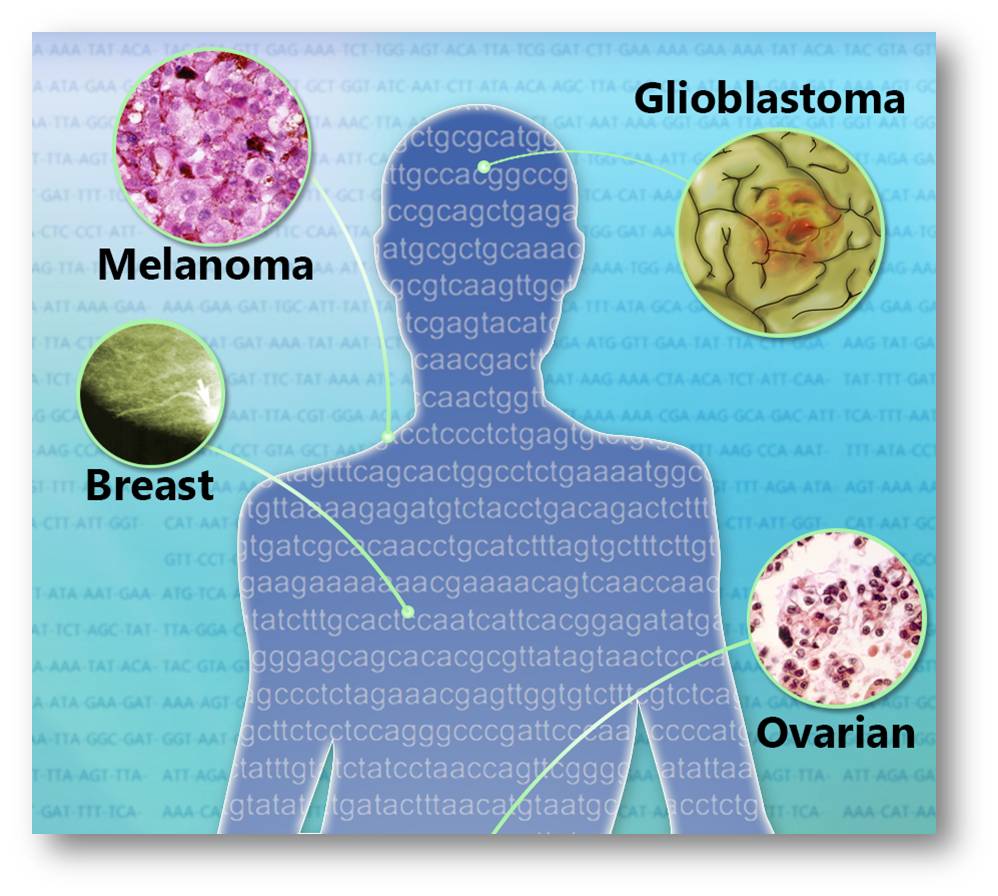

…Varianten für die Resistenz gegenüber Krebs…

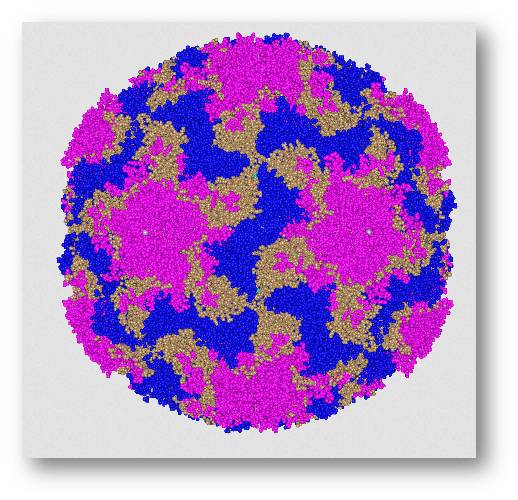

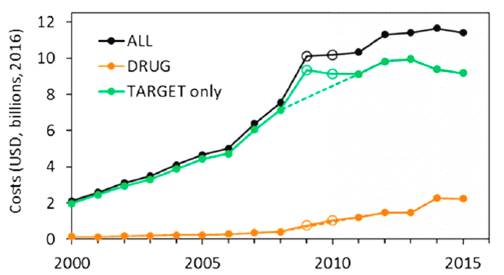

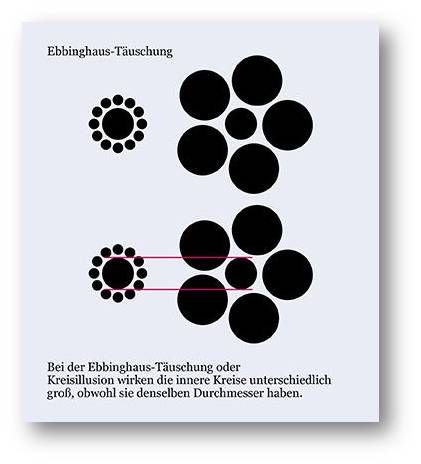

Bei einem Screening gegen eine große Zahl bekannter Krebsgene zeigte das Genom von Lonesome George 5 Erweiterungen in Genen, die für Tumorsuppressorproteine kodieren; ihre Identität lässt auf eine Rolle in der Immunüberwachung schließen - ein Immunsystem, das Krebs aktiv bekämpfte. Die immunologische Ausstattung könnte dazu beitragen, das Paradoxon von Peto zu erklären, dass nämlich Krebs bei größeren Tierarten eine geringere Häufigkeit hat. Abbildung 2 unten (rote Punkte).

Abbildung 2. Genomische Basis für Langlebigkeit und Fehlen von Krebserkrankungen in Riesenschildkröten. Relevante Genvarianten; Punkte zeigen deren Anwesenheit in den verschiedenen Spezies. (Bild: Ausschnitt aus Fig.2. in [1] von der Redaktion eingefügt . cc-by-Lizenz.)

…Varianten, die gegen Proteinaggregation schützen…

Lonesome Georges Genom enthielt auch eine Enzymvariante, die auf einen möglichen Schutz gegen die Art von Proteinaggregation hinweist, welche der Parkinson-Krankheit und der Alzheimer-Krankheit zugrunde liegt. Es sind Varianten des Gens TDO2 (Tryptophan 2,3, Dioxygenase), die mit der Regulation der Alpha-Synuclein-Aggregation in Würmern zusammenhängen. Die Genvariante in Lonesome George hemmt das Tryptophan abbauende Enzym - dies bietet einen Schutz vor Proteinaggregation.

…Varianten, die in Zusammenhang mit Langlebigkeit stehen…

Besonders interessant war für mich die Untersuchung von Genen, die mit der Langlebigkeit anderer Arten in Zusammenhang stehen. "Wir hatten zuvor neun Merkmale der Alterung beschrieben. Nachdem wir auf Basis dieser Klassifizierung 500 Gene untersucht hatten, fanden wir interessante Varianten, die möglicherweise sechs dieser Merkmale bei Riesenschildkröten betreffen und damit neue Wege für die Alternsforschung eröffnen", sagte Dr. Lopez-Otin . Abbildung 2.

Lonesome George besaß ein halbes Dutzend alterungssassoziierte Gene mit einzigartigen Varianten, welche die Intaktheit des Genoms, die Reparatur der DNA-Reparatur (Basenexzision) und eine Resistenz gegen doppelsträngige DNA-Brüche fördern (was bedeutet, dass CRISPR wahrscheinlich nicht bei einer Riesenschildkröte funktionieren würde). Lonesome George gelang es auch, seine Chromosomenenden, seine Telomere, lang zu halten und die Uhr der biologischen Zellteilung zu verlangsamen. Außerdem weisen einzigartige Genvarianten auf eine überlegene Zell-Zell-Kommunikation, ein robustes Zytoskelett und auf Mitochondrien hin, die besonders gut zur Entgiftung geeignet sind.

Lonesome George hatte Varianten von Alterungsgenen mit dem Nacktmull gemeinsam, dem am längsten lebenden Nagetier (es kann bis zu 28 Jahre alt werden; Anm. Red,). Abbildung 3.

Abbildung 3. Der Nacktmull , das am längsten lebende Nagetier (Bild: Wikipedia, Roman Klementschitz, Wien cc-by-sa)

Darüber hinaus zeigt sein Genom eine positive Selektion in zwei Genen, welche für Biomarker einer Langlebigkeit des Menschen in Gesundheit kodieren (Alpha 2-HS Glycoprotein - AHSG - und Fibroblast Growth Factor 19 - FGF19 -, ein gastrointestinales Hormon).

Fazit der Forscher

"Lonesome George - der letzte Vertreter von C. abingdonii und ein wohlbekanntes Symbol für die Notlage bedrohter Arten - hat ein Vermächtnis hinterlassen, das die in seinem Genom niedergelegte Geschichte einschließt, deren Entzifferung gerade erst begonnen hat."

Speedy wäre stolz.

[1] Víctor Quesada et al., Giant tortoise genomes provide insights into longevity and age-related disease. Nature Ecology & Evolution 2018. https://doi.org/10.1038/s41559-018-0733-x open access; cc-by-Lizenz.

*Der Artikel ist erstmals am 6. Dezember 2018 in PLOS Blogs - DNA Science Blog unter dem Titel "Genome of Galapagos Gentle Giant Lonesome George Leaves Clues to Longevity"" erschienen (https://blogs.plos.org/dnascience/2018/12/06/genome-of-galapagos-gentle-giant-lonesome-george-leaves-clues-to-longevity/) und steht unter einer cc-by Lizenz. Die Autorin hat sich freundlicherweise mit der Übersetzung ihrer Artikel durch ScienceBlog.at einverstanden erklärt, welche so genau wie möglich den englischen Fassungen folgen. Von der Redaktion eingefügt wurde Abbildung 2, das einen Ausschnitt aus der Originalarbeit [1] zeigt.

Weiterführende Links

Riesenschildkröte "Lonesome George" gestorben. 2012, Video 0:20 min.

Preserving Lonesome George. American Museum of Natural History 2014. Video 4:34 min.

The Biggest Tortoise In the World | Big Pacific.2017. Video 6:03 min. Standard YouTube Lizenz

Nacktmull - ein Nager mit "Superkräften" | [w] wie wissen. ARD 26.03-2018. Video 6:11 min.

Grenzen der Klimamodellierungen

Grenzen der KlimamodellierungenDo, 06.12.2018 - 15:47 — Carbon Brief

![]()

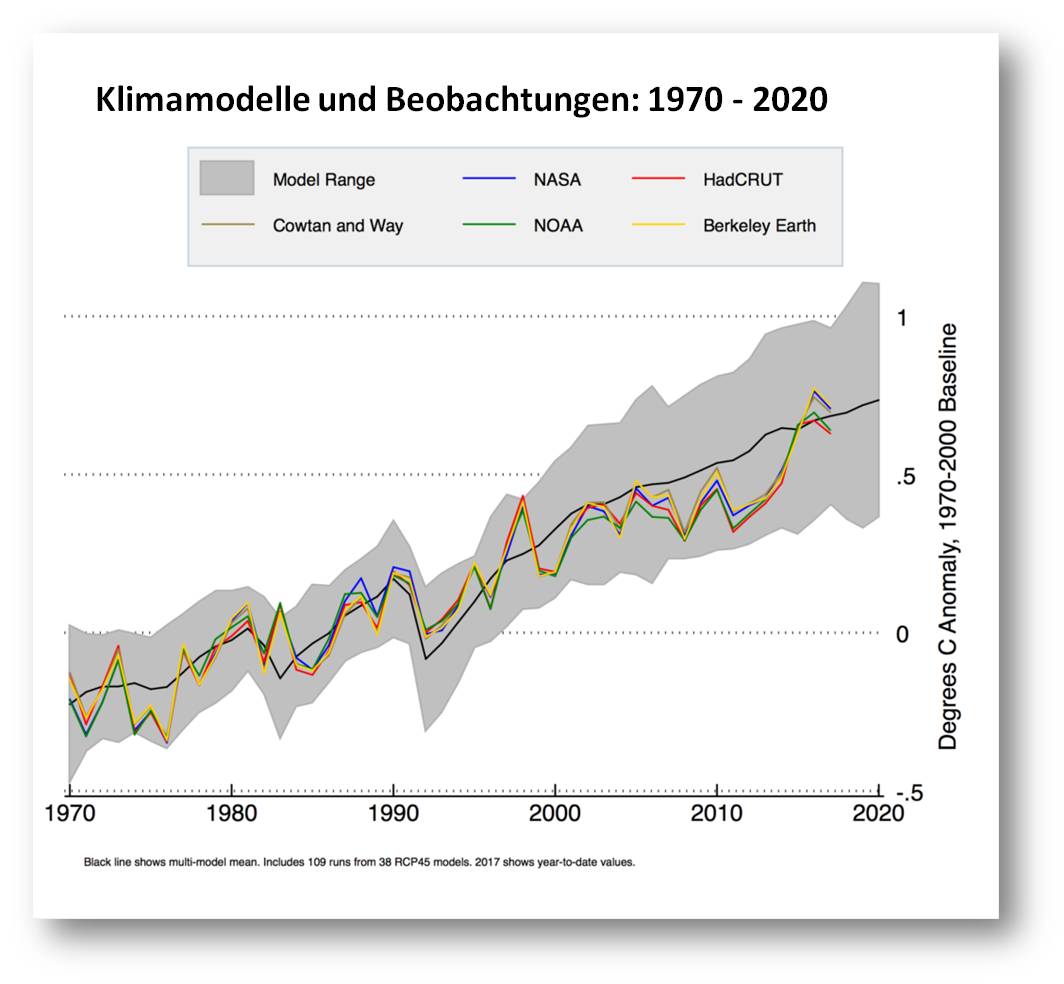

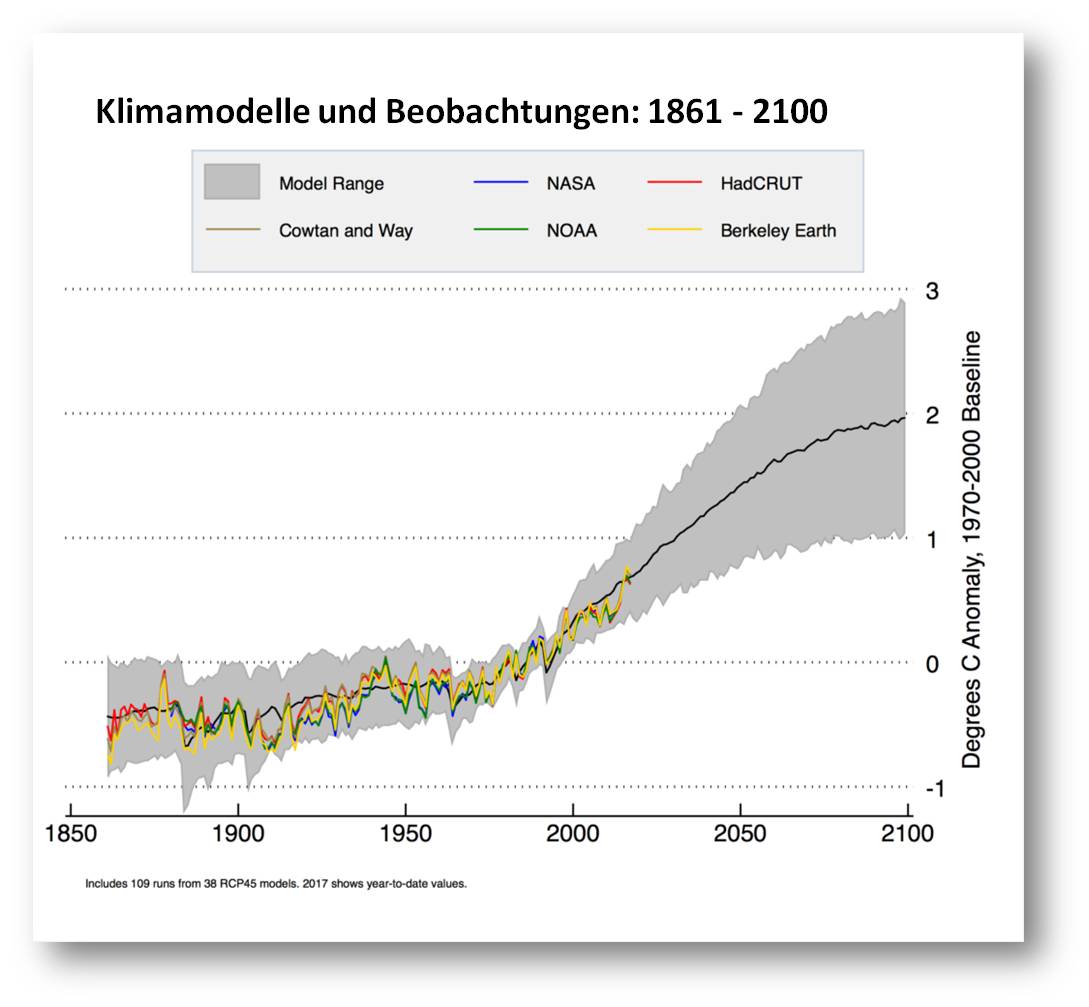

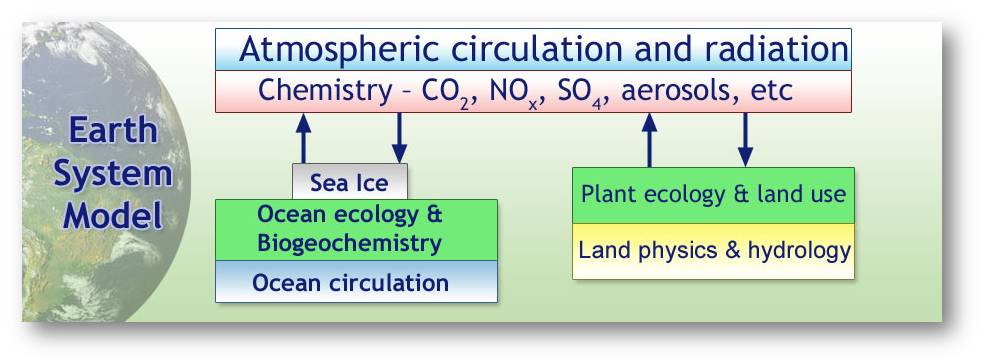

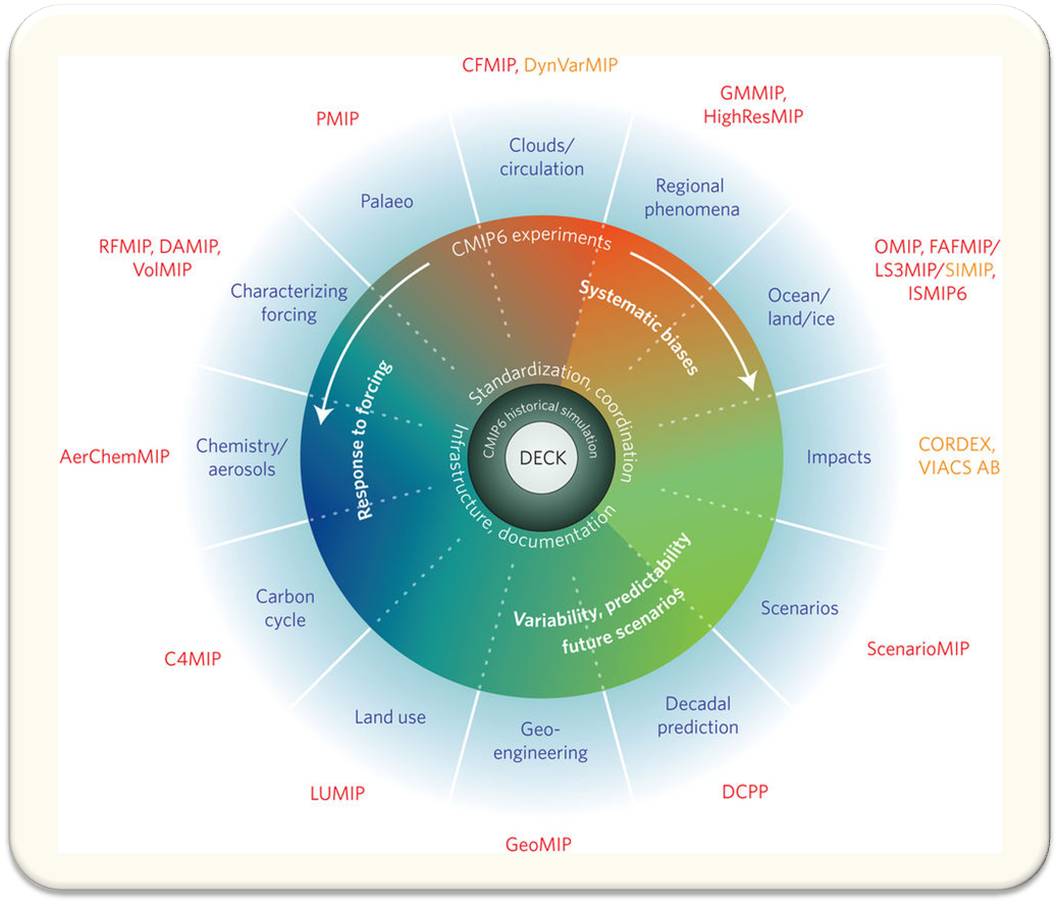

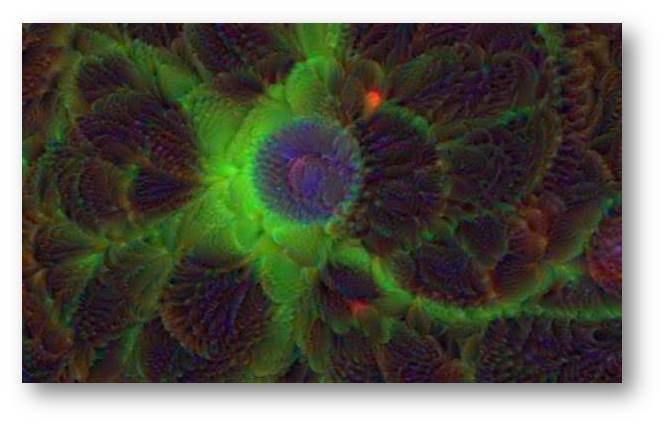

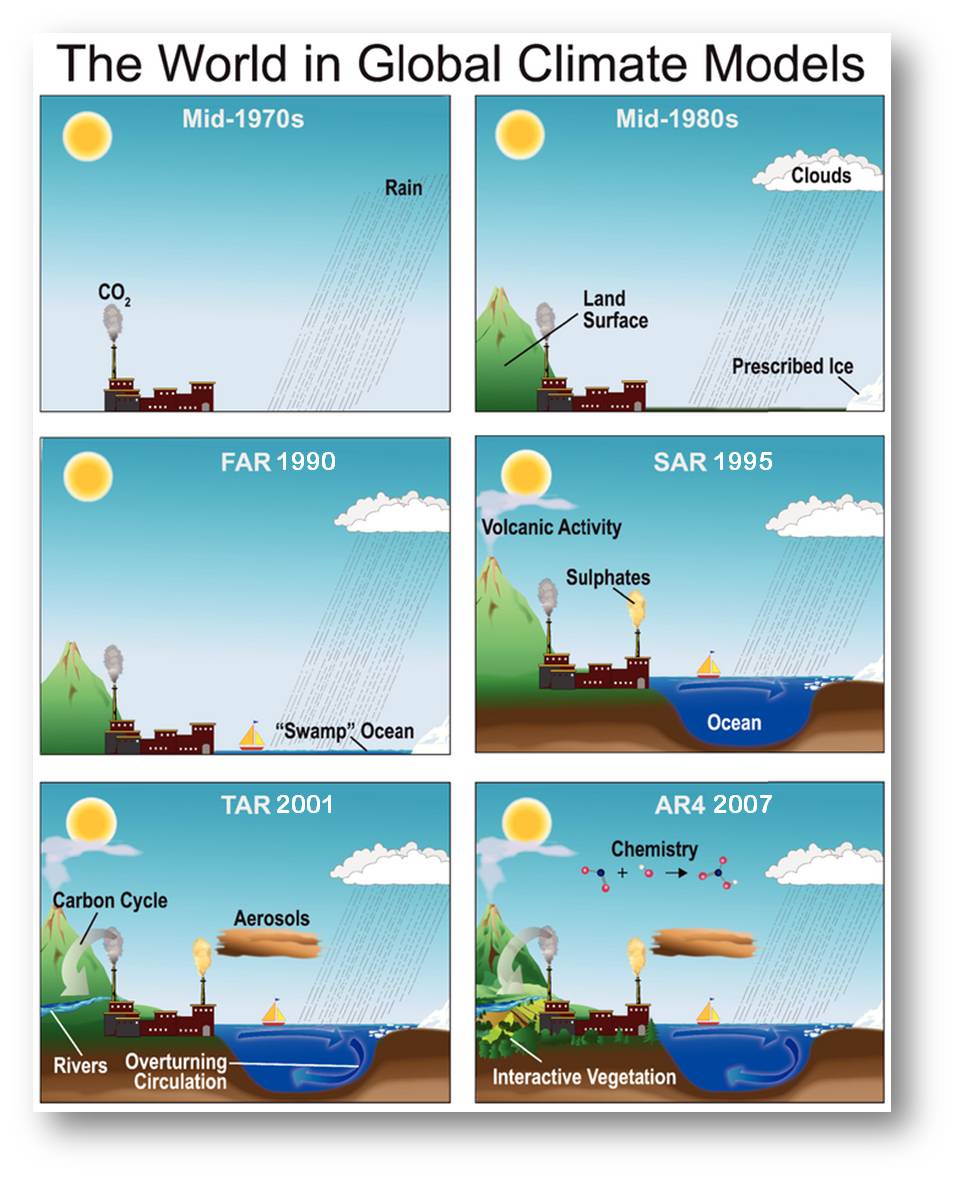

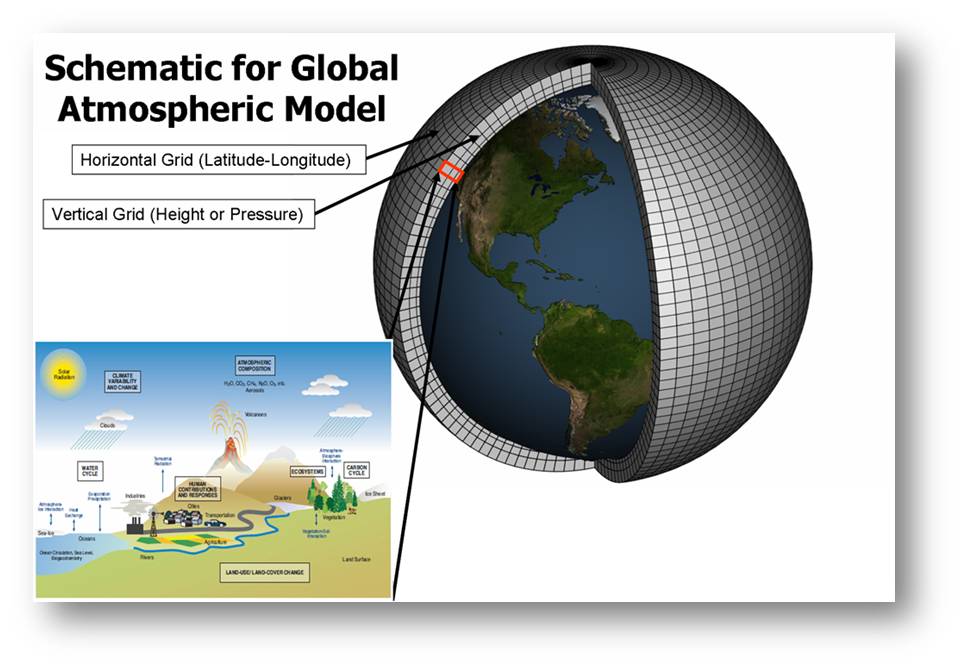

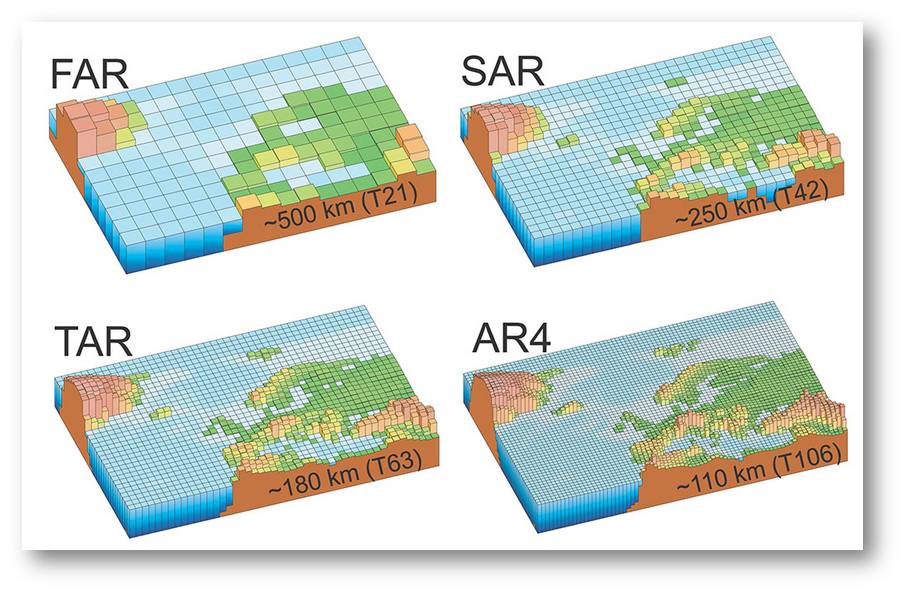

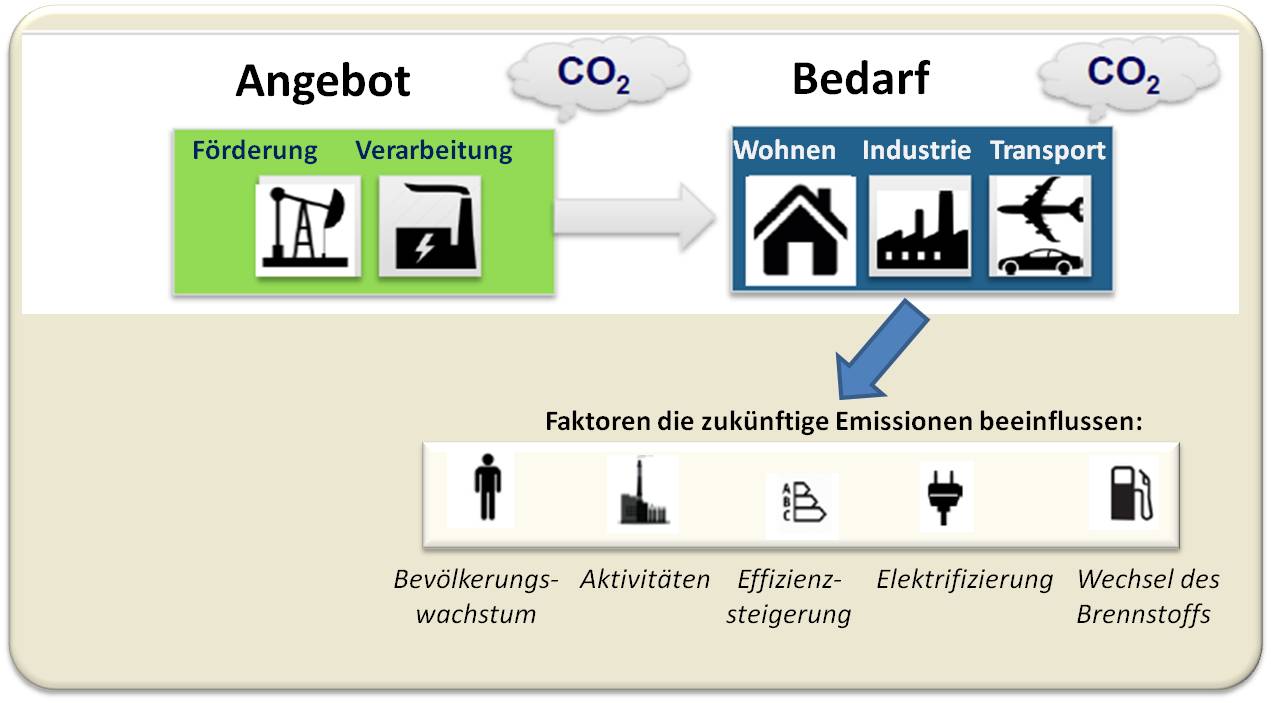

Man kann es nicht oft genug wiederholen: Klimamodelle bieten keine völlig korrekte Darstellung des Erdklimas und sind dazu auch nicht in der Lage. Das Klima ist ja von Natur aus chaotisch, eine Simulation mit 100% iger Genauigkeit daher nicht möglich. Dennoch können Modelle das globale Klima ziemlich gut wiedergeben. Wo und welche Probleme noch bestehen und welche Lösungen man erarbeitet, beschreibt der folgende Artikel , Teil 7 einer umfassenden, leicht verständlichen Serie "Q&A: How do climate models work?", die von der britischen Plattform Carbon Brief stammt (Teile 1 -6[1, 2, 3, 4, 5, 6].*

Wie genau Klimaprognosen ausfallen, hängt auch von der Qualität der Annahmen ab, die in die Modelle einfließen.

- Beispielsweise wissen Wissenschaftler ja nicht, ob die Treibhausgasemissionen sinken werden - sie nehmen daher Schätzungen vor, die auf verschiedenen Szenarien einer zukünftigen sozioökonomischen Entwicklung basieren. Dies erhöht die Unsicherheit der Klimaprojektionen.

- Ebenso gibt es künftige Aspekte, für die - auf Grund ihres in der Erdgeschichte so seltenen Auftretens - nur äußerst schwer Voraussagen gemacht werden können. Ein Beispiel dafür betrifft die Eisschilde: wenn diese abschmelzen könnten sie instabil werden und den erwarteten Anstieg des Meeresspiegels beschleunigen.

Klimamodelle werden immer komplizierter und anspruchsvoller - dennoch gibt es immer noch Aspekte des Klimasystems, die Modelle nicht so gut erfassen können, wie es die Wissenschaftler wünschen.

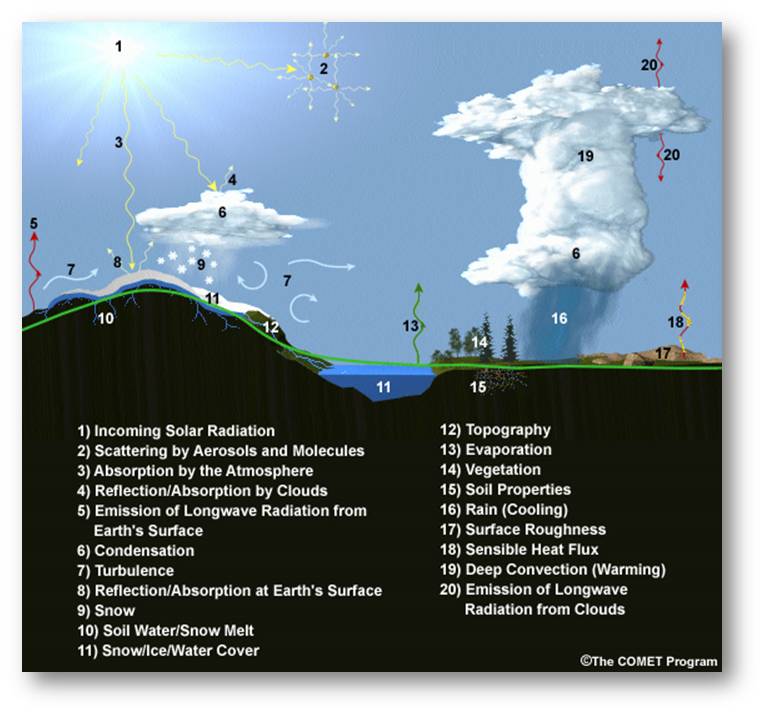

Das Problem Wolken

Eine der wesentlichen Einschränkungen der Klimamodelle liegt darin, wie gut sie Wolken darstellen können.

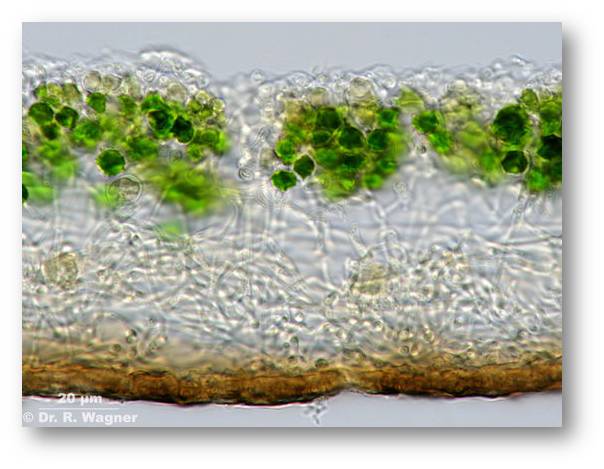

Wolken sind Klimaforschern ein ständiger Dorn im Auge. Sie bedecken jeweils rund zwei Drittel der Erdoberfläche, doch einzelne Wolken können sich innerhalb weniger Minuten bilden und auflösen, Wolken können den Planeten sowohl wärmen als auch kühlen; die hängt von der Art der Wolke ab und der Tageszeit. Dazu kommt, dass Wissenschaftler keine Aufzeichnungen darüber besitzen, wie Wolken in der fernen Vergangenheit beschaffen waren - damit wird es schwieriger festzustellen, ob und wie sie sich in der Zwischenzeit verändert haben.

In Hinblick auf die Schwierigkeiten beim Modellieren von Wolken tritt als besonderer Aspekt die Konvektion hervor. Dies ist der Prozess, bei dem die warme Luft an der Erdoberfläche durch die Atmosphäre emporsteigt, sich abkühlt und die darin enthaltene Feuchtigkeit dann zu Wolken kondensiert.

An heißen Tagen erwärmt sich die Luft schnell, was die Konvektion fördert. Dies kann zu heftigen Regenfällen von kurzer Dauer führen, die häufig von Donner und Blitzen begleitet werden.

Abbildung 1. Konvektionsströmung, die zu Wolkenbildung führt und auch zu Gewittern. Credit: Niccolò Ubalducci / Flickr (CC BY-NC-ND 2.0)

Abbildung 1. Konvektionsströmung, die zu Wolkenbildung führt und auch zu Gewittern. Credit: Niccolò Ubalducci / Flickr (CC BY-NC-ND 2.0)

Durch Konvektion verursachte Niederschläge können kurzfristig und stark lokalisiert auftreten. Um solche Niederschlagsereignisse zu erfassen, verfügen globale Klimamodelle über eine ungenügende, zu grobe Auflösung.

Wissenschaftler verwenden stattdessen „Parametrisierungen“ [6], welche die mittleren (durchschnittlichen) Auswirkungen der Konvektion über eine einzelne Gitterzelle darstellen. Dies bedeutet, dass Globale Klimamodelle (GCMs) keine individuellen Stürme und lokale Starkregenereignisse simulieren. Dies erklärt Dr. Lizzie Kendon, leitende Wissenschaftlerin für Klimaextreme am Met Office Hadley Center Carbon Brief gegenüber:

„GCMs sind nicht in der Lage, die Intensitäten der Niederschläge im Stundenraster und extreme Niederschläge im Sommer zu erfassen. Bei der groben Auflösung der globalen Modelle wäre die Verlässlichkeit stündlicher Regenprognosen oder konvektiver Extrema sehr niedrig“.

Um diesem Problem beizukommen, haben Wissenschaftler besonders hochauflösende Klimamodelle entwickelt. Diese haben Gitterzellen, die weniger als einige zehn Kilometer breit sind. Diese „Konvektion-berücksichtigenden“ Modelle können größere Konvektionsstürme simulieren, ohne dass eine Parametrisierung erforderlich ist.

Allerdings ist das ein Kompromiss: mehr in Details zu gehen bedeutet, dass die Modelle noch nicht den gesamten Globus abdecken können. Auch, wenn die Oberfläche kleiner geworden ist und Supercomputer verwendet werden, benötigen derartige Simulationen immer noch sehr lange Laufzeiten, vor allem, wenn Wissenschaftler viele Variationen des sogenannten Modell-Ensembles ausführen möchten. (zu Modell-Ensembles:siehe [4]).

Beispielsweise verwenden Simulationen, die Teil des Projekts IMPALA "Future Climate For Africa" ("Verbesserung von Modellprozessen für afrikanisches Klima") sind, Modelle, welche die Konvektion berücksichtigen und dies für ganz Afrika. Allerdings geschieht dies nur für einen Part des Ensembles, so Kendon. In ganz ähnlicher Weise wird das nächste Set der UK-Klimaprojektionen, das im nächsten Jahr fällig wird („UKCP18“) durchgeführt und zwar für 10 Ensemble-Modelle, jedoch nur für Großbritannien.

Es liegt aber noch ein weiter Weg vor uns, um Modelle, die Konvektion berücksichtigen, auf die globale Dimension ausdehnen zu können. Kendon drückt dies explizit so aus: "Es wird wahrscheinlich viele Jahre dauern, bis wir uns [die Rechenleistung für] konvektionsfähige globale Klimasimulationen leisten können, insbesondere für mehrere Simulationen eines Ensembles."

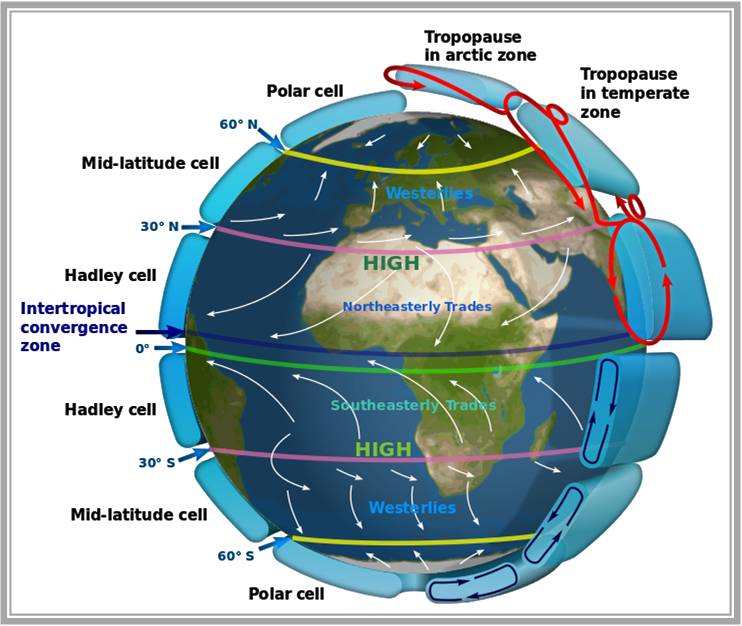

Die doppelte ITC Zone (innertropische Konvergenzzone)

Ähnlich wie das Wolken-Problem in den globalen Klimamodellen ist auch die "doppelte innertropische Konvergenzzone" zu sehen. Bei der innertropische Konvergenzzone (ITCZ) handelt es sich um einen riesigen Tiefdruckgürtel, der die Erde in Äquatornähe umgibt (Abbildung 2). Diese Zone regelt die jährlichen Niederschlagsmuster in einem Großteil der Tropengebiete und ist daher für Milliarden von Menschen ein äußerst wichtiges Klimaelement.

Abbildung 2. Die Innertropische Konvergenzzone (ITCZ) und die wesentlichen globalen Zirkulationssysteme in der Erdatmosphäre – Strömungen, die zwischen der warmen Luft in den Tropen und der kalten Luft in den Polgebieten ausgleichen. Dazu zählen die tropische Passatzirkulation (Hadley Zelle) zwischen 30oNord und 30o Süd, in der in Bodennähe Nordost-Passate oder Südostpassate in Richtung Äquator und polwärts - wegen der Corioloskraft - westlich gerichtete Winde wehen. In der Polarzelle treffen die entgegengesetzt strömenden Luftmassen von Polarluft und subtropischer Warmluft zusammen. (Quelle: Kaidor; CC BY-SA 3.0 from Wikimedia Commons)

Abbildung 2. Die Innertropische Konvergenzzone (ITCZ) und die wesentlichen globalen Zirkulationssysteme in der Erdatmosphäre – Strömungen, die zwischen der warmen Luft in den Tropen und der kalten Luft in den Polgebieten ausgleichen. Dazu zählen die tropische Passatzirkulation (Hadley Zelle) zwischen 30oNord und 30o Süd, in der in Bodennähe Nordost-Passate oder Südostpassate in Richtung Äquator und polwärts - wegen der Corioloskraft - westlich gerichtete Winde wehen. In der Polarzelle treffen die entgegengesetzt strömenden Luftmassen von Polarluft und subtropischer Warmluft zusammen. (Quelle: Kaidor; CC BY-SA 3.0 from Wikimedia Commons)

Die ITC Zone verschiebt sich während des Jahres über die Tropen hin nach Norden und Süden und folgt dabei grob dem Sonnenstand in den Jahreszeiten. Globale Klimamodelle erzeugen die ITCZ in ihren Simulationen - sie entsteht als Folge der Wechselwirkung zwischen den einzelnen physikalischen Prozessen, die im Modell eingegeben sind. Wie jedoch US-Wissenschaftler vom Caltech erläutern, gibt es einige Gebiete, in denen Klimamodelle Schwierigkeiten haben, die Position der ITCZ korrekt darzustellen (https://doi.org/10.1175/JCLI-D-15-0328.1):

“Im östlichen Pazifik liegt die ITCZ den Großteil des Jahres über nördlich des Äquators und mäandriert einige wenige Breitengrade um den sechsten Breitengrad. Für einen kurzen Zeitraum im Frühjahr spaltet sich die Zone jedoch in zwei ITCZs auf beiden Seiten des Äquators auf. Die derzeitigen Klimamodelle übertreiben diese Aufspaltung in zwei ITCZs, was zur bekannten Doppel-ITCZ-Verzerrung der Modelle führt“.

Die meisten Globalen Klimamodelle zeigen zu einem gewissen Grad das doppelte ITCZ-Problem; dies führt dazu, dass sie für einen Großteil der Tropen der südlichen Hemisphäre zu viel Regen simulieren und für den Pazifik am Äquator manchmal zu wenig Regen.

Die doppelte ITC Zone "ist vielleicht der wichtigste und permanenteste systematische Fehler in aktuellen Klimamodellen", sagt Dr. Baoqiang Xiang, ein leitender Wissenschaftler am Geophysical Fluid Dynamics Laboratory der National Oceanic and Atmospheric Administration in den USA. Daraus ergibt sich vor allem: Modellierer halten Vorhersagen, wie sich die ITC Zone im Verlauf der Klimaerwärmung ändern könnte, für weniger verlässlich. Es gibt aber auch weitere Beeinflussungen, sagt Xiang zu Carbon Brief:

„Zum Beispiel prognostizieren die meisten aktuellen Klimamodelle einen abgeschwächten Passatwind und eine Abschwächung der Walker-Zirkulation (d.i. ein Strömungskreislauf der Luft über dem äquatorialem Pazifik; Anm. Redn). Die Existenz des doppelten ITCZ-Problems könnte zu einer Unterschätzung dieses geschwächten Passatwinds führen."

(Passatwinde sind annähernd konstante östliche Winde, welche beiderseits des Äquators um die Erde zirkulieren.)

Darüber hinaus legt eine 2015 erschienen Studie (in Geophysical Research Letters) nahe, dass die doppelte ITCZ die Rückkopplungen von Wolken und Wasserdampf in Modellen beeinflusst und daher für die Klimasensitivität# eine Rolle spielt. Man fand heraus, "dass Modelle mit einer starken doppelten ITC Zone einen niedrigeren Wert für die Gleichgewichts-Klimasensitivität (ECS) aufweisen, was darauf hindeutet, dass „die meisten Modelle die ECS unterschätzt haben“. Wenn Modelle aber die ECS unterschätzen, wird sich als Reaktion auf vom Menschen verursachte Emissionen das Klima stärker erwärmen, als es die aktuellen Prognosen vermuten lassen.

Die Ursachen für die doppelte ITCZ in Modellen sind komplex und waren Gegenstand zahlreicher Studien, erklärt Xiang gegenüber Carbon Brief. Nach seiner Meinung gibt es eine Reihe von ursächlichen Faktoren, einschließlich der Art und Weise, wie Konvektion in Modellen parametrisiert wird.

Beispielsweise kam ein 2012 veröffentlichter Artikel (in den Proceedings der National Academy of Sciences) zu dem Schluss, dass das Problem daher rührt, dass die meisten Modellen nicht genügend dicke Wolken über dem "oft bedeckten Südozean" erzeugen. Dies führt dann zu höheren Temperaturen über der Südhemisphäre als üblich und auch zur Verschiebung der tropischen Niederschläge nach Süden.

Fragt man danach, wann Wissenschaftler dieses Problem lösen werden können, so lässt sich darauf laut Xiang nur schwer eine Antwort finden:

„Meiner Meinung nach werden wir dieses Problem in den kommenden zehn Jahren möglicherweise nicht vollständig lösen können. Mit dem verbesserten Verständnis der Modell-Physik, der Erhöhung der Modellauflösung und verlässlicheren Beobachtungen haben wir jedoch bedeutende Fortschritte erzielt.“

Jetstreams (Strahlströme)

Ein weiteres allgemeines Problem bei Klimamodellen betrifft schließlich die Position von Jetstreams in den Klimamodellen. Jet Streams sind mäandrierende Flüsse von Hochgeschwindigkeitswinden, die hoch in der Atmosphäre strömen. Sie können Wettersysteme von Westen nach Osten über die ganze Erde fließen lassen.

Abbildung 3. NASA Visualisierung des Europäischen Jetstream (screenshot). Dieser wird durch das Zusammentreffen kalter absinkender Luftmassen aus der Arktis und aufsteigender warmer Luft aus den Tropen erzeugt - es ist ein strömendes Band aus westlichen Winden, das rund um den Planeten mäandriert. Die Visualisierung verwendet Wetter-und Klimabeobachtungen des NASA MERRA Daten Modell. Video 1:23 min. https://www.youtube.com/watch?time_continue=3&v=Xybvt-J-7Og (Credit: NASA's Scientific Visualization Studio. The Blue Marble data is courtesy of Reto Stockli (NASA/GSFC)

Abbildung 3. NASA Visualisierung des Europäischen Jetstream (screenshot). Dieser wird durch das Zusammentreffen kalter absinkender Luftmassen aus der Arktis und aufsteigender warmer Luft aus den Tropen erzeugt - es ist ein strömendes Band aus westlichen Winden, das rund um den Planeten mäandriert. Die Visualisierung verwendet Wetter-und Klimabeobachtungen des NASA MERRA Daten Modell. Video 1:23 min. https://www.youtube.com/watch?time_continue=3&v=Xybvt-J-7Og (Credit: NASA's Scientific Visualization Studio. The Blue Marble data is courtesy of Reto Stockli (NASA/GSFC)

Wie es auch bei der ITC Zone der Fall ist, erzeugen Klimamodelle Jetstreams aufgrund der in ihrem Code enthaltenen grundlegenden physikalischen Gleichungen.

Jetstreams scheinen jedoch in Modellen oft zu "zonal" zu sein - mit anderen Worten, sie fallen zu stark und zu geradlinig aus, erklärt Dr. Tim Woollings, Dozent für physikalische Klimawissenschaft an der Universität Oxford und ehemaliger Leiter der gemeinsamen Met Office/Universities Process Evaluierungsgruppe on Blocking and Storm Tracks. Er sagt Carbon Brief:

„In der realen Welt schert der Jet etwas nach Norden aus, wenn er den Atlantik überquert (und ein Stück den Pazifik). Weil Modelle dies unterschätzen, ist der Jet im Durchschnitt oft zu weit in Richtung Äquator orientiert.“

Dies führt dazu, dass Modelle nicht immer korrekt auf den Bahnen - den sogenannten Sturmbahnen - liegen, welche Niederdruck-Wetter einschlagen. In Modellen sind Stürme oft zu träge, sagt Woollings, und sie erreichen nicht die ausreichende Stärke und klingen zu schnell ab. Es gibt Möglichkeiten, dies zu verbessern, und einige sind zielführender als andere. Im Allgemeinen kann es hilfreich sein, wenn man die Auflösung des Modells erhöht sagt Woollings:

„Wenn wir beispielsweise die Auflösung erhöhen, werden die Gipfel der Berge etwas höher und dies trägt dazu bei, die Jets etwas nach Norden abzulenken. Es passieren auch kompliziertere Dinge; wenn wir bessere, aktivere Stürme simulieren können, kann dies einen Dominoeffekt auf den Jet-Stream haben, der teilweise von den Stürmen angetrieben wird.“

(Mit zunehmender Auflösung des Modells werden Berggipfel höher, da das Modell durch die größeren Details mehr vom Berg "sehen" kann, wenn er sich nach oben hin verengt.)

"Eine weitere Option besteht darin , dass man verbessert, wie das Modell die Physik der Atmosphäre in seinen Gleichungen darstellt," fügt Woollings hinzu und zwar "mittels neuer, cleverer Formen, um die Strömungsmechanik im Computercode zu approximieren".

# Klimasensitivität: Die Erwärmung, die wir erwarten können, wenn das Kohlendioxid in der Atmosphäre doppelt so hoch ist wie vor der industriellen Revolution. Es gibt zwei Arten Klimasensitivität zu definieren: Der Transient Climate Response (TCR) ist die Erwärmung an der Erdoberfläche, die wir zum Zeitpunkt der CO2-Verdoppelung erwarten können, die Gleichgewichts-Klimasensitivität (ECS) ist dagegen die gesamte Erwärmung, wenn die Erde Zeit gehabt hat sich an das zusätzliche Kohlendioxid anzupassen.

* *Der Artikel ist der Homepage von Carbon Brief: "Q&A: How do climate models work?" entnommen (https://www.carbonbrief.org/qa-how-do-climate-models-work). Unter dem Titel" What are the main limitations in climate modeling at the moment?" ist es die Fortsetzung einer, von mehreren Autoren stammenden Serie, die am 15. Jänner 2018 online gestellt wurde. Die unter einer cc-by-nc-nd 4.0 Lizenz stehenden Artikel wurden im Einverständnis mit Carbon Brief möglichst wortgetreu von der Redaktion aus dem Englischen übersetzt und von Carbon Brief freigegeben.

Carbon Brief - https://www.carbonbrief.org/ - ist eine britische Website, welche die neuesten Entwicklungen in den Bereichen Klimawissenschaft, Klimapolitik und Energiepolitik abdeckt. Die Seite bemüht sich um klare Daten-basierte Artikel und Illustrationen, um mitzuhelfen das Verstehen des Klimawandels von Seiten der Wissenschaft und auch der Politik zu verbessern . Im Jahr 2017 wurde Carbon Brief bei den renommierten Online Media Awards als"Best Specialist Site for Journalism" ausgezeichnet.

Weiterführende Links

Informationen zu Carbon Brief: https://www.carbonbrief.org/about-us

Carbon Brief: What's causing global warming? Video 1:22 min. (14.12.2017)

David Attenborough: Climate Change - Britain Under Threat Video 1:00:14 (2013)

Max-Planck-Gesellschaft: Klimamodelle - die Welt im Computer (26.10.2015), Video 5:05 min. Standard YouTube Lizenz.

CarbonBrief im ScienceBlog

[1] Teil 1 (19.04.2018): Was Sie schon immer über Klimamodelle wissen wollten – eine Einführung

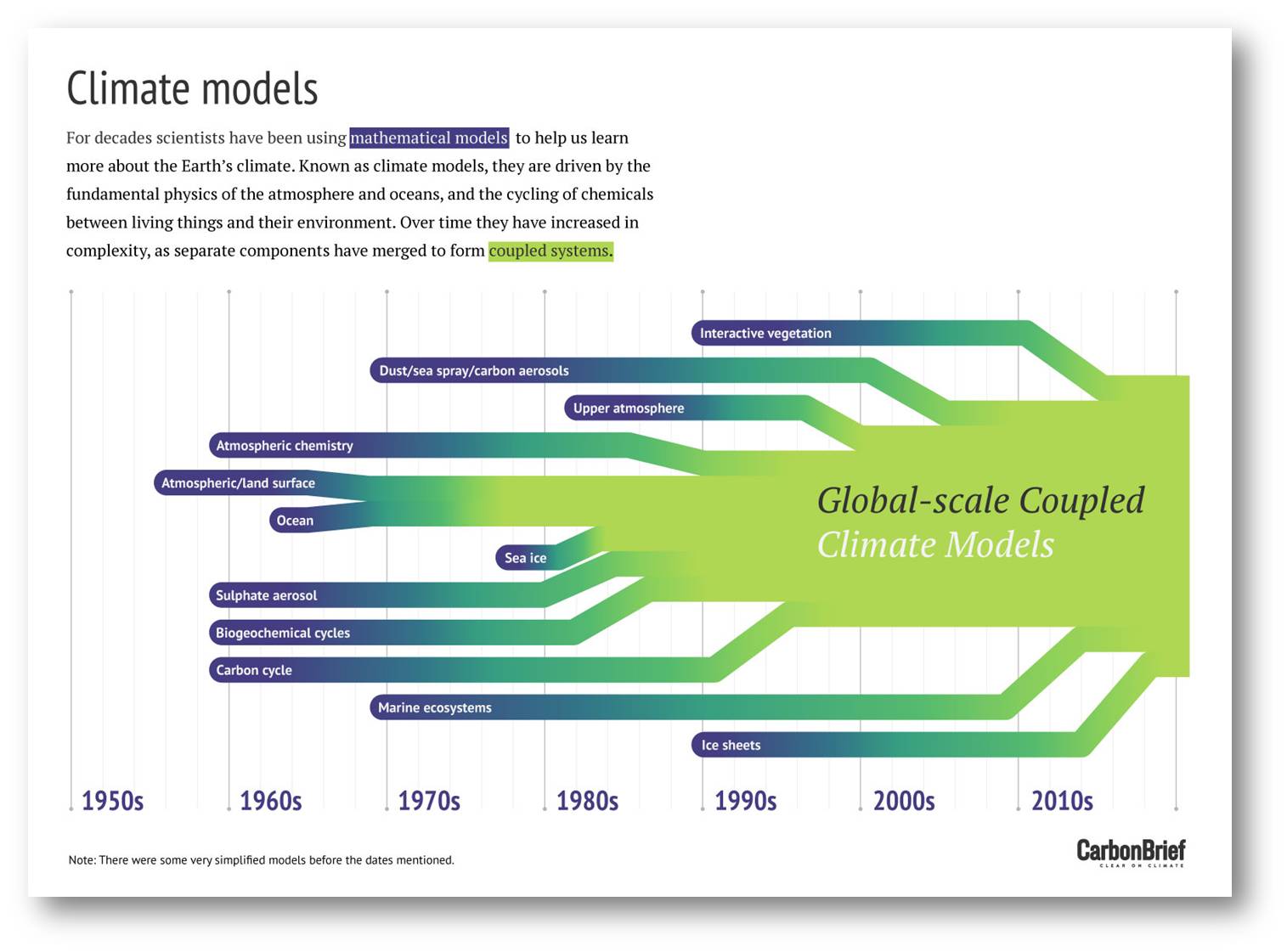

[2] Teil 2 (31.05.2018): Klimamodelle: von einfachen zu hoch komplexen Modellen

[3] Teil 3 (21.06.2018): Klimamodelle: Rohstoff und Produkt — Was in Modelle einfließt und was sie errechnen

[4] Teil 4 (23.8.2018): Welche Fragen stellen Wissenschaftler an Klimamodelle , welche Experimente führen sie durch?

[5] Teil 5 (20.09.2018).: Wer betreibt Klimamodellierung und wie vergleichbar sind die Ergebnisse?

[6] Teil 6 (1.11.2018): Klimamodelle: wie werden diese validiert?

Comments

Das ›Hot Model‹-Problem

In seinem jüngsten ›Assessment Report‹ AR6, adressiert das IPCC ein Problem, dass einige Modelle eine stärkere Erwärmung zeigen, als durch Evidenz belegt werden kann. Das kann zum Problem werden, wenn Wissenschaft, Politik, Medien und Öffentlichkeit aus Unwissen mit derartigen Modellen umgehen.

Zu diesem Problem hier eine Leseempfehlung (Englisch): https://www.nature.com/articles/d41586-022-01192-2

(Der Artikel erklärt auch, warum dieses Problem erst jetzt, mit immer komplexer werdenden Modellen, zutage tritt.)

- Log in to post comments

Krankenhausinfektionen – Keime können auch aus dem Mikrobiom des Patienten stammen

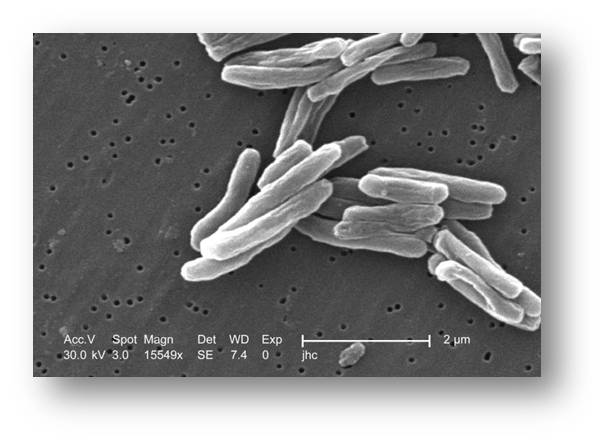

Krankenhausinfektionen – Keime können auch aus dem Mikrobiom des Patienten stammenDo, 29.11.2018 - 09:40 — Francis S. Collins

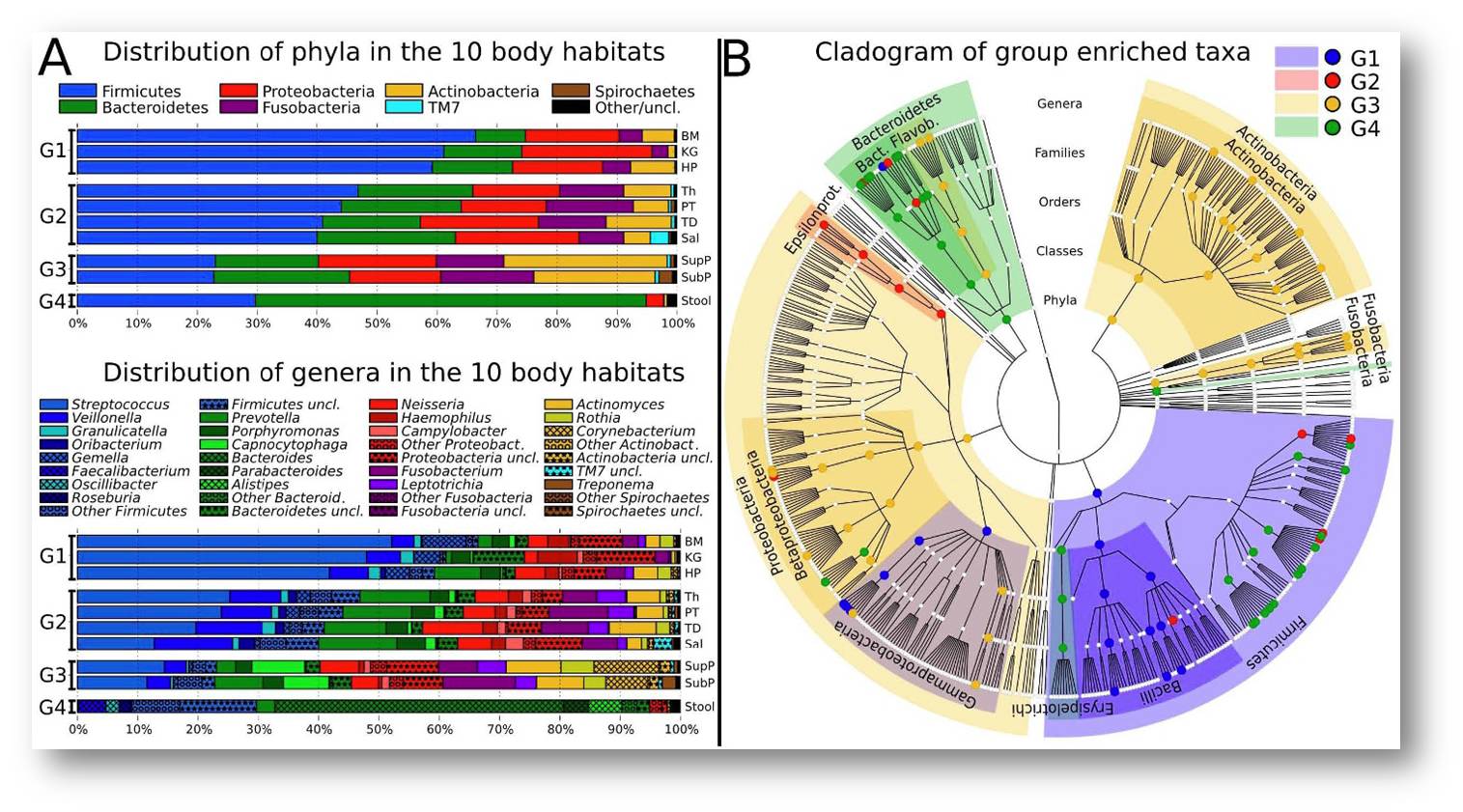

![]() Weltweit erkranken Millionen Patienten an lebensbedrohenden Infektionen, die sie sich während ihres Aufenthalts im Krankenhaus zuziehen und zig-Tausende sterben daran . Bis jetzt wurden dafür Im wesentlichen unzureichende hygienische Bedingungen in den Spitälern verantwortlich gemacht. Eine neue Studie an Knochenmark-transplantierten und dementsprechend immunsupprimierten Patienten zeigt nun, dass die infektiösen Keime auch aus dem Mikrobiom des Darms der Patienten selbst stammen können und bietet damit neue Ansätze zu Prävention und Therapie derartiger Infektionen [1]. Francis Collins, NIH-Direktor und ehem. Leiter des "Human Genome Project", berichtet über diese wegweisenden Ergebnisse.*

Weltweit erkranken Millionen Patienten an lebensbedrohenden Infektionen, die sie sich während ihres Aufenthalts im Krankenhaus zuziehen und zig-Tausende sterben daran . Bis jetzt wurden dafür Im wesentlichen unzureichende hygienische Bedingungen in den Spitälern verantwortlich gemacht. Eine neue Studie an Knochenmark-transplantierten und dementsprechend immunsupprimierten Patienten zeigt nun, dass die infektiösen Keime auch aus dem Mikrobiom des Darms der Patienten selbst stammen können und bietet damit neue Ansätze zu Prävention und Therapie derartiger Infektionen [1]. Francis Collins, NIH-Direktor und ehem. Leiter des "Human Genome Project", berichtet über diese wegweisenden Ergebnisse.*

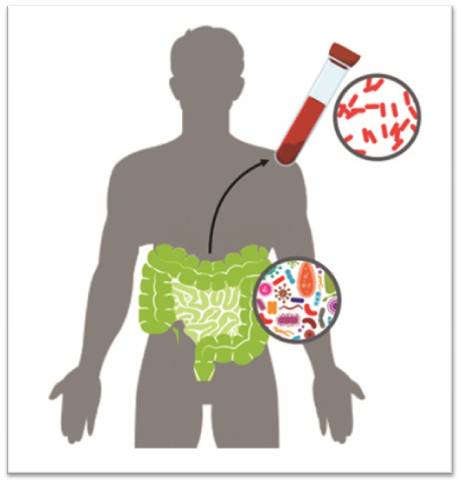

Während ihrer Behandlung im Krankenhaus erkranken erschreckend viele Patienten an lebensbedrohender Sepsis - d.i. an Infektionen in der Blutbahn. Man hat angenommen, dass dafür Mikroben verantwortlich sind, die hauptsächlich auf medizinischen Geräten herumsitzen und auf dem Spitalspersonal oder auch auf anderen Patienten und Besuchern auf ihre Opfer lauern. Das ist auch sicherlich oft der Fall. Nun hat ein von den National Institutes of Health (NIH) gefördertes Team herausgefunden, dass ein erheblicher Teil dieser Krankenhausinfektionen tatsächlich aus einer ganz anderen Quelle stammen kann, nämlich aus dem Körper des Patienten selbst.

In einer Studie an 30 Knochenmark-transplantierten Patienten, die an Blutinfektionen litten, wendeten die Forscher ein neu entwickeltes Bioinformatik Tool namens StrainSifter ("Stamm-Prüfer", Anm. Redn) an: in mehr als einem Drittel der Fälle entsprach die DNA-Sequenz der infektiösen Keime jener DNA , die bereits im Dickdarm der Patienten lebende Mikroorganismen aufwiesen [1] . Dafür, dass derartige Keime von Patient zu Patient übertragen werden, fanden die Forscher auf Basis der DNA-Datenaber kaum Hinweise.

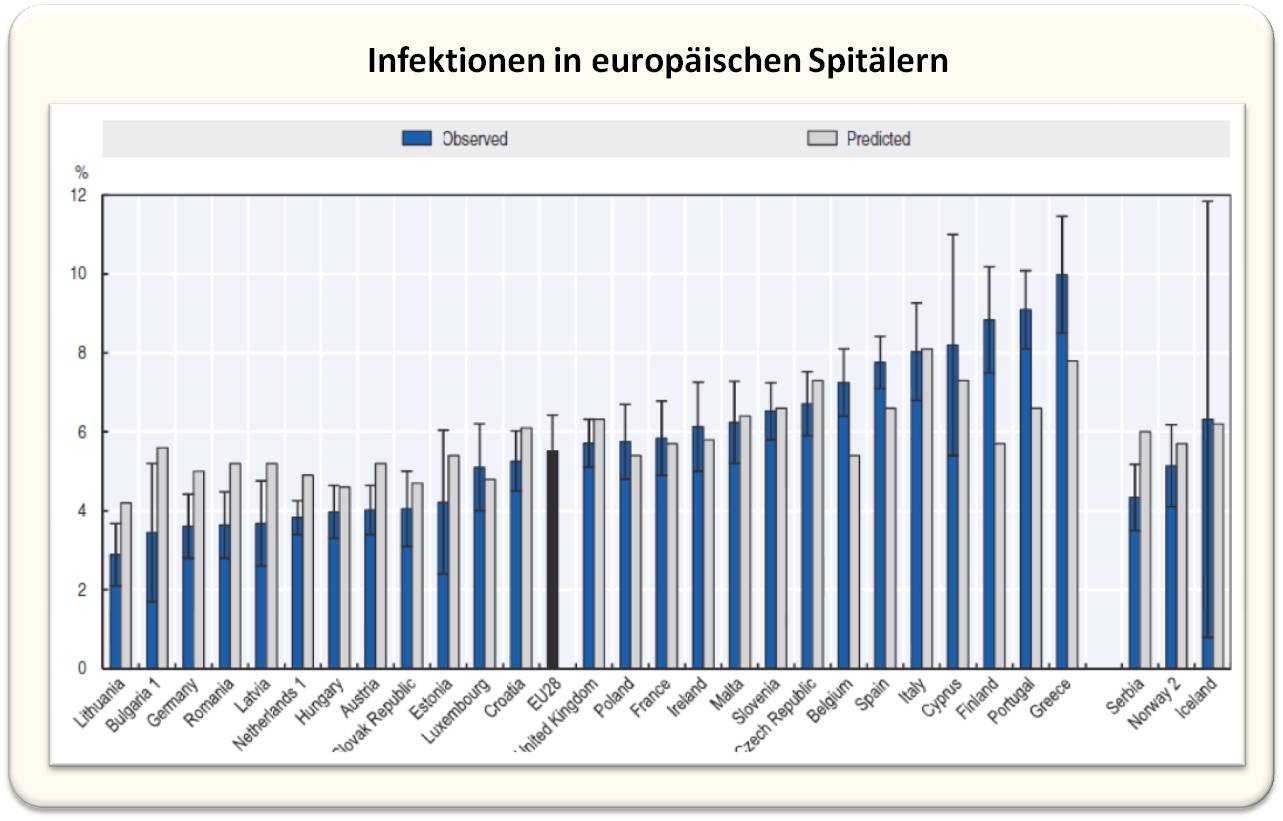

Infektionen im Krankenhaus

In den Vereinigten Staaten erleidet etwa einer von 50 Patienten mindestens eine Infektion während seines Krankenhausaufenthalte [2]. Solche Infektionen sind jedes Jahr für Zehntausende von Todesfällen verantwortlich und sind in den Vereinigten Staaten eine der häufigsten Todesursachen [3].

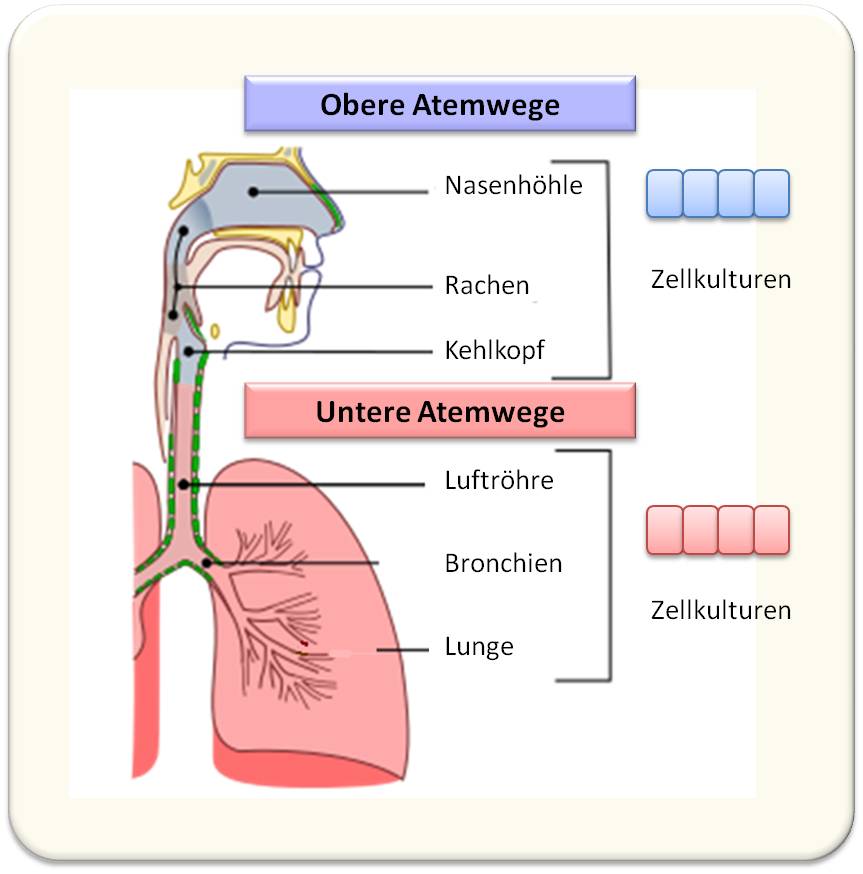

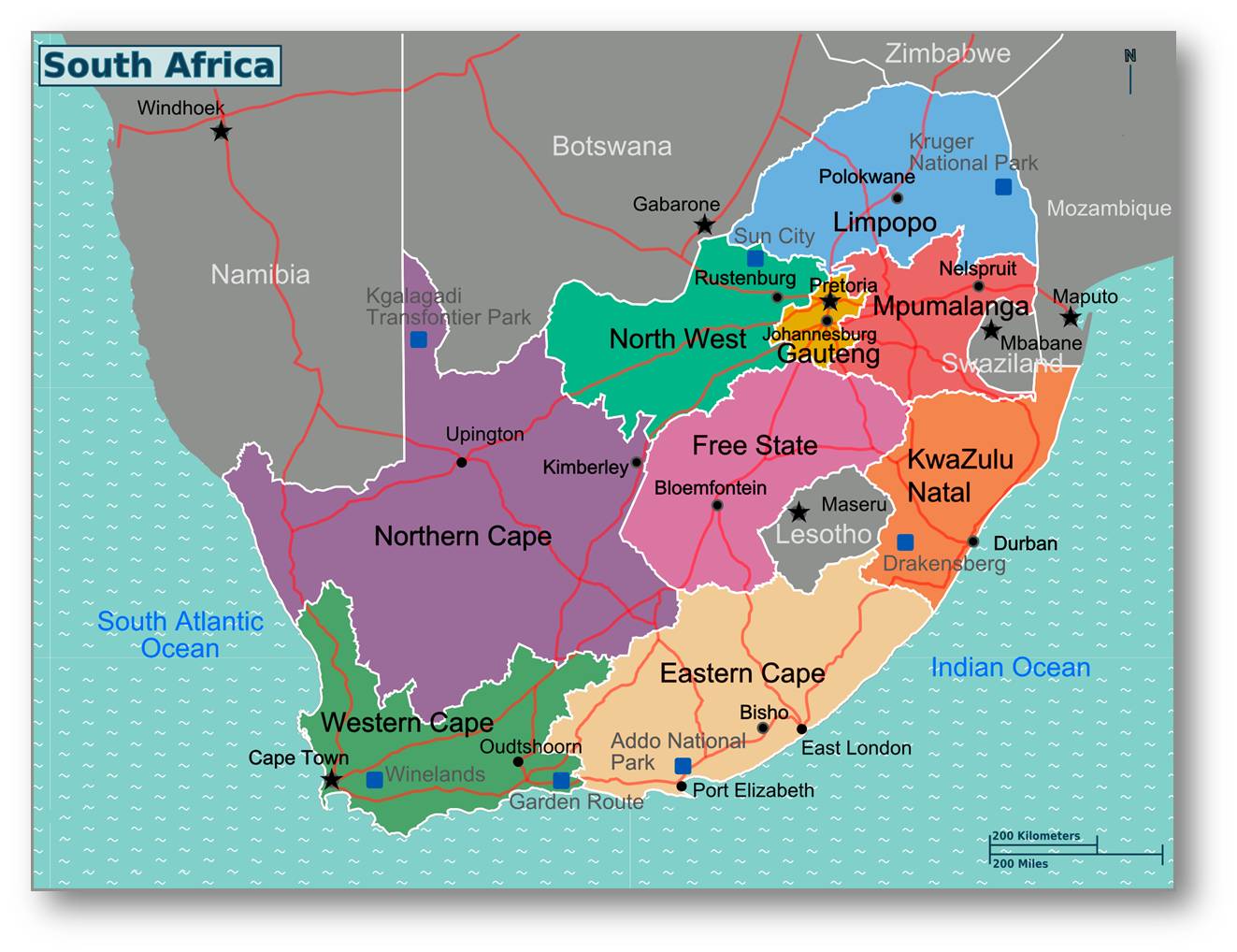

Auch in Europa zählen Infektionen im Krankenhaus zu den häufigen Erkrankungen (Abbildung 1) und fordern auch hier sehr viele Todesopfer. (Text und Bild von der Redn. eingefügt)

Abbildung 1. Anteil der Patienten, die im Zeitraum 2016 - 2017 zumindest an einer im Spital hervorgerufenen Infektion erkrankt sind. (Bild und Text von der Redaktion eingefügt, Quelle: ECDC 2016-17 Point prevalence survey)

Was ist die Ursache von Krankenhausinfektionen?

Während ihrer Assistenzzeit in der Inneren Medizin erweckten im Krankenhaus erworbene Infektionen das Interesse von Ami Bhatt (Stanford University, Palo Alto, Kalifornien). Als ihre Patienten Sepsis entwickelten, ging Bhatt daran die Ursache dafür festzustellen. Sie erkannte aber bald, dass es kompliziert werden würde den Ursprung der Infektion zu bestimmen.

Als Bhatt über mögliche Quellen der im Krankenhaus erworbenen Infektionen nachdachte, zog sie auch das Mikrobiom in Erwägung - die Tausenden von Mikroben, die auf ganz natürliche Weise in und auf dem menschlichen Körper leben. In zunehmendem Maße werden wir ja vieler wichtiger Funktionen des Mikrobioms gewahr, die es auf unseren Stoffwechsel, unsere Immunität und sogar auf unsere psychische Gesundheit ausübt. Bhatt überlegte nun, ob Keime aus dem Mikrobiom in den Blutkreislauf mancher Patienten gelangen könnten, insbesondere bei Patienten, deren Immunsystem bereits beeinträchtigt ist.

Die Studie an immunsupprimierten Patienten

Mit ihren Kollegen (darunter den Erstautoren der Studie Fiona Tamburini und Tessa Andermann) konzentrierte sich Bhatt auf den Darm, der ja natürlicher Lebensraum für viele Hunderte verschiedene Arten von Mikroben ist. Ihr Team rekrutierte Patienten, die sich im Stanford University Hospital einer Transplantation des Knochenmarks unterzogen und sammelte von ihnen wöchentliche Stuhlproben; jede dieser Proben enthielt eine Fülle mikrobiellen Lebens, das aus dem Darm stammte.

Patienten, die Knochenmark transplantiert bekommen, erhalten Medikamente, um das Immunsystem zu supprimieren, um ihren Organismus davon abzuhalten die kostbaren Spenderzellen zu attackieren. Aufgrund des supprimierten Immunsystems sind solche Patienten aber auch einem erhöhten Infektionsrisiko ausgesetzt.

Erkrankte nun ein Transplantationspatient an einer Sepsis - und zwar innerhalb von 30 Tagen nachdem man die Darmmikroben enthaltenden Stuhlproben gesammelt hatte -, so isolierten die Forscher das verursachende Bakterium aus dem Blut, brachten es Kultur und sequenzierten seine DNA.

Der nächste Schritt bestand dann darin, dass sie untersuchten ob es eine exakte Übereinstimmung zwischen der DNA des Infektionserregers und der DNA eines Bakteriums in der Stuhlprobe des Patienten geben könnte. Dies würde dann darauf hindeuten , dass der Infektionserreger aus dem Mikrobiom des Darms stammte.

Ein überaus schwieriges Unterfangen

Obwohl vom Konzept her simpel, war die Durchführung dieser Untersuchung dann alles andere als einfach. Die Forscher mussten ja die DNA eines einzelnen Infektionserregers mit all den DNA-Sequenzen vergleichen, die man von den Hunderten im Darm ansässigen Mikroben - dem Darmmikrobiom - bestimmt hatte. Es war eine Analyse, die zudem extreme Präzision erforderte. Es war eine Herausforderung, welche die Forscher so beschrieben: Man setzt viele Hunderte verschiedener Fotografien zusammen, die zuvor in kleine Stücke geschnitten, zusammengemischt und aufgeschüttelt worden waren, bevor man dann versucht die wieder hergestellten Fotos mit einem anderen Foto abzugleichen.

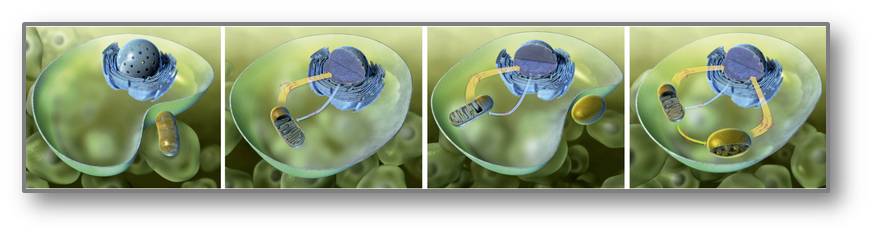

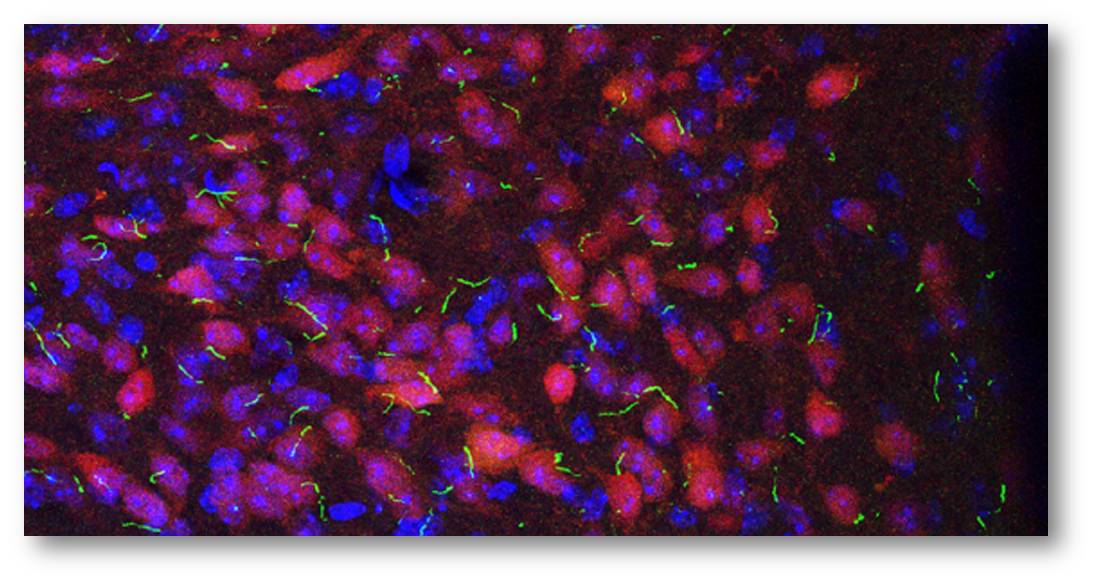

Die Forscher schafften diese schwierige Aufgabe mit ihrem Bioinformatik Tool StrainSifter. Sie konnten damit zeigen, dass in mehr als einem Drittel der Stuhlproben genau der gleiche Bakterienstamm enthalten war, der den jeweiligen Patienten krank gemacht hatte. Abbildung 2.

Abbildung 2. Sepsis im Krankenhaus: Mittels eines neuen Bioinformatik Tools wurde nachgewiesen ob ein, in der Blutbahn entdeckter Infektionserreger aus dem Mikrobiom des Darms stammt. (Credit: Fiona Tamburini, Stanford University, Palo Alto, CA)

Abbildung 2. Sepsis im Krankenhaus: Mittels eines neuen Bioinformatik Tools wurde nachgewiesen ob ein, in der Blutbahn entdeckter Infektionserreger aus dem Mikrobiom des Darms stammt. (Credit: Fiona Tamburini, Stanford University, Palo Alto, CA)

Interessanterweise gab es aber kaum Anzeichen dafür, dass diese Stämme auch im Blut oder im Stuhl anderer Patienten im selben Krankenhaus gefunden wurden. Mit anderen Worten, die Keime schienen sich nicht von Person zu Person auszubreiten.

Die Ergebnisse weisen darauf hin,

dass viele der an Sepsis Erkrankten sich die Infektion nicht aus der Umgebung oder von einer anderen Person zugezogen hatten, sondern vielmehr aufgrund eines mikrobiellen Ungleichgewichts im eigenen Körper. Bhatt merkte an, dass die Studienteilnehmer im Krankenhaus häufig intensiv mit Antibiotika und anderen Medikamenten behandelt wurden. Ohne sorgfältige Behandlung könnten ihre Körper zu Brutstätten für infektiöse und antibiotikaresistente Bakterien werden.

Tatsächlich bestätigten die klinischen Befunde und die DNA-Daten, dass Antibiotika-resistente Stämme von Escherichia coli und Klebsiella-pneumoniae im Verdauungstrakt vorlagen, Keime, die häufige Ursachen für schwere Lungenentzündung, Harnwegsinfektionen und andere möglicherweise schwere Infektionen sind. Darüber hinaus fanden sich im Darm dieser Knochenmark-Empfänger auch andere Krankheitserreger, die man dort nicht vermutet hätte (beispielweise Pseuomonas aeruginosa und Staphylococcus epidermiis; von Rdn. ergänzt).

Fazit

Wenn optimale Hygienepraktiken auch nach wie vor für die Prävention von Krankenhausinfektionen entscheidend sind, so lassen die neuen Ergebnisse darauf schließen, dass diese Prävention komplizierter sein kann als man ursprünglich dachte. Um die Infektionsquelle korrekt zu identifizieren, kann es notwendig sein das individuelle Mikrobiom jedes Patienten in Betracht zu ziehen. Die gute Nachricht: mit den zunehmenden Möglichkeiten die Quelle von Blutinfektionen zu ermitteln, wird dies dem Gesundheitssystem helfen, gezieltere und effektivere Methoden zu entwickeln, um Krankenhausinfektionen künftig zu verhindern und in den Griff zu bekommen.

[1] Precision identification of diverse bloodstream pathogens in the gut microbiome. Tamburini FB, Andermann TM, Tkachenko E, Senchyna F, Banaei N, Bhatt AS. Nat Med. 2018 Oct 15. DOI:10.1038/s41591-018-0202-8.

[2] Health-care Associated Infection Data. Centers for Disease Control and Prevention.

[3] Estimating health care-associated infections and deaths in U.S. hospitals, 2002. Klevens RM, Edwards JR, Richards CL Jr, Horan TC, Gaynes RP, Pollock DA, Cardo DM. Public Health Rep. 2007 Mar-Apr;122(2):160-6.

* Dieser Artikel von NIH Director Francis Collins, M.D., Ph.D. erschien unter dem Titel: " Some ‘Hospital-Acquired’ Infections Traced to Patient’s Own Microbiome" " zuerst (am 23. Oktober 2018) im NIH Director’s Blog. https://directorsblog.nih.gov/2018/10/23/some-hospital-acquired-infections-traced-to-patients-own-microbiome/ Der Artikel wurde von der Redaktion möglichst wortgetreu aus dem Englischen übersetzt und geringfügig (mit Untertiteln) für den Blog adaptiert. Zur Illustration wurden Abbildung 1 (plus Text) von der Redaktion eingefügt. Reprinted (and translated by ScienceBlog) with kind permission from the National Institutes of Health (NIH).

Weiterführende Links

- National Institutes of Health (NIH) in Bethesda (Maryland).

- Bhatt Lab (Stanford University, Palo Alto, CA)

- OECD/EU (2018), Health at a Glance: Europe 2018: State of Health in the EU Cycle,

OECD Publishing, Paris

Artikel zu ähnlichen Themen im ScienceBlog

- Francis Collins, 18.09.2017 Ein erweiterter Blick auf das Mikrobiom des Menschen

- Redaktion, 10.05.2018: Anton Weichselbaum und das menschliche Mikrobiom - ein Vortrag vor 125 Jahren

- Redaktion, 22.11.2018: Eurobarometer 478: zum Wissenstand der EU-Bürger über Antibiotika, deren Anwendung und Vermeidung von Resistenzentstehung

- Inge Schuster, 23.09.2016: Gehen wir auf eine Post-Antibiotika Ära zu?

Eurobarometer 478: zum Wissenstand der EU-Bürger über Antibiotika, deren Anwendung und Vermeidung von Resistenzentstehung

Eurobarometer 478: zum Wissenstand der EU-Bürger über Antibiotika, deren Anwendung und Vermeidung von ResistenzentstehungDo, 22.11.2018 - 06:07 — redaktion

![]()

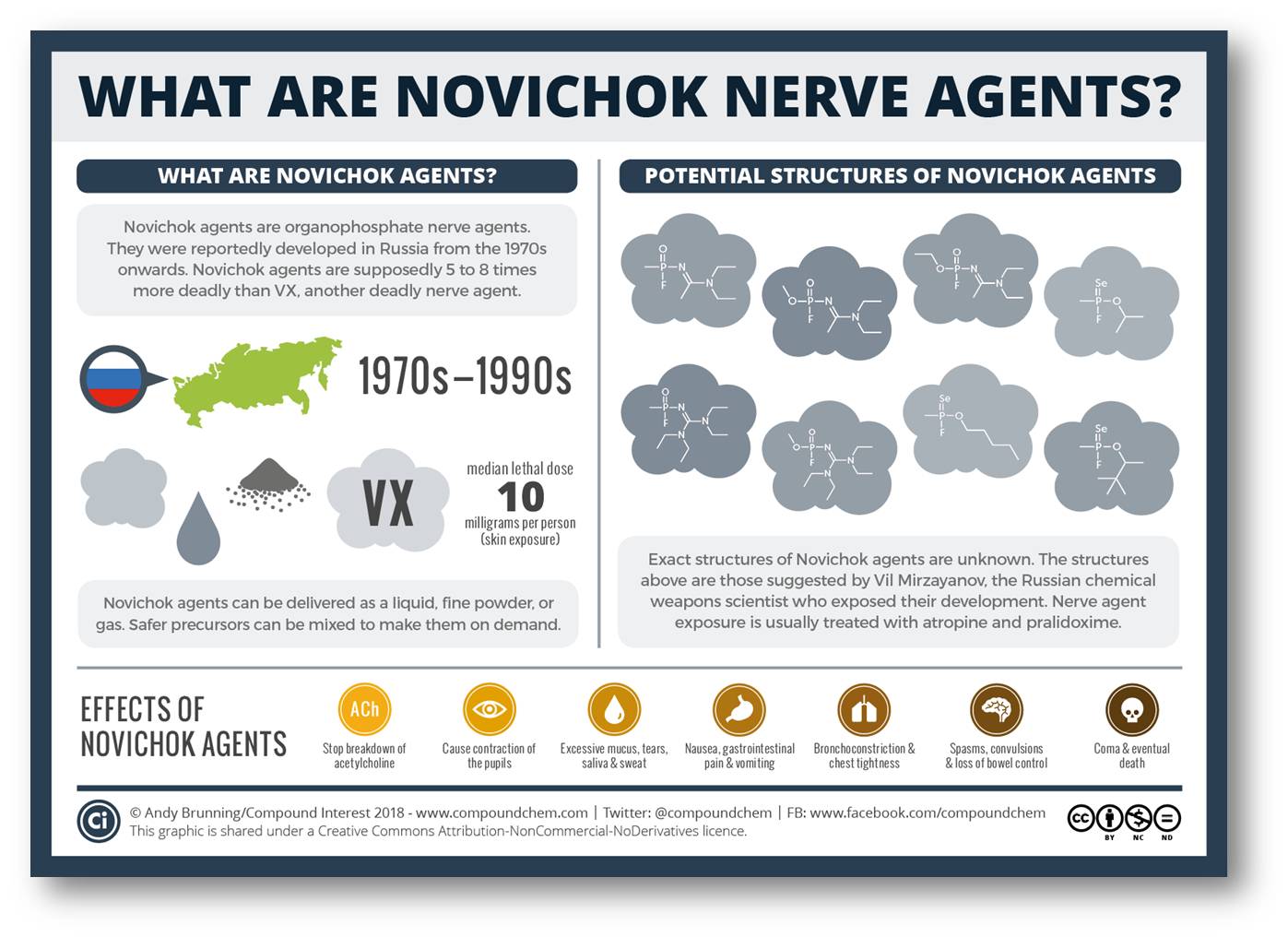

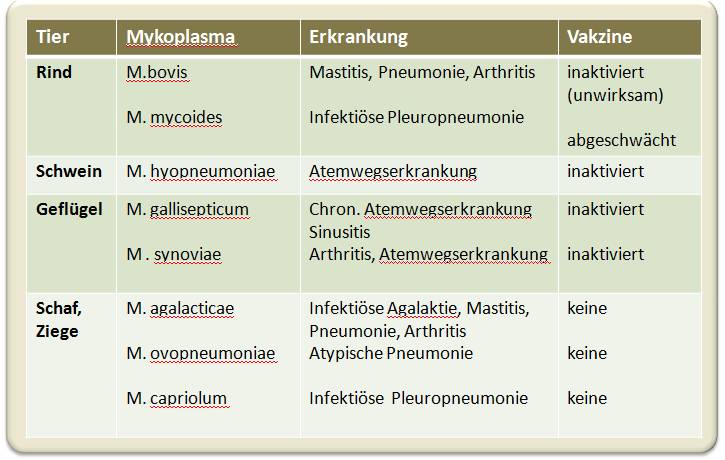

Dass Mikroorganismen - Bakterien, Pilze, Protozoen - und ebenso Viren zunehmend Resistenz gegen antimikrobielle Substanzen entwickeln, für die sie vordem hochsensitiv waren, ist ein natürlicher Vorgang der Evolution. Ein übermäßiger/unsachgemäßer Einsatz der gegen Bakterien wirksamen Antibiotika hat so (multi-)resistente Keime entstehen lassen, gegen die auch die potentesten Reserve-Antibiotika nichts mehr ausrichten - Infektionen mit resistenten Keimen führen im EU-Raum jährlich zu mehr als 25 000 Todesfällen. Mit dem Ziel Antibiotika gezielt und maßvoll anzuwenden befragt die EU-Kommission seit 2009 ihre Bürger hinsichtlich ihres Wissens um Antibiotika, deren Gebrauch und Risiken. Die Ergebnisse der letzten Umfrage im September 2018 liegen nun im Special Eurobarometer 478 vor [1].

Der rasche Anstieg der Lebenserwartung im 20. Jahrhundert ist - neben besserer Ernährung und Hygiene - vor allem vor allem auf die wirksame Bekämpfung von Infektionskrankheiten, insbesondere von bakteriellen Infektionen, mit Medikamenten und Vakzinen zurückzuführen. Rund 200 unterschiedliche antimikrobielle Wirkstoffe gegen verschiedene Erreger im Human- und Veterinärsektor stehen heute zur Verfügung - darunter Antibiotika, die gegen ein weites Spektrum von Bakterien wirken (Breitband-Antibiotika) und solche die spezifisch gegen einzelne Keime gerichtet sind.

Resistenzentstehung…

Allerdings hat mit steigender Anwendung der Antibiotika deren Wirksamkeit abgenommen. Die Erreger werden dagegen in stark zunehmendem Maße resistent. Es ist dies ein Evolutionsprozess basierend auf Genmutation und natürlicher Selektion: Auf Grund der raschen Zellteilung bei einer relativ hohen Mutationsrate kann eine wachsende Bakterienpopulation Keime enthalten, in welchen ein mutiertes Protein nun einen wesentlich weniger empfindlichen Angriffspunkt ("Target") für ein Medikament darstellt und/oder imstande ist das Medikament abzubauen und damit dessen Wirkung zu verringern. Resistente Keime können überdies das mutierte Gen an andere Bakterien übertragen.

In Gegenwart eines antimikrobiellen Medikaments werden nun zuerst die empfindlichsten Keime abgetötet und sukzessive dann die immer resistenteren. Wird ungenügend lang behandelt, so erfolgt Selektion der resistenteren Keime, die sich nun munter weiter vermehren können. Resistente Keime entstehen auch, wenn Antibiotika unsachgemäß eingesetzt werden, bei Infektionen angewandt werden, gegen die sie unwirksam sind, wie dies bei den durch Viren verursachten grippalen Infekten und der Influenza der Fall ist.

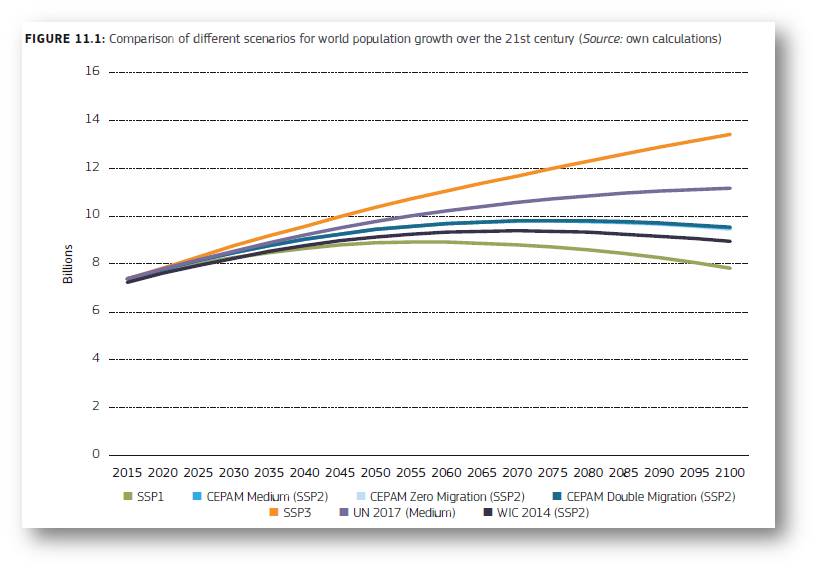

…ein globales Problem

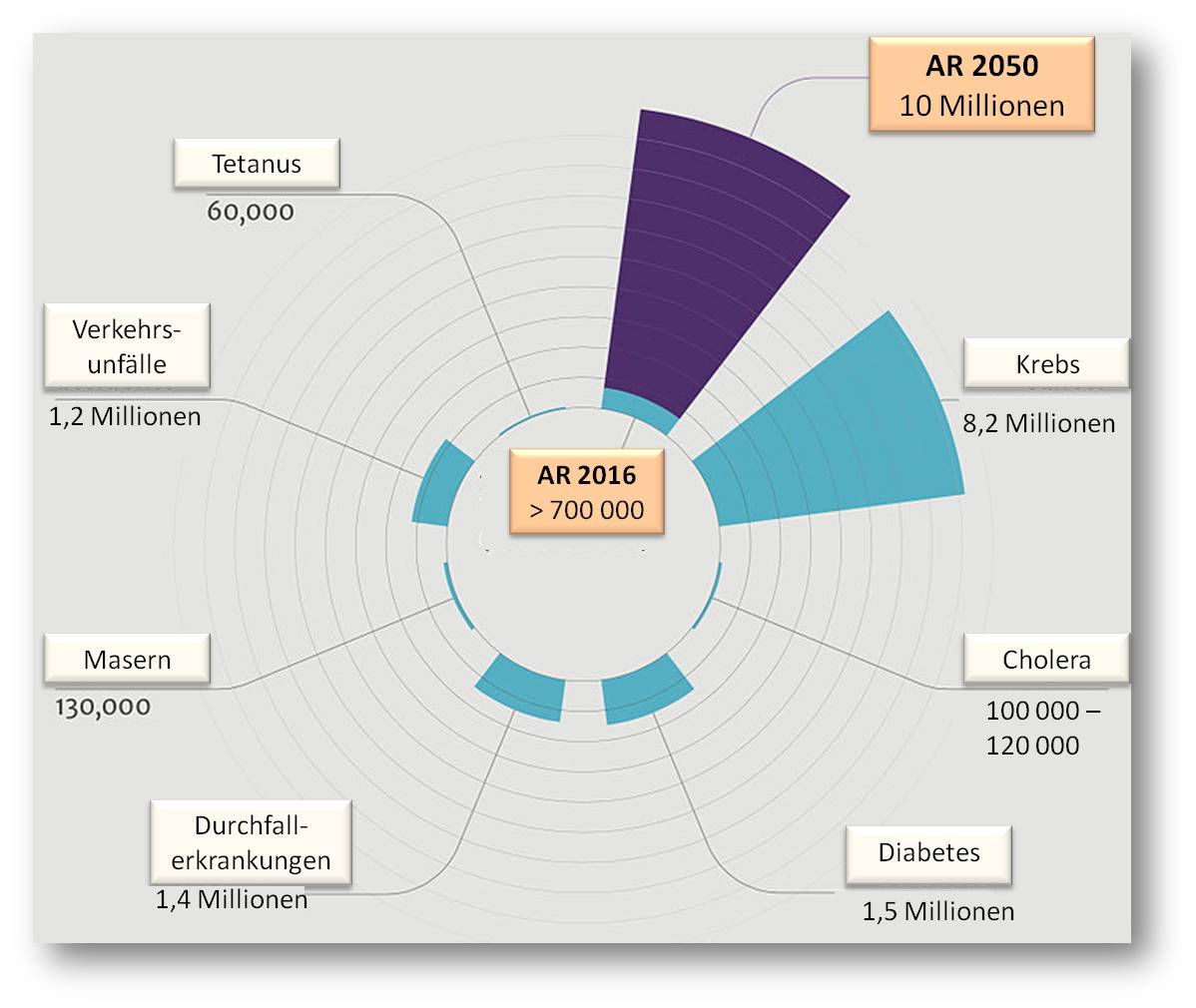

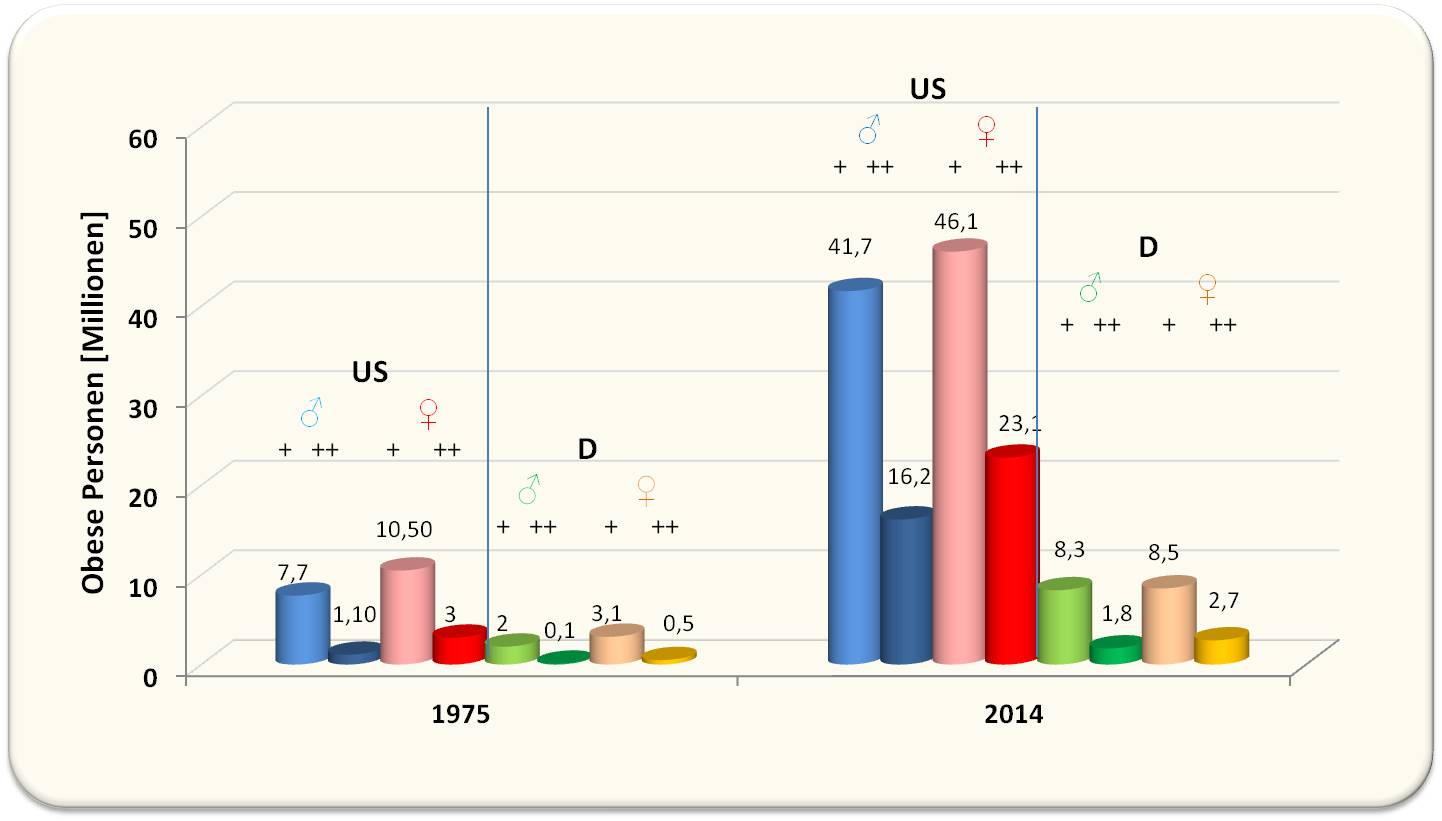

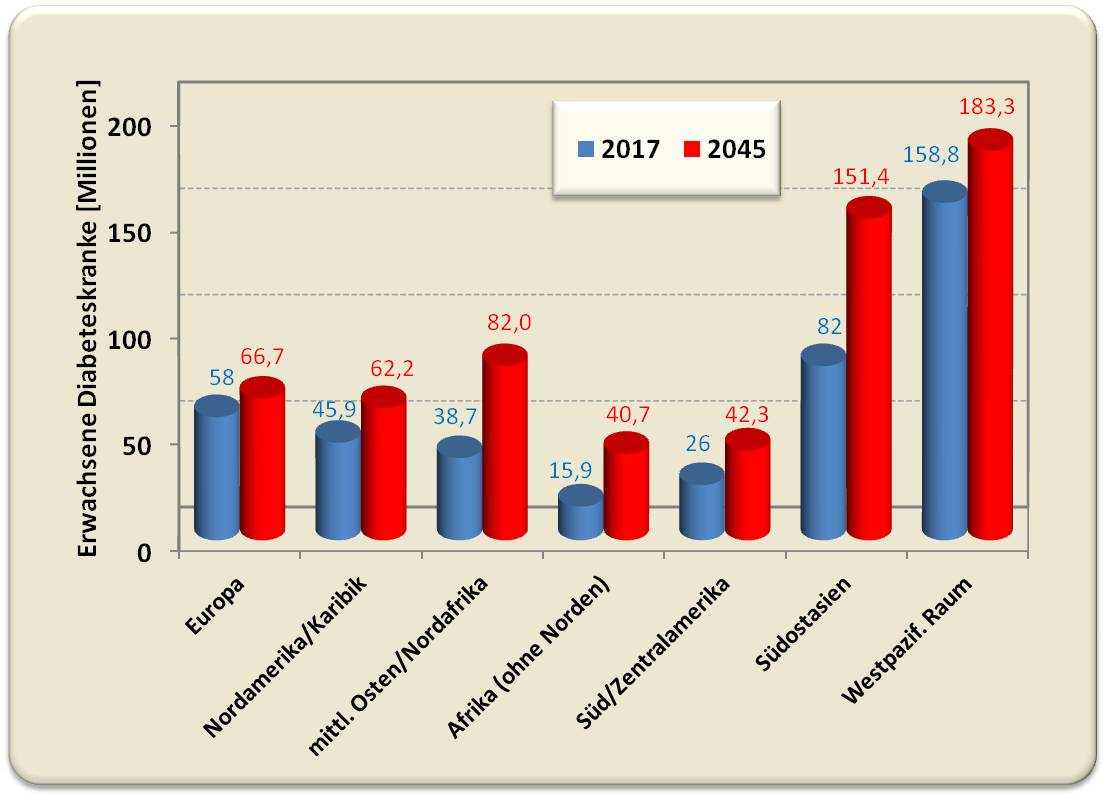

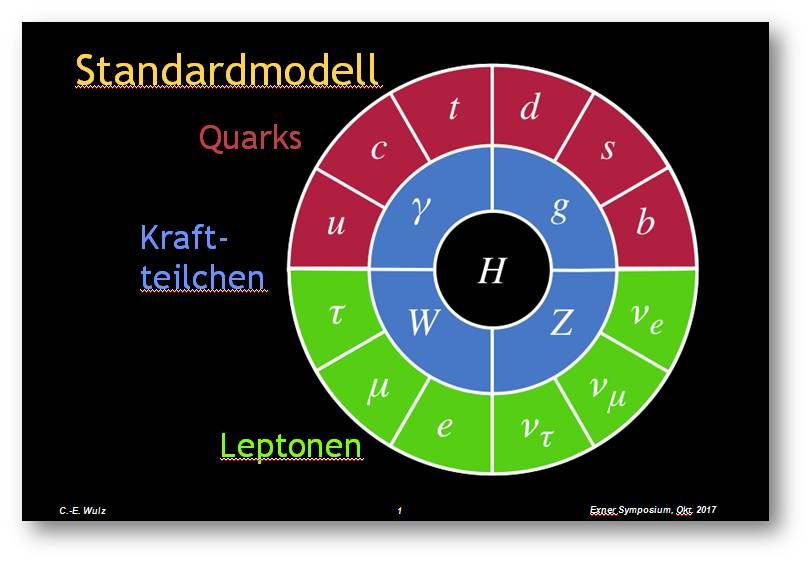

Die Entwicklung resistenter Keime, insbesondere multiresistenter - d.i. gegen eine breite Palette von Antibiotika resistenter - Keime ist ein weltweites Problem, das kein Land allein lösen kann. Globale Schätzungen aus dem Jahr 2016 gehen von mindestens 700 000, durch Infektionen mit resistenten Keimen verursachten Toten aus; 2050 könnte diese Zahl auf 10 Millionen ansteigen [2]. Abbildung 1.

Abbildung 1. Globale Todesfälle im Jahr infolge von Antibiotikaresistenz (AR) im Vergleich zu anderen Ursachen (Quelle: ‘Tackling drug-resistant infections globally: Final report and recommendations. https://amr-review.org/‘Tackling drug-resistant infections globally: Final report and recommendations sites/default/files /160525_Final%20paper_with%20cover.pdf (Lizenz cc-by 4.0))

Abbildung 1. Globale Todesfälle im Jahr infolge von Antibiotikaresistenz (AR) im Vergleich zu anderen Ursachen (Quelle: ‘Tackling drug-resistant infections globally: Final report and recommendations. https://amr-review.org/‘Tackling drug-resistant infections globally: Final report and recommendations sites/default/files /160525_Final%20paper_with%20cover.pdf (Lizenz cc-by 4.0))

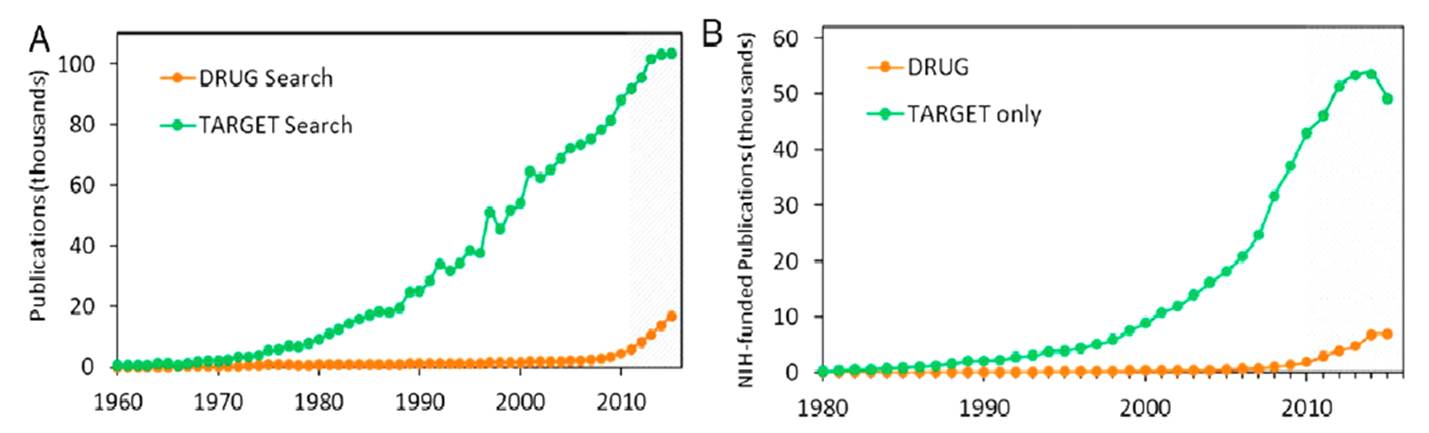

Die Verschärfung der Situation resultiert daraus, dass Resistenzen sich viel, viel schneller entwickeln - auch auf Grund einer breiten unkritischen Anwendung - als neue Wirkstoffe gefunden, entwickelt und auf den Markt gebracht werden können. Letzteres ist auch dadurch bedingt, dass die Pharmazeutische Industrie den für sie nur wenig aussichtsreichen und kaum lukrativen Sektor der Antibiotika Forschung und Entwicklung jahrzehntelang ignorierte und auch akademische Institutionen dieses Gebiet vernachlässigt haben. Vom Budget der US-amerikanischen National Institutes of Health (NIH) - 142,5 Milliarden $ von 2010 bis 2014 - gingen 26,5 Milliarden in die Krebsforschung, 14,5 Milliarden in das HIV/AIDS-Gebiet, 5 Milliarden in Diabetes und nur 1,7 Milliarden $ - knappe 1,2 % - in die Antibiotikaforschung [2].

Was geschieht in der Europäischen Union?

Allein in der EU geht man jährlich von mehr als 25 000 Menschen aus, die in Folge von antimikrobieller Resistenz sterben. Abgesehen von dem Leiden der Betroffenen sind die durch (multi)resistente Keime verursachten Behandlungskosten enorm, ebenso wie die Einbußen durch Produktionsausfall. [1]. Die Bekämpfung der antimikrobiellen Resistenzen ist ein prioritäres Anliegen der EU und sie hat im Mai 2017 einen neuen Europäischen Aktionsplan zur Bekämpfung antimikrobieller Resistenzen im Rahmen des Konzepts „Eine Gesundheit“ vorgelegt [3]. (Zitat aus dem Aktionsplan:Mit dem Begriff „Eine Gesundheit“ wird ein Konzept beschrieben, mit dem anerkannt wird, dass menschliche und tierische Gesundheit miteinander zusammenhängen, dass Krankheiten vom Menschen auf Tiere und umgekehrt übertragen werden und deshalb bei beiden bekämpft werden müssen. Das „Eine-Gesundheit“-Konzept umfasst auch die Umwelt, die einen weiteren Verbindungspunkt zwischen Mensch und Tier und ebenfalls eine potenzielle Quelle neuer resistenter Mikroorganismen darstellt.[3])

Zu diesem Aktionsplan gehört - neben der Förderung relevanter Forschung & Entwicklung - auch für ein besseres Verständnis der EU-Bürger bezüglich eines sachgemäßen Gebrauchs von antimikrobiellen Medikamenten zu sorgen und so die Entwicklung und Ausbreitung von resistenten Keimen hintanzuhalten. Dass vielen Bürgern ein derartiger Zusammenhang nicht bewusst ist, haben mehrere, seit 2009 erhobene Eurobarometer Umfragen ergeben. Die letzte dieser Umfragen hat im September 2018 stattgefunden und deren bereits vorliegende Ergebnisse werden im Folgenden kurz dargestellt.

Spezial Eurobarometer 478: Antimikrobielle Resistenz [1]

Dies war nun die vierte repräsentative Umfrage, welche die die EU-Kommission in Auftrag gegeben hat, um aktuelle Meinungen, Kenntnisse und Verhaltensweisen der EU-Bürger zum Problem antimikrobielle Resistenz zu erheben. Die Umfrage erfolgte in den 28 Mitgliedstaaten vom 8. bis 26. September 2018 und insgesamt 27 474 Personen ab 15 Jahren und aus unterschiedlichen sozialen und demographischen Gruppen - rund 1 000 Personen je Mitgliedsland -nahmen teil. wurden persönlich (face to face) in ihrem Heim und in ihrer Muttersprache interviewt.

Die Teilnehmer wurden u.a. gefragt ob und warum sie im letzten Jahr Antibiotika genommen hatten, wie sie diese erhalten hatten und ob ein Test auf den Erreger der Erkrankung erfolgt war. Des weiteren wurde das Verständnis zu Wirksamkeit und Anwendung der Antibiotika erhoben und zu den Risiken eines unsachgemäßen Gebrauchs, auch woher die Bürger entsprechende Information erhalten hatten und wie verlässlich sie diese Quellen einstuften.

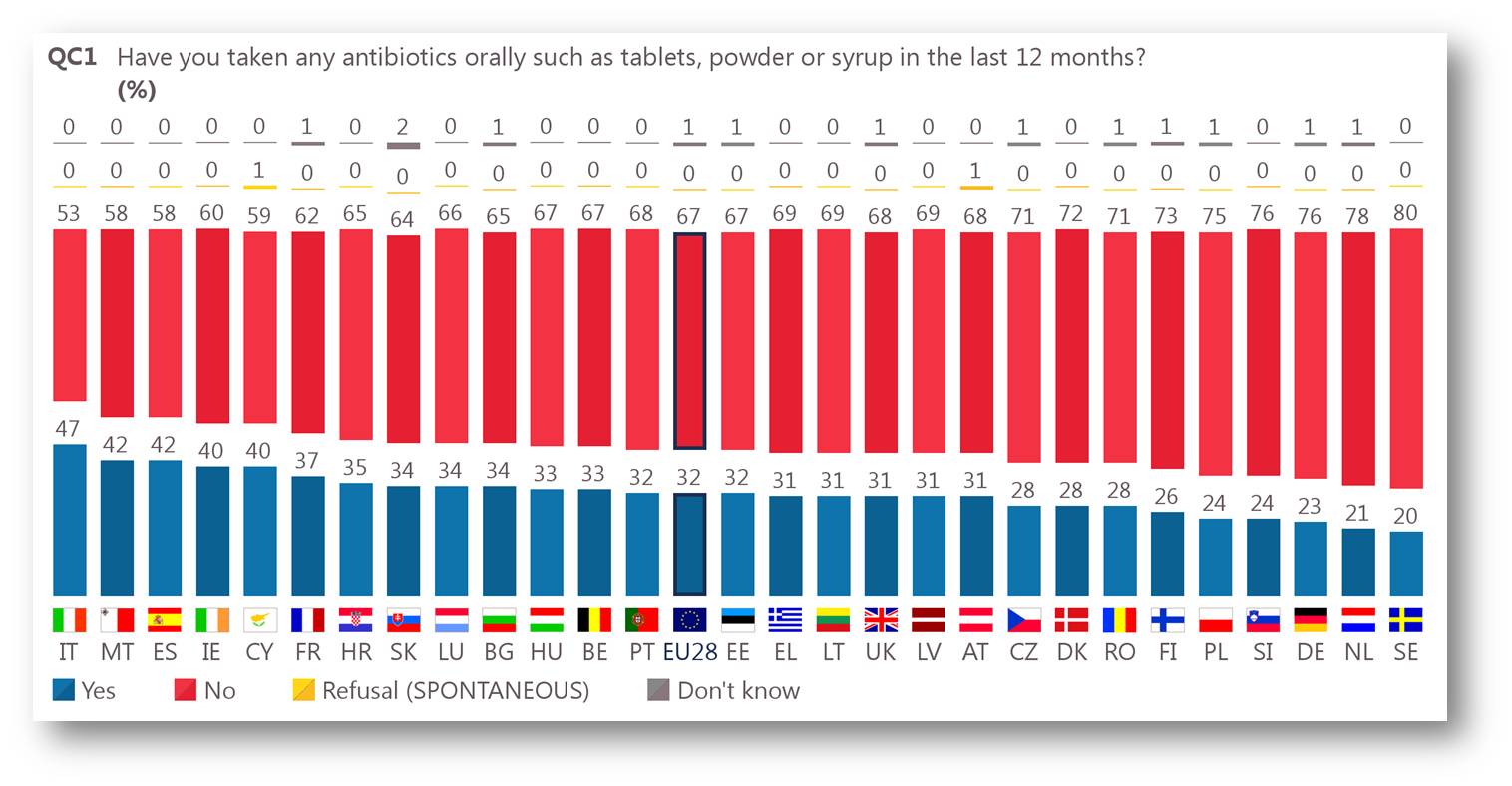

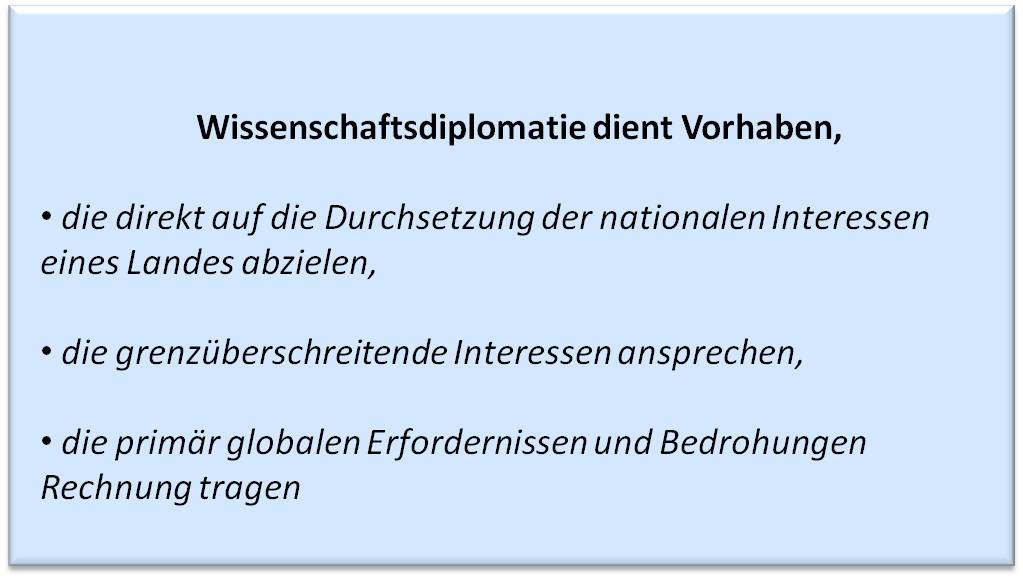

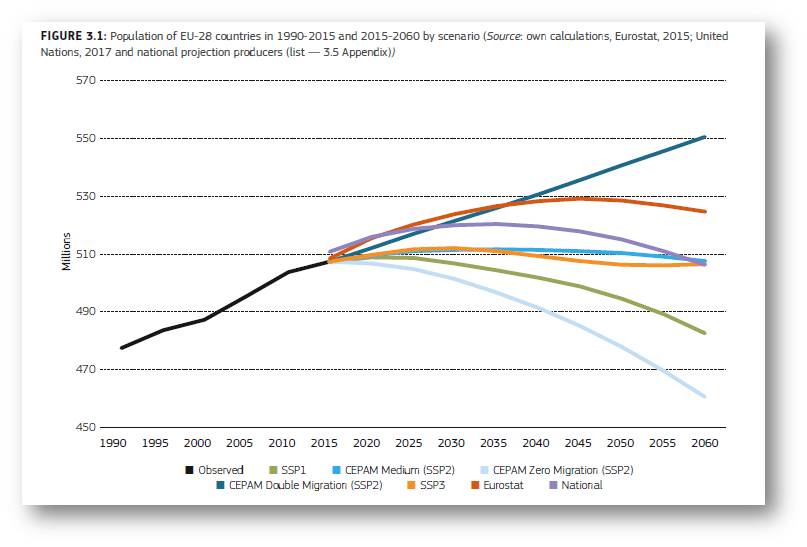

Haben Sie im letzten Jahr Antibiotika genommen?

Diese Frage beantworteten im Mittel 32 % der befragten EU-Bürger mit Ja - ein deutlicher Rückgang seit 2009 (40 %), allerdings ist der Unterschied zwischen den Staaten groß. Während nahezu die Hälfte der Italiener angab Antibiotika genommen zu haben, waren dies in Schweden, Holland und Deutschland weniger als ein Viertel der Befragten. Österreich liegt mit rund 31 % der befragten Personen im EU-Mittel. Abbildung 2. Eine demographische Analyse ordnet erhöhten Antibiotika-Verbrauch eher Personen mit abgebrochener Ausbildung, niedrigerem sozialen Status, ohne Beschäftigung , Altersgruppen zwischen 15 und 24 Jahren und solchen über 65 Jahren und Frauen zu.

Abbildung 2. Haben Sie im letzten Jahr orale Antibiotika genommen? Zwischen 20 und 47 % der Teilnahme bejahen diese Frage.(Quelle: [1])

Abbildung 2. Haben Sie im letzten Jahr orale Antibiotika genommen? Zwischen 20 und 47 % der Teilnahme bejahen diese Frage.(Quelle: [1])

Von wem und wofür erhielten Sie Antibiotika (verschrieben)?