2016

2016 Redaktion Wed, 20.03.2019 - 01:04Kenne Dich selbst - aus wie vielen und welchen Körperzellen und Mikroben besteht unser Organismus?

Kenne Dich selbst - aus wie vielen und welchen Körperzellen und Mikroben besteht unser Organismus?Do, 22.12.2016 - 05:22 — Redaktion

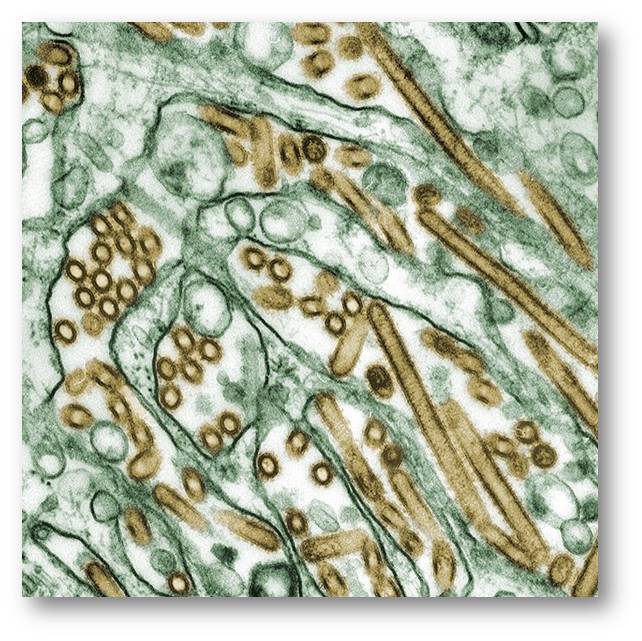

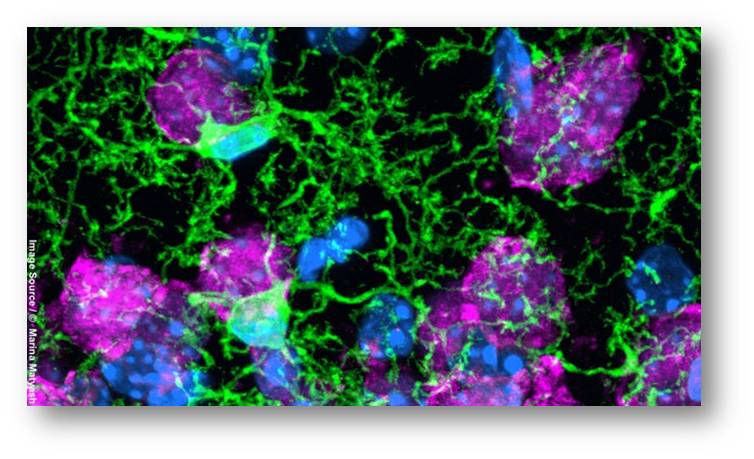

![]() Mikroorganismen sind überall -um uns herum und natürlich auch auf und in unserem Körper. In den letzten Jahren ist das Interesse an diesen Mitbewohnern und deren Einfluss auf unseren Metabolismus und unsere Gesundheit enorm gestiegen. Bis vor kurzem ging man davon aus, dass im Organismus zehnmal, ja sogar hundertmal mehr Mikroorganismen als Humanzellen vorliegen- einer kaum hinterfragten Schätzung aus den 1970er Jahren. Der Biologe Ron Milo (Begründer der "BioNumbers database" und Professor am Weizman-Institut, Rehovot) und sein Team haben nun eine kritische Analyse und Quantifizierung der unterschiedlichen Zelltypen ausgeführt: demnach enthält unser Körper etwa 30 Billionen menschliche Zellen, wobei rund 90 % davon hämatopoietische (blutbildende) Zellen sind, die Zahl der Bakterien liegt bei circa 39 Billionen, etwa gleichauf mit der Zahl der Humanzellen. Der folgende Artikel ist eine stark gekürzte, aus dem Englischen übersetzte Version der vor Kurzem in PLoSBiol (open access, cc-by) veröffentlichten Untersuchung von R. Sender, S. Fuchs und R. Milo [1].

Mikroorganismen sind überall -um uns herum und natürlich auch auf und in unserem Körper. In den letzten Jahren ist das Interesse an diesen Mitbewohnern und deren Einfluss auf unseren Metabolismus und unsere Gesundheit enorm gestiegen. Bis vor kurzem ging man davon aus, dass im Organismus zehnmal, ja sogar hundertmal mehr Mikroorganismen als Humanzellen vorliegen- einer kaum hinterfragten Schätzung aus den 1970er Jahren. Der Biologe Ron Milo (Begründer der "BioNumbers database" und Professor am Weizman-Institut, Rehovot) und sein Team haben nun eine kritische Analyse und Quantifizierung der unterschiedlichen Zelltypen ausgeführt: demnach enthält unser Körper etwa 30 Billionen menschliche Zellen, wobei rund 90 % davon hämatopoietische (blutbildende) Zellen sind, die Zahl der Bakterien liegt bei circa 39 Billionen, etwa gleichauf mit der Zahl der Humanzellen. Der folgende Artikel ist eine stark gekürzte, aus dem Englischen übersetzte Version der vor Kurzem in PLoSBiol (open access, cc-by) veröffentlichten Untersuchung von R. Sender, S. Fuchs und R. Milo [1].

Wie viele Zellen enthält der menschliche Körper?

Außer Angaben von Größenordnungen - diese allerdings ohne deren Quelle oder Abweichungsbreite zu nennen - sind hierzu nur sehr wenige detaillierte Abschätzungen erfolgt. Ähnliches gilt für die weltweit kolportierte Feststellung, dass 100 bis 1000 Billionen (1014 bis 1015) Bakterien, d.i. 10- bis 100-mal mehr Bakterien als Humanzellen, unseren Körper besiedeln - es sind dies Zahlen, die ihren Ursprung in einer groben Schätzung aus dem Jahr 1972 haben und offensichtlich nicht mehr hinterfragt wurden.

Vor Kurzem ist eine Untersuchung des Teams von Ron Milo (Weizman Institute of Sciences, Rehovot) in den Fachjournalen Science und PLoSBiol erschienen, die auf eine verlässlichere Abschätzung der humanen und mikrobiellen Zellzahlen in einzelnen Organen abzielt [1, 2]. Diese Schätzungen (die inklusive Unsicherheitsbereichen angegeben werden) basieren auf der kritischen Analyse einer umfassenden Sammlung von älteren bis neuesten Literaturangaben zur Anzahl von Zellen und Größe von Organen. Da der Großteil dieser Angaben an Gruppen von Männern erhoben wurde, geht die Untersuchung von einem "Standard"-Mann aus, der als 20 - 30 Jahre alt, 70 Kilo schwer und 1,70 groß definiert ist.

Unser Mikrobiom

Mikroben gibt es überall im menschlichen Körper, hauptsächlich sitzen sie auf den äußeren und inneren Oberflächen: u.a. im Gastrointestinaltrakt, auf der Haut, im Speichel, auf der Mundschleimhaut und der Bindehaut. Bakterien sind dabei die dominierenden Mikroorganismen, ihre Zahl übersteigt die der Archäa und Eukaryoten (Pilze) um 2 - 3 Größenordnungen, die letzteren spielen bei der Abschätzung der Gesamtzahl unserer Mitbewohner also kaum eine Rolle, sind also vernachlässigbar.

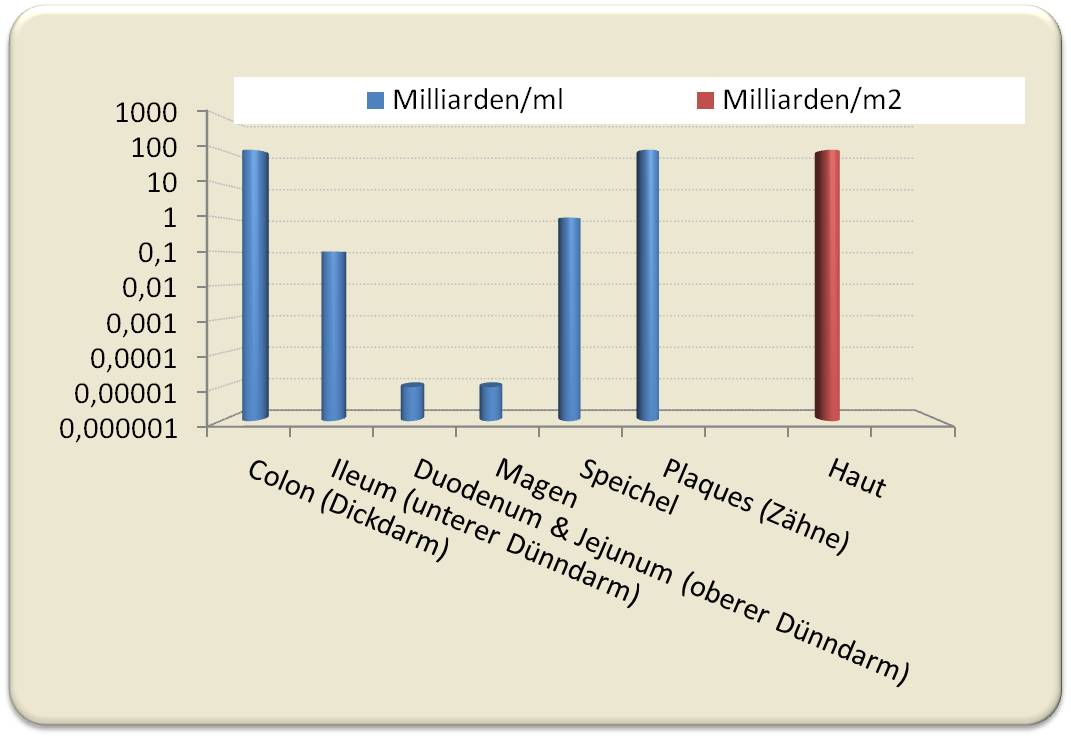

Quantitativ betrachtet sitzt die überwiegende Mehrheit der Bakterien im Verdauungstrakt und hier vor allem im Dickdarm. Jeder Milliliter Dickdarminhalt enthält rund 90 Milliarden Mikroorganismen. Im angrenzenden, unteren Teil des Dünndarms ("Ileum") gibt es nur etwa 100 Millionen Mikroben/ml, im davor liegenden oberen Teil des Dünndarms (Jejunum), im Duodenum und ebenso im (sauren) Magen ist deren Konzentration auf 1000 - 10 000/ml gesunken. Bei einem inneren Volumen des Dickdarms von etwa 400 ml (auf den "Standard"-Mann bezogen) enthält dieser Abschnitt bis zu 38 Billionen Bakterien (Standardfehler 25 %). Alle anderen Abschnitte des Verdauungstraktes und auch der übrigen Organe tragen insgesamt höchstens 1 Billion Mikroben zur Gesamtzahl bei. Im Mundbereich sitzen zwar sehr viele Bakterien im Zahnbelag und im Speichel - in Anbetracht der kleinen Volumina dieser Kompartimente ist der Beitrag zur Gesamtzahl Mikroben aber vernachlässigbar. Abbildung 1 zeigt typische Konzentrationen von Bakterien im Verdauungstrakt uns auf unserer Haut.

Abbildung 1. Konzentration von Bakterien in Organen des menschlichen Körpers. Im Colon wurde die Bakterienzahl in verdünnten Stuhlproben bestimmt, u.a. durch Flureszenzmikroskopie. (Basierend auf den Daten von Tabelle 1 in [1] wurde die Abbildung von der Redaktion erstellt.)

Abbildung 1. Konzentration von Bakterien in Organen des menschlichen Körpers. Im Colon wurde die Bakterienzahl in verdünnten Stuhlproben bestimmt, u.a. durch Flureszenzmikroskopie. (Basierend auf den Daten von Tabelle 1 in [1] wurde die Abbildung von der Redaktion erstellt.)

Das Volumen des Dickdarminhalts bestimmt also die Zahl an Bakterien in unserem Körper. Dieses für den "Standard"-Mann mittels MRI (Magnetresonanz) bestimmte Volumen von rund 0,4 l (Standardabweichung 17 %) erhöht sich nach Mahlzeiten um ca. 10 % und ist nach jedem Stuhlgang um etwa ein Viertel bis ein Drittel reduziert.

Wie tragen Bakterien zu unserem Gesamtgewicht bei? Hier braucht wieder nur der Dickdarminhalt berücksichtigt werden, der rund 0,2 kg Bakterien (Trockengewicht 50 - 100g) oder 0,3 % des Körpergewichtes eines 70 kg Mannes entspricht. Damit unterscheiden sich diese Daten wesentlich von früheren Schätzungen, die davon ausgingen, dass der Mensch 1 - 3 kg Bakterien beherbergt.

Zur Zahl unserer Körperzellen…

Die meisten Literaturangaben gehen davon aus, dass es zwischen einer Billion (1012) und 100 Billionen (1014) Körperzellen gibt. Diese Zahlen resultieren aus groben Überschlagsrechnungen, indem man das Körpergewicht durch das Gewicht einer Zelle teilt. Dabei werden für Zellen Volumina von 1 000 bis 10 000 µm3 und der Einfachheit halber eine Dichte ähnlich wie Wasser angenommen -eine durchschnittliche Zelle würde dann 10-12 bis 10-11 kg schwer sein.

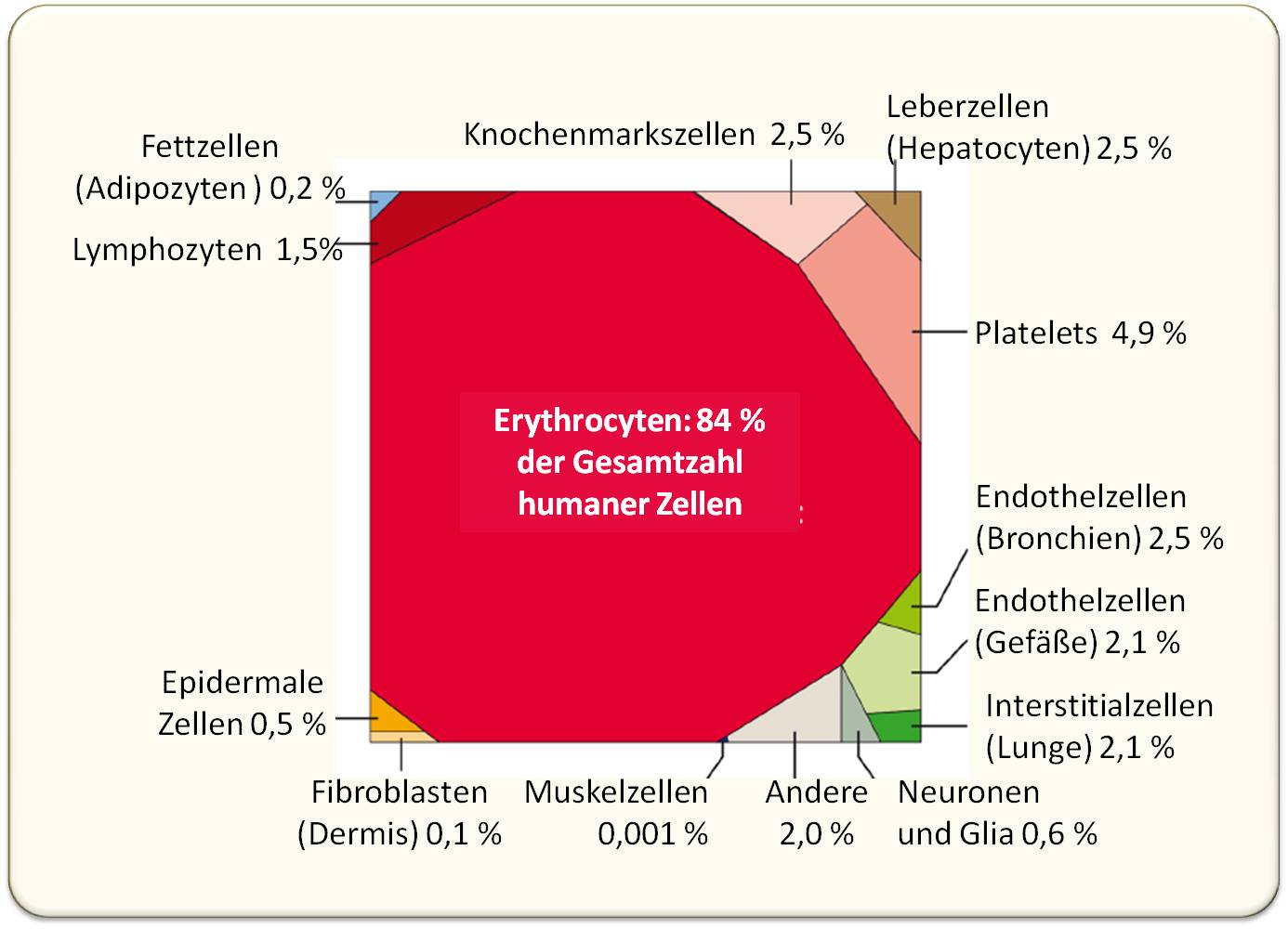

Eine differenzierterer Ansatz geht nicht von derartigen durchschnittlichen Zellen aus sondern zählt die unterschiedlichen Zellen ihrem Typ entsprechend - beispielsweise Erythrocyten im Blut oder z.B Muskelzellen oder Fettzellen direkt in ihren Organen (mittels histologischer Bestimmungen). Eine kürzlich erfolgte Studie hat 56 Kategorien von Zelltypen unterschieden und deren Zahl im Körper bestimmt [3]. Ron Milo und sein Team haben diese Daten kritisch revidiert und erheben für den Standard-Mann nun eine Gesamtzahl an Körperzellen von 30 Billionen (3.1013). 13 der 56 Kategorien machen 98 % der gesamten Humanzellen aus (Abbildung 2):

Abbildung 2. Anteil der unterschiedlichen Zelltypen an der Gesamtzahl humaner Körperzellen. Nur Zelltypen, die > 0,4 % zur Gesamtzahl (rund 30 Billionen)beitragen, sind dargestellt. Die Fläche der Vielecke ist proportional zur Zellzahl (Voronoi tree map; Visualization performed using the online tool at http://bionic-vis.biologie.unigreifswald.de/.)

Abbildung 2. Anteil der unterschiedlichen Zelltypen an der Gesamtzahl humaner Körperzellen. Nur Zelltypen, die > 0,4 % zur Gesamtzahl (rund 30 Billionen)beitragen, sind dargestellt. Die Fläche der Vielecke ist proportional zur Zellzahl (Voronoi tree map; Visualization performed using the online tool at http://bionic-vis.biologie.unigreifswald.de/.)

Die roten Blutkörperchen (Erythrocyten) sind die dominierende Zellenart. Bei einem Blutvolumen von 4,9 Liter und einer mittleren RBC-Zahl von 5 Milliarden Zellen im Milliliter kommt man zu einer Gesamtzahl von 2,5 x 1013 (25 Billionen). Nahezu 90 % aller Zellen besitzen keinen Zellkern: es sind dies Erythrocyten (84 %) und Platelets (4,9 %); nur 10 % aller Zellen haben einen Zellkern.

Die differenzierteren Analysen kommen zu wichtigen neuen Ergebnissen: so wird das früher akzeptierte 10 : 1 Verhältnis von Gliazellen zu Neuronen durch eine neue Studie widerlegt: mit jeweils 8,5 x 1010 ist die Anzahl der Glia-Zellen und Neuronen etwa gleich hoch. Abschätzungen der Endothel-Zellen, welche die gesamte Länge des Gefäßsystems als Basis nehmen, ergaben eine auf ein Viertel reduzierte Zellzahl (600 Milliarden). Besonders drastisch reduzierte sich die Zahl der Fibroblasten der Haut - von 1,85 Billionen auf 26 Milliarden - als deren Dichte über die gesamte Dicke der Dermis bestimmt wurde.

…und wie sie zur Gesamtmasse beitragen

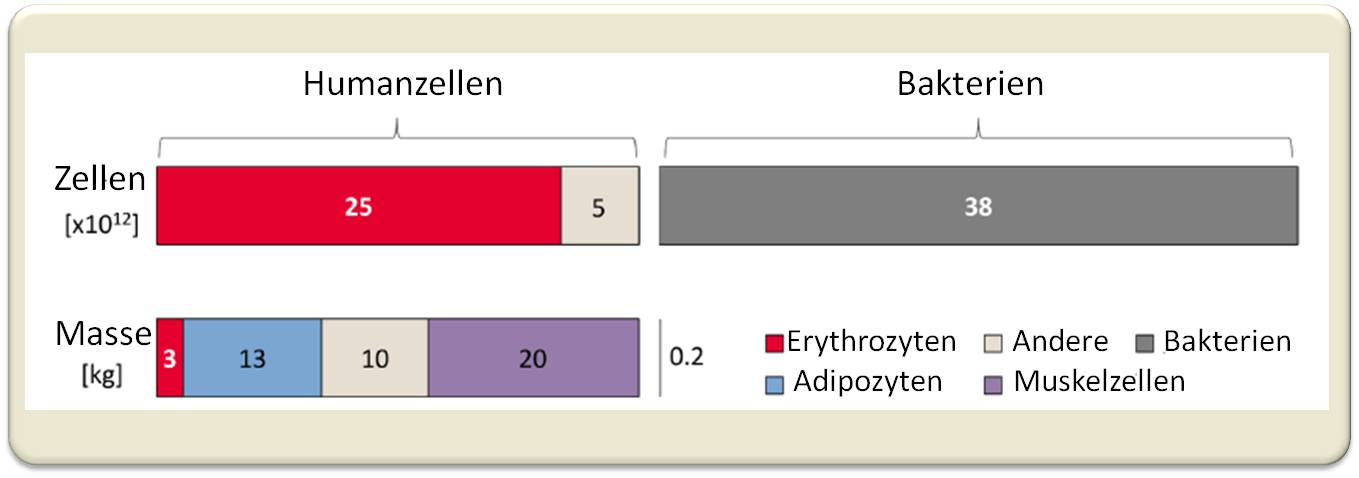

Es besteht eine offensichtliche Diskrepanz zwischen den Beiträgen zur gesamten Zellmasse und zur Zahl der Zellen. Abbildung 3.

Abbildung 3. Anzahl und Massen unterschiedlicher Zelltypen im Körper eines 70 kg schweren Mannes. Oben: Zahl der Zellen (in Billionen); Unten: Beiträge zur Masse (in kg; die extrazelluläre Masse von rund 24 kg ist nicht miteinbezogen). Rechts: Zum Vergleich Bakterien, die im Menschen nur 0,2 kg der gesamten Masse ausmachen.

Abbildung 3. Anzahl und Massen unterschiedlicher Zelltypen im Körper eines 70 kg schweren Mannes. Oben: Zahl der Zellen (in Billionen); Unten: Beiträge zur Masse (in kg; die extrazelluläre Masse von rund 24 kg ist nicht miteinbezogen). Rechts: Zum Vergleich Bakterien, die im Menschen nur 0,2 kg der gesamten Masse ausmachen.

Erythrocyten, mit 84 % die zahlreichsten Zellen, sind die kleinsten Zellen (Volumen: etwa 100 µm3) und tragen insgesamt 3 kg zur Gesamtmasse bei. Im Gegensatz dazu setzen sich 75 % der gesamten Zellmasse aus den großen (>10 000 µm3) Muskel- und Fettzellen zusammen, die aber nur einen kleinen Anteil von 0,2 % an der Gesamtzahl ausmachen.

Bakterien - entsprechend ihrem sehr kleinen Volumen - tragen nur 0,2 kg zur Gesamtmasse bei, sind zahlenmäßig jedoch vergleichbar mit der Gesamtzahl an Körperzellen.

Fazit

Dass das Verhältnis von Bakterien zu Körperzellen nun nahe 1:1 liegt, verringert nicht die biologische Bedeutsamkeit unserer Mitbewohner. Die aktuelle Studie führt uns aber die Grenzen unseres derzeitigen Verstehens vor Augen und zeigt uns die Wichtigkeit eines quantitativen Verständnisses.

Zahlen sollten auf den jeweils besten verfügbaren Daten basieren, um einen quantitativen biologischen Diskurs ernsthaft zu führen, um spezifische biologische Fragen zu beantworten. Die Kenntnis von Zellzahlen konnte beispielweise in einer rezenten Studie Unterschiede in der Tumoranfälligkeit verschiedener Organe verständlich machen [4]. Derartige quantitative Betrachtungen finden ihre Anwendung auch auf dynamische Prozesse in der Entwicklung und auf die Akkumulation von Mutationen.

Von Überschlagsrechnungen zu quantitativem Denken: Welches Problem scheint geeigneter zu sein, um von einer quantitativen Perspektive aus betrachtet zu werden, als die Frage woraus unsere Körper bestehen, der Delphische Imperativ "Erkenne Dich selbst".

[1] Sender R, Fuchs S, Milo R (2016) Revised Estimates for the Number of Human and Bacteria Cells in the Body. PLoS Biol 14-8: e1002533.doi:10.1371/journal.pbio.1002533. Open access. cc-by

[2] Sender R, Fuchs S, Milo R (2016) Are We Really Vastly Outnumbered? Revisiting the Ratio of Bacterial to Host Cells in Humans. Cell 164: 337-340 http://dx.doi.org/10.1016/j.cell.2016.01.013

[3] Bianconi E, Piovesan A, Facchin F, Beraudi A, Casadei R, Frabetti F, et al. An estimation of the number of cells in the human body. Ann Hum Biol 2013; 40:463–71. doi:10.3109/03014460.2013.807878 PMID: 23829164

[4] Tomasetti C, Vogelstein B. Variation in cancer risk among tissues can be explained by the number of stem cell divisions. Science 2015; 347:78–80. doi: 10.1126/science.1260825 PMID: 25554788

Weiterführende Links

Ron Milo: A sixth sense for understanding our cells. TEDxWeizmannInstitute . Video 15:01 min. Veröffentlicht am 20.08.2014 BioNumbers database: http://bionumbers.hms.harvard.edu/ Ron Milo, Associate Professor am Department of Plant and Environmental Sciences at the Weizmann Institute of Science hat diese Datenbank . He created the BioNumbers database when he was a Systems Biology Fellow at Harvard Medical School

Wie groß, wie viel, wie stark, wie schnell,… ? Auf dem Weg zu einer quantitativen Biologie

Wie groß, wie viel, wie stark, wie schnell,… ? Auf dem Weg zu einer quantitativen BiologieDo, 29.12.2016 - 05:08 — Redaktion

![]() In der vergangenen Woche waren aufsehenerregende Befunde zur Frage, wie viele und welche Zellen der menschliche Körper enthält, im ScienceBlog erschienen. Außer diesen Daten hat der Biologe Ron Milo (Professor am Weizman-Institut, Rehovot) zusammen mit dem Biophysiker Rob Phillips (Professor am Caltech, Pasadena) eine Datenbank "BioNumbers" [1] für biologische Daten geschaffen, die quantitativ und in allen Details schnellstens aufgerufen werden können. Mit dem vor kurzem online und im Printformat erschienenen "Cell Biology by the Numbers" [2] ist den Autoren ein Meilenstein auf dem Weg zu einer quantitativen Biologie gelungen.

In der vergangenen Woche waren aufsehenerregende Befunde zur Frage, wie viele und welche Zellen der menschliche Körper enthält, im ScienceBlog erschienen. Außer diesen Daten hat der Biologe Ron Milo (Professor am Weizman-Institut, Rehovot) zusammen mit dem Biophysiker Rob Phillips (Professor am Caltech, Pasadena) eine Datenbank "BioNumbers" [1] für biologische Daten geschaffen, die quantitativ und in allen Details schnellstens aufgerufen werden können. Mit dem vor kurzem online und im Printformat erschienenen "Cell Biology by the Numbers" [2] ist den Autoren ein Meilenstein auf dem Weg zu einer quantitativen Biologie gelungen.

Biologie als Lehre von den lebenden Systemen ist lange ohne quantitative Beschreibungen - d.i. ohne eine Basis an konkreten Zahlen und Formeln - ausgekommen. Charles Darwin, beispielsweise hat in seinem Buch „Über die Entstehung der Arten“ keine einzige mathematische Formel verwendet. Allerdings meinte er später: "nach Jahren habe ich es zutiefst bedauert nicht zumindest ein bisschen von den grundlegenden Prinzipien der Mathematik zu verstehen. Menschen, die darin begabt sind, haben einen zusätzlichen Sinn."[3].

Ganz im Gegensatz zu den Disziplinen Physik und Chemie, auf deren Gesetzen ja auch die Biologieaufbaut, hat in dieser quantitatives Denken bislang eine weniger bedeutende Rolle gespielt. Bedingt durch die ungeheure Komplexität lebender Systeme, werden Phänomene auch heute meistens bloß qualitativ beschrieben ohne auf ein "wie viel" oder "wie schnell" einzugehen, werden experimentelle Ergebnisse in Form punktueller Aufnahmen des zellulären Geschehens dargestellt. Handbücher in der Physik oder Chemie ermöglichen Schlüsseldaten/Kenngrößen sehr rasch aufzufinden. Dergleichen hat bis jetzt in der Biologie gefehlt. Es ist ein überaus frustrierender, langwieriger Prozess einigermaßen verlässliche Schlüsseldaten auch zu ganz trivialen Fragen aus der exponentiell wachsenden Fülle an Fachliteratur und online-Informationen zu extrahieren. Quantitative Eigenschaften biologischer Systeme hängen ja vom Organismus/Zelltyp, seinem Zustand und den experimentellen Methoden ab. Was man findet sind Daten, die aus unterschiedlichen Quellen stammen, unter unterschiedlichen experimentellen Bedingungen gewonnen wurden, nicht standardisiert sind und deren Streuung unbekannt ist.

Die Notwendigkeit Schlüsselzahlen und Standardgrößen zusammenzustellen, die das Leben von Zellen beschreiben, ist offensichtlich. Dies haben Ron Milo (Prof. am Weizmann Institute of Sciences, Rehovot) und Rob Phillips (Professor of Biophysics and Biology at California Institute of Technology - Caltech - Pasadena) mit der Schaffung einer Datenbank "BioNumbers" [1] und vor kurzem mit einem online frei zugänglichen Handbuch "Cell Biology in Numbers" [ 2] getan.

"BioNumbers" - eine Datenbank nützlicher biologischer Zahlen

Bereits 2007 haben Ron Milo und Rob Phillips begonnen eine Website [1] zu entwickeln, die als Portal für die enorme Fülle von Messdaten an biologischen Systemen dient und zwar auf der molekularen und zellulären Ebene. Das Ziel dieser Seite ist es jede gängige biologische Zahl "in einer Minute" aufzufinden und dies zusammen mit Angabe der Quelle, der Bestimmungsmethode und anderen relevanten Informationen. Zahlen, die man nicht so leicht findet, etwa zu Fragen wie: welches Volumen haben die unterschiedlichsten Zelltypen, wie lange dauern die Generationszeiten von Organismen, wie hoch sind die Konzentrationen von Ionen und Metaboliten in Zellen oder wie viele Ribosomen sind in verschiedenen Zelltypen. Die Angaben sind mit Kennzahlen - BioNumbers Identification Number (BNID) - versehen, die auf der Website oder von Google aus aufgerufen werden können und alle Details aufzeigen.

Dazu gibt es auch Daten-Kollektionen zu speziellen Fragestellungen wie z.B. zur Photosynthese oder über "erstaunliche BioNumbers" .

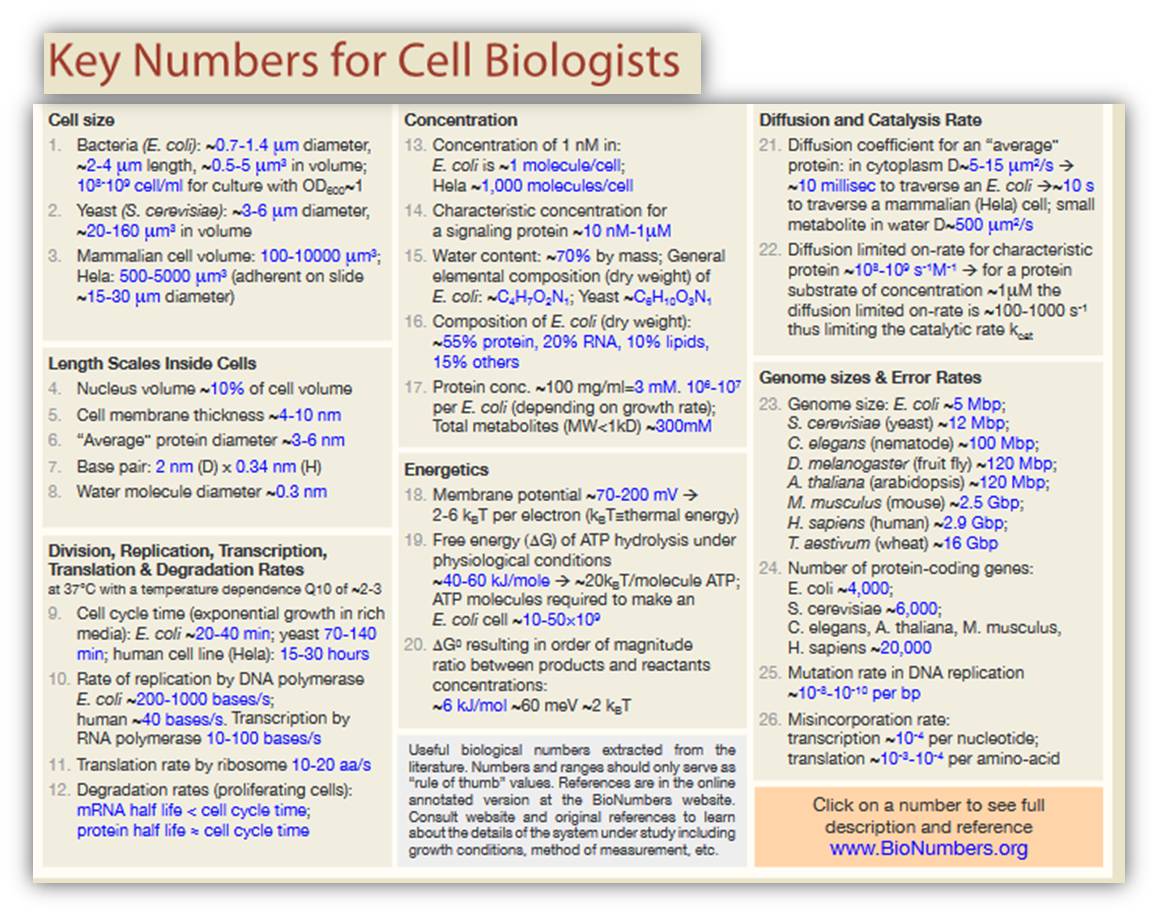

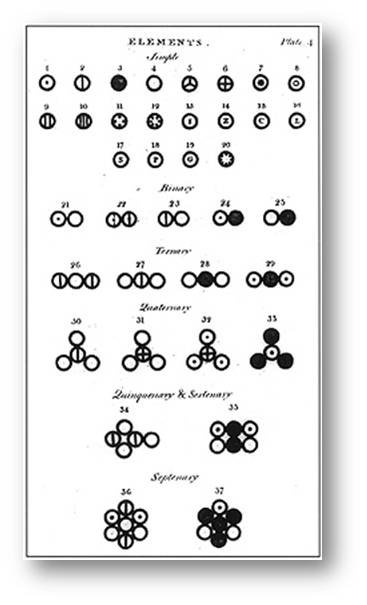

Ein Beispiel, wie Daten zusammengefasst werden, findet sich unter der Rubrik "Key Bionumbers" (Schema).  Schema 1. Eine Zusammenstellung fundamentaler Zahlen für den Zellbiologen. Der Klick auf eine Zahl zeigt deren Quelle und eine ausführliche Beschreibung (häufig in Tabellenform) "BioNumbers" wird koordiniert und entwickelt im Milo lab am Weizmann Institute http://bionumbers.hms.harvard.edu/KeyNumbers.aspx

Schema 1. Eine Zusammenstellung fundamentaler Zahlen für den Zellbiologen. Der Klick auf eine Zahl zeigt deren Quelle und eine ausführliche Beschreibung (häufig in Tabellenform) "BioNumbers" wird koordiniert und entwickelt im Milo lab am Weizmann Institute http://bionumbers.hms.harvard.edu/KeyNumbers.aspx

"Cell Biology by the Numbers"

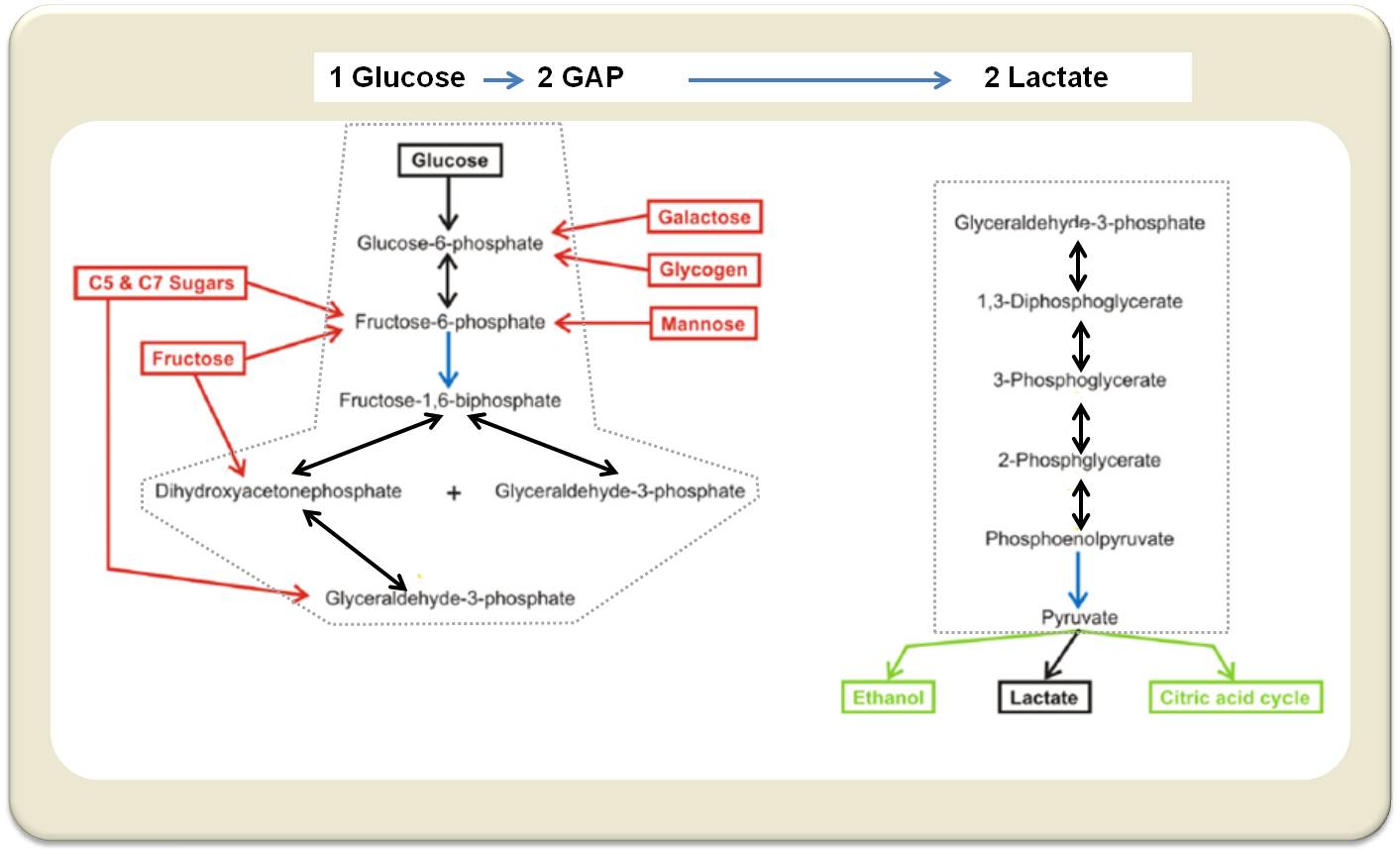

Das knapp 400 Seiten starke Buch [2] führt den Leser in grandioser Weise zu einem "Zählen in der Biologie". In insgesamt 6 Kapiteln lädt es ein, grundlegende Daten lebender Zellen quantitativ zu erkunden. Die Kapitel befassen sich mit der Größe und Geometrie von Zellen, mit Konzentrationen, mit Energien und Kräften, mit Geschwindigkeiten, mit Information und Fehlerbreite. Jedes Kapitel enthält eine Reihe von Skizzen ("Vignetten"), jeweils eingeleitet durch eine Fragestellung. Die Antwort erfolgt in Form leicht verständlicher, kurzer Geschichten, die alle relevanten Parameter/Zahlen und erklärende Illustrationen enthalten. Fragen im Kapitel "Größe von Zellen" sind beispielsweise:

Wie groß sind Viren? Wie groß ist E.coli und welche Masse hat es? Wie groß ist eine knospende Hefezelle? Wie groß ist eine menschliche Zelle?

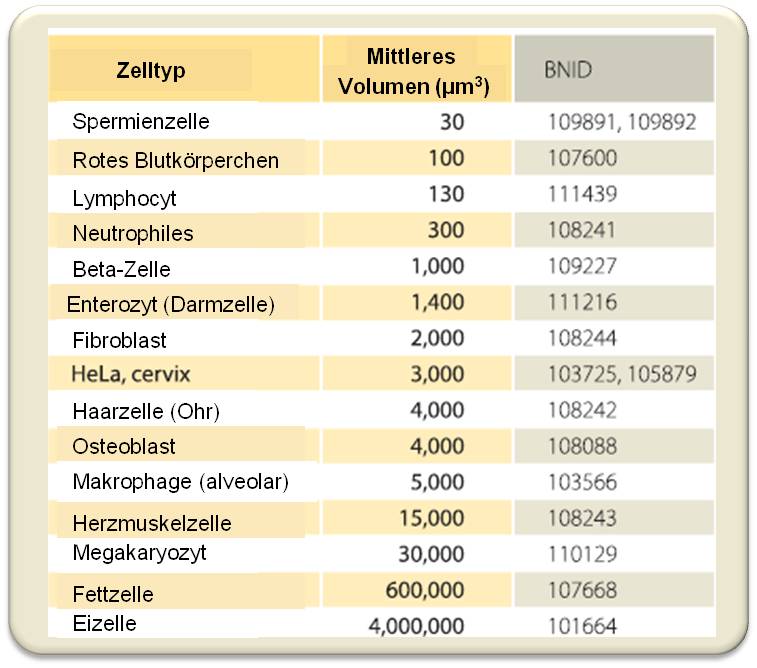

Dass menschliche Zellen sehr unterschiedliche Größe haben können, ist in der folgenden Tabelle dargestellt.

Tabelle. Charakteristische Volumina menschlicher Zellen. Für Zellen wie Neuronen oder Fettzellen werden Größenunterschiede von bis zu mehr als dem Zehnfachen beobachtet. Andere Zellen - z.B. rote Blutkörperchen - haben nur geringe Größenunterschiede. 1μm: 1/1000 mm; ein Volumen 1μm3 wiegt - auf Wasser bezogen - 1picogram (1/Milliardstel mg). BNID: BioNumbers Identification Number, werden auf der Website "BioNumbers" oder von Google aus aufgerufen und bieten Referenzen und Kommentare. (Quelle: http://book.bionumbers.org/ p. 44; adaptiert)

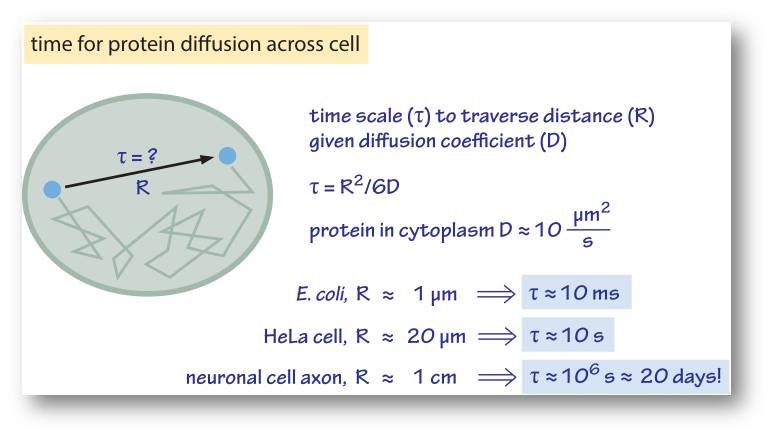

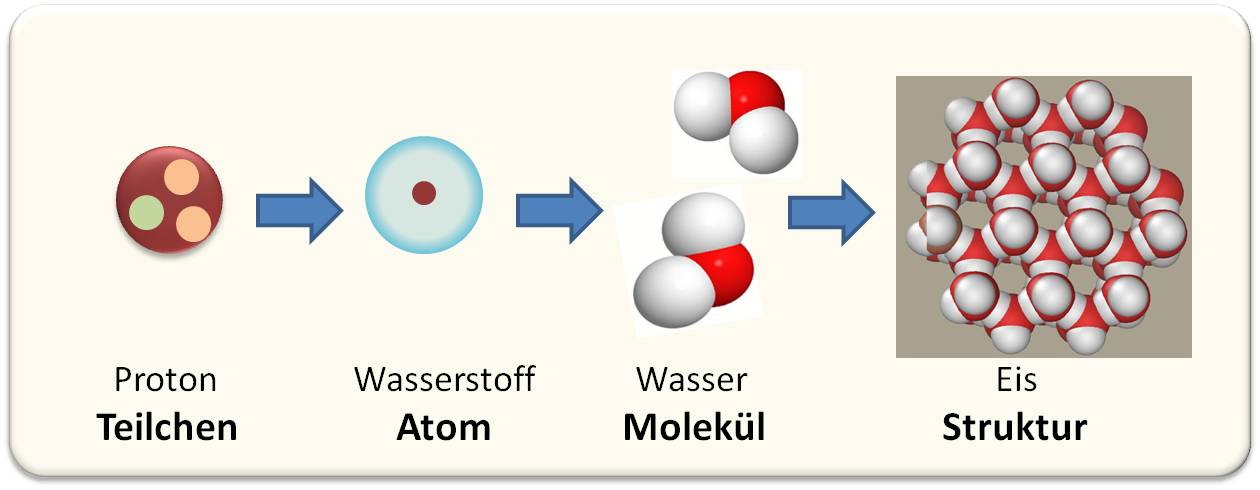

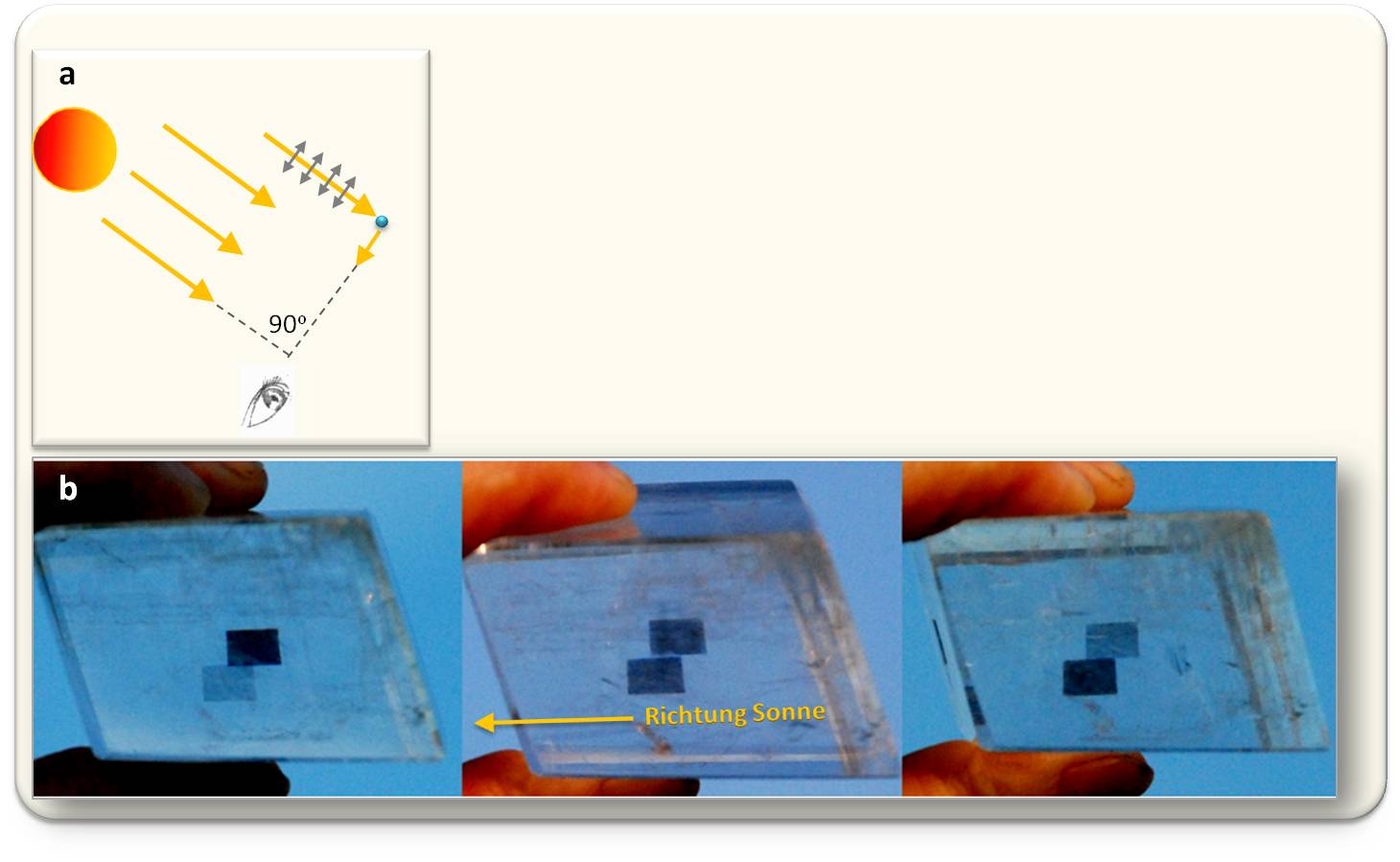

Ein ganz wesentlicher Aspekt dieser Skizzen ist aber, dass zu einzelnen Fragestellungen Berechnungen ausgeführt werden. Es sind Überschlagsrechnungen. Mit deren Hilfe kann der Leser nachvollziehen, wie einige der Schlüsseldaten zustandekommen und selbst ähnliche Abschätzungen für seine eigenen Zwecke anwenden. Als Beispiel ist hier die Abschätzung angeführt: Wie lange braucht ein Proteinmolekül, um von einem Ende der Zelle zum anderen zu gelangen (Abbildung).

Abbildung. Welche Zeit braucht ein Protein um eine Zelle durch Diffusion zu durchqueren? Die Überschlagsrechnung nimmt ein relativ kleines Protein (MW: 30 000 D) an, sein Diffusionskoeffizient D (in μm2/s) gilt für das proteinreiche Zellplasma, der Faktor 6 im Nenner der Gleichung berücksichtigt Diffusion in alle 3 Dimensionen. Die Distanz R hängt von der Zellgröße ab. Erstaunliches Ergebnis:Diffusion entlang eines 1 cm langen Axons einer Nervenzelle würde 20 Tage in Anspruch nehmen. (Quelle: http://book.bionumbers.org/ p. 362).

Abbildung. Welche Zeit braucht ein Protein um eine Zelle durch Diffusion zu durchqueren? Die Überschlagsrechnung nimmt ein relativ kleines Protein (MW: 30 000 D) an, sein Diffusionskoeffizient D (in μm2/s) gilt für das proteinreiche Zellplasma, der Faktor 6 im Nenner der Gleichung berücksichtigt Diffusion in alle 3 Dimensionen. Die Distanz R hängt von der Zellgröße ab. Erstaunliches Ergebnis:Diffusion entlang eines 1 cm langen Axons einer Nervenzelle würde 20 Tage in Anspruch nehmen. (Quelle: http://book.bionumbers.org/ p. 362).

Fazit

Von der Fülle an Informationen, welche die Datenbank "BioNumbers" und das vor kurzem online und im Printformat erschienene "Cell Biology by the Numbers" bieten, konnte hier natürlich nur ein winziger Ausschnitt gebracht werden. Das Buch ist leicht zu lesen, ganz nach Belieben absatzweise, kapitelweise. Es bringt sowohl dem Wissenschafter dringend benötigte Daten als auch dem interessierten Laien Einblicke in die Parameter, die das Leben von Zellen steuern. Es verführt ihn zum Schmökern und macht ihm völlig neue Zusammenhänge klar, lässt ihn vielleicht sogar selbst Abschätzungen über biologische Prozesse ausführen.

Zweifellos ist den Autoren Ron Milo und Rob Phillips mit ihrem Buch ein Meilenstein auf dem Weg zu einer quantitativen Biologie geglückt.

[1] BioNumbers database Milo et al. Nucl. Acids Res. (2010) 38 (suppl 1): D750-D753. http://bionumbers.hms.harvard.edu/

[2] Ron Milo, Rob Phillips, Cell Biology by Numbers . Draft: online free accessible http://book.bionumbers.org/ Printed: Garland Science, Taylor & Francis Group (December 07, 2015) [3] The autobiography of Charles Darwin by Charles Darwin. http://www.gutenberg.org/files/2010/2010-h/2010-h.htm

homepage Ron Milo: http://www.weizmann.ac.il/plants/Milo/

homepage Rob Phillips: http://www.rpgroup.caltech.edu/people/phillips.html

Weiterführende Links

- Ron Milo: A sixth sense for understanding our cells. TEDxWeizmannInstitute . Video 15:01 min. Veröffentlicht am 20.08.2014.

- Rob Phillips: "A Vision for Quantitative Biology" given at the iBioMagazine in August 2010. Video 15:15 min.

Vorlesungszyklus von Ron Milo

Cell Biology by the Numbers, 2014

6 Vorlesungen, die im Wesentlichen die Kapitel des gleichnamigen Buchs zum Inhalt haben und insbsondere Überschlagsrechnungen zum Inhalt haben. Die Dauer der Vorlesungen liegt zwischen 1:03 und 1:38 Stunden.

1) https://www.youtube.com/watch?v=DV0JjwrBVU4

2) https://www.youtube.com/watch?v=rcFfDkgJG2Y

3) https://www.youtube.com/watch?v=H7DVKQS69W8

4) https://www.youtube.com/watch?v=M54MQ_14UBk

5) https://www.youtube.com/watch?v=YFyC0kus0-E

6) https://www.youtube.com/watch?v=2RBmPLPfzKg

Artikel im ScienceBlog

- Redaktion, 22.12.2016. Kenne Dich selbst - aus wie vielen und welchen Körperzellen und Mikroben besteht unser Organismus?

- Peter Schuster, 23.05.2014. Gibt es einen Newton des Grashalms?

Die Großhirnrinde, ein hochdimensionales, dynamisches System

Die Großhirnrinde, ein hochdimensionales, dynamisches SystemDo, 15.12.2016 - 03:48 — Wolf Singer & Andreea Lazar

Wie schafft es unser Gehirn aus einer Vielzahl an optischen, klanglichen und haptischen Sinneseindrücken einheitliche Wahrnehmungen zu erzeugen? Wie können daraus kohärente Bilder der Welt entstehen? Wolf Singer (Direktor em. am Max-Planck-Institut für Hirnforschung und Leiter des Ernst Strüngmann Instituts für Neurowissenschaften; Frankfurt/M), einer der weltweit profiliertesten Neurowissenschafter, und Andreea Lazar (Postdoc am Max-Planck-Institut für Hirnforschung) zeigen hier auf , dass die Funktionsabläufe in unserem Gehirn nicht zentral organisiert sind, sondern in hohem Maße parallel erfolgen. Dass in der Großhirnrinde ein Prinzip der Informationskodierung und Verarbeitung verwirklicht ist, welches auf der hohen Dimensionalität dynamischer Zustände von rekurrierend gekoppelten Netzwerken basiert.*

Wahrnehmen beruht auf Rekonstruktion

Damit Sinnessignale Wahrnehmungen werden können, müssen sie unter Hinzuziehung von Vorwissen, das im Gehirn gespeichert ist, geordnet und interpretiert werden. Ein erheblicher Anteil dieser Rekonstruktionen wird von der Großhirnrinde erbracht. Wie einzigartig diese Leistung ist, wird deutlich, wenn man bedenkt, dass zum Beispiel auf der Netzhaut des Auges durch den optischen Apparat lediglich eine zweidimensionale, kontinuierliche Verteilung elektromagnetischer Wellen erzeugt wird, die sich in ihrer Intensität und Wellenlänge unterscheiden.

Aus dieser Information, die über die Nervenzellen in der Netzhaut in neuronale Erregungen verwandelt und an die Hirnrinde weitergeleitet wird, erzeugt das Gehirn dann das, was wir wahrnehmen: dreidimensionale Objekte, die voneinander und dem Hintergrund deutlich abgegrenzt und damit identifizierbar sind. Es ist dies eine Leistung, die selbst von den besten derzeit verfügbaren technischen Mustererkennungssystemen nur unter eingeschränkten und relativ stereotypen Bedingungen erbracht werden kann. Unser Gehirn löst diese Aufgabe mühelos und in Bruchteilen einer Sekunde.

Eine notwendige Voraussetzung für diesen Verarbeitungsschritt, der als Szenen- oder Bildsegmentierung benannt wird, ist der Vergleich der einlaufenden Sinnessignale mit gespeicherten Modellen über die Struktur der Sehwelt. Das Gehirn weiß bereits, wie Objekte beschaffen sind und nutzt dieses Vorwissen, um die verfügbaren Sinnessignale zu ordnen und miteinander so zu verbinden, dass voneinander abgegrenzte Gestalten erkennbar werden. Schon in den Dreißigerjahren des letzten Jahrhunderts haben Gestaltpsychologen wie Wertheimer, Koffka und Köhler, die unter anderem in Frankfurt tätig waren, diejenigen Gestaltprinzipien herausgearbeitet, nach denen unsere Gehirne Objekte voneinander abgrenzen.

So zeichnet sich ein Objekt dadurch aus, dass es eine kontinuierliche, geschlossene Umrandung aufweist, dass sich alle seine Konturen mit der gleichen Geschwindigkeit in die gleiche Richtung bewegen, wenn sich das Objekt bewegt, dass seine Bestandteile gewisse Merkmale gemein haben, beispielsweise miteinander verbunden zu sein, oder die gleiche Farbe oder Textur zu haben. Viele psychophysische Experimente verweisen darauf, dass diese Regeln im Gehirn abgespeichert sind und über alle Spezies hinweg große Ähnlichkeiten aufweisen. Letzteres ist nicht verwunderlich, da wir alle in der gleichen Welt leben, mit den gleichen Wahrnehmungsproblemen konfrontiert sind und sich im Laufe der Evolution der Arten eine optimale Strategie herausgebildet hat.

"Wir bilden nicht ab, wir konstruieren"

Das Wissen über Gestaltprinzipien ist zum großen Teil angeboren und in der Verschaltung der Großhirnrindenareale niedergelegt, die sich mit der Verarbeitung von Sinnessignalen befassen. Uns ist nicht bewusst, dass wir über diese Regeln verfügen, da sie über evolutionäre Ausleseprozesse optimiert, in den Genen gespeichert und in der Architektur unseres Nervensystems niedergelegt wurden. Ein Teil der Gestaltkriterien wird jedoch im Laufe der frühen Hirnentwicklung durch Erfahrung erlernt und ebenfalls durch strukturelle Veränderungen in den entsprechenden Neuronennetzen gespeichert und steht dann genauso wie das angeborene Vorwissen für die Interpretation von Sinnessignalen zur Verfügung.

Eine zentrale und noch weitestgehend ungelöste Frage ist nun, wie die Verrechnung der eingehenden Sinnessignale mit dem gespeicherten Vorwissen erfolgt. Einige Randbedingungen, die im Folgenden erläutert werden, lassen erahnen, dass es sich hier um einen ganz außergewöhnlichen Vorgang handeln muss, für den es keine triviale Erklärung geben kann.

Ein geheimnisvolles Speichermedium

Zur Veranschaulichung des Problems muss in Erinnerung gerufen werden, dass Menschen, aber das gilt auch für die meisten anderen Tierarten mit hoch differenzierten Sehsystemen, etwa viermal in der Sekunde die Blickrichtung wechseln, um die Sehwelt zu erkunden oder Bilder auf ihren Gehalt hin abzutasten. Dies bedeutet, dass die Vergleichsoperationen zwischen einlaufenden Sinnessignalen und dem gespeicherten Vorwissen in etwa 200 Millisekunden erfolgen muss. Wenn der Segmentierungsprozess ein vertrautes Objekt isoliert, ist auch der Erkennungsprozess innerhalb von wenigen hundert Millisekunden abgeschlossen. Dies bedeutet, dass auch das gesamte im Gehirn gespeicherte Wissen über Objekte, denen man im Laufe des Lebens begegnet ist, in einem Speicher abgelegt sein muss, der es erlaubt, auf beliebige Inhalte innerhalb von Bruchteilen einer Sekunde zuzugreifen.

In den heute für die Musterverarbeitung verwendeten Computersystemen ist für jeden gespeicherten Inhalt ein adressierbarer Speicherplatz reserviert und die Suche nach dem gewünschten, für den Abgleich erforderlichen Speicherinhalt erfolgt im Wesentlichen seriell. Diese einfache Strategie ist hoch effizient, weil Elektronenrechner mit sehr hoher Taktfrequenz arbeiten können und deshalb die Suchzeiten erträglich sind.

…ein parallel strukturierter Suchprozess

Im Gehirn kann eine solche Strategie keinesfalls realisiert sein, da die Zeitkonstanten, mit denen Neuronen arbeiten, um viele Größenordnungen länger sind als die von Transistoren. Es muss also ein anderes Prinzip verwirklicht sein. Es muss ein Speicherplatz konfiguriert werden, in dem eine unvorstellbare Zahl von Inhalten so gestapelt werden kann, dass auf sie ein parallel strukturierter Suchprozess angewandt werden kann, sodass die Zugriffszeit nur unwesentlich von der Lage des zu suchenden Inhaltes abhängt.

Bei einer seriellen Anordnung wie in den Speichern von Elektronenrechnern dauert die Suche nach Inhalten am Ende der Liste naturgemäß länger als für solche, die am Anfang stehen. Dies scheint bei dem im Gehirn realisierten Speicherprozess nicht der Fall zu sein. Es muss also ein Raum geschaffen werden, der die Überlagerung einer sehr großen Zahl von Inhalten erlaubt - es ist leicht zu sehen, dass ein solcher Raum eine sehr hohe Dimensionalität aufweisen muss. Der dreidimensionale kartesianische Raum, in diesem Fall also eine anatomisch segregierte Anordnung von Inhalten, scheidet aus. Hochdimensionale Räume können jedoch erschlossen werden, wenn die Zeit als Kodierungsdimension hinzugezogen wird und der Raum durch distinkte Zustände eines dynamischen Systems definiert wird. In diesem Fall muss dafür gesorgt werden, ein dynamisches System zu erzeugen, dass eine sehr, sehr große Zahl unterschiedlicher Zustände annehmen kann. Jedem dieser Zustände könnte dann ein ganz bestimmter Inhalt zugeordnet werden. Es muss dann lediglich eine Möglichkeit gefunden werden, dass dieses System beim Eintreffen der Suchsignale, in unserem Fall der Signale von Sinnesorganen, sehr schnell in den Zustand einschwingt, der einem gespeicherten Inhalt entspricht.

Die Arbeitshypothese, die wir in Frankfurt seit geraumer Zeit verfolgen,

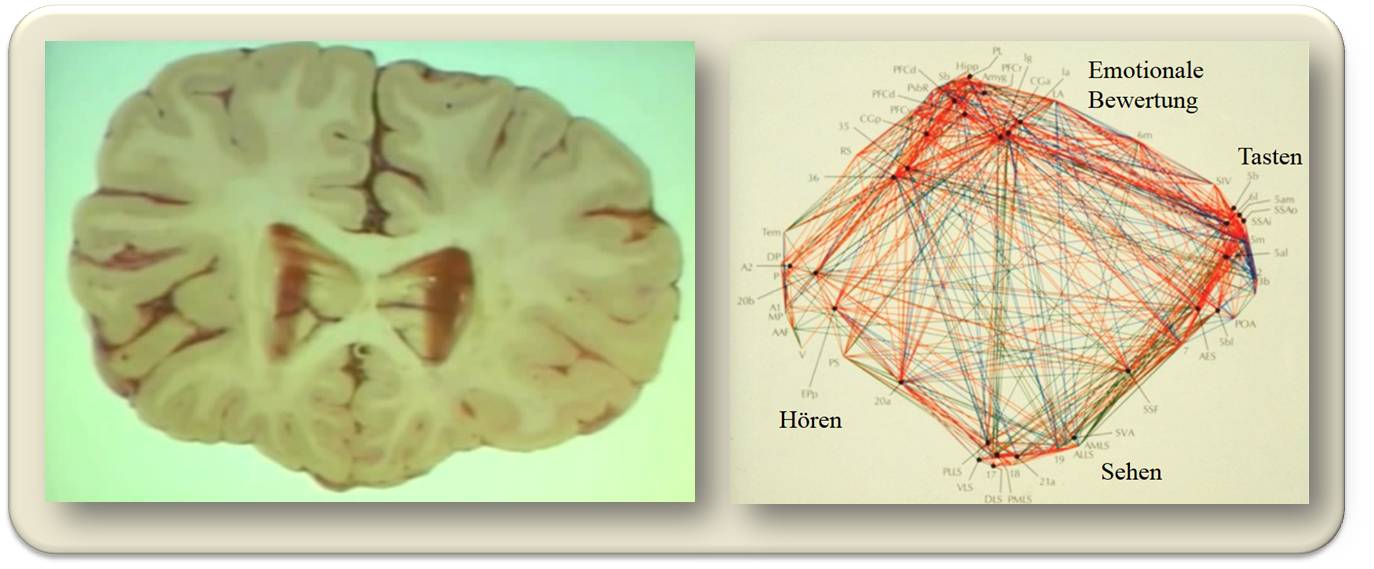

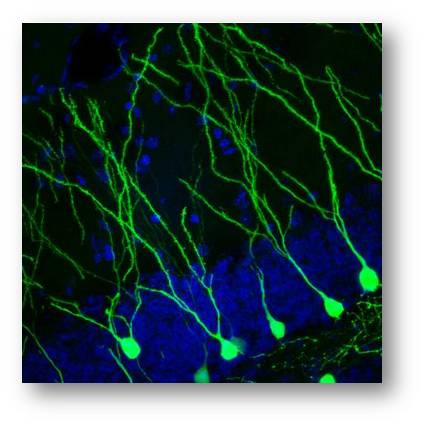

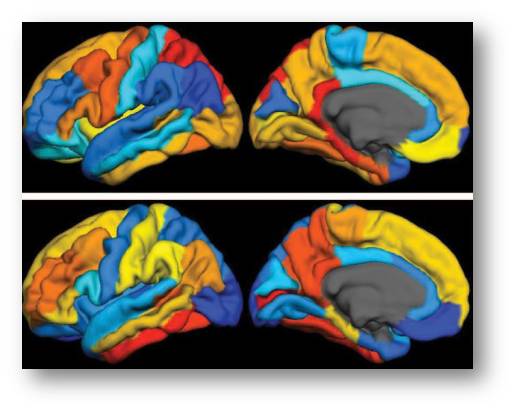

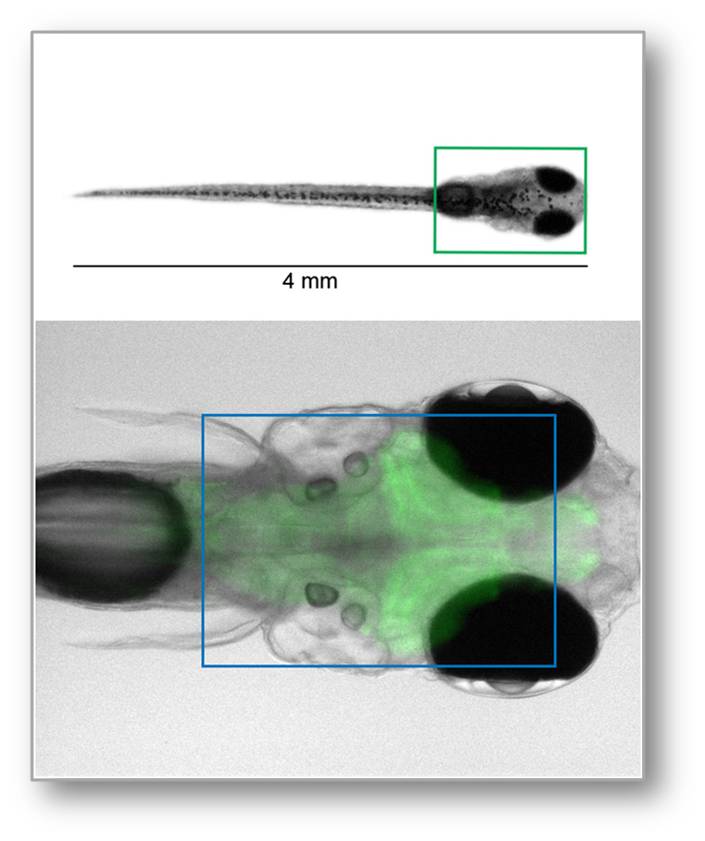

geht davon aus, dass die Großhirnrinde (Abbildung 1) als ein dynamisches System verstanden werden kann, das die geforderten Eigenschaften aufweist.

Abbildung 1. Das Gehirn. Links: Querschnitt des menschlichen Gehirns. Die wenige Millimeter dicke Großhirnrinde (Cortex), Teil der grauen Substanz, ist dicht gepackt mit Nervenzellen- rund 60 000 je mm3 - von denen jede mit bis zu 20 000 anderen Nervenzellen "spricht" und von ebenso vielen aus der Nachbarschaft und von weiter entfernten Bereichen "angesprochen" wird. Die in allen Bereichen nahezu identische interne Struktur der Großhirnrinde weist auf nahezu idente, darin ablaufende Verarbeitungsprozesse hin, die Bereiche erhalten jedoch unterschiedliche Eingangsinformationen. Rechts: Verschaltung der sensorischen Hirnrindenareale (Punkte) von Katzen; neuronale Verkopplungen (Linien) von Milliarden Neuronen.

Abbildung 1. Das Gehirn. Links: Querschnitt des menschlichen Gehirns. Die wenige Millimeter dicke Großhirnrinde (Cortex), Teil der grauen Substanz, ist dicht gepackt mit Nervenzellen- rund 60 000 je mm3 - von denen jede mit bis zu 20 000 anderen Nervenzellen "spricht" und von ebenso vielen aus der Nachbarschaft und von weiter entfernten Bereichen "angesprochen" wird. Die in allen Bereichen nahezu identische interne Struktur der Großhirnrinde weist auf nahezu idente, darin ablaufende Verarbeitungsprozesse hin, die Bereiche erhalten jedoch unterschiedliche Eingangsinformationen. Rechts: Verschaltung der sensorischen Hirnrindenareale (Punkte) von Katzen; neuronale Verkopplungen (Linien) von Milliarden Neuronen.

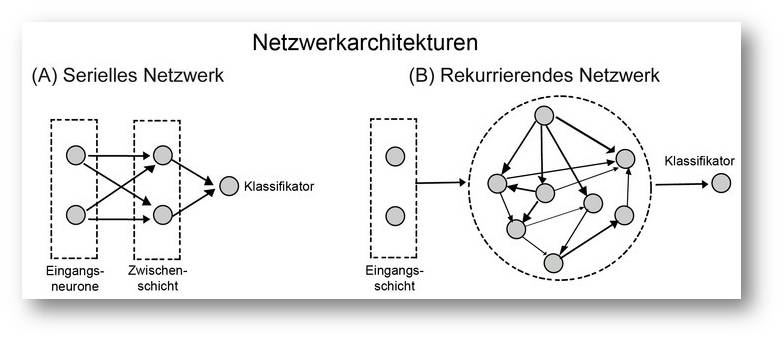

Eines der dominierenden Verschaltungsprinzipien ist, dass Neuronengruppen in der Großhirnrinde reziprok miteinander verbunden sind, sich also gegenseitig beeinflussen können. Wegen der riesigen Zahl von Neuronen, die in einem bestimmten Hirnrindenareal miteinander wechselwirken können, entsteht eine ungeheuer komplexe, hochdimensionale Dynamik, die den erforderlichen Kodierungsraum bereitstellen könnte. Hinzukommt, und das ist eine Entdeckung, die wir in Frankfurt vor mehr als zwanzig Jahren machten, dass lokale Gruppen von Neuronen – die Knoten im Netzwerk – wie Oszillatoren schwingen können (Abbildung 2). Dies erhöht noch einmal mehr die Komplexität der möglichen Dynamik, da auch der Phasenraum zur Kodierung mit genutzt werden kann.

Abbildung 2. (A) Ein klassisches neuronales Netz, wie es in vielen Mustererkennungssystemen verwendet wird. Eingangssignale werden auf eine Schicht von Neuronen verteilt und durch divergente Verschaltungen in Zielneuronen rekombiniert. Dadurch entsteht ein spezifisches Aktivitätsmuster, das dann von Ausgangsneuronen klassifiziert wird. Die Verbindungen von der Zwischenschicht auf die Ausgangsneuronen werden durch einen maschinellen Lernvorgang so gewichtet, dass auf ein gegebenes Muster in der Zwischenschicht nur ein bestimmtes Neuron in der Ausgangsschicht erregt wird. (B) Die Zwischenschicht wurde durch ein rekurrierend gekoppeltes Netzwerk ersetzt. Dieses entwickelt hoch komplexe, dynamische Zustände, die jedoch nach wie vor für die Eingangsmuster spezifisch sind. Die Aktivität einiger dieser Netzwerkknoten wird wiederum auf Ausgangsneurone verteilt, die dann ebenfalls über einen Lernvorgang zu Klassifikatoren für die komplexen Muster ausgebildet werden.© Ernst-Strüngmann Institut/Singer, Lazar, Benzaid

Abbildung 2. (A) Ein klassisches neuronales Netz, wie es in vielen Mustererkennungssystemen verwendet wird. Eingangssignale werden auf eine Schicht von Neuronen verteilt und durch divergente Verschaltungen in Zielneuronen rekombiniert. Dadurch entsteht ein spezifisches Aktivitätsmuster, das dann von Ausgangsneuronen klassifiziert wird. Die Verbindungen von der Zwischenschicht auf die Ausgangsneuronen werden durch einen maschinellen Lernvorgang so gewichtet, dass auf ein gegebenes Muster in der Zwischenschicht nur ein bestimmtes Neuron in der Ausgangsschicht erregt wird. (B) Die Zwischenschicht wurde durch ein rekurrierend gekoppeltes Netzwerk ersetzt. Dieses entwickelt hoch komplexe, dynamische Zustände, die jedoch nach wie vor für die Eingangsmuster spezifisch sind. Die Aktivität einiger dieser Netzwerkknoten wird wiederum auf Ausgangsneurone verteilt, die dann ebenfalls über einen Lernvorgang zu Klassifikatoren für die komplexen Muster ausgebildet werden.© Ernst-Strüngmann Institut/Singer, Lazar, Benzaid

Falls die Großhirnrinde tatsächlich hochdimensionale Dynamik nutzt, um den Abgleich von einlaufenden Signalen mit gespeicherten Inhalten vorzunehmen, dann müssen eine Reihe von überprüfbaren Voraussagen zutreffen. Bei der Formulierung dieser Voraussagen standen die Ergebnisse von theoretischen Arbeiten und Simulationsstudien über künstliche neuronale Netzwerke Pate.

Die Eigenschaften solcher Netzwerke werden seit etwa einer Dekade untersucht, weil sie wegen ihrer hochdimensionalen Dynamik bestimmte Vorteile für die maschinelle Klassifizierung von raumzeitlich strukturierten Mustern aufweisen. Diese informationsverarbeitende Strategie wurde unter dem Namen "reservoir computing" bekannt. Wenn raumzeitlich strukturierte Eingangssignale an einige Knoten solcher Netzwerke verteilt werden, findet man, dass aufgrund der Wechselwirkungsdynamik die Information über den verwendeten Reiz eine Weile gespeichert bleibt und dass sich die Aktivitätsmuster von sequenziell dargebotenen Reizen überlagern, sodass zu einem bestimmten Zeitpunkt die Information über mehrere Reize gleichzeitig verfügbar ist. Und schließlich erweist sich, dass solche Systeme wegen der hohen Dimensionalität ihres Zustandsraumes die Trennung und Klassifizierung von Eingangsmustern sehr erleichtern.

Bestätigte Voraussagen und Überraschungen

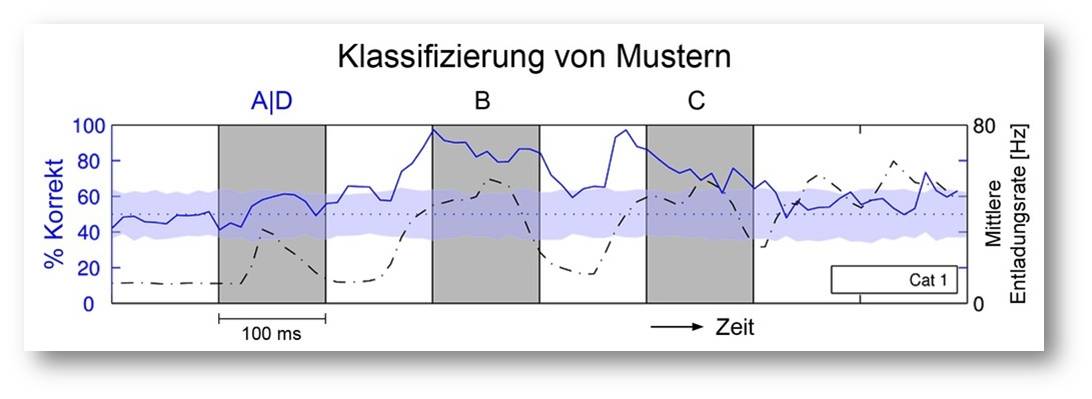

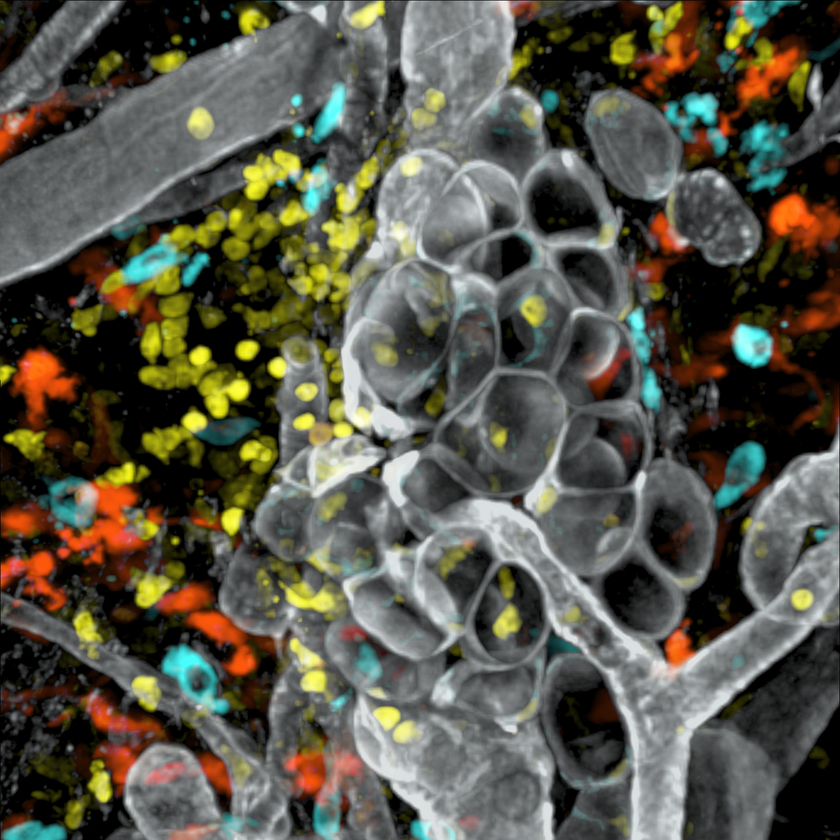

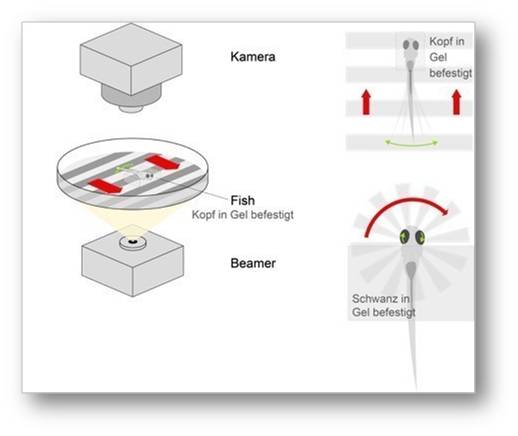

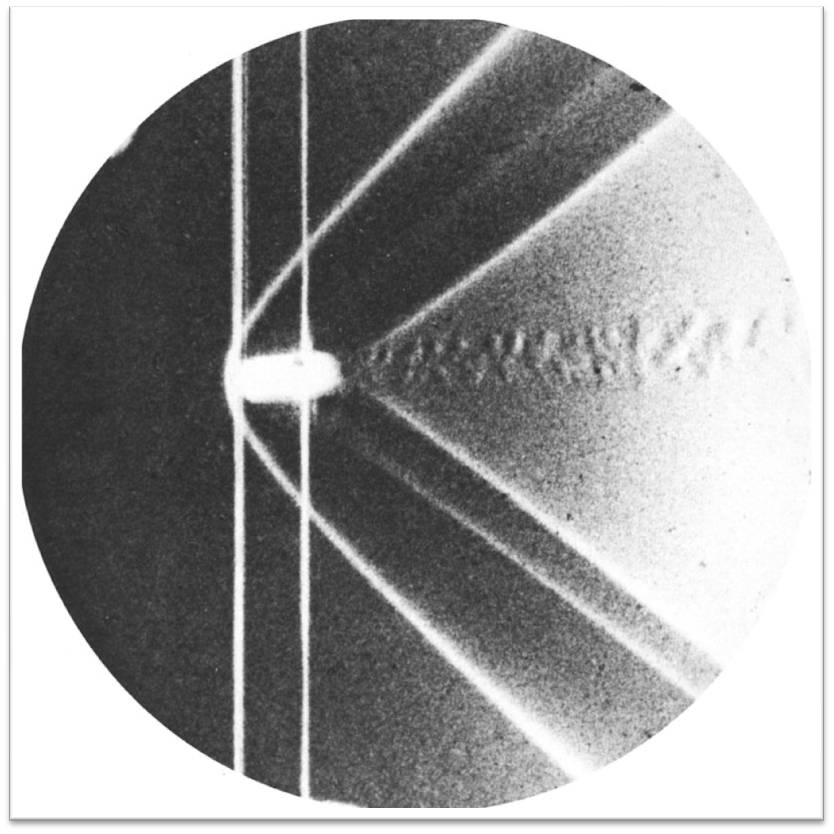

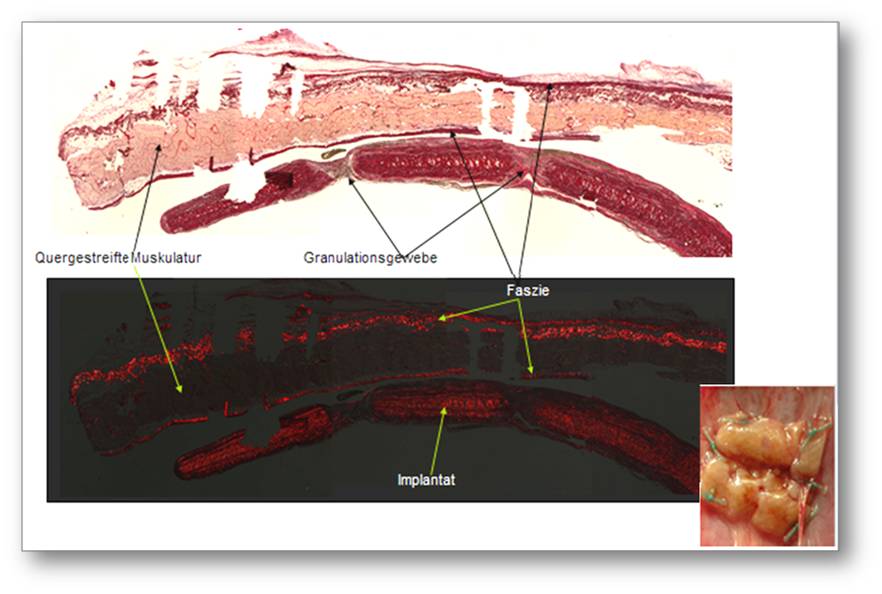

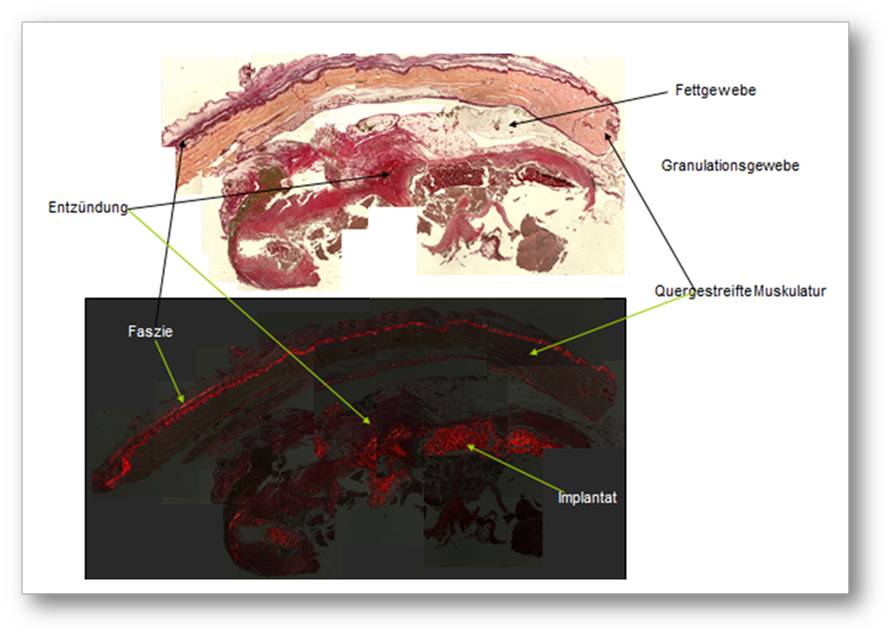

Ein Schwerpunkt unserer Arbeiten lag in den vergangenen Jahren darauf, die oben aufgeführten Voraussagen zu testen. Hierzu ist es erforderlich, die Aktivität einer großen Zahl (>50) von Neuronen (Knoten) der Großhirnrinde gleichzeitig zu erfassen, Sinnesreize darzubieten, die resultierende Netzwerkdynamik zu analysieren und mit Hilfe von Methoden aus dem Bereich des maschinellen Lernens dahingehend zu prüfen, ob reizspezifische Informationen in der raumzeitlichen Verteilung der neuronalen Aktivitätsmuster zu finden sind. Um diese Messungen durchführen zu können, werden Tieren in Vollnarkose haarfeine Elektroden in die Großhirnrinde implantiert, über die später die Aktivität der Nervenzellen registriert werden kann. Die hierbei eingesetzten Verfahren ähneln im Detail jenen, die bei Patienten angewandt werden, die aus diagnostischen Gründen Elektroden implantiert bekommen oder um Hirnstrukturen zu reizen, wie das bei der Therapie der Parkinsonschen Erkrankung routinemäßig erfolgt. Die Messungen selbst sind schmerzfrei und bedeuten für die Tiere keine wesentliche Einschränkung, da das Gehirn schmerzunempfindlich ist und die sehr feinen und flexiblen Elektroden bei sachgemäßer Implantation keine Schäden verursachen. Mit Hilfe solcher Untersuchungen konnten wir im Laufe der letzten Jahre die oben aufgeführten Voraussagen bestätigen und die eingangs formulierte Hypothese stützen (Abbildung 3).

Abbildung 3. Hier wurde überprüft, ob sich aus der Aktivität von 60 zufällig ausgewählten Neuronen der Sehrinde einer Katze rückschließen lässt, welcher Reiz (A oder D) zu Beginn einer Serie von Reizen (A/D, B, C) dargeboten wurde. Linke Ordinate: Prozentsatz der richtigen Klassifizierungen (durchgezogene Linie); Rechte Ordinate: Gemittelte Aktivität der Neuronen (gestrichelte Linie); Abszisse: Zeitverlauf der Reizdarbietung. Etwa 100 Millisekunden nach Darbietung des ersten Reizes lässt sich mit fast 100%iger Sicherheit aus dem Erregungsmuster der Neuronen feststellen, welches der erste Reiz (A oder D) war, und diese Information ist auch nach Darbietung des zweiten Reizes (B) noch fast vollständig erhalten. Erst nach dem dritten Reiz (C) sinkt die Klassifizierbarkeit auf das Zufallsniveau ab (graues Band). © Ernst-Strüngmann Institut/Singer, Lazar, Benzaid

Abbildung 3. Hier wurde überprüft, ob sich aus der Aktivität von 60 zufällig ausgewählten Neuronen der Sehrinde einer Katze rückschließen lässt, welcher Reiz (A oder D) zu Beginn einer Serie von Reizen (A/D, B, C) dargeboten wurde. Linke Ordinate: Prozentsatz der richtigen Klassifizierungen (durchgezogene Linie); Rechte Ordinate: Gemittelte Aktivität der Neuronen (gestrichelte Linie); Abszisse: Zeitverlauf der Reizdarbietung. Etwa 100 Millisekunden nach Darbietung des ersten Reizes lässt sich mit fast 100%iger Sicherheit aus dem Erregungsmuster der Neuronen feststellen, welches der erste Reiz (A oder D) war, und diese Information ist auch nach Darbietung des zweiten Reizes (B) noch fast vollständig erhalten. Erst nach dem dritten Reiz (C) sinkt die Klassifizierbarkeit auf das Zufallsniveau ab (graues Band). © Ernst-Strüngmann Institut/Singer, Lazar, Benzaid

Wie so oft in der Grundlagenforschung zeigten die Daten aber auch vollkommen Unerwartetes. Es stellte sich heraus, dass es im Verlauf der Untersuchungen zunehmend leichter wurde, die von den dargebotenen Reizen erzeugten Aktivitätsmuster zu klassifizieren und den Reizen zuzuordnen. Dies konnte nur bedeuten, dass das kortikale Netzwerk bestimmte, reizspezifische Merkmalskombinationen gelernt und dem Fundus von Vorwissen hinzugefügt hat. Offenbar bewirkte die wiederholte Darbietung der Reizmuster eine Veränderung der Netzwerkeigenschaften, die ihrerseits dafür sorgten, dass die entstehenden hochdimensionalen Muster im Netzwerk weniger überlappten und deshalb besser voneinander unterscheidbar wurden. Diese Vermutung erhält ihre direkte Bestätigung durch eine mathematische Analyse der respektiven Muster.

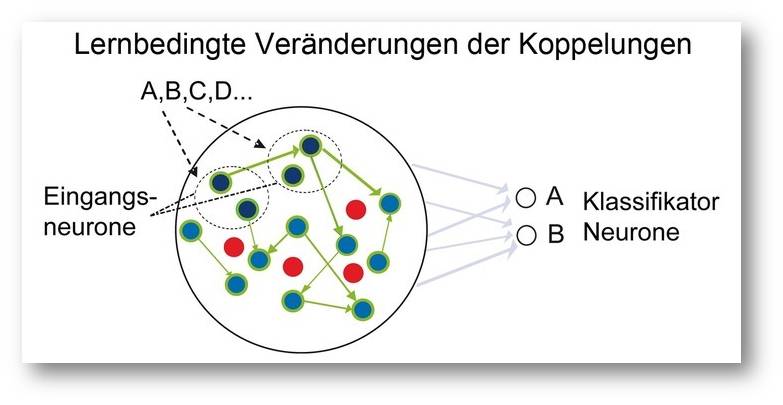

Als Mechanismus für diese lernbedingten Veränderungen vermuten wir eine aktivitätsabhängige Veränderung der Effizienz der reziproken Verbindungen zwischen den Neuronen. Hinweise für solche erfahrungsabhängigen Veränderungen der synaptischen Effizienz eben dieser Verbindungen hatten wir bereits vor Jahren in Experimenten erhalten, bei denen die Auswirkung von Umweltreizen auf die Ausreifung der Großhirnrinde untersucht wurde. Einen direkten und komplementären Hinweis für das Vorliegen eines solchen Mechanismus lieferte schließlich die Beobachtung, dass die neuronalen Netzwerke auch spontan und ohne jede Reizung die Aktivitätsmuster erzeugen, die von oft gesehenen Reizen hervorgerufen werden. Obgleich weder antizipiert noch gezielt gesucht, bilden diese zusätzlichen Befunde eine starke Stütze für die Hypothese, dass die hochdimensionale Dynamik kortikaler Netzwerke tatsächlich genutzt wird, um sensorische Signale mit gespeicherten Vorwissen zu vergleichen und im Falle der Stimmigkeit zu klassifizieren.

Plausibilitätskontrollen durch Simulationen

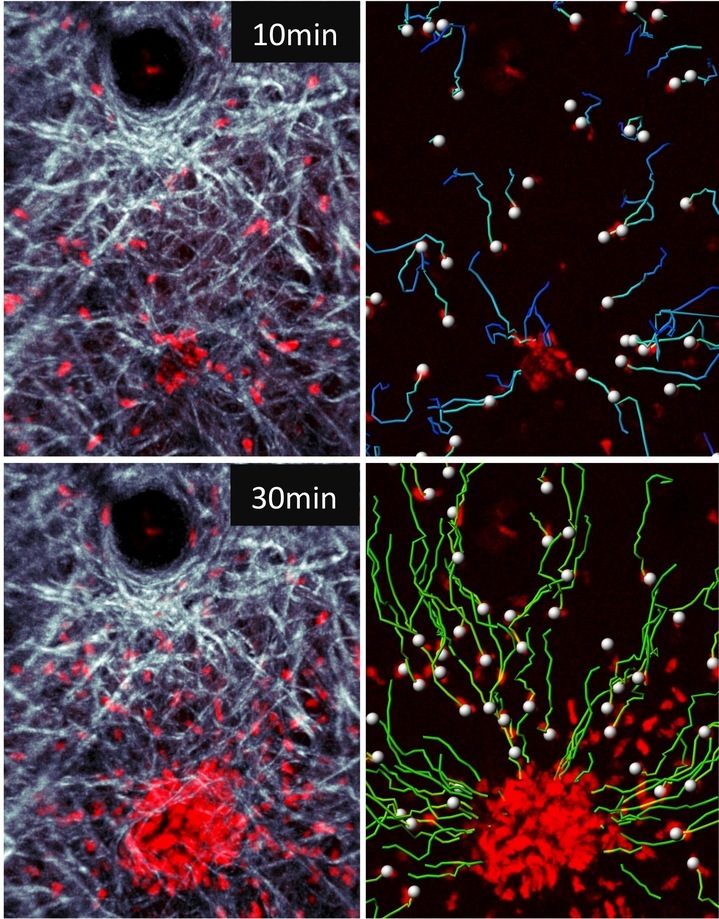

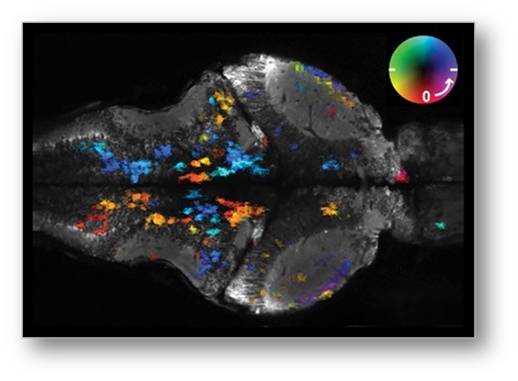

Jetzt stand es an zu klären, ob reizspezifische Veränderungen in der Stärke der reziproken Koppelungsverbindungen zwischen den Neuronen (Knoten) tatsächlich eine Verbesserung der Klassifizierungsleistungen solcher Netzwerke mit sich bringen. Hierzu haben Andreea Lazar und Jochen Triesch auf konventionellen Rechnern rückgekoppelte Netzwerke simuliert und die Koppelverbindungen mit adaptiven Synapsen ausgestattet, die ihre Effizienz in Abhängigkeit von der Struktur der auftretenden Aktivierungsmuster verändern können (Abbildung 4).

Abbildung 4. Schematische Darstellung des Effektes wiederholter Reizdarbietung in einem simulierten Netzwerk. Die ursprünglich gleich effizienten Verbindungen zwischen den Neuronen im Netzwerk werden entsprechend den verschiedenen Reizen verstärkt (dicke Verbindungen) oder abgeschwächt (dünne oder fehlende Verbindungen), wodurch die von verschiedenen Reizen induzierten, dynamischen Muster sich zunehmend voneinander unterscheiden und besser klassifizierbar werden. © Ernst-Strüngmann Institut/Singer, Lazar, Benzaid

Abbildung 4. Schematische Darstellung des Effektes wiederholter Reizdarbietung in einem simulierten Netzwerk. Die ursprünglich gleich effizienten Verbindungen zwischen den Neuronen im Netzwerk werden entsprechend den verschiedenen Reizen verstärkt (dicke Verbindungen) oder abgeschwächt (dünne oder fehlende Verbindungen), wodurch die von verschiedenen Reizen induzierten, dynamischen Muster sich zunehmend voneinander unterscheiden und besser klassifizierbar werden. © Ernst-Strüngmann Institut/Singer, Lazar, Benzaid

Diese Modifikationen erfolgten nach Regeln, die bereits bei Untersuchungen von Lernvorgängen an realen neuronalen Strukturen erarbeitet worden waren. Die simulierten Netzwerke mit adaptiven Verbindungen wurden daraufhin mit unterschiedlichen Reizsequenzen aktiviert und es zeigte sich, dass sich die Klassifizierungsleistung dieser sich selbst adaptierenden Netzwerke mit wiederholter Reizdarbietung, man könnte auch sagen mit zunehmender Erfahrung, deutlich verbesserte und weit über das hinaus ging, was konventionelle rekurrierende Netzwerke zu leisten vermögen.

Diese Kongruenz von experimentellen und simulierten Daten macht es in unseren Augen sehr wahrscheinlich, dass in der Großhirnrinde ein Kodierungsprinzip verwirklicht ist, das sich deutlich von allen bisher entweder postulierten oder in künstlichen Systemen realisierten Musterverarbeitungsprozessen unterscheidet. Sollte sich diese Vermutung in zukünftigen Untersuchungen bestätigen, wären wir einen Schritt weiter im Verständnis der nach wie vor rätselhaften Funktion der Großhirnrinde. Vielleicht, so die Hoffnung, wird uns das helfen, die ebenfalls rätselhaften Mechanismen besser zu verstehen, die jenen psychischen Erkrankungen zu Grunde liegen, die auf Störungen von Großhirnrindenfunktionen beruhen.

Mit Sicherheit wird es möglich sein, die gewonnenen Erkenntnisse für die Entwicklung völlig neuartiger informationsverarbeitender Systeme zu nutzen.

Literaturhinweise

1. Lazar, A.; Pipa, G., Triesch, J. SORN: a self-organizing recurrent neural network . Frontiers in Computational Neuroscience 3:23 (2009)

2. Nikolic, D.; Häusler, S.; Singer, W.; Maass, W. Distributed fading memory for stimulus properties in the primary visual cortex. PLOS Biology 7: e1000260 (2009)

3. Singer, W. Cortical dynamics revisited. Trends in Cognitive Sciences 17: 616-626 (2013)

*Der unter dem Titel "Die Großhirnrinde, ein hochdimensionales, dynamisches System" im Jahrbuch der Max-Planck Gesellschaft 2016 erschienene Artikel (https://www.mpg.de/9974873/ESI_JB_2016?c=10583665 ) wurde mit freundlicher Zustimmung des Autors und der MPG-Pressestelle ScienceBlog.at zur Verfügung gestellt. Er erscheint hier leicht gekürzt (Abbildung 3 des Originals wurde weggelassen) und für den Blog adaptiert (Für's leichtere Scrollen wurden einige Untertitel und Absätze eingefügt. Zur Erläuterung von Hirnrinde und Verschaltung der sensorischen Hirnrindenareale wurde Abbildung 1 von der Redaktion eingefügt, die beiden Bilder stammen vom Autor.) .

Weiterführende Links

AIL-Talk: Wolf Singer - Neuronale Grundlagen des Bewusstseins. Video 1:29:27 from Angewandte Innovation Lab. 07.09.2016. https://vimeo.com/184970876

Wolf Singer: The encoding of semantic relations. Conference: East-West Connections, NTU Para Limes. Video (englisch) 1:19:15; 11.11.2016. (Standard Youtube Lizenz) Wolf Singer - Vom Bild zur Wahrnehmung. Iconic Turn - Felix Burda Memorial Lectures. Video 2:03:05; 22.08.2012.(Standard Youtube Lizenz) Wolf Singer: Hirnentwicklung und Umwelt oder Wie Wissen erworben und gespeichert wird.

Wozu braucht unser Gehirn so viel Cholesterin?

Wozu braucht unser Gehirn so viel Cholesterin?Do, 08.12.2016 - 08:37 — Inge Schuster

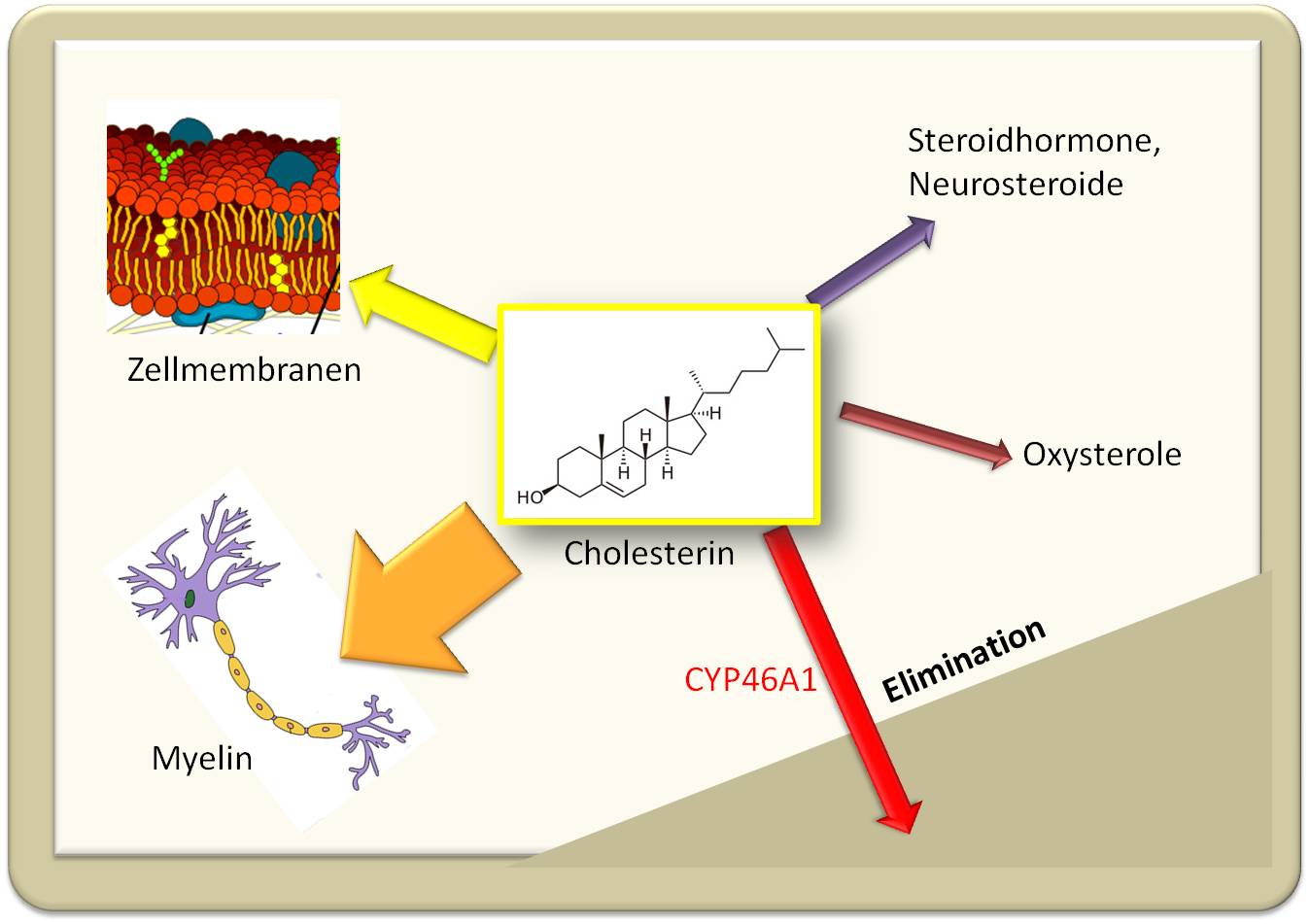

Unser Gehirn enthält enorm hohe Mengen an Cholesterin, das sowohl essentieller Baustein der Nervenfasern ist, als auch Quelle vieler hormonell aktiver Neurosteroide und Oxysterole. Da die Blut-Hirnschranke eine Aufnahme von Cholesterin aus dem Blut verhindert, muss das Hirn seinen Bedarf an Cholesterin selbst synthetisieren. Die empfindliche Balance zwischen Synthese von Cholesterin und Eliminierung von überschüssigem Cholesterin wird durch Oxysterole reguliert.

Wenn man nach dem Organ fragt, das den höchsten Cholesteringehalt in unserem Körper aufweist, so ist die Antwort klar: es ist dies unser Gehirn. Mit rund 1,4 kg macht das Hirn zwar nur 2 % der gesamten Körpermasse eines Erwachsenen aus, es enthält aber 25 % des darin enthaltenen Cholesterin. In Zahlen ausgedrückt: bis zu 37 g Cholesterin finden sich im Hirn; bezogen auf die Trockenmasse des Gehirns, das rund 80 % Wassergehalt aufweist, bestehen also > 10% der Gehirnsubstanz aus Cholesterin. In unserem gesamten Blut zirkulieren dagegen nur 7% des gesamten Cholesterins.

Um es gleich vorweg zu nehmen: das Cholesterin im Hirn kann nicht über das Blut dorthin gelangen. Um die Blutgefäße, die das Gehirn versorgen, herum existiert eine sehr effiziente, dichte Barriere - die sogenannte „Blut-Hirn Schranke“ -, die den Import von Cholesterin aus dem Blut und ebenso auch den Export von überschüssigem Cholesterin in den zirkulierenden Blutstrom verhindert. Das Hirn ist also darauf angewiesen, Cholesterin selbst zu synthetisieren.

Wozu aber braucht das Hirn so viel Cholesterin?

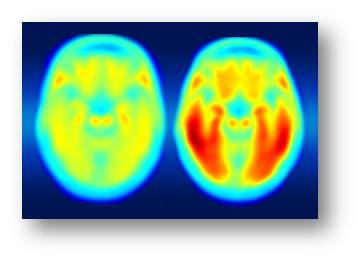

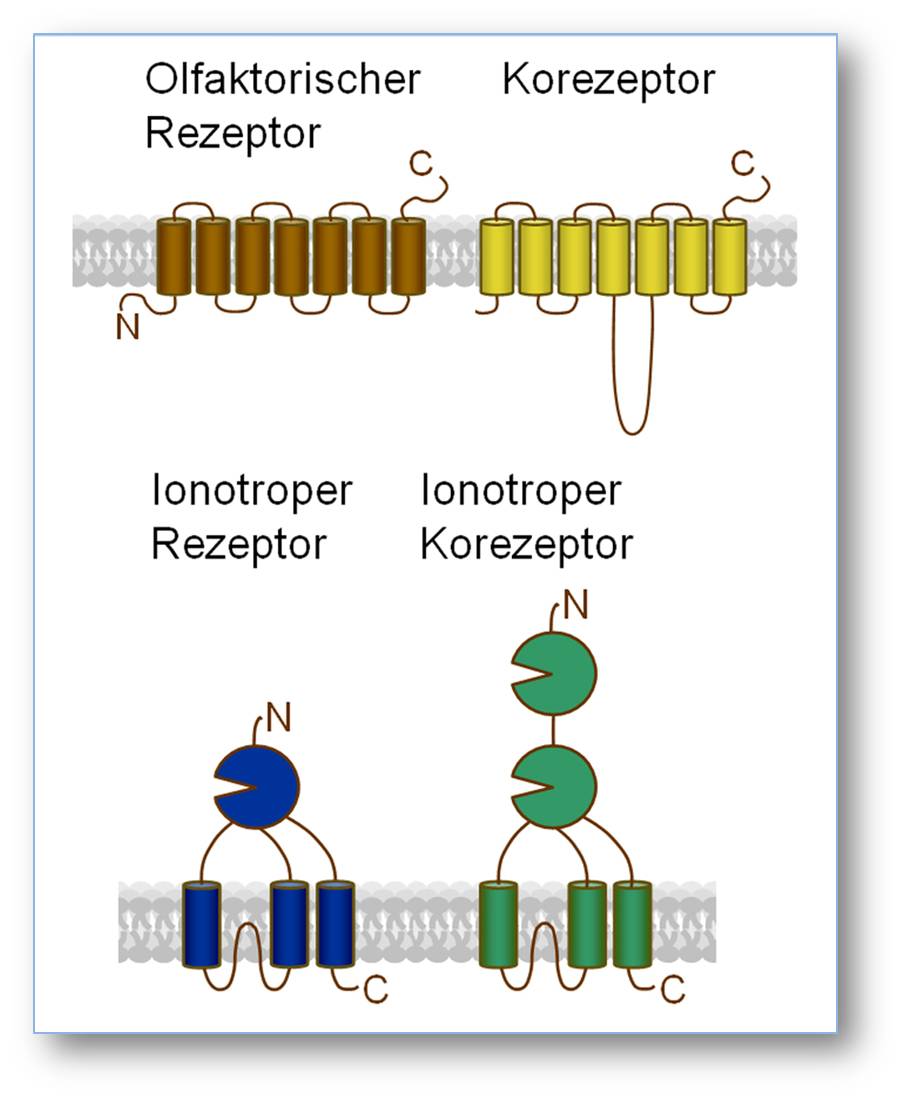

Cholesterin ist sowohl ein essentieller struktureller Baustein - vor allem in dem aus Zellmembranen generierten Myelin - als auch eine Quelle vieler hormonell aktiver Substanzen - der sogenannten Neurosteroide - und von Signalmolekülen, den Oxysterolen. Über diese Funktionen gibt Abbildung 1 einen groben Überblick .

Abbildung 1. Cholesterin ist integraler Bestandteil von Zellmembranen, Hauptkomponente der Axone umhüllenden Myelinschichten, Quelle von Steroidhormonen und Oxysterolen. Die Eliminierung aus dem Gehirn kann im Wesentlichen nur über die von CYP46A1 katalysierte Bildung eines Oxysterols erfolgen. (Bilder: Zellmembranen und Neuron stammen aus Wikipedia und sind gemeinfrei).

Abbildung 1. Cholesterin ist integraler Bestandteil von Zellmembranen, Hauptkomponente der Axone umhüllenden Myelinschichten, Quelle von Steroidhormonen und Oxysterolen. Die Eliminierung aus dem Gehirn kann im Wesentlichen nur über die von CYP46A1 katalysierte Bildung eines Oxysterols erfolgen. (Bilder: Zellmembranen und Neuron stammen aus Wikipedia und sind gemeinfrei).

Cholesterin in Zellmembranen…

Wie auch in allen anderen Körperzellen ist Cholesterin integraler Bestandteil der äußeren Zellmembran und der intrazellulären Membranen von Hirnzellen - d.i. von Neuronen und Gliazellen. Cholesterin trägt entscheidend zur Permeabilitätsbarriere zwischen Zelle und Umgebung, zwischen intrazellulärem Kompartiment und angrenzender Umgebung bei, reguliert die Plastizität (Fluidität) der Membranen und moduliert Aktivität und Funktion von darin eingebetteten Signalmolekülen. Eine einzigartige Rolle kommt dabei den Zellmembranen spezieller Gliazellen zu, sogenannter Oligodendriten, welche kompakte isolierende Myelinschichten bilden.

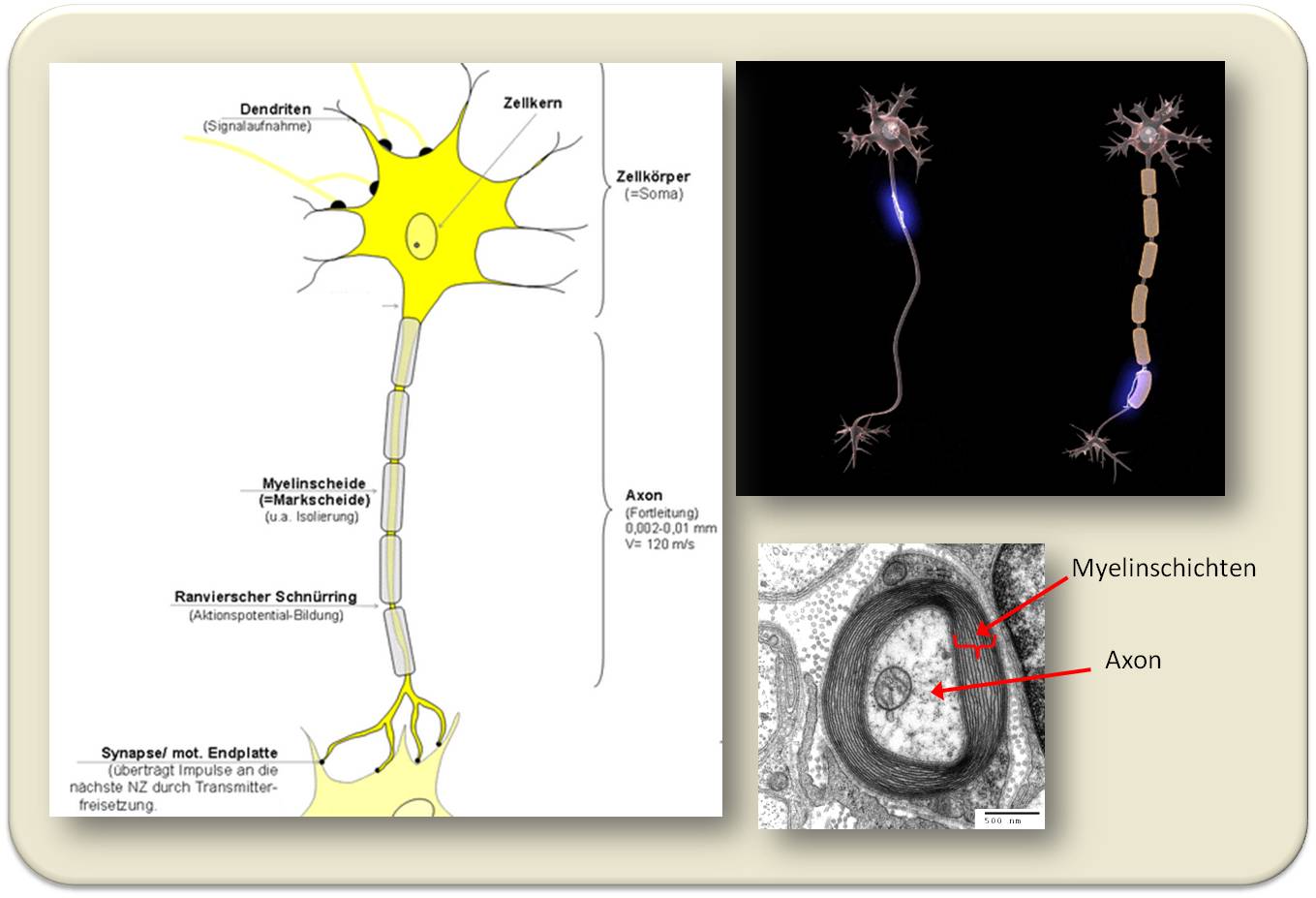

…speziell im Myelin

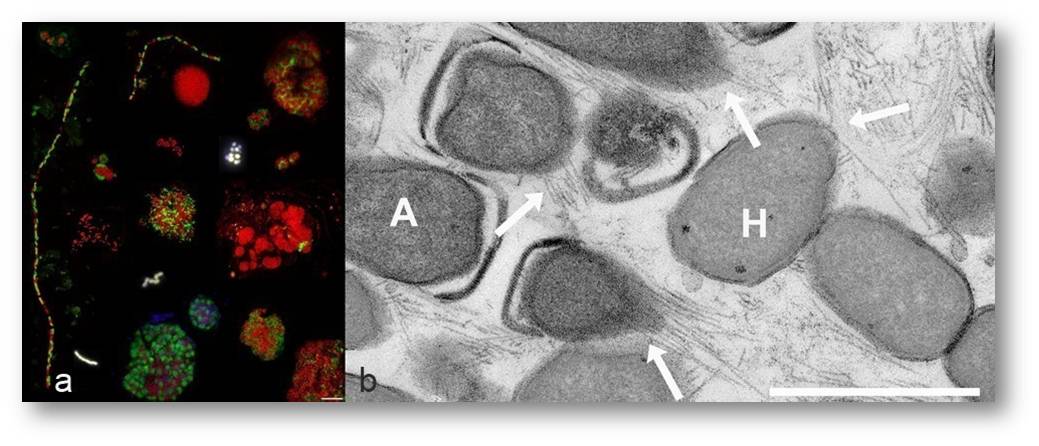

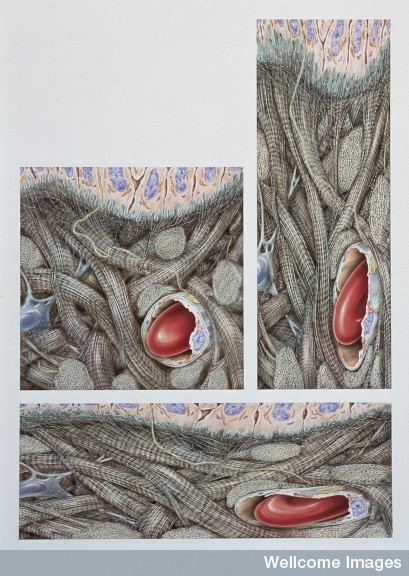

Der Großteil des Cholesterins befindet sich in einer fettreichen Myelin genannten Substanz: diese besteht bis zu 80 % aus Lipiden - unterschiedlichen Phospholipiden, Glykolipiden, Sphingolipiden - und inkludiert 22 % Cholesterin, welches damit die in höchster Konzentration vertretene Einzelstruktur ist. Wie erwähnt, entsteht Myelin aus den Zellmembranen von Oligodendriten, die sich spiralförmig viele Male um die Fortsätze (Axone) der Nervenzellen (Neuronen) wickeln und diese so elektrisch von der Umgebung isolieren (Abbildung 2, rechts unten). Die spezielle Struktur dieser Isolationsschicht mit Einschnürungen (Ranvierschen Schnürringen) ermöglicht eine sprunghafte, höchst effiziente und rasche Weiterleitung des elektrischen Nervenimpulses vom Zellköper der Nervenzelle entlang seines Axons zur nächsten Nervenzelle. Abbildung 2.

Da Myelin optisch weiß erscheint, sieht man das Hirn dort, wo die Nervenfasern in sehr hoher Dichte vorliegen, als“weiße Substanz” .

Abbildung 2. Das Axon einer Nervenzelle (links) ist umhüllt von einer (unterbrochenen) Isolationsschicht aus Myelin, entstanden durch vielfache Umwicklung mit der Zellmembran von speziellen Gliazellen (im Querschnitt rechts unten).Die Struktur der Isolationsschicht erlaubt eine wesentlich raschere und effizientere Weiterleitung des elektrischen Signals als dies bei einer ununterbrochenen Nervenfaser der Fall wäre (rechts oben). (Bilder aus Wikipedia. links: H.Hoffmeister, Impulsfortleitung an der Nervenzelle - cc-by-sa 3.0; rechts: Dr. Jana - http://docjana.com/#/saltatory ; https://www.patreon.com/posts/4374048, cc-by 4.0 ; Transmission electron micrograph, Electron Microscopy Facility at Trinity College, Hartford CT)

Abbildung 2. Das Axon einer Nervenzelle (links) ist umhüllt von einer (unterbrochenen) Isolationsschicht aus Myelin, entstanden durch vielfache Umwicklung mit der Zellmembran von speziellen Gliazellen (im Querschnitt rechts unten).Die Struktur der Isolationsschicht erlaubt eine wesentlich raschere und effizientere Weiterleitung des elektrischen Signals als dies bei einer ununterbrochenen Nervenfaser der Fall wäre (rechts oben). (Bilder aus Wikipedia. links: H.Hoffmeister, Impulsfortleitung an der Nervenzelle - cc-by-sa 3.0; rechts: Dr. Jana - http://docjana.com/#/saltatory ; https://www.patreon.com/posts/4374048, cc-by 4.0 ; Transmission electron micrograph, Electron Microscopy Facility at Trinity College, Hartford CT)

Cholesterin als Quelle von Neurosteroiden…

Dass Steroidhormone verschiedenste Gehirnfunktionen - von der Entwicklung des Nervensystems, inklusive der Ausbildung von Dendriten, von Konnektivitäten der Synapsen und der Myelinisierung bis hin zu den Vorgängen des Erkennens, der Emotionen und den verschiedenartigsten Verhaltensweisen - regulieren, ist seit langem bekannt. Noch vor etwas mehr als einem Jahrzehnt dachte man, dass diese Hormone in den wesentlichen Steroiderzeugenden Organen - den Gonaden, der Placenta, der Nebenniere - gebildet würden und dann über den Blutkreislauf durch die Blut-Hirnschranke hindurch, in das Hirn transportiert würden, um dort ihre physiologischen Wirkungen zu entfalten. (Der Begriff Hormon war ja ursprünglich definiert als: von speziellen Drüsen erzeugter Botenstoff, der über den Blutstrom zum Zielorgan transportiert wird, wo er seine Wirkung entfaltet.) Erst in letzter Zeit wurde es klar, dass Neuronen ebenso wie Gliazellen alle wesentlichen Enzyme zur Steroidhormonsynthese besitzen (es sind hauptsächlich Enzyme aus den Cytochrom P450 Familien). Dementsprechend sind zahlreiche Hirnregionen - u.a. der zerebrale Cortex, der Hippocampus und der Hypothalamus - selbst in der Lage Cholesterin in ein sehr weites Spektrum hormonell aktiver Steroide umzuwandeln. Diese, hier auch als Neurosteroide bezeichneten, Hormone werden also lokal erzeugt und wirken lokal - in der erzeugenden Zelle selbst (autokrine Wirkung) und/oder in benachbarten Zellen (parakrine Wirkung).

…und von Oxysterolen

Oxysterole entstehen durch oxydative Angriffe auf das Cholesterinmolekül. Verursacher sind einerseits Enzyme und hier wiederum hauptsächlich Mitglieder der Cytochrom P450 Familien (darunter solche, die in die Synthese von Steroidhormonen involviert sind), aber auch reaktive Sauerstoffspezies. Es ist eine Fülle unterschiedlicher Oxysterole, die in Proben menschlichen Gehirns nachgewiesen wurden, wobei einige auch aus dem Organismus ins Gehirn gelangt sein können - für Oxysterole stellt die Blut-Hirnschranke kein Hindernis dar.

Welche (patho)physiologische Rolle einzelne Oxysterole im Gehirn spielen, ist Gegenstand intensiver Untersuchungen. Insbesondere werden einige Oxysterole mit der Entstehung von neurodegenerativen Erkrankungen (u.a. Alzheimer-, Huntington-, Parkinsonkrankheit) in Zusammenhang gebracht. Eine vor kurzem veröffentlichte Analyse von Fallstudien aus den letzten 15 Jahren konnte hier aber (auch auf Grund mangelhafter Vergleichbarkeit der Protokolle) noch zu keinen konsistenten Aussagen gelangen. Feststehen dürfte jedoch der Einfluss von Oxysterolen auf die Homöostase des Cholesterin - also auf die Balance zwischen seiner Synthese und seinem Abbaus.

Die Cholesterin Homöostase

Bis vor rund 20 Jahren dachte man, dass die Neurogenese - die Entstehung neuer Nervenzellen - im Zentralnervensystem bereits im frühen Kindesalter abgeschlossen wäre. Heute weiß man, dass abhängig von diversen Stimuli neuronale Stammzellen auch im Alter noch neue Nervenzellen bilden können und, dass dies in Regionen des Hippocampus der Fall ist. Dafür und auch für den lokalen Bedarf an Neurosteroiden benötigt das Gehirn während unserer gesamten Lebensdauer Cholesterin (Abbildung 1), das es, wie eingangs erwähnt, auch zur Gänze selbst herstellen muss. Die Syntheserate ist im Gehirn Erwachsener niedrig, die Verweildauer des Cholesterins im Gehirn lang (Halbwertszeit 5 Jahre).

Die Cholesterinsynthese findet in Gliazellen und in geringerem Maße auch in Neuronen statt. Es ist dies der gleiche Weg, wie auch in allen anderen Körperzellen, der von der aktivierten Essigsäure ausgeht und über viele Stufen (und viele physiologisch wichtige Zwischenprodukte) zum Cholesterin führt. An mehreren Stellen dieses Weges greifen Oxysterole ein und schalten via Regulierung der Transkription von Target-Genen und der Funktion einzelner Proteine die Cholesterinsynthese an oder ab.

Um stets einen weitgehend konstanten Pegel an verfügbaren Cholesterin zu gewährleisten, muss es nicht nur regulierende Eingriffe in die Synthese geben, sondern auch Wege, um ein Zuviel an Cholesterin zu kompensieren. Überschüssiges Cholesterin (z.B. von abgestorbenen Zellen) kann auf Grund der Blut-Hirnschranke ja nicht direkt eliminiert werden. Ingemar Björkhem, ein führender Forscher auf dem Gebiet der Oxysterole, hat ein ein Enzym - CYP46A1 - entdeckt, das praktisch ausschließlich im Hirn (speziell in den Neuronen) vorkommt und Cholesterin zu dem Oxysterol 24S-Hydroxycholesterin oxydiert. Dieses Oxysterol gelangt direkt über die Blut- Hirn Barriere in den Blutstrom - es ist dies der Hauptweg der Cholesterin-Eliminierung. Die resultierenden 24S-Hydroxycholesterin-Blutspiegel sind demnach ein spezifischer Indikator für den Cholesterin-Stoffwechsel des Hirns aus denen aber auch Aussagen über pathologische Zustände und deren Progression oder Reduktion erhalten werden. CYP46A1 ist damit ein Schlüsselenzym der zerebralen Homöostase von Cholesterin. Die Modulierung dieses Enzyms durch Aktivierung oder Inhibierung könnte eine therapeutische Strategie zur Behandlung kognitiver Defekte/neurodegenerativer Erkrankungen darstellen.

Ausblick

Vor dem Hintergrund einer alternden Bevölkerung und einer Zunahme von neurodegenerativen Erkrankungen ist Forschung an Neurosteroiden und Oxysterolen im Gehirn ein vielversprechendes "Hot Topic", das von zahlreichen Gruppen bearbeitet wird. Es steht dabei nicht nur die Hoffnung auf neue therapeutische Ansätze im Vordergrund sondern auch der Wunsch die noch im Alter andauernde Neurogenese in unserem Lernzentrum, dem Hippocampus, zu verstehen und positiv beeinflussen zu können.

Ein wichtiger Aspekt ist natürlich auch die Klärung der Frage, ob und welchen Einfluss die weltweit angewandten Cholesterinsenker (die auch die Blut-Hirnschranke passieren) auf die Homöostase des Cholesterins im Gehirn und seine Funktion ausüben.

Literatur, die in diesen Artikel eingeflossen ist (kann auf Anfrage zugesandt werden):

I.Björkhem (2006) Crossing the barrier: oxysterols as cholesterol transporters and metabolic modulators in the brain. J Int Med 260, Issue 6, 493–508

Spalding KL et al., (2013). Dynamics of hippocampal neurogenesis in adult humans. Cell 153:1219-1277

L.Iuliano et al., (2015) Cholesterol metabolites exported from human brain. Steroids 45(Pt B) · February 2015. DOI: 10.1016/j.steroids.2015.01.026 ·

Winnie Luu et al., (2016) Oxysterols: Old Tale, New Twists. Annu. Rev. Pharmacol. Toxicol. 56:447–67

Miguel Moutinho et al., (2016) Cholesterol 24-hydroxylase: Brain cholesterol metabolism and beyond. Biochimica et Biophysica Acta 1861: 1911–1920

Weiterführende Links

3sat nano - Mythos Cholesterin Video 5:43 min.

Gerhard Roth (Institut für Hirnforschung , Universität Bremen) Das Gehirn (2) | Wie einzigartig ist der Mensch? (6) Video 14:14 min; https://www.youtube.com/watch?v=JPdha_5cTrE (Standard-YouTube-Lizenz)

Arvid Leyh: Neurone: Bausteine des Denkens. Video 2:51 min. https://www.youtube.comwatch?v=usosLatcMK8 (das Gehirn.info, Lizenz: cc-by-nc)

Zum Thema sind im ScienceBlog erschienen:

Inge Schuster 13.09.2013: Die Sage vom bösen Cholesterin

Walter Kutschera 04.10.2013: The Ugly and the Beautiful — Datierung menschlicher DNA mit Hilfe des C-14-Atombombenpeaks. http://scienceblog.at/ugly-and-beautiful-%E2%80%94-datierung-menschliche....

Mutterkorn – von Massenvergiftungen im Mittelalter zu hochwirksamen Arzneimitteln der Gegenwart

Mutterkorn – von Massenvergiftungen im Mittelalter zu hochwirksamen Arzneimitteln der GegenwartDo, 01.12.2016 - 05:25 — Günter Engel

![]() Die Verseuchung von Brotgetreide mit Mutterkorn hat vor allem im Mittelalter zu verheerenden Epidemien - dem Antoniusfeuer - geführt. Als später die Ursache der Vergiftungen erkannt worden waren, begann man die Wirkstoffe des Mutterkorns - Ergotalkaloide - zu erforschen und für therapeutische Anwendungen zu nutzen. Der Biochemiker Günter Engel (Sandoz/Novartis) war an der Charakterisierung der Angriffspunkte dieser Wirkstoffe und der Erfindung entsprechender Therapeutika beteiligt. Sein chemisches Arbeitsgebiet erweckte in ihm das Interesse an mittelalterlicher Kunst.

Die Verseuchung von Brotgetreide mit Mutterkorn hat vor allem im Mittelalter zu verheerenden Epidemien - dem Antoniusfeuer - geführt. Als später die Ursache der Vergiftungen erkannt worden waren, begann man die Wirkstoffe des Mutterkorns - Ergotalkaloide - zu erforschen und für therapeutische Anwendungen zu nutzen. Der Biochemiker Günter Engel (Sandoz/Novartis) war an der Charakterisierung der Angriffspunkte dieser Wirkstoffe und der Erfindung entsprechender Therapeutika beteiligt. Sein chemisches Arbeitsgebiet erweckte in ihm das Interesse an mittelalterlicher Kunst.

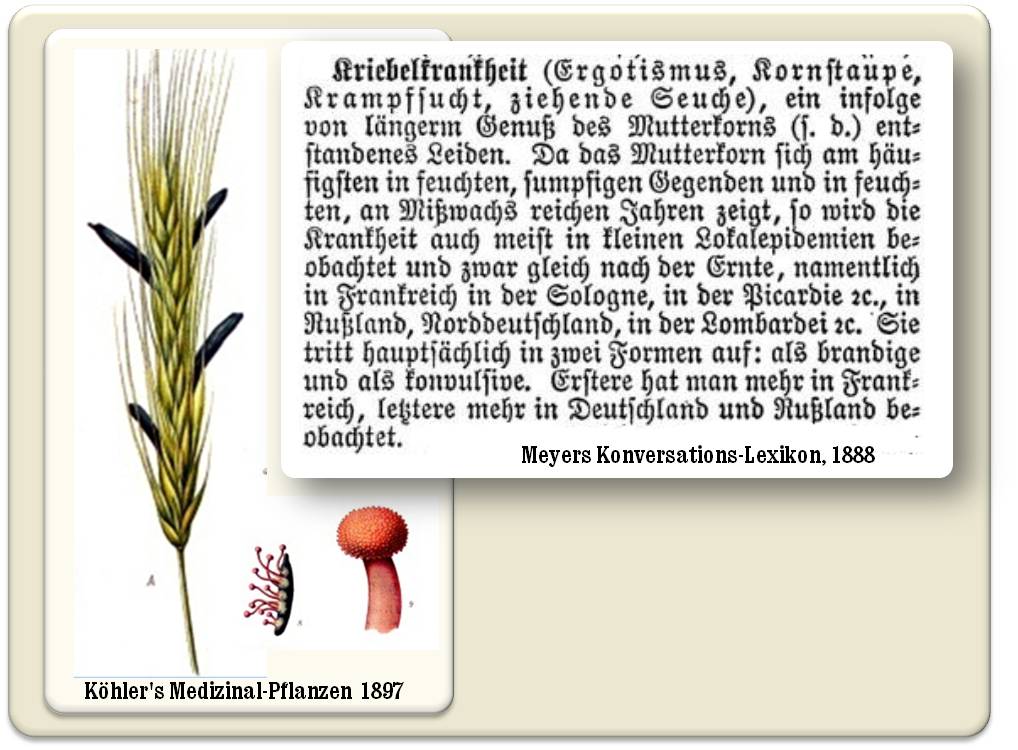

Das Mutterkorn ist die Überwinterungsform (Sklerotium) eines Schlauchpilzes (Claviceps purpurea Tulasne), der vornehmlich Roggen (aber auch viele andere Gräser) befällt und aus dessen Ähren violettschwarze Zapfen herauswachsen (Abbildung 1). Der Name rührt davon her, dass Mutterkorn seit dem frühen Mittelalter von Hebammen zur Beschleunigung der Geburt verwendet wurde. Erst zu Beginn des 20. Jahrhunderts haben englische Chemiker aus Mutterkorn eine auf die Gebärmutter wirkende Substanz isolieren können, die allerdings auf Grund ihrer toxischen Nebenwirkungen- als Ergotoxin bezeichnet - in der Medizin keine Anwendung fand. Mit den Inhaltsstoffen des Mutterkorns, den sogenannten Ergotalkaloiden hat sich dann der Schweizer Chemiker Albert Hofmann (1906 - 2008) in der ersten Hälfte des 20. Jahrhunderts intensiv beschäftigt: auf der Basis dieser Naturstoffe gelang es ihm eine Menge sehr wirksamer Arzneistoffe zu synthetisieren, die heute noch zu den Standardtherapien in einigen Indikationsgebieten zählen.

Abbildung 1. Mutterkorn. Links: das Sklerotium des Schlauchpilzes Claviceps purpurea in einer Roggenähre und der rote aus dem Sklerotium herauswachsende Fruchtträger (Ausschnitt aus Franz Eugen Köhler, Köhler's Medizinal-Pflanzen 1897). Rechts: Meyers Konversationslexikon aus dem Jahr 1888 zeigt, dass damals in Europa lokale Mutterkornepidemien noch vorkamen (Ausschnitt aus: Meyers Konversationslexikon 1888, http://elexikon.ch/1888_bild/10_0208#Bild_1888 ). (Beide Quellen sind älter als 70 Jahre und damit gemeinfrei)

Abbildung 1. Mutterkorn. Links: das Sklerotium des Schlauchpilzes Claviceps purpurea in einer Roggenähre und der rote aus dem Sklerotium herauswachsende Fruchtträger (Ausschnitt aus Franz Eugen Köhler, Köhler's Medizinal-Pflanzen 1897). Rechts: Meyers Konversationslexikon aus dem Jahr 1888 zeigt, dass damals in Europa lokale Mutterkornepidemien noch vorkamen (Ausschnitt aus: Meyers Konversationslexikon 1888, http://elexikon.ch/1888_bild/10_0208#Bild_1888 ). (Beide Quellen sind älter als 70 Jahre und damit gemeinfrei)

Mutterkornvergiftungen

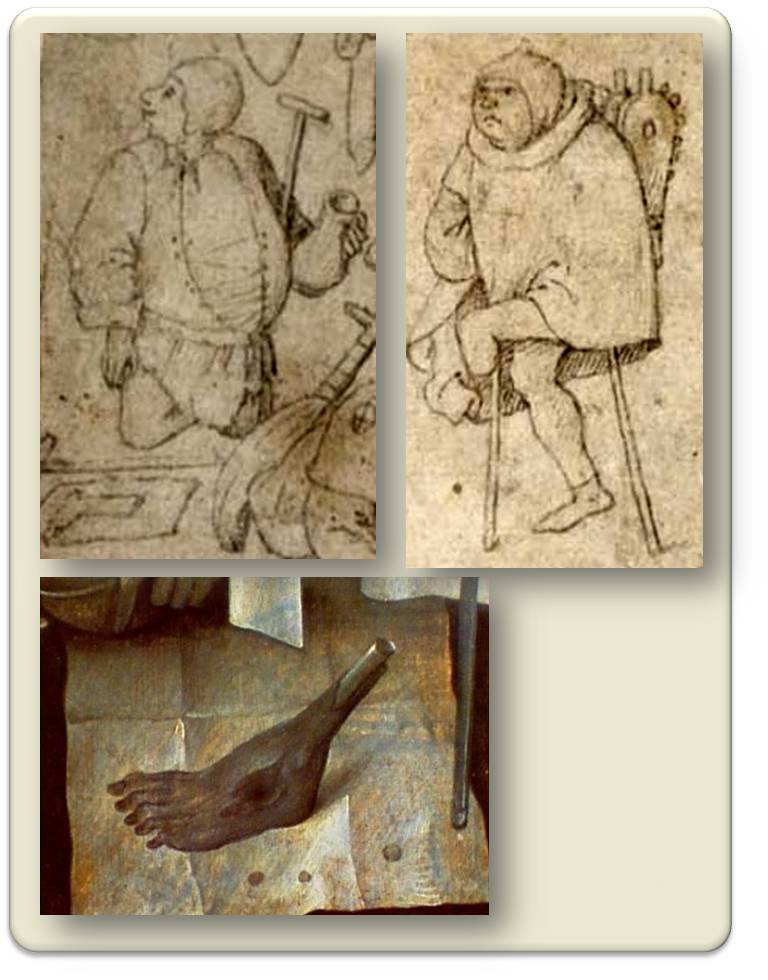

Pharmakologisch gesehen rufen Ergotalkaloide eine "Myriade" von Wirkungen auf Nervensystem und Blutgefäße hervor. Ergotvergiftungen - Ergotismus - manifestieren sich in zwei Formen: dem Ergotismus gangraenosus ("brandigen" Ergotismus) und dem Ergotismus convulsivus (der "Kriebelkrankheit"). Abbildung 1. In sehr hoher Dosierung verabreicht verursachen Ergotalkaloide eine starke Verengung der arteriellen Blutgefäße. Dies führt unter heftigen, brennenden Schmerzen in den befallenen Gefäßen zu einer Mangeldurchblutung bis hin zum völligen Blutstillstand, gefolgt von einer Nekrotisierung und anschließenden Mumifizierung des Gewebes. Letztendlich ergibt sich eine Trennung der Glieder vom übrigen Körper ohne Blutverlust. Das Absterben einzelner Körperteile erfolgt in ganz verschiedenem Ausmaß. Nur selten, wenn Nässe eindringt kommt es zu einem feuchten Gangrän. Nach dem Verlust der erkrankten Extremität tritt häufig eine vollkommene Heilung ein, der Betroffene kann als Krüppel weiterleben. Abbildung 2.

Abbildung 2. Mittelalterliche Darstellungen von Opfern des Ergotismus gangraenosus. Ein Bettler (oben links) hat seinen durch Ergotismus mumifizierten, abgetrennten Fuß vor sich ausgebreitet, ein anderer humpelt davon. (Hieronymus Bosch, Federzeichnungen, Königliche Bibliothek Brüssel). Unten: amputierter Fuß eines Bettlers, auf einem weißen Tuch. (Hieronymus Bosch, Ausschnitt aus dem Triptychon "Das jüngste Gericht", Akademie der bildenden Künste, Wien). Die Antoniter beschäftigten auch Wundärzte, die ohne Narkose (die Glieder waren abgestorben) wie hier dargestellt den Fuß absägten.

Abbildung 2. Mittelalterliche Darstellungen von Opfern des Ergotismus gangraenosus. Ein Bettler (oben links) hat seinen durch Ergotismus mumifizierten, abgetrennten Fuß vor sich ausgebreitet, ein anderer humpelt davon. (Hieronymus Bosch, Federzeichnungen, Königliche Bibliothek Brüssel). Unten: amputierter Fuß eines Bettlers, auf einem weißen Tuch. (Hieronymus Bosch, Ausschnitt aus dem Triptychon "Das jüngste Gericht", Akademie der bildenden Künste, Wien). Die Antoniter beschäftigten auch Wundärzte, die ohne Narkose (die Glieder waren abgestorben) wie hier dargestellt den Fuß absägten.

Die konvulsive Form äußert sich mit Parästhesien - Kribbeln, Ameisenlaufen - der Glieder, schmerzhaften Krämpfen, die an Tetanus erinnern und oft tödlich enden, epilepsieartigen Anfällen und Psychosen.

Epidemien im Mittelalter

Da im Mittelalter der Roggen und damit das daraus hergestellte Brot bis zu zwanzig Prozent Mutterkorn enthielt, brachen nach der Ernte immer wieder Mutterkornvergiftungen in verschiedenen Teilen Europas seuchenartig aus. Diese Vergiftungen - damals Antoniusfeuer (auch ignis sacer – heiliges Feuer) genannt - kamen durch den Verzehr großer Mengen von Ergotalkaloiden zustande - der mittelalterliche Mensch kannte die Ursache nicht und hatte keine Möglichkeit zu deren Vermeidung.

Die arme Landbevölkerung litt viel mehr unter diesen Epidemien als die Adeligen, die sich von Weizen und Fleisch ernährten. Die Hauptnahrung der ärmeren Leute bestand ja vornehmlich aus dunklen Getreideprodukten.

Im Mittelalter herrschte eine abergläubische Vorstellung von dieser Krankheit, sie galt als ein Zeichen des göttlichen Zorns über die Missachtung des Gottesfriedens. Die Verstümmelten wurde als ein warnendes Beispiel angesehen, Personen, die am Ergotismus convulsivus litten, galten als vom Teufel oder von Dämonen besessen, die Mortalität soll sehr groß gewesen sein.

Die Entstehung des Antoniterorden

Da der mittelalterliche Mensch der Krankheit völlig hilflos gegenüberstand, wandte er sich an die Schutzheiligen seiner Gegend. Der Schutzheilige, der bald alle überstrahlen sollte, war der etwa 251 in Ägypten geborene hl. Antonius. Dieser war ein Wüstenheiliger, hatte ein Eremitendasein gewählt und - wie Gemälde des Mittelalters und der beginnenden Neuzeit äußerst suggestiv zeigen - offensichtlich erfolgreich gegen "Dämonen" - Versuchungen durch Wünsche, Triebe, Emotionen, Laster - angekämpft (s.u.). Reliquien dieses Heiligen wurden in einer Kirche eines kleinen Ortes - Saint Antoine - in der Dauphine aufbewahrt. Berichten zufolge soll deren Verehrung zu einer Unzahl an Wunderheilungen geführt haben, der Ort wurde zum Wallfahrtsort und es entstand ein Krankenhaus (um das Jahr 1095), um die vielen kranken, von unerträglichen Schmerzen geplagten Pilger zu versorgen. Schließlich kam es zur Gründung des Ordens der Antoniter, der 1247 von Bonifatius VIII bestätigt wurde.

Die Antoniter waren ein mittelalterlicher Spitalorden oder moderner ausgedrückt eine Krankenhausträgerschaft, die sich ausschließlich derjenigen annahm, die am Antoniusfeuer litten oder auf Grund der Krankheit zu Krüppeln geworden waren. Die Zahl der Krankenhäuser nahm unter der Leitung des Ordens rapide zu - um 1500 gab es bereits 364 dieser Anstalten in Europa.

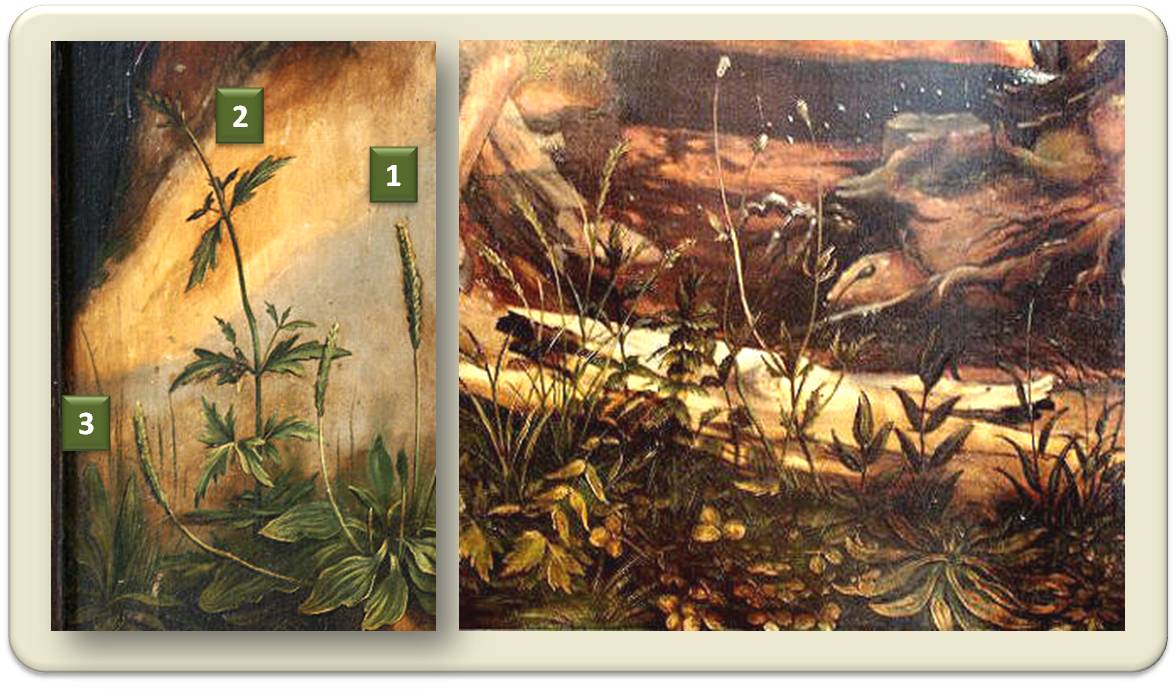

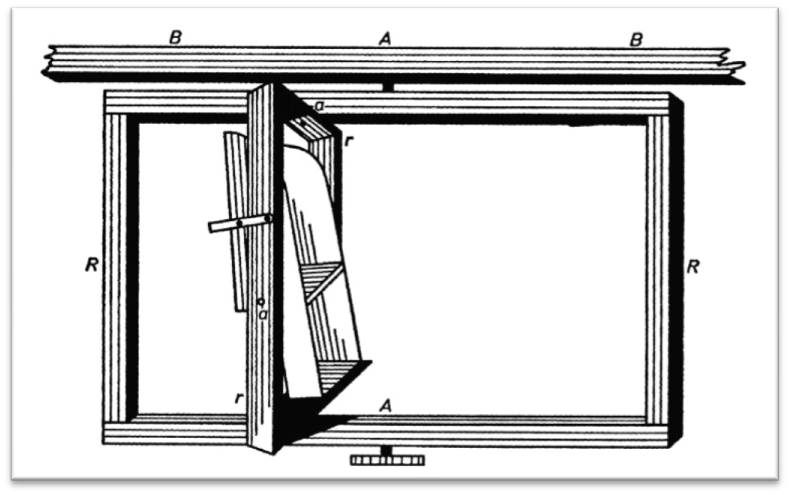

Medizin und Kunst - ein ganzheitlicher Therapieansatz der Antoniter

Jedem Krankenhaus standen die singularia remedia zur Verfügung, die den Ruf der Antoniter über ganz Europa bekannt gemacht hatten und die Erkrankten von überall herbeieilen ließen. Es waren dies der Antoniusbalsam und der Antoniuswein. Der Wein erhielt durch das Eintauchen der Antoniusreliquien seine religiöse Bedeutung und war - wie der gewöhnliche Krankenwein - mit Heilkräutern versetzt, denen gefäßerweiternde (der Ergotwirkung entgegenwirkende) und schmerzstillende Eigenschaften zukommen. Welche Heilkräuter die Antoniter benutzten, geht u.a. aus einem Gemälde des von Matthias Grünewald 1512 - 1516 geschaffenen Isenheimer Altars hervor. Abbildung 3. Die botanisch sehr genau gemalten Pflanzen werden alle in den Kräuterbüchern des Mittelalters zur Bekämpfung des Antoniusfeuers erwähnt.

Eine vor kurzem wiederentdeckte, lange verschollen geglaubte Rezeptur des Antoniusbalsam beschreibt 14 Heilkräuter, die sich als entzündungshemmend und wundheilend erweisen.

Abbildung 3. Matthias Grünewald: Heilpflanzen, die von den Antonitern benutzt wurden. Ausschnitt aus dem unteren Teil des Bildes: Der Besuch des hl. Antonius bei dem Eremiten Paulus auf dem linken Flügel der dritten Schauseite des Isenheimer Altars. Links: die Zahlen bezeichnen 1: Breitwegerich (zur Wundbehandlung), 2: Eisenkraut (durchblutungssteigernd), 3: Spitzwegerich. Rechts: wahrscheinlich handelt es sich hier um Saatmohn, Kreuzenzian, Schwalbenwurz, Ehrenpreis, Taubnessel, kriechenden Hahnenfuß, Weissklee (Museum Unterlinden, Colmar).

Neben dem Balsam und dem Antoniuswein wurde stärkende, gute Nahrung verabreicht: mutterkornfreies Brot - Weizenbrot - und Schweinefleisch. Schweinschmalz - das die Haut sehr gut durchdringt - diente als Salbengrundlage. Schließlich kam noch die regelmäßige Versorgung durch die Wundärzte hinzu.

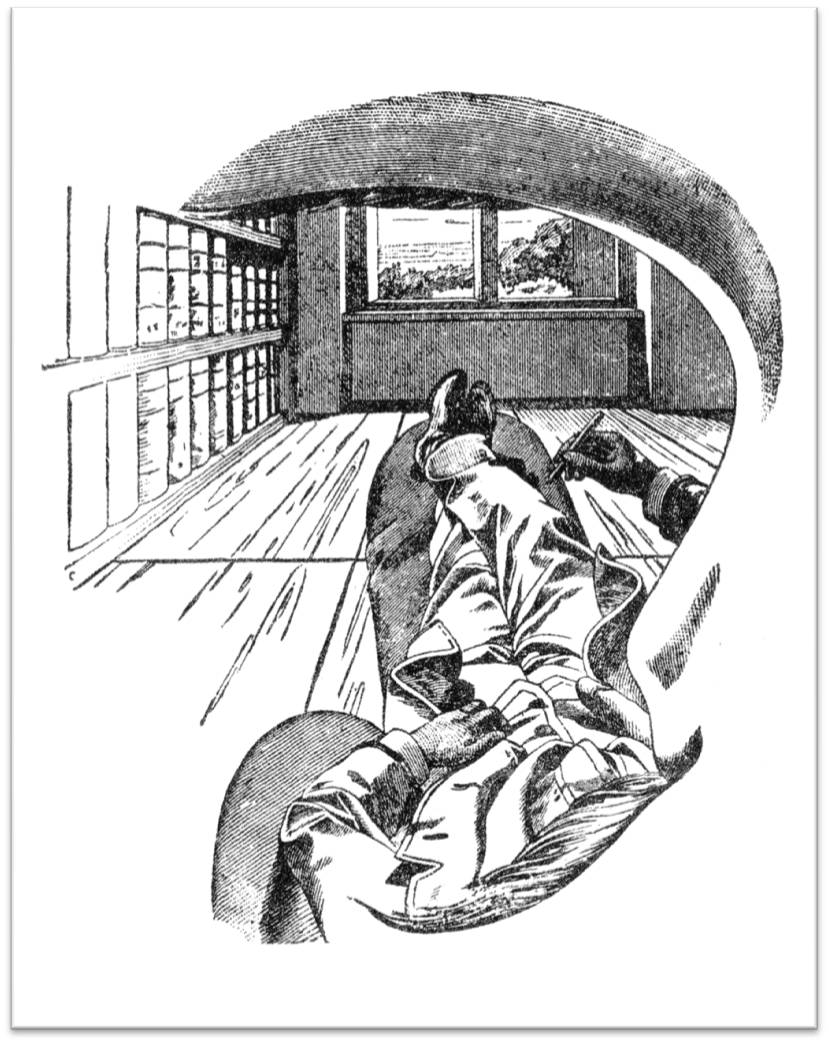

Bei den Antonitern trafen die Spitalsinsassen auf Leidensgenossen, die gleiche schmerzliche Erfahrungen durchgestanden hatten und schon wieder auf dem Weg der Besserung waren.

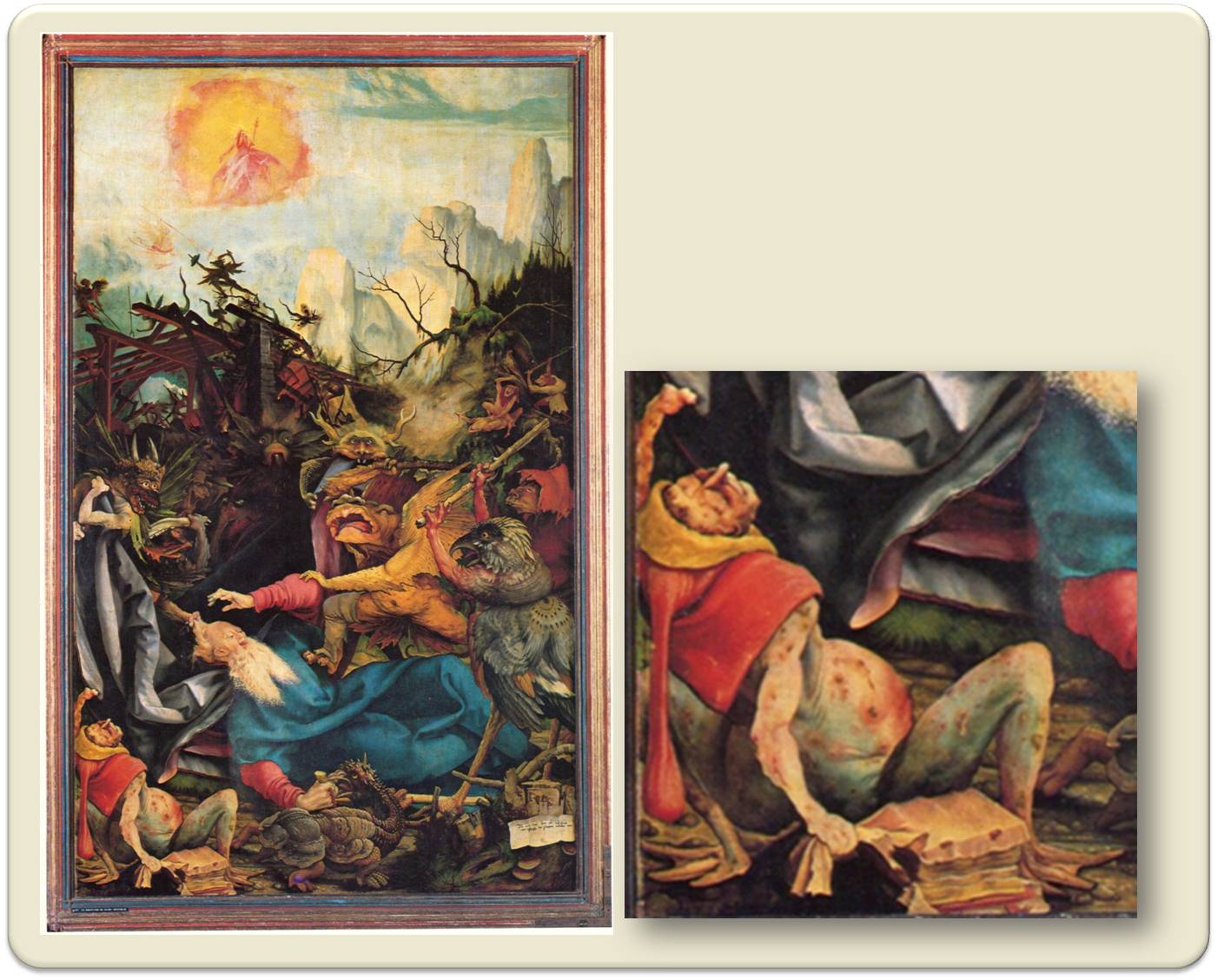

Zur Heilungsförderung verordneten die Antoniter zusätzlich den Gang vor den Altar: Als Teil eines ganzheitlichen Therapieansatzes wurden in den Antoniterspitälern im Spätmittelalter Gemälde eingesetzt, die den Betrachter in der Krankheitsbewältigung unterstützen und zum "Heil" führen sollten. Die Ergotismusopfer sollten zu sich selbst finden, in ihrer Krankheit die göttliche Strafe erkennen, symbolisch dargestellt durch den ignis sacer, die Versuchung durch die Dämonen sowie deren Überwindung. Ein Werk mit besonders starker Ausstrahlung ist das von Matthias Grünewald geschaffene Altargemälde "Versuchung des hl. Antonius" im Isenheimer Kloster, einem wohlhabenden, bedeutenden Antoniterkloster im Elsass, nahe Colmar. Abbildung 4.

Zu den bekanntesten weiteren Malern, die damals Aufträge von den Antonitern erhielten, zählten, Martin Schongauer, Niklaus Manuel und wahrscheinlich Hieronymus Bosch. Das Mutterkorn übte in dieser Zeit nicht nur auf die Medizin, sondern auch auf die Kunst einen bedeutenden Einfluss aus.

Abbildung 4. Matthias Grünewald: Die Versuchung des hl. Antonius. Rechter Flügel der dritten Schauseite des Isenheimer Altars. Links: 8 Dämonen- als Repräsentanten der menschlichen Laster - peinigen den Heiligen. Rechts: Ausschnitt des linken unteren Rands: ein Dämon mit den Symptomen des Ergotismus gangraenosus. Die blaugrünen Flossenfüße symbolisieren die Kälte, das Abgestorbene, die Geschwüre zeigen den von Fäulnisbakterien unterwanderten brandigen Ergotismus. (Museum Unterlinden, Colmar).

Aus dem Gift werden hochwirksame Heilmittel

Dass ein Zusammenhang zwischen Mutterkorn und dem Antoniusfeuer besteht, wurde erst im 17. Jahrhundert erkannt und im 18. Jahrhundert streng wissenschaftlich bewiesen. Mit Kenntnis der Ursache der Erkrankung wurden Präventivmaßnahmen - Überwachung und Entfernung des Mutterkornanteils im Brotgetreide - ergriffen. Hinzu kamen steigender Wohlstand und veränderte Essgewohnheiten (die Kartoffel wurde zu einem Grundnahrungsmittel) und führten allmählich zum weitestgehenden Verschwinden des Antoniusfeuer.

Wie einleitend bereits erwähnt, wurden wässrigeMutterkornextrakte über Jahrhunderte traditionell in der Geburtsmedizin angewandt. Diese Extrakte waren wenig haltbar, unrein und daher nicht exakt dosierbar - sie führten häufig zu den für Ergotalkaloide typischen Nebenwirkungen. Dem Naturstoffchemiker Arthur Stoll - er begründete die Pharmaabteilung der ehemaligen Farbenfirma Sandoz - gelang es 1918 mit schonender, chemischer Aufreinigungstechnologie das uterusaktive Prinzip des Mutterkorns zu extrahieren und zu reinigen. Es war ein Alkaloid, das er Ergotamin nannte und das sich an der menschlichen Gebärmutter als hervorragend blutungshemmend erwies. Unter der Bezeichnung Gynergen® fand das Mittel einen führenden Platz in der Geburtshilfe und später auch als Specificum zur Behandlung der Migräne.

Einer der ersten Chemiker in Stolls neuer Naturstoffabteilung war Albert Hofmann, der ab 1935 Substanzen durch Synthese herstellte, die im Mutterkorn nur in sehr kleinen Mengen vorhanden waren, beispielsweise das Ergonovin. Mit seinen Methoden konnte er auch eine Anzahl verwandter Strukturen von Ergotalkaloiden mit hoher pharmakologischer Wirksamkeit synthetisieren: u.a. das von Ergonovin abgeleitete Methergin® und das Lysergsäurediäthylamid - LSD - das stärkste öffentliche Aufmerksamkeit erregte. Erfolgversprechende klinische Untersuchungen des LSD als Hilfsmittel in der Psychoanalyse wurden in den 1960er Jahren allerdings vom Missbrauch als bevorzugte (Party)Droge überschattet und die Substanz auf die Liste der Rauschmittel gesetzt.

Ein besonders wichtiger Schritt Albert Hofmanns war die Hydrierung des aus drei Alkaloiden bestehenden Ergotoxins. Anstelle der blutdrucksteigernden, gefäßverengenden Eigenschaften des Ergotoxins, bewirkten die hydrierten Verbindungen nun Blutdrucksenkung und Gefäßerweiterung - u.a. auch eine verbesserte Gehirndurchblutung und dies bei insgesamt geringerer Toxizität. Unter dem Handelsnamen Hydergin® wurde das Mittel in den 1970er Jahren zum umsatzstärksten Produkt der Firma. Ebenfalls sehr erfolgreich war die Hydrierung des Ergotamin: Als Dihydroergot - DHE - wurde das Mittel in der Hypotonie und bei vaskulären Kopfschmerzen eingesetzt.

Eines der letzten Ergotalkaloide, das Medizingeschichte geschrieben hat, war das Bromokriptin - Parlodel®. Damit wurde ein neues Kapitel in der (Neuro)endokrinologie aufgeschlagen. Dieses Produkt wirkt auf die Sekretion des Prolaktins, Dopamins und Wachstumhormons. Als Hauptindikationen gelten Parkinson, Akromegalie und Tumoren der Hypophyse.

Die Isolierung und Derivierung der Mutterkornalkaloide stellte also über mehr als 60 Jahre eine medizinalchemische "Fundgrube" für Sandoz dar und eine herausragende Erfolgsgeschichte der Naturstoffchemie.

Weiterführende Links

Klaus Roth (FU Berlin) Vortrag: Vom Isenheimer Altar zu den Beatles. Video 1:14:35 min. Lange Nacht der Chemie - Vom Isenheimer Altar zu den Beatles (Prof. Roth - F.U. Berlin). Roth unternimmt eine weite Reise vom heiligen Antonius über einen Getreidepilz hin zu einem psychedelischen Musikvideo der Beatles.

Das "Heilige Feuer" oder "Antonius Feuer" (Sehr ausführliche Seite über die Leistungen der Antoniter , die medizinischen und kunstgeschichtlichen Aspekte)

Mutterkorn: Halluzinogen und Auslöser von Vergiftungen. Peter Schmersahl (2010)

Ergot: the story of a parasitic fungus (Wellcome Library, 1958; d.i. noch vor dem Siegeszug der auf Ergotalkaloiden basierenden Arzneimittel). Video 24.44 min.

LSD - Die Entdeckung einer Wunderdroge (Dr. Albert Hofmann)Video 44:33 min.

Albert Hofmann - Die Bedeutung von LSD aus der Sicht des Entdeckers. Video 32:30 min. Interview mit Albert Hofmann zum Abschluss des Symposiums "LSD - Sorgenkind und Wunderdroge" Internationales Symposium zum 100. Geburtstag von Albert Hofmann (2006, Basel)

Das Geburtsjahr bestimmt das Risiko an Vogelgrippe zu erkranken

Das Geburtsjahr bestimmt das Risiko an Vogelgrippe zu erkrankenDo, 24.11.2016 - 14:27 — Francis S. Collins

![]() Wahrscheinlich können Sie sich nicht mehr erinnern, wann Sie als Kind das erste Mal Grippe hatten. Neue Erkenntnisse sprechen dafür, dass das menschliche Immunsystem jedoch seine erste Begegnung mit einem Grippevirus niemals vergisst. Es nützt dieses immunologische "Gedächtnis" möglicherweise sogar, um gegen künftige Infektionen mit neuen Stämmen der Vogelgrippe zu schützen. Diese eben erschienenen, grundlegenden Ergebnisse einer NIH-unterstützten Untersuchung fasst der Chemiker und Mediziner Francis Collins, Direktor der US National Institutes of Health (NIH) und ehem. Leiter des "Human Genome Project" hier zusammen.*

Wahrscheinlich können Sie sich nicht mehr erinnern, wann Sie als Kind das erste Mal Grippe hatten. Neue Erkenntnisse sprechen dafür, dass das menschliche Immunsystem jedoch seine erste Begegnung mit einem Grippevirus niemals vergisst. Es nützt dieses immunologische "Gedächtnis" möglicherweise sogar, um gegen künftige Infektionen mit neuen Stämmen der Vogelgrippe zu schützen. Diese eben erschienenen, grundlegenden Ergebnisse einer NIH-unterstützten Untersuchung fasst der Chemiker und Mediziner Francis Collins, Direktor der US National Institutes of Health (NIH) und ehem. Leiter des "Human Genome Project" hier zusammen.*

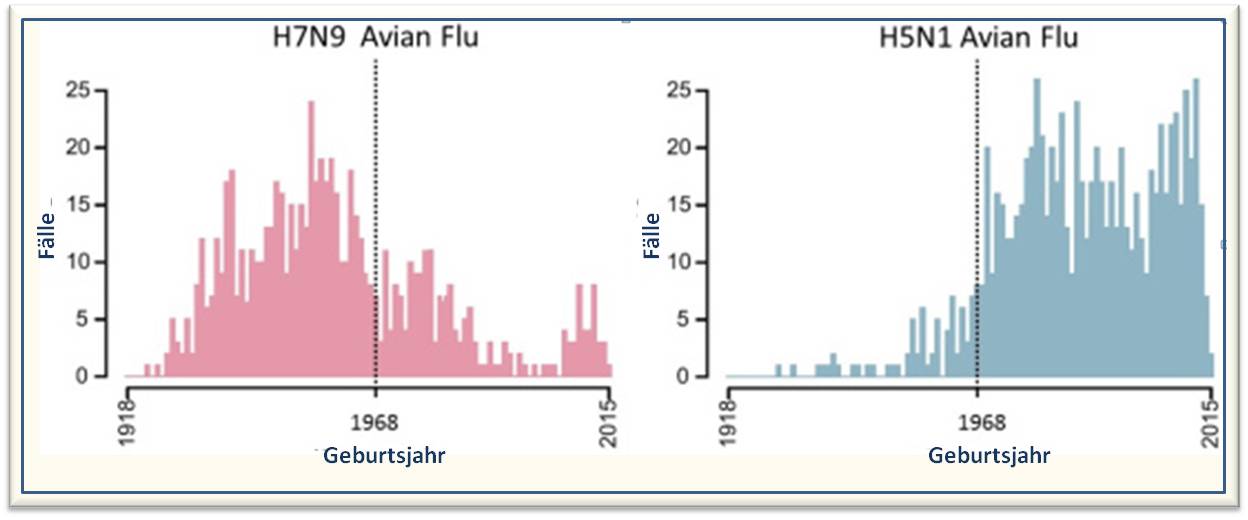

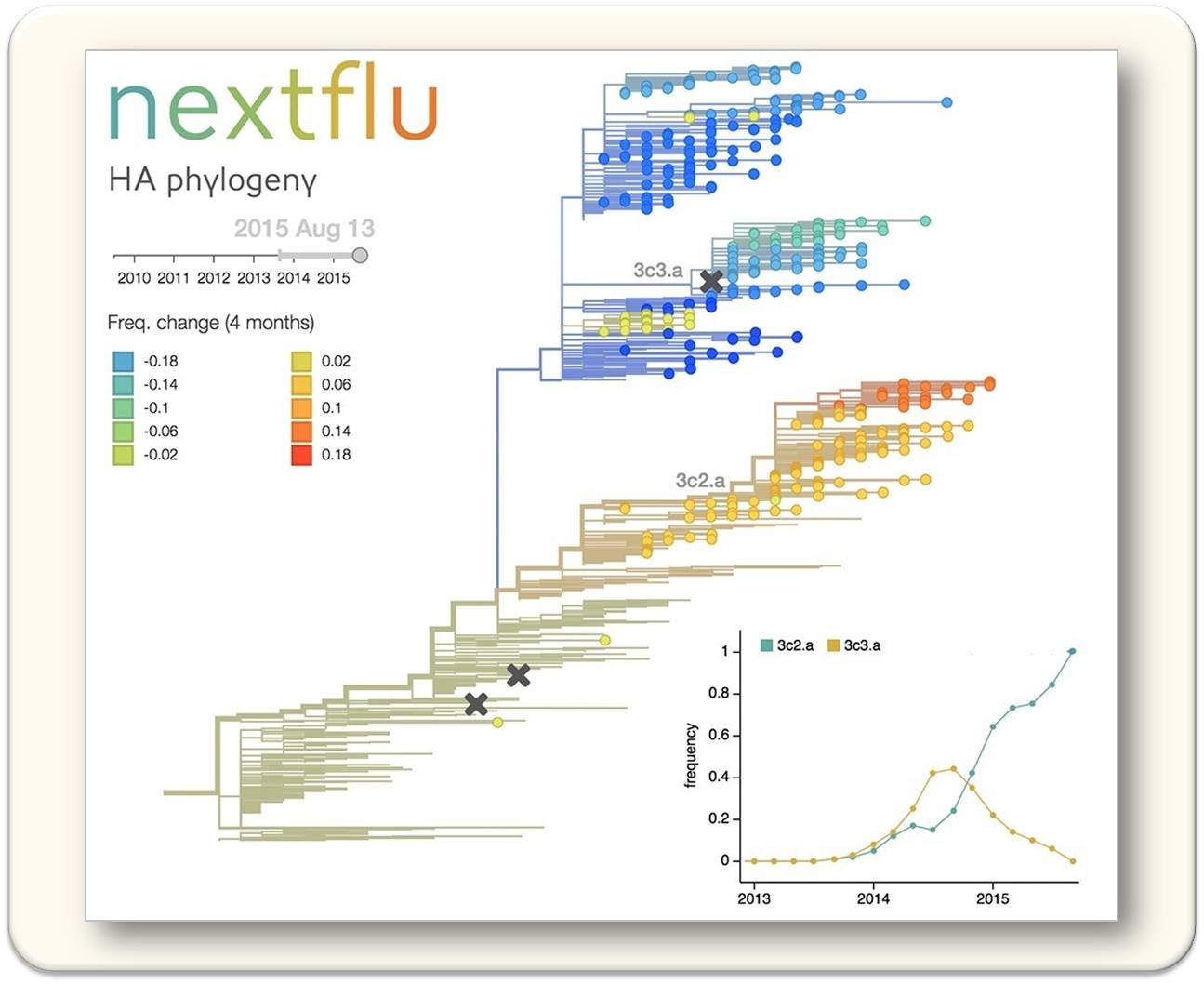

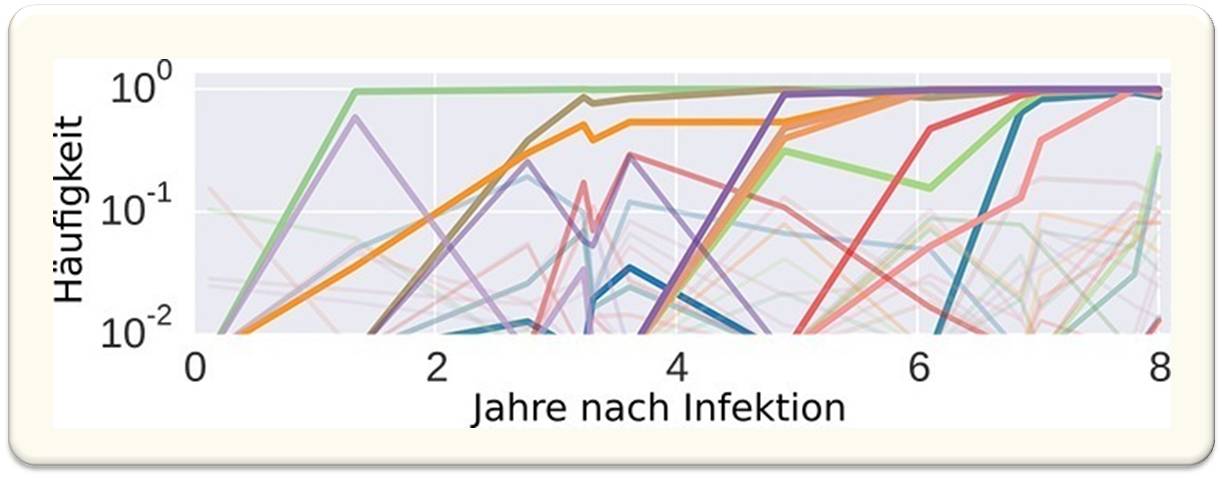

Ein NIH-unterstütztes Forschungsteam hat Fälle von Vogelgrippe zwischen 1997 und 2015 in sechs Ländern in Asien und dem mittleren Osten untersucht und gesehen, dass vor 1968 geborene Menschen ein geringeres Risiko hatten an H5N1-Vogelgrippe schwer zu erkranken oder daran zu sterben, als die später geborenen. Genau das Gegenteil war bei dem Vogelgrippestamm H7N9 der Fall: die vor 1968 Geborenen hatten ein wesentlich höheres Risiko, während die später Geborenen häufig besser geschützt waren.

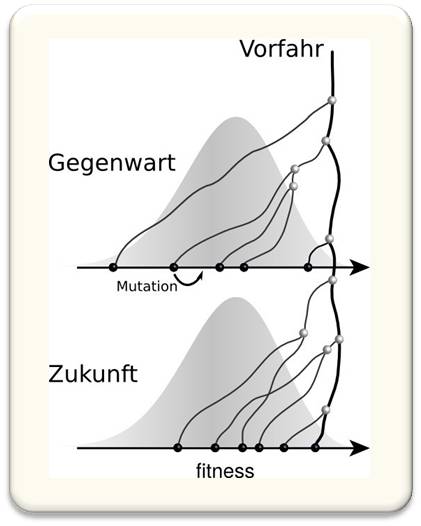

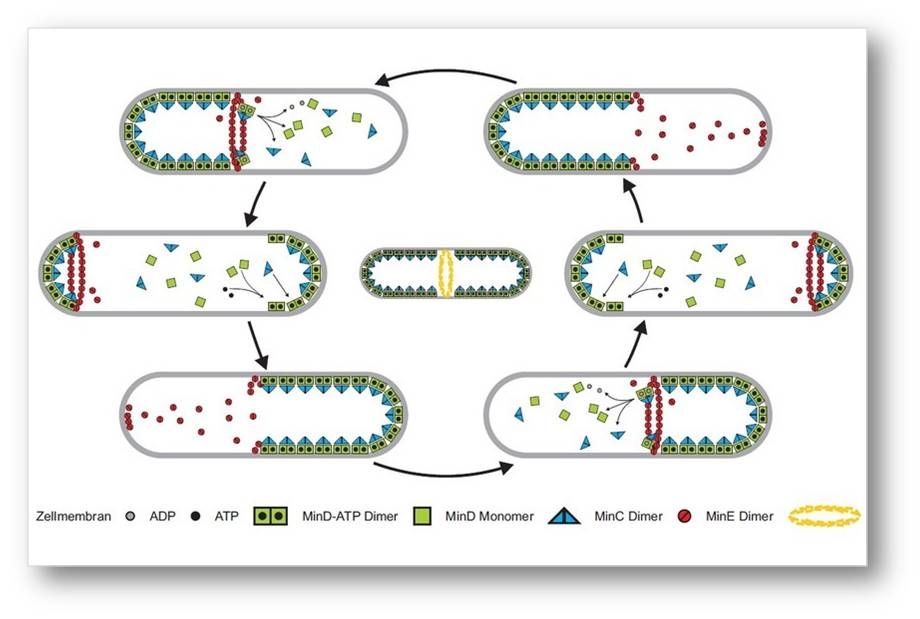

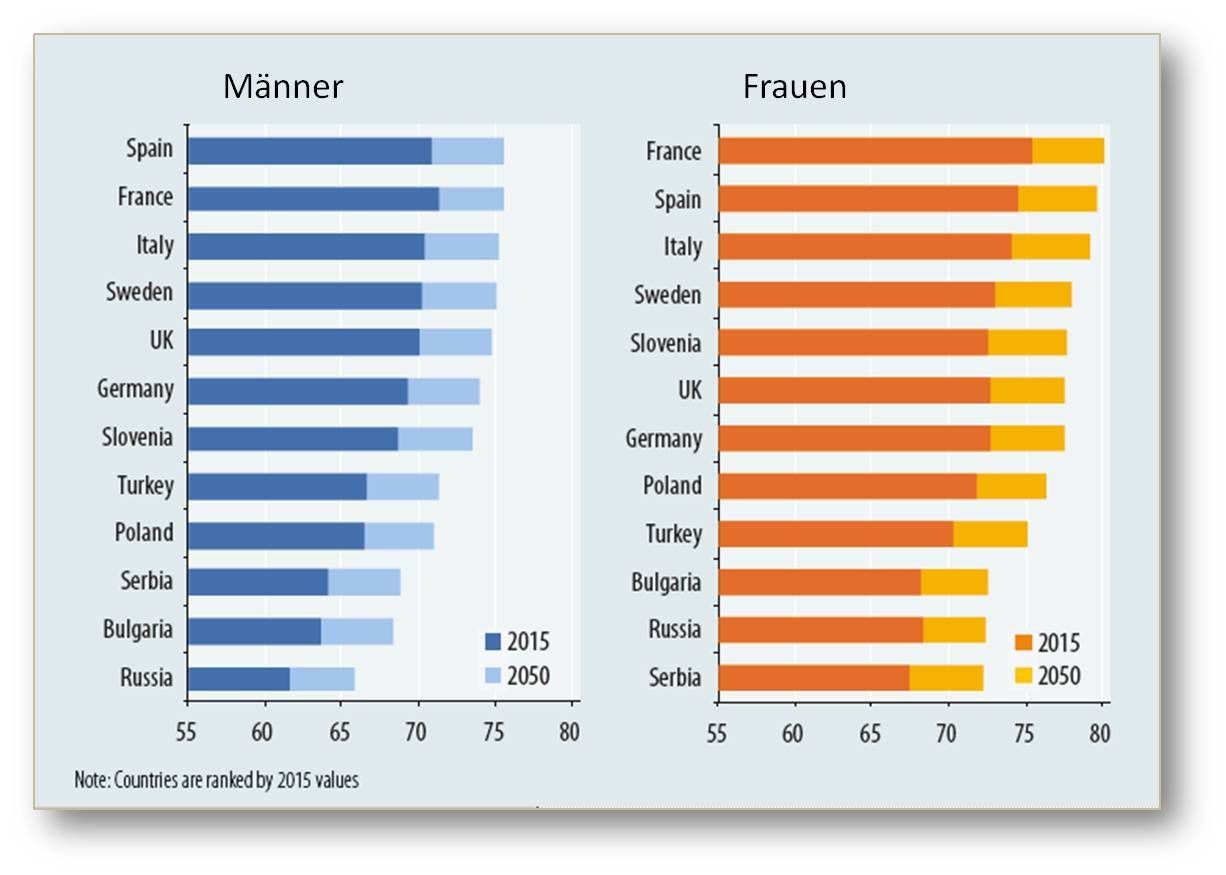

Wie kommt dieser Gegensatz zustande?