2019

2019 Redaktion Wed, 20.03.2019 - 01:05Die Klimadiskussion – eine, die nirgendwo hinführt.

Die Klimadiskussion – eine, die nirgendwo hinführt.Do, 26.12.2019 — Matthias Wolf

![]() Die Klimadiskussion wird, nicht zuletzt befeuert durch die FFF- (Fridays for Future) Bewegung, immer hitziger. Zwei ›Lager‹ haben sich gebildet, die einander gegenseitig unterstellen, in allem, was sie sagen, daneben zu liegen; Wörter wie ›Grabenkampf‹ und ›Gesellschaftsspaltung‹ drängen sich auf. Exemplarisch für die gesamte öffentliche Debatte kann eine jüngst auf ServusTV geführte Diskussion im Talk im Hangar-7 stehen, die hier besprochen wird. Was keiner Seite in den Sinn kommt: sie können durchaus beide recht haben mit ihren Vorhaltungen, denn beide können daneben liegen – was nach Meinung des Autors der Fall ist und hier nachzuweisen versucht werden soll. Der folgende Text nimmt Bezug auf die Fernsehdiskussion, die man hier nachschauen kann (aber nicht unbedingt muss, um folgen zu können).

Die Klimadiskussion wird, nicht zuletzt befeuert durch die FFF- (Fridays for Future) Bewegung, immer hitziger. Zwei ›Lager‹ haben sich gebildet, die einander gegenseitig unterstellen, in allem, was sie sagen, daneben zu liegen; Wörter wie ›Grabenkampf‹ und ›Gesellschaftsspaltung‹ drängen sich auf. Exemplarisch für die gesamte öffentliche Debatte kann eine jüngst auf ServusTV geführte Diskussion im Talk im Hangar-7 stehen, die hier besprochen wird. Was keiner Seite in den Sinn kommt: sie können durchaus beide recht haben mit ihren Vorhaltungen, denn beide können daneben liegen – was nach Meinung des Autors der Fall ist und hier nachzuweisen versucht werden soll. Der folgende Text nimmt Bezug auf die Fernsehdiskussion, die man hier nachschauen kann (aber nicht unbedingt muss, um folgen zu können).

Der jüngste Talk im Hangar-7 unter dem Titel ›Politik verschläft Klimaschutz: Wachstum um jeden Preis?‹, hatte eine Gruppe von Klimabewegten auf der einen sowie Vertreter von Liberalismus und Wirtschaft auf der anderen Seite geladen; er kann stellvertretend für die gesamte gesellschaftliche Debatte als mahnendes Beispiel dienen: sie führt nirgendwohin.

Kurzzusammenfassung: Die Fraktion der Klimabewegten argumentiert immer wieder, dass wir das Gesellschaftssystem ›umbauen‹ müssten – und zwar rasch! – und insbesondere, dass der Kapitalismus an der Misere schuld sei. Die (selbstgefühlten) ›Realos‹ halten dagegen, dass einzig der Kapitalismus in der Lage wäre, das Problem zu lösen.

Spoiler: Beide Lager vermengen unterm Strich im Eifer des Gefechts munter Richtiges mit Halbrichtigem und Falschem und greifen letztendlich zu kurz.

Die Argumente

Analysieren wir zuerst, wo die Argumentationslinien richtig liegen und wo nicht.

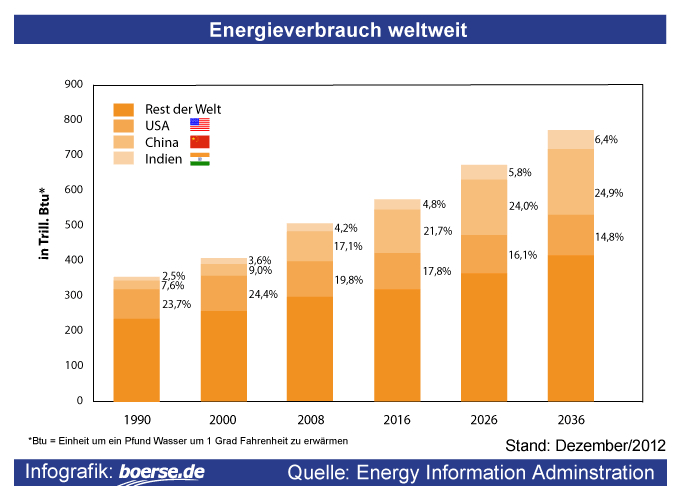

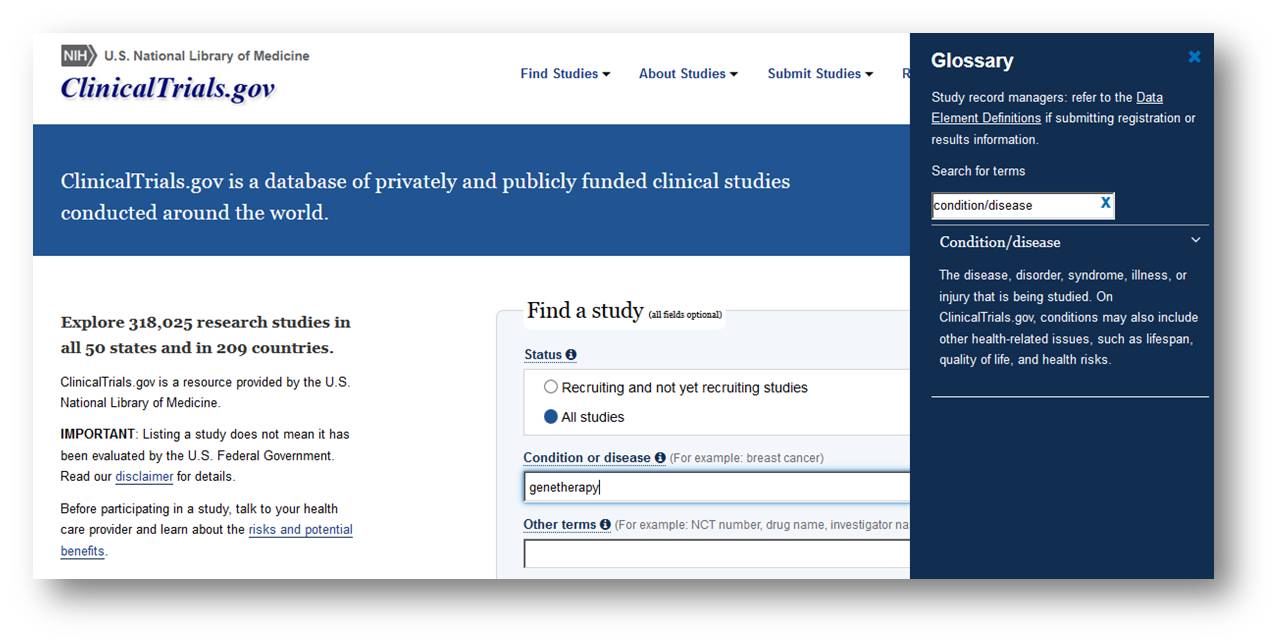

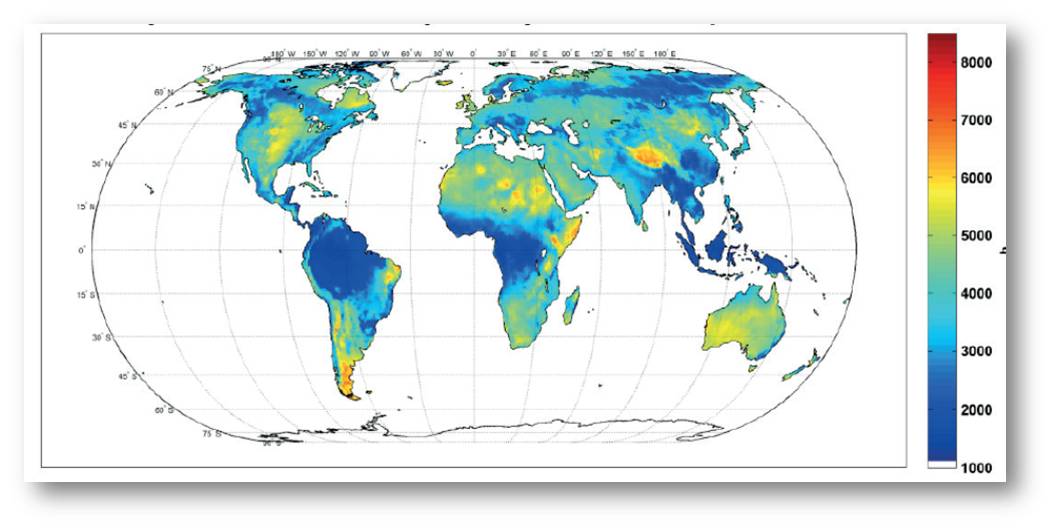

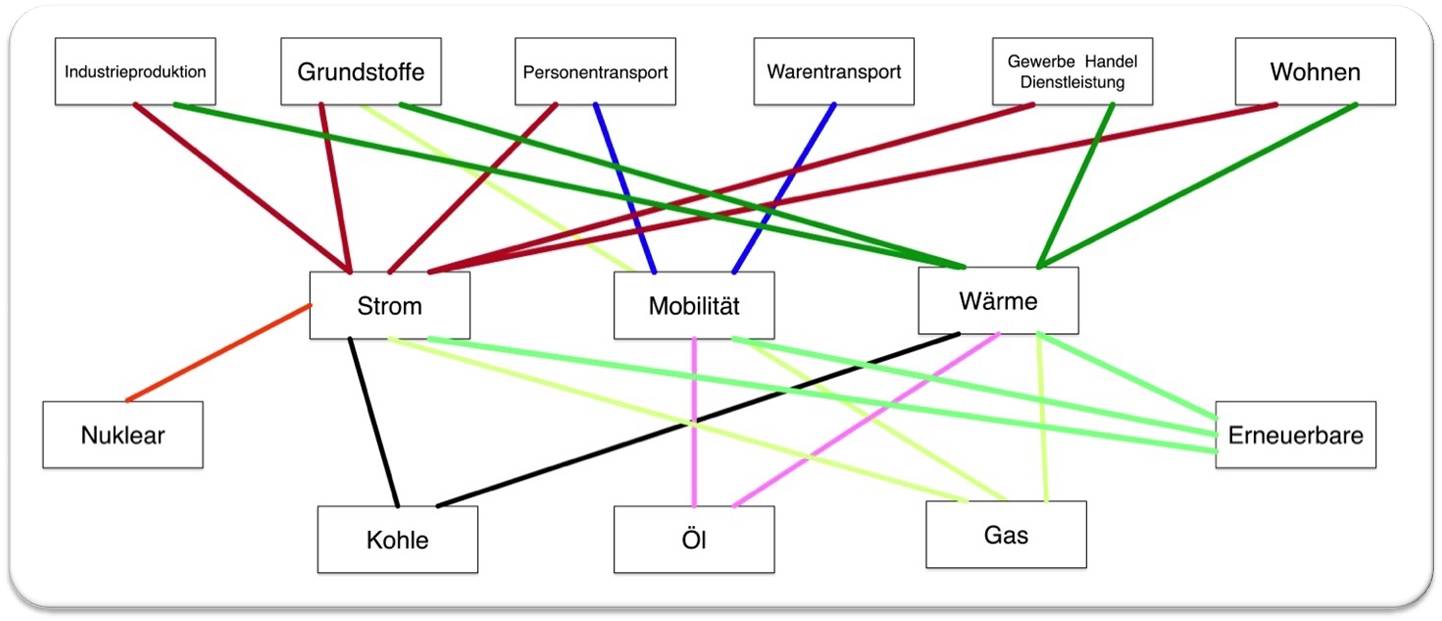

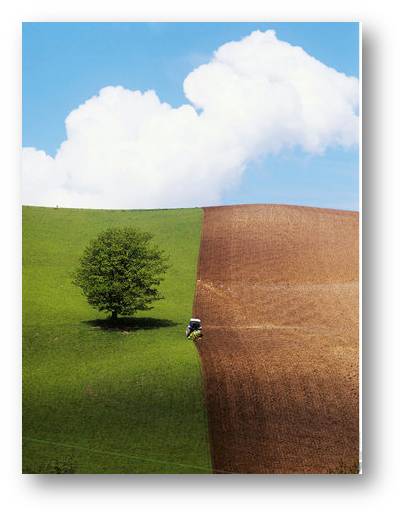

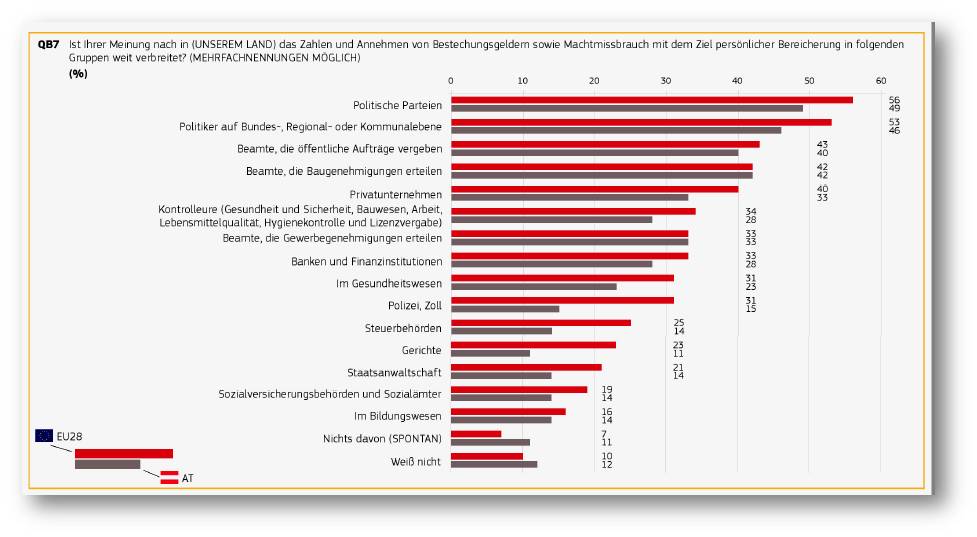

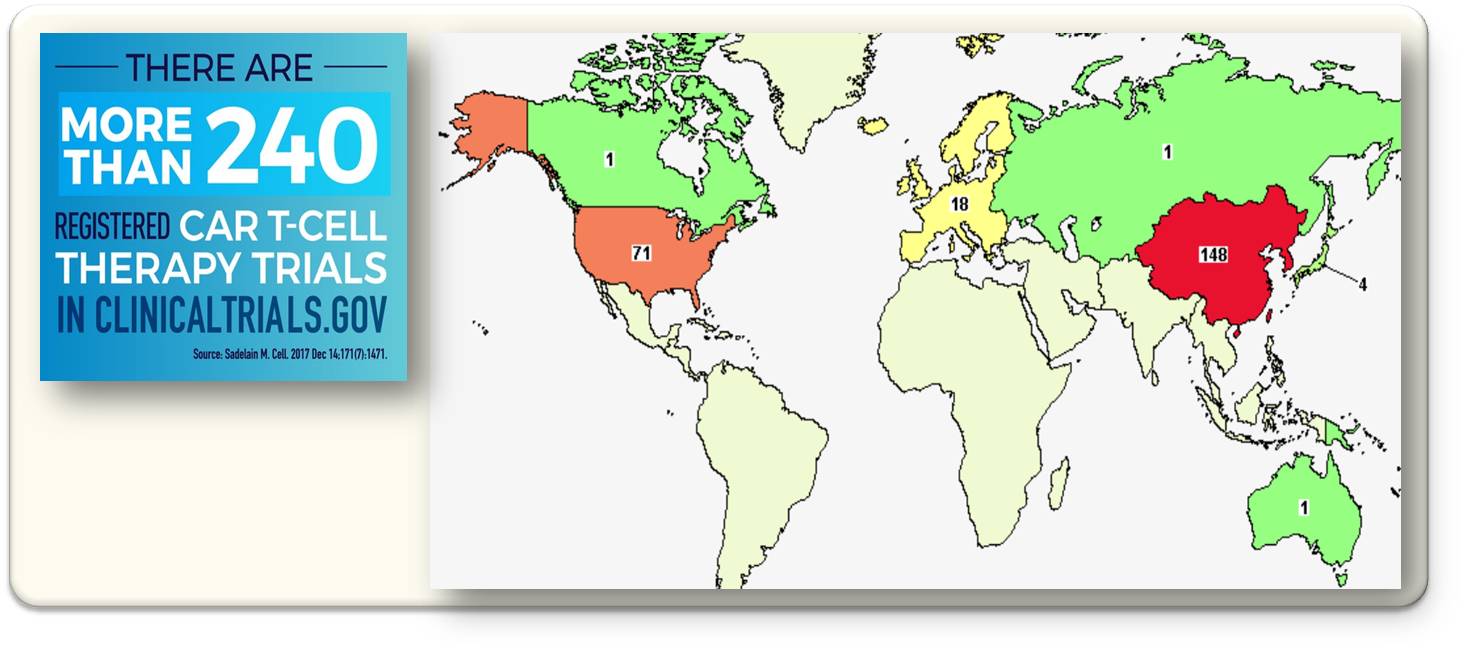

Die Klimabewegten

Insbesondere eine junge Jus-Studentin argumentiert mit Herzblut für die Demokratie, die allerdings Lösungen hervorbringen müsse. Die vom Moderator immer wieder gestellte Frage, was, wenn sich keine Mehrheiten fänden, scheint ihr so unvorstellbar, dass sie ihr völlig sinn- und inhaltsleeres Ausweichen bzw. die dann doch von ihr angedeutete Entsorgung eben jener von ihr selbst hochgelobten Demokratie selbst nicht erkennt. Bei aller Sympathie: Studenten sind eben keine erfahrenen Krisenmanager mit Überblick und Sachkenntnis. Leuchtmittel und Staubsauger leistungszubegrenzen, um den Stromverbrauch zu senken, aber gleichzeitig die Gesellschaft ins E-Auto  Abbildung 1: Prognose des weltweiten Energieverbrauchs. (Quelle: Energy Information Administration) setzen zu wollen, ist ein Widerspruch in sich, auch wenn das als nur scheinbar hingestellt werden soll. (Abbildung 1)

Abbildung 1: Prognose des weltweiten Energieverbrauchs. (Quelle: Energy Information Administration) setzen zu wollen, ist ein Widerspruch in sich, auch wenn das als nur scheinbar hingestellt werden soll. (Abbildung 1)

Durchaus richtig liegt sie mit dem Appell, eigenes Zögern nicht mit der Inaktivität anderer begründen zu können. Allein, sie zieht die falschen Schlüsse daraus: es geht nicht darum (und ist dem Planeten völlig egal!), aktiv zu werden um des aktiv Werdens Willen – es muss schon auch das Richtige getan werden!

Gänzlich falsch ist die Forderung nach einem Umbau der Gesellschaft: So etwas würde – selbst, wenn man Erfolgsaussichten unterstellte! – Jahrzehnte dauern. Zeit, die wir nicht haben; somit stellt sich die Frage auch nicht. Die Situation ist vergleichbar mit der eines Kapitäns, der feststellt, dass er mit seinem Containerfrachter 100sm von der Kurslinie abgekommen ist: Er kann nicht dorthin ›springen‹, wo er sein müsste. Er kann nur eine Kurskorrektur anordnen, damit das Ziel von der jetzigen Position aus noch erreicht wird. Ähnlich geht es uns: den ›entwickelten‹ Gesellschaften einen Totalumbau bis, bildlich gesprochen, 31.12. verordnen zu wollen ist nichts anderes als der Versuch, den Frachter 100sm zu versetzen. Vielleicht sogar aus der richtigen Motivation, das mag schon sein, aber nichtsdestotrotz völlig sinnlos, weil es aus prinzipiellen Gründen nicht einmal ansatzweise gelingen kann. Und schlimmer noch: schon der Versuch würde dringend benötigte Kapazitäten binden.

Die Gegenseite

Die Vertreter von Wirtschaft und Liberalismus halten dagegen, die Erfahrung lehre, dass nur der Kapitalismus in der Lage sei, derartige Probleme überhaupt zu stemmen. Insoweit liegen sie richtig: alles Oktroyierte führte in der Vergangenheit auf die eine oder andere Weise letztendlich ins Desaster. Und zwar egal, wie ›edel‹ die jeweilige Anfangsidee auch war. Völlig richtig ist, dass so oder so in die Bewältigung des Klimawandels gewaltige Summen fließen werden müssen, die jemand erwirtschaften muss, was ausschließlich und nur dem Kapitalismus überhaupt zugetraut werden kann. So weit, so stimmig.

Wo sie nicht richtig liegen, ist, den Vorschlag einer CO₂-Besteuerung als ›Planwirtschaft‹ zu bezeichnen. Eine CO₂-Steuer hat mit Planwirtschaft, wo Produktionsmengen und Preise bis auf Betriebsebene hinunter von oben dekretiert werden, nicht einmal in Ansätzen zu tun und die Vorhaltung soll lediglich das Konzept schon im Vorfeld diskreditieren. Leider eine zutiefst unseriöse Argumentattrappe.

Ebenfalls falsch (das ist jetzt weniger auf die Fernsehdiskussion als auf die allgemeine Debatte bezogen) liegt die gesamte Fraktion damit, ständig den wissenschaftlichen Erkenntnisstand in Zweifel zu ziehen. Es ist, im Gegenteil, sogar bestürzend ›schlicht‹, weltweite Jahrzehnte-Verschwörungen 100 000er zu unterstellen, Ergebnisse zu leugnen und/oder völlig Irrelevantes ins Treffen zu führen. (Um ein Beispiel zu nennen: ›Klimawandel gab es immer; er hat natürliche Ursachen.‹ Ja, und? Selbst wenn, was würde das am aktuellen Problem ändern? Aber ich kann Sie beunruhigen: die aktuelle Erwärmung ist, nach allem, was wir sagen können, von uns Menschen verursacht.)

Persönlich stimmt es mich zutiefst traurig, dass insbesondere Liberale – die sich selbst, sprechen wir's doch aus, intellektuell und an Informationsbereitschaft und -fähigkeit für überlegen halten – auch den dümmsten Schmonzes unhinterfragt weiterverbreiten, ohne irgendetwas dabei zu merken. Es ist geradezu verblüffend, in welch simpel gestrickte Konstruktionen sie sich mitunter versteigen, wenn man in Diskussionen beginnt, ihre Antithesen wissenschaftlich zu zerlegen. Motto: Es kann nicht sein, was nicht sein darf.

Und das bringt mich zum Hauptkritikpunkt: Dass von allen Pfeilen im Köcher nur der Kapitalismus das Problem erfolgreich angehen kann, stimmt. Was aber nicht stimmt, ist, dass sich die angesprochene Klimaproblematik im Kapitalismus bzw. seiner Wirtschaftsform ›Markt‹ sozusagen ›von selbst‹ regeln würde – es kann gar nicht stimmen.

Was leistet der Markt – und was nicht?

Und zwar, weil es das Wesen des Marktes in seinem Kern verkennt: Markt ist geeignet, ein Wirtschaften unter dem Diktat der ›knappen Ressource‹1 zu gewährleisten, weil sich ein Preis bildet, der sicherstellt, dass die zu einem Zeitpunkt zur Verfügung stehenden Ressourcen jeweils den ›höchstwertigen‹ Verwendungen zugeführt werden.

Nash-Gleichgewichte

Definiert von John Forbes Nash jr. (dessen Leben in ›A Beautiful Mind‹ verfilmt wurde. Sehenswert!)

Nash-Gleichgewichte, ein Begriff aus der Spieletheorie, stellen sich ein, wenn Gleichgestellte Eigeninteressen verfolgen. Es handelt sich um selbststabilisierende, suboptimale Gleichgewichtszustände, die nur noch schwer oder gar nicht verlassen werden können. Die Wikipedia nennt das ›Gefangenen-Dilemma‹ als Beispiel, aber ein anderes ist vielleicht viel griffiger:

Szenario: ein Strand, zwei Eisverkäufer. Optimal für alle wäre, wenn ein Verkäufer bei ¼ der Strandlänge stünde, der andere bei ¾.  Abbildung 2a: Optimale Konstellation. (Bild: Autor) Dann würden beide gleich viel verkaufen, kein Weg wäre für einen Eiskäufer länger als ¼ der Strandlänge.

Abbildung 2a: Optimale Konstellation. (Bild: Autor) Dann würden beide gleich viel verkaufen, kein Weg wäre für einen Eiskäufer länger als ¼ der Strandlänge.

Schnell kommt einer auf die Idee, sich 2m näher zur Mitte zu stellen, weil er dadurch dem anderen etwas von seinem ›Einzugsgebiet‹ abzwackt. Der andere merkt das, denkt sich ›nicht mit mir‹ und rückt 4m näher zur Mitte. Ende vom Lied:  Abbildung 2b: Konstellation nach Erreichen des Nash-Gleichgewichts. (Bild: Autor)beide stehen Rücken an Rücken in der ½ des Strandes und verkaufen wieder gleich viel Eis (selbststabilisierend). Aber weniger als vorher, weil vielen Gästen an den Enden des Strandes der Weg jetzt zu lang wurde und sie lieber auf das Eis verzichten (suboptimal).

Abbildung 2b: Konstellation nach Erreichen des Nash-Gleichgewichts. (Bild: Autor)beide stehen Rücken an Rücken in der ½ des Strandes und verkaufen wieder gleich viel Eis (selbststabilisierend). Aber weniger als vorher, weil vielen Gästen an den Enden des Strandes der Weg jetzt zu lang wurde und sie lieber auf das Eis verzichten (suboptimal).

Für diese Entdeckung erhielt Nash 1994 den Alfred-Nobel-Gedächtnispreis für Wirtschaftswissenschaften3. Er erklärt spieletheoretisch, wieso eine Allmende (Gemeinschaftsalm) unausweichlich zur Übernutzung bis zur Zerstörung führt: weil jeder Spieler sein Ergebnis optimieren muss und keiner das Gesamtergebnis ›auf dem Schirm‹ hat.

Ist eine Ressource aber nicht ›knapp‹ – oder scheint es nicht zu sein – kann das Regelinstrument Markt nur versagen, weil die unbegrenzte (›freie‹) Ressource keinen Preis hat; sie ist gratis. Ohne hier allzusehr ins Detail gehen zu wollen: dieses Versagen wird in der ›Tragödie der Allmende‹ [1] sichtbar. Was sich einstellt – einstellen muss! – sind so genannte ›Nash-Gleichgewichte‹, die selbststabilisierend aber suboptimal sind. (Siehe Kasten.) Das ist, was wir auf oberster Ebene, jener der Staaten, beobachten und der Grund, warum ein Klimagipfel nach dem anderen scheitert.

Was wäre das Richtige?

Weder kann noch will der Autor versuchen, die Frage endrichtig zu beantworten. Aber ein paar Punkte seien skizzenhaft genannt – frei angelehnt an das ›Pareto-Prinzip‹ [2], nach dem man mit 20% des Aufwandes 80% des Effekts erzielt.

Es kann nicht darum gehen, die Gesellschaft zu verändern. Gesellschaften verändern sich zwar, aber jeder Eingriff von oben oder außen kann nur zu sozialen Unruhen führen – die sofort alles lähmen und so wieder das Ergebnis gefährden würden. (Aktuelles Beispiel: die ›gilets jaunes‹2 in Frankreich.) Es muss darum gehen, der Gesellschaft ihre materiellen Grundlagen auf nachhaltige Weise bereitzustellen – selbst, wenn das für Manche ein Reizwort ist. Bildlich gesprochen müssen wir die Bobbahn umbauen, nicht den Bob.

Der Ansatzpunkt

Der Hebel wäre also, die Atmosphäre von einer freien in eine knappe Ressource zu verwandeln. Übersetzt auf das Kapitalismus-Instrument Markt: sie muss einen Preis bekommen!

Das wurde in der Vergangenheit bereits mit der Etablierung eines Marktes von CO₂-Zertifikaten (leider handwerklich kurz gegriffen) versucht [3]; in diesem Punkt liegen die Klimabewegten also grundsätzlich richtig. Aktuell wird eine Erhöhung der Preise angestrebt [4] (was natürlich wieder ein Eingriff ist und somit aus liberaler Sicht eine Niederlage. Allein, a) mir fällt auch nichts Besseres ein und b) müssen wirtschaftlich Berufenere beurteilen, ob das in der angedachten Weise funktionieren kann. Ich bin da überfragt; ich kann nur sagen: grundsätzlich halte ich den Gedanken für richtig.)

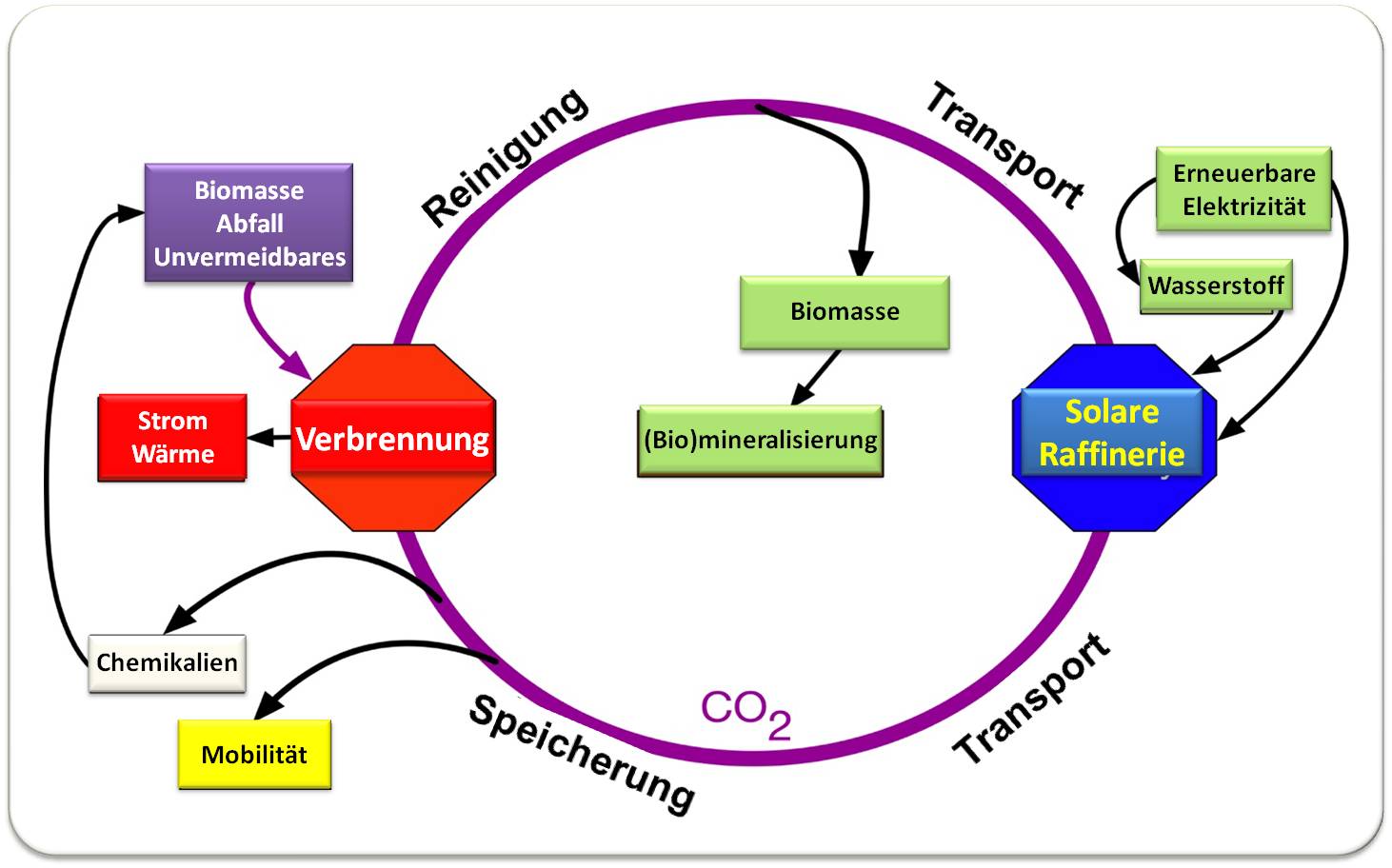

Raus aus Kohlenstoff – und zwar mit oberster Priorität.

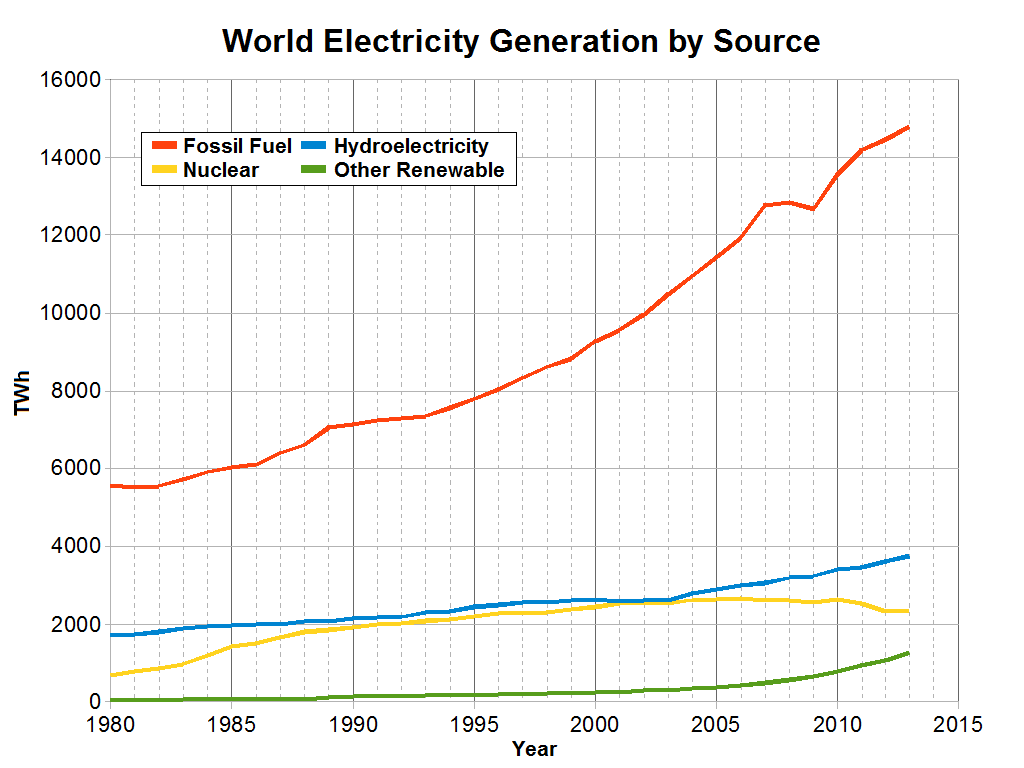

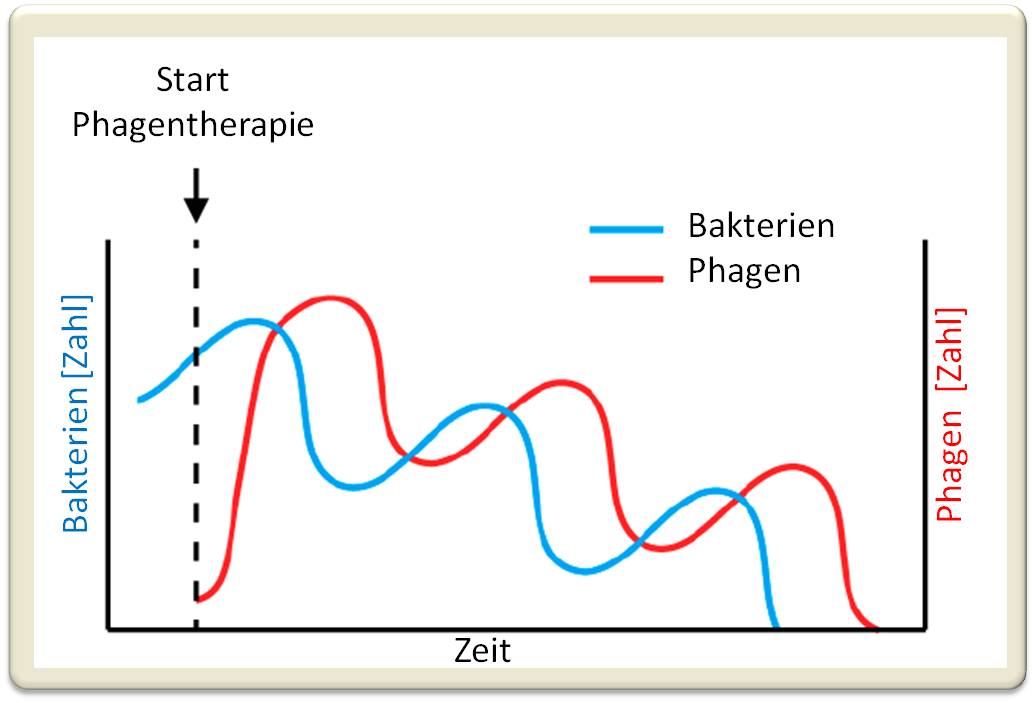

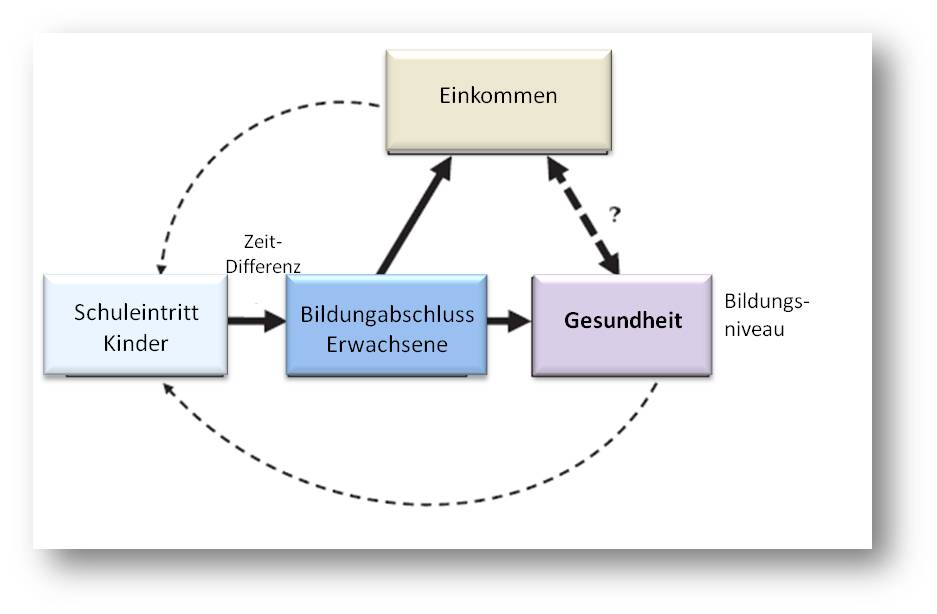

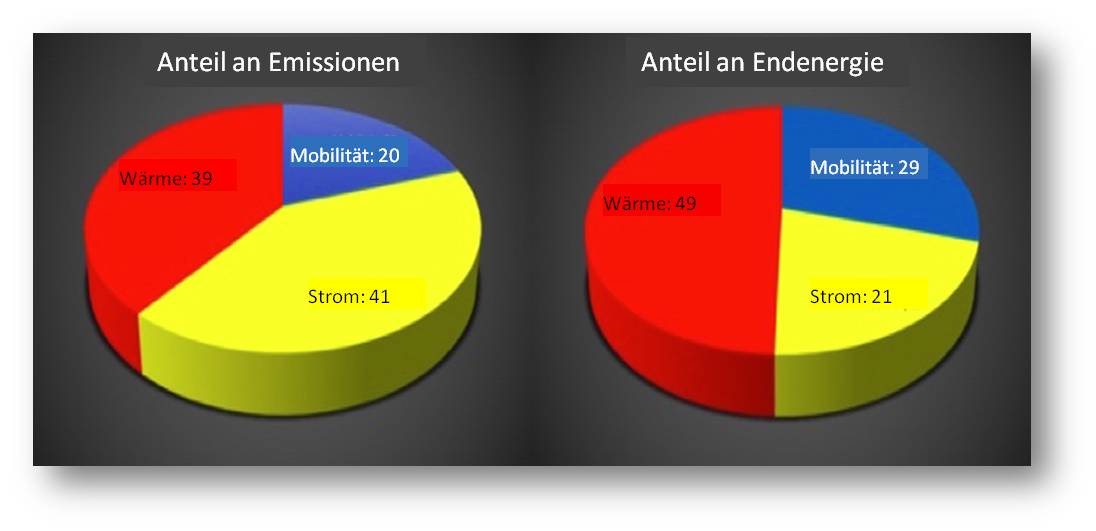

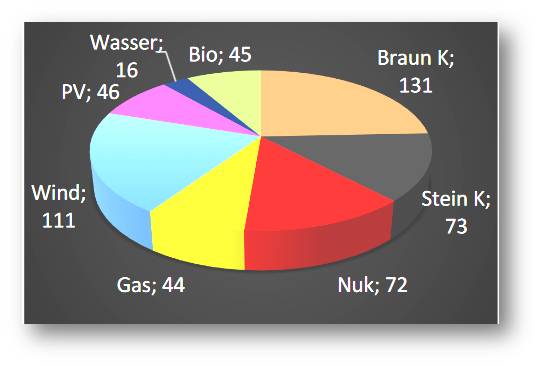

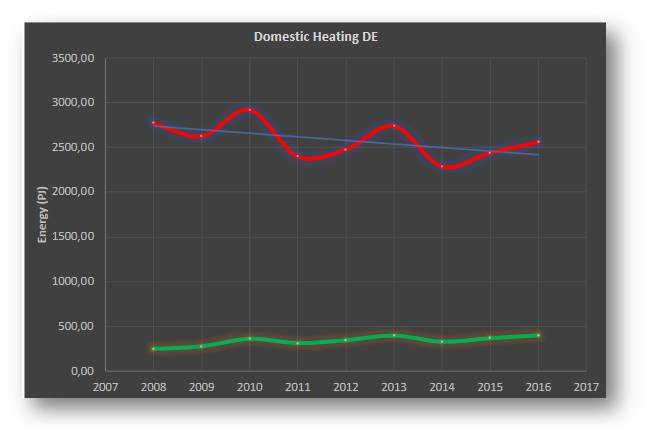

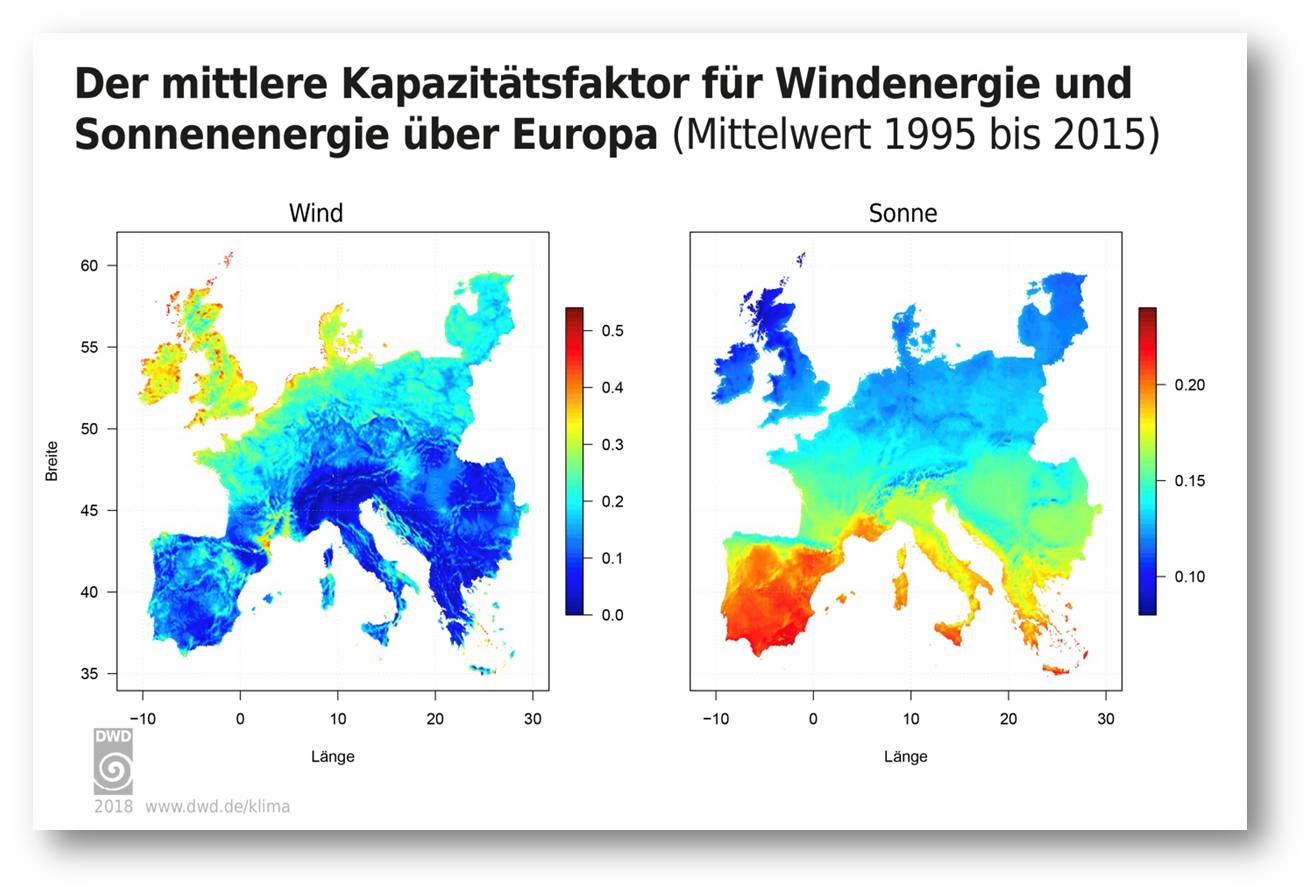

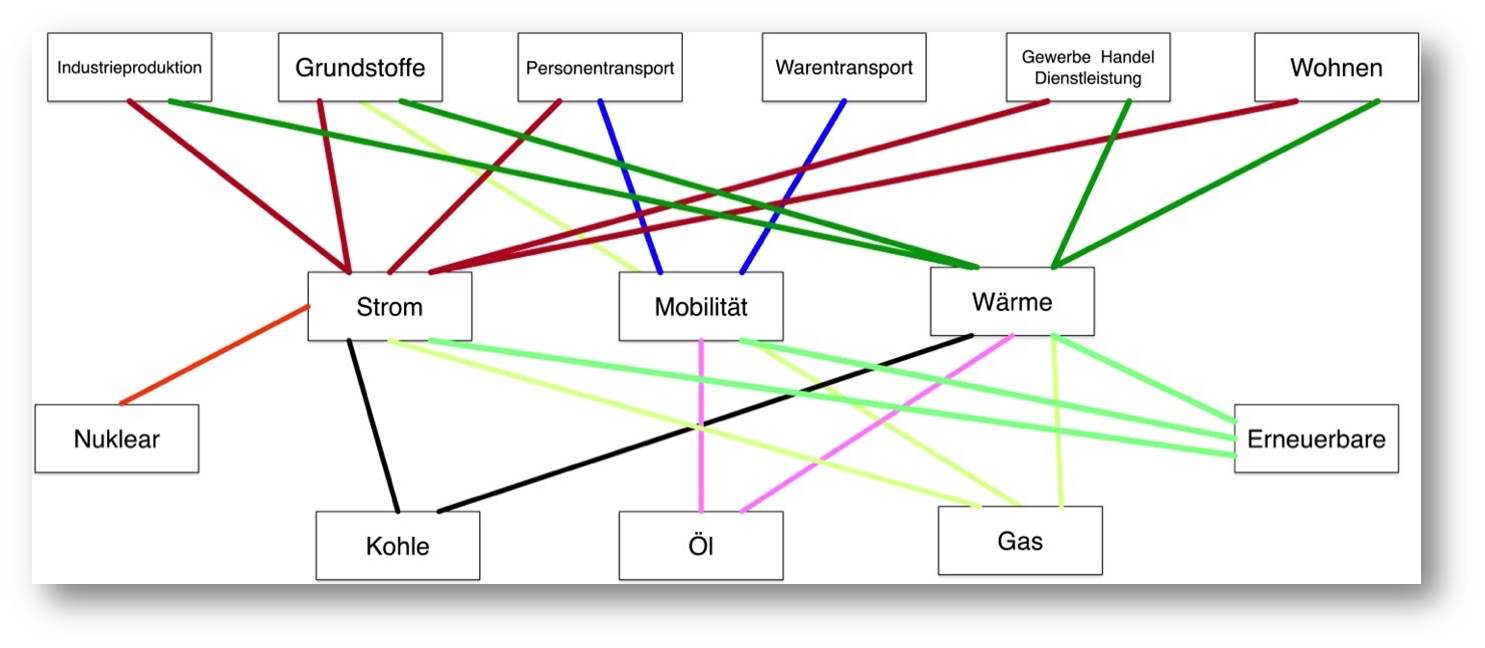

Insbesondere heißt Klimaschutz CO₂-Emissionen abzusenken. Zuerst müssten die Kohlekraftwerke vom Netz (siehe Abbildung 3), dann Gaskraftwerke. Wenn das bedeutet, dass wir Kernkraftwerke laufen lassen müssen, um die Grundlast bereit zu stellen, dann ist das zur Kenntnis zu nehmen [5]. Das verschafft uns die Zeit, die wir benötigen, um den Ausbau der Erneuerbaren, der Netze, der Speicher und der dezentralen Versorgung vorzunehmen.  Abbildung 3: Absolute und relative Anteile der einzelnen Energieerzeugungsarten. (Bild: Wikimedia)(Natürlich spricht nichts dagegen, den Ausbau sofort anzugehen. Aber die Hoffnung, in wenigen Jahren 75 oder so Prozent der (weiter wachsen müssenden! – siehe Abbildungen 1 & 3) Energieversorgung so bereitstellen zu können, ist völlig unbetamt und von Sachkenntnis ungetrübt.)

Abbildung 3: Absolute und relative Anteile der einzelnen Energieerzeugungsarten. (Bild: Wikimedia)(Natürlich spricht nichts dagegen, den Ausbau sofort anzugehen. Aber die Hoffnung, in wenigen Jahren 75 oder so Prozent der (weiter wachsen müssenden! – siehe Abbildungen 1 & 3) Energieversorgung so bereitstellen zu können, ist völlig unbetamt und von Sachkenntnis ungetrübt.)

Energie

Andere Energiequellen müssen erschlossen werden, wie Fusion und/oder alternative Kernkraftkonzepte (langfristig). Selbstverständlich auch völlig dezentrale Energieerzeugung, wie beispielsweise, dass alle neu errichteten Gebäude sich so weit es geht selbst mit Energie versorgen und sich intelligent mit einander vernetzen.

Obwohl das Meiste davon natürlich nur langfristig wirkt, würde es uns insgesamt in die Lage versetzen, Schwellenländern dann fertige Technologien in die Hand zu geben, wenn diese sie brauchen. Wer, außer uns, die ›1. Welt‹, hätte denn die Kapazitäten dazu? Denn ein weiterer, in der öffentlichen Debatte gern übersehener Punkt ist ja, dass aufstrebende Gesellschaften auch einen geradezu unersättlichen Energiehunger entwickeln. Auch das ist eine tickende Bombe, die es zu entschärfen gilt. Und am Beispiel Indien, wo sich aktuell 370 Kohlekraftwerke in Planung oder Bau befinden [6], sieht man, dass das Hemd immer noch das ist, was es immer war: näher als der Rock.

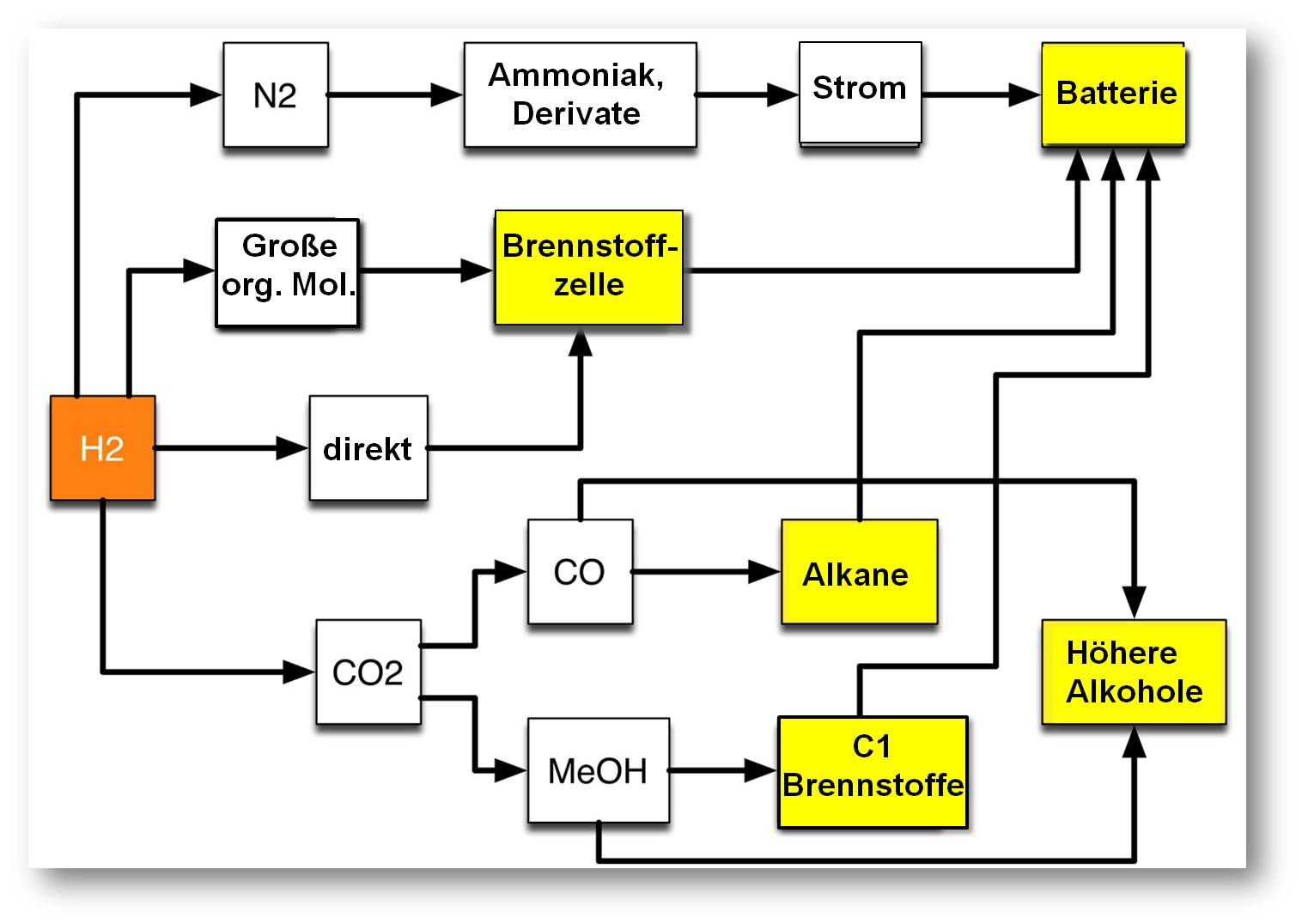

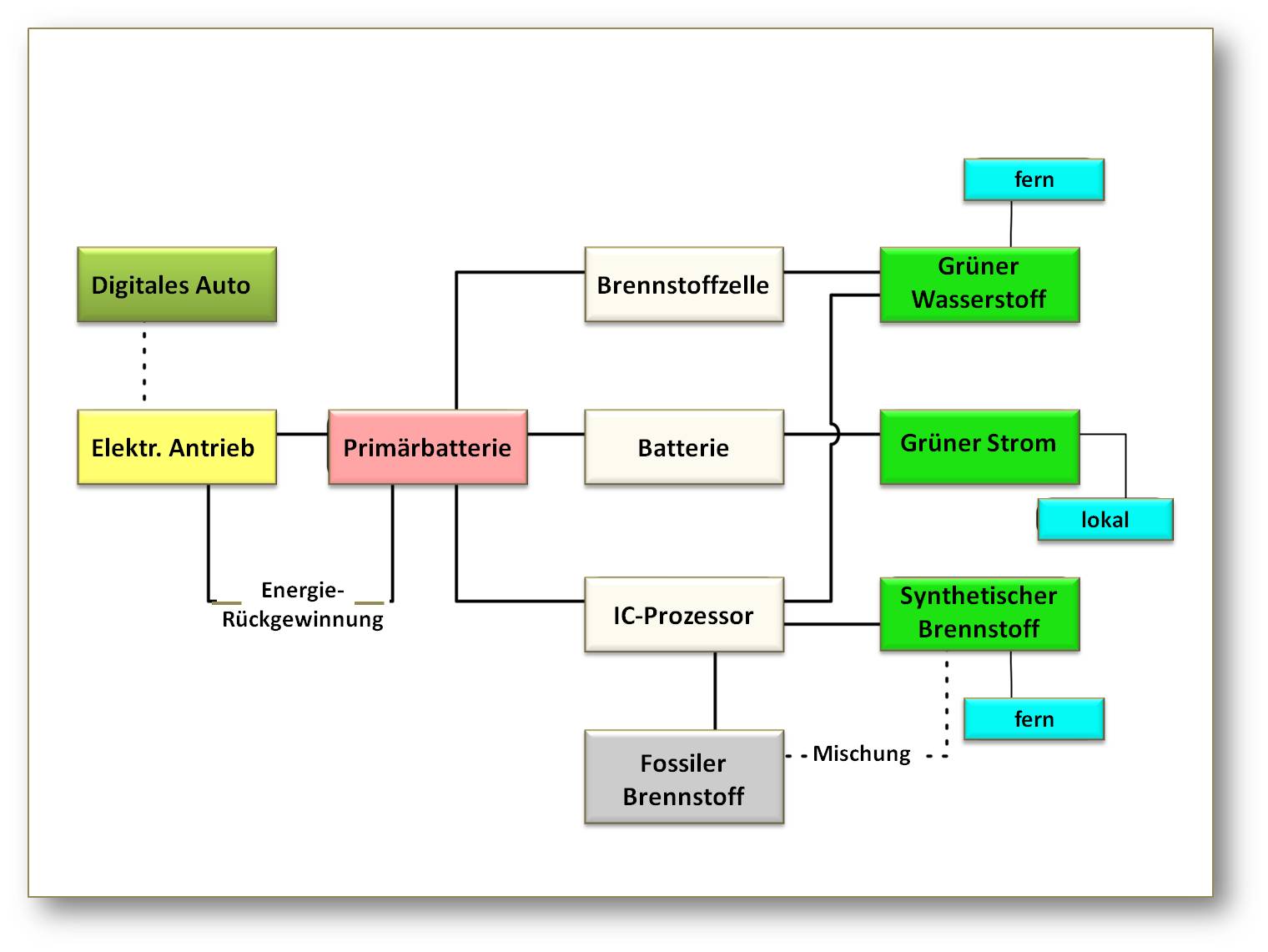

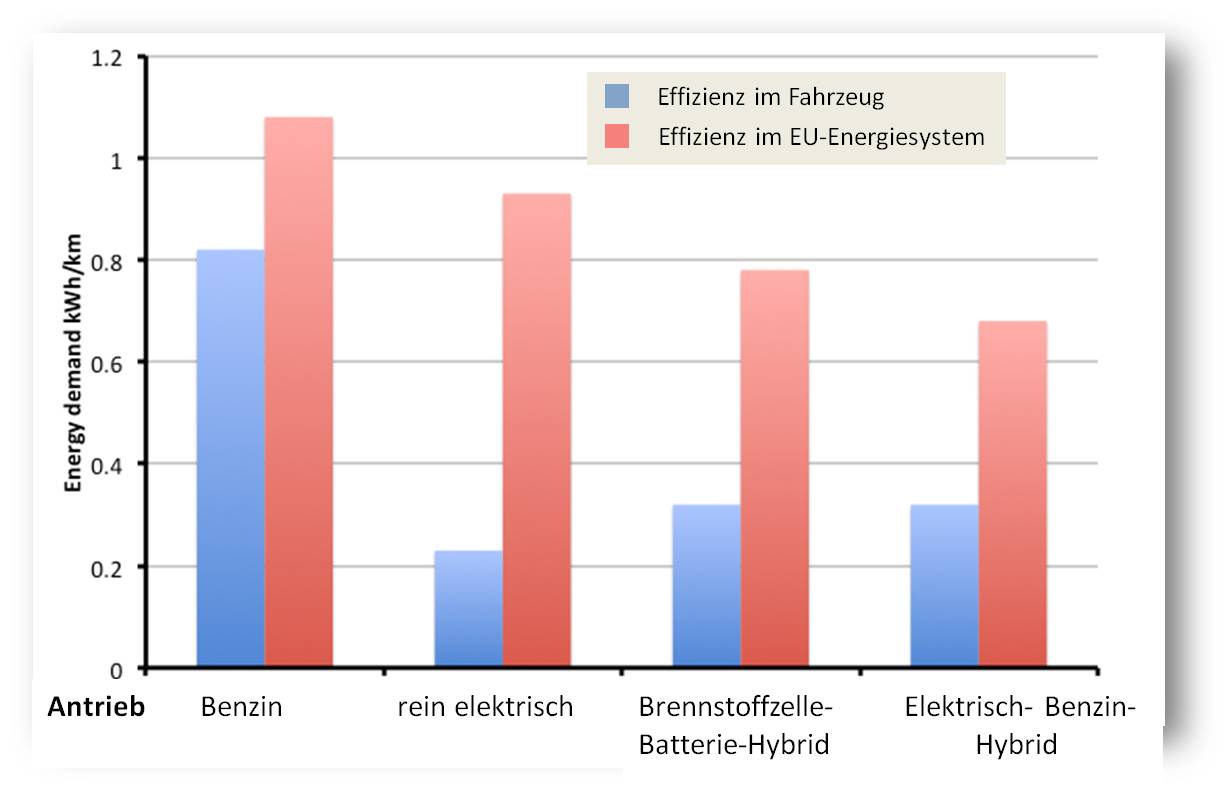

Verkehr

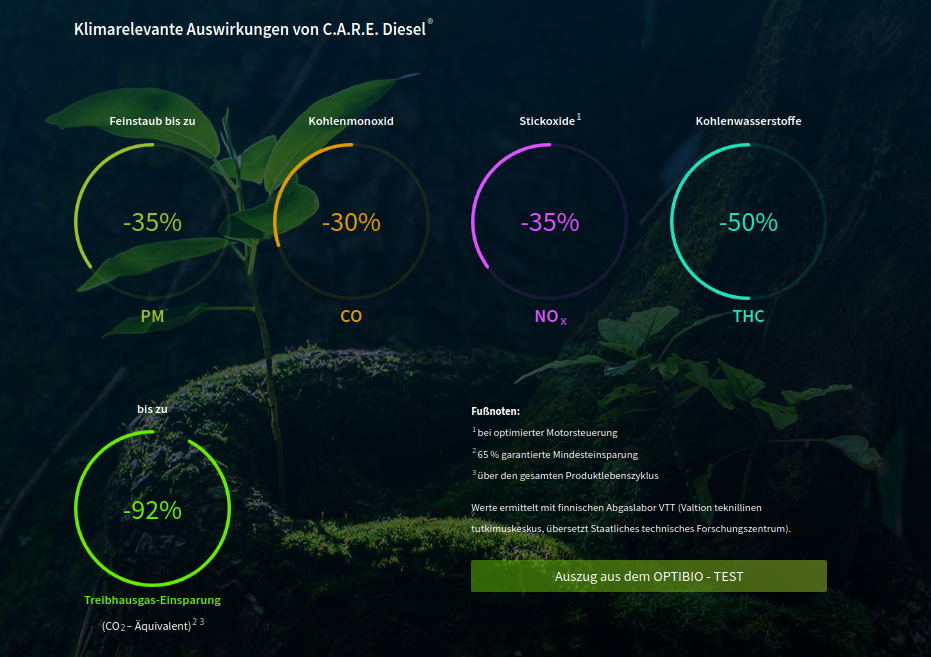

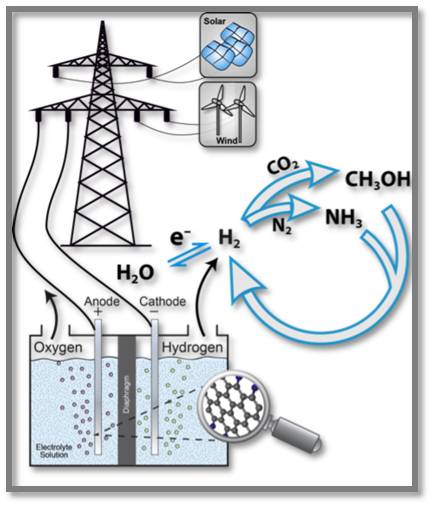

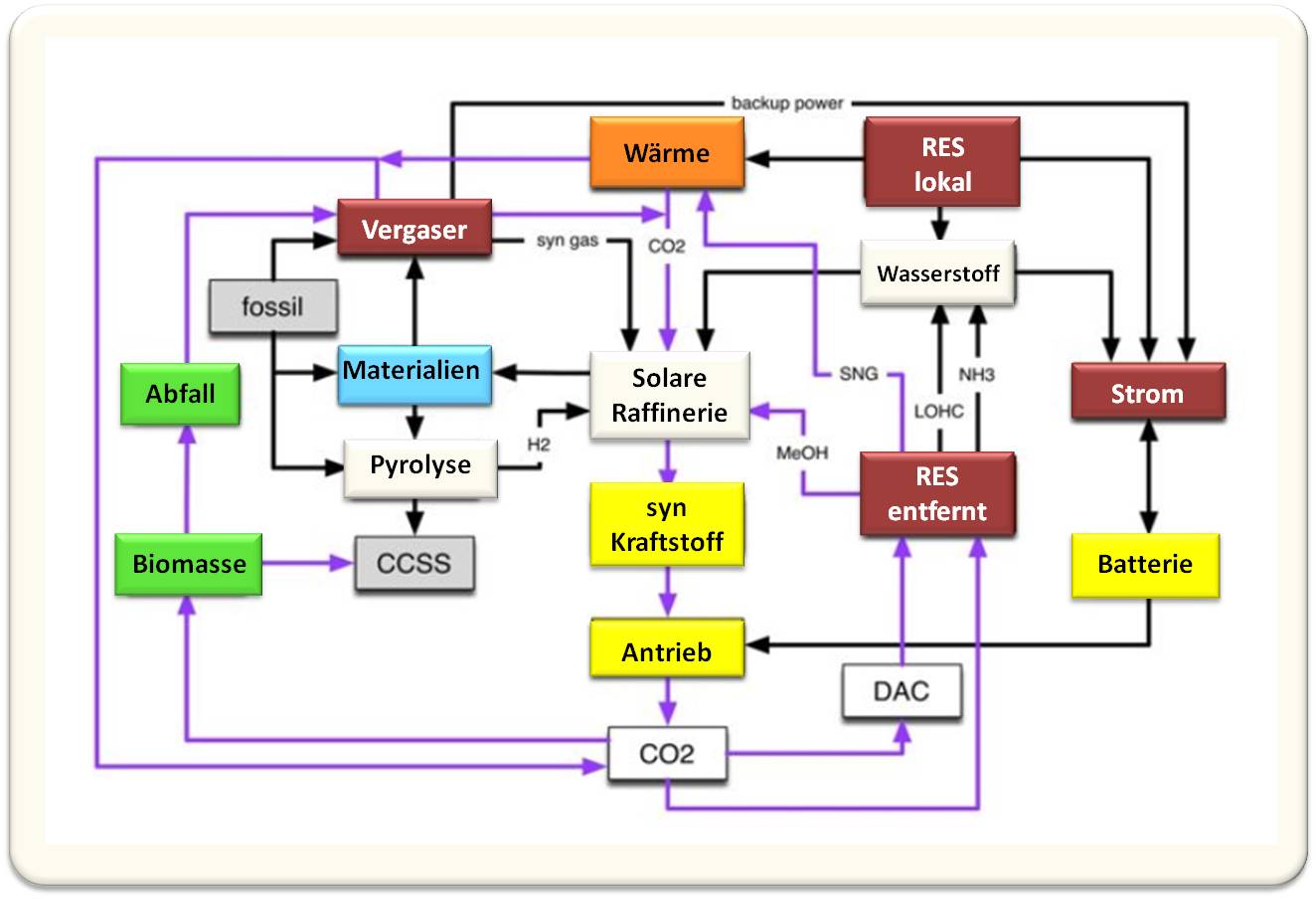

Ein Spezialfall ist der Sektor Verkehr (bei uns immerhin verantwortlich für 25% der Emissionen): Viel sinnvoller als nur auf E-Autos (die schmutziger sind, als die Befürworter das wahrhaben wollen) zu setzen wäre es, CO₂-neutrale Kraftstoffe  Abbildung 4: Klimarelevante Auswirkungen von C.A.R.E Diesel. Allerdings sind nicht alle Auswirkungen gleich. Zum Beispiel geht man davon aus, dass Aerosole (Feinstaub) kühlend auf die Atmosphäre wirken. (Bild: Toolfuel GmbH)zu entwickeln (was das atmosphärische CO₂ zwar nicht senken, aber wenigstens nicht noch weiter befeuern würde) und so den gesamten Verkehr zu neutralisieren. Das sollte für Schiff / Straße / Flugverkehr gleichermaßen in relativ kurzer Zeit machbar sein (was immer noch eher ›Jahrzehnte‹ als ›Jahre‹ heißt, denn so etwas will erst einmal im großen Maßstab ausgerollt werden). Das würde, nebenbei erwähnt, auch die Transport-Bombe entschärfen, die die Globalisierung im Kofferraum liegen hat.

Abbildung 4: Klimarelevante Auswirkungen von C.A.R.E Diesel. Allerdings sind nicht alle Auswirkungen gleich. Zum Beispiel geht man davon aus, dass Aerosole (Feinstaub) kühlend auf die Atmosphäre wirken. (Bild: Toolfuel GmbH)zu entwickeln (was das atmosphärische CO₂ zwar nicht senken, aber wenigstens nicht noch weiter befeuern würde) und so den gesamten Verkehr zu neutralisieren. Das sollte für Schiff / Straße / Flugverkehr gleichermaßen in relativ kurzer Zeit machbar sein (was immer noch eher ›Jahrzehnte‹ als ›Jahre‹ heißt, denn so etwas will erst einmal im großen Maßstab ausgerollt werden). Das würde, nebenbei erwähnt, auch die Transport-Bombe entschärfen, die die Globalisierung im Kofferraum liegen hat.

Entwicklung alternativer Techniken sind mit Hochdruck voranzutreiben, aber man darf dabei nicht auf den Überblick vergessen! Das batteriegestützte E-Auto wird vermutlich seinen Platz haben (bei der aktuellen Akku-Technik habe ich Zweifel daran, dass es das sollte. Aber auch hier wird die Technik nicht stehenbleiben.) Aber auf diese einzige Karte zu setzen scheint mir mit an Sicherheit grenzender Wahrscheinlichkeit kontraproduktiv. Zu begrenzt ist (wenigstens derzeit) der sinnvolle Einsatzbereich. Auch Wasserstoff wird seinen Platz haben – wobei ich nicht der Meinung bin, dass ausschließlich elektrolytische Herstellung infrage kommt. Vielmehr gilt es, CO₂-Abscheidetechniken zu entwickeln, sodass wir auch katalytisch aus fossilen Trägern Wasserstoff gewinnen können (Das würde auch schlagartig H₂ von einer reinen, verlustbehafteten Speicherform in eine Energiequelle verwandeln. Das dabei – ebenso wie bei anderen Prozessen! – entstehende CO₂ können wir abzuscheiden und im Boden einzulagern lernen.)

Fazit

Die Liste möglicher und sinnvoller Ansatzpunkte ließe sich schier endlos fortsetzen. Leider zeigt bereits diese kurze auf, wie verengt der Blick der Spitzenpolitik, aber auch der Interessensvertreter zu sein scheint, die sich darin gefallen, operative Hektik vorzutäuschen und sich auf punktuelle Maßnahmen konzentrieren. Im guten Fall bringen sie wenig (E-Auto), im schlechten sind sie dem Ziel abträglich (Energiewende – jedenfalls so, wie von Deutschland auf Schiene gesetzt). Oft sind sie einfach auch nur ein Schwindeletikett: Stichwort ›Klimanotstand‹ in der EU – einer der gar nicht so vielen Regionen weltweit, in denen es mit an Sicherheit grenzender Wahrscheinlichkeit gar keinen geben können wird.

Trotz alledem bin ich bin unerschütterlicher Optimist und behaupte, wir stecken mitten im Lösungsprozess – es sieht nur nicht für alle danach aus. Für völlig verkehrt halte ich das Panikschüren von beiden Seiten: Die Einen, die behaupten, dass nichts getan würde und in den Raum stellen, dass wir in 10 Jahren gegrillt würden ebenso wie die Anderen, die business as usual fordern und den Rückfall ins Mittelalter an die Wand malen.

Was wir brauchen, ist Aufbruchsstimmung, nicht Resignation. Und schon gar nicht eine weitere Gesellschaftsspaltung.

Endnoten

1 Von einer ›knappen Ressource‹ spricht der Wirtschafter, wenn zu einem Zeiptunkt nicht genügend einer Ressouce zur Verfügung steht, um alle Anfragen gleichzeitig zu bedienen.

2 Die ›Gelbwesten-Bewegung‹ in Frankreich, die nach massiven Treibstoffpreiserhöhungen begann, das Land durch Demonstrationen und Streiks regelrecht ins Chaos zu stürzen.

3 Landläufig ›Wirtschaftsnobelpreis‹.

Nachweise und weiterführende Links

[1] Peter Schuster: Die Tragödie des Gemeinguts

[2] Peter Schuster: Wie erfolgt eine Optimierung im Fall mehrerer Kriterien? Pareto-Effizienz und schnelle Heuristik

[3] Wikipedia: Emmissionsrechtehandel

[4] t-online – AFP: Ein Preis für CO2 – was kostet uns das Klima?

[5] Helmut Rauch: Ist die Kernenergie böse?

[6] natur.de – Nadja Podbregar: Setzt Indien weiter auf Kohle?

Alternsforschung: Proteine im Blut zeigen Ihr Alter an

Alternsforschung: Proteine im Blut zeigen Ihr Alter anDo, 19.12.2019 — Francis S. Collins

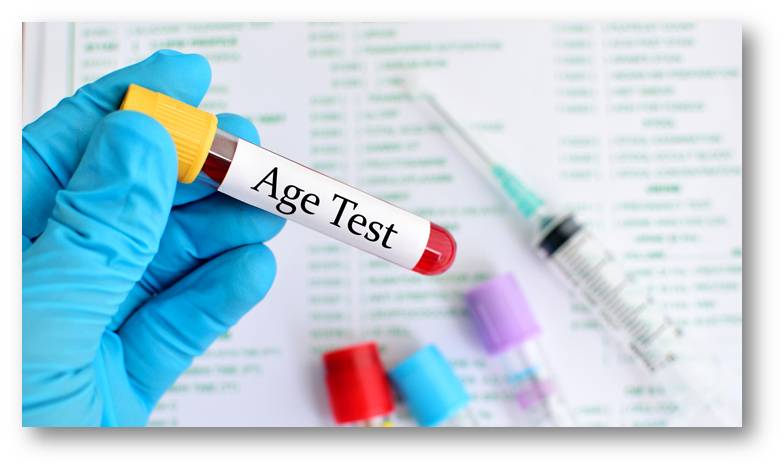

![]() Altern dominiert als Risikofaktor für eine Reihe chronischer Krankheiten, welche verkürzend auf die Lebenszeit wirken. Die an Mäusen erhobene Hypothese, dass Proteine im Blut auf den Alterungsprozess einwirken, wurde in einer neuen Studie an Blutproben von mehr als 4 200 Personen im Alter von 18 - 95 Jahren untersucht und charakteristische altersabhängige, in Schüben erfolgende Veränderungen im Proteom (d.i die Gesamtheit der Proteine im Blut) beobachtet. Auf Basis von 373 (von insgesamt 3000) altersabhängigen Proteinen wurde eine Proteom-Uhr erstellt , die eine genaue Altersbestimmung von Testpersonen erlaubt. Francis S. Collins - Pionier der Genforschung und seit 10 Jahren Direktor der US-National Institutes of Health ( NIH) - berichtet über diese NIH-unterstützte Studie.*

Altern dominiert als Risikofaktor für eine Reihe chronischer Krankheiten, welche verkürzend auf die Lebenszeit wirken. Die an Mäusen erhobene Hypothese, dass Proteine im Blut auf den Alterungsprozess einwirken, wurde in einer neuen Studie an Blutproben von mehr als 4 200 Personen im Alter von 18 - 95 Jahren untersucht und charakteristische altersabhängige, in Schüben erfolgende Veränderungen im Proteom (d.i die Gesamtheit der Proteine im Blut) beobachtet. Auf Basis von 373 (von insgesamt 3000) altersabhängigen Proteinen wurde eine Proteom-Uhr erstellt , die eine genaue Altersbestimmung von Testpersonen erlaubt. Francis S. Collins - Pionier der Genforschung und seit 10 Jahren Direktor der US-National Institutes of Health ( NIH) - berichtet über diese NIH-unterstützte Studie.*

Wie verändern sich im Alterungsprozess die Spiegel der Proteine im Blut?

Wie lässt sich feststellen, wie alt jemand ist?

Natürlich kann man in dessen Führerschein nachsehen oder nach Anzeichen von Gesichtsfalten und grauem Haar suchen. Wie allerdings Forscher in einer eben veröffentlichten neuen Studie herausgefunden haben, kann man der richtigen Antwort auch durch eine Blutuntersuchung ziemlich nahe kommen.

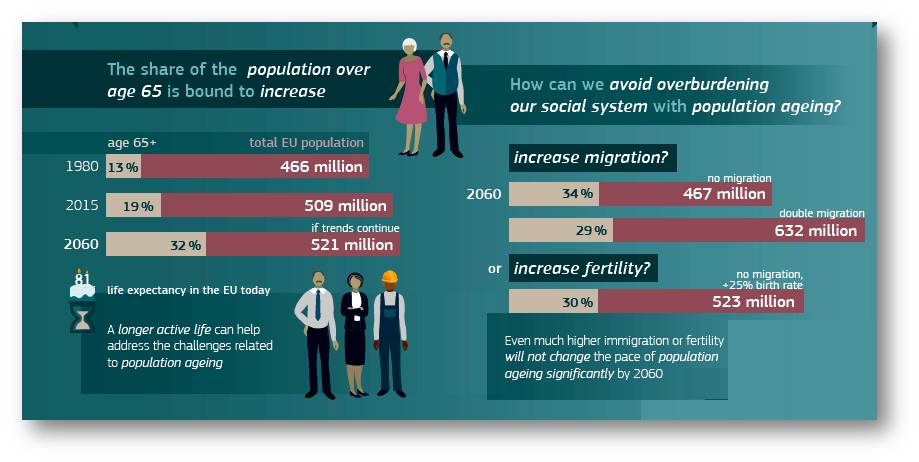

Das mag überraschend erscheinen. In einer kürzlich durchgeführten Studie, die im Journal Nature Medicine veröffentlicht wurde [1], gelang es einem NIH-geförderten Forscherteam jedoch, das Alter von Personen recht zuverlässig zu bestimmen, indem sie Blutproben auf die Konzentration von einigen hundert Proteinen untersuchten. Die Ergebnisse bieten wichtige neue Einblicke in das, was geschieht, wenn wir älter werden. Beispielsweise weist das Team darauf hin, dass der biologische Alterungsprozess nicht gleichförmig verläuft, sondern sich zeitweise zu beschleunigen scheint - wobei die größten Schübe im Durchschnitt im Alter um die 34, 60 und 78 Jahre auftreten.

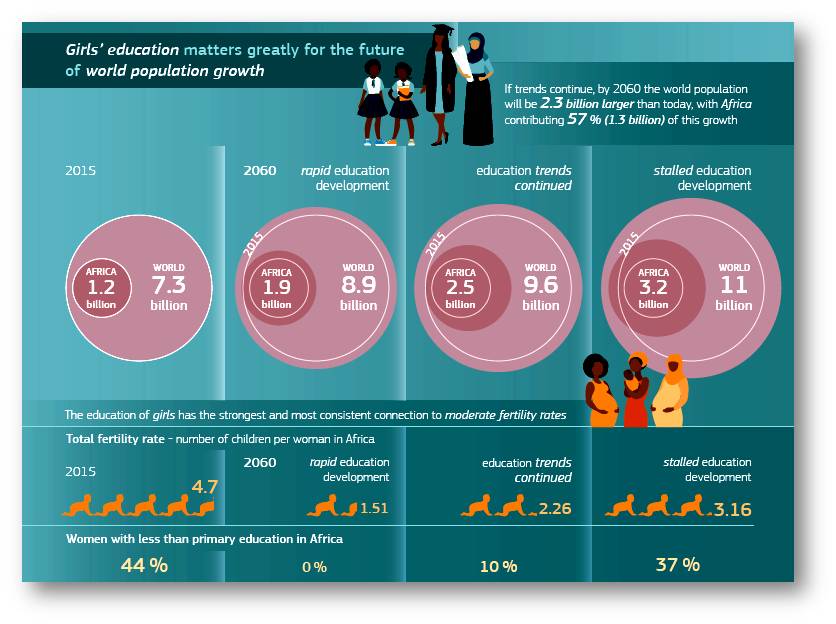

Diese Ergebnisse deuten darauf hin, dass es eines Tages könnte möglich werden könnte mit Hilfe einer Blutuntersuchung Personen zu identifizieren, die biologisch schneller altern als andere (Abbildung 1). Solche Menschen wären bereits in jüngeren Jahren einem Risiko für Herz-Kreislauf-Erkrankungen, für Alzheimer-Krankheit, degenerative Gelenksveränderungen und andere altersbedingte Gesundheitsprobleme ausgesetzt.

Abbildung 1. Aus einer Blutprobe das Alter bestimmen. (Credit: Adapted from iStock/jarun011)

Abbildung 1. Aus einer Blutprobe das Alter bestimmen. (Credit: Adapted from iStock/jarun011)

Darüber hinaus erweckt diese Studie die Hoffnung auf Behandlungen, welche die Proteom-Uhr (Proteom bedeutet hier die Gesamtheit der Proteine im Blut; Anm. Redn.) verlangsamen und Menschen helfen biologisch vielleicht jünger zu sein als es ihrem chronologischen Alter entspricht. Ein solches Szenario mag sich wie reine Phantasie anhören, aber die Forschergruppe der derzeitigen Studie hat schon vor einigen Jahren gezeigt, dass es tatsächlich möglich ist, eine ältere Maus zu verjüngen, wenn man ihr Blut von einer viel jüngeren Maus infundiert.

Die Proteom-Uhr

Diese und frühere Ergebnisse aus dem Labor von Tony Wyss-Coray (Stanford School of Medicine;(Palo Alto, Kalifornien), hatten auf die reizvolle Möglichkeit hingedeutet, dass im Blut junger Individuen bestimmte Substanzen vorhanden sind, die das alternde Gehirn und andere Körperteile verjüngen können. Auf der Suche nach weiteren Hinweisen untersuchte das Wyss-Coray-Team nun, wie sich die Zusammensetzung der Proteine im Blut mit steigendem Alter der Menschen ändert.

Zu diesem Zweck isolierten sie Plasma von mehr als 4.200 gesunden Personen im Alter von 18 bis 95 Jahren. Die Daten von mehr als der Hälfte der Teilnehmer verwendeten die Forscher dann, um eine Proteom-Uhr des Alterns zu erstellen. Diese Uhr konnte das chronologische Alter der verbleibenden 1.446 Studienteilnehmer innerhalb gewisser Grenzen genau vorhersagen. Die besten Vorhersagen basierten dabei auf nur 373 der insgesamt fast 3.000 mit der Uhr korrelierten Proteine.

Als weitere Validierung konnte die Proteom-Uhr auch das korrekte chronologische Alter von vier Personengruppen zuverlässig vorhersagen, die nicht an der Studie teilgenommen hatten. Interessanterweise war es möglich, eine vernünftige Aussage über das Alter bereits auf Grundlage von nur neun der aussagekräftigsten Proteine der Uhr zu treffen.

Rolle im Alterungsprozess

Die Ergebnisse zeigen, dass mit dem Alter charakteristische Veränderungen im Proteom auftreten und wahrscheinlich wichtige und bisher unbekannte Auswirkungen auf die Gesundheit haben. Die im Blutkreislauf zirkulierenden Proteine stammen schließlich nicht nur aus Blutzellen, sondern auch aus Zellen im gesamten Körper. Interessanterweise berichten die Forscher, dass Menschen, die aufgrund ihrer Blutproteine biologisch jünger als ihr tatsächliches chronologisches Alter erschienen, auch bei kognitiven und physischen Tests bessere Ergebnisse erzielten.

Die meisten von uns betrachten das Altern als einen graduellen, linearen Prozess. Die Ergebnisse der Proteomstudie legen jedoch nahe, dass biologisch gesehen das Altern einem komplexeren Muster folgt. Einige Proteine stiegen mit der Zeit allmählich auf fast lineare Weise an oder nahmen ab. Aber die Spiegel vieler anderer Proteine veränderten sich mit der Zeit wesentlich stärker. Beispielsweise blieb ein neuronales Protein im Blut bis zum Alter von etwa 60 Jahren konstant und stieg dann an. Warum das so ist, muss noch geklärt werden.

Wie bereits erwähnt, konnten die Forscher zeigen, dass der Alterungsprozess in einer Reihenfolge von drei Schüben abläuft. Wyss-Coray sagte, es sei besonders interessant, dass der erste Schub in der frühen Lebensmitte um das 34. Lebensjahr stattfindet, noch lange bevor sich die üblichen Anzeichen des Alterns und die damit verbundenen Gesundheitsprobleme bemerkbar machen.

Dass Männer und Frauen unterschiedlich altern, ist allgemein bekannt; die Proteomstudie ergänzt die diesbezüglichen Beweise. Rund zwei Drittel der Proteine, die sich mit dem Alter veränderten, zeigten auch Geschlechtsunterschiede. Der Effekt des Alterns auf die wichtigsten Proteine der Uhr ist jedoch viel stärker ist als die geschlechtsspezifischen Unterschiede, daher kann die proteomische Uhr das Alter bei allen Menschen genau vorhersagen.

Fazit

Insgesamt zeigen die Ergebnisse, dass Proteine im Blut ein brauchbares Maß für das chronologische und biologische Alter einer Person darstellen können und dass - zusammen mit früheren Studien von Wyss-Coray - diese Proteine eine aktive Rolle im Alterungsprozess spielen können. Wie Wyss-Coray sagt, will sich sein Team nun intensiver mit den Befunden befassen, um mehr über die Herkunft bestimmter Proteine im Blutkreislauf zu erfahren, darüber was sie für unsere Gesundheit bedeuten und wie man die Proteom-Uhr möglicherweise zurückdrehen kann.

[1] Lehallier B, et al., Undulating changes in human plasma proteome profiles across the lifespan. Nat Med. 2019 Dec;25(12):1843-1850. (Das Paper ist nicht frei zugänglich; Anm. Redn.)

* Dieser Artikel von NIH Director Francis S. Collins, M.D., Ph.D. erschien zuerst (am 17. Dezember 2019) im NIH Director’s Blog unter dem Titel: "Aging Research: Blood Proteins Show Your Age" https://directorsblog.nih.gov/2019/12/17/aging-research-plasma-proteins-show-your-age/ und wurde geringfügig für den ScienceBlog adaptiert. Reprinted (and translated by ScienceBlog) with permission from the National Institutes of Health (NIH).

Weiterführende Links

- What Do We Know About Healthy Aging?

- Cognitive Health.

- Francis S. Collins (2017): Aging Research: Plasma Protein Revitalizes the Brain.

- Tony Wiss-Corey How young blood might help reverse aging. Yes, really. (2015) TED-Talk, 13:15 min.

Die Horvath'sche Uhr zur Altersbestimmung: Norbert Bischofberger, 24.05.2018: Auf dem Weg zu einer Medizin der Zukunft.

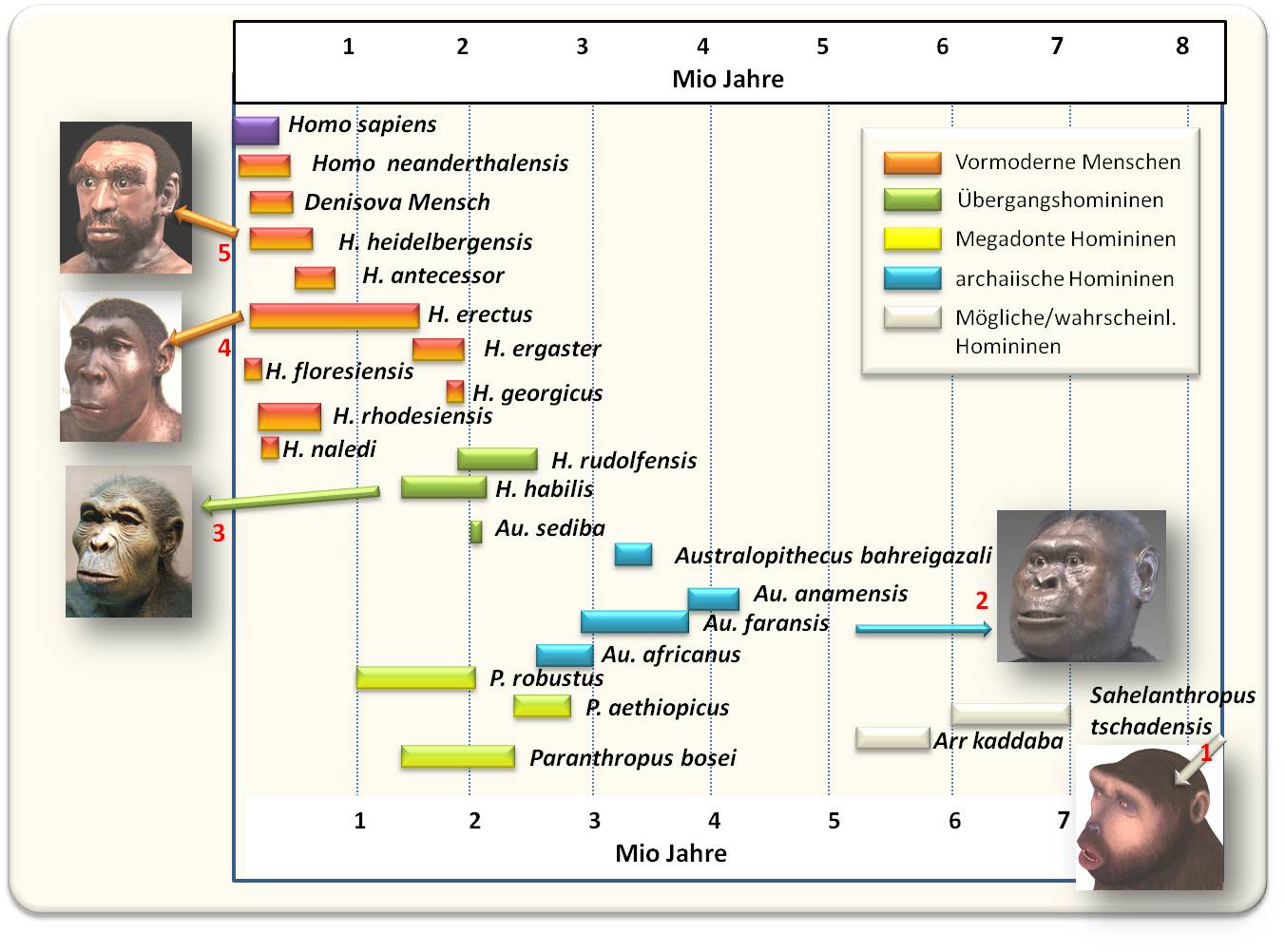

Transhumanismus - der Mensch steuert selbst seine Evolution

Transhumanismus - der Mensch steuert selbst seine EvolutionDo, 12.12.2019 — Inge Schuster

Unter der Bezeichnung Transhumanismus sind In den letzten Jahrzehnten mehrere, von einander nicht scharf abgegrenzte weltanschauliche Strömungen vor allem im angelsächsischem Raum entstanden, die mit Hilfe von Wissenschaft und Technologie die Grenzen des biologischen Menschen überwinden und seine Fähigkeiten erweitern möchten. Alle diese Ideologien verbindet die Erwartung, dass damit die Chancen auf ein erfülltes Leben erhöht werden. Dies reicht von Gen-Verbesserung, Umkehrung des Alterungsprozess bis zur Verschmelzung von Mensch und Maschine (Cyborg) und darüber hinaus zu einer nichtbiologischen neuen posthumanen Spezies. Der folgende Überblick gibt meine Sicht als Biowissenschafter - jedoch ohne ethische Wertung - wieder.*

Im Verlauf der Evolution hat der Mensch großartige physische und geistige Fähigkeiten erworben - dass diese noch verbesserbar sind, ist unbestritten. Unter dem Begriff "Transhumanismus" sind In den letzten Jahrzehnten vor allem im angelsächsischem Raum mehrere, von einander nicht scharf abgegrenzte weltanschauliche Strömungen entstanden, die - an die Antike und später an den Renaissance-Humanismus und die Aufklärung anknüpfend - in Summe die Verbesserung des Menschen - das Human Enhancement - zum Ziel haben.

Nach Meinung der Transhumanisten ist der Mensch die erste Spezies, welche die eigene Evolution nicht mehr dem Zufall zu überlassen braucht, sondern - quasi im Zeitraffer - selbst planen und steuern kann.

Ziele der selbstgesteuerten Evolution

Basierend auf den Erkenntnissen der modernen (Natur)Wissenschaften und unter Einsatz bereits etablierter, noch zu realisierender oder auch erst in Zukunft denkbarer Technologien sollen die Grenzen der physischen und intellektuellen Möglichkeiten des Menschen erweitert und damit seine Chancen auf ein erfülltes Leben erhöht werden. Es geht um das Erreichen

- einer höchstmöglichen Intelligenz,

- einer höchstmöglichen Lebensdauer und

- eines größtmöglichen Wohlbefindens.

Für eine derartige Optimierung und - nach eigenen Vorstellungen erfolgenden - Umformung des menschlichen Organismus, sehen Transhumanisten gezielte technische und genetische Eingriffe vor. Sie wollen damit den Alterungsprozess stoppen, degenerative Krankheiten ausmerzen, die mentale Leistungsfähigkeit steigern und insgesamt das Leben verbessern und verlängern. Das sind Vorhaben, welche zweifellos weitgehende Zustimmung finden; die weltweite Forschung hat dazu bereits eine Fülle neuer Erkenntnisse, Konzepte und Anwendungsmöglichkeiten geliefert.

Dubioser sind Pläne der sogenannten Kryoniker:

Menschen, die nicht auf lebensverlängernde Praktiken warten können, weil sie vorher an heute noch nicht heilbaren Krankheiten sterben, wird eine Zwischenlösung in Aussicht gestellt. Nach Meinung der Kryoniker tritt der Tod ja nicht mit dem Aufhören von Herzschlag und Gehirntod ein, sondern erst dann, wenn die Zellen des Körpers bereits irreversibel geschädigt sind. Um dies zu verhindern, werden "Patienten" unmittelbar nach ihrem klinischen Tod in flüssigem Stickstoff bei -196 °C (vitrifiziert) gelagert, mit der Zusage wieder "geweckt" zu werden, wenn der Fortschritt der Wissenschaft eine Heilung von der einst tödlichen Krankheit verspricht. Für dieses Verfahren existieren bereits mehrere Anbieter. Im größten dieser Unternehmen, der bereits 1972 in Arizona gegründeten Alcor Life Extension Foundation, lagern aktuell 171 solcher "Patienten" und 1269 Personen haben die legalen und finanziellen Vorkehrungen für den - nach ihrer Überzeugung - Zwischenzustand "nicht lebendig - nicht tot" getroffen.

Völlig utopisch

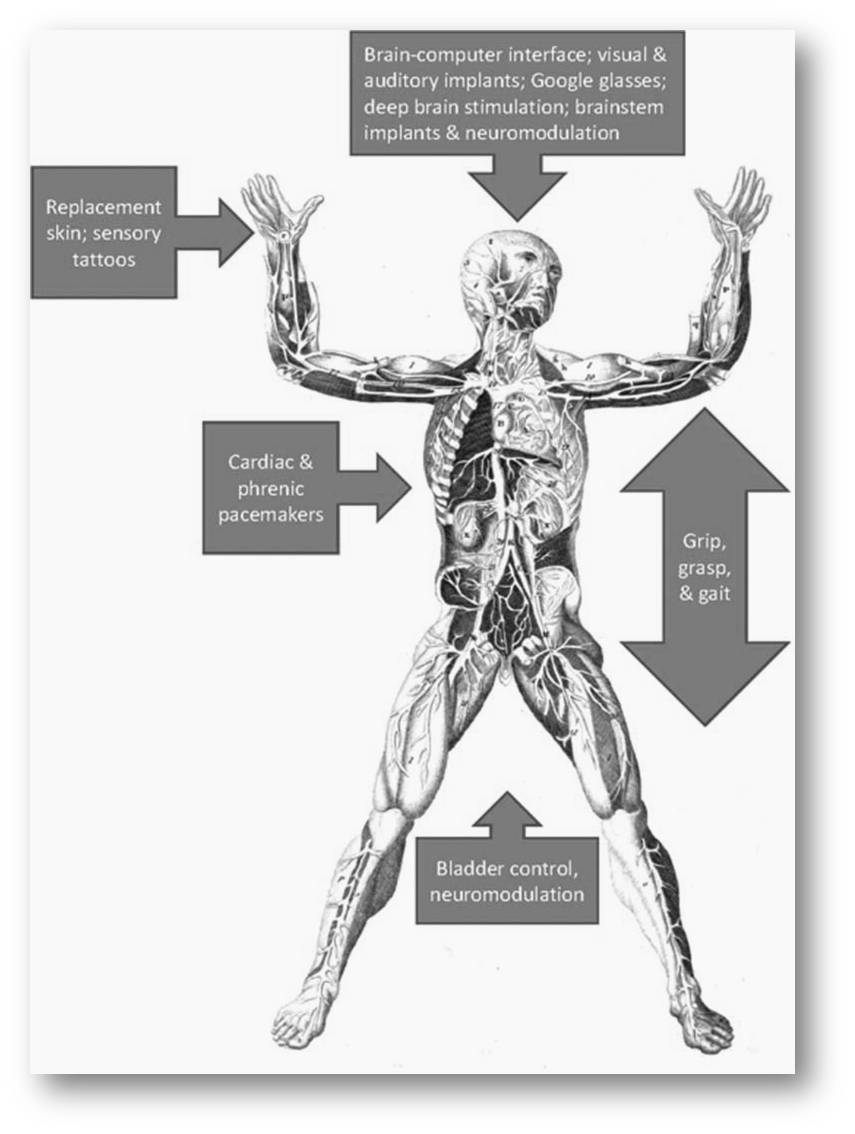

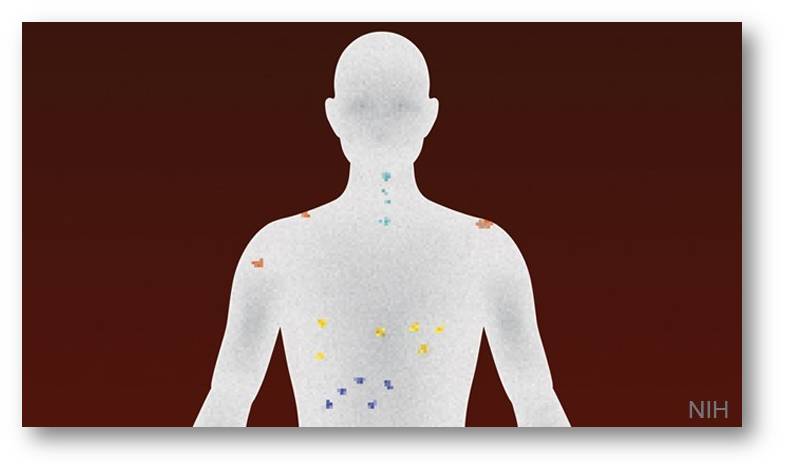

muten Visionen an, wohin sich der Mensch schließlich entwickeln soll. Insgesamt soll die Natur des Menschen - sein störungsanfälliger Körper, sein verbesserungsfähiges Gehirn - technisch überwunden werden, Mensch und Maschine zum hybriden Mensch-Maschine Wesen, einem sogenannten Cyborg (cybernetic organism) verschmelzen (Abbildung 1).

Abbildung1. Die Verschmelzung von Mensch und Maschine (Bild: pixabay, gemeinfrei)

Abbildung1. Die Verschmelzung von Mensch und Maschine (Bild: pixabay, gemeinfrei)

Mit dem sich exponentiell beschleunigendem technologischen Fortschritt soll - optimistischen Schätzungen führender Transhumanisten zufolge - Künstliche Intelligenz in wenigen Jahren/Jahrzehnten die Leistungsfähigkeit der menschlichen Intelligenz erreicht haben und mit dieser dann zur Super-Intelligenz fusionieren. Ab diesem, als Singularity bezeichneten Zeitpunkt wird sich das menschliche Leben unvorhersehbar, irreversibel verändern. Radikale Transhumanisten gehen davon aus, dass das Gehirn dann in all seinen Funktionen samt dem emergenten Bewusstsein erforscht sein wird, alle seine Inhalte gescannt werden können und mittels eines sogenannten Mind-Upload auf einen anderen, nicht-biologischen Träger (z.B. ein elektronisches Netzwerk) hochgeladen werden können. Am Ende dieser Transformation steht dann ein posthumanes Wesen, eine digitale Kopie, die -losgelöst vom Körper - virtuell praktisch "ewig" weiterexistieren kann.

Das Transhumanismus Manifest

Die unterschiedlichen Strömungen moderater bis radikaler Transhumanisten haben schließlich zu einer gemeinsamen Deklaration zusammengefunden. Der britische Philosoph Nick Bostrom verfasste 1999 zusammen mit dem schwedischen Informatiker und Neurowissenschafter Anders Sandberg das Transhumanistische Manifest, welches von weltweiten Transhumanisten-Gruppen mehrmals umformuliert und in letzter Fassung 2009 von Humanity+ - dem Dachverband der Transhumanisten (siehe nächstes Kapitel) - angenommen wurde. Darin wird die Wahlfreiheit des Einzelnen betont sein Leben nach seinen Vorstellungen zu optimieren, aber auch die Risiken angesprochen, die neue Technologien mit sich bringen können und die moralische Verantwortung gegenüber künftigen Generationen berücksichtigt [1].

Wer sind die Akteure des Transhumanismus?

Den Traum die Grenzen der menschlichen Natur mittels innovativer Technologien zu überschreiten dürfte es seit Anbeginn der Menschheit gegeben haben. Mythen erzählen von Daidalos, der für seine Flucht ein - zumindest für ihn selbst - funktionierendes Fluggerät gebaut hat, vom Titanen Prometheus der das - für die Menschheitsentwicklung essentielle - Feuer zur Erde brachte. Im Mittelalter träumte man vom Jungbrunnen, der dem Altern ein Ende machen sollte, in der Renaissance hat Leonardo da Vinci eine unglaubliche Vielfalt neuartiger Maschinen zur Erweiterung der Tätigkeitsfelder des Menschen entworfen. Die Liste ließe sich noch sehr lange fortsetzen.

Den Begriff Transhumanismus selbst hat der Evolutionsbiologe, Eugeniker und Philosoph Julian Huxley, (Bruder von Aldous Huxley, dem Verfasser der "Brave New World") 1957 in seinem Buch "New Bottles for New Wine" geprägt. Er versteht darunter den Menschen,

"der Mensch bleibt, aber seine Grenzen überschreitet, indem er neue Möglichkeiten seiner menschlichen Natur und für diese Natur realisiert" [2].

Transhumanistische Vorstellungen blieben lange Spielplatz von Philosophen und Science-Fiction Autoren. Mit den bahnbrechenden Erkenntnissen der Molekularbiologie, mit neuen Technologien der Biotechnologie, bildgebenden Verfahren, neuen Methoden der regenerativen Medizin und insbesondere mit der exponentiellen Steigerung von Computerleistung und immer aussagekräftigeren Algorithmen setzte in den frühen 1980er Jahren die eigentliche Entwicklung des Transhumanismus ein. Kalifornien war das Zentrum, der Einzugsbereich der University of Los Angeles und des Hotspots für Innovationen und Startups, Silicon Valley.

Daraus sind weltweite, sehr einflussreiche ideologische Strömungen geworden; die Zahl der Aktivisten - eine heterogene Mischung u.a. aus Mathematikern, IT-Experten, Physikern, Technologen, Biowissenschaftern und Medizinern ebenso wie aus Philosophen, Ethikern, Ökonomen und auch Journalisten und Science-Fiction Autoren - ist stark gewachsen. (Details dazu in [3]).

Der Dachverband der Transhumanisten,

die World Transhumanist Association (WTA) wurde 1998 von den britischen Philosophen Nick Bostrom und David Pearce gegründet mit dem Ziel: i) die Öffentlichkeit mit neu aufkommenden Technologien vertraut zu machen, ii) die Rechte derer zu verteidigen, die solche Technologien für ihr Human Enhancement in Anspruch nehmen wollen und iii) mögliche Konsequenzen von aufkommenden Technologien vorweg zu nehmen und Lösungen vorzuschlagen. Diese rasch wachsende Einrichtung wurde später in Humanity+ umbenannt und zählt heute rund 6000 Mitglieder. Geschäftsführerin ist derzeit Natasha Vita- More, die Künstlerin, Designerin und Alternsforscherin, Pionierin des Transhumanismus und Professorin an der University of Advancing Technology ist. In ihrer Forschung an dem Modellorganismus Caenorhabditis elegans hat sie kürzlich ein für das Kryonik-Gebiet aufregendes Ergebnis gefunden: die Erinnerung des mikroskopisch kleinen Wurms an antrainiertes Verhalten blieb nach dem Kryokonservieren (Vitrifizieren) und Wiederauftauen erhalten.

Singularity University

Zu den prominentesten und schillerndsten Vertretern der Szene gehört der IT-Experte Ray Kurzweil, der durch Dutzende Erfindungen - u.a. des Flachbett-Scanners, des ersten Sprach-Synthesizers, von Lesegeräten für Blindenschrift und von Bilderkennungssoftware - berühmt und reich geworden ist. Als einer der radikalsten Transhumanisten vertritt Kurzweil die Vision einer schon bald eintretenden Singularität - der Verschmelzung von künstlicher mit menschlicher Intelligenz (siehe oben). Singularität trägt auch die von ihm 2008 gegründete Singularity University im Titel. Diese, in unmittelbarer Nachbarschaft zur Raumfahrtbehörde NASA und zum Mega-Unternehmen Google gelegene Privatuniversität wurde zum Zentrum transhumanistischer Ideologien, zu dem Führungskräfte und Startup-Unternehmer hin pilgern - trotz exorbitanter Gebühren und ohne einen akademischen Abschluss zu erhalten. Diskutiert wird hier mit Wissenschaftern und erfolgreichen Unternehmern aus dem Silicon Valley u.a. über Künstliche Intelligenz, Robotik , Synthetische Biologie, Virtual Reality und es werden Zukunftsideen entwickelt, welche die Welt verändern sollen. Die Singularity University wurde lange Jahre mit Millionenbeiträgen von Google-Alphabet unterstützt. Google, das Unsummen in die Entwicklung der Künstlichen Intelligenz investiert, hat Kurzweil 2012 als Chefingenieur für technische Entwicklung eingesetzt.

Thinktanks wie die Singularity Universität sind auch andernorts entstanden. Dank großzügiger Unterstützungen werden Hunderte transhumanistische Projekte auch an hoch renommierten Universitäten bearbeitet. Fördergelder kommen vor allem von Branchen die von transhumanistischen Visionen zu profitieren hoffen, insbesondere von IT-Branchen (die von diversesten implantierbaren Chips träumen) und auch von Pharmafirmen.

Auf dem Weg zum Cyborg

Wenn der Transhumanismus eine Verbesserung des Menschen durch technische und genetische Eingriffe vorsieht, so ist einiges davon schon heute realisiert. Die Optimierung des menschlichen Körpers durch Medizin und Technologie ist ja nichts Neues. Hilfsmittel zur Milderung/Behebung körperlicher Einschränkungen wie z. B. die Brille gibt es seit Jahrhunderten, Arm- und Beinprothesen reichen in die vorchristliche Zeit zurück.

Neben äußerlich angebrachten Prothesen finden sich im menschlichen Körper zunehmend diverse Ersatzteile - Implantate genannte Endoprothesen - und auch Chips:

Hüft- und Knieprothesen sind besonders bei älteren Personen häufig anzutreffen, künstliche Linsen und Netzhautimplantate geben die Sehkraft zurück, Cochleaimplantate können das Hörvermögen wieder herstellen, Zahnimplantaten ermöglichen wieder fest zubeißen zu können. Herzklappen können durch künstliche Klappen, beschädigte Gefäße durch Kunststoff- und Knorpelgewebe-prothesen ersetzt werden, Herzschrittmacher regen den Herzmuskel zur Kontraktion an, Hirnschrittmacher stimulieren bestimmte Hirnareale und werden u.a. bei Parkinson-Kranken angewandt. Dazu kommen Implantate in der plastischen Chirurgie, wie sie nach Unfällen aber auch für kosmetische Zwecke eingesetzt werden. Implantiert werden auch Depots von Arzneimitteln, die dann den Wirkstoff kontinuierlich über lange Zeit abgeben.

Transplantationen von Organen sind heute an der Tagesordnung. Aus Mangel an Spenderorganen arbeiten Forscher weltweit daran Organe wie Herz und Leber aus Stammzellen eines Patienten zu züchten (und auch im 3D-Drucker aufzubauen). Für Hauttransplantate funktioniert dies bereits seit längerer Zeit.

Ohne weiter darauf einzugehen: durch Genmanipulation und Genselektion wird ein Großteil der Krankheiten und auch Alterungsprozesse verhindert werden können; gentechnische Eingriffe (wenn auch noch nicht in die Keimbahn) sind bereits Realität geworden.

Schon lange Realität sind künstliche Befruchtung, Präimplantationsdiagnostik, Geschlechtsumwandlungen, etc. Mit Hilfe von Arzneimitteln können Gedächtnisleistungen und Lernvorgänge verbessert werden, kognitive Störungen gemildert.

Bereits eingesetzt werden direkte Gehirn-Computer- und Gehirn-Maschine-Schnittstellen. Körperlich behinderte Menschen können so durch Gedanken Geräte steuern und Prothesen bewegen. Einen Schritt weiter geht der Unternehmer Elon Musk (CEO von Tesla, Gründung/Beteiligung u.a. bei PayPal, dem privaten Raumfahrtsunternehmen SpaceX und SolarCity): er hat das Unternehmen Neuralink gegründet, das daran arbeitet Gehirnwellen direkt mit Künstlicher Intelligenz zu verbinden.

Chips, wie sie üblicherweise zur Identifizierung von Haustieren implantiert werden, stehen wegen Sicherheitsrisiken und möglichen Nebenwirkungen bei Anwendung am Menschen unter heftiger Kritik. Auf der positiven Seite stehen Nano-Chips, welche die Körperfunktionen überwachen und rechtzeitig Alarm schlagen, um Therapien zu ermöglichen. Der erste CHIP (RFID-Transponder) wurde übrigens bereits 2002 von der US-amerikanischen Food and Drug Administration (FDA) zugelassen. Unter die Haut am Arm implantiert kann dieser beispielsweise den Zutritt zu Räumen ermöglichen.

Einige der aufgezählten Anwendungen sind in Abbildung 2 zusammengefasst.

Abbildung 2. Neurotechnologien der Rehabilitierung, die auch zum "Enhancement" typischer menschlicher Fähigkeiten nützlich sein können. (Das Bild stammt aus: EP Zehr: The Potential Transformation of Our Species by Neural Enhancement. J Motor Behavior, (2015). 47, 73 -78.und steht unter einer cc-by-nc - Lizenz).

Abbildung 2. Neurotechnologien der Rehabilitierung, die auch zum "Enhancement" typischer menschlicher Fähigkeiten nützlich sein können. (Das Bild stammt aus: EP Zehr: The Potential Transformation of Our Species by Neural Enhancement. J Motor Behavior, (2015). 47, 73 -78.und steht unter einer cc-by-nc - Lizenz).

Viele Menschen könnten also auch als Cyborgs bezeichnet werden.

Cyborg nennt sich zumindest der von Geburt an farbenblinde Brite Neil Harbisson, der durch Auftritte in Talk-Shows populär geworden ist. Er zeigt sich dort mit einer am Kopf befestigten Antenne samt Farbsensor, der über einen implantierten Chip Farben aber auch Bilder in Töne umwandelt; damit erweitert er auch die naturgegebene menschliche Wahrnehmung.

Die Verschmelzung von Mensch und Technik ist also bereits voll im Gang. Technologien dienen nicht mehr nur behinderten und/oder kranken Menschen, sie erweitern auch die Fähigkeiten gesunder Menschen. Wir sind also bereits auf dem Weg in eine transhumanistische Gesellschaft.

Was ist machbar?

Vieles, was vor kurzem noch als reine Utopie gegolten hat, ist heute bereits realisiert worden oder in den Bereich des Realisierbaren gerückt. Wenn von der zunehmenden Verschmelzung Mensch-Maschine, Gehirn-Maschine die Rede ist, so sehen wir diese in vielen Aspekten bereits in Gang gebracht.

Die eingangs dargelegten Ziele des Human Enhancement - Erreichen einer höchstmöglichen Intelligenz, einer höchstmöglichen Lebensdauer und eines größtmöglichen Wohlbefindens - werden als realisierbar angesehen, lassen aber viele Fragen offen. Der Mensch als hochkomplexes, dynamisches System ist ja noch kaum verstanden.

Wie werden sich welche Eingriffe auf den Einzelnen, auf die Gesellschaft langfristig auswirken, welche Rückkopplungen können entstehen? Werden mehrere Klassen von Menschen entstehen - unverändert gebliebene, partiell veränderte und stark veränderte, die den anderen dann in allen Belangen haushoch überlegen sind?

Zu diesen Fragestellungen wird weltweit intensiv geforscht, als essentiell betrachtet man dabei die interdisziplinäre Zusammenarbeit, das Zusammenwachsen der neuen Disziplinen Nanotechnologie (Grundlage für alle Techniken auf der atomaren und molekularen Ebene), Biotechnologie (inklusive Gentechnik), Informationstechnologie (mit Elektronik, Robotik, Künstlicher Intelligenz) und Neurowissenschaften (mit dem Endziel des vollen Verstehens der Gehirnfunktion). In die Forschung dieser sogenannten Converging Technologies investieren die USA mehrere Milliarden Dollar auch in Europa erhalten sie milliardenschwere Förderung.

Ist Lebensverlängerung über ein physiologisch determiniertes Limit hinaus möglich?

Auch ein höchstmöglich optimierter Organismus ist den fehlerbehafteten biochemischen Prozessen in seinen Zellen und auch Schadstoffen aus der Umwelt ausgesetzt, die zu Mutationen im Erbmaterial, zu defekten Proteinen, zu gestörten Signalfunktionen, geschädigten Organellen, Zellen und Organen führen. Alle diese Prozesse unterbinden zu wollen, erscheint auch aus dem heutigen physiologisch, biochemischen Wissen kaum machbar.

Ist die kryonische "Zwischenlösung" machbar?

Ist das Vitrifizieren und Wiedererwecken toter Körper mit allen ihren früheren Funktionen machbar?

Was für einzelne intakte Zellen - wie Ei - und Samenzellen - und auch für den früher erwähnten Fadenwurm gilt, der im Besitz seiner Erinnerung erweckt wurde, ist zumindest in naher Zukunft wohl kaum auf den Vielzellenorganismus des Menschen übertragbar. Insbesondere nicht auf die Funktionsfähigkeit des ungemein komplexen Gehirns, mit der ungeheuren Zahl gealterter - da kaum erneuerbarer - Neuronen, die infolge der Vitrifizierung (zur Vermeidung von Kristallbildung) toxischen Kälteschutzmitteln ausgesetzt werden.

Mind Uploading

Einige Transhumanisten träumen davon den mentalen Inhalt des Gehirns auf ein externes Medium zu übertragen - das Mind Uploading -, das dann "ewig" weiterbestehen kann.

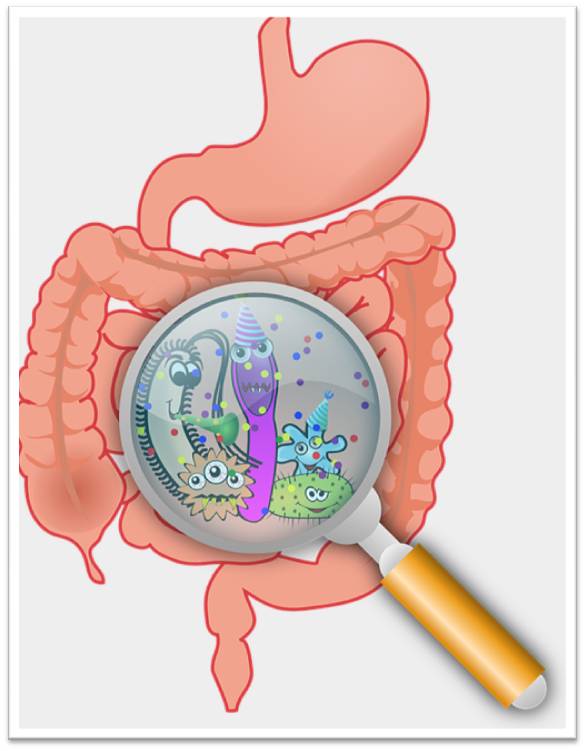

Auch, wenn Mammutprojekte wie das Europäische Human Brain Project die Funktionsweise des Gehirns aufklären und mit Hilfe von Modellen das gesamte Hirn simulieren wollen, so reicht das nicht als Basis für den Upload. Die ungeheure Komplexität unserer Denkfabrik resultiert ja nicht nur aus der Architektur und Vernetzung der Nervenzellen (inklusive Wechselwirkungen mit Glia- und anderen Zellen), sondern auch aus der Dynamik mit der elektrische und chemische Signale erzeugt und weitergeleitet werden. Zu den Inhalten des Gehirns gehören auch die Informationen, die es aus Rückenmark und peripherem Nervensystem erhält und schließlich auch die Signale, die unsere Mitbewohner - das Mikrobiom - in das Hirn senden.

Dies alles quantitativ in seiner Dynamik zu erfassen und modellieren zu wollen, erscheint - auch bei weiterhin exponentiell zunehmender Rechnerleistung - ein vielleicht in sehr ferner Zukunft diskutierbares Vorhaben.

[1] Transhumanist Declaration. https://humanityplus.org/philosophy/transhumanist-declaration/ abgerufen am 13.9.2019

[2] Huxley Julian, New Bottles for New Wine, Chatto & Windus, London (1957) https://archive.org/details/NewBottlesForNewWine/page 17 abgerufen am 16.9.2019

[3 ] More Max und Vita-More Natasha (eds),The Transhumanist Reader: Classical and Contemporary Essays on the Science, Technology, and Philosophy of the Human Future. John Wiley & Sons. (2013). https://books.google.at/books?id=YeFo_20rfz0C&dq=Daedalus%3B+or,+Science+and&hl=de&source=gbs_navlinks_s

*Dies ist die verkürzte Version des Artikels "Transhumanismus – Selbstgesteuerte Evolution des Menschen", der eben in Imago Hominis 26 (3) 131 – 140 · ISSN 1021-9803 erschienen ist. https://www.imabe.org/index.php?id=2662

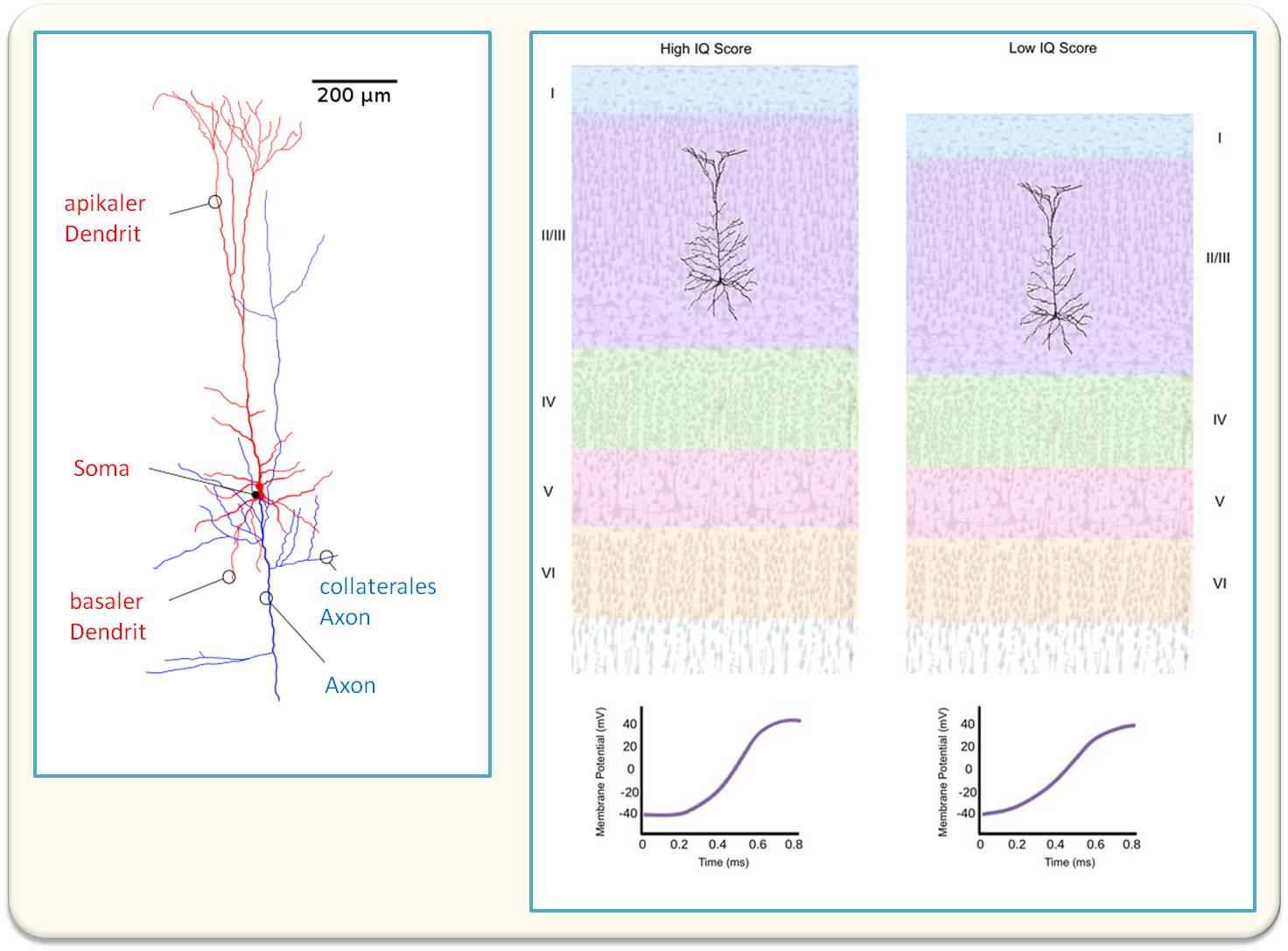

Die Großhirnrinde verarbeitet Information anders als künstliche intelligente Systeme

Die Großhirnrinde verarbeitet Information anders als künstliche intelligente SystemeDo, 05.12.2019 — Wolf Singer

Bereits heute übertreffen künstliche intelligente Systeme in einigen Bereichen die Leistungen des menschlichen Gehirns. In natürlichen Systemen, vor allem in der Großhirnrinde, sind jedoch Verarbeitungsstrategien verwirklicht, die sich in wesentlichen Aspekten von denen künstlicher Systeme unterscheiden. Ein besseres Verständnis natürlicher intelligenter Systeme kann zur Aufklärung der Ursachen von krankheitsbedingten Störungen beitragen und zudem die Konzeption wesentlich effizienterer künstlicher Systeme erlauben. Diese natürlichen intelligenten Systeme besser zu verstehen ist das zentrale Anliegen eines der renommiertesten Hirnforscher Prof. Dr.Dr.hc.mult Wolf Singer (Max-Planck-Institut für Hirnforschung und Ernst Strüngmann Institut für Neurowissenschaften, Frankfurt)*

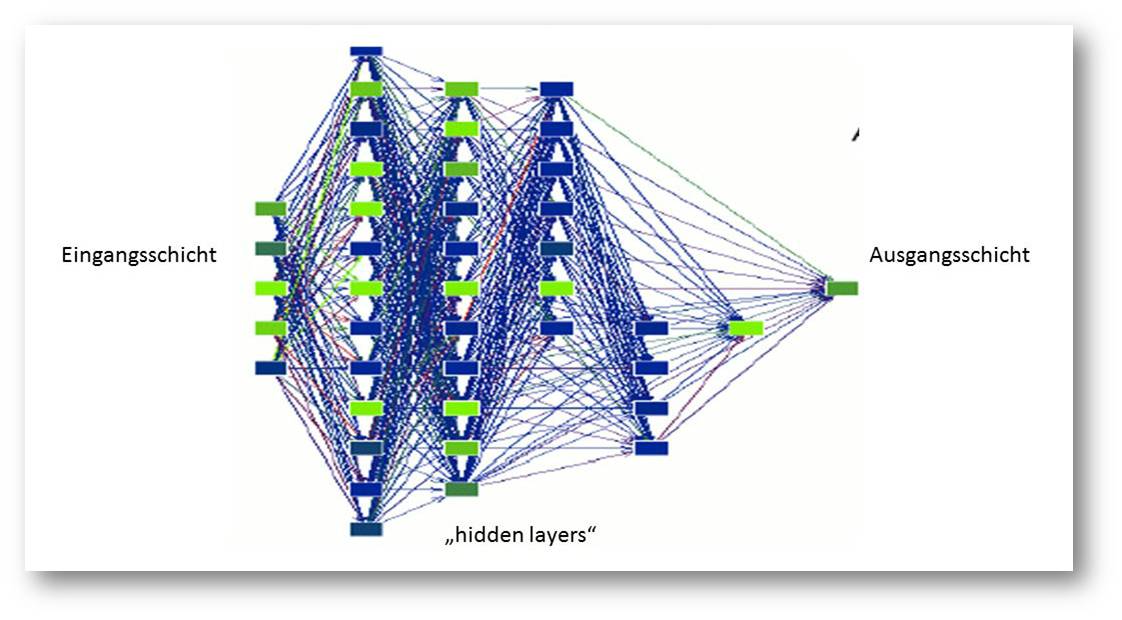

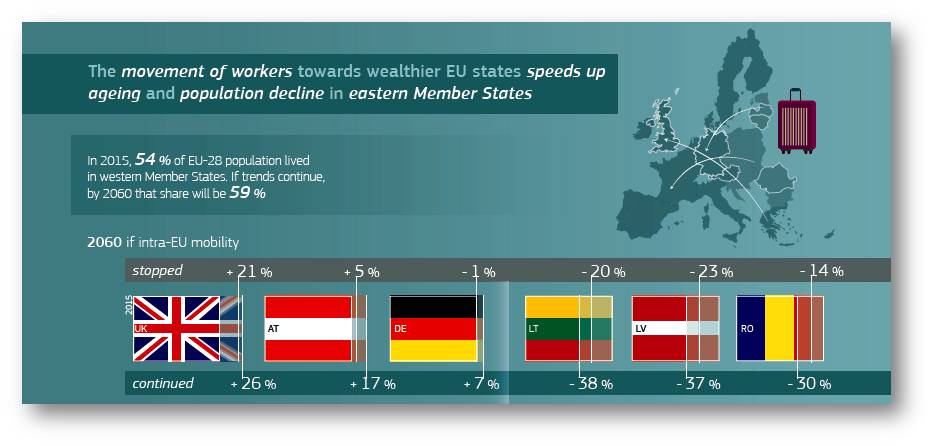

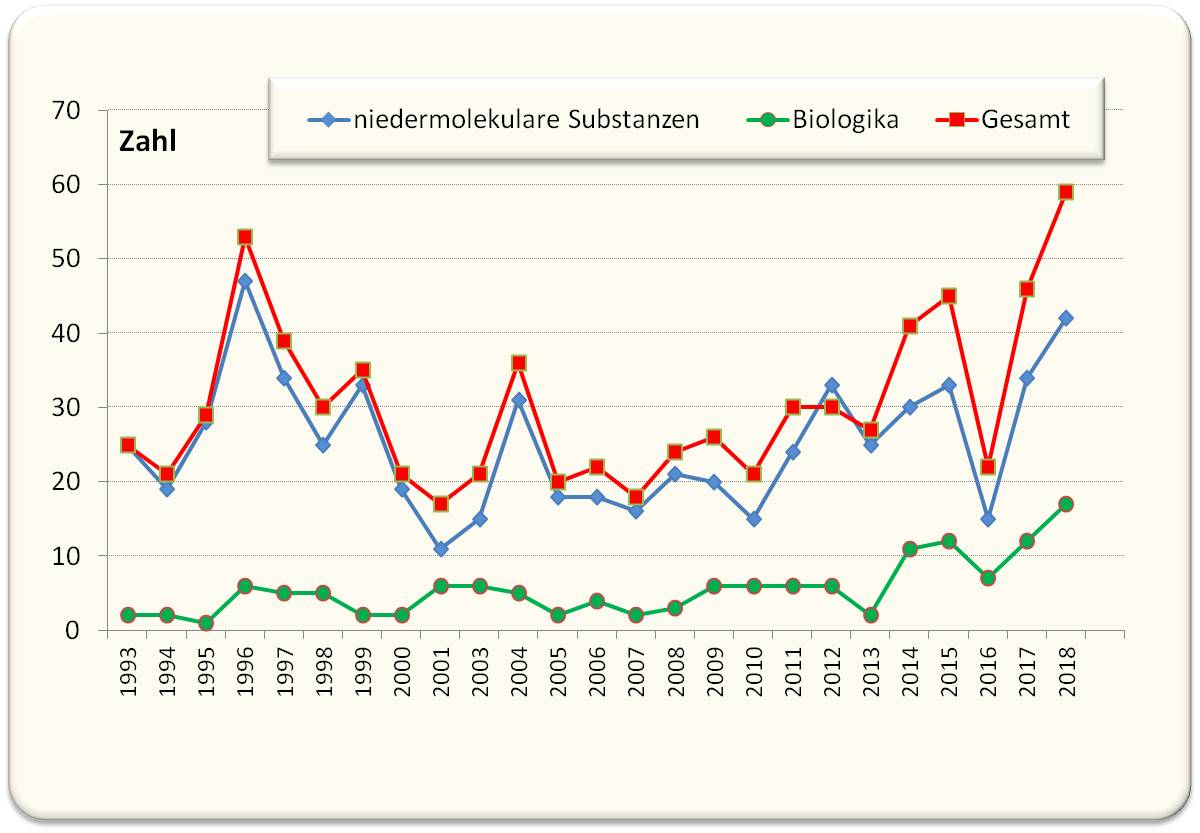

Bereits heute übertreffen in manchen Bereichen die Leistungen künstlicher intelligenter (KI-) Systeme die von biologischen Systemen. Viele der effizientesten KI-Algorithmen orientieren sich an neuronalen Systemen, doch die Hirnforschung liefert Hinweise dafür, dass in natürlichen Systemen, vor allem in der Großhirnrinde, zusätzliche Verarbeitungsstrategien Anwendung finden, die sich von denen derzeitiger KI-Systeme grundlegend unterscheiden. Die meisten KI-Systeme beruhen auf den in den achtziger Jahren des letzten Jahrhunderts eingeführten „neuronalen Netzen“. Deren Architektur ist in Abbildung 1 skizziert.

Abbildung 1. Architektur eines „deep learning networks“: Die Knoten dieser Netze bestehen aus Schaltelementen, die gewisse Merkmale von Nervenzellen aufweisen - sie summieren die Aktivität der Eingangsverbindungen und geben das Ergebnis an die Knoten nachfolgender Verarbeitungsschichten weiter. © Ernst-Strüngmann-Institut/Singer

Abbildung 1. Architektur eines „deep learning networks“: Die Knoten dieser Netze bestehen aus Schaltelementen, die gewisse Merkmale von Nervenzellen aufweisen - sie summieren die Aktivität der Eingangsverbindungen und geben das Ergebnis an die Knoten nachfolgender Verarbeitungsschichten weiter. © Ernst-Strüngmann-Institut/Singer

Jeder Knoten der Eingangsschicht ist mit vielen Knoten der nächsthöheren verbunden. Die ersten KI-Systeme umfassten nur drei Schichten: eine Eingangsschicht, eine mittlere Schicht („hidden layer“ genannt), deren Aktivität nicht direkt zugänglich sein muss, und eine Ausgangsschicht, die die Aktivitätsverteilung der mittleren Schicht ausliest. Heute sind die leistungsstärksten Netze bis zu hundert Schichten tief. Die besondere Schwierigkeit besteht darin, die Gewichtung der Verbindungen über Millionen von Lernschritten so einzustellen, dass jedes der zu unterscheidenden Eingangsmuster in der Ausgangsschicht zu einem leicht klassifizierbaren Erregungsmuster führt.

Damit solche Netzwerke z. B. zur Mustererkennung eingesetzt werden können, muss man dafür sorgen, dass ein bestimmtes Erregungsmuster der Eingangsschicht zur bevorzugten Erregung eines ganz bestimmten Knotens der Ausgangsschicht führt. Hierzu werden an der Eingangsschicht viele Muster erzeugt und es wird versucht, die Effizienz der Verbindungen zwischen den Schichten durch wiederholte Justierung schrittweise zu verbessern. Je nach Anzahl der zu unterscheidenden Muster und deren Ähnlichkeit kann dies viele Millionen von Justierungs- bzw. Lernschritten erfordern. Hierbei werden die Verbindungen ermittelt, deren Aktivität zu dem gewünschten Ergebnis beiträgt. Diese werden dann verstärkt und die anderen abgeschwächt. Es wird also die Abweichung vom gewünschten Ergebnis, der Fehler, in das Netzwerk zurückgemeldet. Dieser Prozess (back propagation genannt) ist extrem aufwändig und hat in biologischen Systemen keine Entsprechung.

Heutige künstliche Systeme beruhen auf dem gleichen Grundprinzip, umfassen jedoch bis zu 100 Schichten und werden deshalb als „deep learning networks“ bezeichnet. Beherrschbar ist diese riesige Zahl von Verbindungen zwischen den Schichten dank ausgeklügelter Algorithmen, welche die Justierung vornehmen, und dank riesiger Rechenkapazitäten und Datenbanken, die es erlauben, die Systeme mit Millionen von Beispielen zu trainieren.

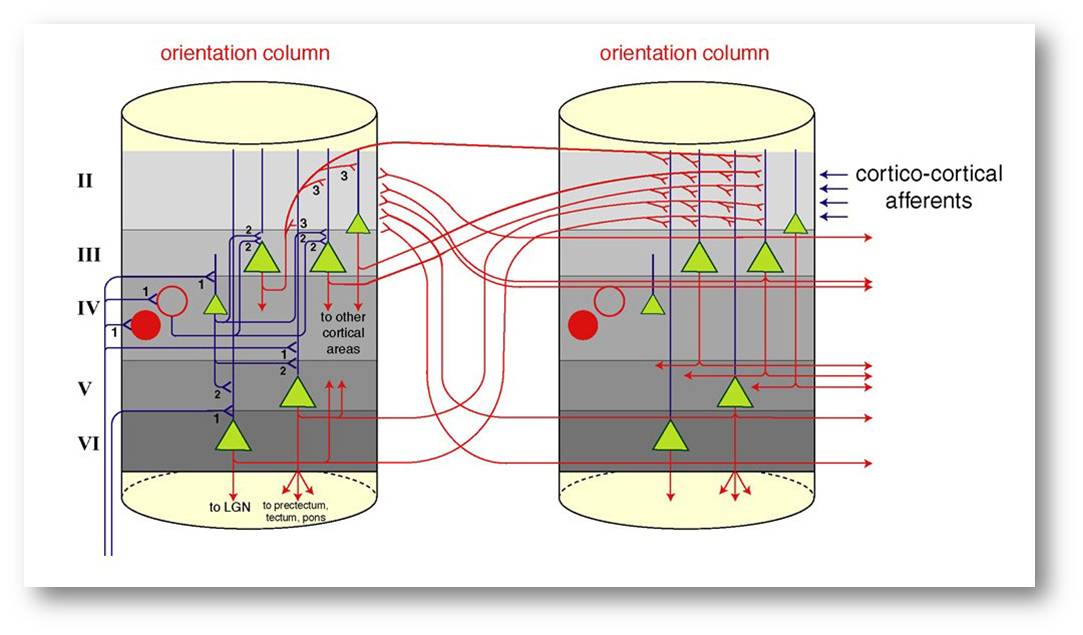

In natürlichen Systemen sind Netzwerkknoten innerhalb einer Schicht und zwischen den Schichten reziprok miteinander verbunden

Charakteristisch für diese künstlichen Netze ist, dass es keine Verbindungen zwischen den Knoten innerhalb der gleichen Schichten gibt und der Aktivitätsfluss stets nur von den niederen zu den hohen Schichten erfolgt. Wie jedoch Abbildung 2 zeigt, unterscheiden sich künstliche Systeme von den natürlichen in genau diesen Aspekten: Die Knoten einer Schicht stehen über Myriaden von Verbindungen miteinander in Wechselwirkung und der Aktivitätsfluss zwischen den Schichten erfolgt in beiden Richtungen.

Abbildung 2. Stark vereinfachtes Diagramm der Verschaltung von Nervenzellen in der Großhirnrinde. Hier bestehen die Knoten des Netzwerkes aus Modulen von bereits sehr komplexen Schaltkreisen. Diese sind ihrerseits über Myriaden von rekurrierenden Verbindungen (rot) untereinander und über Rückkopplungsschleifen mit den Knoten der vorherigen Schicht gekoppelt. Somit erfolgt der Aktivitätsfluss sowohl horizontal wie vertikal in beiden Richtungen. © Ernst-Strüngmann-Institut/Singer

Abbildung 2. Stark vereinfachtes Diagramm der Verschaltung von Nervenzellen in der Großhirnrinde. Hier bestehen die Knoten des Netzwerkes aus Modulen von bereits sehr komplexen Schaltkreisen. Diese sind ihrerseits über Myriaden von rekurrierenden Verbindungen (rot) untereinander und über Rückkopplungsschleifen mit den Knoten der vorherigen Schicht gekoppelt. Somit erfolgt der Aktivitätsfluss sowohl horizontal wie vertikal in beiden Richtungen. © Ernst-Strüngmann-Institut/Singer

In biologischen Systemen wird die Effizienz der Verbindungen nach lokalen Regeln justiert. Nervenzellen dienen als Knoten, die viel mehr leisten, als Eingangsaktivitäten zu summieren. Ihre integrativen Eigenschaften werden durch komplizierte hemmende Schaltkreise und zudem durch eine Vielzahl modulierender Eingänge abhängig von der jeweiligen Aufgabenstellung verändert. Auch können die Knoten oszillieren und sich wegen der wechselseitigen Koppelungen in unterschiedlichen Frequenzbereichen synchronisieren. Auf Grund dieser Eigenschaften entwickeln die Neuronen-Netze der Großhirnrinde eine hochkomplexe, nicht-lineare Dynamik, die es erlaubt, sehr hochdimensionale Zustandsräume zu erschließen.

Mit diesen Eigenschaften natürlicher Neuronen-Netze können Rechenoperationen verwirklicht werden, die in bisherigen KI-Systemen nur mit sehr großem Aufwand zu realisieren sind: zeitlich aufeinander folgende Ereignisse lassen sich problemlos miteinander verrechnen, Bezüge zwischen bestimmten Mustermerkmalen können sehr flexibel kodiert werden und wegen der hohen Dimensionalität der Netzwerkdynamik kann mit relativ geringem Aufwand eine sehr große Menge an Information gespeichert werden. Auf diese Weise kann über die aktivitätsabhängige Justierung der Effizienz der reziproken Verbindungen eine riesige Menge von Informationen gespeichert und dasselbe Netzwerk dann zur Interpretation von Sinnessignalen verwendet werden.

Um unser Konzept zu überprüfen, müssen wir die Aktivität einer möglichst großen Zahl von Netzwerkknoten erfassen, Kenngrößen für deren dynamische Wechselwirkungen berechnen und bestimmen, wie diese sich verhalten, wenn gespeichertes „Vorwissen“ mit der jeweils verfügbaren Sinnesinformation verglichen wird. Wir nehmen diese Messungen an nicht-menschlichen Primaten vor, die gelernt haben, visuelle Muster zu unterscheiden, zu erinnern und uns durch Tastendruck das Ergebnis mitzuteilen – ähnlich wie Computerspieler. Während die Tiere die Aufgaben erledigen, erfassen wir mit dauerhaft implantierten Elektroden die Aktivität von Neuronen der Sehrinde. Die Implantation erfolgt in Vollnarkose und läuft genau wie die Implantation von Elektroden bei menschlichen Patienten ab. Die Messungen selbst sind für die Tiere nur wenig belastend und können in der Regel über viele Jahre hinweg ohne weitere Eingriffe vorgenommen werden.

Ausblick

Wir erhoffen uns von diesen Arbeiten ein tieferes Verständnis der neuronalen Prozesse, die unseren kognitiven und exekutiven Leistungen zu Grunde liegen. Unsere Überzeugung ist, dass diese Erkenntnisse den Schlüssel für das Verständnis der Ursachen gestörter neurologischer und psychischer Funktionen und für zukünftige therapeutische Ansätze bergen. Um hier Fortschritte zu erzielen, bedarf es jedoch noch erheblicher Anstrengungen in der Grundlagenforschung. Auch ist zu erwarten, dass ein tieferes Verständnis der Großhirnrindenfunktion dazu beitragen wird, energieeffizientere und flexiblere KI-Systeme zu entwickeln. Hierfür sind jedoch neue Technologien erforderlich. Es genügt nicht, neuronale Prozesse mit gewaltigem Aufwand digital zu simulieren. Sie müssen direkt in geeigneten Hardware-Modulen implementiert werden, die auch analoge Rechenvorgänge verlässlich bewältigen können.

*Der unter dem Titel "Informationsverarbeitung in der Großhirnrinde" im Jahrbuch der Max-Planck Gesellschaft 2018 erschienene Artikel (https://www.mpg.de/12587759/esi-frankfurt_jb_2018?c=917421 DOI 10.17617/1.7M ) wurde mit freundlicher Zustimmung des Autors und der MPG-Pressestelle ScienceBlog.at zur Verfügung gestellt. Er erscheint hier ungekürzt aber ohne Literaturzitate, die im Original nachgesehen werden können

Weiterführende Links

- Interview mit Wolf Singer - Physik und Biologie wachsen zusammen. HyperraumTV, (24.10.2016) Video 15:30 min.

- AIL-Talk: Wolf Singer - Neuronale Grundlagen des Bewusstseins. Video 1:29:27 from Angewandte Innovation Lab. 07.09.2016

Artikel im ScienceBlog

- Wolf Singer, 16.12.2016: Die Großhirnrinde, ein hochdimensionales, dynamisches System.

Wenn das angepeilte Target nicht das tatsächliche Target ist - ein Grund für das klinische Scheitern von Wirkstoffen gegen Krebs

Wenn das angepeilte Target nicht das tatsächliche Target ist - ein Grund für das klinische Scheitern von Wirkstoffen gegen KrebsDo, 28.11.2019 — Ricki Lewis

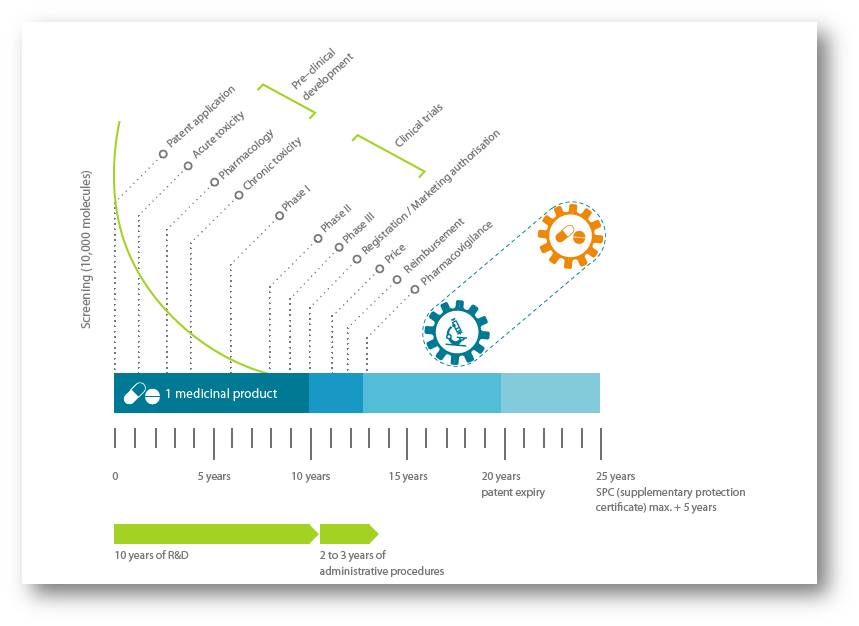

![]() Der Entwicklung neuer Arzneimittel geht die Suche nach Zielstrukturen - Targets - voraus, die essentiell in das Krankheitsgeschehen involviert sind und gegen die dann Wirkstoffe designt werden können. Der allergrößte Teil der solcherart gegen Krebserkrankungen entwickelten Stoffe scheitert aber in der klinischen Prüfung, wobei mangelnde Wirksamkeit einer der Hauptgründe ist. Unter Anwendung der CRISPR-Cas Technologie deckt eine neue Studie an einer Reihe von klinischen Entwicklungssubstanzen nun auf, dass deren postulierte Targets und damit die Wirkungsmechanismen unrichtig sind und eine bereits in der Präklinik erfolgende Validierung der echten Targets die Zahl unwirksamer klinischer Studien reduzieren könnte. Die Genetikerin Ricki Lewis berichtet über diese Studie.*

Der Entwicklung neuer Arzneimittel geht die Suche nach Zielstrukturen - Targets - voraus, die essentiell in das Krankheitsgeschehen involviert sind und gegen die dann Wirkstoffe designt werden können. Der allergrößte Teil der solcherart gegen Krebserkrankungen entwickelten Stoffe scheitert aber in der klinischen Prüfung, wobei mangelnde Wirksamkeit einer der Hauptgründe ist. Unter Anwendung der CRISPR-Cas Technologie deckt eine neue Studie an einer Reihe von klinischen Entwicklungssubstanzen nun auf, dass deren postulierte Targets und damit die Wirkungsmechanismen unrichtig sind und eine bereits in der Präklinik erfolgende Validierung der echten Targets die Zahl unwirksamer klinischer Studien reduzieren könnte. Die Genetikerin Ricki Lewis berichtet über diese Studie.*

Siebenundneunzig Prozent der potenziellen neuen Krebsmedikamente erreichen nie den Markt; sie fallen in den klinischen Studien durch, wenn sie die Kriterien für Sicherheit oder Wirksamkeit nicht erfüllen.

"Wir haben keine Ahnung, warum das so ist. Die extrem hohe Ausfallsrate deutet aber meiner Meinung darauf hin, dass einige grundlegende Probleme in der Art und Weise bestehen, wie neue Zielstrukturen (Targets) für Wirkstoffe untersucht und neue Wirkstoffe charakterisiert werden “, meinte der Molekularbiologe Jason Sheltzer (Fellow am Cold Spring Harbor Laboratory, Long Island, NY) und beschloss diesbezüglich Untersuchungen anzustellen.

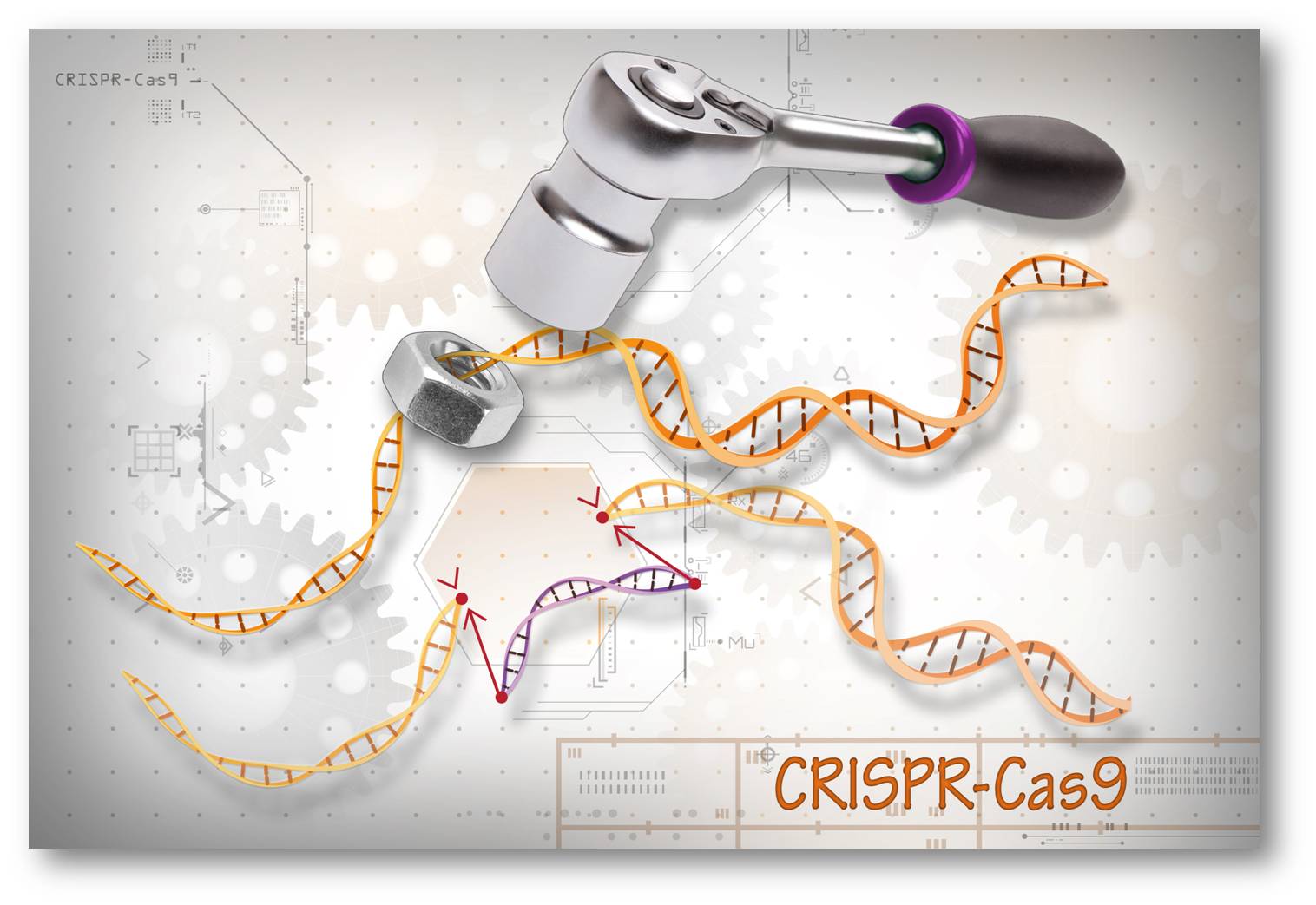

CRISPR - ein präzises Instrument

In der Zeitschrift Science Translational Medicine vom September 2019 berichten Sheltzer und sein Team, dass man die "Genschere"( Gen-Editing-Tool) CRISPR-Cas9 eingesetzt habe, um zu prüfen, ob 10 experimentelle Krebsmedikamente genau so wirken, wie ihre Entwickler es angekündigt hatten [1] (Abbildung 1). Und sie fanden, dass die Art und Weise, wie diese Substanzen für Targets gesucht hatten, mit einem Tunnelblick erfolgt war, was erklären könnte, warum bestimmte Patienten nicht so wie erhofft reagieren.

Wie ein Pfeil, der in einem Baum landet anstatt im Zentrum der Schießscheibe, können manche Krebsmedikamente ihre Targets tatsächlich nicht erreichen- allerdings waren viele Studien nicht dazu angelegt dies aufzudecken. Sehen Ergebnisse erfolgversprechend aus, so durchläuft die Entwicklungsverbindung das Labyrinth bis zur FDA-Zulassung.

Abbildung 1. Die CRISPR-Cas Technologie führt gezielt Doppelstrangbrüche in der DNA ein und ermöglicht ein präzises Manipulieren - Löschen, Korrigieren oder Ersetzen - von Genen in jeder Zelle.

Abbildung 1. Die CRISPR-Cas Technologie führt gezielt Doppelstrangbrüche in der DNA ein und ermöglicht ein präzises Manipulieren - Löschen, Korrigieren oder Ersetzen - von Genen in jeder Zelle.

Die Strategie von Sheltzer war einfach: Man wendet CRISPR an, um das Target der Wahl zu entfernen. Falls das Medikament dann immer noch wirkt, ist dieses Target nicht das wirkliche Target. Die Forscher testeten Wirkstoffe, die sich in klinischen Studien befinden oder einst befunden haben oder in präklinischen Studien (an Tieren oder menschlichen Zellen) - jedoch keine Krebsmedikamente, die derzeit auf dem Markt sind. Die Experimente wurden an von Krebspatienten stammenden Standardzelllinien durchgeführt.

„Das Konzept bei vielen dieser Wirkstoffe ist, dass sie die Funktion eines bestimmten Proteins in Krebszellen blockieren. Wir konnten allerdings zeigen, dass die meisten dieser Medikamente nicht dadurch wirken,dass sie die Funktion des als Target angegebenen Proteins blockieren“, erklärte Sheltzer.

Mit Hilfe von CRISPR wird eine genauere Bestimmung potenzieller Wirkstofftargets möglich als mit der älteren Methode, der RNA-Interferenz (RNAi). RNAi unterbindet die Genexpression, anstatt wie CRISPR ein Gen auszuschneiden.

Könnte ein kleines Molekül an mehr als eine Art von Targets binden, so wie wenn man Pfeile losschießt, die auf Bäume, Büsche und auch in das Zentrum der Schießscheibe treffen? Was in vitro ein validiertes Target für einen Wirkstoff darstellt, ist manchmal nicht gerade das, was in einem Körper passiert.

Allerdings kann ein Medikament zugelassen werden, ohne dass irgendjemand genau weiß, wie es wirkt. Dies trifft auf Antidepressiva zu, welche die Wiederaufnahme von Serotonin selektiv hemmen (SSRI). Bilder in Inseraten zeigen neuromuskuläre Synapsen, in denen das Medikament an die Wiederaufnahmeproteine bindet und so Serotonin länger verfügbar in Synapsen hält und damit vermutlich ein die Symptomatik auslösendes Defizit ausgleicht. Googelt man aber nach SSRI, so erhält man die Antwort: "der genaue Wirkungsmechanismus von SSRIs ist nicht bekannt".

Vom "Brandroden" zum Treffen von Targets

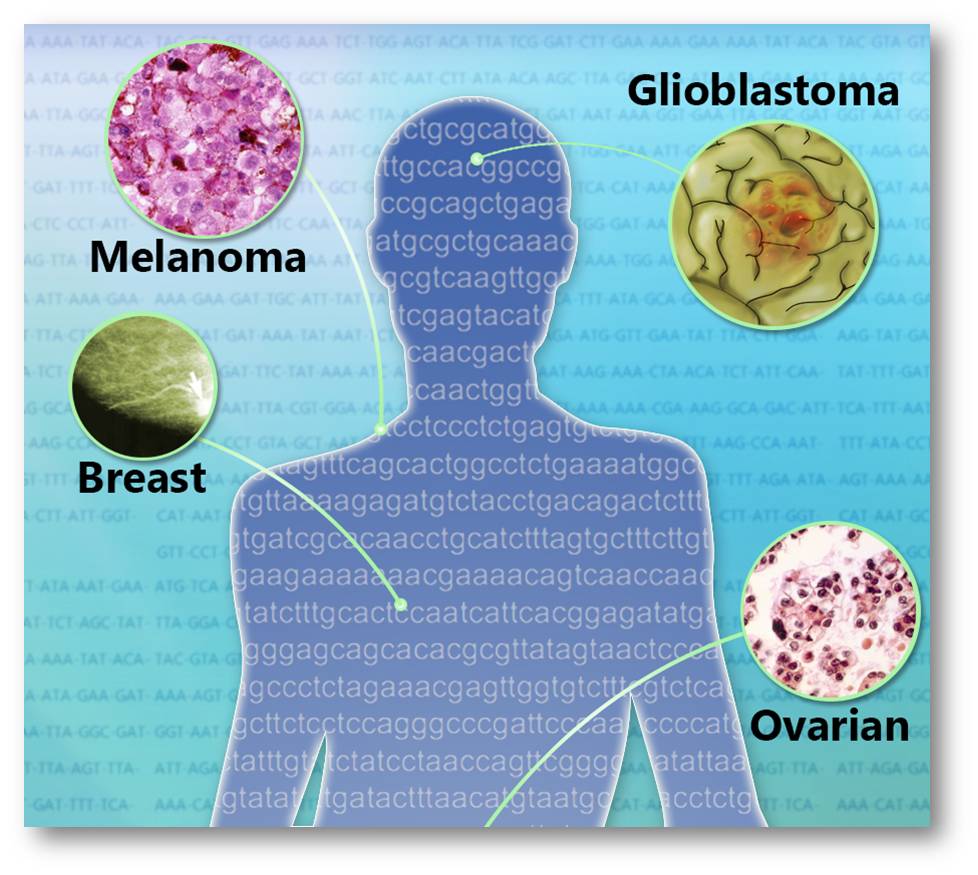

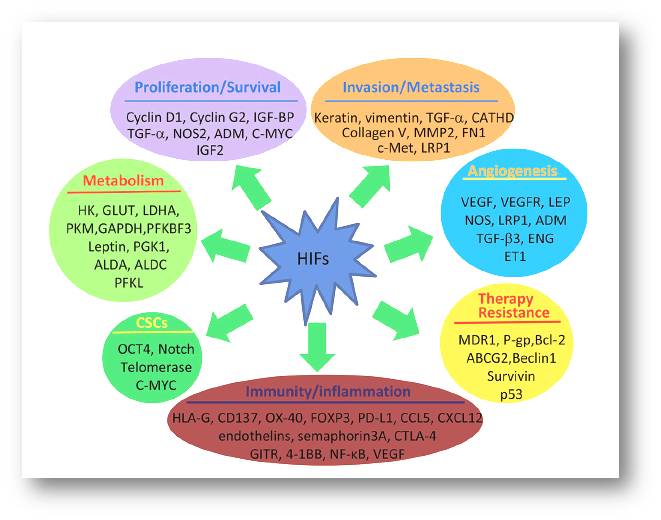

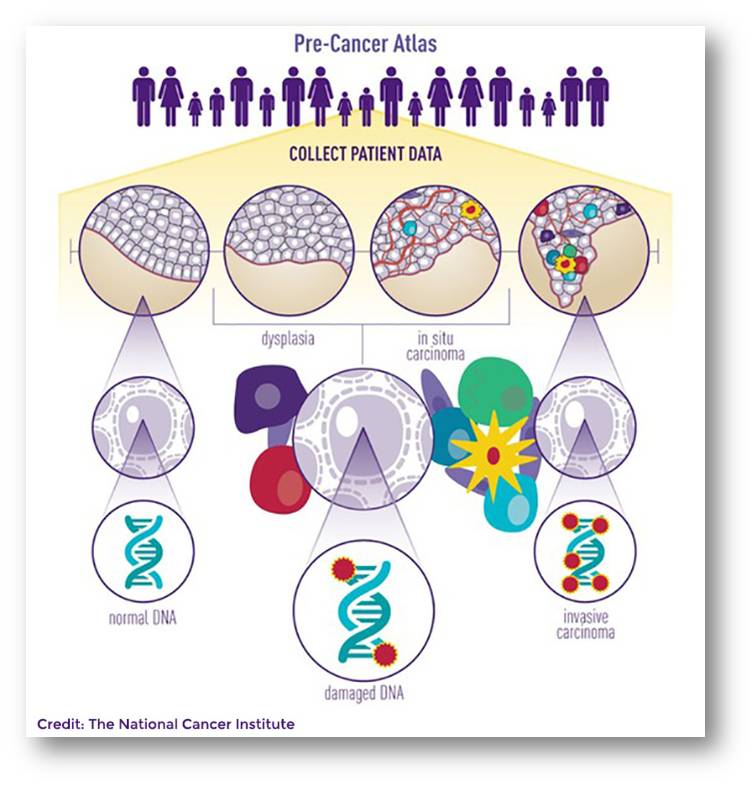

Einige der neuen Krebsmedikamente zielen auf Moleküle ab, die für Krebszellen spezifisch sind (Abbildung 2) Unter diesen finden sich:

- Rezeptoren von Wachstumsfaktoren oder Hormonen

- Enzyme, die in der Zellteilung eine entscheidende Rolle spielen - wie Cycline und Kinasen

- Immun-Checkpoint-Hemmer, welche die von Krebszellen verursachte Unterdrückung der Immunantwort aufheben.

Abbildung 2. Medikamente, die zielgerichtet ihr Target treffen.

Abbildung 2. Medikamente, die zielgerichtet ihr Target treffen.

Diese zielgerichteten Medikamente bieten eine Alternative oder Ergänzung zu herkömmlichen Medikamenten, die nicht nur die Krebszellen zerstören sondern ganz allgemein viele Typen von sich schnell teilenden Zellen.

Den Anfang der auf Targets abzielenden Medikamente hat 1998 Herceptin gemacht; seine Erfinder wurden kürzlich mit dem Lasker-Preis geehrt. Ein weiteres ungemein erfolgreiches Krebsmedikament, Gleevec, wurde 2001 in nur wenigen Monaten nach der Einreichung von der FDA zugelassen. Heute wird in Inseraten salbungsvoll das neue Arsenal an Krebstherapien vorgestellt: Zelboraf, Tafinlar, Keytruda, Opdivo.

Auf ein Target zugeschnittene Medikamente können allerdings versagen, wenn eine neue Mutation das Target verändert oder wenn Krebszellen einen alternativen Weg finden, der die Zellteilungsrate erhöht.

Zurück zum Sheltzer-Experiment

Die Forscher verfolgten einen zweifachen experimentellen Ansatz basierend auf den Überlegungen:

- Man entfernt das Target (beispielsweise ein Protein an der Zelloberfläche) in Krebszellen. Wenn sich die Zellen dennoch weiter teilen, war das Target nicht essentiell.

- Man fügt Krebszellen, in denen das Target entfernt worden war, den Wirkstoff zu. Wenn die Zellen trotzdem sterben, dann trifft die Substanz irgendetwas anderes.

Das erste getestete Medikament

Bereits früher hatte Sheltzer ein Protein namens MELK (“maternal embryonic leucine zipper kinase”) untersucht, gegen welches das Unternehmen, OncoTherapy Science, einen Inhibitor mit der Bezeichnung OTS167 entwickelt. Da MELK in vielen Tumorarten reichlich vorkommt, nahm man an, dass es für deren Wachstum essentiell und damit ein Target für Medikamente ist. Als aber nun mit CRISPR das für das MELK-Protein kodierende Gen entfernt wurde, passierte gar nichts.

"Zu unserer großen Überraschung starben die Krebszellen nicht ab, als wir diese Proteine eliminierten, Im Gegensatz zu früheren Veröffentlichungen wuchsen die Krebszellen lustig weiter. MELK war ihnen einfach egal“, sagte Sheltzer.

Die Sheltzer-Gruppe veröffentlichte die Ergebnisse zu MELK im Jahr 2017 [2] und wies dabei auf die Möglichkeit hin, dass OTS167 möglicherweise den falschen Baum anbellt. Die Entwicklungsverbindung befindet sich nun in einer klinischen Phase-1-Studie (Sicherheitsprüfung) für solide Tumoren und rekrutiert Patienten für eine Phase-1-Studie bei dreifachnegativem und metastasiertem Brustkrebs.

Die MELK-Geschichte inspirierte die Gruppe, ihre „Strategie zur genetischen Target-Abklärung“ anzuwenden, um herauszufinden ob 10 weitere Wirkstoffe ihre mutmaßlichen Targets tatsächlich erreichen. In klinischen Studien erhalten insgesamt an die tausend Krebspatienten eines dieser Präparate verabreicht.

Eine andere Fehlannahme führt zur Entdeckung eines neuen Targets

In der erwähnten neuen Veröffentlichung [1] prüften die Forscher einen weiteren Wirkstoff - OTS964 - , der zur Behandlung bestimmter Lungen- und Brustkrebserkrankungen entwickelt wurde. Dabei haben sie ein neues Target für Krebsmedikamente entdeckt. Abbildung 3.

Abbildung 3. Auf Targets abzielende Krebstherapien basieren auf Mutation des Targets und nicht auf seine Lokalisierung in einem Organ (Bild: NHGRI)

Abbildung 3. Auf Targets abzielende Krebstherapien basieren auf Mutation des Targets und nicht auf seine Lokalisierung in einem Organ (Bild: NHGRI)

Versuche mit Interferenz-RNA hatten darauf hingewiesen, dass die Zielstruktur von OTS964 ein Protein namens PBK ist. Aber CRISPR hat dann eine andere Geschichte erzählt- "es stellte sich heraus, dass die Wechselwirkung mit PBK nichts damit zu tun hat, wie der Wirkstoff tatsächlich Krebszellen abtötet", sagte Sheltzer.

Um herauszufinden, wie die auf PBK abzielende Substanz wirkt, versetzten die Forscher die Krebszellen mit einen hohen Überschuss davon und ließen den Zellen dann Zeit Mutationen zu generieren, die es ihnen ermöglichen würden, resistent gegen den Wirkstoff zu werden. Krebsgenome sind von Natur aus instabil und mutieren häufig. Wenn eine Mutation eine Zelle resistent gegen ein Medikament macht, so hat diese Zelle einen Vorteil und beginnt bald den Tumor zu dominieren.

Zu entdecken, wie eine Zelle gegen ein Medikament resistent wird, ist unbezahlbare Information.

Die Resistenz-Experimente haben gezeigt, dass die Verwundbarkeit der Krebszellen durch den Wirkstoffkandidaten OTS964, nicht PBK zuzuschreiben ist, sondern einem Gen, welches für das Protein CDK11 codiert. Dies ist eine sogenannte "Cyclin-abhängige Kinase", ein Enzym, das eine Komponente des Pfades ist, der zur Zellteilung führt.

Beginnend mit Ibrance im Februar 2015 hat die FDA hat bereits Inhibitoren der Cyclin abhängigen Kinase CDK4/6 zugelassen, um bestimmte Formen von Brustkrebs zu behandeln. CDK11 ist ein brandneues und möglicherweise bedeutendes Target.

Was kommt als nächstes?

Auf einer Pressekonferenz sind die Forscher auf Befürchtungen eingegangen, dass sich ihre Ergebnisse auf Menschen auswirken werden, die bereits auf Targets abzielende Krebsmedikamente einnehmen. Ihr Argument war, dass ihre Untersuchungen keine zugelassenen Medikamente betrafen, die auf Bäume statt auf Schießscheiben zielten.

Wie sieht es aber mit laufenden klinischen Studien an Krebswirkstoffen aus?

Sheltzer hat versucht die Leute, welche die Studien durchführen, aufmerksam zu machen. „Ich habe einen FOIA (Freedom of Information Act) bei der FDA eingereicht, um zu versuchen zusätzliche Informationen zur Sicherheit und Wirksamkeit dieser Prüfsubstanzen zu erhalten. Die FDA lehnte es ab, diese Daten weiterzugeben, und sagte, dass diese bis zur Zulassung der Medikamente durch sie geheim bleiben müssten.“

Sheltzer wandte sich auch an die Unternehmen, welche als Sponsoren der klinischen Studien auftraten; auch diese gaben keinerlei Information weiter.

„Ich denke, dass Geheimhaltung und Intransparenz in diesem Abschnitt der Arzneimittelentwicklung den wissenschaftlichen Fortschritt wirklich beeinträchtigen. Viele der an Krebspatienten getesteten Medikamente bringen diesen tragischerweise keine Hilfe. Würde man entsprechende Evidenz routinemäßig sammeln, bevor Entwicklungsprodukte in klinische Studien eintreten, wären wir besser in der Lage den Patienten Therapien zuzuweisen, welche diesen höchstwahrscheinlich einigen Nutzen bringen. Mit derartigem Wissen können wir meines Erachtens das Versprechen einer Präzisionsmedizin besser erfüllen “, sagte Sheltzer.

Die Pharmaunternehmen würden gut daran tun auf Grundlagenforscher mehr zu hören, die herausfinden, wie Dinge funktionieren oder eben nicht funktionieren (wie beispielsweise Shelzer). Die CRISPR-Technologie ermöglicht Forschern "eine verbesserte Suche nach den zentralen Genen im Krebsgeschehen und eine bessere Validierung des Wirkungsmechanismus eines Arzneimittels an seinem Target. Wir glauben, dass eine derartige präklinische Grundlage den Klinikern helfen wird, bessere klinische Studien zu designen, um die Ausfallrate neuer Medikamente zu senken “, schloss Sheltzer.

[1] Ann Lin et al., Off-target toxicity is a common mechanism of action of cancer drugs undergoing clinical trials. Science Translational Medicine (2019): 11, 509, eaaw8412. DOI: 10.1126/scitranslmed.aaw8412

[2] Ann Lin et al., CRISPR/Cas9 mutagenesis invalidates a putative cancer dependency targeted in on-going clinical trials. eLife. 2017; 6: e24179. doi: 10.7554/eLife.24179

* Der Artikel ist erstmals am 24. Oktober 2019 in PLOS Blogs - DNA Science Blog unter dem Titel "When the Target Isn’t Really the Target: One Way Cancer Drugs Fall Out of Clinical Trials " erschienen (https://blogs.plos.org/dnascience/2019/10/24/when-the-target-isnt-really-the-target-one-way-cancer-drugs-fall-out-of-clinical-trials/) und steht unter einer cc-by Lizenz . Die Autorin hat sich freundlicherweise mit der Übersetzung ihrer Artikel durch ScienceBlog.at einverstanden erklärt, welche so genau wie möglich der englischen Fassung folgen.

Weiterführende Links

Gen-editing mit CRISPR/Cas9 Video 3:13 min (deutsch) , Max-Planck Gesellschaft (2016) (Standard-YouTube-Lizenz )

Francis.S.Collins, 02.02.2017: Finden und Ersetzen: Genchirurgie mittels CRISPR/Cas9 erscheint ein aussichtsreicher Weg zur Gentherapie.

Von Erwin Schrödingers "Was ist Leben" zu "Alles Leben ist Chemie"

Von Erwin Schrödingers "Was ist Leben" zu "Alles Leben ist Chemie"Do, 21.11.2019 — Peter Schuster

![]() Als Begründer der Wellenmechanik, die eine mathematische Beschreibung atomarer Vorgänge ermöglicht, war der österreichische Physiker Erwin Schrödinger berühmt und 1933 mit dem Nobelpreis ausgezeichnet worden. Bestrebt ein alles umfassendes Weltbild zu schaffen hat er vor 75 Jahren einen schmalen Band "Was ist Leben? Die lebende Zelle mit den Augen des Physikers betrachtet" herausgegeben, der ungemein populär wurde, viele der bedeutendsten Naturwissenschafter inspirierte (aber auch ernstzunehmende Kritik erhielt) und den Boden für eine molekulare Betrachtungsweise biologischer Vorgänge bereitete. Der theoretische Chemiker Peter Schuster (emer. Univ Prof an der Universität Wien) spannt hier den Bogen von diesen Anfängen der Molekularbiologie hin zu ihrem aktuellen Status. *

Als Begründer der Wellenmechanik, die eine mathematische Beschreibung atomarer Vorgänge ermöglicht, war der österreichische Physiker Erwin Schrödinger berühmt und 1933 mit dem Nobelpreis ausgezeichnet worden. Bestrebt ein alles umfassendes Weltbild zu schaffen hat er vor 75 Jahren einen schmalen Band "Was ist Leben? Die lebende Zelle mit den Augen des Physikers betrachtet" herausgegeben, der ungemein populär wurde, viele der bedeutendsten Naturwissenschafter inspirierte (aber auch ernstzunehmende Kritik erhielt) und den Boden für eine molekulare Betrachtungsweise biologischer Vorgänge bereitete. Der theoretische Chemiker Peter Schuster (emer. Univ Prof an der Universität Wien) spannt hier den Bogen von diesen Anfängen der Molekularbiologie hin zu ihrem aktuellen Status. *

Von Schrödinger's "Was ist Leben?"…

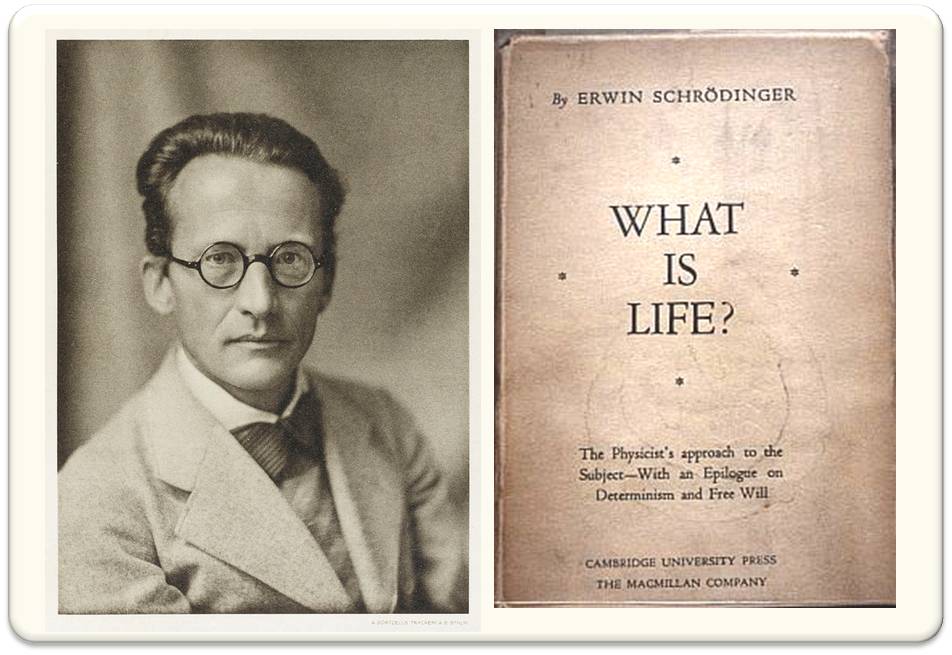

Basierend auf drei öffentlichen Vorlesungen, die Schrödinger in seiner Dubliner Zeit am Trinity College gehalten hatte, erschien 1944 „Was ist Leben“ [1] Abbildung 1. Das schmale Bändchen war enorm erfolgreich, inspirierend und einflussreich: „Bis 1948 wurden 65 Rezensionen verfasst und etwa 100.000 Exemplare verkauft“ , schreibt Max Perutz 1987. Für die enorm positive Bewertung des Büchleins durch die Öffentlichkeit, die für eine wissenschaftliche Veröffentlichung, ja sogar für eine populärwissenschaftliche Schrift außergewöhnlich ist, sehen Historiker drei Gründe: (i) Das Heft ist in einer eleganten, lebendigen und fast dichterischen Form verfasst , (ii) Die Zeit war reif für ein Überdenken der wissenschaftlichen Wurzeln, auf denen die Biologie aufbaute und (iii) Fragen nach dem Ursprung des Lebens oder auch nach dem Ursprung des Universums sind nach wie vor von großem öffentlichen Interesse, da sie ja Antworten auf die brennende Frage bieten : "Woher kommen wir Menschen?"

Abbildung 1. Erwin Schrödinger (1887 -1961) um 1933 - als er den Nobelpreis erhielt und sein bahnbrechendes, 1944 erschienenes kleines Büchlein "What is Life". (Beide Bilder sind gemeinfrei)

Abbildung 1. Erwin Schrödinger (1887 -1961) um 1933 - als er den Nobelpreis erhielt und sein bahnbrechendes, 1944 erschienenes kleines Büchlein "What is Life". (Beide Bilder sind gemeinfrei)

„Was ist Leben?“ erschien unmittelbar bevor die Revolution in der Biologie - das Denken in molekularen Strukturen - einsetzte. Zahlreiche der berühmtesten Forscher - darunter die Entdecker der Doppelhelix-Struktur der DNA, James Watson, Francis Crick, Maurice Wilkins, der Genetiker Max Delbrück, der Phagenforscher Gunter Stent und der Neurophysiologe Seymour Benzer - äusserten durch Schrödingers Buch maßgeblich inspiriert und zu ihren Arbeiten ermutigt worden zu sein.

Die Begeisterung für „Was ist Leben?“ und sein starker Einfluss auf junge Wissenschaftler, insbesondere auf Physiker, stehen allerdings in krassem Gegensatz dazu, wie einige Top-Experten den wissenschaftlichen Inhalt bewerteten. Der für seine Arbeiten zur "Natur der chemischen Bindung" berühmte Linus Pauling, Max Perutz, der die Kristallstruktur des Hämoglobins aufklärte und der oben erwähnte Francis Crick - alle drei waren für ihre Arbeiten mit dem Nobelpreis ausgezeichnet worden - äußerten sich sehr kritisch. So regte sich Linus Pauling über Schrödingers Metapher von Organismen auf, die sich von „Negentropie“ ernähren, d.i. dass diese - anstatt in einen Zustand wachsender Unordnung zu geraten (beschrieben durch die Zustandsgröße "Entropie") und schlussendlich zu zerfallen - sich selbst strukturieren und diese Ordnung auch an die Nachkommen weitergeben, indem sie "Ordnung aus der Umgebung" aufnehmen. Pauling's Hauptargument war, dass das energetische und entropische Gleichgewicht der lebenden Zelle bereits verstanden wurde, als Schrödinger seine Vorlesungen hielt, dass die durch das zelluläre Adenosintriphosphat (ATP) - die „energetische Währung des Lebens" - bereitgestellte freie Energie eine viel größere energetische als entropische Komponente hat, und damit Freie Energie anstelle von Entropie in isothermen Systemen eine geeignete thermodynamische Funktion darstellt.

Max Perutz und Francis Crick kritisierten insbesondere Schrödinger's Verwendung des Begriffs „aperiodischer Kristall“. Makromoleküle und Polymere waren ja bereits seit Anfang der zwanziger Jahre durch die Arbeiten von Hermann Staudinger, Hermann Mark und anderen bekannt und sind keine Kristalle in dem Sinne, dass sie flexibel sind und keine Festkörperstruktur aufweisen. Laut dem Wissenschaftshistoriker Horace Judson erschienen Francis Crick einige Details von Schrödingers Wissenschaft „in ihrer Unbeholfenheit fast peinlich", er ätzte: "ich nehme an, der Mann hatte noch nie von einem Polymer gehört!"

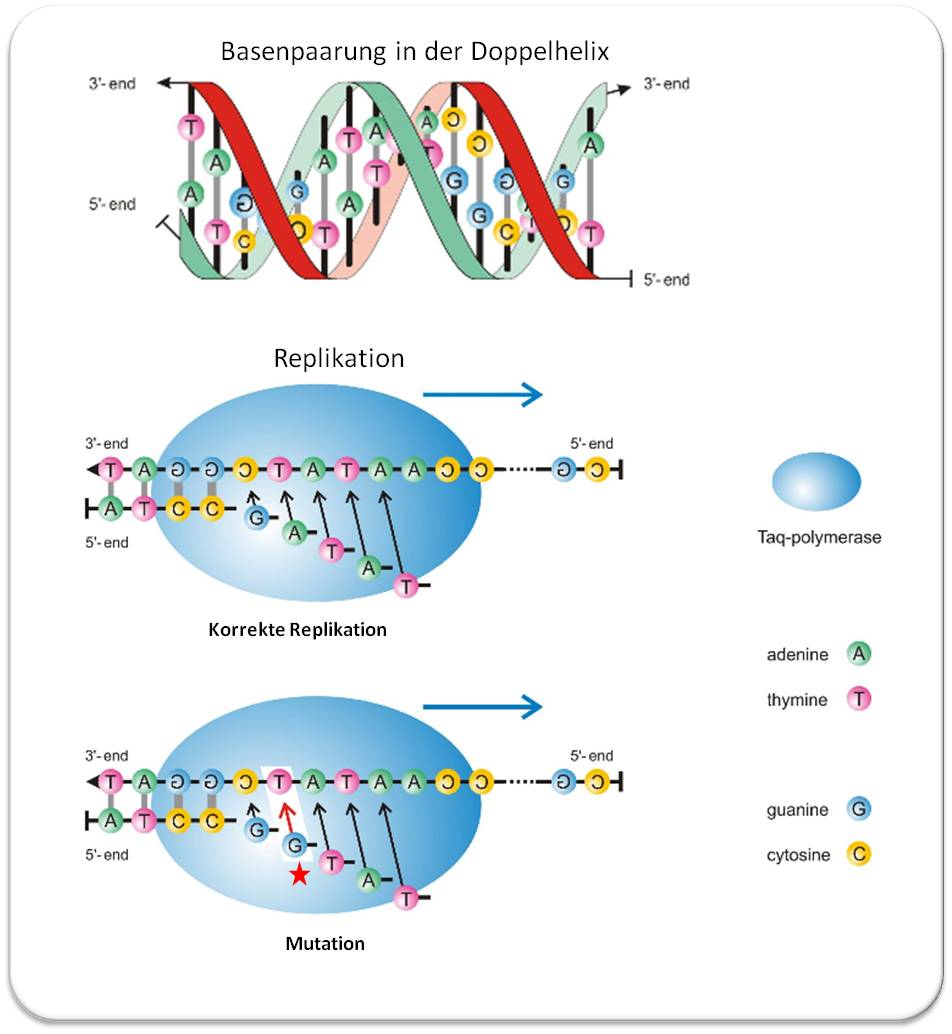

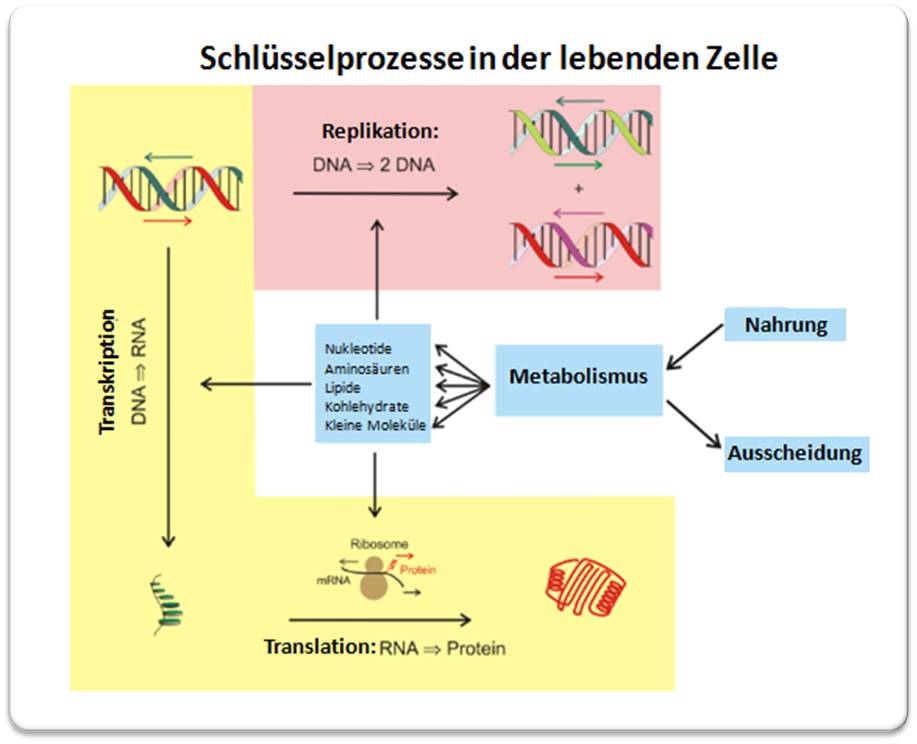

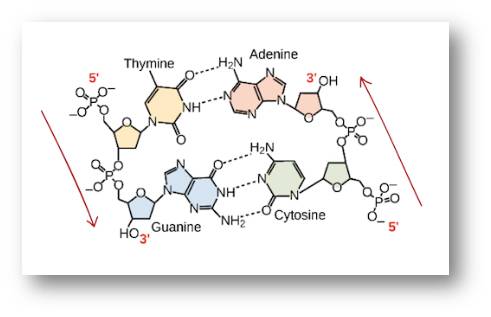

Ein wichtiges Thema, auf das Schrödinger richtig hinwies: Wann immer eine Sequenz mittlerer Länge vorliegt, die aus mehreren Arten von Monomeren aufgebaut ist, kann aufgrund der „kombinatorischen Komplexität“ die Zahl möglicher Kombinationen das Universum leicht füllen. Wie wir aus dem Morse-Alphabet oder den Computercodes wissen, reichen zwei Symbole aus.