2015

2015 Redaktion Wed, 20.03.2019 - 01:03Vom Newtonschen Weltbild zur gekrümmten Raumzeit – 100 Jahre Allgemeine Relativitätstheorie

Vom Newtonschen Weltbild zur gekrümmten Raumzeit – 100 Jahre Allgemeine Relativitätstheorie25.12.2015 - 08:18 — Peter Christian Aichelburg

![]()

Am 25. November 1915 hat Albert Einstein seine Allgemeine Relativitätstheorie an der Preußischen Akademie der Wissenschaften präsentiert. Diese Theorie hat das Weltbild revolutioniert, wurde Grundlage sowohl der modernen Kosmologie als auch praktischer Anwendungen, wie beispielsweise des Navigationssystems GPS. Der theoretische Physiker Peter C. Aichelburg (emer. Prof. Universität Wien), dessen Forschungsgebiet selbst im Bereich der Allgemeinen Relativitätstheorie liegt, führt uns hier in die Zeit ihrer Entstehung und zeigt ihre moderne Bedeutung.

„Es handelt sich um die Prüfung der sogenannten allgemeinen Relativitätstheorie. Diese Theorie gründet sich auf die Voraussetzung, dass Zeit und Raum keine physikalische Realität zukomme; sie führt zu einer ganz bestimmten Theorie der Schwerkraft, gemäß welcher die klassische Theorie Newtons nur in erster, wenn auch vorzüglicher Näherung gültig ist. Die Prüfung der Ergebnisse jener Theorie sind nur auf astronomischem Wege möglich….. „ Albert Einstein, Brief an Otto Naumann am 7. Dezember 1915

Stellen Sie sich vor, Sie kommen mit dem Auto in eine fremde Stadt und wollen zum gebuchten Hotel. Sie schalten das Navigationssystem ein, das Sie sicher durch das Straßengewirr bringen soll. Anfangs stimmen die Hinweise recht gut, aber schon nach zehn Minuten werden die Hinweise ungenau. Die Straße, in die Sie aufgefordert werden einzubiegen, ist die falsche, und alsbald sind die Hinweise unbrauchbar. So oder so ähnlich muss es dem US-Geheimdienst ergangen sein, als er das erste Globale Positionierung-System (GPS) getestet hat. Gott sei Dank haben die Verantwortlichen auf die Physiker gehört und eine Korrekturmöglichkeit eingebaut, um die Folgen aus der Einsteinschen Relativitätstheorie zu berücksichtigen.

Diese Theorie, die nun ihren 100. Geburtstag feiert, hat damals das Weltbild revolutioniert: Im Newtonschen Verständnis waren Raum und Zeit vorgegebene Größen, gleichsam die Bühne, auf der sich die physikalischen Begebenheiten zutragen. Mit der Allgemeinen Relativitätstheorie wurden sie zur gekrümmten Raumzeit und somit zum Teil des dynamischen Geschehens.

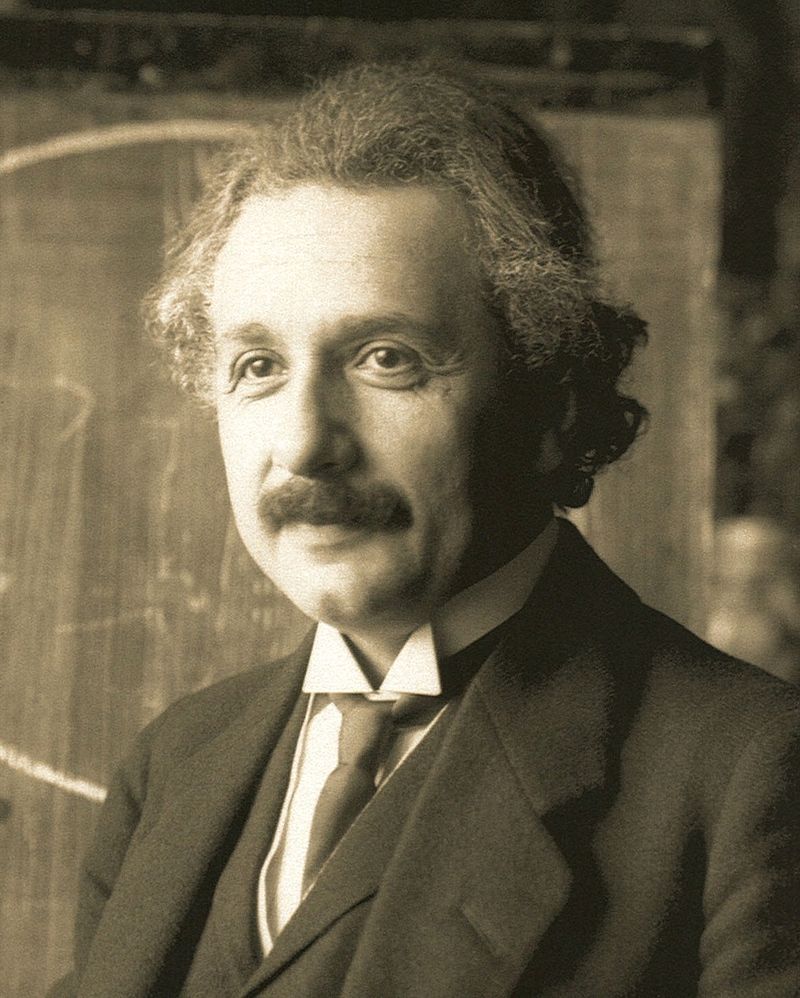

Abbildung 1. Albert Einstein, im Jahr 1921. (Foto: Ferdinand Schmutzer; das Bild ist in der Public Domain)

Abbildung 1. Albert Einstein, im Jahr 1921. (Foto: Ferdinand Schmutzer; das Bild ist in der Public Domain)

Beweis bei Sonnenfinsternis

Am 20. November 1915 legt der Göttinger Mathematiker David Hilbert in einer Mitteilung an die „Königliche Gesellschaft der Wissenschaften zu Göttingen“ jene Gleichungen einer geometrischen Formulierung der Gravitation vor, um die sich Einstein jahrelang bemüht hat. Fünf Tage später gibt Einstein dieselben Gleichungen der Preußischen Akademie bekannt.

Wie konnte dies geschehen? Einstein war im Juni 1915 zu Vorträgen in Göttingen, in denen er über seine Ideen zu einer neuen Theorie der Gravitation und den noch ungelösten Problemen berichtete. Als er am 25. November die endgültigen Gleichungen vorlegt, kannte er zwar Hilberts Ableitung flüchtig. Aber es ist unwahrscheinlich, dass er diese aus Hilberts Arbeit übernommen hat. Jedenfalls führte dies zu einer Verstimmung mit Hilbert – bis dieser ausdrücklich feststellte, dass die neue Gravitationstheorie ganz das Werk Einsteins sei.

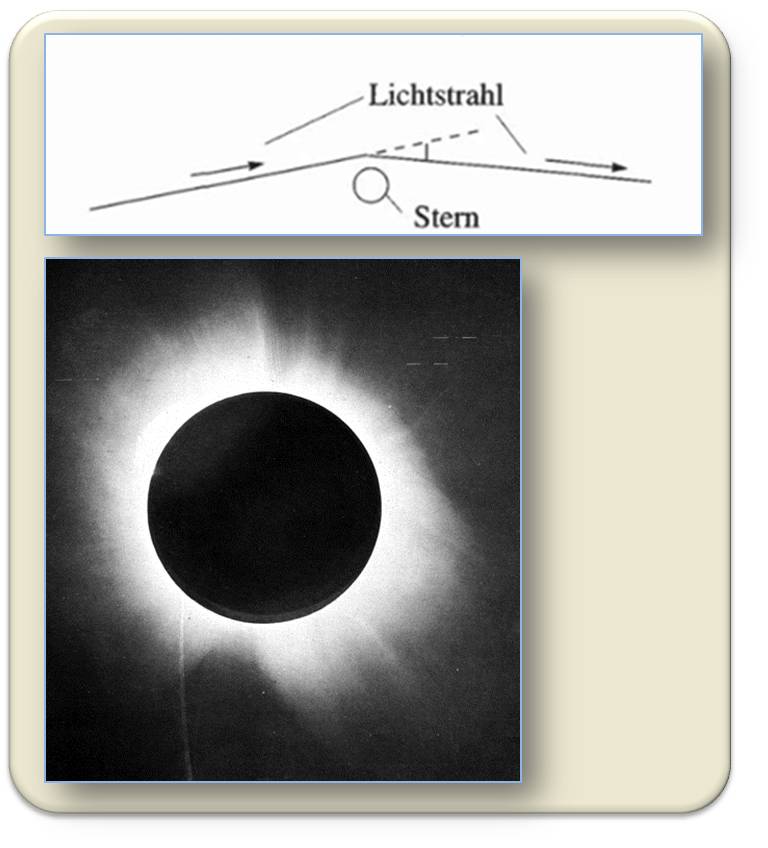

Eine der Konsequenzen der Einsteinschen Theorie ist, dass Licht im Schwerefeld eine Ablenkung erfährt. Dieser Effekt sollte sich bei Sternenlicht, das nahe am Sonnenrand vorbei geht, bemerkbar machen. Abbildung 2. Um diese Ablenkung zu beobachten, bedarf es einer totalen Sonnenfinsternis, weil sonst das Sonnenlicht das Sternenlicht überstrahlt. Einstein wollte bereits 1914, also noch bevor er die endgültigen Gleichungen hatte, diesen Effekt bei einer Sonnenfinsternis in Russland testen. Dazu kam es aber wegen des Ausbruchs des Ersten Weltkriegs nicht. Erst 1919 plante der britische Astronom Sir Arthur Eddington eine entsprechende Expedition nach Westafrika. Als ein halbes Jahr später in einer feierlichen Sitzung der „Royal Society“ und der „Royal Astronomical Society“ in London die Vorhersage der neuen Theorie offiziell bestätigt wurde, war Einstein über Nacht international bekannt.

Abbildung 2. „Die Theorie ergibt das Resultat, dass ein neben einem Himmelskörper vorbeigehender Lichtstrahl eine Ablenkung erfährt“ (Bild und Zitat: A. Einstein 7.12.2015, Brief an Otto Naumann; siehe weiterführende Links) Unten: Diesen Effekt konnte Sir Arthur Eddington bei Sternenlicht - d.i. bei einer totalen Sonnenfinsternis - nachweisen.

Abbildung 2. „Die Theorie ergibt das Resultat, dass ein neben einem Himmelskörper vorbeigehender Lichtstrahl eine Ablenkung erfährt“ (Bild und Zitat: A. Einstein 7.12.2015, Brief an Otto Naumann; siehe weiterführende Links) Unten: Diesen Effekt konnte Sir Arthur Eddington bei Sternenlicht - d.i. bei einer totalen Sonnenfinsternis - nachweisen.

Welche Bedeutung aber kommt Einsteins Theorie heute noch zu?

Viele der Konsequenzen sind schwer nachzuweisen und doch spielen sie, wie sich am Beispiel des GPS zeigt, auch in unser tägliches Leben hinein. Unbestritten sind die Effekte der Theorie für die Erforschung des Kosmos. Die oben erwähnte Lichtablenkung im Gravitationsfeld wird heute dazu benützt, um etwa die Masse von Galaxienhaufen abzuschätzen. Das durch Materie-Ansammlungen hervorgerufene Schwerefeld führt zu einer Bündelung der Lichtstrahlen, die von einer dahinter liegenden Quelle stammen. Diese sogenannten Gravitationslinsen ermöglichen es, auch Objekte zu sehen, die wegen ihrer Lichtschwäche sonst kaum zu beobachten wären. Eine der wohl spektakulärsten Konsequenzen aus Einsteins Theorie sind Schwarze Löcher: auf dem Papier Lösungen für Gleichungen, bei denen die Geometrie in einem Gebiet so stark gekrümmt ist, dass nichts daraus entweichen kann – nicht einmal Licht, daher der Name. Solche Schwarzen Löcher entstehen, wenn ein massereicher Stern am Ende seiner Entwicklung durch die Gravitation in sich zusammenbricht. Heute sind Forscher überzeugt, dass es unzählige solcher Objekte auch in unserer Milchstraße gibt. Die Beobachtung erfolgt indirekt durch das Aufleuchten hineinfallender Materie. Zuletzt ist es evident geworden, dass sich riesige Schwarze Löcher im Zentrum vieler Galaxien befinden – in unserer Milchstraße etwa eines mit circa vier Millionen Sonnenmassen. Dies zeigen Beobachtungen von Sternen, die das Schwarze Loch umkreisen.

Einsteins „kosmologische Konstante“

Allerdings ist es bis jetzt nicht gelungen, eine der Vorhersagen von Einsteins Theorie direkt nachzuweisen: Während sich die Gravitationswirkung nach der Newtonschen Theorie instantan, also augenblicklich ausbreitet, so verlangt schon die Spezielle Relativitätstheorie, dass sich jedes Signal höchstens mit Lichtgeschwindigkeit fortpflanzt. Wie aber sieht es mit Veränderungen in der Geometrie aus?

1918 publiziert Einstein eine Arbeit über Gravitationswellen, in der er nachweist, dass sich Störungen der Geometrie mit Lichtgeschwindigkeit ausbreiten und Energie transportieren, ähnlich wie elektromagnetische Wellen. Gravitationswellen werden durch bewegte Massen erzeugt, sind aber meist zu schwach, um bemerkt zu werden. Indirekt gibt es Beweise für die Existenz von Gravitationswellen, denn sie entziehen dem System Energie.

Rund um den Erdball gibt es Forschungsteams, die sogenannte Gravitationswellen- Detektoren entwickelt haben und laufend Messungen durchführen. Dieses Ziel verfolgt nun auch das „eLISA“-Projekt der Europäischen Raumfahrtagentur ESA. Hier arbeiten Theoretiker und Experimentalphysiker zusammen. Denn um das extrem schwache Signal aus dem Hintergrund herauszufiltern, bedarf es einer genauen Vorhersage über die Form des zu erwartenden Signals. In den nächsten Jahren sollte es gelingen, Gravitationswellen direkt nachzuweisen. Dies würde ein neues Fenster in den Kosmos öffnen und uns Kunde von dramatischen Vorgängen in fernen Galaxien bringen – und somit auch zu einem besseren Verständnis der Entwicklung des Universums beitragen.

Schon 1917 hat Einstein seine Theorie auf den Kosmos als Ganzes angewandt. Er war der Meinung, das Universum sei im Großen unveränderlich, und hat daher nach einer statischen Lösung gesucht. Als der exzentrische Physiker erkannte, dass seine Gleichungen eine solche nicht zulassen, fügte er die „kosmologische Konstante“ ein: Dies hat er später angeblich mit „die größte Eselei meines Lebens“ quittiert. Denn er hätte die Expansion des Kosmos, die 1929 der Astronom Edwin Hubble durch Beobachtung des Auseinander-Driftens der Galaxien entdeckte, vorhersagen können.

Zurück in die Ursuppe

Die Einsteinsche Theorie ist die Grundlage für die moderne Kosmologie. Wir haben starke Hinweise, dass sich das Universum vor circa 14 Milliarden Jahren aus einer extrem dichten und heißen „Ursuppe“ entwickelt hat, aus der die heute zu beobachtenden Strukturen nach und nach entstanden sind. Dennoch zeigt diese Urknall-Theorie die Grenzen der Einsteinschen Theorie auf: Denn verfolgt man die Entwicklung des Kosmos in der Zeit zurück, so gelangt man zu immer höheren Dichten bis, wie die Theoretiker es nennen, eine „Singularität“ entsteht. Hier muss die Theorie durch Neues ersetzt werden.

Quantengravitation ist das neue Schlagwort, denn den Gesetzen des Mikrokosmos sollte auch die Gravitation unterworfen sein. Trotz interessanter Ansätze wie etwa die String-Theorie oder die Schleifengravitation gibt es aber noch keine zufriedenstellende Lösung. Zweifellos gehört Einsteins Gravitationstheorie auch noch nach hundert Jahren zu den größten geistigen Leistungen in der Physik. Und sie prägt unsere Vorstellung von Raum und Zeit bis heute.

*Der vorliegende Text ist die leicht modifizierte Fassung eines Artikels, den Die Furche am 3. Dezember 2015 brachte.

Weiterführende Links

Eine umfassende Sammlung der Schriften Albert Einsteins ist zu finden in: PRINCETON'S SERIES Collected Papers of Albert Einstein. http://press.princeton.edu/catalogs/series/title/collected-papers-of-alb... .

Alle Dokumente sind in der ursprünglichen Sprache wiedergegeben. Der Zeitraum 1914 – 1917 findet sich in Band 6: http://einsteinpapers.press.princeton.edu/vol6-doc .Darunter ist auch die Präsentation der Allgemeinen Relativitätstheorie an der Preußischen Akademie der Wissenschaften und eine „gemeinverständliche“ Darstellung Einsteins „Über die speziell und allgemeine Relativitätstheorie“.

Was die Collected Papers bieten:

“Selected from among more than 40,000 documents contained in the personal collection of Albert Einstein (1879-1955), and 15,000 Einstein and Einstein-related documents discovered by the editors since the beginning of the Einstein Project, The Collected Papers will provide the first complete picture of a massive written legacy that ranges from Einstein's first work on the special and general theories of relativity and the origins of quantum theory, to expressions of his profound concern with civil liberties, education, Zionism, pacifism, and disarmament. The series will contain over 14,000 documents and will fill twenty-five volumes. Sponsored by the Hebrew University of Jerusalem and Princeton University Press

The Digital Einstein Papers is an exciting new free, open-access website that puts The Collected Papers of Albert Einstein online for the very first time, bringing the writings of the twentieth century’s most influential scientist to a wider audience than ever before.”

EU-Umfrage: Der Klimawandel stellt für die EU-Bürger ein sehr ernstes Problem dar

EU-Umfrage: Der Klimawandel stellt für die EU-Bürger ein sehr ernstes Problem darFr, 18.12.2015 - 06:55 — Inge Schuster

![]()

Vor wenigen Tagen haben sich 195 Länder in Paris auf einen ersten rechtsverbindlichen, globalen Klimavertrag geeinigt, der die Erderwärmung eindämmen soll (Framework Convention on Climate Change [1]). Die Ziele sind sehr ehrgeizig und werden – wenn sie ernstgenommen werden – den Abschied von der fossilen Energie bedeuten und damit unsere Welt völlig verändern. Die Europäische Union hat zu dieser Übereinkunft ganz wesentlich beigetragen. Wieweit aber stehen die EU-Bürger selbst hinter einem derartigen Abkommen, welchen Stellenwert räumen sie dem Klimawandel unter den globalen Problemen ein und welche Aktivitäten setzen sie/haben sie bereits zu seiner Bekämpfung gesetzt? Eine EU-weite Umfrage zu diesem Thema hat im Frühsommer d.J. stattgefunden; die Ergebnisse sind unmittelbar vor Beginn der Klimakonferenz veröffentlicht worden und zeigen, dass die Menschen den Ernst der Situation erfasst haben und zu Klimaschutzmaßnahmen bereit sind (Special Eurobarometer 435 [2]).

Die Umfrage „Spezial Eurobarometer 435“

Im Auftrag der Europäischen Kommission wurde im Frühjahr 2015 eine Umfrage in den 28 Mitgliedsländern durchgeführt, welche die Einstellung der Bevölkerung zum Klimawandel, deren diesbezügliche Verhaltensweisen und Erwartungen für die Zukunft erkunden sollte. Es war dies nicht das erste Mal, dass die EU-Bürger rund um dieses Thema befragt wurden. Derartige Erhebungen hatten schon 2008, 2009, 2011 und 2013 stattgefunden und liefen auch jetzt nach dem bereits bewährten Muster ab. Ein Heer von Interviewern (Mitarbeiter der global arbeitenden Marktforschungsinstitution TNS opinion & social network) schwärmte aus, um in jedem Mitgliedsstaat jeweils rund 1000 Personen in ihrem Heim und in ihrer Muttersprache zu befragen. Insgesamt waren dies 27 718 Personen, die aus verschiedenen sozialen und demographischen Gruppen stammten und einen repräsentativen Querschnitt durch die jeweilige Bevölkerung eines Landes boten. In diesen persönlichen Interviews wurden dieses Mal Fragen zu vier Themenkreisen gestellt:

- Zur Wahrnehmung des Klimawandels: welchen Stellenwert nimmt der Klimawandel ein unter anderen globalen Problemen und als wie ernstes Problem wird er selbst gesehen?

- Zur Bekämpfung des Klimawandels: wer ist primär für Maßnahmen zur Bekämpfung verantwortlich und hat der Befragte selbst Schritte zur Verringerung von Treibhausgasemissionen gesetzt?

- Zur Einstellung hinsichtlich Bekämpfung des Klimawandels und Reduktion des Imports fossiler Brennstoffe: bringt die Bekämpfung des Klimawandels Vorteile für die Wirtschaft und können derartige Maßnahmen wirksam sein ohne, dass alle Länder der Welt sich daran beteiligen?

- Zu Zukunftsperspektiven: sollen Staaten Ziele für erneuerbare Energien festlegen und Energieeffizienz fördern?

Im vorliegenden Bericht soll ein allgemeiner Überblick über die Ergebnisse dieser Umfrage gegeben werden, wobei der Fokus auf Österreich und Deutschland gelegt wird. Weitere Details, auch zu den anderen EU-Staaten, sind unter [2] und [3] zu finden.

Die Ergebnisse der Umfrage

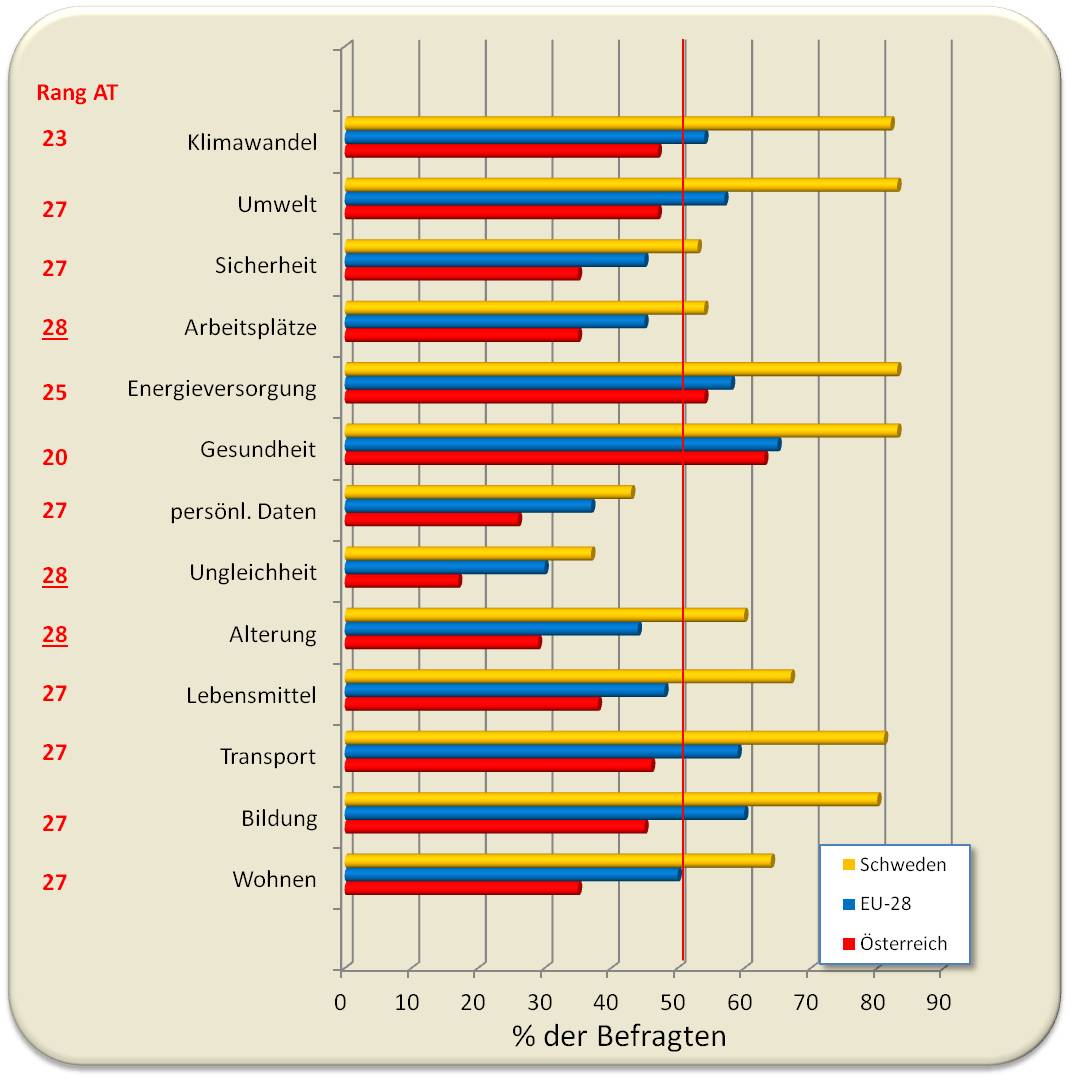

Themenkreis 1: Wie wird der Klimawandel wahrgenommen?

Der Klimawandel bleibt eine Hauptsorge der europäischen Bevölkerung: Insgesamt 91 % der Befragten betrachten den Klimawandel als ernstes Problem und 69 % als sehr ernstes Problem. Die Meinung der befragten Österreicher entspricht hier dem EU-Durchschnitt; auch in Deutschland sind es 91 %, die den Klimawandel als ernstes Problem sehen und – etwas mehr als im EU-Durchschnitt - 72 % als sehr ernstes Problem.

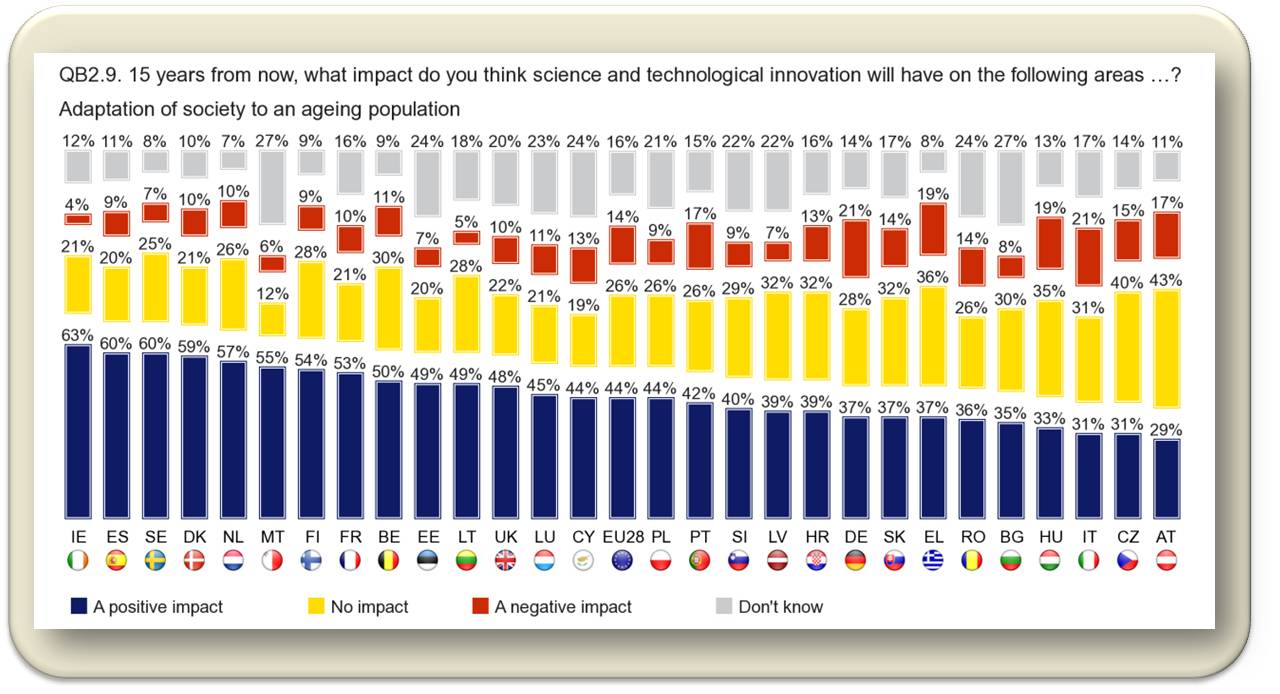

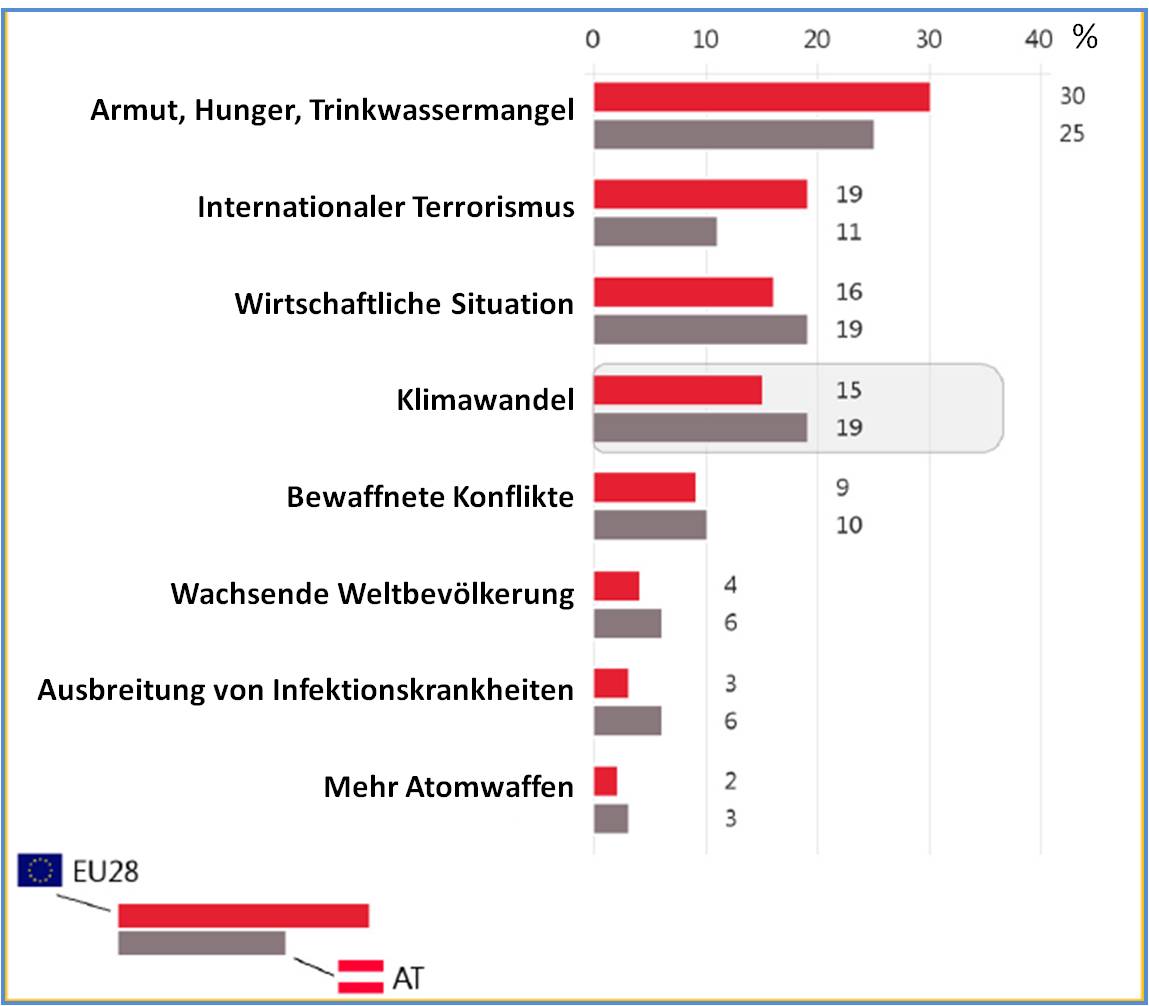

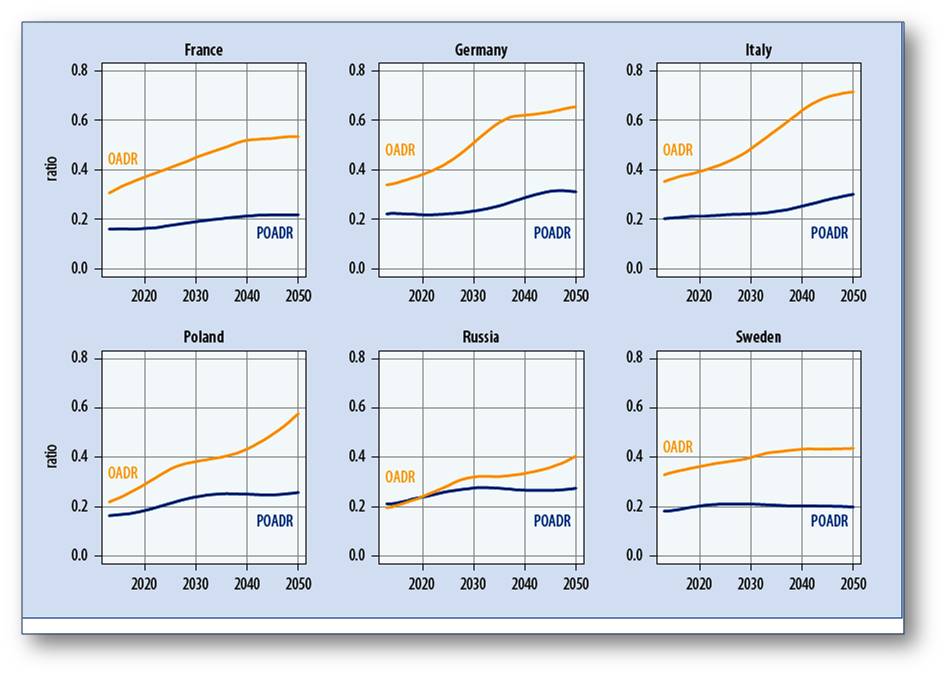

Vom sozial-demographischen Standpunkt aus betrachtet scheint der Bildungsgrad wenig Einfluss darauf zu haben, ob der Klimawandel als ernstes Problem gesehen wird oder nicht. Probleme, denen die Welt aktuell gegenübersteht: welche sind die wichtigsten? Dazu meint nahezu die Hälfte (47 %) der Europäer, dass der Klimawandel zu den größten Problemen gehört und etwa jeder Sechste (15 %), dass dieser überhaupt das Hauptproblem darstellt. EU-weit gesehen rangiert damit der Klimawandel hinter den globalen Problemen „Armut, Hunger, Trinkwassermangel“ (30 %), „Internationaler Terrorismus“ (19 %) und „Wirtschaftliche Situation“ (16 %) an vierter Stelle (Abbildung 1).

Dieses Ranking zeigt aber starke regionale Unterschiede:

An erster Stelle steht bei den Befragten in 19 der 28 Staaten – darunter auch in Österreich und Deutschland – die Armut. In jeweils 2 Staaten nehmen der internationale Terrorismus (Malta, Tschechien) und die wirtschaftliche Situation (Zypern, Italien) die Spitzenposition ein; in drei osteuropäichen Staaten (Lettland, Estland und Polen) ist es die Angst vor bewaffneten Konflikten und in den drei nordeuropäischen Staaten Schweden, Dänemark und Finnland der Klimawandel.

In Österreich rangiert der Klimawandel – über dem EU-Durchschnitt - etwa gleichauf mit der wirtschaftlichen Situation bereits hinter der Armut (Abbildung 1).

Abbildung 1. Welches der genannten Probleme betrachten Sie als das Hauptproblem für die Menschheit? (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Fact sheets in national languages- Austria [3])

Abbildung 1. Welches der genannten Probleme betrachten Sie als das Hauptproblem für die Menschheit? (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Fact sheets in national languages- Austria [3])

Noch gravierender sehen die Deutschen den Klimawandel: 26% der Befragten sehen ihn als wichtigstes globales Problem; damit liegt er nur knapp hinter der Armut, die 28 % als Hauptproblem angaben.

Themenkreis 2: Bekämpfung des Klimawandels

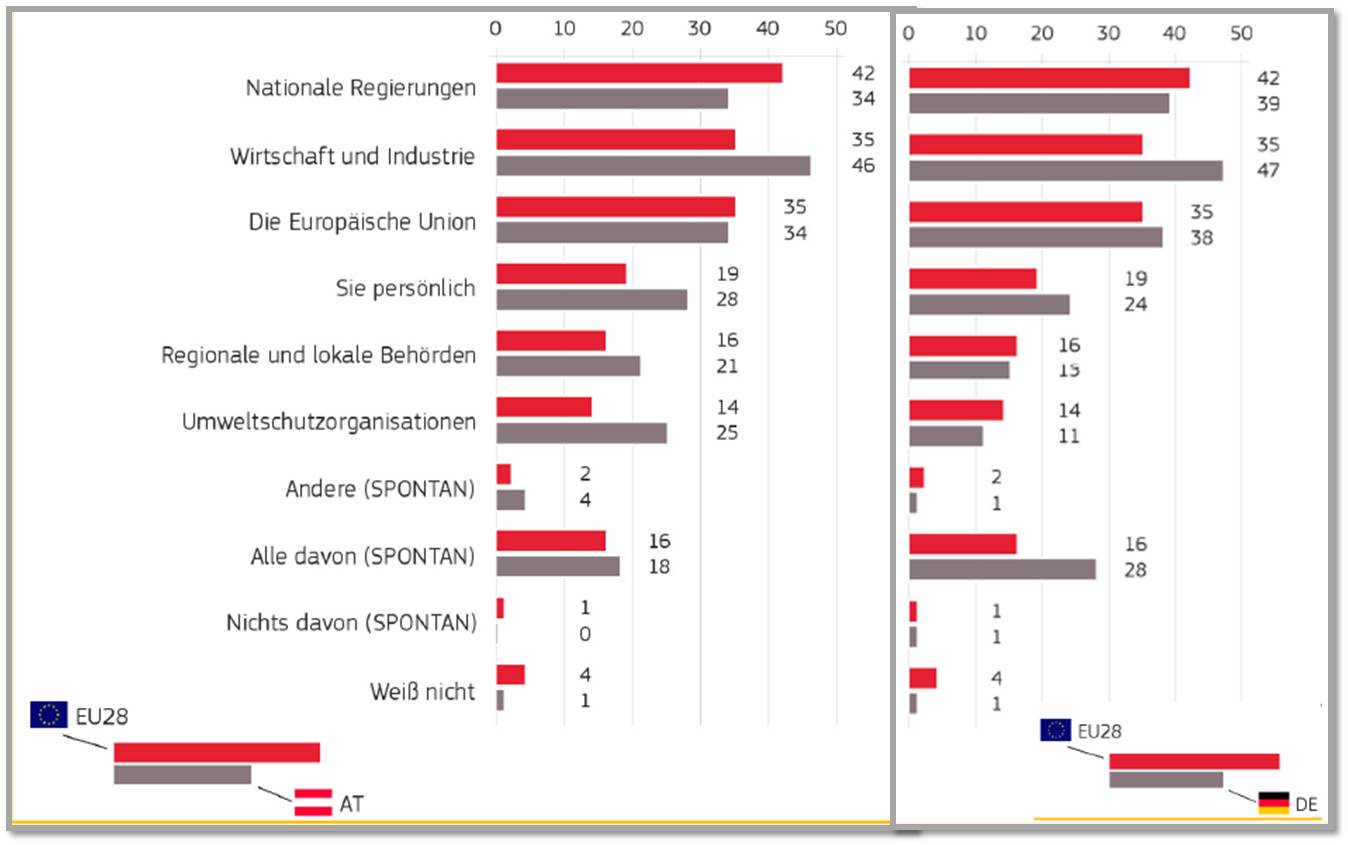

Hier stand zuerst die Frage im Vordergrund: „Wer ist innerhalb der EU für die Bekämpfung des Klimawandels verantwortlich?“ (Abbildung 2).

EU-weit wird hier die Verantwortung primär bei den nationalen Regierungen gesehen, dahinter liegen gleichauf Wirtschaft & Industrie und die Europäische Union.

In Österreich, Deutschland und einigen anderen Staaten (CZ, FI, HU, SI, LT, BG, LV) wird dagegen der Wirtschaft & Industrie die Hauptverantwortung zugeschrieben. In Österreich meinen auch wesentlich mehr Menschen als im EU-Durchschnitt, dass sich Umweltschutzorganisationen um das Problem kümmern sollten (dieser Ansicht sind auch viele osteuropäische Staaten).

Abbildung 2. „Wer ist innerhalb der EU für die Bekämpfung des Klimawandels verantwortlich? (Mehrfachnennungen möglich).“ Angaben in % der Befragten (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Fact sheets in national languages- Austria [3])

Abbildung 2. „Wer ist innerhalb der EU für die Bekämpfung des Klimawandels verantwortlich? (Mehrfachnennungen möglich).“ Angaben in % der Befragten (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Fact sheets in national languages- Austria [3])

Interessant erscheint: in Österreich und Deutschland wird ein hohes Maß an Eigenverantwortung angegeben (nur übertroffen von den nordeuropäischen Ländern). Wie die sozial-demographische Analyse der Antworten zeigt, beeinflussen Bildungsgrad und Alter die Bereitschaft Eigenverantwortung zu übernehmen: je früher Personen ihren Bildungsweg beendet hatten und je älter sie waren, desto geringer war ihre Bereitschaft.

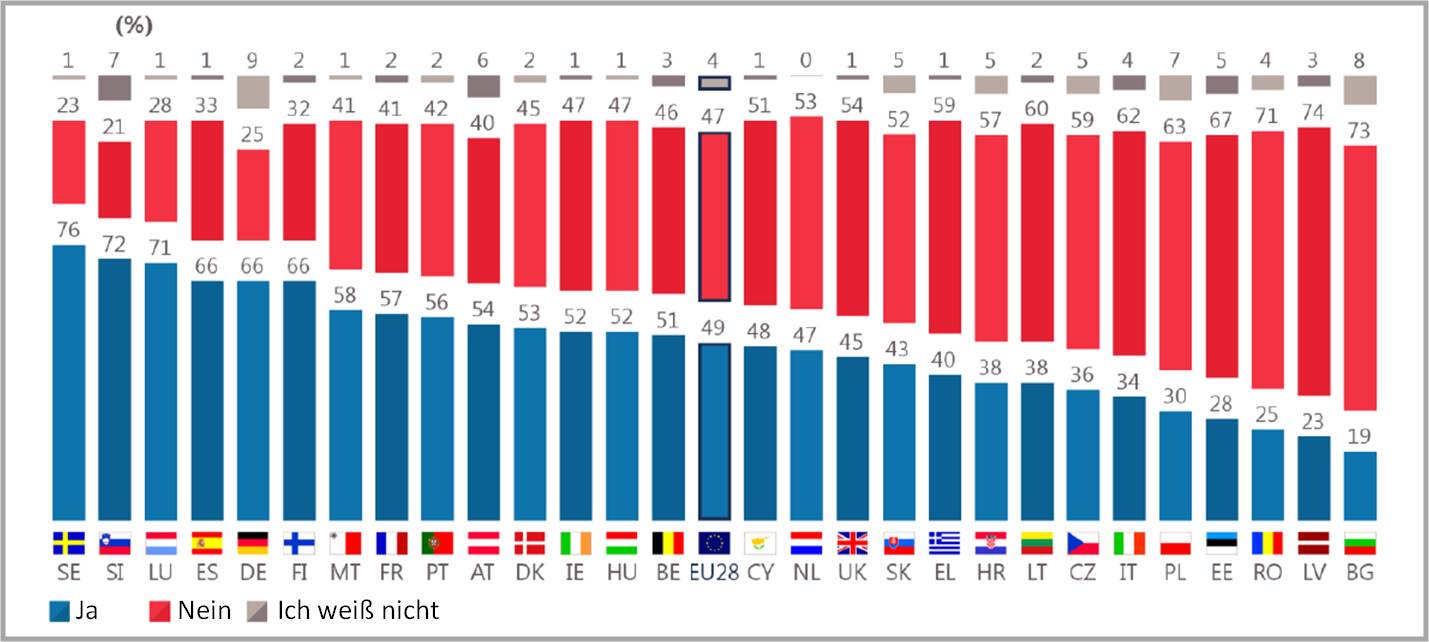

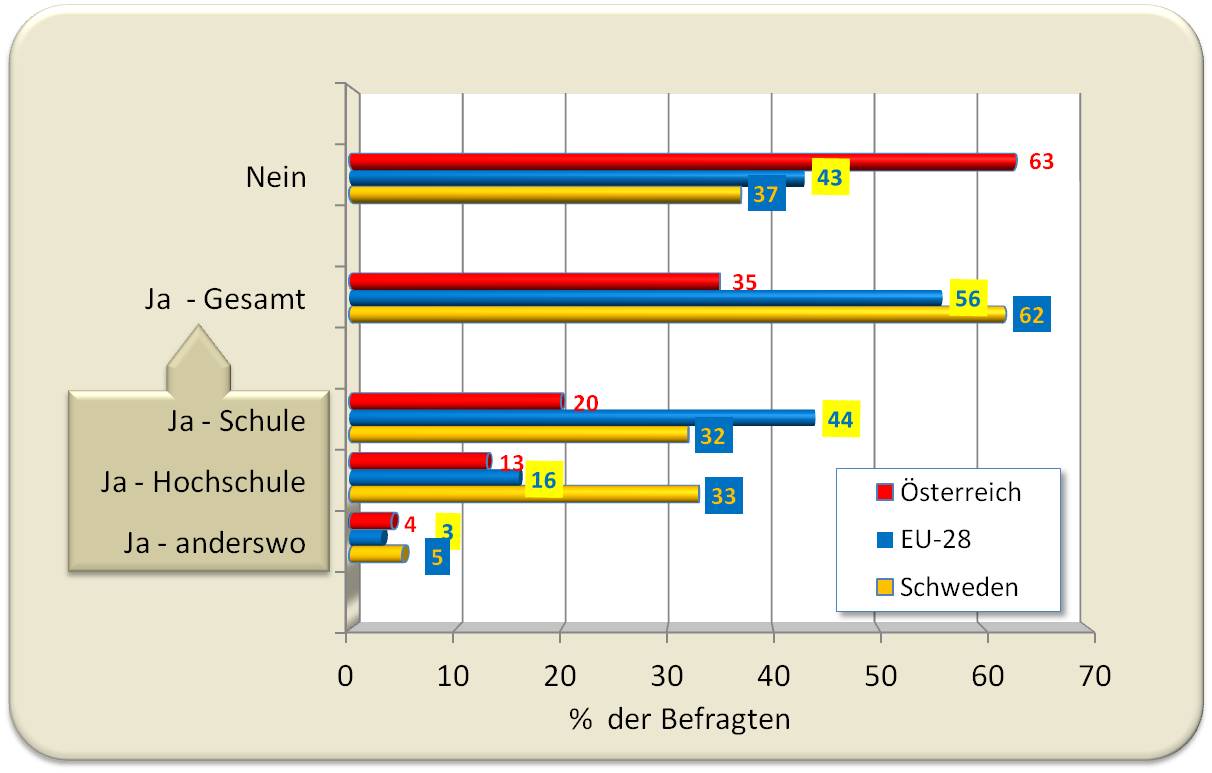

Wie weit tragen Sie persönlich zum Klimaschutz bei? Dass sie bereits persönlich Maßnahmen zum Klimaschutz getroffen hätten, gaben im EU-Durchschnitt 49 % der Befragten an. Dabei zeigten sich aber große regionale Unterschiede. Die meisten positiven Antworten- von über 70 % der Befragten - kamen aus Schweden, Slowenien und Luxemburg, die wenigsten – 19 -28 % - aus Bulgarien, Lettland, Estland und Rumänien (Abbildung 3).

Mehr als die Hälfte der Bürger in Österreich (54 %) und Deutschland (66 %) sagten, dass sie im letzten Halbjahr etwas zum Klimaschutz beigetragen hätten

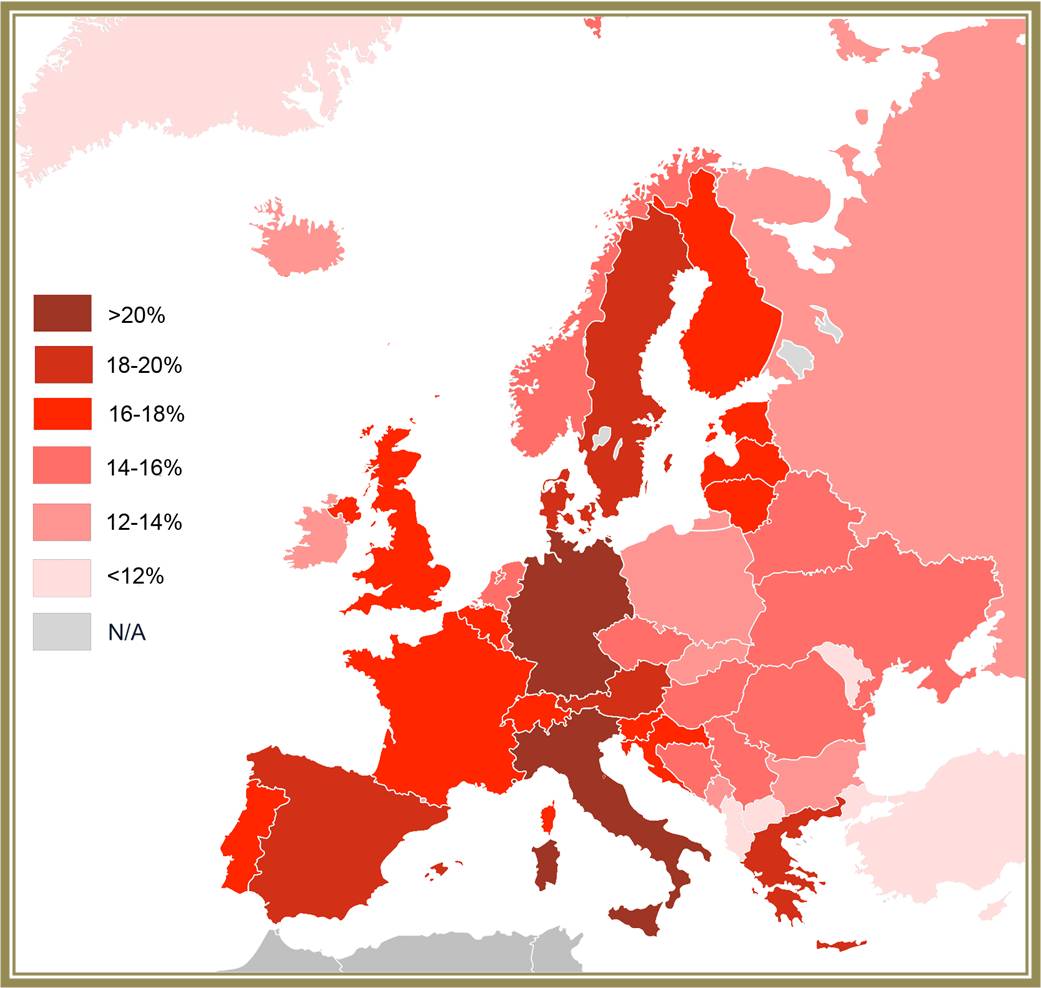

Abbildung 3.Haben Sie selbst im letzten Halbjahr Maßnahmen zum Klimaschutz getroffen? (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Report [2])

Abbildung 3.Haben Sie selbst im letzten Halbjahr Maßnahmen zum Klimaschutz getroffen? (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Report [2])

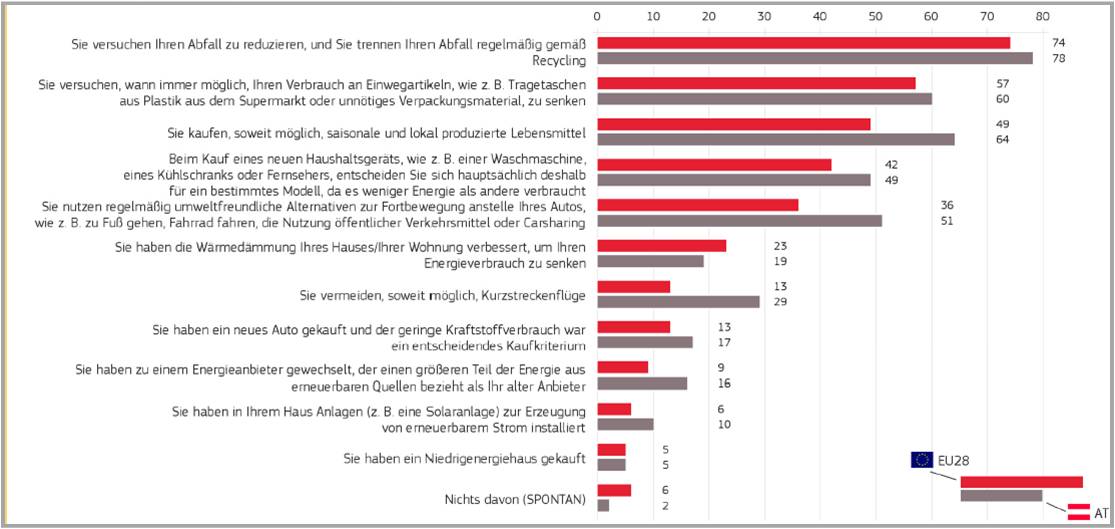

Als nun aber an Hand einer Liste von Handlungen nach den konkreten Maßnahmen gefragt wurde, erwies es sich, dass im EU-Durchschnitt tatsächlich 93 % der Menschen, in Österreich und Deutschland 98 % Beiträge geleistet hatten. Diese Maßnahmen betreffen vor allem

- die Reduktion von Abfall und Trennung zur Wiederverwertung

- die Reduktion des Verbrauchs von Wegwerfartikeln

- die Anschaffung energieeffizienter Haushaltsgeräte

- die Nutzung umweltfreundlicher Verkehrsmittel

- der Einkauf lokal produzierter Lebensmittel

Im Vergleich mit dem EU-Durchschnitt wurden nahezu alle Maßnahmen in Österreich und Deutschland bedeutend häufiger ergriffen. Abbildung 4 zeigt die Daten für Österreich, auf die Wiedergabe der sehr ähnlichen Daten für Deutschland wird verzichtet).  Abbildung 4. „Welche dieser Handlungen treffen, wenn überhaupt, auf Sie zu? (Mehrfachnennungen möglich).“ Angaben in % der Befragten. (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Fact sheets in national languages- Austria [3])

Abbildung 4. „Welche dieser Handlungen treffen, wenn überhaupt, auf Sie zu? (Mehrfachnennungen möglich).“ Angaben in % der Befragten. (Quelle: European Commission, Special Eurobarometer 435. Climate Change, Fact sheets in national languages- Austria [3])

Themenkreis 3: Einstellung der Europäer zur Bekämpfung des Klimawandels - wer ist verantwortlich?

Hier gibt es eine sehr positive Einstellung der EU-Bürger: die überwiegende Mehrheit in allen Staaten (im Durchschnitt 81 %, Österreich und Deutschland liegen mit 75 % und 79 % knapp darunter) stimmte zu, dass die Bekämpfung des Klimawandels und eine effizientere Energienutzung die Wirtschaft und den Arbeitsmarkt in der EU ankurbeln würden.

Noch beeindruckender war, dass die überwältigende Mehrheit der Befragten (im EU-Durchschnitt 93%) der Meinung war, dass die Bekämpfung des Klimawandels nur wirksam sein wird, wenn alle Länder der Welt gemeinsam handeln.

Etwas differenzierter war die Haltung zu Fragen, die den Import von fossilen Brennstoffen betrafen:

- Kann die EU wirtschaftlich profitieren, wenn weniger fossile Brennstoffe von außerhalb der EU importiert werden? Dies bejahten im EU-Durchschnitt zwar 55 % (in Österreich 70 %, in Deutschland 63 %), allerdings verneinten dies 30 % der Holländer und 28 % der Schweden.

- Kann die Sicherheit der Energieversorgung in der EU erhöht werden, wenn weniger fossile Brennstoffe von außerhalb der EU importiert werden? Hier liegt die durchschnittliche Zustimmung bei 65 % (Österreich 74 %, Deutschland 65 %), in Estland, Holland und Lettland unter 50 %.

Themenkreis 4: Ausblick in die Zukunft

Festlegung von Zielen für erneuerbare Energien

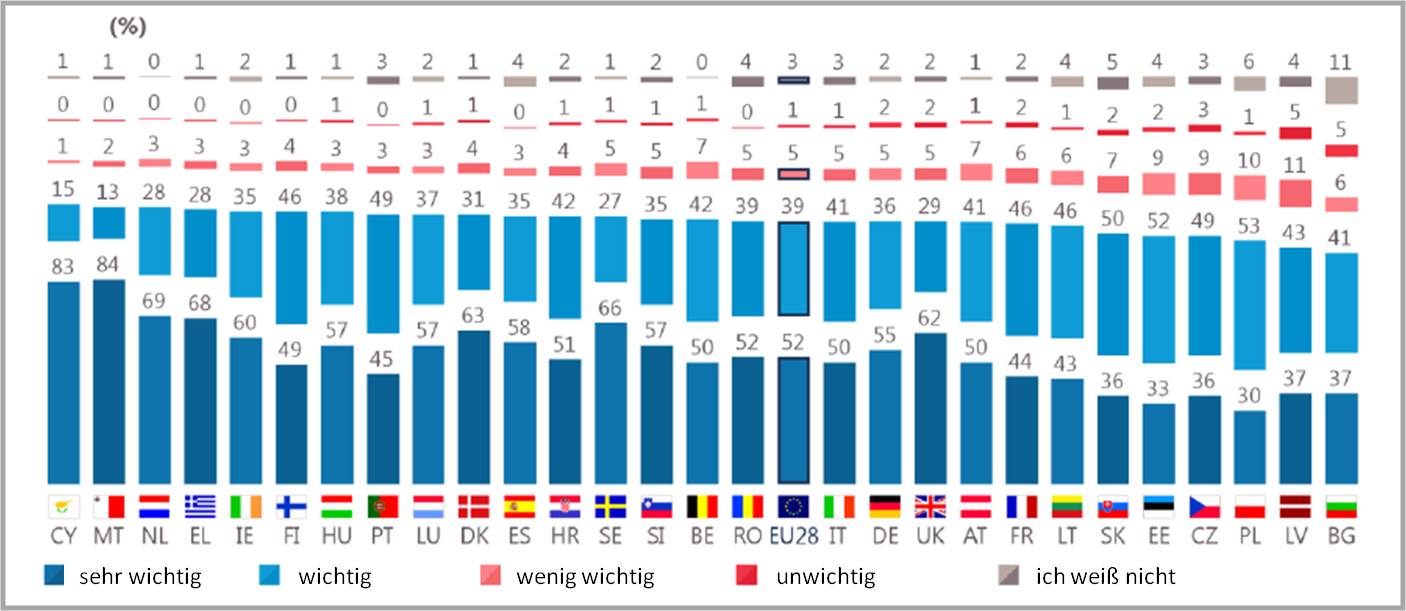

Hier herrscht ein weitgehender Konsens in allen EU-Staaten: die große Mehrheit der Befragten – 91 % - hält es außerdem für wichtig, dass ihre Regierung Ziele festlegt, um den Anteil der Nutzung erneuerbarer Energien wie beispielsweise Wind- und Solarenergie zu erhöhen. Abbildung 5.

Abbildung 5. Wie wichtig ist es Ihrer Ansicht nach, dass die Nationale Regierung Ziele festlegt, um die Nutzung erneuerbarer Energien wie beispielsweise Wind- und Solarenergie zu erhöhen? Quelle: European Commission, Special Eurobarometer 435. Climate Change, Report [2])

Abbildung 5. Wie wichtig ist es Ihrer Ansicht nach, dass die Nationale Regierung Ziele festlegt, um die Nutzung erneuerbarer Energien wie beispielsweise Wind- und Solarenergie zu erhöhen? Quelle: European Commission, Special Eurobarometer 435. Climate Change, Report [2])

Verbesserung der Energieeffizienz

Auch zu der Frage ob es wichtig ist, dass die Nationale Regierung die Verbesserung der Energieeffizienz bis 2030 unterstützt - z.B, durch Förderung der Wärmedämmung von Wohngebäuden oder des Kaufs von Energiesparlampen – herrschte weitestgehende Zustimmung (EU-Durchschnitt 92 %; Österreich 86 %, Deutschland 90 %)

Fazit

- Die Europäer betrachten den Klimawandel als eines der ernstesten Probleme mit denen die Menschheit konfrontiert ist, aber auch als eine große Herausforderung.

- Sie meinen, dass der Kampf gegen den Klimawandel und eine effizientere Energienutzung zu einem Aufschwung der Wirtschaft und zur Schaffung neuer Jobs führen wird.

- Ebenso wird eine Reduktion der Importe fossiler Brennstoffe die Wirtschaft beleben und die Sicherung der Energieversorgung erhöhen.

- Die Bekämpfung des Klimawandels wird aber nur dann wirksam sein, wenn alle Länder der Welt gemeinsam handeln. Allerdings kann jeder dazu persönlich beitragen und der Großteil der Europäer hat auch schon diesbezügliche Maßnahmen gesetzt.

Der eben in Paris erwirkte, erste globale Klimavertrag ist auf der Basis erdrückender wissenschaftlicher Erkenntnisse entstanden. Die Wissenschaft konnte die Politik überzeugen und offensichtlich auch Europas Einwohner. Die gegenwärtige EU-Umfrage zeigt, dass das Vertragswerk auch im Sinne der Ansichten unserer Bevölkerung ist.

[1] Adoption of the Paris Agreement. Proposal by the President (12.12.2015). FCCC/CP/2015/L.9/Rev.1 http://unfccc.int/documentation/documents/advanced_search/items/6911.php...

[2] Special Eurobarometer 435. Climate Change (Fieldwork May – June 2015, published: 26. 11.2015) Report http://ec.europa.eu/COMMFrontOffice/PublicOpinion/index.cfm/Survey/getSu...

[3] Special Eurobarometer 435. Climate Change, Factsheets in national languages http://ec.europa.eu/COMMFrontOffice/PublicOpinion/index.cfm/Survey/getSu...

Der Boden – die Lösung globaler Probleme liegt unter unseren Füßen

Der Boden – die Lösung globaler Probleme liegt unter unseren FüßenFr, 11.12.2015 - 10:28 — Rattan Lal

![]() Böden sind nicht nur die Basis unserer Lebensführung, Nahrungsmittelproduktion und Wasserversorgung. Wie der weltbekannte Bodenwissenschafter Rattan Lal (Ohio State University) zeigt, besitzen Böden auch eine enorme Kapazität zur Kohlenstoffspeicherung und können damit wesentlich zur Regulierung der Treibhausgasemissionen beitragen*. Dieses Potential dürfte bei den Spitzen der Weltpolitik auf Resonanz stoßen: Als das „Internationale Jahr der Böden (IYS)“ im Hauptsitz der FAO am 5. Dezember 2015 feierlich zu Ende ging (die Klimakonferenz COP 21 in Paris läuft noch), appellierte Ban Ki Moon, der Generalsekretär der UNO an die Versammlung: “Wir müssen die nachhaltige Nutzung unseres terrestrischen Ökosystems sicherstellen, während wir den Klimawandel und seine Folgen bekämpfen. Die Speicherung von Kohlenstoff in den Böden bedeutet einen essentiellen Beitrag zur Eindämmung des Klimawandels“. Der nachfolgende Essay ist die Fortsetzung des vor einer Woche erschienenen Artikels:“Der Boden – Grundlage unseres Lebens“**

Böden sind nicht nur die Basis unserer Lebensführung, Nahrungsmittelproduktion und Wasserversorgung. Wie der weltbekannte Bodenwissenschafter Rattan Lal (Ohio State University) zeigt, besitzen Böden auch eine enorme Kapazität zur Kohlenstoffspeicherung und können damit wesentlich zur Regulierung der Treibhausgasemissionen beitragen*. Dieses Potential dürfte bei den Spitzen der Weltpolitik auf Resonanz stoßen: Als das „Internationale Jahr der Böden (IYS)“ im Hauptsitz der FAO am 5. Dezember 2015 feierlich zu Ende ging (die Klimakonferenz COP 21 in Paris läuft noch), appellierte Ban Ki Moon, der Generalsekretär der UNO an die Versammlung: “Wir müssen die nachhaltige Nutzung unseres terrestrischen Ökosystems sicherstellen, während wir den Klimawandel und seine Folgen bekämpfen. Die Speicherung von Kohlenstoff in den Böden bedeutet einen essentiellen Beitrag zur Eindämmung des Klimawandels“. Der nachfolgende Essay ist die Fortsetzung des vor einer Woche erschienenen Artikels:“Der Boden – Grundlage unseres Lebens“**

„Böden sind die Grundlage irdischen Lebens, der Nutzungsdruck durch den Menschen erreicht aber kritische Grenzen. Ein sorgsamer Umgang mit dem Boden ist essentieller Bestandteil einer nachhaltigen Landwirtschaft und bietet auch einen wertvollen Ansatz zur Regulierung des Klimas und einen Weg die Leistungen des Ökosystems und die Biodiversität zu erhalten.“ (Präambel: World Soil Charter, FAO, 2015)

Was ist nachhaltige Bodennutzug?

Meiner Meinung nach bedeutet das:

- Ersetze, was entfernt wurde – wenn Nährstoffe verloren gingen, ersetze sie.

- Reagiere umsichtig auf veränderte Bedingungen - wenn die Struktur eines Bodens (die räumliche Anordnung der Bodenteilchen) geändert wurde, ist davon auch seine Wasserbindungskapazität betroffen.

- Mach Dir bewusst, was anthropogene und natürliche Störungen bewirken können und sei bereit diesen zu begegnen.

Will man eine sichere Ernährungslage für die steigende Weltbevölkerung gewährleisten, muss die nachhaltige Landnutzung gleichzeitig aber auch mit einer nachhaltigen Intensivierung der Produktivität verbunden sein. Wir können ein „Mehr aus Weniger“ produzieren: ein Mehr

- auf weniger Landfläche

- pro jeden Tropfen Wasser

- pro Menge an eingesetztem Dünger und Pestiziden

- pro Energieeinheit pro Einheit der CO2-Emission

Dazu kommt, dass wir auch weniger verbrauchen und weniger vergeuden dürfen.

Ernterückstände zur Erzeugung von Biotreibstoff?

Die Erzeugung von Biotreibstoff ist zweifellos eine wichtige Strategie, um die Abhängigkeit von fossilen Brennstoffen zu verringern. Ist es ökonomisch vertretbar Ernterückstände dafür einzusetzen? Welche Folgen hat das für den Boden?

Ich möchte dazu von einem Langzeitexperiment berichten, das wir von 1972 bis 1987 in Nigeria durchführten. Die Fragestellung war: was passiert, wenn ein Landwirt nach jeder Ernte die Ernterückstände komplett entfernt (in Afrika wird dieses Material ja für Zäune, Dächer, Einstreu, Brennmaterial, etc. verwendet) oder, wenn er sie am Feld belässt. In beiden Fällen wurden dieselben Pflanzen angebaut und es wurde in derselben Weise gedüngt. Nach 15 Jahren war der Unterschied nur zu deutlich (Abbildung 1).

Der Grund für diesen Unterschied: durch die exzessive Entfernung der Ernterückstände wurde den Mikroorganismen und Tieren, die im Boden leben, die Nahrungsquelle entzogen. Bodenorganismen sind aber der biologische Antrieb der Erde.

Abbildung 1. Was passiert, wenn über längere Zeit die Ernterückstände vom Feld entfernt wurden? Dies war auf dem Maisfeld im Vordergrund 15 Jahre lang der Fall, während auf dem ansonsten gleichbehandelten Feld im Hintergrund die Rückstände belassen wurden.

Abbildung 1. Was passiert, wenn über längere Zeit die Ernterückstände vom Feld entfernt wurden? Dies war auf dem Maisfeld im Vordergrund 15 Jahre lang der Fall, während auf dem ansonsten gleichbehandelten Feld im Hintergrund die Rückstände belassen wurden.

Sind ähnliche Auswirkungen auch in Gegenden mit gemäßigtem Klima zu erwarten?

Wir starteten dazu einen in gleicher Weise designten Langzeitversuch in Ohio. 8 Jahre nach Beginn der Studie – das war 2012 – gab es in den US ein besonders trockenes Jahr (es fielen 50 % der üblichen Regenmenge). Dort, wo die Ernterückstände immer entfernt worden waren fiel die Maisernte, um 60 % niedriger aus als auf dem Feld, auf dem die Rückstände belassen wurden. Der Verbleib der Rückstände machte den Boden offensichtlich gegen Trockenheit widerstandsfähiger!

Derartige Auswirkungen auf die Produktivität muss man sich überlegen, wenn man Ernterückstände zur Produktion von Bioethanol heranziehen möchte. Biotreibstoff aus Ernterückständen ist nicht gratis! Man zahlt dafür einen sehr hohen Preis.

Man sollte also die Biomasse liegenlassen – für die aktiven Bodenorganismen, die den Boden lebendig erhalten. Da Mikroorganismen die Kohlenstoffverbindungen der Biomasse in ihre eigene Biomasse umwandeln, ist dies eine sehr effiziente Strategie, um organischen Kohlenstoff in den Böden („soil organic carbon“ SOC) zu binden und zu speichern (Kohlenstoff-Biosequestrierung).

Biosequestrierung des CO2 der Atmosphäre

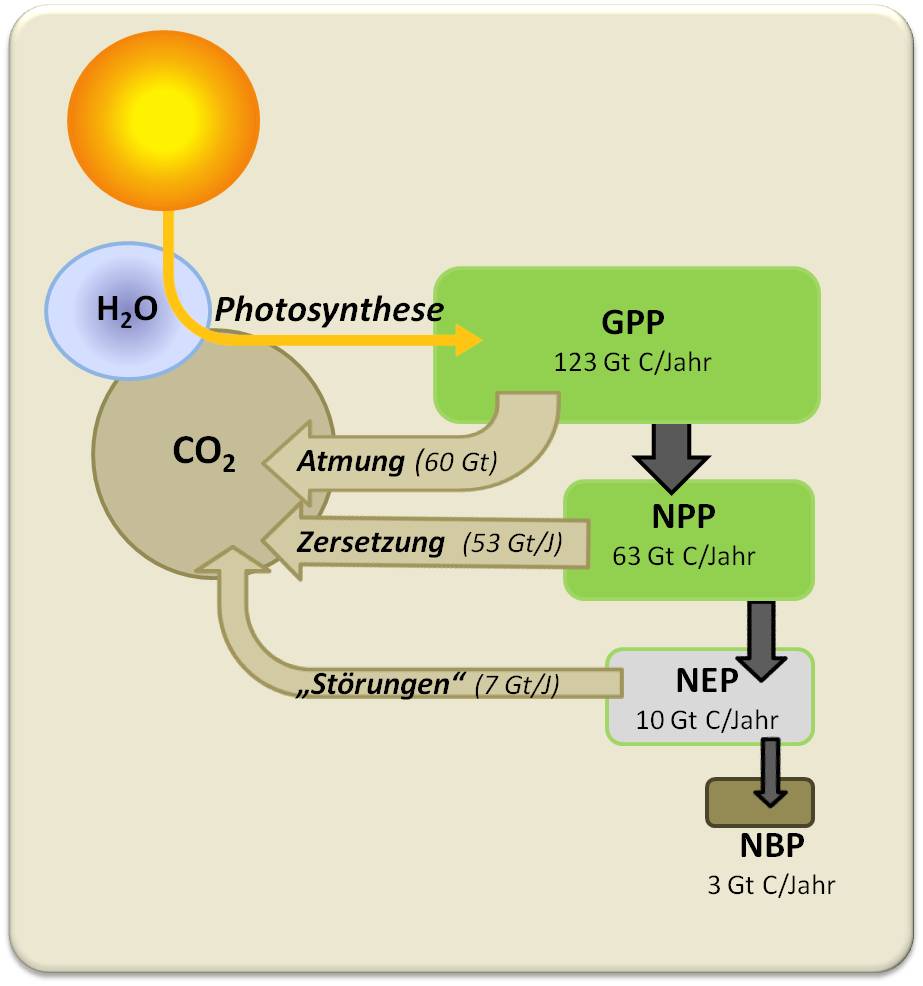

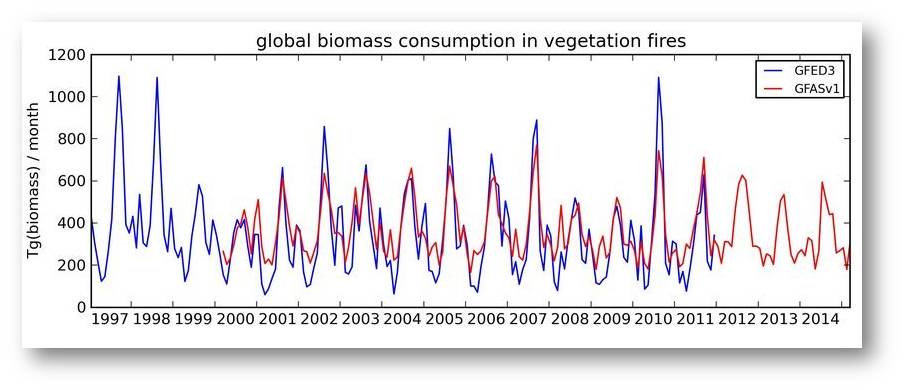

Wieviel CO2 aus der Atmosphäre in Biomasse umgewandelt wird, ist in Abbildung 2 schematisch dargestellt:

Abbildung 2. Die globale terrestrische Bindung und Speicherung von Kohlenstoff. GPP: Bruttoprimärproduktion durch autotrophe Pflanzen. NPP: Nettoprimärproduktion (= GPP minus Abatmung durch autotrophe Pflanzen). NEP: Nettoproduktion des Ökosystem (= GPP minus Zersetzung: Abatmung durch heterotrophe Organismen/mikrobiellen Abbau). NBP: Nettoproduktion aller Ökosysteme (alle natürlichen und anthropogenen Störungen miteingerechnet). Gt: Gigatonne = 1Mrd t.

Abbildung 2. Die globale terrestrische Bindung und Speicherung von Kohlenstoff. GPP: Bruttoprimärproduktion durch autotrophe Pflanzen. NPP: Nettoprimärproduktion (= GPP minus Abatmung durch autotrophe Pflanzen). NEP: Nettoproduktion des Ökosystem (= GPP minus Zersetzung: Abatmung durch heterotrophe Organismen/mikrobiellen Abbau). NBP: Nettoproduktion aller Ökosysteme (alle natürlichen und anthropogenen Störungen miteingerechnet). Gt: Gigatonne = 1Mrd t.

Von der Sonnenstrahlung, die die Erdoberfläche erreicht, nutzen die Pflanzen nur etwa 0,05 % der Energie, um mittels Photosynthese das CO2 der Luft und Wasser in organische Kohlenstoffverbindungen – insgesamt 123 Gt/Jahr – umzuwandeln. Etwa die Hälfte dieser sogenannten Bruttoprimärproduktion (gross primary production - GPP) atmen die Pflanzen als CO2 wieder ab - die Nettoprimärproduktion (net primary production - NPP) beträgt jährlich also insgesamt 63 Gigatonnen (Gt) organisch fixierten Kohlenstoffs. Davon wird ein Großteil durch heterotrophe Atmung zersetzt – über Aufnahme und Abbau entlang der Nahrungskette und mikrobielle Zersetzung von totem Material – aber auch durch große Flächenbrände: die Nettoproduktion des Ökosystems (net ecosystem productivity - NEP) liegt bei 10 Gt organisch fixierten Kohlenstoffs. Alle durch natürliche und anthropogene Störungen verursachten Verluste zusammengerechnet verbleibt rund 1 Gt organisch fixierter Kohlenstoff (net biome productivity – NBP).

Kohlenstoffspeicherung im Boden

In der Nettoprimärproduktion entstehen jährlich 63 Gt organisch fixierten Kohlenstoffs: in der gleichen Zeit generieren wir 6 x so hohe Emissionen aus dem Verbrauch fossiler Brennstoffe und zusätzlich aus der landwirtschaftlichen Bodennutzung. Wenn wir steuern können, was mit der wichtigen Kohlenstoffquelle der Nettoprimärproduktion geschieht, können wir das Problem des CO2 in der Atmosphäre in den Griff bekommen.

Die Frage ist, wie wir das schaffen.

Wenn wir den globalen Kohlenstoffgehalt im Boden betrachten, so liegen bis zu einer Tiefe von 2 – 3 m rund 6 000 Gt C vor; zwei Drittel bis drei Viertel (in den obersten 30 cm) davon in Form von organisch gebundenem Kohlenstoff.

Wie und wieweit können wir diesen Kohlenstoffgehalt erhöhen?

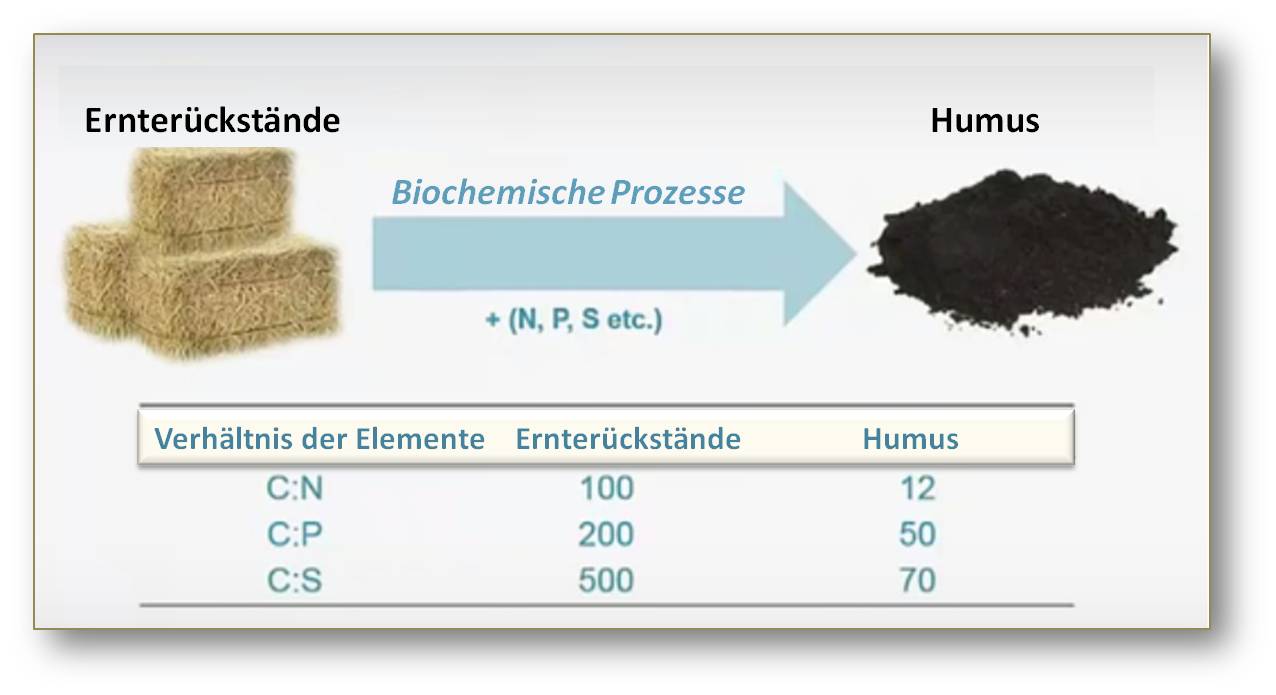

Hier wird sehr schnell klar: mit dem Zufügen von Biomasse allein – beispielsweise in Form von Ernterückständen - ist es nicht getan. Diese bewirken zwar, dass der Boden seine Feuchtigkeit behält, die biochemische Umwandlung in Humus erfordert aber zusätzliche Nährstoffe. Denn: Im Vergleich zum Humus ist der Gehalt von N, P und Schwefel in den Rückständen stark abgereichert (Abbildung 3).

Abbildung 3. Es werden Nährstoffe gebraucht um Biomasse in Humus umzuwandeln

Abbildung 3. Es werden Nährstoffe gebraucht um Biomasse in Humus umzuwandeln

Ohne den Zusatz der Nährstoffe kann also keine Humusbildung erfolgen – der Kohlenstoff wird bloß als CO2 in die Atmosphäre abgeatmet.

Der Kohlenstoffkreislauf ist eng gekoppelt an die Kreisläufe von Wasser, Stickstoff, Phosphor und Schwefel.

Was kostet die Kohlenstoff-Sequestrierung?

Die Nährstoffe und damit die Kohlenstoff-Sequestrierung sind nicht gratis. Meine Schätzungen gehen dahin, dass der Gegenwert für die Speicherung von 1 t Kohlenstoff etwa 120 $ beträgt. Jemand muss also dafür zahlen. Da Landwirte der gesamten Gesellschaft nützen, wenn den atmosphärischen Kohlenstoff durch Sequestrierung reduzieren, müssen sie dafür entsprechend entschädigt werden.

Wir benötigen solide wissenschaftliche Daten

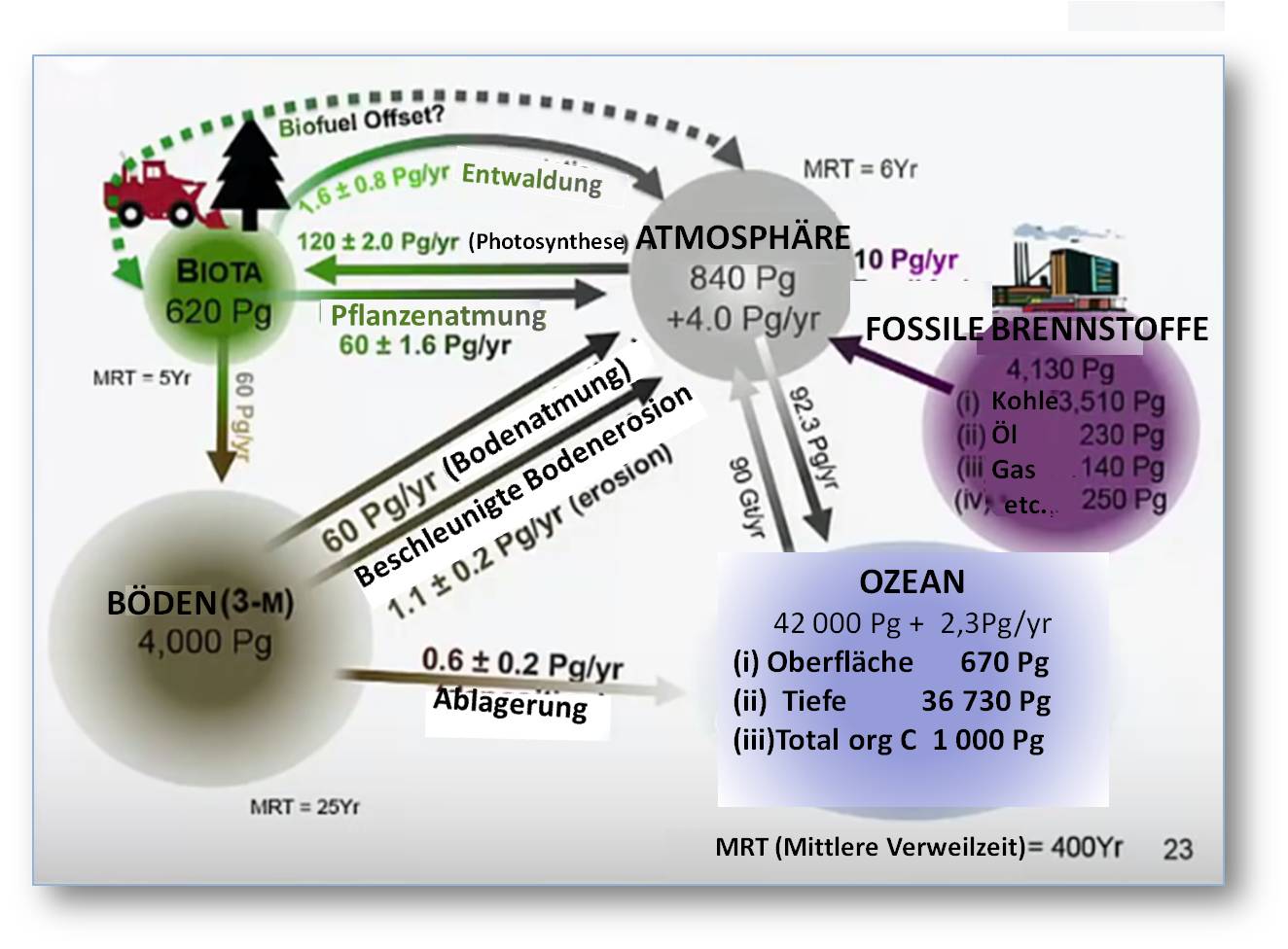

Die C-Sequestrierung setzt auch eine detaillierte Kenntnis des Kohlenstoffkreislaufs voraus. Dieser ist in groben Zügen in Abbildung 4 dargestellt:  Abbildung 4. Der globale Kohlenstoffkreislauf – Kohlenstoffsenken und -emittenten (1Pg = 1Gt)

Abbildung 4. Der globale Kohlenstoffkreislauf – Kohlenstoffsenken und -emittenten (1Pg = 1Gt)

Der Kohlenstoffpool in der Atmosphäre beträgt zurzeit rund 840 Gt - Jährlich kommen 4 Gt aus der Verwendung fossiler Brennstoffe dazu und 1 Gt aus der Entwaldung. Die Photosynthese der Pflanzen entzieht CO2 der Atmosphäre und atmet die Hälfte davon wieder ab. Emissionen kommen auch aus den Böden, in denen (ohne Permafrostgebiete) etwa 4 000 Gt organischer Kohlenstoff gespeichert sind: Bodenatmung und beschleunigte Erosion führen zur Reduktion des organisch gebundenen Kohlenstoffs. (Aktuell wird der Verlust durch Erosion allerdings kaum diskutiert). Ein Teil des C im Boden geht auch in den Ozean, der das größte Kohlenstoffreservoir ist und Kohlenstoff ebenfalls emittiert.

Wir können dieses Geschehen modellieren, auch die Verweilzeit des Kohlenstoffs in den einzelnen Systemen berechnen – auf globaler Basis, auf nationaler Basis bis hin zur Verweilzeit auf einzelnen Landflächen (siehe Abbildung 4). Die Voraussetzung dazu: um die Modelle, die diesen Berechnungen zugrundeliegen, zu validieren, benötigen wir solide Daten, experimentell erhobene Daten.

Der Verlauf der Kohlenstoffanreicherung

Wenn Wälder oder Grasland in Ackerland umgewidmet werden, sinkt der Kohlenstoffgehalt im Boden auf etwa 50 % und wird durch Erosion weiter reduziert. Wird die Erosion unter Kontrolle gebracht, ist nach etwa 50 Jahren im gemäßigten Klima und nach vielleicht 10 Jahren im tropischen Klima (etwa in Nigeria) ein neuer Gleichgewichtszustand erreicht. Wenn zu diesem Zeitpunkt Maßnahmen ergriffen werden –beispielsweise hinsichtlich der Ernterückstände -, so kann der C-Gehalt über Jahre hinweg wieder ansteigen bis ein neues Gleichgewicht erreicht ist, wobei der so erreichbare C-Gehalt aber niedriger ist als der ursprüngliche. Unter Einsatz weiterer Technologien – etwa Abdecken der Felder, Zugabe von Nährstoffen, Biokohle, Düngemitteln – kann vielleicht auch ein maximaler Kohlenstoffgehalt erreicht werden, der dem des Ausgangszustands entspricht, in manchen Fällen diesen sogar übertreffen kann. Der Unterschied zwischen Minimum und Maximum gibt die Kapazität des Bodens als Kohlenstoffsenke an.

Wie schnell die C-Anreicherung im Boden erfolgt, muss experimentell bestimmt werden. Und es muss auch herausgefunden werden, welche Verfahren sich dazu am besten eignen. Zur Anwendung können u.a. kommen: konservierender Ackerbau, Anwendung von Biokohle, Agrarforstwirtschaft, Aufforstung, Bekämpfung von Wüstenbildung, Wasserspeicherung, unterschiedliche Landwirtschaftssysteme. Es gibt kein einzelnes Verfahren, das für alle Böden der Erde (davon gibt es mehrere hunderttausende verschiedene Typen) taugt.

Für eine nachhaltige Bodenbewirtschaftung - 10 grundsätzliche Regeln

- 1. Ursachen der Bodendegradation. Die Verschlechterung der Böden ist ein biophysikalischer Prozess, der ökonomische, soziale und politische Ursachen hat. Die Gefährdung der Böden liegt aber eher in dem „wie“ als in dem „was“ kultiviert wird.

- 2. Verantwortung für die Böden und menschliches Leid. Bevor Menschen für ihre Böden verantworlich gemacht weden können, müssen zuerst ihre existenziellen Grundbedürfnisse gesichert sein.

- 3. Nährstoffe, Kohlenstoff, Wasser. Ohne die Bodenqualität zu beeinträchtigen ist es unmöglich mehr dem Boden zu entnehmen als man eingesetzt hat. Nur, wenn das Entnommene – Kohlenstoff, Nährstoffe, Wasser - ersetzt wird, bleibt der Boden fruchtbar und lässt sich steuern.

- 4. Marginalitätsprinzip. Schlechte Böden, die mit marginalem Einsatz bebaut werden, erbringen marginale Erträge und ein marginales Leben. Nur qualitativ gute Böden und gutes Saatgut erzielen gute Erträge und ermöglichen ein gutes Leben.

- 5. Organische vs. mineralische Nährstoffe. Pflanzen können nicht unterscheiden ob Nitrate oder Phosphate aus Mineraldünger oder organischen Quellen stammen. Es ist eine Frage der Logistik – können wir auf 1 500 Mio ha jährlich 10 Tonnen Stallmist/Jauche aufbringen, transportieren? (Wenn ja, ist dies sicherlich die beste Lösung). Unsere Strategie muss lauten: mehr aus weniger zu erzeugen!

- 6. Kohlenstoff im Boden und Treibhausgase. Es hat den gleichen Effekt auf das Klima ob nun CO2 aus dem organisch gebundenen Kohlenstoff der Böden emittiert wird oder ob es bei der Verbrennung fossiler Brennstoffe oder der Trockenlegung von Mooren entsteht. Abhängig davon wie er bearbeitet wird, kann der Boden kann eine Quelle oder auch eine Senke von Treibhausgasen sein.

- 7. Boden und Saatgut. Spitzensaatgut kann nur dort Erfolg haben, wo es unter optimalen Bedingungen wächst. Auch Spitzensorten können Wasser und Nährstoffe nicht aus jedem Boden (beispielsweise aus Felsen).

- 8. Boden als Senke für atmosphärisches CO2 Böden sind integraler Bestandteil jeder Strategie zur Reduktion der Klimaerwärmung und zum Schutz der Umwelt.

- 9. Motor der ökonomischen Entwicklung. Nachhaltige Bodenbearbeitung ist Motor der ökonomischen Entwicklung, der politischen Stabilität und des Wandels der Bevölkerung vor allem in den Entwicklungsländern.

- 10. Moderne Innovationen - tradiertes Wissen. Nachhaltige Bodenbearbeitung bedeutet die Anwendung moderner Innovationen, die auf überliefertem Wissen beruhen. Wir können die Krankheiten von heute nicht mit der Medizin von gestern heilen – wir können aber auf dieser aufbauen!

Ausblick

Wenn ich nächstes Jahr die Präsidentschaft der International Union of Soil Sciences (IUSS) antrete, kommt die schwierige Aufgabe auf mich zu, einen Fahrplan für die Bodenwissenschaften im 21. Jahrhundert zu skizzieren.

Ich beginne also auf dieser Straße zu fahren und sehe ich meinen ersten Halt in der Periode 2015 – 2025. Welche Aufgaben kommen hier auf die Bodenwissenschaften zu? Ich denke es sind dies:

- Nachhaltige Intensivierung der Produktivität

- Steuerung des Phytobioms (d.i. alle Faktoren die Pflanzen beeinflussen oder von Pflanzen beeinflusst werden)

- Entwicklung von Böden, die Pflanzenkrankheiten unterdrücken (sodass keine Pflanzenschutzmittel mehr nötig sind)

- Urbane Landwirtschaft

- Weltraum-Landwirtschaft (Versuche auf dem Mond oder Mars)

- Sequestrierung von Kohlenstoff in Boden und Biosphäre (ich hoffe diese enorm wichtige Aufgabe wird bei der COP 21 Zustimmung finden)

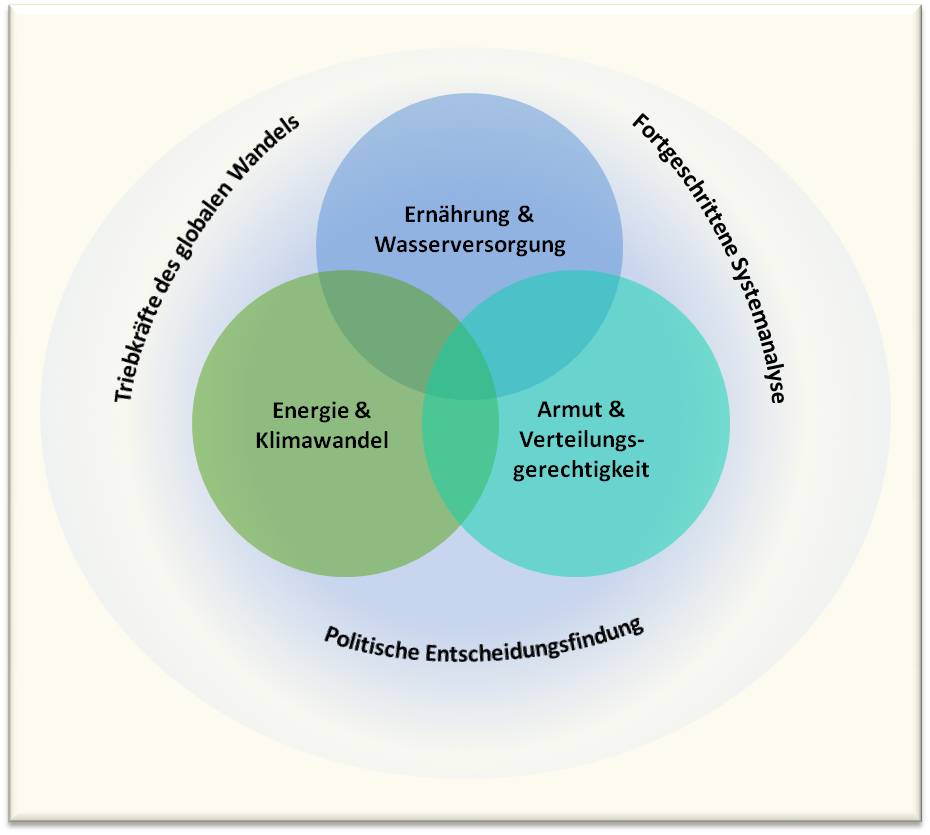

- Der Nexus Ansatz (die Sicherstellung von Wasser, Energie und Nahrung, die miteinander verknüpft sind).

Wenn ich auf dieser Straße weiterfahre, sehe ich für den nächsten Abschnitt in der Periode 2025 – 2050 weitere Herausforderungen:

- Entwicklung einer Nährwert-bezogenen Landwirtschaft (wir müssen dem versteckten Hunger den Kampf ansagen, dem Mangel an Vitaminen und Mineralstoffen)

- Auffinden von pharmazeutisch wirksamen Stoffen(der Großteil derartiger Substanzen sind Naturstoffe)

- Herstellung synthetischer Böden und von

- Böden aus extraterrestrischen Komponenten

- Untersuchung von Bodenprozessen bei verringerter Schwerkraft

- Bodenumwandlungen und Klimawandel

Als großes Ziel sollte eine Landwirtschaft mit Null Emissionen angestrebt werden.

*Rattan Lal; 27.11.2015 Boden - Der große Kohlenstoffspeicher **Prof. Rattan Lal hat seinen Vortrag „The Solutions Underfoot: The Power of Soil“ (gehalten am 2. November 2015 im Konferenzzentrum Laxenburg) freundlicherweise dem ScienceBlog zur Verfügung gestellt. Mit seinem Einverständnis wurde der Vortrag transkribiert, daraus eine deutsche Version geschaffen und diese geringfügig für den Blog adaptiert. Auf Grund der Länge des Artikels ist dieser in zwei Teilen erschienen (Teil 1 am 4. Dezember 2015). Ein Video-Mitschnitt des Vortrags kann abgerufen werden unter: https://www.youtube.com/watch?v=Uh0TwQyw37A&feature=youtu.be

Weiterführende Links

- Bodenatlas - Daten und Fakten über Acker, Land und Erde (Kooperationsprojekt zum internationalen Jahr des Bodens von Heinrich-Böll-Stiftung, IASS, BUND, Le Monde diplomatique, 2015. Alle Grafiken und Texte stehen unter der offenen Creative Commons Lizenz CC-BY-SA ) https://www.bund.net/fileadmin/bundnet/publikationen/landwirtschaft/1501...

- G. Miehlich: Böden – alles Dreck oder was? Gedanken zum Internationalen Jahr des Bodens. https://www.geo.uni-hamburg.de/bodenkunde/service/publrel/pdf/miehlich-2...

- Globale Landflächen und Biomasse nachhaltig und Ressourcen schonend nutzen (Umweltbundesamt, Oktober 2012) https://www.umweltbundesamt.de/sites/default/files/medien/479/publikatio...

- Sustainable Development Goals: http://www.entwicklung.at/aktuelles/neue-globale-ziele/

- Let's talk about soil. Video (deutsch): https://vimeo.com/53674443

Artikel zum Thema „Boden“ im ScienceBlog:

- Rattan Lal; 04.12.2015: Der Boden – Grundlage unseres Lebens

- Rattan Lal; 27.11.2015: Boden – Der große Kohlenstoffspeicher

- Hans-Rudolf Bork; 14.11.2014: Die Böden der Erde: Diversität und Wandel seit dem Neolithikum

- Reinhard F. Hüttl; 01.08.2014: Vom System Erde zum System Erde-Mensch

- Julia Pongratz & Christian Reick; 18.07.2014: Landwirtschaft pflügt das Klima um

- Gerhard Glatzel; 21.03.2013: Rückkehr zur Energie aus dem Wald – mehr als ein Holzweg? Teil 1 – Energiewende und Klimaschutz (insg. 3 Teile)

- Gottfried Schatz; 06.08.2013: Erdfieber — Das Unbehagen der Wissenschaft bei der Klimadebatte

- Gerhard Glatzel; 24.01.2013: Umweltökologie und Politik - Der Frust der nicht gehörten Wissenschaftler

- Gerhard Glatzel; 28.06.2011: Hat die Menschheit bereits den Boden unter den Füßen verloren?

Der Boden – Grundlage unseres Lebens

Der Boden – Grundlage unseres LebensFr, 04.12.2015 - 07:30 — Rattan Lal

![]() Die vielen miteinander konkurrierenden Nutzungen des Bodens durch die noch immer wachsende Weltbevölkerung machen ihn zur stark gefährdeten Ressource. Der sorgsame, nachhaltige Umgang mit dem Boden und die Wiederherstellung degradierter und verarmter Böden sind daher unerlässlich, sie sind die Lösung wesentlicher globaler Probleme des 21. Jahrhunderts . Rattan Lal (Ohio State University), einer der weltweit führenden Bodenwissenschaftler, zeigt hier die Bedeutung des Bodens und seine Rolle im globalen ökologischen Wandel auf.*

Die vielen miteinander konkurrierenden Nutzungen des Bodens durch die noch immer wachsende Weltbevölkerung machen ihn zur stark gefährdeten Ressource. Der sorgsame, nachhaltige Umgang mit dem Boden und die Wiederherstellung degradierter und verarmter Böden sind daher unerlässlich, sie sind die Lösung wesentlicher globaler Probleme des 21. Jahrhunderts . Rattan Lal (Ohio State University), einer der weltweit führenden Bodenwissenschaftler, zeigt hier die Bedeutung des Bodens und seine Rolle im globalen ökologischen Wandel auf.*

„Hallo, Ihr Leute. Wisst Ihr wer ich bin, was ich bin?

Ich bin die Geomembran der Erde. Ich bin der Euch schützende Filter, Euer Puffer, Euer Vermittler von Energie, Wasser und biogeochemischen Stoffen. Ich bin der Erhalter Eures fruchtbaren Lebens, bin Quelle der Elemente und Lebensraum für den Großteil der Organismen. Ich bin die Grundlage, die Euch trägt, die Wiege Eurer Mythen und der Staub, aus dem Ihr wiederkehrt. Ich bin ein Boden!“ (Richard Arnold) -

Mit diesen wenigen Worten hat der bekannte amerikanische Bodenwissenschafter Richard Arnold zusammengefasst was der Boden ist, was er vermag und welche fundamentale Rolle er für unsere Existenz spielt.

Der Boden reagiert auf (die von Menschen geschaffenen) globalen Herausforderungen und Probleme. Deren Lösungen finden wir - im wahrsten Sinn des Wortes - unter unseren Füßen.

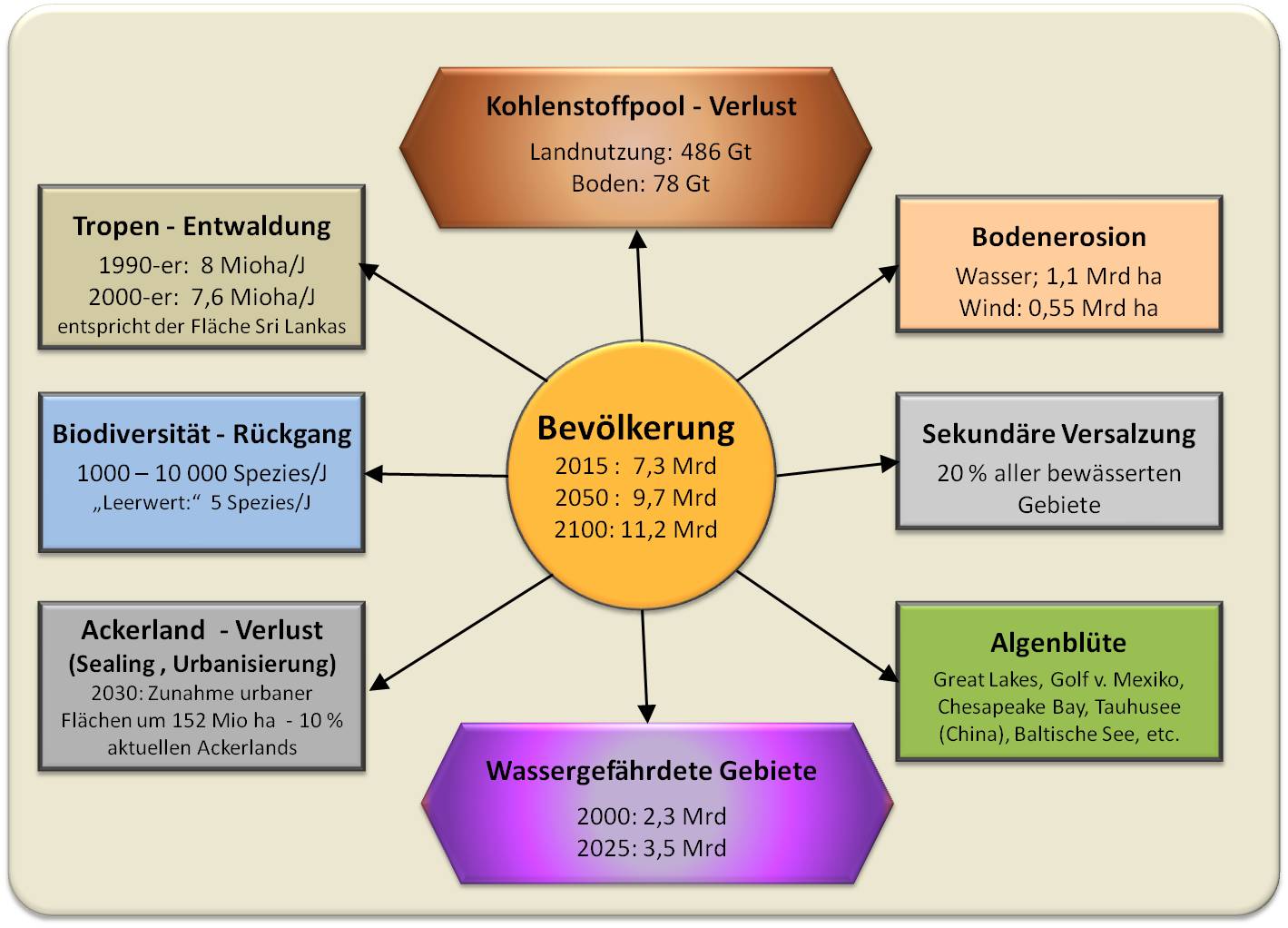

Auswirkungen des Menschen auf den Boden (Abbildung 1)

Ein zentraler Punkt ist die Zunahme der Weltbevölkerung. Gegenwärtig gibt es 7,3 Milliarden Menschen, im Jahr 2050 werden es 9,7 Milliarden sein - stellen Sie sich vor, es erscheinen zusätzliche 2,4 Milliarden Gäste zum Abendessen - und 11,2 Milliarden im Jahr 2100.

Bodendegradation ist ein Problem, vom dem rund 24 % der Landfläche betroffen sind: durch Wassererosion gingen bereits 1,1 Mrd ha verloren, durch Winderosion 0,55 Mrd. ha. (Unter Bodendegradation versteht man: dauerhafte/irreversible Veränderungen bis hin zum Verlust der Strukturen und Funktionen von Böden durch natürliche oder anthropogene Störungen)

Abbildung 1. Wechselbeziehungen zwischen Mensch und Ökosystem Boden. Mit dem enormen Anstieg der Weltbevölkerung entsteht ein immer stärkerer Nutzungsdruck auf das Ökosystem (Beschreibung im Text).

Abbildung 1. Wechselbeziehungen zwischen Mensch und Ökosystem Boden. Mit dem enormen Anstieg der Weltbevölkerung entsteht ein immer stärkerer Nutzungsdruck auf das Ökosystem (Beschreibung im Text).

Sekundäre Versalzung der Böden: diese tritt bei rund 20 % der bewässerten Landfläche - dies sind rund 300 Mio ha - auf.

Die Algenblüte ist Folge von Wasserverschmutzung, von übermäßigem Transport von Phosphor und anderen Elementen aus dem Agro-Ökosystem in das Wasser-Ökosystem. Vom Veralgen sind viele Wasserflächen betroffen, u.a. die großen Seen in den US, der Golf von Mexico.

Problem Urbanisierung: schon heute lebt die Hälfte der Weltbevölkerung bereits in Städten, im Jahr 2050 werden dies 60 – 70 % sein. Stadtgebiete werden bis 2030 um 152 Mio ha zugenommen haben. Dies entspricht 10 % der gesamten gegenwärtigen Ackerbaufläche.

Reduzierung der Biodiversität: mit dem Anstieg der menschlichen Bevölkerung geht ein sehr rascher Verlust an Arten einher – jährlich verschwinden 1000 bis zu 10 000 Spezies (ohne Einwirkung des Menschen wären es gerade 5 Spezies).

Entwaldung insbesondere in den Tropengebieten: in den 1990-er Jahren gingen dadurch jährlich 8 Mio ha verloren, in den 2000-er Jahren 7,6 Mio ha – dies bedeutet, dass jährlich Flächen in der Größe von Sri Lanka entwaldet werden.

Wasserressourcen: extensive Nutzung des - zum Teil fossilen – Grundwassers aus Grundwasserleitersystemen (Aquifere) führt zum drastischen Absinken der Grundwasserspiegel: einige Aquifere (u.a. der Ogallala Aquifer in den US, Aquifere in den Ebenen von Südasien und Nordchina) verzeichnen ein Absinken von bis zu 2 m im Jahr. Die Zahl der in Gebieten mit Wassermangel lebenden Menschen nimmt jedoch zu; waren es 2,3 Mrd im Jahr 2000, so werden es bereits 2025 schon 3,5 Mrd Menschen sein.

Emission von Treibhausgasen: Seit den Anfängen des Ackerbaus vor 10 000 Jahren haben wir aus dem gesamtem Kohlenstoffpool der terrestrischen Biosphäre – d.i. Vegetation und Böden zusammengenommen - bereits 486 Gigatonnen (Gt; 1 Gt = 1 Mrd t) Kohlenstoff in die Atmosphäre verloren. Aus den Böden des Ackerlands waren es nach meinen Schätzungen 80 Gt Kohlenstoff.

Böden sind endliche Ressourcen

Böden entstehen äußerst langsam - es dauert meistens mehrere tausend Jahre bis sich eine dünne fruchtbare Schicht gebildet hat. Böden sind daher in menschlichen Zeitdimensionen nicht erneuerbar. Zum Verbrauch der Ressource Boden tragen sehr, sehr viele Nutzungen bei, die miteinander konkurrieren: Landflächen dienen nicht nur der Landwirtschaft, sie werden der Industrialisierung gewidmet, der Urbanisierung einschließlich der notwendigen Infrastruktur (s.u.), der Schaffung von Erholungsräumen, u.a.m. Insbesondere greift auch die nutzungsbedingte Änderung der Artenvielfalt (der Bodenorganismen) in das System Boden ein. Dazu kommen viele weitere Öko-Dienstleistungen des Bodens, die wir noch sehr wenig verstehen.

Haben wir den „Peak Soil“ bereits überschritten?

Für viele knappe Ressourcen kann der Zeitverlauf der Gewinnung in Form einer glockenförmigen Kurve, wie der sogenannten „Hubbert Kurve“ dargestellt werden (benannt nach dem Geophysiker MK Hubbert, der mit dieser Kurve erstmals die Erdölförderung beschrieb): Am Beginn nimmt die Förderungsrate zu, bis ein Maximum – der Peak - erreicht ist. Dadurch werden die noch vorhandenen, endlichen Vorräte immer rascher aufgebraucht - ein exponentielles Abklingen der Förderrate ist die Folge. Es gibt einen „Peak Öl“, „Peak Phosphor“, „Peak Wasser“.

Ein derartiger Kurvenverlauf mit einem „Peak Soil“ erscheint auch für die Ressource Boden plausibel (Abbildung 2), der Peak dürfte hier aber schon überschritten sein. Nicht nur die Landwirtschaft, auch sehr viele andere Nutzungen konkurrieren ja um die endliche Ressource Boden (siehe oben). Naturschutz, die Erhaltung unserer Böden sind von unabdingbarer Wichtigkeit: „Peak Soil“ bedeutet gefährdete oder bereits tote Böden - ebenso wie gewisse Arten von Vögeln und Tieren können auch Böden gefährdet oder schon vernichtet sein. Als Beispiel sind hier weite Flächen der Sahel-Zone zu nennen – es sind tote Böden, die bereits fast einen halben Meter Dicke und ihre ursprüngliche Charakteristik eingebüßt haben. Ein hoffnungsloses Bild: Die Bodenerosion wird in Afrika besonders gravierend ausfallen: Schätzungen gehen davon aus, dass bis 2090 dort 36 % des Bodens von Erosion betroffen sein werden, während es im globalen Mittel 14 % sein werden.

Abbildung 2. Haben wir den „Peak Soil“ bereits überschritten? Hypothetischer Zeitverlauf der endlichen Ressource Boden. Rechts unten: der tote Boden in der Sahel Zone.

Abbildung 2. Haben wir den „Peak Soil“ bereits überschritten? Hypothetischer Zeitverlauf der endlichen Ressource Boden. Rechts unten: der tote Boden in der Sahel Zone.

Das Problem der steigenden Urbanisierung

Um für 1 Million Menschen Unterkunft und Infrastruktur zu schaffen werden 40 000 ha Land benötigt. Bei dem aktuellen Anstieg der Weltbevölkerung um 75 Millionen Menschen im Jahr bedeutet das, dass jährlich 3 Mio ha landwirtschaftlich nutzbare Flächen dafür umgewidmet werden müssen.

Mit der zunehmenden Verstädterung ist auch ein Wachsen der Megacities – d.i. von Städten mit mehr als 10 Millionen Einwohnern - verbunden: gibt es davon heute 28, werden es 2030 bereits 41 sein. Dies wirft enorme logistische Probleme auf. Eine Megacity mit 10 Mio Einwohnern benötigt täglich 6000 t Nahrungsmittel, die in die Stadt geliefert werden und nicht mehr an ihren Ursprungsort zurückkehren, die Abfälle verursachen und Umwelt und Gesundheit gefährden. In ausgedehnten Regionen, wo es wenige Bäume und Steine gibt – beispielsweise in Teilen NW-Indiens –wird zudem Boden abgetragen, um daraus Ziegel für den Hausbau zu produzieren.

Inwieweit können sich Böden erholen?

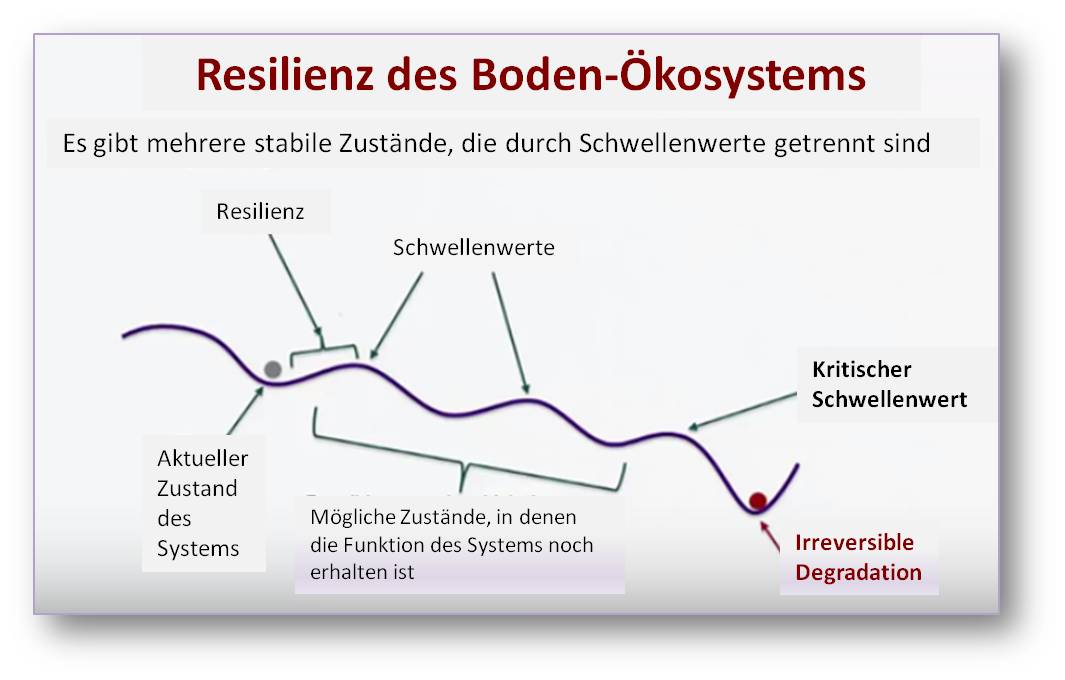

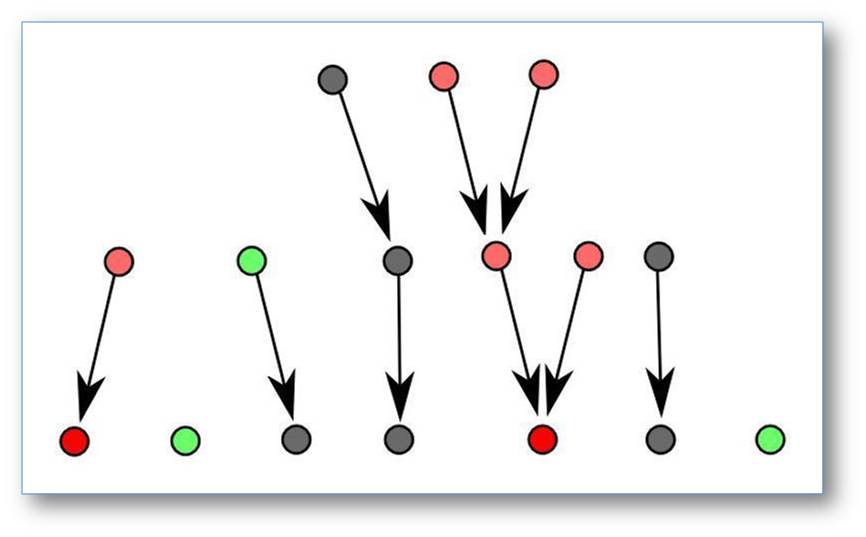

Die Fähigkeit eines Systems nach exogenen Störungen wieder zu seiner ursprünglichen Funktion zurückzukehren, wird als Resilienz (resilire = „zurückspringen“) bezeichnet. Der Boden verändert sich laufend. Als Folge von Störungen kann er eine Reihe von stabilen Zuständen einnehmen, in denen er seine Funktion (Produktivität) noch beibehält oder sich wieder erholt. Dies ist in Abbildung 3 vereinfacht dargestellt. Diese Resilienz ist gegeben, solange die Störungen mäßig ausfallen. Überschreiten sie aber einen kritischen Schwellenwert, so kann der Boden nicht in seinen vorherigen Status zurückkehren, sich nicht mehr erholen – sein Charakter und seine Funktion sind verloren gegangen (wie es beispielweise bei den erwähnten toten Böden in der Sahel Zone der Fall ist), er ist irreversibel degradiert.

Abbildung 3. Die Resilienz des Boden-Ökosystems. Der funktionsfähige Boden - hier durch eine graue Kugel gekennzeichnet- behält bei mäßigen Störungen die Funktion bei. Bei Überschreiten des kritischen Schwellenwertes kann das System nicht mehr in einen funktionsfähigen Zustand zurückkehren, sein Charakter ist verloren gegangen (rote Kugel).

Abbildung 3. Die Resilienz des Boden-Ökosystems. Der funktionsfähige Boden - hier durch eine graue Kugel gekennzeichnet- behält bei mäßigen Störungen die Funktion bei. Bei Überschreiten des kritischen Schwellenwertes kann das System nicht mehr in einen funktionsfähigen Zustand zurückkehren, sein Charakter ist verloren gegangen (rote Kugel).

Was sind nun die wesentlichen Eigenschaften der Böden? und Was sind die Schwellenwerte? Hier müssen wir erst die zugrunde liegenden wissenschaftlichen Prinzipien verstehen, um geeignete Maßnahmen treffen zu können, bevor der kritische Schwellenwert überschritten wird, der zur irreversiblen Degradation führt.

Die landwirtschaftliche Bodennutzung

Analysiert man die gegenwärtige Landnutzung, so

- beansprucht die Landwirtschaft - das heißt Ackerbau und Viehzucht - rund 40 % der globalen Landflächen. Davon sind 75 % - rund 3,7 Mrd ha – der Viehzucht gewidmet (teilweise kann auf diesen Flächen auch nichts anderes gemacht werden),

- werden für die Bewässerung dieser Flächen rund 70 % des globalen Süßwassers verbraucht,

- werden 30 – 35 % der globalen Treibhausgas-Emissionen durch die landwirtschaftliche Nutzung hervorgerufen.

Dennoch: für 1 von 7 Menschen – d.i. für mehr als 1 Mrd Menschen - ist die Ernährungslage unsicher und, 2 – 3 von 7 Menschen gelten als mangelernährt.

Der Nahrungsmittelbedarf in der Zukunft

Wie kann der Ernährungsbedarf beispielsweise im Jahr 2050 – bei einem Zuwachs von rund 2,4 Mrd Menschen - sichergestellt werden?

Die häufige Antwort darauf: indem wir die landwirtschaftlich genutzten Flächen erweitern. Natürliche Ökosysteme – seien es nun Wälder, Steppen oder Feuchtgebiete – in Ackerbau- und Viehzuchtsgebiete umwandeln.

Diese Anschauungen kann ich nicht teilen! Ich meine, wir müssen andere Wege ins Auge fassen und die Natur vor weiterer Ausbeutung schützen. Es gibt dazu eine Reihe von Möglichkeiten. Vorauszuschicken ist dabei, dass global gesehen bereits ausreichend Nahrungsmittel produziert werden, um auch 10 Mrd Menschen zu ernähren. Eine sichere Ernährungslage kann gewährleistet werden, indem

- Abfälle drastisch (um 30 – 50 %) reduziert werden,

- der Zugang zu Nahrungsmitteln erleichtert wird – Maßnahmen gegen Armut, Ungleichheit, politische Instabilitäten und Konflikte ergriffen werden,

- die Verteilung von Nahrungsmitteln global verbessert wird,

- mehr pflanzlich basierte Nahrung zum Einsatz kommt (dies bedeutet nicht den Verzicht auf Nahrung tierischen Ursprungs, sondern, dass vielleicht nicht alle drei Mahlzeiten täglich vom Tier kommen),

- persönliche Verantwortung übernommen wird, nichts als selbstverständlich vorausgesetzt wird. Jeder von uns ist „Täter“ und „Opfer“. Wenn jeder auch nur eine geringfügige Verbesserung bewirkt: bei 7,3 Mrd Menschen kann dies eine enorme Auswirkung haben,

- die Produktivität der bereits landwirtschaftlich genutzten Flächen erhöht wird, degradiertes Land wiederhergestellt wird. Mit den gegenwärtigen etablierten Technologien kann in vielen Regionen Afrikas (wo ich 20 Jahre lang gearbeitet habe) und auch in Südasien der Ertrag des Ackerlands um das Doppelte ja sogar um das Vierfache gesteigert werden.

Warum sollte man also die vorhandenen Ressourcen nicht in angemessener Weise nutzen, bevor man daran denkt ursprüngliches Land in Kulturland umzuwandeln?

Ernährungssicherheit zu erreichen, Landökosysteme zu schützen, wiederherstellen und eine nachhaltige Landwirtschaft zu fördern: diese Ziele gehören auch zu den „Sustainable Development Goals“ (SDGs; „Zielen nachhaltiger Entwicklung“), welche die Vereinten Nationen im September 2015 verabschiedet haben. Es sind dies 17 Hauptziele mit 169 Unterzielen, die für alle Staaten Gültigkeit haben und - mit einer Laufzeit von 15 Jahren - am 1.Jänner 2016 in Kraft treten.

*Prof. Rattan Lal hat freundlicherweise seinen Vortrag „The Solutions Underfoot: The Power of Soil“ (gehalten am 2. November 2015 im Konferenzzentrum Laxenburg) dem ScienceBlog zur Verfügung gestellt. Mit seinem Einverständnis wurde der Vortrag transkribiert, übersetzt und geringfügig für den Blog adaptiert. Auf Grund der Länge des Artikels erscheint dieser in zwei Teilen (Teil 2 am 11. Dezember 2015). Ein Video-Mitschnitt des Vortrags kann abgerufen werden unter: https://www.youtube.com/watch?v=Uh0TwQyw37A&feature=youtu.be.

Weiterführende Links

- Bodenatlas - Daten und Fakten über Acker, Land und Erde (Kooperationsprojekt zum internationalen Jahr des Bodens von Heinrich-Böll-Stiftung, IASS, BUND, Le Monde diplomatique, 2015. Alle Grafiken und Texte stehen unter der offenen Creative Commons Lizenz CC-BY-SA ) https://www.bund.net/fileadmin/bundnet/publikationen/landwirtschaft/1501...

- G. Miehlich: Böden – alles Dreck oder was? Gedanken zum Internationalen Jahr des Bodens. https://www.geo.uni-hamburg.de/bodenkunde/service/publrel/pdf/miehlich-2...

- Globale Landflächen und Biomasse nachhaltig und Ressourcen schonend nutzen (Umweltbundesamt, Oktober 2012) https://www.umweltbundesamt.de/sites/default/files/medien/479/publikatio...

- Sustainable Development Goals http://www.entwicklung.at/aktuelles/neue-globale-ziele/

Artikel zum Thema „Boden“ im ScienceBlog:

- Rattan Lal; 27.11.2015: Boden – Der große Kohlenstoffspeicher

- Hans-Rudolf Bork; 14.11.2014: Die Böden der Erde: Diversität und Wandel seit dem Neolithikum

- Reinhard F. Hüttl; 01.08.2014: Vom System Erde zum System Erde-Mensch

- Julia Pongratz & Christian Reick; 18.07.2014: Landwirtschaft pflügt das Klima um

- Gerhard Glatzel; 21.03.2013: Rückkehr zur Energie aus dem Wald – mehr als ein Holzweg? Teil 1 - Energiewende und Klimaschutz (insg. 3 Teile)

- Gottfried Schatz; 23.02.2012: Erdfieber — Das Unbehagen der Wissenschaft bei der Klimadebatte

- Gerhard Glatzel; 24.01.2013: Umweltökologie und Politik — Der Frust der nicht gehörten Wissenschaftler

- Gerhard Glatzel; 28.06.2011: Hat die Menschheit bereits den Boden unter den Füßen verloren?

Boden - Der große Kohlenstoffspeicher

Boden - Der große KohlenstoffspeicherFr, 27.11.2015 - 11:41 — Rattan Lal

![]() In drei Tagen treffen 25 000 Delegierte aus mehr als 190 Ländern zur diesjährigen UN-Klimakonferenz (COP 21) in Paris zusammen. Deren Ziel ist es ein globales Klimaschutzabkommen zustande zu bringen, welches die drohenden katastrophalen Auswirkungen des Klimawandels verhindert aber dennoch ein Wirtschaftswachstum in gefährdeten Entwicklungsländern ermöglicht. Der renommierte Bodenexperte Rattan Lal (Ohio State University) hat in bahnbrechenden Untersuchungen das Potential des Bodens zur Kohlenstoffspeicherung aufgezeigt und darauf basierende, effiziente Verfahrensweisen, um dem globalen Wandel entgegenzuwirken. Von diesen Konzepten überzeugt, wird der französische Landwirtschaftsminister Stephane Le Foll diese unter die empfohlenen Maßnahmen der COP 21 aufnehmen. Im nachstehenden Artikel* gibt Rattan Lal einen summarischen Überblick über die Kohlenstoffspeicherung in unterschiedlichen Bodentypen. Dies ist als Einleitung zu weiteren Artikeln des Autors zu sehen, in denen er über die anthropogenen Auswirkungen auf Boden und Klima berichten und Lösungsvorschläge geben wird.

In drei Tagen treffen 25 000 Delegierte aus mehr als 190 Ländern zur diesjährigen UN-Klimakonferenz (COP 21) in Paris zusammen. Deren Ziel ist es ein globales Klimaschutzabkommen zustande zu bringen, welches die drohenden katastrophalen Auswirkungen des Klimawandels verhindert aber dennoch ein Wirtschaftswachstum in gefährdeten Entwicklungsländern ermöglicht. Der renommierte Bodenexperte Rattan Lal (Ohio State University) hat in bahnbrechenden Untersuchungen das Potential des Bodens zur Kohlenstoffspeicherung aufgezeigt und darauf basierende, effiziente Verfahrensweisen, um dem globalen Wandel entgegenzuwirken. Von diesen Konzepten überzeugt, wird der französische Landwirtschaftsminister Stephane Le Foll diese unter die empfohlenen Maßnahmen der COP 21 aufnehmen. Im nachstehenden Artikel* gibt Rattan Lal einen summarischen Überblick über die Kohlenstoffspeicherung in unterschiedlichen Bodentypen. Dies ist als Einleitung zu weiteren Artikeln des Autors zu sehen, in denen er über die anthropogenen Auswirkungen auf Boden und Klima berichten und Lösungsvorschläge geben wird.

Wenn Böden richtig behandelt werden, nehmen sie aus der Atmosphäre Kohlenstoff auf – ein wichtiger Beitrag gegen die Erderwärmung. Doch die industrielle Landwirtschaft nimmt darauf keine Rücksicht.

Boden und Klima

Das Klima trägt aktiv dazu bei, wie sich der Boden ausbildet, ist untrennbar mit seiner Qualität verbunden. Der Boden wiederum beeinflusst in erheblichem Maße das Klima. Beide befinden sich in einem dynamischen Gleichgewicht.

Gräbt man mit einem Spaten ein rund 50 cm tiefes Loch und glättet dessen Wände, so sieht man eine Reihe verschiedener Schichten. Die oberste Schicht ist wahrscheinlich schwarz, es folgen braune oder graue Farbtöne, vielleicht mit schwarzen oder roten Bändern dazwischen. Diese Schichten werden „Horizonte“ genannt und sind charakteristisch für bestimmte Klimazonen. In den Nadelwäldern, die sich in den nördlichen Breiten ausdehnen, findet sich ein typisches graues Band, das wie Asche aussieht und „Podsol“ genannt wird. Viele Böden der Feuchttropen sind rot oder gelb wegen des darin enthaltenen Eisens oder Aluminiums. Sie heißen „Ferralsole“.

Die Schichten werden vom Klima verursacht. Regen löst bestimmte Mineralien und Salze und führt diese im durchsickernden Wasser nach unten. Verdunstung und Kapillarwirkung befördern sie wieder nach oben, wo sie sich in charakteristischen Schichten oder eben auf der Oberfläche ablagern. Feinpartikel können sich in einer bestimmten Tiefe ansammeln und eine wasserstauende „Ortstein“-Schicht bilden. Wasser und Säure nagen am Fels, brechen ihn auf und bilden neuen Boden. Durch das Zusammenspiel aus Klima, dem Grundgestein und der Topografie sowie durch menschliche Eingriffe wie Pflügen oder Bewässerung entstehen Böden, die entweder sandig, schluffig oder lehmig sind, sauer oder basisch, wassergesättigt oder gut entwässert, fruchtbar oder unfruchtbar.

Das Klima beeinflusst den Boden auch durch die Vegetation, die auf ihm wächst, und die Tiere und Mikroorganismen, die in ihm leben. Pflanzenwurzeln und Pilzmyzelien binden die Erde und ziehen Wasser und Nährstoffe heraus; Regenwürmer, Maulwürfe und Insekten wühlen und graben darin und sorgen für Durchlüftung und Kanäle für die Wasserabfuhr. Wenn Pflanzen absterben, werden sie zu Humus zersetzt, dieser schwarzen Schicht an der Oberfläche vieler Böden. Diese organischen Substanzen sind für die Fruchtbarkeit des Bodens von entscheidender Bedeutung. Sie halten die Bodenpartikel zusammen und schließen Wasser und Nährstoffe ein, die somit erreichbar für Wurzeln sind.

Wächst nichts oder zu wenig – zum Beispiel nach dem Pflügen oder in trockeneren Gebieten – ist der Boden den Elementen ausgesetzt. Regentropfen brechen Klumpen auf und waschen Partikel fort. Wenn starker Regen auf die Oberfläche prasselt, können sich Krusten bilden, die verhindern, dass Wasser rasch einsickern kann. Es läuft auf der Oberfläche ab und spült dabei den wertvollen Mutterboden mit weg, lässt Flüsse braun werden und Rückhaltezonen verlanden. In Trockenzeiten kann der Wind Staub und Sand aufwirbeln und hunderte Kilometer weit tragen.

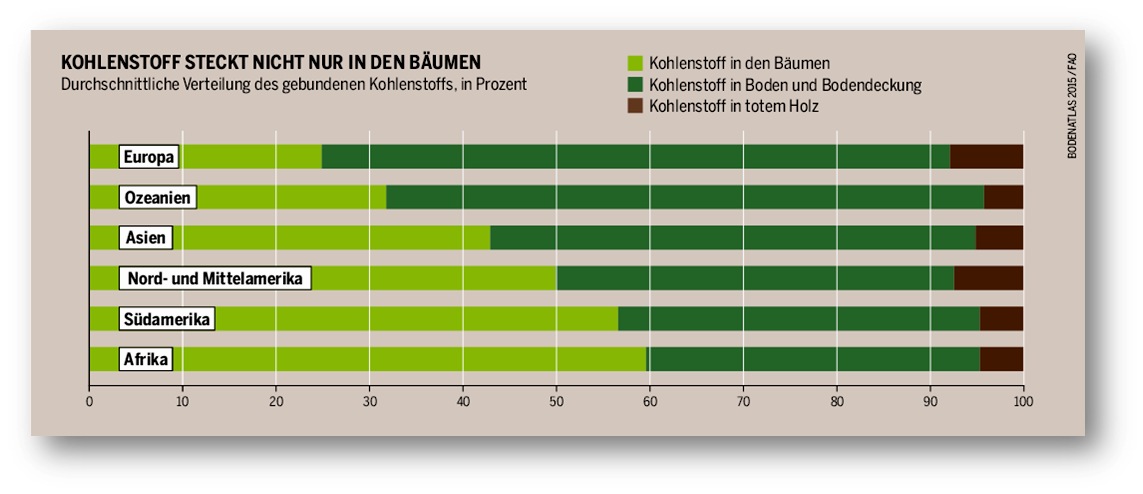

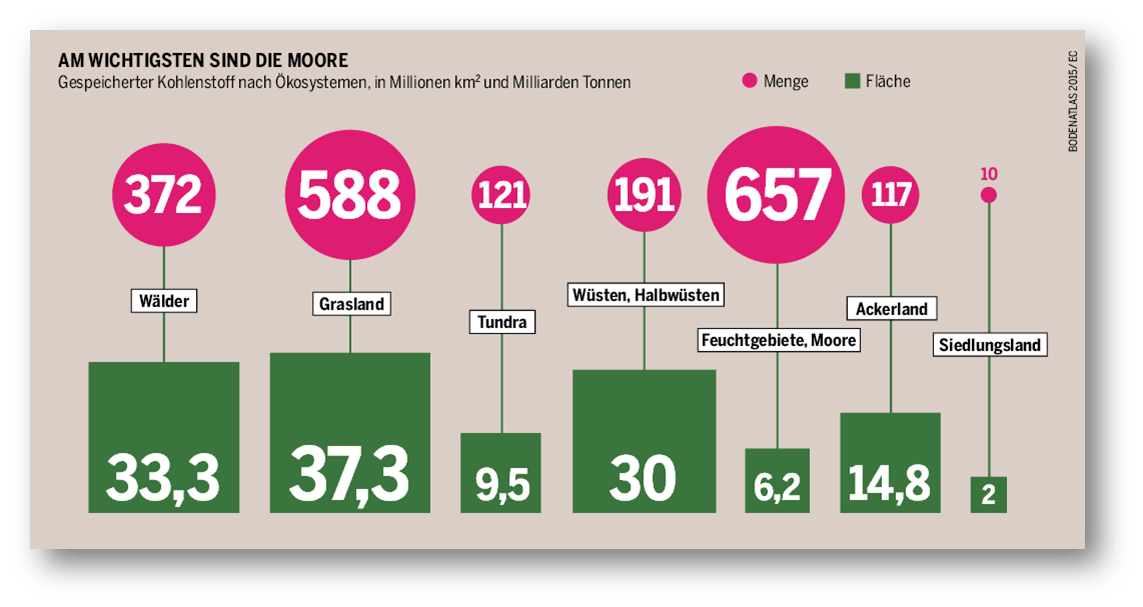

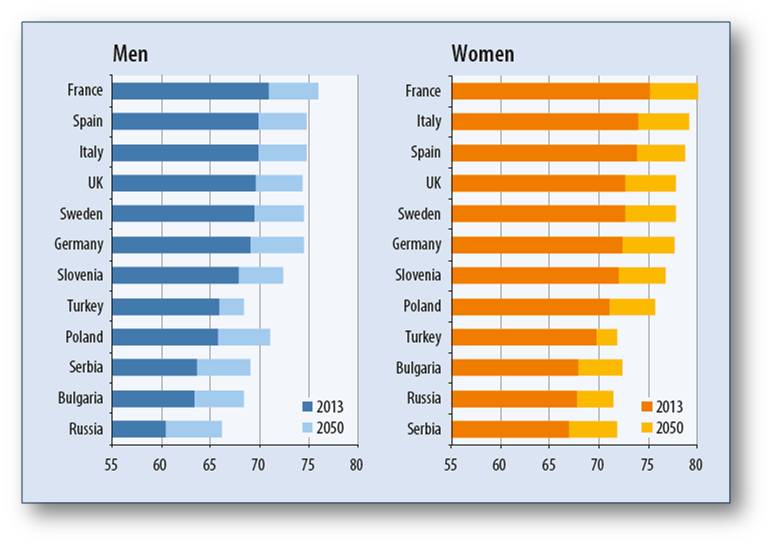

Der Boden ist eine gewaltige Kohlenstoffsenke

Klima beeinflusst also den Boden – und umgekehrt wirkt sich die Beschaffenheit des Bodens auch auf das Klima aus. Kohlendioxid und andere Treibhausgase spielen hier eine besonders wichtige Rolle. Der Boden ist eine gewaltige Kohlenstoffsenke: Er enthält mehr Kohlenstoff als die Atmosphäre und die gesamte Erdvegetation zusammen(Abbildung 1). Vergleichsweise geringe Verluste der Menge organischer Substanzen im Boden können eine große Wirkung auf die Atmosphäre und damit auf die Erwärmung der Erde haben.

Abbildung 1. Kohlenstoff in Boden und Vegetation. In Europa sammelt sich der Kohlenstoff mehr in den Böden als in den Pflanzen – in Afrika ist es umgekehrt.[1].

Abbildung 1. Kohlenstoff in Boden und Vegetation. In Europa sammelt sich der Kohlenstoff mehr in den Böden als in den Pflanzen – in Afrika ist es umgekehrt.[1].

Ackerland, das rund 1,5 Milliarden Hektar der Erdoberfläche ausmacht, enthält im Allgemeinen weniger organische Substanzen als Böden mit natürlicher Vegetation. Das Pflügen von landwirtschaftlichen Nutzflächen und das Ernten von Feldfrüchten beschleunigt die Freisetzung von Kohlendioxid in die Atmosphäre. Der Reisanbau setzt Methan frei, ein 25-fach stärkeres Treibhausgas als Kohlendioxid. Stickstoffdünger führt zur Emission von Distickstoffmonoxid (N2O), einem noch schädlicheren Gas. Bessere Bewirtschaftungsmethoden wie beispielsweise eingeschränktes Pflügen, Erosionsschutz, Gründüngung oder Kompost und Dung können dem Boden wieder Kohlenstoff zuführen.

Rund 3,5 Milliarden Hektar weltweit sind Weideland. Rinder und andere Wiederkäuer sind große Verursacher von Treibhausgasen: Durch Aufstoßen, Blähungen und Dung werden Methan und N2O abgegeben. Weideland in Trockengebieten nimmt relativ wenig Kohlenstoff pro Hektar auf. Da es sich jedoch über große Flächen erstreckt, kann es insgesamt sehr viel Kohlenstoff absorbieren, wenn es gut bewirtschaftet, also zum Beispiel kontrolliert beweidet wird, wenn Brände vermieden, Bäume gepflanzt, Boden und Wasser bewahrt werden, wenn erodiertes und versalztes Land sich erholen kann und Feuchtgebiete wiederhergestellt werden.

Abbildung 2. Gespeicherter Kohlenstoff nach Ökosystemen [2]. Die Renaturierung von Mooren und Feuchtgebieten lohnt sich besonders. Aber kein Ökosystem darf vernachlässigt werden.

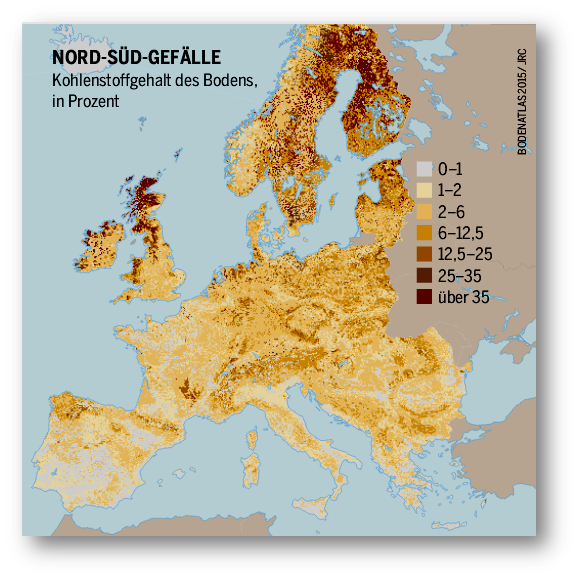

Wälder bedecken rund 4 Milliarden Hektar Fläche auf der Erde. Die Böden, auf denen tropischer Regenwald wächst, sind erstaunlich unfruchtbar: Regen schwemmt die Nährstoffe schnell fort. Die meisten Pflanzennährstoffe und Kohlenstoffe im Regenwald sind in der Vegetation selbst enthalten. Sterben die Organismen, so zersetzen sie sich rasch in dem heißen, feuchten Klima, und die Nährstoffe werden in neuen Pflanzen wiederverwertet. Wenn Bäume gefällt oder verbrannt werden, dann werden große Mengen Kohlenstoff in die Atmosphäre abgegeben. Die Böden unter den ausgedehnten nördlichen Wäldern Nordamerikas, Skandinaviens und Nordrusslands hingegen enthalten riesige Mengen Kohlenstoff, insbesondere in Torfmooren (Abbildungen 2, 3).

Abbildung 3. Kohlenstoffgehalt des Bodens [3]. Europa emittiert viel mehr Treibhausgase als es bindet, Zudem sinkt die Qualität der Böden. Doch je weniger er lebt, umso weniger speichert er.

Abbildung 3. Kohlenstoffgehalt des Bodens [3]. Europa emittiert viel mehr Treibhausgase als es bindet, Zudem sinkt die Qualität der Böden. Doch je weniger er lebt, umso weniger speichert er.

Vorausgesetzt, er wird richtig bewirtschaftet, ist der Boden grundsätzlich in der Lage, reichlich Kohlenstoff aufzunehmen und so zu helfen, dass die Erde sich nicht weiter erwärmt.

Entscheidend wird sein, ob es gelingt, die Fähigkeit des Bodens zur Speicherung des Kohlenstoffes wiederherzustellen.

[1] FAO, Global Forest Resources Assessment 2005, nach Atlas der Globalisierung spezial: Klima,2008 S. 35, http://bit.ly/1vZlQqi

[2] EC, Soil organic matter management across the EU, Technical Report 2011-051, S. 20, http://bit.ly/1yQrKct.

[3] JRC Topsoil Organic Carbon Content, 2003, http://bit.ly/1DcY51f

*Der Artikel stammt aus: Bodenatlas - Daten und Fakten über Acker, Land und Erde (Kooperationsprojekt zum internationalen Jahr des Bodens von Heinrich-Böll-Stiftung, IASS, BUND, Le Monde diplomatique, 2015. Alle Grafiken und Texte stehen unter der offenen Creative Commons Lizenz CC-BY-SA ) https://www.bund.net/fileadmin/bundnet/publikationen/landwirtschaft/1501...

In den nächsten Wochen werden zwei weiteren Artikel des Autors folgen, in denen er über die anthropogenen Auswirkungen auf Boden und Klima berichten und Lösungsvorschläge geben wird.

Weiterführende Links

Zum Thema Boden und Klima sind zahlreiche Artikel im ScienceBlog, vor allem im Themenschwerpunkt ›Klima & Klimawandel‹, erschienen:

- Peter Lemke; 06.11.2015: Klimaschwankungen, Klimawandel – wie geht es weiter?

- Peter Lemke; 30.10.2015: Wie Natur und Mensch das Klima beeinflussen und wie sich das auf die Energiebilanz der Erde auswirkt

- Reinhard F. Hüttl; 01.08.2014: Vom System Erde zum System Erde-Mensch

- Julia Pongratz & Christian Reick; 18.07.2014: Landwirtschaft pflügt das Klima um

- Gerhard Glatzel; 21.03.2013: Rückkehr zur Energie aus dem Wald – mehr als ein Holzweg? Teil 1 - Energiewende und Klimaschutz (insg. 3 Teile)

- Reinhard Böhm; 06.09.2012: Spielt unser Klima verrückt? Zur Variabilität der Klimaschwankungen im Großraum der Alpen

- Gottfried Schatz; 23.02.2012: Erdfieber — Das Unbehagen der Wissenschaft bei der Klimadebatte

- Reinhard Böhm; 19.01.2012: Signal to noise — Betrachtungen zur Klimawandeldiskussion

Weitere Artikel zum Thema:

Comments

Gerodete Regenwaldflächen…

Gerodete Regenwaldflächen bleiben auch nach Wiederaufforstung jahrelang CO2-Quellen.

https://www.derstandard.at/story/2000142385381/nachwachsender-regenwald-gibt-mehr-co2-frei-als-er-bindet

- Log in to post comments

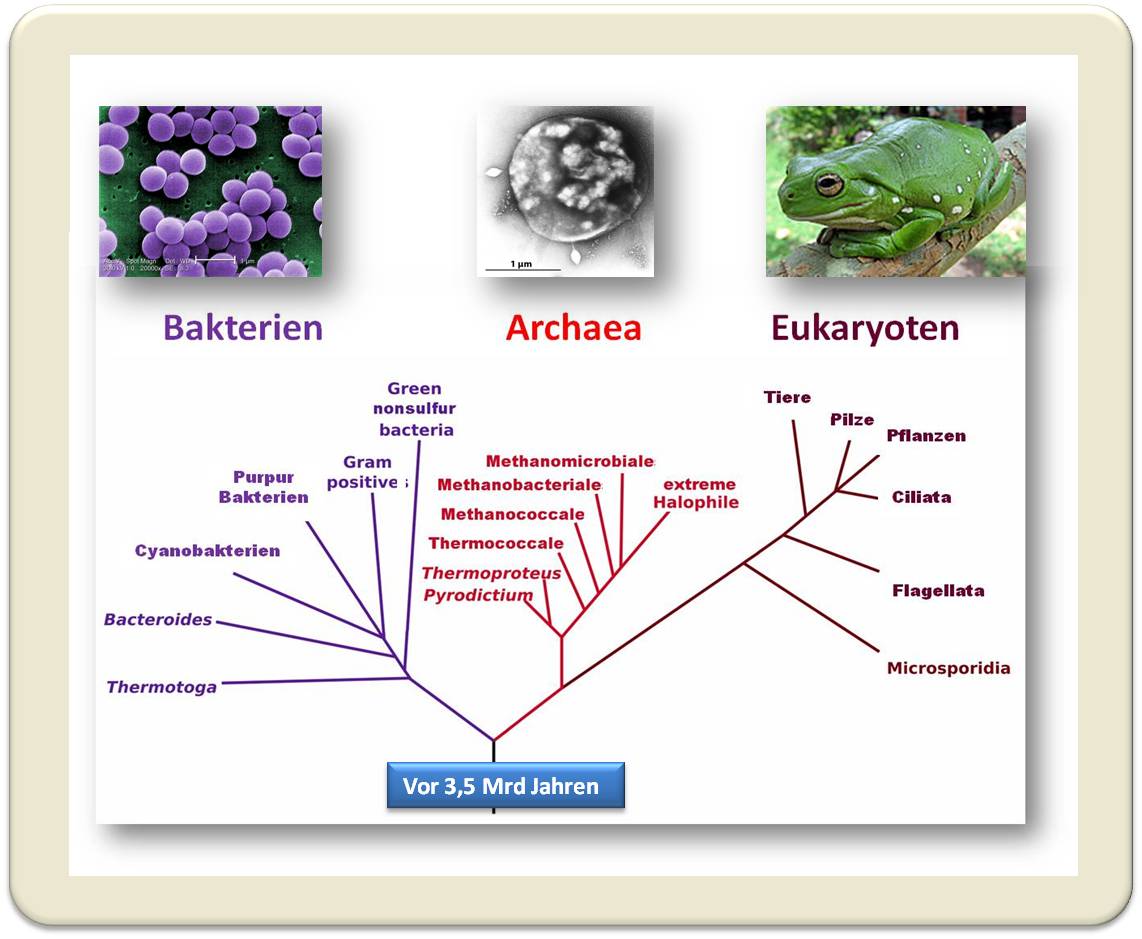

Von Bakterien zum Menschen: Die Rekonstruktion der frühen Evolution mit fossilen Biomarkern

Von Bakterien zum Menschen: Die Rekonstruktion der frühen Evolution mit fossilen BiomarkernFr, 20.11.2015 - 11:23 — Christian Hallmann

![]() Das Leben auf der Erde ist erstaunlich alt. Nach ihrer Entstehung vor ca. 4,5 Milliarden Jahren war die Erde ein äußerst lebensfeindlicher Ort – ohne verfestigte Kruste, ohne Wasser und mit häufigen Meteoriteneinschlägen. Sobald die Umweltbedingungen sich erstmalig stabilisierten und flüssiges Wasser vorkam, sollte es nicht lange dauern, bis erstes Leben in Form primitiver einzelliger Bakterien erschien. Christian Olivier Eduard Hallmann, Leiter der Forschungsgruppe Organische Paläobiogeochemie (MPI Biogeochemie, Jena) erforscht, wie sich das Leben auf der Erde zwischen seinem ersten Aufkommen und den heutigen komplexen Ökosystemen entwickelt hat.*

Das Leben auf der Erde ist erstaunlich alt. Nach ihrer Entstehung vor ca. 4,5 Milliarden Jahren war die Erde ein äußerst lebensfeindlicher Ort – ohne verfestigte Kruste, ohne Wasser und mit häufigen Meteoriteneinschlägen. Sobald die Umweltbedingungen sich erstmalig stabilisierten und flüssiges Wasser vorkam, sollte es nicht lange dauern, bis erstes Leben in Form primitiver einzelliger Bakterien erschien. Christian Olivier Eduard Hallmann, Leiter der Forschungsgruppe Organische Paläobiogeochemie (MPI Biogeochemie, Jena) erforscht, wie sich das Leben auf der Erde zwischen seinem ersten Aufkommen und den heutigen komplexen Ökosystemen entwickelt hat.*

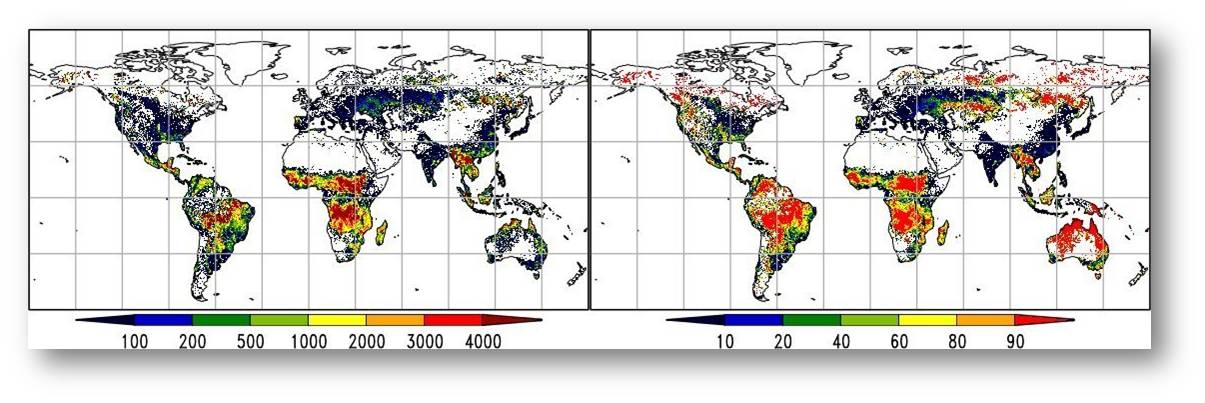

Die ältesten Spuren des Lebens

Die ältesten Spuren irdischen Lebens befinden sich fernab der Zivilisation im Westaustralischen Outback (Abbildung 1). In einer geologischen Formation, welche als Warrawoona-Gruppe bekannt ist, enthält teilweise verkieseltes 3,5 Milliarden Jahre altes Karbonatgestein kleine, jedoch regelmäßige konische Strukturen, sogenannte Stromatolite, deren Entstehung unverkennbar auf Mikroorganismen zurückzuführen ist.

Abbildung 1. Mikrobiell gebildete Stromatoliten in der ca. 3,5 Milliarden Jahre alten Warrawoona-Gruppe (Westaustralien) bilden den zurzeit ältesten anerkannten Nachweis für die Existenz von Leben auf der Erde © C. Hallmann

Abbildung 1. Mikrobiell gebildete Stromatoliten in der ca. 3,5 Milliarden Jahre alten Warrawoona-Gruppe (Westaustralien) bilden den zurzeit ältesten anerkannten Nachweis für die Existenz von Leben auf der Erde © C. Hallmann

Dies allein ist allerdings kein Indiz für den Ursprung des Lebens.

Sedimentäres Gestein, welches sich als Sand, Ton und Karbonat in Meeresbecken und Seen ablagert, durchläuft mitsamt den Kontinenten, auf denen sich die Gesteine befinden, sogenannte Wilson-Zyklen. Durch die tektonische Bewegung der Kontinentalplatten werden Gebirge wie Falten aufgeworfen und im Laufe der Zeit wieder abgetragen. Vulkanische Aktivität bricht das umgebende Gestein auf und wenn eine Platte sich unter ihre Nachbarplatte schiebt, schmilzt diese langsam auf und Ihre Gesteinsinformation fließt in das große Mantelreservoir ein. So ist es nicht verwunderlich, dass im Laufe der Zeit immer weniger ursprünglich abgelagertes Sedimentgestein vorhanden ist. Die Warrawoona-Gruppe enthält die ältesten Sedimentgesteine auf der Erde, welche nicht unter hohem Druck und hohen Temperaturen umgewandelt wurden.

Das Leben auf der Erde könnte also noch älter sein, doch diese Information ist durch die gesteinsverändernden Prozesse für immer verloren gegangen.

Parallelentwicklung von Leben auf dem Mars

Falls das Leben sich gleichzeitig auf Erde und Mars entwickelt hat (es gibt die Hypothese, dass die notwendigen organischen Moleküle des Lebens mit Meteoriten auf die Erde gekommen sind – diese wären somit ebenfalls auf dem Mars gelandet), wäre es möglich, weitere Einblicke zum frühesten Leben auf unserem Nachbarplaneten zu finden. Dort hat die Aktivität der Plattentektonik irgendwann aufgehört und wesentlich älteres Gestein ist noch unverändert vorhanden. Die technischen und methodischen Anforderungen an die Mars-Forschung, welche aktuell von der NASA mit dem Curiosity Rover durchgeführt wird, sind allerdings viel höher als auf der Erde und die Fragestellung ist höchst spekulativ.

Fragen zur frühen Evolution

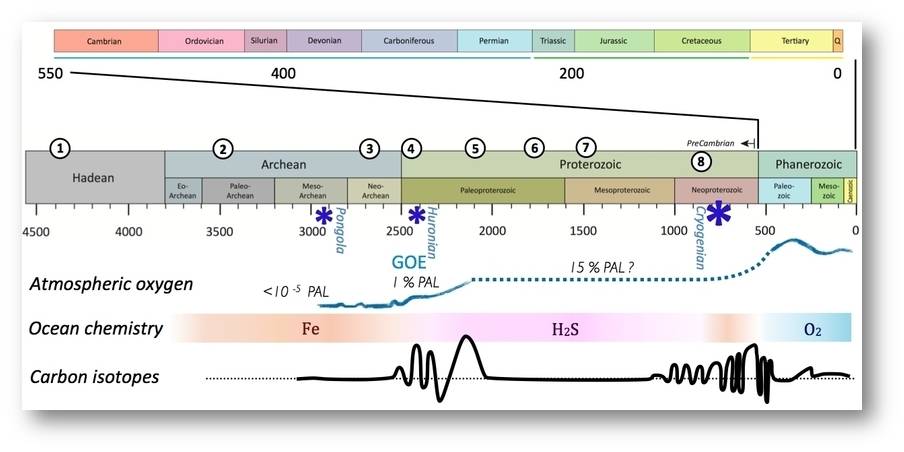

Abbildung 2. Zeitbalken der 4,5 Milliarden Jahre irdischer Entwicklung mit den bedeutendsten Übergängen und Ereignissen: (1) flüssiges Wasser, (2) Warrawoona-Gruppe Stromatolite, (3) bis vor kurzem die ältesten vermuteten Biomarker, (4) Schwefelisotope deuten auf steigende atmosphärische Sauerstoffkonzentrationen, (5) älteste eindeutige cyanobakterielle Mikrofossilien, (6) möglicher Ursprung der Eukaryonten nach Molekular-Uhr Studien, (7) älteste eindeutige Mikrofossilien eukaryontischer Algen, (8 ) älteste unangefochtene reguläre Steroidbiomarker eukaryotischen Ursprungs. Der Sauerstoffgehalt der Atmosphäre (‘atmospheric oxygen’) stieg zum ersten Mal während des GOE (Great Oxidation Event) und erreichte möglicherweise 1% des heutigen Atmosphärengehalts (PAL: present atmospheric level). Starke Schwankungen in sedimentären Kohlenstoffisotopen (‘carbon isotopes’) deuten auf eine Instabilität des marinen Kohlenstoffzyklus‘.© C. Hallmann