2022

2022 inge Fri, 07.01.2022 - 20:15Fliegen lehren uns, wie wir lernen

Fliegen lehren uns, wie wir lernenDo, 29.12.2022 — Nora Schultz

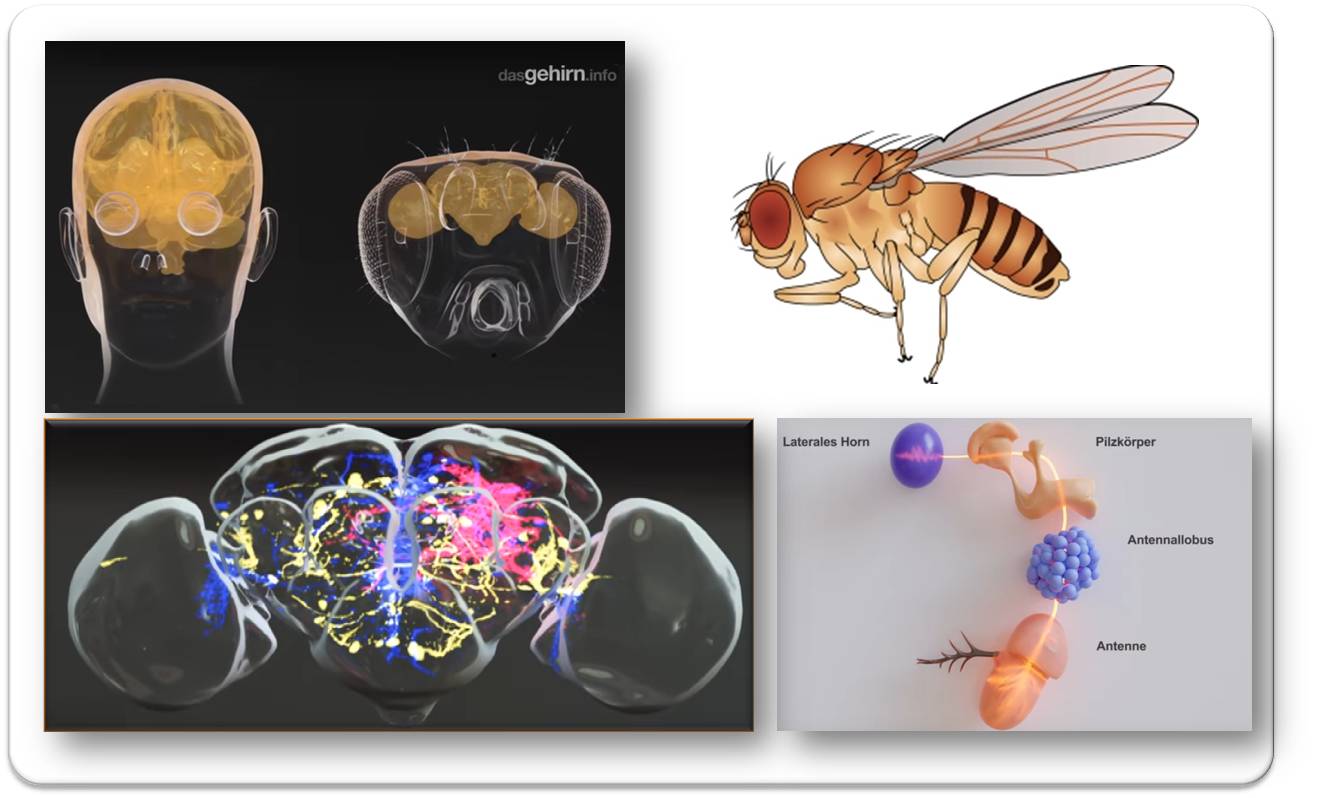

Die Taufliege Drosophila gehört zu den beliebtesten Tiermodellen der Genetiker und auch der Neurowissenschafter. Zwar liegen zwischen Fliegen und Menschen Welten; doch schaut man dem kleinen Insekt ins Gehirn – und ins Genom – , so zeigt sich, dass doch vieles sehr ähnlich funktioniert. Viele der heute auch für den Menschen relevanten Gene wurden erstmals in Taufliegen entdeckt. Die Tiere entfalten komplexe Verhaltensmuster, sie machen Erfahrungen, bewerten, lernen, erinnern sich und können auch vergessen. Die Entwicklungsbiologin Nora Schultz gibt eine Einführung in das faszinierendeThema.*

In Kurt Neumanns Horrorfilm „Die Fliege“ aus dem Jahr 1958 widerfahren einem Forscher schlimme Dinge, nachdem sein Körper in einem Experiment versehentlich mit dem einer Fliege verschmolzen ist. Im Gegensatz dazu bleibt die reale Forschung, die sich in vielen Disziplinen seit mehr als 100 Jahren um die Taufliege Drosophila melanogaster dreht, bislang ohne gruselige Nebenwirkungen. An Visionsfülle steht die Realität dem Film jedoch kaum nach: Das kleine Insekt – vielen auch als Frucht- oder Essigfliege bekannt – soll große Fragen beantworten und hat viele Antworten bereits geliefert: Wie wächst aus einer befruchteten Eizelle ein komplexer Körper? Wie entstehen Krebs und andere Krankheiten? Wie lernt ein Gehirn?

Gerade die letzte Frage erscheint anmaßend. Nur 100.000 Neurone arbeiten im Drosophila-Gehirn; im Menschenkopf knäulen sich 86 Milliarden Nervenzellen, fast zehntausendmal so viele. Doch was man bisher über die Fliege weiß, gibt Anlass zum Optimismus, dass uns das bescheidene Fliegenhirn einiges über das Lernen lehren kann. Nicht ohne Grund ist Drosophila das liebste Versuchstier der Forschung. (Siehe Box).

|

Drosophila - Superstar unter den Tiermodellen

Bild von Redn. eingefügt. Quelle: Flickr by cudmore. https://www.flickr.com/photos/cudmore/4277800. Lizenz: cc-by-sa. |

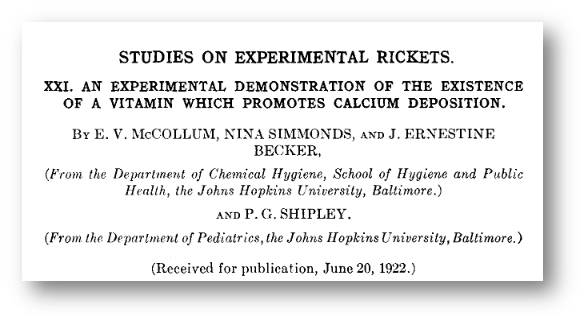

Schon um 1910 wusste der US-amerikanische Zoologe und Genetiker Thomas Hunt Morgan die Vorzüge der kleinen Fliege zu schätzen: für seine Pionierarbeiten in der Genetik, für die er später den Nobelpreis bekam. Taufliegen sind klein, pflegeleicht, überaus fruchtbar und vermehren sich schnell. Eine Generationszeit dauert gerade mal zehn Tage. Morgan und sein Team benötigten in ihrem „Fly Room“ – einem nur 35 Quadratmeter kleinen Labor – anfangs wenig mehr als reife Bananen, Milchflaschen und Lupen, um an tausenden Fliegen zu beobachten, wie bestimmte Merkmale von Generation zu Generation weitervererbt wurden.

Es sind die Gene

Dabei wurde schnell klar, dass Fliegen in vielerlei anderer Hinsicht einen Glücksgriff für die biologische Forschung bedeuten. Die Tiere lassen sich sowohl genetisch als auch zell- und molekularbiologisch überaus gut untersuchen und manipulieren. Morgan und viele andere, die schon bald in dessen Fußstapfen traten, entlockten Drosophila zunächst Geheimnisse, indem sie die Tiere mutierenden Röntgenstrahlen oder Chemikalien aussetzten. Die Effekte dieser Mutationen untersuchten sie dann im Rahmen sogenannter Screens in mühevoller Kleinarbeit und ordneten sie konkreten Positionen auf den Chromosomen zu.

Christiane Nüsslein-Volhard und Eric Wieschaus beispielsweise charakterisierten 1980 auf diese Weise 600 Mutationen in 120 Genen, die das Segmentmuster von Fliegenlarven verändern – eine Arbeit, für die sie später ebenfalls den Nobelpreis erhielten. Damit entschlüsselten sie entscheidenden Mechanismen der Embryonalentwicklung. Und, wie sich später herausstellte, orchestrieren diese Gene vielfach auch bei anderen Tieren bis hin zum Menschen die Entwicklung und sind an Krankheitsprozessen beteiligt – so auch im Nervensystem.

Die überraschende Ähnlichkeit zwischen Taufliegen und anderen, mit ihr nur äußerst entfernt verwandten Lebewesen hat sich seitdem immer wieder bestätigt. Im Jahr 2000 gelang es, das Genom der Fliege vollständig zu entschlüsseln; wenige Monate später erschien 2001 die erste, noch nicht ganz vollständige Sequenzierung des menschlichen Genoms. Seitdem ist klar, dass es für viele menschliche Gene entsprechende Pendants mit ähnlicher Struktur und/oder Funktion in der Fliege gibt. Das gilt beispielsweise für 77 Prozent der 2001 bekannten krankheitsrelevanten menschlichen Gene . Die Liste wird in einer online einsehbaren Datenbank, der „ Flybase “ “ (https://flybase.org/lists/FBhh/), ständig aktualisiert.

Durchaus lernfähig

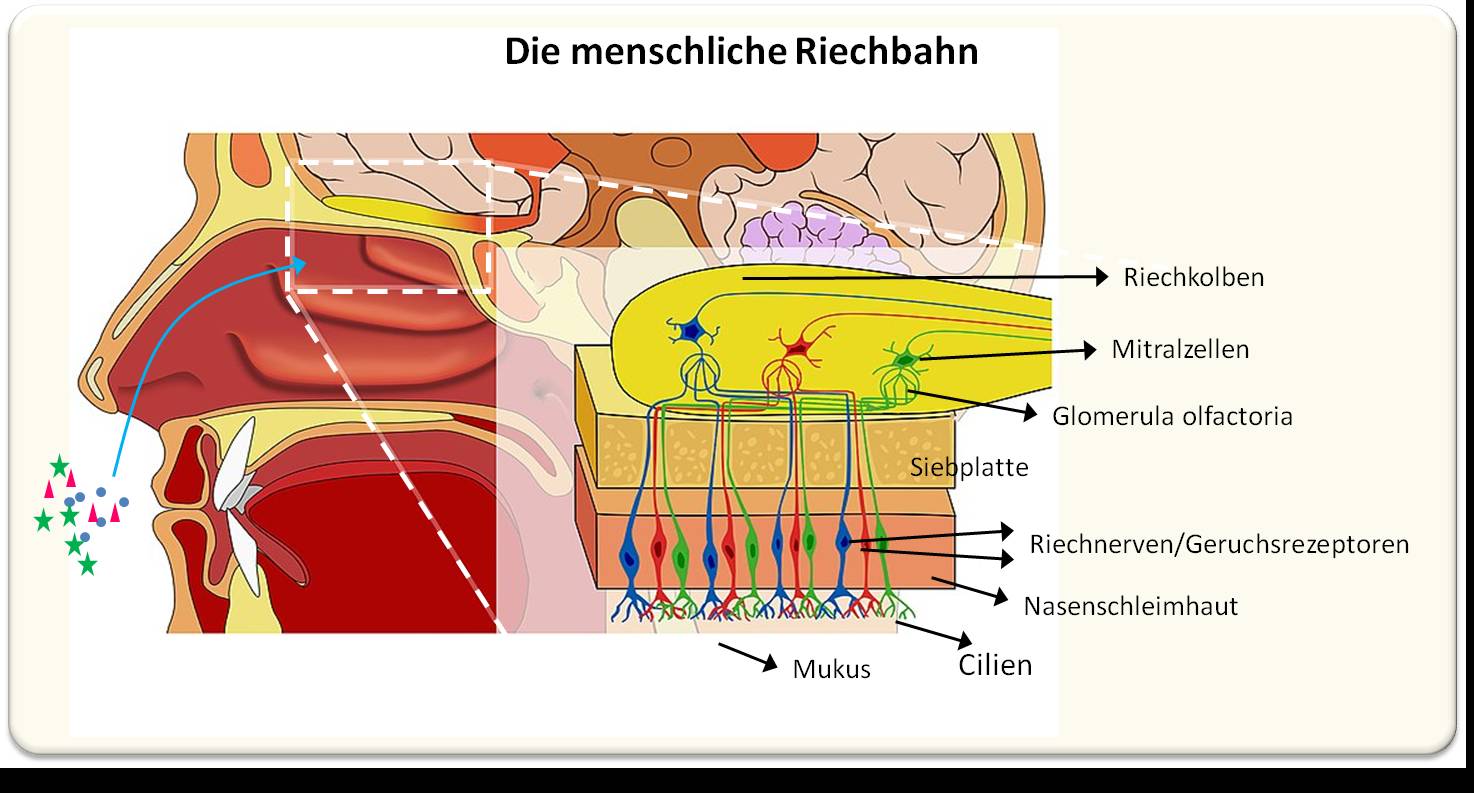

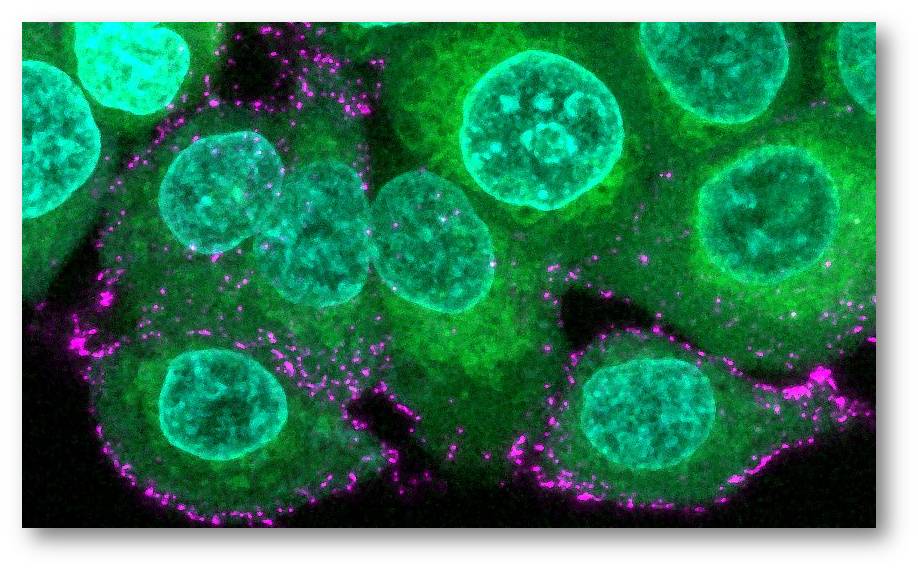

Auch das Fliegenhirn ähnelt dem menschlichen Gehirn mehr, als man zunächst vermuten möchte. Es ist zwar nur so groß wie ein Mohnkorn, leistet aber auf diesem kleinen Raum eine ganze Menge an Dingen. Fliegen riechen und sehen zum Beispiel sehr gut und gleichen diese und andere sensorische Informationen ständig mit weiteren Details ab, um Entscheidungen zu treffen, durch den dreidimensionalen Raum zu navigieren, Futter zu finden, Gefahren zu meiden und andere Fliegen zu bezirzen oder zu bekämpfen.Abbildung.

| Fliegenhirn:- Klein wie ein Mohnkorn, aber ähnlicher dem menschlichen Gehirn, als man vermuten möchte. Unten: Signale der Aussenwelt - z.B. Duft - werden im Pilzkörper verarbeitet. (Bilder von Redn. eingefügt. Quelle: Die Fliege. https://www.youtube.com/watch?v=oH0Fy3lp7Zg.© 2022 www.dasGehirn.info. Lizenz: cc-by-nc) |

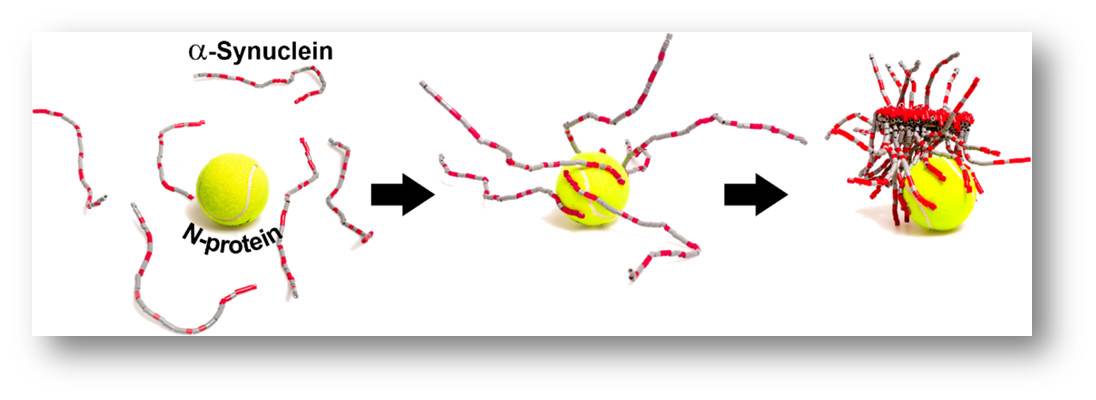

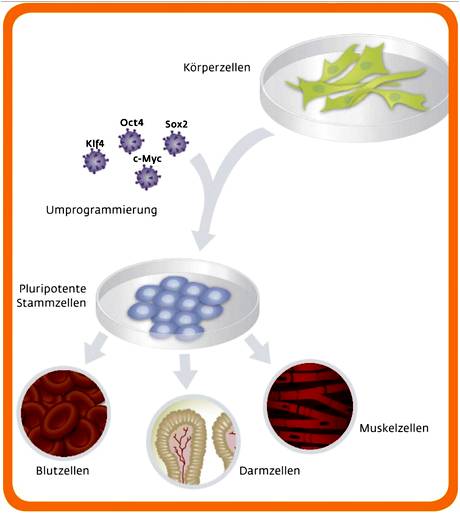

Ein derart komplexes Verhaltensrepertoire kann nur entfalten, wer lernfähig ist. Fliegen lernen, greifen auf Erinnerungen zurück und vergessen manches auch wieder, genau wie Menschen. Selbst wenn zwischen dem Alltag von Drosophila melanogaster und dem des Homo sapiens Welten liegen, sind die Grundherausforderungen ans Überleben im Kern so ähnlich, dass auch bewährte Lernmechanismen im Laufe der Evolution erhalten geblieben sind – genau wie die beteiligten Gene. Schon in den 1960er und -70er Jahren entdeckte der US-Forscher Seymour Benzer in Screens Gene, die sich auf die Lernfähigkeit von Fliegen auswirken. Gene mit den klangvollen Namen dunce und rutabaga zum Beispiel verschlüsseln die Bauanleitung für Enzyme, die eine wichtige Rolle in intrazellulären Signalkaskaden spielen, die essenziell für Lernprozesse sind. Auch von diesen und vielen weiteren neurobiologisch relevanten Fliegengenen haben Forschende seitdem menschliche Pendants ausgemacht. Es existieren also durchaus grundlegende Gemeinsamkeiten zwischen Drosophila melanogaster und Homo sapiens. Und so ist es dann auch möglich, durch Untersuchungen an der Fliege auch für den Menschen relevante Details darüber herauszufinden, wie Erfahrungen und Lernprozesse, aber auch Krankheiten die neuronalen Schaltkreise verändern, die zur Verhaltenssteuerung dienen.

Fliegenforschung vorn

Die Taufliege macht es Forschern leicht, sie experimentell unter die Lupe zu nehmen und Fragen nachzugehen, die sich beim Menschen oder auch bei anderen Versuchstieren nicht oder nur schwer untersuchen lassen. Bereits seit den 1980er Jahren existieren experimentelle Techniken, um gezielt in das Genom der Fliege einzugreifen, und sie werden ständig verfeinert. Bestimmte Gene oder Genabschnitte lassen sich gezielt in einzelnen Gewebe- oder Zelltypen aktivieren, blockieren oder in ihrer Funktion verändern, auch durch Zugabe von Transgenen, also Genabschnitten anderer Spezies. Solche Veränderungen können dauerhaft sein oder so konzipiert, dass sie sich durch bestimmte Signale ein- und ausschalten lassen, etwa durch Licht.

Bei der Untersuchung molekularer und zellulärer Lernmechanismen hat zudem gerade die kleine Statur des Fliegenhirns einen entscheidenden Vorteil: „In der Maus liegen die Zellen und Schaltkreise, die an einem bestimmten Verhalten mitwirken, so weit auseinander, dass man sie nicht gleichzeitig bei der Arbeit beobachten kann“, sagt André Fiala von der Universität Göttingen. „In der Fliege hingegen können wir zugleich auf die Details der einzelnen Nervenzelle mit ihren Synapsen schauen und auf das, was im Netzwerk passiert.“

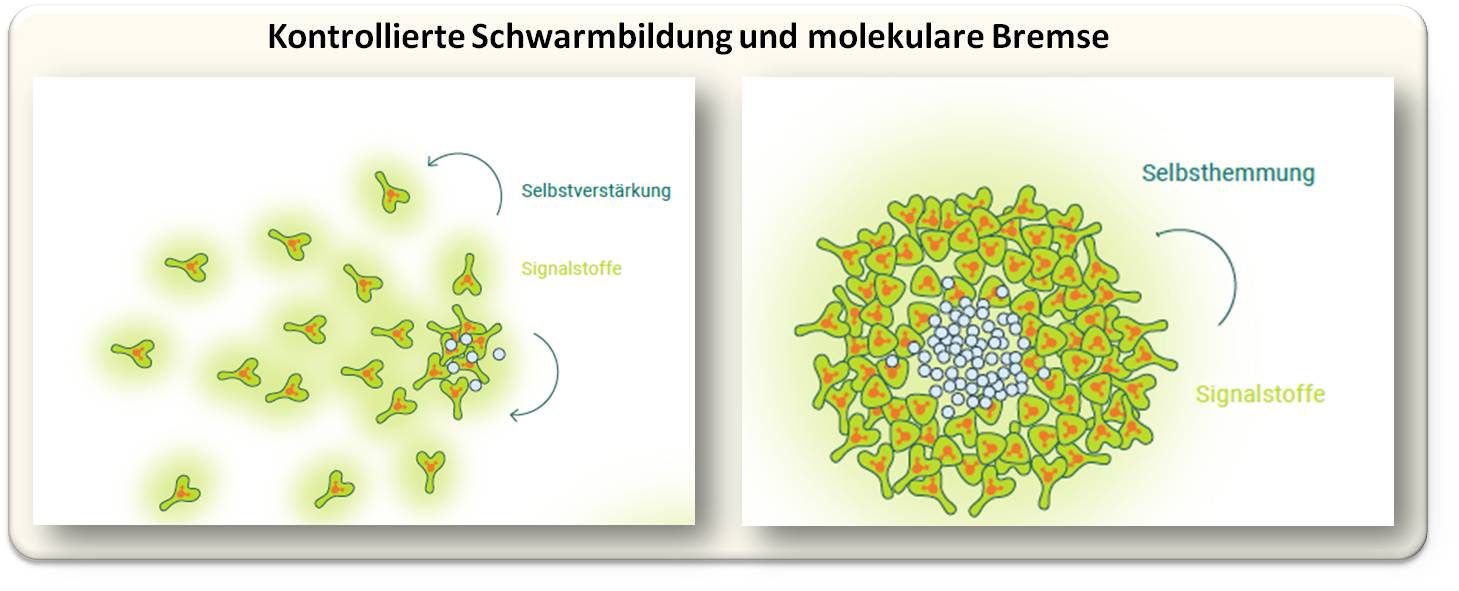

Flexible Neurone

Dabei zeigt sich, dass unterschiedliche Synapsen in ein und derselben Zelle je nach Geruch unterschiedlich aktiv sind – und dass diese Aktivitätsmuster sich verändern, wenn die Fliege lernt, einen Duft mit einem negativen Reiz, beispielsweise Schmerz zu verknüpfen. Diese Veränderungen gibt die Kenyonzelle an die an den jeweiligen Synapsen verknüpften Neurone weiter, die nun selbst verändert auf die stärkeren oder schwächeren Signale reagieren, die an dieser Synapse empfangen. Das Gelernte ist damit als messbare Gedächtnisspur fixiert worden. „Interessant ist, dass das Gedächtnis hier nicht in ganzen Zellen, sondern in einzelnen Zellabschnitten codiert wird“, erklärt Fiala. Aktuell untersucht sein Team, wie diese abschnittsweise Regulierung der Aktivität auf der molekularen Ebene funktioniert.

Es gibt noch viele weitere offene Fragen zur Verhaltenssteuerung, bei deren Beantwortung die Pilzkörper der Fliege helfen könnten. Was verändert sich zum Beispiel, wenn Gedächtnisspuren vom Kurzzeitgedächtnis ins Langzeitgedächtnis wandern? Wie genau lernt man, dass bestimmte Nahrungsmittel giftig oder verdorben waren, wenn zwischen der Aufnahme und unangenehmen Symptomen etwas Zeit verstreicht? Wie unterscheiden sich Lernprozesse, bei denen ein bestimmtes Ereignis mit einer angenehmen Belohnung verbunden wird von solchen, bei denen man „nur“ einer unangenehmen Situation entkommt? Und was geschieht, wenn das Altern oder neurodegenerative Erkrankungen die Funktion von Zellen und Schaltkreisen, die am Lernen und Gedächtnis beteiligt sind, beeinträchtigt?

Mit Hilfe von Drosophila und einem gut gefüllten molekularbiologischen Werkzeugkasten lassen sich Antworten finden und in Computermodelle übersetzen, die auch für Menschen relevante Vorhersagen darüber erlauben, wie die raum-zeitliche Dynamik von Molekülen, Zellen und Netzwerken im Gehirn Lernprozesse und die Steuerung von Verhalten. Solche Modelle könnten sogar im Bereich Künstliche Intelligenz zum Einsatz kommen, um Maschinen effektiver lernen zu lassen. Welche Erkenntnisse aus der Fliegenwelt dann wirklich auch für den Menschen gelten, bleibt abzuwarten. Um das, was sie von der Fliege gelernt haben, auf die nächste Ebene zu bringen, setzen Forscher auch auf weitere, näher mit dem Menschen verwandte Modellorganismen, wie Zebrafische und Mäuse, sowie auf Studien mit menschlichen Zellkulturen und Gewebeproben. Ein aus Mensch und Fliege verschmolzenes Mischwesen wie in Neumanns Horrorfilm braucht es zur Klärung dieser Fragen zum Glück nicht.

* Der Artikel stammt von der Webseite www.dasGehirn.info, einer exzellenten Plattform mit dem Ziel "das Gehirn, seine Funktionen und seine Bedeutung für unser Fühlen, Denken und Handeln darzustellen – umfassend, verständlich, attraktiv und anschaulich in Wort, Bild und Ton." (Es ist ein Projekt der Gemeinnützigen Hertie-Stiftung und der Neurowissenschaftlichen Gesellschaft e.V. in Zusammenarbeit mit dem Zentrum für Kunst und Medientechnologie Karlsruhe). Im Fokus des Monats Dezember steht das Thema "Fliege". Der vorliegende Artikel ist am 6.12.2022 unter dem Titel: "Fliegen? Wieso Fliegen?" https://www.dasgehirn.info/entdecken/die-fliege/fliegen-wieso-fliegen erschienen. Der unter einer cc-by-nc-sa Lizenz stehende Artikel wurde unverändert in den Blog gestellt, die Abbildungen von der Redaktion eingefügt.

Weiterführende Links

Arvid Ley (dasGehirnInfo): Die Fliege. (12.2022) Video 5:07 min. https://www.youtube.com/watch?v=oH0Fy3lp7Zg

Arvid Ley (dasGehirnInfo): Im Kopf der Fliege. (12.2022) Video 36:06 min. https://www.youtube.com/watch?v=BBQZd-fKCh0&t=50s

Zum Weiterlesen

• Hales KG, Korey CA, Larracuente AM, Roberts DM. Genetics on the Fly: A Primer on the Drosophila Model System. Genetics. 2015 Nov;201(3):815-42. DOI: 10.1534/genetics.115.183392

• Bellen HJ, Tong C, Tsuda H. 100 years of Drosophila research and its impact on vertebrate neuroscience: a history lesson for the future. Nat Rev Neurosci. 2010 Jul;11(7):514-22. doi: 10.1038/nrn2839

• Bilz, F., Geurten, B.R.H., Hancock, C.E., Widmann, A., and Fiala, A. (2020). Visualisation of a distributed synaptic memory code in the Drosophila brain. Neuron, 106, 1–14. DOI: 10.1016/j.neuron.2020.03.010

• https://www.annualreviews.org/doi/10.1146/annurev-cellbio-113015-023138.https://doi.org/10.1146/annurev-cellbio-113015-023138

• https://www.sciencedirect.com/science/article/pii/S0092867418307876

• https://www.cell.com/cell/fulltext/S0092-8674(18)30787-6

Fliegen im ScienceBlog

Jacob w.Gehring, 25.10.2012: Auge um Auge — Entwicklung und Evolution des Auges

Gottfried Schatz, 13.12.2013: Wider die Natur? — Wie Gene und Umwelt das sexuelle Verhalten prägen

Bill S. Hansson, 19.12.2014: Täuschende Schönheiten

Gero Miesenböck, 23.02.2017: Optogenetik erleuchtet Informationsverarbeitung im Gehirn

Nora Schultz, 30.12.2021: Sinne und Taten - von der einzelnen Sinneszelle zu komplexem Verhalten

Was uns Baumblätter über Zahl und Diversität der Insektenarten erzählen können

Was uns Baumblätter über Zahl und Diversität der Insektenarten erzählen könnenDo, 22.12.2022 — Redaktion

![]()

In den letzten Jahren häufen sich die dramatischen Berichte über den enormen Rückgang der Insekten, wobei sich die Beobachtungen oft nur auf kurze Zeiträume und begrenzte Standorte erstrecken und die Biomasse gefangener Tiere zur Abschätzung der reduzierten Biodiversität (Artenzusammensetzung) herangezogen wird. Eine bahnbrechende Studie hat nun erstmals Anzahl und Biodiversität der Insektenarten an Hand von über drei Jahrzehnte lang gesammelten und konservierten Baumblättern verfolgt. Aus diesen Blättern wurden DNA-Spuren - sogenannte Umwelt-DNA (eDNA) - , wie sie von Insekten beim Fressen von Blättern zurückbleiben, extrahiert, analysiert und Tausende Insektenarten nachgewiesen. Es zeigte sich, dass die Gesamtzahl der Insektenarten im Laufe der Zeit weitgehend gleich blieb, viele einzelne Arten jedoch zurückgingen und durch neue, sich weiter verbreitende Arten ersetzt wurden.*

Insekten stellen ein Barometer für die Gesundheit der Umwelt dar. Ökosysteme auf der ganzen Welt sind beispiellosen, vom Menschen verursachten Belastungen ausgesetzt, die sich vom Klimawandel über die Umweltverschmutzung bis zur intensiven Landnutzung hin erstrecken. Diese Belastungen wurden in letzter Zeit mit mehreren dramatischen Rückgängen der Insektenpopulationen in Verbindung gebracht, insbesondere in Gebieten, die von stark industrialisierter Landwirtschaft betroffen sind.

Ohne darauf weiter einzugehen - die Zusammenhänge zwischen Insektenrückgang, Umweltbelastung und r Gesundheit der Ökosysteme sind derzeit nur wenig verstanden. Ein Rückgang in einem Gebiet mag wohl katastrophal aussehen, könnte aber auch einfach Teil normaler, längerfristiger Veränderungen sein. Oft wissen wir nicht, ob der Insektenrückgang ein lokales Phänomen ist oder weitergehende Umwelttrends widerspiegelt. Zudem reichen die meisten Studien zeitlich nicht weit genug zurück oder decken keinen ausreichend großen geografischen Bereich ab, um solche Unterscheidungen treffen zu können.

Probenmaterial: eDNA aus Baumblättern

Will man den Insektenrückgang verstehen und dagegen ankämpfen, so braucht man zuverlässige Methoden, um Insektenpopulationen über lange Zeiträume verfolgen zu können. Zur Lösung dieses Problems hat ein Forscherteam um den Biogeographen Henrik Krehenwinkel (von derUniversität Trier) für Untersuchungen an Insektengemeinschaften eine neue Quelle herangezogen, nämlich Baumblätter. Es ist dies ein Probenmaterial, das ursprünglich für andere Zwecke - nämlich zur Untersuchung der Luftverschmutzung - gesammelt und in der deutschen Bundesumweltprobenbank archiviert wurde. Dieses Material enthält aber auch die DNA von Insekten, die damit vor dem Einsammeln in Kontakt gekommen sind: beispielsweise ist dies in Kauspuren zurückgebliebene DNA, d.i. an Stellen wo die Insekten die Blätter angeknabbert hatten. Diese DNA wird als Umwelt-DNA oder kurz eDNA bezeichnet.

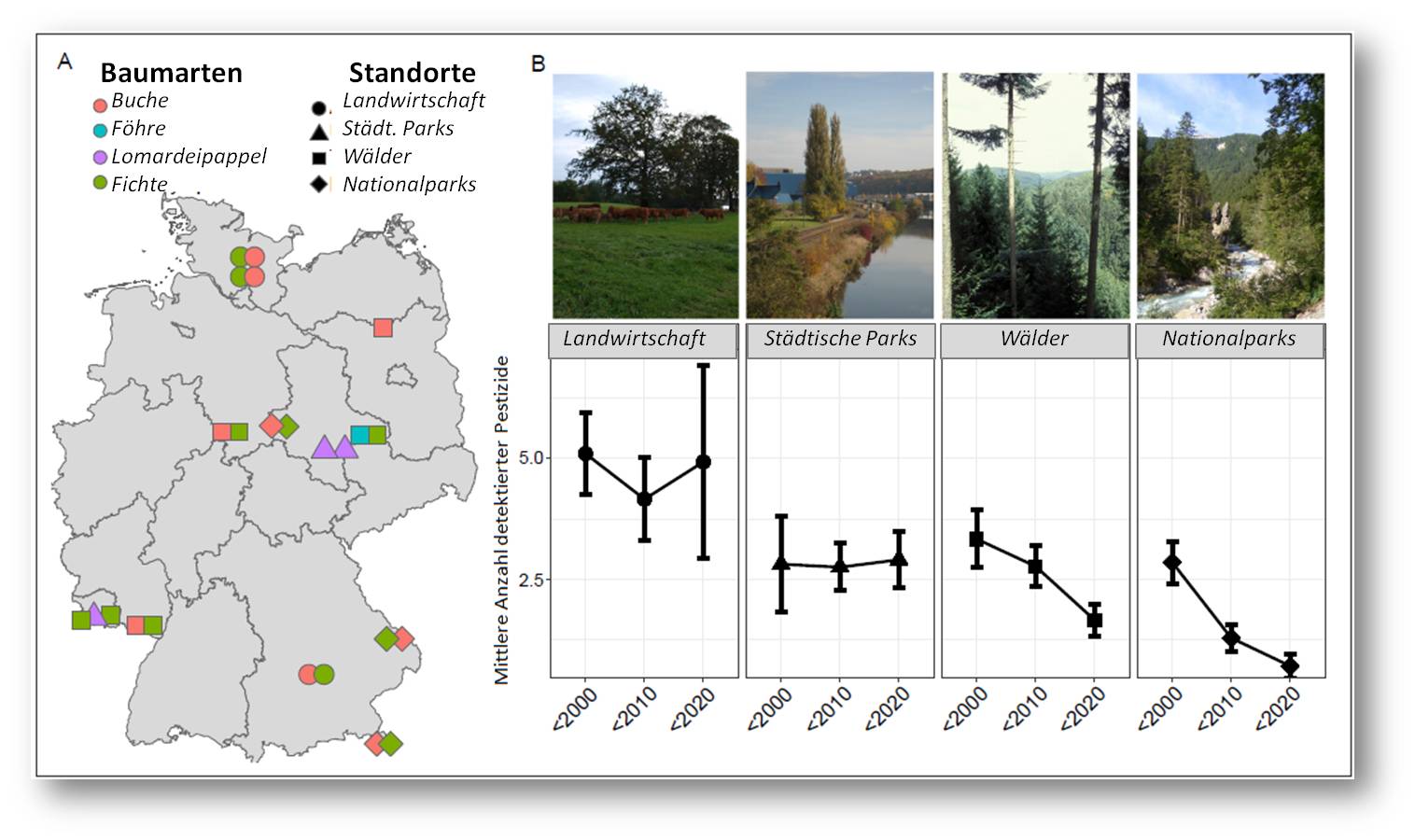

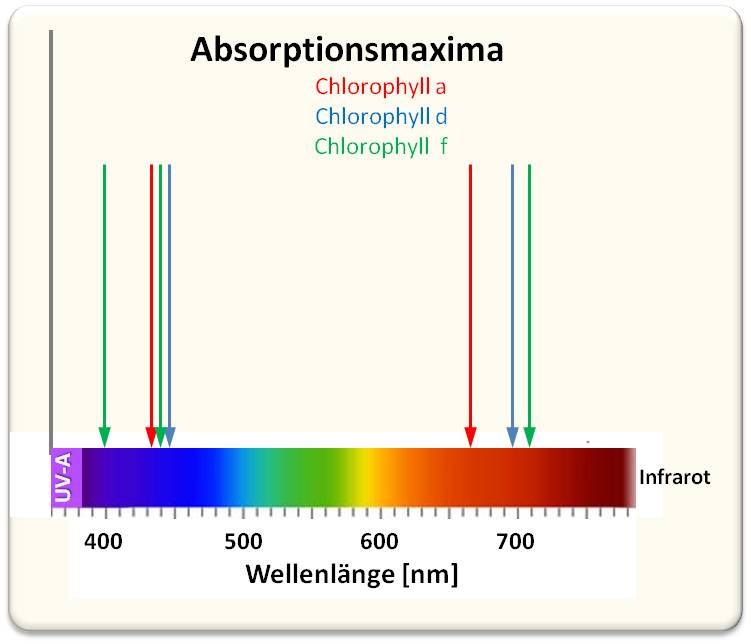

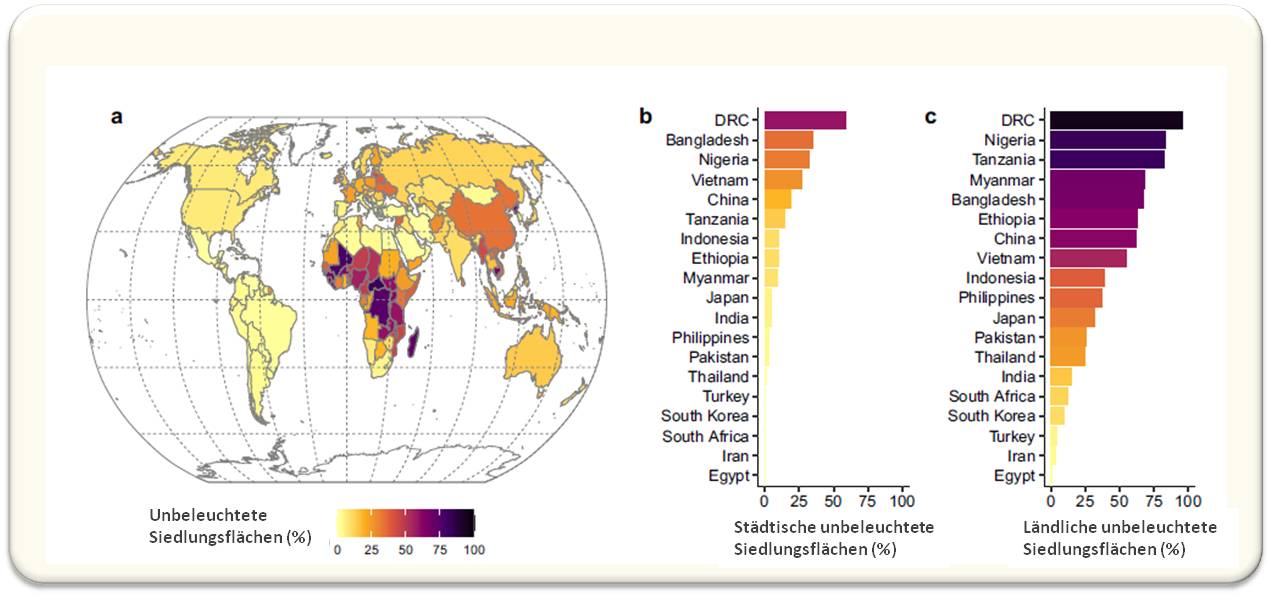

| Abbildung 1: Sammelstellen von Baumblättern und Baumarten(A) und repräsentative Typen der Landnutzung (B). Analysen der Pestizidbelastung zu drei Zeitpunkten zeigen eine gleichbleibende, mit durchschnittlich 5 Pestiziden höchste Belastung auf landwirtschaftlich genutzten Flächen. (Bild von Redn. eingefügt aus H.Krehenwinkel et al., 2022 [1]; Lizenz: cc-by) |

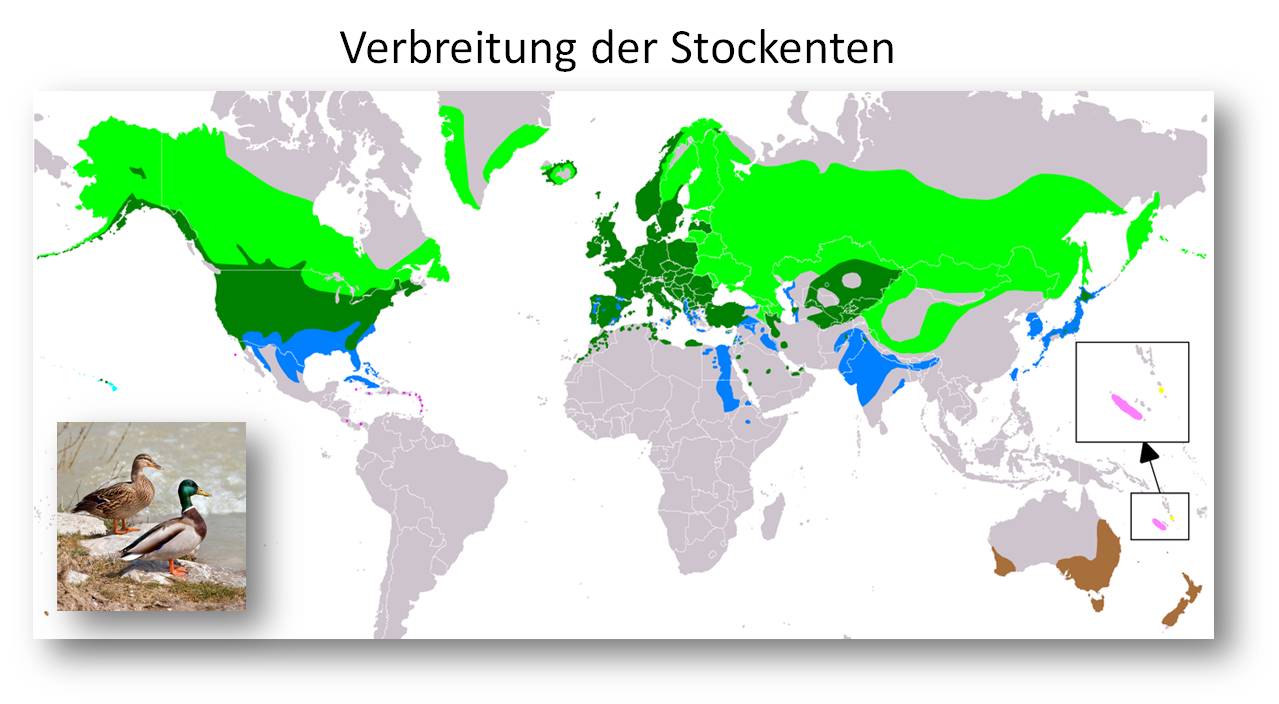

Um die Insektengemeinschaften, die in diesen Bäumen lebten, zu untersuchen, haben Krehenwinkel und sein Team zunächst die eDNA aus den Blättern extrahiert und sequenziert. Die Blätter stammten dabei von vier Baumarten - Buche, Föhre, Lombardeipapel und Fichte -, die an 24 Standorten in ganz Deutschland fachgerecht unter standardisierten Bedingungen über einen Zeitraum von 30 Jahren gesammelt und konserviert worden waren. Die Standorte waren für vier Landnutzungstypen repräsentativ: landwirtschaftlich benutzte Flächen, städtische Parks, Wälder und Nationalparks. Abbildung 1.

Die Analyse der verschiedenen DNA-Sequenzen aus den Blattproben

ergab nicht nur die Anzahl der Insektenarten, sondern auch die Häufigkeit (oder Seltenheit) der einzelnen Arten innerhalb der einzelnen Gemeinschaften. Die eDNA-Analyse hat subtile Veränderungen in der Zusammensetzung der Gemeinschaften der Waldinsekten ergeben. In den Wäldern, aus denen die untersuchten Blätter herstammten, ist die Gesamtzahl der Insektenarten im Verlauf der letzten drei Jahrzehnte weitgehend gleich geblieben. Viele einzelne Arten sind zwar zurück gegangen, aber nur um dann durch neue Arten abgelöst zu werden.

| Abbildung 2: Änderungen von Diversität und Zahl (Biomasse) der Insektenarten in allen Standorten im Zeitraum von 30 Jahren. Oben links: Über alle Standorte ist die Diversität der Insektenarten nahezu unverändert geblieben; die Reduktion einiger Arten wurde durch neue Besiedler abgelöst Oben rechts: gleichbleibende Diversität von Insektenklassen. Unten: Bei gleichbleibender Diversität ist über den Zeitraum ein Rückgang der Biomasse zu beobachten. (Bilder von Redn. eingefügt aus H.Krehenwinkel et al., 2022 [1]; Lizenz: cc-by) |

Solche Veränderungen haben sich für alle Insektenordnungen als unabhängig von der Art der Landnutzung erwiesen. Die neuen Besiedler haben sich bereits weit verbreitet - dies führt wahrscheinlich zu einem Gesamtmuster mit weniger Arten, die sich aber weiter verbreiten - mit anderen Worten zu mehr Homogenität der Populationen. Abbildung 2.

Fazit

Der Ansatz von Krehenwinkel, et al. [1] bietet eine zuverlässige Methode, um Insektenpopulationen über mehrere Jahrzehnte hinweg im Detail zu untersuchen. Dabei ist es essentiell auf archiviertes Probenmaterial aus Umweltstudien zurück greifen zu können. Informationen, die daraus gewonnen werden, haben praktische Bedeutung für Umweltfragen von enormen sozialen Auswirkungen, die vom Naturschutz über die Landwirtschaft bis hin zur öffentlichen Gesundheit reichen.

[1] Henrik Krehenwinkel et al., (2022): Environmental DNA from archived leaves reveals widespread temporal turnover and biotic homogenization in forest arthropod communities. eLife 11:e78521. https://doi.org/10.7554/eLife.78521.

* Eine leicht verständliche Zusammenfassung (Digest) des Artikels von H. Krewinkel et al., 2022, [1] ist am 20.12.2022 unter dem Titel "Insect data grown on trees" im eLife Magazin erschienen: https://elifesciences.org/digests/78521/insect-data-grown-on-trees. Der Digest wurde von der Redaktion ins Deutsche übersetzt und mit 2 Abbildungen aus dem Originaltext [1] plus Legenden ergänzt. eLife ist ein open access Journal, alle Inhalte stehen unter einer cc-by Lizenz .

Weiterführende Links:

Uni Trier (2022) eDNA: Ein entscheidender Fortschritt für das Biomonitoring. Video 4:00 min. https://www.youtube.com/watch?v=F0sTyYRiCvA

Artikel im ScienceBlog:

- Ricki Lewis, 15.12.2022: Ein 2 Millionen Jahre altes Ökosystem im Klimawandel mittels Umwelt-DNA rekonstruiert

- Ricki Lewis, 21.11.2021: Umwelt-DNA (eDNA) erlaubt einen Blick in die Dämmerzone der Meere

- Redaktion, 28.12.2017: Artikel über den dramatischen Rückgang der Insekten erzielt 2017 Top-Reichweite in Fachwelt und Öffentlichkeit

Ein 2 Millionen Jahre altes Ökosystem im Klimawandel mittels Umwelt-DNA rekonstruiert

Ein 2 Millionen Jahre altes Ökosystem im Klimawandel mittels Umwelt-DNA rekonstruiertDo, 15.12.2022 — Ricki Lewis

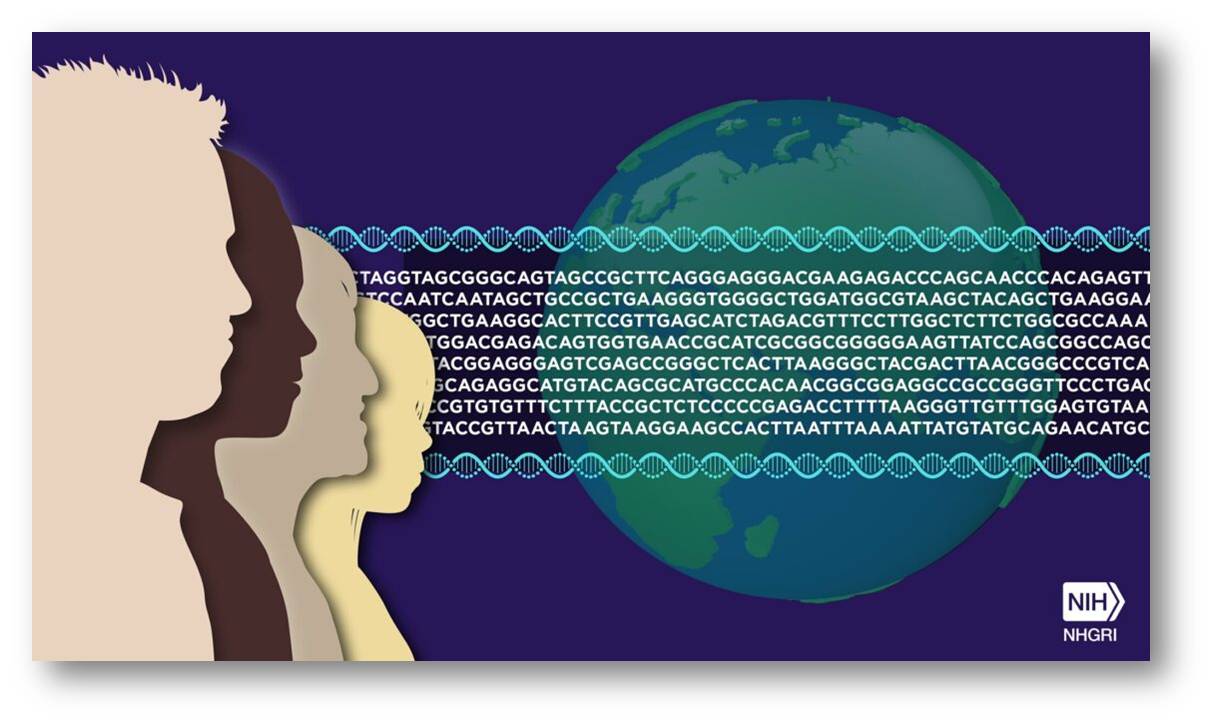

Eine vor 2 Millionen Jahren belebte Landschaft im nördlichen Grönland konnte aus an Mineralien gebundenen DNA-Stückchen rekonstruiert werden. Diese lässt ein eiszeitliches Ökosystem inmitten eines Klimawandels erkennen und zeigt möglicherweise Wege auf, wie auf die heute steigenden globalen Temperaturen reagiert werden kann. Probensammlung, Analyse und Interpretation der Umwelt-DNA aus dieser fernen Zeit und von diesem fernen Ort liefern einen "genetischen Fahrplan", wie sich Organismen an ein wärmer werdendes Klima anpassen können. Die Untersuchung war vergangene Woche das Titelthema des Fachjournals Nature [1]. Auf einer Pressekonferenz haben sechs Mitglieder des 40-köpfigen multinationalen Teams die Ergebnisse erläutert. Die Genetikerin Ricki Lewis berichtet darüber.*

Umwelt-DNA (eDNA)

wird verwendet, um sowohl frühere als auch heutige Lebensräume zu beschreiben. Bislang stammte die älteste eDNA von einem Mammut, das vor einer Million Jahren in Sibirien lebte.

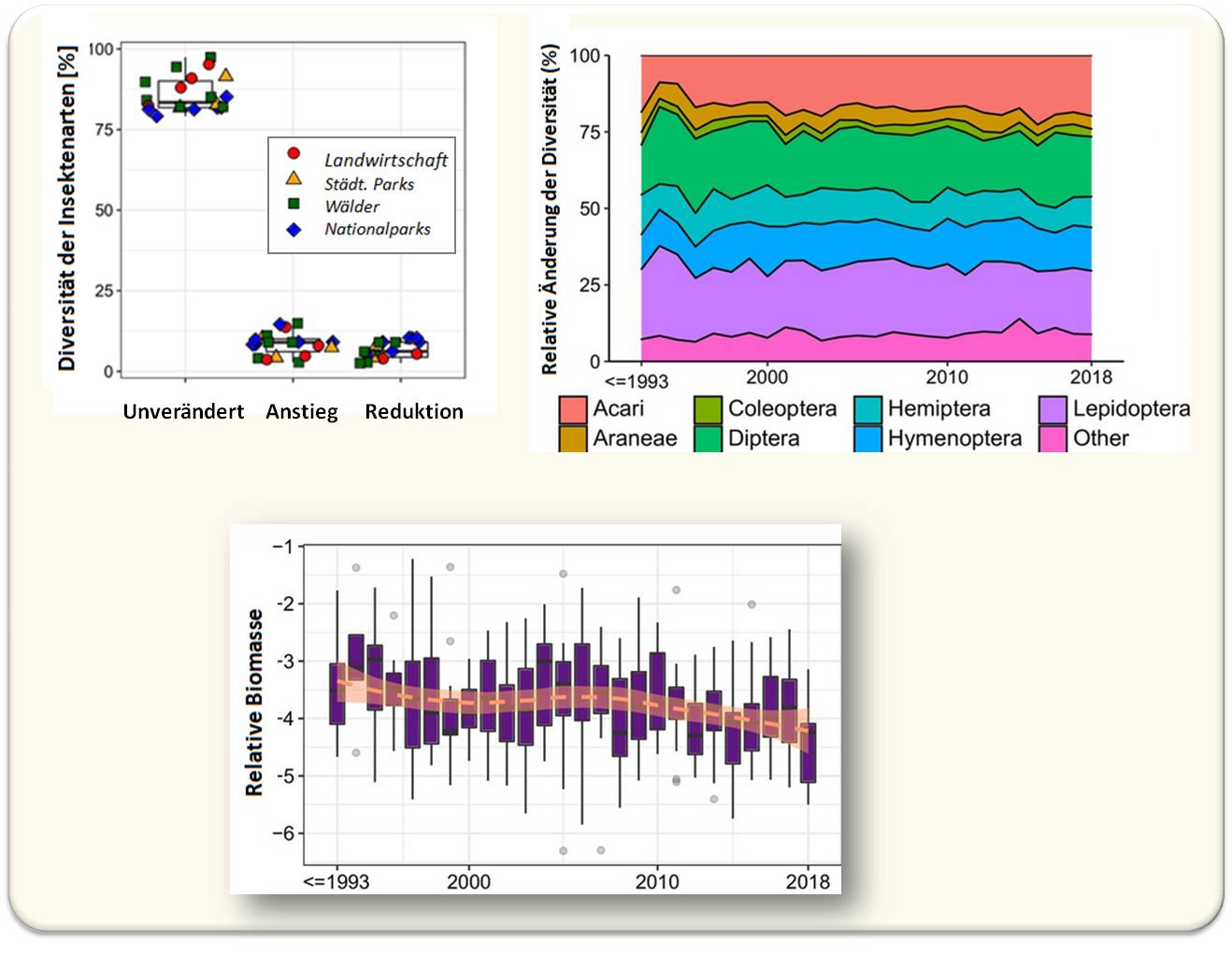

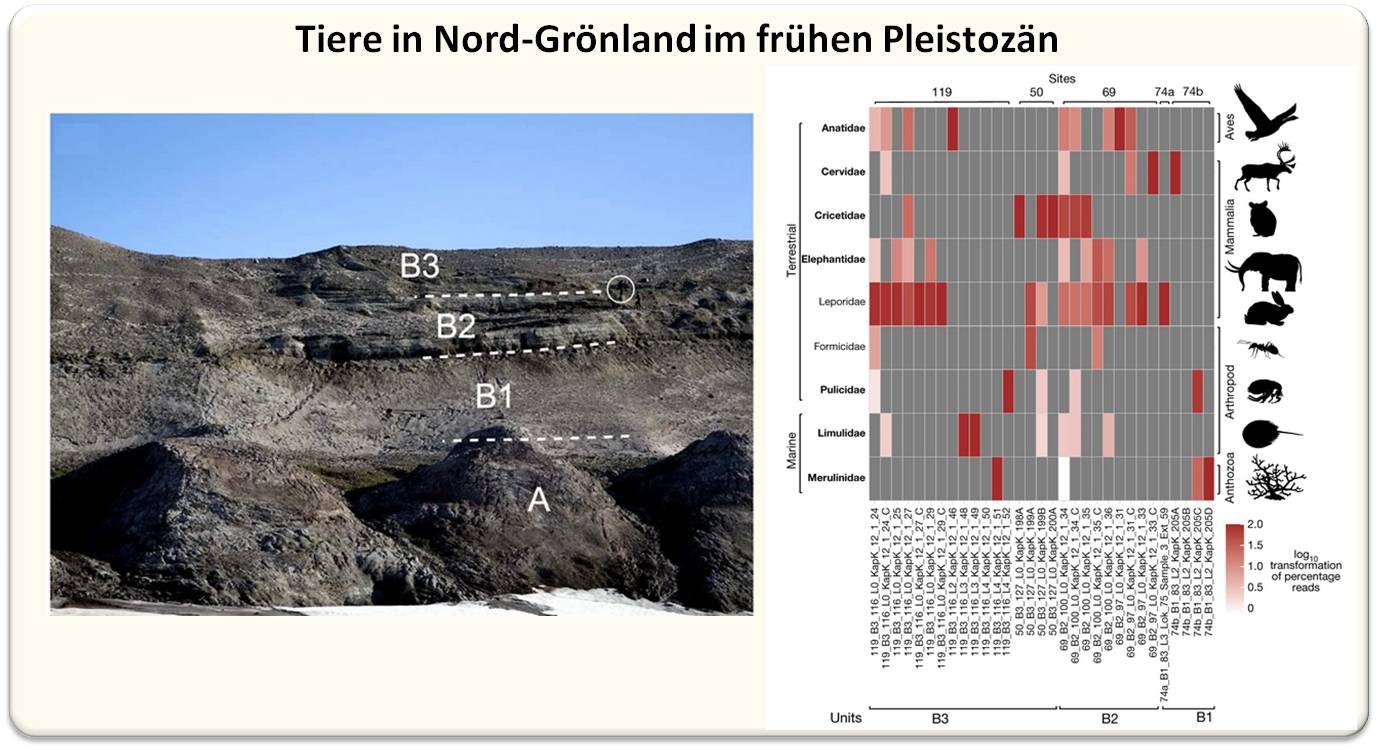

In der neuen Studie [1] kommt die eDNA aus der Kap København Formation in der "polaren Wüste" von Peary Land, Nordgrönland (Abbildung 1). Mit Fossilien und konservierten Pollen ermöglicht eDNA ein Bild längst vergangener Lebensräume zu zeichnen.

eDNA wird von den Zellen in die Umgebung ausgeschieden , wobei aus Mitochondrien und Chloroplasten stammende eDNA häufiger vorkommt als Kern-DNA, da diese Organellen in zahlreichen Kopien in einer Zelle vorliegen. Außerdem ist es wahrscheinlicher, dass sie erhalten bleibt, weil sie im Vergleich zur DNA in einem Zellkern stärker fragmentiert ist.

Der Leiter des Teams, Eske Willerslev, ein Geogenetiker von der Universität Cambridge, vergleicht von Fossilien und eDNA hergeleitete Evidenz. "Bei einem Fossil weiß man, dass die DNA von einem einzigen Individuum stammt. Aus Sedimenten heraus kann man ein Genom rekonstruieren, aber man weiß nicht, ob das Genom von einem oder mehreren Individuen stammt. Ein großer Vorteil der Umwelt-DNA ist jedoch, dass man DNA von Organismen erhalten kann, die nicht versteinert sind, und dass man das gesamte Ökosystem sehen kann." Der Umweltkontext ist ebenfalls wichtig. Man denke nur an die Fossilien eines Elefanten und einer Pflanze, die nur wenige Kilometer entfernt sind. Der Fund von DNA an den beiden Orten ist nicht so aussagekräftig wie der Fund der Pflanzen-DNA im Darm des Elefanten.

" DNA kann sich schnell zersetzen, aber wir haben gezeigt, dass wir unter den richtigen Voraussetzungen weiter in die Vergangenheit zurückgehen können, als man es sich je vorzustellen wagte. Damit schlagen wir ein neues Kapitel auf, das eine Million Jahre länger in der Geschichte zurückliegt. Zum ersten Mal können wir einen direkten Blick auf die DNA eines vergangenen Ökosystems werfen, das so weit in der Vergangenheit liegt", so Willerslev.

Der Fundort

Die Forscher haben an fünf Standorten 41 verwertbare Proben im Ton und Quarz gesammelt Abbildung 1., wobei jedes Schnipsel genetischen Materials nur Millionstel Millimeter lang war.

| Abbildung 1. Die Kap København Formation in Nord Grönland. Geografische Lage (a) und Abfolge der Ablagerungen: Räumliche Verteilung der Erosionsreste der rund 100 m mächtigen Abfolge von flachmarinen küstennahen Sedimenten zwischen Mudderbugt und dem Mittelgebirge im Norden (b und c). (Bild von Redn. eingefügt aus Kjaer et al. 2022 [1], Lizenz cc-by) . |

"Die alten DNA-Proben waren tief im Sediment vergraben, das sich über 20 000 Jahre in einer flachen Bucht angesammelt hatte. Das Sediment wurde schließlich im Eis oder im Permafrostboden konserviert und - was entscheidend ist - zwei Millionen Jahre lang nicht vom Menschen gestört", erklärt der Geologe Kurt Kjaer von der Universität Kopenhagen.

Die rund 100 m dicke Sedimentschicht sammelte sich in der Mündung eines Fjords an, der im nördlichsten Punkt Grönlands in den Arktischen Ozean ragt. Am Ende der pleistozäne Eiszeit, vor zwei bis drei Millionen Jahren, schwankte das Klima in Grönland eine Zeit lang zwischen arktisch und gemäßigt. Die Temperaturen waren um 10 bis 17 Grad Celsius wärmer als heute.

Geschichten aus der eDNA lesen

Drei technologische Fortschritte ermöglichten laut Willerslev die Untersuchung:

- die Entdeckung, wie DNA an Mineralienpartikel bindet,

- eine neue Sequenzierungsplattform, die kleine Schnipsel "frayed" DNA (DNA mit an den Enden geöffneten Basenpaaren) verarbeiten kann,

- das Sammeln des alten genetischen Materials (mit einem coolen "Arctic PaleoChip" - klingt wie ein Diäteis, ist aber eine optimierte Strategie zu gezielten Anreicherung der eDNA).

Für die Konservierung der eDNA hat deren Wechselwirkung mit der Mineral-Grenzfläche eine entscheidende Roll gespielt. Karina Sand von der Universität Kopenhagen eklärt: "Marine Bedingungen haben die Adsorption der DNA an Mineralien begünstigt; die recht starke Bindung konnte so den enzymatischen Abbau der eDNA verhindern. Alle Mineralien in der Formation konnten DNA adsorbieren, allerdings in anderen Stärken, als wir sie kannten."

Im offenen Meerwasser hätte - laut Sand - die Bindung von DNA an Mineralien nicht stattgefunden. Die Forscher haben die Bindung moderner DNA an Oberflächen mit Hilfe der Rasterkraftmikroskopie untersucht und die Parameter manipuliert, um nachzuvollziehen, was mit den konservierten DNA-Stücken in den alten Sedimenten Grönlands wohl geschehen war.

Dann verglichen die Forscher die kurzen eDNA-Sequenzen mit denen moderner Arten in DNA-Datenbanken. Einige Proben stimmten mit entfernten zeitgenössischen Verwandten überein, während andere keine Treffer ergaben. Anhand bekannter Mutationsraten bestimmter DNA-Sequenzen lassen sich Zeitrahmen auf alte DNA anwenden.

Als die ersten Artenidentifizierungen mit ungefähren Zeitangaben eintrafen, waren die Forscher zunächst verwirrt, berichtet Mikkel Pedersen von der Universität Kopenhagen. "Als ich die Daten erhielt, kam mir das verrückt vor, ich verstand die Zeitstempel nicht. Wir hatten Taxa (taxonomische Gruppen) verschiedener Landpflanzen und -tiere, und plötzlich tauchten marine Arten auf! Das war wirklich merkwürdig. Also rannte ich zu Kurts Büro und fragte: 'Was hast du mir gegeben? Marine Taxa oder terrestrische?' Das war ein Zeichen dafür, dass der Boden in eine marine Umgebung gespült worden war." Abbildung 2.

| Abbildung 2. Terrestrische und marine Tiere am Fundort 69. Taxonomische Profile der Tierbestände aus den Sedimentgruppen B1, B2 und B3 (b). (Bild von Redn. eingefügt aus Kjaer et al. 2022 [1], Lizenz cc-by) . |

Flora und Fauna des alten Ökosystems

Das Bild des alten Ökosystems glich einem riesigen, aus wenigen Teilen bestehenden Puzzle - aus Fossilien, konservierten Pollen und DNA, die vor allem aus den widerstandsfähigen Chloroplasten und Mitochondrien stammte. Anhand dieser spärlichen Hinweise identifizierte das Team 102 Pflanzenarten, von Algen bis hin zu Bäumen, auf Gattungsebene - die Auflösung war nicht hoch genug, um Arten zu unterscheiden, so Pedersen. "Wir fanden 9 Tierarten, die zu dieser Zeit in der Landschaft am häufigsten vorkamen (und DNA hinterlassen hatten)- Abbildung 2 -, sowie viele Bakterien und Pilze. Wahrscheinlich ist die große Mehrheit der Pflanzen und Tiere aufgrund ihrer ständig niedrigen Biomasse nicht nachweisbar", fügte er hinzu.

Fossilien und DNA aus dem südlichen Teil des Gebiets deuten auf Pappeln, Rotzedern und Tannen hin. "Die Pflanzen kamen in einer Weise zusammen vor, die wir heute nicht mehr sehen würden. Es war ein offener borealer Wald mit Pappeln, Weiden, Birken und Thujabäumen und einer Mischung aus arktischen und borealen Sträuchern und Kräutern", so Pedersen.

Mastodonten lebten in diesem Gebiet, was überraschend war, da sie aufgrund ihrer Fossilien nur aus Nord- und Mittelamerika bekannt waren. Die neue Information wurde durch den reichlichen Kot des riesigen Tieres möglich, der auch Spuren der DNA seiner Nahrung von Bäumen und Sträuchern enthält.

Die DNA zeigte auch, dass atlantische Pfeilschwanzkrebse weiter südlich im Atlantik lebten als heute, was auf wärmere Oberflächengewässer während des Pleistozäns schließen lässt. Winzige DNA-Stücke stammen auch von Gänsen, Hasen, Rentieren, Lemmingen, einem Korallenriff-Erbauer und einer Ameisen- und Flohart.

Der Schauplatz

Bis zur Entdeckung der DNA war die einzige Spur eines Säugetiers ein Stück eines Zahns. Willerslev erzählte, wie das Team auf seinen Fund reagierte:

"Als wir 2006 wegen eines anderen Projekts in dieses Gebiet kamen, haben wir nicht viel gesehen. Es war ähnlich wie in der Sahara, fast kein Leben. Flechten, Moose, das war's. Es war also sehr aufregend, als wir die DNA wiederherstellten und ein ganz anderes Ökosystem zum Vorschein kam. Aus Makrofossilien wusste man, dass es dort einen Wald gegeben hatte, aber die DNA identifizierte viel mehr Taxa. Pollen und Makrofossilien hatten einige Arten identifiziert, aber die Umwelt-DNA identifizierte 102 Pflanzen!

Als wir die DNA eines Mastodons, eines mit Nordamerika assoziierten Tieres, fanden, dachten wir, dass es nach Grönland geschwommen sein und das Eis überquert haben musste!

Wir haben auch Rentiere detektiert. Erstaunlich! Wir hatten erwartet, dass es sich dabei um eine viel jüngere Art handelt. Rentierhaare und Pfeilschwanzkrebse in einer Meeresumgebung lassen auf ein viel wärmeres Klima schließen.

Stellen Sie sich vor, Sie stehen mit Gummistiefeln in der Bucht, schauen nach oben und sehen einen Wald, Mastodonten und Rentiere, die herumlaufen, und einen Fluss, der Sedimente und Ablagerungen vom Land mit sich führt. Deshalb ist die DNA eine Mischung aus terrrestrischen und marinen Organismen. Irgendwann hob sich das Land, so dass die riesigen Berge jetzt im Landesinneren liegen und nicht mehr an der Küste." Abbildung 3.

| Abbildung 3. " Stellen Sie sich vor, Sie stehen mit Gummistiefeln in der Bucht, schauen nach oben und sehen einen Wald, Mastodonten und Rentiere,......". (Illustration credit: Beth Zaiken/bethzaiken.com; siehe [2]) |

Ein Vorbehalt gegenüber der Aussagekraft der eDNA-Forschung ist die Häufigkeit des eDNA-Vorkommens: Von einer Art mit einer kleinen Population wird wahrscheinlich kaum eDNA auftauchen. Und das ist der Grund, warum nach der Beweislage, Karnivoren in Grönland nicht vorkamen.

Es ist ein Zahlenspiel, so Willerslev. "Je mehr Biomasse, desto mehr DNA ist übrig. Pflanzen sind häufiger als Pflanzenfresser und die wiederum häufiger als Fleischfresser. Aber wenn wir weiterhin Proben nehmen und die DNA sequenzieren, sage ich voraus, dass wir irgendwann Beweise für Fleischfresser finden werden, vielleicht ein Tier, das Mastodonten gefressen hat." Er fügt hinzu, dass es (noch) keine-DNA Evidenz für Bären, Wölfe und Säbelzahntiger gibt, vertraute Bewohner pleistozäner Szenen.

Ein genetischer Fahrplan

Ist der in Grönland entdeckte Zeitabschnitt ein Vorbote dessen, was die derzeitige Klimaerwärmung mit sich bringen wird? Wahrscheinlich nicht, sagt Willerslev, aber das ist nicht unbedingt eine schlechte Nachricht:

"Dieses Ökosystem und seine Mix aus arktischen und gemäßigten Arten hat kein modernes Gegenstück. Das deutet darauf hin, dass unsere Fähigkeit, die biologischen Folgen des Klimawandels vorherzusagen, ziemlich schlecht ist. Ausgehend von der heutigen Artenvielfalt hätte niemand ein solches Ökosystem vorausgesagt. Dies zeigt jedoch, dass die Plastizität der Organismen größer und komplexer ist, als wir es uns vorgestellt haben. "

Was wir haben, betont Willerslev, ist eine "genetische Roadmap mit Hinweisen in Form von Genen, wie sich Organismen an einen sehr schnellen Klimawandel anpassen. Aber viele dieser Anpassungen sind wahrscheinlich verloren gegangen, weil sie über lange Zeit keinen Nutzen brachten. Jetzt vollzieht sich der Klimawandel extrem schnell, und die Evolution kann dem nicht folgen. Wir sollten also mit großen Aussterbeereignissen rechnen."

Was aber, wenn wir die Informationen aus Studien wie der in Grönland nutzen, um den DNA-Veränderungen, die die Anpassung an Umweltveränderungen vorantreiben, zuvorzukommen? Kann die Biotechnologie hier eingreifen? Vielleicht.

"Die Gentechnik könnte die Strategie nachahmen, die Pflanzen und Bäume vor zwei Millionen Jahren entwickelt haben, um in einem Klima mit steigenden Temperaturen zu überleben und das Aussterben einiger Arten zu verhindern", so Kjaer.

Willerslev rechnet damit, dass sich solche Bemühungen zunächst auf Pflanzen konzentrieren. "Die Roadmap kann Aufschluss darüber geben, wo und wie man das Genom einer Pflanze verändern kann, um sie widerstandsfähiger gegen den Klimawandel zu machen. Die Werkzeuge sind vorhanden. Das klingt drastisch, und ich sage nicht, dass es so sein sollte, aber es eröffnet eine neue Möglichkeit, die Auswirkungen des Klimawandels abzumildern."

Doch im Moment könnte das Überleben der Arten ein Wettlauf mit der Zeit sein, auch wenn sich das Klima schon früher verändert hat. Pedersen zieht eine eher ernüchternde Bilanz:

"Die Daten deuten darauf hin, dass sich mehr Arten entwickeln und an stark schwankende Temperaturen anpassen können als bisher angenommen. Entscheidend ist jedoch, dass diese Ergebnisse zeigen, dass sie dafür Zeit brauchen. Die Geschwindigkeit der heutigen globalen Erwärmung bedeutet, dass Organismen und Arten diese Zeit nicht haben, so dass der Klimanotstand eine enorme Bedrohung für die Artenvielfalt bleibt. Für einige Arten steht das Aussterben unmittelbar bevor."

----------------------------------------------------

[1] Kjær, K.H., Winther Pedersen, M., De Sanctis, B. et al. A 2-million-year-old ecosystem in Greenland uncovered by environmental DNA. Nature 612, 283–291 (2022). https://doi.org/10.1038/s41586-022-05453-y. open access;Lizenz: cc-by

[2]The world's oldest DNA: Extinct beasts of ancient Greenland. Nature Video 9:12 min. https://www.youtube.com/watch?v=qav579ZURpk&t=550s.

* Der Artikel ist erstmals am 8.Dezember 2022 in PLOS Blogs - DNA Science Blog unter dem Titel "A 2-Million-Year-Old Ecosystem in the Throes of Climate Change Revealed in Environmental DNA" https://dnascience.plos.org/2022/12/08/a-2-million-year-old-ecosystem-in-the-throes-of-climate-change-revealed-in-environmental-dna/ erschienen und steht unter einer cc-by Lizenz . Die Autorin hat sich freundlicherweise mit der Übersetzung ihrer Artikel durch ScienceBlog.at einverstanden erklärt, welche so genau wie möglich der englischen Fassung folgen.

Die globale Krise der Antibiotikaresistenz und diesbezügliches Wissen und Verhaltensweisen der EU-Bürger (Spezial Eurobarometer 522)

Die globale Krise der Antibiotikaresistenz und diesbezügliches Wissen und Verhaltensweisen der EU-Bürger (Spezial Eurobarometer 522)So, 11.12.2022— Redaktion

![]()

Übermäßiger und untauglicher Einsatz von Antibiotika in Human- und Veterinärmedizin hat zunehmend zur Entstehung (multi-) resistenter Keime geführt, gegen die auch die potentesten Reserve-Antibiotika nichts mehr ausrichten können; an und mit antibiotikaresistenten Infektionen sterben weltweit jährlich bereits Millionen Menschen. Um die Ausbreitung solcher Infektionen einzudämmen, ist ein gezielter, maßvoller Umgang mit Antibiotika erforderlich. Dies setzt ausreichende Kenntnisse über Antibiotika, deren Gebrauch und Risiken voraus. Seit 2009 hat die EU-Kommission ihre Bürger nun bereits zum fünften Mal hinsichtlich ihres diesbezüglichen Wissenstands, ihrer Einstellungen und Verhaltensweisen befragt. Laut der diesjährigen Umfrage ist der Einsatz von Antibiotika zwar auf den bislang niedrigsten Wert gesunken, allerdings nimmt die Hälfte der Befragten fälschlicherweise an, dass Antibiotika gegen Virusinfektionen wirken und wendet diese auch dagegen an - das Problem, dasss über 90 % der dafür ausgestellten Rezepte und Behandlungen von Ärzten stammten, wird nicht behandelt [1].

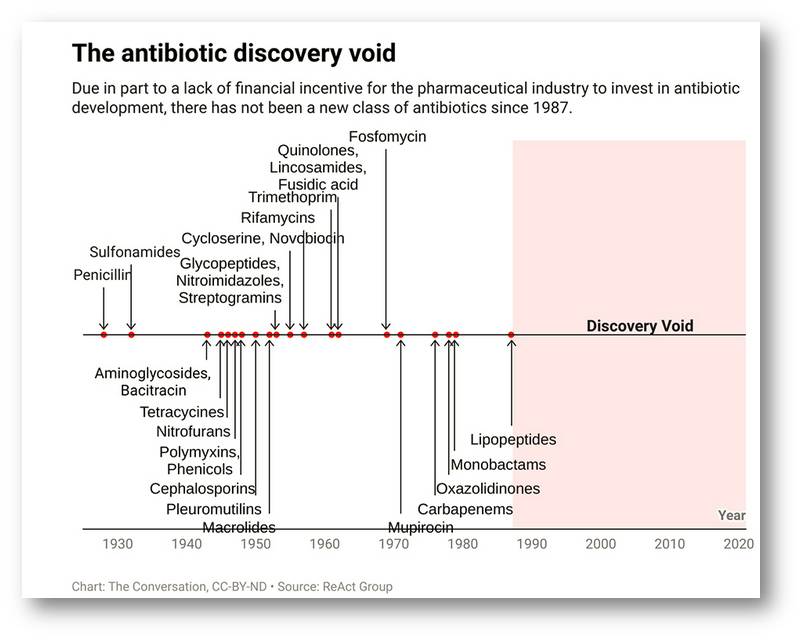

Die Krise der Antibiotikaresistenz ist - wie auch andere derzeitige Krisen - eine globale und anthropogen, vom Menschen gemacht. Verursacht wurde sie durch übermäßigen Einsatz und falsche Anwendung der vorhandenen Antibiotika und eine vor mehr als 30 Jahren ins Stocken geratene Entwicklung neuer wirksamer Antibiotika, gegen die (vorübergehend noch) keine Resistenzen bestehen. Zuvor existierte eine so breite Palette hochwirksamer Medikamente, dass die Pharmaindustrie die Forschung und Entwicklung neuer Antibiotikaklassen einstellte und aus nachvollziehbaren Rentabilitätsgründen auch nicht wieder aufnahm, als Resistenzen gegen mehr und mehr "alte" Antibiotika auftauchten. Abbildung 1.

| Abbildung 1. Seit mehr als 30 Jahren sind keine neue Klassen von Antibiotika auf den Markt gekommen. (Bild übernommen aus A. Hudson (11.2021) https://www.asbmb.org/asbmb-today/policy/110721/antibiotic-resistance-is-at-a-crisis-point. Quelle React Group, Lizenz cc-by-nd) |

Antibiotikaresistenzen sind auf dem Vormarsch....

Mikroorganismen - ob es sich nun um Bakterien, Pilze, Algen, Viren oder Protozoen handelt - werden in zunehmendem Maße gegen antimikrobielle Substanzen resistent, auf die sie vordem hochsensitiv angesprochen haben. Dies ist ein natürlicher Evolutionsprozess, der auf Genmutation und Selektion der fittesten - d.i. im Infektionsprozess am besten propagierenden - Mikrobenstämme basiert.

Bakterien vermehren sich sehr rasch und machen bei der Kopierung ihres Erbguts relativ viele Fehler. Durch solche Mutationen kann eine bakterielle Zielstruktur (Target) von dem dagegen designten Antibiotikum schlechter/nicht mehr erkannt werden; das betroffene Bakterium kann sich in Gegenwart des Antibiotikums weiter zu einer neuen, resistenteren Population vermehren. Erfolgt eine Antibiotika Behandlung nicht ausreichend lang, oder war die Dosis zu niedrig, um auch die resistenteren Keime zu eliminieren, so bleiben diese über und können ihre Resistenzgene auch auf andere Bakterien übertragen. So entstehen dann multiresistente Erreger.

Der übermäßige Einsatz von Antibiotika in der Human- und Veterinärmedizin und ihre falsche Anwendung - etwa bei der Behandlung von Viren, gegen die sie ja unwirksam sind, oder wenn sie nicht über die notwendige Behandlungsdauer eingenommen werden - haben die Resistenzentwicklung von Bakterien gegen diese Medikamente forciert und zu einer enormen Gefahr für die ganze Welt werden lassen.

Gegen Antibiotika (multi)resistente Bakterien kommen überall und in allen Ländern vor. Sie finden sich in Lebensmitteln, in der Umwelt, bei Tier und Mensch; in Spitälern - vor allem in den Intensivstationen - stellen sie eine enorme Bedrohung dar. Es wird damit immer schwieriger, Patienten vor solchen Infektionen zu schützen und chirurgische Eingriffe, Transplantationen, Chemotherapien und andere Behandlungen mit nur geringem Risiko durchzuführen. Ein Video der WHO vor 2 Wochen hat eingehend vor einem Aufsuchen von Spitälern ohne triftigem Grund gewarnt [2].

Eine Prognose der WHO aus dem Jahr 2015 geht davon aus, dass 2050 voraussichtlich bereits 10 Millionen Menschen an bakteriellen Infektionen sterben werden, mehr als an der bisherigen Nummer 1, den Krebserkrankungen, sofern keine wirksamen neuen Medikamente, Vakzinen oder andere Behandlungsmethoden auf den Markt kommen. Eine neue Studie [3] lässt befürchten, dass dieser Todeszoll schon viel früher erreicht werden wird.

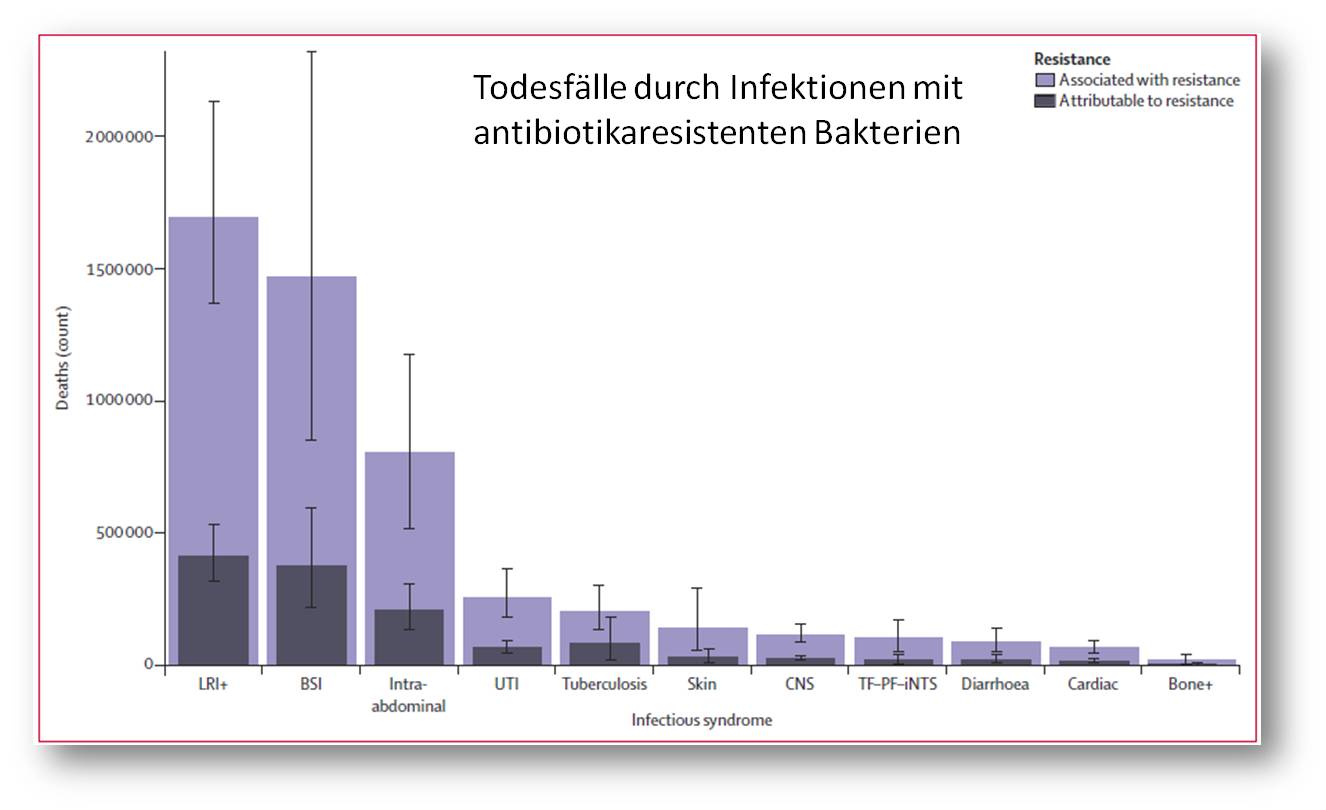

....... und gehören bereits zu den häufigsten Todesursachen

Die Entwicklung der Corona-Pandemie hat die Gefahr der global steigenden Antibiotikaresistenzen vorübergehend in den Hintergrund rücken lassen, obwohl deren Auswirkungen noch gravierender sein dürften, als die von COVID-19. So sind laut täglichem Dashboard seit Beginn der Pandemie anfangs 2020 rund 6,65 Millionen Menschen an und mit COVID-19 verstorben. Pandemien sind definitionsgemäß aber zeitlich begrenzt, nicht so Antibiotikaresistenzen - die Zahl der Schwerstkranken und der Todeszoll steigen weiter und weiter. Eine neue, im Rahmen des Global Research on Antimicrobial Resistance (GRAM) Project durchgeführte Studie, liefert die erste umfassende Evaluierung der antibiotikaresistenten Bakterien und deren Auswirkungen auf der ganzen Welt. Basierend auf der Analyse von 471 Millionen einzelnen Datensätzen oder Isolaten aus 204 Ländern kommt das Autorenteam (mehr als 170 Forscher!) zu dem Schluss, dass 1,27 Millionen Todesfälle im Jahr 2019 direkt durch Antibiotikaresistenzen verursacht wurden und insgesamt 4,95 Millionen Verstorbene mit mindestens einer antibiotikaresistenten Infektion assoziiert wurden [3].

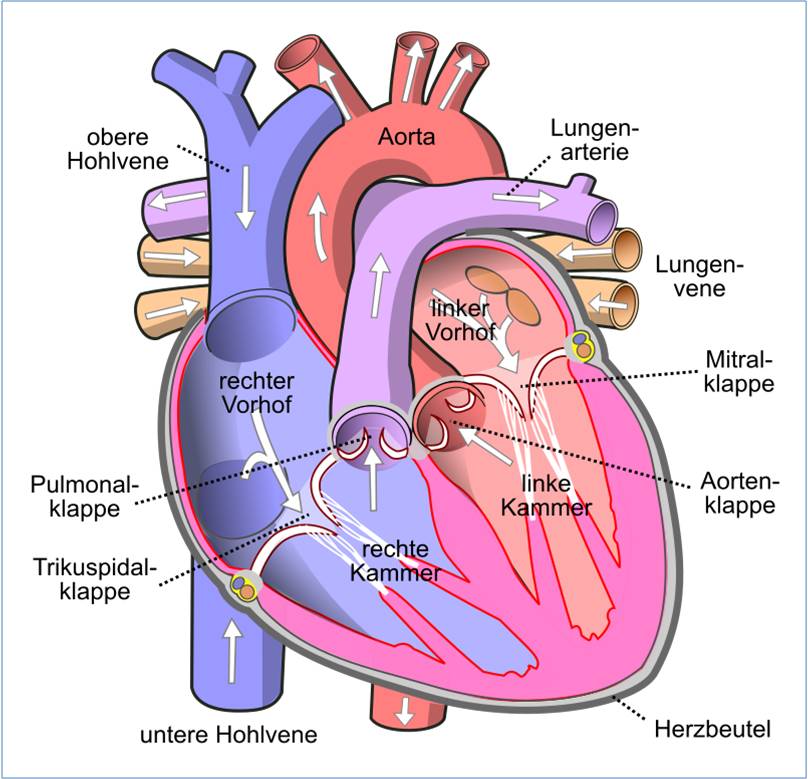

Es sind durchwegs häufige, früher auf Antibiotika gut ansprechende bakterielle Infektionen, die nun durch resistente, oft multiresistente Keime ausgelöst werden; vor allem sind hier Infektionen der unteren Atemwege, des Blutkreislaufs (Sepsis) und intraabdominelle Infektionen zu nennen, die Hunderttausende Todesopfer fordern. Abbildung 2. Für fast 80 % dieser Todesfälle sind 6 (multi)resistent gewordene Bakterienstämme verantwortlich von: Escherichia coli , Staphylococcus aureus, Klebsiella pneumoniae , Streptococcus pneumoniae, Acinetobacter baumannii, und Pseudomonas aeruginosa [3].

Diese Ergebnisse unterstreichen die Notwendigkeit kollektiver globaler Maßnahmen, wie die Entwicklung neuer Antibiotika - die von der Pharmaindustrie über Jahrzehnte ignoriert wurden - und Impfstoffe und eine verbesserte Überwachung der Antibiotikaresistenz.

| Abbildung 2. Weltweite Todesfälle (Zahlen), die auf bakterielle Resistenz gegen Antibiotika zurückzuführen sind ("attributable")/ damit in Verbindung stehen ("associated"), nach infektiösem Krankheitsbild. Abkürzungen stehen für bakterielle Infektionen von: LRI+: unteren Atemwegen,Thorax; BSI: Blutbahn; UTI: Harntrakt, Pyelonephritis; CNS: Meningitis u.a. CNS Infektionen, cardiac: Endocarditis u.a.; Skin= Haut und Subcutis; Bone+: Knochen, Gelenke; TF–PF–iNTS= Typhus, Paratyphus und invasive nicht-typhoide Salmonella spp. (Bild aus ‘Global burden of bacterial antimicrobial resistance in 2019: a systematic analysis’ [2]; Lizenz: cc-by) |

Zur Situation in der EU....

Laut einem aktuellen Report der ECDC (Europäisches Zentrum für die Prävention und die Kontrolle von Krankheiten) sind im Zeitraum 2016 - 2020 in der EU/EEA jährlich mehr als 35 000 Menschen an antibiotikaresistenten Infektionen gestorben [4]; 4 Jahre zuvor war man noch von mehr als 25 000 Todesfällen ausgegangen. Die Infektionen mit den oben genannten resistenten Bakterienstämmen haben sich z.T. mehr als verdoppelt.

Die Bekämpfung von antibiotikaresistenten Infektionen hat zweifellos prioritäre Bedeutung. Die EU hat bereits 2017 den Aktionsplan "One Health" ins Leben gerufen, der über 70 Maßnahmen in neun Politikbereichen umfasst und Gesundheit von Mensch und Tier, Landwirtschaft, Umwelt und Forschung einschliesst [5]. Es kommt darin klar zum Ausdruckt, dass "menschliche und tierische Gesundheit miteinander zusammenhängen, Krankheiten vom Menschen auf Tiere und umgekehrt übertragen werden und deshalb bei beiden bekämpft werden müssen" [5].

Zudem soll auch für ein besseres Verständnis der EU-Bürger für das Resistenzproblem und einen sachgerechten Umgang mit Antibiotika gesorgt werden. In diesem Sinn hat nun bereits zum fünften Mal seit 2009 - vom Feber bis März 2022 - eine Befragung der EU-Bürger zur Antibiotikaresistenz stattgefunden.

.........und EU-weite Umfrage zur Antibiotikaresistenz - Spezial Eurobarometer 522

Wie in den vergangenen Umfragen war das Ziel Kenntnisse, Meinungen und Verhaltensweisen der EU-Bürger zum Problem antimikrobielle Resistenz zu erheben. Im Auftrag der EU-Kommission erfolgte die Umfrage in den 27 Mitgliedstaaten vom 21.Feber bis 21.März, und insgesamt 26 511 Personen ab 15 Jahren und aus unterschiedlichen sozialen und demographischen Gruppen - rund 1000 Personen je Mitgliedsland -nahmen teil. Diese wurden persönlich (face to face) in ihrem Heim und in ihrer Muttersprache interviewt.

Wie auch 2018 wurden die Teilnehmer u.a. gefragt ob und warum sie im letzten Jahr Antibiotika genommen hatten, wie sie diese erhalten hatten und ob ein Test auf den Erreger der Erkrankung erfolgt war.

Des weiteren gab es Fragen

- zum Kenntnisstand über die Funktionsweise von Antibiotika, über die mit einem unnötigen Einsatz verbundenen Risiken, ob sich die Bürger ausreichend über die Notwendigkeit den unnötigen Antibiotikaeinsatz einzuschränken informiert fühlten, sowie ihr Interesse, mehr und aus welchen Quellen über Antibiotika zu erfahren,

- zu Ansichten über die am besten geeignete politische Reaktion auf Antibiotikaresistenzen,

- zu Einstellungen zur Verwendung von Antibiotika bei kranken Tieren und zur Kenntnis des Verbots einer Anwendung von Antibiotika zur Wachstumsförderung bei Nutztieren,

- zum Verbrauch von Antibiotika sowie Zugang und Bedarf an Antibiotika im Zusammenhang mit der COVID-19-Pandemie.

Die Antworten lauteten ähnlich wie 2018 und nicht minder besorgniserregend:

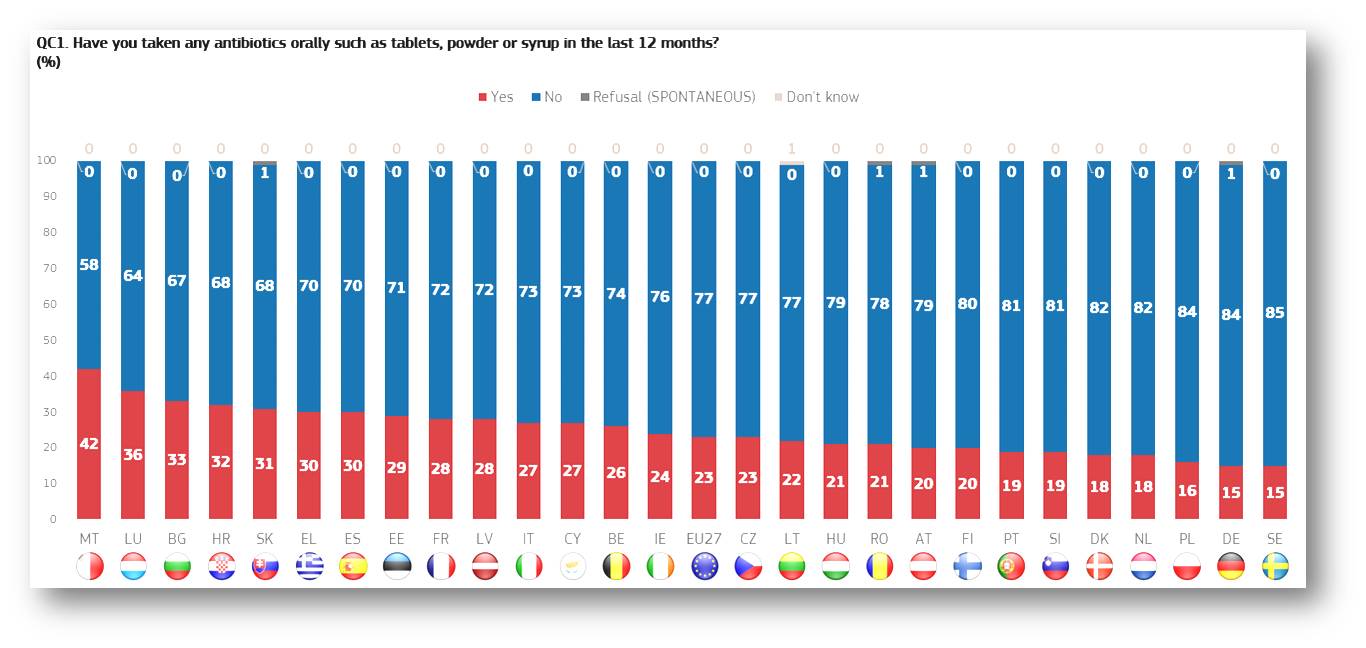

Haben Sie im letzten Jahr Antibiotika genommen?

Diese Frage beantworteten im EU27-Mittel 23 % der befragten Bürger mit Ja. Dies war scheinbar ein erfreulicher Rückgang zu den früheren Umfragen: 2009 waren es im Mittel 40 %, 2018 immerhin noch 32 %. Der Unterschied im Antibiotikaverbrauch der einzelnen Länder war beträchtlich und reichte von 15 % in Schweden und Deutschland bis 42 % in Malta; in Österreich haben 20 % der befragten Personen angegeben Antibiotika genommen zu haben. Abbildung 3.

Allerdings dürfte der starke Rückgang seit 2018 eine Folge der COVID-19 Epidemie sein: In einem späteren Abschnitt gaben im EU27-Schnitt insgesamt 45 % - in Österreich 47 % - der Befragten an, dass durch COVID-19 der Bedarf an Antibiotika gesunken sei, weil sie aufgrund verstärkter persönlicher Schutzmaßnahmen wie Masken, räumlicher Distanzierung, verstärkter Handhygiene und auch während der Lockdowns seltener erkrankten.

| Abbildung 3. Haben Sie im letzten Jahr orale Antibiotika genommen? Zwischen 15 und 42 % der Teilnahme bejahen diese Frage.(Quelle: [1]) |

Es ist hier besonders wichtig zu betonen, dass der überwiegende Teil der Befragten in allen Ländern (80 - 95 %) ihre Antibiotika über ein ärztliches Rezept oder direkt vom Arzt erhalten haben, der Rest hatte es sich sonst wo -- in Apotheken, von Freunden, aus übrig gebliebenen Packungen - besorgt. Am unteren Ende der Skala lagen Österreich und Belgien mit 84 % ärztlichen Verschreibungen und Rumänien mit 80 %.

Wofür wurden Antibiotika eingesetzt?

Der (COVID-19-bedingte) Rückgang im Verbrauch von Antibiotika erhält einen negativen Beigeschmack, da ein beträchtlicher Teil der EU-Bürger diese fälschlicherweise bei viralen Infektionen wie "Erkältung", Grippe, der zumeist viral verursachten Bronchitis und den Begleitsymptomen (Fieber, Halsschmerzen, Husten) einsetzte, in denen Antibiotika nutzlos sind:

Nach der im EU27-Schnitt am häufigsten genannten Harnwegsinfektion (15 %) rangierten bereits Anwendungen bei Halsschmerzen (13 %), Bronchitis (12 %), Erkältung (11 %), Grippe (10 %) und Fieber (10 %), um die 9% hatten Antibiotika auch gegen COVID-19 angewandt. Dabei erfolgte die Verschreibung von Antibiotika im EU27-Schnitt bei rund 53 % der Befragten (in Österreich bei 51 %) ohne dass eine Testung auf Bakterien in Blut, Harn oder Speichel stattgefunden hätte.

Man kann sich darüber nur wundern, dass Ärzte für bis zu 98 % der angewandten Antibiotika Rezepte ausgestellt haben, auch wenn offensichtlich virale Infektionen vorlagen, und auch nur in der Hälfte der Fälle auf das mögliche Vorliegen bakterieller Infektionen getestet wurde.

Kenntnisse über Antibiotika und ihre Anwendung

Hier wurden dieselben 4 Fragen wie bereits 2018 gestellt, die Antworten lassen nach wie vor besorgniserregende Wissenslücken erkennen.

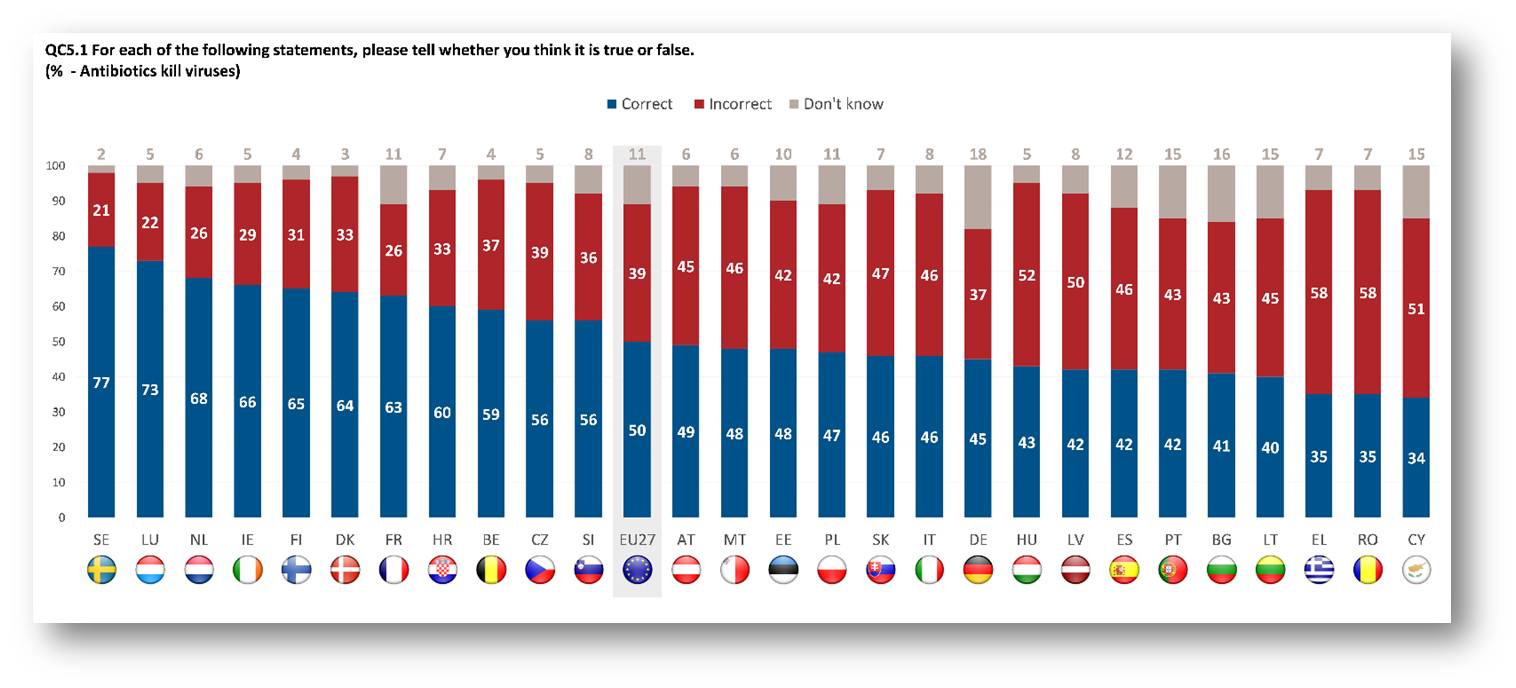

- Können Antibiotika Viren töten ? Im EU27-Mittel gaben nur 50 % (2018: 43 %) der Befragten die richtige Antwort "Nein", dass Antibiotika dazu nicht imstande sind. 11 % sagten, dass sie es nicht wüssten. Auch in den bestabschneidenden Ländern Schweden, Luxemburg, Niederlande und Irland gaben nur 3/4 bis 2/3 der Befragten die richtige Antwort. Österreich hat mit 49 % gegenüber 2018 - damals 28 % - aufgeholt. Abbildung 4.

| Abbildung 4 Können Antibiotika Viren töten? Wissenslücken bestehen in allen Ländern (Quelle: [1]) |

- 2. Sind Antibiotika bei Verkühlung wirksam? Im EU27-Schnitt wurde dies von 62 % der Teilnehmer richtig mit "Nein" beantwortet (2018 waren es 66 %). In nur 6 Staaten (Ungarn, Bulgarien, Polen, Griechenland, Zypern und Rumänien) gab weniger als die Hälfte die richtige Antwort.

- Kann unnötige Anwendung von Antibiotika zu deren Wirkungsverlust führen? Hier wussten die Europäer besser Bescheid. 82 % der Teilnehmer bejahten dies (2018 waren es 85 %). Nur 5 Staaten - Bulgarien, Frankreich, Italien, Ungarn und Rumänien - lagen mit der richtigen Antwort unter 80 %.

- Ist die Anwendung von Antibiotika häufig mit Nebenwirkungen - beispielsweise Durchfall - verbunden? Wie 2018 ist in allen Staaten der überwiegende Teil der befragten Bevölkerung - EU27-Mittel 67 % (2018 68 %) - dieser Meinung. Die Bandbreite reicht von 57 % in Rumänien bis 81 % in Polen.

Der Kenntnisstand ist zusammengefasst, ähnlich wie 2018: europaweit ist etwa nur ein Viertel der Teilnehmer in der Lage die 4 Fragen richtig zu beantworten, und es gibt keinen Staat, in welchem die Mehrheit der Bevölkerung auf alle 4 Fragen die richtige Antwort gibt. Am besten schneidet Nordeuropa ab (Finnland, Schweden, Holland, Luxemburg und Dänemark), am schlechtesten Lettland, Rumänien und Bulgarien.

- Ähnlich wie 2018 war dem Großteil der Befragten (EU-Schnitt 85 %) bewusst, dass Antibiotika in der vom Arzt verschriebenen Menge und Dauer genommen werden sollen. Allerdings meinen im Mittel 13 %, dass sie mit der Einnahme aufhören können, sobald es ihnen besser geht.

- Darüber, dass Antibiotika nicht unnötigerweise (beispielsweise bei einer Verkühlung) eingenommen werden sollten, fühlte sich nur ein Fünftel der Befragten informiert. Diese hatten die Information im Wesentlichen vom ihrem Arzt, Apotheker aber auch aus verschiedenen Medien erhalten, wobei Arzt und Apotheker als besonders vertrauenswürdig angesehen wurden.

--------------------------------------------------------------------------------

- Die Anwendung von Antibiotika im Veterinärgebiet, die damit verbundenen Risiken und die Einstellungen dazu in der EU sollen wegen der enormen Wichtigkeit in einem nachfolgenden Artikel dargestellt werden.

Fazit

Durch uns verursachte Antibiotikaresistenzen haben eine sehr bedrohliche Lage entstehen lassen, die - wie im Fall von COVID-19 - nur durch ernsthafte, globale Anstrengungen gemildert/gelöst werden kann. Hier brauchbare Informationen zu liefern, ist auch das Ziel der letzten diesbezüglichen EU-weiten Umfrage [1]: "Um die Resistenz gegen antimikrobielle Mittel, die eine große Bedrohung für die öffentliche Gesundheit in Europa und weltweit darstellt, zu verlangsamen und zu verringern, ist es von entscheidender Bedeutung, den übermäßigen und falschen Einsatz von Antibiotika zu reduzieren. Das Wissen, die Einstellung und das Verhalten der Allgemeinheit spielen eine Schlüsselrolle bei der Gewährleistung eines umsichtigen Einsatzes von Antibiotika.".

Der vorliegende Report [1] zur Umfrage hält dieser Ambition leider in keiner Weise stand. Es ist eine Aneinanderreihung von Zahlen aus den einzelnen Ländern, ohne die Ergebnisse im Zusammenhang zu diskutieren:

Beispielsweise wird in den Conclusions stolz verkündet, dass der Antibiotikaverbrauch im letzten Jahr stark gesunken ist, ohne darauf einzugehen, dass dies - den Antworten der EU-Bürger entsprechend - zumindest zum großen Teil - den Restriktionen der COVID-19 Pandemie geschuldet war. Ebendort wird auch konstatiert, dass "insgesamt das Wissen der Europäer über Antibiotika verbesserungswürdig ist", da ja nur "die Hälfte weiß, dass Antibiotika gegen Viren unwirksam sind" und ein hoher Anteil der Europäer diese auch bei viralen Infektionen - Erkältungen, Influenza und deren Symptomen - einsetzt. Dass über 90 % der dafür ausgestellten Rezepte und Behandlungen von Ärzten stammten, und daher primär deren Vorgangsweise in Frage gestellt werden sollte, wird nicht angesprochen. Unerwähnt in den Conclusions bleibt auch der enorme Antibiotikaverbrauch im Veterinärgebiet mit den Risiken der weiten Verbreitung (multi)resistenter Keime.

Alles in allem ist Eurobarometer 522 ein ärgerliches, oberflächliches Machwerk, dessen Informationsgehalt mit den vermutlichen Kosten kaum im Einklang steht.

------------------------------------------------------------

[1] Special Eurobarometer 522: Antimicrobial Resistance. 17. November 2022. doi: 10.2875/16102

[2] WHO's Science in 5: Microbes are becoming resistant to antibiotics (24 November 2022), Video 5:29 min. https://www.youtube.com/watch?v=ELRw0jRiJe0&t=320s

[3] Antimicrobial Resistance Collaborators ‘Global burden of bacterial antimicrobial resistance in 2019: a systematic analysis’ Lancet2022; 399: 629-55. https://doi.org/10.1016/ S0140-6736(21)02724-0

[4] 35 000 annual deaths from antimicrobial resistance in the EU/EEA (press release, 17. 11.2022). https://www.ecdc.europa.eu/en/news-events/eaad-2022-launch

[5] Europäischer Aktionsplan zur Bekämpfung antimikrobieller Resistenzen im Rahmen des Konzepts „Eine Gesundheit“ {SWD(2017) 240 final} https://eur-lex.europa.eu/legal-content/DE/TXT/?uri=COM%3A2017%3A339%3AFIN

Weiterführende Links

Antibiotic resistance - the silent tsunami. Video 2:50 min. https://www.youtube.com/watch?v=Uti42LK3lAQ

Wie wirken Antibiotika? Video 5:44 min. Eine sehr leicht verständliche Zusammenfassung (2015; Standard YouTube Lizenz)

Artikel im ScienceBlog:

Redaktion, 22.11.2018: Eurobarometer 478: zum Wissenstand der EU-Bürger über Antibiotika, deren Anwendung und Vermeidung von Resistenzentstehung

Inge Schuster, 23.09.2016: Gehen wir auf eine Post-Antibiotika Ära zu?

Mit dem Herzen sehen: Wie Herz und Gehirn kommunizieren

Mit dem Herzen sehen: Wie Herz und Gehirn kommunizierenDo. 01.12.2022— Susanne Donner

Hirn und Herz kommunizieren miteinander über das autonome Nervensystem und über Botenstoffe und beeinflussen einander massiv. Im Gehirn existiert ein Abbild des Herzens: Der Herzschlag ist dort über das Herzschlag-evozierte Potential (HEP) repräsentiert. Mit dem Herzschlag ändert sich unsere Wahrnehmung und sogar unsere Neigung zu Vorurteilen. Umgekehrt wirken sich psychische Belastungen sowie neurologische Erkrankungen auf die Herzgesundheit aus. Die Chemikerin und Wissenschaftsjournalistin Susanne Donner fasst die faszinierenden Ergebnisse dieser neuen Forschungsrichtung zusammen.*

Die 85 Männer ahnten nicht, dass sie sich auf ein Experiment eingelassen hatten, das später in die Lehrbücher der Psychologie eingehen würde. Ein Teil von ihnen überquerte auf einer stabilen Holzbrücke den kanadischen Capilano Canyon. Eine andere Gruppe musste über eine schwankende Hängebrücke auf die andere Seite gelangen. Festhalten konnten sie sich bei dieser furchteinflößenden Überquerung nur an zwei Drahtseilen. Links und rechts ging es 70 Meter in die Tiefe.

Auf der Mitte der beiden Brücken wartete jeweils eine attraktive Frau. Die Probanden sollten in ihrem Beisein einen Fragenbogen ausfüllen und einen Text schreiben. Für weitere Fragen bot die Frau ihre private Rufnummer an.

Mit dem Experiment wollten Donald Dutton und sein Kollege Arthur Aron von der University of British Columbia in Vancouver herausfinden, ob die aufregende Brückenüberquerung die Wahrnehmung und das Verhalten gegenüber der attraktiven Mitarbeiterin beeinflusste.

Weiche Knie oder Schmetterlinge im Bauch?

1974 veröffentlichten die Psychologen ihr Experiment im Journal of Personality and Social Psychology – mit Ergebnissen, die bis heute schmunzeln lassen: Ein Drittel der Männer, die jener Frau auf der schwankenden Hängebrücke begegnete, rief sie später an. Nach der Überquerung der stabilen Brücke nahmen dagegen nur elf Prozent der Männer Kontakt auf. Offenbar projizierten die Probanden ihre Aufregung auf die Frau und wähnten sich zu ihr hingezogen. Das verrieten auch die Texte, die die Männer schrieben: Auf der schwankenden Brücke enthielten die Schriftstücke mehr sexuelle Bezüge [1].

Die falsche Zuordnung des Gefühls zu einem Ereignis bezeichnen Psychologen als „Fehlattribution“. Dahinter steht, dass sich weiche Knie und Schmetterlinge im Bauch ja tatsächlich ähnlich anfühlen: In beiden Fällen schlägt das Herz fester, der Puls beschleunigt sich. „Mann“ schwitzt vielleicht.

Nun sind wir nicht jeden Tag verliebt und schon gar nicht begeben wir uns regelmäßig auf eine schwankende Hängebrücke. Doch die Kommunikation zwischen Herz und Hirn beeinflusst unser Leben permanent.

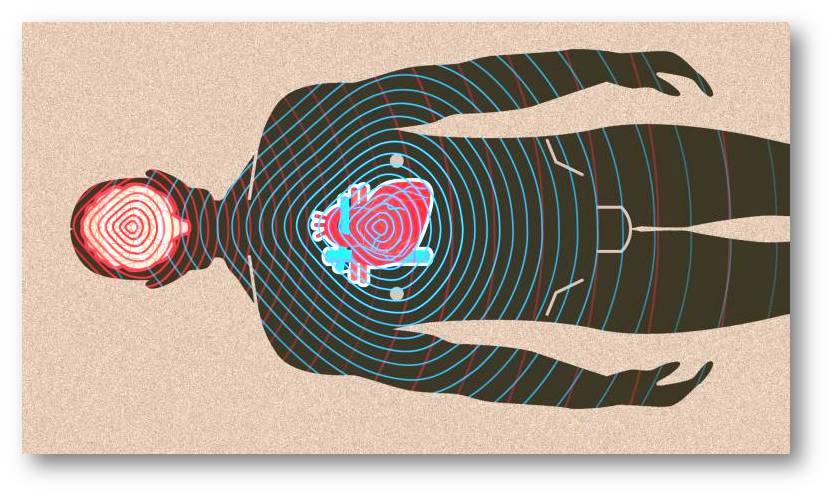

Der immergleiche Herzschlag ist gefährlich

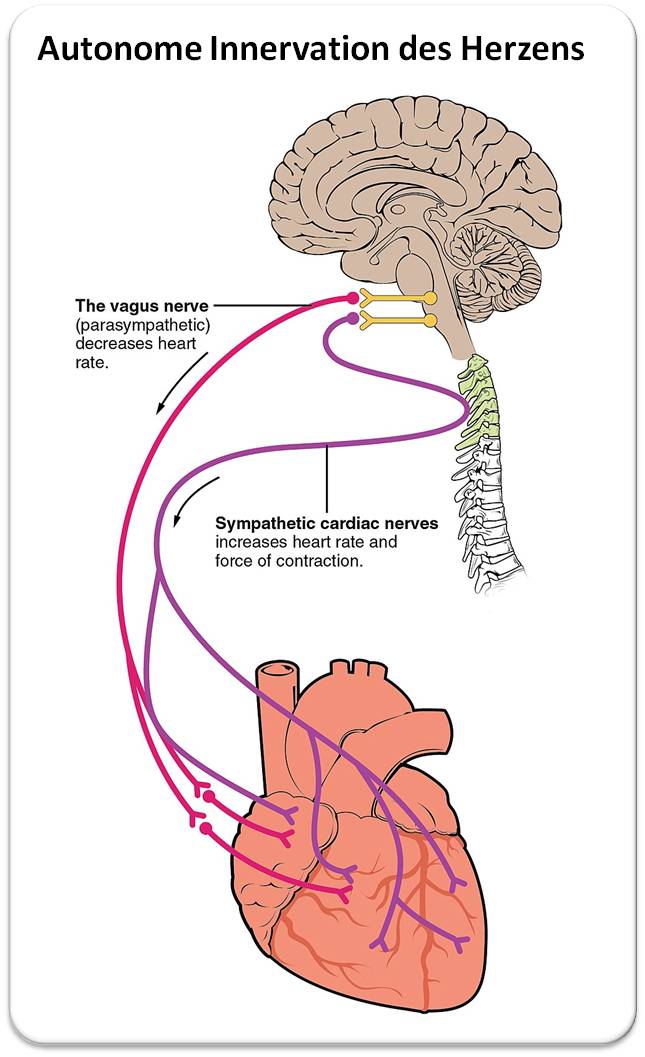

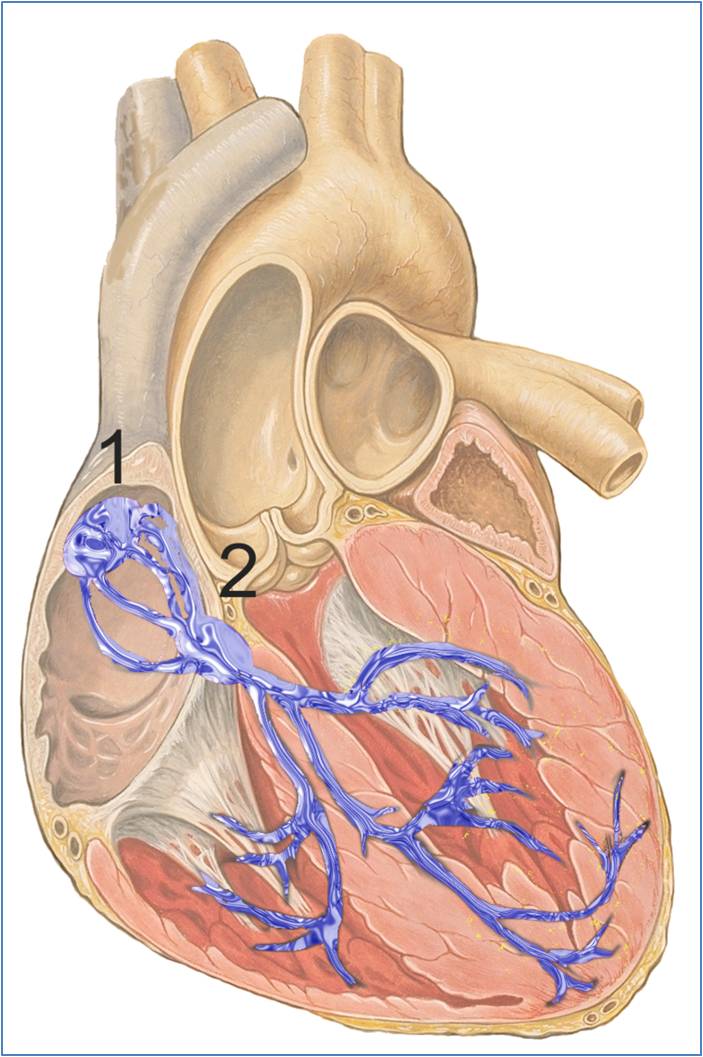

Beide Organe sind gewissermaßen über eine Standleitung verbunden, das autonome Nervensystem. „Autonom“ heißt es, weil es sich nicht direkt willentlich beeinflussen lässt. Es besteht aus Sympathicus und Parasympathicus. Die beiden Nervensysteme werden überwiegend vom Hirnstamm gesteuert und wirken als Gegenspieler. Abbildung 1.

| Abbildung 1. . Sympathicus und Parasympathicus regulieren die Herzaktivität (Bild von Redn. eingefügt aus: OpenStax College - Anatomy & Physiology, Connexions Web site; Fig. 19.32. http://cnx.org/content/col11496/1.6/ Lizenz: cc-by) |

Der Sympathicus aktiviert uns und sorgt für die notwendigen körperlichen Reaktionen auf Angriff und Flucht. Er lässt unser Herz beispielsweise bei Bedrohung schneller schlagen und erhöht den Muskeltonus. Er sorgt für ein rotes Gesicht in einer peinlichen Situation oder für hektische Flecken bei einem Vortrag.

Der Parasympathicus dagegen bringt uns in die Ruhe. Er verlangsamt die Atmung und lässt das Herz gemächlich schlagen. Auf diese Weise halten sich Entspannung und Anspannung beim gesunden Menschen ständig die Waage. Im Nebeneffekt ist der Herzschlag variabel. Er passt sich ständig der jeweiligen Situation an. Eine hohe Herzratenvariabilität gilt als Zeichen einer vitalen Herz-Hirn-Connection und letztlich von Gesundheit. „Eine starre Herzfunktion ist dagegen lebensbedrohlich und kann zum plötzlichen Tod führen“, sagt Neurologe Arno Villringer vom Max-Planck-Institut für Kognitions- und Neurowissenschaften in Leipzig.

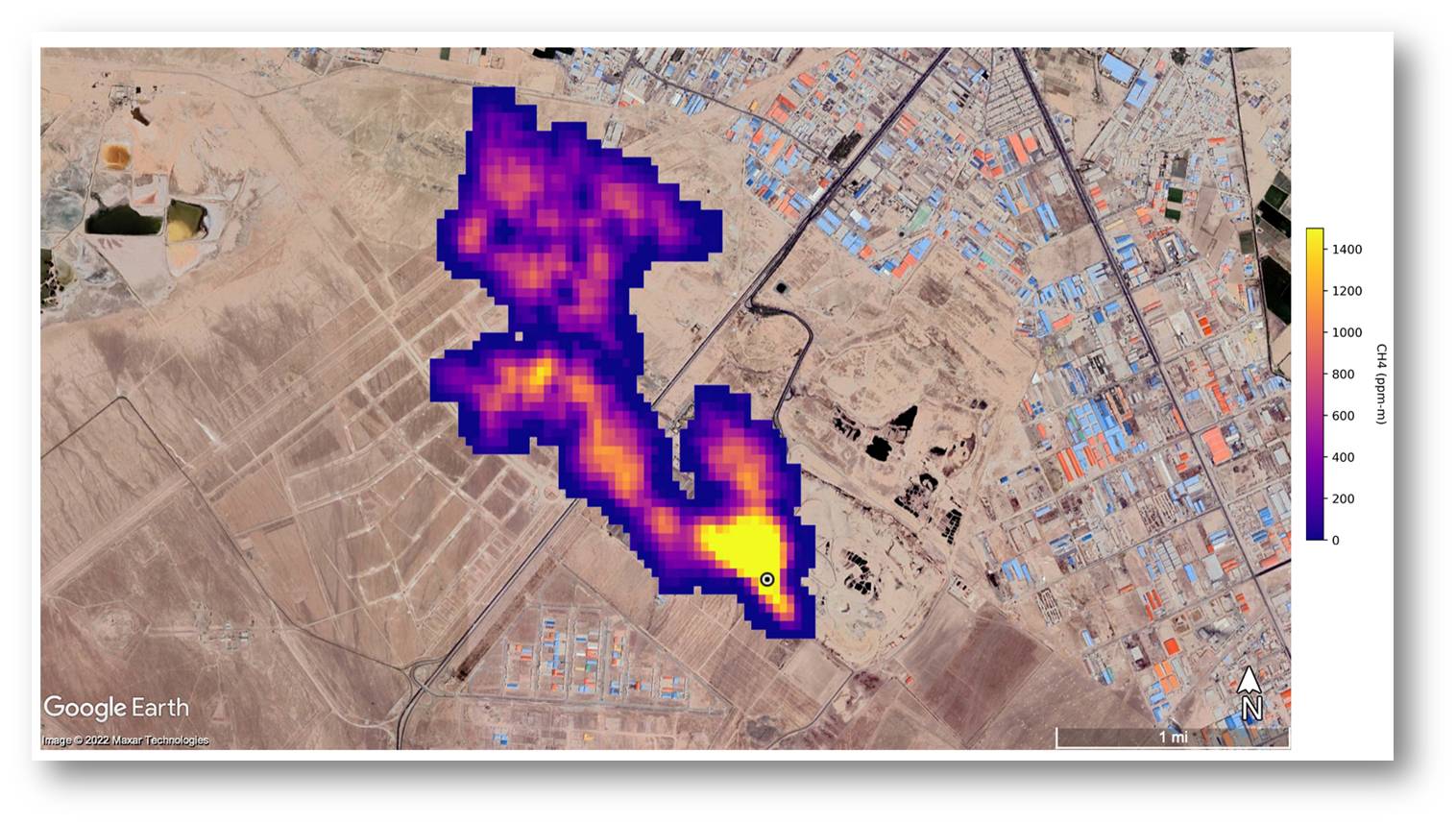

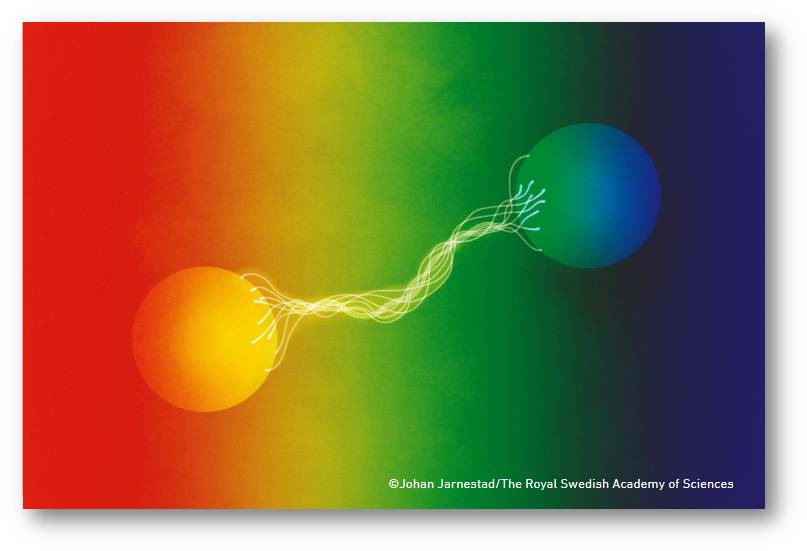

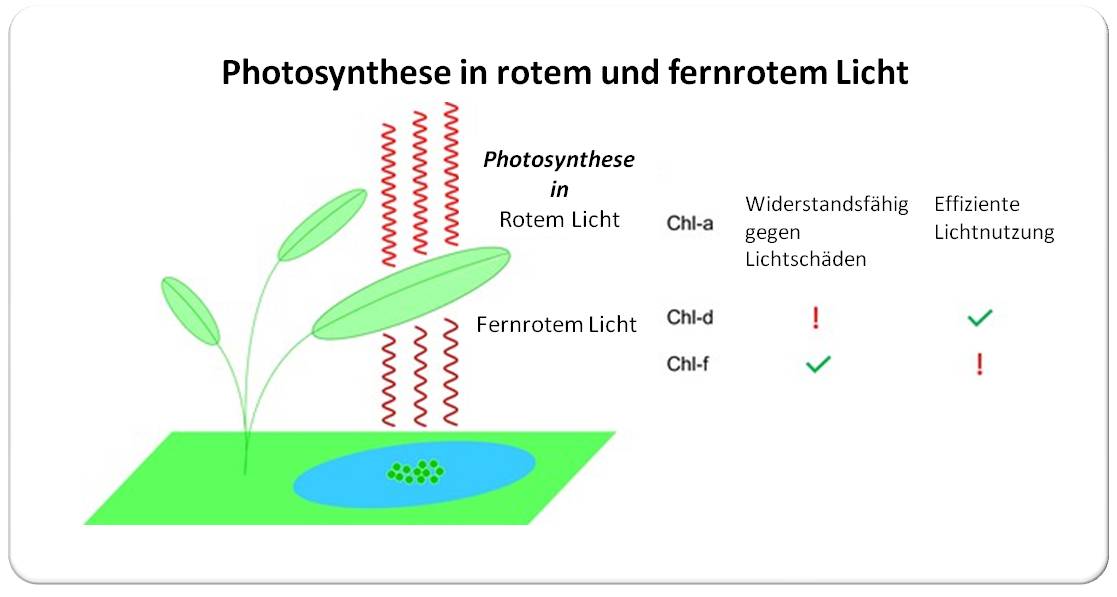

Ein Abbild des Herzens im Hirn

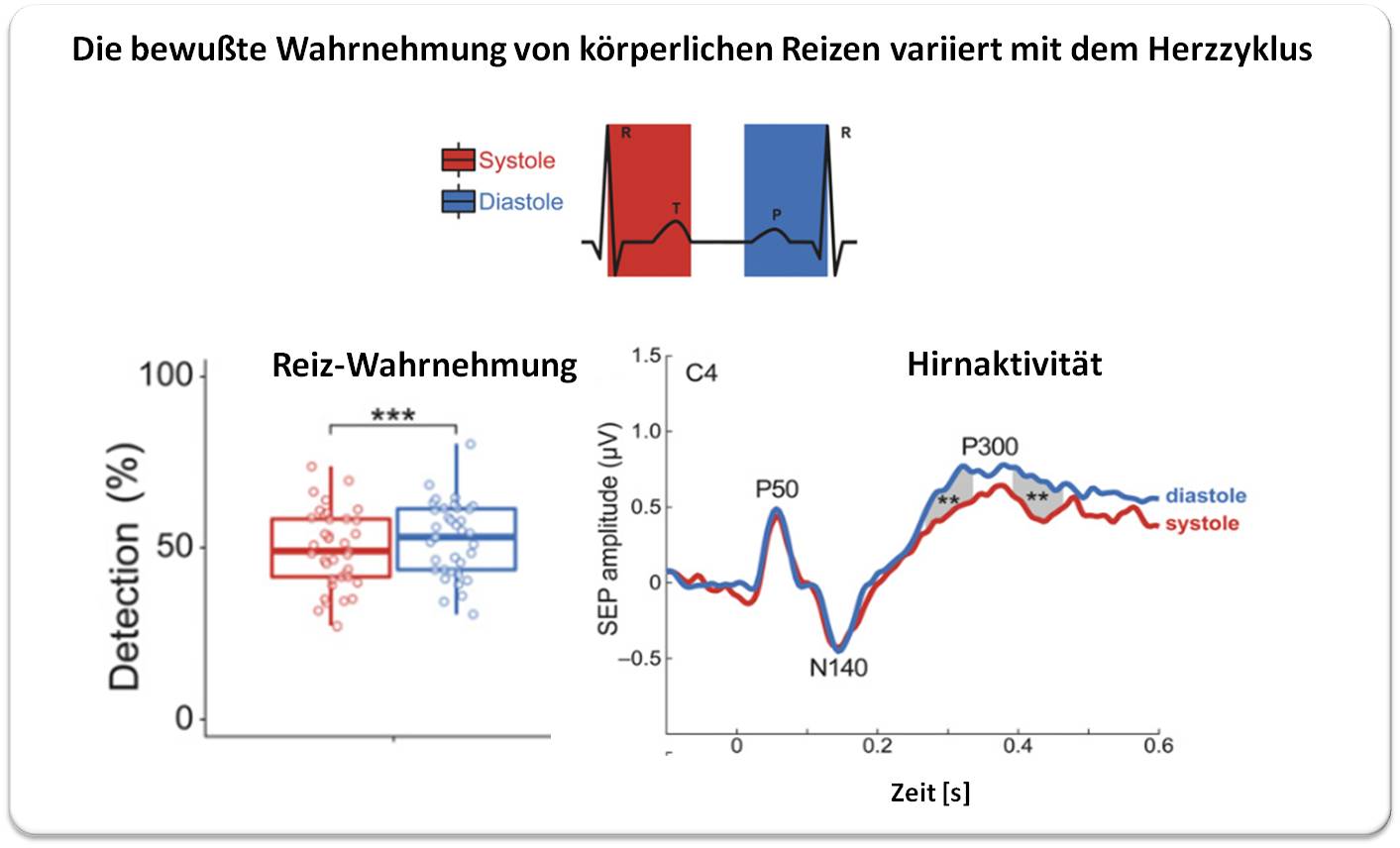

Villringer interessiert sich für feinstimmige Kommunikation zwischen Gehirn und Herz. Dafür analysieren Forscher seiner Arbeitsgruppe das Elektrokardiogramm und die Hirnströme gleichzeitig. Sie gleichen das Muster elektrischer Erregung in beiden Organen im Detail miteinander ab. Es fällt auf, dass bestimmte Regionen des Gehirns synchron mit dem Herzen aktiviert werden. Es kommt zu einem gewissen Gleichklang in beiden Organen. Messbar wird das im so genannte Herzschlag-evozierten Potential (Heartbeat-evoked Potential, kurz: HEP). Infolge der elektrischen Erregungsausbreitung im Herzgewebe, die zur Kontraktion des Herzmuskels führt, entsteht eine elektrische Spannung. Diese lässt sich im Gehirn als Erregung messen. Vor allem in der Inselregion des Gehirns konnte Villringer diese rhythmische Korrelation mit dem Herzen feststellen. Es handelt sich quasi um ein Abbild des pumpenden Herzens im Hirn. Abbildung 2.

| Abbildung 2 . Links: Während der systolischen Phase (rot) werden schwache äussere Reize weniger stark wahrgenommen als in der diastolischen Phase (blau). Rechts: Ein Teil der Gehirnaktivität (“P300”) ist in der systolischen Phase unterdrückt (Bild von Redn. eingefügt ; Quelle: AL et al., PNAS (2020), [2]; Lizenz cc-by) |

Der Neurologe geht davon aus, dass das HEP aber weit mehr besagt. Es ist nämlich bei verschiedenen Menschen unterschiedlich hoch. „Wir vermuten, dass das Gehirn zwei unterschiedliche Modi hat. Wenn das HEP hoch ist, konzentriert man sich auf den eigenen Körper, die Innenwelt. Im zweiten Modus ist das HEP niedrig: Man wendet sich der Außenwelt zu, im evolutiven Kontext waren das etwa Nahrungssuche und Angriff“, sagt Villringer. Zu dieser Deutung passt ein weiterer Befund: Wenn das HEP groß ist, nehmen Probanden einen äußeren elektrischen Reiz am Finger schwächer wahr. Umgekehrt nehmen sie diesen intensiver wahr, wenn das HEP kleiner ist. Dies beschrieb Villringers Team 2020 im Fachblatt PNAS [2].

Wie der Herzschlag das Denken und Fühlen verändert

Noch ist unklar, ob die Höhe des HEP und damit die Größe des Abbilds des Herzens im Hirn nur von der Situation abhängt oder auch eine Persönlichkeitseigenschaft ist. Fest steht nur, dass der Einfluss des Herzens auf das Gehirn so ausgeprägt ist, dass sich sogar der Herzschlag auf die Wahrnehmung und das Denken auswirkt.

Wieder untersuchte Villringers Team dazu, wie stark Probanden einen elektrischen Reiz am Finger empfinden. Wenn das Herz sich zusammenzieht und Blut in den Körper pumpt, also in der so genannten systolischen Phase, spüren sie den Reiz nicht so intensiv. Das könnte daran liegen, vermuten die Forscher, dass just in diesem Moment Rezeptoren in den großen Blutgefäßen eine Information über den Blutdruck ans Gehirn übermitteln. Der Informationsschwall dieser so genannten Barorezeptoren nimmt das Gehirn offenbar ziemlich in Beschlag. Eindrücke der Außenwelt erreichen uns in diesem Moment nur gedämpft. In der folgenden Diastole dagegen registrieren Probanden einen äußeren elektrischen Reiz intensiver. In dieser Phase füllt sich das Herz wieder mit Blut.

Es war nicht der erste Befund dieser Art. Ein Experiment von Psychologen um Ruben Azevedo von der Universität in London ist laut Villringer das wohl beunruhigendste Ergebnis zum Einfluss des Herzschlags. Azevedo zeigte 30 Probanden in schneller Folge Fotos von Gesichtern – entweder schwarzer oder weißer Männer gefolgt von einer Waffe oder einem Werkzeug. Möglichst rasch sollten die Testpersonen zuordnen, ob einem hellhäutigen oder dunkelhäutigen Mann ein Werkzeug oder eine Waffe folgt. Dabei erfassten die Experimentatoren auch den Herzschlag. Wenn das Herz sich zusammenzog und Blut in die Gefäße strömte, folgten die Teilnehmer signifikant häufiger ihrem Vorurteil: Sie wiesen einem schwarzen Mann eine Waffe zu. In dieser Phase wird das Gehirn so sehr von den Barorezeptoren in Beschlag genommen, dass für die kritische Selbstreflexion nicht mehr genug Hirn übrigbleibt, argumentiert Azevedo 2016 in Nature Communications [3].

Wenn das Gehirn leidet, schwächelt das Herz

Herz und Hirn stehen in einer innigen Verbindung. Aus dieser Perspektive verwundert es nicht, dass sich viele neurologische Erkrankungen auf das Herz auswirken können. Wer an einer Depression leidet, hat beispielsweise ein doppelt so hohes Risiko einen Herzinfarkt oder einen plötzlichen Herztod zu erleiden. Bei knapp 62 Prozent der Schlaganfallpatienten sitzen in den Herzgefäßen Plaques. Und ein Herzinfarkt nach dem Hirnschlag ist eine gefürchtete Komplikation auf den Intensivstationen.

Und sogar auf Stress hin können kerngesunde Menschen eine Herzmuskelschwäche entwickeln. Dieses Krankheitsbild beschrieb ein japanischer Arzt in den neunziger Jahren und benannte es als „Takotsubo-Syndrom“.

„Die Betroffenen kommen in die Notaufnahmen verängstigt, mit Brustschmerzen und Atemnot“, erzählen Victor Schweiger und Julien Mereier aus der Arbeitsgruppe des Kardiologen Christian Templin vom Universitätsspital Zürich. „Manchmal erzählen sie, dass am Tag vorher der Mann gestorben ist. In der Katheteruntersuchung sind dann alle Gefäße offen.“ Die linke Herzkammer pumpt allerdings weniger effizient als gewöhnlich. Die Herzspitze ist ballonartig erweitert, die Hauptschlagader dagegen verengt.

Auf die leichte Schulter darf man die stressbedingte Herzschwäche nicht nehmen, warnen die beiden angehenden Kardiologen. Die Betroffenen brauchen eine Reha, um sich zu erholen. Ihr Risiko zu sterben, ist erhöht. „Es ist nicht nur etwas Psychisches, wie viele glauben, sondern eine körperliche Erkrankung“, betont Schweiger.

Gebrochenes Herz mit Folgen

Das legt auch eine Untersuchung der Gehirne von Patienten mit funktioneller Magnetresonanztomografie nahe, die Templin 2019 der Fachwelt vorstellte [4]. Danach ist die Verarbeitung emotionaler Eindrücke bei den Betroffenen in verschiedenen Gehirnarealen weniger ausgeprägt. Diese verminderte Konnektivität fiel besonders in der Amygdala, dem Hippocampus und dem Gyrus cinguli auf, die für die Kontrolle von Emotionen entscheidend sind. Amygdala und Gyrus cinguli sind zudem an der Steuerung des autonomen Nervensystems beteiligt und können darüber auch die Herzfunktion beeinflussen.

Wie das Gehirn bei einem emotionalen Ereignis das Herz stresst, ist gleichwohl nicht genau verstanden. Eine Schlüsselrolle kommt wohl dem Stresshormon Adrenalin zu. Künstlich gegebenes Adrenalin kann in Tieren eine Herzmuskelschwäche auslösen. In den Patienten sind die Spiegel bestimmter Katecholamine, zu denen die Botenstoffe Adrenalin, Dopamin und Noradrenalin gehören, ein bis drei Tage nach dem Auftreten des Takotsubo-Syndroms deutlich höher als in Gesunden. Bekanntermaßen schadet ein Übermaß an Katecholaminen auf Dauer dem Herzen.

Auch nach einem Schlaganfall sind die Pegel der Katecholamine erhöht. An diesem Punkt schließt sich der Kreis: Ein schwächelndes Herz kann nicht nur eine Reaktion auf heftigen Liebeskummer oder einen Todesfall sein. Auch neurologische Ereignisse gehen gar nicht selten, nämlich in 7,6 Prozent der Fälle, einem Takotsubo-Syndrom voraus. Das konnte Templins Team in den Daten des weltweit größten Registers mit mittlerweile mehr als 4.000 Patienten erkennen [4]. „Meist liegen nur ein bis zwei, maximal zehn Tage zwischen dem Erstereignis im Hirn und der stressbedingten Herzmuskelschwäche“, sagt Schweiger.

Wie neurologische Erkrankungen und seelisches Leid dem Herzen zusetzen, versucht die junge Disziplin der Psychokardiologie zu ergründen. „Es ist schon verblüffend“, sagt Schweiger. „Trauer, Ärger und Freude können organische Veränderungen an einem so wichtigen Organ hervorrufen.“

Als ob Johann Wolfgang von Goethe es schon vor zweihundert Jahren geahnt hätte, als er über die Liebe dichtete: „Herz, mein Herz, was soll das geben? Was bedränget dich so sehr? Welch ein fremdes neues Leben! Ich erkenne dich nicht mehr.“

[1] Donald D, et al.: Some evidence for heightened sexual attraction under conditions of hig anxiety. Journal of Personality and Social Psychology, 1974, 30 (4). (zum Abstract: https://pubmed.ncbi.nlm.nih.gov/4455773/)

[2] Al E, et al.: Heart–brain interactions shape somatosensory perception and evoked potentials. PNAS, 2020 Mai, 117 (19) 10575-10584. (zum Volltext: https://www.nature.com/articles/ncomms13854)

[3] Azevedo R, et al.: Cardiac afferent activity modulates the expression of racial stereotypes. Nature Communications, 2016 Januar, 8 (13854). (zum Volltext: https://academic.oup.com/eurheartj/article/40/15/1183/5366976?login=false)

[4] Templin C, et al.: Altered limbic and autonomic processing supports brain-heart axis in Takotsubo syndrome. European Heart Journal, 2019 April, 40 (15): 1183–1187. (zum Volltext https://www.pnas.org/doi/full/10.1073/pnas.1915629117)

*Der Artikel ist am 1.10.2022 auf der Website https://www.dasgehirn.info/ unter dem Titel "Die Herz-Hirn Connection" erschienen https://www.dasgehirn.info/grundlagen/herz/die-herz-hirn-connection und steht unter einer CC-BY-NC-SA Lizenz.

www.dasGehirn.info ist ein Projekt der Klaus Tschira Stiftung, der Neurowissenschaftlichen Gesellschaft e.V. in Zusammenarbeit mit dem ZKM | Zentrum für Kunst und Medien Karlsruhe.

Verwandte Artikel im ScienceBlog

Nora Schultz, 13.10.2022: Neurokardiologie - Herz und Gehirn bilden ein System

Artikel von Susanne Donner unter: https://scienceblog.at/susanne-donner

Wie alles anfing: Ein Reiseführer auf dem Weg zur Entstehung und Entwicklung des Lebens

Wie alles anfing: Ein Reiseführer auf dem Weg zur Entstehung und Entwicklung des LebensDo, 24.11.2022 -— Inge Schuster

![]()

Vor 53 Jahren, als die Molekularbiologie noch in den Kinderschuhen steckte, habe ich den ebenso jungen Biochemiker Manfred Bühner auf einer wissenschaftlichen Tagung kennengelernt. Manfred war insbesondere von einem Vortrag des US-Amerikaners Michael Rossmanns fasziniert; dieser Pionier der Strukturaufklärung von Enzymen mittels Röntgenstrukturanalyse nahm dann Manfred als Postdoc in seiner Abteilung auf. Manfred konnte sich dort in die damals noch sehr neuen Methoden einarbeiten und baute nach seiner Rückkehr nach Deutschland in Würzburg das erste Forschungslabor an Hochschulen für Röntgenstrukturanalyse von Biomolekülen auf. Seine Forschungen zu Struktur, Funktion und deren Optimierung führten immer wieder zum Thema "chemische Evolution" . Manfred Bühner hat nun darüber ein großartiges Buch "Wie alles anfing - Von Molekülen über Einzeller zum Menschen" verfasst [1]. Die folgende Rezension soll einen kurzen Eindruck davon geben.

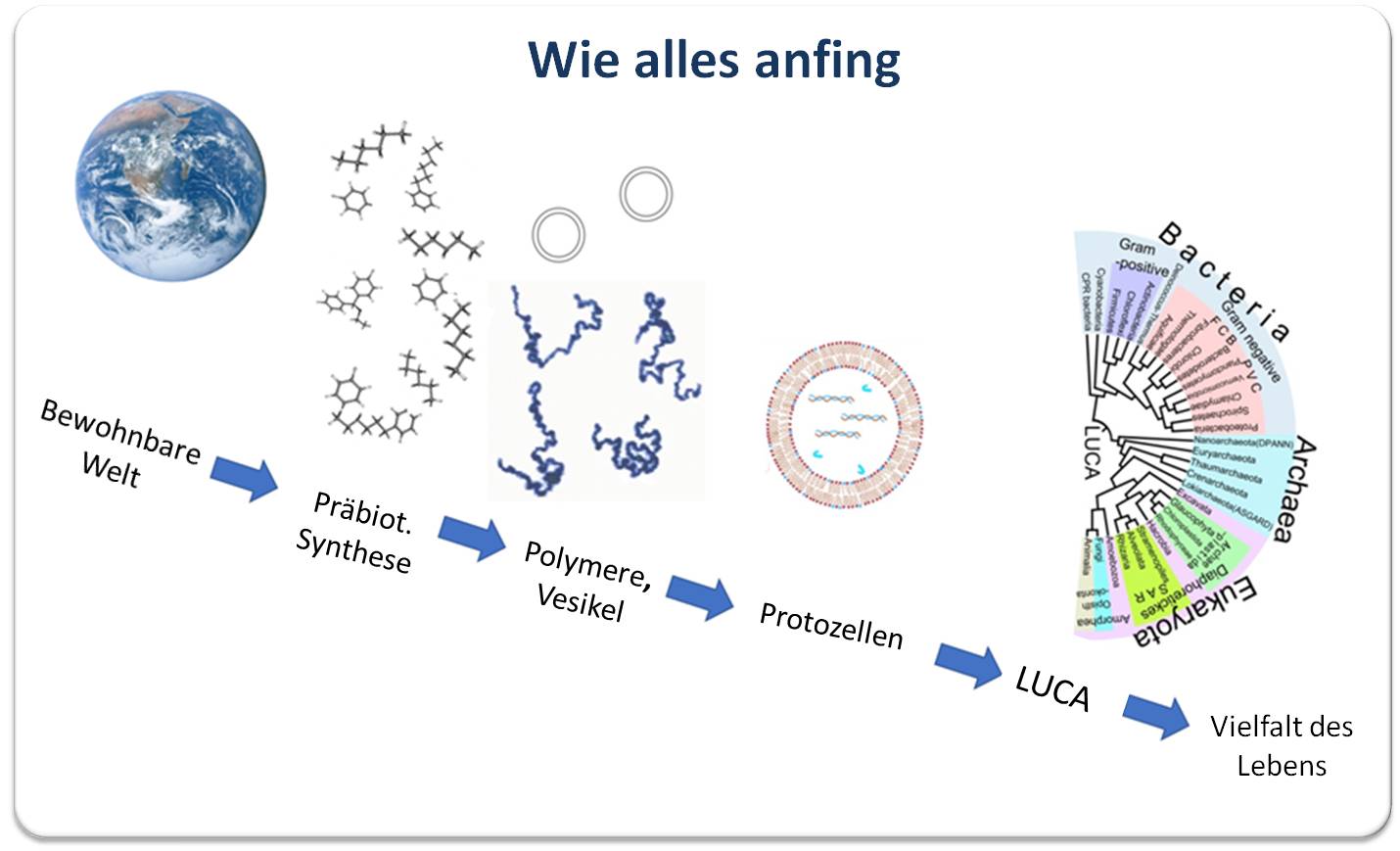

Wie ist auf unserem Planeten aus unbelebter Materie belebte Materie bis hin zu komplexen, intelligenten Lebensformen der Gegenwart entstanden? Anders als in den meisten deutschsprachigen Büchern über Evolution, deren Hauptaugenmerk auf der biologischen Phase - also auf der Entwicklung der Arten - liegt, steht in "Wie alles anfing" die präbiotische Phase, die chemische Evolution, im Zentrum.

"Leben ist aus einer geradezu banalen Aneinanderreihung von ganz einfachen und selbständig ablaufenden physikalischen und chemischen Reaktionen entstanden"

In vier Teilen, auf rund 170 Seiten (plus einem ausführlichen Anhang mit chemischen und physikalischen Grundlagen, sowie einem Glossar) führt der Biochemiker Manfred Bühner aus, dass und warum die Chemie die Basis für den Weg zum Leben, wie auch für das Leben in seiner ganzen Vielfalt ist. In der nüchternen, induktiven Betrachtungsweise des Naturwissenschaftlers, die von Beobachtungen und zu berücksichtigenden Rahmenbedingungen ausgeht, kommt er zu dem Schluss: "Leben ist aus einer geradezu banalen Aneinanderreihung von ganz einfachen und selbständig ablaufenden physikalischen und chemischen Reaktionen entstanden". Er bezieht sich dabei auf etabliertes Wissen über Struktur, Funktion und Steuerung der Bausteine lebender Materie und auf plausible Mechanismen ihrer Entstehung, die in der zweiten Hälfte des vorigen Jahrhunderts - dank der Fortschritte der Molekularbiologie - enorm ausgeweitet wurden. Bühner ist Zeitzeuge dieser Entwicklung und hat selbst seit den frühen 1970er Jahren an der Aufklärung der 3D-Struktur von Enzymen gearbeitet und sich eingehend mit deren Evolution zu den überaus präzisen Katalysatoren der Gegenwart befasst.

| Abbildung 1. . Kohlenstoff im Zentrum der Chemischen Evolution. Von der Entstehung organischer Moleküle in der Uratmosphäre über Biomoleküle, Protozellen bis hin zur ersten Lebensform LUCA (Last universal common ancestor) . Quelle: Chiswick Chap, https://en.wikipedia.org/wiki/Abiogenesis; Lizenz: cc-by-sa. |

Entstanden ist ein umfassender Überblick über mehr als 4,5 Milliarden Jahre Evolution, der mit der Entstehung der chemischen Elemente im Universum und den chemischen Reaktionen von Atomen und Molekülen in der Uratmosphäre beginnt. Abbildung. Bühner erklärt, warum (nur) Kohlenstoff auf Grund seiner vielfältigen Bindungsmöglichkeiten die strukturelle Basis für die Bausteine des Lebens bieten kann und wie in den Reaktionen mit den am häufigsten vorhandenen Elementen - Wasserstoff, Sauerstoff, Stickstoff - und dazu Phosphor und Schwefel zwangsläufig ein nahezu unendliches Spektrum von Biomolekülen entstehen konnte. Verständlicherweise konnten die weniger stabilen Makromoleküle - Kohlenhydrate, Proteine, Nukleinsäuren - erst entstehen, als vor etwa 4,3 Milliarden Jahren die Oberflächentemperatur der Erde gesunken war und atmosphärischer Wasserdampf zu Meeren kondensierte; geschützt vor zu zerstörerischer UV-Strahlung reicherten sich die Moleküle der Uratmosphäre in diesen "Ursuppen" an, aggregierten und reagierten miteinander. Bühner zeigt wahrscheinliche Synthesewege auf, erläutert, welche Rolle dabei flüssiges Wasser spielte und woher die zur Polymerisierung notwendige Energie kommen konnte.

Wie er an späterer Stelle ausführt, sollten - nach den im ganzen Universum geltenden Gesetzen der Chemie und Physik und sofern es die planetar-physikalischen Bedingungen erlaubten - auch auf anderen Himmelskörpern die Moleküle der Uratmosphäre einer zumindest sehr ähnlichen chemischen Evolution unterworfen (gewesen) sein.

Hervorgehoben wird die zentrale Bedeutung der Nukleinsäuren, deren Fähigkeit komplementäre Nukleotide anzulagern und Kopien mit der in der Nukleotid-Abfolge gespeicherten Information entstehen zu lassen, die Grundvoraussetzung für Leben, Vermehrung und Vielfalt der Nachkommenschaft ist. Es wird gezeigt wie die Nukleotid-Sequenz der RNA - und später der längeren, stabileren DNA - für die Aminosäurensequenz von Proteinen kodiert, wie Ablesung und Übersetzung des Codes funktionieren, wie schlussendlich kompliziert gefaltete Proteine entstehen und was solche zu hocheffektiv, spezifisch arbeitenden Enzymen macht. Zur Lösung des Henne- Ei Dilemmas - Was kam zuerst - Proteine, die das Kopieren der Nukleinsäuren katalysieren oder Nukleinsäuren, die für solche Proteine kodieren? - verweist Bühner auf die sogenannten Ribozyme - Ribonukleinsäuren mit zusätzlichen katalytischen Eigenschaften, die in anfänglichen RNA-Welten imstande gewesen sein dürften ohne zusätzliche Katalysatoren den vorerst langsamen und fehlerbehafteten Kopierprozess von RNAs zu beschleunigen und verbessern.

Breiten Raum nimmt auch die Chemie der niedermolekularen Lipide und der daraus spontan gebildeten Membranen ein: wie aus Membran-umschlossenen Tröpfchen der Ursuppe mit darin gelösten Biomolekülen erste Protozellen generiert werden konnten und wie diese Protozellen Stoffwechselsysteme entwickelten, die energieliefernde Stoffe aus der Ursuppe aufnehmen, für Funktionen wie Kopieren und Katalyse einsetzen und Abfallprodukte ausscheiden konnten. Nach mehreren Hundertmillionen Jahren chemischer Evolution, in denen vermutlich unzählige Biomoleküle ausprobiert und verworfen worden waren, gab es vor etwa 3,7 Milliarden Jahren erstmals Voraussetzungen für die Entstehung von Leben, die - als die geophysikalischen Bedingungen taugten - zu ersten Prokaryoten, einzelligen Vorläufern von Bakterien und Archaeen, führten.

"Das Leben? Ist alles nur Chemie mit der Fähigkeit zum autonomen Selbstkopieren"

sagt Bühner. Dieses Kopieren ist Hauptthema des (wesentlich kürzeren, da in der populärwissenschaftlichen Literatur bereits ausführlichst behandelten) Teils über biologische Evolution: wie dem Zufall unterworfene Mutationen in den Nukleotid-Basen und Selektion der Nachkommenschaft durch Adaptation an die Umgebungsbedingungen die Basis für die Evolution der Arten schufen; wie Optimierung von Kopiermaschinerie und Reparatursystemen für defekte Nukleotide immer größere Speicherkapazitäten und damit komplizierter aufgebaute Organismen ermöglichten. Als wesentliche Meilensteine in dem ungeheuer langen Zeitraum der biologischen Evolution (immer mit dem Fokus auf deren Chemie) nennt der Autor die "Erfindung" der Photosynthese durch Cyanobakterien vor etwa 2,7 Milliarden Jahren (d.i. der Nutzung von Sonnenergie zur Synthese von Kohlenhydraten aus CO2 und H2O, wobei der entstehende, für viele Proteobakterien toxische Sauerstoff das erste große Artensterben auslöste) und die Entstehung von Eukaryonten aus Archaea und Proteobakterien durch Endosymbiose 1 Milliarde Jahre später. Der letzte Teil des Buches führt dann von der Entstehung von Mehrzellern vor 800 Millionen Jahren, dem Aufkommen der sexuellen Vermehrung, der Entstehung von kompliziert aufgebauten Organismen bis zu intelligentem Leben und dem Homo sapiens.

Fazit

Ohne philosophische Aspekte zu berühren, erklärt das Buch in überzeugender Weise, wie Leben durch chemische Evolution entstanden sein kann. Anspruchsvoll und sehr dicht geschrieben vermittelt jede Zeile profundes, sorgfältig recherchiertes Wissen und bietet selbst für den Chemiker neue, inspirierende Einblicke. Vor allem Studenten und Absolventen naturwissenschaftlicher und medizinischer Fachrichtungen, (Oberstufen-)Schüler aber auch am Thema Evolution interessierte Laien werden (mit etwas "Nach-Googeln") das Buch mit Gewinn lesen.

Addendum: In einer zweiten Auflage sollte der Verlag die chemischen Strukturformeln in einer dem heutigen Usus adäquaten Form wiedergeben.

[1] In der Reihe De Gruyter De Gruyter Populärwissenschaftliche Reihe:

Bühner, Manfred. Wie alles anfing: Von Molekülen über Einzeller zum Menschen, Berlin, Boston: De Gruyter, 2022. https://doi.org/10.1515/9783110783155

Artikel im ScienceBlog zu verwandten Themen

- Themenschwerpukt Evolution

- Inge Schuster, 04.10.2018: Nobelpreis für Chemie 2018: Darwins Prinzipien im Reagenzglas oder "Gerichtete Evolution von Enzymen"

- Inge Schuster, 04.05.2017: Manfred Eigen: Von "unmessbar" schnellen Reaktionen zur Evolution komplexer biologischer Systeme

- Peter Schuster, 12.04.2012: Wie universell ist das Darwinsche Prinzip?

- ------------------------------

Eine rasche Senkung der Methanemissionen ist erforderlich

Eine rasche Senkung der Methanemissionen ist erforderlichDo, 17.11.2022 — IIASA

Die vom Menschen verursachten Methanemissionen sind für fast 45 % der derzeitigen Nettoerwärmung verantwortlich. Der von der Climate and Clean Air Coalition herausgegebene und von der IIASA-Forscherin Lena Höglund-Isaksson mitverfasste Bericht "Global Methane Assessment 2030 Baseline Report" bewertet die Fortschritte bei den globalen Reduktionsbemühungen. Wenn die Welt den globalen Temperaturanstieg unter den Zielwerten von 1,5° und 2°C halten will, sind rasche Maßnahmen erforderlich.*

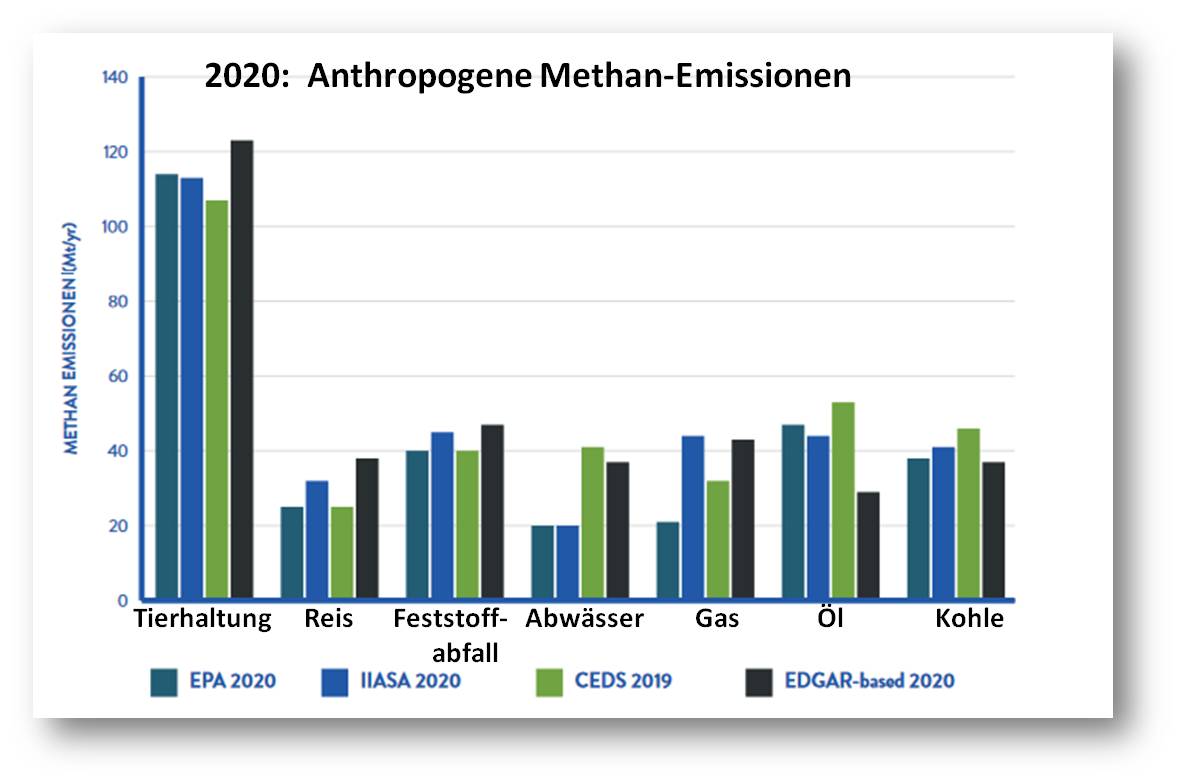

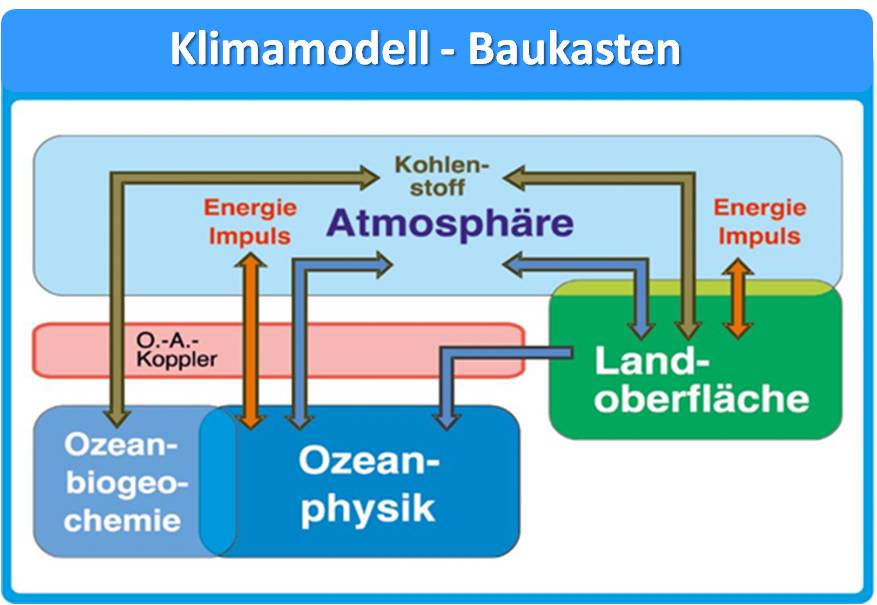

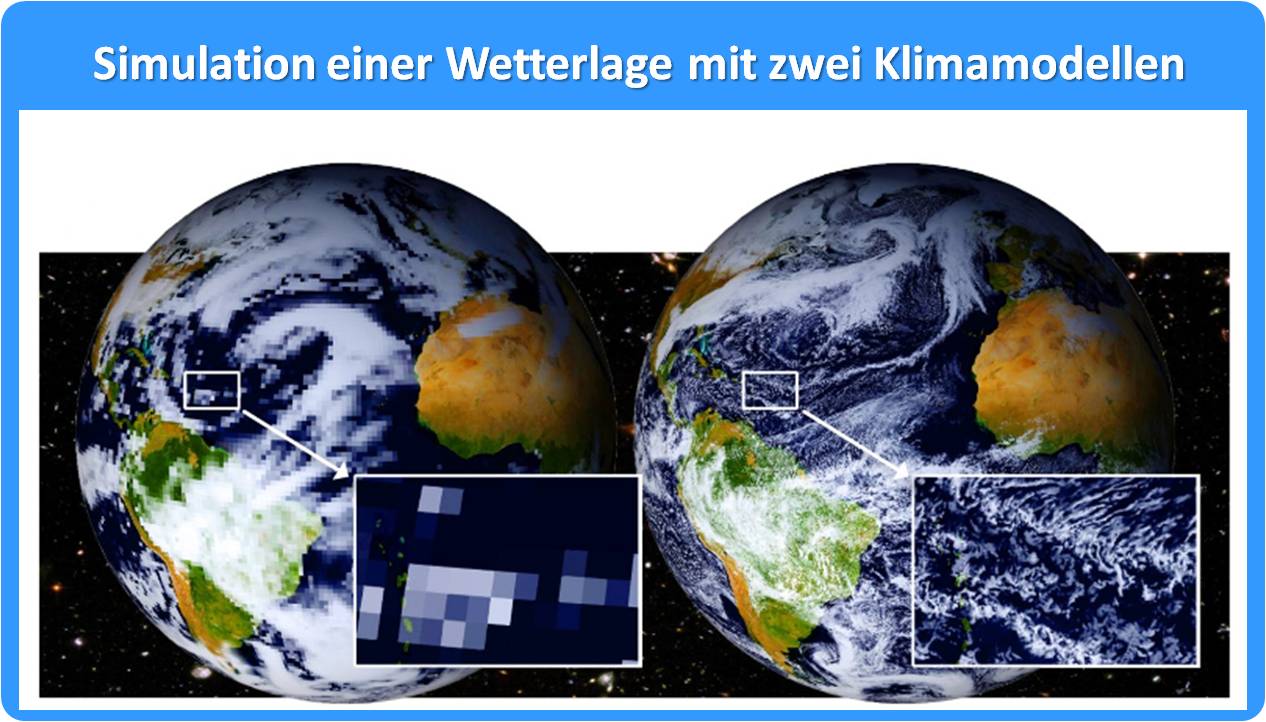

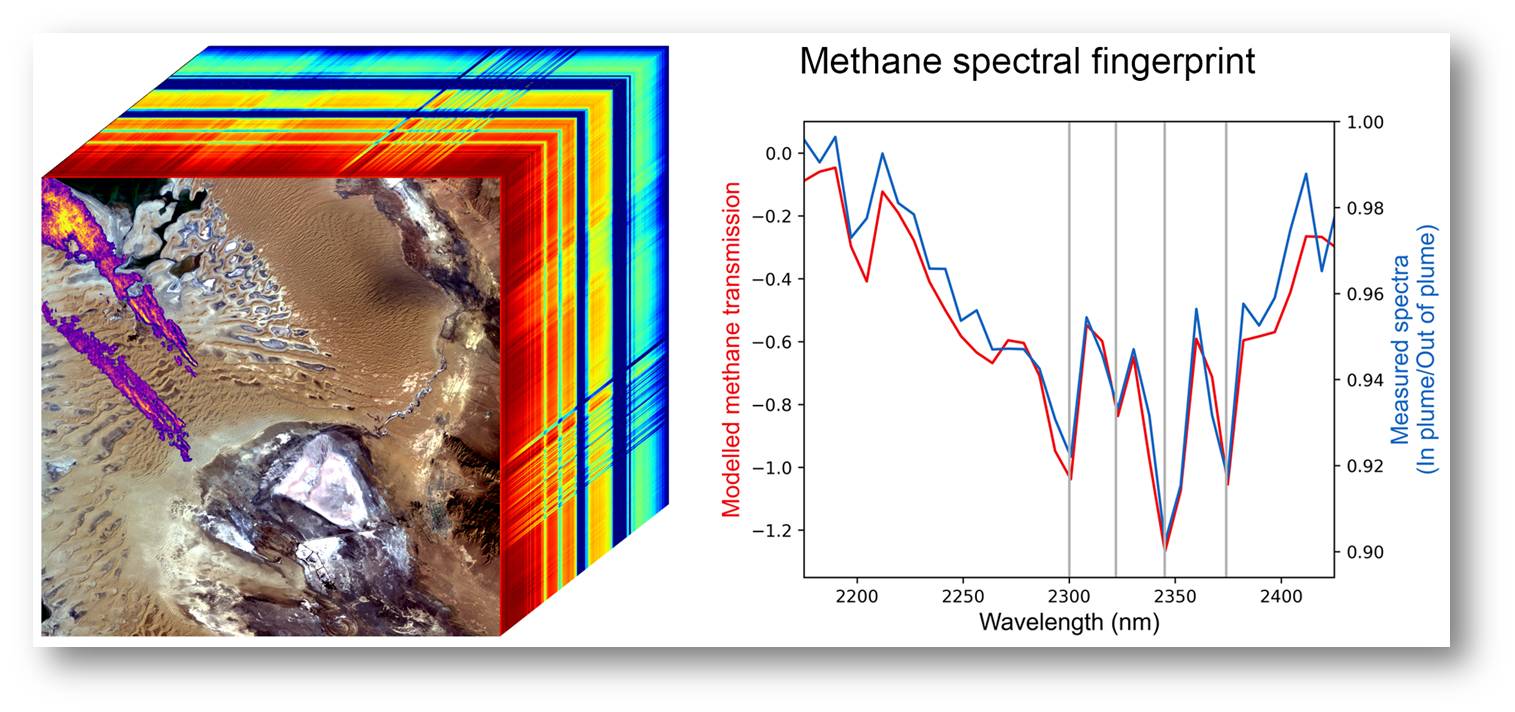

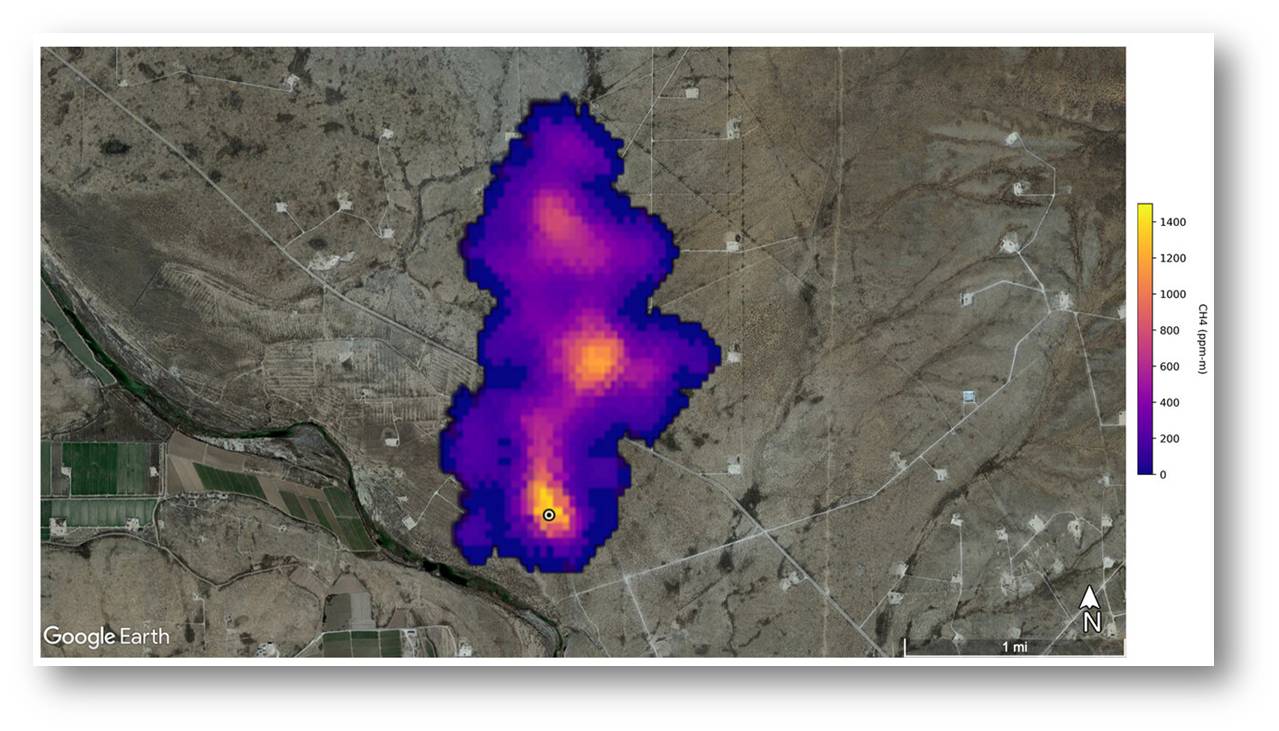

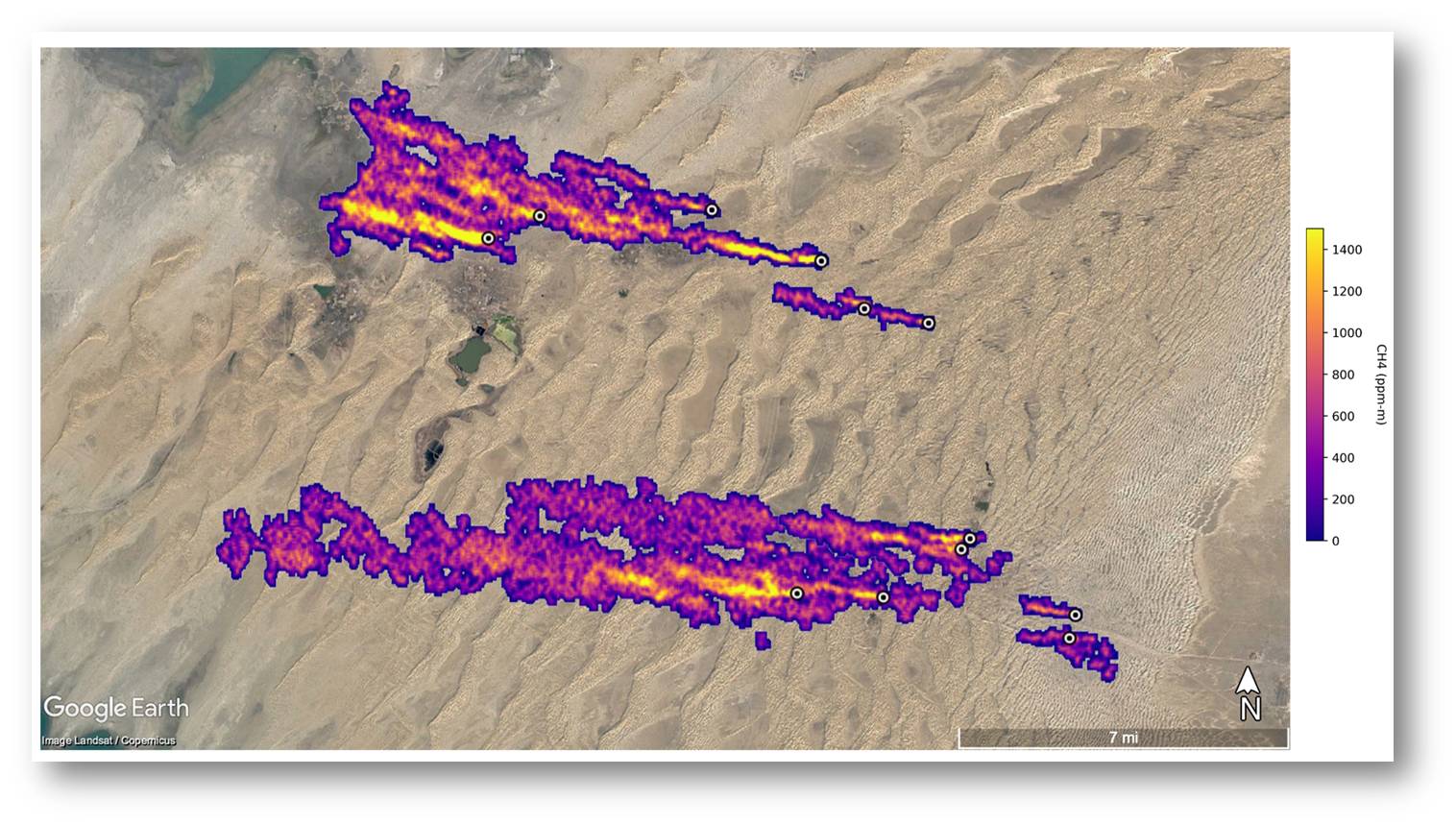

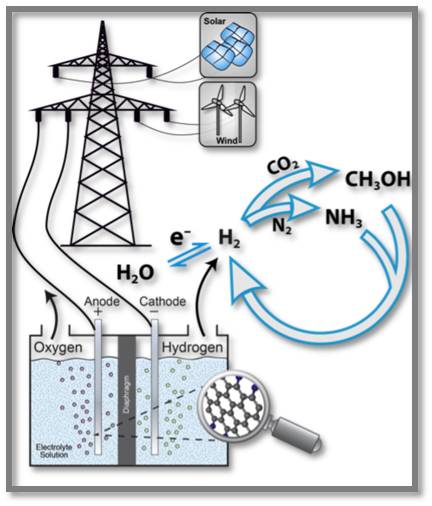

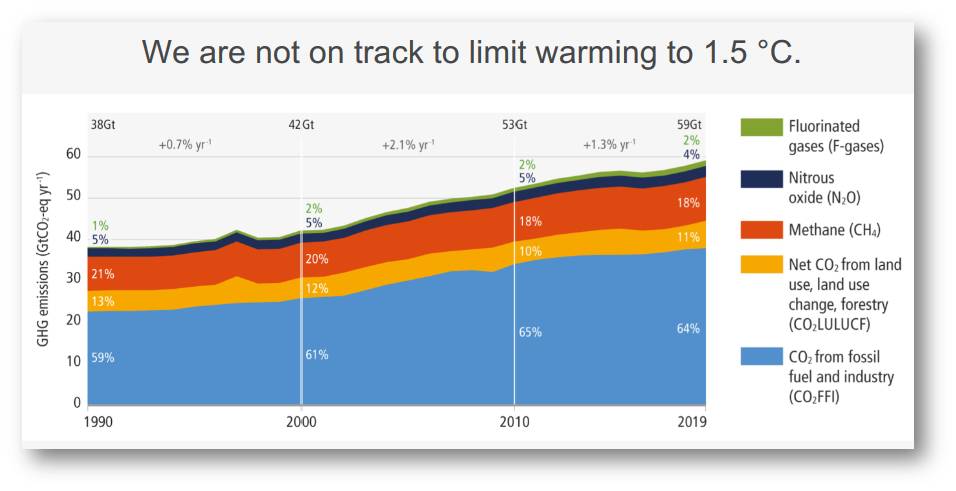

Während der Zusammenhang zwischen Kohlendioxid (CO2)-Emissionen und steigenden Temperaturen weithin bekannt ist, findet die Rolle von Methan als Treiber des Klimawandels in der Öffentlichkeit im Allgemeinen weniger Beachtung. Die Methankonzentrationen in der Atmosphäre steigen rapide an, was zu einem überwiegendem Teil auf Emissionen aus menschlichen Tätigkeiten zurückzuführen ist. Sie liegen derzeit bei 260 % des vorindustriellen Niveaus und betragen jährlich zwischen 350 und 390 Millionen Tonnen. Um die globale Erwärmung in den nächsten Jahrzehnten einzudämmen, muss die CO2-Reduzierung durch rasche und wirksame Maßnahmen zur Verringerung von Methan und anderen Klimaschadstoffen ergänzt werden. Abbildung 1.

| Abbildung 1. Gewinnung fossiler Brennstoffe, Landwirtschaft und Abfallwirtschaft sind Hauptverursacher anthropogener Methanemissionen. (Bild von Red. aus "Global Methane Assessment: 2030 Baseline Report" [1] eingefügt; Lizenz: cc-by-nc). |