2014

2014 Redaktion Wed, 20.03.2019 - 01:03Popularisierung der Naturwissenschaften im 19. Jahrhundert

Popularisierung der Naturwissenschaften im 19. JahrhundertFr, 26.12.2014 - 09:06 — Redaktion

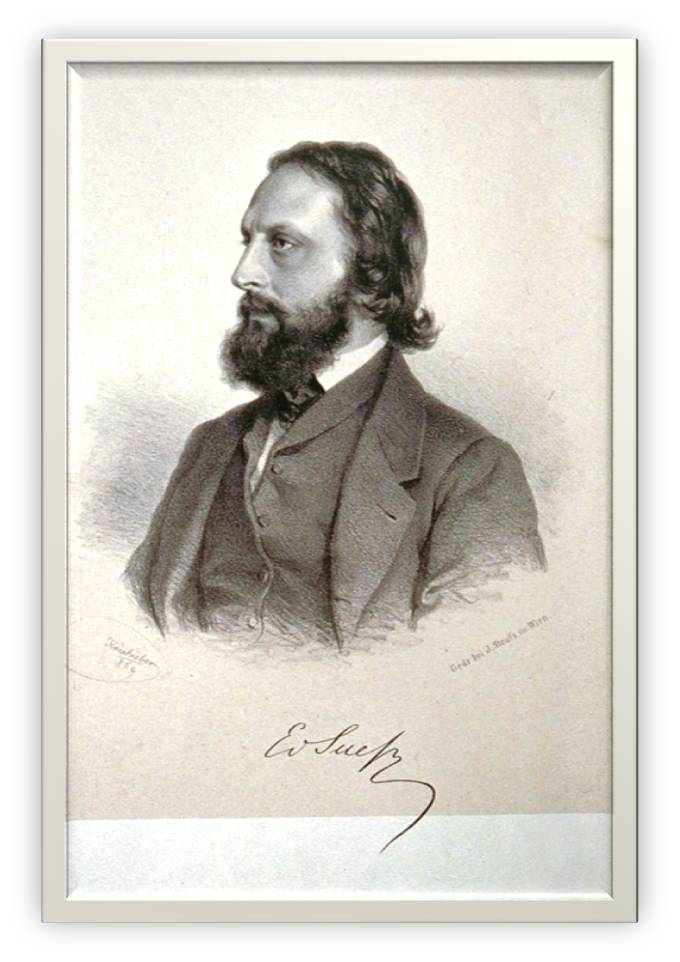

![]() Der hundertste Todestag von Eduard Suess (1831 – 1914) bot heuer vielfach Gelegenheit das grandiose Lebenswerk dieses Mannes zu würdigen: dem Paläontologen und Geologen Suess verdanken wir grundlegende Erkenntnisse zur Tektonik der Erdoberfläche (Gebirgsfaltung, Gondwanaland, Thetys). Auf den Politiker Suess gehen u.a. Planung und Bau der Wiener Hochquellenwasserleitung und die Donauregulierung zurück. Der Wissenschaftskommunikator Suess und seine von Erfolg gekrönten Bemühungen zur Popularisierung der Naturwissenschaften sind dagegen kaum bekannt.

Der hundertste Todestag von Eduard Suess (1831 – 1914) bot heuer vielfach Gelegenheit das grandiose Lebenswerk dieses Mannes zu würdigen: dem Paläontologen und Geologen Suess verdanken wir grundlegende Erkenntnisse zur Tektonik der Erdoberfläche (Gebirgsfaltung, Gondwanaland, Thetys). Auf den Politiker Suess gehen u.a. Planung und Bau der Wiener Hochquellenwasserleitung und die Donauregulierung zurück. Der Wissenschaftskommunikator Suess und seine von Erfolg gekrönten Bemühungen zur Popularisierung der Naturwissenschaften sind dagegen kaum bekannt.

Eduard Suess: Verein zur Verbreitung naturwissenschaftlicher Kenntnisse

Suess war maßgeblich an der Gründung des auch heute noch existierenden „Vereins zur Verbreitung naturwissenschaftlicher Kenntnisse“ im Jahre 1860 beteiligt und dessen erster Präsident [1,2]. Im Rahmen dieses Vereins wurden frei zugängliche, populäre Vorträge gehalten; laut Suess (s.u.) waren diese „lediglich naturwissenschaftlichen Fächern entnommen, der Kreis von Vortragenden hat fast ausschließlich aus jüngeren Fachmännern bestanden“. Diese Vorträge – aufgezeichnet in bis dato 152 Jahrbüchern des Vereins – geben einen faszinierenden Einblick in den Fortschritt der Naturwissenschaften in unserem Land.

Mehrere Artikel hat der ausgezeichnete Vortragende und als Lehrer hochgeschätzte Eduard Suess selbst beigesteuert. Wäre Eduard Suess unser Zeitgenosse, hätte er - in Hinblick auf die Reichweite - wahrscheinlich auch eine digitale Form der Kommunikation, vielleicht in Form eines Blog, gewählt.

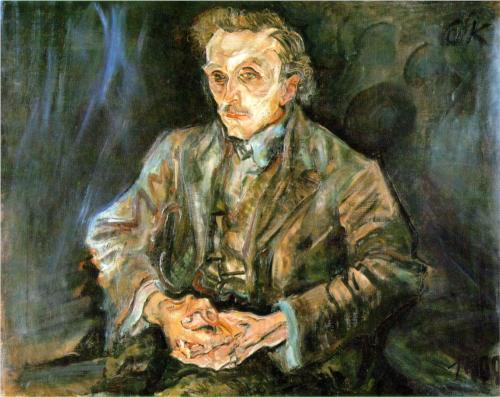

Abbildung 1. Eduard Suess 1869 (Bild: Wikipedia)

Abbildung 1. Eduard Suess 1869 (Bild: Wikipedia)

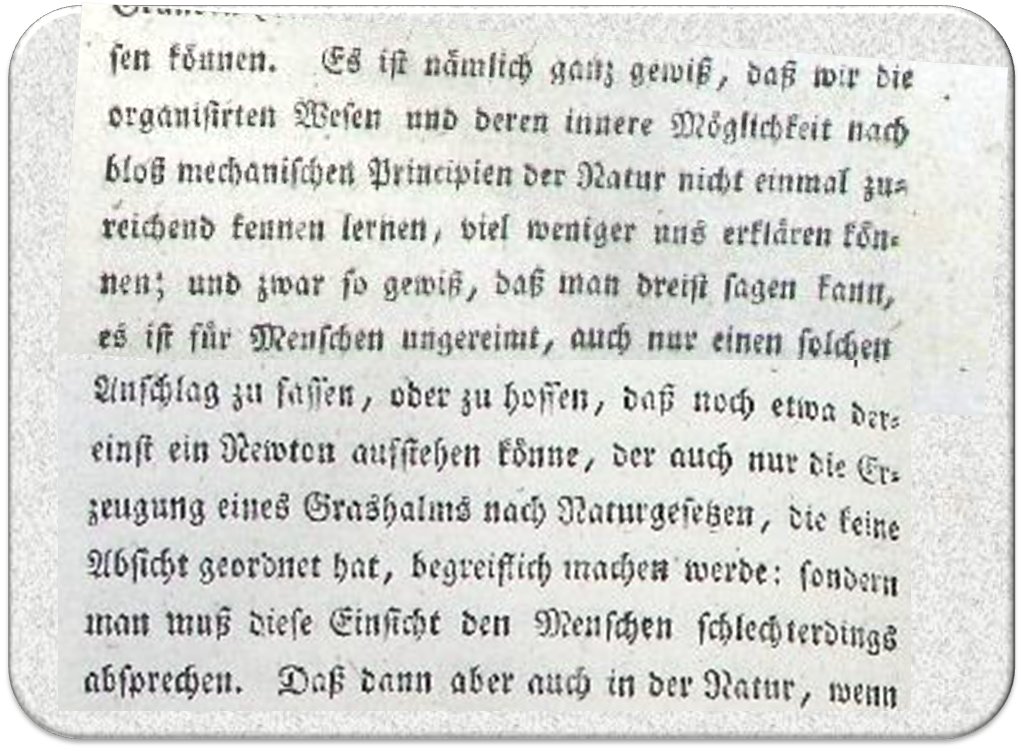

Im Folgenden findet sich die Rede, die Suess am 15.1.1860 anlässlich der Gründungsversammlung des Vereins zur Verbreitung naturwissenschaftlicher Kenntnisse gehalten hat [3]. Die ursprüngliche Schreibweise wurde beibehalten.

Eduard Suess: Ueber die Entstehung und die Aufgabe des Vereines

»Gestatten Sie mir, im Namen seiner Begründer den heute zum ersten Male versammelten

„Verein zur Verbreitung naturwissenschaftlicher Kenntnisse"

herzlich zu begrüssen. Den verschiedenartigsten Lebensstellungen angehörig, haben Sie Sich auf unsere Einladung hin vereinigt, um Ihre Zustimmung auszusprechen zu unseren Bemühungen, die neueren Erfahrungen der Naturforschung einem weiteren Kreise bekannt zu geben und den durch ihren Beruf den strengeren Studien ferner Stehenden einen Einblick zu öffnen in jene wunderbarsten und unvergänglichsten Eroberungen des menschlichen Geistes, welche die stolze Zierde unseres Jahrhunderts ausmachen.

Lassen Sie mich zuerst die durch die heutige Versammlung erwiesene Thatsache aussprechen, dass es in Wien auch ausserhalb der gelehrten Gesellschaften eine grosse Anzahl von Männern gibt, welche den Werth naturwissenschaftlicher Forschung erkennen. Ueberflüssig wäre es hinzuzufügen, wie bedeutungsvoll und wie hoch erfreulich diese Thatsache sei und so schreite ich denn sogleich daran, einige Worte von der Entstehung und von der Aufgabe dieses neuen Vereines zu sagen.

Populäre Vorlesungen gab es bereits an vielen Orten Deutschlands

Vor einigen Jahren sah man in vielen Städten Deutschlands Fachmänner sich vereinigen, um populäre Vorlesungen abzuhalten. In mehreren Orten haben sie ein wissbegieriges Publikum gefunden, welches durch seine Aufmerksamkeit ihre Anstrengungen belohnte und haben diese Vorlesungen in jedem Winter, bis zum diesjährigen, ihre Fortsetzung gefunden. Sie sind dabei, anfangs eine neue und fremdartige Erscheinung, zu einem nicht unwesentlichen Momente in dem geistigen Leben dieser Bevölkerungen geworden. Mit den Jahren haben sie in den verschiedenen Städten einen etwas verschiedenen localen Charakter angenommen. Während z. B. Königsberg sich rühmen mag, in einzelnen seiner Vorträge neue Anschauungen über die ersten Weltgesetze ausgesprochen gehört zu haben, sind jene in München mit allem Glanze hochberühmter Namen und eines königlichen Mäcenatenthumes umgeben worden.

Montagsvorlesungen seit dem Herbste 1855 – Vorläufer des Vereins

Auch in unserem Kreise ist mancher neue Gedanke ausgesprochen und manches schöne Ergebniss zum ersten Male vorgelegt worden, auch bei uns hat sich mancher hochgeachtete Staatsmann als ein Zuhörer eingefunden; unser erstes Ziel ist aber stets nur das gewesen, zu belehren. Unsere Vorträge sind lediglich naturwissenschaftlichen Fächern entnommen gewesen-, der Kreis von Vortragenden hat fast ausschliesslich aus jüngeren Fachmännern bestanden, aber Ihre Aufmerksamkeit und Ihr Beifall haben uns gelehrt, dass wir in der Erfüllung unserer Aufgabe glücklich waren.

Seit dem Herbste 1855 bis zum heutigen Tage sind nahe an neunzig öffentliche Vorträge von uns gehalten worden, und da in den letzten Jahren die Zahl der Zuhörer nie weit unter 200 fiel, dürfen wir wohl annehmen, dass es uns auch in der That gelungen sei, einige Belehrung zu verbreiten.

Die ersten Vorträge fanden im Winter 1855/6 auf Anregung unsers unvergesslichen Grailich, im Saale der k. k. geol. Reichsanstalt auf der Landstrasse statt. Im Winter 1856/7 pflegte der uns so freundlich angebotene Saal bereits trotz seiner entfernten Lage so überfüllt zu sein, dass wir bedacht sein mussten, ein grösseres Locale zu beschaffen.

Im Herbste 1857 öffnete uns die k. Akademie der Wissenschaften auf den Vorschlag ihres Präsidenten Sr. Excellenz des Freiherrn von Baumgartner in dem 2. Stockwerke ihres eben bezogenen Gebäudes mit grösster Liberalität einen bei weitem geräumigeren Saal. Drei Winter hindurch fanden hier unsere Zusammenkünfte statt, aber auch hier ereignete es sich nicht selten, dass die Zahl der Zuhörer auf mehrere Hundert stieg und nicht Platz finden konnte. Im Laufe dieses Winters endlich hat die k. Akademie, stets die wärmste Förderin unseres Unternehmens, uns einen noch grösseren, den sogenannten grünen Saal geöffnet, in welchem unsere Vorlesungen jetzt stattfinden.

Gründung des Vereins

Bei so steigender Theilnahme hat es der diesjährige Kreis von Vortragenden für seine Pflicht gehalten, Vorkehrungen zu treffen, welche dem Unternehmen eine Dauer für die Zukunft und zugleich eine ausgiebigere Wirksamkeit sichern sollten. Am 4. November vereinigten wir uns, um eine Eingabe an die Behörde um die Bewilligung zur Errichtung dieses Vereines zu unterzeichnen. Am 4. März erfloss die kaiserliche Genehmigung unserer Bitte, am 15. April die endgiltige Gutheissung unserer Statuten.

Binnen weniger als einem Monate ist der neue Verein zu der zahlreichen Versammlung herangewachsen, welche Sie um Sich sehen [4]. Es ist ein neues Centrum geistiger Thätigkeit geschaffen. Lassen Sie mich von dem sprechen, was mir als seine Aufgabe vorschwebt.

Sie Alle gewiss, verehrte Anwesende, freuen sich der besseren Jahreszeit und des grünen Rasens und der wundervollen Schattirungen des Laubholzes. Manchen tragen seine Träume weiter. Er erinnert sich des nahen Hochgebirges und der Schönheiten, die es birgt und mit Entzücken gedenkt er des Tages, an welchem er zuerst seinen Fuss auf eine jener Hochspitzen setzte, unter denen die Länder ausgebreitet liegen wie eine Landkarte. Das Auge weitgeöffnet, um das grenzenlose Bild zu umfassen, die Brust erfüllt von der reineren Luft der Höhen und gehoben durch das Bewusstsein überstandener Mühen, lässt der Wanderer tief in seine Seele den Eindruck so vieler Pracht sich senken und spricht leise: Wie schön!

Das, verehrte Anwesende, ist die unmittelbare Freude an der Schöpfung, zu welcher es weiterer Kenntnisse eben nicht bedarf. Wer sich jedoch mit einiger Ausdauer dem Studium der Naturwissenschaften hingibt, lernt bald ein ähnliches Entzücken an Bildern gemessen, welche er nicht sinnlich wahrzunehmen, sondern nur aus seinen Erfahrungen zu construiren weiss. Und von dem Augenblicke an, in welchem die Seele für Freuden dieser Art empfänglich geworden, ist das Studium für ihn nichts mehr, als eine ununterbrochene Reihe der reinsten und beneidenswerthesten Genüsse; von der Bewunderung der Aussenwelt kehrt er befriedigt zurück zu der Bewunderung des menschlichen Geistes, der sie so weit zu durchdenken im Stande ist.

Wir vermögen nicht, Ihnen an Winterabenden den unmittelbaren Naturgenuss einer schönen Landschaft herzuzaubern, aber wir nehmen die einzelnen Theile aus dem Bilde und lehren Sie dieselben besser zu betrachten. Der Bau des Gebirges, auf welchem Sie gestanden, die Organisation der Pflanzen, die Sie auf demselben trafen, selbst die Luftströmungen, die Sie empfanden, ja sogar die Natur der erleuchtenden Sonne, solches sind die Gegenstände unserer Vorträge und wenn Sie nach diesen im Sommer wieder hinaustreten in die offene Natur, dann hat sich, so hoffen wir, zu Ihrer früheren Freude auch ein etwas höherer Grad von Verständniss gesellt, Sie wissen der Natur tiefer in ihr grünes Auge zu schauen und die grössere Innigkeit Ihres Entzückens lehrt Sie, wie schön der Beruf des Naturforschers sei.

Es ist etwas Eigenthümliches um diesen Beruf

Ein glücklicher Gedanke in einem hellen Kopfe lehrt die Menschheit Worte fliegen zu lassen längs einem Drahte mit einer Geschwindigkeit von mehreren tausend Meilen in der Sekunde. Ein glücklicher Gedanke dort, und es ist uns das Mittel gegeben, den ungreifbaren Sonnenstrahl zu zerlegen und mit Hilfe von Lichterscheinungen neue Stoffe zu erkennen, deren Vorhandensein die zartesten Reagentien nicht verrathen hatten. Mühsam beobachtet am Mikroskope ein Forscher die Sexualorgane der Pflanzen, bis er uns endlich beweist, dass die Fortpflanzungserscheinungen bei ihnen auf eine wunderbare Weise mit den Vorgängen im Thierreiche übereinstimmen. Ein Anderer zeigt Ihnen aus dem Vergleiche langer Beobachtungstabellen, dass ein innerer Zusammenhang bestehe zwischen den Flecken auf der Sonne und dem Nordlichte. Ein Dritter lehrt Sie mit einem Male alle die über die Organisation, die Verbreitung und die Vergangenheit lebender Wesen gesammelten Erfahrungen von einem neuen Standpunkte aus betrachten und regt in einer einzigen Schrift hunderte von Fragen an, welche, neue Fragen gebärend, noch manche Generation nach uns beschäftigen werden.

Wie der Wanderer vom Berge aus seinen Blick über Berge, Thäler und Ebene schweifen lässt und Fluss, Wald und Ortschaften unter sich erkennt, so gewöhnt sich der Geist, über den ganzen Planeten hinzublicken, über die vielgestaltige Pflanzendecke des Erdballes und alles Leben, das da pulsirt von den Polen bis in die Tropenwälder. In die entferntesten Epochen einer unmessbaren Vergangenheit senkt er seine durchdringenden Gedanken und mit seinem unwiderstehlichsten Instrumente, der Mathematik, verfolgt er die Bahnen der Welten.

Und nun frage ich Sie, verehrte Anwesende, welche Lehre geeigneter sein könnte dem Menschen die ganze Erhabenheit der Stellung zu zeigen, die ihm in dieser Schöpfung angewiesen ist. Er fühlt sich der Herr. Auf einen Ossa von Erfahrungen träumt er einen Pelion von Vernunftschlüssen zu thürmen und dünkt sich der wahre, titanische Sohn der alten Mutter Gaia, bis endlich sein Blick die Nebel von Weltsystemen trifft, die um ihn kreisen und er gedemüthigt zurücksinkt.

Diese gewaltigen Schwankungen der Seele sind es, welche einen der höchsten Momente der Anregung in unserer Wissenschaft bilden. Das Gleichgewicht, das endlich folgt, erklärt Ihnen die grenzenlose Begeisterung und zugleich die ruhige Hingebung von welchen Hunderte von Naturforschern in unsern Tagen Zeugniss geben. Denken Sie an die Grossthaten arktischer Reisender und fragen Sie Sich dann, ob die Weltgeschichte irgend eine Heldenthat kenne, der dieses ruhige Eintreten in die Gefahren sich nicht vergleichen lässt.

Von der Ostküste des tropischen Amerika's fliesst ein mächtiger Strom warmen Wassers, der Golfstrom, Europa zu und einen Theil unserer Westküsten bespülend, erwärmt er unser Klima und befeuchtet er unsere Landschaften. Auf seinem Wege umfiiesst er die Halbinsel Florida, welche aus Korallenbildungen besteht. Millionen winziger Korallenthierchen vermehren heute noch fort und fort den Saum der Halbinsel und jedes einzelne Individuum trägt unbewusst sein Atom dazu bei, um dem Golfstrom eine andere Richtung zu geben und jenseits des Ocean's das Klima von Europa zu beeinflussen. So werden oft in der Natur durch kleine Kräfte grosse Wirkungen hervorgebracht. Mit Bewusstsein aber strebt nur der Mensch grossen Zielen nach.

Lassen Sie uns, die wir jung sind, glauben, dass unsere Ziele grosse seien, wie unser Object sicher ein grosses ist.

Ja, gross ist diese Schöpfung und unerschöpflich sind ihre Wunder. Das Auge vermag nicht sie zu fassen, vergebens müht sich der Geist, um sie alle zu begreifen; wie soll die Lippe im Stande sein sie alle zu schildern? Einzelne Skizzen, flüchtige Scenen aus dem grossen, lebensvollen, ewigen All sind es, die wir im besten Falle Ihnen versprechen können.

Der feinere Geist findet den Zusammenhang der Fragmente und ahnt die harmonische Grossartigkeit des Ganzen. Ja und eben diesen erhebenden Gedanken an die ewige, unendliche und unveränderliche Gesetzmässigkeit des Kosmos hinauszutragen in's Volk, das ist's was ich als die Mission dieses Vereines erkenne. Mag die Theilnahme seiner Mitglieder, der Eifer seiner Ausschüsse, mag vor Allem gegenseitiges Vertrauen und gegenseitige Zuneigung, dieser wahre Lebensnerv jeder gesellschaftlichen Verbindung, ihn durchströmen und kräftigen und ihm eine würdige Rolle schaffen inmitten des allgemeineren Erwachens geistigen Lebens, welchem unser Vaterland endlich entgegengeht.«

[1] http://www.univie.ac.at/Verbreitung-naturwiss-Kenntnisse/

[2] http://www.adulteducation.at/de/historiografie/institutionen/419/

[3] Eduard Suess: Ueber die Entstehung und die Aufgabe des Vereins. http://www.landesmuseum.at/pdf_frei_remote/SVVNWK_1_0003-0014.pdf

[4] An der Gründungsversammlung haben 31 Mitglieder teilgenommen, davon waren rund 2/3 Beamte und (Hochschul)lehrer, dazu kamen Studenten, Fabrikanten, Kaufleute, Freischaffende und auch Handwerker. ( Karl Hornstein: Über den Stand der Mitgliederzahl und des Vereinsvermögens. http://www.landesmuseum.at/pdf_frei_remote/SVVNWK_1_0015-0020.pdf)

The Face of The Earth - The Legacy of Eduard Suess (4:16)

Wiener Vorlesungen: Eduard Suess (1:17:27)

Eduard Suess Ausstellung (2:00)

Täuschende Schönheiten

Täuschende SchönheitenFr, 19.12.2014 - 06:29 — Bill S. Hansson

![]() Mit chemischen Tricks täuschen Aronstabgewächse und Orchideenblüten den Geruchssinn fliegender Insekten, um fremden Pollen zu empfangen und eigenen Pollen an benachbarte Blüten weiterzugeben. Dazu imitieren die Pflanzen beispielsweise die Duftstoffe gärender Hefe, um Fruchtfliegen anzulocken, oder weibliche Sexuallockstoffe, um Insektenmännchen als Bestäuber zu missbrauchen und am Ende sogar ohne Belohnung zu entlassen. Der Biologe Bill S. Hansson, Direktor am Max-Planck Institut für Chemische Ökologie und derzeitiger Vizepräsident der Max Planck Gesellschaft zeigt auf, wie die Aufklärung der chemischen Botenstoffe und ihrer Wirkung neue Einblicke in die Ökologie und Ko-Evolution von Pflanzen und Insekten erlaubt.*

Mit chemischen Tricks täuschen Aronstabgewächse und Orchideenblüten den Geruchssinn fliegender Insekten, um fremden Pollen zu empfangen und eigenen Pollen an benachbarte Blüten weiterzugeben. Dazu imitieren die Pflanzen beispielsweise die Duftstoffe gärender Hefe, um Fruchtfliegen anzulocken, oder weibliche Sexuallockstoffe, um Insektenmännchen als Bestäuber zu missbrauchen und am Ende sogar ohne Belohnung zu entlassen. Der Biologe Bill S. Hansson, Direktor am Max-Planck Institut für Chemische Ökologie und derzeitiger Vizepräsident der Max Planck Gesellschaft zeigt auf, wie die Aufklärung der chemischen Botenstoffe und ihrer Wirkung neue Einblicke in die Ökologie und Ko-Evolution von Pflanzen und Insekten erlaubt.*

Beziehungen zwischen Insekten und Pflanzen werden gern als Paradebeispiel für Mutualismus, also gegenseitigen Nutzen, betrachtet: Blüten werden durch das Insekt bestäubt, und der Bestäuber wird dafür mit reichlich Nektar belohnt. Der Mensch empfindet den Blütenduft, mit dem Pflanzen ihre Bestäuber anlocken, meist als angenehm.

Schon seit langem ist jedoch bekannt, dass sich einige Blütenpflanzen nicht an die oben erwähnten „sozialen“ Spielregeln halten. Stattdessen nutzen sie verschiedenste Arten von Lockstoffen, um Insekten auszutricksen und so zur Bestäubung zu verführen. Ein solches System steht in der Evolution unter einem äußerst hohen Selektionsdruck: Insekt und Blüte befinden sich – nach der so genannten Red-Queen-Hypothese – in einem endlosen Wettstreit, in dem die Blüte kontinuierlich täuscht und das Insekt vermeiden sollte, immer wieder getäuscht zu werden.

Der Vorteil der Pflanze

bei einer solchen Interaktion ist deutlich: Sie wird bestäubt, ohne dafür mit der Produktion von Nektar bezahlen zu müssen.

Das Insekt aber ist im Nachteil. Wenn es von der Pflanze an der Nase herumgeführt und als Bestäuber missbraucht wird, verliert es wertvolle Zeit und Energie. Oft hält eine Blüte das Insekt sogar für mehrere Stunden gefangen, um einen wirksamen Pollentransfer zur nächsten Blüte sicherzustellen. Im kurzen Leben vieler Insekten ist ein solcher Zeitverlust sehr kostspielig und sollte möglichst vermieden werden. Daher müssen „betrügerische“ Pflanzen Blüten hervorbringen, die für das Zielinsekt unwiderstehlich sind, denn sonst würde die Selektion Insekten hervorbringen, die gelernt haben, Imitation (z.B. Blütenduft) von Vorlage (z.B. Lockstoff des Weibchens) zu unterscheiden.

Wie sieht ein idealer Köder aus,

dem ein Insekt nicht widerstehen kann? Jedes Insekt möchte sich während seiner Lebenszeit so effektiv wie möglich fortpflanzen. Chemische Signalstoffe stellen daher zweckdienliche Mittel dar, die instrumentalisiert werden können. Insekten sind weitestgehend geruchsgesteuert, deshalb ahmen manche Blütenpflanzen Duftsignaturen nach, die bei der Fortpflanzung von Bienen, Fliegen, Käfern und anderen Insekten eine Rolle spielen. Zwei Hauptkategorien dieser molekularen Mimikry, die auf verschiedene Bereiche des tierischen Reproduktionssystems abzielen, können unterschieden werden: Sexuelle Mimikry, bei der die Blüte den Sexuallockstoff des anderen Geschlechts, in der Regel des Insektenweibchens, vortäuscht, und Mimikry der Brutstelle, bei der die Blüte eine perfekte Nahrungsquelle für die aus den abgelegten Eiern schlüpfenden Larven imitiert.

In diesem Artikel werden Beispiele aus den verschiedenen Systemen vorgestellt, bei denen die sensorischen Signale, die bei der Täuschung eine Rolle spielen, kürzlich aufgeklärt werden konnten. Der Schwerpunkt liegt auf Geruchssignalen, aber auch visuelle und thermische Signale wurden analysiert.

Sexuelle Täuschung

Ein Insektenmännchen kann es sich nicht leisten, auch nur eine Gelegenheit zur Paarung zu verpassen, denn es möchte sein Genom ebenso erfolgreich fortpflanzen wie seine Mitbewerber. Ein Insektenleben ist kurz und vor allem – die Gelegenheiten sind selten. Die starke Anziehungskraft des männlichen Insekts hin zur Sexualpartnerin ist deshalb eine perfekte Zielvorgabe für Pflanzen, entsprechende „Bestäubungssysteme“ zu entwickeln.

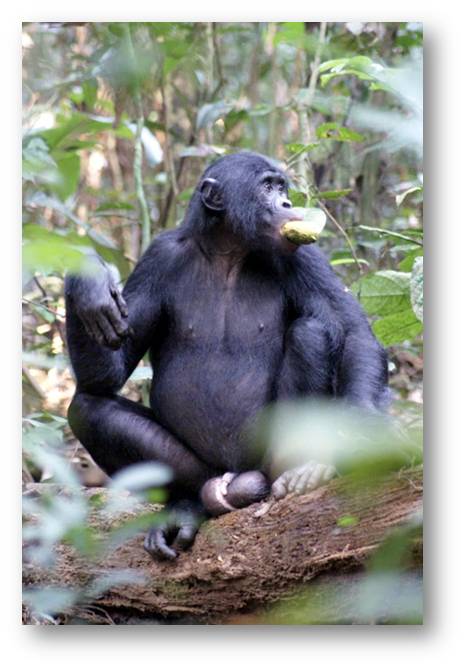

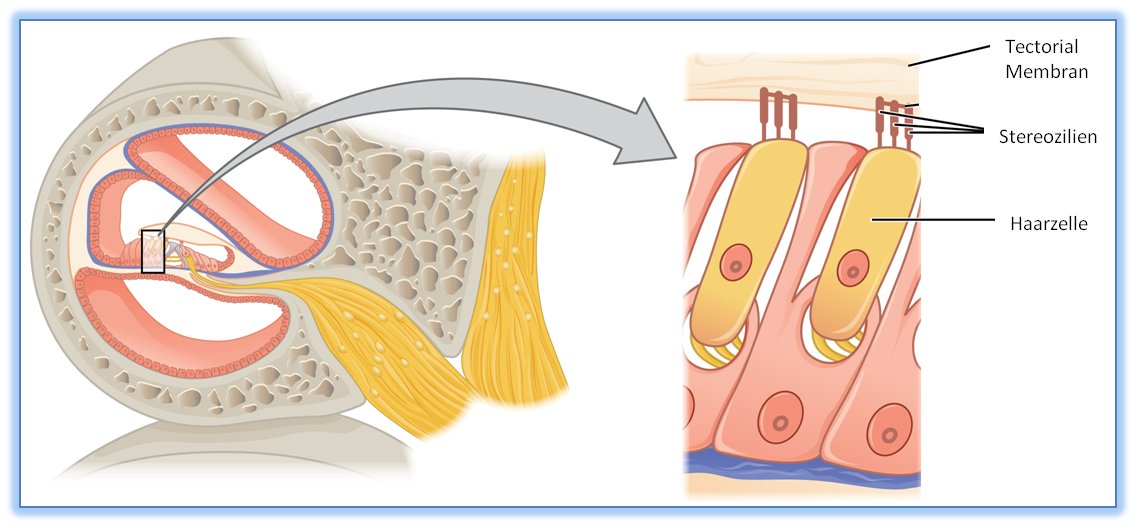

Von den Pflanzen, die eine sexuelle Mimikry entwickelt haben, sind vor allem die Orchideen bekannt (Abbildung 1). Das erste System, das sowohl auf chemischer als auch verhaltensbiologischer Ebene untersucht wurde, ist die Wechselwirkung zwischen der Orchideenart Ophrys sphegodes (Spinnenragwurz) und Sandbienen der Gattung Andrena.

In verschiedenen Studien konnte nachgewiesen werden, dass die Orchidee tatsächlich das aus einem Gemisch verschiedener Substanzen bestehende Sexualpheromon eines Bienenweibchens imitiert, und zwar so perfekt, dass das Männchen sogar versucht, mit der Blüte zu kopulieren, und so die Pollenmasse garantiert an seinem Körper kleben bleibt.  Abbildung 1.

Abbildung 1.

Abb. 1. Die Blüte der Orchideenart Ophrys insectifera (Fliegenragwurz), die eine weibliche Wespe sowohl visuell als auch chemisch nachahmt, um Wespenmännchen zur Bestäubung zu verführen. Die Blüte imitiert das Weibchen derart perfekt, dass das Männchen versucht, sich mit ihr zu paaren. Auf diese Weise kommt sein Kopf mit der klebrigen Pollenmasse in Kontakt und der Pollen wird auf die nächste Blüte übertragen. © Zeichnung: Max-Planck-Institut für chemische Ökologie/Hansson

Die Chemie der Täuschung

Das Pheromongemisch besteht aus etwa zehn verschiedenen Kohlenwasserstoffmolekülen, aber das Bestäubungssystem ist noch viel ausgeklügelter als zunächst angenommen.

Eine weibliche Biene paart sich nämlich nur ein einziges Mal mit einem Männchen. Jedes Weibchen besitzt einen individuellen Geruch, der sich von dem der anderen Weibchen minimal, nämlich je nach Mengenverhältnis der flüchtigen Kohlenwasserstoffmoleküle, unterscheidet. Um keine Zeit damit zu vergeuden, ein Weibchen zu umwerben, mit dem es sich bereits gepaart hat, merkt sich das Männchen die Duftsignaturen seiner bereits eroberten Partnerinnen.

Würden also alle Blüten der betrügerischen Orchideen gleich riechen, würden die Männchen keine weitere Blüte aufsuchen, weil sie dort ein Weibchen vermuten würden, mit dem sie sich bereits gepaart haben. Die Blüten geben deshalb Duftbouquets ab, die sich voneinander unterscheiden, und zwar in einer Variationsbreite, die den voneinander abweichenden Lockstoffbouquets der Weibchen entspricht.

Auf diese Weise wird das Männchen dazu verführt, von Blüte zu Blüte zu fliegen, und erst damit überträgt es den Pollen und sichert die Fortpflanzung und genetische Variabilität der Orchideenart.

Vorgetäuschte Brutstellen

Sexuelle Mimikry von Pflanzen ist fast immer auf paarungswillige Insektenmännchen ausgerichtet, die sich nur allzu leicht überlisten lassen. Von Pflanzen vorgetäuschte Brutstellen hingegen führen Insektenweibchen in die Irre, die nach einer geeigneten Nahrungsquelle für ihren Nachwuchs suchen. In den letzten Jahren wurden zahlreiche Arten der Gattung Arum aus der Familie der Aronstabgewächse analysiert, weil man vermutete, dass hier Brutstellen-vortäuschende Pflanzen zu finden sein sollten. Von diesen Pflanzen ist bekannt, dass sie – zumindest für die menschliche Nase – sehr eigenartige Blütendüfte produzieren und außerdem ein breites Spektrum an Bestäubern anlocken.

Ein Aronstabgewächs mit dem volkstümlichen Namen „Totes Pferd“

Die ersten Untersuchungen zur Brutstellen-Mimikry konzentrierten sich auf Pflanzen der Art Helicodiceros muscivorus, im Volksmund auch „Totes Pferd“ (dead horse arum) genannt. Diese auffällige und vor allem übelriechende Pflanze kommt auf kleinen Inseln im Mittelmeerraum vor. Sie ist fast immer in der Nähe größerer Möwenkolonien zu finden und blüht kurz bevor die Möwenjungen schlüpfen. In diesem Zeitraum trifft man interessanterweise auch auf große Populationen sogenannter Fleischfliegen, und tatsächlich konnte nachgewiesen werden, dass die Blüten den Geruch von verrottendem Fleisch imitieren und damit Fleischfliegen als unfreiwillige Bestäuber anlocken.

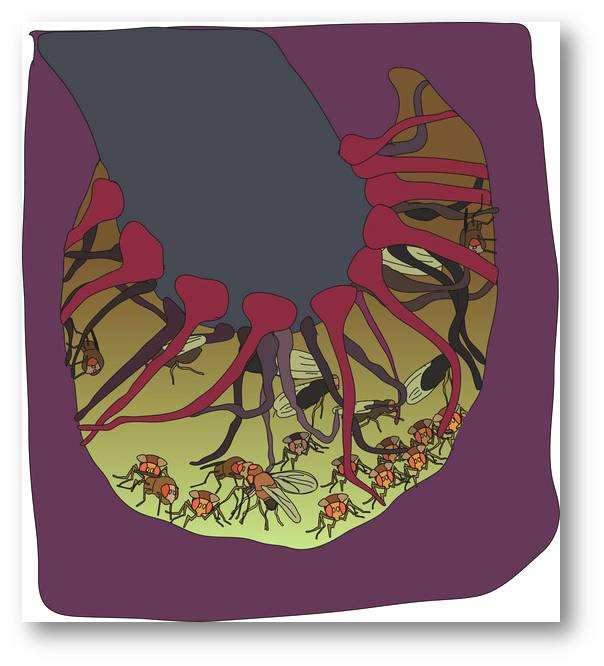

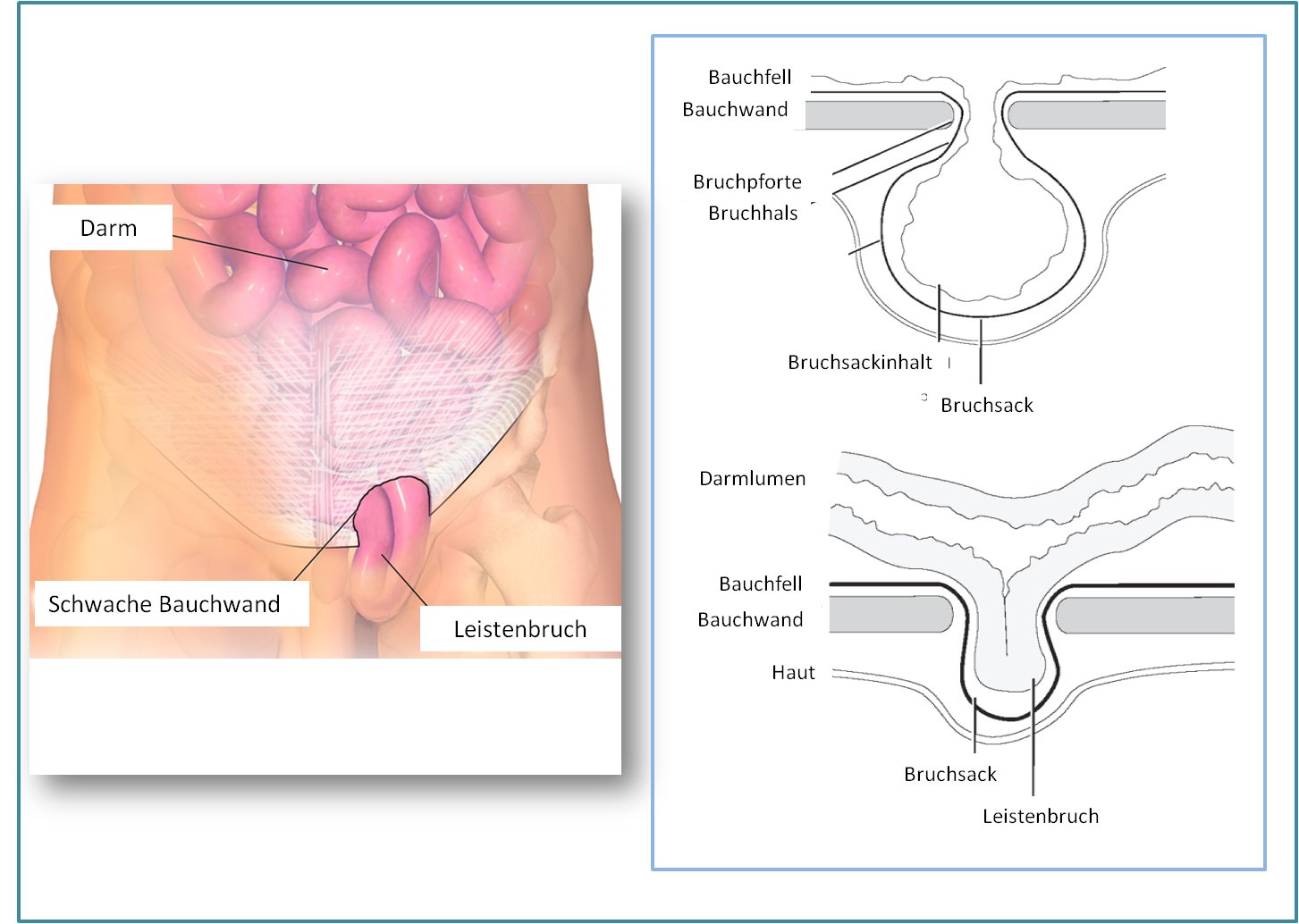

Elektrophysiologische Experimente zeigten, dass die Antennen der Fliege, also ihre „Nase“, auf den Geruch der Pflanze und den Geruch von fauligem Fleisch identisch reagierten. Bei den aktiven Komponenten der in der Blüte produzierten Duftmischung handelte es sich um drei verschiedene Oligosulfide. Zusätzlich heizt sich die Blüte auf und übersteigt die Umgebungstemperatur um etwa 15 Grad Celsius. Sie ahmt damit die Hitze nach, die in einem faulenden Tierkadaver entsteht. Die Blüte öffnet sich zwei Tage lang, produziert ihren fauligen Geruch und zusätzliche Wärme aber nur am ersten Tag. Diese Tatsache ermöglichte es den Wissenschaftlern, die Attraktivität der Blütensignale genau zu testen. Dazu wurde die Blüte am zweiten Tag – wenn sie normalerweise nicht mehr riecht – zuerst mit einem synthetischen Duft versehen. Es zeigte sich, dass die Fliegen im gleichen Ausmaß wie am ersten Tag angelockt wurden, allerdings krabbelten sie nicht bis in den Kelch der Blüte hinein, wo die Fliegen üblicherweise für einige Zeit gefangen gehalten werden, um die Pollenübertragung sicherzustellen (Abbildung 2).

Abbildung 2. Zeichnung des Blütenkelchs des Aronstabgewächses Dead Horse Arum, der als Fliegenfalle fungiert. Die Fliegen werden durch die Kombination von olfaktorischen, visuellen und thermischen Stimuli angelockt, was die Pflanze für weibliche Fleischfliegen, die nach Eiablage ihrem Nachwuchs eine optimale Nahrungsquelle bieten wollen, unwiderstehlich macht. Sie werden in der Kammer gefangen, wo sie die weiblichen Blüten (ganz unten im Kelch) bestäuben. Am zweiten Tag welken die Stacheln oberhalb der weiblichen Blüten und die Fliegen werden wieder freigelassen, damit sie den Pollen der männlichen Blüten übertragen können. © Zeichnung: Max-Planck-Institut für chemische Ökologie/Hansson

Abbildung 2. Zeichnung des Blütenkelchs des Aronstabgewächses Dead Horse Arum, der als Fliegenfalle fungiert. Die Fliegen werden durch die Kombination von olfaktorischen, visuellen und thermischen Stimuli angelockt, was die Pflanze für weibliche Fleischfliegen, die nach Eiablage ihrem Nachwuchs eine optimale Nahrungsquelle bieten wollen, unwiderstehlich macht. Sie werden in der Kammer gefangen, wo sie die weiblichen Blüten (ganz unten im Kelch) bestäuben. Am zweiten Tag welken die Stacheln oberhalb der weiblichen Blüten und die Fliegen werden wieder freigelassen, damit sie den Pollen der männlichen Blüten übertragen können. © Zeichnung: Max-Planck-Institut für chemische Ökologie/Hansson

Die Täuschung funktionierte jedoch vollständig, wenn dem Kelch künstlich genügend Wärme hinzugefügt wurde: Die Fliegen gingen in die Falle. Dieses Aronstabgewächs bedient sich also einer multisensorischen Täuschung, um Fleischfliegen erfolgreich anzulocken. Neben der Geruchs- und Wärme-Imitation verwendet die Pflanze zusätzliche mechanosensorische und visuelle Signale, um ihre Attraktivität bei den Fliegen noch weiter zu steigern.

Die Bestäubungsstrategie von Helicodiceros muscivorus hängt von der perfekten Nachahmung einer unwiderstehlichen Ressource ab, damit Fliegenweibchen das vermeintlich optimale Eiablagesubstrat nicht ignorieren können. Gleichzeitig drängt die Pflanze die Fliegen aus der Perspektive der Evolution kaum dazu, Maßnahmen gegen die Täuschung zu entwickeln, weil sie für ihre betrügerischen Aktionen nur kurze Zeitfenster (wenige Wochen) und sehr begrenzte Lebensräume (kleine Mittelmeerinseln) nutzt.

Aronstabgewächse auf Kreta

Auf der Insel Kreta kommen verschiedene Arten der Gattung Arum vor. In einer Reihe von Feld- sowie Laborexperimenten wurden vier dieser Arten näher untersucht. Es konnte gezeigt werden, dass zwei Arten, A. cyrenaicum und A. concinnatum, einen strengen Geruch nach Tierkot abgeben und mit Helicodiceros muscivorus („Totes Pferd“, s.o.) einige Ähnlichkeiten aufweisen: Beide Pflanzenarten besitzen wärmebildende Gewebe und mit ihren sich ähnelnden Duftbouquets locken sie kleine Fliegen an, die sie für einige Zeit gefangen halten. Obwohl sie den gleichen Lebensraum teilen, unterscheiden sich die zwei Arum-Arten in der Blütezeit, weshalb eine gegenseitige Befruchtung ausgeschlossen ist.

Hingegen haben die beiden Arten A. creticum und A. idaeum einen eher traditionellen Bestäubungsmechanismus entwickelt, der auf dem gegenseitigen Nutzen für Pflanze und Bestäuber beruht. Statt eines stinkenden Geruchs geben sie einen, zumindest für uns Menschen, angenehmeren Blütenduft ab, der Bienen und Käfer anlockt. Obwohl die beiden Arum-Arten dieselben Bestäuberarten anlocken, unterscheidet sich der Hauptbestandteil im Duft von A. creticum von dem in A. idaeum, und die Bestäuber können möglicherweise die Düfte der beiden Arten unterscheiden. Ein Vergleich aller wesentlichen Blütenduftkomponenten der vier kretischen Arum-Arten, die mittels Gaschromatografie-Massenspektrometrie identifiziert wurden, ergab Ähnlichkeiten und Unterschiede. Die zwei belohnenden, mutualistischen Arten A. creticum und A. idaeum und die beiden nicht-belohnenden, fliegenfangenden Arten A. cyrenaicum und A. concinnatum bilden jeweils zwei Duftstoffgruppen, wobei sich die jeweiligen Gruppenpaare der belohnenden bzw. nicht-belohnenden Spezies deutlich voneinander unterscheiden.

Die Schwarze Calla

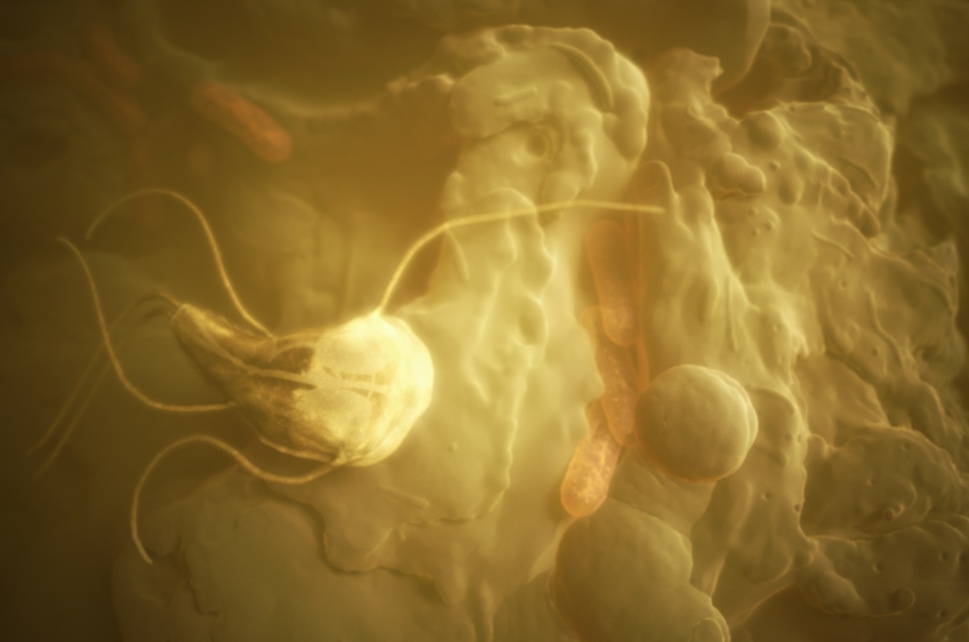

In einer der neuesten Arbeiten aus unserer Abteilung wurde eine Population der Schwarzen Calla (Arum palaestinum) im Norden Israels untersucht. In ersten Feldstudien konnte beobachtet werden, dass Blüten dieser Art eine große Anzahl von Taufliegen (Drosophiliden) anlocken (Abbildung 3).

Abbildung 3. Taufliegen (Drosophiliden; auch Essig- oder Fruchtfliegen genannt) sind im Kelch einer Schwarzen Calla gefangen.Die Fliegen wurden durch Duftstoffe angelockt, die durch Hefe vergorene Früchte imitieren. ©Zeichnung: Max-Planck-Institut für chemische Ökologie/Hansson

Abbildung 3. Taufliegen (Drosophiliden; auch Essig- oder Fruchtfliegen genannt) sind im Kelch einer Schwarzen Calla gefangen.Die Fliegen wurden durch Duftstoffe angelockt, die durch Hefe vergorene Früchte imitieren. ©Zeichnung: Max-Planck-Institut für chemische Ökologie/Hansson

Eine einzige Blüte konnte innerhalb weniger Stunden bis zu 500 Fliegen ködern.

Das Duftbouquet der Blüte wurde daraufhin genauer analysiert. Auf die menschliche Nase wirkt der Duft ähnlich wie der eines süßen Weines. Unter den Duftbestandteilen befanden sich 2,3-Butandionacetat und Acetoinacetat. Diese beiden Komponenten kommen sehr selten in Blütenduftbouquets vor, dagegen treten sie häufig als Produkte alkoholischer Gärung auf.

Im weiteren Verlauf der Untersuchungen wurde deutlich, dass die Calla in der Tat einen Gärungsprozess imitiert, indem sie ein Duftbouquet mit sieben typischen Gärungs-Geruchsstoffen produziert. Im Labor wurde die Anziehungskraft verschiedentlich zusammengestellter Duftmischungen getestet: Es zeigte sich, dass eine Mischung aus genau denjenigen Duftkomponenten auf die Fliegen besonders anziehend wirkt, die z.B. dem Duftprofil faulender Bananen entspricht, also einem Substrat, auf das Drosophiliden von Natur aus nahezu versessen sind.

Mithilfe des optical imaging wurden die primären Geruchszentren im Gehirn der Drosophiliden betrachtet, und es konnte abgeleitet werden, welche Geruchsrezeptoren in der Fliegenantenne aktiviert werden. Ein Vergleich dieser Rezeptoren innerhalb aller Fruchtfliegenarten, deren Genom vollständig sequenziert wurde (insgesamt 12 Arten), ergab, dass der Blütenduft der Schwarzen Calla drei Hauptgruppen von Rezeptoren aktiviert. Davon ist eine Gruppe in allen zwölf Arten hoch konserviert: Diese Rezeptoren signalisieren die Anwesenheit von gärenden Hefepilzen – also der Grundnahrungsquelle der Fliegen. Die zweite Gruppe signalisiert, dass von Hefe fermentierte Früchte in der Nähe sind; diese Rezeptoren sind somit besonders in Obst-konsumierenden Fliegenarten zu finden. Die dritte Gruppe von Rezeptoren ist weniger konserviert als die anderen beiden und scheint sich an die spezifischen Bedürfnisse obstfressender Art angepasst zu haben. Fazit: Die Blüte der Schwarzen Calla produziert somit den perfekten Lockduft, indem sie eine Reihe verschiedener wichtiger Reizleitungen in das Fliegengehirn kombiniert, die sämtlich der Fliege folgende Botschaft übermitteln: Komm zu mir, hier ist etwas wirklich Leckeres!

Die Analyse des Bestäubungssystems von A. palaestinum ist ein ausgezeichnetes Beispiel für die Erforschung der Funktionalität von sensorisch basiertem Verhalten. Die Blüte bietet die sensorischen Signale, die benötigt werden, um sie für Fliegen so verführerisch wie möglich zu machen. Diese Signale wiederum sind die Eintrittskarte dafür, das System im Gehirn der Fliegen zu analysieren und bis zu ihrem Verhalten weiter zu verfolgen.

Die nächsten Schritte

Unsere Studien werden derzeit in verschiedene Richtungen weiter verfolgt. In einigen Mittelmeer-Regionen werden Populationen von Arum dioscoridis verglichen. Diese Art befindet sich anscheinend inmitten eines Prozesses voranschreitender Speziation (Artbildung) und divergiert in der Zusammensetzung abgegebener Duftmoleküle, Blütezeit und Morphologie. Interessanterweise scheinen verschiedene Populationen unterschiedlichen Kot nachzuahmen: einige riechen mehr nach dem Kot von Raubtieren, andere nach dem von Pflanzenfressern. In der Türkei wird der Hügel-Aronstab A. rupicola untersucht, der vermutlich einen Mechanismus entwickelt hat, warmblütige Säugetiere nachzuahmen, um blutsaugende Insekten als Bestäuber anzulocken.

Darüber hinaus wurde kürzlich entdeckt, dass eine Orchidee die Alarmpheromone von Blattlauskolonien imitiert, um räuberische Schwebfliegen anzulocken [9]. Zudem werden zurzeit weitere Pflanzenarten gesucht, die Drosophiliden täuschen, denn solche Pflanzen vermitteln ein einzigartiges Wissen darüber, welche Stimuli für diese genetischen und verhaltensbiologischen Modellorganismen wirklich unwiderstehlich sind.

Die Betrachtung der in diesem Artikel geschilderten unterschiedlichen Bestäubungssysteme offenbart die treibenden Kräfte der Evolution und erlaubt damit einen Einblick in ökologische Mechanismen und Wechselwirkungen, die sonst nur schwer bestimmbar gewesen wären.

*Der im Forschungsmagazin der Max-Planck Gesellschaft 2011 erschienene Artikel Artikel http://www.mpg.de/1155805/Taeuschende_Schoenheiten?c=1070738 wurde mit freundlicher Zustimmung des Autors und der MPG-Pressestelle ScienceBlog.at zur Verfügung gestellt. Der Artikel erscheint hier in voller Länge, geringfügig für den Blog adaptiert und ohne Literaturzitate.

Weiterführende Links

Wild orchid wasp mimic - David Attenborough - BBC Video 2:58 min, https://www.youtube.com/watch?v=-h8I3cqpgnA

Wild Orchids of Israel:Seduction of the Long-horned Bee Video 3:40 min, https://www.youtube.com/watch?v=yFftHXbjEQA

Wow - the biggest flower in the world - Titan Arum - David Attenborough - BBC wildlife Video 2:28 min, https://www.youtube.com/watch?v=FHaWu2rcP94

Dead Horse Arum Video 3:29 min, https://www.youtube.com/watch?v=OelTxxW0GvY

Was macht HCB so gefährlich?

Was macht HCB so gefährlich?Fr, 12.12.2014 - 05:18 — Inge Schuster

![]() Zur Zeit geht eine Meldung durch alle Medien und sorgt für größte Verunsicherung: Schadstoffmessungen haben in einigen Milchproben aus dem Kärntner Görtschitztal erhöhte Werte von Hexachlorbenzol (HCB) festgestellt. Ein Skandal, wie es einige Medienberichte – unter Akklamation zahlreicher Kommentatoren – titulieren? Die bis jetzt vorliegenden Untersuchungsergebnisse erlauben sicherlich (noch) nicht, dass man auf eine längerfristige Gefährdung der Bewohner des Görtschitztales oder der Konsumenten seiner Produkte schließen könnte.

Zur Zeit geht eine Meldung durch alle Medien und sorgt für größte Verunsicherung: Schadstoffmessungen haben in einigen Milchproben aus dem Kärntner Görtschitztal erhöhte Werte von Hexachlorbenzol (HCB) festgestellt. Ein Skandal, wie es einige Medienberichte – unter Akklamation zahlreicher Kommentatoren – titulieren? Die bis jetzt vorliegenden Untersuchungsergebnisse erlauben sicherlich (noch) nicht, dass man auf eine längerfristige Gefährdung der Bewohner des Görtschitztales oder der Konsumenten seiner Produkte schließen könnte.

Da ich mich jahrzehntelang mit dem „Schicksal“ von Fremdstoffen in der Biosphäre beschäftigt habe, möchte ich von dieser Warte aus das vermutlich gravierendste Problem von Hexachlorbenzol (HCB) ansprechen, nämlich seine sehr hohe Persistenz in der Biosphäre. Näheres zu HCB selbst, seinem Vorkommen (u.a. in Lebensmitteln), seiner Anreicherung in Organismen und damit verbundenen gesundheitlichen Risiken, sowie offizielle Berichte und Richtlinien – von Seiten der EU und der US – finden sich am Schluss des Artikels (Reports in English, free download).

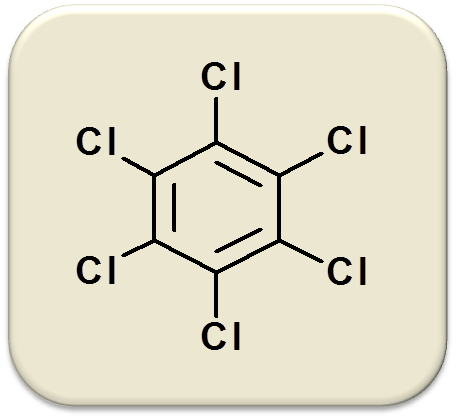

Was ist Hexachlorbenzol (HCB)?

Simpel ausgedrückt: ein einfaches kleines Molekül (C 6 Cl 6 – Molekulargewicht 284 D), ein Benzol, das alle 6 Positionen seines Rings durch Chloratome besetzt hat (Abbildung 1).

Die weiße, relativ flüchtige Substanz wird durch Chlorierung von Benzol hergestellt; sie ist in Wasser praktisch unlöslich, löst sich dagegen 500 000 Mal besser in nichtwässrigen Systemen wie Ölen, Fetten und ganz allgemein organischen Lösungsmitteln.

Abbildung 1. Chemische Struktur von Hexachlorbenzol (HCB)

Abbildung 1. Chemische Struktur von Hexachlorbenzol (HCB)

HCB ist eine chemisch sehr stabile Verbindung. Ein Abbau in der Atmosphäre (durch Radikalreaktionen, Photolyse) ist extrem langsam (Halbwertzeiten in der Größenordnung von mehreren Jahren), ebenso in biologischen Systemen (s.u.). Als Folge akkumuliert HCB in der Umwelt.

Verwendung von HCB und gesundheitliche Probleme

Bis in die frühen 1980er Jahre wurde Hexachlorbenzol weltweit exzessiv genutzt. HCB diente vor allem als hochwirksames Fungizid – d.i. als Mittel gegen Pilzbefall: In der Landwirtschaft wurden damit große Durchbrüche erzielt u.a. gegen den Weizensteinbrand; dazu wurde mit HCB gebeiztes Saatgut eingesetzt, welches bis zu rund 1g der Substanz im kg enthalten konnte. Als Fungizid wurde HCB auch in Holzschutzmitteln genutzt. Weite Verwendung fand HCB in der Industrie: u.a. als Zusatzstoff von PVC (Polyvinylchlorid - beispielsweise für Bodenbeläge) und von Isolationsmaterialien, bei der Herstellung von Graphitanoden, von pyrotechnischen Produkten u.v.a.m.

In der zweiten Hälfte der 1950er Jahre gab es dann gravierende Hinweise, dass durch HCB schwere gesundheitliche Schäden verursacht werden können: In Südostanatolien hatte eine Bevölkerungsgruppe Saatgut verwendet, das mit einer viel zu hohen Menge an HCB (2kg HCB/1 000kg) präpariert gewesen war und über Jahre das Brot gegessen, das sie aus den erhaltenen Ernten produzierten. Rund 4 000 Personen erkrankten damals, vor allem an Porphyrie (Porphyria cutanea tarda – PCT) – Zielorgane waren neben der Leber: Haut, Knochen und Schilddrüse – und rund 10% der Erwachsenen starben. Die offensichtlich viel zu hohen HCB Konzentrationen in der Muttermilch führten aber zu einer extrem hohen Sterblichkeit (95%!) von Kindern unter 2 Jahren.

Schätzungen zufolge hatten die Menschen über Jahre hinweg täglich 50 – 200mg HCB (0,7 – 2,9 mg/kg Körpergewicht) zu sich genommen. Auch Jahrzehnte später litten sie noch unter den Folgeerscheinungen des HCB. (Zum Vergleich: die bei uns heute als tolerierbar geschätzte tägliche Aufnahme liegt bei 0,01µg/kg (Mikrogramm/kg) Körpergewicht, d.i. um mehr als 100 000mal niedriger.)

Eine derartige Katastrophe ist zum Glück anderswo nicht aufgetreten.

Als Folge gab es an vielen Orten - weltweit - Untersuchungen der Bevölkerung. Wichtig war vor allem das Risiko von Personen zu erheben, die im Umkreis von Industrien zu Herstellung, Anwendung und Entsorgung von chlorierten Verbindungen lebten und z.T. auch dort beschäftigt waren. Gemessen an den HCB-Serumspiegeln waren z.T. recht hohe HCB-Belastungen ersichtlich (z.B in Flix/Spanien lagen die Serumkonzentrationen bei 93 – 223µg/l ). Die von verschiedenen Gruppen erhobenen Gesundheitsdaten waren aber recht ambivalent: eine Reihe von Daten wies darauf hin, dass die HCB-Belastung keinen oder einen nur sehr geringen Einfluss auf relevante klinische Parameter bewirkte, andere Daten zeigten Zusammenhänge zu Schädigungen von Leber, Muskel, Schilddrüse u.a.

Für die Argumentationen zur Schädlichkeit von HCB wurden (und werden weiterhin) gerne eindeutige Daten aus Tierversuchen (von Maus, Ratte, Hund bis hin zum Affen) und auch aus in vitro Versuchen mit Zellkulturen ins Treffen geführt. Das Problem dabei ist: die in diesen Versuchen angewandten HCB- Dosen betrugen ein Vielfaches der Dosen, die sich als katastrophale Belastung in Ostanatolien erwiesen hatten.

Reduktion der HCB Emissionen

In Anbetracht der mit HCB verbundenen Risiken wurde in der Folge die Produktion von HCB weitestgehend eingestellt, sein landwirtschaftlicher Einsatz von der Europäischen Gemeinschaft 1981 verboten.

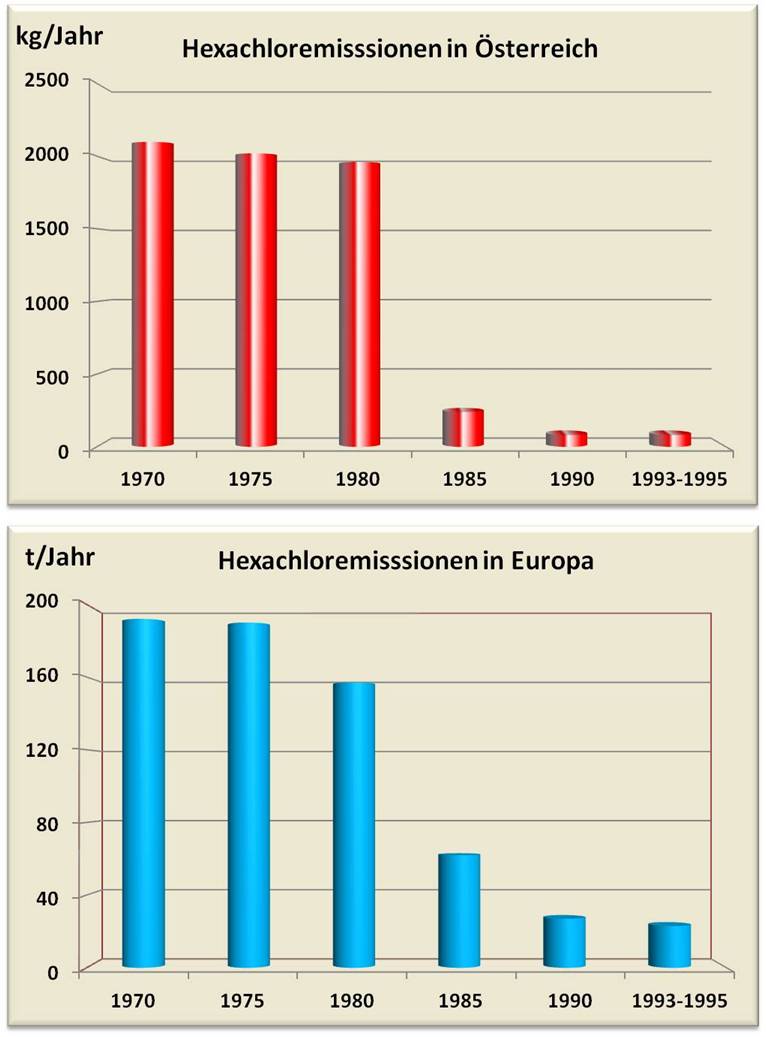

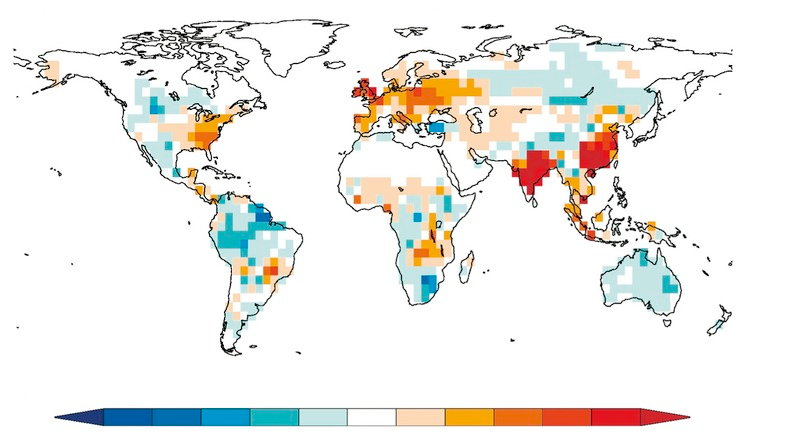

Im Jahre 2001 haben 151 Staaten das weltweite Verbot von 12 Chlorverbindungen („das dreckige Dutzend“) – darunter HCB – in der Stockholmer Konvention zum Schutz der Gesundheit und der Umwelt unterzeichnet. Damit wurde das Problem mit HCB bedeutend verringert, aber nicht völlig aus der Welt geschafft (Abbildung 2).

HCB ist – auf einem niedrigeren Level - weiter in der Umwelt vorhanden:

- Es entsteht bei praktisch allen Verbrennungsprozessen, die in Gegenwart von Kohlenstoff und Chlor ablaufen (beides ubiquitäre Elemente der Biosphäre). Besonders hohe Konzentrationen - mehrere Gramm HCB je Tonne Material - können bei Verbrennung von Klärschlamm oder Polyvinylchlorid (PVC) anfallen.

- HCB ist ein Nebenprodukt bei der Herstellung von chlorierten Lösungsmitteln und Pestiziden.

- HCB liegt in Altlasten im Boden vor.

Abbildung 2. Die Emission von Hexachlorbenzol ist stark zurückgegangen aber nicht völlig verschwunden

Abbildung 2. Die Emission von Hexachlorbenzol ist stark zurückgegangen aber nicht völlig verschwunden

Das Problem der Persistenz von HCB

Der wesentliche Grund für die Gefährlichkeit von HCB liegt in seiner Persistenz.

Wie auch für andere kleine, lipophile (fettlösliche) Moleküle ist es kein Problem für HCB, durch die Lipidschicht der Zellmembran ins Zellinnere, in ganze Organismen einzutreten. Da das Zellinnere reich an Lipid-haltigen Strukturen und auch an diversen Proteinen ist, an die fettlösliche Moleküle binden können, kommt es zu deren Anreicherung in der Zelle. Dies ist auch für HCB der Fall.

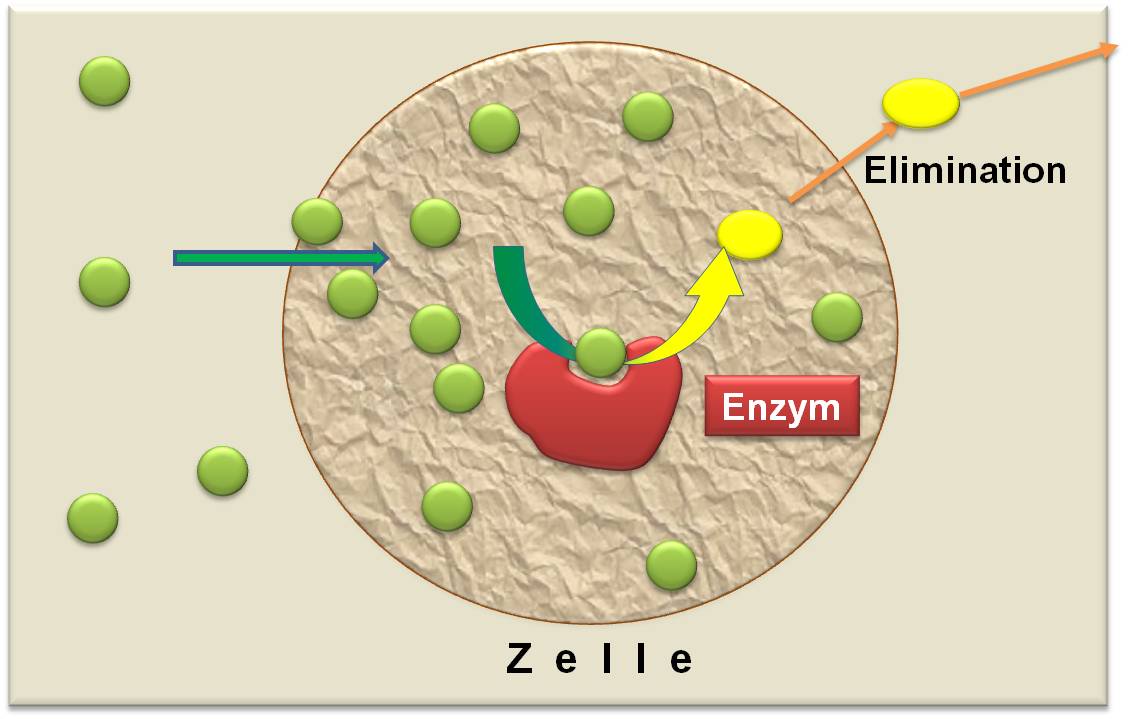

Da zunehmende Anreicherungen von Fremdstoffen die Funktion von Zellproteinen- und Strukturen enorm beeinträchtigen/schädigen würden, enthalten Zellen ein Set von Enzymen, welche nahezu alle Fremdstoffe in Verbindungen umwandeln, welche weniger anreichern und damit aus den Zellen ausgeschieden – eliminiert – werden. Für den Großteil der Fremdstoffe – auch beispielsweise für die meisten Medikamente - genügen dazu einige wenige Vertreter aus der sogenannten Cytochrom P450 (CYP) Familie. Diese binden den jeweiligen Fremdstoff und oxydieren ihn. Dabei entsteht ein Produkt (der Metabolit), das zumeist weniger fettlöslich und mehr wasserlöslich ist. Dieses kann aber noch weitere Male oxydiert werden - solange bis es auf Grund seiner sehr geringen Lipophilie kaum noch Bindungspartner im Zellinneren findet.

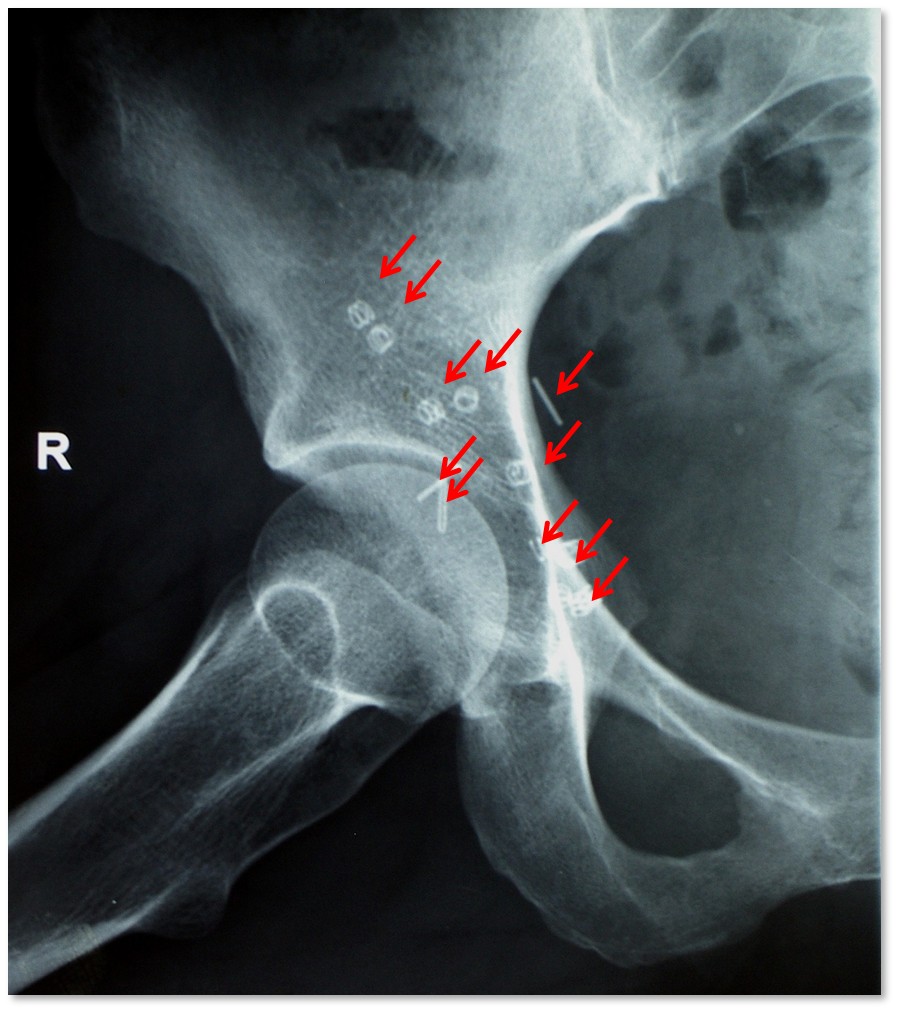

Im Fall des HCB existieren ebenfalls Enzyme (CYP1A1 CYP1A2, CYP3A4), die den Stoff binden können (Abbildung 3). Es ist für diese allerdings sehr schwierig die Kohlenstoff-Chlor Bindungen im Molekül anzugreifen um das Molekül zu oxydieren. Dementsprechend erfolgen derartige Oxydationen nur äußerst langsam. Kommt von außen noch weiteres HCB, ohne dass äquivalente Mengen die Zelle verlassen können, so reichert sich die Substanz mehr und mehr in den Zellen an. (Dies gilt auch für andere mehrfach chlorierte Substanzen, wie beispielsweise die Dioxine.)

Abbildung 3. Infolge einer sehr langsamen Umwandlung von HCB (grün) in weniger fettlösliche Produkte (gelb) kommt es zur Diskrepanz zwischen Aufnahme und Eliminierung und HCB reichert sich mehr und mehr an.

Abbildung 3. Infolge einer sehr langsamen Umwandlung von HCB (grün) in weniger fettlösliche Produkte (gelb) kommt es zur Diskrepanz zwischen Aufnahme und Eliminierung und HCB reichert sich mehr und mehr an.

Die mangelnde Fähigkeit HCB in weniger fettlösliche Substanzen umzuwandeln gilt gleichermaßen für Mikroorganismen, das Pflanzen-, Pilze- und Tierreich. Dementsprechend dauert es sehr lange (Halbwertszeiten von mehreren Jahren bis zu Jahrzehnten) bis Altlasten von HCB durch im Erdreich lebende Organismen abgebaut sind.

Aus dem Wasser gelangt HCB in die dort lebenden Tiere und reichert sich an, aus der Luft und dem Boden in Pflanzen, aus der Luft und der Nahrung in die Landbewohner. Über die Nahrungskette nehmen wir überall HCB-kontaminiertes Material zu uns.

Der Abbau von HCB wurde in vielen Spezies untersucht – er ist überall sehr langsam.

Vom Menschen gibt es nur indirekte Daten. Schätzungen der Eliminierungsraten (Halbwertszeiten) bewegen sich von 2 – 3 Jahren bis hin zu 6 Jahren und darüber. Wichtig erscheint dabei: HCB ist nicht gleichmäßig auf den Organismus verteilt, der Großteil wandert – wie könnte es anders sein – aus der Blutzirkulation ins Fettgewebe. Während HCB im Blut üblicherweise unter 1ng/ml (Nanogramm pro Milliliter) liegt, können es im Fettgewebe auch bis zu mehreren 100ng/ml sein. (Bei Gewichtsverlust taucht dann vermehrt HCB im Blut und in den Organen auf.)

Muß man sich vor HCB also fürchten?

Mit dem Rückgang der HCB-Emissionen (Abbildung 2) ist es – zwar langsam aber dennoch ähnlich dramatisch - auch zu einer entsprechenden Verringerung des HCB in unserem Organismus gekommen. Im Boden hat sich HCB verringert, ebenso in der Nahrungskette. Messungen aus Deutschland belegen beispielsweise, dass zwischen 1983 und 1998 eine 90% Reduktion von HCB im humanen Fettgewebe erfolgt ist.

Basierend auf den Untersuchungen an Tiermodellen hat man Richtlinien zu tolerierbare Mengen der täglichen Aufnahme (DTA-Wert) für den Menschen abgeschätzt. Dabei ging man vom niedrigsten, gerade noch beobachtbaren Effekt beim Tier aus und hat dann – überaus vorsichtig - noch einen Sicherheitsfaktor von 1 000 eingebaut, um das Risiko einer möglichen Cancerogenität und einer hormonellen Schädigung mit einzubeziehen:

Demnach sollte eine langfristige tägliche Aufnahme von 0,01µg/kg Körpergewicht (im Schnitt 0,70µg pro Erwachsenem) zu keinen gesundheitlichen Störungen führen.

Die Frage, welche Lebensmittel aus einer Mit HCB kontaminierten Region und wieviel davon zum Verzehr gelangen dürfen, sollte an Hand der DTA-Werte beantwortet werden.

Mit HCB werden wir weiter leben müssen – es entsteht schließlich, wenn auch in kleinen Mengen, auch durch natürliche Ursachen. Es wird auch weiterhin in unseren Körpern detektiert werden können.

Literatur

(free download)

- Recommendation from the Scientific Committee on Occupational Exposure Limits for Hexachlorobenzene (SCOEL/SUM/188; 12. 2013) http://www.ser.nl/documents/82398.pdf

- J. Barber et al. 2005: Hexachlorobenzene - Sources, environmental fate and risk characterization. http://www.eurochlor.org/media/1495/sd9-hexachlorobenzene-final.pdf

- The 2011 European Union Report on Pesticide Residues in Food (published on 27th June 2014, replaces the earlier version). EFSA Journal 2014;12(5):3694.

http://www.efsa.europa.eu/de/efsajournal/pub/3694.htm

The report presents the results of the control activities related to pesticide residues in food carried out in 2011 in 29 European countries

- Draft Toxicological Profile for Hexachlorobenzene U.S. DEPARTMENT OF HEALTH AND HUMAN SERVICES, Public Health Service, Agency for Toxic Substances and Disease Registry (Juni 2013).

Gefahr aus dem Dschungel – Unser Kampf gegen das Ebola-Virus

Gefahr aus dem Dschungel – Unser Kampf gegen das Ebola-VirusFr, 05.12.2014 - 08:52 — Gottfried Schatz

![]() Wir könnten das gefürchtete Virus durch bewährte Strategien und wirksame Impfstoffe in Schach halten, doch Kriege und mangelnde Weitsicht haben dies bisher verhindert. Impfgegner gefährden mit ihrer Irrationalität sich selbst und ihre Mitbürger, ohne sich schuldig zu fühlen.

Wir könnten das gefürchtete Virus durch bewährte Strategien und wirksame Impfstoffe in Schach halten, doch Kriege und mangelnde Weitsicht haben dies bisher verhindert. Impfgegner gefährden mit ihrer Irrationalität sich selbst und ihre Mitbürger, ohne sich schuldig zu fühlen.

An einem Septembertag des Jahres 1976 überbrachte ein Pilot der Sabena Airlines dem jungen Antwerpener Wissenschaftler Peter Piot eine blaue Thermosflasche. Laut dem Begleitbrief enthielt sie eisgekühlte Blutproben einer belgischen Nonne die im abgelegenen Dorf Yambuku im damaligen Zaïre mit hohem Fieber erkrankt war. Könnte Dr. Piots Institut das Blut auf Gelbfieber-Virus testen? Das Blut enthielt zwar weder dieses Virus noch andere bekannte pathogene Viren, tötete jedoch alle Labortiere, denen man es einspritzte. Offenbarg barg es einen besonders tödlichen, noch unbekannten Krankheitserreger.

Ein neues Virus

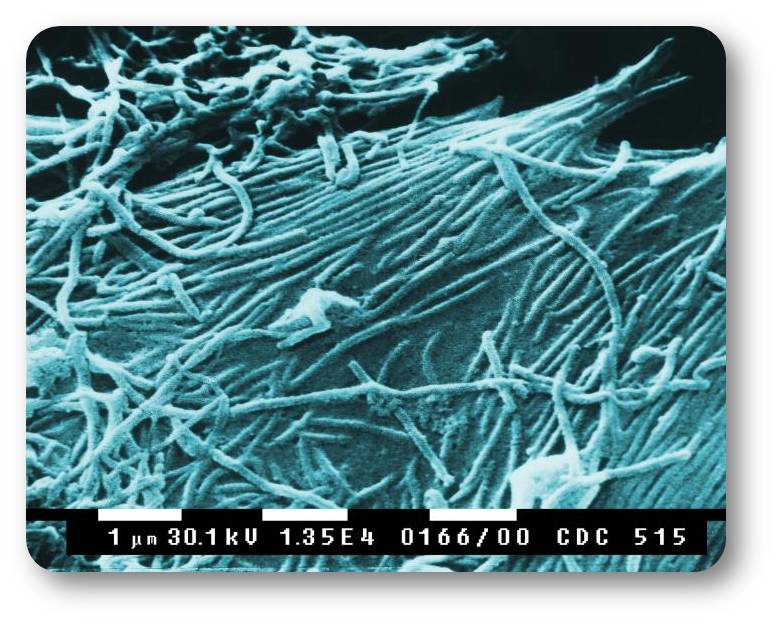

Er entpuppte sich als ein ungewöhnlich langes, wurmähnliches Virus (Abbildung 1), das etwa tausendmal dünner als ein menschliches Haar war und fatal dem gefürchteten Marburg-Virus glich, das 1967 in Marburg mehrere Laborarbeiter getötet hatte.

Abbildung 1. Ebola Viren. Elektronenmikroskopische Aufnahme (Quelle: Wikipedia; CDC - http://phil.cdc.gov/phil)

Abbildung 1. Ebola Viren. Elektronenmikroskopische Aufnahme (Quelle: Wikipedia; CDC - http://phil.cdc.gov/phil)

Ebola – vorerst wenig interessant -…

Wenige Tage darauf entsandte die belgische Regierung Peter Piot nach Yambuku, wo er und andere Wissenschaftler das neue Virus nach dem Ebola Fluss in der Nähe des Dorfes „Ebola Virus“ tauften. Zu diesem Zeitpunkt war die Seuche bereits im Abklingen, so dass das öffentliche Interesse an ihr bald verebbte. Das Virus meldete sich mehrmals kurz zurück - wie 1977 in der Demokratischen Republik Kongo und 1979 im Sudan – liess dann aber 15 Jahre lang nichts mehr von sich hören.

…wird zum Flächenbrand…

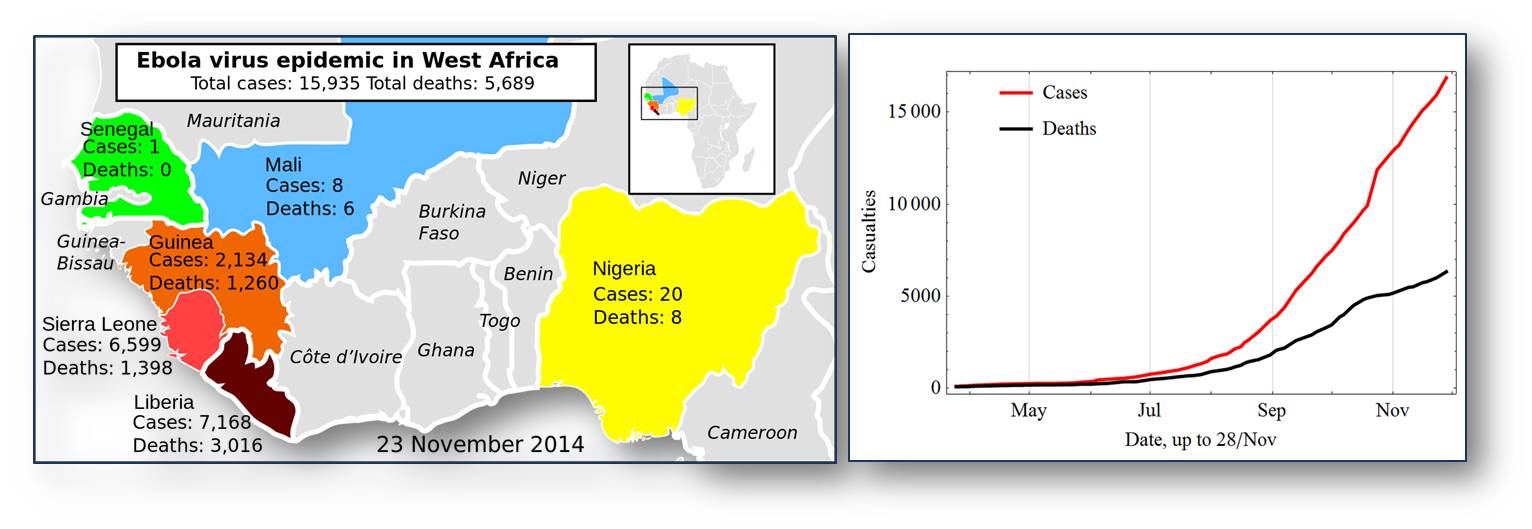

Als es 1994 wieder auftauchte, forderte es zum ersten Mal auch in Westafrika menschliche Opfer. Dort brach dann Ende 2013 in Guinea, Nigeria, Sierra Leone und Liberia die bisher verheerendste Ebola Epidemie aus, die bis jetzt mindestens 10‘000 Erkrankte und 5‘000 Tote gefordert hat. Obwohl Nigeria die Epidemie angeblich eindämmen konnte, wütet sie in den benachbarten Ländern immer noch außer Kontrolle, so dass die die Todesfälle noch dramatisch zunehmen dürften (Abbildung 2).  Abbildung 2. Ebolavirus-Epidemie in Westafrika 2014 betroffene Länder und Zahl der infizierten Personen bzw. Zahl der Todesfälle (inkl. Verdachtsfälle) Quelle: Wikipedia (links:Mikael Häggström, updated by Brian Groen; rechts: Leopoldo Marti R.)

Abbildung 2. Ebolavirus-Epidemie in Westafrika 2014 betroffene Länder und Zahl der infizierten Personen bzw. Zahl der Todesfälle (inkl. Verdachtsfälle) Quelle: Wikipedia (links:Mikael Häggström, updated by Brian Groen; rechts: Leopoldo Marti R.)

Dieser Flächenbrand wurde dadurch geschürt, dass einige der betroffenen Länder grausame Bürgerkriege hinter sich hatten, welche die öffentliche Infrastruktur zerstört und viele Ärzte vertrieben hatten. Schlecht ausgerüstete Spitäler, die wichtige Hygieneregeln missachteten, hatten die Verbreitung von Ebola und anderen Seuchen in Afrika und anderen Schwellenländern schon seit jeher begünstigt; diesmal war ihre todbringende Rolle besonders schwerwiegend, weil die Seuche im dicht besiedelten Grenzgebiet zwischen den betroffenen Ländern ausbrach.

Strenge Sicherheitsvorkehrungen wie die sofortige Isolierung der Erkrankten und ihrer Familienmitglieder sowie schnelle Identifizierung aller möglichen Kontaktpersonen sind immer noch unser wirksamster Schutz gegen diese Krankheit, die durch direkten Körperkontakt oder Körperflüssigkeiten übertragen wird. Deswegen könnten wir sie in Europa oder Nordamerika wahrscheinlich schnell unter Kontrolle bringen.

…mit hoher Letalität

Wir kennen vom Ebola Virus fünf Varianten, von denen vier für Menschen tödlich sein können. Die derzeit grassierende „Zaïre“ Variante ist die gefährlichste: sie tötet zwischen 50 und 90 % aller infizierten Menschen. In den ersten 8-10 Tagen bewirkt sie lediglich grippeähnliche Symptome wie Fieber, Schüttelfrost und Muskelschmerzen, doch dann folgen Übelkeit, Durchfall, innere Blutungen und schliesslich ein allgemeines Organversagen, wobei unsere Ärzte sich auf Symptombekämpfung wie Fiebersenkung und Flüssigkeits- und Salzzufuhr beschränken müssen.

Wir haben heute noch keine wirksamen Waffen, um uns gegen dieses tödliche Virus zu wehren.

Viren sind keine Lebewesen, sondern wandernde Gene, die sich zu ihrem Schutz mit einer Membran oder einer Eiweiß-Schicht umhüllen. Um sich zu vermehren, dringen sie in lebende Zellen ein und missbrauchen deren Infrastruktur für die eigene Fortpflanzung. Im Gegensatz zu Bakterien besitzen Viren weder eigene Stoffwechselprozesse noch komplexe Zellwände, an denen wir sie mit unseren Antibiotika treffen könnten.

Die wenigen Medikamente gegen Viren im Köcher unserer Ärzte blockieren die Vermehrung der Virus-Erbsubstanz oder den Stoffwechsel infizierter Zellen, sind jedoch gegen das Ebola-Virus unwirksam. Zudem gelingt es Ebola, unser Immunsystem zu überlisten, so dass es infizierte Zellen nicht mehr verlässlich erkennt und abtötet, bevor das Virus sich im Körper ausbreiten kann. Wer jedoch eine Ebola-Infektion überlebt, entwickelt Antikörper, die nicht nur vor einer Neuinfektion schützen, sondern bei Verabreichung an Ebola-Kranke auch diesen das Leben retten können.

Antikörper gegen Ebola-Proteine - ZMapp

Blutserum oder gereinigte Antikörper von Ebola-Überlebenden sind also wirksame Ebola-Medikamente, die allerdings nur in relativ geringen Mengen verfügbar und deshalb nicht großflächig einsetzbar sind.

Die Übertragung von Blutserum oder Blutproteinen zwischen Menschen birgt zudem stets Risiken. Das Medikament Zmapp, das sich noch in Entwicklung befindet, würde diese Probleme vermeiden. Forscher aus Kanada und den USA entwickelten es in einem langwierigen Verfahren, in dem sie zunächst einige Proteine aus dem Ebola-Virus reinigten, sie Mäusen eingespritzten und dann die gegen diese Proteine gebildeten Maus-Antikörper reinigten. In einem zweiten Schritt isolierten sie aus den immunisierten Mäusen die Gene für diese Antikörper und veränderten sie so, dass sie menschlichen Antikörper-Genen möglichst ähnlich waren. Schließlich schleusten sie diese „vermenschlichten“ Antikörper-Gene in Tabakpflanzen ein, welche die Antikörper innerhalb weniger Wochen in großer Menge produzierten.

Zmapp ist eine Mischung dreier Antikörper, die sich spezifisch an das Ebola-Virus binden und es unschädlich machen. Ob es Ebola-Kranke verlässlich heilen kann ist jedoch noch ungewiss. Für Makaken-Affen ist dies jedoch bereits bewiesen, so dass die amerikanischen Gesundheitsbehörden vor kurzem den Einsatz von Zmapp an menschlichen Patienten auf vorläufiger Basis gestatteten.

Selbst wenn Zmapp alle Hoffnungen erfüllen sollte, wäre es jedoch zu teuer und im menschlichen Körper zu instabil, um ganze Bevölkerungen langfristig vor dem Virus zu schützen.

Impfungen gegen Ebola

Dafür braucht es aktive Immunisierungen - die viel debattierten „Impfungen“. Bei diesen werden gesunden Menschen inaktivierte Viren oder gereinigte Virusproteine verabreicht, die dann innerhalb von Wochen oder Monaten die Bildung spezifischer Antikörper gegen das jeweilige Virus auslösen und so über Jahre oder sogar Jahrzehnte vor einer Infektion schützen.

Solche vorausschauenden Immunisierungen haben Grippe, Polio und Masern in reichen Ländern wirksam eingedämmt und die gefürchteten Pocken weltweit ausgerottet. Bei einem unerwarteten Seuchenausbruch oder der plötzlichen Mutation eines gefährlichen Virus entfalten Impfungen ihre Wirkung allerdings zu langsam. Die flächendeckende Schutzwirkung von Impfungen wird auch dadurch beeinträchtigt, dass viele Menschen Schutzimpfungen aus irrationalen Gründen ablehnen oder gar bekämpfen.

Derzeit befinden sich mehrere Impfstoffe gegen Ebola im Entwicklungsstadium, wobei eine ursprünglich in Basel ansässige Biotech-Firma an vorderster Front beteiligt ist. Der von ihr entwickelte Impfstoff besteht aus einem für Menschen harmlosen Schimpansen-Virus, dem die Gene zweier Ebola-Proteine eingepflanzt wurden. Dringt dieses modifizierte Trägervirus in menschliche Zellen ein, bewirkt es in diesen die Bildung der beiden Virusproteine, die dann im Körper die Bildung von spezifischen Antikörpern gegen das Ebola-Virus auslösen. Das Rennen um wirksame und billige Impfstoffe gegen Ebola ist in vollem Gange, so dass wir wohl schon innerhalb der nächsten Jahre imstande sein werden, die Bevölkerungen in den gefährdeten Regionen Afrikas vor weiteren großflächigen Ebola-Katastrophen zu schützen.

Die Mikroben haben das letzte Wort

Die erfolgreiche Ausrottung des Pocken-Virus darf jedoch nicht darüber hinwegtäuschen, dass wir den Krieg gegen krankheitserregende Viren und Bakterien nie endgültig gewinnen werden. Schon Louis Pasteur sagte „Die Mikroben werden das letzte Wort haben.“ Bakterien und vor allem Viren verändern ihr Erbgut und damit auch ihre Eigenschaften viel schneller als wir neue Medikamente entwickeln können. Dies gilt umso mehr, als unsere Gesellschaft der Bekämpfung von Seuchen, so wie allen anderen langfristigen Zielen, viel zu wenig Beachtung schenkt. Das „Institut für Allergie und Infektionskrankheiten“ im US Bundesstaat Washington, DC, ist weltweit die größte Organisation zur Seuchenbekämpfung, doch ihr Jahresbudget von etwa fünf Milliarden Dollar ist nur etwa halb so groß wie der Betrag, den die Menschheit jedes Jahr für Kaugummi ausgibt.

Und Impfgegner gefährden mit ihrer Irrationalität sich selbst und ihre Mitbürger. ohne sich schuldig zu fühlen. „Dummheit ist nicht verantwortlich, denn ihre Krankheit ist, dass Verantwortung an ihr nicht haftet.“ Die deutsche Schriftstellerin Bettina von Arnim hat es bereits 1852 gewusst.

Weiterführende Links

Strategien gegen Ebola 16.11.2014

Im Gespräch mit der DW: Walter Lindner, Ebola-Beauftragter der Bundesregierung Deutschland

http://www.dw.de/strategien-gegen-ebola/av-18047359 12:07min

Der Ebola Virus

Natgeodocu, 07.10.2014

https://www.youtube.com/watch?v=OnYWDe7Hvq4 1:11:29

Der Kampf gegen Lungenentzündung

Der Kampf gegen LungenentzündungFr, 21.11.2014 - 08:35 — Bill and Melinda Gates Foundation

![]()

Lungenentzündung ist die Haupttodesursache bei Kindern unter fünf Jahren, wobei 99 % aller Todesfälle in Entwicklungsländern verzeichnet werden. Die Bill & Melinda Gates Foundation möchte in Zusammenarbeit mit Partnern (Pharmakonzernen, Regierungen, NGO’s, der Weltbank und globalen Gesundheitsorganisationen) die Entwicklung und Bereitstellung von Impfstoffen für Lungenentzündung verbessern und die Anwendung von Antibiotikatherapien und Diagnosetests ausweiten. Der folgende Artikel wurde mit freundlicher Zustimmung der Gates Foundation der Website der Stiftung* entnommen.

Lungenentzündung ist die Haupttodesursache bei Kindern unter fünf Jahren, wobei 99 % aller Todesfälle in Entwicklungsländern verzeichnet werden. Die Bill & Melinda Gates Foundation möchte in Zusammenarbeit mit Partnern (Pharmakonzernen, Regierungen, NGO’s, der Weltbank und globalen Gesundheitsorganisationen) die Entwicklung und Bereitstellung von Impfstoffen für Lungenentzündung verbessern und die Anwendung von Antibiotikatherapien und Diagnosetests ausweiten. Der folgende Artikel wurde mit freundlicher Zustimmung der Gates Foundation der Website der Stiftung* entnommen.

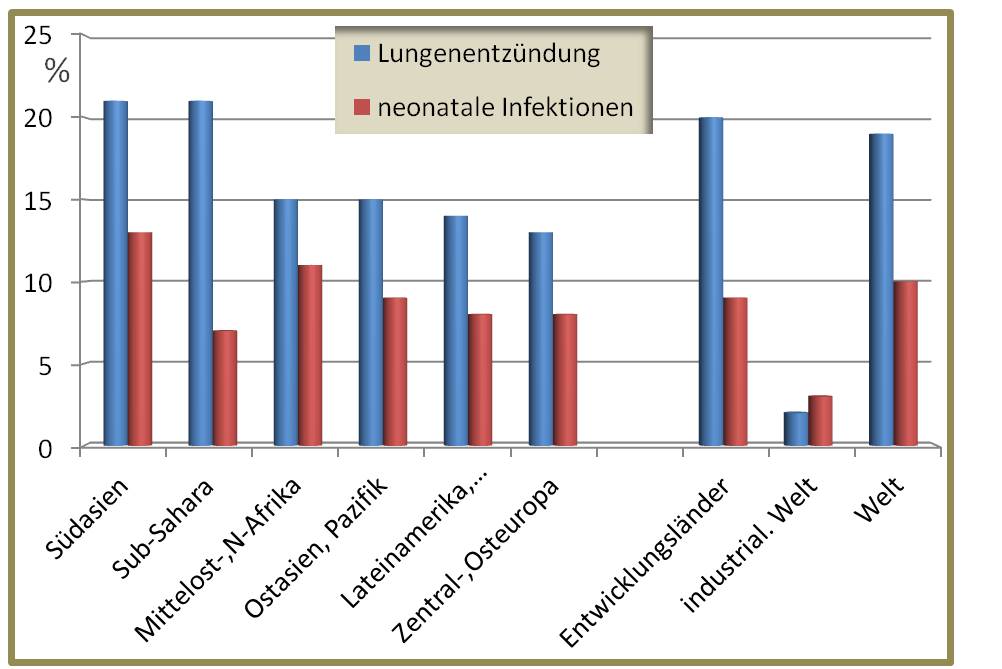

Obwohl die Zahl der Todesfälle bei Kindern in den letzten 20 Jahren von 12,6 Millionen auf 6,6 Millionen zurückgegangen ist, bleiben Lungenentzündungen weiterhin weltweit die Haupttodesursache bei Kindern unter fünf Jahren. Trotz verfügbarer Maßnahmen starben 2011 1,3 Millionen Kinder an den Folgen einer Lungenentzündung. Das sind 18 % aller kindlichen Todesfälle. Fast alle Todesfälle waren in Entwicklungsländern zu beklagen, insbesondere in den afrikanischen Staaten südlich der Sahara und in Südasien.

Lungenentzündungen sind weltweit die Haupttodesursache von Kindern unter fünf Jahren. Neonatale Infektionen: hauptsächlich Lungenentzündungen und Sepsis; Angaben in % der Todesfälle. (Zahlen stammenvon UNICEF/WHO, Pneumonia: The forgotten killer of children, 2006. Abbildung von der Redaktion eingefügt)

Lungenentzündungen sind weltweit die Haupttodesursache von Kindern unter fünf Jahren. Neonatale Infektionen: hauptsächlich Lungenentzündungen und Sepsis; Angaben in % der Todesfälle. (Zahlen stammenvon UNICEF/WHO, Pneumonia: The forgotten killer of children, 2006. Abbildung von der Redaktion eingefügt)

Lungenentzündung ist eine durch verschiedene Viren und Bakterien ausgelöste Infektion und es sind mehrere Maßnahmen nötig, um die Kindersterblichkeit infolge dieser Krankheit zu senken. Für die Erreger Streptococcus pneumoniae (Pneumokokken) und Haemophilus influenzae Typ b (Hib), die häufigsten bakteriellen Erreger nach den ersten Lebensmonaten, gibt es Impfungen. Einige virale und bakterielle Erreger führen bei Kleinkindern unverhältnismäßig zum Tod bevor sie geimpft werden können.

Ein tödlicher Krankheitsverlauf kann bei Kindern mithilfe von Impfstoffen, Diagnosetests und Therapien verhindert werden, aber in den Entwicklungsländern stellen die Verfügbarkeit, der Zugang und die Kosten weiterhin Probleme dar. Schätzungen zufolge ist fast die Hälfte aller Kindestode infolge einer Lungenentzündung auf eine mangelhafte bzw. späte Diagnose und Therapie zurückzuführen. In Ländern mit beschränkten Ressourcen können Unterernährung, HIV-Infektionen und Luftverschmutzung das Risiko für Kinder, an einer Lungenentzündung zu erkranken, erhöhen.

Die Chance

Das weltweite Gesundheitswesen verfügt über die entsprechenden Hilfsmittel und entwickelt neue, um Kinder in Entwicklungsländern besser vor Lungenentzündung zu schützen.

Impfstoffe haben bereits dazu beigetragen, Lungenentzündungen bei Kindern wesentlich zu reduzieren Wir benötigen jedoch eine bessere Durchimpfungsrate und erschwingliche Impfstoffe für jene Länder, die besonders unter der Krankheit leiden, wie Indien und Nigeria. Wenn Frauen während der Schwangerschaft geimpft werden, können Sie die Antikörper an das Baby weitergeben und es schützen. Die Impfung von schwangeren Frauen muss allerdings noch ausgeweitet werden. Derzeit werden schwangere Frauen nur gegen Tetanus geimpft. Vor Kurzem hat die Weltgesundheitsorganisation (WHO) im Rahmen seiner Strategie, Grippetodesfälle zu vermeiden, die Impfung schwangerer Frauen gegen Grippe empfohlen. Die frühe Behandlung ist ein weiterer wichtiger Faktor. Bei einer rechtzeitigen Diagnose kann Lungenentzündung bei Kindern mithilfe einer Antibiotikatherapie über einen Zeitraum von drei Tagen für nur 21 bis 42 US-Cents behandelt werden.

Glücklicherweise steigt das Bewusstsein dafür, dass es sich bei Lungenentzündung um ein weltweites Gesundheitsproblem handelt. Im Jahr 2013 riefen die WHO und UNICEF den Global Action Plan for Pneumonia and Diarrhoea (GAPPD) ins Leben, um die Krankheit zu bekämpfen. Der GAPPD fordert den Einsatz bewährter Maßnahmen wie Impfungen gegen Masern, Keuchhusten, Pneumokokken und Haemophilus influenzae Typ b (Hib), ausschließliches Stillen bis zum sechsten Lebensmonat und eine verbesserte Führung der Einzelfälle in den Gemeinden.

Unsere Strategie

Die Strategie für Lungenentzündung der Bill & Melinda Gates Foundation reflektiert weitgehend den GAPPD-Ansatz „Protect, Prevent, Treat (Schützen, Vorbeugen, Behandeln)“. Unser Schwerpunkt liegt auf den häufigsten Ursachen von Lungenentzündung bei Kindern, d. h. Pneumokokken, Influenza und RSV und wir setzen auch unser langjähriges Engagement für Impfstoffe gegen Meningokokken fort. Diese Bakterien sind zwar nicht die Hauptursache für Lungenentzündung, können aber Meningitisepidemien auslösen. Außerdem entwickeln wir derzeit eine Plattform für die Impfung von Müttern, um Mütter und Kinder vor Erregern zu schützen, die vor allem bei Neugeborenen unverhältnismässig oft zum Tod führen können. Dazu gehören RSV, Influenza, Keuchhusten, Tetanus und Streptokokken der Gruppe A.

In einem Krankenhaus in Nairobi, Kenia, bereitet eine Krankenschwester eine Impfung gegen Pneumokokken vor.

In einem Krankenhaus in Nairobi, Kenia, bereitet eine Krankenschwester eine Impfung gegen Pneumokokken vor.

Unser wichtigster Partner in den Bemühungen um einen breiteren Zugang zu Impfstoffen gegen Pneumokokken ist die GAVI Alliance, eine öffentlich-private Partnerschaft, die Impfstoffe für Kinder in den ärmsten Ländern der Welt finanziert. Durch Impfungen gegen Hib und Pneumokokken können in diesen Ländern das Leben von 2,9 Millionen Kindern gerettet und 52 Millionen neue Fälle von Lungenentzündung vermieden werden.

Unser Hauptanliegen ist die Förderung einer umfassenden Bereitstellung von aktuell verfügbaren Impfstoffen gegen Pneumokokken und Meningokokken sowie die Entwicklung neuer Impfstoffe für verbesserten Impfschutz sowie verbesserte Wirksamkeit, Sicherheit und Kosteneffizienz.

Impfstoffe schützen aber nicht gegen alle Fälle von Lungenentzündung . Daher setzen wir uns auch für einen verbesserten Therapiezugang in öffentlichen und privaten Gesundheitssystemen ein. Besonders in Ländern, die bei der Einführung von Impfstoffen im Rückstand sind, ist ein verbesserter Therapiezugang von entscheidender Bedeutung, wenn es um die Rettung von Menschenleben geht. Dazu gehören Interventionen an mehreren Punkten während der Behandlung, wie die Menschen davon zu überzeugen, medizinische Hilfe in Anspruch zu nehmen und informelle Dienstleistungsanbieter bei der Behandlung zu unterstützen.

Weitere Prioritäten sind die Verbesserung der krankheitsbezogenen Datenerfassung über Lungenentzündung, die Erhöhung des internationalen Spendenaufkommens und die Untersuchung der Zusammenhänge zwischen Lungenentzündung und Luftverschmutzung in geschlossenen Räumen.

Unsere Strategie wird durch die Bemühungen verschiedener anderer Stiftungsprogramme im Bereich der Impfstoffbereitstellung, Ernährung, Gesundheit von Müttern, Neugeborenen und Kindern sowie in Bezug auf Darm- und Durchfallerkrankungen ergänzt.

Fokusbereiche

Wir konzentrieren uns bei unserer Arbeit auf sieben vorrangige Initiativen: Pneumokokken, Meningokokken, Diagnose und Therapie, strategische Informationen und Interessengruppen, RSV, Influenza und Risikofaktoren. Obwohl Menschen aller Altersgruppen an Lungenentzündung erkranken, konzentrieren wir unsere Arbeit auf Kinder unter fünf Jahren

Pneumokokken

Pneumokokken sind die Hauptursache für Lungenentzündung und verantwortlich für 40 % aller Todesfälle bei Kindern unter fünf Jahren. Wir wollen einen breiteren Zugang zu den zwei kommerziell erhältlichen Pneumokokken-Konjugatimpfstoffen schaffen und gleichzeitig die Entwicklung, regulatorische Genehmigung und Bereitstellung neuer und verbesserter Impfstoffe fördern.

Gekühlte Lagerung eines Impfstoffs gegen Pneumokokken in Nairobi, Kenia.

Gekühlte Lagerung eines Impfstoffs gegen Pneumokokken in Nairobi, Kenia.

Wir haben gemeinsam mit der GAVI Alliance das Advance Market Commitment for Pneumococcal Vaccines eingeführt, ein innovativer Finanzierungsmechanismus zur beschleunigten Zulassung von für Entwicklungsländer bestimmten Pneumokokken-Impfstoffen in der Endphase ihrer Entwicklung und Unterstützung der Herstellung. Um den Preis dieser teuren Impfstoffe zu senken, insbesondere in Gebieten, in denen viele Menschen an Lungenentzündung erkranken, arbeiten wir mit PATH und dem Serum Institute of India an der Entwicklung eines preisgünstigen Pneumokokken-Konjugatimpfstoffs.

Meningokokken

Um die ansteckende Meningitis A in Afrika auszurotten, fördern wir das Meningitis Vaccine Project, eine Zusammenarbeit von PATH, WHO, den Gesundheitsministern afrikanischer Länder und dem Serum Institute of India. Im Rahmen dieses Projekts wurde der erschwingliche Impfstoff MenAfriVac entwickelt. Der speziell für Afrika entwickelte Impfstoff schützt anhaltend gegen die lebensbedrohliche, von Meningokokkenerregern ausgelöste Meningitis, eine bakterielle Entzündung der Gehirn- und Rückenmarksflüssigkeit.

Einführung des Impfstoffs MenAfriVac in Burkina Faso im Jahr 2010. (Foto © PATH / Gabe Bienczycki)

Einführung des Impfstoffs MenAfriVac in Burkina Faso im Jahr 2010. (Foto © PATH / Gabe Bienczycki)

MenAfriVac wurde erstmals 2010 in Burkina Faso eingesetzt. Seitdem haben mehr als 100 Millionen Menschen in Afrika südlich der Sahara den Impfstoff erhalten und erste Daten zeigen, dass er gegen den Ausbruch von Menikokken A wirksam ist. Die Menikokken-A-Bakterie wurde in fast allen geimpften Bevölkerungsgruppen ausgerottet. Mit unserer Strategie wollen wir sichergehen, dass auch Kleinkinder MenAfriVac erhalten und der Impfstoff in das Routineimpfprogramm aufgenommen wird. Wir setzen uns für weitere Forschungen und Überwachung der Entwicklung der Krankheit ein. Gegebenenfalls werden über diesen neuen Impfstoff hinaus noch weitere Maßnahmen benötigt.

Diagnose und Behandlung

Es ist dringend notwendig, Kinder mit schweren Atemwegserkrankungen angemessen medizinisch zu versorgen. Zahlreiche Kinder sterben, weil ihre Familie die Symptome nicht erkennen bzw. weil sie nicht frühzeitig ärztlich behandelt werden. Kinder, die zu einem Arzt gebracht werden, werden möglicherweise falsch diagnostiziert oder nicht richtig behandelt. Wenn die Krankheit bereits so weit fortgeschritten ist, dass besondere Kenntnisse oder bestimmte Geräte, wie zum Beispiel zur Sauerstoffversorgung notwendig werden, stehen diese eventuell nicht zur Verfügung oder sind nicht erreichbar.

Wir arbeiten eng mit anderen Stiftungsteams zusammen, um kranken Kindern Zugang zu wirksamen Behandlungsmöglichkeiten zu geben und konzentrieren uns dabei besonders auf Nigeria, den nördlichen Teil Indiens und Burkina Faso. Wir haben uns für diese Länder entschieden, da dort besonders viele Kinder unter Krankheiten leiden, eine große Bereitschaft zur Innovation besteht und wir auf starke Partnerorganisationen zurückgreifen können. Im Rahmen unserer Arbeit vermitteln wir medizinischem Personal die Fähigkeit, Anzeichen und Symptome von Lungenentzündung besser zu erkennen und wir wollen Frauen darin unterstützen, eigenständig medizinische Hilfe und Unterstützung zu fordern. Schließlich fördern wir die Entwicklung von schnellen Diagnosetests für Lungenentzündung und setzen uns für eine Verbesserung des Überweisungssystems für schwer erkrankte Kinder ein. In Ländern, die eine gemeindebasierte Fallführung verwenden, engagieren wir uns für die Nachhaltigkeit dieses Ansatzes und wir wollen die Gesundheitsversorgung durch kleine private Anbieter verbessern.

Strategische Informationen und Fürsprache

Wir investieren in die Erfassung und Auswertung qualitativ hochwertiger Daten zu den Ursachen von Lungenentzündung und ihrer globalen Belastung, die einen direkten Beitrag zur Impfstoffentwicklung, zu besseren Therapien und verbesserter Bereitstellung von Dienstleistungen, zu Innovationen bei Diagnosetests und Behandlungen sowie zu einer genaueren Auswertung der Todesfälle leisten.

Wir wollen auch vermehrt auf de Gefahren von Lungenentzündung für Kinder hinweisen. Zu unseren Prioritäten gehört die Sicherung ausreichender finanzieller Mittel für die wichtigen Impfstoffe und die Unterstützung von Interessengruppen im Bereich kindlicher Gesundheit. Wir fordern von den betroffenen Ländern und auch weltweit ein stärkeres politisches Bekenntnis zu evidenzbasierter Prävention und Behandlung von Lungenentzündung. Wir wollen mehr Finanzierung für Immunisierungsprogramme bekommen, um sicherzustellen, dass Regierungen wichtige Initiativen zur globalen Gesundheit wie z. B. den Global Vaccine Action Plan für die Decade of Vaccines konsequent begleiten.

RSV-Virus

Das RSV ist eine der Hauptursachen für Atemwegsinfektionen bei Kindern, vor allem in den ersten sechs Lebensmonaten. Im Gegensatz zu anderen Ursachen für Lungenentzündung, auf die wir mit unserer Strategie eingehen, gibt es keinen Impfstoff gegen RSV. Wir unterstützen die Entwicklung eines RSV-Impfstoffs für Mütter. Außerdem unterstützen wir eine bessere globale Datenerfassung zu Sterblichkeits- und Erkrankungsraten aufgrund einer RSV-Infektion sowie zu den langfristigen Folgen schwerer RSV-Erkrankungen. Mithilfe dieser Informationen können die potenziellen Auswirkungen und Kosteneffizienz von RSV-Impfstoffkandidaten beurteilt werden, die derzeit in der Entwicklungsphase sind.

Influenza

Es ist unser Ziel, influenzabezogene Daten in Entwicklungsländern zu vervollständigen, und existierende Strategien zur Steigerung der Nachfrage nach Impfungen gegen saisonale Influenza zu bewerten und Schwangeren und Kleinkindern in ressourcenarmen Regionen Zugang zu erschwinglichen und wirksamen Impfstoffen zu geben.

Existierende Influenzaimpfungen sind die Basis unserer Immunisierungsstrategie für Mütter und könnten den Weg für zusätzliche Impfungen für schwangere Frauen ebnen. In Zusammenarbeit mit globalen Partnern wollen wir wissenschaftliche, technische, regulatorische, operationelle und finanzielle Herausforderungen identifizieren und angehen , die sich bei einer Ausweitung der Immunisierung von Schwangeren stellen, die aber schwangere Frauen und deren Babys schützen. Wir unterstützen zudem Forschungsarbeiten, die sich mit den Auswirkungen einer Influenzaimpfung der Mutter auf die Entwicklung des Fötus befassen und arbeiten an der Entwicklung eines verbesserten Influenzaimpfstoffs für Kinder unter 2 Jahren.

Risikofaktoren

Wir wollen nicht nur die Immunisierung gegen Lungenentzündung ausweiten und Therapien verbessern, sondern auch das Risiko von Umweltfaktoren senken. Angemessene Ernährung und Stillen sind Bestandteil der Stiftungsstrategie und tragen wesentlich zur Entwicklung eines starken kindlichen Immunsystems zum Abwehren von Infektionen bei.

Auch die Reduzierung der Luftverschmutzung in geschlossenen Räumen kann das Risiko einer chronischen Lungenentzündung verringern. Wir investieren in Forschungsarbeiten, die den Zusammenhang zwischen Luftverschmutzung in geschlossenen Räumen und kindlicher Lungenentzündung im Hinblick auf eine Dosis-Wirkungsbeziehung untersuchen. Außerdem engagieren wir uns für verbesserte Überwachungstechnologien zur Messung individueller Partikelbelastung und zur Festlegung von Surrogatendpunkten für anschließende klinische Studien. Unsere Arbeit in diesem Bereich wird vorangebracht je mehr wir über die Verbindung zwischen Luftverschmutzung in geschlossenen Räumen und Lungenentzündung wissen.

* http://www.gatesfoundation.org/de/What-We-Do/Global-Health/Pneumonia

Weiterführende Links

World Health Organzation (WHO)

-

Pneumonia: http://www.who.int/topics/pneumococcal_infections/en/

-

The Integrated Global Action Plan for the Prevention and Control of Pneumonia and Diarrhoea (GAPPD), by WHO/UNICEF: http://apps.who.int/iris/bitstream/10665/79200/1/9789241505239_eng.pdf?ua=1

Videos

-

Lungenentzündung, 1:35 min http://www.onmeda.de/video/lungenerkrankungen-11/lungenentz%C3%BCndung-v...

- Pneumonia, 4:44 min (einfaches Englisch) https://www.youtube.com/watch?v=aKduNgfePLU

- Jemen: Neue Impfung gegen Pneumokokken gibt Eltern Hoffnung (Video mit deutschen Untertiteln), 3:09 min https://www.youtube.com/watch?v=3WKcK-obk00

- The story of GAVI: the power of partnership: Video 1:35 min (englisch). https://www.youtube.com/watch?v=i7_f4JchhvQ&list=UUe7zpKgGM4RNBYK0ryXttLQ

Bill and Melinda Gates Foundation im ScienceBlog:

- 29.08.2014: Der Kampf gegen Darm- und Durchfallerkrankungen

- 27.06.2014: Der Kampf gegen Vernachlässigte Infektionskrankheiten

- 09.05.2014: Der Kampf gegen Tuberkulose

- 02.05.2014: Der Kampf gegen Malaria

Hochwässer – eine ökologische Notwendigkeit

Hochwässer – eine ökologische NotwendigkeitFr, 28.11.2014 - 08:52 — Mathias Jungwirth & Severin Hohensinner

![]()

Hochwässer und das mit ihnen verbundene Prozessgeschehen sind natürliche Ereignisse. Aus der Sicht der Ökologie stellen Hochwässer lebensraumerhaltende und damit absolut notwendige „Störungen“ dar. Die langfristige Erhaltung, Entwicklung und Restauration von Fließgewässern setzt daher die Initiierung/Wiederherstellung natürlicher Prozesse voraus.

Hochwässer und das mit ihnen verbundene Prozessgeschehen sind natürliche Ereignisse. Aus der Sicht der Ökologie stellen Hochwässer lebensraumerhaltende und damit absolut notwendige „Störungen“ dar. Die langfristige Erhaltung, Entwicklung und Restauration von Fließgewässern setzt daher die Initiierung/Wiederherstellung natürlicher Prozesse voraus.

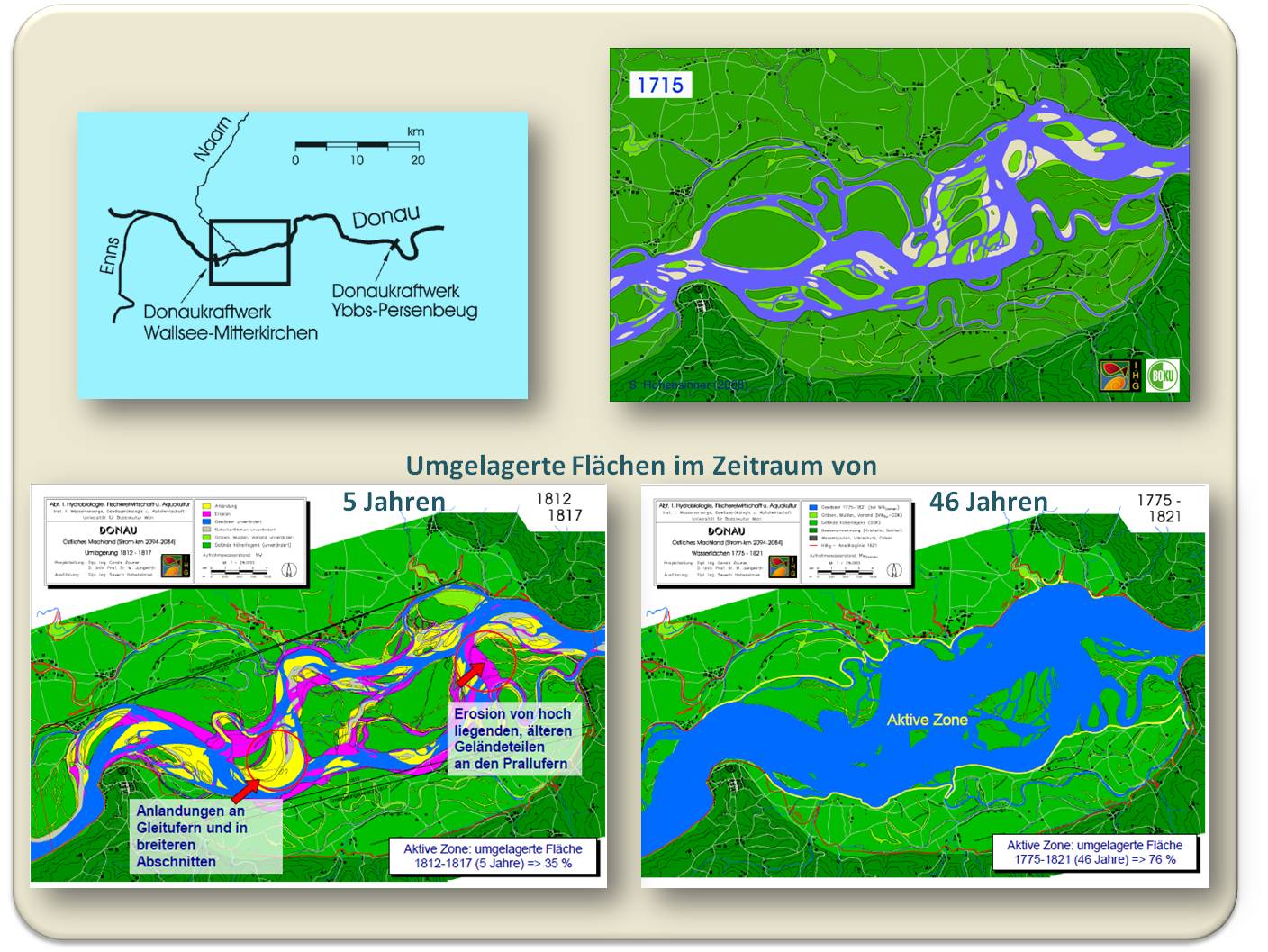

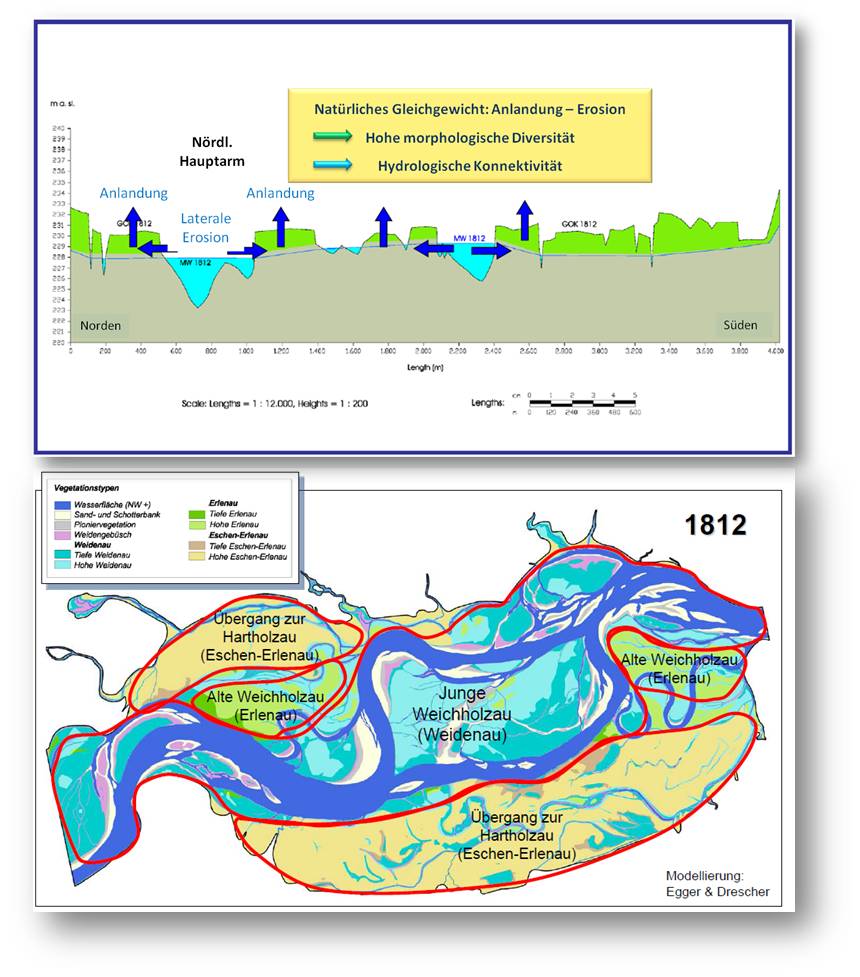

Im vorangegangenen Artikel „Leben im Fluss nach (Extrem-) Hochwässern“ [1] hatten wir bereits dargestellt, wie Hochwässer als wichtige Komponente im Zuge des hydrologischen Geschehens ein dynamisches Gleichgewicht von Erosion, Umlagerung und Sedimentation, und damit stetige Erneuerung und Umgestaltung des Lebensraumes von Flusslandschaften garantieren. Die damit verbundenen Verjüngungs- aber auch Alterungsprozesse sind für die Tier- und Pflanzenwelt von elementarer Bedeutung, da sie eine enorme Vielfalt der Habitatausstattung und damit die hohe Artenvielfalt solcher Lebensräume bewirken.

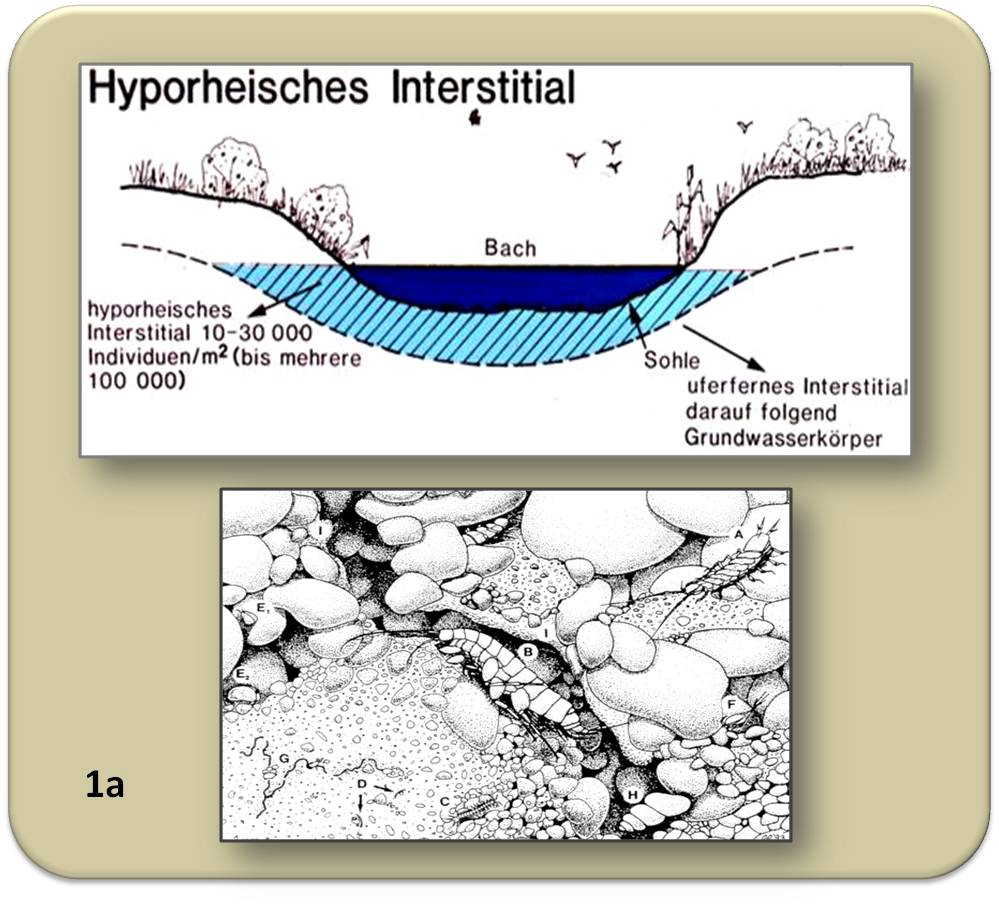

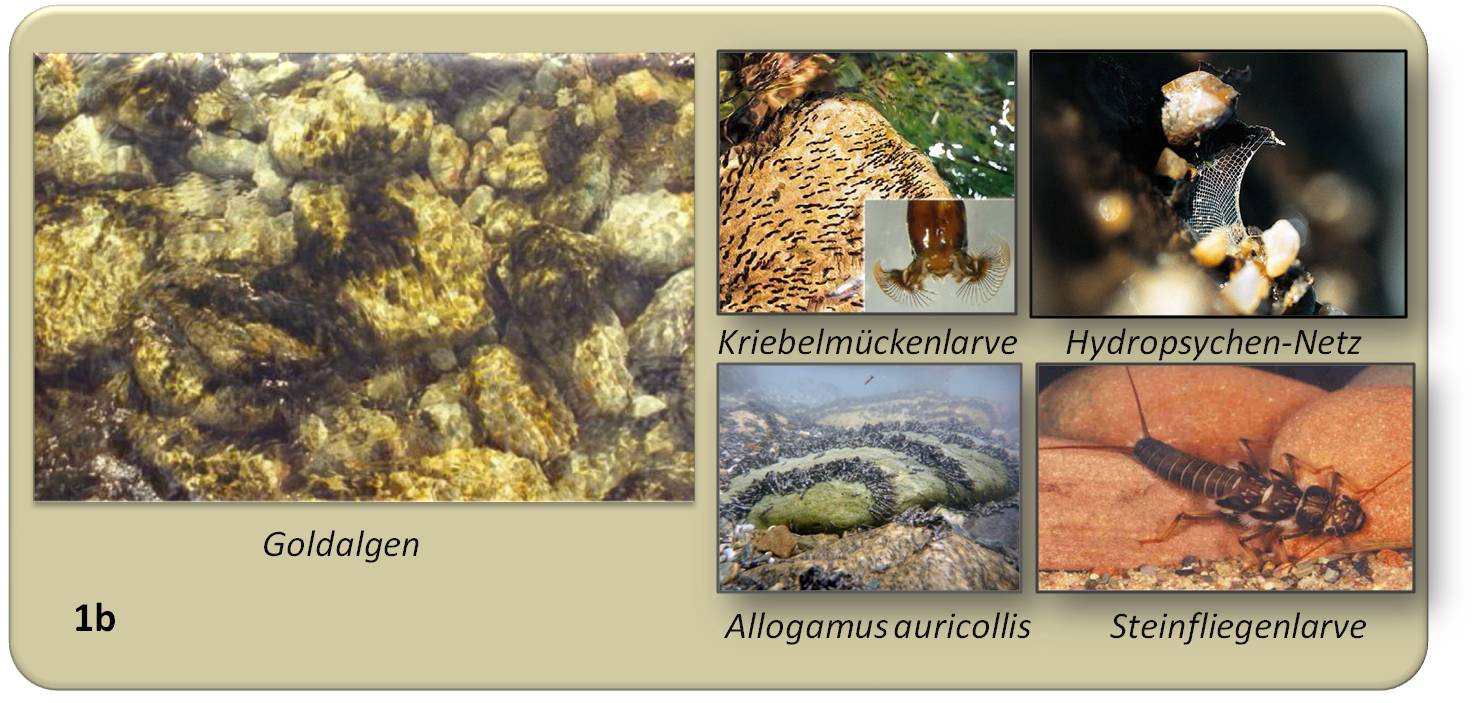

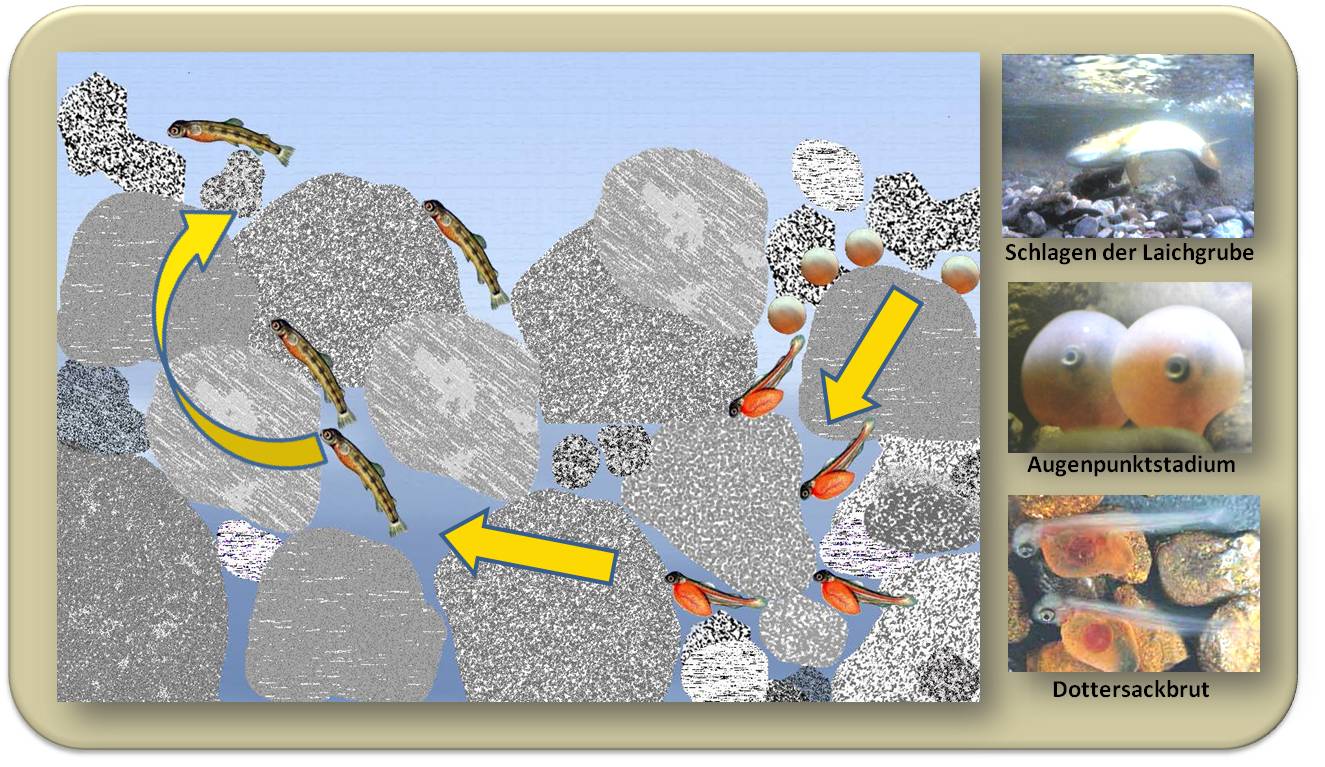

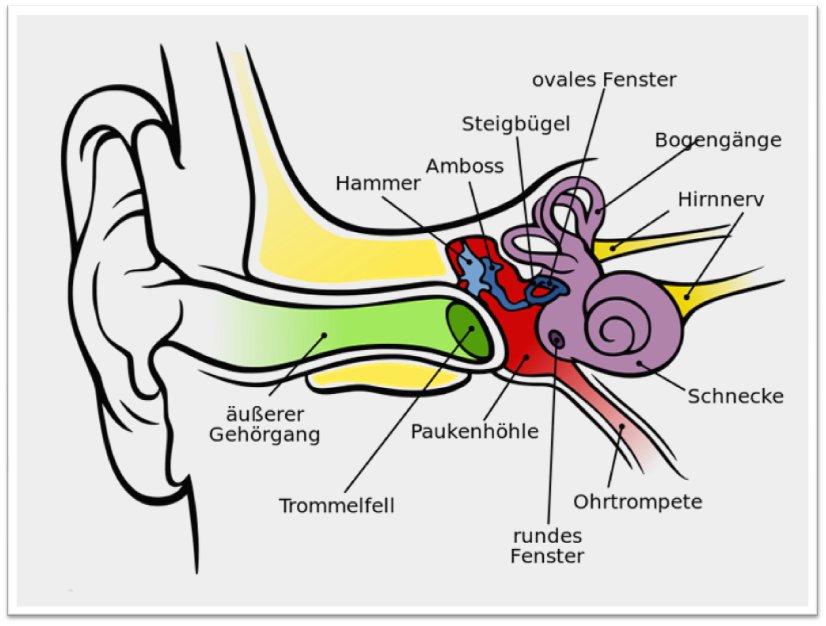

Bettsedimente als Lebensraum

Betrachtet man ein Fließgewässer im Querschnitt, so stellt der Porenraum der aus Kies und Schotter bestehenden Bettsedimente, das sogenannte hyporheische Interstitial, den zentralen Lebensraum dar (Abbildung 1a). Die kleinräumige Morphologie der Bachsohle und die vom Bachwasser durchflossenen Sohlsubstrate werden von Geologie, Gefälle, Abfluss und Art der Feststoffe (Kies, Schotter, Sande etc.) bestimmt. Der Lebensraum der Bettsedimente reicht seitlich vielfach weit über das eigentliche Bachbett bzw. die Ufer hinaus und geht vertikal in den Grundwasserkörper über, der Lebensraum einer typischen Grundwasserfauna ist.

Während an der Oberfläche der Bettsedimente Algen sitzen, die mittels Photosynthese Biomasse produzieren, lebt im lichtlosen Porenraum der Sedimente eine ungeheure Vielfalt an kleinen tierischen Organismen, das sogenannten Makrozoobenthos (MZB). Dies sind vor allem Insektenlarven, Kleinkrebse, Schnecken und Muscheln. Im Durchschnitt finden sich rund 30 000 - 100 000 derartige Organismen unter 1 m2 Sedimentoberfläche (Abbildung 1b). Sehr klein, aber mit einer insgesamt hohen Biomasse und Produktion, sind es zudem Bakterien, Pilze und andere Mikroorganismen, die in Form von Biofilmen jedes Substratkörnchen überziehen. Zusammen mit dem MZB bilden sie den „Bioreaktor“ der Bettsedimente, der die enorme Selbstreinigungskraft von Fließgewässern ausmacht.

Abbildung 1. Querschnitt durch ein Bachbett. a) Der Porenraum der Bettsedimente (das hyporheische Interstitial) ist b) Lebensraum für eine Vielzahl an benthischen Organismen: photosynthetisch aktive Algen an der Oberfläche und repräsentative Vertreter des Makrozoobenthos.