2024

2024 inge Thu, 04.01.2024 - 01:13Gesteigerte Produktion von Elektrofahrzeugen könnte unerwünschte Verschmutzungsschwerpunkte schaffen

Gesteigerte Produktion von Elektrofahrzeugen könnte unerwünschte Verschmutzungsschwerpunkte schaffenSa, 28.12.2024 — IIASA

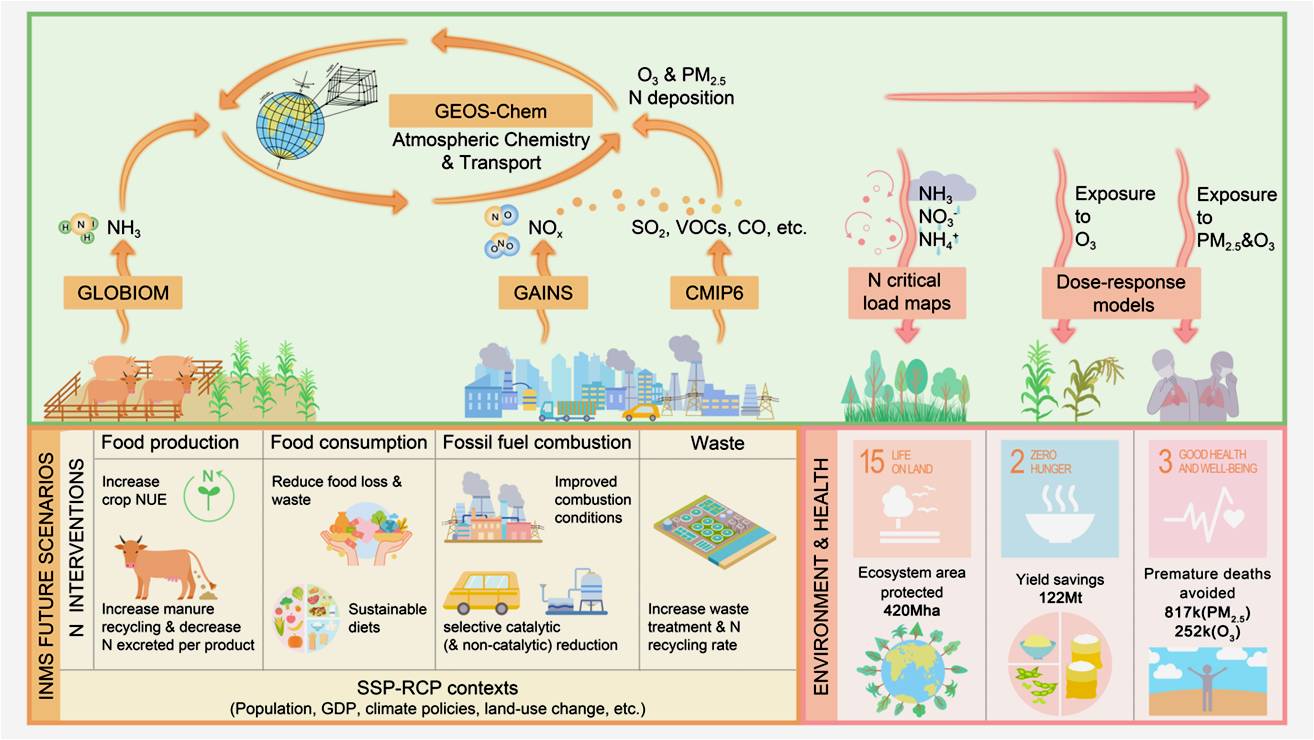

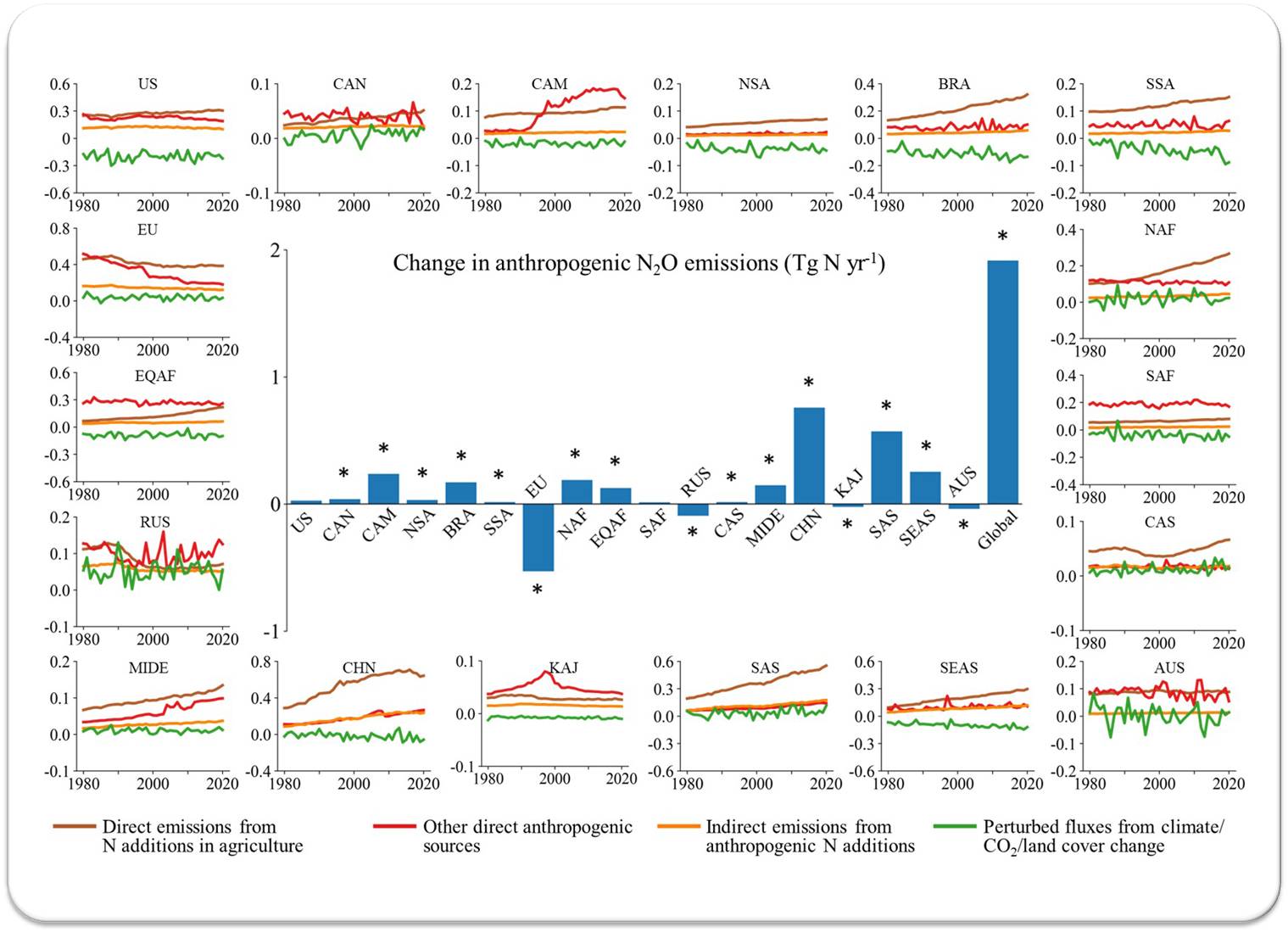

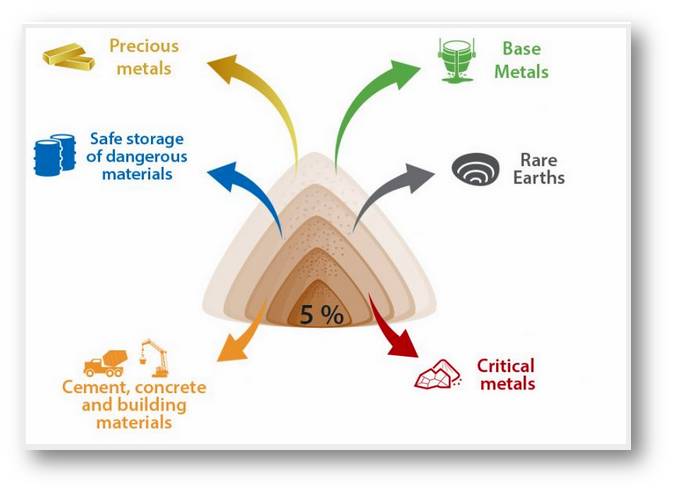

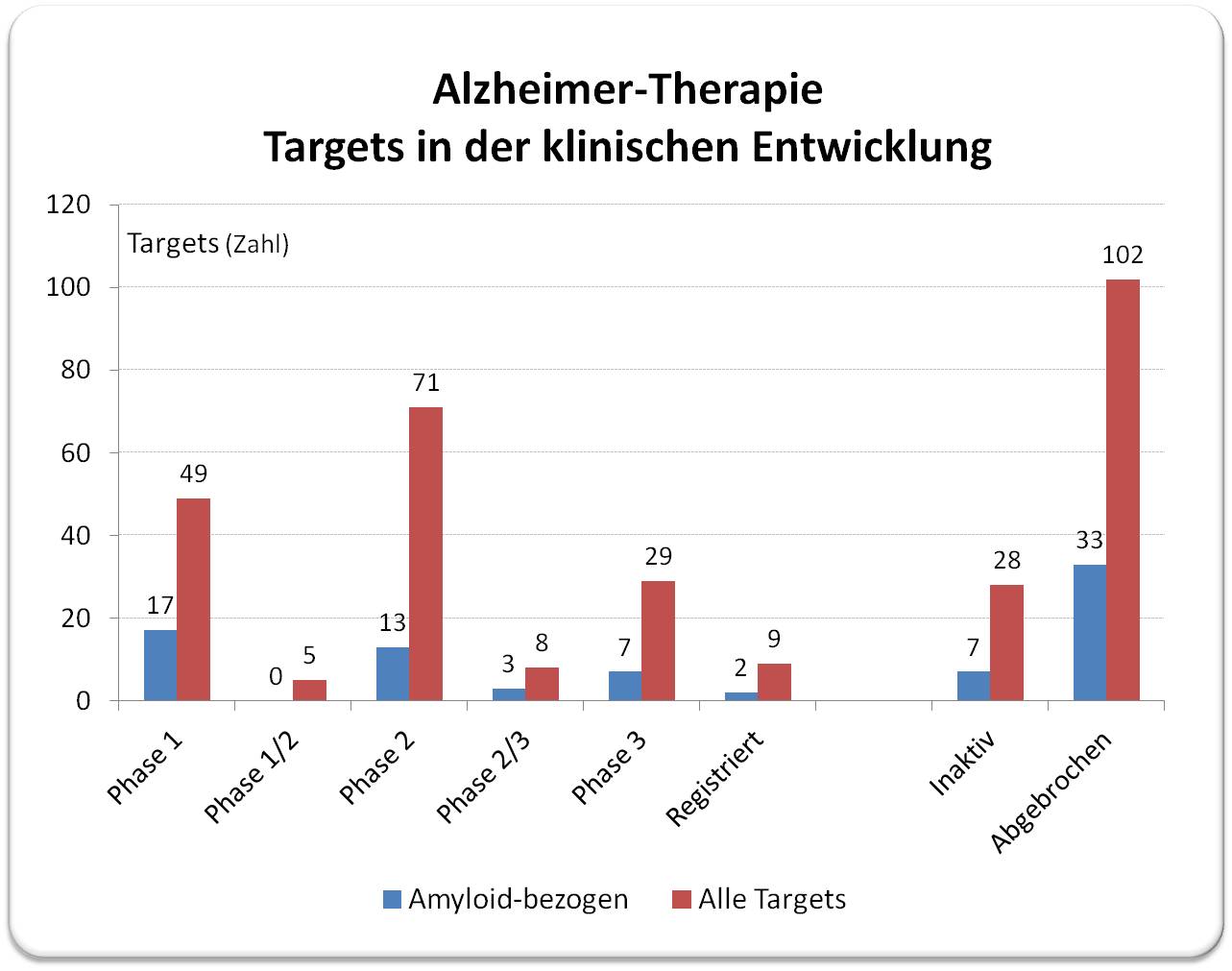

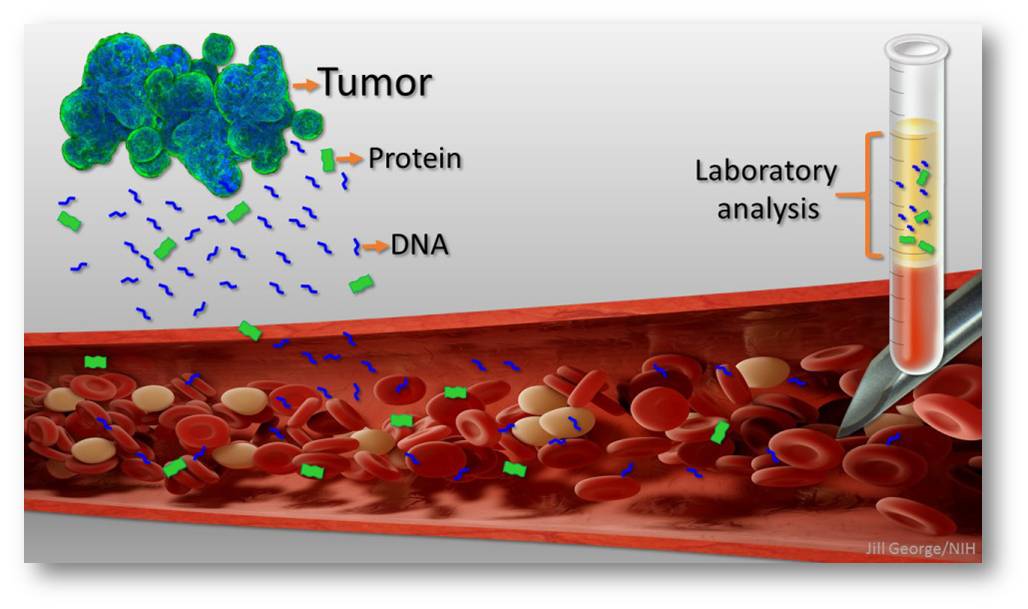

Die Umstellung auf Elektrofahrzeuge ist eine zentrale Strategie zur Reduzierung der Schadstoffemissionen und damit zu einem Grundpfeiler der globalen Energiewende geworden. Ein sehr rascher Anstieg der Produktion von E-Autos kann allerdings aufgrund der emissionsintensiven Erzeugung von kritischen Batteriematerialien - insbesondere auf Nickel- und Kobaltbasis - in der Nähe von Produktionszentren zu Hotspots von Umweltverschmutzung führen. Eine aktuelle Studie der Princeton University und des International Institute of Applied Science Analysis (IIASA) zeigt mögliche derartige Umweltauswirkungen auf China und Indien, zwei der am schnellsten wachsenden Märkte für Elektrofahrzeuge.*

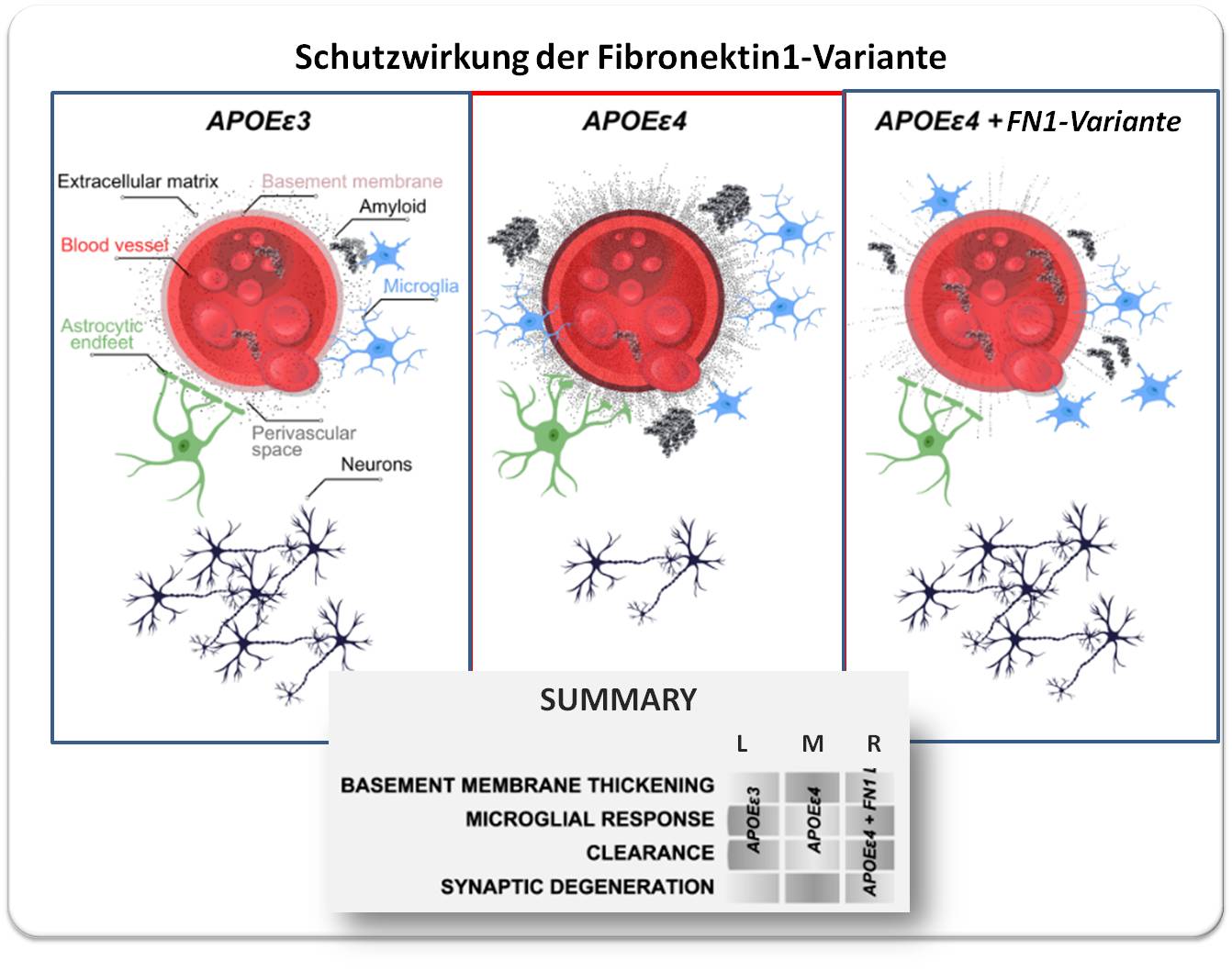

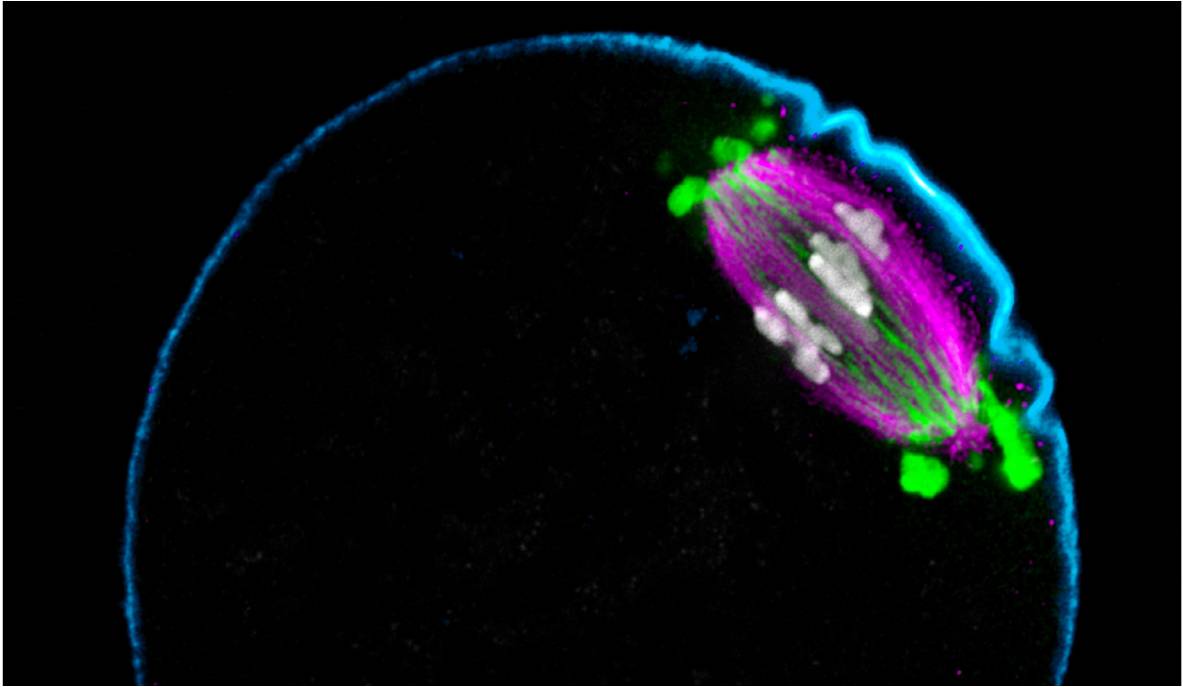

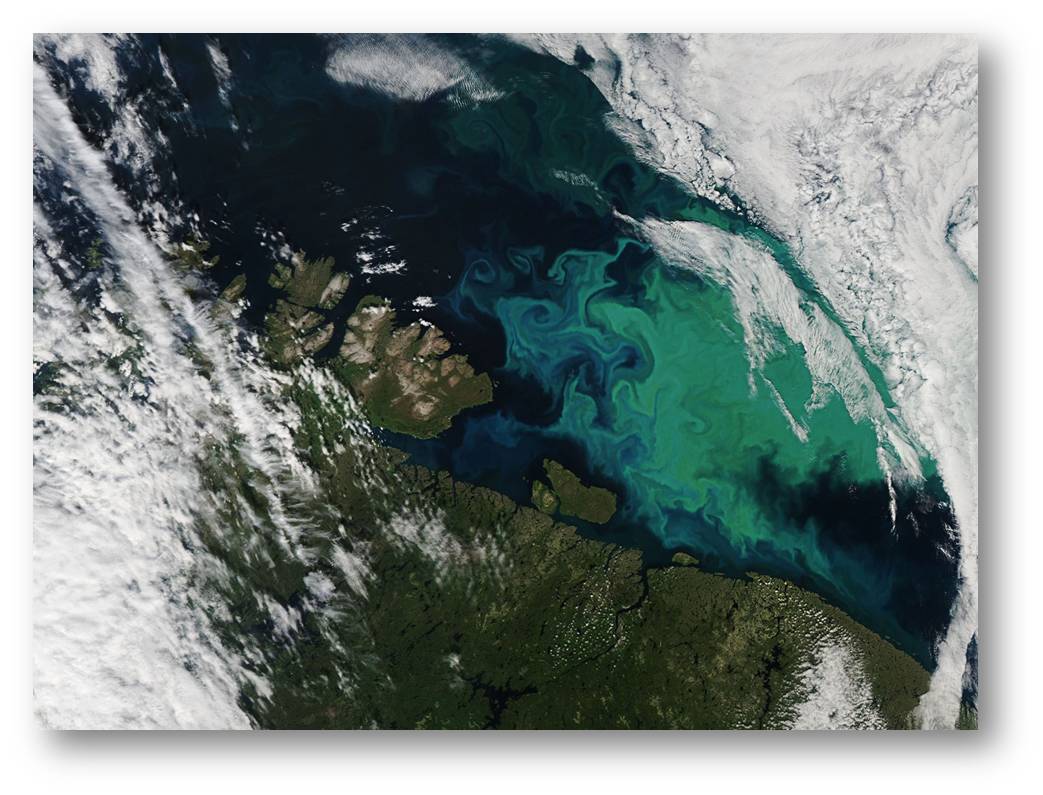

| Abbildung. Hotspots der Erzeugung von emissionsinensiven Batteriematerialien. |

Mit dem Fokus auf Indien und China haben Forscher in der jüngst in der Zeitschrift Environmental Science & Technology veröffentlichten Studie festgestellt, dass dort die nationalen Schwefeldioxidemissionen (SO2) um bis zu 20 % über das derzeitige Niveau ansteigen könnten, sofern die Länder ihre Lieferketten für Elektrofahrzeuge vollständig inländisch gestalten würden [Sharma et al., 2024]. Der überwiegende Teil dieser SO2-Emissionen käme aus der Raffinierung und Produktion von Nickel und Kobalt - wichtigen Mineralien für die heutigen Batterien von Elektrofahrzeugen.

"Viele Diskussionen über Elektrofahrzeuge konzentrieren sich auf die Minimierung der Emissionen aus dem Verkehrs- und Energiesektor", sagt der korrespondierende Autor Wei Peng, Assistenzprofessor für öffentliche und internationale Angelegenheiten sowie für das Andlinger Center for Energy and the Environment an der Princeton University. "Wir zeigen hier aber, dass die Auswirkungen von Elektrofahrzeugen nicht bei den Auspuffemissionen der Fahrzeuge oder bei der Elektrizität enden. Es geht auch um die gesamte Beschaffungskette."

Die Forscher argumentieren, dass die Länder bei der Entwicklung von Dekarbonisierungsplänen strategisch über den Aufbau sauberer Lieferketten nachdenken müssen.

Was die Batterieproduktion betrifft, betonte das Team die Wichtigkeit der Entwicklung und Durchsetzung strenger Luftverschmutzungsnormen, um unbeabsichtigte Folgen der Umstellung auf Elektrofahrzeuge zu vermeiden. Die Forscher haben auch die Entwicklung alternativer Batterien-Chemie vorgeschlagen, um die prozessbedingten SO2-Emissionen bei der Herstellung heutiger Batterien zu vermeiden.

"Wenn man sich tief genug in eine saubere Energietechnologie vertieft, wird man feststellen, dass es Herausforderungen oder Kompromisse gibt", sagt die Erstautorin Anjali Sharma, die die Arbeit als Postdoktorandin in Pengs Gruppe abgeschlossen hat und jetzt Assistenzprofessorin am Zentrum für Klimastudien und am Ashank Desai Centre for Policy Studies am Indian Institute of Technology in Bombay ist. "Die Existenz dieser Kompromisse bedeutet nicht, dass wir die Energiewende stoppen müssen, aber es bedeutet, dass wir proaktiv handeln müssen, um diese Kompromisse so weit wie möglich abzumildern."

Eine Geschichte von zwei Ländern

Sowohl China als auch Indien haben gute Gründe, SO2-Emissionen zu vermeiden: Die Verbindung ist ein Vorläufer von Feinstaub und trägt zu einer Reihe von Herz-Kreislauf- und Atemwegsproblemen bei. Die beiden Länder leiden bereits unter einer hohen Luftverschmutzung. Allein im Jahr 2019 waren rund 1,4 Millionen vorzeitige Todesfälle in China und rund 1,7 Millionen vorzeitige Todesfälle in Indien auf die Feinstaubbelastung zurückzuführen.

Die beiden Länder befinden sich jedoch in unterschiedlichen Entwicklungsstadien für Elektrofahrzeuge. In China ist eine inländische Erzeugungskette für Elektrofahrzeuge der Status quo, während Indien noch im frühen Stadium der Entwicklung von solchen Ketten steckt. Der Vergleich hat den Forschern geholfen, kurzfristige Prioritäten zu identifizieren, während sie an Aufbau und Fortsetzung einer inländischen Lieferkette für Elektrofahrzeuge arbeiten.

"Unsere Ergebnisse deuten darauf hin, dass Indien sich auf die Verringerung der Emissionen des Energiesektors konzentrieren sollte, während China der Verringerung der Emissionen aus der Raffinierung von Batteriematerialien Vorrang einräumen sollte, um die Umweltauswirkungen der Umstellung auf Elektrofahrzeuge abzumildern", bemerkt der Mitautor der Studie, Pallav Purohit, Senior Researcher Scholar in der Pollution Management Research Group des IIASA Energy, Climate, and Environment Program.

In Indien wäre es am einfachsten, sich zunächst auf die Beseitigung der Verschmutzung durch den Energiesektor zu konzentrieren. Dazu müssten strenge Maßnahmen zur Kontrolle der SO2-Verschmutzung in Wärmekraftwerken durchgesetzt werden, wobei ausgereifte Technologien wie die Rauchgasentschwefelung zum Einsatz kämen. In China, wo es bereits strenge Emissionskontrollen für den Energiesektor gibt, muss der Schwerpunkt auf die Verringerung der SO2-Emissionen aus dem Batterieherstellungsprozess verlagert werden, mit dem die Forscher weniger vertraut sind.

Den Forschern zufolge wäre es jedoch ein entscheidender Fehler die Emissionen aus der Batterieherstellung zu ignorieren. In Szenarien, in denen China und Indien ihre Lieferketten vollständig auslagern, trug die Priorisierung eines saubereren Netzes wenig bis gar nicht zur Senkung der SO2-Emissionen bei. Stattdessen konnten nur Szenarien, die sich auf die Säuberung von Batterieherstellungsprozessen konzentrierten, SO2-Verschmutzungs-Hotspots vermeiden.

"Die Menschen gehen im Allgemeinen davon aus, dass der Übergang zu einer umweltfreundlicheren Technologie immer eine Win-Win-Situation ist - es wird Vorteile für das Klima und die Luftqualität geben", so Sharma. "Aber wenn man die Produktion nicht berücksichtigt, kann es sein, dass man zwar die Kohlenstoff- und Stickoxidemissionen senkt, aber die Luftverschmutzung in den Gemeinden in der Nähe der Produktionszentren erhöht."

Menschenzentrierte Ansätze zur Dekarbonisierung

Die Analyse konzentrierte sich zwar auf China und Indien, doch die Forscher argumentieren, dass die Umweltverschmutzung durch die Batterieherstellung mit der zunehmenden Verbreitung von Elektrofahrzeugen zu einem immer größeren globalen Problem werden wird, wenn man nichts dagegen tut. Selbst wenn Länder wie China und Indien die Batterieherstellung auslagerten, würden sie ohne Strategien zur Verringerung der SO2-Emissionen das Problem einfach auf ein anderes Land abwälzen.

"Es ist wichtig, Elektrofahrzeuge aus der Perspektive der globalen Lieferkette zu betrachten", sagt Sharma. "Selbst wenn Indien sich gegen den Aufbau einer inländischen Lieferkette entscheidete und stattdessen die Fahrzeuge aus anderen Ländern importierte, würde die Verschmutzung nicht verschwinden. Sie würde einfach in ein anderes Land verlagert werden."

Neben ihrer politischen Empfehlung für proaktive Luftverschmutzungsnormen, die wahrscheinlich auf nationaler oder subnationaler Ebene erfolgen würden, haben die Forscher auch untersucht, wie eine Änderung der Batteriechemie in Elektrofahrzeugen unerwünschte SO2-Emissionen auf globalerer Ebene vermeiden könnte.

Während die meisten Elektrofahrzeugbatterien heute auf Kobalt und Nickel basieren, könnten mit dem Aufkommen alternativer chemischer Systeme, die Eisen und Phosphat verwenden (so genannte Lithium-Eisenphosphat-Batterien), einige der mit dem Abbau und der Raffinierung von Kobalt und Nickel verbundenen Probleme umgangen werden. Durch den Verzicht auf die beiden Mineralien führten Szenarien mit einem hohen Verbreitungsgrad von Lithium-Phosphat-Batterien zu deutlich weniger SO2-Emissionen bei der Herstellung.

In jedem Fall stellen die Ergebnisse des Teams eine Mahnung dar, bei der Entwicklung von Dekarbonisierungsplänen die Menschen im Auge zu behalten, da selbst die vielversprechendsten Technologien unerwünschte und unbeabsichtigte Folgen haben können.

"Saubere Energietechnologien sind zwar vielversprechend, aber sie haben auch potenzielle Nachteile. Diese sollten uns jedoch nicht davon abhalten, eine nachhaltige Zukunft anzustreben, sondern uns vielmehr dazu motivieren, ihre negativen Auswirkungen abzuschwächen", schließt Koautor Fabian Wagner, Principal Research Scholar in den Forschungsgruppen Pollution Management und Transformative Institutional and Social Solutions des IIASA Energy, Climate, and Environment Program.

Sharma, A., Peng, W., Urpelainen, J., Dai, H., Purohit, P., Wagner, F. (2024). Multisectoral Emission Impacts of Electric Vehicle Transition in China and India. Environmental Science & Technology Vol 58, Issue 44 DOI: 10.1021/acs.est.4c02694

*Der Artikel " Increase in electric vehicles could create unwanted pollution hotspots" ist am 20.Dezember 2024 auf der IIASA-Website erschienen. (https://iiasa.ac.at/news/dec-2024/increase-in-electric-vehicles-could-create-unwanted-pollution-hotspots). Der unter einer cc-by-nc-Lizenz stehende Artikel wurde von der Redaktion möglichst wortgetreu übersetzt. IIASA hat freundlicherweise der Veröffentlichung der von uns übersetzten Inhalte seiner Website und Presseaussendungen in unserem Blog zugestimmt.

Der Themenschwerpunkt:Klima und Klimawandel

im ScienceBlog enthält bereits mehr als 50 Artikel, die sich vor allem mit Klimamodellen und den Folgen des Klimawandels bis zu Strategien seiner Eindämmung befassen.

Eine erste weltweite Karte der Klimagefahrenzonen

Eine erste weltweite Karte der KlimagefahrenzonenDo, 28.11.2024 — IIASA

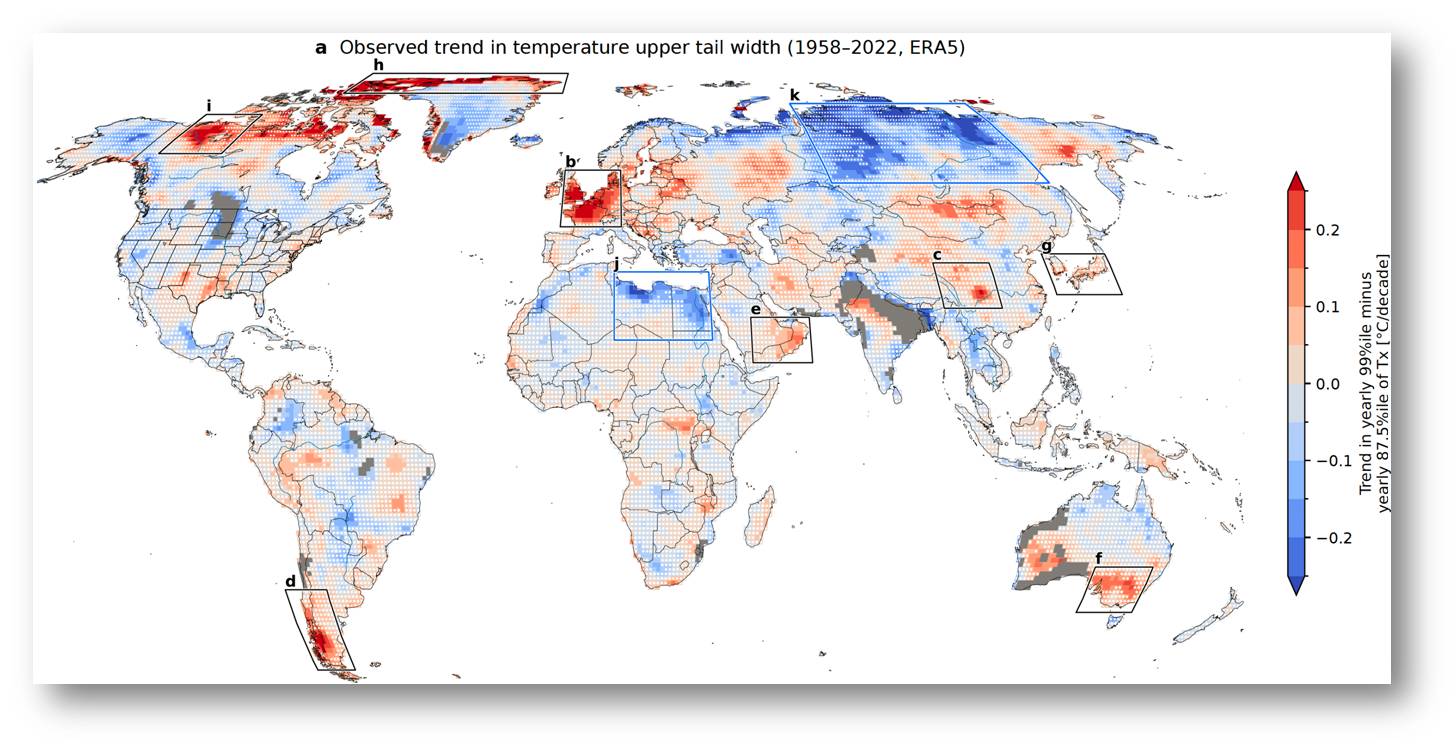

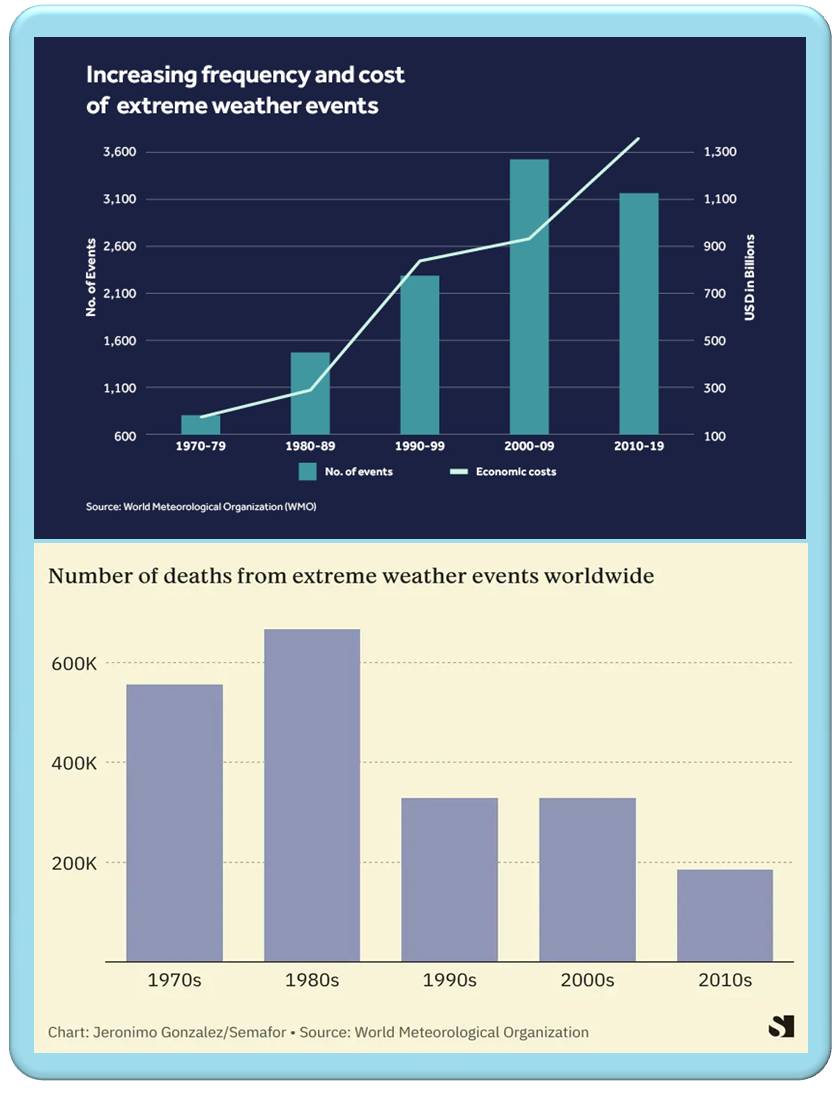

In einer neuen Studie haben Wissenschafter des IIASA und der Columbia University festgestellt, dass bestimmte Regionen der Erde von extremen Temperaturen durchwegs stärker betroffen sind, als es die modernen Klimamodelle für die gegenwärtige Erwärmung vorausgesagt haben. Die Studie liefert die erste weltweite Karte dieser regionalen Klimagefahrenzonen.*

Angesichts der kontinuierlichen Zunahme der Durchschnittstemperaturen in den letzten Jahrzehnten wirft der jüngste Anstieg rekordverdächtiger extremer Hitzewellen die Frage auf, inwieweit Klimamodelle adäquate Schätzungen der Beziehungen zwischen Veränderungen der globalen Durchschnittstemperatur und regionalen Klimarisiken liefern können. Die Studie, die soeben im Fachjournal Proceedings of the National Academy of Sciences (PNAS) veröffentlicht wurde, liefert die erste weltweite Karte der Hochrisikogebiete [1].

"Es geht hier um extreme Trends, die das Ergebnis physikalischer Wechselwirkungen sind, die wir noch nicht ganz verstehen dürften", erklärt Kai Kornhuber, Ersttautor der Studie und Themenleiter für Wetterextreme und Klimadynamik im IIASA-Programm Energie, Klima und Umwelt. "Diese Regionen werden zu temporären Treibhäusern". Kornhuber ist auch Assistenzprofessor für Klima an der Columbia Climate School.

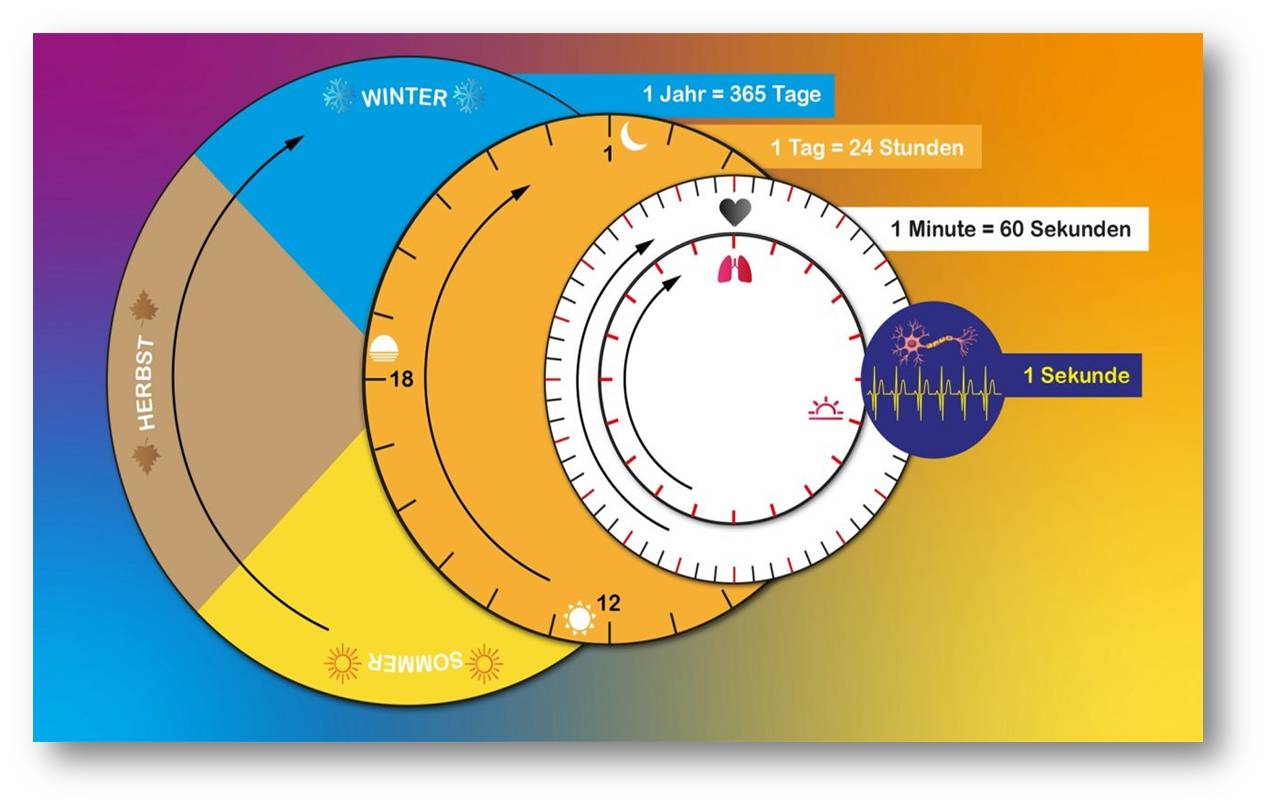

In der Studie werden die Hitzewellen der letzten 65 Jahre untersucht und Gebiete identifiziert, in denen die extreme Hitze deutlich schneller zunimmt als die typischen Temperaturen der warmen Jahreszeit insgesamt. Dies führt häufig zu Höchsttemperaturrekorden, die wiederholt gebrochen wurden. Diese extremen Hitzewellen sind vor allem in den letzten fünf Jahren schlagend geworden, wenngleich einige bereits in den frühen 2000er Jahren oder davor auftraten.

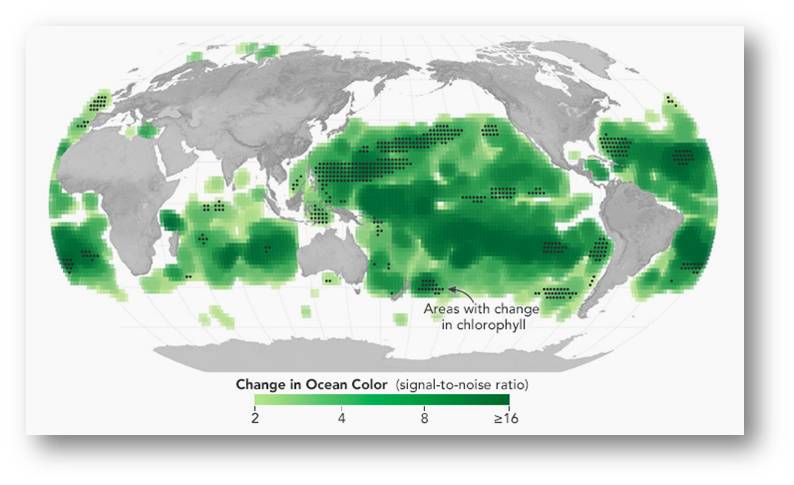

Zu den am stärksten betroffenen Regionen gehören Zentralchina, Japan, Korea, die arabische Halbinsel, Ostaustralien sowie Teile Südamerikas und die Arktis. Das intensivste und beständigste Signal kommt jedoch aus Nordwesteuropa, wo eine Folge von Hitzewellen zu rund 60 000 Todesfällen im Jahr 2022 und zu 47 000 im Jahr 2023 beitrug. Diese ereigneten sich unter anderem in Deutschland, Frankreich, dem Vereinigten Königreich und den Niederlanden. Abbildung.

Im September dieses Jahres wurden in Österreich, Frankreich, Ungarn, Slowenien, Norwegen und Schweden neue Höchsttemperaturrekorde aufgestellt. Auch in vielen Teilen des Südwestens der Vereinigten Staaten und in Kalifornien wurden bis weit in den Oktober hinein Rekordtemperaturen gemessen.

| Abbildung. Veränderungen im Bereich der Höchsttemperaturen zwischen 1958 und 2022.( Lizenz cc-by-nc) |

In diesen Regionen steigen die Extremtemperaturen schneller an als die durchschnittlichen Sommertemperaturen, und zwar in einem Tempo, das weit über dem liegt, das die modernen Klimamodelle in den letzten Jahrzehnten vorausgesagt haben. Das Phänomen tritt jedoch nicht überall auf; die Studie zeigt, dass der Temperaturanstieg in vielen anderen Regionen geringer ausfällt, als die Modelle vorhersagen würden. Dazu gehören weite Gebiete im nördlichen Zentrum der Vereinigten Staaten und im südlichen Zentrum Kanadas, innere Teile Südamerikas, große Teile Sibiriens, Nordafrikas und Nordaustraliens.

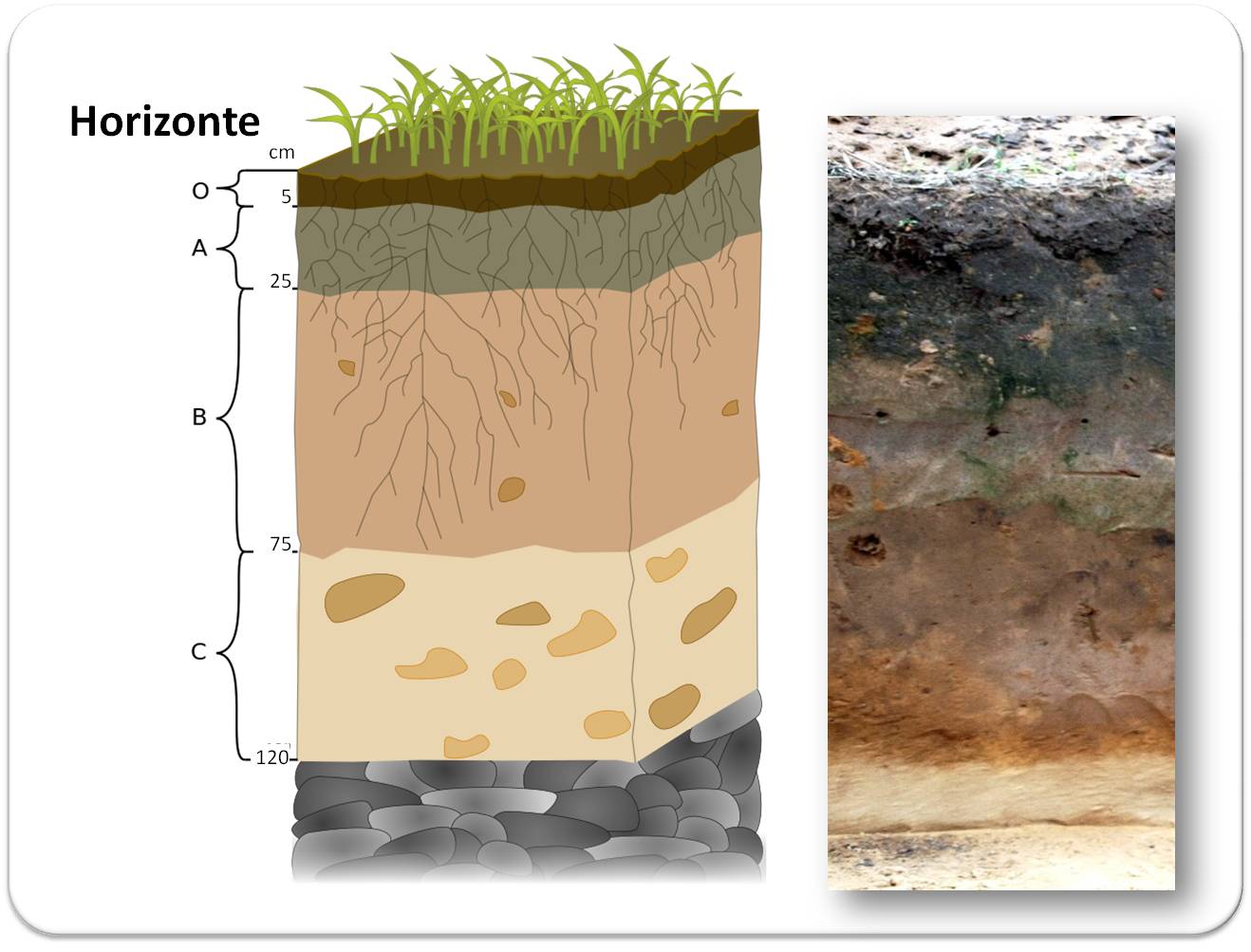

"In den meisten Gebieten werden die heißesten Tage des Jahres etwa gleich schnell warm wie typische Sommertage, was das vorherrschende Signal des Klimawandels ist, und in einigen Gebieten sogar langsamer. In den von uns aufgezeigten Hotspots haben sich die heißesten Tage jedoch besonders schnell erwärmt, was verschiedene Ursachen haben könnte. An manchen Orten könnten bestimmte Wettermuster, die eine Hitzewelle auslösen, häufiger auftreten, oder das Austrocknen des Bodens könnte die heißesten Temperaturen verstärken - es wird wichtig sein, diese spezifischen lokalen Faktoren zu entschlüsseln", sagt Koautor Samuel Bartusek, Doktorand an der Columbia University.

"Aufgrund ihrer beispiellosen Charakteristik sind diese Hitzewellen in der Regel mit schwerwiegenden gesundheitlichen Folgen verbunden und können katastrophale Auswirkungen auf die Landwirtschaft, die Vegetation und die Infrastruktur haben", ergänzt Kornhuber. "Wir sind nicht darauf vorbereitet und können uns möglicherweise nicht schnell genug anpassen."

Diese Studie ist ein wichtiger erster Schritt zur Bewältigung der sich abzeichnenden Risiken durch extreme und noch nie dagewesene Hitze, indem Regionen identifiziert werden, die in der Vergangenheit mit einem rasch ansteigenden Risiko konfrontiert waren, und indem quantifiziert wird wieweit Modelle fähig sind diese Signale zu simulieren.

--------------------------------------------------------------------------------

[1] Kai Kornhuber, Samuel Bartusek, Richard Seager and Mingfang Ting: Global emergence of regional heatwave hotspots outpaces climate model simulations. PNAS 121,49. December 3, 2024, https://doi.org/10.1073/pnas.2411258121 (cc-by-nc-nd)

*Der Artikel " Mapping the world's climate danger zones" ist am 26.November 2024 auf der IIASA Website erschienen (https://iiasa.ac.at/news/nov-2024/mapping-worlds-climate-danger-zones). Der unter einer cc-by-nc-Lizenz stehende Artikel wurde von der Redaktion möglichst wortgetreu übersetzt. IIASA hat freundlicherweise der Veröffentlichung der von uns übersetzten Inhalte seiner Website und Presseaussendungen in unserem Blog zugestimmt.

Der Themenschwerpunkt: Klima und Klimawandel im ScienceBlog

enthält bereirs mehr als 50 Artikel, die sich vor allem mit Klimamodellen und den Folgen des Klimawandels bis zu Strategien seiner Eindämmung befassen.

Von ägyptischen Katzenmumien zu modernen Haustieren

Von ägyptischen Katzenmumien zu modernen HaustierenFr, 22.11.2024 — Redaktion

![]()

Um Einblicke in die bereits sehr lange Beziehung zwischen Katzen und Menschen zu gewinnen, analysiert das EU-finanzierte Projekt FELIX archäologische Proben von Katzen, die aus der Zeitspanne von vor 10 000 Jahren bis hin zum 18. und 19. Jahrhundert und von archäologischen Stätten in Europa, dem Nahen und Mittleren Osten und Nordafrika stammen. Das Projekt konzentriert sich dabei auf drei fundamentale Bereiche, die stark vom Vorgang der Domestizierung beeinflusst werden: Auf Genome, Ernährung und Mikroorganismen. Die Arbeit von FELIX wird einen neuen Blickwinkel auf die Debatte über die Domestizierung von Tieren und die einzigartigen biologischen und ökologischen Besonderheiten bieten, die die Domestizierung von Katzen und deren weltweite Verbreitung geprägt haben.*

Egal ob verehrtes Symbol antiker Zivilisationen, Schädlingsbekämpfung auf vier Beinen oder Lieblingshaustier – unsere Verbindung zur Hauskatze reicht viele tausend Jahre zurück. Trotz dieser langen Beziehung ist jedoch nur sehr wenig darüber bekannt, welche biologischen und kulturellen Entwicklungen hinter dem Aufkommen der Interaktionen zwischen Katze und Mensch im Laufe der Zeit stehen.

Diese Wissenslücke soll nun vom EU-finanzierten Projekt FELIX [1, 2] geschlossen werden, indem mittels modernster bioarchäologischer Methoden die Überreste von mehr als 800 Katzen vergangener Zeiten untersucht werden. Die Proben stammen aus dem Zeitraum von vor 10 000 Jahren bis ins 18. und 19. Jahrhundert. Sie wurden aus archäologischen Stätten in Europa, dem Nahen und Mittleren Osten sowie Nordafrika entnommen. Das von der Universität Tor Vergata in Rom koordinierte, 2021 begonnene Projekt wir bis 31. März 2026 dauern.

Katzenbesitzer, die mit der rätselhaften und unabhängigen Natur ihrer geliebten Haustiere vertraut sind, wird es wahrscheinlich nicht überraschen, dass Wissenschaftler herausgefunden haben, dass der Domestikationsprozess von Katzen im Vergleich zu anderen Tieren recht ungewöhnlich verlaufen ist.

"Katzen sind in gewisser Weise wirklich seltsam, weil sie sich stark an den Menschen angepasst haben, ohne dabei ihr Wesen wirklich zu verändern", sagt Dr. Claudio Ottoni, Paläogenetiker von der Universität Tor Vergata in Rom. "Selbst körperlich unterscheiden sich Wildkatzen und Hauskatzen nicht sehr. Katzen waren in der Evolution sehr erfolgreich und haben sich sehr gut an die menschliche Nische angepasst, was faszinierend ist."

Antike DNA

Ottoni, der mit Hilfe alter DNA die Vergangenheit von menschlichen und tierischen Populationen rekonstruiert, leitet das EU Projekt Felix. Das internationale Forschungsteam, dem führende Experten für Paläontologie, Archäozoologie und Molekularbiologie aus Museen und akademischen Instituten in ganz Europa angehören, analysiert über 1 300 archäologische Proben von Katzen aus einigen der wichtigsten Museumssammlungen.

Durch die Extraktion der genetischen Daten aus diesen alten Überresten von Katzen wollen die Forscher die einzigartigen biologischen und umweltbedingten Einflüsse rekonstruieren, welche die Domestizierung der Katze geprägt haben, und das Auftreten von Hauskatzen auf der ganzen Welt nachverfolgen.

Hightech-Analyse

Um das Risiko einer DNA-Kontamination zu minimieren, arbeiten die Forscher in spezialisierten Einrichtungen und testen Katzenproben mit modernsten molekularbiologischen Techniken, die es ihnen ermöglichen, genetische Informationen zu extrahieren und zu analysieren.

Winzige Knochen- und Zahnfragmente werden zu einigen Milligramm Pulver zermahlen, aus dem die DNA extrahiert und in "genomische Bibliotheken" umgewandelt wird - eine Sammlung sich überlappender DNA-Fragmente, die zusammen die gesamte genomische DNA eines einzelnen Organismus bilden. Die genetische Information wird dann mit Hilfe der leistungsstarken Next-Generation-Sequenzierung entschlüsselt - einer Gensequenzierungstechnologie, die es ermöglicht, große Datenmengen sehr schnell zu verarbeiten. Unterstützt werden die Forscher dabei von der Recheninfrastruktur des Cineca, einer der europäischen Großforschungseinrichtungen und einem der weltweit leistungsfähigsten Supercomputing-Dienstleister. Diese hochentwickelte Technologie ermöglicht es den Forschern, biologische Systeme auf einem bisher unerreichten Niveau zu untersuchen und wird es auch leichter machen, Muster genetischer Mutationen über die Zeit hin zu erkennen, die die verschiedenen Stadien der Domestizierung von Katzen anzeigen.

"Auf diese Weise können wir feststellen, ob ein alter Knochen zum Beispiel zu einer europäischen Wildkatze oder zu einer afrikanischen oder nahöstlichen Wildkatze gehört, die der Vorfahre der modernen Hauskatze ist", sagt Ottoni.

Fischen nach Hinweisen

Es wird auch untersucht, wie sich die Ernährung der Katze in Verbindung mit dem Menschen verändert hat, indem stabile Isotope, chemische Marker der alten Ernährung und Zahnstein analysiert werden. Schließlich wird das Vorhandensein von pathogenen Mikroorganismen in alten Katzen untersucht und wie die Beziehung zwischen Mensch und Katze die Übertragung bestimmter Infektionskrankheiten auf den Menschen (Zoonosen) bestimmt hat.

Die Forscher setzen ausgefeilte Techniken ein, die auf der chemischen Analyse von Kollagen, dem am häufigsten vorkommenden Protein in Knochen, basieren, um zu untersuchen, wie sich die Ernährung der Katzen im Laufe der Zeit entwickelt hat. Wann haben sie zum Beispiel begonnen, Fisch zu fressen, weil die Fischer sie mit den Resten ihres Fangs fütterten? So kann man sich ein Bild davon machen, wie sich die Domestizierung der Katze entwickelt hat [3].

| Abbildung 1: . Ägyptische Katzenmumien könnten neue Informationen über die Abstammung unserer Katzen-Partner liefern. ©Andrea Izzotti, Shutterstock.com |

Auf Grund der weitverbreiteten Ikonographie von Katzen und der Entdeckung von Katzenmumien (Abbildung 1), die als Opfergaben für die Götter gedacht waren, haben Wissenschafter über lange Zeit geglaubt, dass die Domestizierung der Katze im alten Ägypten ihren Ausgang genommen hat. Die Entdeckung der antiken Grabstätte eines jungen Mannes und einer Katze auf Zypern - im neolithischen Dorf Shillourokambos - im Jahr 2004 deutete jedoch darauf hin, dass Katzen bereits vor 11 000 Jahren domestiziert worden sein könnten.

Die von Ottoni und seinen Kollegen durchgeführte DNA-Analyse hofft, dieses Geheimnis zu lüften. Die bisherigen Ergebnisse deuten darauf hin, dass die Verbindung zwischen den europäischen Hauskatzen und den Menschen in Nordafrika begann und möglicherweise mit den Römern, die über das Mittelmeer Handel trieben, nach Europa kam.

"Wenn alles vor etwa 10 000 Jahren begonnen hat, würden wir erwarten, dass die Katzen bald darauf nach Europa gebracht wurden, so wie es bei Schweinen und anderen Haustieren finden", sagt Ottoni. "Unsere DNA-Analyse zeigt jedoch, dass die Katzen in Europa damals noch Wildkatzen waren und erst viel später, vor etwa 2 500 Jahren, genetisch von der domestizierten Katzenart abstammen."

Wie diese verschiedenen Zentren der Katzendomestikation zusammenwirkten, kann jedoch erst geklärt werden, wenn die Analyse des Genoms der alten Katzen - des Bauplans, der alle Informationen über Wachstum, Entwicklung und Funktion eines Organismus enthält - abgeschlossen ist.

Das geheime Leben der Katzenmumien

In den letzten zwei Jahren der Studie werden die Forscher die genetischen Geheimnisse ihrer großen Sammlung ägyptischer Katzenmumien entschlüsseln. Sie wollen die DNA dieser Katzen mit der DNA moderner Hauskatzen und mit der DNA von antiken Katzenresten vergleichen, die bereits in Europa analysiert wurden.

| Abbildung 2: Professor Wim van Neer analysiert Schädel von Katzenmumien aus den Gräbern von Beni Hassan in Ägypten. © Bea De Cupere, RBINS |

Das Forscherteam wird mit ägyptischen Katzenmumien arbeiten, die aus verschiedenen Sammlungen in ganz Europa stammen, darunter aus dem Naturhistorischen Museum in Wien, dem Musée des Confluences in Lyon, dem Natural History Museum und dem British Museum in London sowie dem Naturhistorischen Museum in Warschau.

Professor Wim Van Neer, ein renommierter belgischer Archäo-Zoologe am Königlichen Belgischen Institut für Naturwissenschaften in Brüssel, ist eng in diesen Teil der Forschung eingebunden. Er hat selbst Katzenmumien in Ägypten ausgegraben und verfügt über praktische Erfahrungen, die in seine Forschung einfließen. Abbildung 2.

"Als ich sechs vollständige Katzenskelette in einem 6 000 Jahre alten ägyptischen Grab ausgrub, konnte ich zeigen, dass diese Tiere zwar gezähmt, aber nicht vollständig domestiziert waren", so van Neer. "Diese Funde liegen mehr als 2 000 Jahre vor den frühesten Nachweisen von Hauskatzen im pharaonischen Ägypten. Ich frage mich immer noch, ob diese frühen Versuche, Katzen zu kontrollieren, schließlich zur Domestizierung führten."

Eine der Herausforderungen für die Forscher ist die mögliche Beschädigung der DNA durch den Mumifizierungsprozess. Van Neer hofft, dass die hochentwickelte Sequenzierungstechnologie, die ihnen jetzt zur Verfügung steht, dazu beitragen wird, diese potenzielle Hürde zu überwinden und weitere Einzelheiten über die faszinierende Reise der Hauskatze vom Wildtier zum Couch-Begleiter zu enthüllen.

"Ich sehe, wie viel die Menschen über ihre Katzen wissen wollen. Dieses Projekt wirft ein Licht darauf, wie die Beziehung des Menschen zur Katze begann - und wo", so Ottoni.

[1] EU-Projekt: Genomes, food and microorganisms in the (pre)history of cat-human interactions. https://cordis.europa.eu/project/id/101002811/de DOI 10.3030/101002811

[2] Neue Erkenntnisse über den zweitbesten Freund des Menschen: https://cordis.europa.eu/article/id/445553-gaining-new-insight-into-man-s-second-best-friend/de

[3] Brozou, A., Fuller, B.T., De Cupere, B. et al. A dietary perspective of cat-human interactions in two medieval harbors in Iran and Oman revealed through stable isotope analysis. Sci Rep 13, 12316 (2023). https://doi.org/10.1038/s41598-023-39417-7

* Dieser Artikel wurde ursprünglich am 31. Oktober 2024 von Ali Jones in Horizon, the EU Research and Innovation Magazine unter dem Titel "Tracing the journey from Egyptian cat mummies to modern house pets" - "https://projects.research-and-innovation.ec.europa.eu/en/horizon-magazine/tracing-journey-egyptian-cat-mummies-modern-house-pets" - publiziert. Der unter einer cc-by-Lizenz stehende Artikel wurde von der Redaktion möglichst wortgetreu aus dem Englischen übersetzt und durch einige Sätze aus der Homepage des Projekts [1, 2] ergänzt.

Cat domestication: From farms to sofas. Nature Video, 3:27 min. https://www.youtube.com/watch?v=SgZKFVaSDRw

Project Repository Journal: The feline enigma: exploring the origins, dispersal and evolution of domestic cats. https://edition.pagesuite.com/html5/reader/production/default.aspx?pubname=&edid=ed873552-5d35-420b-a949-90ae295e058b&pnum=70

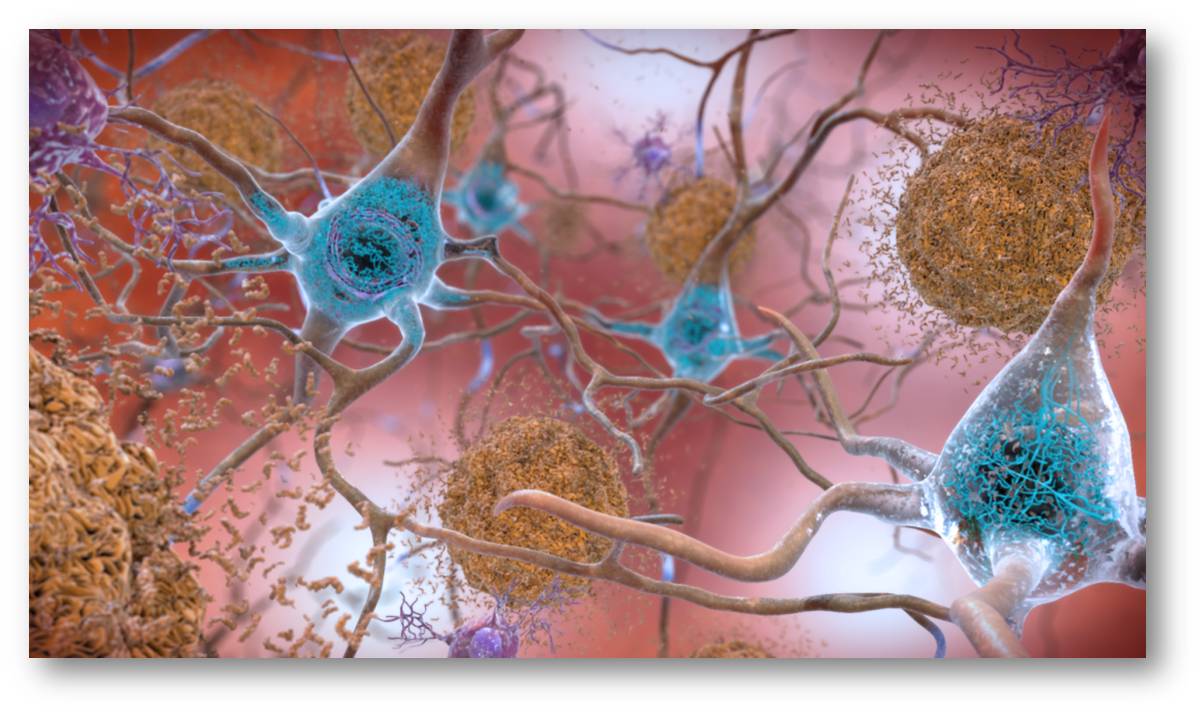

Wie das Gehirn von Abfallstoffen gereinigt wird

Wie das Gehirn von Abfallstoffen gereinigt wirdDo 14. 11.2024— Christian Wolf

Das Gehirn ist rund um die Uhr aktiv. Dabei fällt viel Müll an. Um diesen zu beseitigen, haben unsere grauen Zellen eine eigene Putzkolonne, die wir noch gar nicht so lange kennen: Das sogenannte glymphatische System nutzt die Hirnflüssigkeit, die durch Kanäle und Zellzwischenräume im Gehirn fließt, um Stoffwechselprodukte und Toxine aufzunehmen und abzutransportieren. Schlaf fördert möglicherweise die Effizienz des Reinigungssystems: Zellzwischenräume im Gehirn vergrößern sich während des Schlafs, was eine bessere Abfallentsorgung ermöglicht. Einige Forschungsergebnisse stellen diese Rolle des Schlafs allerdings in Frage.*

|

Die Putzkolonne im Gehirn |

Das Gehirn gleicht ein wenig einem modernen Firmengebäude. Die Hirnregionen sind dabei die einzelnen Abteilungen. In jedem gut funktionierenden Bürokomplex braucht es ein effizientes Reinigungssystem, um alles sauber zu halten. Auch das Gehirn hat eine eigene Reinigungscrew, die dafür sorgt, dass der Laden reibungslos läuft.

Im restlichen Körper entfernt das Lymphsystem überschüssige Flüssigkeit, Abfallstoffe, Zelltrümmer, Krankheitserreger und andere unerwünschte Substanzen aus den Geweben. Doch wie wird das Gehirn seinen Müll los? Diese Frage ist nicht ganz unwichtig, da das Gehirn einen besonders aktiven Stoffwechsel hat. Entsprechend fällt auch einiges an Abfallprodukten an.

Der Fluss des Liquors

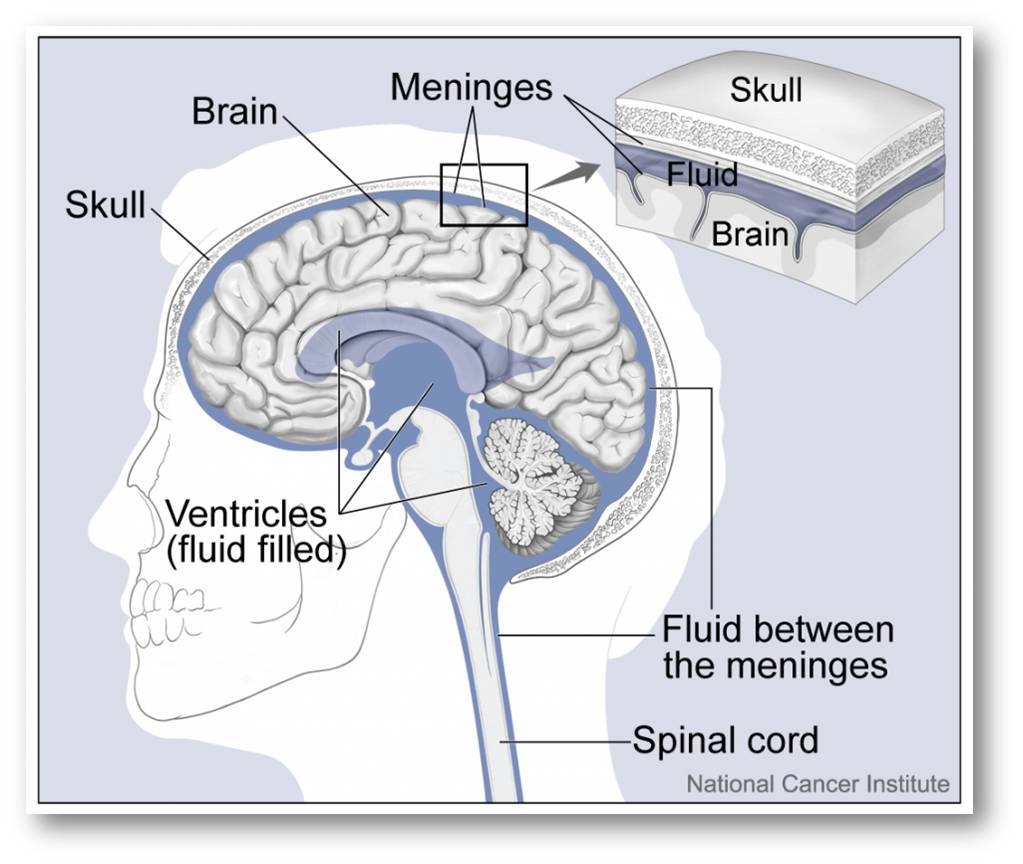

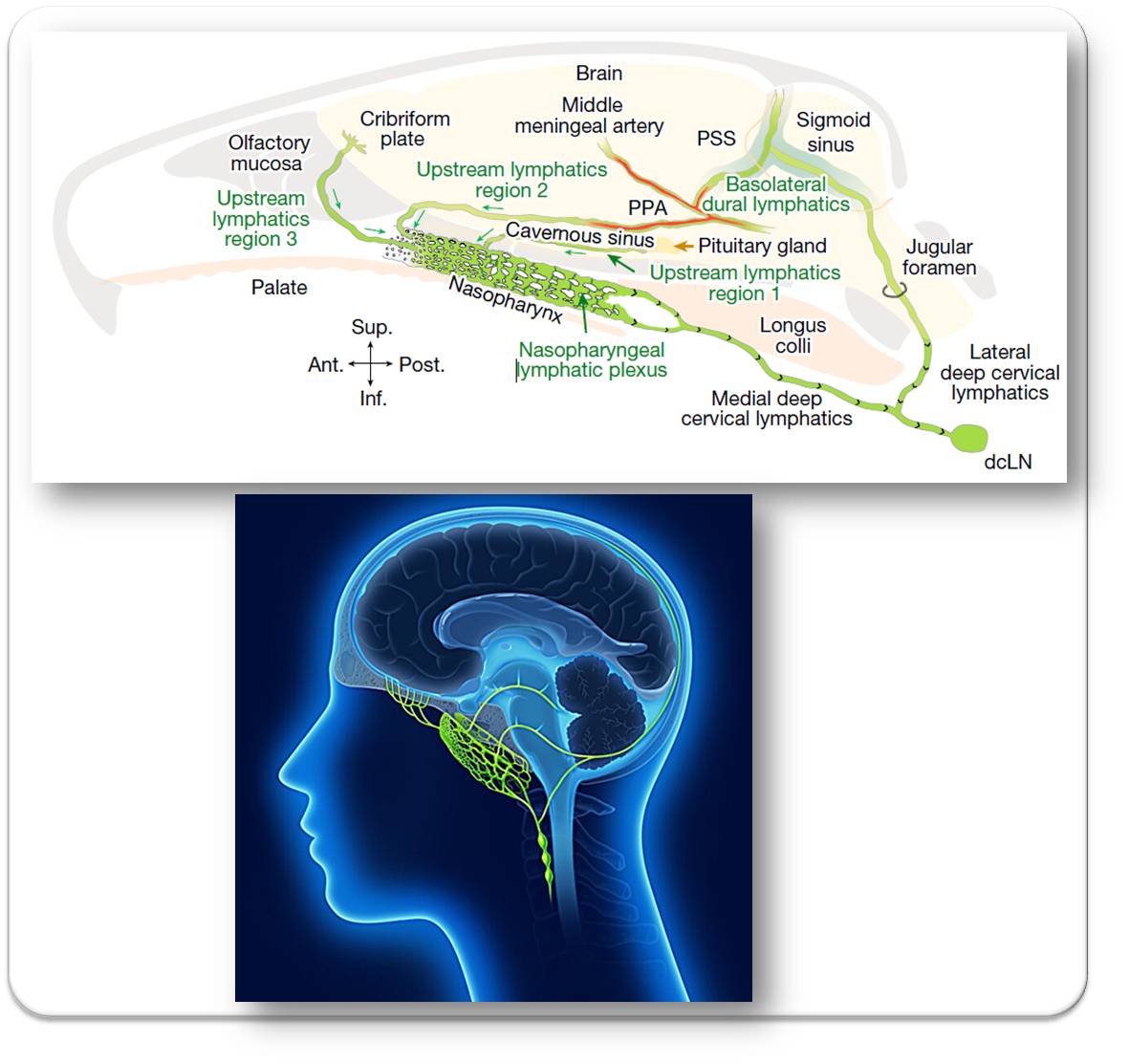

Bis vor kurzem glaubten Forscher, das Gehirn habe kein eigenes Lymphsystem, das die Reinigung übernimmt. Über ein Jahrhundert lang nahm man an, der Fluss des Liquors, der Hirnflüssigkeit, übernehme diese Funktion. Die Hirnflüssigkeit umgibt Gehirn und Rückenmark, schützt sie vor Stößen und transportiert Nährstoffe zu den Nervenzellen – und Substanzen von diesen weg. Abbildung 1 (von Redn. eigefügt).

|

Abbildung 1. Die Hirnflüssigkeit (Liquor) wird in den Hirnkammern (Ventrikeln) gebildet, fließt in den Raum zwischen der mittleren Hirnhaut (Arachnoidea) und der inneren Hirnhaut (Pia mater). Von hier aus umspült der Liquor das Gehirn und absteigend als Rückenmarksflüssigkeit das Rückenmark. (Bild: Advanced Anatomy 2nd. Ed. Copyright © 2018 by PHED 301 Students.Lizenz:cc-by-nc-nd.) |

Zwar verspottet man Menschen, die nicht ganz so helle sind, gerne als Hohlköpfe. Doch tatsächlich sind wir im Grunde alle Hohlköpfe, denn tief in seinem Inneren ist das Gehirn tatsächlich hohl. Das liegt am Ventrikelsystem, einem Netzwerk miteinander verbundener Hohlräume, in denen sich die Hirnflüssigkeit befindet. Diese Ventrikel produzieren den Liquor und verteilen ihn.

Forscher gingen nun davon aus, dass sich von Nervenzellen und Gliazellen produzierte Abfallstoffe und Stoffwechselprodukte in der Hirnflüssigkeit sammeln und mit dieser in einer Art passivem Transport entfernt werden. Der Haken an dieser These: Dieser Vorgang wäre viel zu langsam, um eine effektive Müllabfuhr zu bilden. Es muss demnach anders laufen.

Das feinkörnige Bild

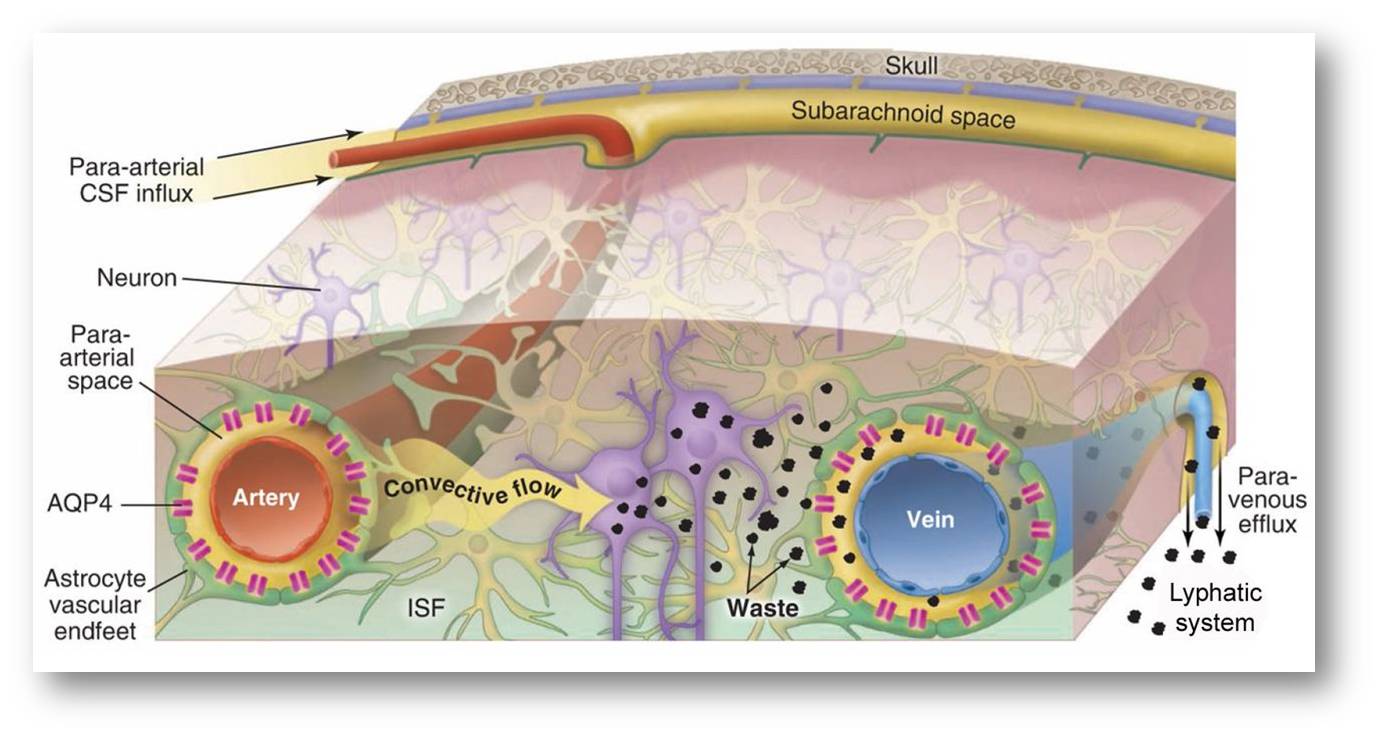

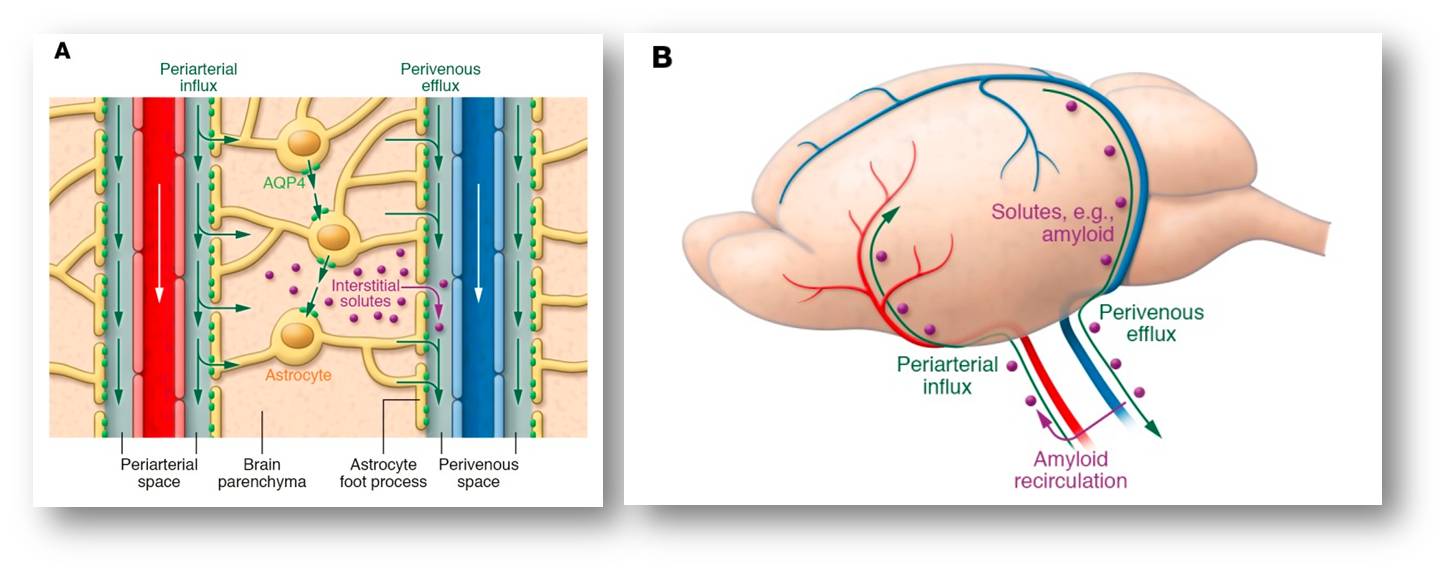

Erst 2012 entdeckten Forscher um die dänische Neurowissenschaftlerin Maiken Nedergaard vom University of Rochester Medical Center, dass das Gehirn ein eigenes Abfallentsorgungssystem besitzt – ähnlich dem Lymphsystem im restlichen Körper. Sie nannten es das "glymphatische System". Der Name setzt sich aus „Glia“ und „lymphatisch“ zusammen, da Gliazellen darin eine wichtige Rolle spielen. Das glymphatische System ist ein fließendes Durchlaufsystem zum Abtransport von überflüssigen und schädlichen Stoffen, bei dem auch der Liquor eine wichtige Rolle spielt. Abbildung 2 (von Redn. eigefügt).

|

A Das glymphatische System - Zufluss, Austausch Liquor(CSF) - Interstitielle Flüssigkeit( ISF) und Abfluss: Der Zufluss von Liquor in das Gehirn erfolgt über die para-arteriellen Bahnen und wird dann mit der ISF ausgetauscht. Der gemischte Liquor und der ISF mit den interstitiellen Stoffwechselabfällen fließen in die paravenösen Bahnen und von dort in das Lymphgefäßsystem. AQP4: Wasserkanäle . (Bild: Quan Jiang, MRI and glymphatic system. https://doi.org/10.1136/svn-2018-000197 cc-by-nc ) |

Im Rahmen der Abfallentsorgung fließt der Liquor durch verschiedene Räume im Gehirn. Dazu gehören winzige Kanäle, die parallel zu den Blutgefäßen verlaufen. Sie befinden sich zwischen den Blutgefäßen und dem umgebenden Gewebe.

Anschließend tritt die Hirnflüssigkeit in das Hirngewebe ein. Hier kommen die Gliazellen, genauer Astrozyten, ins Spiel. Diese Hirnzellen besitzen wasserleitende Kanäle in ihren Endfüßchen. Durch diese Kanäle wird der Liquor in die Zellzwischenräume des Gehirngewebes verteilt, also in den Bereich, der nicht von Blutgefäßen, Nervenfasern oder Zellen eingenommen wird.

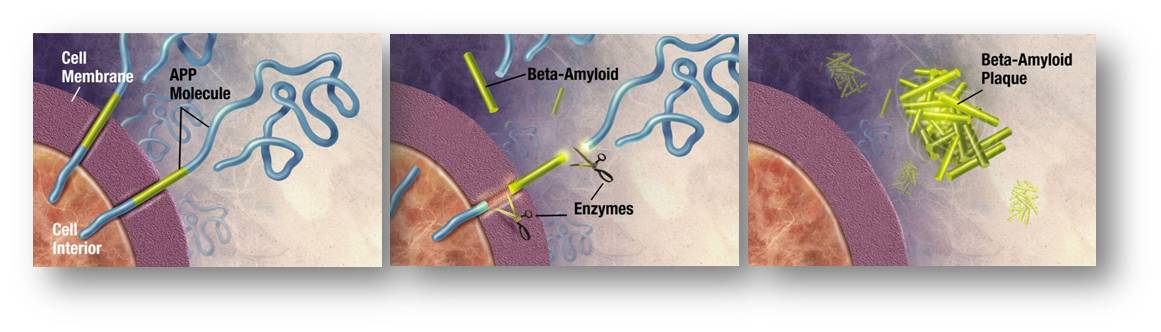

Das Entscheidende ist nun: Während die Hirnflüssigkeit durch das Hirngewebe fließt, nimmt sie Abfälle auf, die durch den Zellstoffwechsel entstehen. Wie schon die Originalstudien von Maiken Nedergaard und ihren Kollegen 2012 deutlich machten, gehört dazu Beta-Amyloid. Dieses Eiweiß genießt einen schlechten Ruf. Denn die Ansammlung und Ablagerung des Proteins wird mit der Entstehung der Alzheimer-Erkrankung in Verbindung gebracht. Schließlich wird der Liquor samt Abfallstoffen entlang der Venen wieder abtransportiert. Klappt der Abtransport von Stoffen wie Beta-Amyloid nicht gut, könnte das möglicherweise dieEntstehung von neurodegenerativen Erkrankungen wie Alzheimer begünstigen.

Warum wir schlafen

Quasi nebenbei hat Maiken Nedergaard mit ihrer Forschung zum glymphatischen System auch einen möglichen Grund dafür gefunden, warum wir überhaupt schlafen. Wie wichtig guter Schlaf ist, fällt uns in der Regel dann auf, wenn er uns fehlt. War die Nacht mal wieder viel zu kurz, schlägt das nicht nur auf die Stimmung. Meist sind wir dann geistig nicht voll auf der Höhe. Den genauen Grund dafür kennt die Wissenschaft nicht.

Einer der Funktionen von Schlaf könnte darin liegen, dass das Gehirn währenddessen den eigenen Haushalt auf Vordermann bringt. Wie Maiken Nedergard 2013 in einer Studie an Mäusen belegen konnte, wird offenbar im Zuge des Schlummerns am meisten Müll abtransportiert. Der Zwischenraum zwischen den Zellen im Gehirngewebe nahm während des Schlafs durch Schrumpfung der Zellkörper um bis zu 60 Prozent zu.

Verantwortlich dafür ist unter anderem Noradrenalin, ein Botenstoff, der das Wachheitsniveau reguliert. Er scheint gleichzeitig die Größe des Zellzwischenraums zu steuern. Noradrenalin-vermittelte Signale verändern offenbar das Zellvolumen und verkleinern dadurch den Raum zwischen den Hirnzellen. Hemmten Nedergaard und ihre Kollegen diese Signale medikamentös, vergrößerte sich der Zwischenraum zwischen den Zellen. Das führte zu einer effizienteren Beseitigung von Abfallprodukten ähnlich wie im Schlaf.

Der naheliegende Vorteil von größeren Zellzwischenräumen während des Schlafs: Durch mehr Platz zwischen den Zellen kann die Hirnflüssigkeit besser zirkulieren und die Abfallstoffe effizienter abtransportieren. Tatsächlich wurde Beta-Amyloid in der Untersuchung von Nedergaard aus den Gehirnen schlafender Mäuse doppelt so schnell beseitigt wie bei wachen Mäusen. Ein weiterer Vorteil: Der Schlaf ermöglicht es dem glymphatischen System, intensiver zu arbeiten. Denn die Energie, die im Gehirn sonst für kognitive und andere Leistungen draufgeht, steht dann für die Reinigung des Gehirns zur Verfügung. In einer Untersuchung von 2019 kam Nedergaard zu dem Ergebnis, dass vor allem im Tiefschlaf die Abfallentsorgung auf Hochtouren läuft: „Schlaf ist entscheidend für die Funktion des Abfallbeseitigungssystems des Gehirns“, sagt sie in einer Pressemitteilung. „Und diese Studie zeigt, je tiefer der Schlaf ist, desto besser."

Müllabfuhr: Im Schlaf wirklich effektiver?

Allerdings stellte kürzlich eine Studie infrage, ob Schlaf wirklich dazu dient, die Abfallentsorgung zu unterstützen. Nick Franks, Professor für Biophysik und Anästhesie am Imperial College London, und seine Kollegen kamen genau zu dem gegenteiligen Ergebnis: Stoffe im Gehirn von Mäusen wurden während des Schlafs nicht etwa stärker beseitigt – der Abtransport war sogar deutlich vermindert. "Die Idee, Schlaf könne das Gehirn von Stoffwechselprodukten befreien, war verlockend", sagt Nick Franks. Aber die Daten, die dies untermauern sollten, seien meist indirekt gewesen. "Man hat gemessen, wie schnell bestimmte Nachweismoleküle in das Gehirn gelangten. Und hat dies als Ersatz für das, was hinausging, angesehen.“ Seine eigenen Daten seien direkter. Tatsächlich hatten die Wissenschaftler um Franks Markermoleküle ins Gehirn injiziert und gemessen, wie schnell sie wieder austraten. Schlaf und Narkosemittel hemmten die Ausscheidung. "Daher ist es unwahrscheinlich, dass die Ausscheidung von Stoffwechselprodukten der Hauptgrund dafür ist, dass wir schlafen müssen."

Ob im Schlaf wirklich der Großputz stattfindet, ist also nicht ganz klar. Dafür häufen sich die Belege, dass das Gehirn tatsächlich über eine eigene Putzkolonne verfügt. Ähnlich wie ein modernes, gut funktionierendes Firmengebäude.

-Zum Weiterlesen

- Hablitz , L.M. et al.: Increased glymphatic influx is correlated with high EEG delta power and low heart rate in mice under anesthesia. In: Sci Adv 2019 Feb 27;5(2):eaav5447.

- Miao , A. et al.: Brain clearance is reduced during sleep and anesthesia. In: Nat Neurosci 2024 Jun;27(6):1046-1050.

* Der Artikel von Christian Wolf ist unter dem Titel " Die Putzkolonne im Gehirn" auf der Webseite www.dasGehirn.info am 1.Mai 2024 erschienen (https://www.dasgehirn.info/die-putzkolonne-im-gehirn). Der Artikel steht unter einer cc-by-nc-sa Lizenz. Der Text wurde mit Ausnahme des Titels von der Redaktion unverändert übernommen; zur Visualisierung wurden 2 Abbildungen eingefügt.

dasGehirn ist eine exzellente deutsche Plattform mit dem Ziel "das Gehirn, seine Funktionen und seine Bedeutung für unser Fühlen, Denken und Handeln darzustellen – umfassend, verständlich, attraktiv und anschaulich in Wort, Bild und Ton." (Es ist ein Projekt der Gemeinnützigen Hertie-Stiftung und der Neurowissenschaftlichen Gesellschaft e.V. in Zusammenarbeit mit dem Zentrum für Kunst und Medientechnologie Karlsruhe).

Artikel zum Thema im ScienceBlog:

Redaktion, 19.10.2017: Ein neues Kapitel in der Hirnforschung: das menschliche Gehirn kann Abfallprodukte über ein Lymphsystem entsorgen.

Inge Schuster, 12.02.2024: Zur Drainage des Gehirngewebes über ein Netzwerk von Lymphgefäßen im Nasen-Rachenraum.

Wie wirkt eine ketogene Diät gegen Autoimmunerkrankungen?

Wie wirkt eine ketogene Diät gegen Autoimmunerkrankungen?Mo, 11.11.2024 — Redaktion

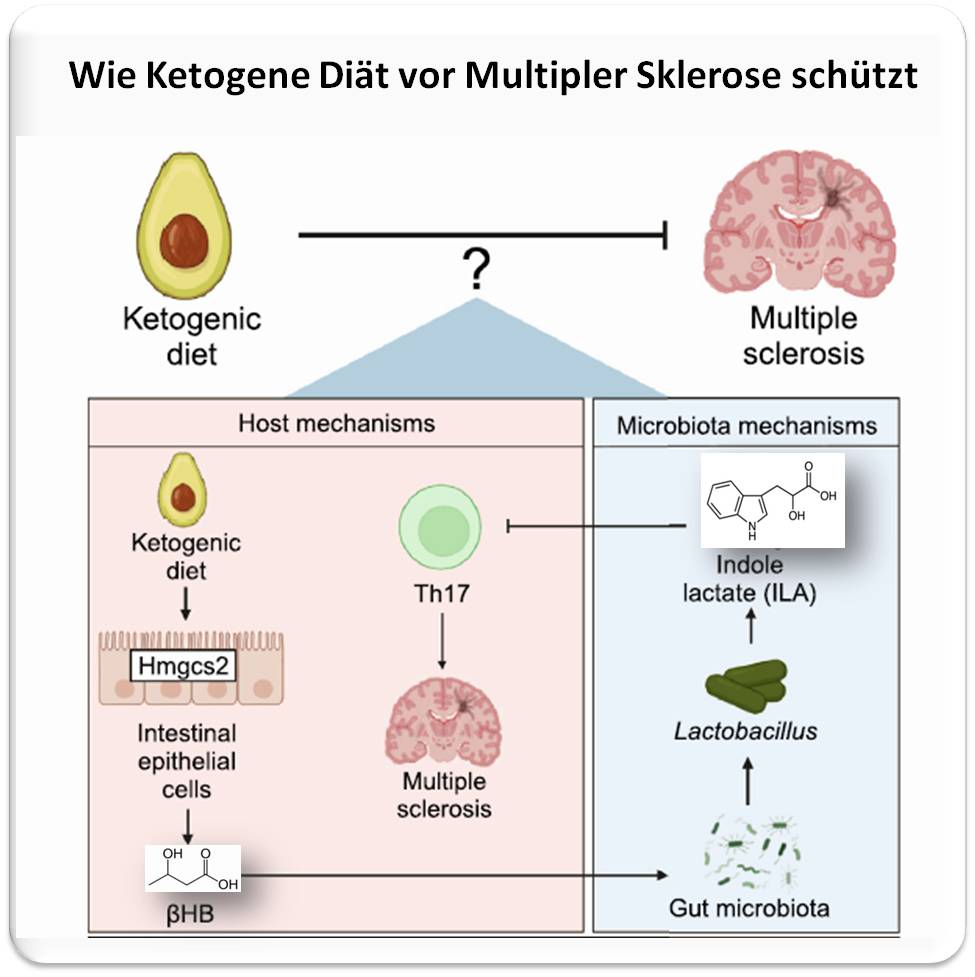

Ernährung und dadurch bedingte Veränderungen des Darm- Mikrobioms haben Auswirkungen auf diverse Autoimmunerkrankungen. Eine neue Untersuchung an einem Mausmodell der Multiplen Sklerose (MS) analysiert nun die komplexen Interaktionen zwischen Wirt und Mikrobiom und erklärt, wie eine ketogene Diät vor der Erkrankung schützt: Der Diät-bedingt im Wirtsorganismus entstehende Ketonkörper b-Hydroxybuttersäure (b-HB) ist notwendig und selbst ausreichend, um Inzidenz und Schwere der Erkrankung zu reduzieren. Zudem regt b-HB ein Darmbakterium zur Produktion des Stoffwechselprodukts Indol-Milchsäure (ILA) an, welches die für MS charakteristischen Entzündungsrektionen blockiert. Falls sich diese Ergebnisse auf den Menschen übertragen lassen, könnte anstelle einer restriktiven Keto-Diät Supplementierung von b-HB direkt zur Behandlung von Autoimmunkrankheiten eingesetzt werden.

Ketogene Diäten werden zwar bereits seit mehr als hundert Jahren klinisch angewandt, um epileptische Anfälle vor allem bei therapieresistenten (jugendlichen) Patienten zu kontrollieren, ihre Popularität hat aber erst in den letzten Jahrzehnten sprunghaft zugenommen. Keto-Diäten verhelfen zur Gewichtsabnahme, zeigen vielversprechende Auswirkungen u.a. auf das metabolische Syndrom, auf Entzündungen, Krebserkrankungen und können das Mikrobiom vorteilhaft verändern. Wie Langzeitstudien an Kindern und jungen Erwachsenen gezeigt haben, ist eine kohlenhydratreduzierte ketogene Diät offensichtlich gesundheitlich unbedenklich.

Seit mehr als 10 Jahren mehren sich die Berichte, wonach ketogene Diäten die Symptome von Autoimmunkrankheiten - darunter Multiple Sklerose (MS), entzündliche Darmerkrankungen, rheumatoide Arthritis und auch Diabetes -verbessern. Ob die Wirkung dieser Ernährungsform über den Wirt und/oder das Mikrobiom zustande kommt, war bislang unklar. Ein vorwiegend von der Universität San Francisco (UCSF) stammendes Forscherteam konnte nun diese Frage an Hand eines allgemein akzeptierten Modells für Autoimmunerkrankungen aufklären und damit möglicherweise den Weg zu einer erfolgversprechenden Therapie dieser Krankheiten bereiten [Alexander et al., 2024].

|

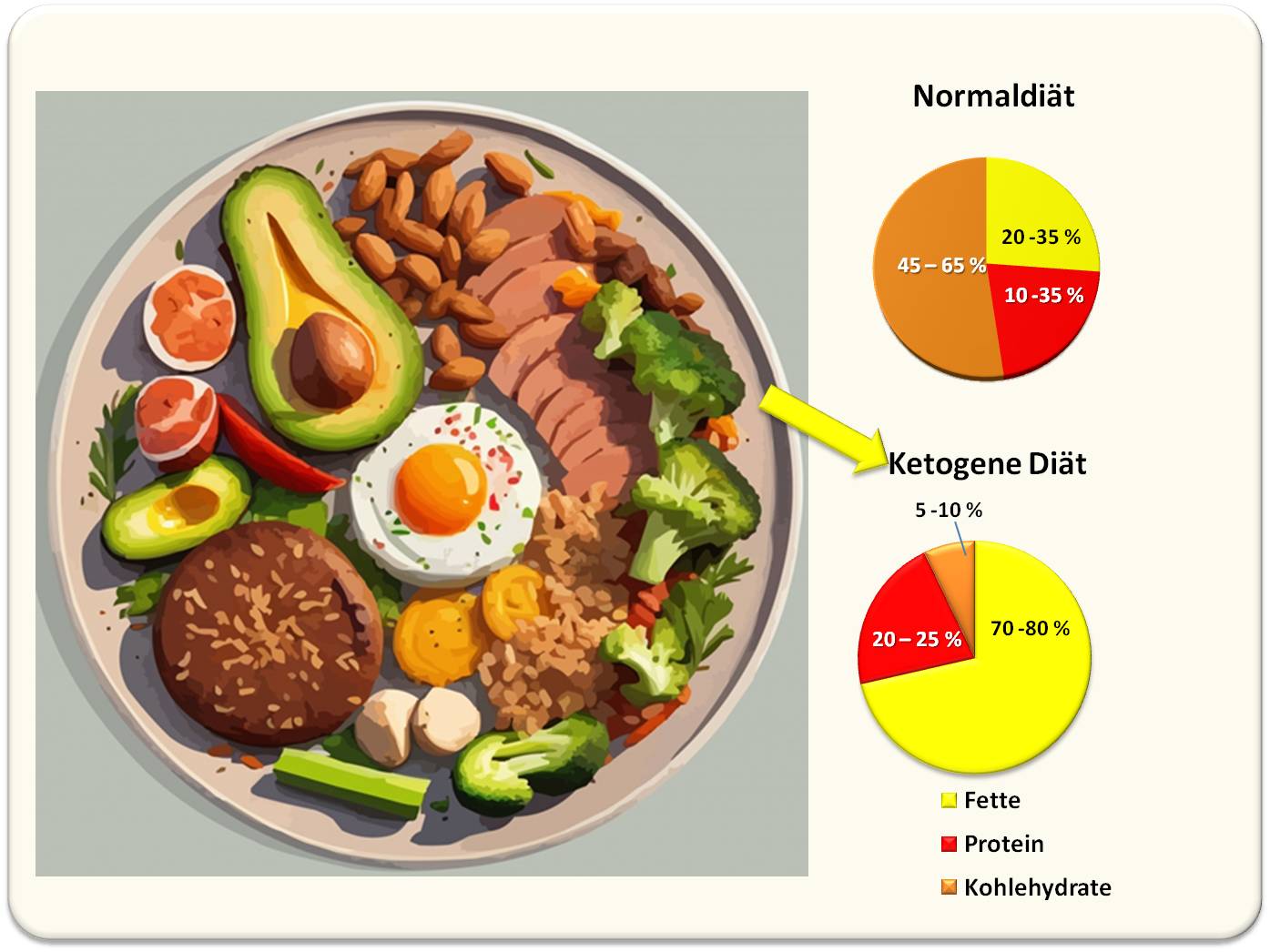

Abbildung 1: Ketogene Diät: viel Fett, aureichend Protein, sehr wenig Kohlenhydrate (Bild: Mohamed_hassan, gemeinfrei) |

Eine Schlüsselrolle spielt der Metabolit b-Hydroxybuttersäure, der diätbedingt in höherer Menge im Wirtsorganismus produziert wird und über eine Veränderung des Darm-Mikrobioms zu einer verringerten Aktivierung des Immunsystems führt.

Der folgende Abschnitt gibt eine kurze Information zu diesem Metaboliten.

Was macht eine ketogene Diät aus?

In der Normaldiät liefern kohlenhydratreiche Lebensmittel wie Brot, Nudeln, Reis, Süßwaren und Obst den primären Energielieferanten im Zellstoffwechsel, die Glukose. Bei einer täglichen Zufuhr von 2000 kcal werden im Mittel 275 g Kohlenhydrate aufgenommen. (Abbildung 1, rechts oben).

Die Keto-Diät schränkt solche Lebensmittel sehr stark ein, erlaubt aber ausreichende Proteinzufuhr und nahezu unbegrenzten Verzehr von Fett. (Abbildung 1, rechts unten.) Werden einem Erwachsenen täglich weniger als 50 g Kohlenhydrate zugeführt, so reicht dies nicht mehr aus, um den Organismus mit Glukose zu versorgen und dieser schaltet den Stoffwechsel um und gewinnt Energie aus der Fettsäure-Oxidation (Lipidoxidation).

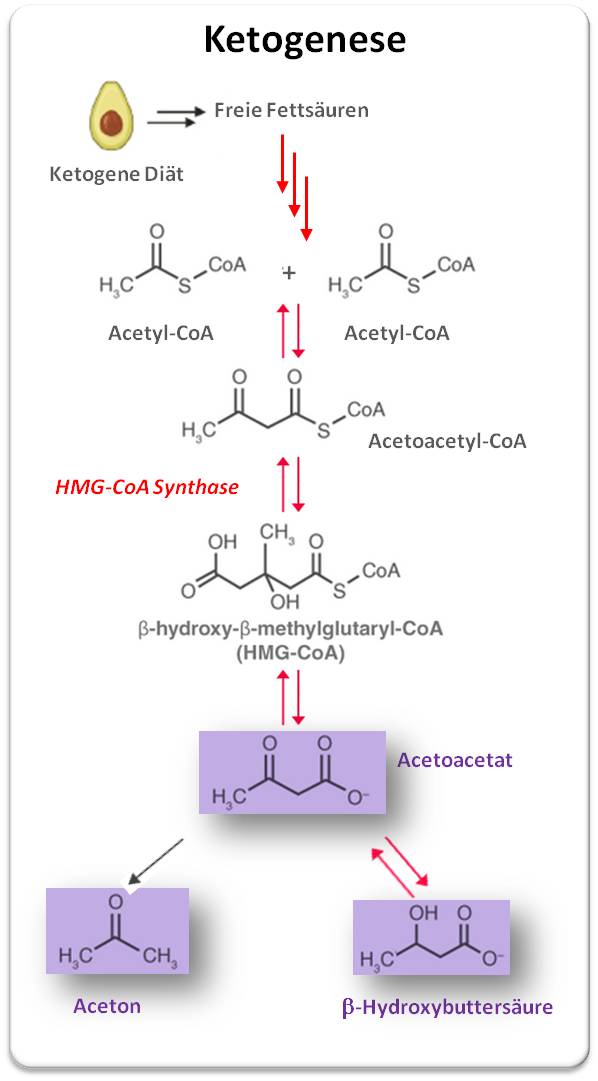

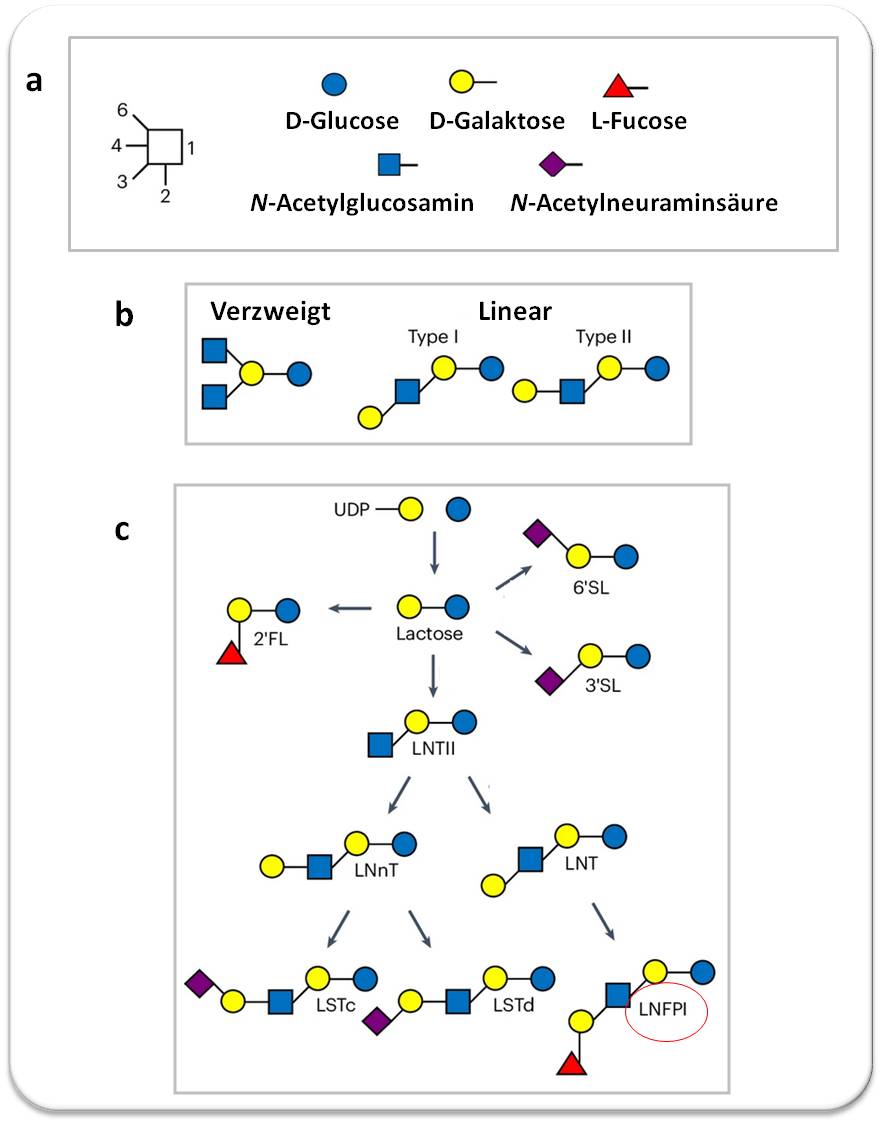

Der als Ketogenese bezeichnete Prozess

findet in den Mitochondrien vor allem der Leber- und Darmepithelzellen statt; er ist in Abbildung 2 vereinfacht dargestellt: Aus den Fettsäuren entstehen aktivierte Essigsäure (Acetyl-CoA) und in einer Reihe von Folgereaktionen drei sogenannte Ketonkörper: Acetoacetat, Aceton und b-Hydroxybuttersäure. Geschwindigkeitsbestimmend für die Umsetzung ist das Enzym HMG-CoA Synthase. Die wasserlöslichen Ketonkörper Acetoacetat und b-Hydroxybuttersäure treten in den Blutkreislauf ein und dienen praktisch allen Zellen als Energielieferanten. Darüber hinaus zeigen sie weitreichende Auswirkungen auf das Immunsystem; u.a. unterdrücken sie Entzündungsreaktionen und modifizieren die Funktion von T-Zellen (Th17-Zellen).

|

Abbildung 2: Von der Fettsäureoxidation zu den Ketonkörpern (lila) Acetoacetat, Aceton und b-Hydroxybuttersäure . Stark vereinfachte Darstellung. Rote.Pfeile: Enzymreaktionen. HMG-CoA-Synthase katalysiert den geschwindigkeitsbestimmenden Schritt. Schwarzer Pfeil: spontane , nichtenzymatische Reaktion. |

Von der Keto-Diät zur Entdeckung von zwei Schlüsselsubstanzen zur Therapie von Autoimmunerkrankungen

Die hier berichtete Studie des Forscherteams um Peter J. Turnbaugh (University San Francisco) wurde an einem Mausmodell der experimentellen Autoimmun-Enzephalomyelitis (EAE) durchgeführt [Alexander et al., 2024]. Dabei wird die Krankheit durch Immunisierung mit einem Peptid hervorgerufen, das zu autoimmuner Demyelinisierung der Nervenfasern führt. Unter allen Modellen der Multiplen Sklerose spiegelt dieses Modell deren Autoimmunpathogenese am besten wider und wird weltweit in der Forschung aber auch in der Entwicklung von Therapien am häufigsten verwendet.

Schlüsselrolle von b-Hydroxybuttersäure

Wie erwartet reduzierte die Keto-Diät (KD: 90,5 % Fett, 0 % Kohlenhydrate, 10 % Protein) die Schwere und die Inzidenzrate der Erkrankung im Vergleich zur Kontrollgruppe (HFD: mit zu KD abgestimmten Zutaten 75 % Fett, 15 % Kohlenhydrate, 9,5 % Protein), die zwar einen hohen Fettanteil aufwies aber auch ausreichend Kohlenhydrate, um nicht auf Ketogenese umzuschalten. Abbildung 3 A, B. In der KD-Gruppe war dagegen die b-Hydroxybuttersäure im Blut auf das rund Fünffache erhöht und die für EAE charakteristischen Immunzellen und Entzündungsfaktoren stark reduziert.

Ein völlig überraschendes Ergebnis der Studie war, dass Supplementierung der Kontrollgruppe (HFD-Mäuse) allein mit b-Hydroxybuttersäure(-ester: KE)) ausreicht, um eine mit der Keto-Diät vergleichbar starke Reduktion der EAE zu erzielen (Abbildung 3 C,D).

Bei transgenen Mäusen, deren HMG-CoA-Synthase (siehe Abbildung 2) ausgeschaltet ist und, die daher nicht in der Lage sind b-Hydroxybuttersäure im Darm zu produzieren, erweist sich die Keto-Diät als wirkungslos - die Tiere entwickeln eine der Kontrollgruppe gleichende schwere Krankheit (Abbildung 3 E,F).

|

Abbildung 3: In einem Mausmodell für Multiple Sklerose reduziert ketogene Diät Schwere und Inzidenzrate der Erkrankung. A, B: Vergleich Ketogene Diät (KD) versus nicht-ketogene Diät (HFD). C, D Supplementierung der nicht-ketogenen Diät (HFD) mit b-Hydroxybuttersäure (ester) führt zu vergleichbar hohem Schutz wie die ketogene Diät. E, F: Ketogene Diät zeigt bei transgenen Tieren (Hmgcs2IEC, die auf Grund der ausgeschalteten HMG-CoA-Synthase keine b-Hydroxybuttersäure produzieren können, keine Schutzwirkung wie der Wildtyp (Hmgcs2WT). G,H: Bei keimfreien (d.i. ohne Mikrobiom gezüchteten) Mäusen kannt die Keto-Diät trotz gesteigerter b-Hydroxybuttersäure Produktion den Krankheitsverlauf nicht positiv beeinflussen. (Daten sind Mittelwerte ± SEM; jeder Punkt stammt von einer einzelnen Maus. Bilder stammen aus Figures 1, 2, 3 in Alexander et al., 2024, Lizenz cc-by.) |

b-Hydroxybuttersäure wirkt über das Mikrobiom

Im Gegensatz zu "nomalen" Tieren zeigte die Keto-Diät bei keimfrei - d.i. ohne Mikrobiom - gezüchteten (GF) Mäusen keinerlei Auswirkungen auf Schwere und Inzidenz der EAE (Abbildung 3 G, H), obwohl diese Tiere mehr als fünffach erhöhte b-Hydroxybuttersäure-Spiegel aufwiesen. Offensichtlich war also das Darm-Mikrobiom notwendig, um b-Hydroxybuttersäure wirksam werden zu lassen.

Um herauszufinden, wie dieser Metabolit das Darmmikrobiom beeinflusst, isolierte das Forscherteam Bakterien aus den Därmen von Mäusen, die mit der Keto-Diät, der fettreichen HF-Diät oder der mit der b-Hydroxybuttersäure supplementierten HF-Diät gefüttert wurden und untersuchten jede dieser Gruppen auf Stoffwechselprodukte. Es stellte sich heraus, dass die positiven Auswirkungen der Keto-Diät auf einen Typ der Lactobacíllus Species - Lactobacillus murinus - zurückzuführen waren. L. murinus produziert Indol-Milchsäure (ein Abbauprodukt der Aminosäure Tryptophan). Dieser Metabolit unterdrückt die Funktion bestimmter T-Zellen (Th17), die u.a. den für die Pathogenese von MS charakteristischen Entzündungsfaktor IL-17 produzieren.

Schlussendlich behandelten die Forscher die Mäuse anstelle der Keto-Diät direkt mit dem Keim L.murinus oder mit dessen Metabolit Indol-Milchsäure und konnten feststellen, dass dies die Tiere in gleicher Weise vor EAE schützte, wie die Keto-Diät oder der Wirtsmetabolit b-Hydroxybuttersäure.

Abbildung 4 fasst die erfolgversprechenden Auswirkungen der Keto-Diät auf das Modell der multiplen Sklerose zusammen.

|

Abbildung 4: Zwei Verbindungen bestimmen die neuroprotektive Wirkung der ketogenen Diät: Die durch die Diät im Wirtsorganismus erzeugte Hydroxybuttersäure (HB), die wiederum das Darmmikrobiom zugunsten von Produzenten der Indol-Milchsäure (ILA) verändert, welche Entzündungsreaktionen des Immunsystems unterdrückt. (Bild stammt aus Alexander et al., 2024, Lizenz cc-by.) |

Fazit

Ketogene Diät schützt vor einer Autoimmunerkrankung in einer Mikrobiom-abhängigen Weise.

Der durch die Diät vom Wirtsorganismus erzeugte Metabolit b-Hydroxybuttersäure ist für die Schutzwirkung notwendig und alleine ausreichend.

b-Hydroxybuttersäure verändert die Diversität des Mikrobioms zugunsten von Bakterien, die Indol-Milchsäure produzieren; dieser bakterielle Metabolit unterdrückt entzündungsfördernde Immunzellen (Th17) und trägt so zur neuroprotektiven Wirkung bei.

Falls sich diese Ergebnisse auf den Menschen übertragen lassen, könnte anstelle einer restriktiven Keto-Diät Supplementierung von b-Hydroxybuttersäure direkt zur Behandlung von Autoimmunkrankheiten eingesetzt werden. Die Wirkung könnte möglicherweise durch zusätzliche Gabe von Indol-Milchsäure verstärkt werden.

---------------------------------

Anmerkung der Redaktion: b-Hydroxybuttersäure wird tatsächlich durch ketogene Diät im Menschen massiv hochreguliert!

Vor 9 Monaten wurde im ScienceBlog über eine randomisierte klinische Untersuchung berichtet, in der die Auswirkungen von ketogener Diät und veganer Diät auf Stoffwechsel, Immunsystem und Mikrobiom mit Hilfe eines Multiomic Anatzes verglichen wurden (Redaktion, 16.02.2024). Von den insgesamt im Plasma erfassten 860 Stoffwechselprodukten (Metaboliten) waren 131 bei ketogener Ernährung hochreguliert. Von allen strukturell identifizierten Metaboliten war b-Hydroxybuttersäure am stärksten hochreguliert (mittlere relative Plasmaspiegel bei Normaldiät 1,29, bei Keto-Diät 5,36 und bei veganer Diät bei 0,30. (Link V.M et al, 22024, Supplementary Information: Table 5)).

Alexander et al., 2024, A diet-dependent host metabolite shapes the gut microbiota to protect from autoimmunity. Cell Reports, 114891. https://doi.org/10.1016/j.celrep.2024.114891

Redaktion, 16.02.2024: Wie sich die Umstellung auf vegane oder ketogene Ernährung auf unser Immunsystem auswirkt.

Link, V.M., Subramanian, P., Cheung, F. et al. Differential peripheral immune signatures elicited by vegan versus ketogenic diets in humans. Nat Med (2024). https://doi.org/10.1038/s41591-023-02761-2

Die Problematik von "Do Your Own Research" und "Believe in Science"

Die Problematik von "Do Your Own Research" und "Believe in Science"Do,31.10.2024 — Ricki Lewis

Der Slogan "Do Your Own Research" (DYOR) wurde in den 1990er Jahren von dem US-Verschwörungstheoretiker Milton William Cooper geprägt. DYOR, das für „Mach' Deine eigene Recherche“ steht, d.i. sich selbst zu informieren, anstatt alles zu glauben, was man liest, wurde zum geflügelten Wort in der Kryptoszene und in den 2010er Jahren häufig von Impfgegnern im Internet verwendet. Während der COVID-Pandemie zeigten sich dann die negativen Auswirkungen von DYOR, eine Überfülle von selbst-recherchierten Fehlinformationen online und offline nährte Gerüchte und Verschwörungstheorien: das Misstrauen gegenüber wissenschaftlichen Institutionen und staatlichen Maßnahmen zur Eindämmung der Pandemie wuchs und wurde politisch instrumentalisiert, es wurden etablierte Beweise für die Wirksamkeit von Impfstoffen negiert, und insgesamt eine noch immer anhaltende globale Anti-Impf-Bewegung ausgelöst. Die Genetikerin Ricki Lewis zeigt die Problematik von DYOR auf, die heute zumeist bedeutet, dass mit Hilfe von Suchmaschinen Informationen gefunden werden, die bestätigen, was man bereits für wahr hält, aber auch von "Believe in Science", da Emotionen in der Wissenschaft fehl am Platze sind.*

Während der Pandemie haben wir uns an unsere Entscheidungsträger gewandt, um aktuelle Informationen über die beispiellose, sich rasch verschlechternde Situation zu erhalten. Als die Tage dann zu Wochen wurden, die Kranken vor den Krankenhäusern der Stadt Schlange standen, flehten wir nach Informationen. Doch vieles davon kam in einer unbekannten Sprache, in der Sprache der Virologie und Immunologie, der öffentlichen Gesundheit und der Epidemiologie.

In jenen frühen Tagen waren Politiker und Regierungsbeamte, die Begriffe wie "Zytokinsturm" und "RNA-Virus" noch nie gehört hatten, plötzlich gefordert, zu erklären, was vor sich ging. Zum Glück meldeten sich sachkundige Stimmen zu Wort. Experten trafen sich regelmäßig mit Wissenschaftsjournalisten und lieferten technische Updates, die wir in unsere Artikel, Blogbeiträge, Podcasts und andere Kommunikationsmittel einfließen ließen.

"Do Your Own Research" fördert wissenschaftlichen Analphabetismus

COVID hat das Mantra DYOR - Do your own research - zu neuem Leben erweckt. "Der Satz "Mach' Deine eigene Recherche" scheint heutzutage allgegenwärtig zu sein, oft von Leuten geäußert, die "Mainstream"-Wissenschaft nicht akzeptieren, von Verschwörungstheoretikern und vielen, die sich als unabhängige Denker aufspielen. Oberflächlich betrachtet scheint das legitim zu sein. Was kann daran falsch sein, Informationen zu suchen und sich eine eigene Meinung zu bilden?"[1]

Allerdings "Recherche/Forschung" zu betreiben, indem man auswählt, was man liest, sieht oder hört, ist überhaupt nicht dasselbe wie die Forschung, die Wissenschafter betreiben. Forscher achten nicht nur auf die Daten, die ihre Hypothesen unterstützen - in der Wissenschaft geht es vielmehr darum, Hypothesen zu verwerfen, weiter zu denken und neue Experimente zu designen, um etwas in der Natur zu untersuchen. In der Wissenschaft geht es um Daten, nicht um "Inhalte".

Die Quellen schreiben den Ursprung von DYOR Milton William "Bill" Cooper zu, der in den 1990er Jahren weithin als "amerikanischer Verschwörungstheoretiker" bezeichnet wurde (u.a. besaß er angeblich Dokumente, die die Anwesenheit von Außerirdischen auf der Erde bestätigten, was aber von amerikanischen Behörden vertuscht wurde; Anm. Redn.). Zwanzig Jahre später heizte sein DYOR die Anti-Impf-Bewegung an und widerlegte seit Dekaden etablierte Beweise für die Wirksamkeit von Impfstoffen. Die Angst vor Impfstoffen tauchte in Verbindung mit QAnon (von Amerika ausgehende Verschwörungstheorien mit rechtsextremem Hintergrund, Anm. Redn.) während der Pandemiejahre wieder auf und hat sich auch in der Zeit nach COVID nicht gelegt.

|

Abbildung. DYOR - Mach' Deine eigene Recherche: Fehleinschätzungen während der COVID-19 Pandemie. (Bild modifiziert nach Fernandozhiminaicela https://pixabay.com/photos/covid-19-coronavirus-pandemic-4985553/) |

Unterstützung für 'DYOR' steht in Zusammenhang mit COVID-19-Fehleinschätzungen und Misstrauen in die Wissenschaft

Sedona Chinn von der University of Wisconsin und Ariel Hasell von der University of Michigan haben im Juni 2023 im Harvard Kennedy School Misinformation Review die Studie "Support for 'doing your own research' is associated with COVID-19 misperceptions and scientific mistrust" veröffentlicht. [2] (Chinn und Hasell sind selbst keine Wissenschafter - ihr Fachgebiet ist die Vermittlung von Wissenschaft).

Darin haben Chinn und Hasell die Daten einer YouGov-Umfrage von erwachsenen US-Bürgern analysiert, die im Dezember 2020 an 1.500 Personen und im März 2021 an weiteren 1.015 Personen durchgeführt wurde. Die Teilnehmer wurden gefragt, ob sie drei Aussagen über DYOR zustimmten, die auf einer 7-Punkte-Skala von "stimme überhaupt nicht zu" bis "stimme voll und ganz zu" bewertet wurden:

1. "Jeder kann ein Experte auf einem Gebiet sein, wenn er nur genug recherchiert".

2. "Ich ziehe es vor, selbst zu recherchieren, anstatt mich auf Experten und Intellektuelle zu verlassen".

3. "Die Meinung von Menschen, die selbst recherchiert haben, ist genauso gültig wie die Meinung von Experten und Intellektuellen."

Die statistische Auswertung zeigte, was wir instinktiv wissen oder zumindest vermuten. Chinn und Hasell kommen zu dem Schluss:

1. "Menschen überschätzen oft ihre Fähigkeiten, Informationen zu suchen und zu interpretieren, und neigen dazu, nach Informationen zu suchen, die mit bereits vorhandenen Werten, Überzeugungen und Identitäten übereinstimmen. Voreingenommenheit in der Wahrnehmung kann zu falschen Schlussfolgerungen führen, insbesondere dann, wenn den Einzelnen Fachwissen und Schulung in wissenschaftlichen Arbeitsweisen fehlen oder sie sich auf ihr Bauchgefühl verlassen."

2. DYOR kann auch "die Skepsis gegenüber wissenschaftlichen Institutionen und Mainstream-Informationsquellen fördern, indem betont wird, wie diese die Öffentlichkeit in die Irre führen könnten. Solche Aufrufe können die Sichtweise widerspiegeln, dass wissenschaftliche Institutionen oder Mainstream-Nachrichtenmedien korrupt sind oder eine versteckte Agenda haben, die den eigenen Weltanschauungen und Zielen feindlich gegenübersteht. Wenn auch DYOR-Aussagen nicht ausschließlich zur Förderung von Fehlinformationen verwendet werden, so zeigen unsere Ergebnisse, dass DYOR-Sichtweisenen mit Misstrauen gegenüber wissenschaftlichen Einrichtungen und COVID-19-Fehleinschätzungen zusammenhängen." Selbst gut gemeinte DYOR könnte die Skepsis gegenüber offiziellen Informationsquellen fördern, fügen sie hinzu.

3. Eine weitere Verwendung von DYOR kann darin bestehen, eine "politische Identität gegen das Establishment" zu unterstützen, anstatt nach Daten, Beweisen oder Informationen zu suchen. An der Impfstofffront "wird DYOR oft in Verbindung mit Ressentiments gegenüber Ärzten und Wissenschaftern angeführt, die persönliche Erfahrung und Intuition abtun ... eine Manifestation der Verachtung für Eliten und nicht eine Bestätigung der Bedeutung unabhängiger Forschung."

"Believe in Science" datiert länger zurück als DYOR, ist aber noch problematischer

Ich kann Memes nicht leiden. (Memes sind (meist witzige) kurze Videos oder Bilder mit Schriftzügen, die sich im Internet in rasantem Tempo verbreiten; Anm. Redn.) Wenn es um keine Ansichtssachen geht, können sie unrichtig sein, aber dennoch verlässlich klingen, vor allem, wenn sie kopiert und eingefügt werden wie ein transponierbares Element ("springendes Gen"), das über ein Genom flitzt.

Eine gute Freundin hat kürzlich einen besonders ärgerlichen Satz auf Facebook gepostet: "Fakten zu glauben und der Wissenschaft zu vertrauen, bedeutet nicht, dass man ein 'Liberaler' ist. Es bedeutet, dass man 'gebildet' ist."

|

"Believe in Science" - "Glaube" und "Vertrauen" sind Emotionen, die in der Wissenschaft nichts verloren haben. |

Das Problem dabei ist, dass "Glaube" und "Vertrauen" Emotionen sind. Sie haben in der Wissenschaft nichts verloren. Die erste Antwort auf den Facebook-Post meiner Freundin: "Wir sollten nicht vergessen, dass ein Großteil der *Wissenschaft* von der Regierung und speziellen Interessengruppen finanziert wird. Recherchieren Sie selbst und machen Sie einen sogenannten *Faktencheck.*" spiegelt genau das wider, was Chinn und Hasell in ihrer Analyse (s.o.) festgestellt hatten.

Der DYOR-er setzt damit wissenschaftliche Forschung einer "Forschung" gleich, die aus dem Lesen von Memes besteht, entscheidet was Wissenschaft ist und was nicht, nach dem, was er glaubt. .

Meine Antwort darauf lautete: "Die NIH und NSF (US-National Science Foundation; Anm. Redn.) finanzieren die Grundlagenforschung von Tausenden Wissenschaftern. Ohne Grundlagenforschung hätten wir keine Medikamente. Meine eigene Forschung befasste sich mit Fruchtfliegen, führte aber zu Behandlungen für Leukämien und andere Krankheiten. "Spezielle Interessengruppen" sind nicht der Feind. Dazu gehören die Biotech-Unternehmen, die uns gezielte Krebsmedikamente sowie Gen- und Immuntherapien liefern..."

Mein Mann Larry wies darauf hin, dass die anfängliche staatliche Finanzierung zur "Erfindung von Mikrowellenherden, Mobiltelefonen, Hörgeräten, Satellitenkommunikation, E-Mail, künstlichen Organen und Gliedmaßen und Hunderten von anderen Dingen" geführt hat.

Memes wie dieses, insbesondere die Beschwörung von DYOR und "Glaube an die Wissenschaft", untergraben weiterhin den Respekt vor der tatsächlichen Arbeit der Wissenschafter.

"Doing your own research" bedeutet, dass man das, was man liest, hört und sieht, so auswählt, dass es vorgefasste Meinungen unterstützt. Dies lässt die Kreativität, die Objektivität und das kritische Denken vermissen, die ein praktizierender Wissenschafter an den Tag legt, wenn er "Forschung betreibt".

DYOR bedeutet, dass man die Ideen und Gedanken anderer aufnimmt und vielleicht auswählt, um das zu unterstützen, was man selbst bereits für wahr hält. Wissenschaftliche Forschung ist etwas ganz anderes. Wissenschaft ist ein Zyklus des Forschens, Testens, Interpretierens und Überarbeitens von Hypothesen.

Fazit

Forschung in der Wissenschaft bedeutet viel Lesen, Nachdenken, Testen, Beobachten, Hypothesen aufstellen und das, was wir zu wissen glaubten, ständig zu revidieren. Sie ist ein kontinuierlicher Prozess, der sich über Jahrzehnte erstreckt.

Und deshalb stört mich - und vermutlich auch einige andere - der leichtfertige Satz "Recherchieren/Forschen Sie selbst". Um ein Experte auf einem Gebiet zu sein, gehört weit mehr dazu, als bereits bekannte Informationen aufzunehmen, die bestätigen, was man bereits weiß oder glaubt. Dieser Satz erweist der Wissenschaft und den Wissenschaftlern einen schlechten Dienst.

*Der Artikel ist erstmals am 24. Oktober 2024 in PLOS Blogs - DNA Science Blog unter dem Titel " The Dangers of “Do Your Own Research” and “Believe in Science” https://dnascience.plos.org/2024/10/24/the-dangers-of-do-your-own-research-and-believe-in-science/erschienen und steht unter einer cc-by Lizenz. Die Autorin hat sich freundlicherweise mit der Übersetzung ihrer Artikel durch ScienceBlog.at einverstanden erklärt, welche so genau wie möglich der englischen Fassung folgt. Auf Grund seiner ungewöhnlichen Länge wurde hier allerdings nur der erste Teil des Artikels wiedergegeben und von der Redaktion mit einer Abbildung ergänzt

[1] Melanie Trecek-King: (2021)Thinking is Power -The problem with “doing your own research” https://thinkingispower.com/the-problem-with-doing-your-own-research/

[2] Sedona Chinn& Ariel Hasell (2023): Support for “doing your own research” is associated with COVID-19 misperceptions and scientific mistrust. Harvard Kennedy School Misinformation Review. 4, 3, DOI: https://doi.org/10.37016/mr-2020-117.

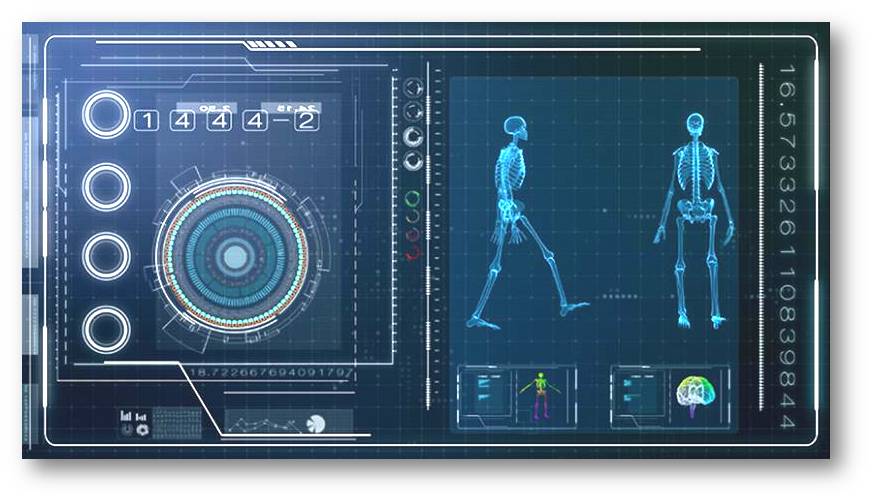

Gehirnaktivität bei körperlicher Bewegung - ein neues Verfahren bietet Einblicke in die Parkinson-Erkrankung

Gehirnaktivität bei körperlicher Bewegung - ein neues Verfahren bietet Einblicke in die Parkinson-ErkrankungDo, 24.10.2024 — Redaktion

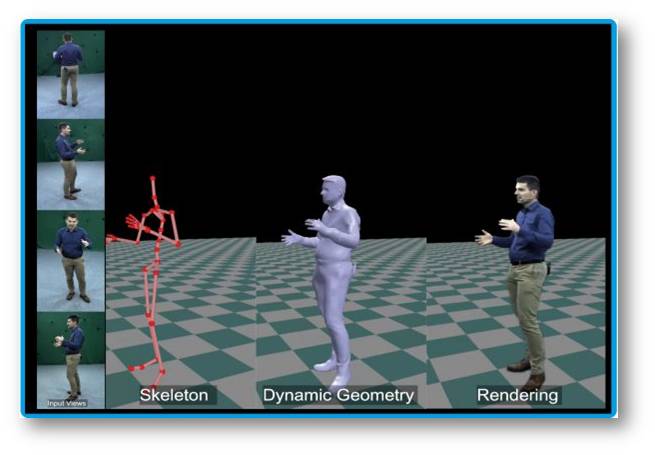

Mit dem kürzlich entwickelten integrativen mobilen Gehirn-/Körperbildgebungsverfahren MoBI (Mobile Brain/Body Imaging) lassen sich die Gehirn- und Muskeldynamik darstellen. Bei dem Verfahren werden mobile Elektroenzephalographie und Bewegungserfassung synchronisiert, um die Interaktion zwischen Gehirndynamik, Bewegung und Kognition bei menschlichen Bewegungen wie Gehen und Gleichgewicht halten oder dem Erlernen motorisch-kognitiver Abläufe zu untersuchen. Im Rahmen des EU-finanzierten Projekts TwinBrain hat ein internationales Forscherteam mit Hilfe von MoBI die Gehirnaktivitäten bei Bewegung verfolgt und konnte bereits frühe Anzeichen von Störungen der Gehirn-Körper-Koordination, wie sie bei der Parkinson-Krankheit auftreten erkennen.*

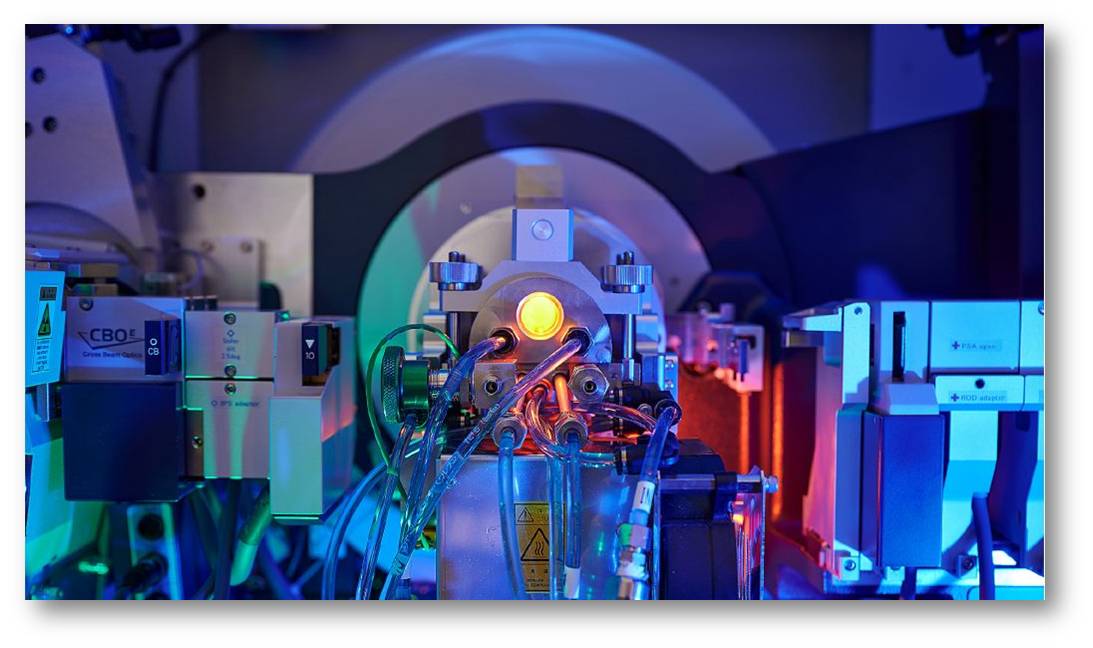

| EU-Projekt TwinBrain: Zusammenspiel von Muskel- und Hirnaktivität- (http://www.twinbrain.si/) |

Ein Durchbruch in der medizinischen Bildgebung hat es einem EU-finanzierten Forscherteam ermöglicht, die Gehirnaktivität während körperlicher Bewegung zu beobachten. Diese Arbeit soll den Weg für eine frühzeitige Erkennung der Parkinson-Krankheit und anderer neurologischer Störungen ebnen, von denen weltweit Millionen Menschen betroffen sind.

Bis vor kurzem bestand keine Möglichkeit zu beobachten, was im Gehirn während körperlicher Bewegung vor sich geht. Für Standard-Gehirnscans müssen sich die Probanden hinlegen und stillhalten; dies schränkt die Möglichkeiten der Wissenschafter ein, zu verstehen, wie das Gehirn alltägliche Situationen verarbeitet und darauf reagiert.

Dank der gemeinsamen Arbeit von Forschern im Rahmen von TwinBrain, einer dreijährigen, von der EU finanzierten und von slowenischen Wissenschaftern koordinierten Forschungsinitiative, konnte die Technologie, die dies ermöglicht, auf neue Gehirnregionen und neue Funktionen ausgedehnt werden.

Wir machen ständig Multitasking, fast ohne nachzudenken. Stellen Sie sich einfach vor, Sie gehen in den Supermarkt. Sie navigieren durch die Gänge auf der Suche nach den Artikeln auf Ihrem Einkaufszettel, halten dabei Ausschau nach den neuesten Schnäppchen und versuchen, nicht mit anderen Einkäufern zusammenzustoßen. EU-Forscher untersuchen nun solche alltäglichen Aktivitäten in der Hoffnung, wichtige Hinweise für die Erkennung und Behandlung schwerer neurologischer Krankheiten zu finden.

"Diese Situation mag für junge und gesunde Menschen sehr einfach erscheinen, aber sie verlangt dem Gehirn auch ein leistungsfähiges Multitasking ab", so Dr. Uroš Marušič, leitender wissenschaftlicher Mitarbeiter am Wissenschafts- und Forschungszentrum in Koper, Slowenien, und Leiter des neu eröffneten slowenischen Labors für mobile Bildgebung von Gehirn und Körper - SloMoBIL.

Verstehen des Zusammenspiels zwischen Muskeln und Gehirn

Marušič leitete die TwinBrain-Forschung, bei der die Dynamik von Gehirn und Bewegung auf eine bisher unerforschte Weise untersucht wurde. Die Initiative, die im Januar dieses Jahres abgeschlossen wurde, brachte Forscher der Technischen Universität Berlin in Deutschland, der Universität Triest in Italien und der Universität Genf in der Schweiz zusammen, um gemeinsam neue Wege in Diagnose und Behandlung komplexer neurologischer, die Bewegung beeinträchtigender Erkrankungen zu beschreiten. Dazu gehört auch die Parkinson-Krankheit, eine fortschreitende neurologische Erkrankung, von der weltweit mehr als 8 Millionen Menschen betroffen sind.

Mit steigendem Alter sind unsere neuronalen Ressourcen erschöpft, wodurch die so genannte kognitiv-motorische Interferenz zunimmt, d. h. wir können nicht mehr in gleicher Weise multitasken. Dies beeinträchtigt das, was Marušič als "Muskel-Hirn-Crosstalk" bezeichnet.

"Im Frühstadium der Parkinson-Krankheit kompensiert das Gehirn im Hintergrund Gleichgewichts- und Bewegungsdefizite", so Marušič, der auch ao. Professor für Kinesiologie an der Alma Mater Europaea Universität in Maribor (Slowenien) ist. Dies kann dazu führen, dass eine Person stolpert oder stürzt.

Die Forscher haben eine Technologie namens Mobile Brain/Body Imaging (MoBI) weiterentwickelt, die es ihnen ermöglicht, Gehirn und Körperbewegungen gleichzeitig zu überwachen. Ihre Arbeit wird es ermöglichen, verdächtige Anzeichen für neurologische Probleme zu erkennen und Behandlungen früher einzuleiten.

| Mobile Brain/Body Imaging (MoBI): Eine bahnbrechende Technologie, um die Gehirnaktivität während körperlicher Aktivität zu überwachen. © Tridsanu Thopet, Shutterstock.com |

MoBI wird im Berlin Brain/Body Imaging Lab (BEMoBIL) an der Technischen Universität Berlin eingehend untersucht. Dank TwinBrain wurde diese Technologie von Deutschland nach Slowenien transferiert und mit Unterstützung von Neurologen und Forschern aus Italien und der Schweiz weiterentwickelt.

"Sobald man Studienteilnehmer mit einer zusätzlichen kognitiven Aufgabe konfrontiert - beispielsweise mit einer Frage, während sie balancieren -, sehen wir, dass sie versuchen, zusätzliche neuronale Ressourcen zu aktivieren, aber sie können nicht immer alles verarbeiten", so Marušič.

Denken in Bewegung

Die MoBI-Technologie kombiniert die Technologie des Elektroenzephalogramms (EEG), einen Test, der die elektrische Aktivität im Gehirn bestimmt, mit der Elektromyografie (EMG), die die Muskelreaktion oder die elektrische Aktivität als Reaktion auf die Stimulation des Muskels durch einen Nerv misst. Außerdem wird die Motion-Capture-Technologie eingesetzt.

"Wir können jetzt messen, was im Gehirn vor sich geht, während man geht, läuft oder andere Arten von körperlicher oder geistiger Aktivität ausübt", so Marušič.

Marušič bezeichnet dies als einen der größten Erfolge der bisherigen Forschung, die aber auch eine enorme Big Data Herausforderung verursacht hat. Seit MoBI im Jahr 2021 nach Slowenien transferiert wurde, haben siebenundfünfzig Teilnehmer an den Tests teilgenommen. Für jede Sekunde der Aktivität wurden Hunderte von Messwerten erfasst, was zu Millionen von Datenpunkten führte. Diese werden nun mit Hilfe von künstlicher Intelligenz und einem Supercomputer synchronisiert und analysiert - ein Prozess, der bereits spannende Ergebnisse liefert.

Paolo Manganotti, Professor für Neurologie an der Universität Triest, war an der Rekrutierung und Testung von Freiwilligen für die TwinBrain-Studie beteiligt. Er stellte fest, dass die Teilnehmer nur zu gerne bereit waren, an der Studie teilzunehmen, um deren Ergebnisse nicht nur für sich selbst, sondern auch für künftige Patienten zu verbessern.

"TwinBrain bietet bahnbrechende Erkenntnisse für die klinische Praxis. Durch die Integration der neuesten Technologie können wir die Diagnose und Überwachung der Parkinson-Krankheit innerhalb weniger Jahre revolutionieren und die Zufriedenheit der Patienten und ihre Lebensqualität verbessern", so Manganotti.

Personalisierte Gesundheitsversorgung

Der nächste Schritt für Marušič ist die Vereinfachung und Optimierung der Technologie im Rahmen des neuen TBrainBoost-Projekts, das ebenfalls von der EU finanziert wird und bei SloMoBIL in Slowenien angesiedelt ist. Diesmal mit neuen Forschungspartnern aus Belgien, Deutschland, Malta und Slowenien.

Dies wird die Entwicklung neuer Produkte auf der Grundlage der MoBI-Technologie für einen breiteren klinischen Einsatz zugunsten von Patienten mit neurologischen Erkrankungen ermöglichen. Es festigt auch die Rolle von SloMoBIL als regionales Exzellenzzentrum für die Forschung in diesem Bereich.

Langfristig hofft Marušič, dass dies zu einer besseren und früheren Behandlung der Parkinson-Krankheit und anderer neurologischer Erkrankungen sowie zu einer stärker personalisierten Gesundheitsversorgung führen wird.

"Ich möchte, dass die Patienten an einen Ort kommen können, an dem alle Probleme gleichzeitig behandelt werden. Personalisierte Zentren, die Diagnostik und Behandlungen anbieten, die auf ihre Bedürfnisse zugeschnitten sind - ein Ort, der alles bietet", sagt er.

*Dieser Artikel wurde ursprünglich am 3. September 2024 von Andrew Dunne in Horizon, the EU Research and Innovation Magazine unter dem Titel "Brain on the move – studying the brain in motion offers new insights into Parkinson’s disease" - https://projects.research-and-innovation.ec.europa.eu/en/horizon-magazine/brain-move-studying-brain-motion-offers-new-insights-parkinsons-disease - publiziert. Der unter einer cc-by-Lizenz stehende Artikel wurde von der Redaktion möglichst wortgetreu aus dem Englischen übersetzt. Die erste Abbildung wurde von der Redaktion der Webseite des TwinBrain-Projekts http://www.twinbrain.si/ entnommen.

TWINning the BRAIN with machine learning for neuro-muscular efficiency:https://cordis.europa.eu/project/id/952401/de?isPreviewer=1

Laboratory of the Institute for Kinesiology Research, SloMoBIL laboratory (Slovenian Mobile Brain/Body Imaging Laboratory, Koper) https://www.zrs-kp.si/en/institutes-and-units/laboratory-of-the-institute-for-kinesiology-research/

TwinBrain project - short documentary, 2023,Video 7:10 min. https://www.youtube.com/watch?v=Vm42f2cIJw0&t=3s

TwinBrain EU project - promo video April 2022, Video 1:54 min. https://www.youtube.com/watch?v=3rnnEfDZHAI&t=61s

Berlin Mobile Brain/Body Imaging Lab (BeMoBIL): https://www.tu.berlin/bpn/forschung/berlin-mobile-brain-body-imaging-lab

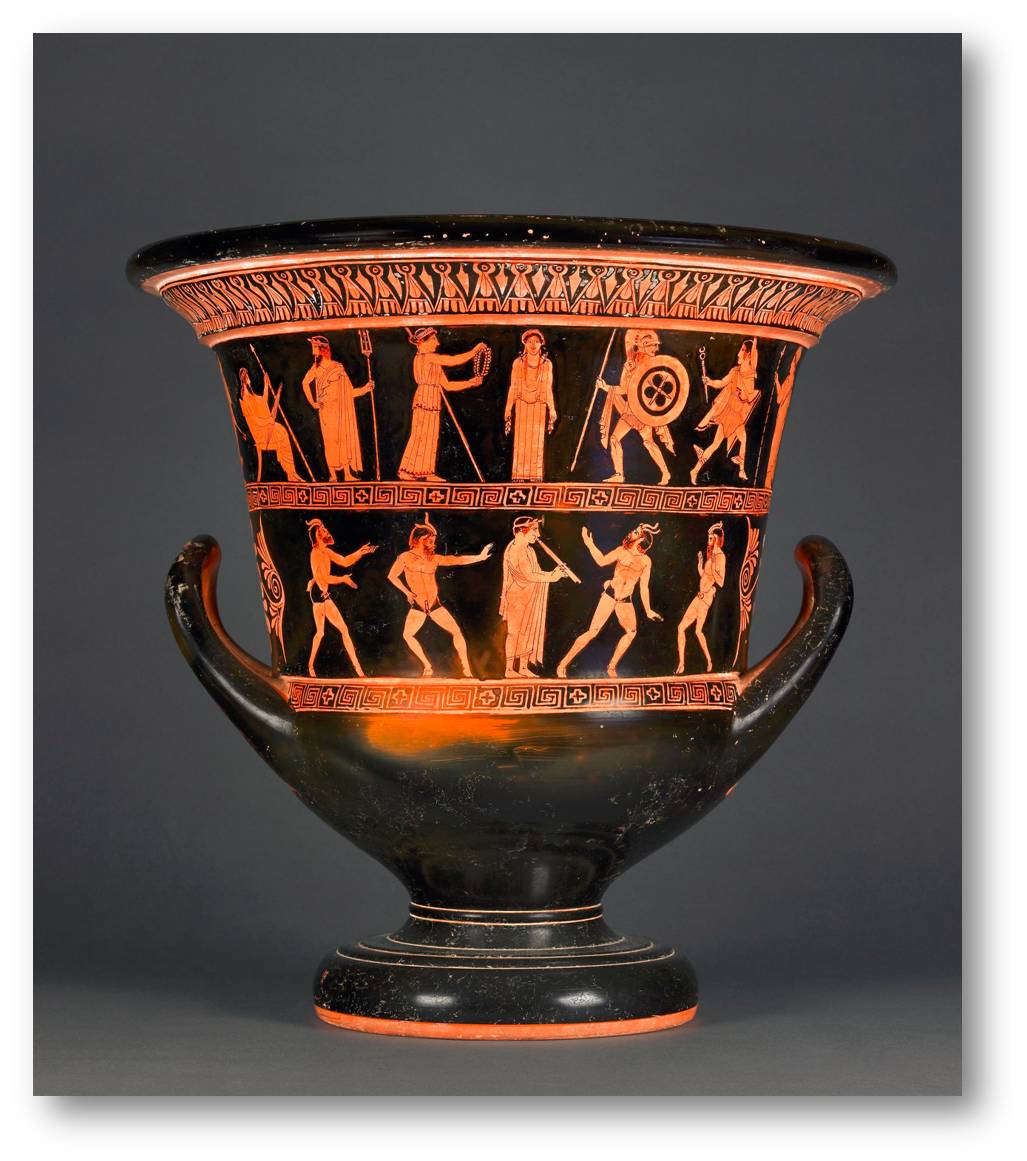

Künstliche Intelligenz - Artikelsammlung im ScienceBlog

Künstliche Intelligenz - Artikelsammlung im ScienceBlogSa, 19.10.2024— Inge Schuster

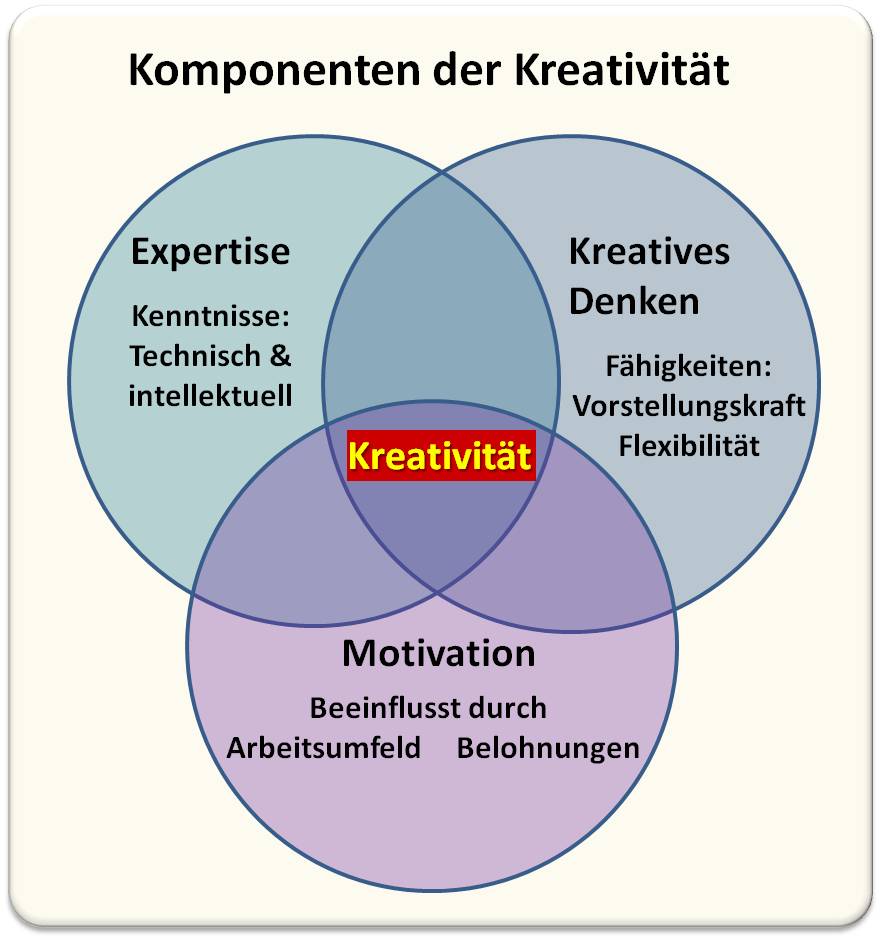

„Künstliche Intelligenz (KI) ist die Fähigkeit einer Maschine, menschliche Fähigkeiten wie logisches Denken, Lernen, Planen und Kreativität zu imitieren.“ (Europäisches Parlament, Webseite). In rasantem Tempo hat sich die KI-Forschung von einem teilweise als Science Fiction belächelten Gebiet zum unverzichtbaren, effizienten Werkzeug in Wissenschaft und Wirtschaft entwickelt und in zunehmendem Maße auch in unserem Alltag Einzug gehalten. Seit mehr als zehn Jahren wird im ScienceBlog über Erfordernisse, Anwendungen aber auch Risiken der KI informiert. Der folgende Bericht ist eine Zusammenstellung der bereits sehr umfangreichen Artikelsammlung, die laufend ergänzt werden soll.

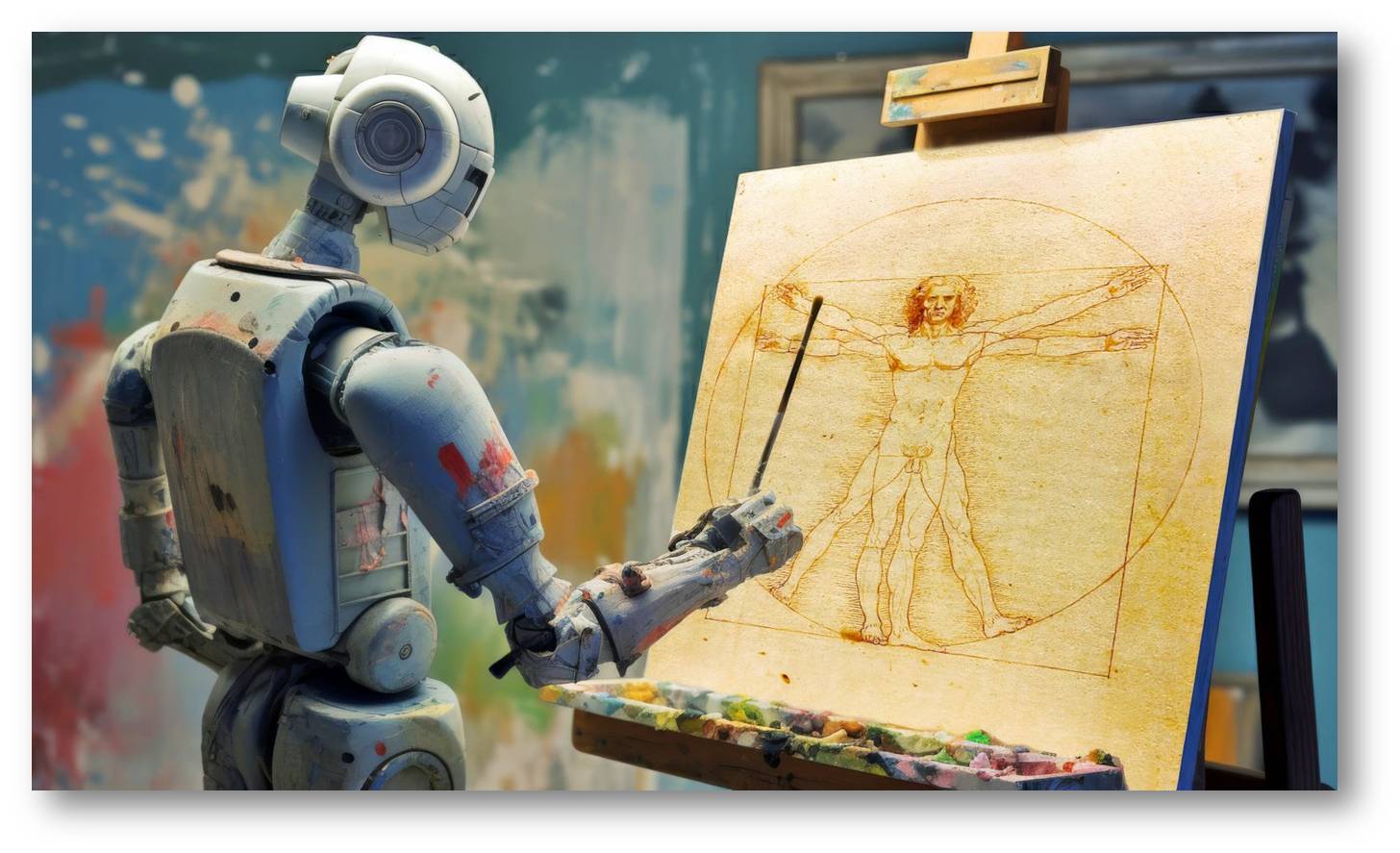

Von der uralten Vision.....

Seit jeher besteht der Wunsch künstliche, dem Menschen an Fähigkeiten gleichende Kreaturen zu schaffen. So berichtet die griechische Mythologie von Hephaistos, dem Gott der Kunstfertigkeit, der u.a. auf Geheiß des Göttervaters Zeus die wunderschöne, mit allen positiven Eigenschaften versehene weibliche Figur, Pandora, aus Lehm fabrizierte (Abbildung 1). Mit Hilfe dieses unwiderstehlichen Wesens wollte Zeus aber die Menschen für den Diebstahl des Feuers durch Prometheus bestrafen; Pandora sollte Epimetheus, den erst im Nachhinein denkendenBruder des Prometheus verführen und von Neugier geplagt einen Krug öffnen, der mit allem Leid und Übel gefüllt war. Neugier und fehlendes Überlegen möglicher Folgen führten dazu, dass sich alles Böse über die Erde ergoss - eine auch für unsere heutige Wissenschaft gültige Metapher.

| Abbildung 1. Pandora - eine Metapher für von Neugier getriebenes vorschnelles Handeln. Vase aus dem 5 Jh- v.Chr, Oben: Pandora (Mitte) wird von den Göttern mit allen positiven Atrtributen versehen; untere Reihe : Tanzende Satyren. (Bild: British Museum, London (CC BY-NC-SA 4.0) |

Die Literatur ist voll von weiteren fiktiven Kreationen. Einige hervorstechende Beispiele sind der im 12. Jahrhundert vom Prager Rabbi Löw aus Lehm mittels eines Buchstabencodes geschaffene Golem, ein Befehlsempfänger ohne eigenen freien Willen, die im 19. Jh. von E.T.A. Hoffmann im Sandmann beschriebene Puppe Olimpia oder Mary Shelley's Frankenstein. Einige Darstellungen haben die realen Entwicklungen der künstlichen Intelligenz vorweg genommen.

............ zum Forschungsgebiet

Der Anfang des Forschungsgebiets Künstliche Intelligenz ist mit der Dartmouth Conference (New Hampshire) im Jahr 1956 festzusetzen. Die Konferenzteilnehmer - u.a. Marvin Minsky, Claude Shannon und John Mc Carthy - waren über Jahrzehnte hinweg führend in der KI-Forschung. In einem Antrag auf Förderung an die Rockefeller Foundation schrieben die Initiatoren: „Wir schlagen vor, im Laufe des Sommers 1956 über zwei Monate ein Seminar zur künstlichen Intelligenz mit zehn Teilnehmern am Dartmouth College durchzuführen. Das Seminar soll von der Annahme ausgehen, dass grundsätzlich alle Aspekte des Lernens und anderer Merkmale der Intelligenz so genau beschrieben werden können, dass eine Maschine zur Simulation dieser Vorgänge gebaut werden kann. Es soll versucht werden, herauszufinden, wie Maschinen dazu gebracht werden können, Sprache zu benutzen, Abstraktionen vorzunehmen und Konzepte zu entwickeln, Probleme von der Art, die zurzeit dem Menschen vorbehalten sind, zu lösen, und sich selbst weiter zu verbessern. Wir glauben, dass in dem einen oder anderen dieser Problemfelder bedeutsame Fortschritte erzielt werden können, wenn eine sorgfältig zusammengestellte Gruppe von Wissenschaftlern einen Sommer lang gemeinsam daran arbeitet.“ (http://www-formal.stanford.edu/jmc/history/dartmouth/dartmouth.htm).

Die Hauptthemen dieses Workshops zeigten - neben Informatik und Mathematik - bereits viele, aus verschiedenen Forschungsrichtungen stammende Teildisziplinen. Anfängliche Erfolge beim Lösen einfacher mathematischer Probleme oder im Schachspiel führten zu überoptimistischen Einschätzungen. Einer der Pioniere in KI, Marvin Minsky meinte 1970: "In 3 bis 8 Jahren werden wir eine Maschine mit der allgemeinen Intelligenz eines Durchschnittsmenschen haben." Die Enttäuschung folgte. Es fehlten damals noch ausreichende Computerkapazitäten zur Verarbeitung und Speicherung von Daten. Die anfängliche Hype brach in sich zusammen, es kam zu einer "Eiszeit" der KI.

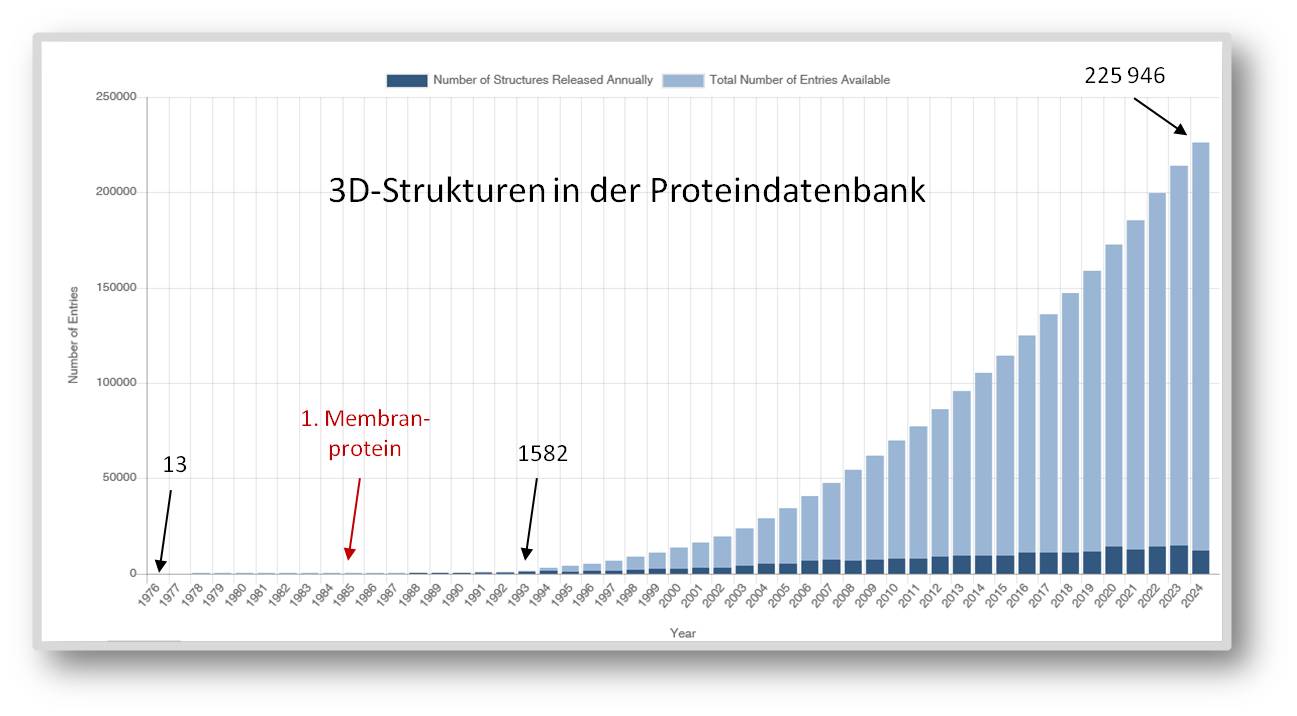

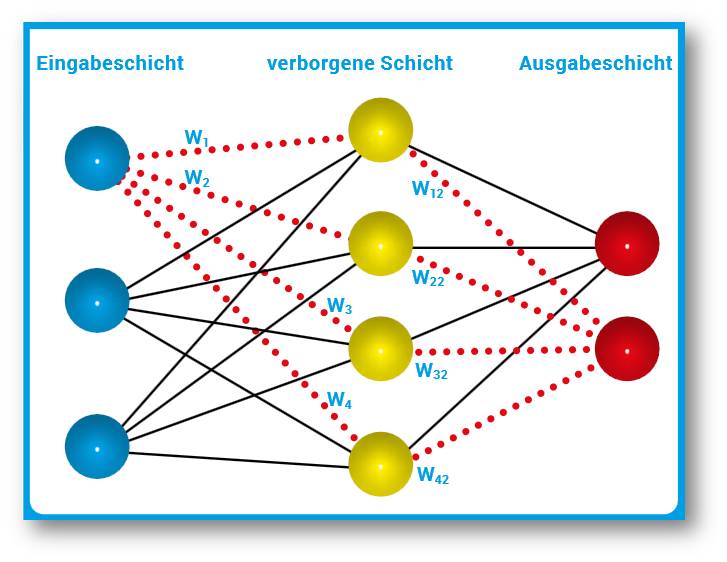

Erst mit dem exponentiellen Anstieg der Computerleistung und neuen Technologien, die nicht nur in den Lebenswissenschaften zu einem explosionsartigen Anstieg von gespeicherten Datenmengen - den Big Data - führten, erlebte die KI ab den 1990er Jahren eine Renaissance. Auf der Basis von Maschinellem Lernen und dem vom diesjährigen Physik-Nobelpreisträger Geoffrey Hinton entwickelten tiefen Neuronalen Netzwerk, dem Deep Learning, ermöglichten nun Datenbanken die Erkennung von Mustern in riesigen, komplexen wissenschaftlichen Datensätzen.

---------- und unverzichtbarem Werkzeug in Forschung, Industrie und Alltag

Wir stehen am Beginn eines neuen, durch maschinelle Intelligenz geprägten Zeitalters. In vielen unserer Lebensbereiche gibt es bereits künstliche Unterstützung - dies reicht vom allgegenwärtigen Smartphone, Übersetzungstools und dem immer häufiger genutzten Sprachmodell ChatGPT, über Ansätze zum autonomen Fahren und in Dienstleistungsbereichen eingesetzte Roboter bis zu präziser medizinischer Diagnostik und Einsatz von Implantaten für immer mehr Körperfunktionen. Einige Beispiele sind in Abbildung 2 zusammengefasst.

| Abbildung 2. Künstliche Intelligenz – Nutzen im Alltag und mögliche Einsatzgebiete. (© Europäische Union, [20-06-2023 ] – Quelle: Europäisches Parlament) /em> |

In vielen naturwissenschaftlichen Disziplinen hat sich die Künstliche Intelligenz bereits gut etabliert. KI ist aus Biologie und medizinischer Diagnostik nicht mehr wegzudenken; die in Genanalyse, Mikroskopie, Computertomographie und MRI-Analyse anfallenden enormen Datenmengen können nun schnell verarbeitet werden und aussagekräftige Muster/Diagnosen liefern. Auch in der Suche nach neuen Wirkstoffen und nach Systemen, die Umweltgifte abbauen, spielt die KI eine wichtige Rolle. In den Geowissenschaften wird KI eingesetzt, um belastbare Vorhersagen über die Auswirkungen von Klimaextrema zu erhalten und die Gesellschaften dagegen widerstandsfähiger zu machen. Die Liste könnte fast endlos fortgesetzt werden.

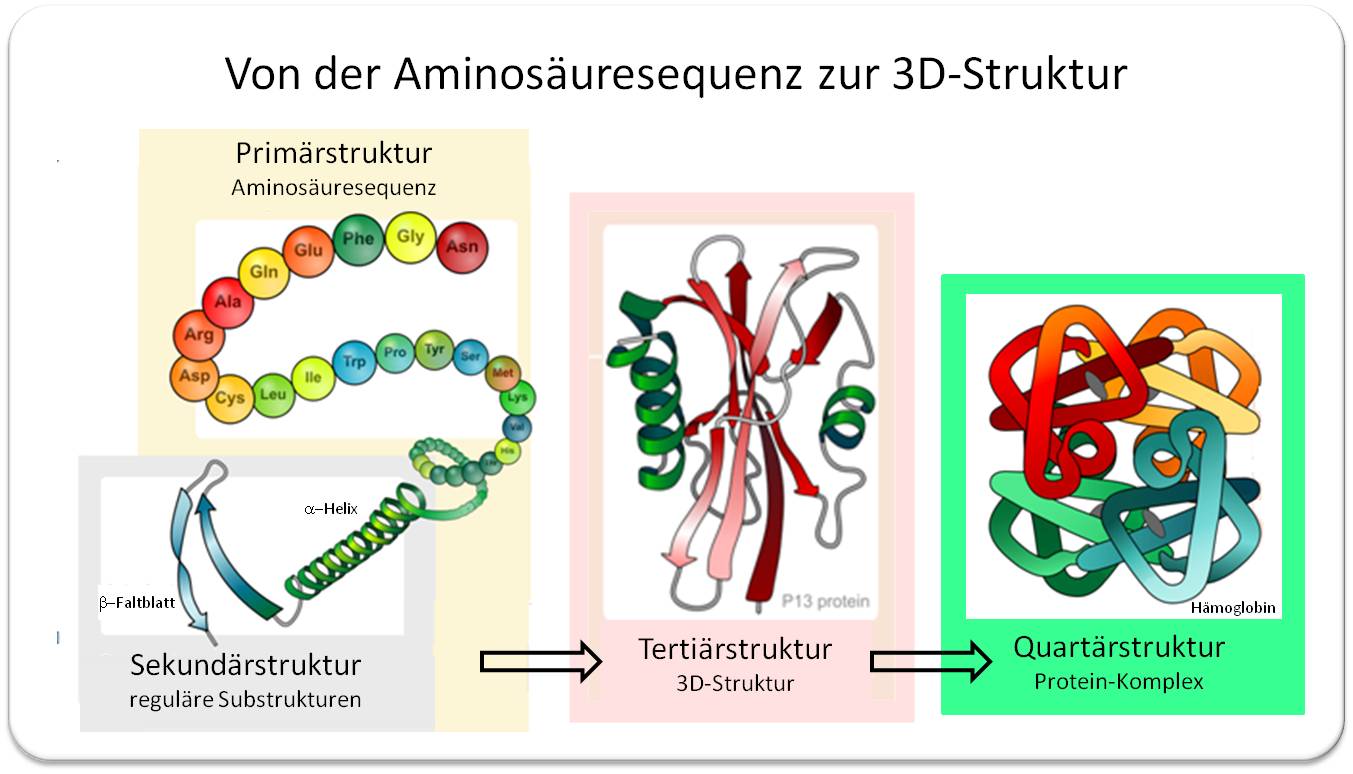

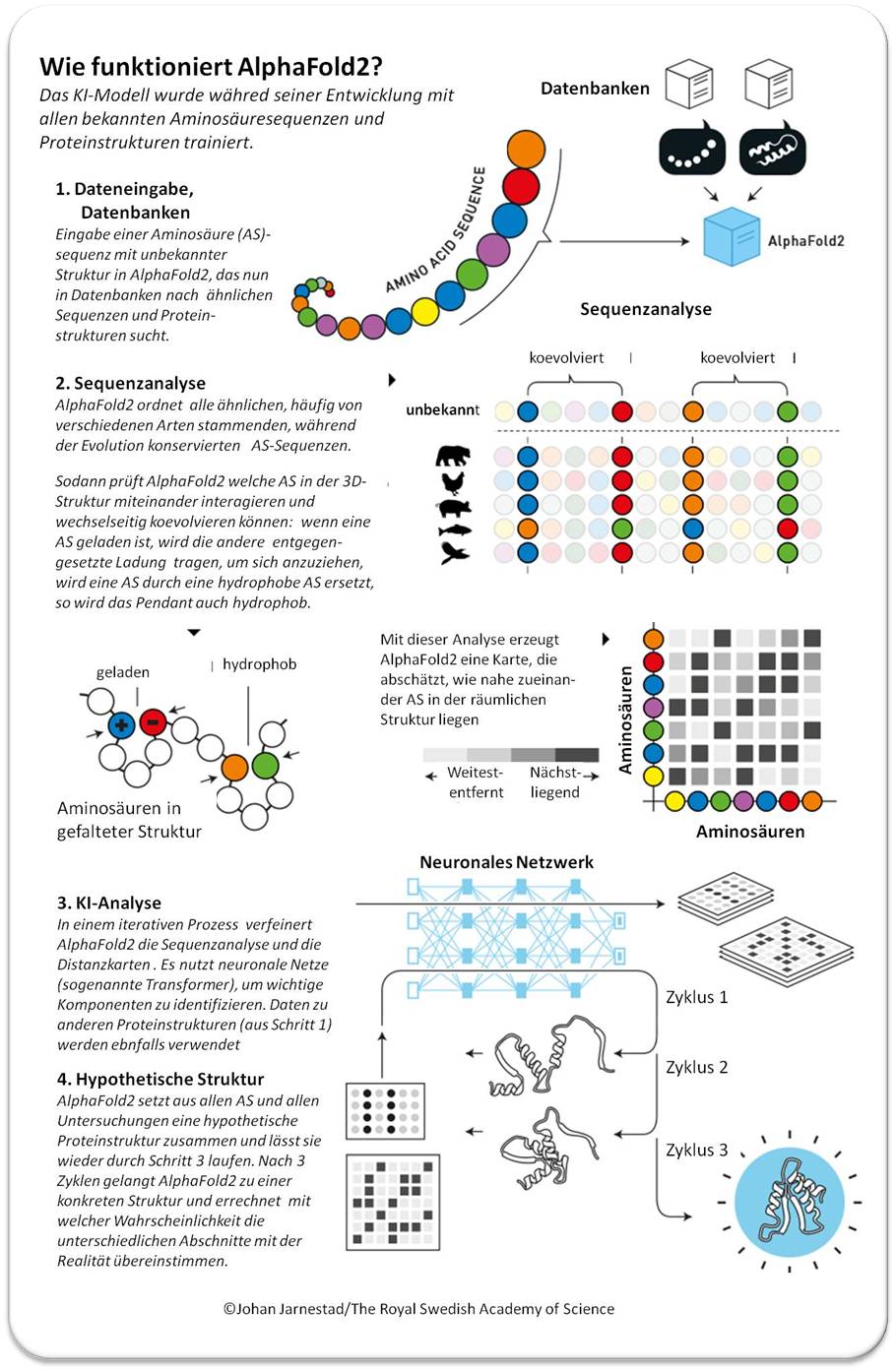

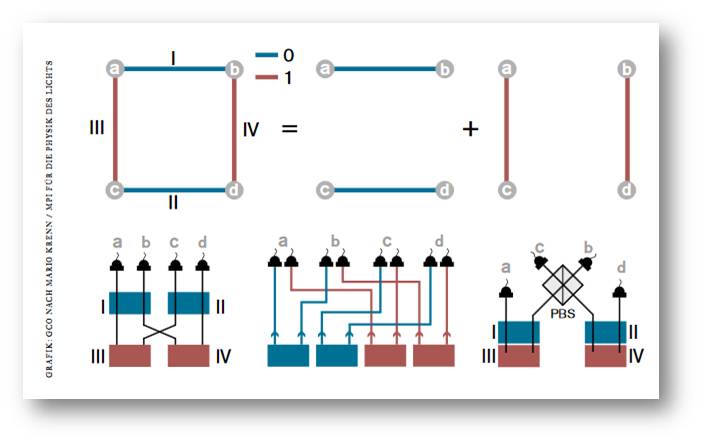

Welche Bedeutung Künstliche Intelligenz (KI) heute in Wissenschaft, Wirtschaft und Gesellschaft hat, lässt sich wohl am besten daran zu erkennen, dass der Nobelpreis 2024 sowohl in Physik als auch in Chemie für Pionierleistungen in diesem Gebiet vergeben wurde. Die Physik-Preisträger John Hopfield (USA) und Geoffrey Hinton (Kanada) waren Wegbereiter, die für »bahnbrechende Entdeckungen und Erfindungen, die maschinelles Lernen mit künstlichen neuronalen Netzen ermöglichen« ausgezeichnet wurden. Darauf aufbauend ist es den Chemie-Preisträgern Demis Hassabis (UK) und John Jumper (UK) gelungen mit ihrem KI-Modell AlphaFold2 die räumliche Struktur praktisch aller Proteine mit hoher Genauigkeit aus den Aminosäuresequenzen vorherzusagen; David Baker (US) hat mit Rosetta ein Computerprogramm zum Design von völlig neuen Proteinen mit speziellen Eigenschaften entwickelt. Die nun ausgezeichneten KI-gestützten Technologien sind öffentlich frei zugänglich und wurden in den wenigen Jahren seit ihrer Freigabe bereits von Millionen Forschern für "unzählige" Fragestellungen des Proteindesigns und der Strukturvorhersage genutzt. Die Ergebnisse werden wohl unsere Welt verändern.

Wo viel Licht ist, ist auch Schatten

In zunehmendem Maße wird Kritik laut, dass KI sich auch zu einer dunklen Seite entwickeln kann. So meint der Evolutionsbiologe Paul Rainey: "Wie Viren oder andere invasive Organismen den Menschen, die Umwelt und sogar den Planeten bedrohen können, besteht auch die reale Gefahr, dass vermehrungsfähige KI unbeabsichtigte negative Auswirkungen auf den Menschen und die Erde hat. Sie könnte sich unkontrolliert verbreiten, die Ressourcen der Erde erschöpfen und die Ökosysteme schädigen" (Paul Rainey, 2023).

Schärfer formuliert es das Center for AI Safety, dem neben anderen prominenten KI-Forschern auch der diesjährige Chemie Nobelpreisträger Demis Hassabis angehört, in einem Aufruf im Jahr 2023: "Die Minderung des Risikos für eine Auslöschung der Menschheit durch künstliche Intelligenz sollte neben anderen Risiken von gesellschaftlichem Ausmaß wie Pandemien und Nuklearkrieg eine globale Priorität haben“.

Auch der diesjährige Physik-Nobelpreisträger Geoffrey Hinton warnt vor der Technologie, die er miterschaffen hat, weil sie die Menschen überfordern, durch kriegerische Anwendungen und poltische Manipulationen sogar gefährden könne.

Die eingangs erwähnte Metapher von der Neugier-getriebenen Nutzung einer Technologie ohne Überlegen der möglichen Folgen sollte bedacht werden, um nicht eine Büchse der Pandora zu öffnen.

Artikel im ScienceBlog über Erfordernisse für und Anwendungen von Künstlicher Intelligenz

Nestor C. Tandina,24.07.2025: Wie Large Language Models funktionieren - Eine Einführung für Neugierige

Redaktion, 13.07.2025: Macht uns die Nutzung von ChatGPT denkfaul?