Do. 30.03.2023 — Redaktion

![]()

Weltweit arbeiten Forscher daran, um aus der menschlichen Hirnaktivität mit Hilfe künstlicher Intelligenz zu verstehen, wie das Gehirn die Welt darstellt. Japanische Forscher von der Universität Osaka haben nun erstmals den im August 2022 eingeführten Text-Bild-Generator Stable Diffusion zur Interpretation der in einem funktionellen Magnetresonanztomographen (fMRI) erzeugten Gehirnscans menschlicher Probanden verwendet, die bestimmte Bilder betrachteten. Die Ergebnisse sind verblüffend - die mit KI aus den Gehirnscans nachgebildeten Bilder stimmten zu 80 % mit den betrachteten Originalen (in Farbe, Form, Inhalt, Bedeutung) überein. Die Technologie steckt allerdings noch in den Kinderschuhen und wurde erst mit wenigen Personen getestet. Eines Tages könnte sie aber Menschen helfen, zu kommunizieren oder Träume entschlüsseln, sagen die Forscher.*

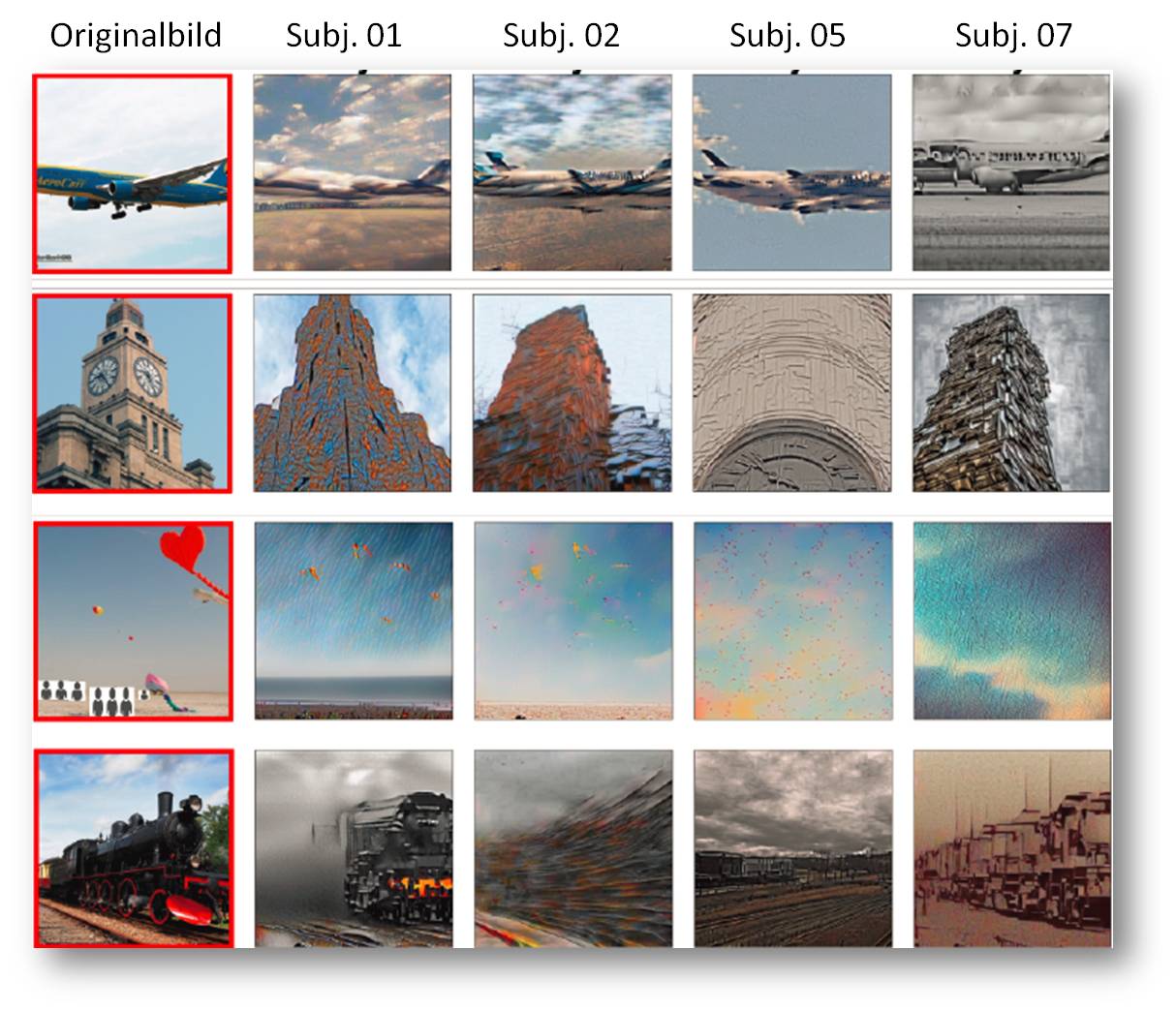

Es klingt wie ein Science-Fiction-Roman: Forscher von der Universität Osaka haben erfolgreich ein System der künstlichen Intelligenz (KI) trainiert, das Bilder, die sich Menschen angesehen haben, auf der Grundlage ihrer Gehirnscans nachbildet. Die KI hat Bilder von Objekten generiert wie u.a. von einem Teddybär, einem Uhrenturm und einem Flugzeug, nachdem die Teilnehmer ähnliche Bilder gesehen hatten. Abbildung 1.

| Abbildung 1. Gezeigte Bilder (roter Kasten, obere Reihe) und aus fMRI-Signalen rekonstruierte Bilder (grauer Kasten, untere Reihe) für einen Probanden (subj01) . (Quelle: Takagi und Nishimoto /bioRxiv, 2022 [1]; Lizenz: cc-by) |

"Die Genauigkeit dieser neuen Methode ist beeindruckend", sagt Iris Groen, eine Neurowissenschaftlerin an der Universität Amsterdam, die nicht an der Forschung beteiligt war, zu Kamal Nahas vom Fachjournal Science.

Die Technologie, die Gehirnscans in Bilder umwandelt, ist zwar noch auf lange Zeit nicht für den öffentlichen Einsatz bereit, könnte sich aber eines Tages als nützlich erweisen, um zu verstehen, was in den Köpfen der Menschen vor sich geht, so die Forscher. Sobald die Wissenschaftler das Konzept weiter verfeinert haben, könnten Ärzte es dann einsetzen, um Menschen, die z. B. an Lähmungen leiden, bei der Kommunikation zu helfen. Es könnte auch Neurowissenschaftlern helfen, Träume zu interpretieren oder sogar zu verstehen, wie andere Spezies die Welt um sie herum wahrnehmen.

Die Forscher der Universität Osaka in Japan gehören zu den Wissenschaftlern, die KI einsetzen, um menschliche Gehirnscans zu verstehen. Ihr Ansatz ist dabei der erste, der den Text-Bild-Generator Stable Diffusion verwendet, der im August 2022 in die schnell wachsende KI-Szene eingeführt wurde. Ihr Modell ist auch viel einfacher, da es nur Tausende statt Millionen von Parametern oder Werten benötigt, die beim Training gelernt werden.

Details dazu hat das Team in einer neuen Arbeit auf dem Preprint-Server bioRxiv veröffentlicht (die Arbeit ist derzeit noch nicht begutachtet) [1]. Wie Science berichtet plant das Team, seine Ergebnisse auf einer bevorstehenden Konferenz zum Thema Computer Vision zu präsentieren.

Wie funktioniert das Ganze also?

Normalerweise gibt ein Benutzer ein Wort oder einen Satz ein, das Stable Diffusion - oder andere ähnliche Technologien wie DALL-E 2 (siehe Videos, unten) und Midjourney - in ein Bild umwandelt. Dieser Prozess funktioniert, weil die KI-Technologien viele vorhandene Bilder und die dazugehörigen Textbeschriftungen studiert haben - mit der Zeit ermöglicht dieses Training der Technologie, Muster zu erkennen, die sie dann auf der Grundlage einer Eingabeaufforderung neu erstellen kann.

Die Forscher gingen bei diesem Training noch einen Schritt weiter, indem sie einem KI-Modell beibrachten, funktionelle Magnetresonanztomographie-Daten (fMRI) mit Bildern zu verknüpfen. Genauer gesagt verwendeten die Forscher die fMRI- Scans von vier Teilnehmern, die sich im Rahmen einer früheren, nicht in Zusammenhang stehenden Studie 10 000 verschiedene Bilder von Menschen, Landschaften und Objekten angesehen hatten. Außerdem trainierten sie ein zweites KI-Modell, um die Gehirnaktivität in den fMRT-Daten mit Textbeschreibungen der Bilder zu verknüpfen, welche die Studienteilnehmer betrachteten.

Mit diesen beiden Modellen konnte Stable Diffusion die fMRI-Daten in relativ genaue Imitationen von Bildern umwandeln, die nicht Teil des KI-Trainingssets waren. Abbildung 2. Auf der Grundlage der Gehirnscans konnte das erste Modell die Perspektive und das Layout, das der Teilnehmer gesehen hatte, nachbilden, aber die erzeugten Bilder zeigten wolkige und unspezifische Figuren. Doch dann kam das zweite Modell zum Einsatz und konnte anhand der Textbeschreibungen aus den Trainingsbildern erkennen, auf welches Objekt die Personen blickten. Erhielt es also einen Gehirnscan, der einem der Trainingsbilder ähnelte, das als eine Person markiert war, die ein Flugzeug betrachtete, setzte es ein Flugzeug in das generierte Bild ein und folgte dabei der Perspektive des ersten Modells. Die Technologie erreichte eine Genauigkeit von etwa 80 Prozent.

| Abbildung 2. Die Originalbilder (links) und die von der KI generierten Bilder für alle vier Teilnehmer. (Quelle: Takagi und Nishimoto /bioRxiv, 2022 [1]; Lizenz: cc-by) |

In der Tat sehen die nachgebildeten Bilder den Originalen unheimlich ähnlich, wenn auch mit einigen deutlichen Unterschieden. Die von der KI generierte Version einer Lokomotive ist beispielsweise in einen düsteren grauen Nebel gehüllt, anstatt den fröhlichen, hellblauen Himmel des tatsächlichen Bildes zu zeigen. Und die KI-Darstellung eines Uhrenturms sieht eher wie ein abstraktes Kunstwerk aus als ein echtes Foto.

Grenzen der Technologie

Die Technologie ist vielversprechend, aber sie hat noch einige Grenzen. Sie kann nur Bilder von Objekten nachbilden, die in ihrem Schulungsmaterial enthalten sind. In der beschriebenen Studie hat die künstliche Intelligenz die Gehirnaktivität von nur vier Personen verarbeitet; das Modell müsste aber mit den Gehirnscans jeder neuen Person neu trainiert werden - ein teurer und zeitaufwändiger Prozess. Daher ist es unwahrscheinlich, dass die Technologie für die breite Öffentlichkeit zugänglich wird - zumindest nicht in ihrer derzeitigen Form.

"Das ist für den täglichen Gebrauch überhaupt nicht praktikabel", sagt Sikun Lin, ein Informatiker an der University of California Santa Barbara, der nicht an dem Projekt beteiligt war, gegenüber Carissa Wong von New Scientist.

Ganz allgemein betrachtet gibt es dazu größere Bedenken gegenüber KI-Technologien:

- Inwieweit ist dies ein Diebstahl an menschlichen Künstlern, inwieweit werden Urheberrechtsgesetze verletzt?

- Wird die Polizei dadurch voreingenommener gegenüber bestimmten Personengruppen,

- Inwieweit trägt KI zu Fehlinformationen bei oder zur Verletzung unserer Privatsphäre?

Mit diesen und vielen anderen Fragen beschäftigen sich Ingenieure und Ethiker, und die Diskussionen werden wahrscheinlich noch für absehbare Zeit weitergehen, selbst wenn Wissenschaftler neue - und potenziell nützliche - Möglichkeiten für den Einsatz von KI entwickeln.

"Wenn es um sehr leistungsfähige Technologien geht - und offensichtlich wird die KI eine der leistungsfähigsten überhaupt sein - müssen wir vorsichtig sein", sagt Demis Hassabis, CEO des KI-Forschungslabors DeepMind, im vergangenen Jahr zu Billy Perrigo vom Time Magazine. "Es ist wie bei Experimentatoren, von denen viele nicht wissen, dass sie gefährliches Material in der Hand haben."

[1] Yu Takagi & Shinji Nishimoto: High-resolution image reconstruction with latent diffusion models from human brain activity. bioRxiv preprint doi: https://doi.org/10.1101/2022.11.18.517004

*Der vorliegende Artikel von Sarah Kuta ist unter dem Titel "This A.I. Used Brain Scans to Recreate Images People Saw" https://www.smithsonianmag.com/smart-news/this-ai-used-brain-scans-to-recreate-images-people-saw-180981768/ am 9. März 2023 im Smithsonian Magazin erschienen. Der Artikel wurde von der Redaktion möglichst wortgetreu übersetzt.

Smithsonian Institution (Smithsonian, , https://www.si.edu/) ist eine bedeutende US-amerikanische Forschungs- und Bildungseinrichtung, die auch zahlreiche Museen, Galerien und den Nationalzoo betreibt. Das Smithsonian stellt seine komplette Sammlung nach und nach in elektronischer Form (2D und teilweise 3D) unter der freien CC-0-Lizenz kostenlos zur Weiterverbreitung zur Verfügung. Das Smithsonian Magazine (aus dem der obige Artikel stammt) bringt eine Fülle faszinierender, leicht verständlicher Artikelaus allen Bereichen der Natur und der Gesellschaften. https://www.smithsonianmag.com/?utm_source=siedu&utm_medium=referral&utm_campaign=home.

Weiterführende Links

Stable Diffusion Public Release (22.08.2022); ein Deep-Learning-Text-zu-Bild-Generator. Das Open-Source-Programm wird hauptsächlich zur Generierung detaillierter Bilder auf der Grundlage von Textbeschreibungen verwendet. https://stability.ai/blog/stable-diffusion-public-release

Stability AI Launch. Video 52:50 min. https://www.youtube.com/watch?v=S3qlqY_sOPw

DALL•E 2 Explained (06.04.2022). Video 2:46 min. . https://www.youtube.com/watch?v=qTgPSKKjfVg. DALL•E 2 is a new AI system that can create realistic images and art from a description in natural language

DALL-E 2 Tutorial für Anfänger | Bilder erstellen & bearbeiten mit Künstlicher Intelligenz. Video 14:28 min.https://www.youtube.com/watch?v=sZ_n1vV0aJY . Kostenlos Bilder aus Worten generieren lassen mit der KI von Openai. Dalle kann aber noch mehr als das.

- Printer-friendly version

- Log in to post comments