2013

2013 Redaktion Wed, 20.03.2019 - 01:02Der ScienceBlog zum Jahreswechsel 2013/2014

Der ScienceBlog zum Jahreswechsel 2013/2014Fr, 27.12.2013 - 15:57 — Redaktion

“The distinctive character of our own time lies in the vast and constantly increasing part, which is played by natural knowledge. Not only is our daily life shaped by it, not only does the prosperity of millions of men depend on it, but our whole theory of life has long been influenced, consciously or unconsciously, by the general conceptions of the universe, which has been forced upon us by physical science.” Aus: Thomas H. Huxley (1882), Science and Culture

“The distinctive character of our own time lies in the vast and constantly increasing part, which is played by natural knowledge. Not only is our daily life shaped by it, not only does the prosperity of millions of men depend on it, but our whole theory of life has long been influenced, consciously or unconsciously, by the general conceptions of the universe, which has been forced upon us by physical science.” Aus: Thomas H. Huxley (1882), Science and Culture

Abb.: Kaleidoskop; Artwork von Eric Taylor zum Debut-Album »Blue Siberia« des Rock-Trios »Star FK Radium«.

Dem obigen Zitat des britischen Biologen und Verfechter der Darwin’schen Evolutionstheorie T. H. Huxley merkt man wohl nicht an, dass es bereits 131 Jahre alt ist. Naturwissenschaften – ihre Grundlagen und Anwendungen – nehmen bei Huxley einen ungeheuer hohen Stellenwert ein, sie formen Leben und Weltbild des Einzelnen, wie das ganzer großer Gesellschaften.

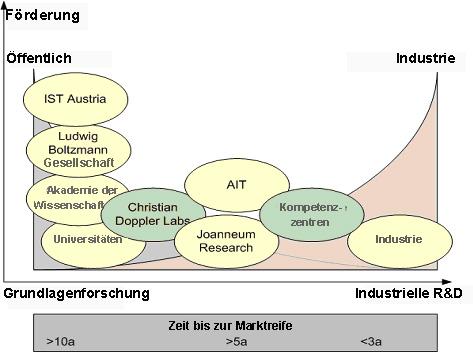

Der Stellenwert der Naturwissenschaften in Österreich

Es erübrigt sich festzustellen, dass unser heutiges Leben in einem noch viel höherem Maße durch Naturwissenschaften und Technik geprägt ist. Dennoch begegnen weiteste Bevölkerungsschichten in unserem Land diesen Wissenszweigen mit Verständnislosigkeit, Desinteresse und Ablehnung, stufen sie bestenfalls als irrelevant für ihr eigenes Leben ein [1,2]. Der minimale Stellenwert, der bei uns der Wissenschaft ganz allgemein zugewiesen wird, kommt aktuell auch in der Ressortaufteilung des neuen Regierungsprogramms zum Ausdruck, in der blamablen Einsparung eines eigenständigen Ministeriums für Wissenschaft und Forschung (siehe auch unseren vorwöchigen Artikel „Quid pro quo?“[3]). Rot-schwarzes Schachbrettdenken hat es nicht erlaubt, Wissenschaftsagenda, Grundlagen- und Angewandte Forschung, die über zahlreiche Ministerien, insbesondere dem Ministerium für Verkehr, Innovation und Technologie, verstreut sind, in einem einzigen Wissenschaftsministerium zu bündeln. Damit ist wohl für die nächsten Jahre die Chance vertan, eine zeitgemäße Struktur der Forschungsagenda zu etablieren, in der die Förderungen von Projekten transparent, leistungsbezogen und dennoch ressourcenschonend vergeben werden.

Fehlende Bildungsstandards…

Der niedrige Stellenwert der Wissenschaft, vor allem der Naturwissenschaften, wird aber auch aus den „Bildungsplänen“ für die heranwachsende Jugend ersichtlich, aus der Wissenschaftsberichterstattung und -kommunikation für die Erwachsenen:

In Schulen existieren nach wie vor keine Bildungsstandards für Naturwissenschaften, darüber, was ein Pflichtschulabgänger, was ein Absolvent der AHS wissen sollte (siehe Bifie Bildungsstandards). In den Lehrplänen der Oberstufen sind naturwissenschaftliche Fächer nicht nur unterrepräsentiert, die Unterrichtsstunden wurden, trotz einem enorm angestiegenen Wissen, gegenüber früher gekürzt.

…und Mangel an seriöser, leicht verständlicher Information für Erwachsene…

Ihre rudimentären naturwissenschaftlichen Kenntnisse können Schulabgänger als Erwachsene aber kaum noch verbessern. Prinzipiell wäre Information aus den Massenmedien zu beziehen, vor allem aus dem Fernsehen, aber auch aus den Printmedien und in steigendem Maße aus dem Internet. Dem steht entgegen, dass in den ersten beiden Medien Unterhaltungswert und Befriedigung der Sensationsgier oberste Priorität besitzen, wenig quotenbringende Wissenschaftsberichte zumeist an unterster Stelle rangieren: In den Jahren 2009 bis 2012 hat der ORF die Sendezeit für „Wissenschaft und Bildung“ von 303 Stunden auf 214 Stunden (1,22 % der gesamten Sendezeit) reduziert, zugunsten eines erhöhten Angebots an Unterhaltung (46 %) und Sportsendungen (6,8 %). (Quelle: ORF-Jahresberichte). In den Printmedien führen überhaupt nur wenige Tageszeitungen eine Wissenschaftsrubrik – komplexe Sachverhalte werden aber auch hier häufig nicht allgemein verständlich dargestellt und sind zum Teil auch nicht ausreichend recherchiert.

Das Internet weist wohl ein ungeheures Wissensangebot auf; seriöse, leicht verständliche Information ist aber nicht einfach zu finden. Ein Großteil der Videos auf Youtube, aber auch viele Diskussionsplattformen und auf den ersten Blick seriös wirkende Webseiten, erweisen sich bei näherem Ansehen als zu wenig verständlich oder krass pseudowissenschaftlich. Die eigentliche Fachliteratur in ihrem „fachchinesisch“ erscheint auch für interessierte Laien natürlich weitestgehend unverständlich.

…führen über Unwissen zu Verunsicherung und Ablehnung

Unsere Gesellschaft besteht schon zum Großteil aus Menschen, die den Naturwissenschaften – und hier vor allem der Chemie – äußerst ablehnend gegenüberstehen. Befürchtungen hinsichtlich Gefahren, die in Lebensmitteln, Trinkwasser, Umwelt, Kosmetika, Arzneimittel und vielem anderen lauern, werden hier vor allem auch durch die Medien (und NGO’s) geschürt und führen zu beinahe schon irrationalen Ängsten. Eine adäquate, durchaus kritische Auseinandersetzung mit den zugrunde liegenden Problemen ist aber kaum möglich, da ja erforderliche Grundkenntnisse fehlen

Der ScienceBlog

Mit dem ScienceBlog streben wir an:

„Laien über wichtige naturwissenschaftliche Grundlagen und Standpunkte zu informieren, deren Grenzen in kritischer Weise abzustecken, Vorurteilen fundiert entgegenzutreten und insgesamt, in der Form eines zeitgemäßen Diskussionsforums, das zur Zeit leider sehr geringe, allgemeine Interesse an Naturwissenschaften zu steigern“.

Ein Kaleidoskop der Disziplinen…

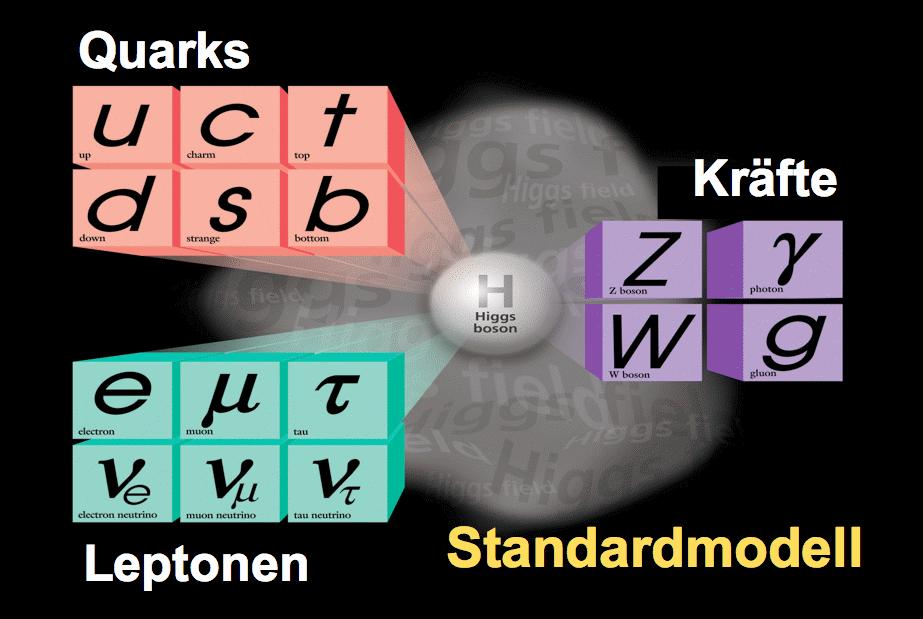

Der ScienceBlog unterscheidet sich von anderen Wissenschaftsblogs dadurch, dass er nicht nur ein spezielles Fachgebiet darstellt, sondern transdisziplinären Charakter besitzt, die Naturwissenschaften in ihrer ganzen Breite umspannt. Er inkludiert also Physik, Geowissenschaften, Weltraumforschung, Chemie, Biologie bis hin zur molekularen Pharmakologie und Medizin. Ebenso sind Mathematik/Informatik als Grundlage und Gebiete, die auf Naturwissenschaften basieren, vertreten. Dazu kommen wissenschaftspolitische Artikel hinsichtlich naturwissenschaftlicher Bildung, Forschung und deren Förderung – mit speziellem Fokus auf die Situation in Österreich.

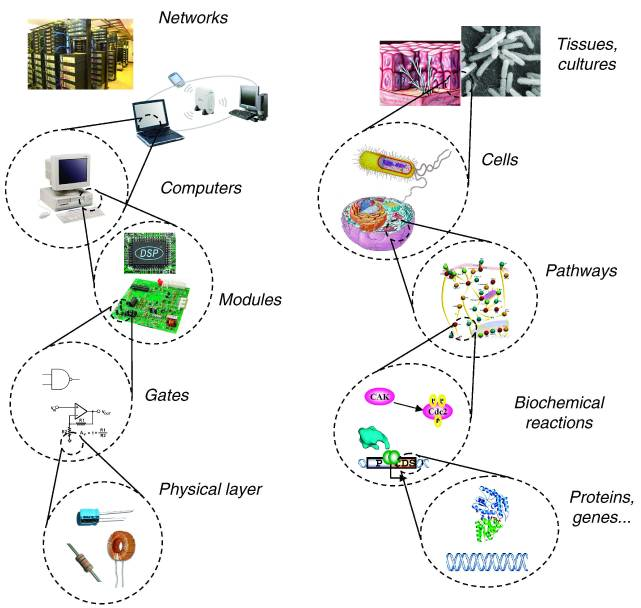

Damit entspricht der Blog der transdisziplinären Natur der meisten real existierenden Fragestellungen und ermöglicht deren Diskussion von der Warte verschiedener Fachrichtungen aus. Beispielsweise kommt ja die moderne Medizin („science-based medicine“) heute nicht mehr ohne Biochemie und Molekularbiologie aus, erfordert die Suche nach neuen Arzneimitteln ein breites Spektrum an Disziplinen, unter anderem die analytische und synthetische Chemie, die Strukturchemie, Biochemie, Molekularbiologie, der Informationstechnologien, Computermodellierungen und natürlich pharmazeutische Wissenschaften und medizinische Grundlagen.

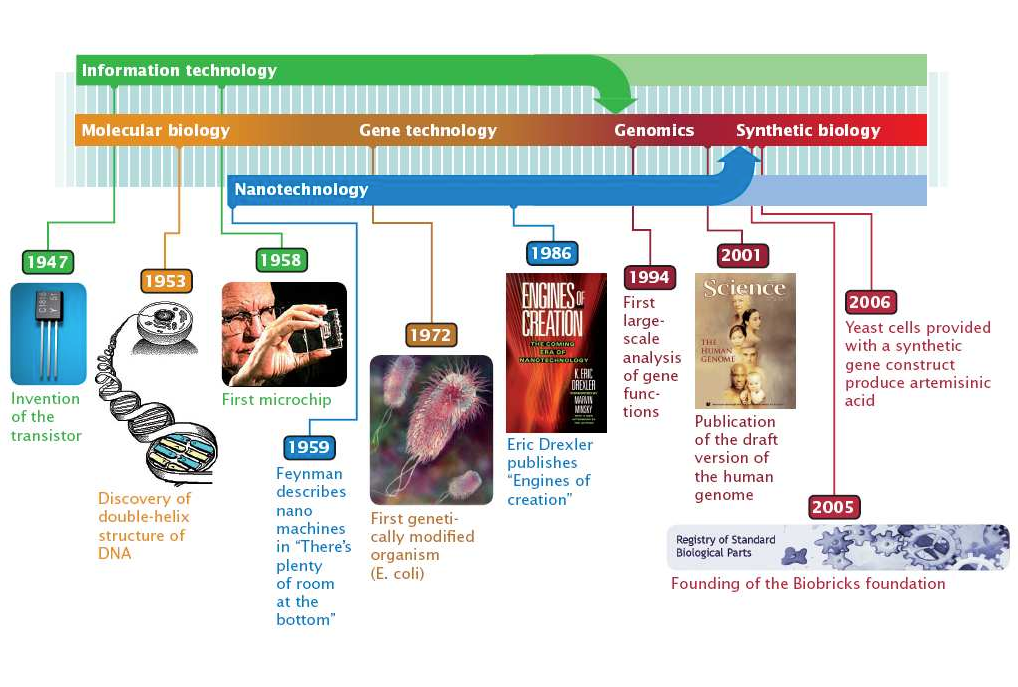

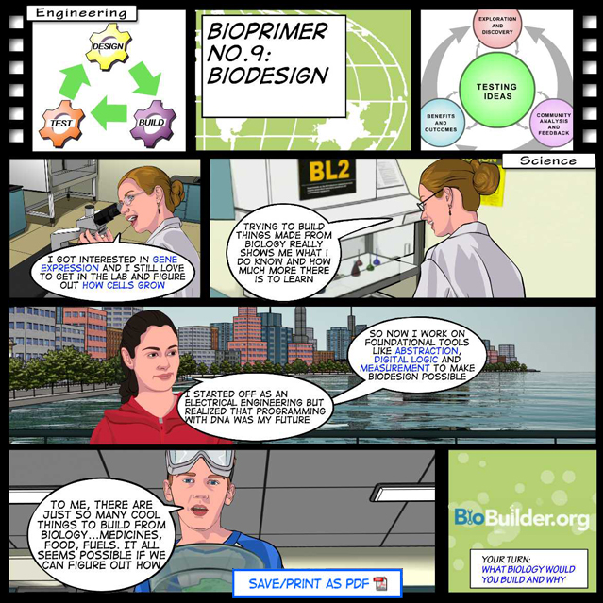

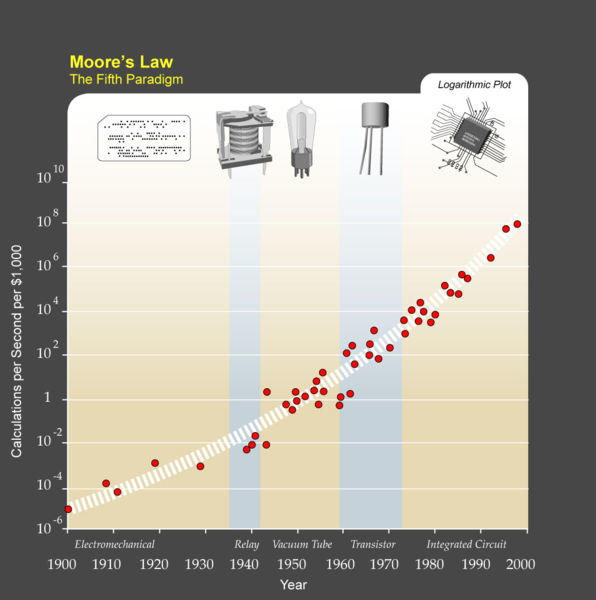

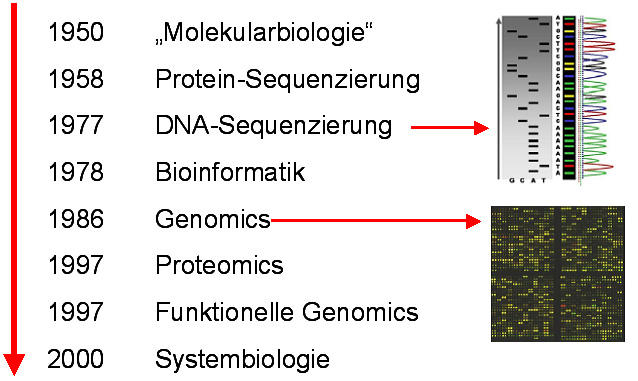

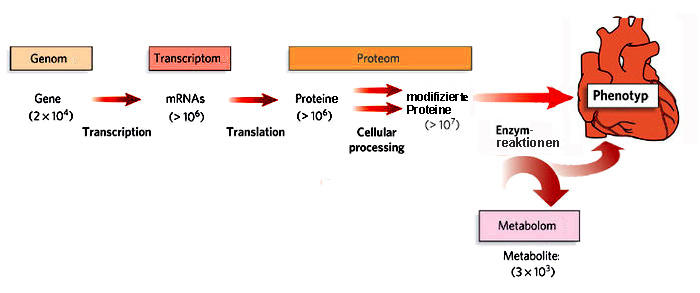

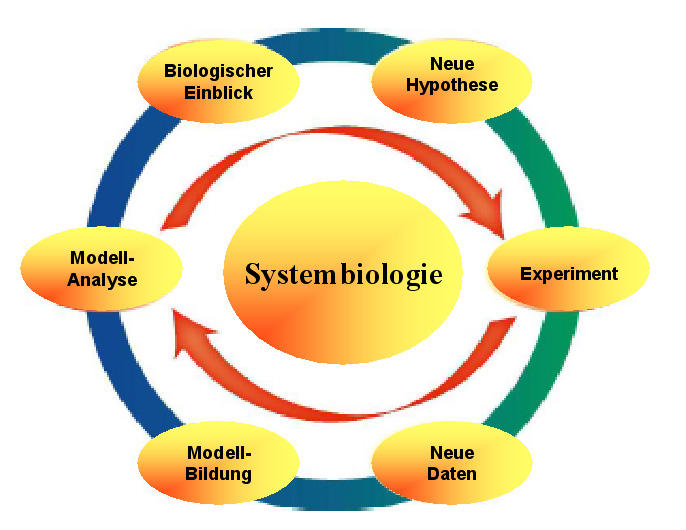

Aktuelle Ansätze in den Naturwissenschaften benutzen Wissen und Technologien aus unterschiedlichsten Disziplinen und setzen diese kaleidoskopartig zu immer neuen Strukturen, zu immer neuen Anwendungen, zusammen. Dies gilt insbesondere für das Bestreben, die überaus komplexen Zusammenhänge von Systemen, wie beispielsweise von Zellen, Organen und ganzen Organismen in einer holistischen (systemtheoretischen) Weise zu beschreiben, das heißt, in ihrer Dynamik und unter Einbeziehung aller möglichen Wechselwirkungen. (Ein derartiger, äußerst aufwändiger Ansatz (beispielsweise der Systembiologie, Systempharmakologie,...) konnte natürlich erst auf der Basis der heute verfügbaren Möglichkeiten der Datenspeicherung und Datenverarbeitung ins Auge gefasst werden.) Ein Paradebeispiel stellt hier auch die als Leitwissenschaft des 21. Jahrhunderts apostrophierte „Synthetische Biologie“ dar.

…erfordert ein Kollektiv kompetenter Autoren

Wenn die Inhalte der Artikel durchwegs „state of the art“ sein sollen, fundierte wissenschaftliche Ergebnisse und Schlussfolgerungen aufzeigen sollen, können sie zweifellos nicht von einem einzelnen Blogger stammen. Der ScienceBlog hat es sich zur Aufgabe gemacht, international ausgewiesene (vorwiegend aus Österreich stammende) Experten als Autoren zu rekrutieren, die jeweils aus ihren Fachgebieten in leicht verständlicher, deutscher Sprache schreiben. Der Blog stellt also „Wissenschaft aus erster Hand“ dar. Damit unterscheidet sich unser Blog grundlegend von anderen naturwissenschaftlichen Blogs im Ausland, die häufig von einem einzelnen Blogger betreut werden und sich auf ein einzelnes Fachgebiet beschränken.

Der ScienceBlog 2013

Der ScienceBlog – vor zweieinhalb Jahren ins Leben gerufen – hat vor neun Monaten einen Relaunch erfahren und ist auf eine neue, eigene Webseite umgezogen [4]. Alle bis dahin erschienenen wissenschaftlichen Artikel wurden bereits auf die neue Seite übernommen – sie haben ja noch nichts an Gültigkeit der Information und der Aussagen eingebüßt.

Mit der Erscheinungsfrequenz 1 Artikel/Woche liegen bis jetzt Insgesamt 125 Artikel vor, die von 46 Autoren stammen. Zu den einzelnen Artikeln gibt es meistens weiterführende Links (seriöse, leicht verständliche Literatur und – wo immer möglich – Videos), die auch gepflegt werden.

Mit großer Freude können wir berichten, dass seit dem Relaunch die Zugriffszahlen zu unserem Blog stark ansteigen, dass wir in der Google-Bewertung („PageRank“) unserer Seite ein '7/10' erhalten haben – eine Bewertung, die bis jetzt nur sehr wenige Wissenschaftsblogs erzielten (z.B. das amerikanische Format: Science-Based-Medicine, nicht aber die großen deutschen Blog-Portale SciLogs.de oder ScienceBlogs.de).

Vision: ScienceBlog 2014

Unseren Blog wollen wir zu etwas Einzigartigem in der Blogosphäre gestalten.

Zur Zeit gruppieren wir die einzelnen Artikel nach Themenschwerpunkten (siehe z.B. die Schwerpunkte „Synthetische Biologie“ und „Klima & Klimawandel“) und erstellen zu allen Artikeln Schlagwortlisten. Dies gibt die Möglichkeit, auf alle Artikel zurückzugreifen, ein Thema von den Gesichtspunkten unterschiedlicher Disziplinen aus zu betrachten und (hoffentlich auch) zu diskutieren.

Es entsteht somit eine blogweite Informations- und Diskussions-Plattform über das gesamte Spektrum der Naturwissenschaften auf dem durch unsere Autoren garantierten höchsten Niveau! Ein neues Format, das über Themenschwerpunkte ein Vorgehen nach Art eines e-Books erlaubt, darüber hinaus aber die Möglichkeit einer breiten Diskussion bietet. In diesem Sinne

Ein Prosit Neujahr!

Allen unsere Autoren, denen wir herzlich für Ihre brillanten, wertvollen Artikel danken, die den ScienceBlog zu einer neuen Form der fächerübergreifenden Kommunikation zwischen Wissenschaft und Öffentlichkeit machen .

Allen unseren Besuchern, denen wir auch im neuen Jahr faszinierende Berichte über die Natur in uns und um uns versprechen. Wir hoffen, dass Sie uns auch in Ihrem Freundes- und Bekanntenkreis weiterempfehlen!

Siehe auch [1] Wissenschaftskommunikation in Österreich und die Rolle der Medien — Teil 1: Eine Bestandsaufnahme

3] Quid pro quo? Zur Einsparung des Wissenschaftsministeriums

[4] ScienceBlog in neuem Gewande — Kontinuität und Neubeginn

Quid pro quo? Zur Einsparung des Wissenschaftsministeriums

Quid pro quo? Zur Einsparung des WissenschaftsministeriumsFr, 20.12.2013 - 05:40 — Redaktion

![]() In ihrem ScienceBlog-Artikel „Wissenschaftskommunikation in Österreich und die Rolle der Medien“ haben Josef Seethaler und Helmut Denk vor wenigen Wochen den alarmierend niedrigen Stellenwert beklagt, den Wissenschaft und Forschung in unserem Land haben: die Mehrheit der Österreicher (fast doppelt so viele wie im EU-Durchschnitt) betrachtet diesbezügliche Informationen als irrelevant für ihr tägliches Leben, weniger als die Hälfte stimmt einer Unterstützung der Grundlagenforschung durch die öffentliche Hand zu.

In ihrem ScienceBlog-Artikel „Wissenschaftskommunikation in Österreich und die Rolle der Medien“ haben Josef Seethaler und Helmut Denk vor wenigen Wochen den alarmierend niedrigen Stellenwert beklagt, den Wissenschaft und Forschung in unserem Land haben: die Mehrheit der Österreicher (fast doppelt so viele wie im EU-Durchschnitt) betrachtet diesbezügliche Informationen als irrelevant für ihr tägliches Leben, weniger als die Hälfte stimmt einer Unterstützung der Grundlagenforschung durch die öffentliche Hand zu.

Hier wie dort bildet Österreich das Schlusslicht unter den Staaten der Europäischen Union. Wenn es noch eines weiteren Beweises für diese von Ignoranz und Desinteresse getragene Auffassung von Wissenschaft bedurft hätte, so bietet diesen die Ressortaufteilung des neuen Regierungsprogramms: die Einsparung eines eigenständigen Ministeriums für Wissenschaft und Forschung und die Zuordnung seiner Agenda zum Wirtschaftsministerium.

Was aber wird hier eingespart,

wenn der nun auch für Wissenschaft zuständige Minister Mitterlehner im Ö1-Morgenjournal vom 17.12. 2013 darlegt „da bleibt das Ministerium komplett gleich, was also die Abteilungen anbelangt, was die Sektionen betrifft, was aber auch die Spitzenbeamten anbelangt; es bleibt jeder in seinem Bereich jeder an seinem Arbeitsplatz“? Es kann doch wohl nicht nur um die Einsparung des Salärs des Wissenschaftsministers gehen!

Was bietet ein gemeinsames Dach mit dem Wirtschaftsministerium?

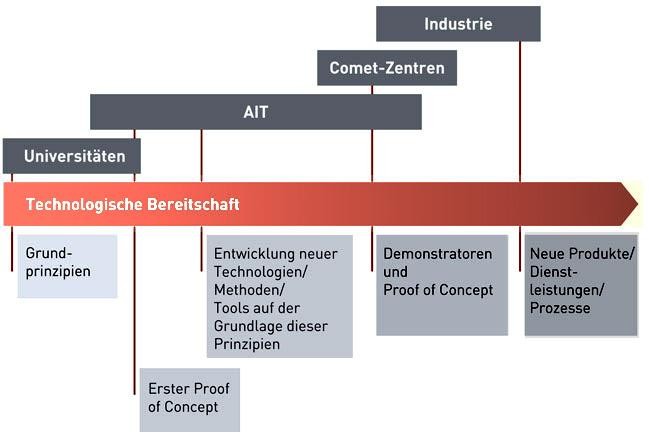

Dazu Mitterlehner: „es wird hier nur organisatorisch eine gemeinsame neue Führung gestaltet und ein neuer Anspruch auch erhoben, der sich auf die Forschung bezieht. Die EU hat all ihre Programme auf die Innovationskette ausgerichtet, von der Grundlagenforschung über die angewandte Forschung bis zu den Unternehmen hin. Und genau diese Synergiepotentiale, die bessere Effizienz, die verstärkte Effizienz wollen wir auch im Bereich Forschung leben.“

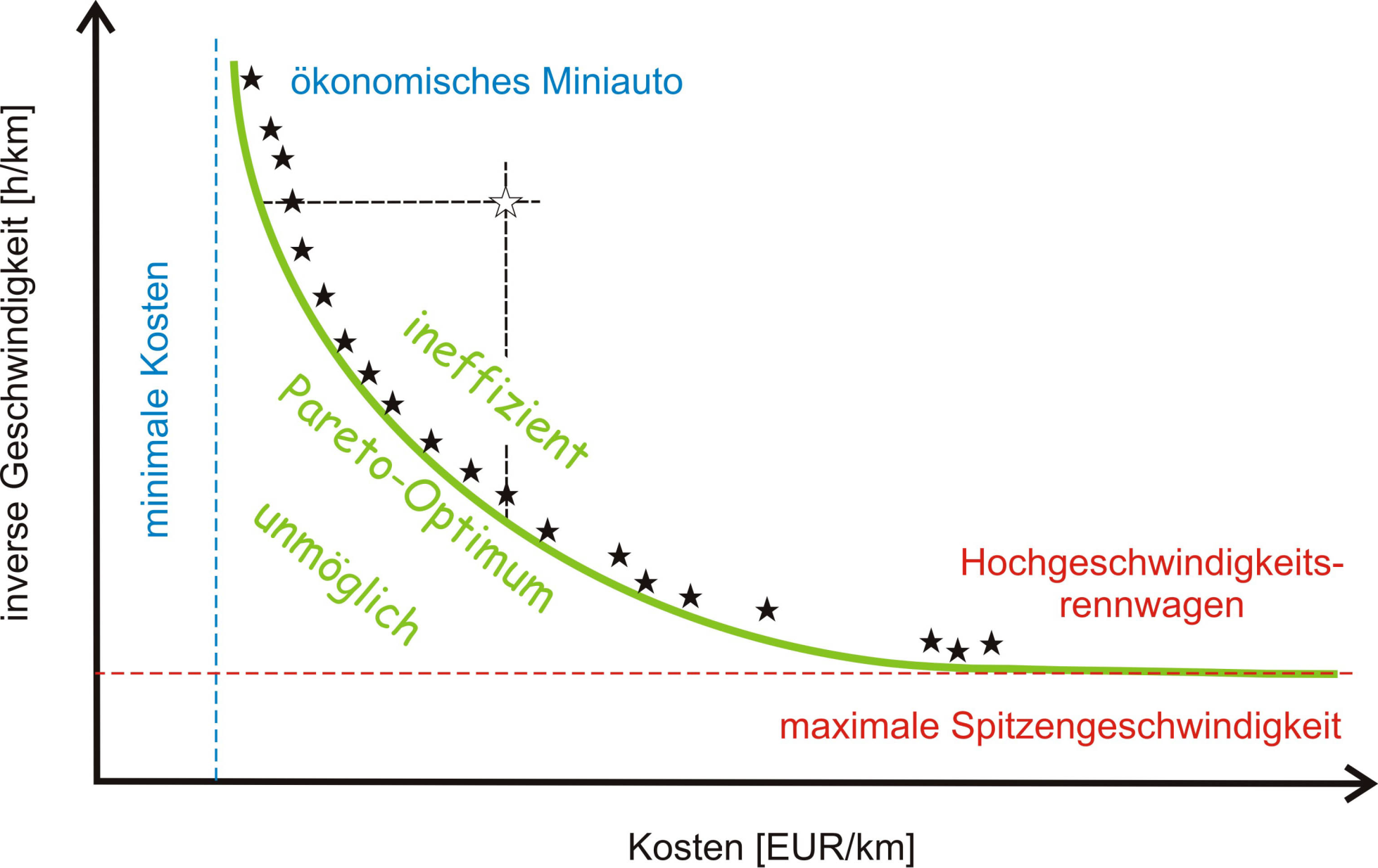

Dies ist die durchaus verständliche Sprache eines Wirtschaftsministers, der ja die Interessen von Industrie-, Gewerbe- und Tourismusbetrieben vertritt. Dies klingt ganz nach zielorientierter, angewandter Forschung, nach Lösungsansätzen für vorgegebene Probleme, deren Erfolge „unmittelbar“ meßbar/brauchbar sind. Die erkenntnisorientierte Grundlagenforschung läßt sich nicht in diesen Rahmen pressen, ist ja eine Reise ins Neuland. Gerade ihre Ergebnisse sind aber die Basis für Innovationen, für entscheidende Durchbrüche nicht nur in Hinblick auf eine prosperierende Wirtschaft eines Landes, sondern auch für das Wohlergehen unserer Gesellschaft und der unserer Nachkommen.

Das Regierungsprogramm gibt vor, daß in den nächsten fünf Jahren Bundesmittel zur Anhebung der Forschungsquote verfügbar gemacht werden sollen – allerdings mit dem Zusatz „unter Maßgabe budgetärer Möglichkeiten“. Angesichts limitierter Ressourcen und eines starken Druckes zur Unterstützung der durch das Wirtschaftsministerium vertretenen forschenden Unternehmen (Motto: Sicherung von Arbeitsplätzen, Wirtschafts“entfesselung“), werden ökonomische Überlegungen einer schnell verwertbaren angewandten Forschung und Technologieentwicklung wohl den Vorzug geben vor einer (in den Augen vieler Beurteiler vielleicht nutzlosen) Grundlagenforschung.

Für ein unabhängiges Wissenschaftsministerium!

Wissenschaft und Forschung werden im Regierungsprogramm als elementare Stützen der gesamtstaatlichen Entwicklung Österreichs und seiner Potentiale gesehen und sollen langfristig abgesichert werden. Wenn dazu Rahmenbedingungen und strukturelle Voraussetzungen bestmöglich, wettbewerbsfähig und zukunftsorientiert gestaltet werden müssen, so ist dies wohl am zielstrebigsten in einem eigenen Ministerium, unter Führung eines mit dem akademischen Forschungsbetrieb bestvertrauten Leiters, zu bewerkstelligen. Die Nachordnung unter (vorwiegend) ökonomische Interessen schadet der Wissenschaft und den Wissenschaftern, ist eine Geringschätzung der wichtigsten Ressource, die unser rohstoffarmes Land aufzuweisen hat.

Weiterführende Links

Im ScienceBlog

Josef Seethaler & Helmut Denk; 31.10.2013: Wissenschaftskommunikation in Österreich und die Rolle der Medien. — Teil 2: Was sollte verändert werden?

Josef Seethaler & Helmut Denk; 17.10.2013: Wissenschaftskommunikation in Österreich und die Rolle der Medien — Teil 1: Eine Bestandsaufnahme

Franz Kerschbaum; 13.10.2011: Die Wissenschaftler sind ja selbst schuld

Peter Schuster; 08.09.2011: Grundlagenforschung in Österreich: Förderung des wissenschaftlichen Nachwuchses

Peter Schuster; 11.08.2011: Grundlagenforschung in Österreich: Rekrutierung von Spitzenkräften

Peter Schuster; 21.07.2011: Grundlagenforschung in Österreich: Erkennen von Exzellenz

Peter Schuster; 03.07.2011: Grundlagenforschung in Österreich: Exzellenzstrategie – Mehr als ein Lippenbekenntnis?

Initiativen

Österreich braucht ein WIssenschaftsministerium

Für die Einführung des Ministeriums für Wissenschaft und Forschung

Ein eigenständiges Wissenschaftsministerium für Österreich

Wider die Natur? — Wie Gene und Umwelt das sexuelle Verhalten prägen

Wider die Natur? — Wie Gene und Umwelt das sexuelle Verhalten prägenFr, 13.12.2013 - 06:19 — Gottfried Schatz

![]()

Auch im Tierreich gibt es nicht nur Heterosexualität. An der Fruchtfliege Drosophila lässt sich das gut studieren. Gegenüber voreiligen Schlüssen vom tierischen auf das menschliche Sexualleben ist allerdings Skepsis angebracht.

Auch im Tierreich gibt es nicht nur Heterosexualität. An der Fruchtfliege Drosophila lässt sich das gut studieren. Gegenüber voreiligen Schlüssen vom tierischen auf das menschliche Sexualleben ist allerdings Skepsis angebracht.

«Wenn jemand beim Knaben schläft wie beim Weibe, die haben einen Greuel getan und sollen beide des Todes sterben; ihr Blut sei auf ihnen.» Der Nachhall dieses fast drei Jahrtausende alten biblischen Donnerworts aus Levitikus 20 ist auch heute noch nicht verstummt. Und da es auch die Liebe zwischen erwachsenen Männern verbot, hat es unzähligen von ihnen das Lebensglück geraubt. England liess noch 1835 Homosexuelle hinrichten; Hitlers Schergen deportierten und ermordeten Zehntausende von ihnen; und der berüchtigte Paragraf 175 des preussischen Strafrechts ahndete «Ausschweifung gegen die Natur» bis ins Jahr 1969. Erst 1997 setzte die Europäische Gemeinschaft im Vertrag von Amsterdam der gesetzlichen Ächtung homosexueller Menschen ein Ende. Auch die Zeit, als Psychiater Homosexuelle zu «heilen» versuchten, ist wohl endgültig vorbei.

Gene und/oder Umwelt?

Was bewegt Menschen zur gleichgeschlechtlichen Liebe? Sind es unsere Gene – oder ist es die Umwelt?

Dass Gene eine wichtige Rolle spielen, zeigen Untersuchungen an Zwillingsbrüdern: Ist einer von ihnen homosexuell, dann ist die Wahrscheinlichkeit, dass es auch der andere ist, bei eineiigen (also genetisch identischen) Zwillingen etwa doppelt so hoch wie bei zweieiigen – und bei diesen wiederum doppelt so hoch wie bei nichtverwandten adoptierten Brüdern. Diese und andere Ergebnisse sprechen dafür, dass mehrere Gene im Spiel sind, dass auch die Umgebung eine Rolle spielt und dass es zwischen Hetero- und Homosexualität viele Zwischentöne gibt. Wir Menschen sind nur ein später Zweig am Lebensbaum – es finden sich urtümliche Vorläufer unseres Verhaltens oft in Tieren oder sogar Bakterien.

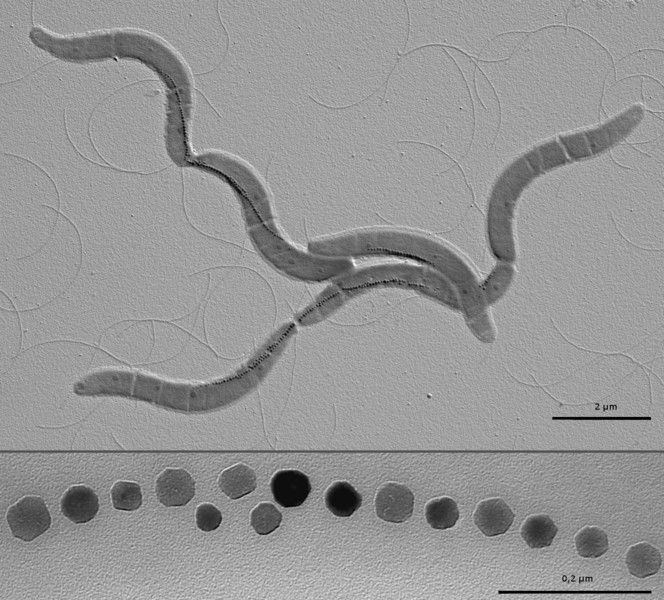

Die Fruchtfliege Drosophila als Modell

Nicht zuletzt gilt dies auch für sexuelles Verhalten. Bei der Fruchtfliege Drosophila melanogaster (Abbildung) ist dieses Verhalten streng stereotyp, weil dieses kleine Insekt nur hunderttausend Nervenzellen besitzt – lächerlich wenig im Vergleich zu den zehn Milliarden Nervenzellen eines Menschen. Dennoch ist auch bei Drosophila die Werbung Männersache – und das letzte Wort ein Vorrecht des Weibchens. Und auch bei Drosophila interessieren sich einige Männchen sowohl für Weibchen als auch für Männchen.

Abbildung. Drosophila melanogaster – Männchen und Weibchen (Bild: Sarefo, Wikimedia Commons)

Abbildung. Drosophila melanogaster – Männchen und Weibchen (Bild: Sarefo, Wikimedia Commons)

Genmutationen aber auch Medikamente verändern sexuelles Verhalten

Dieses bisexuelle Verhalten lässt sich durch Mutation einzelner Gene so verstärken, dass fast jedes Männchen beide Geschlechter mit gleicher Inbrunst umwirbt. Zwei dieser Gene entfalten ihre Wirkung bereits während der embryonalen Entwicklung, bei der sie Hunderte, wenn nicht Tausende untergeordneter Gene und damit die geschlechtsspezifische Ausbildung des Gehirns und anderer Körperteile steuern.

Ein weiteres Gen erhöht die Konzentration des Nervensignalstoffs Glutamat im Gehirn und erhöht damit die Reizschwelle gewisser Nervenzellen, die geschlechtsspezifische Gerüche verarbeiten. Fällt dieses Gen durch Mutation aus, so sinkt die Glutamatkonzentration im Gehirn, die Glutamat-spezifischen Nervenzellen werden überempfindlich – und melden dann vielleicht nicht nur weibliche, sondern auch männliche Düfte als sexuellen Anreiz. Deshalb können auch Medikamente, die Glutamat-spezifische Nervenzellen künstlich anregen, in normalen Fliegen bisexuelles Verhalten auslösen.

Attraktion zwischen Männchen wird aber offenbar auch von Nerven mitbestimmt, die auf das Gehirnhormon Serotonin ansprechen: Erhöht man die Konzentration dieses Hormons genetisch oder durch Medikamente, so werden nicht nur männliche Fliegen, sondern auch Rattenmännchen und Kater bisexuell.

Fliegenweibchen sind in ihrer sexuellen Vorliebe offenbar viel gefestigter, denn ihre kompromisslose Vorliebe für das «starke Geschlecht» liess sich bisher weder durch Medikamente noch durch Mutation von Genen ins Wanken bringen. Allerdings sind Untersuchungen zur sexuellen Neigung der Weibchen viel schwieriger durchzuführen als bei den Männchen; die Weibchen könnten also noch für Überraschungen sorgen.

Ein neues Gen unterdrückt Bisexualität

Im Gegensatz zu Drosophila melanogaster ist bei vielen anderen Drosophila-Arten männliche Bisexualität häufig oder gar die Regel. Warum «duldet» die Natur dieses Verhalten, obwohl es nicht der Fortpflanzung dient? Drosophila melanogaster schneiderte vor zwei bis drei Millionen Jahren aus Teilen ihres Erbmaterials ein neues Gen, das die Männchen auf Weibchen fixiert. Pflanzt man dieses Gen Männchen anderer Drosophila-Arten ein, unterdrückt es auch deren Bisexualität.

Auch eine Überzahl bisexueller Mutanten kann in «normalen» Drosophila-melanogaster-Männchen bisexuelles Verhalten auslösen. Diese Männchen folgen dabei offenbar nicht instinktiv einem aphrodisischen Duftbefehl ihrer bisexuellen Artgenossen, sondern ändern ihr sexuelles Verhalten erst im Verlauf von Stunden. Vermutlich müssen sie erst ihr Nervensystem oder andere Körperteile «umprogrammieren». Auch die Umwelt kann also bisexuelles Verhalten auslösen, wobei es noch offen ist, ob dieses erworbene Verhalten an die männlichen Nachkommen vererbt werden kann. Denkbar wäre dies, denn Umwelteinflüsse können die Struktur von Chromosomen so verändern, dass diese Veränderungen an die Nachkommen weitergegeben werden. Selbst für Fliegen sind Gene also nicht immer Schicksal.

So faszinierend diese Ergebnisse auch sind – über die menschliche Homosexualität verraten sie uns nur wenig. Bisexualität ist nicht Homosexualität – und eine Fliege kein Mensch. Gene beeinflussen zudem das Verhalten von Fliegen und Menschen nicht unmittelbar, sondern über den Bau von Körperstrukturen, die dem Verhalten zugrunde liegen; und sie erfüllen diese Aufgabe meist als komplexe, aus vielen Genen gewirkte Netzwerke. Wir haben zwar die Buchstabenfolgen aller dreizehntausend Drosophila-melanogaster-Gene entziffert, kennen aber erst wenige, die das Paarungsverhalten der Fliege mitprägen. Bei uns Menschen ist das Rätsel noch weit grösser, besitzen wir doch zweimal mehr Gene und hunderttausendmal mehr Nervenzellen als Drosophila. Zudem können wir auch die Anweisungen unserer Gene viel freier interpretieren und unser Gehirn im Wechselspiel mit der Umwelt viel individueller prägen.

Verschlungene Pfade

Es wäre deshalb töricht und verantwortungslos, Bi- oder Homosexualität bei uns Menschen einfach als genetischen Imperativ abzutun – oder aber den Einfluss von Genen zu leugnen und die Ursache allein der Umwelt zuzuschreiben. Dass Gene menschliche Homosexualität mitbestimmen, steht ausser Zweifel, doch auch hormonelle Einflüsse während der embryonalen Entwicklung scheinen eine wichtige Rolle zu spielen. Und da der Hormonstoffwechsel einer werdenden Mutter – und damit auch der des Embryos – auf Umwelteinflüsse anspricht, werden die molekularen Auslöser menschlicher Homosexualität wohl noch lange im Dunkeln bleiben.

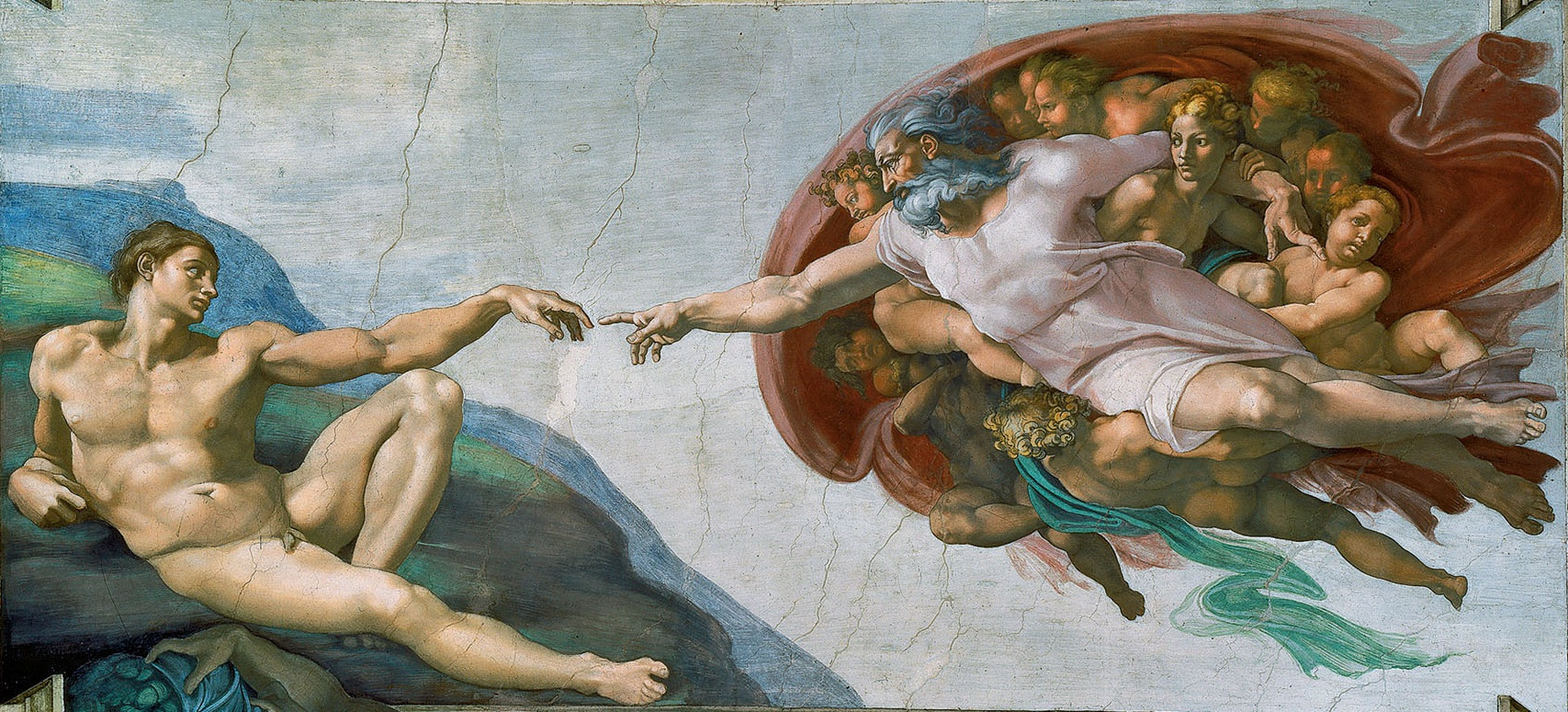

Der Pfad von den Genen zum Verhalten ist bei uns Menschen verschlungener und wundersamer als bei Tieren und führt uns oft zu unerwarteten Ergebnissen. Wer wagte da zu behaupten, eines dieser Ergebnisse sei bei Tieren natürlich, bei uns Menschen jedoch «Sünde wider die Natur»? Dieser Sünde macht sich nur schuldig, wer uns nicht als Teil des Lebensbaumes, sondern als einmaliges Wunder der Schöpfung sieht. «Überall also liegen Vorbilder der menschlichen Handlungsweisen, in denen das Tier geübt wird; [. . .] sie [. . .] dennoch als Maschinen betrachten [zu] wollen, ist eine Sünde wider die Natur» – so Johann Gottfried Herder, vor mehr als zweihundert Jahren.

Weiterführende Links

Ein hervorragender Übersichtsartikel zu dem Thema (in Englisch): Bailey NW, M.Zuk: Same-sex sexual behavior and evolution. Trends in Ecology & Evolution, June 16, 2009 (free download) http://www.thestranger.com/images/blogimages/2009/09/14/1252958575-evolu...

Schwule Tiere"Missbrauch durch die Politik" : http://www.zeit.de/online/2008/22/homosexualitaet-tiere-interview/komple.... Zeit Interview: Gut 500 Tierarten verhalten sich homosexuell. Rückschlüsse auf den Menschen lassen sich daraus aber kaum ziehen, sagt Verhaltensforscher Paul Vasey

Der im Artikel angesprochene »Baum des Lebens« ist durchaus mehr als ein geflügeltes Wort. Wer an langen Winterabenden gerne herumschmökert, wird hier fündig: Tree of Life Web Project

Im ScienceBlog-Artikel Das Leben ein Traum — Warum wir nicht Sklaven unserer Gene sind erläutert Schatz, inwiefern die Gene zwar wichtig, aber nicht allesbestimmend für die Ausprägung bestimmter Merkmale sind.

Das Ignaz-Lieben Projekt — Über Momente, Zufälle und Alfred Bader

Das Ignaz-Lieben Projekt — Über Momente, Zufälle und Alfred BaderFr, 06.12.2013 - 07:38 — Christian Noe

![]()

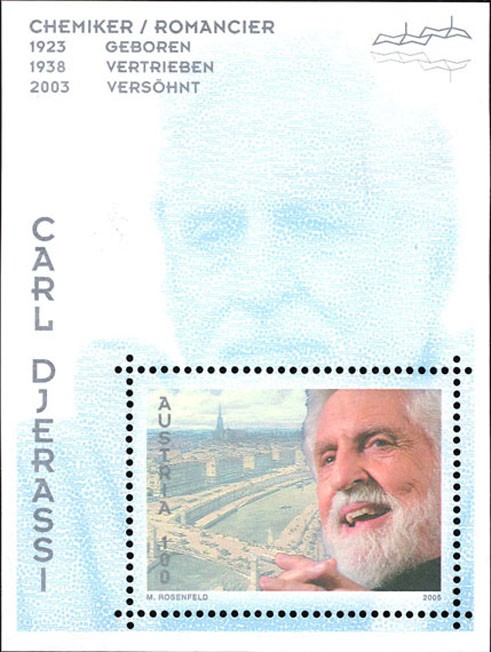

Vor wenigen Tagen fand die Verleihung des Ignaz-Lieben Preises statt. Dieser prestigeträchtige, älteste Preis der Österreichischen Akademie der Wissenschaften wurde 1863 gestiftet und 1938 auf Grund der Verfolgung der Stifterfamilie eingestellt. Durch großzügige finanzielle Unterstützung von Isabel und Alfred Bader konnte der Preis 2004 reaktiviert werden. Der Chemiker Christian Noe war essentiell in diese Reaktivierung involviert; der nachfolgende Text ist die leicht gekürzte Fassung seines Vortrags zum heurigen 10-Jahresjubiläum der Preisvergabe.

Vor wenigen Tagen fand die Verleihung des Ignaz-Lieben Preises statt. Dieser prestigeträchtige, älteste Preis der Österreichischen Akademie der Wissenschaften wurde 1863 gestiftet und 1938 auf Grund der Verfolgung der Stifterfamilie eingestellt. Durch großzügige finanzielle Unterstützung von Isabel und Alfred Bader konnte der Preis 2004 reaktiviert werden. Der Chemiker Christian Noe war essentiell in diese Reaktivierung involviert; der nachfolgende Text ist die leicht gekürzte Fassung seines Vortrags zum heurigen 10-Jahresjubiläum der Preisvergabe.

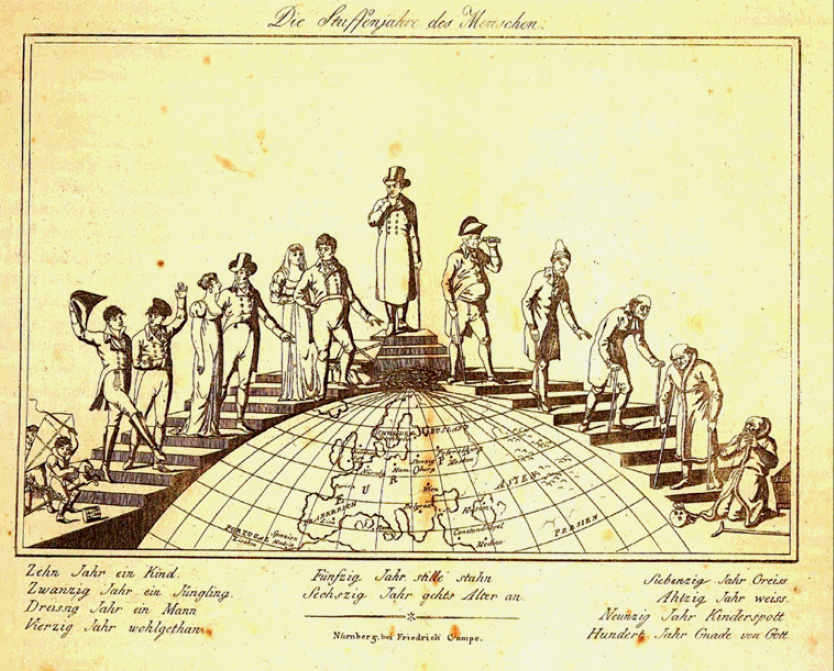

Unser Dasein scheint kontinuierlich dahinzufließen, manchmal gemächlich, manchmal in reißendem Fluss. Ganz selten sind jene besonders intensiv erlebten Momente, welche sich bildhaft im Kopf festsetzen - manchmal für die Dauer des ganzen Lebens. Von einige wenigen solcher unvergesslicher Momente soll hier die Rede sein, um das scheinbar zufällige Zustandekommen und den Ablauf des Lieben-Projektes zu schildern, das seinen Höhepunkt in der Wiedererrichtung des Ignaz-Lieben Preises vor 10 Jahren fand.

Das Ignaz-Lieben Projekt ist ganz eng mit Alfred Bader verknüpft, jenem Mann der - als Kind aus Wien vertrieben - in einer schier unglaublichen Karriere das weltweit größte Feinchemieunternehmen geschaffen hat: Sigma-Aldrich. Es gibt kaum ein chemisches oder biologisches Labor in der Welt, in welchem sich nicht ein Katalog dieser Firma findet.

Alfred Bader und das Loschmidt-Projekt

Alfred Bader habe ich vor etwa 30 Jahren durch meinen Mentor Paul Löw-Beer kennengelernt.

Abbildung 1. Alfred Bader (Quelle: http://www.chemheritage.org)

Abbildung 1. Alfred Bader (Quelle: http://www.chemheritage.org)

Einige Jahre später hat mich Alfred Bader gebeten in der Österreichischen Nationalbibliothek jenes weithin unbekannte Buch von Josef Loschmidt aus dem Jahre 1861 aufzustöbern, in welchem die erste Benzolformel abgebildet sein sollte [1]. Als ich das Buch aufschlug war ich perplex: Eine Abbildung des Äthylens war vor meinen Augen, dargestellt als Überlappung zweier Kohlenstoffatome, mit eingezeichneter Doppelbindung und den kleinen Wasserstoffatomen an den richtigen Positionen (siehe [2]: p. 198) – ein unvergesslicher Moment: Das sollte 1861 gezeichnet gewesen sein, lange bevor es auch nur die üblichen Strichformeln gab? Sei´s drum! Ich schickte die Kopien in die USA und Alfred Bader hielt – mit mir als Koautor - einen Vortrag bei der Jahrestagung der Amerikanischen Chemischen Gesellschaft „Loschmidt, not Kekule, published first benzene-ring diagrams“. Dies war der Beginn eines langen, gemeinsamen Weges, der in die Chemiegeschichte führte und Josef Loschmidt zum Mittelpunkt hatte.

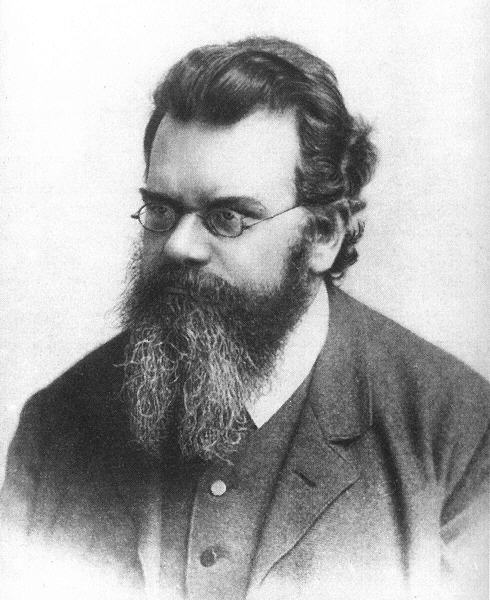

Der großartige Visionär Loschmidt stellte ein Faszinosum für den spontan bilderfassenden Eidetiker Alfred Bader dar [2]. Mir wiederum wurde durch diese Beschäftigung immerhin klar, weshalb Loschmidt seine Zahl errechnet hat [1], und dass er in der Vorbereitung dazu quasi nebenher in genialer Weise einen geradezu perfekten Entwurf zur Konstitution der organischen Moleküle vorgelegt hat.

Alfred Bader trieb mich beharrlich an und hielt Vortrag um Vortrag: Für ihn war das Ganze auch ein Kampf gegen die Borniertheit von Chemiehistorikern. Josef Loschmidt musste einfach die ihm gebührende Anerkennung erhalten. Das Anliegen beherrschte ihn. Loschmidt wurde so zum Loschmidt-Projekt. 1995 zum 100 jährigen Todesjahr sollte ein Symposium stattfinden.

Robert Rosners Weg zum Chemiehistoriker

Ein weiterer unvergesslicher Moment: Ich stand an der Ecke Ring-Währingerstrasse. Wegen meiner anstehenden Berufung an die Universität Frankfurt musste ich eine Lösung für das Loschmidt-Projekt finden. Wilhelm Fleischhacker, damals Dekan der Naturwissen-schaftlichen Fakultät hatte sich bereit erklärt, die Schirmherrschaft über das Projekt zu übernehmen. Aber wer würde die notwendige wissenschaftliche Detailarbeit koordinieren? In diesem Moment tauchte aus der Tiefe der Rolltreppe Dr. Robert Rosner auf, der engste und treueste Mitarbeiter von Paul Löw-Beer in der Loba-Chemie. War das gar ein „deus ex machina“?

„Wie geht es Ihnen?“

„Ich bin jetzt in Pension.“

„Was machen Sie jetzt?“ „Ich studiere Geschichte.“

„Sie sind ein ausgezeichneter Chemiker. Sie sollten Chemiegeschichte studieren. Es gibt da ein ganz tolles Projekt, noch dazu gemeinsam mit Alfred Bader“.

Rosner wurde ein Eckpfeiler des Loschmidt Symposiums 1995 und nebenher einer der profiliertesten österreichischen Chemiehistoriker.

Die Geburt des Lieben-Projekts

Ein nächster Moment, ca. 15 Jahre später: Zurückberufen in die Heimat, immer noch voller Sendungsbewusstsein und optimistischem Gestaltungswillen, hatte mich der Zufall zum Dekan der Fakultät für Naturwissenschaften und Mathematik der Universität Wien gemacht. Dr. Rosner besuchte mich im imperialen Büro:

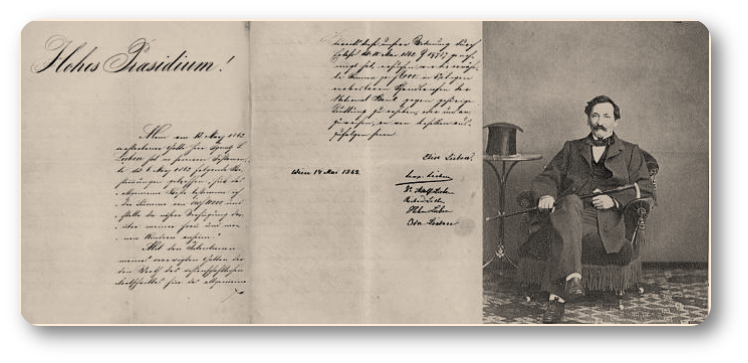

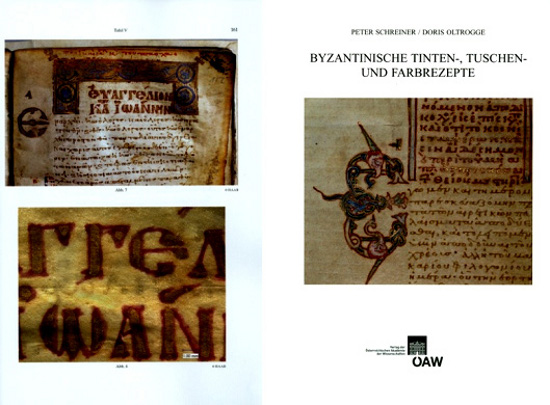

„Haben Sie schon etwas vom Ignaz-Lieben Preis (Abbildung 2) gehört?“

„Nein!“

„Der größte Preis der Akademie der Wissenschaften, von den Nationalsozialisten abgeschafft [3]. Man müsste ein Symposium dazu machen. Das ist aber nicht einfach zu finanzieren.“

„Wen interessiert schon ein Symposium über einen nicht mehr existierenden Preis. Wenn schon, dann muss man den Preis wiedererrichten.“

Abbildung 2. Ignaz-Lieben Preis (benannt nach dem Gründer des Bankhauses Lieben, rechts): Stiftungsbrief datiert 1862, signiert von Adolf Lieben.

Abbildung 2. Ignaz-Lieben Preis (benannt nach dem Gründer des Bankhauses Lieben, rechts): Stiftungsbrief datiert 1862, signiert von Adolf Lieben.

Es kam spontan, von naivem Optimismus getragen. Das war der Beginn des Lieben-Projektes. Natürlich benötigten wir vor allem die Rückendeckung der Akademie der Wissenschaften. Peter Schuster, der damalige Vizepräsident, den ich persönlich kannte und als besonders konstruktiv schätzte, gab - wie erhofft - sofort die Zustimmung. Das Projektteam konnte aufgestellt werden.

Ein Kern von „Aktivisten“ hatte sich schon im Zuge des Loschmidt Projektes gebildet. Hans Desser konnten wir als Generalsekretär gewinnen. Dr. Wolfgang Lieben-Sutter vertrat die Stifterfamilie. Die Chemiehistoriker waren u.a. mit Bobby Rosner, Werner Soukup und Gerhard Pohl präsent, für journalistische Kontakte war Reinhard Schlögel zuständig.

Nicht nur der Preis selbst sollte wiedererrichtet werden. Es sollte auch Ausstellungen geben. Also fand sich auch Georg Haber, der Direktor des Jüdischen Museums, in unserer Runde. Die Ideen sprudelten nur so: Ein wissenschaftliches Symposium anlässlich der Eröffnung, künstlerische Portraits der Preisträger von Udo Wid, und sogar eine Lesung von Carl Djerassi.

Wer aber wird den Lieben-Preis finanzieren?

Wie immer im Juni, war Alfred Bader mit seiner Frau Isabel auch 2003 nach Wien gekommen. Wie üblich sollte es vor allem eine Woche des Beisammenseins mit alten Freunden und mit viel Kunst sein. Der Zufall wollte es, dass zeitgleich im Kleinen Festsaal der Universität eine Tagung stattfand: „Österreich und der Nationalsozialismus – Die Folgen für die wissenschaftliche und humanistische Bildung“. Bader ging mehrmals hin und war sichtlich beeindruckt. „Ich dachte, es gibt in Wien nur wenige anständige Freunde, der Rest verwurzelt in der braunen Vergangenheit. Aber die Jugend ist ganz anders. Ich will das Geld für die Wiederrichtung des Lieben-Preises geben.“

Er sagte das spontan mit leichtem Lächeln und kam mir glücklich und irgendwie befreit vor. Ein vertriebener Jude als Stifter des neuen Lieben-Preises, rückblickend fast beschämend, voraussehend ein anhaltendes Zeichen des Sieges der Humanität über alle Gemeinheit hinweg.

Ich musste Dr. Wolfgang Lieben-Seutter zum Kaffee nach Hause einladen. Alfred Bader, ganz schüchtern:

„Erlauben Sie mir, dass ich das Geld für einen Preis gebe, welcher wieder den Namen Ihrer Familie trägt?“

Ein Brautvater, den der Bräutigam mit einem Heiratsantrag für seine Tochter überrascht, konnte nicht verdutzter sein, als es Dr. Lieben war. Auch das: ein unvergesslicher Moment und Anblick – alle waren glücklich. Es galt noch einige Feinheiten festzulegen: Der Preis sollte über die Grenzen hinweg, auch in den anderen Ländern der ehemaligen Donaumonarchie, ausgeschrieben werden. Das Preisgeld sollte 18.000 Dollar – später 36.000 Dollar – betragen, wie beim alten Preis: Nicht ohne Grund: 18 - Chai: die Zahl, die bei den Juden für das Leben steht! Auch der Preis lebte wieder.

Die Wiedergeburt des Lieben-Preises

Die zahlreichen Veranstaltungen zur Wiedererrichtung verliefen wie geplant, samt einem Konzert im Wiener Konzerthaus. Beim Gespräch im Senatsaal der Universität trafen sich die beiden Schulkollegen Alfred Bader und Carl Djerassi – und redeten erstmals seit jener Zeit wieder in deutscher Sprache miteinander.

Der erste neue Lieben-Preis wurde an den ungarischen Neurophysiologen Zoltan Nusser verliehen. Isabel und Alfred Bader nahmen zufrieden und glücklich an der Veranstaltung teil. Im Englischen gibt es den Ausdruck der „good chemistry“ zwischen Menschen. Eine solche bestand zwischen den Ehepaaren Bader und Mang, dem damaligen Präsidenten der Akademie. Auch das erwies sich als gute Fügung.

und die Stiftung der Baderpreise

Die Wien-Besuche der Baders in den nächsten Jahren waren eine Zeit voller positiver Dynamik. In fast logischer Konsequenz wurden die beiden Bader-Preise nacheinander ins Leben gerufen:

- Der Bader Preis für Geschichte der Naturwissenschaften, inspiriert durch die Loschmidt-Forschung und

- der Bader Preis für Kunstgeschichte, getragen von dem Wunsch des Stifters und genialen Experten für Barockkunst, dass diese in der Stadt des Barocks auch umfassend gewürdigt werden sollte.

Bader - der Mäzen

Das Triptychon der von Bader gestifteten Preise – ein Zufall? „Als zufällig bezeichnen wir eine Sache nur, wenn wir ihre Ursache nicht kennen.“ hat schon Baruch Spinoza in den Ethika geschrieben.

Alfred Bader hat sein erfolgreiches Leben aus der Wissenschaft heraus entwickelt. Die Chemie hat ihm von Anfang an Halt gegeben und ihn zeitlebens begleitet. Der Lieben Preis soll daher den Besten ihres Faches den weiteren Berufsweg ebnen. Das war neben der großartigen Versöhnungsgeste sein eigentliches Motiv, das Preisgeld bereitzustellen.

In der Chemiegeschichte wiederum hat der Industrielle Alfred Bader in späten Jahren wieder zu eigener Forschungsarbeit gefunden, mit dem Ziel zur historischen Wahrheit zu gelangen, dabei Wesentliches aufzuzeigen und zugleich einem großen Wissenschaftler Gerechtigkeit widerfahren zu lassen. Dieser Preis soll vor allem auch jüngere Naturwissenschaftler motivieren, sich mit der Geschichte und der gesellschaftlichen Bedeutung ihres Faches zu befassen.

Der Preis für Kunstgeschichte scheint da zunächst nicht hineinzupassen: „Studiere die Wissenschaft der Kunst! Studiere die Kunst der Wissenschaft! Nimm wahr, dass alles mit allem anderen verbunden ist!“ heißt es allerdings schon bei Leonardo da Vinci. Die Liebe zum Sammeln, die Liebe zur Kunst sind gleichermaßen wie alles andere Tun von Alfred Bader Ausdruck einer intellektuellen Gesamtpersönlichkeit. Im Geschäftsleben handelt er beherrscht und scharf logisch denkend. Auf der anderen Seite vermag er durch seine besondere eidetische Begabung in Bruchteilen von Sekunden spontan Verborgenes in Bildern wahrzunehmen, das dem normalen Betrachter verschlossen bleibt.

Das erfüllte und erfolgreiche Leben Alfred Baders ist somit zugleich auch eine Mahnung an Naturwissenschaftler, sich aus der Beschränktheit ihrer Disziplinen herauszubewegen.

Die Ignaz-Lieben Gesellschaft zur Erforschung der Geschichte der Naturwissenschaften

Das Ignaz-Lieben-Projekt war mit der Preis-Wiedererrichtung allerdings nicht ganz abgeschlossen. Die Idee einer engen Zusammenarbeit von Naturwissenschaftlern und Historikern sollte in einem Initiativkolleg der Universität weiterleben. Der Wissenschaftshistoriker Mitchell Ash, Professor an der Universität Wien, hat hier von Anfang an die Federführung übernommen, mit großem Erfolg das Initiativkolleg zur Bewilligung geführt und aus diesem mittlerweile ein großes FWF-Doktoratsprogramm entwickelt.

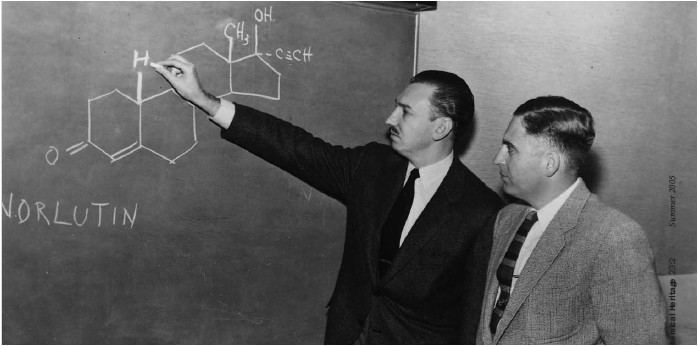

Zusätzlich wurde 2006 die Ignaz-Lieben-Gesellschaft gegründet, deren Ziel eine umfassende Förderung und Dokumentation der Geschichte der Naturwissenschaften in Österreich und den angrenzenden Ländern der ehemaligen Donaumonarchie ist, wobei die gegenseitige Durchdringung von Wissenschaft, Gesellschaft, Politik und Kultur herausgearbeitet werden soll. Die systematische Zusammenarbeit von an Geschichte interessierten Naturwissenschaftlern mit professionellen Historikern bewährt sich, die Gesellschaft verweist auf ein sehr erfolgreiches Wirken. Parallel zur Lieben-Preisverleihung findet jährlich entweder ein Workshop oder ein Symposium statt, beispielsweise „Über die Wurzeln der Sexualhormonforschung“ (2008), in welchem Zeitzeugen vortrugen, „Zentraleuropäische Wissenschaft und Technologie im frühen 20. Jahrhundert“ waren Themen der folgenden Veranstaltungen. Auch das heurige Symposium knüpft mit „Wissenschaft, Technik, Industrie und das Militär in der Habsburgermonarchie im 1. Weltkrieg” an diese Themen an. welches vor zwei Wochen an der Technischen Universität stattfand, war ein Erfolg. Details zur Ignaz-Lieben-Gesellschaft und zu ihren Veranstaltungen finden sich auf der homepage: http://www.i-l-g.at/. .

Vor nicht einmal 200 Jahren, hat der große Wortschöpfer William Whewell den Begriff „scientist“ als Bezeichnung für jene Naturphilosophen geprägt, welche ihre Wissenschaft auf das Messbare und Wägbare beschränken wollten. Letztlich ging es dabei um den aufkommenden grundsätzlich reduktionistischen Ansatz der Experimentalforschung, welcher mittlerweile den Triumph und die Dominanz der modernen Naturwissenschaften herbeigeführt hat. Die damals kreierten Fachdisziplinen - wie Physik, Chemie, Biologie - haben sich mittlerweile zu Wissenschaftsstämmen mit eigener Kultur entwickelt. Von manchen werden sie bereits als beengende Silos wahrgenommen. Heute ist es daher ein wichtiges Anliegen geworden, die reduktionistische Enge der Wissenschaftsdisziplinen aufzubrechen. Diese Forderung gilt nicht zuletzt auch für die unzeitgemäße Trennung von Geistes- und Naturwissenschaften. Mit ihrer verpflichtenden Zusammenarbeit von Geistes- und Naturwissenschaftlern kann die Lieben Gesellschaft dazu sicher einen Beitrag leisten.

[1] Der Chemiker und Physiker Joseph Loschmidt (1821 - 1895), Professor an der Universität Wien. stellte in seinem 1861 erschienenen Buch „ Chemische Studien“ als erster Strukturformeln organischer Verbindungen dar - insgesamt von 368 Verbindungen -, wobei er für Benzol eine ringförmige Struktur vorschlug (4 Jahre vor Kekule, dem die Entdeckung des Benzolrings zugeschrieben wird). Loschmidt folgerte, daß die meisten aromatischen Verbindungen als Derivate des Benzols C6H6 angesehen werden können, ebenso wie die aliphatischen Verbindungen als Derivate des Methans CH4. Bekannt wurde Loschmidt vor allem durch die nach ihm benannte Konstante: der Zahl der Moleküle eines idealen Gases, die sich in einem definierten Volumen befinden.

[2] A.Bader, Josef Loschmidt the father of Molecular Modelling . Royal Institution Proceedings 64 (1992), pp. 197–2–05. http://www.loschmidt.cz/pdf/father.pdf (link existiert nicht mehr)

[3] Der Ignaz-Lieben-Preis - 1862 von Adolf Lieben gestiftet –wurde 1937 zum letzten Mal verliehen. Durch eine großzügige Stiftung von Alfred Bader konnte er 2004 zum ersten Mal wieder vergeben werden.

Weiterführende Links

http://www.i-l-g.at/PDF/dokumente/Lieben-Preis-2.pdf

http://stipendien.oeaw.ac.at/de/geschichte-des-ignaz-l-lieben-preises

Zur Preisvergabe 2013: http://www.oeaw.ac.at/deutsch/aktuell/presse/pressemeldungen/aktuelle-na...

Sigma-Aldrich – weltweit größte, von Alfred Bader aufgebaute Feinchemikalienfirma: http://www.sigmaaldrich.com/customer-service/about-us/sigma-aldrich-hist...

Recycling & Wachstum — Vom Ursprung des Lebens bis zur modernen Gesellschaft.

Recycling & Wachstum — Vom Ursprung des Lebens bis zur modernen Gesellschaft.Fr, 29.11.2013 - 08:56 — Peter Schuster

![]()

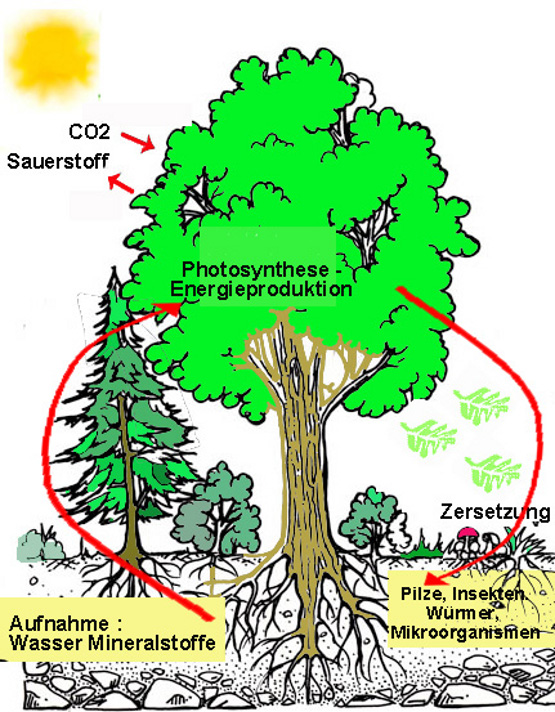

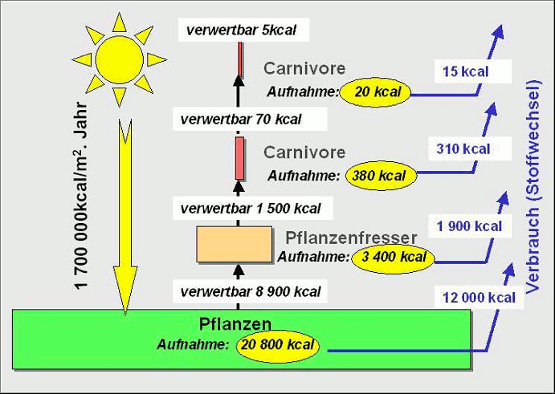

Exponentielles Wachstum erschöpft sehr rasch und effizient die vorhandenen Ressourcen. Ist ein essentielles Reservoir entleert und eine Auffüllung nicht möglich, so stirbt die Mangel leidende Population aus. Dementsprechend liegt die einzige Möglichkeit mit raschem Wachstum zurecht zu kommen in der Wiederverwertung - dem Recyceln – von Material.

Exponentielles Wachstum erschöpft sehr rasch und effizient die vorhandenen Ressourcen. Ist ein essentielles Reservoir entleert und eine Auffüllung nicht möglich, so stirbt die Mangel leidende Population aus. Dementsprechend liegt die einzige Möglichkeit mit raschem Wachstum zurecht zu kommen in der Wiederverwertung - dem Recyceln – von Material.

Der britische Nationalökonom und Sozialphilosoph Robert Malthus (1766 - 1834) dürfte wohl der Erste gewesen sein, der sich mit den Konsequenzen auseinandersetzte, wenn Wachstum in Form einer geometrischen Progression* erfolgt. Konkret hatte er in einigen amerikanischen Kolonien, die über ausreichend Ressourcen verfügten, beobachtet, daß sich die Bevölkerung im Zeitabstand von jeweils 25 Jahren verdoppelte. In seinem „Essay on the Principle of Population” [1] stellte Malthus die These auf, dass sich die Population der Menschen in einer geometrischen Progression (1, 2, 4, 8, 16, 32, 64, 128…..) vermehrt, die Nahrungsmittelproduktion dagegen bestenfalls in arithmetischer Progression (linear; 1, 2, 3, 4, 5,6,…), dass es daher zu einer Auseinanderentwicklung von Lebensmittel-Nachfrage und Angebot kommen müsste. Als Konsequenz prognostizierte er eine steigende Verknappung der Lebensmittel, die zur fortschreitenden Verelendung der Bevölkerung, Hungersnöten, Krieg und Epidemien führen sollte.

Ununterbrochenes, grenzenloses Wachstum – eine Vervielfachung durch Autokatalyse* - wird heute üblicherweise durch eine Exponentialfunktion* dargestellt, wobei dafür auch unlimitierte Ressourcen angenommen werden. Eine klassische Veranschaulichung bedient sich der Metapher von den Seerosen: Angenommen, Seerosen verdoppeln täglich die Fläche, die sie auf einem Teich bedecken. Wenn sie vor drei Tagen ein Achtel des Teichs bedeckt hatten und damit kaum sichtbar waren, hatten sie sich vor zwei Tagen auf ein Viertel, vor einem Tag bereits auf die Hälfte des Teichs ausgedehnt und nehmen heute die gesamte Oberfläche ein – eine Katastrophe, da sie damit Licht abhängiges Leben im darunter liegenden Wasser verhindern.

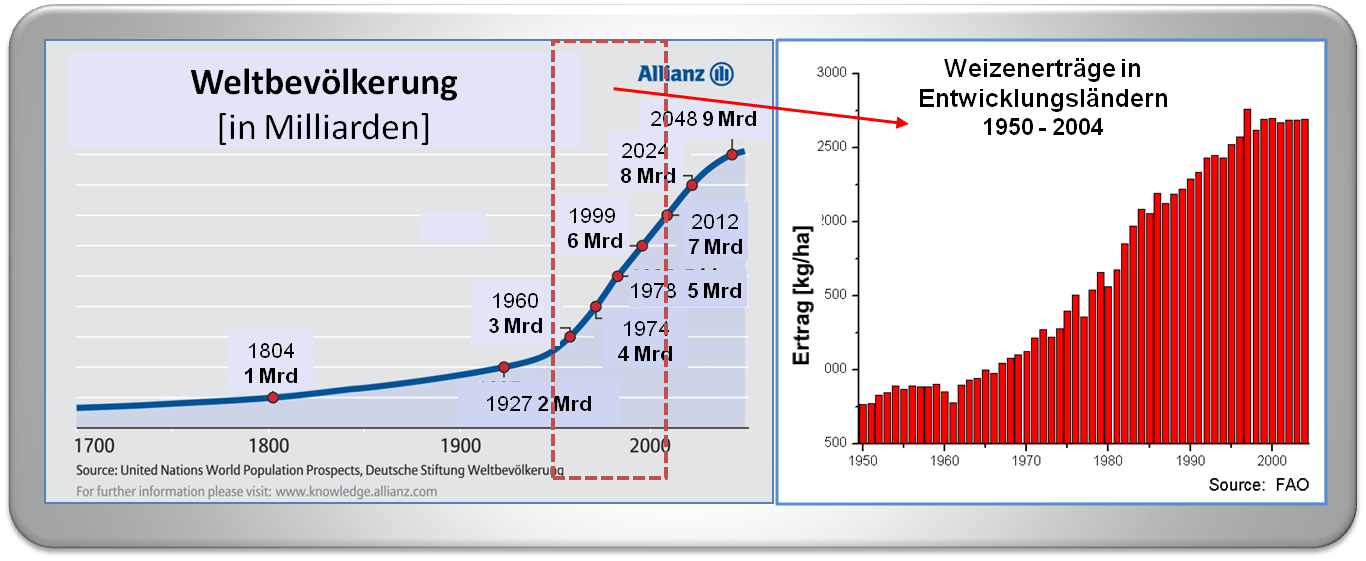

Malthus hatte die einfache und nach wie vor gültige Voraussage gemacht, dass das Auseinanderdriften von Bevölkerungswachstum und Nahrungsmittelproduktion zu Hungerkatastrophen führen muss und nur durch Geburtenkontrolle in Schach gehalten werden kann (Abbildung 1).

Abbildung 1. Essay on the Principle of Population. Robert Malthus veröffentlichte diese Abhandlung anonym im Jahre 1798 [1].

Abbildung 1. Essay on the Principle of Population. Robert Malthus veröffentlichte diese Abhandlung anonym im Jahre 1798 [1].

Auch, wenn neue Technologien, wie beispielsweise die „grüne Revolution“ der 1960er und 1970er Jahre, zu nicht vorhersehbaren Steigerungen der Ernteerträge führten, änderten diese nichts an dem prinzipiellen Problem:

Ein Mehr an verfügbarer Nahrung verursacht einen Anstieg in einer Population und zwar so lange, bis ein Grenzwert erreicht wird, an welchem die nun die vergrößerte Population zu hungern beginnt. Das Malthus-Modell zeigt Geburtenkontrolle als den einzig richtigen Ausweg aus dem Dilemma.

Wachstum und Biologische Evolution

Die biologische Evolution basiert darauf, dass sich die einzelnen Individuen in Populationen von Spezies multiplikativ vermehren und miteinander konkurrieren. Auch, wenn exponentielles Wachstum nur über eine limitierte Zeitspanne aufrecht erhalten werden kann, bleibt der Prozeß einer „Selection of the fittest“ der gleiche – ob es sich nun um eine wachsende, gleichbleibende oder sogar sinkende Population handelt, solange die Spezies nicht als Ganzes ausstirbt. Erfolgreiche Konkurrenz bei exponentiellem Wachstum gelingt nur Varianten, die exponentiell mit höherer Fitness oder solchen, die „hyperbolisch“ wachsen.

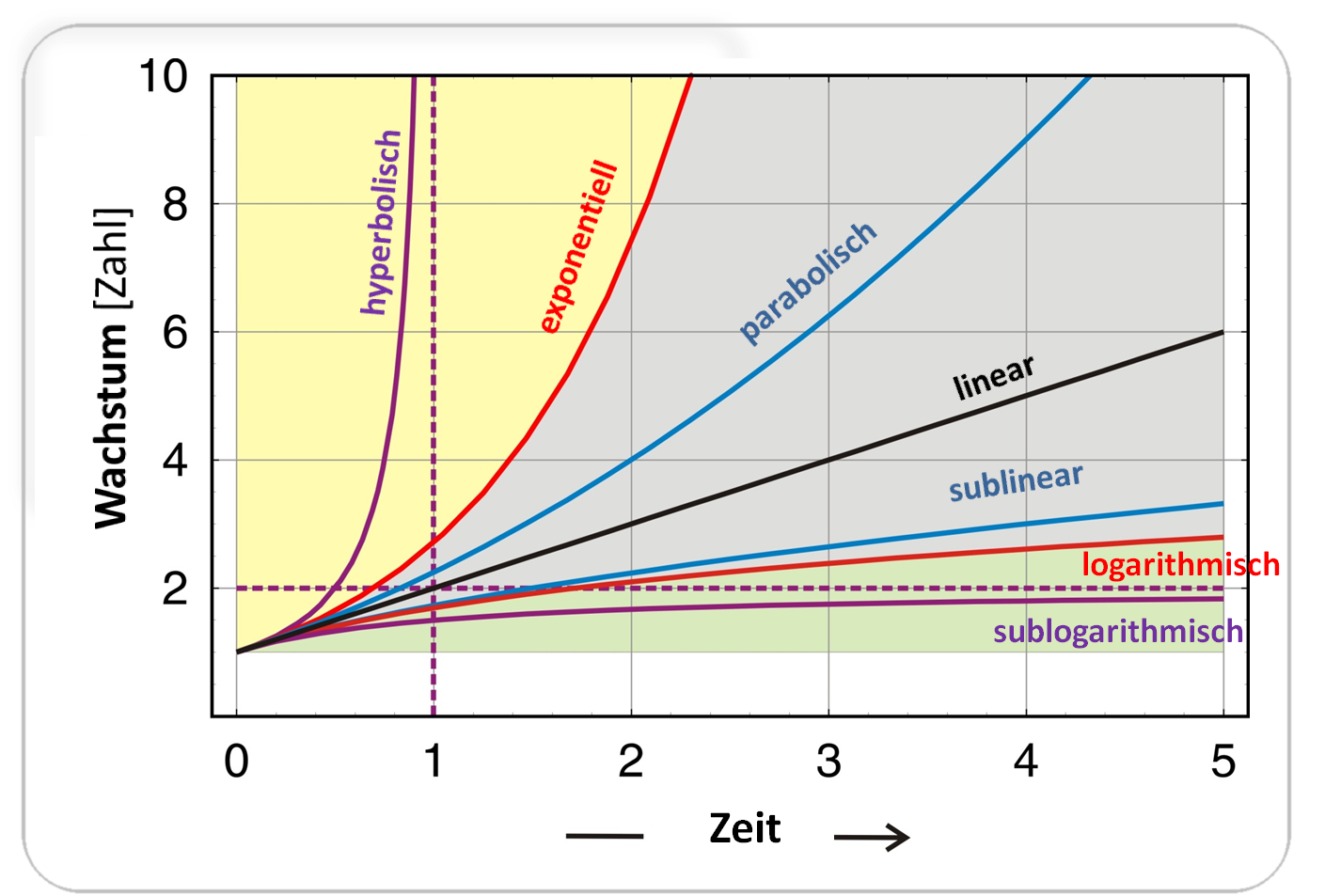

Abbildung 2 illustriert unterschiedliche Formen von Wachstumskurven

Abbildung 2. Grenzenloses Wachstum – Idealisierte Funktionen. Zu Beginn (Zeitpunkt: 0) haben alle Funktionen den Wert: x(0) = 1. Wachstum: i) hyperbolisch ( x(t) = 1 / (1-t) ; lila) ii) exponentiell (x(t) = expt; rot) iii) parabolisch (x(t)=(1+t/2)²; blau), iv) linear (x(t) = 1 + t; schwarz), v) sublinear (x(t) = 1+t/(1+t); blau), vi) logarithmisch (x(t) = 1+log(1+t); rot), sublogarithmisch (x(t) = 1+t/(1+t); lila). Im gelben Bereich erreicht das Wachstum den Wert „unendlich“ in endlicher Zeit, im grauen Bereich dagegen erst nach unendlicher Zeit und es bleibt endlich Im grünen Bereich auch nach unendlicher Zeitdauer.

Abbildung 2. Grenzenloses Wachstum – Idealisierte Funktionen. Zu Beginn (Zeitpunkt: 0) haben alle Funktionen den Wert: x(0) = 1. Wachstum: i) hyperbolisch ( x(t) = 1 / (1-t) ; lila) ii) exponentiell (x(t) = expt; rot) iii) parabolisch (x(t)=(1+t/2)²; blau), iv) linear (x(t) = 1 + t; schwarz), v) sublinear (x(t) = 1+t/(1+t); blau), vi) logarithmisch (x(t) = 1+log(1+t); rot), sublogarithmisch (x(t) = 1+t/(1+t); lila). Im gelben Bereich erreicht das Wachstum den Wert „unendlich“ in endlicher Zeit, im grauen Bereich dagegen erst nach unendlicher Zeit und es bleibt endlich Im grünen Bereich auch nach unendlicher Zeitdauer.

Hyperbolisches, exponentielles und parabolisches Wachstum verbrauchen sehr rasch und effizient die vorhandenen Ressourcen. Dementsprechend liegt die einzige Möglichkeit mit raschem Wachstum zurecht zu kommen in der Wiederverwertung - dem Recyceln – von Material: stärkeres Wachstum von Varianten mit begrenzter Lebensdauer führt zu einer erhöhten Absterberate und damit zu mehr an recycelbarer Substanz. Auch lineares Wachstum und das noch langsamere logarithmische Wachstum nähern sich der Unendlichmarke, wenn man unendlich lang wartet.

In allen diesen Fällen ist Recycling also eine Voraussetzung für effizientes Wachstum aber keine ausreichende Bedingung – es können ja Ressourcen, wie beispielsweise Energie, dabei (vollständig) aufgebraucht werden.

Nur die langsamste „sublogarithmische“ Form erreicht auch nach unendlich langer Zeit einen endlichen Grenzwert. Es erscheint wichtig darauf hinzuweisen, daß nur diese langsamste Form des Wachstums mit einem Reservoir an vorhandenen Ressourcen auskommen und über längere Zeit aufrechterhalten werden kann. Dieser Typ Wachstumskurve zeichnet sich dadurch aus, dass die Wachstumsraten mit zunehmender Dauer sinken.

Jede Form grenzenlosen Wachstums – charakterisiert durch Wachstumskurven mit hyperbolischem, exponentiellem, parabolischem, linearen und sublinearem Verlauf – kann nur für begrenzte Zeitdauer andauern. Es muß hier nicht besonders betont werden, daß Ökonomen, die eine konstante Wachstumsrate predigen, in der einen oder anderen Weise einem Trugschluß unterliegen.

Recycling ist ausreichend um Darwinsche Selektion in einer konstant bleibenden Population fortbestehen zu lassen und Grenzen der Populationsgröße können prinzipiell für alle Formen des Wachstums erzwungen werden – Recyceln der Ressourcen hilft dann die Populationen zu erhalten.

Ursprung des Lebens – Autokatalyse - Recycling

Theoretische und experimentelle Modelle zum Ursprung des Lebens konzentrieren sich üblicherweise auf ein oder mehrere der drei Kernpunkte, nämlich auf die

i. Erzeugung, Speicherung und Erhaltung von Information in den Genen,

ii. Aufnahme von Energie und Umwandlung zur Treibkraft von Stoffwechselprozessen,

iii. Schaffung eines abgeschlossenen lokalen Umfelds durch Kompartimentbildung

Basis der Darwin’schen Selektion und unabdingbar auch in den frühesten Phasen der Evolution - im Übergang von unbelebter zu lebender Materie - ist dann der autokatalytische Prozeß, der zur Vervielfachung der Spezies führt (s.o.). Der noch präbiotische Stoffwechsel muß die zentrale Hauptaufgabe lösen: die Produktion der Bausteine, aus denen die wichtigsten Biomoleküle, Proteine und Nukleinsäuren, hergestellt werden können - ein riesiges Reservoir an organischen Verbindungen in ein relativ kleines Set von Schlüsselmolekülen zu „kanalisieren“.

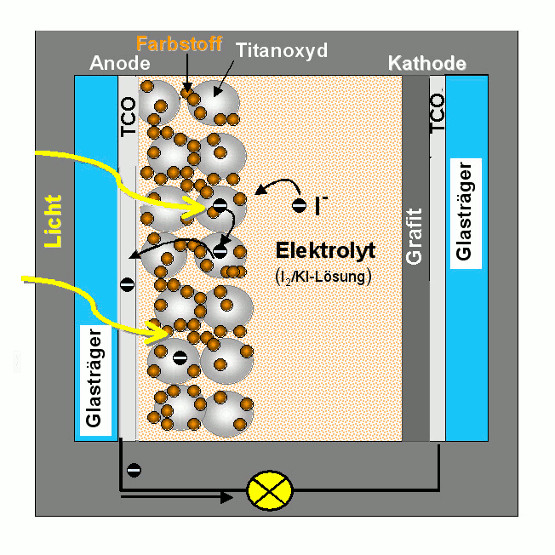

In die Diskussion, wie ein derartiger früher Stoffwechsel ausgesehen haben könnte, ist erst in jüngster Zeit auch der Aspekt des Recycelns eingeflossen. Es bedeutet zweifellos einen Selektions-Vorteil, wenn in der Reaktion A + X → 2X das autokatalytische Produkt X zu einem weiteren Produkt D abgebaut wird, das in einem Energie-abhängigen Prozess wieder in den Ausgangsstoff A zurückverwandelt – recycelt - werden kann. Ein derartiges Recycling-System, das seine Energie aus photochemischen Reaktionen beziehen sollte, wurde bereits vor drei Jahrzehnten vorgeschlagen [2]. Interessanterweise bezieht die erste, mit eigenem Stoffwechsel ausgestattete Protozelle (das „Los Alamos Bug“) ihre Energie aus einer photochemischen Reaktion an einem Rutheniumkomplex.

Offensichtlich ist Photochemie die geeignetste Taktik um energieabhängige Reaktionen zu ermöglichen: Licht als Energiequelle erscheint ja unerschöpflich. Lichtabhängige an Membranen gekoppelte Reaktionen dürften auch die ersten und bis jetzt effizientesten Wege gewesen sein, auf welchen präbiotische und frühe prokaryotische Zellen Energie „einfingen“ und in chemische Energie umwandelten [3]: Die ältesten uns bekannten Fossilien sind vermutlich Relikte ursprünglicher photosynthetischer Cyanobakterien [4]. Dazu kommt, daß photochemische Reaktionen hochspezifisch ablaufen und zu hohen Produktmengen führen können, vor allem, wenn die Quantenausbeute keine Rolle spielt.

Bevölkerungswachstum und Recycling

Kommen wir nun wieder auf unser ursprüngliches Problem zurück – die Ernährung einer exponentiell wachsenden Weltbevölkerung (Abbildung 3).

Malthus, dessen Prognosen offensichtlich nicht eintrafen, konnte natürlich den technischen Fortschritt im vergangenen Jahrhundert, insbesondere die „Grüne Revolution“ nicht voraussehen. Auf Grund der Verwendung von modifizierten Pflanzen, synthetisch hergestellten Düngemitteln, Pestiziden, Bewässerungssystemen und der Mechanisierung der Feldarbeit sind die Ernteerträge weltweit enorm gestiegen und haben trotz der enorm gestiegenen Population den „Hunger in der Welt“ reduziert (aber nicht beseitigen können).

Abbildung 3. Innerhalb der letzten 60 Jahre ist die Weltbevölkerung nahezu auf das Dreifache angewachsen. Gleichzeitig führte die „Grüne Revolution“ zur enormen Steigerung der Ernteerträge.

Abbildung 3. Innerhalb der letzten 60 Jahre ist die Weltbevölkerung nahezu auf das Dreifache angewachsen. Gleichzeitig führte die „Grüne Revolution“ zur enormen Steigerung der Ernteerträge.

Die Grundprobleme bestehen aber weiter. Das Bevölkerungswachstum setzt sich ungebrochen fort, die landwirtschaftliche Produktion verlangsamt sich, es gibt nur wenige neue, für den Ackerbau geeignete Gebiete, die Verstädterung reduziert zusätzlich landwirtschaftlich nutzbare Flächen. Dazu kommen alle die durch die Intensivwirtschaft verursachten negativen Effekte auf die Umwelt.

Damit stellt sich die Frage, inwieweit Ressourcen/Rohstoffe langfristig zur Verfügung stehen werden und wie diese aus industriellen Abfällen wiedergewonnen werden können.

Wertvolle Metalle lassen sich leicht recyceln, die meisten Metall erzeugenden Konzerne besitzen ein Repertoire an Verfahren, um jegliche Art von Metall aus Rückständen und Schlacken aufzureinigen, und sie wenden diese Verfahren an, wann immer die Preise auf dem Weltmarkt genug hoch sind.

Hinsichtlich der landwirtschaftlichen Nutzung sind Verbrauch und Recycling zweier essentieller Elemente zu beachten, die eine conditio sine qua non für jegliches Leben darstellen: Stickstoff und Phosphor.

Recycling von Stickstoff

Gasförmiger molekularer Stickstoff (N2) ist ubiquitär, findet sich in unerschöpflichen Mengen in in unserer Atmosphäre. Allerdings kann Stickstoff in dieser Form weder von Pflanzen noch von Tieren verwertet werden, nur einige Bakterienstämme sind dazu in der Lage und produzieren daraus Stickstoff-haltige Moleküle, zum Nutzen aller anderer Organismen.

Bis zum Beginn des 20. Jahrhunderts gab es nur zwei Formen von Techniken zur Gewinnung eines für uns verwertbaren Stickstoffs, durch Verwendung von: i) Leguminosen – d.i. Hülsenfrüchte –, die in Symbiose mit den Stickstoff-assimilierenden Bakterien der Spezies Rhizobium leben, und ii) Dünger aus Guano, dem Exkrement von Vögeln, welche auch heute noch in großen Kolonien die Inseln entlang der Küste von Peru und Chile besiedeln. Die Verwendung von Guano als Dünger bedeutet ein Recyceln des Stickstoffs, allerdings mit einer unglaublich langen Zykluszeit.

Diese Situation änderte sich vollkommen, als zwei deutsche Chemiker, Fritz Haber und Carl Bosch, ein Verfahren erfanden, in welchem sie aus molekularem Stickstoff und Wasserstoff mit Hilfe eines Katalysators Ammoniak herstellen konnten. Auch, wenn dieses Verfahren äusserst viel Energie verbraucht, haben die aus dem synthetischen Ammoniak hergestellten Düngemittel den natürlichen Guanodünger praktisch vollständig ersetzt – vermutlich war dies die wichtigste Grundlage einer ausreichernden Nahrungsmittelproduktion für eine enorm gewachsene und weiter wachsende Weltbevölkerung. Die Relevanz der Ammoniaksynthese ist vielleicht am besten aus einer Abschätzung von Robert Horwath aus dem Jahr 2008 ersichtlich: dieser findet, dass bereits mehr als 80 % des in den menschlichen Proteinen eingebauten Stickstoffs eine Haber-Bosch Anlage von innen gesehen haben.

Der Stickstoff-Zyklus ist ein hervorragendes Beispiel für ein Recycling mit einem riesigen Reservoir. Die Produktion von synthetischem, verwertbarem Stickstoff stößt praktisch an keine Grenzen außer an die der Energieversorgung und der Umweltprobleme auf Grund der intensivst betriebenen Landwirtschaft und der durch Düngemittel verursachten Verunreinigung von Wasser.

Recycling von Phosphor

Phosphor ist ein essentielles Element in unseren Biopolymeren, beispielsweise den Nukleinsäuren. Intensiver Ackerbau benötigt Phosphat-haltigen Dünger, darüber hinaus sind Phosphate unabdingbare Bestandteile moderner Waschmittel.

Die herkömmliche Quelle für Phosphor sind phosphatreiche Mineralien (z.B. Apatit). Frühere Lagerstätten sind nun aber bereits weitgehend erschöpft, geeignete neue, mit geringer (Schwermetall-) Verunreinigung zunehmend schwerer zu finden. In Analogie zu dem häufig verwendeten Begriff „peak oil“ – also dem Ende des Erdöls - sprechen einige Experten schon vom „peak phosphorous“.

Mittlerweile hat die Phosphor-Industrie Strategien entwickelt um Phosphate aus Abwässern zurückzugewinnen. Hier besteht aber ein gravierender Unterschied zum Recyceln von Stickstoff, der in reiner Form aus einem praktisch unerschöpflichen Reservoir erhalten wird: Die Rückgewinnung von Phosphaten erfolgt aus hochverdünnten Lösungen, die jede Menge Verunreinigungen enthalten, eine Aufreinigung von Phosphaten, die bereits in Flüsse oder gar ins Meer gelangt sind, ist ökonomisch praktisch nicht vertretbar.

Fazit

Exponentielles Wachstum erschöpft alle Reservoire an Ressourcen. Ist ein essentielles Reservoir entleert und eine Auffüllung nicht möglich, so stirbt die Mangel leidende Population aus. (Experimentelle Modelle zur präbiotischen Evolution haben hier ihre Schwachstellen.)

Recyceln bietet eine Lösung des Problems, da die Menge des recycelten Materials mit der Menge an Autokatalysatoren gekoppelt ist und die Effizienz des Recyclingprozesses, zusammen mit anderen Faktoren, die Menge an Autokatalysatoren bestimmt, die aufrechterhalten werden kann. Dies gilt in gleicher Weise für die früheste („primordial“) Form der Autokatalyse, für die biologische Evolution der Spezies und ebenso für die Entwicklung der menschlichen Gesellschaften.

[1] Robert Malthus: Eine Abhandlung über das Bevölkerungsgesetz oder eine Untersuchung seiner Bedeutung für die menschliche Wohlfahrt in Vergangenheit und Zukunft, nebst einer Prüfung unserer Aussichten auf eine künftige Beseitigung oder Linderung der Übel, die es verursacht (6. Auflage, aus dem Englischen übersetzt und frei abrufbar; Digitale Texte der Bibliothek des Seminars für Wirtschafts- und Sozialgeschichte, Uni Köln) http://www.digitalis.uni-koeln.de/Malthus/malthus_index.html

[2] Schuster, P.; Sigmund, K. Dynamics of evolutionary optimization. Ber. Bunseges. Phys. Chem. 1985, 89, 668-682.

[3] Lane, N.; Martin, W.F. The origin of membrane bioenergetics. Cell 2012, 151, 1406-1416.

[4] Schopf, J.W. Fossil evidence of Archaean life. Phil.Trans.Roy.Soc.London B 2006, 361, 869-855.

Eine ausführlichere Version dieses Essays (in Englisch) findet sich auf der homepage des Autors: http://www.tbi.univie.ac.at/~pks/Preprints/pks_365.pdf

*Glossar

Autokatalyse: Das Produkt (X) einer Reaktion ist ein Katalysator, der von ihm selbst katalysierten Reaktion: (A) + X → 2X. Da im Verlauf der Reaktion das Produkt - die Menge des Katalysators - ansteigt, nimmt die Geschwindigkeit der Reaktion exponentiell zu.

Arithmetische Progression: Zahlenfolge, in der aufeinanderfolgende Zahlen sich um denselben Betrag erhöhen, z.B. um 1: 1, 2, 3, 4, 5, 6,…..

Geometrische Progression: Zahlenfolge, in der aufeinanderfolgende Zahlen in einem konstanten Verhältnis stehen, also mit demselben Faktor multipliziert werden; z.B. mit dem Faktor 2: 2, 4, 8, 16, 32, 64,….

Exponentialfunktion: In gleich langen Zeitintervallen ändert sich der Funktionswert um denselben Faktor: y = aX (a: Basis, x: Exponent), beispielsweise beträgt bei einer Basis 2 der Funktionswert nach 1, 2, 3, 4, 5, 6 Zeitintervallen: 21, 22, 23, 24, 25, 26,………also: 2, 4, 8, 16, 32, 64,….Der Verlauf natürlicher Prozesse des Wachstums und auch des Zerfalls (z.B. des radioaktiven Zerfalls) wird am besten durch eine Funktion mit der sogenannten natürlichen Basis e, der von Leonhard Euler eingeführten Zahl = 2,7182….dargestellt, also f(x) = ex.

Weiterführende Links

Nur noch Stehplätze. Thomas Robert Malthus: Das Bevölkerungsgesetz (Christoph Neßhöver 1999, Zeit online) http://www.zeit.de/1999/21/199921.biblio-serie_.xml

Bevölkerungswachstum: Die Welt ist nicht genug (M. Becker, Spiegel Online 2011). http://www.spiegel.de/wissenschaft/mensch/bevoelkerungswachstum-die-welt-ist-nicht-genug-a-794203.html

Forschungszentrum – Reparaturwerkstatt – Gewebefarm. — Das Ludwig Boltzmann Institut für Experimentelle und Klinische Traumatologie

Forschungszentrum – Reparaturwerkstatt – Gewebefarm. — Das Ludwig Boltzmann Institut für Experimentelle und Klinische TraumatologieFr, 22.11.2013 - 05:01 — Heinz Redl

![]()

Mit dem Ziel die diagnostischen und therapeutischen Maßnahmen in Unfallchirurgie und Intensivmedizin zu verbessern, wurde 1980 das Ludwig Boltzmann Institut für Experimentelle und Klinische Traumatologie gegründet. Bahnbrechende Innovationen im Bereich der regenerativen Medizin und der Behandlung von Schock und Sepsis und deren erfolgreiche Anwendung an Patienten haben der Institution weltweite Anerkennung gebracht. Heinz Redl ist seit 15 Jahren Leiter dieses Instituts, das Grundlagenforschung mit angewandter Forschung und translationaler Medizin verknüpft.

Mit dem Ziel die diagnostischen und therapeutischen Maßnahmen in Unfallchirurgie und Intensivmedizin zu verbessern, wurde 1980 das Ludwig Boltzmann Institut für Experimentelle und Klinische Traumatologie gegründet. Bahnbrechende Innovationen im Bereich der regenerativen Medizin und der Behandlung von Schock und Sepsis und deren erfolgreiche Anwendung an Patienten haben der Institution weltweite Anerkennung gebracht. Heinz Redl ist seit 15 Jahren Leiter dieses Instituts, das Grundlagenforschung mit angewandter Forschung und translationaler Medizin verknüpft.

Die Grundlagen für derartige Heilerfolge stammen aus der traumatologischen Forschung, der „Wissenschaft von Verletzungen und Wunden sowie deren Entstehung und Therapie“. In diesem, bei uns seit dem Beginn der 1970er Jahre etablierten Gebiet leistet Österreich weltweite Pionierarbeit, liefert bahnbrechende Entwicklungen und beispielgebende Resultate.

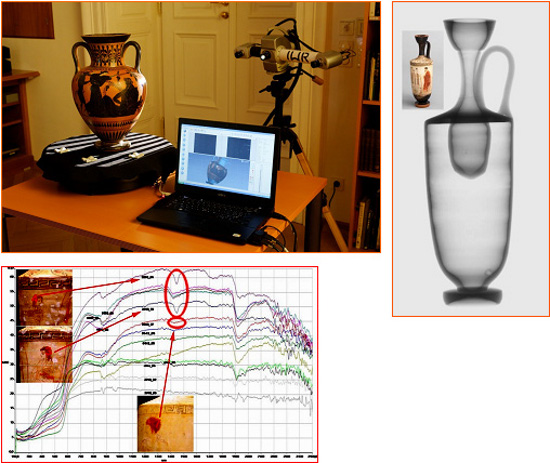

Abbildung 1. Altgriechische Traumatologie: Achilleus bandagiert den Arm seines verletzten Freundes Patroklos (Vasenmalerei 5 Jh AC)

Abbildung 1. Altgriechische Traumatologie: Achilleus bandagiert den Arm seines verletzten Freundes Patroklos (Vasenmalerei 5 Jh AC)

40 Jahre Traumaforschung in Österreich

Entsprechend der für sie im Gesetz festgelegten Verpflichtung, die ständige Verbesserung der Behandlung von Patienten zu gewährleisten, hat die Allgemeine Unfallversicherungsanstalt (AUVA) bereits 1973 ein Forschungsinstitut für Traumatologie eingerichtet, das zusammen mit dem 1980 gegründeten Ludwig Boltzmann Institut für experimentelle und klinische Traumatologie (LBI Trauma) das Forschungszentrum für Traumatologie bildet und im Wiener Unfallkrankenhaus Lorenz Böhler angesiedelt ist. Im Jahr 1998 wurde zur Unterstützung die non-profit Organisation Trauma Care Consult eingegliedert.

Eine Aussenstelle wurde im Jahr 2003 in Linz errichtet, die in Kooperation mit der Blutbank des oberösterreichischen Roten Kreuz betrieben wird und sich der Gewinnung und Erforschung von humanen, adulten Stammzellen widmet.

Das LBI Trauma: „vom Labortisch zum Krankenbett“

Das Ziel der Arbeiten am LBI Trauma ist es die diagnostischen und therapeutischen Maßnahmen in Unfallchirurgie und Intensivmedizin zu verbessern. Dies erfolgt einerseits durch eigene Forschungsprojekte im Bereich der Geweberegeneration und Polytrauma/Schock/Sepsis, aber auch durch Evaluation und praktische Anwendung internationaler Forschungsergebnisse.

Forschungsmaxime ist dabei die Verbindung von experimenteller Forschung und klinischer Anwendung „vom Labortisch zum Krankenbett“- die sogenannte translationale Forschung. Durch eine enge interdisziplinäre Zusammenarbeit präklinischer und klinischer Experten-Teams gehen gesicherte Ergebnisse aus der Grundlagenforschung rasch und direkt in die Anwendung über und kommen speziell Unfall-Patienten zugute.

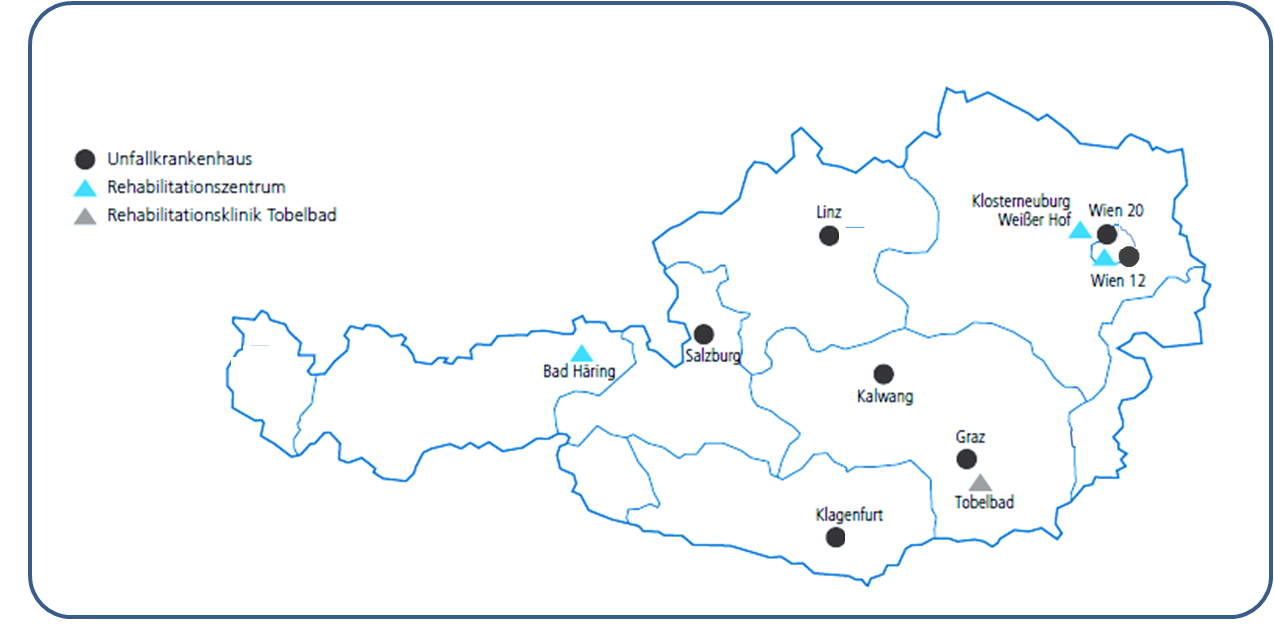

In diesem Sinne „versorgt“ das LBI Trauma die 7 Unfallkrankenhäuser und 4 Rehabilitätszentren der AUVA mit den Ergebnissen seiner Forschung und Entwicklungen (Abbildung 2).

Abbildung 2. Forschung für rund 4,7 Millionen Versicherte. Neueste medizinische Kenntnisse und Methoden werden in den 7 Unfallkrankenhäusern und 4 Rehabiltationszentren der AUVA zur Behandlung von jährlich rund 375 000 Verletzten eingesetzt.

Abbildung 2. Forschung für rund 4,7 Millionen Versicherte. Neueste medizinische Kenntnisse und Methoden werden in den 7 Unfallkrankenhäusern und 4 Rehabiltationszentren der AUVA zur Behandlung von jährlich rund 375 000 Verletzten eingesetzt.

Das Team des LBI besteht zur Zeit aus rund 80 Personen - aus Chemikern, Biochemikern, Ärzten, Tierärzten, Physikern, Medizin- und Elektrotechnikern. Auf Grund dieser multidisziplinären Zusammensetzung ist es möglich ein sehr großes Spektrum angewandter Forschung abzudecken.

Das LBI Trauma ist in fächerübergreifenden Kooperationen in vielen Gebieten der Humanmedizin engagiert und an zahlreichen österreichischen und europäischen Forschungsprojekten beteiligt (u.a. GENAU und EU-Projekte Angioscaff, BIODESIGN)

Eine Kooperation mit der Medizinischen Universität Wien, der Bernhard Gottlieb Universitätszahnklinik und dem Oberösterreichischen Roten Kreuz hat 2006 zur Gründung des österreichischen Forschungsclusters für Geweberegeneration geführt, in welchem das LBI die zentrale Rolle spielt. Dieser Cluster führt in einer gemeinsamen Forschungsstruktur das interdisziplinäre Forscherteam des LBI und Spezialisten für bildgebende Verfahren (z.B. Hochfeld Magnet Resonanz) zusammen mit klinischen Experten für die Regeneration von Knochen, Gelenken und Nerven. Das Ziel dieses Forschungsclusters ist ein besseres Verständnis der Regeneration von Weichteilen, Knorpel, Knochen und Nerven und - darauf aufbauend - neue und verbesserte Behandlungsmethoden.

Erfolg und internationale Reputation des Forschungszentrums werden nicht nur durch die Anzahl an wissenschaftlichen Publikationen (über 1200 seit 1980), Monographien und Patentfamilien dokumentiert, sondern auch durch die Rolle in den internationalen Fachgesellschaften, die es durch die Organisation großer internationaler Fachkongresse in Wien erlangt hat, beispielsweise des dritten Weltkongresses der Tissue Engineering & Regenerative Medicine Society (TERMIS) im September 2012, die den Autor zu ihrem europäischen Präsidenten gewählt hat.

Das Institut ist auch in der Aus- und Weiterbildung von Ärzten, Studenten und PostDocs involviert und veranstaltet Lehrgänge in Partnerschaft mit dem Technikum Wien (" Tissue Engineering and Regenerative Medicine"), der TU Wien ("Biomedical Engineering") sowie der Medizinischen Universität Wien ("Regeneration of Bone and Joint").

Finanziert wird das LBI Trauma von der AUVA und der Ludwig Boltzmann Gesellschaft, darüber hinaus auch direkt über Projekte aus der Industrie und der Europäischen Union.

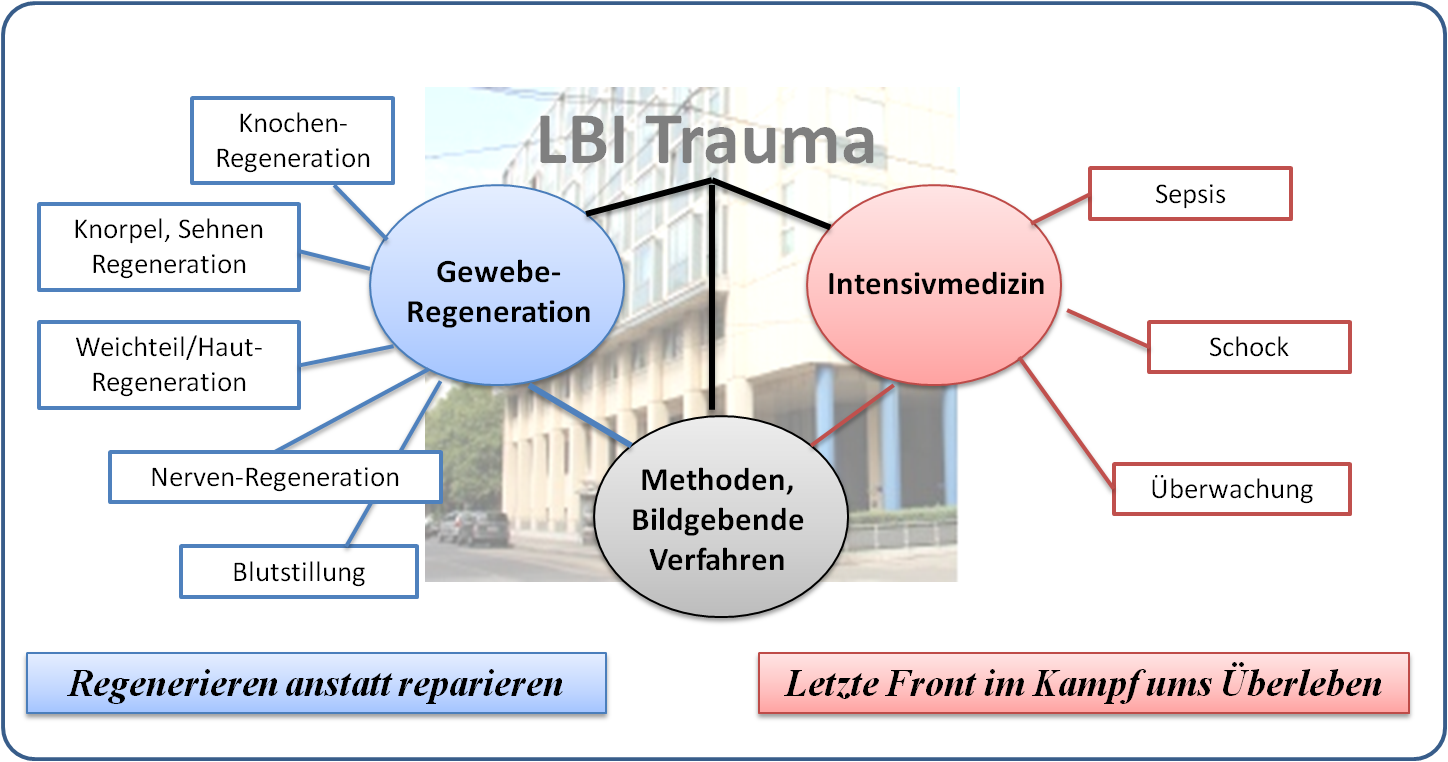

Forschungsschwerpunkte des LBI

Die beiden großen Forschungsbereiche am LBI Trauma sind Geweberegeneration und Intensivmedizin. Daneben bietet das Institut als Service für klinische Mediziner Ausstattung und Methoden, die es erlauben Forschungsfragen in der Unfallchirurgie kompetent zu bearbeiten. Ein Überblick über die Forschungsbereiche und Projekte ist in Abbildung 3 gegeben.  Abbildung 3. Forschungsbereiche und Projekte des LBI Trauma. Details zur Organisation der Bereiche und einzelnen Projekte: siehe http://trauma.lbg.ac.at/

Abbildung 3. Forschungsbereiche und Projekte des LBI Trauma. Details zur Organisation der Bereiche und einzelnen Projekte: siehe http://trauma.lbg.ac.at/

Schwerpunkt: Geweberegeneration

Ein Zugang zur Geweberegeneration ist es, die Wundheilung durch den Einsatz von Wachstumsfaktoren oder speziellen Wundverbänden zu beschleunigen.

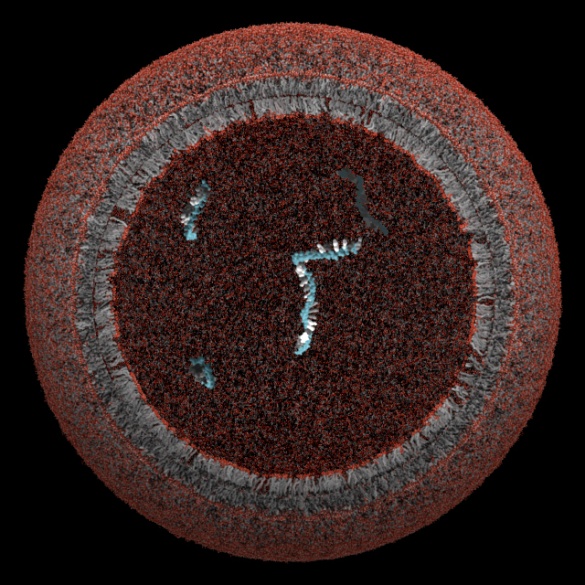

Ein anderer Zugang beruht auf der Möglichkeit Stammzellen zu verwenden, die aus verschiedenen Quellen, wie zum Beispiel aus dem Knochenmark, dem Fettgewebe, der Plazenta oder der Nabelschnur gewonnen werden können. Diese Stammzellen können entweder mit Hilfe von Wachstumsfaktoren oder mechanischer Stimulierung oder einer Kombination von beiden in vitro oder in vivo in die gewünschte Zellart differenziert werden. Die Zellen werden dann in spezifischen Trägerstrukturen („Scaffolds“) oder Hydrogele eingebracht, die biochemisch stabil und biokompatibel und zusätzlich biologisch abbaubar sein müssen.

Der Verbund aus Zellen und Trägerstrukturen wird in passende Modelle implantiert oder injiziert und dort auf Biokompatibilität geprüft und die regenerative Kapazität gemessen. Bei Haut können spezielle Belastungs-/Dehnungstests durchgeführt werden, bei Knochen und Osteosynthesematerialien stehen verschiedene biomechanische Tests und morphologische Methoden zu Verfügung.

Blutstillung (Hämostase). Neben der Weiterentwicklung der Gewebeklebung mit Fibrin werden neue Methoden zum Stoppen von Blutungen erforscht. Ein großes Problem stellen Gerinnungsstörungen bei der Versorgung von Schwerverletzten dar, die mit massiven Blutungen einhergehen und zu einer deutlich erhöhten Mortalität führen.

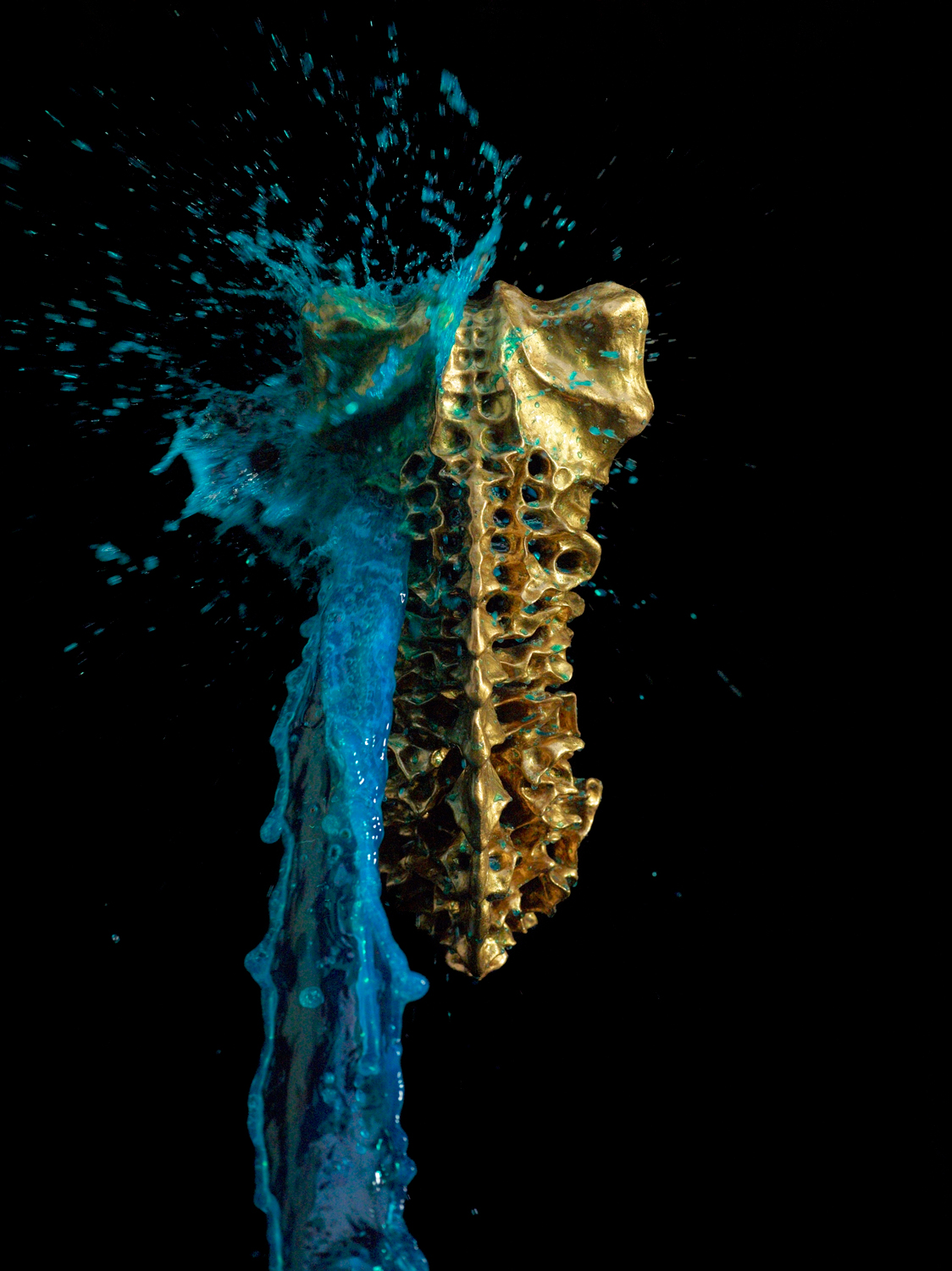

Knochenregeneration. Hier geht es um die Entwicklung neuer und die Verbesserung existierender Behandlungsverfahren (Ersatzmaterialien und Implantatoberflächen) und die Untersuchung aktueller Therapiekonzepte im Hinblick auf ihre Effizienz und ethische Vertretbarkeit in der Praxis. Grundlagenforschung und optimierte biomechanische und histologische Methoden unterstützen die Arbeit des Teams.

Neurogeneration. Der Bereich der Neuroregeneration beschäftigt sich mit den kritischsten Ereignissen von Traumapatienten und ist daher in zwei spezialisierte Teams gegliedert:

Das erste Team befasst sich mit Rückenmarksverletzungen (d.i. mit dem Zentralnervensystem), wobei das Hauptaugenmerk bei speziellen bildgebenden Verfahren, den molekularen Mechanismen und den therapeutischen Aspekten liegt, um Sekundärschäden nach einer Rückenmarksverletzung zu reduzieren.

Das zweite Team beschäftigt sich mit der Regeneration peripherer Nerven und der Reinnervation ihrer Zielorgane (wie zB. der Muskulatur). Es werden sowohl experimentelle wie auch klinische Studien durchgeführt um eine Verbesserungen der Regeneration peripherer Nerven und der mikrochirurgischen Nervennahttechnik zu erreichen. Auch sind die Verbesserung der funktionellen Endergebnisse durch die Nützung und Verstärkung der Plastizität des Gehirnes Teil dieser Forschung. Können Nervendefekte nicht direkt „genäht" werden, so werden diese mit Zell - besiedelten und Wachstumsfaktor - versetzten bioresorbierbaren künstlichen Nerven-Transplantaten überbrückt.

Knorpel-/Sehnenregeneration. Im Bereich Knorpel und Sehnen wird an der Verbesserung der Regeneration, nach einem Trauma, durch neue Kombinationen von Zellen, Biomaterialien und Wachstumsfaktoren beziehungsweise mechanischer Stimulierung gearbeitet. Ziel ist das Austesten neuer Methoden und die Überführung in die klinische Anwendung, wobei vor allem bildgebende Verfahren zur Qualitätskontrolle eingesetzt werden sollen.

Schwerpunkt: Intensivmedizin

Dieser Forschungsbereich versucht die wesentlichen pathologischen Vorgänge aufzuklären, die der Sepsis und dem septischen Schock zugrunde liegen. Zum Einen vermag das Blutgefäß-system die Organe nicht mehr ausreichend zu durchbluten und zum Anderen vermögen die Zellen nicht mehr ausreichend Sauerstoff aus dem Blut aufzunehmen.

Die Forschungsziele sowohl experimentell als auch klinisch im Bereich von Schock und Trauma umfassen das Verständnis der zugrundeliegenden Mechanismen. Dazu zählt vor allem die Aufklärung der molekularen Mechanismen, die das Entzündungsgeschehen und Organversagen im septischen Schock verursachen. Das Hauptaugenmerk gilt dabei auf den so genannten reaktiven Sauerstoff Spezies (ROS), Stickstoffmonoxyd (NO), verschiedenen Übergangsmetallen, sowie wichtigen pro- and anti-entzündlichen Mediatorstoffen, die an den pathologischen Veränderungen bei Sepsis und in Folge beim Organversagen beteiligt sind.

Ein weiterer wichtiger Aspekt ist die Untersuchung der durch Sepsis ausgelösten Funktionsänderungen und Schädigungen an Zellen und subzellulären Organellen. Damit wird versucht, Einblicke in die Kausalkette der Vorgänge zu bekommen, die letztlich zum (multiplen) Organversagen und zum Tod führen kann. Das Hauptaugenmerk dabei liegt auf den Mitochondrien und ihrer Funktion unter septischen Bedingungen.

Angestrebt wird eine maßgeschneiderte Therapie („personalisierte Medizin“), die vom individuellen Immunstatus des Patienten ausgeht und sensitive Nachweismethoden zur Diagnose, Planung und Überwachung individueller therapeutischer Maßnahmen anwendet.

Reparieren und/oder regenerieren. Auf dem Weg zum künstlich hergestellten Organersatz

Mit der Weiterentwicklung des „Fibrinklebers“ hat das Institut Geschichte geschrieben. Wo früher Blutgefäße oder Gewebeteile genäht wurden, wird heute weltweit geklebt. Die Möglichkeiten und Vorteile dieses für jegliche „Reparaturen“ – Blutstillung, Verschluß von verletzten Gewebeteilen, Wundheilung, etc. – essentiellen Verfahrens sollen demnächst in einem eigenen Artikel: „Kleben statt Nähen“ dargestellt werden.

Wenn heute die volle Funktionsfähigkeit von kranken, verletzten bis hin zu zerstörten Organ(teil)en wieder hergestellt werden soll, kann dies im Prinzip durch gezielte Züchtung von körpereigenen Geweben – Tissue Engineering – bereits bewerkstelligt werden. Derartige Züchtungen basieren auf menschlichen Zellen, welche die in Frage stehenden Gewebe – Knochen, Sehnen, Knorpel, Haut, etc. – zu regenerieren vermögen. Diese Zellen werden auf eine Trägerstruktur aufgebracht und durch mechanische Reize oder biologische Stimuli (z.B. Wachstumsfaktoren) zur Vermehrung angeregt. Stammzellen, vor allem aus dem Fettgewebe des betroffenen Patienten, sind hervorragend für derartige Züchtungen geeignet. Als Trägerstruktur dienen biologische Materialien wie humanes Fibrin oder Seiden-Fibroin.

Diese Methode wird bei uns beispielsweise für schwere Knieverletzungen, wie den Kreuzbandriß, entwickelt: Eine Trägerstruktur aus Seidenfibroin wird mit Stammzellen besiedelt und – in Kooperation mit der TU Wien - im Bioreaktor gedehnt und gedreht, wie dies unter natürlicher Belastung der Fall ist. Die Trägerstruktur weist die Stabilität, Reißfestigkeit und Beweglichkeit eines natürlichen Kreuzbandes auf und kann, in das Kniegelenk eingesetzt, sofort mechanisch belastet werden. Innerhalb weniger Monate haben die Stammzellen dann ein neues, natürliches und belastbares Band generiert und die Trägerstruktur wurde vom Körper abgebaut. Dieses im Tiermodell bereits erprobte Verfahren soll in Kürze an Patienten getestet werden.

Kombinationen von Zellen auf Trägern mit wachstumsfördernden Maßnahmen, wie Wachstumsfaktoren und/oder mechanischen Reizen (z.B. Stroßwellen), erbringen Verbesserungen in der Regeneration von Nerven und ihrer Funktionalität. Mit derartigen Systemen könnten beispielsweise Erfolge bei Querschnittsgelähmten erzielt werden. Stoßwellentherapie wird übrigens bereits seit längerer Zeit in der Therapie von schlecht heilenden Knochenbrüchen und chronischen Wunden eingesetzt.

Die Vision in Zukunft verletzte oder auch altersbedingt veränderte Gewebe nicht nur reparieren sondern mittels künstlich hergestellter Produkte auch regenerieren zu können, erscheint durchaus plausibel.

Weiterführende Links

Webseite des LBI Trauma: http://trauma.lbg.ac.at/de/

Video über das LBI Trauma: http://www.meetscience.tv/episode/LBI_Trauma 7:12 min

Webseite der Allgemeinen Unfallversicherungsanstalt: http://www.auva.at/mediaDB/754204_Alles%20aus%20EINER%20Hand.pdf

Formaldehyd als Schlüsselbaustein der präbiotischen Evolution — Monade in der Welt der Biomoleküle

Formaldehyd als Schlüsselbaustein der präbiotischen Evolution — Monade in der Welt der BiomoleküleFr, 15.11.2013 - 06:07 — Christian Noe

![]()

Physik und Chemie reichen aus, um die Entstehung der großen Klassen der Biomoleküle ( der Kohlehydrate, Lipide, Aminosäuren, Nukleinsäuren) aus den in der Uratmosphäre vorhandenen Molekülen zu erklären. Das kleine Molekül des Formaldehyds war auf Grund seiner ihm innewohnenden Reaktivität in der Lage ein nahezu vollständiges Set an präbiotischen Biomolekülen aufzubauen.

Physik und Chemie reichen aus, um die Entstehung der großen Klassen der Biomoleküle ( der Kohlehydrate, Lipide, Aminosäuren, Nukleinsäuren) aus den in der Uratmosphäre vorhandenen Molekülen zu erklären. Das kleine Molekül des Formaldehyds war auf Grund seiner ihm innewohnenden Reaktivität in der Lage ein nahezu vollständiges Set an präbiotischen Biomolekülen aufzubauen.

Beginnend mit den Pythagoräern, über Gordano Bruno und Gottfried Leibniz bis hin in unsere Zeit verwenden Philosophen den Begriff Monade – abgeleitet vom griechischen „monas“: die Einheit - um „elementare Einheiten“ zu beschreiben, aus denen die Erscheinungen der Wirklichkeit zusammengesetzt sind. Auch, wenn Bedeutungen und Deutungen der Monaden unterschiedlich ausfallen, so ist es deren gemeinsames Charakteristikum , daß sie nicht nur kleinste physische Einheiten, sondern auch deren Funktionen definieren.

Ein „verstaubter“ Begriff in der modernen Biologie?