2011

2011 Redaktion Wed, 20.03.2019 - 01:01Was ist und was bedeutet für uns die Nano-Biotechnologie? - Ein Diskurs von Karin Saage und Eva Sinner

Was ist und was bedeutet für uns die Nano-Biotechnologie? - Ein Diskurs von Karin Saage und Eva SinnerFr, 15.12.2011 - 04:20 — Eva Sinner & Karin Saage

Die „Technik“ als in der ursprünglichen Wortbedeutung Kunstfertigkeit, handwerkliches Geschick, ist etwas, das schon immer zum Menschen gehörte. Schon lange vor der sprichwörtlich gewordenen Erfindung des Rades hat sich der Mensch verschiedener Werkzeuge bedient, um seine Umwelt, aber auch sein eigenes Leben zu verändern. Natürlich immer im guten Glauben an eine Verbesserung.

Auch die Gegenwart ist schon so sehr von Technik geprägt, dass wir kaum im Stande wären, die Uhr zurückzudrehen. Selbst wenn derartige Phantasien im Moment Konjunktur haben – ein Leben wie vor hundert Jahren wäre ja schließlich kein Leben frei von Technik.

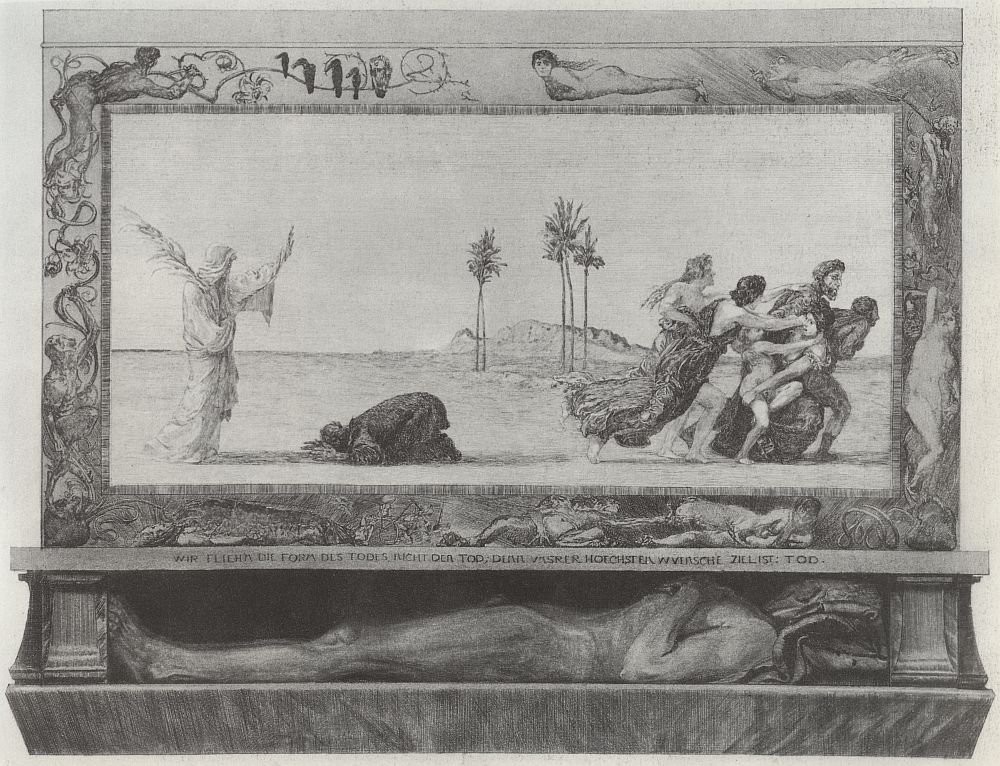

Am Beginn der Menschheit: Die Erschaffung der Menschen durch Prometheus, den Kreativität, »Technik« (Kunstfertigkeit, handwerkliches Geschick) und die Eigenschaft auszeichnen, das (Nach)denken seinen Handlungen voranzusetzen. Athene hilft indem sie ihre Klugheit und ihr Wissen zur Verfügung stellt (Marmorrelief, 3 Jh bC, Louvre)

Allerdings zeigen solche Phantasien, wie zwiespältig der Mensch der Technik, die doch wesensmäßig zu ihm gehört, gegenübersteht. Als wolle er mit dem Blick zurück immer wieder seiner ihm zur Verfügung stehenden Technik entfliehen.

Ein Grund dafür liegt sicher darin, dass in der jüngeren Vergangenheit sich die Biotechnologie als neue Technologie zu verselbständigen und damit immer unbeherrschbarer zu werden schien. Ein neuer Forschungszweig der Biotechnologie, der die kleinsten Bausteine des Lebens thematisiert, ist die Nanobiotechnologie, von „nanos“, dem Zwerg – die Grösseneinheit, die 1000mal kleiner als der Mikrometer ist und damit die Größe von Molekülen beschreibt.

In Kombination mit den Werkzeugen der Gentechnik, ist es ja sogar eine Hoffnung an die Nanobiotechnologie, dass mit ihr neue Möglichkeiten angegangen werden können, die dem Menschen innovativ helfen und damit wertvoll sein können.

Die Frage muß also eher lauten: wie kann man die Gesellschaft mit dem Begriff der Nanobiotechnologie anfreunden und nicht eine Ablehnung riskieren, wie es bei Gentechnik und Strahlenforschung durchaus passiert ist? Wie kann man ein Bewusstsein dafür schaffen, dass dieses Forschungskonzept immens potent, aber nicht bedrohlich sein muss?

Sicher ist ein wichtiger Schritt zu einem positiveren Verhältnis gegenüber der Technik eine breitere Diskussion innerhalb der Gesellschaft darüber, worin das Ziel dieser technischen Entwicklungen bestehen soll.

Wissen wir denn, was das Optimum für den Menschen ist, zu dem ihm die die aktuelle Forschung verhelfen soll?

Meistens denkt man bei dieser Frage an das, was sich ein jeder wünscht: Gesundheit, Glück und ein langes Leben. Aber schon bei der Gesundheit fangen die Probleme an. Was ist Gesundheit?

Heutzutage wird Gesundheit als Freiheit von sämtlichen Schmerzen definiert. Die Akzeptanz gegenüber altersentsprechenden Beschwerden und Makel ist sehr gesunken und bei vielen kaum noch vorhanden. Dass ein langes Leben so ohne weiteres auch nicht Ziel einer Optimierung sein kann, wussten schon die alten Griechen. Als Äos, die Göttin der Morgenröte für ihren Geliebten Tithonos bei Zeus ewiges Leben erbat, um es mit ihm gemeinsam zu verbringen, vergaß sie damit auch den Wunsch nach ewiger Jugend zu verknüpfen. Tithonos alterte immer weiter, ohne je sterben zu können – Ein nicht erstrebenswertes Schicksal, endete er so als zikadenähnliche Daseinsform. Es könnte also einen Kompromiss sein zwischen Lebensqualität und dem Recht, dem Leben zu entkommen, wenn das „Maß“ als voll empfunden wird.

Mit der Definition des Glückes ist es hingegen schwieriger: letztendlich wird Glück sicherlich von jedem ein wenig anders definiert werden. Und das ist wiederum ein Glück für die Forschung. Es scheinen sich für viele, auch skurril anmutende Technologieentwicklungen, Forscher und Geldgeber zu finden, wie zum Beispiel der Temperaturanzeige durch Farbveränderungen auf Getränkedosen, tragbare Telephone, die photographieren können oder Heimroboter in Hundegestalt. Und Vieles, das noch vor einigen Jahren nicht existent war, ist heute eine Selbstverständlichkeit, und Gefahrenpotentiale (siehe Atomenergie) sind durch die Regulativa der Gesellschaft durchaus als „gezähmte“ Technologien existent.

Aber es gibt auch technische Entwicklungen, deren ausschließlicher Nutzen unbestritten ist. Es gibt zum Beispiel neue Oberflächenbeschichtungen von Implantaten, die durch ihre Ähnlichkeit mit einer natürlichen Gewebeoberfläche, das Anwachsen bestimmter Zellarten begünstigen und damit stabiler in den Knochen integriert werden als herkömmliche Implantate. Sowohl bei Hüft- als auch bei Zahnimplantaten ist das eine wesentliche Entwicklung, um die Stabilität zu verbessern.

Wegen der gründlichen Tests ist es grundsätzlich ein langer Weg vom Labor zum Patienten, deshalb ist es auch sehr wichtig, eine breite Basis von Neuentwicklungen zu legen, damit die Wahrscheinlichkeit steigt, dass es einige Forschungsprojekte bis hin zu ihrer Bestimmung in der Gesellschaft schaffen.

Die Identifizierung neuer Medikamente wird ebenfalls durch die Nanobiotechnologie beeinflusst werden: die Strukturaufklärung von Molekülen des menschlichen Körpers, die für die Wirkung von Medikamenten entscheidend sind durch Erschaffen neuer experimenteller Ansätze in der Proteinforschung. Durch die Kenntnis einer molekularen Struktur können viel gezielter, und damit viel schneller, passende Substanzen gefunden werden, die dann als Medikamente eingesetzt werden können. Damit seien an dieser Stelle nur einige willkürliche Beispiele für die Relevanz und Präsenz technologischer Entwicklungen genannt. Es wird anhand dieser Beispiele noch klarer, wie breit das Spektrum in der Nanobiotechnologie ist und es ist zugegeben fast unmöglich, über alle Fortschritte in allen Gebieten informiert zu sein.

Ein Blick in Richtung eines möglichen Ursprungs für technologische Entwicklungen gibt mehr Aufschluss über den Platz in unserer Gesellschaft, den die Technik unserer Meinung nach haben sollte.

Vereinfacht lässt sich sagen, dass es drei Grundmotive für eine technologische Neuentwicklung gibt: wirtschaftliche, gesellschaftliche und „individuelle“. Die gesellschaftlichen und wirtschaftlichen Motivationen sind in jüngster Zeit sehr nahe aneinander gerückt – was wirtschaftlich von Bedeutung ist, findet meist auch in der Gesellschaft eine hohe Akzeptanz und umgekehrt. Ein drittes Motiv ist ein sehr unkontrollierbares und fast als Zufallsereignis zu werten: die persönliche Neugier und Forschungsleidenschaft eines Menschen, der sogar unter widrigen Umständen eine Idee verfolgt. Giordano Bruno, Galileo Galilei oder Sokrates sind hier gute Beispiele für solche Forschernaturen. Die Vorstellung seines Weltbildes war gesellschaftlich extrem unpopulär und dennoch hat er seine Überzeugung bist zur Selbstaufgabe verfolgt. Das ist jetzt ein prominentes und ‚altes’ Beispiel, es würde zu weit führen, alle hier aufzuführen, die praktisch gegen die herrschende Meinung geforscht haben oder durch die Wahl eines abseitigen Themas in einem unpopulären Gebiet geforscht haben.

Es ist nicht sinnvoll die drei Motive mit einer ethischen und moralischen Wertung zu versehen. Aber es ist sehr wichtig im Sinne der Gesellschaft, die alle drei Quellen letzten Endes trägt, diese Motive zu erkennen und am Leben zu erhalten. Dabei ist letzteres Motiv besonders im Auge zu behalten, da Spitzenforschung, die zu neuen Technologien führt, oft aus unpopulären Nischen zu stammen schien. Diese Art der Forschung an neuen Technologien findet in einer geschützten Atmosphäre statt – entkoppelt von wirtschaftlichen und gesellschaftlichen Motiven.

Als prominentes Beispiel für so eine „Nische“, in der ein ausgezeichneter Forscher seine Erkenntnisse erzielte, ist hier Gregor Mendel zu nennen, der in einem Klostergarten Grundlagen der Pflanzengenetik erkannt hat. Seine Forschung fand ohne wirtschaftliche Unterstützung und allein aus persönlichen Motiven statt. Es wäre wünschenswert, wenn der individuelle Forscherdrang auch in Zukunft in einer Art Nischenförderung erhalten bleiben könnte, auch wenn das auf den ersten Blick den aktuellen Elitebestrebungen entgegenwirkt.

Geduld ist etwas, das die Gesellschaft momentan nicht mit der Wissenschaft zu haben scheint. Es werden Programme aufgesetzt und Ziele gesteckt, die gewachsene Ausbildungsstrukturen sowohl an Schulen als auch an Universitäten in kurzer Zeit neu strukturieren wollen – oft mit Vorbildern aus der Wirtschaft. Das mag für manche Bereiche ein geeigneter Ansatz sein, aber tendiert dazu, die Nischen zu eliminieren, in denen langfristig Forschung und Ausbildung stattfindet. Es gibt keine planbare Forschung, da es keine Vorhersehbarkeit von Visionen gibt, aus denen Neuentwicklungen werden können.

Was planbar ist, ist die Ausbildung wissenschaftlichen Nachwuchses. Ausbildung, auf welcher Ebene auch immer, ist untrennbar mit Forschung verknüpft, und je früher ein Interesse an Naturwissenschaften geweckt werden kann, um so eher entsteht eine Gesellschaft, die in Wechselwirkung mit ihren Forschungeinrichtungen sich über mögliche Ziele austauschen kann sowie eine Gesellschaft, die überhaupt erst motivierte und geeignete Forscher hervorbringt. Dabei ist ein Exkurs über den Ursprung von Forschern aus unserer Gesellschaft im Folgenden nötig.

Zunächst sei folgende Arbeitshypothese vorgestellt: Wenn die Forscher aus dem gesamten Spektrum der Gesellschaft stammen, werden sie auch Ziele und Visionen haben können, die dann wiederum den vielen Wünschen und Vorstellungen der Gesellschaft entsprechen. Waren es in der Vergangenheit oft die „reinen“ Disziplinen wie zum Beispiel Medizin, Chemie, Physik, Biologie und Mathematik aus denen die Kernentwicklungen hervorgingen, ist es in der Gegenwart mehr und mehr das fächerübergreifende Forschen, aus dem Fortschritt entsteht. Die Bildung einer Kommission aus verschiedensten Gebieten und Disziplinen, um Bewertungsgrundlagen von menschlicher Stammzellforschung in Deutschland zu beurteilen, ist ein Beispiel dafür, wie wichtig das Ringen um einen gesellschaftlichen Konsens ist, schwierige Forschungsentwicklungen fächerübergreifend und gesellschaftskonform beurteilen zu können – es wird auch in Zukunft die Situation geben, dass Forschungsprojekte schnell und kompetent beurteilt werden müssen, die potenziell gefährlich oder aus moralischen und ethischen Gesichtspunkten untragbar erscheinen – ein wichtiger Punkt in der Diskussion um die synthetische Biologie.

Das ist nicht nur aus Gründen der beiderseitigen Akzeptanz zwischen Forschung und Gesellschaft wichtig. Genauso wie das Sprichwort mit den zwei Seiten einer Medaille, so hat auch die Forschung durchaus bedrohliche Seiten – und sei es auch manchmal nur aus Unkenntnis über die Tatsachen und Hintergründe von Forschungsrichtungen. Wer weiß denn schon in unserer Gesellschaft, was ein Gen eigentlich genau ist, und was die Argumente in der Diskussion um die Gentechnik an Pflanzen so mysteriös werden lässt, dass es offenkundig nur noch „Kontras“ gibt? Es gibt einfach bestimmte Reizworte, die inzwischen von vorne herein negative Reaktionen auslösen, wie zum Beispiel „Genfood“, „Pestizide“, „Tierversuche“. Häufig ist zu diesen Themen eine ausgewogene Diskussion nicht mehr möglich.

An dieser Stelle wäre ein „science communicator“ sinnvoll. Momentan gibt es bereits eine Anleitung, wie diese Kommunikation von den Wissenschaftlern selbst ausgehen könnte und zwar publiziert von der Europäischen Kommission, 2006. Dieses ist zwar schon ein wichtiger Ansatz, wird aber in unseren Augen nur zum Teil den Effekt haben, dass die Wissenschaft den Elfenbeinturm verlässt. Ein Wissenschaftler kann sich aus verschiedenen Gründen nicht neben seiner Forschung um die Außenwirkung seiner Tätigkeit in aller Konsequenz kümmern. Zum einen ist er nicht dafür ausgebildet, zum anderen fehlt es ihm auch schlicht an der Zeit. Unserer Erfahrung nach ist also ein Forscher oft auf geeignete „Übersetzer“ angewiesen.

Die Sensibilisierung in Medien, wie Zeitung und Fernsehen für aktuelle Forschungsergebnisse, hat zugenommen, jedoch ist es immer noch eher Zufall, welche Forschungsergebnisse der Öffentlichkeit mitgeteilt werden. Die Pressestellen der Forschungsinstitute müssen in ihrer Position gestärkt werden, um eine bessere Präsenz und Wirksamkeit zeigen zu können. Die Forscher könnten in diesem Bereich der Wissensverbreitung mehr Bereitschaft zeigen, mit Journalisten zu kommunizieren und könnten dafür durch ein Medientraining vorbereitet werden, denn dadurch fänden beide Seiten zu einer gemeinsamen Sprache. So könnte der Gesellschaft ihr aktueller wissenschaftlicher Kenntnisstand durch die bekannten Medien nahe gebracht werden.

Allerdings muss auch die Gesellschaft, an die die Forschungstätigkeit kommuniziert wird, in der Lage sein, ihr auf Augenhöhe begegnen zu können. Oben genannte, irrationale Reaktionen auf Reizworte entstehen aus Unverständnis und Verunsicherung. An dieser Stelle könnte ein direkter Kontakt zwischen Forschung und Schule eine Perspektive bieten, wie es in jüngster Zeit in Schülerlabors oder auf Wissenschaftsforen geschieht. In diesen Schülerlabors wird Bezug auf aktuelle Forschung genommen und anhand leicht verständlicher Experimente, wie zum Beispiel die Isolation von DNA Molekülen aus Pflanzen, soll das Interesse an Forschung geweckt werden. In Wissenschaftsforen, die in den Zentren verschiedener Städte organisiert werden, wird darüber hinaus ein entscheidendes Grundverständnis vermittelt, das zu einer differenzierten Beurteilung und daraus resultierenden Akzeptanz oder Ablehnung von technologischen Entwicklungen im Alltag führen kann.

Eine Stärkung der Kommunikation zwischen Gesellschaft und Forschern würde auch ein wenig zur Entkopplung wissenschaftlicher Entwicklungen von rein wirtschaftlichen Interessen beitragen. So soll eben nicht nur die Wirtschaft ihre Bedürfnisse an die Forschung formulieren; es wäre schön, wenn dieses auch die Gesellschaft täte. Wir sollten es eben nicht einfach der Wirtschaft überlassen, konkrete Ziele und Bedürfnisse an die Forschung zu formulieren. Damit wäre sichergestellt, dass Innovationsinitiativen, wie die der Bionanotechnologie, als Ergebnis von Forschungsaktivitäten im Interesse der Gesellschaft in ihrer Mitte einen Platz hat und haben wird. Mit dem Szenario von schon oft propagierten „Hybrid-Androiden“, als Ergebnis der Nanobiotechnologie, lassen wir uns noch ein wenig Zeit auf beiden Seiten: der Forschung, die davon noch weit entfernt ist und der Gesellschaft, die das Bedürfnis noch nicht geäußert hat.

Das weite Land — Wie Gene und chemische Botenstoffe unser Verhalten mitbestimmen

Das weite Land — Wie Gene und chemische Botenstoffe unser Verhalten mitbestimmenFr, 08.12.2011- 04:20 — Gottfried Schatz

Unser Charakter wird entscheidend durch die chemische Zwiesprache zwischen den Nervenzellen unseres Gehirns geprägt. Dieses Gesprächsnetz ist so komplex, dass es jedem Menschen seine eigene Persönlichkeit schenkt.

„Die Seele ist ein weites Land“ befand der Schriftsteller und Arzt Arthur Schnitzler, der in seinen Novellen und Dramen Sigmund Freuds Ideen mit aus der Taufe hob. Dieses weite Land der Seele ist jedoch schwer zu fassen, denn Religion, Dichtung, Psychologie und Medizin ordnen ihm jeweils andere Breitengrade zu. Ist es verwegen, dieses Land auch mit dem Kompass der modernen Naturwissenschaft zu erkunden? Darf ein Molekularbiologe auf Seelensuche gehen?

Dieses Wagnis kann nur gelingen, wenn wir „Seele“ enger als „Verhaltensmuster“ oder „Charaktereigenschaft“ definieren. Erst diese Beschränkung erlaubt die präzisen und überprüfbaren Fragen, an denen Naturwissenschaft ihre Kraft entwickelt. Und in der Tat - diese Kraft gewährt uns bereits atemberaubende Einblicke in die chemischen Vorgänge, die unsere Persönlichkeit prägen.

Eindrückliches Beispiel dafür waren gesunde Versuchspersonen, die nach Einnahme des Parkinson-Medikaments Dopa (ein Kürzel für Dihydroxyphenylalanin) bei Glücksspielen risikofreudiger wurden. Dies betraf jedoch nur diejenigen von ihnen, die eine seltene Variante eines bestimmten Gens ererbt hatten, das die Übertragung von Signalen zwischen Nervenzellen steuert. Dieses Gen tritt in verschiedenen Formen auf, die leicht unterschiedlich wirken und so das Verhalten eines Menschen gezielt beeinflussen können.

Nervenzellen verständigen sich untereinander vorwiegend mit Hilfe chemischer Botenstoffe. Meist sind dies einfache kleine Moleküle, wie das mit Dopa eng verwandte Dopamin, die Aminosäuren Glyzin und Glutamat, oder die Aminosäure-Abkömmlinge γ-Aminobuttersäure und Serotonin. Sie werden von einer elektrisch angeregten Senderzelle ausgestossen, wandern zu einer Empfängerzelle, binden sich an spezifische „Rezeptoren“ an deren Oberfläche, und lösen so in der Empfängerzelle ein elektrisches Signal aus.

All dies spielt sich in nur ein bis zwei Tausendstel einer Sekunde in einem hauchdünnen Spalt zwischen den birnenförmig aufgeblähten Enden der beiden Nervenzellen ab. Die beiden Nervenenden und der sie trennende Spalt bilden zusammen eine „Synapse“, die nach Übertragung des Signals wieder schleunigst vom Botenstoff gereinigt werden muss, um einen gefährlichen Dauerreiz der Empfängerzelle zu vermeiden.

Wie diese Reinigung erfolgt, hängt vom Botenstoff und von den beteiligten Nervenzellen ab. Manche Nervenzellen warten einfach darauf, dass der Botenstoff durch Diffusion von selbst verschwindet. Für die meisten Zellen ist dieser Vorgang jedoch zu langsam, sodass sie ihn aktiv beschleunigen: Manche Senderzellen saugen den von ihnen ausgesandten Botenstoff wieder auf, während Empfängerzellen ihre Rezeptoren für ihn maskieren können. Rezeptoren und Aufsaugmaschinen sind Proteine; ihr Bauplan ist in den entsprechenden Genen niedergelegt. Die Entschlüsselung der chemischen Struktur unseres gesamten Erbmaterials offenbarte die erstaunliche Vielfalt solcher Gene und damit auch von Synapsen, mit deren Hilfe unser Gehirn seine noch weitgehend rätselhafte Arbeit bewältigt. Wir kennen mehrere Dutzend Botenstoffe und für fast jeden gibt es eine Vielzahl verschiedener Rezeptor- und Aufsaugproteine, die auf den Botenstoff unterschiedlich ansprechen und eine Synapse unverwechselbar charakterisieren.

Vieles spricht dafür, dass dieses chemische Netzwerk unseren Charakter mitbestimmt. Der Botenstoff Dopamin lindert nicht nur die Leiden von Parkinson-Kranken, sondern kann bei ihnen auch intensive Glücksgefühle, Aggression oder zwanghafte Spielsucht auslösen. Und die Genvariante, die Dopa-behandelten Versuchspersonen erhöhten Wagemut verleiht, enthält den Bauplan für ein spezifisches Rezeptorprotein, über das Dopamin an einen Empfängernerv andockt. Diese Genvariante findet sich auch häufig in impulsiven, rastlosen oder aggressiven Menschen, die Mühe haben, sich über längere Zeit auf ein Thema zu konzentrieren oder sich in eine Gemeinschaft einzufügen. In unserer hoch organisierten Welt ist diese Genvariante meist von Nachteil, doch Nomaden scheint sie Vorteile zu verschaffen; vielleicht schenkt sie ihnen Wagemut und hilft ihnen so, neue Weide- und Jagdgründe zu erobern und Angreifer schneller und mutiger abzuwehren. Dafür spricht, dass diese Gen-Variante erst vor etwa 20'000 bis 40'000 Jahren entstand - also ungefähr zur Zeit, als moderne Menschen Afrika verliessen und nach Nordeuropa vordrangen – und dass sie sich seither in unserer Population behauptet hat. Neuere Untersuchungen haben gezeigt, dass ihre Träger ungewöhnlich bereitwillig sind, asoziale oder finanziell riskante Entscheidungen zu treffen.

Könnte es sein, dass diese Genvariante die periodischen Finanzkrisen unserer kapitalistischen Gesellschaft mitverschuldet?

Der Botenstoff Serotonin löst nicht nur, wie das Dopamin, Glücksgefühle aus, sondern beeinflusst auch das Sexualverhalten von Fliegen und Ratten: Verändert man in diesen den Serotonin-Stoffwechsel durch genetische Eingriffe oder Medikamente, so werden die Tiere homo- oder bisexuell. Und eine einzige Mutation in einem Rezeptorprotein für den Botenstoff Vasopressin kann ein monogames Wühlmaus-Männchen in einen passionierten Don Juan verwandeln.

Synapsen spielen fast überall dort eine Rolle, wo wir mit chemischen Mitteln psychische Krankheiten lindern oder unser Bewusstsein verändern wollen. Antipsychotische Medikamente dämpfen die Signalübertragung durch Dopamin, Serotonin und andere Botenstoffe; LSD löst Halluzinationen aus, weil es sich wie ein „Super-Serotonin“ hartnäckig an einen Serotonin-Rezeptor klammert und so die entsprechende Empfängerzellen übermässig stark und lange anregt. Und die Rauschdroge Kokain verhindert, dass Senderzellen das von ihnen ausgeschüttete Dopamin wieder aufsaugen. Als Folge davon häuft sich dieser glücksspendende Botenstoff in der Synapse an, sodass Kokain-Konsumenten die euphorische Wirkung der Droge bald nicht mehr missen wollen. Um sich gegen diesen Dopamin-Überreiz zu wehren, verringern Empfängernerven die Zahl ihrer Dopamin-Rezeptoren. Sinkt dann bei Kokainentzug der Dopaminspiegel in der Synapse plötzlich ab, so kann diese nicht mehr normal arbeiten und verursacht die gefürchteten Entzugserscheinungen.

Mut, Glücksgefühl, sexuelle Vorliebe und Sozialverhalten sind zwar wichtige Teile dessen, was wir gemeinhin „Charakter“ nennen, reichen aber bei weitem nicht aus, um diesen erschöpfend zu beschreiben. Und ihre genetische Kontrolle ist bei uns Menschen viel subtiler und komplexer als bei einfachen Tieren. Sie unterliegt einem Netzwerk vieler Gene, in dem jedes Gen nur eine bescheidene Rolle spielt.

Wir Menschen haben weder ein „Mut-Gen“ noch ein „Monogamie-Gen“, sondern viele Gene, die diese Verhaltensmuster geringfügig, aber statistisch signifikant beeinflussen. Und selbst diese Behauptung steht auf wackligen Beinen, da sie sich in den meisten Fällen nicht auf eindeutige genetische Beweise, sondern nur auf Korrelationen stützt. Dennoch besteht kein Zweifel daran, dass Synapsen die Fäden sind, aus denen die Natur den wundersamen Gobelin unseres Charakters wirkt. Dieser Gobelin verdankt seinen Farbenreichtum der Wechselwirkung der verschiedenen Rezeptor- und Ansaugproteine in unseren Synapsen, über die ein und derselbe Botenstoff eine breite Palette verschiedener Reaktionen und Empfindungen auslösen kann. Da unser Gehirn etwa 10’000 Milliarden Nervenzellen besitzt und jede von ihnen durch 1000 bis 10'000 Synapsen mit anderen Nervenzellen vernetzt ist, steigt die Zahl der möglichen Wechselwirkungen ins Unendliche. Die Balance zwischen den verschiedenen Fäden dieses unvorstellbar komplexen Netzwerks ist zum Teil erblich, kann aber auch durch Umwelteinflüsse verändert werden; sie ist deshalb für jeden Menschen auf dieser Erde – selbst für eineiige Zwillinge – einmalig.

Sollte es uns je gelingen, alle Fäden dieses Netzwerks zu entwirren und ihre Verflechtung mit Computern darzustellen, so wird die Komplexität dieses Musters alle unsere Vorstellkraft übersteigen. Das Land, von dem Schnitzler sprach, wird wohl auch für Biologen seine geheimnisvollen Weiten wahren.

HOLZWEGE – Benzin aus dem Wald

HOLZWEGE – Benzin aus dem WaldFr, 01.12.2011- 04:20 — Gerhard Glatzel

Am 26. November 2011 schreibt „Die Presse“ als Schlagzeile auf ihrer Titelseite:„Klimapolitik ist klinisch tot – Die Verhandlungen über ein globales Klimaschutzabkommen stecken in einer Sackgasse. Ein Ausweg ist auch bei der UN-Konferenz in Durban nicht in Sicht“

Eine Woche zuvor, am 19. Oktober 2011, hat der österreichische Nationalrat ein Klimaschutzgesetz [1] verabschiedet, das den einzelnen Wirtschaftssektoren ab 2012 verbindliche Einsparziele für Kohlendioxidemissionen vorschreibt. Österreich verpflichtet sich, seine Treibhausgasemissionen bis 2012 um 13 Prozent (gegenüber 1990) sowie bis 2020 um 16 Prozent (gegenüber 2005) zu senken.

Dieser irritierende Widerspruch veranlasst den emeritierten Waldökologen einmal mehr über Klimaschutzpolitik im Allgemeinen und über die Rolle von Wäldern als Energiequelle und Kohlenstoffspeicher im Speziellen zu reflektieren.

Klimaschutz: Faktum – Fiktion – Illusion

Faktum ist, dass sich unser Planet gegenwärtig in einer Phase markanter Klimaerwärmung befindet und diese mit dem Anstieg der Konzentration von Treibhausgasen in der Atmosphäre aus anthropogenen Quellen, insbesondere aus der Verbrennung fossiler Energieträger sowie aus industriellen und agrarischen Aktivitäten, gut korreliert.

Diese Erkenntnis führte 1992 zur Verabschiedung der United Nations Framework Convention on Climate Change (UNFCCC), einem internationalen Umweltabkommen mit dem Ziel, eine gefährliche anthropogene Störung des Klimasystems zu verhindern und die globale Erwärmung zu verlangsamen sowie deren Folgen zu mildern. Am 11. Dezember 1997 wurde das Kyoto-Protokoll als Zusatzprotokoll zur Klimarahmenkonvention der Vereinten Nationen beschlossen. Das am 16. Februar 2005 in Kraft getretene und 2012 auslaufende Abkommen legte erstmals völkerrechtlich verbindliche Zielwerte für den Ausstoß von Treibhausgasen in den Industrieländern fest.

Bis Anfang 2011 haben 191 Staaten sowie die Europäische Union das Kyoto-Protokoll ratifiziert, wobei die USA die bedeutendste Ausnahme bilden. Die Aussichten, beim gegenwärtigen 17. UN-Klimagipfel in Durban (Beginn am 28. November 2012) eine wirksame Nachfolgeregelung zum Kyoto-Protokoll zu finden und global verbindliche Vorschriften für die Reduktion des Ausstoßes von Treibhausgasen beschließen zu können, werden als gering eingestuft.

Fiktion ist, dass die Aktivitäten einer noch immer wachsenden und immer mehr industrialisierten Weltbevölkerung das „Gleichgewicht der Natur“ gestört haben, denn das „Gleichgewicht der Natur“ ist Fiktion. Die Evolution allen Lebens basiert auf Selektion durch sich laufend ändernde Bedingungen der unbelebten und belebten Umwelt. Das auf den griechischen Philosophen Heraklit zurückgeführte „panta rhei“ („alles fließt“) ist eine Metapher für die Prozessualität der Welt. Das Sein ist demnach nicht statisch, sondern als ewiger Wandel dynamisch zu erfassen. Einer der Gründerväter moderner Naturwissenschaft, Gottfried Wilhelm Leibniz (1646 - 1716), betonte in seinen biologischen und geologischen Konzeptionen die Dynamik aller Naturvorgänge.

Auch das „Leben in Harmonie mit der Natur“ ist eine Fiktion romantischer Naturvorstellung. Dass Goethes „Aber die Natur versteht gar keinen Spaß, sie ist immer wahr, immer ernst, immer strenge; sie hat immer recht, und die Fehler und Irrtümer sind immer die des Menschen“ (Goethe zu Eckermann; Gespräche II) immer wieder zitiert wird, entspricht unserem inneren Harmoniebedürfnis. Wir übersehen dabei aber allzu leicht, dass wir in einer vom Menschen seit Jahrtausenden geprägten Kulturlandschaft leben und unsere Nahrungsmittel und Rohstoffe überwiegend nicht aus natürlichen Systemen beziehen. Wir verdrängen auch gerne, dass der große Dichter J.W. Goethe auch Folgendes geschrieben hat: „Gleich mit jedem Regengusse / Ändert sich dein holdes Tal, / Ach, und in dem selben Flusse / Schwimmst du nicht zum zweitenmal.“ (Johann Wolfgang von Goethe, Band 1: Sämtliche Gedichte. Artemis, Zürich 1950, S. 512).

Eine weitere Fiktion sind die Harmonie und das Gleichgewicht innerhalb natürlicher Systeme, die immer wieder als Vorbilder für menschliches Handeln angeführt werden. Scheinbare Gleichgewichtszustände sind statistische Mittelungen von meist erbarmungslosen Kämpfen um limitierende Ressourcen und sagen wenig über die Immunität des Systems gegenüber Veränderungen aus.

Für die Klimaschutzdiskussion verursachte die vereinfachte Argumentation eines für die künftige Entwicklung der Menschheit unverzichtbaren und daher unbedingt zu erhaltenden Gleichgewichtszustandes erhebliche Probleme. Als die Klimaforschung immer mehr harte Daten über die häufig extremen Klimaschwankungen in der älteren und jüngeren Vergangenheit präsentierte, wurde von vielen Bürgern völlig zu Unrecht die gesamte Klimaschutzargumentation angezweifelt. Es rächt sich auch, dass Klimaschutz meist sehr isoliert und singulär existenzbedrohend diskutiert wurde und nicht im Gesamtkontext aller, die gedeihliche künftige Entwicklung der Menschheit bestimmenden Limitationen und Gefahren.

Illusion ist die Umsetzbarkeit globaler Vorgaben für den Ressourceneinsatz. Während in Durban über verbindliche Nachfolgeregelungen für das auslaufende Kyoto-Protokoll diskutiert wird, sehen wir im Fernsehen Bilder von der Erschließung der Kohlevorkommen der Mongolei und in Mosambik sowie den Einsatz von „Hydraulic-Fracturing“ in überaus ergiebigen neuen Shale-Gas-Feldern. „Global Governance“ als Basis für die einvernehmlichen und gerechte Nutzung der Umwelt und der Ressourcen der Erde ist noch immer Utopie oder wahrscheinlich sogar Illusion. Der große oberösterreichische Heimatdichter Franz Stelzhamer (1802 – 1874) hat es vor 150 Jahren auf den Punkt gebracht: „Oana is a Mensch, mehra hans Leit, alle hans Viech“ (Einer ist ein Mensch, Mehrere sind Leute, Alle sind Vieh).

Klimaschutzmaßnahmen – Der Teufel liegt im Detail

Im Vergleich zu früheren Maßnahmen zur Verhinderung oder Verminderung schädlicher Stoffe in der Atmosphäre, die sich an verbindlichen Grenzwerten orientierten, die auf Grundlage wissenschaftlicher Erkenntnisse und technischer Machbarkeit definiert und gegebenenfalls nachjustiert wurden, schlug man bei CO2 und anderen Treibhausgasen den neuen Weg des Emissionshandels ein. Damit wurden Grenzwertüberschreitungen nicht grundsätzlich verboten, sondern verursachen Kosten, weil Emissionsberechtigungen, die von der EU in einem komplexen Regelwerk definiert werden, gekauft werden müssen. Die Erlöse sollen Klimaschutzaktivitäten zufließen.

Die Möglichkeit im Emissionshandel Geld zu verdienen, wurde von Geschäftsleuten rasch erkannt und führte zu einem breiten Angebot an Investitionsmöglichkeiten, für die Lobbyisten und sektorale Interessensvertretungen in Brüssel und in den nationalen Regierungen werben. Besonders erfolgreiche (oder von Lobbyisten erfolgreich vermarktete) Konzepte schaffen die Aufnahme in Empfehlungen oder Richtlinien der EU. Ein bekanntes Beispiel ist E10, ein für Automotoren vorgesehener Kraftstoff, der einen Anteil von 10% Bioethanol enthält und damit zu den Ethanol-Kraftstoffen zählt. Er wurde 2011 in Deutschland im Zusammenhang mit den Erfordernissen der EU-Biokraftstoffrichtlinie eingeführt, um den fossilen Rohstoffverbrauch und CO2–Emissionen zu reduzieren. Ein anderes Beispiel sind die Richtlinien zur Wärmedämmung von Gebäuden, um den Energieverbrauch für Heizung und Klimatisierung zu senken.

Grundsätzliches Problem all dieser Maßnahmen ist, dass sie als Einzelmaßnahme Senkungen der treibhauswirksamen CO2–Emissionen bewirken, aber im Gesamtkontext der Ressourcenpolitik oft nicht evaluiert werden. Beispielsweise lässt sich leicht berechnen, um wie viel eine bessere Wärmedämmung den Energiebedarf für einen Haushalt senkt. Es wird aber nicht gefragt, ob die Einsparungen möglicherweise für die Beheizung der Terrasse oder des Swimmingpools verwendet oder vielleicht in energieintensive Fernreisen investiert werden. E10 wiederum erlaubt, weiterhin mit übergroßen Autos zu fahren, weil es keine Grenzwerte für den maximal zulässigen Treibstoffverbrauch pro Personenkilometer gibt. Bekanntermaßen werden die Automotoren zwar effizienter, die Autos selbst aber größer. Bei Biotreibstoffen wurden auch die Auswirkungen auf die Nahrungsproduktion und die Bodennutzung in Entwicklungsländern viel zu wenig berücksichtigt.

Persönlich sehe ich den Wechsel von Grenzwertregelungen zu Emmissionshandelskonzepten als bisher schwerste Sünde der Umwelt- und Klimaschutzpolitik.

Biotreibstoff aus dem Wald – ein Holzweg?

Angesichts der Tatsache, dass Bioethanol der ersten Generation (aus Getreide, Zuckerrohr oder Zuckerrüben gewonnener Äthylalkohol) in Europa nicht in ausreichenden Mengen erzeugt wird, um die Vorgaben der EU-Biokraftstoffrichtlinie zu erfüllen und Angesichts der Konkurrenz zur Nahrungs- und Futtermittelproduktion sowie in Anbetracht des in Summe eher bescheidenen Beitrages zum Klimaschutz, wird Alkohol aus Nahrungs- und Futtermitteln zunehmend als Sackgasse gesehen.

Kritische Stimmen aus der Entwicklungspolitik, die vor der Verlagerung von Bioethanolproduktion in Entwicklungsländer warnen, haben die Skepsis gegenüber Bioethanol der ersten Generation noch verstärkt. Daher wird in Brüssel jetzt vehement für Bioethanol der zweiten Generation Lobbying betrieben. Das Bioethanol soll dabei aus der gesamten oberirdischen Biomasse von mehrjährigen Pflanzen gewonnen werden, die nicht als Nahrungs- und Futtermittel dienen. Neben mehrjährigen Gräsern wie Chinaschilf (Miscanthus sp.) oder Rutenhirse (Panicum virgatum, ein nordamerikanisches Präriegras), sollen vor allem Energieholzplantagen, meist als Ausschlagkulturen von Weiden und Pappelklonen, den nötigen Rohstoff liefern. Dafür sollen nach den Konzepten der Bioalkoholindustrie bisher als Weide- und Ackerland sowie als Wald genutzte Flächen in Energiepflanzenkulturen mehrjähriger Pflanzen umgewandelt werden.

Nur wenn die Mitgliedsstaaten der EU diesbezüglich regelkonform agieren, können die für E10 oder höhere Beimengungen benötigten Ethanolmengen in Europa erzeugt werden. Es wird gefordert, dass sowohl für die Landwirtschaft als auch für die Forstwirtschaft entsprechende Anreizsysteme geschaffen werden. Diese könnten aus wertgesicherten langfristigen Absatzgarantien und Steuerbegünstigungen oder Subventionen für die Umwandlung bestehen. Außerdem könnten die Bioethanolwerke die hochmechanisierte Bewirtschaftung der Flächen leisten, sodass der Grundbesitzer keine Geräte anschaffen müsste und keinen Aufwand für die Bewirtschaftung seines Landes hat. Arbeitsplätze in der Bioethanolwertschöpfungskette könnten ein zusätzlicher Anreiz sein.

Sowohl für Landwirte als auch für Waldbesitzer sind mehrjährige Energiepflanzenkulturen eine neuartige Form der Landnutzung. Für den Landwirt ist ein „Fruchtfolgewechsel“ zwischen mehrjährigen Energiepflanzenkulturen und einjährigen Nahrungs- oder Futterpflanzen wegen der unterschiedlichen Produktionszeiträume und der zur Bewirtschaftung benötigten unterschiedlichen Geräte kaum möglich. Mehrjährige Energiepflanzenkulturen bedeuten also de facto, dass Flächen, die bisher der Nahrungs- oder Futtermittelproduktion dienten, in Zukunft den unersättlichen Energiehunger der Automobile stillen sollen (eine mittlere Tankfüllung entspricht 100 kg Brot).

Aber auch für den Forstwirt, der traditionell mit langlebigen Holzgewächsen arbeitet, bringt der Umstieg auf Energieholzplantagenwirtschaft massive Änderungen. Dabei ist für Waldbesitzer die energetische Nutzung der Biomasse von Wäldern nichts Neues. Vor der Verwendung fossiler Energieträger und industriell hergestellter Chemikalien wurden 80 – 90 % der Biomasse der Wälder nicht als Sägeholz verwendet, sondern als Brennholz, Holzkohle oder als Rohstoff für Gewerbe und Industrie, allen voran als Pottasche für die Glaserzeugung. Daneben wurde Laubstreu vom Waldboden gesammelt und als Einstreu in Ställen und als Düngemittel in der Landwirtschaft verwendet.

Als fossile Energieträger Brennholz und Holzkohle vom Markt verdrängten, wurden Forstbetriebe zu Veredelungsbetrieben, die versuchen, möglichst viel des Biomassezuwachses in hochwertige Holzsortimente, vor allem Rundholz für die Sägeindustrie, zu lenken. Heute beträgt der Anteil dieser Sortimente 70 – 80 %. Mit schwächerem Holz wird die Papier- und Zellstoffindustrie bedient und auch dafür nicht geeignetes Holz wird meist in Form von Hackschnitzeln als Heizmaterial verwendet. Darüber hinaus noch Biomasse zu entnehmen, führt rasch zur Nährstoffverarmung und Bodenversauerung, weil gerade Reisig und Blattmasse die höchsten Gehalte an Pflanzennährstoffen aufweisen. Darüber wusste man bereits im 19. Jahrhundert gut Bescheid [2].

Aufgrund der geringen Mengen und geringen Lagerungsdichte sowie des Transportes über lange Wegstrecken ist Restbiomasse aus konventioneller Waldbewirtschaftung keine Option für die Bioethanolindustrie. Auch aus ökologischen Gründen wäre der Entzug von Reisig und Blattmasse sehr bedenklich, weil damit dem Bodenleben für die Aufrechterhaltung wichtiger Bodenfunktionen unerlässliche Nahrungs- und Energiequellen vorenthalten würden.

Bioethanol der zweiten Generation kann nach gegenwärtigem Wissensstand nicht in Kleinanlagen am Bauernhof oder dezentral im Forstbetrieb hergestellt werden, sondern nur in Großanlagen, die aus Plantagen innerhalb eines Umkreises von 20 bis 30 km mit Biomasse bedient werden. Das bedeutet, dass Wald in erheblichem Ausmaß in Energieplantagen umgewandelt werden müsste.

Wenn die gesetzlichen und finanziellen Rahmenbedingungen stimmen, werden Waldbesitzer vermutlich nicht zögern, von der aufwändigen Wertholzproduktion auf Biomasseplantagen umzusteigen, die sehr einfach maschinell zu bewirtschaften sind. Angesichts der sehr langen Produktionszeiträume der traditionellen Forstwirtschaft von bis zu hundert Jahren, werden vielleicht manche Waldbesitzer zögern, weil sie Zweifel haben, dass der Bioethanolmarkt für so lange Dauer gesichert ist. In Wald rückgewandelte Energieholzplantagen liefern nämlich erst nach Jahrzehnten kostendeckende Erträge. Volkswirtschaftlich ist es höchst fragwürdig, von Holz als veredelter Waldbiomasse mit vielfältigem Gebrauchswert und großem Wertschöpfungpotenzial in der Verarbeitung auf rohe Biomasse für die Energiewirtschaft umzusteigen, insbesondere dann, wenn öffentliche Mittel eingesetzt werden müssen, um die geringe Wertschöpfung der Produktion zu kompensieren.

Bioethanolfabriken der zweiten Generation verwenden die gesamte oberirdische Biomasse von Pflanzen und sind daher prinzipiell effizienter als die Anlagen der ersten Generation, die in Mitteleuropa vor allem Getreide oder Zuckerrüben verarbeiten. Ein weiterer, immer betonter Vorteil mehrjähriger Biomassenkulturen ist der im Vergleich zu Getreide und Rüben längere Erntezeitraum. Energieholzplantagen können theoretisch das ganze Jahr über genutzt werden. Allerdings ist während des Austriebes der Wassergehalt sehr hoch, und im Winter können Reif und Schnee die Ernte und den Transport sehr erschweren. Der Nachteil von Grasbiomasse oder Holzschnitzeln gegenüber Getreide ist, dass diese wegen ihrer geringen Schüttdichte ungleich schwieriger im Ethanolwerk auf Vorrat zu halten sind. Ohne energieaufwändige Trocknung kann sich geschüttetes Hackgut im Freien bis zur Selbstentzündung erhitzen und dabei natürlich erhebliche Mengen an CO2 und anderen Treibhausgasen freisetzen. Ein hinsichtlich des Klimaschutzes möglicher positiver Effekt mehrjähriger Pflanzenkulturen ist die potenziell größere Kohlenstoffspeicherung im Boden. Um die Kohlenstoffsequestrierung umfassend bewerten zu können, muss man allerdings auch die mögliche Ausgasung von Treibhausgasen aus dem Boden unter verschiedenen Boden- und Klimabedingungen erfassen und berücksichtigen.

Biomasseplantagen müssen wie alle Intensivkulturen gedüngt werden, um die Bodenfruchtbarkeit zu bewahren und hohe Produktivität zu sichern. Energieholzplantagen unterscheiden sich diesbezüglich sehr grundlegend von Wäldern im traditionellen mitteleuropäischen Sinn, die aufgrund des extrem geringen Nährstoffgehaltes des Holzes und der langen Umtriebszeiten ohne Dünger auskommen. In Energieholzplantagen werden ungleich höhere Anteile an nährstoffreichen Pflanzengeweben, wie Rinde und Knospen, entzogen. Daher muss gedüngt werden und man kann bei Biomasseholzplantagen nicht von Wald im traditionellen mitteleuropäischen Sinn sprechen.

Ausgedehnte Änderungen der Landnutzung von traditioneller Land- oder Forstwirtschaft zu neuen mehrjährigen Biomassekulturen für die Biospritproduktion haben natürlich auch erhebliche Auswirkungen auf die Biodiversität. Mehrjährige Gräser (Miscanthus oder Panicum) und Ausschlagplantagen von Weiden oder Pappeln sind völlig andere Habitate für Wildtiere als konventionelle landwirtschaftliche Felder mit Fruchtwechsel, Weideland oder Hochwald. In großflächigen Monokulturen können Schädlinge und Pflanzenkrankheiten unerwartet zum Problem werden. Mit erheblichen Auswirkungen auf Oberflächen- und Grundwasser ist zu rechnen. Da Pflanzung, Pflege und Ernte der Biomasse hoch mechanisiert sind, müssen sich auch die Menschen in ländlichen Gebieten an die geänderten Arbeitsmöglichkeiten anpassen. Der Transport des Erntegutes auf öffentlichen Straßen ist ein weiterer zu berücksichtigender Aspekt. Natürlich ist auch der Erholungswert der ländlichen Räume von den geforderten Umstellungen betroffen.

Zusammenfassend meine ich, dass sich auch die Bioethanolproduktion aus mehrjährigen Biomasseplantagen auf umgewandelten land- und forstwirtschaftlichen Flächen als Holzweg erweisen wird. Solange wir nicht gesamthaft über eine Ressourcen schonende Zukunftsentwicklung nachdenken, werden Lobbyisten und Geschäftsleute, die mit Klimaschutz und insbesondere Emissionshandel viel Geld verdienen, versuchen, die Politik für ihre Zwecke zu beeinflussen. E10 ist ein Beispiel dafür. Insgesamt muss es aber das vorrangige Ziel sein, künftig mit weniger Ressourceninanspruchnahme – von der Energie über seltene Erden bis zu Wasser und Boden – auszukommen und knappe Ressourcen klüger zu nutzen. Klare Vorgaben und Grenzwerte würden meiner Meinung nach Innovationen mehr stimulieren als einseitige Fokussierung auf Kohlenstoffemissionen und Emissionshandel. So schwer das Klimaproblem auch wiegt, es ist bei Weitem nicht die einzige Bedrohung, mit der künftige Generationen fertig werden müssen. Einschränkung von unnötigem Ressourcenverbrauch bedeutet automatisch auch Klimaschutz. GG, Wien, 29.11.2011

[1] Bundesgesetz zur Einhaltung von Höchstmengen von Treibhausgasemissionen und zur Erarbeitung von wirksamen Maßnahmen zum Klimaschutz; BGBl. I Nr. 106/2011

[2] S. Hausegger: „Intensive Forstwirthschaft und ihre Folgen“, Österreichische Vierteljahresschrift für Forstwesen, XI, 1861, S. 88–104 und 248–277

Emer. Univ. Prof. Dr. Gerhard Glatzel war Vorstand des Instituts für Waldökologie an der Universität für Bodenkultur in Wien. Forschungsschwerpunkte: Waldernährung, Waldökosystemdynamik und Sanierung von Waldökosystemen, historische Landnutzungssysteme.

Leben am Mars, Neutrinos und ein schmaler Grat…

Leben am Mars, Neutrinos und ein schmaler Grat…Fr, 24.11.2011- 04:20 — Franz Kerschbaum

Manche von uns erinnern sich noch an den August 1996, als von einem Tag auf den anderen alle Medien voll mit Sensationsmeldungen zum endlich nachgewiesenen Leben auf dem Mars waren. Am besten gefällt mir immer noch die wunderbare Headline von Täglich Alles am 8. August: „ Also doch: Marsmännchen. Ziemlich klein, 3 Milliarden Jahre alt — leider tot“.

Der deutlich sachlichere Artikel in der Presse „Auf der Suche nach Geschwistern im All“ vom 9. August wurde ironisch mit Meister Yoda aus Star Wars illustriert. Die kritischeren Geister mahnten ein Déjà-vu der Anfang des 20. Jahrhunderts von Percival Lowell [1] verursachten Mars-Hysterie ein — doch es half nichts, Zeitungen, Magazine, TV- und Radioformate waren über Wochen voll mit immer spekulativeren Beiträgen zum vermeintlichen Leben am Mars.

Was war geschehen? Am 7. August 1996 stellte die NASA in einer Pressekonferenz bzw. Aussendung [2] der staunenden medialen Öffentlichkeit die sensationellen Ergebnisse einer Untersuchung des Marsmeteoriten ALH84001 vor [3]. Aus mikroskopischen und chemischen Evidenzen schlossen die Forscher in Science: “Although there are alternative explanations for each of these phenomena taken individually, when they are considered collectively, particularly in view of their spatial association, we conclude that they are evidence for primitive life on early Mars.” In der NASA-Pressekonferenz klang dies aus dem Munde einer der Autoren, Richard Zare weniger vorsichtig: “The existing standard of proof, which we think we have met, includes having an accurately dated sample that contains native microfossils, mineralogical features characteristic of life, and evidence of complex organic chemistry."

Selbst das war für die Medien nicht explizit genug. Am besten erhellt der schon am 8. August (!) in der Baltimore Sun erschienene, geradezu hellsichtige Cartoon von Kevin Kallaugher die mediale Rezeptionsgeschichte.

Cartoon von Kevin KAL Kallaugher [4]. Der Cartoon erschien erstmals in der Baltimore Sun am 8. August 1996 anlässlich der NASA Pressekonferenz vom 7. August 1996 bei der Wissenschaftler mögliche Anzeichen für vergangenes, mikrobielles Leben am Mars bekanntgaben. Wiedergabe mit Erlaubnis des Künstlers.

Wie ging die Sache weiter? Schon wenige Monate später erschienen die ersten kritischen Arbeiten, die die einzelnen Indizien für mikrobielle Lebensspuren in ALH84001 auch durch anorganische Prozesse erklärten. Heute ist von der damaligen Euphorie wenig übrig und ALH84001 in der Scientific Community eher ein warnendes Beispiel für allzu „aufgeregte“ Pressearbeit. Die weiteren kritischen Arbeiten zu ALH84001 haben ohne NASA-Rückenwind mit wenigen Ausnahmen [5] keinen Platz mehr in populären Medien gefunden.

Die Moral von der Geschichte: Insbesondere bei Themen mit echtem „Sensationspotential“ werden Wissenschaftler, oft finanziell oder organisatorisch abhängig und eingespannt in professionelle PR-Maschinerien wie der der NASA leicht verführt, bei ihren Aussagen den schmalen Grad wissenschaftlicher Seriosität mit all der nötigen Differenzierung zu Gunsten eines schnellen Medialen Ruhms zu verlassen. Medien greifen dies nur allzu gerne für marktschreierische Schlagzeilen und ebensolche Beiträge auf.

Haben die an wissenschaftlicher Öffentlichkeitsarbeit Beteiligten, die Wissenschaftler und Forschungsinstitutionen einerseits und die Medien andererseits nun etwas daraus gelernt?

Wie mir scheint, zumindest ein klein wenig.

Vor wenigen Wochen, ab dem 23. September 2011 waren die Medien wieder einmal voll mit „bahnbrechenden“, „revolutionären“ Meldungen wie: „Hat Einstein geirrt?“, „Physiker rätseln: Relativitätstheorie widerlegt?“ und ähnlichem. Meist waren selbst in der Boulevardpresse [6] zumindest Fragezeichen dabei, als über die von CERN [7] stolz präsentierten vorläufigen Ergebnisse [8] zu möglicherweise überlichtschnellen Neutrinos berichtet wurde. CERN spielte vorsichtig aber doch mit dem verlockenden Sensationspotential: “If this measurement is confirmed, it might change our view of physics, but we need to be sure that there are no other, more mundane, explanations. That will require independent measurements.” oder “The potential impact on science is too large to draw immediate conclusions or attempt physics interpretations.” Während sich die weitere Fachwelt nach einer kurzen Schrecksekunde unaufgeregt auf die Fehlersuche [9] machte, wurde in den nächsten Tagen und Wochen in Kommentaren und Blogs weiter wild spekuliert . Mittlerweile wurde die Arbeit nach weiteren Tests der Autoren bei Science offiziell eingereicht [10].

Was weitere wissenschaftliche Arbeiten ergeben werden, wissen wir sowohl beim (vergangenen) Leben auf dem Mars als auch bei der (zu hohen?) Geschwindigkeit der Neutrinos nicht – beides zweifelsohne spannende Fragen der gegenwärtigen Forschung mit „Sensationspotential“. In jedem Fall zeigen uns diese und vergleichbare andere mediale Rezeptionsprozesse, wie schmal der Grat zwischen differenzierter wissenschaftlicher Öffentlichkeitsarbeit und Sensationsmache ist.

Und uns Forscherinnen und Forschern sei wieder einmal die alte Forderung “Extraordinary claims require extraordinary proof.“ von Marcello Truzzi ins Stammbuch geschrieben…

Quellen und Einzelnachweise

[1] http://query.nytimes.com/mem/archive-free/pdf?res=F1071FFE3C5512738DDDA00894DA415B868CF1D3 (Seite nicht mehr verfügbar)

[2] http://nssdc.gsfc.nasa.gov/planetary/text/mars_life.txt

[3] http://www.earth.northwestern.edu/people/seth/351/search.life.pdf (Web Archive)

[5] http://www.usatoday.com/tech/science/space/2006-08-06-mars-life_x.htm

[7] http://public.web.cern.ch/press/pressreleases/Releases2011/PR19.11E.html (Web Archive)

[8] http://arxiv.org/abs/1109.4897

[9] http://www.nature.com/news/2011/111020/full/news.2011.605.html

[10] http://news.sciencemag.org/scienceinsider/2011/11/faster-than-light-neutrinos-opera.html (Web Archive)

Zu Wirkung und Nebenwirkungen von Medikamenten

Zu Wirkung und Nebenwirkungen von MedikamentenFr, 17.11.2011 - 04:20 — Inge Schuster

In der zentralen, hochromantischen Szene des Freischütz werden in der Wolfsschlucht Zauberkugeln gegossen, die nie ihr angepeiltes Ziel verfehlen. Die Treffsicherheit derartiger Zauberkugeln hat Paul Ehrlich, der Vater der Chemotherapie, vor rund hundert Jahren als Vision auf die erwünschte Wirkungsweise von Medikamenten übertragen.Ausgehend von den Versprechungen der damals noch jungen Chemie formulierte er: „Wir müssen chemisch zielen lernen“ und meinte damit, daß Medikamente spezifisch an den jeweils relevanten Krankheitserreger und nur an diesen andocken dürften. Dies bedeutete in den von ihm konkret behandelten Projekten: „Das Abtöten von Parasiten ohne erhebliche Schädigung des Organismus“.

Nach wie vor ist es oberstes Ziel der Pharmaforschung Arzneimittel zu finden, die bei einer angestrebten Wirkung frei sind von unerwünschten Nebeneffekten. Dies konnte aber weder zu Zeiten Ehrlichs verwirklicht werden (Ehrlich hatte mit Salvarsan zwar das erste wirksame Mittel gegen Syphilis gefunden, allerdings zeigte dieses erhebliche Nebenwirkungen) noch mit unseren heutigen Mitteln. Jeder Arzneistoff bindet im Organismus an eine Vielzahl von Strukturen und kann deren Eigenschaften modulieren. Das Spektrum der daraus resultierenden Nebenwirkungen reicht von harmlosen Effekten, manchmal auch durchaus positiven Begleiterscheinungen, bis hin zu schwer-und-schwerstwiegenden negativen Auswirkungen.

Die Weltgesundheits-Organisation (WHO) faßt dies in wenigen Sätzen zusammen [1]: “All medicines have side effects and some can be damaging. The effects of any treatment with a medicine cannot be predicted with absolute certainty. All medicines have both benefits and the potential for harm. People in every country of the world are affected by adverse drug reactions (ADRs). Unintended, harmful reactions to medicines – ADRs - are among the leading causes of death in many countries.”

Wie häufig treten schwere und schwerste Nebenwirkungen von Arzneimitteln (ADRs) auf?

Sehr umfangreiche Studien in den USA und England geben an, daß rund 6,6% aller Aufnahmen in Spitäler auf Grund von ADRs erfolgen [2]. Von den Patienten, die bereits wegen anderer Ursachen in stationärer Behandlung sind, erleiden rund 15% Nebenwirkungen, deretwegen sich der Spitalsaufenthalt bedeutend verlängern kann [3]. Vergleichbare Zahlen kommen aus vielen anderen Ländern, vergleichbar sind diese auch hinsichtlich schwerster, zum Tod führender Nebenwirkungen, die an 4.- 6. Stelle der Todesursachen rangieren [3, 4]. Berücksichtigt man, daß Nebenwirkungen bei Patienten in ambulanter Behandlung nicht ausreichend dokumentiert werden, dürfte das gesamte Problem noch wesentlich gravierender sein.

Welche Maßnahmen können getroffen werden um die für betroffene Patienten höchst schädigende, für Institutionen und natürlich auch Leistungsträger höchst unbefriedigende Situation zu verbessern?

Nach Meinung der WHO sollten zumindest 60% der ADRs vermeidbar sein. Deren Ursachen sind u.a:

- eine fehlerhafte Diagnose und damit die Verschreibung einer falschen Medizin oder falschen Dosis einer an und für sich richtigen Medizin,

- das Nichteinhalten der Anweisungen zur Anwendung eines Arzneimittels („Non-Compliance“),

- eine naive Selbstbehandlung mit Arzneimitteln und

- die individuelle genetische Prädisposition des Patienten [1].

Wenn man an diesem multifaktoriellen Rad in Richtung Reduktion von ADRs drehen möchte, kann dies – abgesehen von Fehldiagnosen und Schlampereien – durch bessere Information des Patienten (in einer ihm verständlichen Sprache) geschehen, mit dem Hinweis auf Nutzen und Risiken der empfohlenen Behandlung. Darüber hinaus sehe ich vor allem Chancen in der Berücksichtigung des individuellen genetischen Make-ups eines Patienten, welches Konzentration und Verweildauer eines Arzneimittels im Körper bestimmt und – damit z.T. zusammenhängend – in der Vermeidung von Mehrfach-Medikationen.

Was geschieht mit Fremdstoffen im Allgemeinen und Arzneistoffen im Besonderen im Organismus?

Unser Organismus, wie auch der aller höherer Lebewesen, ist permanent einer ungeheuren Vielfalt und Vielzahl an Fremdstoffen aus Umwelt und Nahrung ausgesetzt, die über Kontakt mit der Körperoberfläche, über das Verdauungssystem oder über die Atemwege in den Organismus gelangen können. In besonderem Maße sind kleine, fettlösliche (lipophile) Fremdstoffe geeignet sich in Fettgewebe und in den Lipid-Membranen, die Zellen und Organellen innerhalb der Zellen umschließen, einzulagern. Ohne einen entsprechenden Schutzmechanismus würde dies zu einer enormen Akkumulation derartiger lipophiler Verbindungen führen und daraus resultierend zum Versagen von Zell-und Organfunktionen.

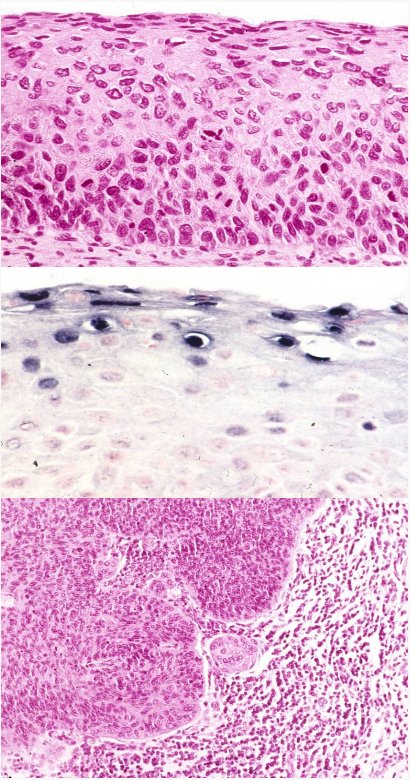

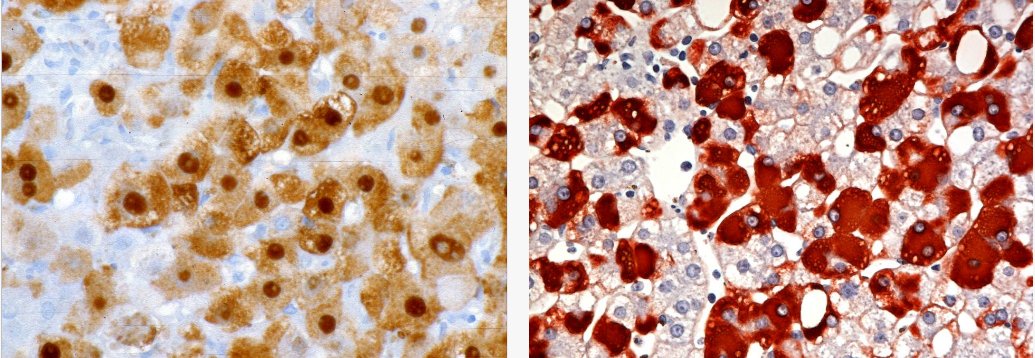

Im Laufe der Evolution haben Organismen eine Reihe von Enzymen – Katalysatoren – entwickelt, die lipophile Fremdstoffe in zunehmend wasserlösliche Produkte (Metabolite) verwandeln können, welche eine geringere Akkumulation in Zellen zeigen und leichter aus dem Organismus ausgeschieden werden können (Abbildung 1).

Abbildung 1. Fettlösliche (lipophile) Fremdstoffe (türkis), die in Zellen eintreten und sich darin anreichern, werden zu wasserlöslicheren, weniger akkumulierenden Metaboliten (grün) umgewandelt.

Abbildung 1. Fettlösliche (lipophile) Fremdstoffe (türkis), die in Zellen eintreten und sich darin anreichern, werden zu wasserlöslicheren, weniger akkumulierenden Metaboliten (grün) umgewandelt.

Im Prinzip ist dieses Set an Enzymen imstande, jedes bereits vorhandene und auch jedes in Zukunft noch zu synthetisierende Molekül zu Produkten umzuwandeln, die den Organismus über die üblichen Ausscheidungswege (Urin, Kot) verlassen können. (Nur wenige Typen von Molekülen, wie z.B. die Dioxine, leisten diesen Enzymen Widerstand, reichern daher bei fortgesetzter Exposition mehr und mehr im Organismus an und führen zu dessen massiver Schädigung).

Für die Fähigkeit verschiedenartigste Fremdstoffe metabolisieren zu können, bedarf es keiner sehr breiten Palette an unterschiedlichsten Enzymen, es genügt eine relativ kleine Gruppe, die sehr breite, zum Teil überlappende Spezifitäten für derartige Substanzen aufweisen. Eine besonders wichtige Rolle spielen dabei Enzyme aus der sogenannten Cytochrom P450 Familie (Eine Familie von Proteinen, die bereits in den primitivsten Lebensformen vorhanden waren und deren Struktur und Funktion über die Evolution konserviert wurde). Diese Enzyme (CYPs) sind für die Umwandlung von mehr als 75% aller lipophilen Fremdstoffe und damit auch für den Großteil an Arzneistoffen verantwortlich.

CYPs finden sich in praktisch allen Organen, besonders viel davon sitzt in Organen wie Leber und Darm, die über die Nahrungsaufnahme primär sehr hohen Konzentrationen an Fremdstoffen ausgesetzt sind. Für den Metabolismus der gebräuchlichen Arzneimittel sind - abhängig von deren jeweiligen Strukturen - nur wenige CYP-Formen verantwortlich (Abbildung 2): Der Großteil aller Pharmaka – vor allem relativ große Moleküle – werden von CYP3A4 umgewandelt, rund 20% von CYP2D6 und ein vergleichbarer Anteil von den nahe verwandten CYPs 2C9 und 2C19.

Abbildung 2. Nur wenige CYP-Formen sind für den Metabolismus aller gebräuchlichen Arzneistoffe verantwortlich.

Abbildung 2. Nur wenige CYP-Formen sind für den Metabolismus aller gebräuchlichen Arzneistoffe verantwortlich.

Konsequenzen der Metabolisierung von Arzneimitteln

Die Metabolisierung von Arzneistoffen führt zu einer Veränderung des Molekülcharakters und damit in den meisten Fällen zum raschen Verlust der erwünschten pharmakologischen Wirkung. Es hängt daher von der vorhandenen Menge und Aktivität der CYP-Formen ab, wie stark ein Medikament wirkt und wie lange seine Wirkung anhält.

Werden – wie es häufig der Fall ist – mehrere unterschiedliche Medikamente gleichzeitig angewandt, die über dieselbe CYP-Form metabolisiert werden, so konkurrrieren diese um dieses Enzym (sogenannte drug-drug interactions) und können sich gegenseitig in ihrem Abbau beeinträchtigen. Langsamerer Metabolismus führt zu längeranhaltenden höheren Konzentrationen und damit zu längerer Wirkung, steigert aber – entsprechend einer „Überdosierung“ – das Risiko für unerwünschte Nebenwirkungen.

Mehrfachmedikationen spielen eine besonders große Rolle bei Spitalspatienten (denen manchmal auch mehr als 15 unterschiedliche Medikamente pro Tag verabreicht werden) und ebenso auch bei Senioren aufgrund steigender Morbidität. Bei erhöhtem Substrat-Angebot können CYPs zwar verstärkt synthetisiert (induziert) werden, jedoch oft nicht ausreichend für Multi-Medikationen. Zunehmend demonstrieren Studien die klinischen Auswirkungen der drug-drug interactions, die besonders ausgeprägt sind, wenn es sich um die Konkurrenz für das CYP2D6 handelt. Dieses Enzym ist nur in relativ niedriger Konzentration vorhanden, aber für den Metabolismus von rund 20% aller gebräuchlichen Pharmaka verantwortlich (Abbildung 2), darunter befinden sich überaus wichtige, häufig gleichzeitig angewandte Klassen von Schmerzmitteln, Antidepressiva, Antipsychotika, Antiarrhythmika und Beta-Blockern.

Menschen unterscheiden sich in der Art und Weise, wie sie mit Arzneistoffen umgehen.

Ein besonderes Problem resultiert aus der genetischen Ausstattung einzelner Patienten. Gene der CYP-Enzyme weisen sogenannte Polymorphismen auf, d.h. es gibt Genvarianten die für CYP-Formen kodieren, deren Spektrum von nicht-funktionsfähigen über (normal-) funktionierende zu extrem rasch funktionierenden Enzymen reicht [5]. Je nachdem welche dieser Formen ein Mensch in seinem Genom geerbt hat, reagiert er in unterschiedlicher Weise auf Medikamente (und andere Fremdstoffe).

Von gravierender klinischer Bedeutung sind hier die Polymorphismen des oben bereits erwähnten CYP2D6: Bis zu 10% der Bevölkerung besitzen kein funktionsfähiges Enzym, d.h. sie können entsprechende Medikamente nicht oder nur sehr langsam (über andere Enzyme) abbauen, das Risiko für Nebenwirkungen ist damit hoch, insbesondere bei (der häufig entbehrlichen) Multi-medikation (siehe oben). Eine ebenso große Bevölkerungsgruppe besitzt ultra-rasch metabolisierende CYP2D6-Formen, d.h. entsprechende Medikamente werden zu rasch abgebaut und können teilweise überhaupt nicht ihre Wirkung entfalten. Was dies für die Therapie mit den oben angegebenen Medikamenten bedeutet, braucht wohl nicht näher angeführt werden.

Pharmakogenetische Tests zur Erhöhung der therapeutischen Wirkung und Vermeidung von Nebenwirkungen

Die junge Wissenschaft Pharmakogenetik untersucht den Einfluß des genetischen „Make-ups“ von Patienten auf Wirkung und Nebenwirkungen von Pharmaka. Als prominentes Beispiel für die erfolgreiche Anwendung pharmakogenetischer Methoden, wird in Fachliteratur und Populärliteratur die Testung auf Genvarianten von CYPs angeführt. Hier ist bereits seit mehreren Jahren ein Bio-Chip am Markt, der es erlaubt, auf die häufigsten Genvarianten von CYP2D6 (und auch CYP2C19) zu prüfen. Dieser Test ist mit rund 1000 € zwar nicht billig, erlaubt es aber einem großen Teil der Untersuchten festzustellen, welcher Gruppe von „Metabolisierern“ sie angehören. Mit dieser Information kann einerseits die Verschreibung von Medikamenten vermieden werden, die schlecht oder gar nicht metabolisiert würden und damit zu schweren Nebenwirkungen führen könnten. Andererseits kann hier und auch im Falle von ultra-rasch Metabolisierern durch entsprechende Adjustierung des Dosierungsschemas die erwünschte Wirkung bei gleichzeitig gemindertem Risiko für schwere Nebenwirkungen erzielt werden.

Die Übernahme der Kosten derartiger Testungen durch öffentliche Kassen sollte für unser Gesundheitssystem prioritäre Bedeutung haben: Patienten würden entscheidend profitieren, wenn sie nicht mehr mit der Wirkung schwerste Nebenwirkungen riskierten oder ein Medikament nach dem anderen auszuprobieren bräuchten, bis endlich eines wirkte. Es würden aber auch die Kosten für das Gesundheitssystem bedeutend sinken, infolge reduzierter Ausgaben für Medikamente ebenso wie infolge insgesamt reduzierter Behandlungskosten.

Einzelnachweise und Quellen:

[1] WHO (2008): http://www.who.int/mediacentre/factsheets/fs293/en/

[2] Pirmohamed M, et al (2004): Adverse drug reactions as cause of admission to hospital: prospective analysis of 18 820 patients. Bmj 329: 15–19

[3] Pirmohamed M. (2010) Drug-drug interactions and adverse drug reactions: separating the wheat from the chaff. Wien Klin Wochenschr 122:62-64

[4] Lazarou J, et al., (1998) Incidence of adverse drug reactions in hospitalized patients: a metaanalysis of prospective studies. Jama 279: 1200–1205

[5] Ingelman-Sundberg M, et al., (2007) Influence of cytochrome P450 polymorphisms on drug therapies: Pharmacogenetic, pharmacoepigenetic and clinical aspects. Pharmacol Ther 116: 496-526

Gibt es Rezepte für die Bewältigung von Komplexität?

Gibt es Rezepte für die Bewältigung von Komplexität?Fr, 03.11.2011- 05:20 — Peter Schuster

Die biologische Evolution schafft komplexe Gebilde und kann damit umgehen.

Unsere heutigen Gesellschaften sind mit überaus komplexen Problemen in Wirtschaft, Zusammenleben und Auseinandersetzung mit der Natur konfrontiert, deren Ursachen zum Teil der Natur inhärent, zum Teil vom Menschen verursacht sind.

Zweifellos sahen sich aber auch frühere Generationen entsprechend ihrem damaligen Wissensstand nicht weniger komplexen Situationen ausgesetzt. Das stetig steigende Wissen der Menschheit liefert zwar immer mehr Einsichten in Zusammenhänge, welche früheren Gesellschaften verschlossen waren, die zu lösenden Probleme haben aber nicht zuletzt durch die rasante Zunahme der Weltbevölkerung in einem ebenso gewaltigen Ausmaß zugenommen.

Wenn man beispielsweise den Problemkreis Wetter und Klima betrachtet, so wurden Unwetter, Blitze, Überflutungen und Dürre bis zum Beginn der Neuzeit als Strafmaßnahmen erzürnter Götter oder als Untaten von Hexen und Zauberern interpretiert. Die zum Teil sehr ausgereifte Weltsicht der Mayas versetzte diese zwar in die Lage die Bewegungen der Gestirne mit einer erstaunlichen Präzision vorauszuberechnen und einen äußerst genauen Kalender zu erstellen, verhalf ihnen aber nicht zum dringend benötigten Regen, für den sie dem Regengott Chaac so viele Menschenopfer darbrachten.

Erst die Physik des ausgehenden 17. und des 18. Jahrhunderts schuf mit der Entdeckung elektrischer Phänomene auch eine neue Basis für die Interpretation der Wettererscheinungen. Benjamin Franklin nutzte diese Kenntnisse und erfand 1752 den Blitzableiter, als er einen Papierdrachen mit Metallspitze in einem Gewitter steigen ließ. Es dauerte allerdings noch zwei Jahrhunderte, bevor eine Theorie der Gewitterbildung und Blitzentladung entwickelt war; die Vorhersagemöglichkeiten, wann und wo ein Blitz einschlagen wird, sind auch heute noch beschränkt. Jedoch war mit dem Blitzableiter eine Schutzmaßnahme möglich geworden, welche viel vom Schrecken der Gewitter genommen hat.

Die Möglichkeit, komplexe Fragestellungen in Angriff zu nehmen, ließ noch auf sich warten. Vorerst feierte die Physik triumphale Erfolge indem es ihr gelang, komplexe Sachverhalte auf möglichst wenige messbare und kontrollierbare Faktoren zu reduzieren. Die Suche nach dem Einfachen führte zur Entwicklung von Telephon, Radio, Grammophon, Kino, Automobil, Flugzeug, Turbine und vielem anderen mehr. Erst Ende des 19. Jahrhunderts begann mit den Pionieren Ludwig Boltzmann und Josiah W. Gibbs die Erforschung der Physik komplexer Vorgänge.

Wann bezeichnen wir einen Sachverhalt als komplex?

Drei Merkmale müssen gleichzeitig zutreffen: (i) die Nichtdurchschaubarkeit, (ii) die Nichtvorhersagbarkeit des Ergebnisses und (iii) die Beeinflussbarkeit des Ergebnisses durch viele Faktoren.

Darüber hinaus kann Komplexität sich in unterschiedlichen Formen manifestieren: als unorganisierte Komplexität und als organisierte Komplexität (W.Weaver: Science and Complexity. 1948).

|

|

| Abbildung 1 - Komplexität: links: Die Brownsche Bewegung als Beispiel für unorganisierte Komplexität (Bild: Christian Bayer, Thomas Steiner, CC-by-SA 2.5); rechts: organisierte Komplexität am Beispiel des Hurrikans Catrina (Bild: NASA 28.8.2005) | |

Als Beispiel für unorganisierte Komplexität kann die Bewegung von Molekülen in einem Gas herangezogen werden. Jedes dieser Milliarden und Abermilliarden Moleküle bewegt sich geradlinig, bis es mit einem anderen Molekül zusammenstößt und abrupt die Richtung ändert. Als sogenannte Brownsche Bewegung unter dem Mikroskop sichtbar gemacht, sieht man die Spur eines großen Teilchens, das – gestoßen durch die aus allen Richtungen kommenden Atome – sich wie in einem Irrflug bewegt. (Abbildung 1). Diese („thermische“) Bewegung erscheint regellos, das Kollektiv der Gasmoleküle weist aber eine ganz genau messbare Dichte und Temperatur auf. Die thermische Bewegung ist unter anderem auch verantwortlich für den Temperaturausgleich durch den Wärmefluss zwischen einer wärmeren und einer kälteren Schicht. Unorganisierte Komplexität ist durch statistische Verfahren – heute in Form der statistischen Mechanik ein integraler Bestandteil der Physik – behandelbar und wird nicht mehr den wirklich komplexen Phänomenen zugeordnet.

„Organisierte Komplexität“ kennen wir in vielen unterschiedlichen Facetten; in ihrer einfachsten Form charakterisiert man sie als das Ergebnis der Selbstorganisation physikalischer Systeme. Zur Illustration als einfaches Beispiel betrachten wir eine Flüssigkeit in einer flachen Schale, die von unten erhitzt wird: Die heiße leichtere Flüssigkeit befindet sich unten, die kalte schwere Flüssigkeit ist oben – ein Ausgleich ist unvermeidbar. Bei geringen Temperaturdifferenzen erfolgt der Temperatur- und Dichteausgleich durch die unkoordinierte thermische Bewegung. Bei größeren Temperaturunterschieden wird diese Form des Ausgleichs zu langsam und die regellose Diffusion wird abgelöst von der Rayleigh-Bénard-Konvektion: an bestimmten Stellen einer Flüssigkeit steigen alle Moleküle nach oben, an anderen Stellen fließen sie nach unten, wodurch der Dichteausgleich rascher bewerkstelligt wird. In der flachen Schale beobachtet man bienenwabenartige Säulchen: Im Inneren der Sechsecke strömt die Flüssigkeit nach oben, an den Rändern nach unten.

Diese Koordination der Bewegung einzelner Moleküle bei höheren Temperaturunterschieden kann auf die Atmosphäre übertragen werden und hat mitunter fatale Konsequenzen: Bei genügend hohen Bodentemperaturen führen die koordinierten Bewegungen der Luftsegmente zur Ausbildung von Gewittern und unter Umständen zu Tornados. Über sehr warmen Meeresoberflächen können Hurrikans oder Taifune entstehen (Abbildung 1). Die gegenwärtige Atmosphärenphysik stellt eine ausgereifte Theorie für die Entstehung von Gewittern, Tornados und Hurrikans zur Verfügung, kann jedoch (noch) nicht präzise vorhersagen, wann und wo ein Tornado oder ein Hurrikan auftreten wird.

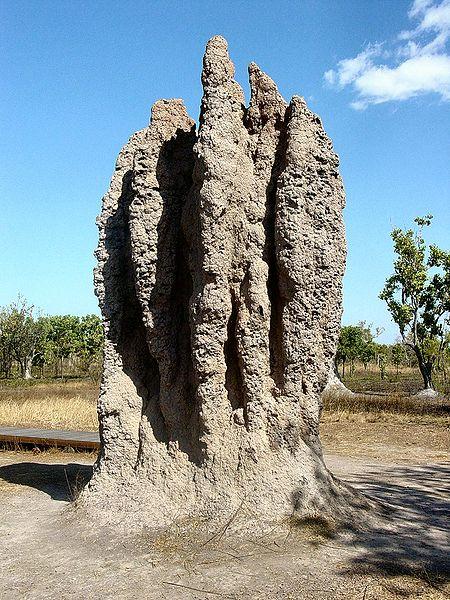

Organisierte Komplexität – Selbstorganisation - Musterbildung

Selbstorganisationsprozesse sind überaus weit verbreitet und keineswegs auf Flüssigkeiten und Gase beschränkt (Abbildung 2). Musterbildung gibt es z.B. wenn der Wind über den feinen Sand einer ebenen Wüste streicht und sich erst waschrumpelartige Formen, später wachsende Sandhaufen und schließlich Dünenlandschaften ausbilden. Bergsteigern bekannt sind die von Kühen auf den Abhängen von Almböden ausgetretenen regelmäßigen Pfadmuster („Ochsenklavier“). Von Termiten gebaute Nester erinnern an Miniaturkathedralen. Alle diese Phänomene werden als Ergebnisse von Selbstorganisation interpretiert – hinreichend komplexe Systeme verhalten sich ohne Zutun von außen so, als ob eine ordnende externe Kraft am Werk wäre. Dieses Entstehen von Ordnungen manifestiert sich nur in Kollektiven und kann nicht direkt aus den Eigenschaften und Handlungen der Individuen erklärt werden.

Selbstorganisation und ihre Mechanismen wurden zu einem zentralen Thema von Physik, Chemie und Biologie des 20. Jahrhunderts. Eindrucksvolle Beispiele für die Entstehung von Mustern bei chemischen Prozessen wurden Anfang der Fünfzigerjahre von Alan Turing, einem englischen Mathematiker und Pionier der Computerwissenschaften vorhergesagt und zur selben Zeit vom russischen Biophysiker Boris Belousov am Beispiel einer komplexen chemischen Reaktion experimentell nachgewiesen. Heute ist die Musterbildung bei chemischen Reaktionen ebenso gut verstanden wie die Kinetik einfacher chemischer Prozesse: Die entstehenden Muster können mit beeindruckender Genauigkeit vorausberechnet werden. Ebenso wie bei den Modellen für die Ausbildung von Tornados oder Hurrikans hängt aber die genaue Vorhersage, wann und wo die Patterns zuerst entstehen werden, von nicht bestimmbaren feinsten Details ab – beispielsweise den molekularen Details der Gefäßoberfläche oder dem Auftreten von winzigen Gasblasen.

Selbstorganisation lebender Systeme - Reproduktion, Mutation, Selektion

Computerrechnungen auf der Basis des Turingschen Modells der Musterbildung ergaben erstaunliche Übereinstimmungen mit den in der Natur auf den Fellen, Häuten und Schalen aufgefundenen Färbungspatterns (Beispiele in Abbildung 3). Das Turingsche Modell auf die embryologische Morphogenese bei Insekten und Wirbeltieren übertragen konnte nicht nur viele Phänomene beschreiben, sondern sogar Fehlbildungen bei mechanischen oder chemischen Störungen des Entwicklungsprozesses korrekt vorhersagen. Allerdings hat die molekulare Aufklärung der Entwicklungsgenetik gezeigt, dass die Prozesse, welche tatsächlich im Organismus ablaufen, viel komplizierter sind als in dem chemisch motivierten Turingschen Modell. Informationsaustausch durch Kontakte zwischen den Zellen, organisierter Transport von Molekülen in und aus Zellen und Signalkaskaden tragen ganz entscheidend zu Stabilität und Reproduzierbarkeit der Entwicklungsvorgänge bei.

Alle Organismen werden von Beginn ihres Lebens an durch Ablesung und Interpretation der auf Nukleinsäuremolekülen – mit Ausnahme einiger weniger Klassen von Viren den Desoxyribonukleinsäuren (DNA) – verschlüsselt niedergelegten genetischen Information aufgebaut. Die Information kann dabei direkt durch Mendelsche Vererbung von den Eltern an die Nachkommen weitergegeben werden oder sie wird über einen der verschiedenen epigenetischen Mechanismen zusätzlich zu den elterlichen Genen übertragen. Der Übersetzungsschlüssel für die genetische Information ist universell: Alle Organismen sprechen dieselbe Sprache. Vor jedem Vermehrungsschritt wird das DNA-Molekül kopiert. Trotz der unwahrscheinlich hohen Genauigkeit sind Kopierfehler (Mutationen) unvermeidbar. Mutationen sind die Ursache der Vielfalt in der Biologie, und sie bauen auch das Reservoir an Varianten auf, unter welchen der Selektionsprozess wählen kann. Nach dem heutigen Stand des Wissens ist die überwiegende Zahl der Mutationen ohne Auswirkung auf den Organismus („neutrale“ Mutationen) oder nachteilig. Eine wichtige Aufgabe des Selektionsprozesses ist die Eliminierung der nachteiligen Varianten. Die seltenen vorteilhaften Varianten werden durch die Selektion verstärkt und manifestieren sich in den Anpassungen an die komplexe Umwelt.

Komplexität lebender Organismen. Wie schafft es die Natur mit diesem ungeheuren Grad an Komplexität erfolgreich umzugehen?

Die Molekularbiologie hat seit ihren Anfängen in den Fünfzigerjahren des vorigen Jahrhunderts die ungeheure Komplexität des molekularen Geschehens in den lebenden Organismen aufgezeigt: Im menschlichen Genom kodieren rund fünfundzwanzigtausend Gene für Proteinmoleküle, welche das komplexe Netzwerk der chemischen Reaktionen des Stoffwechsels zum Laufen bringen und steuern. In unserem Gehirn sind einhundert Milliarden Nervenzellen mit einhundert bis eintausend mal so vielen Verknüpfungen verbunden. Unser Immunsystem kann eine überastronomisch große Zahl von molekularen Erkennungs- und Diskriminierungsakten setzen.

Das größte Rätsel der Biologie besteht weniger im Ausmaß der Komplexität als in der Tatsache, dass derart komplexe Systeme lebenstüchtig und anpassungsfähig sind. (Denken wir doch nur an die von Menschen geschaffenen komplexen Gebilde in der Politik, Gesellschaft und Wirtschaft. Sie alle tendieren zur Instabilität, wenn sie zu groß werden.) Die Lösung dieses Rätsels ist eng verknüpft mit dem evolutionären Mechanismus von Vererbung, Variation und Selektion. Die Natur entwirft neue Strukturen nicht mit den Augen eines Ingenieurs und hat keine Visionen. Sie löst die bestehenden Probleme durch Basteln (die englischen und französischen Begriffe tinkering und bricolage treffen besser, was gemeint ist). Das „Design“ des menschlichen Körpers ist dafür ein eindrucksvolles Beispiel: Stammesgeschichtlich ursprünglich ein Wurm, der sich durch den wässrigen Schlamm schlängelte, wurde daraus ein Torpedo in Fischform, der rasch durch das Wasser schwimmen konnte und im nächsten Schritt den Flossenantrieb zu Gliedmaßen umfunktionierte als er an Land ging. Schließlich, mit Beinen zur Fortbewegung und Armen für geschicktes Handwerk, richtete sich der umgebaute Torpedo auf (und hatte fortan Probleme mit Gelenken und Wirbelsäule).

Der Erfolg der evolutionären Methode besteht in ihrer universellen Anwendbarkeit. Variation und Selektion arbeiten mit einfachen Molekülen ebenso wie mit hochkomplexen Organismen (allerdings ist der Vorgang alles andere als ökonomisch, da eine enorme Zahl nicht zweckdienlicher Konstrukte auftreten kann). Worauf es ankommt sind lediglich die drei Grundvoraussetzungen, Vermehrung mit Vererbung, Mutation durch ungenaue Reproduktion und Selektion auf Grund beschränkter Ressourcen.

Die Evolution einfacher Moleküle findet ihre erfolgreiche Anwendung u.a. in der Evolutionären Biotechnologie, die seit zwanzig Jahren Moleküle züchtet, die z.B. als hochspezifische Diagnostika in der Medizin eingesetzt werden oder als Protein spaltende Enzyme in Waschmitteln. Es fehlt nicht an biologischen Beispielen bei den höchst komplexen Organismen: drei Beispiele für genetisch gesteuerte Begleitentwicklungen der Evolution zum Menschen sind die Verzögerung des Erwachsenwerdens, die Entwicklung eines für menschliche Sprachen geeigneten Kehlkopfs und die besondere Beweglichkeit der Finger für einen diffizilen Werkzeuggebrauch.

Zum Umgang mit Komplexität

In der unbelebten Umwelt bedarf es ausreichenden physikalischen Wissens, um komplexen Phänomenen begegnen zu können. Der Blitzableiter war ein Beispiel für eine einfache und wirkungsvolle Problemlösung. Andere Phänomene können zwar perfekt modelliert werden (z.B. Musterbildung bei atmosphärischen Ereignissen wie Hurrikans, Taifune oder Tornados), aber weder verhindert noch – auf Grund der Natur des Problems – mit ausreichender Präzision vorausgesagt werden. Besonders schwierig ist die gegenwärtige Situation im Fall von globalen Klimaänderungen, da die Zahl der beeinflussenden Faktoren sehr hoch ist und deren Zusammenhänge noch nicht ausreichend verstanden sind.

Eine andere Dimension der Komplexität finden wir in der belebten Natur vor: Die Zahl, der in stark verschachtelten Netzwerken miteinander verknüpften Elemente ist ungeheuer groß und sehr viele Einzelheiten der Interaktionen sind noch unbekannt. Das Rezept, das die Natur hier erfolgreich anwendet um mit diesem Komplexitätsgrad umzugehen, ist der Evolutionsmechanismus.

Noch um einiges komplexer sind Beispiele aus den menschlichen Gesellschaften, wo eine getätigte Vorhersage die weitere Entwicklung beeinflussen kann. Ein typisches Beispiel einer sich selbst erfüllenden Prophezeiung ist z.B. die Ankündigung eines Kursverlusts von Aktien, die zum Verkauf von Aktien führt und damit zum tatsächlichen Kursverlust. Ein anderes Beispiel aus dem Bereich der Medizin ist der Placebo-Effekt - eine Erwartungshaltung, die mit im Prinzip unwirksamen Verbindungen zu therapeutischem Erfolg führt. Hier müssen Naturwissenschafter und Mediziner mit Psychologen, Soziologen und Nationalökonomen zusammenarbeiten, um ein besseres Verständnis dieser Phänomene zu erreichen und vielleicht auch Rezepte für den Umgang mit diesem höchsten Grad an Komplexität erarbeiten zu können.

Analytische Chemie als Wegbereiter der modernen Biowissenschaften

Analytische Chemie als Wegbereiter der modernen BiowissenschaftenDo, 20.10.2011- 04:20 — Günther Bonn

Die Analytische Chemie ist ein Teilgebiet der Chemie und beschäftigt sich mit der Identifizierung und Konzentrationsbestimmung von chemischen Verbindungen. Sie hat in den letzten Jahrzehnten zunehmend an Bedeutung gewonnen. Ein Rückblick zeigt, dass es im Laufe der Jahre immer wichtiger wurde, die Zusammensetzung von Stoffen in verschiedenen Bereichen wie z.B. der Lebensmittel- oder Pharmaindustrie aber auch in der Medizin, präziser und empfindlicher bestimmen zu können.

Damit verbunden ist die ständige Entwicklung von neuen analytischen Methoden, die Einblick in die Zusammenhänge von Molekülen liefern. Die Bedeutung der Analytischen Chemie wird auch durch die steigende Anzahl an Publikationen verdeutlicht (Abbildung 1).

Abbildung 1: Anzahl der in den letzten 60 Jahren publizierten Artikel mit dem Schlüsselwort „Analytik“

Abbildung 1: Anzahl der in den letzten 60 Jahren publizierten Artikel mit dem Schlüsselwort „Analytik“

Die Analytische Chemie ist geprägt von einer rasanten technologischen Entwicklung beginnend im letzten Jahrhundert. Nachfolgende Tabelle 1 gibt einen auszugsweisen Überblick über signifikante innovative analytische Entwicklungsschritte.

In den letzten Jahrzehnten wurden Trennmethoden wie die Gaschromatographie (GC) oder die Hochleistungsflüssigkeitschromatographie (HPLC) entwickelt und optimiert. An dieser Stelle seien Prof. Erika Cremer als Pionierin erwähnt, die 1946 an der Universität Innsbruck mit ihren Dissertanten an der Entwicklung der GC entscheidend mitwirkte und Prof. Csaba Horvath, der an der Yale Universität (USA) in den 60er Jahren mit anderen Kollegen die Hochleistungsflüssigkeitschromatographie-Trenntechnologie entwickelte. Ebenfalls dort wurden Kopplungsverfahren zwischen Trenntechnologie- (HPLC) und Strukturaufklärungsmethoden (Massenspektrometrie – MS) geschaffen, die heute aus den Laboratorien nicht mehr wegzudenken sind. Dafür erhielt Prof. John Fenn 2002 den Nobelpreis für Chemie.

| Jahr | Analysenmethode |

|---|---|

| 1906 | Chromatographie |

| 1930 | Elektrophorese |

| 1937 | Rasterelektronenmikroskopie |

| 1941 | Verteilungschromatographie |

| 1946 | NMR-Spektroskopie (NMR) |

| 1946 | Gaschromatographie (GC) |