Fr, 19.08.2016 - 07:27 — Peter Schuster

![]() Seit mehr als 50 Jahren sind Wissenschafter ebenso wie Laien an die Nutzung von Rechnern gewohnt , die immer schneller und dabei immer effizienter werden, insbesondere, was Prozessorleistung, Größe des internen Speicher und Speicherkapazität betrifft. Der theoretische Chemiker Peter Schuster (emer. Prof. Univ Wien) erklärt hier welche Auswirkungen die - entsprechend dem Moore'schen Gesetz - bis jetzt anhaltende, exponentielle Steigerung der Computerleistung auf die wissenschaftlichen Disziplinen hatte und warum diese bald ein Ende finden wird.

Seit mehr als 50 Jahren sind Wissenschafter ebenso wie Laien an die Nutzung von Rechnern gewohnt , die immer schneller und dabei immer effizienter werden, insbesondere, was Prozessorleistung, Größe des internen Speicher und Speicherkapazität betrifft. Der theoretische Chemiker Peter Schuster (emer. Prof. Univ Wien) erklärt hier welche Auswirkungen die - entsprechend dem Moore'schen Gesetz - bis jetzt anhaltende, exponentielle Steigerung der Computerleistung auf die wissenschaftlichen Disziplinen hatte und warum diese bald ein Ende finden wird.

Kürzlich hat Mitchell Waldrop, US-amerikanischer Teilchenphysiker und Redakteur des Journals Nature, die gegenwärtige Lage der Chip-Hersteller analysiert. Er kommt zur Schlussfolgerung: die von Moore im Jahr 1965 vorausgesagte, bis jetzt anhaltende exponentielle Steigerung der Computerleistung wird nun ein Ende erreichen [1].

Ist dies tatsächlich realistisch?

Als Nutzer von Rechnern seit nahezu deren Anbeginn, möchte ich im Folgenden versuchen die spektakuläre Entwicklung der Computer zu beleuchten: die Erfolge, die bis jetzt für die Mathematik, Naturwissenschaften und Technologien erzielt wurden, ebenso aber auch die möglichen Konsequenzen, die das Ende dieser Entwicklung bedeutet.

Das Moore'sche Gesetz

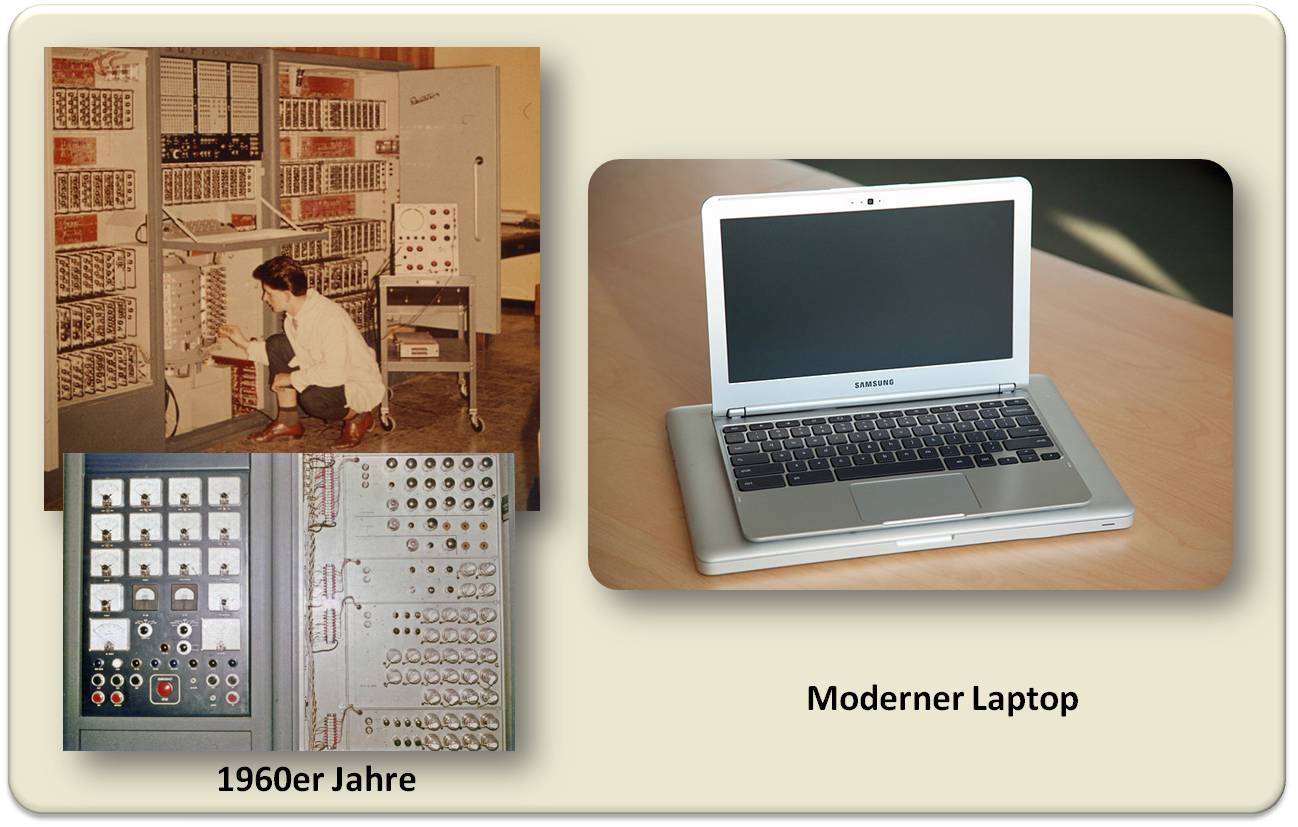

Nur wer bereits an den Rechenanlagen der frühen 1960er Jahre arbeitete, kann die enormen, seitdem erfolgten Fortschritte - im Großen wie auch in jedem kleinsten Detail - wirklich bewerten. Abbildung 1.

Man braucht sich nur an all die lästigen Unannehmlichkeiten von Damals erinnern: an das Stanzen von Lochstreifen, an die Fernschreibgeräte und dann an Prozessoren (Central Processing Units - CPU), die gerade einmal Speicher von 16 KB aufwiesen.

Abbildung 1. 50 Jahre Computer. Links: Einer der ersten Computer in Österreich war das mit 1.600 Elektronenröhren ausgestattete Burroughs 205 Datatron, an dem ich ab 1962 für meine Doktorarbeit rechnete (links unten die Stromversorgung). Das , was damals einen großen Raum füllte, enorme Wärme entwickelte und überaus störanfällig war, brachte unvergleichlich weniger Rechenleistung als (rechts) heute ein kleiner, moderner Laptop. (Bilder links: https://zid.univie.ac.at/chronik , rechts: https://www.wired.com/2013/01/samsung-chromebook-3/; Lizenz cc-by)

Abbildung 1. 50 Jahre Computer. Links: Einer der ersten Computer in Österreich war das mit 1.600 Elektronenröhren ausgestattete Burroughs 205 Datatron, an dem ich ab 1962 für meine Doktorarbeit rechnete (links unten die Stromversorgung). Das , was damals einen großen Raum füllte, enorme Wärme entwickelte und überaus störanfällig war, brachte unvergleichlich weniger Rechenleistung als (rechts) heute ein kleiner, moderner Laptop. (Bilder links: https://zid.univie.ac.at/chronik , rechts: https://www.wired.com/2013/01/samsung-chromebook-3/; Lizenz cc-by)

In diesem damaligen Szenario gab die Prophezeiung Hoffnung , dass die Computer-Leistungsfähigkeit eine exponentielle Steigerung erfahren werde. Diese Voraussage machte Gordon Moore, der ursprünglich ein Doktorat in Chemie, Nebenfach Physik, an der Caltech-Universität erworben hatte, als Postdoc in die angewandte Physik wechselte und schließlich ein führender Wissenschafter und Unternehmer in der Halbleiter-Technologie wurde. In seiner Funktion als Direktor von Forschung & Entwicklung des Fairchild Halbleiter Unternehmens wurde er - anlässlich des 35 jährigen Bestands des Jorurnals Electronics im Jahre 1965 gebeten einen Artikel zu schreiben. Er sollte darstellen, wie sich seiner Meinung nach die Halbleiter-Industrie in den nächsten zehn Jahren entwickeln werde.

Moore's Vorhersage der exponentiellen Steigerung der Leistungsfähigkeit von Computern basierte auf der überaus erfolgreichen Miniaturisierung der Komponenten in dichte integrierte Schaltkreise. Diese Extrapolation aus der beobachteten Entwicklung in der Vergangenheit in die Zukunft - üblicherweise als Moore'sches Gesetz bezeichnet, obwohl es sich augenscheinlich weder um ein physikalisches noch um ein ökonomisches Gesetz handelt und damit besser als Moore'sche Regel gelten sollte - wurde zum Leitprinzip für das Design von Computerspeichern und Mikroprozessoren. Die zur Verdopplung der Leistung nötige Zeit schätzte Moore vorerst auf ein Jahr und korrigierte dies 10 Jahre später auf 2 Jahre. Damals war er bereits Vizepräsident der NM Electronics (später Intel Cooperation), die er 1968 zusammen mit Robert Noyce gegründet hatte.

Exponentielles Wachstum kann nicht ewig fortdauern

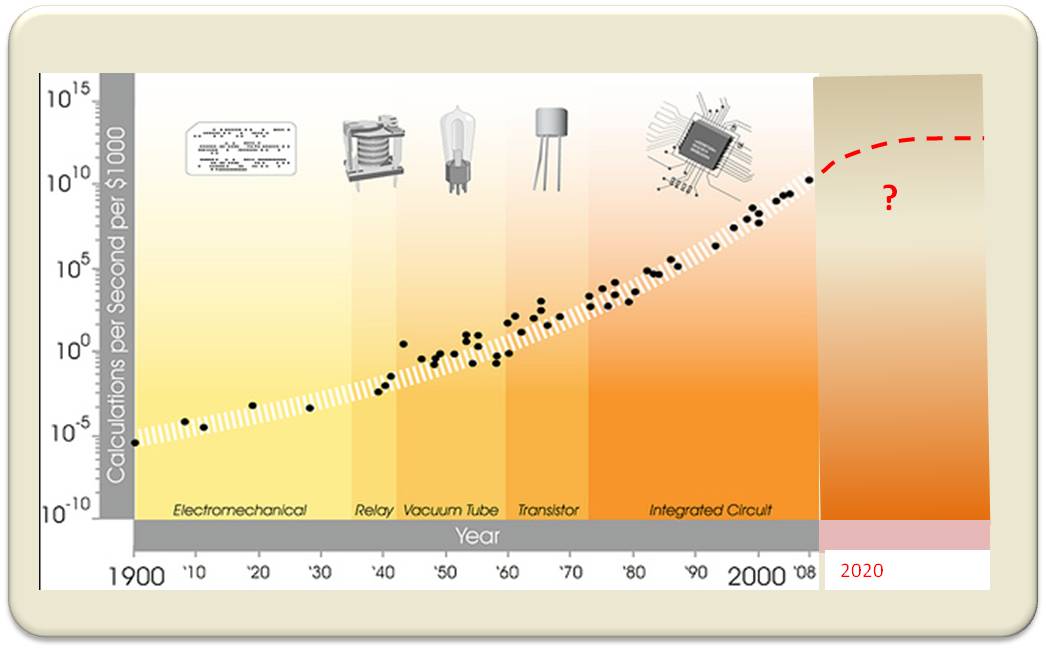

Meiner Ansicht nach grenzt es geradezu an ein Wunder, dass das Moore'sche Gesetz über 50 Jahre gelten konnte. Nach Ansicht des eingangs zitierten Waldrop hat dies teilweise mit dem Forschungs- und Entwicklungsplan - der Road Map - der Halbleiterforschenden Industrie zu tun, die seit den 1990er Jahren alle zwei Jahre die Agenda ihrer Hersteller und Zulieferer koordinierte, nach dem Motto "More Moore". Moore's Gesetz wurde damit zur selbsterfüllenden Prophezeiung und bis jetzt betrachtete die Semiconductor Industry Association (SIA) diese Regel als Grundlage ihrer Strategien für die Zukunft. Abbildung 2.

Abbildung 2. Das Moore'scheGesetz: Die Zahl der Rechenoperationen steigt exponentiell und wird immer billiger. Laut Waldrop sollte ab 2020 eine Stagnation des Wachstums eintreten (rote, gestrichelte Linie; Bild modifiziert nach: https://www.flickr.com/photos/jurvetson/3656849977).

Abbildung 2. Das Moore'scheGesetz: Die Zahl der Rechenoperationen steigt exponentiell und wird immer billiger. Laut Waldrop sollte ab 2020 eine Stagnation des Wachstums eintreten (rote, gestrichelte Linie; Bild modifiziert nach: https://www.flickr.com/photos/jurvetson/3656849977).

Miniaturisierung stößt an Grenzen

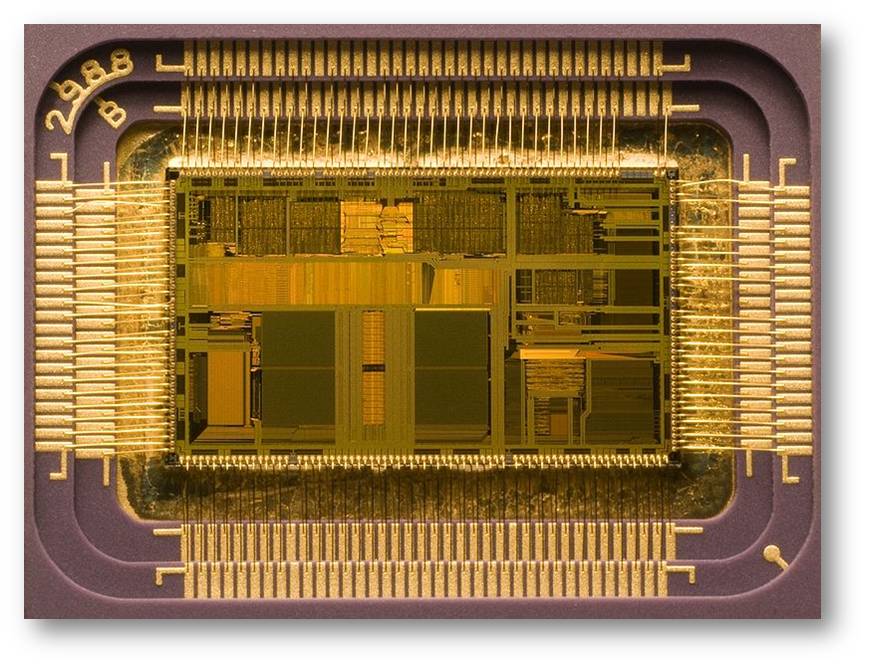

Exponentielles Wachstum wird erwartungsgemäß bald an seine Grenzen stoßen. Dasselbe gilt für die Miniaturisierung. Wenn die Zahl an Transistor-Elementen auf einem Chip zunimmt, sinkt der Abstand in dem Halbleitereigenschaften zum Tragen kommen. Abbildung 3. Die Grenze ist bei etwa atomaren Abständen erreicht, wo bereits Quanteneffekte von Bedeutung werden. Daher wurde vielfach die Ansicht vertreten, dass es der physikalische Abstand ist, der die Grenze der Miniaturisierung und damit das Ende der Moore'schen Extrapolation bestimmt. Es zeigte sich allerdings, dass zuvor eine andere Beschränkung, nämlich die Wärmeentwicklung, bestimmend ist.

Abbildung 3. Ein Mikroprozessor (Intel i486DX2) für einen Personal Computer 1992. Nach Öffnen des Gehäuses des Chips sieht man rund 1,2 Millionen Transistoren auf einer Fläche von etwa 76 mm2 untergebracht. Heute sind es bereits Milliarden Transistoren. (Bild: cc-by-sa. Englische Wikipedia).

Abbildung 3. Ein Mikroprozessor (Intel i486DX2) für einen Personal Computer 1992. Nach Öffnen des Gehäuses des Chips sieht man rund 1,2 Millionen Transistoren auf einer Fläche von etwa 76 mm2 untergebracht. Heute sind es bereits Milliarden Transistoren. (Bild: cc-by-sa. Englische Wikipedia).

Bereits der Computer-Pionier Rolf Landauer hatte auf Basis grundlegender thermodynamischer Überlegungen und der Irreversibilität der Rechenvorgänge das Problem einer unvermeidbaren Wärmeentwicklung erkannt. Die Alternative - unendlich langsames Rechnen und kein Löschen von Daten - würde zwar zu reversiblen Vorgängen führen, aber nicht den Anforderungen an einen Computer entsprechen können.

Der Anstieg der Leistungsfähigkeit der Rechner war bis 2002 teilweise auf das Steigen der Taktfrequenzen zurückzuführen. Seitdem blieben diese aber annähernd konstant - üblicherweise unter 3 GHz, während die Zahl der Transistoren auf einem Chip weiterhin exponentiell anstieg. Früher brachte ein Verkleinern automatisch Vorteile: die Elektronen hatten geringere Distanzen zurückzulegen, die Chips arbeiteten schneller und die Energieaufnahme sank. Als aber zur Jahrhundertwende die Abstände auf den Chips sich unter 90 nm verringerten und der rasche Elektronenfluss mehr Hitze erzeugte als abgeführt werden konnte, wurden dir Chips zu heiß. Die Lösung dieses Problems bestand in der Etablierung von Multiprozessor CPU's - im Prinzip erreicht man mit 4 CPU's, die bei 250 MHz arbeiten, dieselbe Leistung, wie mit einem 1 GHz-Rechner.

Der Rekord im Miniaturisieren von Schaltkreisen liegt derzeit bei einem Durchmesser von 14 nm, entsprechend dem Moore'schen Gesetz könnten 2 - 3 nm in den 2020er Jahren erreicht werden. Dies bedeutet dann aber eine nicht mehr überwindbare Grenze. Mit nur zehn oder weniger Atomen Distanz zwischen den Einheiten kommt man in den Bereich von Quanteneffekten - die Transistoren würden dann hoffnungslos unverlässlich werden. Dieser Quanten-bedingten Grenze steht aber noch eine ökonomische Grenze im Weg. Die Kosten für Chips-Produzenten steigen mit der Zahl der auf einem Chip befindlichen Transistoren exponentiell an - eine experimentelle Beobachtung, die gerne auch als 2. Moore'sches Gesetz bezeichnet wird. Wir stehen damit eines Tages vor der Situation, dass die erforderlichen Investitionen höher werden, als dass sie auch von den größten Unternehmen getragen werden könnten.

Anforderungen des Markts

Ein anderes Faktum, das die Industrie zum Aufgeben des Moore'schen Gesetzes veranlassen wird, wird durch die Forderungen des Markts diktiert. Bis zur Jahrtausendwende dominierten Chips, die in Großrechnern, Minicomputern, Personalcomputern und Laptops eingesetzt wurden. Danach hat sich das Spektrum der Anwendungen enorm erweitert: Smartphones und Tablets benötigen zwar unterschiedliche Prozessoren, die Chips sind aber den früheren Chips aber durchaus vergleichbar. Mit dem Einsatz in Anlagen und Geräten des täglichen Lebens änderte sich die Situation gewaltig. Prozessoren in einer Waschmaschine, einem Geschirrspüler, einem Auto, einer Klimaanlage, etc. müssen ja nicht auf einem "Allzweck"-Chip lokalisiert werden und sie benötigen im allgemeinen auch keine wesentlich höhere Leistungsfähigkeit als derzeit vorhanden ist. Ganz im Gegenteil: auf die spezielle Anwendung getrimmte Geräte erfüllen die Anforderungen fast immer besser und sind, wenn sie in großen Zahlen produziert werden, auch billiger. Die Halbleiter-Industrie geht also in Richtung Spezialisierung und wird damit den Pfad des Moore'schen Gesetzes verlassen.

Eine neue Moore-Ära?

Was wird nun mit den restlichen Firmen, die der Moore'schen Road Map folgen, wenn in den frühen 2020er Jahren eine weitere Miniaturisierung auf Grund störender Quanteneffekte nicht mehr stattfinden kann? Es gibt hier eine Reihe von Ideen wie, um nur zwei Beispiele zu nennen, den Quantencomputer oder neuromorphes Rechnen. Bis jetzt haben diese nur wenig erreicht und es besteht eine Menge an Skepsis. Ungeachtet der Probleme, die mit grundlegend neuen Rechenmethoden zu lösen sein werden - welche deshalb weiter verfolgt werden müssen - erscheint es unwahrscheinlich, dass damit eine neue, ein weiteres halbes Jahrhundert dauernde " Moore Ära" der ComputerEntwicklung eingeleitet wird. Wir können zweifellos punktuelle Verbesserungen der Rechneranlagen erwarten aber nichts davon wird eine über Dekaden andauernde Leistungssteigerung erbringen.

Steigerung der Rechnerleistungen = Fortschritt in den Wissenschaften

Es ist überflüssig zu sagen, dass die Verwendung von Rechnern das Stadium praktisch aller wissenschaftlichen Disziplinen ganz wesentlich verändert hat. Zu den zwei Säulen - Theorie und Experiment - auf denen der wissenschaftliche Fortschritt beruht, ist als dritte Säule die Computersimulation hinzu gekommen.

Dass riesengroße Rechenjobs ausgeführt werden können, hat die Entwicklung neuer, hocheffizienter Algorithmen gefördert , die wiederum maßgeblich zur Steigerung der Rechnermöglichkeiten beigetragen haben. Es ist hier immer wieder zu betonen: für den Fortschritt der Computer-unterstützten Lösung von Problemen ist der Beitrag der numerischen Mathematik mindestens ebenso wichtig wie der Fortschritt in der Hardware.

…in der Mathematik

Um kurz auf den Nutzen gesteigerter Rechnermöglichkeiten für die einzelnen Disziplinen einzugehen: In der reinen Mathematik sind vor allem zwei Auswirkungen zu erwähnen: es gibt nun i) das sogenannte "symbolisches Rechnen", das die Analyse von früher als hoffnungslos kompliziert angesehenen Problemen ermöglicht und ii) mathematische Beweise durch "erschöpfendes Rechnen". Computer-unterstützte Beweise werden zwar nicht von allen Mathematikern akzeptiert , sie tragen aber mehr und mehr zur Lösung alter und neuer offener Probleme bei.

…in der Chemie

Was die Chemie betrifft, so waren vor der Ära der modernen Computer quantenchemische Berechnungen von kleinen Molekülen und Kristallen von sehr ungenauen Näherungen abhängig und verlässliche Resultate gab es nur in außerordentlichen Fällen. Heute bietet die Rechner-Technologie ausreichend Leistung, um sehr genaue Lösungen der stationären Schrödinger-Gleichung für kleine Moleküle zu ermöglichen; die so berechneten Strukturen und Spektren von Molekülen sind häufig genauer als die experimentell bestimmten. Für die Entwicklung von Rechnermethoden in der Quantenchemie wurden Walter Kohn und John Pople 1988 mit dem Nobelpreis ausgezeichnet.

…in den Ingenieurwissenschaften

Hier sind die Erfolge der rechnerunterstützten Anwendungen überaus beeindruckend. Die äußerst genaue „Methode der finiten Elemente“ - grundsätzlich handelt es sich um den Einsatz numerischer Lösungsmethoden für Differentialgleichungen - kann für verschiedenste physikalische Fragestellungen angewandt werden. Beispielsweise sind Berechnungen der Strömungsdynamik bereits so verlässlich geworden, dass sie in ernsthafte Konkurrenz mit Versuchen im Windkanal getreten sind. Rechnergestützte Mechanik zur Stabilität von Beton ist aus den Planungsunterlagen im Tunnel- und Brückenbau nicht mehr wegzudenken, ebenso wie auch Berechnungen zur präzisen Demolierung von Gebäuden. Es könnten hier noch viele andere Beispiele angeführt werden, die interdisziplinäre, komplexe, von vielen Variablen abhängige Optimierungsprobleme lösen. Zu all diesen Anwendungen gibt es bereits Übersichtsartikel.

…in biologisch/medizinischen Wissenschaften

In all den vorher genannten Disziplinen wäre eine weitere Steigerung der Rechnerleistungen im Sinne des Moore'schen Gesetzes zwar wünschenswert, aber - wenn man Berechnung und Experiment in Hinblick auf Genauigkeit und Verlässlichkeit vergleicht - kaum notwendig. Es gibt allerdings Disziplinen, die ein Mehr an Computerleistung erfordern: Dies trifft für die Lösung von Problemen in der molekularen Dynamik zu, für bestimmte Gebiete der theoretischen Biologie, wie beispielsweise der Systembiologie, für die Bioinformatik, deren Ziel das Verwalten und Analysieren von Big Data ist oder auch für die rechnerunterstützte Medizin. Im letzteren Fall würde es wohl einer zweiten, mindestens 50 Jahre anhaltenden Steigerung der Rechnerkapazitäten bedürfen um die Standards einigermaßen erfolgreicher Berechnung zu erreichen. Schon jetzt wird intensiv an verlässlichen Vereinfachungen gearbeitet. Eine Stagnation im weiteren Anstieg der Computerleistung wird diese Entwicklungen entscheidend vorantreiben und könnte damit einen durchaus positiven Impuls auf die Methodenentwicklung und die Implementierung effizienterer Berechnungen haben.

Fazit

Betrachtet man die Chip-erzeugende Industrie und die sich ändernden Anforderungen des Markts, so kommt man zu dem Schluss, dass das Moore'sche Gesetz nun seinEnde findet. Zukünftige Steigerungen der Computer-Leistung werden wohl punktuelle sein, nicht jedoch - wie in den vergangenen 50 Jahren - das ganze System betreffen. Auch, wenn damit kein wesentliches Weiterkommen in der Leistung der Hardware verbunden ist, können wir dennoch einen enormen Fortschritt in der numerischen Mathematik und der Entwicklung von Algorithmen erwarten, die zukünftige Berechnungen noch erfolgreicher machen werden. Es gibt also keinen Grund für Pessimismus!

[1] Waldrop, M.M. More than Moore. Nature 2016, 530:145-147

Der vorliegende Essay ist die deutsche Fassung des Artikels „The end of Moore’s law. Living without an exponential increase in the efficiency of computational facilities?“, der in Kürze im Journal Complexity 21 (1) erscheinen wird und eine komplette Liste von Literaturzitaten enthält.

Weiterführende Links

zu diesem Themenkreis sind im ScienceBlog erschienen:

von Peter Schuster

- 28.03.2013: Wie Computermethoden die Forschung in den Naturwissenschaften verändern

- 03.01.2014: Computerwissenschafter — Marketender im Tross der modernen Naturwissenschaften

- 28.03.2014: Eine stille Revolution in der Mathematik

- 20.02.2015: Beschreibungen der Natur bei unvollständiger Information

von Gerhard Weikum:

- 20.06.2014: Der digitale Zauberlehrling

- Printer-friendly version

- Log in to post comments